Материалы по тегу: ии

|

21.11.2025 [16:25], Руслан Авдеев

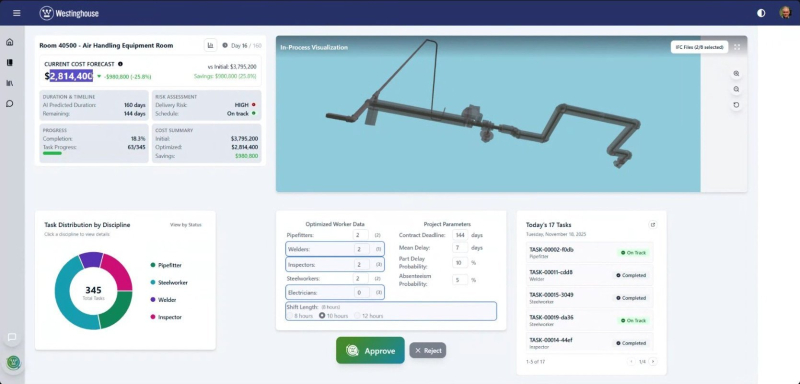

ИИ от Google ускорит строительство ядерных реакторов WestinghouseНа фоне энергодефицита, вызванного развитием отрасли ИИ ЦОД, компании Google и Westinghouse объединили усилия, чтобы оптимизировать строительство атомных мощностей с помощью ИИ-платформы на площадке Google Cloud. В частности, речь идёт о создании и эксплуатации 10 ядерных реакторов. Начало строительство запланировали на 2030 год, сообщает DatacenterKnowledge. Google сообщает, что пилотные испытания ИИ-платформы свидетельствуют об экономии средств и времени при строительстве АЭС. Palantir Technologies и The Nuclear Company развивают похожую ИИ-платформу. Ранее в 2025 года Westinghouse объявила о плане стоимостью $80 млрд, поддержанном правительством США. Он предусматривает создание 10 реакторов AP1000 мощностью 1,15 ГВт каждый к 2030 году. Цель проекта — удовлетворение стремительно растущего спроса на электроэнергию, связанного с ИИ-проектами. Но пока отрасли не хватает времени, поскольку крупные ЦОД уже строятся повсеместно. Согласно отчёту DNV, к 2040 году энергопотребление ЦОД вырастет впятеро, на долю Северной Америки придётся 16 % мирового потребления. Ядерная энергетика многими компаниями считается весьма привлекательным вариантом, поскольку её безопасность и эффективность значительно выросла в последние годы. МАГАТЭ прогнозирует, что к 2050 году совокупная мощность АЭС может удвоиться, а более 20 стран обещали даже утроить её к 2050 году. По оценкам МАГАТЭ, на строительство реактора может уйти до 10–12 лет. При этом даже на перезапуск недавно остановленных АЭС уходит несколько лет. Google и NextEra как раз планируют «оживить» АЭС DAEC к 2029 году, чтобы запитать новые ИИ ЦОД.

Источник изображения: The Register Google Cloud и Westinghouse уверены, что могут использовать ИИ для сокращения сроков строительства. Возможности компаний позволят не только использовать ИИ для строительства реакторов по-новому, но и для повышения эффективности и безопасности уже действующих АЭС. Westinghouse заявляет, что новая ИИ-платформа позволит вводить реакторы в эксплуатацию уже через 5–6 лет после начала строительства. Правда, на проект Westinghouse в Джорджии на базе реакторов AP1000, ушло целых 15 лет и огромные суммы. Westinghouse отмечает, что на пике строительства типичного реактора задействовано 10 тыс. человек, процессы требуют сложной координации действий. Представители компании уже продемонстрировали интерфейс нового инструмента, анализирующего миллионы строительных задач для определения оптимальных графиков и минимизации задержек. Так, в ходе демонстрации показали, как буквально одним щелчком мыши за считанные секунды можно сократить расходы для одной из задач на четверть или $1 млн.

21.11.2025 [14:14], Руслан Авдеев

AWS и Humain построят в Эр-Рияде кампус AI Zone, где развернут до 150 тыс. ИИ-ускорителей NVIDIA GB300 и Amazon TrainiumAWS и инвестиционная компания Humain из Саудовской Аравии объявили о планах развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей. В рамках расширенного партнёрства компании намерены предоставлять вычислительные мощности и ИИ-сервисы из Саудовской Аравии клиентам со всего мира. Первый в своём роде в Саудовской Аравии кампус AI Zone будет применяться для обучения ИИ и инференса, с доступом к новейшей ИИ-инфраструктуре на основе ускорителей NVIDIA GB300 и Amazon Trainium. Клиенты смогут быстро переходить от стадии концепции к непосредственно работам, а «железо» и ПО NVIDIA будут бесшовно интегрированы с инфраструктурой и сервисами AWS. Поддержка Amazon Bedrock, AgentCore и SageMaker обеспечит клиентам немедленный доступ к базовым моделям в рамках единой платформы без необходимости управления базовой инфраструктурой. Для расширения возможностей AI Zone компания Humain присоединится к программе AWS Solution Provider Program. Это поможет реализации совместного плана, анонсированного в мае 2025 года и предусматривающего инвестиции более $5 млрд в ИИ-инфраструктуру, сервисы AWS, обучение и развитие ИИ-специалистов в Саудовской Аравии. Представитель AWS в регионе EMEA заявил, что объединяя локальный опыт и инвестиции Humain с решениями AWS в сфере ИИ, а также аппаратные решения NVIDIA, инновационную платформу Amazon Bedrock и решения для бизнес-пользователей, включая Amazon Quick Suite, партнёры создают инновационный центр мирового уровня, способный обслуживать клиентов по всему миру. AWS и Humain также ускорят внедрение ИИ в государственном и частном секторах, в том числе развитие LLM с поддержкой арабского языка, включая ALLAM, и создание единого маркетплейса ИИ-агентов для правительственных сервисов.

Истчоник изображения: backer Sha/unsplash.com Для подготовки квалифицированных кадров AWS обучит 100 тыс. граждан Саудовской Аравии работе с облачными технологиями и специфике генеративного ИИ в рамках программы Amazon Academy, отдельно планируется поддержать программу повышения квалификации для 10 тыс. женщин. Усилия направлены на подготовку кадров для «ИИ-центричной» экономики, которая, по прогнозам, к 2030 году внесёт в ВВП страны вклад в объёме $130 млрд. Подобные проекты стали возможны во многом благодаря визиту в США наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman). Визит способствовал ряду соглашений американских компаний с саудовским бизнесом и Humain в частности — с участием AMD, xAI, NVIDIA и др., а также открыл дорогу для поставок в королевство передовых ИИ-чипов.

21.11.2025 [12:54], Руслан Авдеев

США одобрили экспорт передовых ИИ-чипов в Саудовскую Аравию, ОАЭ и АрмениюСоединённые Штаты одобрили поставки передовых чипов NVIDIA компании Humain из Саудовской Аравии, а также компании G42 из ОАЭ. Поддерживаемые на государственном уровне компании приобретут до 35 тыс. чипов общей стоимостью $1 млрд, сообщает CNBC. Новое соглашение свидетельствует о крупных изменениях политики США, ранее не желавших прямых поставок ИИ-ускорителей компаниям стран Залива, за которыми стоят государственные структуры. Экспортный контроль вводили, чтобы передовые американские технологии не утекли в Китай. Прошлая администрация последовательно вводила всё новые ограничения поставок, тогда как новая стремится шире распространять американские технологии, для продвижения дальнейшего доминирования США и сохранения глобального технологического лидерства. Министерство торговли подтвердило, что экспорт чипов будет осуществляться с учётом принципов безопасности и строгой отчётности, контролем займётся Бюро промышленности и безопасности министерства. Разрешение на экспорт дали после визита в Вашингтон наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman), королевство пообещало инвестировать в США $1 трлн. Ранее, в ходе майского визита Трампа в страны Залива, речь шла лишь о 600 млрд.

Источник изображения: NEOM/unspalsh.com Саудовская ИИ-компания Humain поддерживается королевским Фондом государственных инвестиций (Public Investment Fund), она подписала соглашения с Adobe, Qualcomm, AMD, Cisco, GlobalAI, Groq, Luma и xAI в ходе инвестиционного форума в Вашингтоне. Humain построит совместно с xAI дата-центр на 500 МВт в Саудовской Аравии. В Humain утверждают, что в 2026 году намерены сделать в королевстве столько, сколько было сделано за предыдущие 20 лет, и рассчитывают, что Саудовская Аравия станет третьим по величине ИИ-хабом в мире после США и Китая. По словам экспертов, у Humain и G42 имеется капитал для инвестиций, связи с NVIDIA и американским правительством. Компании могут воспользоваться этими преимуществами для строительства региональной ИИ-инфраструктуры и хотят использовать её для превращения Персидского Залива в вычислительный хаб. Стоит отметить, что всего пару недель назад Microsoft получила лицензию на экспорт передовых чипов в ОАЭ. Ключевым партнёром компании в стране является G42, но до сегодняшнего дня о поставках чипов именно ей Microsoft не сообщала.

Источник изображения: Gevorg Avetisyan/unsplash.com Тем временем, некоторые преференции от США получила и ещё одна страна — Армения, сообщает Bloomberg. В частности, ИИ-стартапу Firebird разрешили импортировать ускорители NVIDIA в рамках суперкомпьютерного проекта. Речь идёт о 100-МВт объекте, для строительства которого в регион привлекут $500 млн. Он будет использовать серверы Dell и ускорители NVIDIA Blackwell, первая очередь проекта должна заработать во II квартале 2026 года. Во времена последних нормативов Байдена, касавшихся ИИ-чипов, страна относилась ко «второму эшелону» государств по уровню ограничений, наряду с Израилем, Саудовской Аравией и Польшей. Впрочем, при Трампе эту градацию отменили. Приблизительно 20 % мощностей Firebird будет выделено армянским компаниям, остальные 80 % — бизнесам американского происхождения. Компания Firebird из Сан-Франциско была основана в 2025 году и сейчас насчитывает 25 сотрудников. Она ориентируется на строительство ЦОД на «чистой» энергии для развивающихся рынков, и уже ведёт переговоры в некоторых других странах, включая государства Латинской Америки. Экспансия на другие рынки запланирована не ранее 2027 года, пока компания намерена убедиться в успехе начинания в Армении. Впрочем, она уже ведёт переговоры с представителями Министерства торговли США о получении разрешений для прочих развивающихся рынков.

20.11.2025 [17:50], Руслан Авдеев

Nokia меняет стратегию развития, сделав ставку на ИИ, ЦОД и 6GВ ходе мероприятия 2025 Capital Markets Day для акционеров и инвесторов Nokia объявила о масштабной «перезагрузке» с разделением бизнеса на два основных сегмента. Теперь компания состоит из подразделений «Сетевая инфраструктура» и «Мобильная инфраструктура» (Network Infrastructure и Mobile Infrastructure). Годовая операционная прибыль (EBIT) компании должна составить €2,7–€3,2 млрд к 2028 году. Для сравнения, за последние четыре квартала она составила €2 млрд. Подразделение Network Infrastructure под руководством Дэвида Херда (David Heard) будет заниматься оптическими, IP- и фиксированными сетями связи. Оно позиционируется как ключевой сегмент, имеющий важное значение для строительства ИИ ЦОД. Подразделение Mobile Infrastructure под временным управлением гендиректора всей компании Джастина Хотарда (Justin Hotard) займётся ПО, сетями радиосвязи и технологическими стандартами, консолидируя ключевые технологические активы, связанные со стандартами 3GPP и лицензионный бизнес в единый драйвер прибыли для развития сетей 5G и 6G с использованием ИИ-технологий. Ранее компания переманила несколько высокопоставленных сотрудников HPE и Intel, а также получила топ-менеджеров в рамках сделок с Infinera и Juniper Networks. Все они должны помочь в реструктуризации компании. Новая стратегия вступает в силу с 1 января 2026 года. Для подразделений, более не считающихся ключевыми, вроде Fixed Wireless Access (FWA) CPE, Site Implementation & Outside Plant, Enterprise Campus Edge и Microwave Radio выделен вспомогательный сегмент Portfolio Businesses. За последние 12 мес. их общие продажи составили €900 млн, при этом операционный убыток от их деятельности составил €100 млн. Поэтому в 2026 году они подвергнутся стратегической переоценке. Nokia Defense будет работать как «инкубатор» при Nokia Federal Solutions, ориентируясь на обеспечение технологиями связи военных США, Финляндии и их союзников. Для поддержки реформ Nokia представила специфические KPI, заменившие прежние долгосрочные цели. В частности, в подразделении Network Infrastructure планируется добиться среднегодового роста 6–8 % к 2028 году, в Mobile Infrastructure — 48–50 %, а общие операционные расходы сократить с €350 млн до €150 млн к 2028 году. Также планируется пересмотреть финансовые показатели 2024–2025 гг. в соответствии с новой структурой. С I квартала 2026 года компания будет отчитываться по новой форме. Целевой показатель свободной конверсии денежного потока составляет 65–75 %. В целом Nokia выделяет пять стратегических приоритетов:

20.11.2025 [16:26], Руслан Авдеев

Brookfield, NVIDIA и партнёры направят $100 млрд на развитие ИИ-инфраструктуры и энергетикиУправляющая альтернативными активами компания Brookfield Asset Management совместно с NVIDIA запустила проект развития ИИ-инфраструктуры стоимостью $100 млрд. В число партнёров вошла Kuwait Investment Authority (KIA), сообщает Reuters. В основе программы — новый фонд Brookfield Artificial Intelligence Infrastructure Fund (BAIIF), целевой объём инвестиций в акционерный капитал составляет $10 млрд. Фонд уже сумел привлечь $5 от инвесторов, включая саму Brookfield, NVIDIA и KIA. По данным Brookfield, фонд купит связанные с ИИ-инфраструктурой активы на сумму до $100 млрд, включая энергетические мощности, землю, дата-центры и вычислительные мощности при поддержке дополнительных источников финансирования. Brookfield является одним из крупнейших в мире инвесторов в цепочку создания стоимости, связанную с ИИ. Компания потратила по всему миру более €100 млрд ($115,83 млрд) на цифровую инфраструктуру, возобновляемую энергетику и выпуск полупроводников. Активное внедрение ИИ стимулирует и спрос на инвестиции в соответствующую инфраструктуру, в т.ч. дата-центры, HPC и генерацию электроэнергии. Компании стремятся обеспечить мощности для ресурсоёмких ИИ-проектов. По словам Brookfield, ИИ потребует от мира реализации одного из самых масштабных инфраструктурных проектов в истории и в ближайшие годы соответствующие работы обойдутся в $7 трлн.

Источник изображения: Sean Pollock/unsplash.com Изначальные инвестиции фонда включают финансирование рамочного соглашения с Bloom Energy на сумму $5 млрд для установки источников электропитания мощностью до 1 ГВт для дата-центров и ИИ-фабрик. Инвестиция в энергетическую инфраструктуру обеспечит стабильное энергоснабжение энергоёмких объектов ИИ, минуя общественные сети. Ранее в 2025 году Brookfield объявила о намерении инвестировать до kr95 млрд ($10,01 млрд) в ИИ ЦОД в Швеции и выделила €20 млрд на ИИ-проекты во Франции. Конкурирующая BlackRock сформировала аналогичный фонд AI Infrastructure Partnership (AIP), ранее известный как Global AI Infrastructure Investment Partnership (GAIIP), который также вложит до $100 млрд ($30 млрд на первом этапе) в ИИ-инфраструктуру и смежные области. В AIP входят Microsoft, Global Infrastructure Partners (GIP, принадлежит BlackRock), дубайская государственная инвесткомпания MGX (создана Mubadala и G42), NVIDIA, xAI и всё тот же фонд Kuwait Investment Authority (KIA).

20.11.2025 [14:09], Руслан Авдеев

xAI, Humain и NVIDIA построят крупный ИИ ЦОД в Саудовской АравииГлава компании xAI Илон Маск (Elon Musk) объявил о новом совместном проекте xAI, NVIDIA и Humain в Саудовской Аравии. Новость появилась на фоне официального визита саудовского наследного принца Мухаммеда бин Салмана (Mohammed bin Salman) в США, сообщает NBC News. Проект был анонсирован практически одновременно с аналогичным проектом AMD, Cisco и Humain. По словам Маска, с использованием чипов NVIDIA и при участии Humain, созданной при поддержке суверенного фонда благосостояния Саудовской Аравии, компанией xAI будет построен дата-центр мощностью 500 МВт. Для сравнения, кампус ЦОД Colossus 1 компании xAI в Мемфисе является одним из крупнейших в мире действующих вычислительных кластеров и его мощность пока составляет около 300 МВт. Как заявляют в Белом доме, заявления о партнёрстве последовали после заключения меморандума о взаимопонимании в сфере ИИ между США и Саудовской Аравией. В соответствии с новым соглашением, Соединённые Штаты предоставляют ближневосточному королевству доступ к ведущим американским системам и одновременно американские технологии будут защищены от «иностранного влияния».

Источник изображения: NEOM/unspalsh.com По словам Маска, будущее буквально наполнено роботами и космическими ИИ ЦОД. В частности, он заявил, что «гуманоидные роботы станут крупнешим продуктом в истории», что сделает работу «необязательной». Прогнозируя будущее отрасли ИИ, Маск предположил, что через четыре-пять лет спутники с ИИ-модулями на солнечных батареях могут стать самым дешёвым способом обеспечить вычисления.

20.11.2025 [14:00], Руслан Авдеев

AMD, Cisco и Humain развернут ИИ-инфраструктуру на 1 ГВт — первые 100 МВт с Instinct MI450 появятся в Саудовской АравииКомпании AMD, Cisco и саудовская инвестиционная компания Humain, участвующая в комплексных ИИ-проектах, объявили о создании совместного предприятия. Ожидается, что оно поддержит укрепление позиций Саудовской Аравии в качестве ведущего поставщика ИИ-решений мирового класса для клиентов регионального и мирового уровней. Совместное предприятие должно заработать в 2026 году. Партнёры рассчитывают объединить передовые ИИ ЦОД Humain и технологическими решениями AMD и Cisco, обеспечив современную вычислительную инфраструктуру с низкими капитальными затратами и эффективным энергопотреблением. Эксклюзивными технологическими партнёрами предприятия выступят AMD и Cisco, к 2030 году с помощью их продуктов и сервисов планируется обеспечить до 1 ГВт ИИ-инфраструктуры. Компании уже объявили о реализации первой очереди проекта — пока мощностью на 100 МВт, в т.ч. включающую мощности современного дата-центра Humain, ИИ-ускорители AMD Instinct MI450 и инфраструктуру Cisco. Ранее в 2025 году Cisco и AMD объявили о совместной инициативе с Humain, направленной на строительство самой открытой, масштабируемой и экономически эффективной ИИ-инфраструктуры. Новый анонс дополняет планы созданием совместного предприятия для того, чтобы ускорить преобразования и предоставить экономическую инфраструктуру для поддержки использования ИИ заказчиками.

Источник изображения: NEOM/unsplash.com По словам главы AMD Лизы Су (Lisa Su), в рамках расширения сотрудничества в Саудовской Аравии также создаётся Центр передового опыта AMD (AMD Center of Excellence) для углубленной интеграции страны в ИИ-проекты. По данным Cisco, индекс готовности к развитию ИИ (AI Readiness Index) показывает, что, хотя 91 % организаций Саудовской Аравии готовятся к внедрению ИИ-агентов, только 29 % из них уже имеют доступ к значительным мощностям ИИ-ускорителей, что ещё раз подчёркивает острую потребность в современной инфраструктуре ЦОД. Ожидается, что партнёрство не только обеспечит вычислительные мощности для масштабного внедрения ИИ, но и будет способствовать укреплению цифровой экономики страны. Это лишь один из многих проектов для Саудовской Аравии. В 2025 году сообщалось, что Oracle выделит $14 млрд на развитие ИИ и облака в стране, xAI ведёт с Humain переговоры о создании ИИ ЦОД там же, в августе появилась информация, что саудовская center3 потратит $10 млрд на ЦОД общей мощностью 1 ГВт.

20.11.2025 [11:37], Сергей Карасёв

Представлен самый мощный суперкомпьютер на Ближнем Востоке — 122,8-Пфлопс система Shaheen IIIУниверситет науки и технологий имени короля Абдаллы (KAUST) в Саудовской Аравии объявил о запуске вычислительного комплекса Shaheen III. На сегодняшний день, как утверждается, это самый мощный суперкомпьютер на Ближнем Востоке: его FP64-производительность достигает 122,8 Пфлопс. Применять Shaheen III планируется для решения широкого спектра ресурсоёмких задач. Среди них названа разработка нового поколения малых и больших языковых моделей (LLM), ориентированных на арабский регион. Кроме того, суперкомпьютер поможет в создании цифрового двойника всего Аравийского полуострова — интегрированной среды моделирования, объединяющей атмосферные, океанические и земные процессы. Эта виртуальная модель будет способствовать решению комплексных проблем, таких как управление разливами нефти и оптимизация морских перевозок. В числе других задач названы оптимизация сельскохозяйственной деятельности и управления водными ресурсами, поиск передовых материалов, диагностика редких заболеваний, улучшение качества медицинской визуализации, разработка перспективных лекарственных препаратов и пр. Система создана компанией HPE на платформе Cray EX с прямым жидкостным охлаждением (DLC). В общей сложности задействованы 2800 гибридных суперчипов NVIDIA GH200 Grace Hopper с 72-ядерным Arm-процессором NVIDIA Grace и ускорителем NVIDIA H100 с 96 Гбайт памяти HBM3. Общее количество используемых ядер составляет 574 464. Применён интерконнект Slingshot-11. В качестве программной платформы используется HPE Cray OS. В ноябрьском рейтинге самых мощных суперкомпьютеров мира TOP500 система Shaheen III занимает 18-ю позицию. Её теоретическое пиковое быстродействие заявлено на уровне 155,21 Пфлопс. Энергопотребление — 1,98 МВт.

20.11.2025 [10:11], Руслан Авдеев

EDF и OpCore переделают закрытую французскую ТЭС в крупный ИИ ЦОД стоимостью €4 млрдФранцузская государственная энергетическая компания EDF (Électricité de France) и оператор ЦОД OpCore намерены создать дата-центр мощностью в сотни мегаватт недалеко от Парижа. На реализацию проекта потребуется €4 млрд ($4,3 млрд) — это соответствует стратегии ускоренного развития французской ИИ-инфраструктуры, сообщает ESG News. Пока EDF и OpCore ведут переговоры о создании ЦОД на территории бывшей ТЭС в Монтеро-Валле-де-ла-Сен (Montereau-Vallee-de-la-Seine). Участок относится к более широкой Парижской агломерации, где правительство и коммунальные службы намерены ускорить масштабное внедрение цифровых технологий, при этом принимается в расчёт, например, поддержка населения и развитие связи. Ранее в 2025 году EDF сообщила о желании найти застройщиков, способных возвести сверхмощные дата-центры на имеющихся у неё площадках. Компания является одним из крупнейших землевладельцев Франции и предлагает ускоренное присоединение к энергосети для инициатив, отвечающих национальным и экономическим интересам. OpCore, принадлежащая iliad Group и управляемым InfraVia фондам, имеет более 20 лет опыта разработки и управления ЦОД. Благодаря инфраструктурным возможностям iliad Group и капиталу InfraVia, компания может обеспечить инженерные и эксплуатационные потребности кампуса на сотни мегаватт. Источники описывают проект в Монтеро как «стратегический якорь» для развития ИИ в Европе. Проработавшая десятилетия угольная электростанция окончательно закрылась в 2004 году, а перестройка в кампус ЦОД соответствует местным амбициям по «реновации» бывших промышленных территорий с учётом современных экологических ограничений. Ожидается, что в период строительства и эксплуатации ЦОД появятся сотни рабочих мест. Интеграция проекта в местное сообщество будет осуществляться с привлечением муниципальных властей и региональных экономических ведомств. Точная мощность кампуса не указывается, но сам факт того, что речь идёт о сотнях мегаватт, позволяет говорить, что он станет одним из мощнейших ИИ ЦОД в Европе. Французские власти однозначно заявляют о необходимости быстрого создания крупной национальной инфраструктуры, чтобы избежать стратегической зависимости от поставщиков облачных и вычислительных решений неевропейского происхождения. Ввод в эксплуатацию первой очереди запланирован в 2027 году. Проект стал частью более масштабных усилий Франции по упрощению получения разрешений на инфраструктуру. Это способствует реализации национальных приоритетных планов, включая развитие ИИ, облачных сервисов и выпуск аккумуляторов. Представители французских властей всех уровней заявляют о необходимости превращения страны в крупную ИИ-сверхдержаву — лидера отрасли, с упором на атомную энергетику. Стоит отметить, что аналогичные амбиции имеет и Великобритания, тоже делающая ставку на мирный атом. Более того, в Евросоюзе рассматривают необходимость ограничения возможностей американских облачных гигантов.

19.11.2025 [17:38], Руслан Авдеев

По одному GPU на каждого американца: ИИ-облако Lambda привлекло ещё $1,5 млрд инвестиций на амбициозное развитие инфраструктурыПоставщик облачных решений для ИИ-проектов — компания Lambda привлекла более $1,5 млрд. Раунд возглавила холдинговая TWG Global при участии Американского фонда инновационных технологий (US Innovative Technology Fund) и других, уже финансировавших бизнес инвесторов. Как заявил представитель Lambda, новый раунд финансирования поможет компании построить ИИ-фабрики гигаваттного масштаба, обеспечивающие работу сервисов, используемых миллионами людей ежедневно. В компании добавили, что её миссия — сделать вычисления столь же общедоступными, как и, например, электричество, предоставив доступ к ИИ каждому американцу по принципу «один человек — один GPU». В раунде финансирования серии D, состоявшемся в феврале 2025 года, Lambda привлекла $480 млн .

Источник изображения: Lambda Основанная в 2012 году Lambda предлагает облачные вычисления на основе ИИ-ускорителей и, согласно информации на её сайте, располагает 15 дата-центрами по всей территории США. Компания намерена развернуть более 1 млн. ускорителей NVIDIA и 3 ГВт мощностей ЦОД с жидкостным охлаждением. Раунд финансирования последовал за многомиллиардным контрактом компании с Microsoft, заключённым ранее в ноябре. Согласно условиям договора, Lambda предоставит IT-гиганту доступ к десяткам тысяч ИИ-ускорителей. Также подписано соглашение на $1,5 млрд с NVIDIA, которая будет арендовать у Lambda чипы собственного производства. |

|