Материалы по тегу: hardware

|

11.02.2026 [16:48], Владимир Мироненко

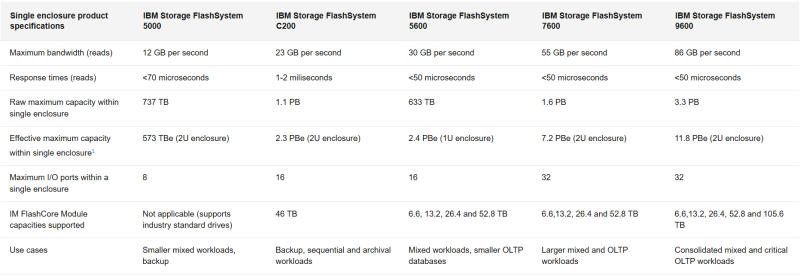

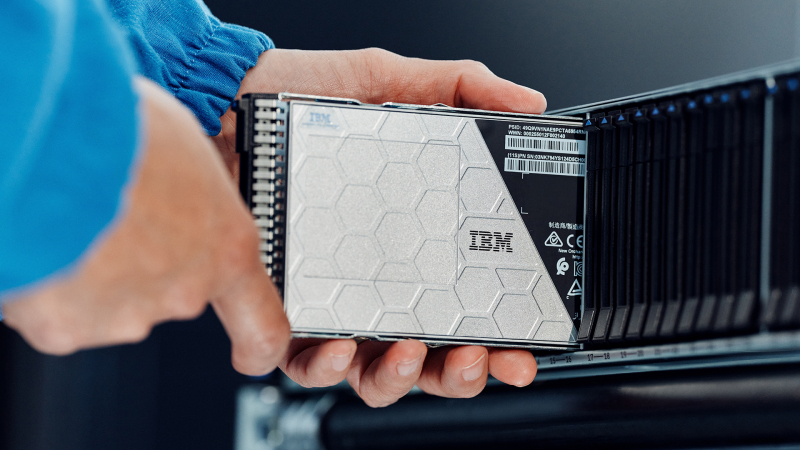

All-Flash СХД IBM FlashSystem 5600, 7600 и 9600 получили автономное ИИ-управлениеIBM представила системы хранения данных FlashSystem класса All-Flash следующего поколения 5600, 7600 и 9600, которые, как утверждается, обеспечивают до 40 % большую эффективность обработки данных, ёмкость и производительность по сравнению с предыдущим поколением. Компания назвала выход сразу трёх новых систем самым значительным обновлением FlashSystem за последние шесть лет. IBM сообщила, что расширяя существующие возможности FlashSystem с помощью агентного ИИ, она переосмысливает отказоустойчивость за счёт постоянной защиты, автономного анализа угроз и индивидуальных рекомендаций по восстановлению. Генеральный директор IBM Storage Сэм Вернер (Sam Werner) описывает новую FlashSystem как постоянно доступный интеллектуальный слой, использующий автономных ИИ-агентов для повышения производительности, безопасности и снижения затрат. Он отметил, что IBM позиционирует этот релиз как шаг к созданию СХД, которая будет служить стратегическим партнёром по ИИ для ИТ-руководителей, а не статическим хранилищем, требующим постоянного ручного контроля. FlashSystems — это классические двухконтроллерные массивы, работающие под управлением ОС SAN Volume Controller и поддерживающие блочное хранение данных. В новых системах установлен флеш-накопитель пятого поколения FlashCore Module ёмкостью до 105,6 Тбайт, разработанный для обеспечения аппаратного ускорения обнаружения программ-вымогателей в реальном времени, сокращения объёма данных, аналитики и управления, с расширенной телеметрией и стабильно низкой задержкой. Система FlashSystem 5600 ориентирована на организации, которым требуются функции корпоративного класса в компактном форм-факторе. Заявлена эффективная ёмкостью до 2,5 Пбайт, пропускная способность до 30 Гбайт/с и производительность до 2,6 млн IOPS (чтение 4K-блоками) в одном 1U-шасси. Узел включает два 12-ядерных Intel Xeon и 256 или 512 Гбайт RAM. Общее количество IO-портов не превышает 16: 10/25/40/100GbE с поддержкой iSCSI и NVMe/TCP или FC32/64 с NVMe/FC (такие же опции и у старших моделей). Система разработана для развёртывания в условиях ограниченного пространства, таких как периферийные узлы, удалённые офисы и небольшие ЦОД. IBM FlashSystem 7600 предназначена для высокопроизводительных масштабируемых сред с растущими рабочими нагрузками, обеспечивает до 7,2 Пбайт эффективной ёмкости в одной системе форм-фактора 2U, 55 Гбайт/с и до 4,3 млн IOPS. 7600 предназначена для работы с большими виртуализированными средами, аналитическими платформами и консолидированными приложениями, требующими большей ёмкости и более быстрого отклика. Узел содержит два 16-ядерных AMD EPYC и 768 Гбайт или 1,5 Тбайт RAM. IBM FlashSystem 9600 создана для критически важных операций, требующих экстремальной производительности и максимальной масштабируемости, обеспечивает до 11,8 Пбайт эффективной ёмкости в одной системе форм-фактора 2U, до 86 Гбайт/с и до 6,3 млн IOPS. Количество портов — до 32. Узлы включают два 48-ядерных AMD EPYC и 1,5 или 3 Тбайт RAM. Типичные сценарии использования системы включают основные банковские системы, ERP-платформы и приложения на основе ИИ, требующие скорости и расширенной безопасности. По данным компании, использование FlashSystem 9600 позволяет снизить эксплуатационные расходы на 57 % за счёт ИИ и консолидации по сравнению с предыдущим поколением. IBM сообщила, что IBM FlashSystem уменьшает требуемый объём хранилища на 30–75 % в зависимости от модели за счёт оптимизированного размещения и консолидации по сравнению с предыдущим поколением. У FlashSystem 7600 и 9600 есть интерактивные светодиодные панели, позволяющие отслеживать состояние системы. IBM также представила FlashSystem.ai, новый набор интеллектуальных сервисов обработки данных на основе ИИ, предназначенных для управления, мониторинга, диагностики и решения проблем на всём пути передачи данных. FlashSystem.ai обеспечивает бесперебойную работу в режиме самообслуживания, автоматизируя ручные и подверженные ошибкам задачи. Благодаря модели, обученной на десятках миллиардов точек данных, собранных с помощью расширенной телеметрии и многолетнего опыта реального работы с данными, платформа может выполнять тысячи автоматизированных решений в день, которые ранее требовали человеческого контроля. Помимо автоматизации, IBM подчеркивает адаптивное поведение СХД. Функции агентного ИИ позволяют понимать шаблоны приложений в течение нескольких часов, объяснять свои рассуждения и учитывать отзывы администраторов для улучшения предложений с течением времени. В последних FlashSystem, по утверждению IBM, FlashSystem.ai может сократить время, затрачиваемое на документацию по аудиту и соответствию требованиям, вдвое благодаря объяснимым рассуждениям ИИ. Системы разработаны для проактивной настройки и интеллектуального размещения рабочих нагрузок, обеспечивая беспрепятственное перемещение данных между конфигурациями хранения, включая массивы сторонних производителей. IBM также утверждает, что ее новый метод обнаружения угроз, обученный на десятках миллиардов точек телеметрических данных, может снизить количество ложных срабатываний до менее 1 %. Компания также заявила, что платформа, используя FlashCore, может обеспечить обнаружение программ-вымогателей и оповещение с помощью ИИ менее чем за 60 с, а также выполнить автономные действия по восстановлению на аппаратном уровне.

11.02.2026 [15:53], Руслан Авдеев

Власти США «по-хорошему» призывают гиперскейлеров самим финансировать расширение ИИ-проектов, а не перекладывать затраты на жителейАдминистрация президента США продолжает продвигать развитие ИИ-проектов, в то же время стремясь ослабить недовольство граждан непомерными аппетитами ЦОД в отношении электричества и воды, а также обещая освободить крупных игроков рынка от пошлин на ИИ-ускорители. Чтобы успокоить общественность, Вашингтон предложил IT-гигантам гарантировать, что расширение их сети ЦОД в США не приведёт к резкому увеличению счетов за электричество или истощению локальных водных ресурсов, сообщает The Register. По информации Politico, предложено добровольное соглашение между президентом США Дональдом Трампом (Donald Trump) и индустрией ЦОД в лице Microsoft, Google, Amazon, Meta✴ и OpenAI, которое устанавливает принципы ответственного потребления электроэнергии, воды и отношений с жителями в местах размещения дата-центров. Новый шаг соответствует вектору предыдущих событий. Ранее президент заявил, что технологический бизнес должен сам финансировать увеличение мощности ЦОД и адаптацию для этого энергетической инфраструктуры, а не перекладывать расходы на обычных потребителей энергии. Компания Microsoft уже пошла навстречу в этом вопросе, представив проект Community-First AI Infrastructure. Кроме того, Министерство энергетики (DOE) оказало давление на оператора электросетей PJM Interconnection, чтобы та провела экстренный аукцион для компенсации роста спроса на электричество со стороны ЦОД.

Источник изображения: Gabriela/unsplash.com Это направлено на сдерживание растущего общественного недовольства появлением дата-центров по всей территории США. По данным НКО, только во II квартале были заблокированы или отложены 20 проектов строительства ЦОД в стране из-за противодействия местных сообществ. В январе 2026 года Белый дом объявил о ввозных пошлинах в размере 25 % на ИИ-ускорители, включая NVIDIA H200 и AMD MI325X, но их закупки для объектов гиперскейлеров в США пошлиной облагаться не будут. По некоторым данным, освобождение от тарифов может зависеть от политики непосредственных производителей вроде тайваньской TSMC, от которых ожидают переноса до половины своего производства в США в рамках программы «реиндустриализации» Соединённых Штатов. Недавно премьер-министр Тайваня назвал такой перенос «невозможным». Впрочем, TSMC уже выделила $165 млрд на строительство производств в Аризоне для выпуска 2-нм чипов, но пока неизвестно, устроит ли это Трампа.

11.02.2026 [15:00], Руслан Авдеев

Trane Technologies приобрела поставщика СЖО для ЦОД LiquidStackИндустрия ИИ находится на пике популярности, стимулируя слияния и поглощения в сегменте продуктов для систем охлаждения ЦОД. Так, компания Trane Technologies, занимающаяся разработкой кондиционеров и смежных решений, приобрела стартап LiquidStack, специализирующийся на СЖО, сообщает The Register. Trane инвестировала в LiquidStack в 2023 году. Также в компанию инвестировали Tiger Global Management ($20 млн) и Wiwynn ($10 млн). LiquidStack была одной из первых компаний, разрабатывавших двухфазное иммерсионное охлаждение для систем майнинга криптовалюты. Фактически компания появилась в 2012 году в результате реорганизации Allied Control Limited (ACL, подразделение The Bitfury Group), которая изначально занималась созданием СЖО для майнинговых систем. Технологию LiquidStack протестировала в 2021 году Microsoft. С тех пор компания пополнила портфолио системами одно- и двухфазного погружного охлаждения, а также решениями прямого охлаждения чипов (DLC), в т.ч. CDU. Сообщается, что после закрытия сделки LiquidStack будет работать в составе подразделения Commercial HVAC. Технологии купленной компании пополнят портфолио продуктов Trane, предназначенных для дата-центров. По данным LiquidStack, покупка включает команду стартапа и производственные мощности, а также инженерные и научно-исследовательские подразделения в Техасе и Гонконге.

Источник изображения: LiquidStack По прогнозам экспертов Dell'Oro Group, к 2030 году рынок физической инфраструктуры ЦОД превысит $80 млрд. Одним из самых быстрорастущих сегментов в нём являются системы управления тепловыми режимами, среднегодовой темп прироста составит 20 %. Эксперты уверены, что к концу десятилетия рынок DLC СЖО достигнет оборота $8 млрд, во многом благодаря ИИ-технологиям. Жидкостное охлаждение сегодня перестало быть желательным дополнительным элементом и стало обязательным для получения максимальной отдачи от современного оборудования ИИ ЦОД. Покупка LiquidStack — не первая попытка Trane выйти на рынок технологий жидкостного охлаждения. Ещё в декабре 2025 года была куплена Stellar Energy, выпускавшая модульные охлаждающие решения и CDU, в том числе для ЦОД. Впрочем, это лишь последние из многих слияний и поглощений на рынке физической инфраструктуры для дата-центров, инициированных бумом ИИ-технологий. В конце 2024 года Schneider Electric купила контрольный пакет акицй Motivair. В декабре 2023 года Vertiv приобрела CoolTera. Почти сразу же после этого она запустила производство на полную мощность, увеличив выпуск CDU в 45 (!) раз.

11.02.2026 [13:38], Руслан Авдеев

Армения получит ещё 41 тыс. NVIDIA GB300 для ИИ ЦОД Firebird за $4 млрдАмериканская компания Firebird, специализирующаяся на облачных и инфраструктурных решениях для ИИ, объявила о реализации второго этапа суперкомпьютерного мегапроекта в Армении. Она получила экспортные лицензии США и разрешения регуляторов на поставку в страну ещё 41 тыс. ускорителей NVIDIA GB300, сообщает HPC Wire. Расширение вычислительного кластера в Армении знаменует собой важную веху. Предполагается, что страна войдёт в пятёрку мест размещения крупнейших кластеров ИИ-ускорителей. Проект стоимостью $4 млрд — одно из крупнейших капиталовложений в технологическую сферу в истории страны. Подробности в ходе визита в Ереван раскрыл вице-президент США Джей Ди Вэнс (JD Vance) при участии вице-президента NVIDIA. По словам Вэнса, США «с гордостью» одобрили замечательное техническое соглашение с NVIDIA. Речь идёт об открытии новых рынков и новых рабочих мест как для американских работников, так и для армянских. 8 августа прошлого года Армения и США подписали меморандум в сфере ИИ и полупроводников. Выданная США экспортная лицензия свидетельствует о том, что проект полностью соответствует американским требованиям. Второй этап — продолжение реализации плана Firebird, выделившей $500 млн на создание в Армении первого ИИ-кластера. Реализация двух этапов обеспечит качественный скачок в технологической инфраструктуре страны. Он позволит проводить исследования в биологии, робототехнике, космической сфере и в сфере ИИ нового поколения. По словам представителей Firebird, новый кластер превращает Армению в глобальный центр суперкомпьютерных вычислений.

11.02.2026 [12:14], Сергей Карасёв

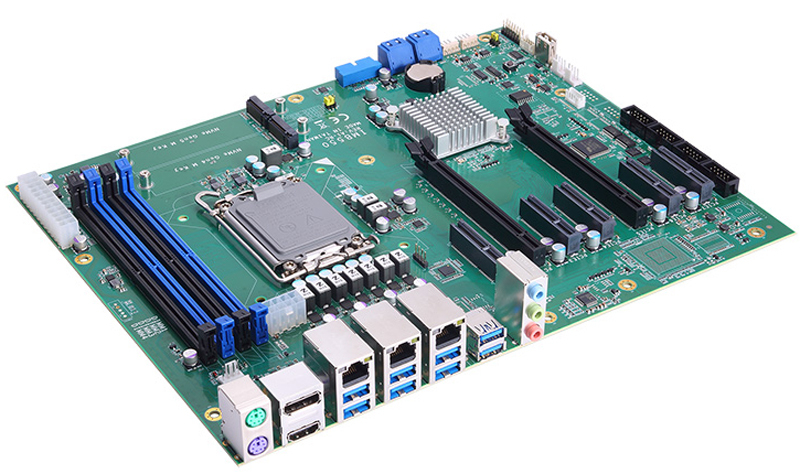

Axiomtek выпустила плату IMB550 на базе Intel Arrow Lake-S для ИИ-приложенийКомпания Axiomtek анонсировала материнскую плату IMB550 типоразмера АТХ, предназначенную для построения индустриальных серверов, встраиваемых НРС-платформ и систем, ориентированных на ИИ-нагрузки, такие как машинное зрение и анализ изображений. Новинка выполнена на наборе логики Intel W880. Допускается установка процессоров Core Ultra 9/7/5 поколения Arrow Lake-S в исполнении LGA1851 с показателем TDP до 125 Вт. Доступны четыре слота для модулей оперативной памяти DDR5-5600 ECC/non-ECC суммарным объёмом до 192 Гбайт. Накопители могут быть подключены к четырём портам SATA-3; допускается формирование массивов RAID 0/1/5/10. Кроме того, есть два коннектора M.2 Key-M 2280 для SSD с интерфейсом PCIe x4 в том числе в конфигурациях RAID 0/1.

Источник изображения: Axiomtek Плата располагает двумя слотами PCIe x16 (PCIe 5.0 x16 + PCIe x0 или PCIe 5.0 x8 + PCIe 4.0 x8) и пятью слотами PCIe x4 (3 × PCIe x4 и 2 × PCIe x2). В оснащение входят два сетевых порта 2.5GbE (на базе Intel I226-V), порт 1GbE (Intel I219-LM) и дополнительный порт 1GbE IPMI (Intel I210-AT; AST2600 — опционально). За безопасность отвечает модуль TPM 2.0. Интерфейсный блок содержит гнёзда PS/2 для клавиатуры и мыши, разъёмы HDMI 1.4b, (до 4096 × 2160 пикселей; 24 Гц) и Displayport++ (DP 1.2; до 4096 × 2304 точки; 60 Гц), по четыре порта USB 3.1 (10 Гбит/с) и USB 3.0 (5 Гбит/с), коннекторы RJ45 для сетевых кабелей и набор аудиогнёзд на 3,5 мм. Через разъёмы на плате можно задействовать до четырёх последовательных портов — по два RS-232 и RS-232/422/485. Габариты новинки составляют 305 × 244 мм. Диапазон рабочих температур простирается от 0 до +60 °C.

11.02.2026 [08:42], Руслан Авдеев

Австралийское неооблако Firmus привлекло $10 млрд в кредит для строительства ИИ-фабрик Project SouthgateАвстралийский неооблачный провайдер Firmus привлёк в кредит $10 млрд. Главными участниками кредитного соглашения стали инвестиционные компании Blackstone и Coatue, сообщает Datacenter Dynamics. По словам Firmus, финансирование позволит развернуть ИИ-фабрики на основе эталонной архитектуры NVIDIA по всей Австралии. Новый план — часть проекта Southgate, реализуемого Firmus в рамках стратегического партнёрства с CDC Data Centres и NVIDIA. Firmus была основана в 2019 году и поначалу специализировалась на криптовалютах и HPC, а также системах иммерсионного охлаждения. Неооблачная компания заявила, что речь идёт об одной из «крупнейших частных сделок по привлечению заёмных средств» за всю историю Австралии. Представитель Blackstone сообщил, что инструменты, стоящие за революцией в сфере ИИ — одно из наиболее перспективных инвестиционных направлений, и Австралия сможет сыграть центральную роль в развитии ИИ-инфраструктуры. Firmus подчеркнула, что благодаря Blackstone и Coatue она поможет удовлетворить растущий спрос на вычислительные мощности для ИИ в мире и создать долгосрочные выгоды как для клиентов, так и для местной экономики в целом. Стоит отметить, что Blackstone владеет крупным региональным оператором ЦОД AirTrunk.

Источник изображения: Firmus Firmus впервые упомянула Project Southgate в сентябре 2025 года в описании ИИ-кампуса в городе Лонсестон (Launceston, Тасмания). На тот момент компания заявляла, что совместный с правительством Тасмании проект к 2026 году обеспечит создание ИИ-инфраструктуры мощностью 90 МВт. Месяцем позже Firmus сообщила, что проекта расширят и на материковую Австралию при содействии CDC Data Centres. Предполагается развёртывание дополнительных объектов в Сиднее, Канберре, Мельбурне и Перте. В ноябре 2025 года сообщалось о привлечении для Project Southgate AU$500 млн ($351 млн). В последнем заявлении Firmus объявила о строительстве нескольких ИИ-фабрик в Австралии, где планируется развернуть тысячи ИИ-ускорителей — общая мощность к 2028 году должна достигнуть 1,6 ГВт. Каждая ИИ-фабрика будет учитывать современные требования к энергоэффективности и параметрам генерации токенов, чтобы удовлетворять потребности самых требовательных клиентов со всего мира. Подчёркивается, что Австралия имеет конкурентоспособный «энергетический профиль» и квалифицированные кадры.

10.02.2026 [15:33], Владимир Мироненко

IBM сворачивает продажи серверов POWER10Спустя несколько месяцев после презентации серверов POWER11 компания IBM уведомила клиентов о предстоящем прекращении продаж систем на базе процессоров POWER10. Как отметил ресурс ITJungle, обычно IBM делает такие объявления заблаговременно, как правило, за полгода или более. В информационном письме AD26-0012 IBM сообщила, что следующие модели не будут продаваться после 31 июля 2026 года, за исключением Китая и Южной Кореи, где их можно будет приобрести до 30 июля 2027 года и где платформы POWER9 и POWER10 оказались чрезвычайно популярны в банковской и финансовых сферах, а также в индустрии страхования:

В перечень снятых с производства серверов не вошёл POWER S1012 Mini, анонсированный в мае 2024 года, поскольку его преемник POWER S1112 Mini всё ещё не анонсирован. Снятие с производства не распространяется на модернизацию POWER E1080 — то, что IBM называет спецификацией дополнительного оборудования (Miscellaneous Equipment Specification, MES). Модернизация на POWER E1080 с предыдущих систем по-прежнему будет доступна, что помогает продлить амортизацию. Это важно для балансов компаний, использующих крупногабаритное оборудование POWER. По данным ITJungle, для других устройств линейки POWER10 модернизация с использованием MES с предыдущих моделей недоступна, а для машин начального и среднего уровня в линейке POWER Systems её давно нет. После июльских дат 2026 и 2027 годов также будет отключена возможность активации процессоров на этих устройствах в процессе перехода с одной модели на другую (что не то же самое, что обновление в понимании IBM). Однако по традиции это не касается оставшихся, но ещё не активированных в рамках одной машины процессоров и памяти. Также после указанных дат для снятых с производства серверов POWER10 не будут предлагаться различные уровни услуг Advanced Expert Care и POWER Expert Care от IBM. Некоторые кабели также будут исключены из каталога, а для более компактных моделей будет снят с продажи ряд плат расширения, адаптеров, памяти DDR5, флеш-накопителей и других периферийных устройств. Это касается только заказов на новые системы. Как полагает ITJungle, немногие клиенты перейдут с POWER10 на POWER11, если только они не приобрели POWER10 на очень раннем этапе цикла. Безусловно, между POWER10 и POWER11 есть важные различия, но их недостаточно, чтобы оправдать масштабное и сложное обновление или переход на новую систему. Согласно прогнозу ITJungle, клиенты POWER10 будут мигрировать уже на POWER12 — возможно, года через три.

10.02.2026 [13:16], Руслан Авдеев

Hitachi рассматривает продажу поставщика СХД Hitachi Vantara за $1,3 млрдЯпонский транснациональный конгломерат Hitachi намерен продать своё подразделение, предлагающее решения для хранения и анализа данных. Для Hitachi Vantara рассчитывают найти покупателя, готового выложить до ¥200 млрд ($1,3 млрд), сообщает Bloomberg. Компания уже наняла консультанта по продажам и передала материалы о бизнесе Hitachi Vantara заинтересованным сторонам, вероятным потенциальным покупателем называется какая-либо частная акционерная компания. По имеющимся данным, сама Hitachi намерена сосредоточиться на более маржинальном бизнесе, чем Hitachi Vantara, вроде инициатив, связанных с передачей энергии и цифровой трансформацией. Сегодня в сферу интересов Hitachi входит энергетика (атомные и иные системы генерации, а также системы передачи), транспорт (поезда и автомобильные платформы), промышленность (индустриальное оборудование), измерительные и аналитические системы, здравоохранение, системы для зданий — лифты и эскалаторы, а также многие бизнесы, связанные с цифровыми решениями. Конечно, попадает туда и бизнес, связанный с хранением и управлением данных, включая Hitachi Vantara.

Источник изображения: Hitachi Vantara Имеется два номинально независимых подразделения Hitachi Vantara — Hitachi Vantara Ltd. в Японии и Hitachi Vantara LLC в США. Выручка Hitachi в 2025 финансовом году включала ¥475 млрд от подразделения IT Products, рост составил 7 % год к году, к этим средствам относится и выручка, связанная с СХД. Показатель EBITDA подразделения IT Products составлял 4,4 %, против 14,8 % для «материнского» бизнеса Digital Systems and Services. По данным Westgrove Research, совокупная годовая выручка бизнеса Hitachi Vantara составила ¥300 млрд ($1,95 млрд). Корнями бизнес Hitachi Vantara уходит в 1989 год, когда Hitachi и EDS приобрели National Advanced Systems у National Semiconductor и назвали новый бизнес, связанный с хранением данных, Hitachi Data Systems (HDS). Hitachi выкупила EDS в 1999 году. В результате череды дальнейших изменений в 2017 году Hitachi организовала слияние HDS с купленной компанией Pentaho, занимавшейся бизнес-аналитикой и подразделением Hitachi Insight Group, занимавшимся преимущественно Интернетом вещей. В результате и появилась Hitachi Vantara. Её массивы хранения данных корпоративного уровня Virtual Storage Platform One (VSP One) имеют хорошую репутацию и ценятся за надёжность. Тем не менее, попытки закрепиться на рынках файловых NAS и объектных хранилищ особенным успехом не увенчались, так что компании не удалось пробиться дальше «второго эшелона». Кроме того, в значительной степени компания упустила возможность массовых поставок систем для ИИ, не сумев вовремя войти в число ключевых партнёров NVIDIA в нише систем хранения данных. Компании не удалось конвертировать свой опыт в сфере монолитных высокопроизводительных корпоративных хранилищ в успешные решения среднего уровня. Предпринимались попытки освоить рынок All-Flash хранилищ, компания даже разрабатывала собственное аппаратное обеспечение для него, но по мере развития массового производства SSD и ужесточения конкуренции, отстала от компаний уровня Dell EMC. Hitachi Consulting присоединилась к Hitachi Vantara в 2020 году. Результат оказался неудовлетворительным, и в 2023 году началась реорганизация в попытках оживить бизнес, в том числе путём найма новых топ-менеджеров. Для бренда VSP One были анонсированы новые продукты, связанные с хранением данных, анонсирована поддержка публичных облачных хранилищ. Как сообщает Blocks & Files, похоже, Hitachi Vantara продолжит обычные бизнес-операции. Слабость позиций компании некоторые эксперты оценивают как результат её подчинения японской Hitachi Ltd. — в результате старшие руководители «размыли» влияние потенциально более предприимчивых лидеров из Кремниевой долины в США. Такое отсутствие успехов в сфере хранения данных преследовало и другие японские конгломераты, включая коллег из Fujitsu и NEC.

09.02.2026 [23:25], Владимир Мироненко

Alphabet возьмёт в долг $20 млрд на 100 лет, чтобы вложиться в ИИХолдинг Alphabet (включает Google), объявивший на прошлой неделе о планах удвоить капзатраты в 2026 году до ≈$180 млрд, планирует привлечь $20 млрд за счёт выпуска долларовых облигаций, сообщил Bloomberg со ссылкой на информированные источники. Поначалу источники сообщали о планах Alphabet привлечь таким образом $15 млрд. По словам источников, помимо США холдинг предлагает инвесторам свои первые в истории размещения облигации в Швейцарии и Великобритании. Последнее будет включать редкую продажу 100-летних облигаций — первый случай, когда технологическая компания пытается осуществить подобное размещение со времён бума доткомов в конце 1990-х годов, отметил Bloomberg. В последний раз такой возможностью воспользовалась Motorola в 1997 году. Источники утверждают, что объявление Alphabet о выпуске долларовых облигаций в понедельник привлекло заявки на более чем $100 млрд. Собеседники Bloomberg сообщили, что холдинг разместит семь выпусков, самый «длинный» из которых со сроком погашения в 2066 году и доходностью на 0,95 п.п. выше, чем у казначейских облигаций США (ранее сообщалось о 1,2 п.п.). Согласно прогнозу Morgan Stanley, в 2026 году крупные инвестиционные компании займут $400 млрд, что намного больше $165 млрд в 2025 году. Массовое размещение облигаций, вероятно, приведёт к рекордному объему выпуска высококачественных долговых обязательств в этом году в размере $2,25 трлн, указал в своей аналитической записке Вишвас Паткар (Vishwas Patkar), глава отдела кредитной стратегии в США Morgan Stanley. Некоторые кредитные стратеги ожидают, что масштабный выпуск облигаций приведёт к расширению спредов (увеличению разницы между ценами покупки и продажи) по корпоративным облигациям, что означает увеличение рисков при операциях с такими активами. «Мы считаем, что сценарий похож на 1997/98 или 2005 год: кредиты показывают худшие результаты, но не “конец цикла”», — написал Паткар, имея в виду период, когда растёт число дефолтов и сокращается доступность кредитов. Последний раз Alphabet выходил на американский рынок облигаций в ноябре 2025 года, когда привлёк $17,5 млрд в рамках сделки с продажей 50-летних облигаций. Это было самое долгосрочное предложение корпоративных технологических облигаций в долларах США в прошлом году, согласно данным Bloomberg. Alphabet также продал в то время облигации на €6,5 млрд в Европе. Другие технологические компании тоже наращивают капзатраты в борьбе за доминирование на ИИ-рынке. Amazon объявила о планах направить на капзатраты в 2026 году $200 млрд, а Meta✴ Platforms планирует потратить от $115 до $135 млрд. Ожидаемые затраты Microsoft составят $145 млрд, а Oracle — $55 млрд.

09.02.2026 [14:20], Сергей Карасёв

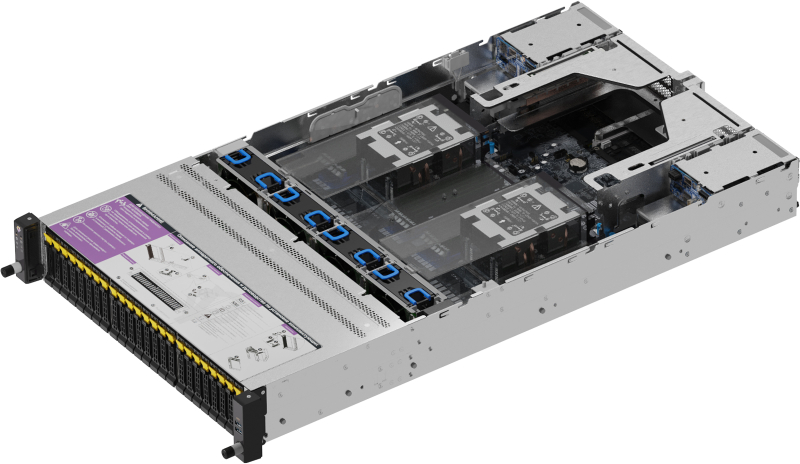

OpenYard выпустила российский двухсокетный сервер RS202A на базе AMD EPYC TurinРоссийский разработчик и производитель корпоративного оборудования OpenYard объявил о начале серийного выпуска серверов RS202A на аппаратной платформе AMD. Устройства предназначены для построения масштабируемых и отказоустойчивых IT-инфраструктур, включая виртуальные среды, аналитические системы и хранилища данных. Серверы выполнены в форм-факторе 2U. Допускается установка двух процессоров AMD EPYC 9005 поколения Turin в исполнении LGA 6096 (SP5) с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-6400 суммарным объёмом до 6 Тбайт. В оснащение входят контроллер ASPEED AST2600, двухпортовый сетевой адаптер 1GbE (Intel I350-AM2) и выделенный сетевой порт управления 1GbE. Во фронтальной части корпуса в зависимости от модификации располагаются 24 отсека для SFF-накопителей (SATA/SAS-4/NVMe PCIe 5.0) или 12 отсеков для LFF-изделий. В тыльной секции находятся четыре посадочных места для SFF-изделий с интерфейсом SATA/SAS-4. Во всех случаях допускается горячая замена. Кроме того, сеть два внутренних слота для SSD типоразмера M.2 2280/22110 с интерфейсом PCIe 3.0 x4 и один слот M.2 2280/22110 PCIe 3.0 x2. Доступны до пяти разъёмов PCIe 5.0 x16 для карт расширения FHHL и до двух разъёмов OCP 3.0 PCIe 5.0 x16 с поддержкой NCSI. Габариты составляют 438 × 87,5 × 815 мм. Установлены два блока питания мощностью 2000 Вт с сертификатом 80 PLUS Platinum. Упомянуты два порта USB 3.2, коннектор Mini-DP и три гнезда RJ45 для сетевых кабелей. Диапазон рабочих температур — от +10 до +35 °C. Производство серверов RS202A осуществляется на собственной площадке OpenYard в Рязани. В настоящее время системы проходят пилотные внедрения в корпоративных IT-средах, а объёмы выпуска планируется масштабировать в зависимости от рыночного спроса, говорит компания. |

|