Материалы по тегу:

|

11.03.2026 [10:54], Руслан Авдеев

Alibaba Cloud ускорит строительство шанхайского ИИ ЦОД с собственными ускорителями ZhenwuAlibaba Cloud прилагает усилия, чтобы ускорить строительство ранее запланированного дата-центра в Шанхае. Китайский облачный гигант объявил о подписании соглашения с властями района Цзиньшань городского подчинения, предусматривающего строительство в городе дата-центра для использования ИИ-чипов собственной разработки, сообщает Datacenter Dynamics. Речь идёт о части проекта Aspara Cloud Intelligent East China Computing Center. По данным Alibaba, новый ЦОД будет одним из крупнейших «умных вычислительных хабов» в Восточном Китае. Оборудование будет построено на ИИ-ускорителях Zhenwu, который разработаны подразделением Alibaba T-Head. Новейшей моделью является чип Zhenwu 810E, имеющий 96 Гбайт памяти HBM2e. Она разработана для обучения ИИ и инференса и полностью работает с ПО собственной разработки. Alibaba и Цзиньшань взаимодействуют довольно давно, в 2021 году они совместно запустили вычислительный центр с инвестициями порядка ¥40 млрд ($5,8 млрд). Согласно новому договору, Alibaba Cloud построит вычислительный объект, который станет образцом для создания «зелёных» ЦОД. Предусмотрена полная независимость от сторонних технологий, включая использование чипов и вычислительных платформ собственной разработки, а также программного обеспечения.

Источник изображения: Henry Chen/unsplash.com У Alibaba Cloud уже имеются «умные вычислительные хабы» в Чжанбэе и Уланчабе, которые компания рассчитывает объединить для создания национальной сети вычислений. Китайский облачный провайдер сегодня оперирует более чем 94 зонами доступности в 29 регионах. Ранее в 2026 году компания заявила, что рассматривает возможность увеличить капитальные расходы на ИИ-инфраструктуру до ¥480 млрд ($69,05 млрд) в следующие три года; в начале 2025 года речь шла о ¥380 млрд ($52,4 млрд). Согласно данным Omdia, в Китае Alibaba контролирует более трети локального рынка ИИ-облаков. По информации гонконгского издания SCMP, в распоряжении Alibaba Cloud было 35,8 % соответствующих мощностей. Второе место занимала Volcano Engine (фактически ByteDance) с 14,8 %. Впрочем, имеются и другие данные. По информации Frost & Sullivan, среди китайских облачных провайдеров, контролирующих всю цепочку создания стоимости «от чипа до облака», лидерами являются Huawei и Baidu. В январе 2026 года сообщалось, что Alibaba Group запустила совместное предприятие с государственной компанией China National Nuclear Company (CNNC), занимающейся реализацией атомных проектов. Проект оценивается в ¥250 млн ($35,9 млн) и, возможно, поможет обеспечивать мощности IT-гиганта энергией, хотя реальный масштаб сотрудничества пока не раскрывается.

11.03.2026 [09:39], Руслан Авдеев

Thinking Machines Lab развернёт 1 ГВт мощностей на основе Vera Rubin при поддержке NVIDIANVIDIA заключила соглашение с Thinking Machines Lab о развёртывании оборудования на основе ускорителей Vera Rubin мощностью не менее 1 ГВт. Проект будет реализован для поддержки обучения передовых моделей стартапа, сообщает Datacenter Dynamics. Глава NVIDIA Дженсен Хуанга (Jensen Huang) заявил, что ИИ — мощнейший инструмент познания в истории человечества, и компания рада сотрудничать с Thinking Machines для воплощения в жизнь захватывающего видения будущего ИИ, предложенного стартапом. NVIDIA также добавила, что вложила в Thinking Machines значительные средства. Кроме того, в рамках партнёрства компании намерены совместно разрабатывать системы обучения, оптимизированные для архитектуры NVIDIA, а также расширять доступ к передовым ИИ-моделям. Где и когда будет развёрнуто оборудование, объявят позже; финансовые подробности сделки также пока не раскрываются. NVIDIA сообщила, что развёртывание оборудования на основе Vera Rubin планируется в начале 2027 года.

Источник изображения: NVIDIA Thinking Machines, основанная в феврале 2025 года бывшим техническим директором OpenAI Мирой Мурати (Mira Murati), по данным самой компании, разрабатывает «мультимодальные системы, работающие совместно с людьми» — в противовес полностью автономным ИИ-системам, над которыми работают другие ИИ-компании. В октябре 2025 года Thinking Machines анонсировала так называемый API Tinker — он разработан для упрощения тонкой настройки open source-моделей. По данным Reuters, на июль 2025 года компания привлекла $2 млрд инвестиций от NVIDIA, AMD, Cisco и других инвесторов; её капитализация составляла $12 млрд. Впрочем, не всё идёт гладко: в январе она лишилась двух соучредителей, которые предпочли вернуться в OpenAI. При этом NVIDIA активно инвестирует и в OpenAI — недавно стороны договорились о вложении в последнюю $30 млрд в обмен на её акции.

11.03.2026 [09:25], Сергей Карасёв

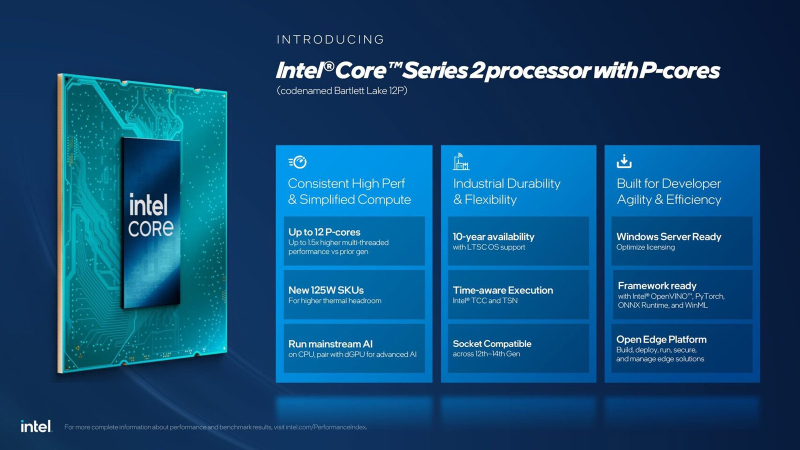

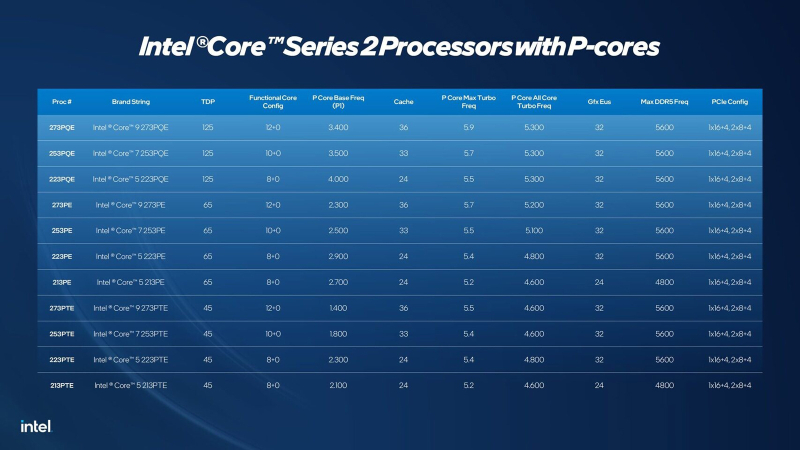

Intel выпустила Bartlett Lake — LGA 1700-процессоры исключительно на P-ядрах Raptor Cove для периферийных системКорпорация Intel в ходе конференции Embedded World 2026, которая с 10 по 12 марта проходит в Нюрнберге (Германия), анонсировала процессоры Core Series 2 семейства Bartlett Lake, рассчитанные на использование в критически важных периферийных системах и промышленном оборудовании. Представленные чипы используют исключительно производительные Р-ядра, количество которых варьируется от 8 до 12 (с возможностью обработки до 24 потоков инструкций). Показатель TDP в зависимости от модификации составляет 45, 65 или 125 Вт. На сегодняшний день в семейство Core Series 2 входят 11 процессоров (см. технические характеристики ниже). Их базовая тактовая частота варьируется от 1,4 до 3,5 ГГц, максимальная частота — от 5,2 до 5,9 ГГц (в турбо-режиме). Объём кеша — от 24 до 36 Мбайт. Чипы могут использовать до 192 Гбайт оперативной памяти DDR5-5600 или DDR4-3200 с поддержкой ECC. В состав изделий входит ускоритель UHD Graphics 770; возможен вывод изображения одновременно на четыре дисплея (вплоть до 4К). Процессоры предлагают до 20 линий PCIe (16 × PCIe 5.0 и 4 × PCIe 4.0). Упомянута поддержка высокоскоростной шины DMI 4.0 (Direct Media Interface 4.0). Кроме того, говорится о совместимости с чипами Core 12-го, 13-го и 14-го поколений для периферийных устройств, что должно упростить модернизацию существующих встраиваемых систем на базе LGA1700. По заявлениям Intel, процессоры Core Series 2 обеспечивают прирост производительности до 1,8 раза (TOPS) по сравнению с решениями предыдущего поколения. Новые чипы оптимизированы для работы с операционными системами реального времени (RTOS). Сопутствующий чипсет Intel PCH обеспечивает поддержку до 12 линий PCIe 4.0 и до 16 линий PCIe 3.0, Wi-Fi 7 и Bluetooth 5.4, 2.5GbE и пр.

10.03.2026 [17:49], Владимир Мироненко

Groq увеличил заказ на производство ИИ-чипов у Samsung более чем в 1,5 разаИИ-стартап Groq, приобретённый NVIDIA за $20 млрд, направил Samsung Electronics запрос на увеличение производства своих чипов, сообщил Chosunbiz со ссылкой на информированные источники. Источники утверждают, что Groq недавно принял решение увеличить производство ИИ-чипов, которое в прошлом году было передано на аутсорсинг подразделению Samsung Electronics, с примерно 9 тыс. пластин до примерно 15 тыс. Если в прошлом году объём производства был ограничен изготовлением опытных образцов чипов для определения их эффективности при использовании для ИИ-инференса, то в этом году, судя по объёму, Groq находится на ранней стадии массового производства для выхода на коммерческие рельсы. Как отметил Chosunbiz, хотя объём поставок Groq для Samsung Electronics невелик, подразделение Samsung Electronics активно работает с потенциальными клиентами, чтобы заложить основу для получения крупных заказов на поставку ИИ-чипов. Помимо Groq, подразделение Samsung Electronics также производит весь ассортимент процессоров для HyperExcel — южнокорейского стартапа по разработке чипов для ИИ-инференса. Samsung Electronics производит ИИ-чипы для Groq и HyperExcel по 4-нм техпроцессу. По словам источника в полупроводниковой отрасли, «4-нм техпроцесс, используемый Samsung Electronics для массового производства чипов Groq для ИИ-нагрузок, включает ряд улучшенных процессов для повышения производительности чипа. Учитывая высокую стоимость процесса и самый высокий спрос в отрасли на 4–5-нм техпроцессы, это также имеет важное значение для обеспечения конкурентного преимущества перед TSMC». Собеседник ресурса Chosunbiz прогнозирует, что с учётом выхода NVIDIA на рынок ИИ-чипов и увеличения производства Groq ожидается бурный рост рынка чипов для ИИ-инференса. Ожидается, что на мероприятии GTC 2026 NVIDIA представит чип для ИИ-инференса на основе дизайна, разработанного Groq, в котором используется память SRAM вместо HBM. Как сообщают источники, одним из заказчиков нового чипа будет OpenAI.

10.03.2026 [17:14], Руслан Авдеев

IBM второй раз пытается заключить контракт с Почтой Великобритании для замены скандального софта Fujitsu HorizonАмериканский IT-гигант IBM подал заявку на заключение контракта с Почтой Великобритании стоимостью в сотни миллионов фунтов стерлингов. Задолго до этого компания уже претендовала на то, чтобы заменить проблемное ПО Horizon японской Fujitsu, но на тот момент не преуспела, сообщает Computer Weekly. Теперь IBM предпринимает вторую попытку. В рамках плана Почты по замене Horizon партнёром по заявке выступает американская DXC. В 2013 году IBM участвовала в проекте с несколькими участниками и уже начала выполнение работ, но заявку отменили в 2015 году. С тех пор Почта должна IBM деньги за уже проделанные работы. Не так давно выяснилось, что работы в своё время не удалось завершить, поскольку понять структуру ПО Horizon без участия Fujitsu было весьма проблематично. Буквально никто не знал, как работает программное обеспечение, и справиться с управлением им без помощи Fujitsu было «феноменально» трудно. Из-за этого возникли сомнения, что с миграцией можно справиться до завершения контракта с японской компанией, поэтому пришлось просто продлить договор на обслуживание с ней. Система Horizon используется и по сей день, а работа IBM полностью так и не была завершена.

Источник изображения: Vitaly Gariev/unspalsh.com Недавно представитель Почты Великобритании в одном из интервью заявил, что следующим летом сотрудничество с Fujitsu прекратится, а к 2030 году от ПО Horizon, состоящего из более чем 80 компонентов, «не останется следов». Сейчас на контракт стоимостью £323 млн претендует IBM. В числе прочего предусмотрены техническая поддержка почтовых служащих, разработка ПО и управление релизами, миграция из собственного ЦОД в облако, а также строительство облачной платформы для внутренних операций и др. Это лишь первая часть тендера; заявки уже подали несколько компаний. Второй лот стоимостью £160 млн призван найти поставщика EPOS-системы пользовательских терминалов для замены устаревшего интерфейса Horizon. Заявки уже подала дюжина потенциальных исполнителей, но только трое из них вошли в шорт-лист. Среди них — компания Escher, занимающаяся разработкой ПО для EPOS и поставлявшая промежуточное ПО (middleware) для системы Horizon в прошлом. Почтовая служба не комментирует состав участников, поскольку тендер ещё не завершён. Одним из требований к возможным исполнителям, уже знакомым с проблемами ПО Horizon, является готовность исправить сложившуюся ситуацию на британской почте. Впервые информация о скандальных проблемах Почты Великобритании появилась ещё в 2009 году. В то время из-за сбоев японского ПО невинно пострадали многочисленные почтовые служащие, некоторые из которых понесли уголовную ответственность. Fujitsu и почтовые чиновники до сих пор перекладывают вину друг на друга, а суд подчеркнул, что и почта, и компания должны были знать о дефектах системы.

10.03.2026 [17:10], Руслан Авдеев

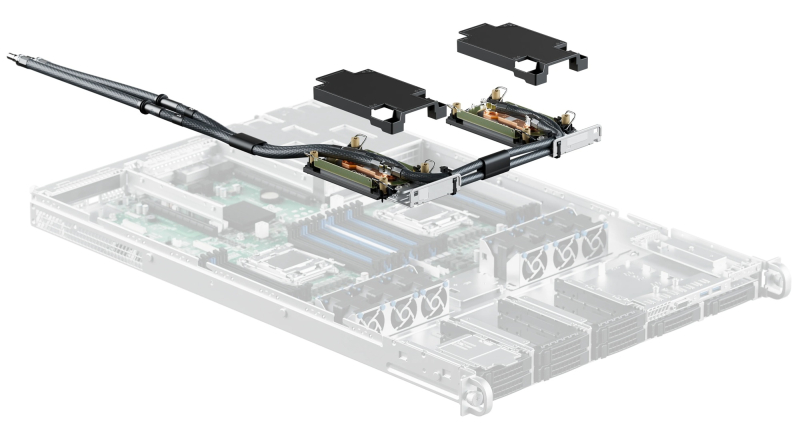

KKR задумала продать производителя СЖО CoolIT почти в 10 раз дороже, чем покупалаАмериканский инвестиционный гигант KKR рассчитывает хорошо заработать на продаже одной из именитых IT-компаний, работающей на рынке систем охлаждения с 2001 года. Бум ИИ привёл к тому, что оценочная стоимость компании CoolIT Systems выросла в несколько раз, сообщает The Financial Times. По данным знакомых с ситуацией источников, KKR и её консультанты работают над продажей компании за $3 млрд. CoolIT, переориентировавшаяся с выпуска систем охлаждения для игровых ПК на СЖО для дата-центров, в 2023 году, на момент покупки KKR контрольного пакета, стоила всего $270 млн. Миноритарной долей владеет суверенный государственный инвестор Mubadala из ОАЭ. По информации источников, пока обсуждение продажи CoolIT находится на ранней стадии и гарантии того, что сделка вообще состоится, отсутствуют. Тем не менее, несколько компаний уже выбраны в качестве потенциальных «стратегических» покупателей. По данным Datacenter Dynamics, ранее CoolIT привлекла около $10 млн в ходе четырёх раундов финансирования. В числе предыдущих инвесторов: Business Development Bank of Canada, nVent, Kline Hill Partners, Vistara Capital Partners, Inovia Partners, AVAC Group и Chart Venture Partners. Масштабная эволюция инфраструктуры ЦОД и развитие ИИ-технологий стали импульсом к росту сделок, напрямую не связанных с компаниями технологического сектора. В частности, речь идёт об энергетике и промышленных сделках с участием поставщиков для ИИ-инфраструктуры. Как свидетельствуют данные НКО American Edge Project, в США уже строятся или планируются к строительству около 3 тыс. дата-центров, не считая 4 тыс. уже действующих площадок. Это неизбежно увеличивает потенциальный спрос на оборудование и сервисы CoolIT. Тем не менее, инвесторы начинают ставить под сомнение окупаемость многих инвестиций крупных компаний в новые дата-центры. В 2025 году производственная компания Eaton заплатила $9,5 млрд за связанный с теплообменными решениями бизнес Boyd Corporation. Предполагается, что это позволит расширить портфолио решений для ЦОД. Купленный бизнес, вероятно, уже в 2026 году принесёт около $1,7 млрд выручки, причём большая её часть приходится на СЖО-решения. Конкурент Vertiv также купил компанию PurgeRite сходного профиля в том же году, заплатив около $1 млрд. На днях частные инвестиционные компании Global Infrastructure Partners (GIP, принадлежит BlackRock) и EQT заключили сделку на $33 млрд, организовав покупку энергокомпании AES Corporation. В своё распоряжение они получили бизнес, генерирующий возобновляемую энергию в огромных объёмах для дата-центров. В последние годы эксперты называют KKR одним из самых агрессивных частных инвесторов, скупающих ЦОД. В 2021 году совместно с GIP она приобрела американского оператора ЦОД CyrusOne. Сделка обошлась в $15 млрд, включая долг.

10.03.2026 [16:30], Руслан Авдеев

ИИ-неооблако Nscale привлекло ещё $2 млрдЗанимающаяся строительством ИИ-фабрик компания Nscale — ключевой элемент стратегии развития ИИ британских властей — объявила о привлечении $2 млрд в ходе раунда финансирования серии C, сообщает Computer Weekly. В итоге за период чуть более года объём финансирования бизнеса превысит $4,9 млрд, новый раунд довёл оценку капитализации компании приблизительно до $14,6 млрд. Во многом такие оценки основаны на планах строительства Nscale дата-центров общей мощностью более 1,3 ГВт. Также компания сообщила о контрактах на поставку 200 тыс. ИИ-ускорителей NVIDIA GB300 и сделках о предоставлении мощностей компании Microsoft на $23 млрд на многих из планируемых площадок. В 2025 году Nscale объявила о готовности вложить $2,5 млрд в дата-центры Великобритании до 2028 года. Речь идёт как о стационарных объектах, так и о модульных ЦОД. В середине 2024 года Nscale приобрела провайдера модульных ЦОД — Kontena. Такие дата-центры позволяют использовать предварительно изготовленные готовые решения, поставку которых можно организовать за считанные месяцы вместо двух-трёх лет для капитальных построек. Ключевой проект — кампус в Лоутоне (Loughton, Эссекс) мощностью от 50 МВт с возможностью расширения до 90 МВт; он считается крупнейшим ИИ ЦОД в Великобритании и предусматривает использование 23 тыс. NVIDIA GB300. Запуск планируется в IV квартале 2026 года. Площадка сочетает модульную конструкцию для быстрого развёртывания со «стационарными» мощностями, которые будут доступны несколько позднее. Дополнительно Nscale строит ЦОД в Гломфьорде (Glomfjord) в Норвегии, где уже имеются модульные мощности на 30 МВт, а также планируется построить ещё 60 МВт с питанием от ГЭС. В Норвегии также имеется проект Stargate Norway: к начальным 230 МВт планируется добавить инфраструктуру ещё на 290 МВт в рамках проекта, реализуемого совместно с OpenAI и Aker ASA. В Барстоу (Barstow, Техас) на арендованных мощностях для Microsoft будет развёрнуто 104 тыс. ИИ-ускорителей в рамках проекта мощностью 234 МВт. Проект должны ввести в эксплуатацию в III квартале 2027 года; позже его планируется масштабировать до 1,2 ГВт.

Источник изображения: Nscale В Синише (Sines, Португалия) изначально планируется развернуть 12,6 тыс. ускорителей NVIDIA GB300, мощность составит около 20 МВт; для охлаждения оборудования планируется использовать морскую воду. Наконец, в Кеблавике (Keflavík, Исландия) в 2026 году планируется развернуть порядка 4,6 тыс. ускорителей NVIDIA с энергопотреблением около 15 МВт, обеспечиваемым геотермальными источниками и ГЭС. Также Nscale имеет свободные мощности ЦОД в арендованных объектах на двух дополнительных площадках в Норвегии, а также в Северной Каролине и др. Nscale зарегистрирована в Великобритании. Лидерами нового раунда финансирования являются норвежская инвестиционная Aker ASA и американский инвестиционный фонд 8090 Industries. В числе других инвесторов — Dell, Lenovo, Nokia и NVIDIA. Компания позиционирует себя как единственного поставщика комплексной инфраструктуры для современного ИИ, а также упоминается в правительственных пресс-релизах, посвящённых сотрудничеству с OpenAI для создания суверенных вычислительных ИИ-мощностей и участию в проекте строительства ЦОД в Лоутоне. Одновременно с привлечением новых средств объявлено о назначении одного из известнейших британских политиков — бывшего вице-премьера Ника Клегга (Nick Clegg) — членом совета директоров. Параллельно Клегг числится партнёром инвестиционной компании Hiro Capital. Также он занимал должность президента по глобальным вопросам в Meta✴. Дополнительно в совет директоров вошли бывший операционный директор (COO) Meta✴ Шерил Сэндберг (Sheryl Sandberg) и бывший президент Yahoo Сьюзан Декер (Susan Decker).

10.03.2026 [16:25], Руслан Авдеев

CNBC: Oracle строит «вчерашние» дата-центры за счёт будущих долговПоколения ИИ-ускорителей обновляются значительно быстрее, чем строятся новые ЦОД. Эта тенденция представляет угрозу как для рынка ИИ-решений в целом, так и для экспансии Oracle, в значительной степени финансируемой за счёт долговых средств, сообщает CNBC. По последним данным, OpenAI больше не планирует расширять партнёрство с Oracle в Абилине (Abilene, Техас), где расположен флагманский ЦОД проекта Stargate. Причина в том, что ИИ-компания нуждается в кластерах с новейшими поколениями ускорителей NVIDIA, а возможности Oracle поставить их OpenAI — под вопросом. В воскресенье Oracle назвала новости о своей деятельности «ложными и неправильными», но в посте компании говорилось лишь о существующих проектах, а планов масштабирования объявление не касалось. Площадка в Абилине будет использовать ускорители NVIDIA Blackwell, но энергия для них начнёт поступать лишь через год. К тому времени OpenAI рассчитывает получить «расширенный» доступ к чипам NVIDIA нового поколения в более крупных кластерах, в других местах. В своё время Oracle получила землю, заказала оборудование и потратила миллиарды долларов на строительство и персонал в расчёте на будущий рост. Теперь в компании отказываются подробно комментировать эту информацию. Отказ от дальнейшего расширения был бы вполне логичным шагом для OpenAI, которой не нужны устаревшие чипы. Раньше NVIDIA представляла новое поколение ИИ-ускорителей каждые два года, но теперь её глава Дженсен Хуанг (Jensen Huang) объявил, что компания перешла на ежегодный цикл обновления, и каждое новое поколение значительно превосходит предыдущее по производительности. Например, представленные в январе 2026 года ускорители Vera Rubin впятеро производительнее Blackwell при инференсе.

Источник изображения: Amy Hirschi/unsplash.com Для компаний, создающих передовые ИИ-модели, малейшее отставание в производительности оборудования может означать серьёзное отставание в бенчмарках и рейтингах. При этом рейтинги внимательно отслеживаются специалистами и бизнесом и сильно влияют на уровень использования ИИ-продуктов, выручку и капитализацию. Тем временем у инфраструктурных компаний на получение участка, подключение электроэнергии, строительство и ввод в эксплуатацию дата-центра уходит минимум год-два, а клиентам требуется новейшее оборудование, которое теперь обновляется каждый год. Дополнительной проблемой Oracle является то, что это единственный гиперскейлер, строящий новую инфраструктуру преимущественно за счёт заёмных средств: долги достигли $100 млрд и продолжают расти. Напротив, Google, AWS и Microsoft пользуются полноводными потоками денег, получаемых от других направлений своей деятельности, приносящих значительную выручку. Сообщается, что партнёр Oracle — компания Blue Owl — отказалась финансировать дополнительный объект. 10 марта Oracle отчитывается о финансовых результатах третьего квартала финансового года, и инвесторы уделят особое внимание тому, как компания намерена обосновать план капитальных затрат в $50 млрд на фоне отрицательного свободного денежного потока. Они также будут оценивать, сохранится ли у компании доступ к источникам финансирования. В текущем году акции компании уже упали на 23 %, а с пика в сентябре 2025 года потеряли более половины своей стоимости. Впрочем, проблема устаревания ускорителей касается не только Oracle. Это угроза рынку ИИ в целом, которая может иметь последствия для всего «ИИ-ландшафта». Каждая из подписываемых сегодня инфраструктурных сделок может привести к тому, что оборудование устареет ещё до того, как к ЦОД подключат электроэнергию. Вместе с тем далеко не всем игрокам ИИ-рынка действительно нужны самые последние модели ускорителей, поскольку конкретные задачи и связанная с ними экономика могут заметно отличаться у разных компаний.

10.03.2026 [12:58], Сергей Карасёв

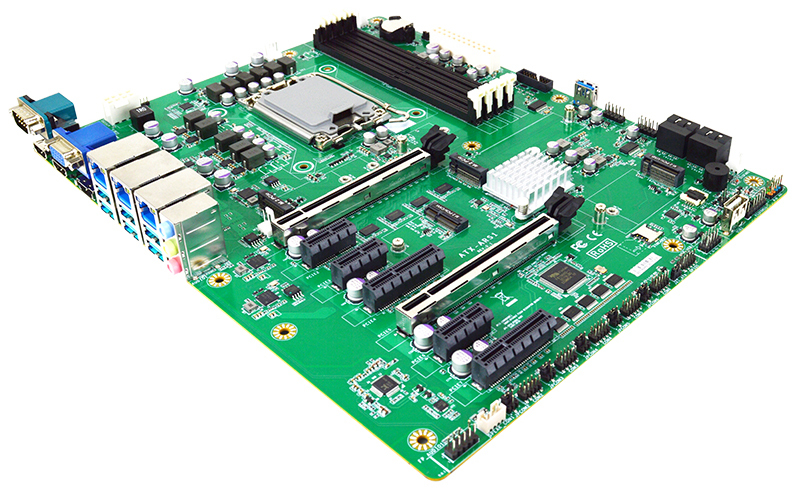

Jetway выпустила индустриальную плату ATX-ARS1-W880 на базе Intel Arrow Lake-SКомпания Jetway анонсировала индустриальную материнскую плату ATX-ARS1-W880, предназначенную для платформ автоматизации, робототехнических комплексов и пр. Новинка рассчитана на эксплуатацию в температурном диапазоне от -20 до +60 °С. Изделие выполнено в форм-факторе АТХ с размерами 305 × 244 мм. Применён набор логики Intel W880: возможна установка процессоров семейства Arrow Lake-S в исполнении LGA1851 с показателем TDP до 125 Вт. Доступны четыре слота CU-DIMM (Clocked Unbuffered DIMM) с поддержкой до 256 Гбайт памяти DDR5-6400. Плата располагает четырьмя портами SATA-3 для накопителей с возможностью формирования массивов RAID 0/1/5/10. Кроме того, имеются коннекторы М.2 M-Key 2242/2260/2280/22110 (PCIe 5.0 x4) и М.2 M-key 2280 (PCIe 4.0 x4) для NVMe SSD. В арсенале новинки — сетевой порт 2.5GbE RJ45 на основе контроллера Intel I226-LM и два порта 2.5GbE RJ45 на базе Intel I226-V. Реализованы слот M.2 E-Key 2230 (USB 2.0/PCIe 3.0 x1; CNVio) для комбинированного адаптера Wi-Fi / Bluetooth и разъём M.2 B-Key 3042/3052 (USB3.1/USB2.0/PCIe 3.0 x1 плюс NanoSIM) для сотового модема 4G/5G.

Источник изображения: Jetway Возможен вывод изображения одновременно на четыре независимых монитора через интерфейс DP1.4a (до 4096 × 2160; 60 Гц), два выхода HDMI 2.1 (до 3840 × 2160; 60 Гц) и аналоговый коннектор D-Sub (1920 × 1080; 60 Гц). Доступны шесть портов USB 3.1 Type-A (10 Гбит/с), последовательный порт RS-232/422/485 и набор аудиогнёзд на 3,5 мм. Через разъёмы на самой плате могут быть задействованы два порта USB 3.0 (5 Гбит/с), шесть портов USB 2.0, а также пять портов RS-232. Плата получила по два слота PCIe 5.0 x16 (1 × PCIe 5.0 ×16 или 2 × PCIe 5.0 x8) и PCIe 4.0 x4, а также три слота PCIe 4.0 x1. Есть два коннектора для вентиляторов охлаждения. Опционально может быть добавлен модуль TPM 2.0 (dTPM) для обеспечения безопасности. Заявлена совместимость с Windows 11 и Linux.

10.03.2026 [12:52], Сергей Карасёв

QCT представила сервер QuantaEdge EGN77C-2U на базе NVIDIA Grace для инфраструктур AI-RANКомпания Quanta Cloud Technology (QCT) анонсировала сервер QuantaEdge EGN77C-2U, использующий дизайн NVIDIA Aerial RAN Computer Pro (ARC-Pro) и подход Nokia anyRAN. Новинка, как ожидается, позволит телеком-операторам ускорить переход к программно-определяемым сетям 5G и 6G с поддержкой ИИ (AI-RAN). Устройство имеет архитектуру 2U2N — два узла в корпусе 2U. Задействованы чипы NVIDIA Grace, объединяющие 72 вычислительных ядра Arm Neoverse V2 (Armv9). Объём памяти LPDDR5X составляет 512 Гбайт в расчёте на узел. В оснащение каждого узла входят GPU-ускоритель NVIDIA RTX PRO 4500 Blackwell, сетевые адаптеры NVIDIA ConnectX-8 Ethernet SuperNIC, 16 портов 25GbE и два порта 400GbE. «Отрасль вступает в новую эпоху беспроводной связи, изначально основанную на ИИ. С помощью QuantaEdge EGN77C-2U, платформы NVIDIA AI Aerial и программного обеспечения Nokia anyRAN мы формируем единую среду, которая поддерживает бесшовную интеграцию ИИ и сетей радиодоступа следующего поколения», — говорит Майк Янг (Mike Yang), президент QCT. Подчёркивается, что сети, изначально созданные на основе ИИ, предлагают качественно новые возможности в плане производительности, эффективности и функциональности. Программно-определяемая архитектура RAN на базе ИИ поможет справляться с экспоненциальным ростом объёмов передаваемых данных и появлением новых ресурсоёмких рабочих нагрузок. Алгоритмы ИИ поддерживают интеллектуальное управление, что позволяет оптимизировать работу сетей в зависимости от текущей ситуации. В результате, может быть сформирован задел для будущих систем связи 6G, которые обеспечат высочайшие скорости передачи информации при минимальных задержках. |

|