Материалы по тегу: ии

|

16.11.2025 [17:38], Руслан Авдеев

Ни доходов, ни рабочих мест: льготы для дата-центров не приносят ничего хорошего большинству штатов США, но отказаться от них трудноАмериканская индустрия ЦОД получает немалые субсидии на уровне штатов, но процедура не всегда прозрачна, а некоторые штаты даже теряют деньги на этом, сообщает некоммерческая организация Good Jobs First. По данным НКО, налоговые льготы для развития ЦОД и облачных вычислений предоставляют 36 штатов, но лишь 11 из них раскрывают, какие именно компании их получают. В остальном всё крайне непрозрачно: лишь в немногих штатах говорят, о каких объёмах льгот идёт речь, и раскрывают информацию о том, выполняют ли компании обещания о капиталовложениях и создают ли рабочие места. В документе «Облачные данные, дорогостоящие сделки: как неохотно штаты раскрывают субсидии центрам обработки данных» (Cloudy Data, Costly Deals: How Poorly States Disclose Data Center Subsidies) приводятся некоторые детали, передаёт The Register.

Источник изображения: zanck FL/unsplash.com В частности, из 11 штатов, раскрывающих информацию об освобождении от налогов с продаж и использования, ни один не разглашает конечных бенефициаров таких послаблений. Тем временем Amazon, Google, Microsoft, Meta✴ и Apple регулярно «прячутся» за дочерними компаниями. Только 5 из 11 штатов раскрывают вероятные или фактические объёмы субсидий, причём с запозданием. Лишь четыре штата — Иллинойс, Индиана, Невада и Огайо — рассказывают о том, сколько рабочих мест обещают создать операторы ЦОД. Ни один из штатов не отчитывается о фактически созданных рабочих местах, хотя налоговые льготы часто связывают именно с появлением новых вакансий. Наконец, только Невада сообщает, какие зарплаты платят сотрудникам в субсидируемых проектах. По словам НКО, во многих штатах речь идёт о двойных стандартах. Большинство проектов, получающих субсидии, освещаются довольно хорошо, но только не дата-центры. В апреле 2024 года Good Jobs First сообщала, что только освобождение дата-центров от налога с продаж и использования ежегодно обходится бюджетам штатов в миллиарды долларов недополученных доходов. В 2025 финансовом году Техас потерял $1 млрд из-за ЦОД, но штат публикует только названия субсидируемых компаний без каких-либо деталей. Вирджиния, крупнейший в стране рынок ЦОД, тоже теряет почти $1 млрд, но какие компании получают льготы и в каком объёме, не раскрывает. Более того, в нескольких штатах чистые убытки составляют от ¢52 до ¢70 с каждого $1 налоговых субсидий.

Источник изображения: Good Jobs First ЦОД, как считается, возглавляют список наиболее неэффективно субсидируемых отраслей в 2025 году. В исследовании рекомендуется резко сократить объёмы расходов штатов на дата-центры, отменив или пересмотрев налоговые льготы. В Джорджии и Огайо уже проголосовали за приостановку или отмену этих льгот, но вето на оба законопроекта наложили губернаторы. В любом случае, как считают в Good Jobs First, штаты должны обеспечить полную прозрачность данных о том, какие компании получают льготы, в каких объёмах и что получают взамен. При этом в исследовании даже не касались других послаблений вроде льгот по налогу на имущество и корпоративную прибыль или же скидки на оплату электроэнергии и воды — эти данные также крайне редко раскрываются. Стоит отметить, что JPMorgan недавно спрогнозировал гигантские расходы на дата-центры в ближайшие пять лет и «астрономический» спрос на соответствующую инфраструктуру, поэтому руководство штатов, возможно, просто не может отказаться от участия в «гонке ЦОД».

16.11.2025 [12:31], Владимир Мироненко

Google инвестирует $40 млрд в строительство трёх ЦОД в ТехасеGoogle объявила об инвестициях в размере $40 млрд в инфраструктуру в Техасе, которые будут направлены в период до 2027 года на строительство трёх новых ЦОД в дополнение к двум имеющимся в Далласе. Как сообщает Bloomberg со ссылкой на Сундара Пичаи (Sundar Pichai), генерального директора холдинга Alphabet, в который входит Google, один из ЦОД будет построен в округе Армстронг (Armstrong), в западной части Техаса, а два других — в округе Хаскелл (Haskell), на участке Западного Техаса недалеко от Абилина (Abilene). Один из ЦОД компании в Хаскелле будет расположен рядом с новой солнечной электростанцией и аккумуляторной станцией, что позволит снизить нагрузку на энергосистему штата. Google подчеркнула, что подходит с всей ответственностью к развитию своей инфраструктуры, подключая новые источники энергии к сети, оплачивая расходы, связанные с её деятельностью, и поддерживая общественные инициативы по повышению энергоэффективности. В Техасе её инициативы включают новый фонд Energy Impact Fund в размере $30 млн для развёртывания и ускорения внедрения энергетических инициатив, а также более 6,2 ГВт новых генерирующих мощностей по соглашениям о закупке электроэнергии с энергетическими компаниями. Сундара Пичаи заявил на пресс-конференции в пятницу, что «инвестиции создадут тысячи рабочих мест, обеспечат профессиональную подготовку студентов и электриков, а также ускорят реализацию инициатив по обеспечению доступности энергии по всему Техасу». Так, Альянс по обучению электриков (Electrical Training Alliance, ETA) при её поддержке обучит существующих электриков и более 1700 стажёров в Техасе к 2030 году, что более чем вдвое увеличит приток новых специалистов. В Техасе расположено не менее 411 дата-центров, это один из крупнейших рынков ЦОД в США, который быстро растёт. Здесь, в округе Шакелфорд (Shackelford) ведёт строительство нового кампуса Frontier площадью более 485 га и мощностью 1,4 ГВт компания Vantage Data Centers. Стоимость проекта составляет более $25 млрд. В Абилине к концу 2025 года должны завершить строительство первой очереди ЦОД кампуса Stargate стоимостью в $1,1 млрд — буквально вчера Crusoe объявила о работах над последним, восьмым по счёту объектом кампуса. Арендатором выступит Oracle, которая предоставит вычислительные мощности компании OpenAI. В Эль-Пасо (El Paso) строит ЦОД мощностью 1 ГВт компания Meta✴ Platforms. Как ожидается, объект стоимостью более $1,5 млрд будет введён в эксплуатацию в 2028 году. Немного ранее, в I квартале 2027 года в Западном Техасе компаниями Poolside и CoreWeave будет построен кампус ЦОД Project Horizon мощностью 2 ГВт. В Амарилло (Amarillo) будет построен 11-ГВт кампус ИИ ЦОД HyperGrid компании Fermi America. Ожидается, что его первая очередь мощностью 1 ГВт будет введена в эксплуатацию в конце 2026 года. Ранее стало известно, что Google инвестирует в течение четырёх лет €5,5 млрд в дата-центры в Германии, планирует построить ИИ ЦОД на австралийском Острове Рождества (Кристмас) в Индийском океане, а также намерена развернуть ИИ-инфраструктуру в космосе в рамках проекта Project Suncatcher. В минувшем квартале Google объявила о $15 млрд инвестиций в штате Андхра-Прадеш (Индия), $5,8 млрд — в Бельгии и по $9 млрд — в Южной Каролине, Оклахоме и Вирджинии (США).

16.11.2025 [12:05], Руслан Авдеев

Не жили богато: капитальные затраты Tencent в III квартале сократились на четверть из-за недоступности ИИ-ускорителейКапитальные затраты китайской Tencent стремительно сокращаются. Виной тому — невозможность закупить столько ИИ-ускорителей, сколько нужно компании, сообщает Datacenter Dynamics. В ходе отчёта за III квартал 2025 года руководства Tencent отметило, что капитальные затраты снижаются из-за изменений доступности ИИ-чипов, а также ограничений в цепочках их поставок. В минувшем квартале капитальные затраты составили всего ¥13 млрд ($1,83 млрд), на 24 % меньше год к году и меньше, чем во II квартале ($2,49 млрд). Ожидается и дальнейшее снижение. Для сравнения, американские облачные гиганты Microsoft, Google и Amazon (AWS) отчитались о капитальных затратах в аналогичной квартале в объёме $34,9 млрд, $24 млрд и $34,2 млрд соответственно. Компании регистрируют значительный рост капитальных затрат в связи с активными инвестициями в ИИ-инфраструктуру. В Tencent уверяют, что у компании достаточно ускорителей для выполнения задач, но отмечено «ограниченное влияние» на доходы от облачных услуг из-за отсутствия достаточного количества ресурсов, доступных клиентам. В то же время американские конкуренты растут двухзначными темпами год к году, во многом благодаря ИИ-бизнесу, и жалуются на недостаток энергии для питания ускорителей.

Источник изображения: Donald Wu/unsplash.com Tencent заявила, что намерена создавать усовершенствованные ИИ-модели — это даст возможность обойти ограничения, связанные с дефицитом чипов. Утверждается, что компании не требуется больше ускорителей для обучения искусственного интеллекта и обновления моделей. Попутно внедряется немало программных улучшений, оптимизирующих инференс, в результате на том же количестве чипов можно обеспечить большие нагрузки. Tencent не раскрывает детальной статистики прибыли в разных сегментах её бизнеса, но в целом он растёт. Общая выручка за квартал составила ¥192,9 млрд ($27,12 млрд), на 15 % больше год к году. Ограничения на доступ китайского бизнеса к ИИ-ускорителям существуют уже довольно давно. Ранее в ноябре президент США Дональд Трамп (Donald Trump) заявил, что самые передовые чипы не достанутся никому, кроме США. По его словам, Китаю позволят сотрудничать с NVIDIA, но покупать придётся устаревшие или ограниченные модели. Впрочем, сейчас, по данным самой NVIDIA, доля её продукции на китайском рынке упала с 95 % практически до нуля, а многие китайские компании научились обходить ограничения, пользуясь зарубежными, в том числе американскими облаками. Некоторые чипы доступны китайским покупателям, не попадающим под санкции, NVIDIA и AMD ранее согласились выплачивать правительству США 15 % выручки от них. Однако теперь уже правительство КНР противодействует их закупкам, продвигая китайские решения на домашнем рынке.

15.11.2025 [16:14], Владимир Мироненко

Broadcom упростила сертификацию оборудования для VCF для ускорения внедрения современных частных облаковBroadcom объявила о значительном обновлении VMware Cloud Foundation (VCF) 9.0 с целью предоставления компаниям более широкого выбора в области оборудования, сетевых решений и open source ПО с открытым исходным кодом. По словам компании, VCF представляет собой частную облачную платформу, открытую и адаптируемую ко всем уровням инфраструктуры. Изменения формируют открытую, гибкую экосистему, которая позволяет клиентам создавать, подключать, защищать и развивать современные частные облака в предпочитаемых ЦОД, периферийных локациях и хостинговых средах. VCF 9.0 теперь сочетает в себе эффективность облачной операционной модели с локальным управлением, расширяя совместимость с решениями разных провайдеров, возможности использования ИИ и преимущества в совокупной стоимости владения, отметил ресурс StorageReview.com. «Создавая открытую экосистему VCF, мы даём компаниям возможность создавать современные частные облака, соответствующие их стратегическим потребностям, гарантируя, что они смогут использовать технологии, необходимые для их уникальных сред», — заявил Пол Тернер (Paul Turner), директор по продуктам подразделения VMware Cloud Foundation компании Broadcom. Обновление включает расширение компанией программы открытой сертификации оборудования, чтобы расширить возможности OEM- и ODM-партнёров. В частности, программа VCF AI ReadyNodes (готовые к работе с VCF ИИ-узлы) призвана упростить процесс сертификации ИИ-узлов, позволяя заказчикам внедрять CPU, GPU и ускорители следующего поколения по мере их появления. VCF AI ReadyNodes будет использоваться для сертификации серверов, прошедших предварительную квалификацию для обучения ИИ-моделей и инференса. Сертифицированные согласно VCF AI ReadyNodes узлы представляют собой предварительно настроенное оборудование с ПО VMware с предсказуемой производительностью, простым управлением и гибкой виртуализацией со сквозным доступом к GPU, а также включают сетевые функции для минимизации задержки и масштабирования пропускной способности. Такие узлы снижают риски проблем при интеграции и сокращают время выхода продукта на рынок, предлагая предварительно проверенные ПАК для обучения и инференса. Они поддерживают плавное обновление через SDDC Manager, обеспечивая синхронизацию обновлений драйверов GPU, прошивок сетевых карт и VMware ESXi для поддержания стабильности в производственных ИИ-средах. Supermicro станет одним из первых OEM-партнёров, сертифицировавших свои серверы в рамках AI ReadyNode. Broadcom также расширила программу VCF ReadyNode, предоставив ODM-партнёрам возможность самостоятельно сертифицировать готовые узлы в рамках программы Broadcom Technology Alliance (TAP). Все сертифицированные системы будут проверены на полную совместимость с VMware Cloud Foundation с последовательным управлением жизненным циклом VCF. Это расширяет возможности поиска поставщиков и сокращает время выполнения заказов. Для узлов для периферийных вычислений компания предлагает вариант VCF Edge, ориентированный на надёжные и компактные серверы для промышленных, оборонных, розничных и др. нужд. Broadcom также сообщила о новой стратегии, направленной на унификацию сетевых инфраструктур и упрощение сетевых операций в современном частном облаке с помощью стандартизированных сетей с EVPN и BGP. Клиенты получат преимущества от защиты на уровне VPC, согласованных сетевых операций, маршрутизации и видимости во всех доменах VCF Networking (NSX) и сетевых решениях сторонних производителей, обеспечивающих унифицированные операции с помощью комплексной автоматизации. Этот подход согласует VCF со стратегией Cisco Nexus One Fabric, обеспечивая более согласованные и надёжные результаты работы для совместных клиентов Cisco и VMware. Cisco Nexus One Fabric расширяет возможности VCF, предоставляя современную, масштабируемую и автоматизированную сетевую архитектуру на основе VXLAN EVPN. VCF Networking (NSX) также теперь поддерживает популярную открытую NOS SONiC. SONiC обеспечивает клиентам снижение затрат за счёт использования стандартного коммутационного оборудования разных производителей, снижая как капитальные, так и эксплуатационные расходы. Кроме того, Broadcom продолжает участвовать в сообществе Kubernetes, являясь одним из пяти крупнейших участников CNCF (Cloud Native Computing Foundation) и работая над проектами Antrea, Cluster API, ContainerD, Contour, etcd, Harbor и т.д. Broadcom объявила, что VMware vSphere Kubernetes Service (VKS) был сертифицирован CNCF как платформа, соответствующая требованиям Kubernetes AI Conformant Platform. Как сообщает The Register, эта недавно запущенная программа соответствия призвана дать клиентам уверенность в том, что контейнерная платформа может надёжно выполнять реальные рабочие нагрузки ИИ. Программа определяет минимальный набор возможностей и конфигураций, необходимых для запуска широко распространенных фреймворков ИИ и машинного обучения в инфраструктуре Kubernetes.

14.11.2025 [16:35], Руслан Авдеев

Пузырь не страшен: JPMorgan прогнозирует, что затраты на ЦОД и ИИ-инфраструктуру составят $5 трлн, а спрос будет «астрономический»Как показал анализ, проведённый JPMorgan Chase & Co., в следующие пять лет на дата-центры, ИИ-инфраструктуру и связанные источники энергоснабжения потратят более $5 трлн, сообщает Datacenter Dynamics. В JPMorgan полагают, что придётся привлечь все публичные рынки капитала, а также частное кредитование, альтернативные источники капитала и даже правительственные средства. Ожидается, что в 2026–2030 гг. построят ЦОД общей мощностью 122 ГВт — масштаб спроса на вычисления будет оставаться «астрономическим». Если бы не дефицит электричества, ввели бы в эксплуатацию ещё больше дата-центров. Сроки поставок газовых турбин выросли до трёх-четырёх лет, а на строительство АЭС традиционно уходило более 10 лет. Своевременно добавить 150 ГВт — серьёзная задача, особенно в свете необходимости модернизации энергосистем. Ожидается, что финансирование волны ЦОД ускорит рост рынка государственных облигаций и рынка синдицированных кредитов после спада, вызванного COVID-19. Годовые потребности в финансировании ЦОД в 2026 году составят порядка $700 млрд, которые можно полностью профинансировать за счёт гиперскейлеров и рынков высоконадёжных облигаций. Тем не менее, к 2030 году потребности превысят $1,4 трлн, для чего потребуется привлекать все финансовые рынки, готовые предоставить капитал.

Источник изображения: Troy Mortier/unsplash.com Средства гиперскейлеров должны сыграть важную роль — эти компании генерируют операционный денежный поток более $700 млрд в год и реинвестируют $500 из них в капитальные затраты. При этом не учитываются порядка $250 млрд расходов на исследования и разработки. В следующие пять лет около $150 млрд поступит от заёмного финансирования и до $200 млрд — от секьюритизации ЦОД (выпуска облигаций под будущие доходы). Рынки высоконадёжных облигаций могут принести $300 млрд в виде инвестиций в ИИ ЦОД уже в следующем году или $1,5 трлн за пять лет. Даже с учётом множества источников средств JPMorgan ожидает, что дефицит финансирования составит $1,4 трлн. Его могло бы компенсировать частное кредитование наряду с более активной финансовой поддержкой со стороны государств, особенно на фоне всеобщего интереса к ИИ в контексте национальной обороны и суверенитета. Тем не менее, JPMorgan не исключает возникновения «ИИ-пузыря», аналогичного «пузырю доткомов» конца 1990-х гг. Также в отчёте уточняется, что для обеспечения 10 % доходности при моделировании инвестиций потребуется выручка на уровне $650 млрд в год, что невероятно много — для достижения таких результатов необходимо внедрять платный ИИ буквально везде. Даже если некоторые компании, работающие в сфере ИИ, получают прибыль, вероятнее всего, будут и «проигравшие», учитывая объёмы привлекаемого капитала и принципа «победитель получает всё» в некоторых сегментах ИИ-экосистемы. Тревожные рассуждения о возможном «пузыре» на рынке ИИ циркулируют уже не первый месяц. Так, в сентябре крах допустила Goldman Sachs, в октябре — Bank of England, а в ноябре The Wall Street Journal привела мнения экспертов Кремниевой долины, которые тоже допускают, что пузырь всё-таки «лопнет».

14.11.2025 [12:56], Руслан Авдеев

Китайская INF Tech обошла санкции США на доступ к ИИ-чипам NVIDIA Blackwell через индонезийское облакоКитайской ИИ-компании INF Tech удалось получить доступ к 2,3 тыс. ускорителей NVIDIA Blackwell благодаря соглашению с индонезийским бизнесом. Несмотря на запрет США на поставки передовых ИИ-чипов в Китай, доступ к вычислительным ресурсам всё же удалось получить, причём с соблюдением буквы американских законов, сообщает The Wall Street Journal. В целом «операция» проводится через партнёров в разных странах и с использованием всевозможных лазеек, но технически американские экспортные законы не нарушаются. Сами чипы находятся в ЦОД, спрятавшемся между частной школой и жилым комплексом в Джакарте — они легально куплены индонезийским телеком-провайдером Indosat Ooredoo Hutchison, которая потратила около $100 млн на 32 стоечных суперускорителя с NVIDIA GB200 NVL72 у компании Aivres из Кремниевой долины, занимающейся выпуском серверов. Все они теперь будут использоваться шанхайской INF Tech. История началась с продажи NVIDIA чипов компании Aivres, которая не является обычным спекулянтом-перепродавцом, а на треть принадлежит китайской Inspur, в 2023 году попавшей в чёрные списки Минторга США, якобы за причастность к суперкомпьютерным проектам китайских военных. Inspur является одним из крупнейших в мире поставщиков серверов. Чёрный список американских властей запрещает NVIDIA напрямую иметь дела с Inspur или подразделений компании, тоже занесённых в чёрные списки, но Aivres, будучи компанией американской, под ограничения не попадает. При этом особого секрета в том, что она наряду с Betapex и KAYTUS Singapore Pte прямо связана с Inspur, нет. Об этом, в частности, прямо говорится в иске HPE.

Источник изображения: David Kristianto/unsplash.com Другими словами, NVIDIA с чистой совестью продала ускорители в полном соответствии с законами, а Aivres закрыла сделку с Indosat в середине 2024 года. Сделка состоялась только после того, как Indosat нашла под чипы конкретного покупателя — INF Tech. ИИ-стартап основан в Китае в 2021 году, а его основатель Ци Юань (Qi Yuan) — профессор Фуданьского университета, бывший высокопоставленный учёный в структуре Alibaba, получивший докторскую степень в MIT и к тому же являющийся гражданином США. По некоторым данным, в обсуждении облачного контракта принимали участие и другие сотрудники Фуданьского университета. Серверы уже доставлены в ЦОД в Индонезии. Они будут использоваться для обучения ИИ-моделей в области финансов и здравоохранения, в частности, фармацевтики. Законов, запрещающих китайским компаниям арендовать доступ к облачным вычислениям за рубежом, не существует. По словам знакомых с тематикой юристов, оборудование запрещено использовать только для военной разведки или создания вооружений. Впрочем, многие американские чиновники всё равно недовольны. Утверждается, что «коммерческие» китайские проекты легко перепрофилировать для военных задач с учётом тесного сотрудничества гражданских и военных структур в КНР. Именно поэтому прошлая администрация США готовила закон, ограничивавший экспорт ИИ-технологий в страны вроде Индонезии, не относящиеся к числу верных сторонников США. В случае принятия этого закона американские компании стали бы обязаны раскрывать информацию о том, кто и почему покупает чипы и не распространяются ли на конечного пользователя ограничения. Новая администрация показала, что не желает иметь с этим законом ничего общего. В результате проверки рисков фактически возложили на NVIDIA. В INF Tech заявляют, что не связаны с военными исследованиями и действуют в соответствии с американскими законами. Теперь компания намерена развивать бизнес за пределами Китая, заключая соглашения с операторами ЦОД в Сингапуре, Малайзии и Таиланде для создания собственной ИИ-инфраструктуры. В Indosat подтвердили, что работают с многонациональными компаниями и каждый клиент, как американский, так и китайский, проходит одинаковый процесс одобрения. Также Indosat подчеркнула, что INF Tech не имеет физического доступа к оборудованию в Джакарте и только использует инфраструктуру для эксплуатации ИИ-продуктов, оптимизированных для Индонезии и Юго-Восточной Азии. По словам главы NVIDIA Дженсена Хуанга (Jensen Huang), доля компании на китайском рынке ИИ-решений упала с 95 % до нуля из-за экспортных ограничений и давно критикует власти США за недальновидность. Впрочем, китайский бизнес и ранее прибегал к использованию американских облаков или контрабандным ускорителям. Представитель NVIDIA не так давно заявлял, что ограничения на поставки уже стоили налогоплательщикам десятков миллиардов долларов, помешали инновациям и заставили уступить долю рынка зарубежным конкурентам.

14.11.2025 [10:03], Руслан Авдеев

NVIDIA ужесточит контроль над выпуском ИИ-платформ, задвинув Foxconn и других партнёров на второй планКомпания NVIDIA готовится изменить текущую бизнес-модель в контексте ИИ-серверов. Она намерена получить под свой контроль производство ИИ-платформ целиком, а не отдельные элементы цепочек поставок, сообщает Wccftech. Если обычно экосистема поставок NVIDIA опирается на партнёров, выпускающих компоненты конечных продуктов — Foxconn, Quanta (QCT) и Wistron (Wiwynn) — со своими собственными разработками, то в будущем компания фактически возьмёт под контроль всё производство вплоть до уровня стоек. До сих пор NVIDIA поставляла в основном ключевые компоненты, такие как ИИ-ускорители и системные платы вроде Bianca Port UPB. Тем не менее, в ходе отчёта Wistron за III квартал 2025 года представитель JPMorgan заявил, что компания, похоже, переходит к «прямым поставкам» полноценных систем. Если раньше NVIDIA отвечала за ключевые элементы стоек — ИИ-ускорители и платы, — то за остальную архитектуру отвечали подрядчики вроде Foxconn, Quanta и других компаний. Теперь, как полагают в JPMorgan, NVIDIA станет напрямую поставлять системы Level-10 (почти полный блок серверной стойки). Компания унифицирует конструкцию систем, заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна и запретит использование проприетарных архитектур, созданных самими подрядчиками. Фактически — это развитие философии MGX-архитектуры, предполагающей единые стандарты от серверного узла до полнофункциональной ИИ-фабрики. При этом время развёртывания таких комплексных систем сократится с 9–12 мес. до 90 дней, т.е. 3 мес. Поскольку 80 % наполнения систем будет предварительно определяться NVIDIA, новые платформы вроде Rubin/Rubin CPX можно будет внедрять ускоренными темпами. NVIDIA выиграет от быстрого вывода систем на рынок, роста маржинальности и расширения так называемого «общего адресуемого рынка» (TAM). В Wistron утверждают, что новая модель выгодна и заказчикам, поскольку ключевые работы по созданию ИИ-оборудования всё равно выполняет компания-подрядчик. В целом NVIDIA стремится перейти от роли обычного поставщика ИИ-чипов к модели, при которой IT-гигант контролирует развёртывание инфраструктуры целиком. Это как ускорит выпуск ИИ-систем, так и укрепит позиции компании. Впрочем, пока информация об изменениях поступает из сторонних источников — в самой NVIDIA её не подтверждали. При этом для гиперскейлеров, которые самостоятельно занимаются разработкой ИИ-платформ, пока, по-видимому, ничего не поменяется.

14.11.2025 [09:38], Сергей Карасёв

«За пределы экзафлопсного уровня»: Eviden представила суперкомпьютерную платформу BullSequana XH3500Компания Eviden, входящая в Atos Group, анонсировала конвергентную суперкомпьютерную платформу BullSequana XH3500 для ресурсоёмких нагрузок ИИ и HPC. Новинка сочетает передовые аппаратные решения с комплексной экосистемой ПО, обеспечивая возможность масштабирования «за пределы экзафлопсного уровня». BullSequana XH3500 использует открытую модульную конструкцию. Такой подход позволяет свободно комбинировать блоки CPU, GPU и сетевые компоненты от различных производителей, адаптируя конфигурации под определённые потребности. При этом устраняется зависимость от какого-либо конкретного поставщика оборудования, что обеспечивает полную технологическую свободу. По заявлениям Eviden, платформа BullSequana XH3500 по сравнению с системой предыдущего поколения позволяет добиться повышения электрической мощности более чем на 80 % в расчёте на 1 м2 и увеличения эффективности охлаждения на 30 % в расчёт на 1 кВт. Это даёт возможность удовлетворить растущие потребности в вычислительных ресурсах без необходимости расширения площадей в дата-центрах. Габариты стойки BullSequana XH3500 без модуля ультраконденсатора составляют 2270 × 900 × 1457 мм. Мощность AC достигает 284 кВт (с одной помпой). Задействовано на 100 % безвентиляторное прямое жидкостное охлаждение (DLC) пятого поколения с возможностью использования горячей воды с температурой до 40 °C. Подсистемы питания и охлаждения выполнены по схеме с резервированием N+1. Доступны 38 универсальных слотов 1U.

Источник изображения: Eviden Для платформы BullSequana XH3500 разработаны узлы BullSequana XH3515B и BullSequana AI1242. Первый соответствует типоразмеру 1U: это одноузловое изделие оборудовано двумя чипами NVIDIA Grace CPU и четырьмя ускорителями NVIDIA Blackwell B200. Возможна установка до девяти NVMe SSD в форм-факторе E1.S. Говорится о поддержке четырёх сетевых устройств Eviden BXI V3 или InfiniBand NDR/XDR. В свою очередь, сервер BullSequana AI1242 имеет исполнение 2U. Данное решение несёт на борту два процессора AMD EPYC Turin и GPU-ускоритель AMD Instinct MI355X. Реализована поддержка восьми устройств Eviden BXI V3 или InfiniBand NDR/XDR, а также четырёх накопителей E1.S NVMe SSD.

14.11.2025 [09:38], Сергей Карасёв

ИТ-холдинг Т1 представил первый ПАК для работы с ИИ-платформой «Сайбокс»Многопрофильный ИТ-холдинг Т1 анонсировал первый отечественный программно-аппаратный комплекс (ПАК), предназначенный для работы с ИИ-платформой «Сайбокс». Решение под названием «ИИ-Фабрика Сайбокс» представляет собой готовую серверную стойку, оснащённую всеми необходимыми компонентами для решения различных ресурсоёмких задач — от подготовки данных до обучения моделей и запуска ИИ-агентов. В основу новинки положен сервер МЛТ-С пятого поколения, созданный российской IT-компании «Мультиллект» (совместное предприятие компании «Азимут» госкорпорации «Ростех» и ИТ-холдинга Т1). Это двухпроцессорная система в форм-факторе 2U, обладающая поддержкой DDR5, PCIe 5.0 и CXL. Сервер совместим с основными системами виртуализации и широким спектром ПО. Он включён в Единый реестр российской радиоэлектронной продукции (Реестр РЭП), утверждённый Минпромторгом России. Машина сертифицирована для обработки и хранения данных, управления ИИ-приложениями и поддержки критической инфраструктуры.

Источник изображения: «Ростех» В состав ПАК входит отечественная MLOps-платформа «Сайбокс» для полного цикла работы с моделями машинного обучения. Она позволяет внедрять в текущие бизнес-процессы компании различные ИИ-сервисы (документооборот, видеоаналитика, промышленная диагностика, планирование ремонтов). Через встроенный маркетплейс можно выбрать готовое решение либо быстро создать ИИ-агента с помощью инструментария no-code/low-code. Упомянуты такие возможности, как запуск, дообучение и объединение больших языковых моделей, реализация RAG-сценариев, интеграция с Hugging Face без внешних зависимостей. «Наше решение — это не набор разрозненных компонентов, а протестированный и готовый к работе комплекс, который позволяет бизнесу получать современный функционал искусственного интеллекта "из коробки". Серверная часть уже хорошо зарекомендовала себя в пилотных проектах в компаниях различных отраслей. Формат полностью российского решения повышает устойчивость бизнеса к внешним и внутренним рискам и ускоряет внедрение инновационных сервисов», — говорит глава Т1. Отмечается, что «ИИ-Фабрика Сайбокс» может применяться в том числе на объектах критической информационной инфраструктуры. Среди потенциальных заказчиков названы предприятия энергетического сектора, транспортной отрасли и пр.

14.11.2025 [09:36], Сергей Карасёв

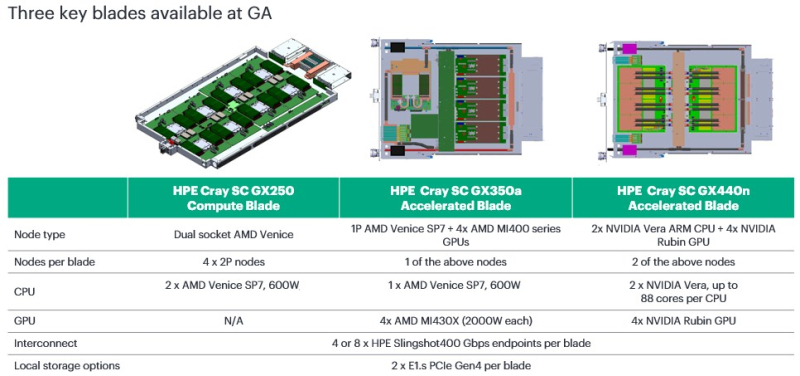

HPE представила CPU- и GPU-узлы суперкомпьютерной платформы Cray Supercomputing GX5000Компания HPE анонсировала новые решения для НРС-задач, являющиеся частью суперкомпьютерной платформы Cray Supercomputing GX5000. В частности, дебютировали узлы GX250 Compute Blade, GX350a Accelerated Blade и GX440n Accelerated Blade, а также высокопроизводительная СХД Storage Systems K3000. Устройство HPE Cray Supercomputing GX250 Compute Blade представляет собой CPU-сервер, оснащённый восемью процессорами AMD EPYC Venice (появятся во II половине 2026 года). В одной стойке могут быть размещены до 40 таких серверов, что обеспечивает самую высокую в отрасли плотность компоновки x86-ядер следующего поколения, говорит компания. В паре с CPU-узлами могут функционировать новые GPU-модули. Так, изделие HPE Cray Supercomputing GX350a Accelerated Blade несёт на борту один чип AMD EPYC Venice и четыре ускорителя AMD Instinct MI430X. В стойку могут устанавливаться до 28 таких серверов, что даёт в сумме 112 ускорителей MI430X. В свою очередь, HPE Cray Supercomputing GX440n Accelerated Blade содержит четыре NVIDIA Vera CPU и восемь NVIDIA Rubin GPU. Допускается монтаж до 24 подобных серверов на стойку, что обеспечивает 192 ускорителя Rubin. Все новинки оборудованы жидкостным охлаждением. СХД HPE Cray Supercomputing Storage Systems K3000 выполнена на сервере HPE ProLiant Compute DL360 Gen12. Могут устанавливаться 8, 12, 16 или 20 накопителей NVMe вместимостью 3,84, 7,68 или 15,36 Тбайт каждый. Объём памяти DRAM — 512 Гбайт, 1 или 2 Тбайт. Применяется платформа DAOS, разработанная для требовательных рабочих нагрузок, таких как анализ данных и машинное обучение. Поддерживаются технологии HPE Slingshot 200, HPE Slingshot 400, InfiniBand NDR и 400GbE. Кроме того, HPE сообщила о том, что для платформы HPE Cray Supercomputing GX5000 доступен интерконнект HPE Slingshot 400. Соответствующие коммутаторы с прямым жидкостным охлаждением наделены 64 портами на 400 Гбит/с. Возможны конфигурации с 8, 16 и 32 коммутаторами, что в сумме позволяет использовать до 512, 1024 и 2048 портов соответственно. О выборе платформы HPE Cray Supercomputing GX5000 для НРС-комплексов нового поколения уже объявили Центр высокопроизводительных вычислений Штутгартского университета (HLRS) и Центр суперкомпьютеров имени Лейбница (LRZ) Баварской академии естественных и гуманитарных наук (BADW). Кроме того, новая платформа является основой суперкомпьютера Discovery Министерства энергетики США (DOE). |

|