Материалы по тегу: epyc

|

11.01.2025 [02:00], Алексей Степин

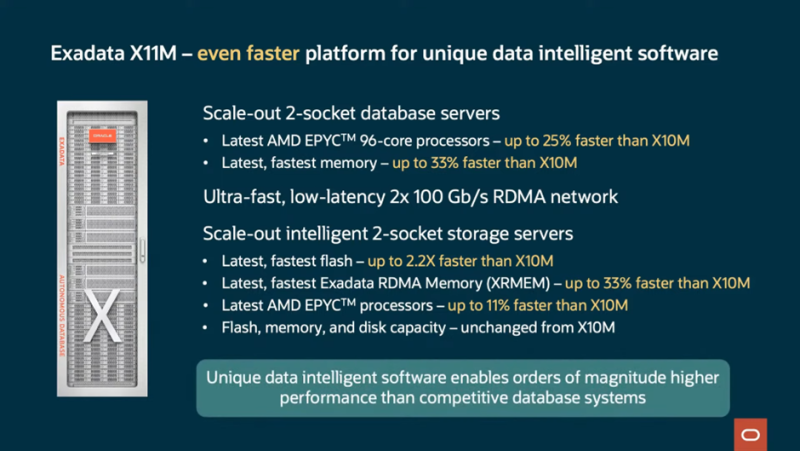

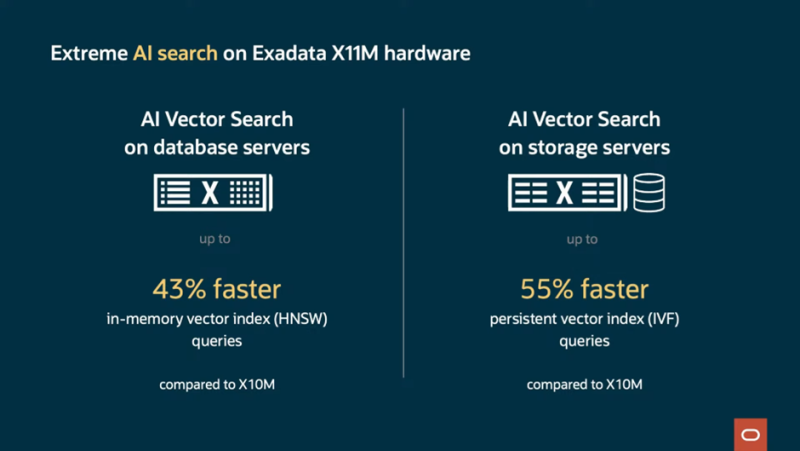

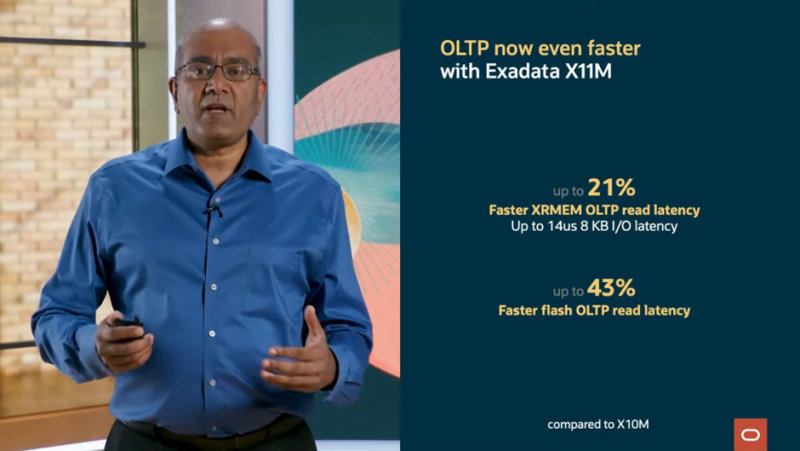

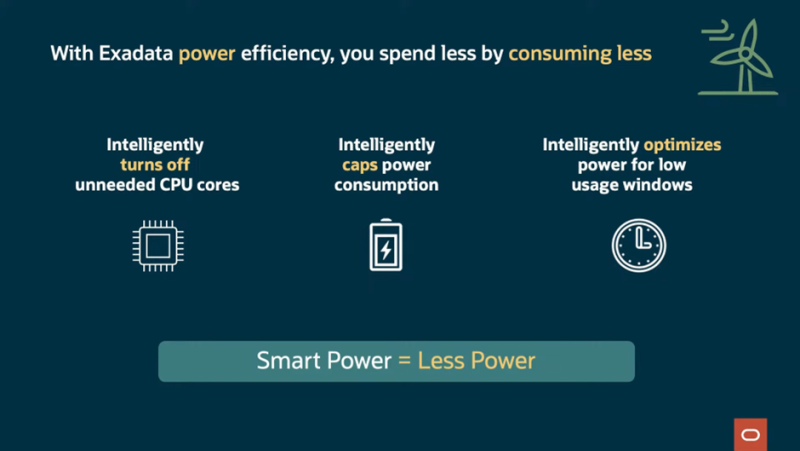

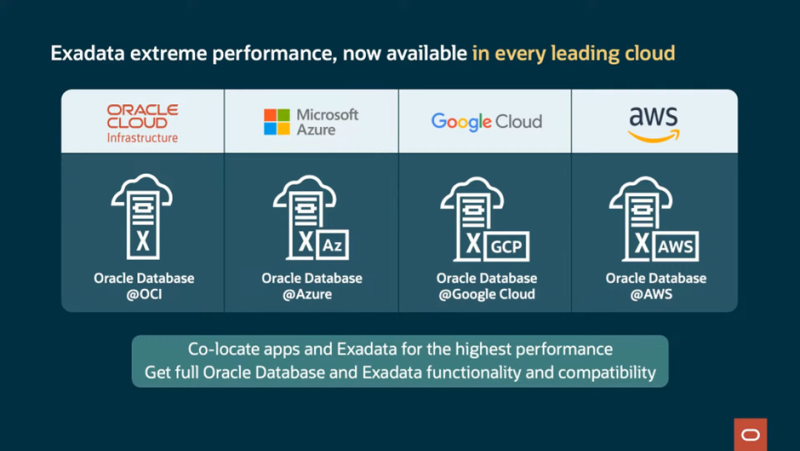

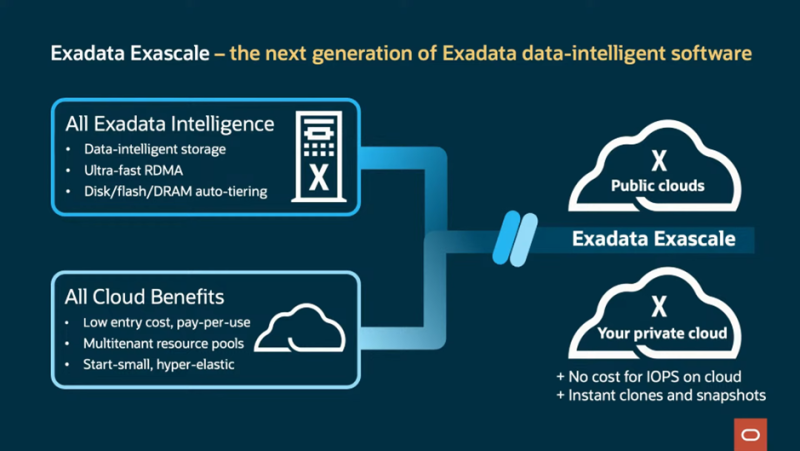

До 2280 ядер и 42 Тбайт RAM на стойку: Oracle представила СУБД-платформу Exadata X11MКомпания Oracle анонсировала новую версию СУБД-платформы Exadata. Ещё в предыдущем поколении, Exadata X10M, Oracle приняла решение отказаться от использования процессоров Intel Xeon. В Exadata X11M упор сделан на гибкость развёртывания: on-premise; в виде локального сервиса, управляемого Oracle; в сторонних облаках, в том числе в составе мультиоблачных конфигураций. Но и прирост производительности тоже заявлен солидный: новое поколение должно продемонстрировать на 55% возросшую скорость векторного поиска, который важен для обучения ИИ-моделей. Скорость сканирования данных выросла в 2,2 раза, а скорость обработки транзакций — на четверть. А на некоторых операциях прирост быстродействия достигает 32 раз. При этом новая платформа стоит столько же, сколько и предыдущая, говорит Oracle. Прирост производительности во многом обусловлен программными оптимизациями, но и аппаратную составляющую компания тоже подтянула. Основой Oracle Exadata X11M являются AMD EPYC, DDR5-6400, NVMe SSD и двухпортовые 100G-адаптеры. Каждый ДБ-сервер X11M содержит два 96-ядерных процессора AMD EPYC и 512 Гбайт RAM с возможностью расширения до 3 Тбайт. Впрочем, есть и конфигурация попроще — X11M-Z имеет один 32-ядерный EPYC и 768 Гбайт или 1,152 Тбайт памяти. В Exadata активно используется механизм RDMA, в том числе кеширующий слой Exadata RDMA Memory (XRMEM), на который уходит большая часть RAM. Серверы хранения данных представлены в трёх вариантах: с одним (HC-Z) либо двумя 32-ядерными процессорами (EF и HC) и памятью объёмом 768 Гбайт либо 1,5 Тбайт соответственно. Узлы хранения HC (High Capacity) включают четыре кеширующих 6,8-Тбайт NVMe-накопителя Flash Accelerator F680 v2 (PCIe 5.0) и двенадцать 22-Тбайт SAS HDD (7200 RPM). В узлах EF (Extreme Flash) вместо HDD используются четыре 30,72-Тбайт NVMe SSD. А узлы HC-Z от HC отличаются тем, что имеют лишь пару 6,8-Тбайт кеширующих NVMe SSD и шесть 22-Тбайт HDD. Минимальная конфигурация Exadata X11M состоит из двух серверов БД и трёх серверов хранения. Она обеспечивает скорость сканирования 135 Гбайт/с и предоставляет 1,9 Пбайт для хранения данных. Последнее достигнуто благодаря использованию гибридного сжатия Oracle Database Hybrid Columnar Compression. В максимальной конфигурации каждая стойка X11M может содержать до 2880 процессорных ядер, 42 Тбайт RAM, 462 Тбайт высокопроизводительной флеш-памяти и 2,2 Пбайт (SSD) или 4,4 Пбайт (HDD) общего дискового пространства. Сетевая часть представлена RoCE-фабрикой на базе двухпортовых адаптеров, работающих в режиме Active–Active. Всего в стойку можно установить от 3 до 15 серверов БД и от 3 до 17 серверов хранения данных. Конфигурация может быть расширена дополнительными стойками, подключаемыми посредством RoCE-интерконнекта, причём поддерживаются смешанные варианты, в которых совместно трудятся стойки Exadata X8M, X9M, X10M и X11M. Простоту масштабирования обеспечивают технологии Oracle Real Application Clusters (RAC) и Exadata Exascale and Automatic Storage Management (ASM). На сегодня Exadata X11M является наиболее продвинутой БД-платформой, сочетающей в себе высочайшую производительность работы с базами данных Oracle, гибкость конфигурации и широкие возможности выбора варианта развёртывания, будь то использование платформы в рамках AWS, Microsoft Azure и Google Cloud или размещение в ЦОД заказчика, говорит Oracle.

28.12.2024 [12:42], Сергей Карасёв

Итальянская нефтегазовая компания Eni запустила суперкомпьютер HPC6 с производительностью 478 ПфлопсИтальянский нефтегазовый гигант Eni запустил вычислительный комплекс HPC6. На сегодняшний день это самый мощный суперкомпьютер в Европе и один из самых производительных в мире: в свежем рейтинге TOP500 он занимает пятую позицию. О подготовке HPC6 сообщалось в начале 2024 года. В основу системы положены процессоры AMD EPYC Milan и ускорители AMD Instinct MI250X. Комплекс выполнен на платформе HPE Cray EX4000 с хранилищем HPE Cray ClusterStor E1000 и интерконнектом HPE Slingshot 11. В общей сложности в состав HPC6 входят 3472 узла, каждый из которых несёт на борту 64-ядерный CPU и четыре ускорителя. Таким образом, суммарное количество ускорителей Instinct MI250X составляет 13 888. Суперкомпьютер обладает FP64-быстродействием 477,9 Пфлопс в тесте Linpack (HPL), тогда как пиковый теоретический показатель достигает 606,97 Пфлопс. Максимальная потребляемая мощность системы составляет 10,17 МВА. Комплекс HPC6 смонтирован на площадке Eni Green Data Center в Феррера-Эрбоньоне: это, как утверждается, один из самых энергоэффективных и экологически чистых дата-центров в Европе. Новый суперкомпьютер оснащён системой прямого жидкостного охлаждения, которая способна рассеивать 96 % вырабатываемого тепла. ЦОД, где располагается HPC6, оборудован массивом солнечных батарей мощностью 1 МВт. Как отмечает ресурс Siliconangle, на создание суперкомпьютера потрачено более €100 млн. Применять комплекс планируется, в частности, для оптимизации работы промышленных предприятий, повышения точности геологических и гидродинамических исследований, разработки источников питания нового поколения, оптимизации цепочки поставок биотоплива, создания инновационных материалов и моделирования поведения плазмы при термоядерном синтезе с магнитным удержанием.

20.12.2024 [12:50], Сергей Карасёв

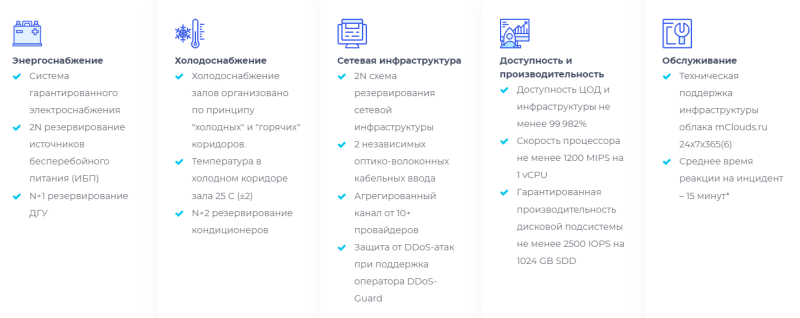

Провайдер mClouds запустил облачную GPU-платформу с чипами AMD EPYC Genoa и ускорителями NVIDIAРоссийский облачный провайдер mClouds объявил о запуске новой платформы на базе GPU для решения ресурсоёмких задач, таких как проектирование в BIM и CAD, рендеринг и обработка видео, машинное обучение, работа с нейросетями и пр. В основу платформы положены процессоры AMD EPYC 9374F поколения Genoa. Эти чипы насчитывают 32 ядра (64 потока инструкций) с тактовой частотой 3,85 ГГц и возможностью повышения до 4,1 ГГц. Стандартный показатель TDP равен 320 Вт. Доступны три базовые конфигурации облачной GPU-платформы: с ускорителями NVIDIA A16 (64 Гбайт памяти) для задач BIM и CAD, NVIDIA L40S (48 Гбайт) для сложных вычислений и рендеринга, а также с NVIDIA L4 (24 Гбайт) для нейросетевого обучения и аналитики. При этом можно добавлять необходимые ресурсы — vCPU, RAM и SSD. Доступны также средства резервного копирования и антивирусная защита Kaspersky Endpoint Security. Провайдер mClouds предлагает гибкие варианты конфигурирования под собственные нужды. Платформа размещена в аттестованном московском дата-центре NORD4 уровня Tier III Gold. Доступность сервиса заявлена на отметке 99,9998 % (по итогам 2023 года), а время реагирования на инциденты составляет менее 15 минут. В тарифы при аренде мощностей на базе GPU входят защита от DDoS-атак, каналы связи с пропускной способностью до 120 Мбит/с на каждый сервер, ОС Windows Server или Linux. «Наша платформа на базе AMD EPYC и NVIDIA выводит вычислительные возможности клиентов на совершенно новый уровень. Мы предоставляем клиентам не просто облачные ресурсы, а инструмент, который поможет им оставаться конкурентоспособными в условиях цифровой трансформации и ускорения внедрения ИИ в бизнесе», — говорит Александр Иванников, директор по развитию провайдера облачной инфраструктуры mClouds.

12.12.2024 [17:36], Сергей Карасёв

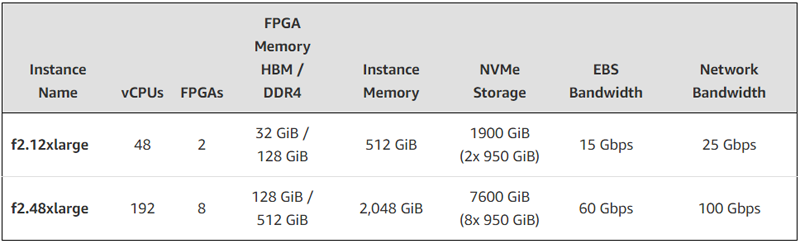

FPGA + EPYC: AWS представила AMD-инстансы EC2 F2 с процессорами Milan и ПЛИС Virtex UltraScale+Облачная платформа AWS анонсировала инстансы второго поколения с FPGA на борту. Экземпляры EC2 F2 ориентированы на решение задач в области геномики, обработки мультимедийных материалов, больших данных, спутниковой связи, компьютерных сетей, моделирования кремниевых чипов и видеотрансляций в реальном времени. В новых инстансах применяются FPGA AMD Virtex UltraScale+ HBM VU47P. Эти изделия содержат 2,852 млн логических ячеек и 9024 DSP. Заявленная ИИ-производительность достигает 28 TOPS при вычислениях INT8. Кроме того, в состав EC2 F2 входят процессоры AMD EPYC поколения Milan. Новые инстансы доступны в вариантах f2.12xlarge и f2.48xlarge — с 48 и 192 vCPU и 2 и 8 FPGA соответственно. Каждая ПЛИС оперирует 16 ГиБ памяти HBM и 64 ГиБ памяти DDR4. Таким образом, в случае f2.12xlarge используется в сумме 32 ГиБ HBM и 128 ГиБ DDR4, а в случае f2.48xlarge — 128 ГиБ и 512 ГиБ соответственно.

Источник изображения: AWS Конфигурация f2.12xlarge включает 512 ГиБ системной памяти и два накопителям NVMe SSD суммарной вместимостью 1900 ГиБ. Пропускная способность сетевого подключения составляет 25 Гбит/с, пропускная способность EBS-томов — 15 Гбит/с. У экземпляра f2.48xlarge объём памяти составляет 2048 ГиБ, общая вместимость NVMe SSD — 7600 ГиБ. Пропускная способность сетевого подключения и EBS-томов достигает 100 Гбит/с и 60 Гбит/с соответственно. Для этого экземпляра предусмотрена поддержка AWS Cloud Digital Interface (CDI) для надёжной передачи несжатого видео (задержка между инстансами заявлена на уровне 8 мс).

11.12.2024 [23:47], Владимир Мироненко

BadRAM: для обхода защиты виртуальных машин в процессорах AMD EPYC достаточно оборудования стоимостью всего $10

amd

cpu

ddr4

ddr5

dram

epyc

hardware

виртуализация

информационная безопасность

уязвимость

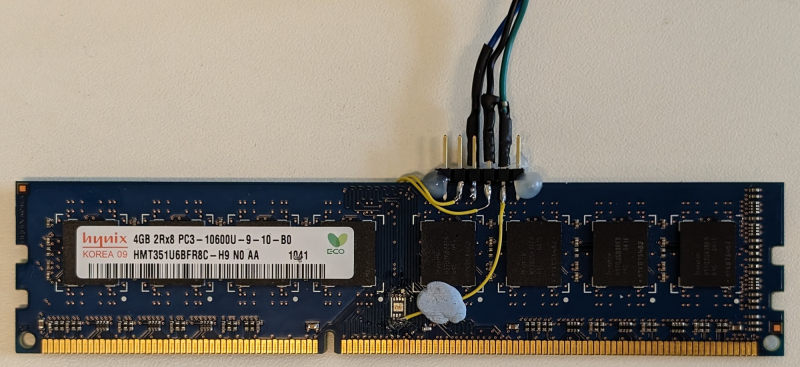

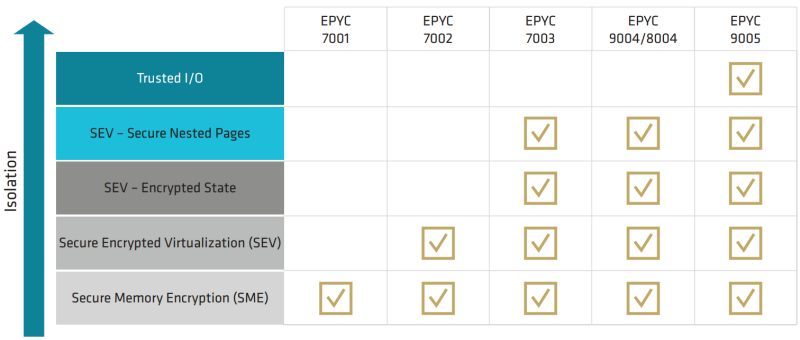

шифрование

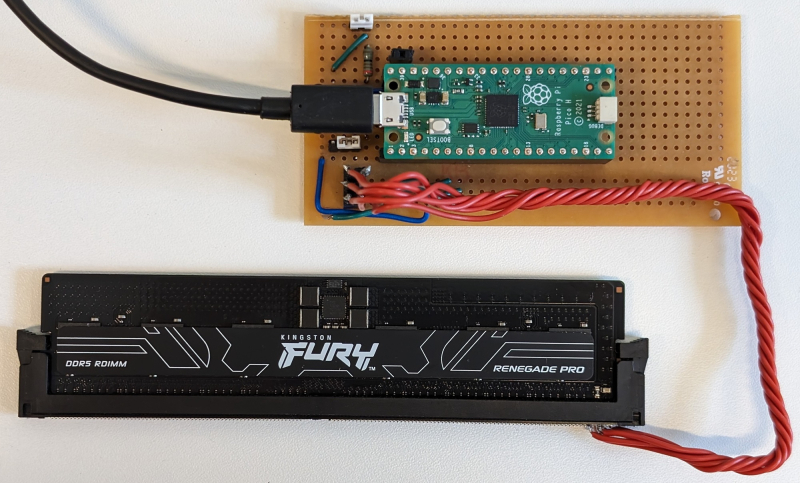

Исследователи Лёвенского католического университета (Бельгия), Любекского университета (Германия) и Бирмингемского университета (Великобритания) обнаружили, что система защиты виртуальных машин от атак с использованием вредоносного гипервизора AMD SEV-SNP (Secure Nested Paging), не так безопасна, как утверждает разработчик, пишет The Register. Технологии Secure Encrypted Virtualization (SEV) предоставляют доверенную среду исполнения (TEE), призванную обеспечить защиту виртуальных машин от незаконных попыток вмешательства со стороны тех, кто имеет доступ к оборудованию ЦОД. Механизм SEV-SNP реализован в процессорах AMD EPYC, начиная с 7003 (Milan). Аналогичные механизмы есть и у конкурентов: Intel Software Guard Extensions (SGX) и Trusted Domain Extensions (TDX), а также Arm Confidential Compute Architecture (CCA). Все эти технологии отвечают за шифрование памяти и изоляцию ресурсов. Исследователи разработали способ обхода SEV-SNP, который они назвали BadRAM (CVE-2024-21944 и AMD-SB-3015). Для атаки требуется оборудование стоимостью около $10, включая Raspberry Pi Pico, разъём DDR и батарею на 9 В. Атака BadRAM требует наличие физического доступа к оборудованию. Она основана на манипуляциях с чипом SPD (Serial Presence Detect), который передаёт данные о модуле DDR4/DDR5 во время загрузки системы. Манипулируя SPD, злоумышленники создают адреса-фантомы для физической памяти, благодаря которым можно незаметно получить доступ к данным в виртуальной машине. «Мы удваиваем видимый в системе объём DIMM, чтобы обмануть контроллер памяти CPU и заставить его использовать дополнительные «фантомные» биты адресации, — объясняют авторы исследования. — Два разных физических адреса теперь ссылаются на одно и то же местоположение DRAM». С помощью таких фантомов злоумышленники могут обойти защиту памяти, раскрывая конфиденциальные данные или вызывя сбои. BadRAM позволяет подделать критически важные отчёты удалённой аттестации и вставлять необнаруживаемые бэкдоры в любую виртуальную машину, защищённую SEV-SNP. Атака может быть реализована и без физического доступа к оборудованию, поскольку некоторые поставщики DRAM оставляют чип SPD разблокированным, что противоречит спецификациям JEDEC. Авторы исследования обнаружили по крайней мере два DDR4-модуля Corsair без должной защиты SPD. Память DDR3 тоже может быть взломана путём замены чипа SPD. «BadRAM полностью подрывает доверие к технологии защищённой зашифрованной виртуализации AMD (SEV-SNP), которая широко используется крупными поставщиками облачных услуг, включая Amazon AWS, Google Cloud и Microsoft Azure», — сообщил The Register Джо Ван Балк (Jo Van Bulck), профессор лаборатории DistriNet на кафедре компьютерных наук KU Leuven. Исследователи отметили, что решения SGX и TDX Intel не имеют такой уязвимости, поскольку в них реализованы контрмеры против создания псевдонимов (alias) памяти. Arm CCA, судя по спецификации, тоже не имеет проблем, но для проверки этого у исследователей не было коммерческих чипов. Полный доклад об атаке исследователи планируют представить в мае 2025 года на конференции IEEE Symposium on Security and Privacy. Исследователи уведомили AMD о найденных проблемах в феврале 2024 года. «AMD рекомендует использовать модули памяти, которые блокируют SPD, а также следовать передовым практикам в области физической безопасности систем. AMD также выпустила обновления прошивок защиты от уязвимости», — сообщили в AMD ресурсу The Register в ответ на просьбу прокомментировать публикацию исследователей.

20.11.2024 [12:11], Сергей Карасёв

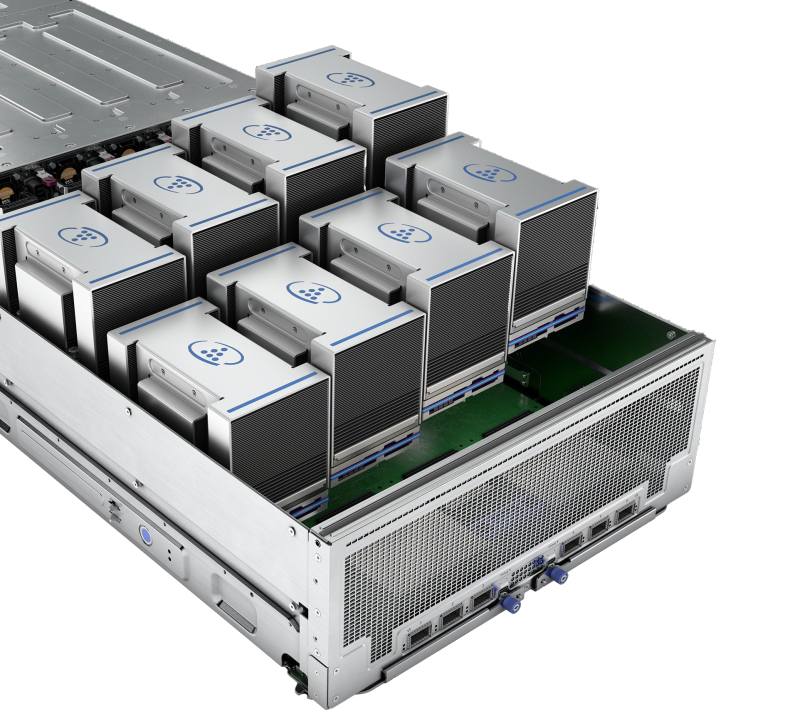

Dell представила ИИ-серверы PowerEdge XE9685L и XE7740Компания Dell анонсировала серверы PowerEdge XE9685L и PowerEdge XE7740, предназначенные для НРС и ресурсоёмких рабочих нагрузок ИИ. Устройства могут монтироваться в 19″ стойку высокой плотности Dell Integrated Rack 5000 (IR5000), что позволяет экономить место в дата-центрах.

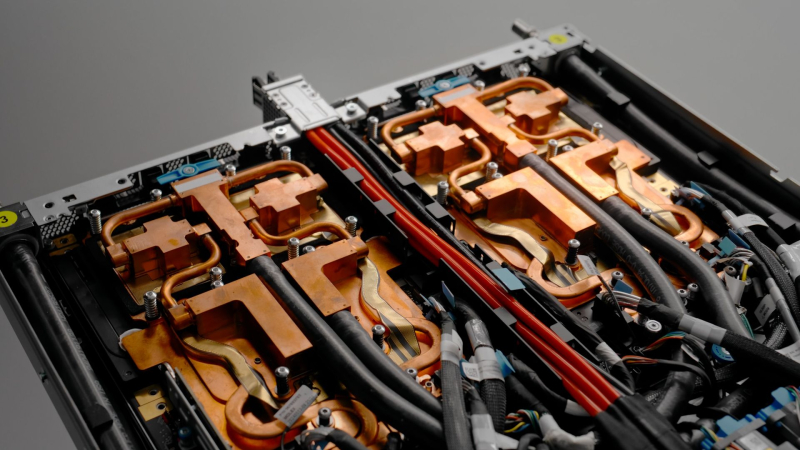

Источник изображений: Dell Модель PowerEdge XE9685L в форм-факторе 4U рассчитана на установку двух процессоров AMD EPYC Turin. Применяется жидкостное охлаждение. Доступны 12 слотов для карт расширения PCIe 5.0. Говорится о возможности использования ускорителей NVIDIA HGX H200 или B200. По заявлениям Dell, система PowerEdge XE9685L предлагает самую высокую в отрасли плотность GPU с поддержкой до 96 ускорителей NVIDIA в расчёте на стойку. Новинка подходит для организаций, решающих масштабные вычислительные задачи, такие как создание крупных моделей ИИ, запуск сложных симуляций или выполнение геномного секвенирования. Конструкция сервера обеспечивает оптимальные тепловые характеристики при высоких рабочих нагрузках, а наличие СЖО повышает энергоэффективность. Вторая модель, PowerEdge XE7740, также имеет типоразмер 4U, но использует воздушное охлаждение. Допускается установка двух процессоров Intel Xeon 6 на базе производительных ядер P-core (Granite Rapids). Заказчики смогут выбирать конфигурации с восемью ИИ-ускорителями двойной ширины, включая Intel Gaudi 3 и NVIDIA H200 NVL, а также с 16 ускорителями одинарной ширины, такими как NVIDIA L4. Сервер подходит для различных вариантов использования, например, для тонкой настройки генеративных моделей ИИ, инференса, аналитики данных и пр. Конструкция машины позволяет эффективно сбалансировать стоимость, производительность и масштабируемость. Dell также готовит к выпуску новый сервер PowerEdge XE на базе NVIDIA GB200 NVL4. Говорится о поддержке до 144 GPU на стойку формата 50OU (Dell IR7000).

20.11.2024 [10:56], Сергей Карасёв

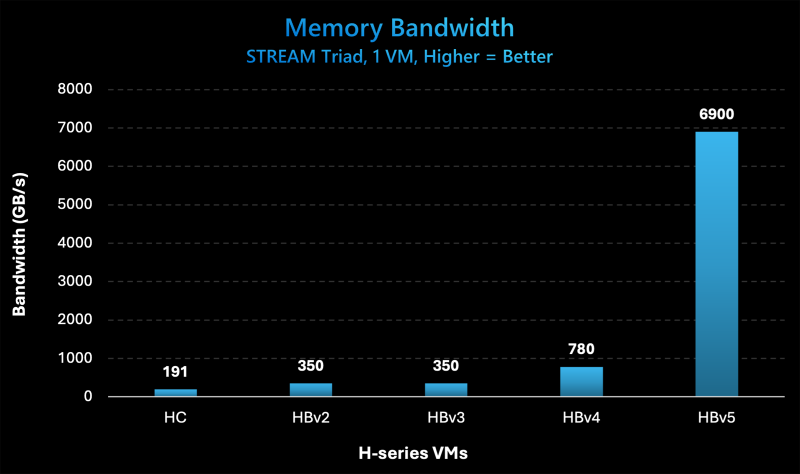

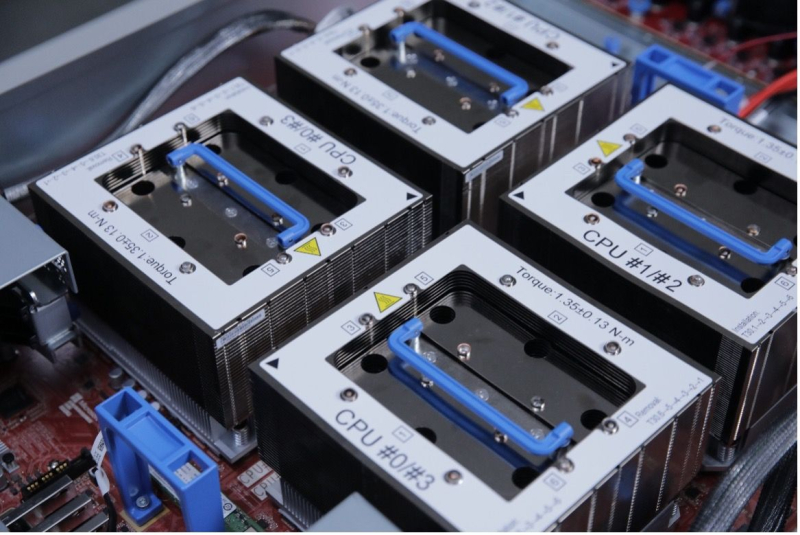

Microsoft представила инстансы Azure HBv5 на основе уникальных чипов AMD EPYC 9V64H с памятью HBM3Компания Microsoft на ежегодной конференции Ignite для разработчиков, IT-специалистов и партнёров анонсировала облачные инстансы Azure HBv5 для HPC-задач, которые предъявляют наиболее высокие требования к пропускной способности памяти. Новые виртуальные машины оптимизированы для таких приложений, как вычислительная гидродинамика, автомобильное и аэрокосмическое моделирование, прогнозирование погоды, исследования в области энергетики, автоматизированное проектирование и пр. Особенность Azure HBv5 заключается в использовании уникальных процессоров AMD EPYC 9V64H (поколения Genoa). Эти чипы насчитывают 88 вычислительных ядер Zen4, тактовая частота которых достигает 4 ГГц. Ближайшим родственником является изделие EPYC 9634, которое содержит 84 ядра (168 потоков) и функционирует на частоте до 3,7 ГГц. По данным ресурса ComputerBase.de, чип EPYC 9V64H также фигурирует под именем Instinct MI300C: по сути, это процессор EPYC, дополненный памятью HBM3. При этом клиентам предоставляется возможность кастомизации характеристик. Отметим, что ранее x86-процессоры с набортной памятью HBM2e были доступны в серии Intel Max (Xeon поколения Sapphire Rapids). Каждый инстанс Azure HBv5 объединяет четыре процессора EPYC 9V64H, что в сумме даёт 352 ядра. Система предоставляет доступ к 450 Гбайт памяти HBM3, пропускная способность которой достигает 6,9 Тбайт/с. Задействован интерконнект NVIDIA Quantum-2 InfiniBand со скоростью передачи данных до 200 Гбит/с в расчёте на CPU. Применены сетевые адаптеры Azure Boost NIC второго поколения, благодаря которым пропускная способность сети Azure Accelerated Networking находится на уровне 160 Гбит/с. Для локального хранилища на основе NVMe SSD заявлена скорость чтения информации до 50 Гбайт/с и скорость записи до 30 Гбайт/с. Отмечается, что по показателю пропускной способности памяти виртуальные машины Azure HBv5 примерно в 8 раз превосходят новейшие альтернативы bare-metal и cloud, в 20 раз опережают инстансы Azure HBv3 и Azure HBv2 (на базе EPYC Milan-X и EPYC Rome) и в 35 раз обходят HPC-серверы возрастом 4–5 лет, жизненный цикл которых приближается к завершению. Машины Azure HBv5 станут доступны в I половине 2025 года.

20.11.2024 [01:40], Владимир Мироненко

Microsoft представила кастомные чипы Azure Boost DPU и Integrated HSM, уникальный AMD EPYC 9V64H с HBM и собственный вариант NVIDIA GB200 NVL72

amd

azure arc

azure stack

dpu

epyc

gb200

hardware

hbm

hpc

microsoft

microsoft azure

nvidia

гибридное облако

ии

информационная безопасность

облако

ускоритель

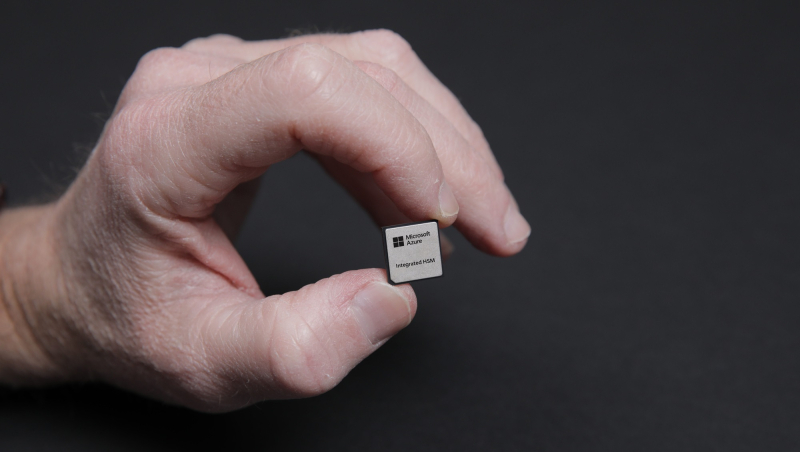

Microsoft представила на конференции Microsoft Ignite новые специализированные чипы Azure Boost DPU и Azure integrated Hardware Security Module (HSM), предназначенные для использования в ЦОД с целью поддержки рабочих нагрузок в облаке Azure и повышения безопасности.

Источник изображений: Microsoft Чтобы снизить зависимость от поставок чипов сторонних компаний, Microsoft занимается разработкой собственных решений для ЦОД. Например, на прошлогодней конференции Microsoft Ignite компания представила Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100 собственной разработки. Azure Boost DPU включает специализированные ускорители для работы с сетью и хранилищем, а также предлагает функции безопасности. Так, скорость работы с хранилищем у будущих инстансов Azure будет вчетверо выше, чем у нынешних, а энергоэффективность при этом вырастет втрое. Не вызывает сомнений, что в разработке Azure Boost DPU участвовали инженеры Fungible, производителя DPU, который Microsoft приобрела в декабре прошлого года. Как отмечает TechCrunch, в последние годы популярность DPU резко увеличилась. AWS разработала уже несколько поколений Nitro, Google совместно с Intel создала IPU, AMD предлагает DPU Pensando, а NVIDIA — BlueField. Есть и другие нишевые игроки. Согласно оценкам Allied Analytics, рынок чипов DPU может составить к 2031 году $5,5 млрд. Ещё один кастомный чип — Azure integrated Hardware Security Module (HSM) — отвечает за хранение цифровых криптографических подписей и ключей шифрования в защищённом модуле «без ущерба для производительности или увеличения задержки». «Azure Integrated HSM будет устанавливаться на каждом новом сервере в ЦОД Microsoft, начиная со следующего года, чтобы повысить защиту всего парка оборудования Azure как для конфиденциальных, так и для общих рабочих нагрузок», — заявила Microsoft. Azure Integrated HSM работает со всем стеком Azure, обеспечивая сквозную безопасность и защиту. Microsoft также объявила, что задействует ускорители NVIDIA Blackwell и кастомные серверные процессоры AMD EPYC. Так, инстансы Azure ND GB200 v6 будут использовать суперускорители NVIDIA GB200 NVL 72 в собственном исполнении Microsoft, а интерконнект Quantum InfiniBand позволит объединить десятки тысяч ускорителей Blackwell. Компания стремительно наращивает закупки этих систем. А инстансы Azure HBv5 получат уникальные 88-ядерные AMD EPYC 9V64H с памятью HBM, которые будут доступны только в облаке Azure. Каждый инстанс включает четыре таких CPU и до 450 Гбайт памяти с агрегированной пропускной способностью 6,9 Тбайт/с. Кроме того, Microsoft анонсировала новое решение Azure Local, которое заменит семейство Azure Stack. Azure Local — это облачная гибридная инфраструктурная платформа, поддерживаемая Azure Arc, которая объединяет локальные среды с «большим» облаком Azure. По словам компании, клиенты получат обновление до Azure Local в автоматическом режиме. Наконец, Microsoft анонсировала новые возможности в Azure AI Foundry, новой «унифицированной» платформе приложений ИИ, где организации смогут проектировать, настраивать и управлять своими приложениями и агентами ИИ. В числе новых опций — Azure AI Foundry SDK (пока в виде превью).

19.11.2024 [23:28], Алексей Степин

HPE обновила HPC-портфолио: узлы Cray EX, СХД E2000, ИИ-серверы ProLiant XD и 400G-интерконнект Slingshot

400gbe

amd

epyc

gb200

h200

habana

hardware

hpc

hpe

intel

mi300

nvidia

sc24

turin

ии

интерконнект

суперкомпьютер

схд

Компания HPE анонсировала обновление модельного ряда HPC-систем HPE Cray Supercomputing EX, а также представила новые модели серверов из серии Proliant. По словам компании, новые HPC-решения предназначены в первую очередь для научно-исследовательских институтов, работающих над решением ресурсоёмких задач.

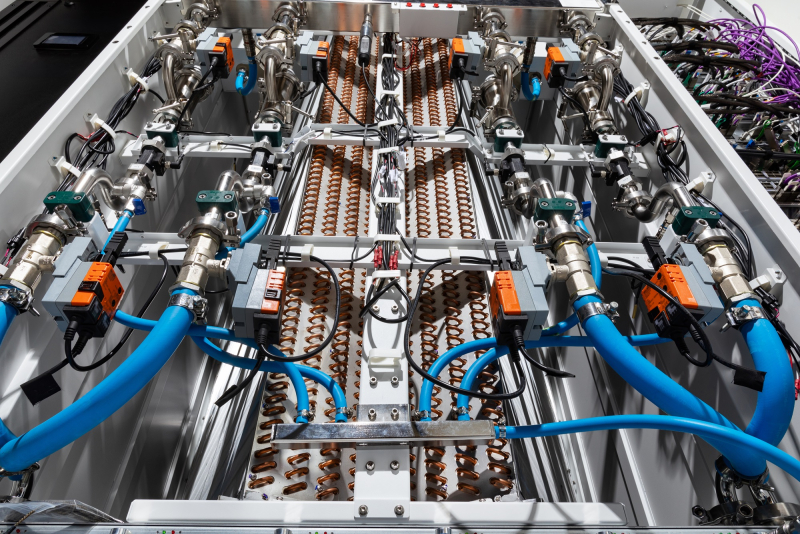

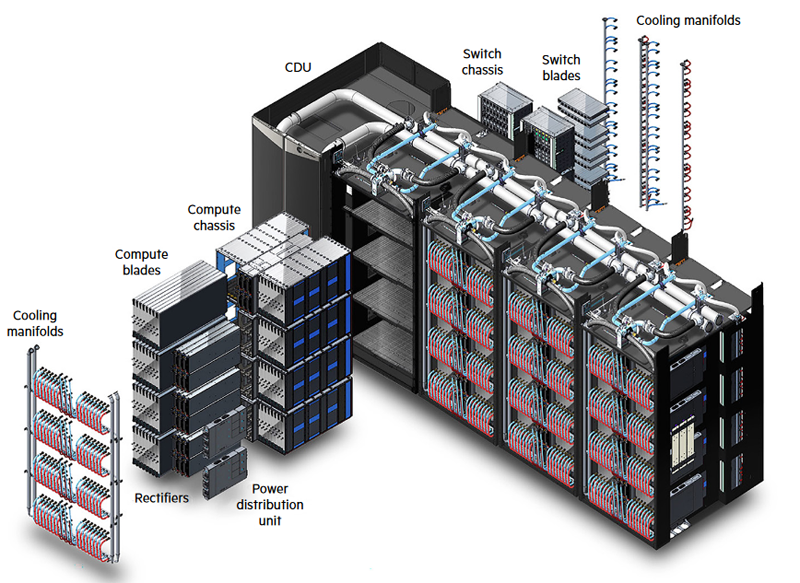

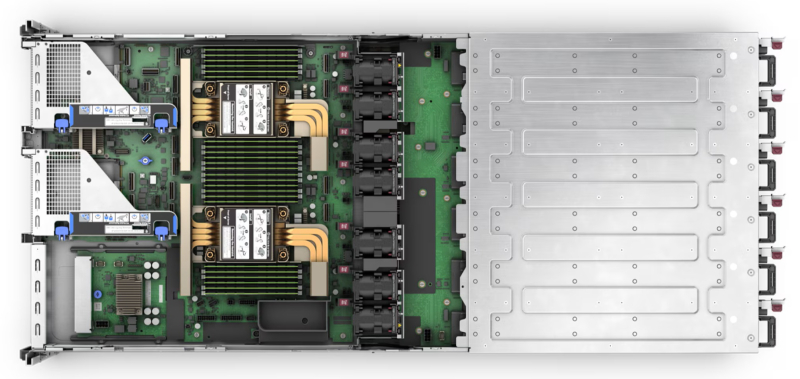

Источник изображений: HPE Обновление касается всех компонентов HPE Cray Supercomputing EX. Открывают список новые процессорные модули HPE Cray Supercomputing EX4252 Gen 2 Compute Blade. В их основе лежит пятое поколение серверных процессоров AMD EPYС Turin, которое на сегодняшний день является самым высокоплотным x86-решениями. Новые модули позволят разместить до 98304 ядер в одном шкафу. Отчасти это также заслуга фирменной системы прямого жидкостного охлаждения. Она охватывает все части суперкомпьютера, включая СХД и сетевые коммутаторы. Начало поставок узлов намечено на весну 2025 года. Процессорные «лезвия» дополнены новыми GPU-модулями HPE Cray Supercomputing EX154n Accelerator Blade, позволяющими разместить в одном шкафу до 224 ускорителей NVIDIA Blackwell. Речь идёт о новейших сборках NVIDIA GB200 NVL4 Superchip. Этот компонент появится на рынке позднее — HPE говорит о конце 2025 года. Обновление коснулось и управляющего ПО HPE Cray Supercomputing User Services Software, получившего новые возможности для пользовательской оптимизации вычислений, в том числе путём управления энергопотреблением. Апдейт получит и фирменный интерконнект HPE Slingshot, который «дорастёт» до 400 Гбит/с, т.е. станет вдвое быстрее нынешнего поколения Slingshot. Пропускная способность коммутаторов составит 51,2 Тбит/c. В новом поколении будут реализованы функции автоматического устранения сетевых заторов и адаптивноой маршрутизации с минимальной латентностью. Дебютирует HPE Slingshot interconnect 400 осенью 2024 года. Ещё одна новинка — СХД HPE Cray Supercomputing Storage Systems E2000, специально разработанная для применения в суперкомпьютерах HPE Cray. В сравнении с предыдущим поколением, новая система должна обеспечить более чем двукратный прирост производительности: с 85 и 65 Гбайт/с до 190 и 140 Гбайт/с при чтении и записи соответственно. В основе новой СХД будет использована ФС Lustre. Появится Supercomputing Storage Systems E2000 уже в начале 2025 года. Что касается новинок из серии Proliant, то они, в отличие от вышеупомянутых решений HPE Cray, нацелены на рынок обычных ИИ-систем. 5U-сервер HPE ProLiant Compute XD680 с воздушным охлаждением представляет собой решение с оптимальным соотношением производительности к цене, рассчитанное как на обучение ИИ-моделей и их тюнинг, так и на инференс. Он оснащён восемью ускорителями Intel Gaudi3 и двумя процессорами Intel Xeon Emerald Rapids. Новинка поступит на рынок в декабре текущего года. Более производительный HPE ProLiant Compute XD685 всё так же выполнен в корпусе высотой 5U, но рассчитан на жидкостное охлаждение. Он будет оснащаться восемью ускорителями NVIDIA H200 в формате SXM, либо более новыми решениями Blackwell, но последняя конфигурация будет доступна не ранее 2025 года, когда ускорители поступят на рынок. Уже доступен ранее анонсированный вариант с восемью ускорителями AMD Instinict MI325X и процессорами AMD EPYC Turin.

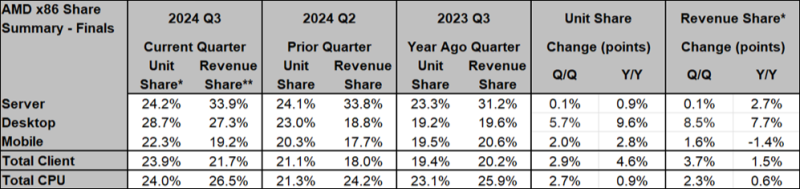

11.11.2024 [11:43], Сергей Карасёв

AMD наращивает долю на рынке серверных чипов на фоне проблем IntelКомпания AMD быстро укрепляет позиции на рынке процессоров с архитектурой х86. Причём, как сообщает ресурс Tom's Hardware, ссылаясь на данные аналитиков Mercury Research, речь идёт обо всех ключевых сегментах — серверном, настольном и мобильном. По итогам III квартала 2024 года доля AMD на глобальном рынке CPU с учётом всех сегментов достигла 24,0 % в штучном выражении. Для сравнения: во II четверти 2024-го этот показатель равнялся 21,3 %, а годом ранее — 23,1 %. Если рассматривать продажи в денежном исчислении, то AMD заняла 26,5 % против 24,2 % во II квартале текущего года и 25,9 % в III квартале 2023-го. AMD наращивает долю на рынке серверных чипов: показатель достиг 24,2 % в натуральном выражении. Во II четверти 2024 года компания контролировала 24,1 % сегмента, а годом ранее — 23,3 %. Если оценивать отгрузки в деньгах, то доля AMD зафиксирована на отметке 33,9 %. Кварталом ранее это значение составляло 33,8 %, а год назад — 31,2 %. В исследовании отмечается, что Intel остаётся лидером в области серверных процессоров с архитектурой х86: доля корпорации в III квартале 2024 года равна 75,8 %. Тем не менее, AMD смогла реализовать больше чипов высокого класса, на что указывает более высокая доля рынка в денежном выражении по сравнению с натуральным. Кроме того, впервые подразделение дата-центров AMD превзошло по выручке группу DCAI в составе Intel — $3,549 млрд против $3,3 млрд по итогам III квартала 2024 года. Отчёт не включает заказные чипы AMD, которые устанавливаются в игровые консоли, а также процессоры для оборудования IoT. Успехи AMD отчасти связаны с проблемами Intel, которая оказалась в очень сложном положении: она борется с жёсткой конкуренцией, а прогресс в сфере ИИ оставляет желать лучшего. Intel вынуждена сокращать тысячи сотрудников по всему миру, уменьшать офисные площади и отказываться от неактуальных продуктов ради улучшения финансовых показателей. |

|