Материалы по тегу: milan

|

28.04.2025 [14:48], Сергей Карасёв

ИИ-суперкомпьютер в чемодане — GigaIO Gryf обеспечит производительность до 30 ТфлопсКомпания GigaIO объявила о доступности системы Gryf — так называемого ИИ-суперкомпьютера в чемодане, разработанного в сотрудничестве с SourceCode. Это сравнительно компактное устройство, как утверждается, обеспечивает производительность ЦОД-класса для периферийных развёртываний. Первая информация о Gryf появилась около года назад. Устройство выполнено в корпусе с габаритами 228,6 × 355,6 × 622,3 мм, а масса составляет примерно 25 кг. Система может эксплуатироваться при температурах от +10 до +32 °C. Конструкция предусматривает использование модулей Sled четырёх типов: это вычислительный узел Compute Sled, блок ускорителя Accelerator Sled, узел хранения Storage Sled и сетевой блок Network Sled. Доступны различные конфигурации, но суммарное количество модулей Sled в составе Gryf не превышает шести. Плюс к этому в любой комплектации устанавливается модуль питания с двумя блоками мощностью 2500 Вт. Узел Compute Sled содержит процессор AMD EPYC 7003 Milan с 16, 32 или 64 ядрами, до 512 Гбайт DDR4, системный SSD формата M.2 (NVMe) вместимостью 512 Гбайт и два порта 100GbE QSFP56. Блок Storage Sled объединяет восемь накопителей NVMe SSD E1.L суммарной вместимостью до 492 Тбайт. Модуль Network Sled предоставляет два порта QSFP28 100GbE и шесть портов SFP28 25GbE. За ИИ-производительность отвечает модуль Accelerator Sled, который может нести на борту ускоритель NVIDIA L40S (48 Гбайт), H100 NVL (94 Гбайт) или H200 NVL (141 Гбайт). В максимальной конфигурации быстродействие в режиме FP64 достигает 30 Тфлопс (3,34 Пфлопс FP8), а пропускная способность памяти — 4,8 Тбайт/с.

Источник изображения: GigaIO Архитектура новинки обеспечивает возможность масштабирования путём объединения в единый комплекс до пяти экземпляров Gryf: в общей сложности можно совместить до 30 модулей Sled в той или иной конфигурации. Заказы на Gryf уже поступили со стороны Министерства обороны США, американских разведывательных структур и пр.

12.12.2024 [17:36], Сергей Карасёв

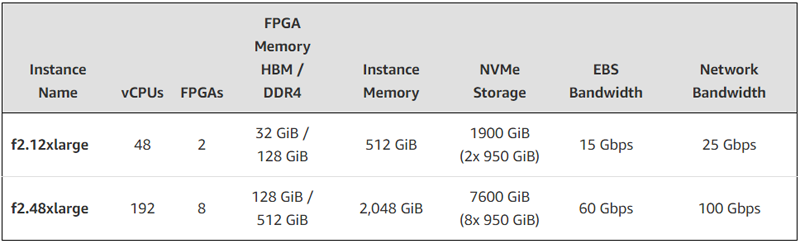

FPGA + EPYC: AWS представила AMD-инстансы EC2 F2 с процессорами Milan и ПЛИС Virtex UltraScale+Облачная платформа AWS анонсировала инстансы второго поколения с FPGA на борту. Экземпляры EC2 F2 ориентированы на решение задач в области геномики, обработки мультимедийных материалов, больших данных, спутниковой связи, компьютерных сетей, моделирования кремниевых чипов и видеотрансляций в реальном времени. В новых инстансах применяются FPGA AMD Virtex UltraScale+ HBM VU47P. Эти изделия содержат 2,852 млн логических ячеек и 9024 DSP. Заявленная ИИ-производительность достигает 28 TOPS при вычислениях INT8. Кроме того, в состав EC2 F2 входят процессоры AMD EPYC поколения Milan. Новые инстансы доступны в вариантах f2.12xlarge и f2.48xlarge — с 48 и 192 vCPU и 2 и 8 FPGA соответственно. Каждая ПЛИС оперирует 16 ГиБ памяти HBM и 64 ГиБ памяти DDR4. Таким образом, в случае f2.12xlarge используется в сумме 32 ГиБ HBM и 128 ГиБ DDR4, а в случае f2.48xlarge — 128 ГиБ и 512 ГиБ соответственно.

Источник изображения: AWS Конфигурация f2.12xlarge включает 512 ГиБ системной памяти и два накопителям NVMe SSD суммарной вместимостью 1900 ГиБ. Пропускная способность сетевого подключения составляет 25 Гбит/с, пропускная способность EBS-томов — 15 Гбит/с. У экземпляра f2.48xlarge объём памяти составляет 2048 ГиБ, общая вместимость NVMe SSD — 7600 ГиБ. Пропускная способность сетевого подключения и EBS-томов достигает 100 Гбит/с и 60 Гбит/с соответственно. Для этого экземпляра предусмотрена поддержка AWS Cloud Digital Interface (CDI) для надёжной передачи несжатого видео (задержка между инстансами заявлена на уровне 8 мс).

28.09.2024 [23:24], Сергей Карасёв

Индия запустила сразу пять суперкомпьютеров за два дня

a100

amd

atos

cascade lake-sp

epyc

eviden

hardware

hpc

intel

milan

nvidia

xeon

индия

метео

суперкомпьютер

Премьер-министр Индии Нарендра Моди, по сообщению The Register, объявил о вводе в эксплуатацию трёх новых высокопроизводительных вычислительных комплексов PARAM Rudra. Запуск этих суперкомпьютеров, как отмечается, является «символом экономической, социальной и промышленной политики» страны. Вдаваться в подробности о технических характеристиках машин Моди во время презентации не стал. Однако некоторую информацию раскрыли организации, которые займутся непосредственной эксплуатацией этих НРС-систем. Один из суперкомпьютеров располагается в Национальном центре радиоастрофизики Индии (NCRA). Данная машина оснащена «несколькими тысячами процессоров Intel» и 90 ускорителями NVIDIA A100, 35 Тбайт памяти и хранилищем вместимостью 2 Пбайт. Ещё один НРС-комплекс смонтирован в Центре фундаментальных наук имени С. Н. Бозе (SNBNCBS): известно, что он обладает быстродействием 838 Тфлопс. Оператором третьей системы является Межуниверситетский центр ускоренных вычислений (IUAC): этот суперкомпьютер с производительностью на уровне 3 Пфлопс использует 24-ядерные чипы Intel Xeon Cascade Lake-SP. Ёмкость хранилища составляет 4 Пбайт. Упомянут интерконнект с пропускной способностью 240 Гбит/с. The Register отмечает, что указанные характеристики в целом соответствуют описанию суперкомпьютеров Rudra первого поколения. Согласно имеющейся документации, такие машины используют:

Ожидается, что машины Rudra второго поколения получат поддержку процессоров Xeon Sapphire Rapids и четырёх GPU-ускорителей. Суперкомпьютеры третьего поколения будут использовать 96-ядерные Arm-процессоры AUM, разработанные индийским Центром развития передовых вычислений: эти изделия будут изготавливаться по 5-нм технологии TSMC. Между тем компания Eviden (дочерняя структура Atos) сообщила о поставках в Индию двух новых суперкомпьютеров. Один из них установлен в Индийском институте тропической метеорологии (IITM) в Пуне, второй — в Национальном центре среднесрочного прогнозирования погоды (NCMRWF) в Нойде. Эти системы, построенные на платформе BullSequana XH2000, предназначены для исследования погоды и климата. В создании комплексов приняли участие AMD, NVIDIA и DDN. Система IITM, получившая название ARKA, обладает быстродействием 11,77 Пфлопс: 3021 узел с AMD EPYC 7643 (Milan), 26 узлов с NVIDIA A100, NVIDIA Quantum InfiniBand и хранилище на 33 Пбайт (ранее говорилось о 3 Пбайт SSD + 29 Пбайт HDD). В свою очередь, суперкомпьютер NCMRWF под названием Arunika обладает производительностью 8,24 Пфлопс: 2115 узлов с AMD EPYC 7643 (Milan), NVIDIA Quantum InfiniBand и хранилище DDN EXAScaler ES400NVX2 (2 Пбайт SSD + 22 Пбайт HDD). Кроме того, эта система включает выделенный блок для приложений ИИ и машинного обучения с быстродействием 1,9 Пфлопс (точность не указана), состоящий из 18 узлов с NVIDIA A100.

08.05.2024 [13:24], Сергей Карасёв

ИИ-суперкомпьютер в чемодане — GigaIO представила платформу GryfКомпания GigaIO совместно с SourceCode анонсировала вычислительную систему Gryf. Это, как утверждается, первый в мире суперкомпьютер для ИИ-нагрузок, выполненный в виде чемодана на колёсиках. Изделие имеет габариты 228,6 × 355,6 × 622,3 мм и весит около 25 кг. Применяется фирменная система интерконнекта FabreX на базе PCI Express. Конфигурация Gryf предусматривает использование модулей (Sled) четырёх типов: это вычислительный узел (Compute Sled), блок ускорителя (Accelerator Sled), узел хранения (Storage Sled) и сетевой блок (Network Sled). Они могут компоноваться в различных сочетаниях, но общее количество модулей в рамках одного экземпляра Gryf не превышает шести. В состав Compute Sled входят процессор AMD EPYC 7313 Milan (16C/32T; 3,0–3,7 ГГц; 155 Вт), 256 Гбайт DDR4-3200, системный накопитель NVMe M.2 SSD вместимостью 256 Гбайт и два 100GbE-порта QSFP56/QSFP28. Может применяться ОС Linux Rocky 8/9 или Ubuntu 20/24. В свою очередь, Accelerator Sled содержит ускоритель NVIDIA L40S (48 Гбайт). Модуль Storage Sled объединяет восемь накопителей NVMe E1.L SSD суммарной вместимостью 246 Гбайт. Наконец, Network Sled предоставляет два разъёма QSFP56 100GbE и шесть 25GbE-портов SFP28. Вся система получает питание от двух блоков мощностью 2500 Вт каждый. Применены шесть вентиляторов охлаждения диаметром 60 мм. Диапазон рабочих температур — от 10 до +32 °C. Одно устройство Gryf обеспечивает производительность до 91,6 Тфлопс FP32, до 733 Тфлопс FP16 и до 1466 Тфлопс FP8. При этом в единый комплекс могут быть связаны до пяти экземпляров Gryf, что позволяет масштабировать быстродействие для выполнения тех или иных задач.

13.03.2024 [17:57], Сергей Карасёв

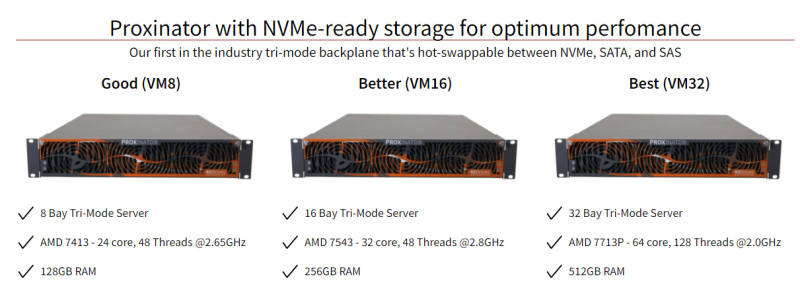

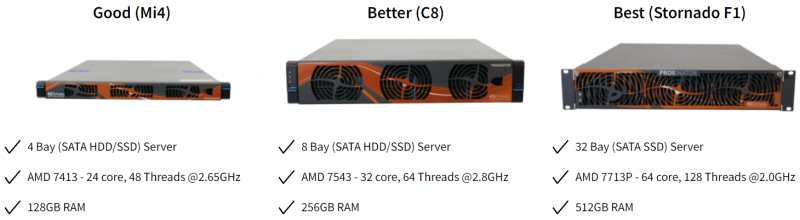

AMD EPYC + Proxmox: 45Drives предложила системы Proxinator в качестве альтернативы VMwareКанадская компания 45Drives анонсировала аппаратные решения семейства Proxinator, предназначенные для создания виртуальной инфратструктуры машин. В основу устройств, рассчитанных на монтаж в стойку, положена аппаратная платформа AMD с процессорами поколения EPYC Milan, дополненная инструментами Proxmox. Отмечается, что после поглощения компании VMware корпорацией Broadcom многие корпоративные пользователи начали искать альтернативные решения. Связано это с кардинальным изменением бизнес-модели VMware. В частности, Broadcom отменила бессрочные лицензии и перевела все продукты на подписную схему. Кроме того, были упразднены скидки и изменён подход к взаимодействию с партнёрами. 45Drives заявляет, что в поисках замены многие корпоративные клиенты не хотят снова становиться зависимыми от проприетарных решений. Системы Proxinator на базе открытого ПО, как утверждается, помогают избежать указанных рисков, одновременно предлагая высокую производительность. Используются платформа виртуализации Proxmox. Говорится, что в максимальной конфигурации на базе одного устройства Proxinator могут быть развёрнуты до 4 тыс. ВМ. В семейство Proxinator входят модели на процессорах AMD EPYC 7413, 7543 и 7713P с 24, 32 и 64 ядрами. Объём оперативной памяти составляет соответственно 128, 256 и 512 Гбайт. При необходимости размер ОЗУ может быть расширен до 2 Тбайт. Возможна установка HDD и SSD с интерфейсами SATA и SAS, а также высокоскоростных модулей NVMe. В зависимости от модификации предусмотрены отсеки для 4, 8, 16 или 32 накопителей. Для систем Proxinator компания 45Drives предлагает техническое обслуживание и всестороннюю поддержку. За $2500 разработчик произведёт настройку, тестирование и миграцию виртуальных машин vSphere. При миграции компания предлагает переиспользовать уже имеющиеся у клиента накопители.

10.08.2022 [22:05], Владимир Мироненко

На пути к Aurora: запущен «тренировочный» суперкомпьютер PolarisАргоннская национальная лаборатория (ANL) Министерства энергетики США объявила о доступности суперкомпьютера Polaris, ранний вариант которого занял 14-е место в последней версии списка TOP500. Он будет использоваться для проведения научных исследований и в качестве испытательного стенда для 2-Эфлопс суперкомпьютера Aurora, запуск которой намечен на ближайшие месяцы. Правда, аппаратно Aurora и Polaris отличаются. Созданная HPE система Polaris состоит из 560 узлов Apollo 6500, каждый из которых оснащён процессором AMD EPYC Milan, четырьмя ускорителями NVIDIA A100 (40 Гбайт) и 512 Гбайт DDR4-памяти. Эти узлы объединены в сеть интерконнектом HPE Slingshot 10 (осенью он будет обновлен до Slingshot 11) и подключены к сдвоенному 100-Пбайт Lustre-хранилищу (Grand и Eagle). Заявленная пиковая производительность должна составить 44 Пфлопс. «Polaris примерно в четыре раза быстрее нашего суперкомпьютера Theta, что делает его самым мощным компьютером в Аргонне на сегодняшний день», — отметил Майкл Папка (Michael Papka), директор Argonne Leadership Computing Facility (ALCF). Он добавил, что возможности Polaris позволят пользователям выполнять моделирование, анализ данных и ИИ-задачи с такими масштабом и скоростью, которые были невозможны с предыдущими вычислительными системами. Помимо работы над подготовкой к запуску Aurora, суперкомпьютер Polaris будет обслуживать внутренние потребности лаборатории, например, работу с комплексом Advanced Photon Source (APS) X-ray. «Благодаря тесной интеграции суперкомпьютеров ALCF с APS, CNM и другими экспериментальными установками мы можем помочь ускорить проведение анализа данных и предоставить информацию, которая позволит исследователям управлять своими экспериментами в режиме реального времени», — заявил Майкл Папка.

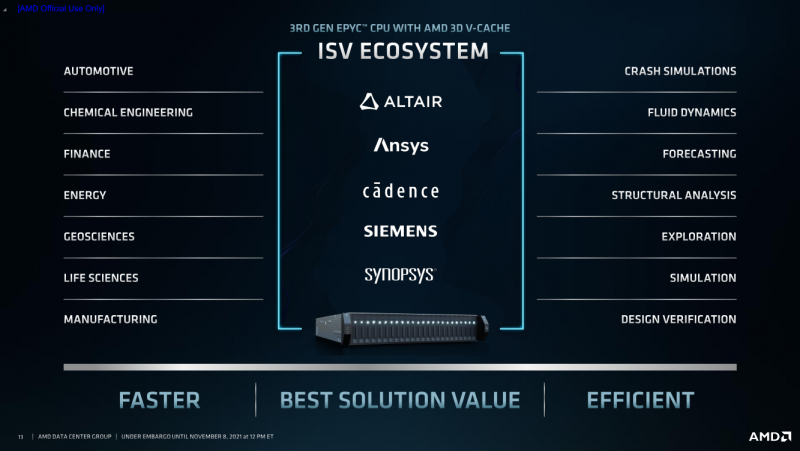

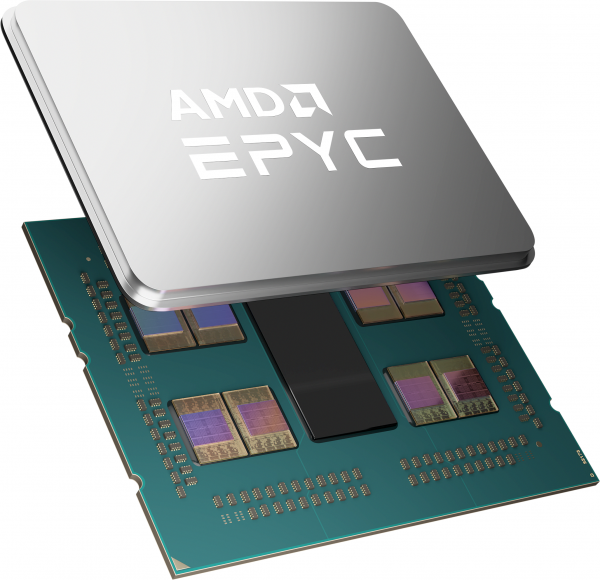

08.11.2021 [20:00], Игорь Осколков

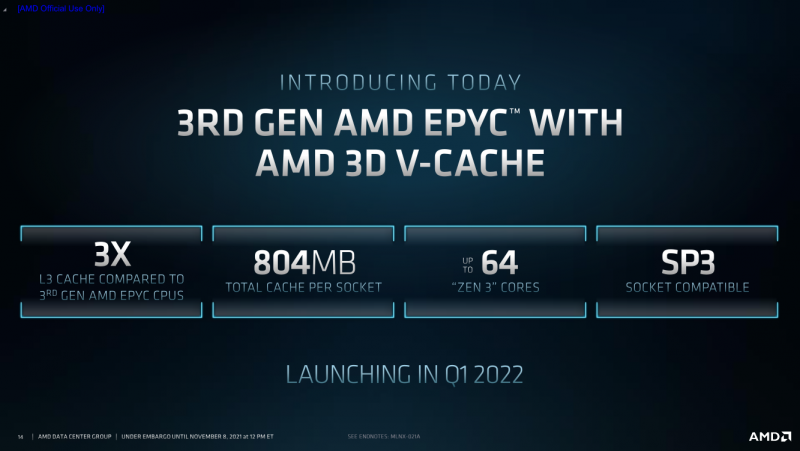

AMD анонсировала процессоры EPYC Milan-X с 3D V-Cache: 804 Мбайт кеша и 64 ядра Zen3AMD анонсировала серию своих серверных процессоров под кодовым названием Milan-X. Новинки являются развитием EPYC 7003 (Milan), представленных весной этого года, и рассчитаны в первую очередь на высокопроизводительные вычисления (HPC). Главным же отличием от «обычных» Milan станет резко увеличенный объём кеш-памяти, что позволило AMD снова назвать свои процессоры самими быстрыми в мире.

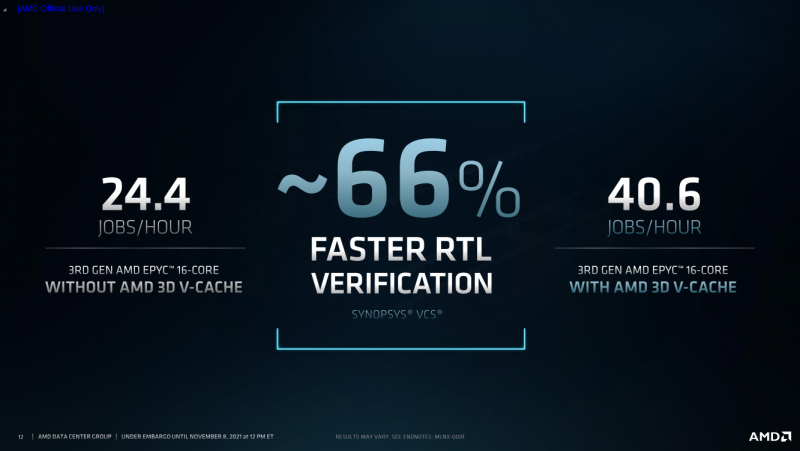

AMD EPYC Milan-X с 3D V-Cache (Здесь и ниже изобржаения AMD) Откуда берётся цифра в 804 Мбайт? Математика простая. На каждое ядро Zen3 приходится по 32 Кбайт L1-кеша для инструкций и данных + 512 Кбайт L2-кеша. На восемь ядер в CCX-комплексе приходится 32 Мбайт общего L3-кеша. И вот к ним добавляются ещё 64 Мбайт 3D V-Cache — в максимальной конфигурации на 8 CCX получается суммарно 768 Мбайт 3D V-Cache в дополнение к иерархии нижележащих кешей. Таким образом, конкретно по этому показателю побит рекорд IBM z15, хотя данный CPU ориентирован на совсем другие задачи. А вот среди x86-64 равных Milan-X сейчас нет. Более того, по словам AMD, реализация 3D V-Cache на текущий момент является уникальной в индустрии. Дополнительный кеш имеет непосредственно подключение к CCX по медным каналами, что позволяет значительно повысить плотность упаковки и энергоэффективность, снизить задержки и улучшить температурный режим. Правда, детальные характеристики V-Cache пока не приводятся.  Что важно, новинки будут совместимы с имеющимися SP3-платформами для Milan, что упростит тестирование и валидацию — для них будет выпущено обновление BIOS. Увы, пока данные по частотам, TDP и цене компания не приводит — выпуск Milan-X запланирован на I квартал 2022 года. Но в сносках к презентации, в частности, упоминаются не только 64-ядерные Milan-X, но и 16-ядерные. Надо полагать, что такие «бутерброды» будут дороже обычных CCX, поскольку здесь цена брака будет выше. Также заявлена совместимость с имеющимся ПО, но и с разработчиками уже ведётся активная работа по дополнительной оптимизации их решений. Наибольшую выгоду от увеличенного кеша получат нагрузки, для которых критична скорость работы с памятью и задержки доступа. Среди таковых AMD упоминает метод конечных элементов, структурный анализ, вычислительную гидродинамику и автоматизированные системы проектирования электроники (EDA). Для последних на примере Synopsys VCS рост производительности составил 66%.

28.05.2021 [00:33], Владимир Мироненко

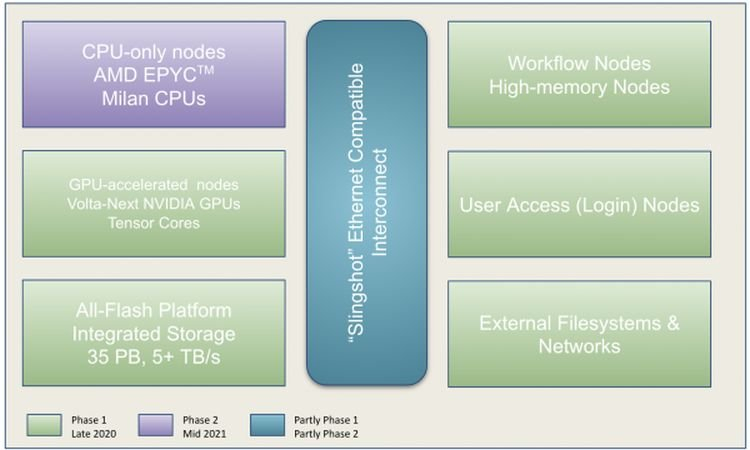

Perlmutter стал самым мощным ИИ-суперкомпьютером в мире: 6 тыс. NVIDIA A100 и 3,8 ЭфлопсВ Национальном вычислительном центре энергетических исследований США (NERSC) Национальной лаборатории им. Лоуренса в Беркли состоялась торжественная церемония, посвящённая официальному запуску суперкомпьютера Perlmutter, также известного как NERSC-9, созданного HPE в партнёрстве с NVIDIA и AMD. Это самый мощный в мире ИИ-суперкомпьютер, базирующийся на 6159 ускорителях NVIDIA A100 и примерно 1500 процессорах AMD EPYC Milan. Его пиковая производительность в вычислениях смешанной точности составляет 3,8 Эфлопс или почти 60 Пфлопс в FP64-вычислениях. Perlmutter основан на платформе HPE Cray EX с прямым жидкостным охлаждением и интерконнектом Slingshot. В состав системы входят как GPU-узлы, так и узлы с процессорами. Для хранения данных используется файловая система Lustre объёмом 35 Пбайт скорость обмена данными более 5 Тбайт/с, которая развёрнута на All-Flash СХД HPE ClusterStor E1000 (тоже, к слову, на базе AMD EPYC). Установка Perlmutter разбита на два этапа. На сегодняшней презентации было объявлено о завершении первого (Phase 1) этапа, который начался в ноябре прошлого года. В его рамках было установлено 1,5 тыс. вычислительных узлов, каждый из которых имеет четыре ускорителя NVIDIA A100, один процессор AMD EPYC Milan и 256 Гбайт памяти. На втором этапе (Phase 2) в конце 2021 года будут добавлены 3 тыс. CPU-узлов c двумя AMD EPYC Milan и 512 Гбайт памяти., а также ещё ещё 20 узлов доступа и четыре узла с большим объёмом памяти.

NERSC Также на первом этапе были развёрнуты служебные узлы, включая 20 узлов доступа пользователей, на которых можно подготавливать контейнеры с приложениями для последующего запуска на суперкомпьютере и использовать Kubernetes для оркестровки. Среда разработки будет включать NVDIA HPC SDK в дополнение к наборам компиляторов CCE (Cray Compiling Environment), GCC и LLVM для поддержки различных средств параллельного программирования, таких как MPI, OpenMP, CUDA и OpenACC для C, C ++ и Fortran. Сообщается, что для Perlmutter готовится более двух десятков заявок на вычисления в области астрофизики, прогнозирования изменений климата и в других сферах. Одной из задач для новой системы станет создание трёхмерной карты видимой Вселенной на основе данных от DESI (Dark Energy Spectroscopic Instrument). Ещё одно направление, для которого задействуют суперкомпьютер, посвящено материаловедению, изучению атомных взаимодействий, которые могут указать путь к созданию более эффективных батарей и биотоплива. |

|