Материалы по тегу: цод

|

14.11.2025 [16:35], Руслан Авдеев

Пузырь не страшен: JPMorgan прогнозирует, что затраты на ЦОД и ИИ-инфраструктуру составят $5 трлн, а спрос будет «астрономический»Как показал анализ, проведённый JPMorgan Chase & Co., в следующие пять лет на дата-центры, ИИ-инфраструктуру и связанные источники энергоснабжения потратят более $5 трлн, сообщает Datacenter Dynamics. В JPMorgan полагают, что придётся привлечь все публичные рынки капитала, а также частное кредитование, альтернативные источники капитала и даже правительственные средства. Ожидается, что в 2026–2030 гг. построят ЦОД общей мощностью 122 ГВт — масштаб спроса на вычисления будет оставаться «астрономическим». Если бы не дефицит электричества, ввели бы в эксплуатацию ещё больше дата-центров. Сроки поставок газовых турбин выросли до трёх-четырёх лет, а на строительство АЭС традиционно уходило более 10 лет. Своевременно добавить 150 ГВт — серьёзная задача, особенно в свете необходимости модернизации энергосистем. Ожидается, что финансирование волны ЦОД ускорит рост рынка государственных облигаций и рынка синдицированных кредитов после спада, вызванного COVID-19. Годовые потребности в финансировании ЦОД в 2026 году составят порядка $700 млрд, которые можно полностью профинансировать за счёт гиперскейлеров и рынков высоконадёжных облигаций. Тем не менее, к 2030 году потребности превысят $1,4 трлн, для чего потребуется привлекать все финансовые рынки, готовые предоставить капитал.

Источник изображения: Troy Mortier/unsplash.com Средства гиперскейлеров должны сыграть важную роль — эти компании генерируют операционный денежный поток более $700 млрд в год и реинвестируют $500 из них в капитальные затраты. При этом не учитываются порядка $250 млрд расходов на исследования и разработки. В следующие пять лет около $150 млрд поступит от заёмного финансирования и до $200 млрд — от секьюритизации ЦОД (выпуска облигаций под будущие доходы). Рынки высоконадёжных облигаций могут принести $300 млрд в виде инвестиций в ИИ ЦОД уже в следующем году или $1,5 трлн за пять лет. Даже с учётом множества источников средств JPMorgan ожидает, что дефицит финансирования составит $1,4 трлн. Его могло бы компенсировать частное кредитование наряду с более активной финансовой поддержкой со стороны государств, особенно на фоне всеобщего интереса к ИИ в контексте национальной обороны и суверенитета. Тем не менее, JPMorgan не исключает возникновения «ИИ-пузыря», аналогичного «пузырю доткомов» конца 1990-х гг. Также в отчёте уточняется, что для обеспечения 10 % доходности при моделировании инвестиций потребуется выручка на уровне $650 млрд в год, что невероятно много — для достижения таких результатов необходимо внедрять платный ИИ буквально везде. Даже если некоторые компании, работающие в сфере ИИ, получают прибыль, вероятнее всего, будут и «проигравшие», учитывая объёмы привлекаемого капитала и принципа «победитель получает всё» в некоторых сегментах ИИ-экосистемы. Тревожные рассуждения о возможном «пузыре» на рынке ИИ циркулируют уже не первый месяц. Так, в сентябре крах допустила Goldman Sachs, в октябре — Bank of England, а в ноябре The Wall Street Journal привела мнения экспертов Кремниевой долины, которые тоже допускают, что пузырь всё-таки «лопнет».

14.11.2025 [08:56], Руслан Авдеев

Microsoft запустила второй «самый передовой» ИИ ЦОД в мире по проекту Fairwater в рамках создания ИИ-суперфабрикиMicrosoft запустила в Атланте (Джорджия) второй ИИ ЦОД по проекту Fairwater, подключенный к первому ИИ ЦОД такого типа в Висконсине для создания вычислительного суперкластера. Связь ЦОД осуществляется с помощью выделенной оптоволоконной сети AI Wide Area Network (AI WAN), специально предназначенной для выполнения ИИ-задач. Размеры и мощность нового ЦОД пока не раскрываются, но дата-центры этой серии станут крупнейшими объектами за всю историю Microsoft, а, возможно, и в мире. В дата-центре используется замкнутая система жидкостного охлаждения, которую обслуживает одна из крупнейших в мире система чиллеров. Объект поддерживает стойки мощностью порядка 140 кВт (1360 кВт на ряд). В целом он использует сотни тысяч новейших ИИ-ускорителей NVIDIA GB200/GB300 NVL72, объединённых двухуровневой 800GbE-сетью с коммутаторами под управлением SONiC. Дата-центр в Атланте имеет два этажа, чтобы сократить расстояние между стойками во всех трёх измерениях. Для AI WAN компания совместно с OpenAI, NVIDIA и другими партнёрами создала и внедрила протокол Multi-Path Reliable Connected (MRC) для оптимальной связи между несколькими дата-центрами класса Fairwater во время обучения сверхкрупных моделей, которые «не помещаются» в один ЦОД. Общая протяжённость каналов AI WAN составляет более 193 тыс. км. В Microsoft отметили, что благодаря надёжной электросети Атланты удалось отказаться от проектов локальной генерации электроэнергии, специальных ИБП и двух линий питания, что сократило время запуска ЦОД и стоимость его эксплуатации. По словам компании, им удалось добиться доступности 99,99 % по цене 99,9 %. Дополнительно разработаны уникальные программные и аппаратные решения для управления энергопотреблением, сглаживающие колебания нагрузок на сеть, вызванные работой ИИ, в том числе за счёт введения вспомогательных заданий во время простоя, самоограничения мощности GPU и использования накопителей энергии на площадке. Microsoft вводит в эксплуатацию всё больше дата-центров проекта Fairwater и намерена объединить их в целую сеть, превратив дата-центры в распределённый виртуальный суперкомпьютер, способный решать проблемы способами, недоступные отдельны объектам. Как считают в компании, если традиционный дата-центр предназначен для запуска миллионов приложений для многочисленных клиентов, то «ИИ-суперфабрика» выполняет одну сложную задачу в миллионах ускорителей. У Microsoft стремительно растут капитальные затраты на ЦОД и ускорители. При этом топ-менеджеры Microsoft признают, что «на самом деле никто не хочет иметь дата-центр у себя на заднем дворе». Жители большинства регионов опасаются роста стоимость коммунальных услуг, ущерба экологии и др.

13.11.2025 [18:17], Руслан Авдеев

Google инвестирует €5,5 млрд в дата-центры в ГерманииGoogle намерена вложить €5,5 млрд ($6,4 млрд) в вычислительные ресурсы и расширение работы на территории Германии. Средства будут потрачены в следующие четыре года, сообщает Bloomberg. IT-гигант сделал соответствующее заявление во вторник в Берлине в ходе встречи представителей компании с местными федеральными министрами. В числе целей для инвестиций — два дата-центра в районе Франкфурта, их мощность не уточняется. Страны Европы стремятся в приоритетном порядке развивать отрасль ЦОД, поскольку опасаются дальнейшего технологического отставания в сфере ИИ от США и Китая. Еврокомиссия уже призвала создавать «гигафабрики» — дата-центры, способные обучать и обслуживать сложнейшие ИИ-модели. На прошлой неделе NVIDIA и Deutsche Telekom объявили о намерении строительства ИИ ЦОД стоимостью €1 млрд в Мюнхене, его открытие запланировано на начало 2026 года. Google подчеркнула, что будущие расходы в Германии — часть «постоянной верности Европе». Годами её приходилось отвечать на вызовы, создаваемые регуляторами региона, связанными с вопросами конфиденциальности, антимонопольного законодательства и авторских прав. Кроме того, компания боролась на этом рынке с Microsoft, безуспешно пытаясь привлечь к борьбе ассоциацию облачных провайдеров. В итоге она создала собственную организацию Open Cloud Coalition (OCC), которую Microsoft, в свою очередь, незамедлительно раскритиковала. В сентябре Google объявила о готовности потратить £5 млрд ($6,8 млрд) в Великобритании в следующие два года. Планы в отношении Германии предполагают расширение трёх офисов Google. Alphabet — материнская структура, стоящая за Google, рассчитывает, что в 2025 году капитальные затраты компании в мировом масштабе составят $93 млрд.

13.11.2025 [17:39], Руслан Авдеев

Меж болот и прерий: Meta✴ начала строительство юбилейного 30-го дата-центра за $1 млрдMeta✴ анонсировала строительство очередного ИИ ЦОД. Объект возведут в городе Бивер Дам (Beaver Dam, Висконсин). Это уже 30-й дата-центр компании по всему миру. Место выбрано благодаря лёгкому доступу к надёжной инфраструктуре и квалифицированной рабочей силе, сообщает Meta✴. Инвестиции в ЦОД в Бивер Дам площадью около 65 тыс. м2 превысят $1 млрд, будет поддерживаться работа более 100 штатных сотрудников. Также Meta✴ вложит около $200 млн в энергетическую инфраструктуру для покрытия расходов, связанных с дата-центром, включая обновление энергосетей, подстанций и ЛЭП. Дополнительно Meta✴ выделит $15 млн для принадлежащего Alliant Energy фонда Hometown Care Energy Fund, который поможет покрыть расходы на электроэнергию нуждающимся семьям. Питание дата-центра будет осуществляться за счёт 100 % «чистой» и возобновляемой энергии, сам объект получит сертификат LEED Gold Certification. Осенью 2026 года в рамках корпоративной программы Data Center Community Action Grants начнётся приём заявок на финансирование школ и местных организаций для внедрения технологий на пользу «общественного блага». Средства выделят на проекты, использующие технологии для развития сообщества, его устойчивости и на образование в сфере STEAM (наука, технология, инженерия, искусство и математика). Также местные малые бизнесы получат доступ к бесплатным программам обучения цифровым навыкам, помогающим использовать ИИ-инструменты, включая Meta✴ AI.

Источник изображений: Meta✴ Отдельное внимание уделено управлению водными и прочими ресурсами. Кампус Beaver Dam будет использовать технологии драйкулинга — это означает, что вода для охлаждения практически не потребуется. Также компания обещает восстановить 100 % воды в местных водных бассейнах, которые потребит ЦОД. Среди прочих мер называются сбор дождевой воды для дальнейшего использования, интеграция водосберегающих технологий на объектах ЦОД, а также благоустройство с использованием местной растительности для снижения потребностей в орошении. Наконец, в партнёрстве с Ducks Unlimited и прочими организациями будут восстановлены 230 га болотных угодий и прерий, окружающих дата-центр, из них 70 га будут переданы Ducks Unlimited для развития экосистем. Это позволит превратить «деградировавшие» болотные угодья в полные жизни, экологически богатые места обитания с тысячами птиц, животных и растений. Как сообщает Bloomberg, глава компании Марк Цукерберг (Mark Zuckerberg) неоднократно поддерживал агрессивные инвестиции в ИИ-инфраструктуру и постоянно говорит инвесторам о том, что лучше вложить в ИИ избыточные средства, чем недостаточные. До 2028 года компания инвестирует $600 млрд в США, значительная часть этих средств будет потрачена на чипы, дата-центры и оборудование. Meta✴ строит гигаваттные ЦОД в некоторых других штатах, включая Огайо, Техас и Луизиану.

13.11.2025 [12:12], Руслан Авдеев

Anthropic инвестирует $50 млрд в американскую ИИ-инфраструктуруИИ-стартап Anthropic объявил о намерении инвестировать $50 млрд в вычислительную инфраструктуру в США. Компания создаст ЦОД совместно с Fluidstack в Техасе, Нью-Йорке и других. местах. Объекты проектируются с учётом запросов Anthropic для обеспечения максимальной эффективности рабочих нагрузок. Fluidstack выбрана в качестве партнёра стартапа за «исключительную гибкость», позволяющую быстро получить гигаватты мощностей. Первые объекты должны ввести в эксплуатацию в 2026 году. ЦОД позволят создать 800 постоянных рабочих мест. План поможет выполнению инициативы администрации Дональда Трампа в области ИИ (AI Action Plan) — она направлена на сохранение лидерства США в сфере искусственного интеллекта. В компании заявляют, что приближаются к созданию ИИ, способного ускорить научные открытия и решать сложные задачи невозможными ранее способами. Для этого необходима инфраструктура, способная поддерживать непрерывное развитие — новые площадки помогут создавать более эффективные ИИ-системы, способные обеспечить новые исследовательские прорывы и создавать рабочие места для американцев. Anthropic с её ИИ-моделями Claude обслуживает более 300 тыс. корпоративных клиентов, а число клиентов, приносящих более $100 тыс. ежегодно, за последний год выросло почти в семь раз. Огромный масштаб инвестиций необходим для удовлетворения растущего спроса на Claude среди сотен тысяч компаний с сохранением передовых позиций в сфере исследований ИИ-технологий. В компании обещают отдавать приоритет «экономически эффективным» и «капиталоэффективным» подходам для достижения своих целей. По данным Datacenter Dynamics, в случае с техасским ЦОД, возможно, речь идёт о ранее анонсированном объекте Fluidstack и TeraWulf на 168 МВт в Абернати (Abernathy) или о совместном c Cipher Mining проекте на 244 МВт. В случае с Нью-Йоркским ЦОД, речь, возможно, идёт о кампусе Lake Mariner — совместном проекте Fluidstack и TeraWulf. Google, имеющая долю 14 % в Anthropic, поддержала оба проекта с участием TeraWulf. Ранее в этом году компания обеспечила гарантии по её кредитам, а также предоставила гарантии по арендным обязательствам Fluidstack на сумму $1,4 млрд для сделки с Cipher, получив в TeraWulf долю 5,4 %, а в бизнесе Fluidstack — 14 %. В октябре Anthropic анонсировала сделку с Google Cloud объёмом более 1 ГВт, которая даст ей доступ к миллиону ускорителей Google TPU. Предстоит уточнить, идёт ли в новом анонсе Anthropic речь о том же самом контракте с участием Fluidstack в качестве посредника — или речь идёт о новой сделке. AWS тоже владеет долей в Anthropic. В октябре она запустила для Anthropic кластер Project Rainier на основе собственных ИИ-ускорителей Tranium2. На площадку потратят $11 млрд (при полной загрузке). Стоимость вычислений Anthropic растёт, но The Information располагает информацией, что ИИ-стартап надеется использовать более эффективные модели, требующие меньших вычислительных мощностей в пересчёте на каждого пользователя. Это снизит затраты и позволит скорее добиться прибыльности бизнеса. По оценкам, $50 млрд инвестиций дадут компании доступ к примерно 5 ГВт ЦОД.

12.11.2025 [17:12], Руслан Авдеев

Конкуренция на рынке аккумуляторных энергохранилищ США скажется на ЦОД — у КНР более дешёвые и качественные АКБ

catl

hardware

jefferies

tesla

дефицит

ибп

ии

китай

прогноз

санкции

сша

цод

электропитание

энергетика

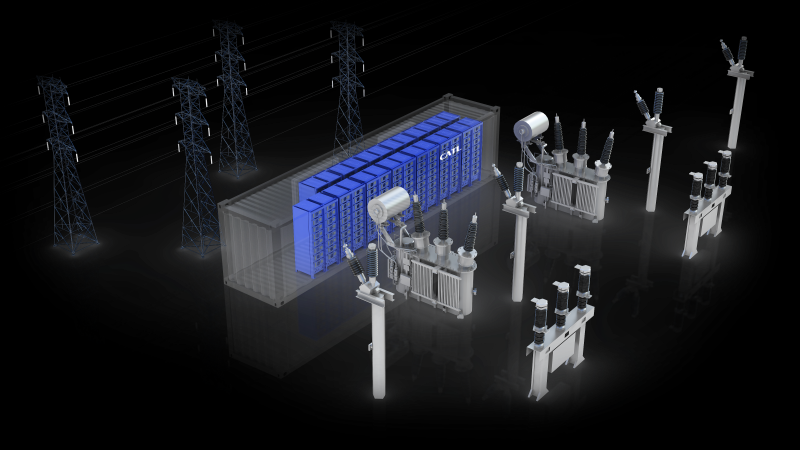

Аккумуляторные энергохранилища (BESS) в скором будущем могут стать стандартом для дата-центров по мере расширения инфраструктуры ИИ ЦОД. Тем не менее американских экспертов настораживает существующая на рынке тенденция — аккумуляторные решения из США во многом уступают китайским аналогам, сообщает The Register. В распоряжение издания попали материалы аналитической компании Jefferies. В отчёте подчёркивается, что гиперскейлеры, строящие ИИ ЦОД, всё больше рассматривают BESS в качестве неотъемлемой части энергетической инфраструктуры. Они всё чаще обращаются к проектам локальной генерации или испытывают проблемы с присоединением к энергосетям, поэтому BESS рассматривается как дополнительный ресурс, позволяющий управлять нагрузками, ускорить подключение и получить избыточные резервы энергии. Аккумуляторные системы используют в качестве резервных наряду с генераторами и другими вариантами получения энергии вроде твёрдооксидных топливных элементов. В Jefferies ожидают, что применение BESS будет расти в связи с трудностями коммунальных служб, которым трудно справиться с ростом спроса на электричество со стороны владельце электромобилей и расширением рынка дата-центров. В отчёте отмечается, что аккумуляторные решения — одна из немногих безуглеродных технологий, которым пророчат процветание при новой администрации США, даже за пределами рынка ЦОД. В следующее десятилетие будут развёрнуты минимум 20 ГВт аккумуляторных энергохранилищ. Наиболее вероятным будет применение литий-железо-фосфатных (LFP или LiFePO4) решений с 2–4-часовым циклом. При этом операторы ЦОД, вероятно, найдут китайские решения более привлекательными как по качеству, так и по цене, но это достаточно рискованный выбор в политической плоскости.

Источник изображения: CATL Наиболее перспективными в Jefferies называют китайских поставщиков CATL и Sungrow. Китайские системы значительно дешевле и совершеннее с точки зрения плотности хранения энергии и эффективности в целом, а последние данные свидетельствуют о росте китайского экспорта. Аналитики полагают, что Китай сохранит преимущество на рынке США и останется весьма конкурентоспособным. Так, в отчёте подчёркивается, что даже налоговая льгота в 40–50 % для произведённых в США систем всё равно не способна сделать китайские альтернативы неконкурентоспособными. Некоторые штаты и коммунальные службы в США, возможно, избегают китайских BESS из-за угроз кибербезопасности. Jefferies называет решения Tesla и Fluence Energy приемлемыми альтернативами. Наилучшие позиции из американских поставщиков для ИИ ЦОД занимает Tesla с решениями Megapack и Megablock. Ожидаемо, что одним из немногих кампусов ЦОД, объявивших о партнёрстве с Tesla, стала xAI (Colossus 1 и Colossus 2), рассчитывающая на ёмкость Megapack в 655 МВт∙ч. В отчёте прогнозируется рост рынка энергохранилищ в 2026 году на уровне менее 10 % из-за вступления в силу ограничений, касающихся иностранных юридических лиц, «вызывающих озабоченность» (FEOC). Кроме того, ситуация не улучшают и тарифные войны, которые на некоторое время привели к увеличению пошлин на импорт в США китайских аккумуляторов более чем на 150 %. Прогнозируется, что спрос на ЦОД на окажет значительного влияния на рынок BESS в 2026 году, поскольку развитие ИИ-технологий всё ещё находится на начальной стадии, но в 2027 году Jefferies ожидает существенного роста.

12.11.2025 [15:52], Руслан Авдеев

ГК Key Point построит коммерческие дата-центры в Санкт-Петербурге и ДагестанеРоссийская ГК Key Point объявила о начале строительства нового коммерческого дата-центра в Санкт-Петербурге. Объект будет возведён на ул. Прокофьева, 10 — он станет крупнейшей колокейшн-площадкой в Санкт-Петербурге и Северо-Западном федеральном округе, сообщает компания. Проект на 20 МВт рассчитан на 1626 IT-стоек. Начало эксплуатации первой очереди совокупной мощностью 5 МВт и ёмкостью 330 стоек по 8 кВт планируется в I квартале 2027 года. Первая очередь проекта получит сертификаты надёжности Tier III. Вторую и третью очереди на 1296 стоек мощностью 15 МВт, введут в эксплуатацию в III квартале того же года и II квартале 2028 года соответственно. II и III очереди сертифицируют в соответствии с уровнем Tier IV. Площадка в Санкт-Петербурге станет первым ЦОД такого уровня на Северо-Западе. Ответственным за полный комплекс работ EPC-подрядчиком проекта является компания «Свободные Технологии Инжиниринг». В ГК Key Point отмечают, что сегодня потребность в современной цифровой инфраструктуре в Санкт-Петербурге растёт год от года, и новый ЦОД повышенной надёжности станет опорой для цифровой экономики всего Северо-Запада. Ранее Key Point объявила, что в IV квартале 2026 года заработает первая очередь Tier III ЦОД компании в Хасавюртовском районе Дагестана. Проект будет построен в два этапа, по 220 стоек на каждом. Общая подведённая мощность составит 5,5 МВт, IT-мощность — 3 МВт. Генеральным подрядчиком и генеральным проектировщиком объекта также выбрана компания «Свободные Технологии Инжиниринг». Партнёром проекта выступает компания «Электросвязь» — ведущий оператор связи в регионе. В сентябре 2024 года сообщалось, что Softline и Key Point развернут сеть модульных дата-центров в Сибири и на Дальнем Востоке. В феврале 2025 года появилась информация, что ВТБ выделит 3,2 млрд рублей на ЦОД Key Point в Свердловской области. В 2026 году должен заработать ЦОД в Ростовской области.

12.11.2025 [15:17], Руслан Авдеев

Microsoft инвестирует $10 млрд в ИИ ЦОД в ПортугалииMicrosoft потратит $10 млрд на ИИ ЦОД на побережье Португалии. Это станет одной из крупнейших инвестиций компании в Европе в 2025 году, сообщает Bloomberg. Речь о проекте кампуса в Синише (Sines) в 150 км от Лиссабона. Строительством парка занимается Microsoft совместно с португальской Start Campus и британским стартапом Nscale. Информацию о проекте и сумме подтвердил президент Microsoft Брэд Смит (Brad Smith). Как отмечает Datacenter Dynamics, в начале года в кампусе введён в эксплуатацию первый из шести планируемых объектов — ЦОД SIN01. $10 млрд покроют расходы на развитие второй фазы проекта. Второй ЦОД SIN02 обеспечит 180 МВт и уже строится. Общая мощность кампуса должна составить 1,2 ГВт. Пока неизвестно, в скольких проектах ЦОД на площадке Microsoft и Nscale будут участвовать совместно. Партнёрство Microsoft, Nscale и Start Campus было анонсировано в октябре 2025 года. Nscale развернёт для Microsoft в Синише 12,6 тыс. ускорителей NVIDIA GB300. Столкнувшись с нехваткой мощностей, компания подписала соглашения с несколькими неооблаками на $60 млрд, в том числе с CoreWeave, Nebius, IREN и Lambda. Только за последний квартал на аренду потрачено $11,1 млрд. Мощности Nscale компания намерена арендовать в Великобритании, США и Норвегии. Всего Microsoft намерена арендовать у Nscale 116 тыс. ускорителей GB300. Хотя большинство ЦОД расположены в районе Лиссабона (присутствуют объекты AtlasEdge, Claranet, Edged, Tata Communications и Equinix), прибрежный город Синиш с населением порядка 15 тыс. человек становится ключевым инвестиционным хабом Португалии. Отсюда проложены и подводные кабели, ещё больше появится в будущем — Medusa, New CAM Ring, Nuvem и Olisipo. В мае китайская CALB Group начала строить в городе фабрику по производству аккумуляторов за €2 млрд ($2,3 млрд). Также Синиш, возможно, станет домом для «ИИ-гигафабрики», поддерживаемой Евросоюзом.

11.11.2025 [15:39], Руслан Авдеев

Tapestry, «ИИ-управляющий» энергосетями от Google X, поможет обеспечить надёжное питание кампуса Rio AI City мощностью 1,8 ГВтОдин из инновационных проектов Google X — компания Tapestry заключила соглашение с властями Рио-де-Жанейро. Компания поможет в создании и поддержке энергетической инфраструктуры 1,8-ГВт кампуса ЦОД Rio AI City, создаваемого при участии NVIDIA и Oracle, сообщает Datacenter Dynamics. Tapestry подключилась к проекту по приглашению мэра Рио Эдуардо Паэса (Eduardo Paes). В рамках сделки Tapestry поможет в оценке и планировании энергетической инфраструктуры AI City. Для управления сетями в проекте будет применяться инструмент GridAware, предлагаемый Tapestry — он обеспечит проверку состояния физической электросети в AI City. Позже инструмент Grid Planning Tool будет применяться для расчёта сценариев, позволяющих нарастить генерирующие мощности и пропускную способность сетей с сохранением почти 100 % надёжности. Также в проекте принимает участие Axia Energia (Electrobras), крупнейшая в Латинской Америке компания по генерации и передаче электроэнергии, оператор и застройщик ЦОД Elea Data Centers, и местная энергокомпания Light SA. Tapestry — инновационный проект под «зонтиком» Google X, который с помощью ИИ создаёт «первую унифицированную модель энергосети». Компания надеется помочь всем, планирующим и строящим электросети, а также управляющим ими. Пользователи ПО смогут оптимизировать энергопотоки и подключать к сети энергию из различных источников. Развитие Rio AI City уже началось. Ожидается, что второй объект кампуса RJO2 получит 80 МВт в 2026 году. Позже в эксплуатацию введут площадки RJO3 и RJO4, ещё на 120 МВт. В дальнейшем на первом этапе мощность можно будет увеличить до 1,5 ГВт (включая существующий объект RJO1), а в будущем — до 3,2 ГВт и 27 объектов.

11.11.2025 [15:14], Руслан Авдеев

Облака и ЦОД Northern Data будут проданы Rumble для создания экосистемы Freedom-First с упором на свободу слова и приватность, а майнинговые мощности достанутся Elektron EnergyНемецкая IT-компания Northern Data Group будет продана видеоплатформе и облачному провайдеру Rumble Inc. Последняя купит 100 % акций Northern Data. Сделка предусматривает покупку всего бизнеса, включая облачные и ИИ-подразделения, и будет закрыта во II половине 2026 года, сообщает Datacenter Dynamics. В Rumble сообщают, что намерены расширить облачный бизнес за счёт активов Northern Data, получив одни из крупнейших массивов ИИ-ускорителей в Европе наряду с ЦОД. Это поможет компании построить собственную экосистему Freedom-First. Экосистема Freedom-First, в отличие от классических гиперскейлеров, якобы предполагает поддержку свободы слова, приватности, независимости и надёжности. В будущем планируется расширить портфолио сервисов, предложив Rumble Wallet, ИИ-ботов и агентов и др. Основанная в 2022 году Rumble включает видеоплатформу, а также облачный сервис Rumble Cloud. Последний распоряжается ЦОД в несколкьих американских штатах. В рамках сделки каждый совладелец Northern Data получит по 2,0281 акций Rumble класса A в обмен на каждую акцию Northern Data. Также среди акционеров распределят $200 млн. На сегодня крупным акционером Northern и Rumble является криптомайнинговая компания Tether. Она, наряду с другими инвесторами, и приняла решение о продаже. В минувшие выходные Northern Data объявила о продаже доли в Lancium, задействованной в проекте Stargate, за $30 млн. Кроме того, упомянуто соглашение с Tether об аренде ИИ-ускорителей на сумму до $150 млн в течение двух лет. Параллельно Northern Data избавится от подразделения, ответственное за майнинг криптовалют, чтобы полностью сосредоточиться на облачных сервисах и ЦОД, сообщает Datacenter Dynamics. Первоначальный платёж за майнинговый бизнес Peak Mining должен был составить $50 млн. Имя покупателя не называлось, но в августе появилась информация, что майнинговое подразделение продадут Elektron Energy за $350 млн. Ещё $150 млн будет выплачено, если прибыль подразделения после сделки достигнет заданных показателей. Вырученные средства пойдёт на расширение облачных и ИИ-сервисов.

Источник изображения: Kanchanara/unsplash.com Northern Data была основана в Германии в 2009 году под именем Northern Bitcoin AG. Бизнес позиционировал себя как «зелёного» майнера биткоинов. В 2020 году компанию переименовали в Northern Data Group и переориентировали на HPC-проекты в целом. Летом 2023 года компания запустила три бернда: Taiga Cloud, Ardent Data Centers и Peak Mining. Облаку Taiga Cloud досталось более 22 тыс. ИИ-ускорителей. Что касается Ardent Data Centers, то восемь ЦОД по всему миру к 2027 году совокупно достигнут мощности порядка 250 МВт. Ardent управляет дата-центрами в Будене (Boden) в Швеция, а также в Норвегии — в Лефдале (Lefdal) на мощностях Lefdal Mine и Кристиансанне (Kristiansand) на мощностях Bulk. В США летом 2025 года компания открыла дата-центр в Питтсбурге (Пенсильвания). Также планируется масштабное строительство в Мейсвилле (Maysville, Джорджия). Также упоминаются мощности для размещения оборудования в Великобритании и Португалии. Дополнительно упомянуто о площадке мощностью 6 МВт в Амстердаме (Нидерланды). В мае Northern Data сообщала о получении от компаний, «зарегистрированных на бирже в США», заявлений о заинтересованности в обсуждении о слиянии с подразделениями Taiga Cloud и Ardent или их приобретении. В августе компания Rumble Inc. объявила, что заинтересована в рассмотрении покупке, в качестве средства оплаты предлагая свои акции взамен активов. Положение Northern Data на рынке не вполне стабильно. Если в июле 2024 года сообщалось, что компания рассматривает вывод на IPO подразделений ЦОД и ИИ, то в сентябре 2025 года появилась информация о том, что европейских офисах компании прошли обыски и аресты. Сообщалось, что компанию подозревают в неуплате €100 млн налогов от деятельности, связанной с криптомайнингом. |

|