Материалы по тегу: ии

|

28.10.2025 [12:54], Руслан Авдеев

Google и NextEra перезапустят АЭС в Айове, чтобы запитать ИИ ЦОДNextEra Energy и Google достигли соглашения о перезапуске зактрытой пять лет назад АЭС в Айове. Это ещё один признак того, что спрос на энергию для ИИ ЦОД открывает «второе дыхание» ядерной энергетике США, сообщает Reuters. 615-МВт АЭС Duane Arnold Energy Center (DAEC) близ Сидар-Рапидс (Cedar Rapids), согласно планам, возобновит работу в начале 2029 года, а Google в течение 25 лет будет закупать у неё электроэнергию. Рядом Google планирует построить до шести ЦОД. Ранее похожее соглашение заключили Microsoft и Constellation Energy. Компании возообновят работу атомной электростанции Three Mile Island в Пенсильвании для снабжения электричеством дата-центров Microsoft. Поставки начнутся даже раньше, чем планировалось. Подход Meta✴ оказался более практичным — компания получит всю энергию действующей АЭС Clinton Clean Energy Center (CCEC), но только с 2027 года, когда закончится государственное субсидирование станции. А AWS просто стала соседом действующей АЭС. Google, Microsoft, Amazon (AWS), Oracle и другие гиперскейлеры, управляющие огромной облачной инфраструктурой, также в последние месяцы заключают соглашения о покупке энергии у атомных стартапов, разрабатывающих термоядерные или малые модульные реакторы (SMR), пока отсутствующие в коммерческой эксплуатации. NextEra и Google также изучают возможность работы с новыми энергетическими технологиями.

Источник изображения: Drew Dau/unsplash.com Как сообщают в NextEra, возобновление работы Duane Arnold является важной вехой. Партнёрство с Google не только возвращает атомную энергетику в Айову, но и ускоряет развитие ядерных технологий нового поколения. Duane Arnold Energy Center — единственная атомная электростанция в Айове. Он закрылся в 2020 году после 45 лет эксплуатации. Хотя в США уже предпринимаются попытки «оживить» три АЭС, ни один из законсервированных объектов пока так и не заработал снова. В Google заявляют, что партнёрство с NextEra послужит моделью получения инвестиций, необходимых для наращивания энергетических мощностей по всей стране. Это обеспечит потребителей надёжной, чистой энергией, сохранив её доступность. Кроме того, проекты помогут создавать новые рабочие места. В целом такие проекты будут стимулировать экономику, основанную на ИИ-технологиях. В NextEra заявляют, что владелец миноритарной доли АЭС — компания Central Iowa Power Cooperative — будет покупать не нужные Google «излишки» энергии по тем же ценам, что и IT-гигант. При этом NextEra подписала соглашение о выкупе 30 % доли АЭС Duane Arnold у Central Iowa Power Cooperative и Corn Belt Power Cooperative, в результате компания станет единственным владельцем АЭС.

28.10.2025 [08:43], Сергей Карасёв

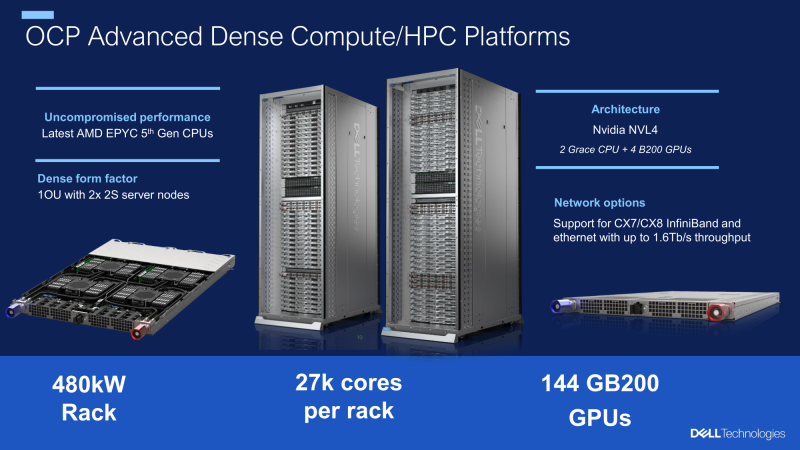

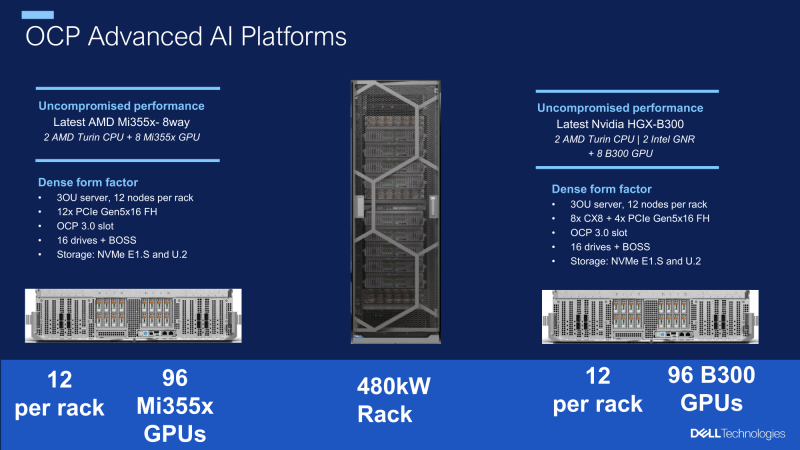

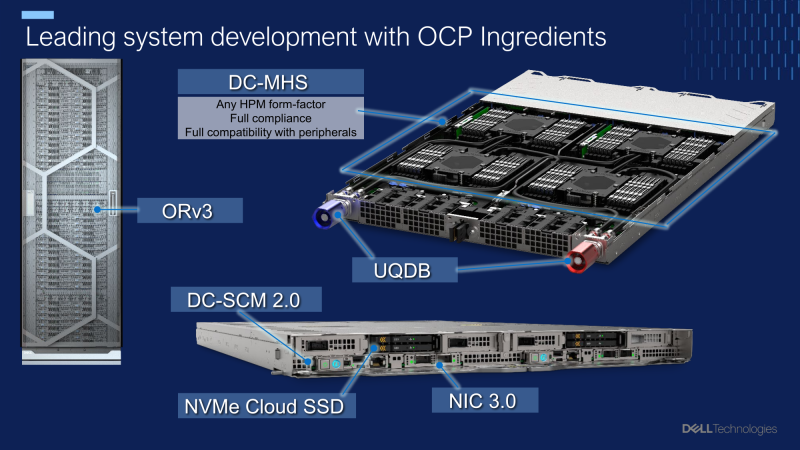

Dell разработала модульные OCP-стойки мощностью 480 кВт для ИИ-системКомпания Dell в ходе мероприятия 2025 OCP Global Summit рассказала о разработке передовых систем для ресурсоёмких нагрузок ИИ и HPC. Речь идёт, в частности, о полностью модульных архитектурах на базе открытых спецификаций, оптимизированных для жидкостного охлаждения. Ихаб Тарази (Ihab Tarazi), главный технический директор и старший вице-президент Dell Technologies, сообщил, что компания установила сотни тысяч GPU-ускорителей в кластерах, использующих оборудование на основе стандарта OCP ORv3. Благодаря достижениям в области водоблоков, термоинтерфейсов, блоков распределения охлаждающей жидкости (CDU) и быстроразъёмных коллекторов упрощается развёртывание масштабных ИИ-платформ, насчитывающих десятки тысяч GPU. Кроме того, Dell совместно с Национальной лабораторией имени Лоуренса в Беркли (LBNL) при Министерстве энергетики США (DoE) разработала модульную OCP-стойку мощностью 480 кВт с возможностью дальнейшего масштабирования до 1 МВт. Решение, ориентированное на экстремальные нагрузки ИИ, допускает установку высокопроизводительных серверов, насчитывающих в общей сложности до 27 тыс. CPU-ядер и до 144 ускорителей NVIDIA GB200. В перспективе также могут использоваться чипы AMD и NVIDIA следующего поколения, такие как Instinct MI450 и Vera Rubin. По словам Тарази, аналогичная архитектура стоек применяется в рамках суперкомпьютерной программы Техасского университета в Остине (UT Austin) и при развёртывании суверенных облаков. В целом, модульный подход обеспечивает возможность независимой модернизации вычислительных ресурсов, хранилищ и сетевых компонентов, сокращая время обновления инфраструктуры с нескольких лет до нескольких недель. Инновации в сфере СЖО повышают надёжность и удобство обслуживания платформ в рамках масштабных ИИ-кластеров.

27.10.2025 [22:50], Владимир Мироненко

Qualcomm анонсировала ИИ-ускорители AI200 и AI250 — прошлое поколение чипов популярным не стало, но компания обещала исправитьсяQualcomm Technologies представила решения нового поколения для ЦОД, оптимизированные для ИИ-инференса — стоечные суперускорители Qualcomm AI200 и AI250. После их анонса акции Qualcomm подскочили на 15 %, показав самый большой внутридневной рост за более чем шесть месяцев, сообщил Bloomberg. Ожидается, что новые решения станут новой точкой роста компании. Она демонстрировала уверенный рост прибыли в течение последних двух лет, но инвесторы отдавали предпочтение акциям других технологических компаний. Qualcomm AI200 — специализированное стоечное решение для ИИ-инференса, обеспечивающее низкую совокупную стоимость владения (TCO). Платформа оптимизирована для инференса больших языковых и мультимодальных моделей (LLM, LMM) и других ИИ-нагрузок. AI200 включает карты с 768 Гбайт LPDDR. Чип основан на NPU Hexagon, которые используются в последних поколениях Snapdragon. Qualcomm AI250 получил инновационную архитектуру, построенную на принципах предельно близкого расположения быстрой памяти к вычислительным ядрам (Near-Memory Computing, NMC), что обеспечит качественно новый уровень эффективности и производительности ИИ-инференса. По словам Qualcomm, новая архитектура обеспечивает более чем десятикратный прирост эффективной пропускной способности памяти и значительное снижение энергопотребления. Это позволит проводить дезагрегированный ИИ-инференс для более эффективного использования оборудования. Оба продукта будут предлагаться отдельно и в составе стоек с полным жидкостным охлаждением, PCIe-коммутаторами для вертикального масштабирования и Ethernet — для горизонтального, а также поддержкой конфиденциальных вычислений. Энергопотребление стойки составит 160 кВт, что ставит новинки в один ряд с GB200 NVL72. Компания отметила, что её программный ИИ-стек гиперскейл-класса, охватывающий все этапы — от прикладного уровня до системного ПО — оптимизирован для ИИ-инференса. Стек поддерживает ведущие фреймворки машинного обучения, механизмы инференса, фреймворки генеративного ИИ и методы оптимизации инференса LLM/LMM, такие как дезагрегированное обслуживание. Обещаны бесшовный перенос моделей и развёртывание моделей платформы Hugging Face в один клик посредством библиотеки Efficient Transformers и пакета Qualcomm AI Inference Suite от Qualcomm. Qualcomm отметила, что её ПО предоставляет готовые к использованию приложения и ИИ-агенты, комплексные инструменты, библиотеки, API и сервисы. Прошлое поколение ускорителей CloudAI 100 не снискало успеха во многом из-за слабой программной экосистемы. От этого же страдала и AMD, которая ускоренными темпами навёрстывает упущенное. Qualcomm AI200 и AI250 поступят в продажу в 2026 и 2027 годах соответственно. Qualcomm также сообщила, что придерживается ежегодного плана развития направления ЦОД, ориентированного на достижение лидирующей в отрасли производительности ИИ-инференса, энергоэффективности и минимальной совокупной стоимости владения (TCO). Кроме того, компания решила вернуться на рынок серверных процессоров. Первым заказчиком анонсированных решений Qualcomm станет саудовский государственный ИИ-стартап Humain, который планирует развернуть 200 МВт ИИ ЦОД на базе новых чипов, начиная с 2026 года. Ранее было заключено соглашение с Cerebras, в рамках которого планировалось использовать для инференса именно чипы Qualcomm, в том числе в Саудовской Аравии. Ещё одним крупным игроком в ИИ-сделках здесь является Groq. Qualcomm запоздало пытается занять заметную долю рынка ИИ-оборудования. Компания считает, что новые решения в области памяти и энергоэффективности, основанные на технологиях для мобильных устройств, привлекут клиентов, несмотря на относительно поздний выход на рынок. Под руководством Криштиану Амона (Cristiano Amon) компания стремится диверсифицировать бизнес, больше не полагаясь на смартфоны, рост продаж которых замедлился. Qualcomm «занимала эту нишу, не торопясь и наращивая мощь», — заявил Дурга Маллади (Durga Malladi), старший вице-президент компании. По его словам, Qualcomm ведёт переговоры со всеми крупнейшими заказчиками о развёртывании стоек на базе своего оборудования.

27.10.2025 [13:42], Руслан Авдеев

BNP Paribas: только инвестиции в ИИ удерживают экономику США от рецессииПо словам финансовых экспертов, в США сложилась ситуация, при которой рецессию в экономике страны предотвращают преимущественно капитальные вложения в сферу ИИ. Строительство инфраструктуры ЦОД и разработка ИИ-моделей обеспечивают экономический рост на фоне потрясений, характерных для других секторов экономики, сообщает The Register. Как свидетельствуют многочисленные источники, это компенсирует негативное влияние высоких процентных ставок и «хаотичную» торговую политику президента США. По словам BNP Paribas, именно ИИ удержал экономику от рецессии. Подчёркивается, что рост расходов убедил бизнесы в неизбежности устойчивого роста. Как считают эксперты Apollo Global Management, «в настоящее время роста корпоративных капиталовложений помимо ИИ практически нет». Несмотря на повышение ставок ФРС, расходы на ИИ практически не сократились — в отличие от типичного поведения инвесторов в таких случаях. Это объясняется тем, что инвестиции в ЦОД в конечном счёте финансируются за счёт роста стоимости акций компаний «великолепной семёрки», включая Microsoft, Amazon, Alphabet и NVIDIA. По расчётам Omdia, мировые капиталовложения в дата-центры в 2025 году превысят $657 млрд, это почти вдвое больше, чем пару лет назад, а основным игроком остаются США. Только годовые расходы Amazon на дата-центры превышают $100 млрд, что примерно равно ВВП Коста-Рики.

Источник изображения: Vitaly Gariev/unspalsh.com По расчётам некоторых экспертов, 92 % экономического роста США в первых двух кварталах 2025 года пришлось на оборудование и ПО для обработки информации. Предполагается, что в конечном счёте ИИ будет помогать экономике, позволяя делать больше с меньшими затратами. Отчасти это уже происходит, но революционных изменений пока не отмечено. Это подтверждается многочисленными исследованиями, свидетельствующими, что несмотря на миллиардные вливания в ИИ, окупаемость инвестиций в этой сфере остаётся неопределённой. Проведённое в США исследование показало, что бизнес инвестировал в ИИ-инициативы десятки миллиардов долларов, но 95 % из них не получили никакой отдачи. По оценкам консультантов Bain & Company, при сохранении нынешней кривой расходов технологический сектор должен обеспечивать к 2030 году продаж в сфере ИИ на $2 трлн ежегодно, поэтому велики опасения относительно формирования очередного финансового пузыря. О вероятности формирования пузыря сообщали Goldman Sachs и Банк Англии. Особенно беспокоит аналитиков оценка OpenAI в $500 млрд, поскольку компания, хотя и известная революционными технологиями, пока не приносит прибыли. Сам её глава Сэм Альтман (Sam Altman) признал, что отрасль ИИ находится в пузыре, но сам он, похоже, не видит в этом ничего страшного, даже с учётом того, что в недавнем отчёте появилась информация, что компания теряет приблизительно втрое больше денег, чем зарабатывает. Правда, фактически за её услуги платят лишь 5 % из 800 млн пользователей ChatGPT.

27.10.2025 [11:16], Сергей Карасёв

Axelera AI представила ИИ-чип Europa с производительностью 629 TOPSНидерландский стартап Axelera AI анонсировал ИИ-ускоритель (AIPU) под названием Europa, предназначенный для таких задач, как генеративные сервисы и приложения компьютерного зрения. По заявлениям разработчиков, чип может использоваться в оборудовании разного класса — от периферийных устройств до корпоративных серверов. В состав Europa AIPU входят восемь «ядер ИИ второго поколения», которые используют векторные движки и технологию цифровых вычислений в оперативной памяти (D-IMC), разработанные специалистами Axelera. Заявленная ИИ-производительность достигает 629 TOPS на операциях INT8. Кроме того, чип содержит 16 специализированных векторных ядер с архитектурой RISC-V, сгруппированных в два кластера: они предназначены для операций пред- и постобработки, не связанных с ИИ. Пиковая производительность блока RISC-V достигает 4915 GOPS (млрд операций в секунду). Интегрированный декодер H.264/H.265 ускоряет выполнение медиазадач. Процессор располагает 256-бит интерфейсом памяти LPDDR5 с пропускной способностью 200 Гбайт/с и 128 Мбайт памяти L2 SRAM. Новинка будет предлагаться в различных форм-факторах, включая компактное исполнение с размерами 35 × 35 мм и карты расширения PCIe 4.0 х4 в различных конфигурациях, в частности, с одним чипом и 16 Гбайт памяти, а также с четырьмя чипами и 256 Гбайт памяти. Разработчикам предоставляет комплект Voyager SDK, который позволяет полностью раскрыть потенциал процессора. В целом, как утверждается, новинка обеспечивает в 3–5 раз более высокую производительность в расчёте на 1 Вт и $1 по сравнению с ведущими отраслевыми решениями в той же категории. Поставки Europa AIPU и PCIe-карт начнутся в I половине 2026 года.

27.10.2025 [10:09], Руслан Авдеев

Для майнинга и ИИ: ГЭС Itaipu запитает дата-центры американской X8 Cloud и канадской Hive DigitalАмериканский стартап X8 Cloud Infrastructure заявил о намерении построить в Парагвае комплекс ИИ ЦОД и облачных сервисов с использованием энергии местной ГЭС Itaipu. Та же электростанция поможет и расширению дата-центра Yguazu компании Hive Digital из Канады, сообщает Datacenter Dynamics. На днях X8 Cloud подписала соглашение с Национальным управлением по электроснабжению Парагвая (Ande) о строительстве «крупнейшей ИИ-инфраструктуры в Латинской Америке». Утверждается, что площадка близ Асунсьона (Asunción) обеспечит в регионе доступ к ИИ-технологиям мирового уровня, но по цене до 70 % ниже общепринятой. Первый ЦОД мощностью 50 МВт заработает в начале 2026 года, а к 2027 году мощность доведут до 500 МВт. Объекты будут питаться исключительно от ГЭС Itaipu, эксплуатацией которой совместно занимаются Бразилия и Парагвай. Установленная мощность станции составляет 14 ГВт. Сообщается, что ЦОД обеспечит бразильским компаниям ИИ-инфраструктуру под юрисдикцией США, при этом соответствующую бразильским нормативам защиты данных, с прозрачным управлением. Кроме того, X8 Cloud обещает низкие затраты на обучение ИИ-моделей и инференс. В будущем компания намерена расширить свою деятельность на территории Бразилии и Аргентины, доведя мощности до 5 ГВт. Канадский криптомайнер Hive Digital Technologies также объявил о расширении деятельности в регионе — мощность ЦОД Yguazu, целиком запитанного от той же ГЭС, будет увеличена с 300 МВт до 400 МВт к III кварталу 2026 года. Компания объявила о бизнес-планах в Парагвае в 2024 году, а затем приобрела площадку у Bitfarms в январе 2025 года. По данным компании, Yguazu уже приносит 8,5 BTC/день. После обновления кампуса ЦОД он станет крупнейшим объектом такого рода в стране, а Hive будет располагать 540 МВт возобновляемой энергии в трёх странах: 400 МВт в Парагвае, по 140 МВт в Канаде и Швеции. Рост майнинга биткоинов в Парагвае поддерживается местными законами. В частности, использование энергии для майнинга не облагается налогами с 2027 года, причём льготы касаются именно криптомайнинга. Именно ГЭС, возможно, позволит превратить Парагвай в региональный хаб ЦОД.

27.10.2025 [08:47], Руслан Авдеев

Монголия рассчитывает привлечь инвестиции в развитие ЦОДВласти Монголии надеются привлечь в страну операторов и застройщиков ЦОД. По словам главы Фонда национального благосостояния Монголии им. Чингисхана Темуулен Баяраа (Temuulen Bayaraa), страна располагает огромной территорией и очень благоприятным климатом для размещения ЦОД, сообщает Datacenter Dynamics. В интервью CNBC глава фонда добавила, что в стране уже работают над созданием специальных экономических зон для размещения дата-центров. Фонд национального благосостояния, основанный в 2024 году, имеет в резерве на $1,4 млрд и намерен привлечь инвесторов доступом к «чистой» энергии. Структура управляется государственной холдинговой компанией Erdenes Mongol, которой принадлежит часть горнодобывающих активов страны. К особым экономическим зонам относится проект «умного» города Хунну (Hunnu City) в 50 км от Улан-Батора. Город должен занять площадь 31 тыс. га, запитан он будет от геотермальных электростанций.

Источник изображения: Vince Gx/unsplash.com В целом рынок дата-центров в Монголии пока очень мал. По данным Data Center Map, в Монголии имеется всего два дата-центра, причём оба в Улан-Баторе: правительственный ЦОД и ЦОД местной телеком-компании Unitel. По статистике Uptime Institute, в стране пять ЦОД, имеющих сертификат Tier II: по два принадлежат XacBank и Khan Bank, а один — Банку Монголии. Все пять находятся в районе Улан-Батора. О наличии собственных ЦОД также говорят S Systems (Shunkhlai Group) и Mobinet (Newcomm Group). Строительством дата-центров занимается и монгольская IT-компания CT Group JSC. Впрочем, привлекательность монгольских территорий для инвесторов, желающих строить дата-центры — под вопросом. В соседнем регионе Внутренняя Монголия (Китай) наспех построенные избыточные мощности ЦОД так и остались невостребованными. Дело в том, что заказчики из густонаселённых восточных районов предпочитают использовать новые кампусы на западе исключительно для хранения, но не обработки данных. Этому мешают высокая задержка доступа, а также дороговизна каналов связи.

26.10.2025 [23:55], Владимир Мироненко

Amazon проморгала рынок и теперь её клиенты бегут за ИИ в облака конкурентовAmazon, стоящая у истоков облачного бизнеса, уже не первый год отстаёт от конкурентов по темпам его роста. И на ИИ-рынке, по общему мнению, она оказалась в роли догоняющей на фоне стремительного роста конкурентов, пишет агентство Bloomberg. На прошлой неделе стало известно, что Google Cloud предоставит Anthropic до 1 млн своих ИИ-чипов TPU, что свидетельствует об углублении партнёрства Google с быстрорастущим ИИ-стартапом и наносит удар по Amazon, инвестировавшей в Anthropic миллиарды долларов. AWS по-прежнему лидирует на облачном рынке, но Microsoft наращивает объём корпоративных продаж быстрее, чем Amazon. В прошлом году, по оценке Gartner, облачное AWS заняла 38 % корпоративных расходов на услуги облачной инфраструктуры, тогда как ещё в 2018 году, по данным компании, у «дочки» Amazon было почти 50 % этого рынка. Чтобы выяснить причины сложившейся ситуации, агентство Bloomberg провело опрос аналитиков в области облачных вычислений и финансов, а также у компаний, которые используют или перепродают облачные решения Amazon, и среди 23 нынешних и бывших сотрудника AWS, работающих в сфере разработки, управления продуктами, маркетинга, продаж и поддержки. Одной из главных причин, тормозящих работу AWS, а также влияющих на гибкость, они назвали внутреннюю бюрократию. Респонденты отметили слабый старт компании в области ИИ, а также то, что она стала менее привлекательной для стартапов. Вместе с тем AWS верна своей давней стратегии на фоне быстро меняющегося рынка. Участники опроса признают, что AWS сохраняет значительные преимущества и лояльность клиентов, но опасаются, что компания теряет свои позиции в погоне за конкурентами, которых когда-то опережала. На следующей неделе Amazon объявит квартальные финансовые результаты, которые, как ожидается, покажут рост облачного бизнеса на 18 % до $32 млрд, что уступает показателю роста годом ранее (19 %). Сказался и серьёзный рост конкуренции на облачном рынке в последние пару лет. Oracle, которую когда-то считали аутсайдером в облачной индустрии, теперь заключает многомиллиардные контракты в области ИИ, хотя и не все верят в её успех. Также наращивают мощности Google и неооблака. Дэйв Маккарти (Dave McCarthy), консультант IDC, отметил, что выбор облачных предложений, ранее ограничивавшийся сервисами Amazon и Microsoft, стал гораздо больше, и это не сулит ничего хорошего Amazon. «Это создаёт новое конкурентное давление, которого раньше не было», — подчеркнул он. Стремясь вернуть себе инициативу, AWS реорганизовала команды по инжинирингу и продажам, провела кадровые перестановки в руководстве, а также отказалась от некоторых собственных правил разработки ради ускорения вывода продуктов на рынок и попыталась сократить бюрократию, возникшую после масштабного набора сотрудников во время пандемии. Кроме того, в этом месяце AWS выпустила Quick Suite, призванный заменить её предыдущий основной ИИ-инструмент для корпоративных клиентов, и в декабре ожидается запуск ряда новых и обновлённых ИИ-сервисов. Представитель Amazon Селена Шен (Selena Shen) сообщила в электронном письме Bloomberg, что AWS по-прежнему лидирует на рынке облачных технологиях с большим отрывом, а её ИИ-сервисы, такие как Amazon Bedrock, SageMaker и Kiro, пользуются спросом у клиентов, в том числе из-за выгодного соотношении цены и производительности фирменных ИИ-ускорителей Trainium2. Amazon заключила за последнее время крупные сделки с широким кругом клиентов, включая Delta Air Lines, Volkswagen, Управление общих служб США (GSA) и State Farm, отметила Шен. «Если вы посмотрите на любой список самых инновационных или быстрорастущих стартапов мира, вы обнаружите, что подавляющее большинство из них в значительной степени разворачивают рабочие нагрузки в AWS», — добавила она, ссылаясь, среди прочего, на списки Forbes и CNBC. Тем не менее, по общему мнению, оставаясь лидером в области облачной инфраструктуры, AWS отстаёт от своих конкурентов в плане привлечения бизнеса, создающего или использующего ИИ-модели. В частности, AWS не поверила в то, что Anthropic сможет монетизировать свои разработки, поэтому стартап в поисках необходимых вычислительных мощностей обратился к Google Cloud. Когда стартап привлёк инвестиции в начале 2023 года, среди инвесторов была и Google. Лишь в сентябре Amazon спохватилась и инвестировала в Anthropic первый из двух запланированных траншей в размере $4 млрд, обязав Anthropic использовать AWS и собственные чипы Amazon, а также предлагать клиентам Amazon модели Claude. Объём инвестиций шокировал ветеранов Amazon, знавших, что компания крайне не любит платить за что-либо по рыночным ценам. Некоторые посчитали это отчаянием, пишет Bloomberg. Amazon долгое время гордилась тем, что работает в режиме стартапа, предоставляя свободу независимым командам. Но этот принцип оказался неэффективным при разработке ИИ-моделей, поскольку научные и инженерные подразделения AWS, розничный отдел Amazon и группы Alexa и устройств занимались схожей, иногда дублирующей работой по обучению собственных ИИ-моделей. На конференции AWS re:Invent в ноябре 2023 года компания сделала упор на ИИ, а чуть позже развернула собственного ИИ-ассистента Amazon Q, который, по словам аналитиков, не принёс ничего революционного рынку, уже переполненному чат-ботами. Amazon провела реорганизацию и централизовала большинство работ по разработке передовых моделей, однако развитие AWS замедлилось. В том числе из-за усложнения иерархии после всплеска найма в результате пандемии. В условиях растущей бюрократии принятие решений происходило не так быстро, как раньше. Кроме того, поскольку ПО AWS стало критически важным для крупных корпоративных и государственных клиентов, в компании установили процедуры, призванные снизить риск того, что невнимательный или недовольный сотрудник может сломать что-то важное — это тоже замедляет работу. В некоторых случах часть сотрудников даже заставили получать разрешения на отправку писем высшему руководству. Шен сообщила, что с 2024 года AWS наняла множество новых руководителей и продвигает по службе тех, кто «демонстрирует производительность и готовность к следующему уровню», и что культура AWS остаётся сильной. Сменивший Адама Селипски (Adam Selipsky) на посту гендиректора AWS Мэтт Гарман (Matt Garman), пользующийся большим доверием разработчиков, частично вернул культуру прошлого. От руководителей продуктов требуется открытое признание ошибок и извлечённых уроков, идеи сотрудников принимаются в виде коротких питчей, а сами разработчики ПО работают посменно, обрабатывая запросы поддержки и инциденты по своим продуктам, чтобы понять потребности клиентов. Кроме того, Гарман завершил или прекратила разработку около трёх десятков устаревших и непопулярных продуктов, перенаправив силы на разработку ИИ-инструментов. Тем не менее, сотрудники выражают обеспокоенность тем, что Amazon теряет привлекательность для стартапов. AWS, как известно, помогла зарождению Netflix, но в последние годы порой отдавала приоритет корпорациям с большими расходами, не желая тратить силы на стартапы, которые могут и не стать долгосрочными богатыми клиентами. По словам аналитиков и стартап-консультантов, Google, используя свою известность, инженеров и навыки в передовых ИИ-инструментах, смогла привлечь многих ведущих стартапов в этой сфере. «Если вы сегодня не привлекаете местные стартапы в сфере ИИ, которые в ближайшие пару лет вырастут в пять-десять раз, это может стать реальной проблемой для бизнеса», — сказал Джош Бек (Josh Beck), аналитик Raymond James. Шен же назвала AWS «лучшим выбором для стартапов», приведя в пример Perplexity и Cursor. Но, к примеру, Пит Шваб (Pete Schwab), основатель стартапа Stronghold Labs в области ИИ-анализа видео, выбрал для своего детища площадку Google из-за её ориентации на небольших разработчиков и качества внутренних ИИ-моделей, хотя сам до этого 10 лет проработал в Amazon. AWS «раньше гораздо лучше привлекала таких людей, как мы», — сказал Шваб. Существующие клиенты AWS сейчас также обращаются к услугам её конкурентов, особенно в ИИ-сфере. Например, Grammarly, пользуется AWS, но для ИИ-решений использует модели OpenAI, в том числе в Microsoft Azure, а также Meta✴ Llama, поскольку AWS Bedrock не отвечает ценовым и другим потребностям компании, заявил технический директор стартапа. В начале этого месяца компания представила Quick Suite — чат-бот и набор ИИ-агентов, предназначенных для анализа данных, создания отчётов или резюмирования веб-контента, которые ориентированы на офисных сотрудников. В этой области компания не добилась особого успеха. Руководители в частном порядке признают, что, в отличие от Google и Microsoft, которые могут демонстрировать свои ИИ-инструменты миллиардам клиентов поисковой системы или пользователей ПК, естественный охват AWS ограничен гораздо более узким сообществом разработчиков. Для этой аудитории AWS продолжает расширять возможности Bedrock. Bedrock считается самым успешным ИИ-продуктом компании, число пользователей которого исчисляется десятками тысяч. По словам клиентов и партнёров, отделы продаж сделали увеличение их количества приоритетом. Однако Amazon может преуспеть в эпоху ИИ, просто выступая в качестве поставщика инфраструктуры для других компаний и управляя ею экономически эффективно. По мнению аналитиков, большая часть корпоративных проектов в области ИИ носит экспериментальный характер. Если проект получит более широкую поддержку, экономия средств и надёжная инфраструктура (если не учитывать недавний сбой) — два основных преимущества AWS — станут ещё важнее, утверждают руководители компании.

26.10.2025 [14:20], Сергей Карасёв

d-Matrix представила систему SquadRack для ИИ-инференса со сверхнизкой задержкойКомпания d-Matrix анонсировала систему SquadRack — стоечное решение для пакетного инференса со сверхнизкой задержкой. Это, как утверждается, первый в отрасли продукт данного класса. В его разработке приняли участие специалисты Arista, Broadcom и Supermicro. В основу SquadRack положена серверная платформа Supermicro X14 AI. Судя по изображениям, используется модель SYS-522GA-NRT, которая допускает установку двух процессоров Intel Xeon 6900 (Granite Rapids) и 24 модулей оперативной памяти DDR5-8800. Доступны 24 фронтальных отсека для SFF-накопителей U.2/U.3 (NVMe). Устройство выполнено в форм-факторе 5U. Система SquadRack предусматривает использование ускорителей d-Matrix Corsair. Их архитектура основана на модифицированных ячейках SRAM для вычислений в памяти (DIMC), работающих на скорости около 150 Тбайт/с. По заявлениям d-Matrix, решение обеспечивает непревзойдённую производительность ИИ-инференса: быстродействие достигает 2,4 Пфлопс (8-бит вычисления). Кроме того, задействованы IO-карты d-Matrix JetStream, предназначенные для распределения нагрузок инференса. Одна такая карта может обслуживать до четырёх экземпляров Corsair, обеспечивая сетевую задержку на уровне 2 мкс. Решение SquadRack также оборудовано PCIe-коммутаторами Broadcom для масштабирования в пределах одного узла. В свою очередь, связь между узлами обеспечивают коммутаторы Arista Leaf Ethernet, подключённые к картам JetStream. Применяется программный стек d-Matrix Aviator. В одну стойку могут быть установлены до восьми экземпляров SquadRack, что позволяет с высокой скоростью обрабатывать модели ИИ, насчитывающие до 100 млрд параметров. В целом, возможно масштабирование до сотен узлов в нескольких серверных стойках.

24.10.2025 [22:50], Владимир Мироненко

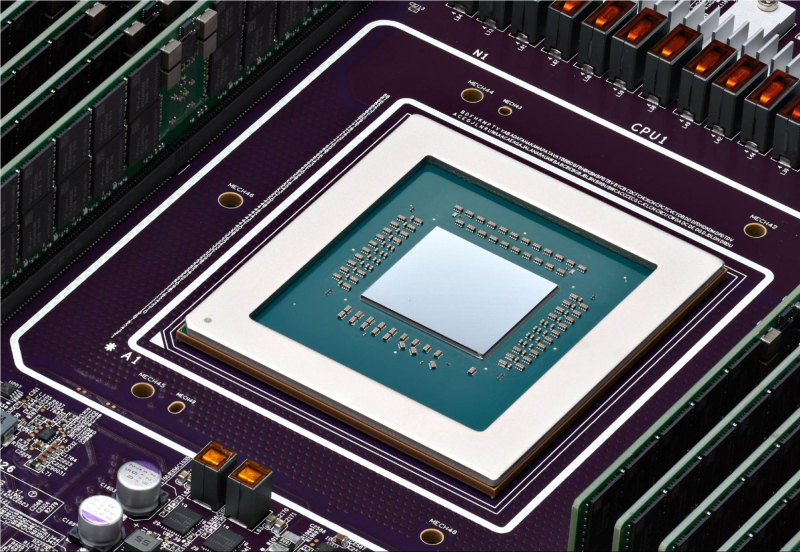

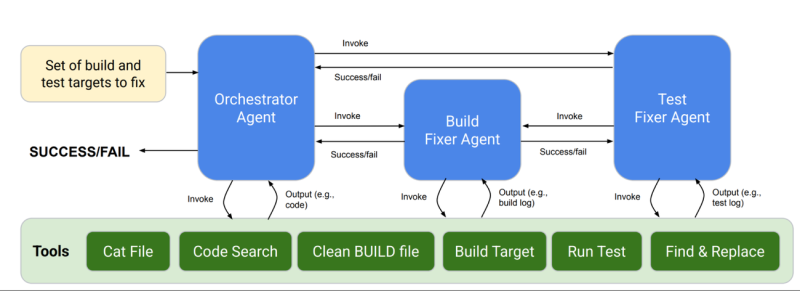

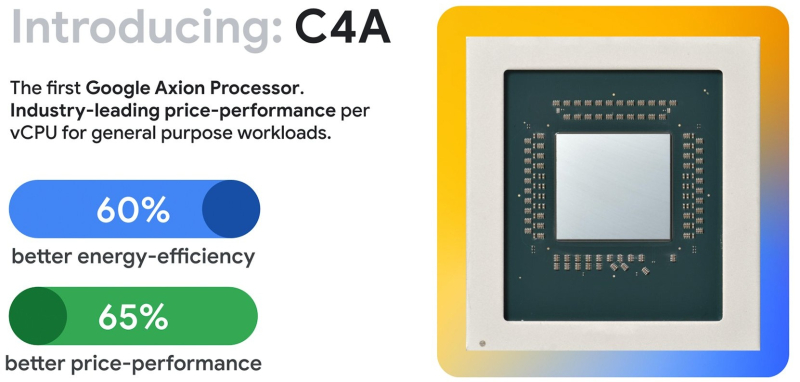

ИИ помог Google перенести 30 тыс. внутренних нагрузок на Arm-процессоры Axion, на очереди ещё 70 тыс.Google объявила, что портировала около 30 тыс. внутренних нагрузок на Arm-архитектуру и планирует перенести ещё порядка 70 тыс. Помогает ей в этом ИИ, но пока не слишком успешно. При этом целиком отказываться от x86-процессоров в пользу собственных Arm-чипов Axion компания пока не планирует. YouTube, Gmail и BigQuery уже работают как на системах с x86, так и c Arm. В процессе портирования приходится уделять внимание архитектурным различиям, таким как особенности работы с числами с плавающей запятой, параллелизм, платформенно-зависимые технологии и производительность. Специалисты Google рассказали, что сначала они перенесли некоторые из ключевых задач, такие как F1, Spanner и Bigtable, используя стандартные методы разработки ПО с привлечением инженеров. Оказалось, что современные компиляторы и инструменты, такие как санитайзеры и фаззеры, избавили разработчиков от множества сюрпризов. Большая часть времени по факту ушла на исправление тестов, обновление сложных систем сборки и развёртывания, как правило, для самых старых и самых нагруженных сервисов, устранение проблем с массовым развёртыванием в рабочих средах и принятие мер по предотвращению дестабилизации критически важных систем. 30 тыс. приложений — это достаточно большой объём кода для того, чтобы задуматься об автоматизации задач. Поэтому компания создала новый мультиагентный ИИ-инструмент CogniPort для исправления ошибок сборки и тестирования. Он успешно справлялся с проблемами примерно в 30 % случаев и лучше всего — с исправлениями тестов, платформенно-зависимыми особенностями и особенностями представления данных. Эффективность не впечатляет, но Google предстоит портировать ещё десятки тысяч нагрузок. пакетов. Кроме того, компания внедрила новую систему непрерывного мониторинга и развёртывания мультиархитектурных нагрузок CHAMP (Continuous Health Monitoring Platform), которая автоматически отбрасывает задачи, работа которых на Arm сопровождается проблемами вроде циклических сбоев или недостаточной производительности, для последующих отладки и профилирования. Чем больше будет запущено нагрузок, тем лучше Borg, управляющий кластерами внутри Google, сможет распределять задачи таким образом, чтобы эффективно использовать Arm-серверы. Это позволит сэкономить затраты, поскольку по словам Google, системы на базе Axion обеспечивают на 65 % лучшее соотношение цены и производительности, чем экземпляры на базе x86, а также на 60 % более высокую энергоэффективность. Ранее Google, по неофициальным данным, высказывала недовольство показателем TCO последних поколений Intel Xeon. Возможно, это побудило компанию заняться созданием собственного процессора. Первой на этот путь, тоже ради улучшения TCO, ступила Amazon, которая разработала уже четыре поколения Arm-процессоров Graviton. В прошлом году компания похвасталась, что у неё есть уже 2 млн этих чипов. Alibaba Cloud в 2021 году представила свой первый Arm-процессор Yitian 710. У Microsoft с прошлого года есть собственные Arm-чипы Cobalt 100, на которые также возложена часть внутренних нагрузок. Наконец, Oracle два года назад сообщила о завершении миграции всех своих облачных сервисов на Arm, включая флагманскую СУБД. Oracle использует процессоры компании Ampere Computing, в которой она владела заметной долей до сделки с SoftBank. Все эти процессоры позволили Arm занять четверть рынка серверных CPU, однако решающую роль сыграло внедрение NVIDIA GB200/GB300. Arm также заключила стратегическое соглашение с Meta✴, чтобы помочь последней с оптимизацией ПО. |

|