Материалы по тегу: nvidia

|

06.03.2026 [17:01], Руслан Авдеев

Инференс-нагрузки Perplexity прописались в облаке CoreWeaveКомпания CoreWeave объявила о заключении долгосрочного соглашения с Perplexity. Стратегическое партнёрство призвано обеспечить выполнение рабочих ИИ-нагрузок последней, также предусмотрено пилотное внедрение в обеих организациях новых сервисов. Утверждается, что CoreWeave позволяет клиентам переходить от разработки непосредственно к внедрению без перепроектирования систем и инструментов. Соглашение предусматривает, что платформа CoreWeave будет использоваться Perplexity для инференса нового поколения. Выделенные кластеры на основе суперускорителей NVIDIA GB200 NVL72 гарантируют соответствие инфраструктуры облачного провайдера изменению задач Perplexity и высоким требованиям экосистемы на основе Sonar и Search API. В своё время Perplexity начинала с выполнения задач инференса с помощью CoreWeave Kubernetes Service и применения платформы W&B Models для (до-)обучения моделей и управления ими на всех этапах, от экспериментального до ввода в эксплуатацию. Дополнительно CoreWeave повсеместно внедрит в своей организации инструменты Perplexity Enterprise Max, что позволит её специалистам искать информацию в интернете и внутренней базе данных, проводить углублённые исследования, анализировать данные и визуализировать их. Партнёрство является свидетельством «мультиоблачной» стратегии Perplexity. Чуть более месяца назад Microsoft заключила крупную облачную сделку с Perplexity, но ключевым провайдером ИИ-поисковика останется AWS.

Источник изображения: CoreWeave/Perplexity Это лишь последняя из удачных сделок CoreWeave, сдающей в аренду мощности даже таким компаниям, как Microsoft, Meta✴ и OpenAI. В 2025 году компания получила средства от NVIDIA, которая арендовала свои же ускорители у CoreWeave. В сентябре 2025 года компания обязалась выкупить у неооблачного оператора все нераспроданные мощности. CoreWeave на волне роста спроса на облачные услуги удвоит в 2026 году капитальные затраты, хотя некоторые инвесторы сомневаются в целесообразности таких мер.

06.03.2026 [08:58], Руслан Авдеев

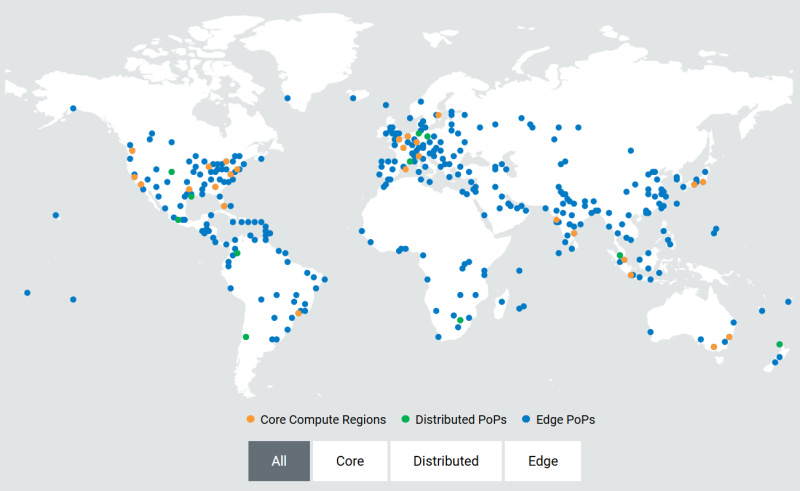

Akamai развернёт тысячи ускорителей NVIDIA RTX Blackwell для распределённого инференсаОблачный провайдер Akamai анонсировал покупку «тысяч» ИИ-ускорителей для развития своей распределённой облачной инфраструктуры по всему миру. Развёртывание новых чипов позволит создать единую оптимизированную ИИ-платформу для быстрого и распределённого инференса в глобальной сети Akamai. По словам компании, она готовит базовую инфраструктуру для «физического» и «агентного» ИИ, где решения необходимо принимать в режиме реального времени. Ранее компания анонсировала проект Akamai Inference Cloud. Как заявляет Akamai, пока крупные облачные бизнесы расширяют проекты обучения ИИ, компания сосредоточилась на удовлетворении потребностей эпохи инференса. Централизованные ИИ-фабрики имеют важное значение для создания моделей, но для их масштабной эксплуатации необходима децентрализованная «нервная система». Внедрение NVIDIA Blackwell в распределённая инфраструктуру, как ожидается, позволит ИИ взаимодействовать с «физическим» миром на местах — с системами автономной доставки, умными энергосетями, роботами-хирургами, антифрод-системами т.п. — без географических и финансовых ограничений, характерных для классических облаков. Интеграция ускорителей Blackwell обеспечит:

Предоставляя инструментарий для выполнения задач ближе к конечным пользователям, Akamai обеспечивает высокую пропускную способность и, как утверждается, одновременно снижает задержку до 2,5 раз. Это позволит бизнесам экономить до 86 % на инференсе в сравнении с обычными облачными компаниями-гиперскейлерами. Платформа объединяет серверы на основе ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition с DPU NVIDIA BlueField-3 и распределённую облачную инфраструктуру Akamai с 4,4 тыс. точек присутствия. Cloudflare применяет платформу с «бессерверным» инференсом в более чем 200 городах. Её Workers AI обеспечивают глобальный инференс с задержкой менее 100 мс без специального выделения кластеров ускорителей. Fastly применяет платформу периферийных вычислений, но предлагает меньшее количество локальных точек присутствия (PoP) для выполнения задач на GPU/CPU.

03.03.2026 [17:18], Руслан Авдеев

NVIDIA инвестировала $4 млрд в поставщиков лазеров и фотоники для ИИ ЦОД Lumentum и CoherentNVIDIA инвестирует по $2 млрд в Lumentum Holdings и Coherent Corp., выпускающие оптическое сетевое оборудование. Сделки также включает «многомиллиардные» обязательства по закупке определённых лазерных компонентов и доступ к ним в будущем, сообщает Silicon Angle. В случае Coherent речь идёт и о других оптоэлектронных комплектующих. В марте 2025 года NVIDIA представила серию коммутаторов Spectrum-X и Quantum-X для дата-центров, использующих интегрированную фотонику (CPO), что позволило отказаться от использования трансиверов, упростить инфраструктуру и снизить энергопотребление сетевых интерконнектов. Lumentum и Coherent выпускают компоненты для таких систем, причём первая ещё осенью прошлого года начала наращивать производственные мощности по их выпуску. Lumentum входит в число ключевых поставщиков лазерных модулей, оптимально подходящих для CPO — с механизмом терморегулирования и оптимизацией сетевой производительности. Выручка Lumentum в 2025 году составила $655,5 млн. Компания производит и иное сетевое оборудование, в том числе классические трансиверы и оптические коммутаторы (OCS), а также поставляет индустриальные лазеры, например, для сварки металлов. Coherent также выпускает и промышленные лазеры, и оптические решения для дата-центров. Так, недавно компания представила оптимизированный CPO-модуль. Кроме того, Coherent предлагает инструменты для разработки оптических сетевых решений. Coherent и Lumentum используют средства NVIDIA для поддержки исследований и конструкторских разработок. Также компании работают над тем, чтобы нарастить производство в США. После объявления о новых инвестициях акции компаний поднялись в цене более чем на 10 %. Доля NVIDIA на рынке Ethernet-коммутаторов стремительно растёт, во многом благодаря спросу на её же ИИ-платформы. Этот сегмент становится всё более прибыльным для компании. При этом агрессивная политика NVIDIA уже привела к дефициту лазеров.

03.03.2026 [10:50], Сергей Карасёв

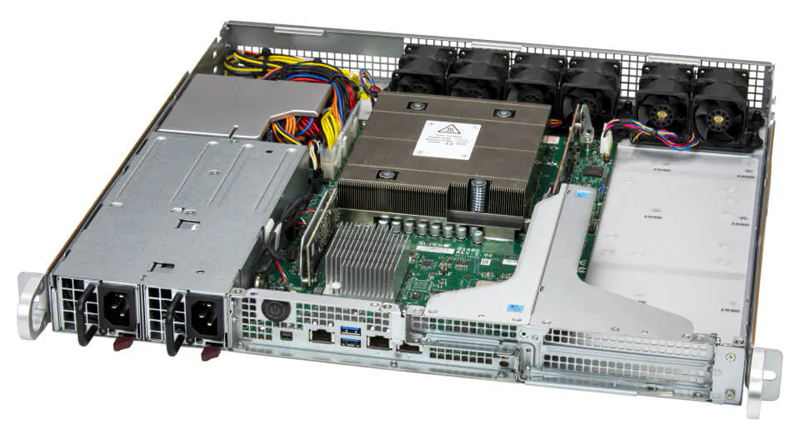

Supermicro представила серверы на базе NVIDIA Grace для инфраструктур AI-RANSupermicro анонсировала серверы на платформе NVIDIA Grace, ориентированные на применение в составе систем AI-RAN. Дебютировали устройства ARS-111L-FR, ARS-221GL-NR и ARS-111GL-NHR, использующие дизайн NVIDIA Aerial RAN Computer (ARC). Модель ARS-111L-FR выполнена в форм-факторе 1U. Задействован один чип NVIDIA Grace, объединяющий 72 вычислительных ядра Arm Neoverse V2 (Armv9). Говорится об использовании 240 Гбайт памяти LPDDR5X. Возможна установка двух ускорителей NVIDIA L4. Сервер оборудован двумя коннекторами M.2 для NVMe SSD с интерфейсом PCIe 5.0 x4, двумя посадочными местами для SFF-накопителей NVMe, двумя слотами для карт PCIe 5.0 x16 FHFL, одним разъёмом PCIe 5.0 x16 HHHL, портами 1GbE (RJ45), USB 3.2 Gen1 (5 Гбит/с) и mini-DP. Могут устанавливаться два блока питания мощностью до 800 Вт с сертификатом 80 Plus Titanium.

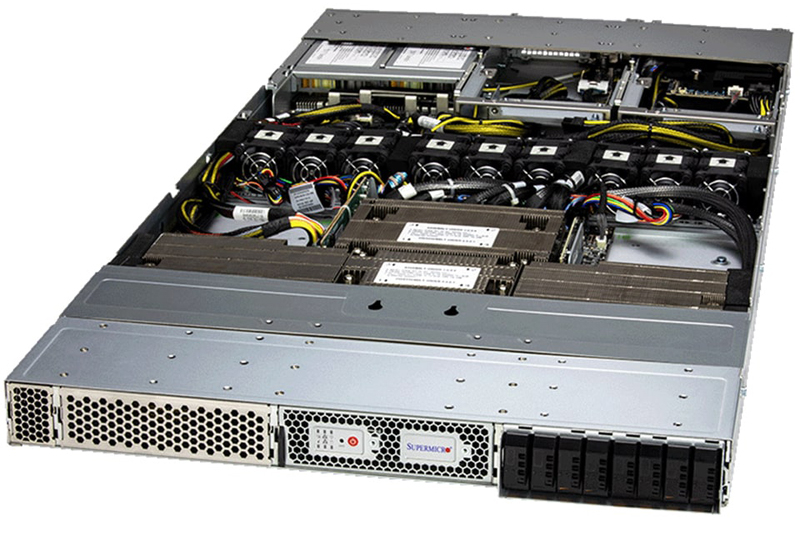

Источник изображений: Supermicro Устройство ARS-221GL-NR, в свою очередь, заключено в корпус 2U. Используется сборка Grace Superchip, которая состоит из двух кристаллов Grace и чипов памяти LPDDR5x общим объёмом до 960 Гбайт. Во фронтальной части располагаются отсеки для NVMe-накопителей E1.S с возможностью горячей замены. Есть два разъёма M.2 M-key 22110 для SSD с интерфейсом PCIe 5.0 x4 (NVMe), три слота для карт PCIe 5.0 x16 FHFL и два слота для карт PCIe 5.0 x16 FHFL двойной ширины. Реализованы порты 1GbE (RJ45), USB 3.0 Type-A (×2) и mini-DP. Питание обеспечивают три блока на 2000 Вт с сертификатом 80 Plus Titanium.  Сервер ARS-111GL-NHR типоразмера 1U несёт на борту NVIDIA GH200. Могут быть установлены до восьми NVMe-накопителей E1.S и два NVMe SSD формата M.2. Доступны два слота для карт PCIe 5.0 x16 FHFL, порты 1GbE (RJ45), USB 3.0 и mini-DP. За питание отвечают два блока мощностью 2000 Вт с сертификатом 80 Plus Titanium. Все новинки оснащены воздушным охлаждением.

02.03.2026 [15:01], Сергей Карасёв

NVIDIA, Ericsson, Nokia и партнёры займутся развитием 6G с использованием ИИ и открытых платформNVIDIA объявила о намерении совместно с партнёрами развивать мобильные сети 6G с применением ИИ, а также открытых и безопасных решений. В инициативе принимают участие Booz Allen, BT Group, Cisco, Deutsche Telekom, Ericsson, MITRE, Nokia, OCUDU Ecosystem Foundation, ODC, SK Telecom, SoftBank и T-Mobile. Проект направлен на формирование «открытой, интеллектуальной и отказоустойчивой» инфраструктуры 6G, способствующей ускорению инноваций в глобальном масштабе. Отмечается, что системы 6G, помимо обеспечения традиционной связи, станут основой для физического ИИ, поддерживая работу миллиардов автономных устройств, транспортных средств, датчиков и роботов. Это значительно повышает требования к безопасности и доверию. Архитектуры, лежащие в основе обычных беспроводных сетей, не способны удовлетворить меняющиеся запросы. Поэтому NVIDIA и партнёры намерены развивать программно-определяемые платформы для беспроводных сетей, изначально созданные с использованием ИИ и открытых разработок. Внедрение ИИ планируется на всех уровнях — RAN, на периферии и в ядре сети. Такой подход позволит сетям 6G обеспечивать безопасную связь, интеллектуальные функции и поддержку принятия решений. Благодаря программно-определяемой архитектуре сети 6G смогут развиваться с течением времени, обрастая новыми функциями. Воспользоваться их преимуществами смогут все участники отрасли — от глобальных операторов и провайдеров услуг до стартапов, исследователей и разработчиков. В целом, как ожидается, сети 6G создадут основу для эры физического ИИ.

28.02.2026 [23:59], Владимир Мироненко

Hyundai инвестирует более $6 млрд в ИИ ЦОД, роботов, водородную и солнечную энергетику

hardware

hyundai

nvidia

водород

ии

инвестиции

робототехника

солнечная энергия

финансы

цод

энергетика

южная корея

Hyundai Motor Group и правительство Южной Кореи подписали соглашение об инвестировании около ₩9 трлн ($6,26 млрд) с целью строительства объединённого инновационного центра в районе Сэмангым (Saemangeum) города Кунсан (Gunsan), который будет включать в себя ИИ ЦОД, завод по производству робототехники и производство водородной/солнечной энергии, сообщило агентство Reuters со ссылкой на министерство земельных ресурсов страны. По данным ведомства, около ₩5,8 трлн (около $4,04 млрд) Hyundai инвестирует в строительство ИИ ЦОД, в котором будет развёрнуто 50 тыс. NVIDIA Blackwell. ЦОД будет оснащён «массивным» хранилищем для хранения огромных массивов данных для обучения, разработки программно-определяемых транспортных средств (SDV) и внедрения «умных заводов», заявили в Hyundai. Ожидается, что интегрированная платформа позволит ускорить исследования и разработку продукции по всей цепочке создания стоимости. Ещё ₩400 млрд (около $278,8 млн) будет выделено на строительство завода по производству роботов, в том числе носимых (экзоскелетов). Также компания инвестирует ₩1 трлн (около $697,2 млн) в строительство электролизерной установки с протонообменной мембраной (Proton Exchange Membrane, PEM) мощностью 200 МВт для производства экологически чистого водорода с использованием возобновляемых источников энергии на месте. Hyundai планирует со временем достичь общей мощности электролизеров в 1 ГВт на внутреннем рынке. Hyundai утверждает, что её технология PEM достигла более чем 90 % локализации, что способствует технологической независимости Южной Кореи и расширению экспортных возможностей экологически чистого водорода, сообщил ресурс Data Center Knowledge. Оставшуюся часть суммы в размере ₩1,3 трлн (около $906,6 млн) компания направит в солнечную энергетику — строительство солнечных электростанций гигаваттного масштаба к 2035 году на основе действующей с 2021 года 99-МВт электростанции. Hyundai рассматривает ЦОД как «мозг» своей ИИ-экосистемы, объединяющий данные производства, логистики и эксплуатации транспортных средств для развития ИИ внутри страны. В центре также будет создан «умный город» с водородными технологиями на основе ИИ, который интегрирует технологии в единую экосистему. Строительство ЦОД, солнечной инфраструктуры и объекта по производству водорода планируется начать в 2027 году и завершить в 2029 году. По прогнозам Hyundai, эти инвестиции принесут экономический эффект в размере около ₩16 трлн (примерно $11 млрд) и позволят создать около 71 тыс. рабочих мест.

26.02.2026 [15:14], Владимир Мироненко

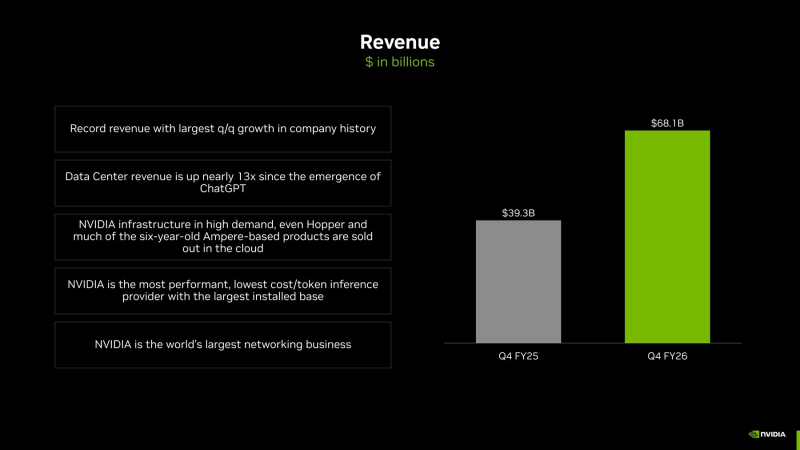

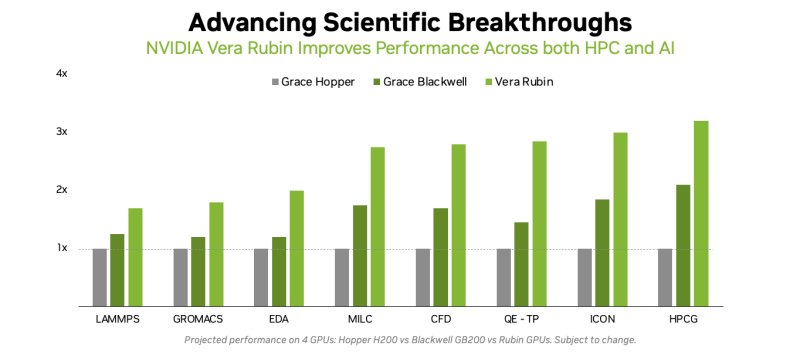

И без Китая всё отлично: квартальные показатели NVIDIA превзошли ожидания благодаря растущим продажам решений для ЦОДNVIDIA опубликовала отчёт о финансовых результатах за IV квартал и 2026 финансовый год, закончившийся 25 января 2026 года. Результаты компании превзошли ожидания Уолл-стрит. Общая выручка NVIDIA за IV финансовый квартал составила $68,13 млрд, что на 20 % больше, чем в III квартале, и на 73 % больше, чем годом ранее, превысив прогноз аналитиков, опрошенных LSEG, в размере $66,21 млрд (по данным CNBC). Скорректированная чистая прибыль на разводнённую акцию (Non-GAAP) составила $1,62 при прогнозе от LSEG в размере $1,53. Чистая прибыль (GAAP) составила $42,96 млрд или $1,76 на разводнённую акцию, тогда как годом ранее эти показатели равнялись $22,09 млрд и $0,89 соответственно. Валовая маржа (GAAP) выросла примерно на 160 базисных пунктов по сравнению с III кварталом и достигла 75 % в отчётном квартале, что соответствует прогнозам Уолл-стрит и немного превосходит ожидания компании. NVIDIA ожидает, что в текущем квартале маржа сократится на 10 базисных пунктов. В I квартале 2027 финансового года компания также ожидает получить выручку в размере $78 млрд ± 2 % (без учёта продаж для ЦОД в Китае) при прогнозе аналитиков в размере $72,6 млрд. «Спрос на вычислительные ресурсы растет экспоненциально — наступил переломный момент в развитии агентного ИИ. Grace Blackwell с NVLink сегодня является лидером в области инференса, обеспечивая на порядок меньшую стоимость токена, а Vera Rubin ещё больше укрепит это лидерство», — сказал Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA. «Внедрение агентов в корпоративном секторе стремительно растет. Наши клиенты стремятся инвестировать в вычислительные мощности для ИИ — в фабрики, которые обеспечивают промышленную революцию в области ИИ и их будущий рост», — добавил он. Более 91 % продаж компании приходится на сегмент решений для ЦОД, выручка которого составила $62,3 млрд, что на 75 % больше год к году, а также превысило ожидания аналитиков в $60,69 млрд, согласно данным StreetAccount. В этом сегменте выручка от поставки решений для вычислений выросла на 58 % год к году до $51,33 млрд, а выручка от продаж сетевого оборудования увеличилась за квартал на 263 % до $10,98 млрд. Финансовый директор Колетт Кресс (Colette Kress) объяснила быстрый рост бизнеса «продолжающимся наращиванием вычислительной инфраструктуры NVLink для систем GB200 и GB300, а также развитием платформ Ethernet и InfiniBand». NVIDIA отметила, что гиперскейлеры «остаются нашей крупнейшей категорией клиентов», на которые приходится чуть более 50 % выручки в сегменте решений для ЦОД. Колетт Кресс также заявила, что, хотя администрация США одобрила поставки «небольших объёмов» чипов H200 для китайских клиентов, а Китай формально разрешил закупки, компания пока не получила от них никакой выручки. «Мы не знаем, будет ли разрешён какой-либо импорт в Китай», — сказала Кресс. Это заявление в корне отличается от её сообщения в прошлом месяце о скорых поставках в КНР и о том, что власти США «лихорадочно работают» над уточнением деталей соглашения о разделе доходов. «Чтобы сохранить свои лидирующие позиции в области вычислительных мощностей для ИИ, Америка должна взаимодействовать с каждым разработчиком и быть предпочтительной платформой для каждого коммерческого предприятия, включая предприятия в Китае, — сказала она. — Мы продолжим взаимодействовать с правительствами США и Китая и отстаивать способность Америки конкурировать на мировом рынке». Среди других направлений деятельности NVIDIA, выручка от игрового бизнеса за IV финансовый квартал выросла год к году на 47 % до $3,7 млрд, хотя и уменьшилась на 13 % по сравнению с предыдущим кварталом. Автомобильное и робототехническое подразделение компании увеличило продажи год к году на 6 % до $604 млн, что ниже ожиданий аналитиков в $654,8 млн, согласно данным StreetAccount. В сегменте профессиональной визуализации продажи выросли на 159 % до $1,3 млрд, значительно превысив прогноз аналитиков в $755,4 млн, согласно данным StreetAccount. По итогам за 2026 финансовый год выручка NVIDIA составила $215,94 млрд, что на 65 % больше, чем годом ранее. Валовая маржа (GAAP) составила 71,1 % против 75,0 % годом ранее (падение — 3,9 п.п.). Чистая прибыль (GAAP) равна $120,07 млрд или $4,9 на разводнённую акцию против $72,88 млрд (рост 65 %) или $2,94 на разводнённую акцию годом ранее.

25.02.2026 [11:55], Сергей Карасёв

Akash Systems начала поставки первых в мире GPU-серверов с алмазным охлаждениемКомпания Akash Systems, базирующаяся в Сан-Франциско (Калифорния, США), объявила о начале поставок первых в мире ИИ-серверов, оснащённых системой алмазного охлаждения Diamond Cooling. Заказчиком выступил NxtGen AI PVT Ltd — крупнейший в Индии государственный облачный провайдер. Технология Diamond Cooling основана на применении синтетических алмазов. Этот материал обладает самой высокой теплопроводностью из всех известных соединений. Akash Systems подчёркивает, что синтетические алмазы способны отводить тепло от чипов в пять раз эффективнее по сравнению с медью, что открывает качественно новые возможности в плане охлаждения современного оборудования высокой плотности для дата-центров, ориентированных на задачи ИИ и НРС. Akash Systems поставляет серверы на базе NVIDIA H200, для охлаждения которых применяется система Diamond Cooling. В отличие от стандартных ЦОД, оборудование в которых функционирует при температурах от +24 до +29 °C, серверы с технологией Diamond Cooled способны обеспечивать максимальную производительность при температуре окружающей среды до +50 °C. Благодаря этому снижаются общие требования к системам охлаждения дата-центров, что позволяет уменьшить эксплуатационные расходы. Среди одного из ключевых преимуществ Diamond Cooling разработчики называют устранение теплового троттлинга: это обеспечивает наилучшее быстродействие при выполнении ресурсоёмких задач, таких как обучение больших языковых моделей (LLM) и инференс. Кроме того, достигается повышение производительности (Флопс/Вт) до 15 % на каждый сервер. Плюс к этому существенно сокращается общее энергопотребление ЦОД, поскольку отпадает необходимость в интенсивном охлаждении. «Система Diamond Cooling решает две самые сложные проблемы в гонке ИИ — повышение энергоэффективности и сокращение капиталовложений. В ситуации, когда увеличение вычислительной мощности на 1–2 % имеет большое значение, повышение на 15 % фактически меняет правила игры», — говорит доктор Феликс Эджекам (Felix Ejeckam), соучредитель и генеральный директор Akash Systems.

20.02.2026 [22:30], Владимир Мироненко

Не $100 млрд, а $30 млрд, и не выиграл, а переиграл — NVIDIA и OpenAI готовят новую инвестиционную сделкуМноголетняя сделка между NVIDIA и OpenAI, в рамках которой производитель ИИ-ускорителей обязался инвестировать в разработчика ИИ-моделей $100 млрд, так и не была подписана. Вместо неё компании готовят более простую схему с инвестициями NVIDIA в акционерный капитал OpenAI в размере $30 млрд в обмен на её акции, сообщил ресурс The Financial Times. По данным источников The Financial Times, переговоры по этому поводу находятся на завершающей стадии, решение может быть принято уже в эти выходные. Инвестиции NVIDIA в акционерный капитал OpenAI в размере $30 млрд являются частью более крупного раунда финансирования, который, как ожидается, позволит OpenAI привлечь более $100 млрд с оценкой её рыночной стоимости в $730 млрд, не считая новых средств, сообщили источники. OpenAI реинвестирует большую часть нового капитала в оборудование NVIDIA, но компании откажутся от прежней сделки на $100 млрд, о которой было объявлено в сентябре, добавили источники. По словам источников, это финансирование поддержит создание новых вычислительных мощностей и, вероятно, со временем приведет к заключению новых сделок. Как отметил ресурс eWeek, на практике ничего не поменяется: OpenAI по-прежнему нуждается в огромных вычислительных мощностях, а NVIDIA по-прежнему находится в центре цепочки поставок оборудования, обеспечивающей работу современной экономики ИИ. Меняется лишь то, как формируются риски, сроки и обязательства. Ранее руководители OpenAI и NVIDIA попытались развеять слухи об охлаждении отношений между их компаниями в связи с замораживанием сделки на $100 млрд. «Нам нравится работать с NVIDIA, и они производят лучшие в мире чипы для ИИ. Мы надеемся оставаться их ключевым клиентом очень долгое время», — заявил генеральный директор OpenAI Сэм Альтман (Sam Altman). Следом глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил CNBC, что любые предположения о «спорах» — это «ерунда». «Нам нравится работать с OpenAI», — сказал он. Тем не менее, OpenAI подписала в начале года крупную сделку с Cerebras и уже начала использовать её царь-чипы. Кроме того, у OpenAI есть и сделка с AMD. По словам источников The Financial Times, OpenAI также находится на заключительном этапе переговоров с SoftBank по поводу инвестиций около $30 млрд, и Amazon, которая может инвестировать до $50 млрд в рамках более широкого партнёрства, предполагающего использование ИИ-моделей GPT. Ожидается, что MGX, государственный инвестиционный фонд Абу-Даби в сфере технологий, и Microsoft также инвестируют крупные суммы, а руководители OpenAI на этой неделе встречаются с венчурными капиталистами и другими инвесторами по поводу дальнейших инвестиционных проектов, добавили источники.

19.02.2026 [09:52], Владимир Мироненко

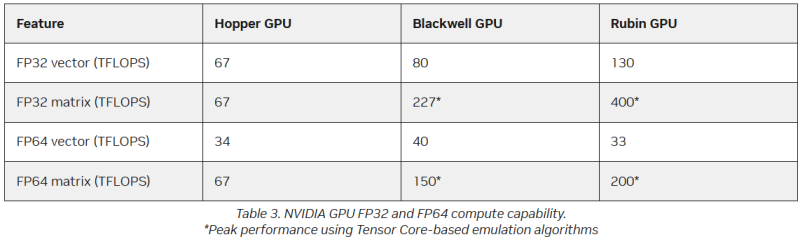

Американская «Миссия Генезис» будет во многом полагаться на «ненастоящие» FP64-вычисленияХотя последнее поколение GPU ориентировано на вычисления с более низкой точностью, которые предпочтительны для ИИ-задач, FP64-вычисления с более высокой точностью по-прежнему «очень важны» для «Миссии Генезис» (Genesis Mission) и её цели — ускорения научных открытий с помощью ИИ, заявил заместитель министра энергетики США по науке и инновациям Дарио Гил (Darío Gil) в интервью HPCwire. «В ходе обсуждений, которые я провел как с [генеральным директором AMD] Лизой Су (Lisa Su), так и с [генеральным директором NVIDIA] Дженсеном [Хуангом] (Jensen Huang), они выразили твёрдую приверженность FP64, подтвердив, что поддержка формата будет продолжаться, — сказал Гил. — Для нас это очень важно, потому что мы не рассматриваем это как замену. Это взаимодополняющие технологии». Он отметил, что для обеспечения вычислительных задач моделирования и симуляции, которые традиционно составляют основу научных вычислений, а также для новых методов ИИ, важно иметь высокопроизводительное оборудование. Гил добавил, что эти два типа вычислений будут работать вместе, чтобы поддержать цель миссии Genesis — расширение границ науки и техники на основе ИИ-технологий. «У вас есть высокоточные симуляционные коды, работающие с FP64. После проверки вы используете их в качестве основы для генерации примеров, на которых вы обучаете суррогатную модель, которую затем запускаете на ИИ-суперкомпьютере, — рассказал Гил. — В итоге вы получаете преимущества с точки зрения производительности и времени решения, часто в 10, 20, 100 раз». Он отметил, что благодаря использованию ИИ-моделей можно получить громадное повышение производительности, но оно зависит от сохранения всего цикла работ, состоящего из экспериментов, моделирования и обучения. «Если вы разорвёте этот цикл и скажете, что у вас больше нет кодов моделирования, то возникнет проблема», — сказал Гил. «Для нас это имеет фундаментальное значение, не только для устаревших кодов, которые мы должны сопровождать и которые так важны для миссии, но и для обеспечения рабочего ИИ-процесса. Поэтому для нас очень важно поддерживать различные архитектурные подходы», — добавил он. В HPC-сообществе возникла обеспокоенность по поводу отсутствия прироста производительности для FP64 в новейших GPU. Напомним, что чип NVIDIA H100, выпущенный в 2022 году, обеспечивает 67 Тфлопс в формате FP64 на тензорных ядрах (34 Тфлопс в векторных вычислениях), в то время как B200 предлагает лишь 37 Тфлопс, а B300 — всего лишь 1,3 Тфлопс. Программная эмуляция FP64-вычислений на тензорных ядрах Blackwell позволяет получить «нечестные» 150 Тфлопс, а из новейших Rubin она позволяет «выжать» 200 Тфлопс. При этом пиковая заявленная производительность векторных FP64-вычислений у Rubin составляет лишь 33 Тфлопс, т.е. нет никакого прироста в сравнении с Hopper. Отметим, что в AMD раскритиковали такой подход, заявив, что он эффективен не для всех сценариев и поэтому такое решение ещё не готово к широкому применению. В свою очередь, эксперты предупреждают, что смещение фокуса производителей на выпуск чипов для ИИ-нагрузок, которые отлично работают с вычислениями с низкой точностью, может привести к дефициту чипов с поддержкой FP64 для HPC, а это грозит потерей лидерства США в этом сегменте рынка. По мере того, как NVIDIA наращивает мощность для выполнения ИИ-задач с низкой точностью вычислений Rubin, компания будет всё больше полагаться на cuBLAS, библиотеку стандартных математических операций CUDA-X, которая эмулирует вычисления с двойной точностью на тензорных ядрах, чтобы постоянно наращивать показатели FP64-производительности. «Мы пытаемся предоставить эти возможности среде разработчиков, чтобы они могли… получить необходимую точность FP64», — заявил в декабре HPCwire Дион Харрис (Dion Harris), старший директор NVIDIA по ИИ/HPC-решениям для гиперскейлеров. Методы эмуляции NVIDIA основаны на схеме Озаки (Ozaki), позволяющей выполнять умножение матриц с высокой точностью, используя многократные вычисления с низкой точностью на тензорных ядрах. NVIDIA утверждает, что использование алгоритма Озаки оправдано, поскольку увеличение производительности FP64 путём добавления большего количества ядер CUDA фактически не повысит общую производительность HPC-приложений, но сделает чипы менее гибкими. По словам компании, анализ реальных нагрузок показывает, что «наивысшая устойчивая производительность FP64 часто достигается на умножении матриц». В Hopper для этого были отдельные аппаратные блоки, но в Blackwell и в Rubin NVIDIA больше опирается на эмуляцию. В то же время, производительность векторных FP64-вычислений остаётся критически важной для научных приложений, в которых не доминируют матричные ядра, признаёт NVIDIA, однако тут же утверждает, что в этих случаях производительность ограничивается перемещением данных через регистры, кеши и HBM, а не непосредственно вычислительными ресурсами. Поэтому сбалансированная конструкция GPU «обеспечивает достаточное количество ресурсов FP64 для насыщения доступной пропускной способности памяти, избегая избыточного выделения вычислительной мощности, которая не может быть эффективно использована». Иными словам, компания ничего менять не собирается. Проект Genesis Mission, вероятно, будет создавать разнообразные ИИ-приложения для научных и инженерных задач, и каждое из них, скорее всего, будет иметь несколько иные вычислительные потребности. Достигли ли NVIDIA и AMD оптимального баланса, используя вычислительные ядра для матричных вычислений и опираясь на эмуляцию Озаки для FP64, ещё предстоит выяснить, пишет HPCwire. |

|