Материалы по тегу: groq

|

03.02.2026 [17:15], Руслан Авдеев

OpenAI не устроили чипы NVIDIA для инференса, теперь она ищет альтернативыПо данным многочисленных отраслевых источников, компания OpenAI недовольна некоторыми ИИ-чипами NVIDIA и с прошлого года ищет им альтернативы. Потенциально это усложнит отношения между крупнейшими игроками рынка на фоне бума ИИ, сообщает Reuters. Изменения стратегии OpenAI связаны с усилением акцента на инференсе. NVIDIA доминирует в нише ускорителей для обучения ИИ-моделей, но теперь инференс стал отдельным рынком с сильной конкуренцией. Решение OpenAI — вызов доминированию NVIDIA в сфере ИИ и препятствие $100-млрд сделки между компаниями, обеспечивающей разработчику чипов долю в ИИ-стартапе в обмен на доступ к передовым ускорителям. Предполагалось, что сделка будет закрыта за недели, но вместо этого переговоры ведутся месяцами. В то же время OpenAI заключила соглашение с AMD и Cerebras (её в своё время даже хотели купить) для получения «альтернативных» чипов, а также разрабатывает собственный ИИ-ускоритель при участии Broadcom. Amazon тоже не прочь предоставить OpenAI собственные ускорители, равно как и Google. Изменение планов OpenAI изменило и потребности в вычислительных мощностях и замедлило переговоры с NVIDIA. В минувшую субботу глава NVIDIA Дженсен Хуанг (Jensen Huang) опроверг слухи о проблемах с OpenAI, назвав их «чепухой» и подчеркнув, что клиенты продолжают выбирать NVIDIA для инференса, поскольку компания обеспечивает наилучшее соотношение производительности и совокупной стоимости владения, причём в больших масштабах. Отдельно представитель OpenAI заявлял, что компания полагается на NVIDIA для поставок большинства чипов для инференса, причём именно NVIDIA обеспечивает наилучшую производительность на каждый вложенный доллар. Глава OpenAI Сэм Альтман (Sam Altman) отметил, что NVIDIA выпускает «лучшие чипы в мире» и есть надежда, что OpenAI останется её «гигантским» клиентом очень долгое время. При этом, как сообщает Reuters со ссылкой на семь источников, OpenAI не удовлетворена производительностью инференса, на которую способны чипы NVIDIA. В частности, речь идёт о специализированных задачах вроде разработки ПО с помощью ИИ и коммуникаций ИИ с другим ПО. По данным одного из источников, компании понадобится новое аппаратное обеспечение, которое в конечном счёте обеспечит в будущем порядка 10 % вычислительных мощностей для инференса. OpenAI обсуждала возможности работы с ИИ-стартапами, включая Cerebras и Groq для обеспечения чипов с более быстрым инференсом, но NVIDIA фактически поглотила Groq на $20 млрд, что привело к прекращению переговоров с компанией. Хотя формально речь идёт неэксклюзивном лицензировании технологий Groq, что в теории позволяет сторонним компаниям получить доступ к решениям Groq, фактически все разработчики перешли в NVIDIA, а оставшаяся небольшая команда отвечает за выполнение облачных контрактов с имеющимися заказчиками. Чипы NVIDIA хорошо подходят для обработки больших объёмов данных при обучении больших ИИ-моделей вроде тех, что стоят за ChatGPT. Тем не менее прогресс требует массового использования уже обученных моделей для дальнейшего инференса и ИИ-рассуждений. Как сообщается, OpenAI с 2025 года ищет альтернативы ускорителям NVIDIA с упором на компании, создающие чипы с большими объёмами интегрированной SRAM. Maia 200 от Microsoft, по-видимому, компании не очень подходит. Инференс моделей более требователен к памяти, чем обучение, а вычислительная нагрузка, наоборот, не так велика. В тоге нередко на доступ к данным уходит больше времени, чем на расчёты. NVIDIA и AMD полагаются на внешнюю память, что замедляет соответствующие процессы общения с чат-ботами. В OpenAI проблемы отметили при эксплуатации системы Codex, активно продвигаемой компанией для создания кода. В компании считают, что некоторые слабости системы связаны именно с оборудованием NVIDIA. Конкуренты OpenAI полагаются на альтернативное оборудование. Anthropic активно использует AWS Trainium и Google TPU, а Google уже много лет использует свои TPU, которые с недавних пор готова отдавать на сторону. TPU оптимизированы в том числе для инференса и в некоторых отношениях более производительны, чем GPU общего назначения AMD и NVIDIA. Когда OpenAI недвусмысленно выразила отношение к технологиям NVIDIA, та предложила компаниям, создающим ускорители с упором на SRAM, включая Cerebras и Groq, купить их бизнес. Cerebras отказалась и заключила прямую сделку с OpenAI. Groq вела переговоры с OpenAI о предоставлении вычислительных мощностей, что вызвало интерес у инвесторов, оценивших капитализацию компании на уровне $14 млрд.

14.01.2026 [09:45], Владимир Мироненко

Самая загадочная сделка 2025 года: зачем NVIDIA потратила $20 млрд на Groq?Сделка NVIDIA с ИИ-стартапом Groq, фактически означающая его поглощение, вызвала вопросы по поводу целей, которые преследует лидер ИИ-рынка. Для того, чтобы избежать волокиты с одобрением сделки регулирующими органами и антимонопольных расследований, NVIDIA провела её под видом приобретения неисключительной лицензии на технологии Groq. В результате сделки ключевые кадры Groq перешли в NVIDIA, а остатки команды во главе с финансовым директором продолжат управлять инфраструктурой GroqCloud и вряд ли смогут сохранить былую конкурентоспособность стартапа. Похожую сделку NVIDIA провела немногим ранее, фактически поглотив стартап Enfabrica, занимавшийся разработкой интерконнекта. В случае с Enfabrica, по слухам, сумма сделки составила $900 млн. Это большая сумма для стартапа, находящегося на ранней стадии, но вполне обоснованная в нынешних условиях, пишет EE Times. Groq — более крупный стартап, но и стоимость сделки гораздо выше — $20 млрд при последней оценке стартапа на уровне $6,9 млрд. Если в отношении Enfabrica предполагалось, что сделка была связана, хотя бы частично, с наймом персонала, то для Groq такая большая сумма вряд ли выглядит оправданной, если речь идёт только о привлечении квалифицированных кадров. Можно допустить, что NVIDIA планирует выпускать чипы Groq. Их упомянул в электронном письме сотрудникам гендиректор NVIDIA Дженсен Хуанг: «Мы планируем интегрировать процессоры Groq с низкой задержкой в архитектуру NVIDIA AI Factory, расширив платформу для обслуживания ещё более широкого спектра задач ИИ-инференса и рабочих нагрузок в реальном времени». Вместе с тем в ходе CES 2026 Хуанг заявил, что технология Groq не станет частью основного портфолио NVIDIA для ЦОД. «[Groq] — это совсем, совсем другое, и я не ожидаю, что что-либо заменит то, что мы делаем с Vera Rubin и нашим следующим поколением, — сказал Хуанг. — Однако мы могли бы добавить его технологию таким образом, чтобы что-то постепенно улучшить, чего мир ещё не смог сделать». Судя по фразе «могли бы», NVIDIA пока окончательно не определилась с тем, что будет делать с активами Groq. Технология Groq позволит решать задачи, которые недоступны для Vera Rubin, в частности, сверхбыстрый инференс в реальном времени, пишет EE Times. Можно предположить, что NVIDIA будет производить и развёртывать чипы Groq как отдельное решение в ЦОД. Хотя Хуанг и сказал об интеграции чипов Groq с архитектурой NVIDIA AI Factory, это всё ещё кажется несколько надуманным, так как означает признание NVIDIA в том, что её GPU не вполне подходят для некоторых рабочих нагрузок. Однако Дженсен Хуанг в очередной раз подчеркнул на CES 2026, что гибкости GPU вполне хватит для любых нагрузок. Впрочем, анонс соускорителей Rubin CPX говорит скорее об обратном. У Groq есть собственный программный стек, но насколько он хорош, сказать трудно. Для перезапуска технологий Groq в качестве продукта NVIDIA потребуется немало работы над ПО, а полноценная интеграция в программную экосистему может оказаться очень сложной. Более реалистичным вариантом может быть использование чиплета Groq вместе с большим чиплетом GPU для обработки определённых нагрузок, но и в этом случае ПО станет камнем преткновения, поскольку аппаратная часть принципиально слабо совместима с CUDA. Возникает вопрос: «Что же есть у Groq, чего нет у NVIDIA?». Одним из ответов может быть детерминизм — концепция, лежащая в основе архитектуры LPU Groq, которую компания пыталась продвинуть в автомобильной промышленности в 2020 году. Детерминизм имеет существенные преимущества для приложений, требующих функциональной безопасности, включая робототехнику — Хуанг в письме, упомянутом выше, говорит о «приложениях реального времени». Но для этого NVIDIA придется изменить свою риторику, признав, что для периферийных вычислений её ускорители подходят не всегда. В любом случае, у NVIDIA имеются огромные ресурсы и команда квалифицированных специалистов. Если бы она захотела создать ИИ-ускоритель, ориентированный на работу со SRAM, а не HBM, это обошлось бы гораздо дешевле уплаченных за Groq $20 млрд. Кроме того, утверждает EE Times, она могла бы за существенно меньшую сумму пробрести d-Matrix или даже SambaNova, которая готова продаться Intel всего за $1,6 млрд. Как полагают аналитики EE Times, помимо лицензирования технологии и найма специалистов Groq, в принятии решения купить стартап также сыграли роль коммерческие факторы. Groq имеет обширные партнёрские отношения с крупными компаниями стран Персидского залива. У стартапа также есть соглашения о суверенном ИИ и в других странах, что могло показаться привлекательным для NVIDIA. Тем не менее, одним из главных аргументов в пользу покупки Groq до сих пор было то, что это вполне жизнеспособная и недорогая альтернатива NVIDIA для построения суверенной ИИ-инфраструктуры. То есть покупку Groq можно также объяснить желанием помешать одному из клиентов-гиперскейлеров купить Groq, будь то из-за аппаратной интеллектуальной собственности или уже развёрнутой инфраструктуры. Это может быть Meta✴, Microsoft или даже OpenAI, чьи планы по созданию собственного ИИ-оборудования всё ещё находятся на стадии подготовки или пока имеют умеренный успех, тогда как Google уже готов отдать «на сторону» свои ускорители TPU, а AWS со своими Trainium всё-таки готова сотрудничать с NVIDIA по аппаратной части. В свою очередь, аналитики ресурса The Register объясняют покупку Groq за столь крупную сумму интересом NVIDIA к «конвейерной архитектуре» (dataflow) стартапа, которая, по сути, создана специально для ускорения вычислений линейной алгебры, выполняемых в ходе инференса. Стоит отметить, что архитектуры с управляемым потоком данных не ограничиваются проектами, ориентированными на SRAM. Например, NextSilicon использует HBM. Groq выбрал SRAM только потому, что это упростило задачу, но нет никаких причин, по которым NVIDIA не могла бы создать dataflow-ускоритель на основе IP-блоков Groq, используя SRAM, HBM или GDDR, пишет The Register. Правильно реализовать такую архитектуру очень сложно, но Groq удалось заставить её работать надлежащим образом, по крайней мере, для инференса, утверждает The Register. Таким образом, Groq даст NVIDIA оптимизированную для инференса вычислительную архитектуру, чего ей так сильно не хватало, полагают аналитики ресурса. Именно этого и не хватает NVIDIA, поскольку у неё фактически нет выделенных чипов для этой задачи. Ситуация изменится с запуском NVIDIA Rubin в 2026 году и их «напарников» Rubin CPX. При этом ускорители Groq LPU в силу малого объёма SRAM для обработки современных LLM необходимо объединять в кластеры из десятков и сотен чипов. Это верно и для других ускорителей примерно того же типа, включая Cerebras. Вместе с тем LPU, по мнению The Register, теоретически могут пригодиться для т.н. спекулятивного декодирования, когда малая модель, не больше нескольких миллиардов параметров, используется для предсказания ответов большой модели. Если малая модель правильно «угадывает» их, общая производительность инференса может вырасти в два-три раза. Стоит ли такая опция $20 млрд, вопрос отдельный, но Хуанг, по-видимому, играет вдолгую.

29.12.2025 [23:06], Владимир Мироненко

Ни один сотрудник Groq не останется внакладе в результате сделки с NVIDIAЗаключение NVIDIA соглашения с Groq, своим конкурентом в области производства ИИ-ускорителей, вызвало вопросы, что означает эта сделка для самих компаний, а также их сотрудников. Структура сделки, оцениваемой, по данным источников Axios, в $20 млрд, призвана свести к минимуму возможность столкновения с обвинениями в нарушении антимонопольного законодательства со стороны регуляторов, поскольку формально нигде на бумаге не зафиксирован факт покупки. Подобного рода сделки заключались на ИИ-рынке и ранее. Согласно условиям соглашения, Groq продолжит действовать как самостоятельная компания под руководством нового гендиректора Саймона Эдвардса (Simon Edwards), ранее исполнявшего обязанности финансового директора. А нынешний генеральный директор Groq Джонатан Росс (Jonathan Ross) и президент Санни Мадра (Sunny Madra) присоединятся к NVIDIA. Оставшиеся сотрудники, по-видимому, будут ответственны за обслуживание ускорителей на Ближнем Востоке и в Европе. Согласно данным источников Axios, большинство акционеров Groq получат выплаты на акцию, привязанные к оценке рыночной стоимости стартапа в $20 млрд. Около 85 % назначенной суммы будет выплачено авансом, еще 10 % — в середине 2026 года, а оставшаяся часть — в конце 2026 года. Также сообщается, что около 90 % персонала Groq перейдёт в NVIDIA. Всем им причитается выплата наличными за все полностью принадлежащие (vested) акции в стартапе. Акции, которые будут им принадлежать после выполнения определённых условий (unvested), будут оплачены согласно оценке стартапа в $20 млрд акциями NVIDIA, которые перейдут в их полную собственность согласно графику. Около 50 человек, перешедших в NVIDIA, получат выплату за все пакеты акций наличными в ускоренном порядке. Остальные сотрудники Groq также получат выплаты за имеющиеся акции стартапа, а также пакет, обеспечивающий экономические стимулы участия в деятельности стартапа. Всем сотрудникам Groq, проработавшим менее года, будет отменен «период ожидания» (vesting period) для закреплённых за ними акций. Благодаря этому ценные бумаги перейдут в их полное владение раньше срока, и они смогут их продать при желании. Также сообщается, что с момента своего основания в 2016 году Groq привлёк около $3,3 млрд венчурного капитала. В число его инвесторов вошли Social Capital, Disruptive, BlackRock, Neuberger Berman, Deutsche Telekom Capital Partners, Samsung, 1789 Capital, Cisco, D1, Cleo Capital, Altimeter, Firestreak Ventures, Conversion Capital и Modi Venture. Кроме того, известно, что Groq ни разу не проводил вторичный тендер, то есть у него не было случаев, когда не были достигнуты намеченные цели по финансированию.

25.12.2025 [02:15], Игорь Осколков

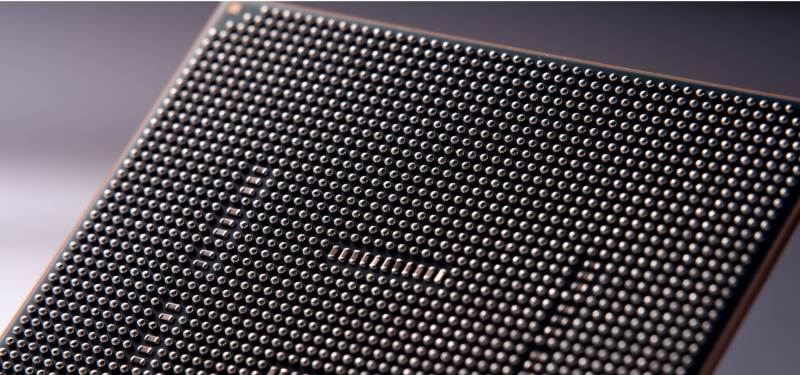

NVIDIA купит за $20 млрд активы разработчика ИИ-ускорителей Groq — это самая дорогая покупка в истории компанииNVIDIA приобретёт активы Groq, своего конкурента в области ИИ-ускорителей, за $20 млрд, передаёт CNBC. Сама Groq заявила, что «заключила неисключительное лицензионное соглашение с NVIDIA на технологии инференса» и что основатель и генеральный директор Groq Джонатан Росс (Jonathan Ross), а также президент компании Санни Мадра (Sunny Madra) и другие высокопоставленные сотрудники «присоединятся к NVIDIA, чтобы помочь продвижению и масштабированию лицензированной технологии». При этом Groq продолжит свою деятельность как независимая компания под руководством Саймона Эдвардса (Simon Edwards). Финансовый директор Nvidia Колетт Кресс (Colette Kress) отказалась комментировать сделку. По-видимому, речь фактически идёт о поглощении Groq, а столь необычная форма сделки выбрана, по примеру других, в попытке снизить внимание к ней регулирующих органов. Стоимость сделки официально не называется, однако Алекс Дэвис (Alex Davis), глава Disruptive, которая инвестировала в Groq более $500 млн, называет сумму в $20 млрд, причём «живыми» деньгами. Дэвис сообщил CNBC, что NVIDIA получит все активы Groq, за исключением её облачного бизнеса. Groq заявила, что «GroqCloud продолжит работать без перебоев». В электронном письме сотрудникам, полученном CNBC, глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что сделка расширит возможности NVIDIA: «Мы планируем интегрировать ускорители Groq в архитектуру NVIDIA AI Factory, расширив платформу для обслуживания ещё более широкого спектра задач инференса и рабочих нагрузок в реальном времени». Хуанг добавил: «Хотя мы пополняем наши ряды талантливыми сотрудниками и лицензируем интеллектуальную собственность Groq, мы не приобретаем Groq как компанию». Эта сделка является крупнейшей покупкой NVIDIA за всю историю. До этого самой крупной сделкой была покупка Mellanox почти за $7 млрд в 2019 году. В конце октября у NVIDIA было $60,6 млрд наличных средств и краткосрочных инвестиций, что на $13,3 млрд больше, чем в начале 2023 года. По схожей с Groq схеме была организована и сделка c Enfabrica, в рамках которой NVIDIA заплатила $900 млн деньгами и акциями за лицензирование технологий и переход главы Enfabrica Рочана Санкара (Rochan Sankar) и других ключевых в NVIDIA. Всего три месяца назад Groq, основанная в 2016 году разработчиками ИИ-ускорителей Google TPU, привлекла $750 млн при оценке примерно в $6,9 млрд. Раунд возглавила Disruptive, к которой присоединились Blackrock, Neuberger Berman, Deutsche Telekom Capital Partners, Samsung, Cisco, D1, Altimeter, 1789 Capital и Infinitum. Повлияло ли на решение NVIDIA слухи о намерении Intel купить разработчика ИИ-ускорителей для инференса SambaNova, который наряду с Cerebras является одним из немногих стартапов, способных составить хоть какую-то серьёзную конкуренцию NVIDIA, не уточняется. Сама Groq планировала достичь выручки в $500 млн в этом году. По словам Дэвиса, компания не планировала продажу, когда к ней обратилась NVIDIA. В сентябре NVIDIA объявила о намерении вложить $5 млрд в Intel, а также инвестировать до $100 млрд в OpenAI. Впрочем, последняя сделка носит циклический характер и пока далеко не продвинулась.

21.10.2025 [00:35], Владимир Мироненко

Ещё одна альтернатива платформам NVIDIA — IBM объединила усилия с GroqIBM и Groq объявили о стратегическом партнёрстве с целью предоставления клиентам возможностей высокоскоростного ИИ-инференса по доступной цене путём объединения watsonx Orchestrate от IBM с аппаратными решениями Groq, что позволит ускорить развёртывание агентных систем ИИ. В рамках партнёрства Groq и IBM планируют интегрировать и усовершенствовать технологию Red Hat vLLM с архитектурой LPU Groq. Ожидается, что совместное решение позволит клиентам использовать возможности watsonx Orchestrate привычным образом и с привычными инструментам в инференс-платформе GroqCloud, предоставляющей разработчикам доступ к высокоскоростной и недорогой обработке LLM. Эта интеграция позволит удовлетворить ключевые потребности разработчиков ИИ-решений, включая оркестрацию инференса, балансировку нагрузки и аппаратное ускорение, что в конечном итоге оптимизирует сам процесс инференса. Также планируется поддержка моделей IBM Granite в GroqCloud для клиентов IBM. IBM отметила, что предприятия при переводе ИИ-агентов из пилотной версии в промышленную эксплуатацию продолжают сталкиваться с проблемами обеспечения скорости, стоимости и надёжности. Партнёрство IBM и Groq позволяет объединить скорость инференса Groq, экономическую эффективность и доступ к новейшим open source моделям с оркестрацией агентского ИИ IBM, предоставляя клиентам инфраструктуру, необходимую для их масштабирования, говорит компания. IBM сообщила, что LPU обеспечивают минимум в пять раз более быстрый и экономичный инференс, чем системы на ускорителях конкурентов, имея, по всей видимости, в виду NVIDIA. Это позволяет обеспечить стабильно низкую задержку и производительность при масштабировании нагрузок, что особенно важно для ИИ-агентов в регулируемых отраслях. В качестве примера IBM привела деятельность клиентов из сферы здравоохранения, которые одновременно получают тысячи сложных вопросов пациентов. Благодаря Groq ИИ-агенты IBM смогут анализировать информацию в режиме реального времени и мгновенно предоставлять точные ответы, позволяя организациям в этой сфере принимать более оперативные и обоснованные решения. В нерегулируемых отраслях клиенты IBM с помощью платформы GroqCloud смогут ускорить работу ИИ-агентов и повысить автоматизацию кадровых процессов и производительность сотрудников. IBM объявила, что сразу же предоставит клиентам доступ к возможностям GroqCloud, а совместные с Groq команды сосредоточатся на предоставлении заказчикам IBM следующих возможностей:

Groq привлекла инвестиции в размере $1,8 млрд, включая раунд финансирования на сумму $750 млн в прошлом месяце с оценкой в $6,9 млрд. В числе её инвесторов — Cisco и Samsung. Также Groq сотрудничает с саудовской Aramco Digital. По данным WSJ, компания развернула в этом году 12 ЦОД и намерена развернуть как минимум ещё 12 в 2026 году. В 2024 году Groq сменила модель работы — с тех пор она больше не продаёт свои ИИ-ускорители, предлагая вместо этого создание ЦОД или облака.

18.09.2025 [10:54], Сергей Карасёв

Стартап Groq привлёк на развитие $750 млн, получив оценку в $6,9 млрдКомпания Groq, предоставляющая сервисы ИИ-инференса, объявила о проведении раунда финансирования на $750 млн — это на 25 % больше суммы в $600 млн, которую планировалось получить изначально. При этом рыночная стоимость стартапа достигла $6,9 млрд, что более чем в два раза превышает оценку годичной давности. Groq была основана в 2016 году Джонатаном Россом (Jonathan Ross), который ранее отвечал за разработку ИИ-ускорителей Google Cloud TPU. Компания Groq занимается созданием специализированных чипов LPU (Language Processing Unit) для работы с большими языковыми моделями (LLM). Кроме того, стартап предлагает клиентам облачные ИИ-сервисы и оборудование для построения локальных вычислительных кластеров. Сообщается, что новый раунд финансирования проведён под предводительством Disruptive при участии Blackrock, Neuberger Berman, Deutsche Telekom Capital Partners и крупной американской управляющей компании паевых инвестиционных фондов Западного побережья США. Кроме того, инвестиционную программу поддержали Samsung, Cisco, D1, Altimeter, 1789 Capital и Infinitum. В целом, по оценкам PitchBook, на сегодняшний день Groq привлекла на развитие более $3 млрд. Компания заявляет, что она обеспечивает вычислительными ресурсами более 2 млн клиентов, включая корпорации из списка Fortune 500. Стартап активно расширяет своё присутствие в глобальном масштабе, используя дата-центры в Северной Америке, Европе и на Ближнем Востоке. В частности, ранее Groq и Aramco Digital, подразделение нефтегазового и химического гиганта Aramco, анонсировали проект по созданию в Саудовской Аравии крупнейшего в мире центра по развитию ИИ.

30.07.2025 [14:46], Руслан Авдеев

Groq намерен привлечь $600 млн финансирования — в случае успеха это удвоит капитализацию бизнесаПо данным источников, знакомых с ходом переговоров в ИИ-отрасли, стартап Groq, занимающийся разработкой ИИ-чипов и программного обеспечения, намерен привлечь около $600 млн в рамках очередного раунда финансирования. В результате капитализация компании может достичь порядка $6 млрд, сообщает издание SCMP. Лидером текущего раунда выступает венчурный инвестор VC Disruptive, который, по данным осведомлённых источников, выделил более $300 млн. В самих Groq и VC Disruptive от комментариев отказались. Основанная в 2012 году компания VC Disruptive из Далласа уже инвестировала в такие технологические гиганты, как Palantir Technologies и Airbnb. Итоги раунда финансирования ещё могут измениться, поскольку он пока не завершён. Во вторник издание The Information сообщило, что Groq сократила прогноз выручки на 2025 год более чем на $1 млрд. По словам одного из источников, Groq скорректировала прогнозируемую выручку. Вместе с тем, по его словам, компания рассчитывает компенсировать недополученные доходы в 2026 году. Сама Groq отказалась комментировать данные о продажах. Тем временем, как отмечают источники, новый раунд финансирования оказался масштабнее, чем первоначально планировалось. Благодаря этому общий объём привлечённых средств превысил $2 млрд, а рыночная стоимость компании удвоилась. В 2024 году компания привлекла $640 млн в рамках раунда, организованного фондом BlackRock. Groq занимается разработкой ИИ-ускорителей и стремится в перспективе составить конкуренцию NVIDIA, рыночная капитализация которой превысила $4 трлн на фоне стремительного роста интереса к ИИ. Кроме того, компания инвестирует в создание глобальной распределённой сети, которая позволит пользователям мгновенно получать ответы на свои запросы. Недавно Groq объявила о первой сделке, предусматривающей строительство европейского ЦОД — в Хельсинки (Финляндии).

08.07.2025 [14:55], Руслан Авдеев

Groq запустила свой первый европейский ЦОД в ХельсинкиКомпания Groq, предлагающая сервисы ИИ-инференса, объявила о расширении своей сети дата-центров, открыв свой первый в Европе ЦОД в Хельсинки (Финляндия). Это поможет удовлетворить растущие потребности европейских клиентов, сообщает пресс-служба компании. Как заявил глава Groq Джонатан Росс (Jonathan Ross), спрос на ИИ-инференс растёт всё быстрее, а европейский дата-центр позволит местным клиентам получить минимальную задержку и готовую инфраструктуру для инференса уже сегодня. Кроме того, данные хранятся на территории Европы. Новый объект создан в Хельсинки на площадке Equinix. Партнёрство Equinix и Groq позволяет клиентам Equinix Fabric организовать инференс на платформе GroqCloud. Новые и действующие пользователи в США и EMEA получат доступ к мощностям для инференса через инфраструктуру Equinix Fabric — публичную, частную или суверенную. В Equinix подчеркнули, что Скандинавия — отличное место для ИИ-инфраструктуры. Благодаря политике поддержки экоустойчивой энергетики, возможности использования фрикулинга для охлаждения и надёжности электросети Финляндия стала приоритетным выбором для размещения новых мощностей. Европейские государственные и негосударственные структуры рассчитывают получить полный контроль над развёртываемой инфраструктурой, в местах, которые выбирают они сами — они пытаются сохранить баланс между потребностью в обеспечении суверенитета данных и защиты их конфиденциальности и обеспечением мобильности этих данных. Благодаря новому проекту клиенты могут получать доступ к GroqCloud через частные подключения. Экспансия в Европе расширяет мощности Groq на площадках Equinix и DataBank в США, Bell Canada в Канаде и HUMAIN в Саудовской Аравии. Они уже генерируют более 20 млн токенов в секунду по всей сети Groq. В некоторой степени это отражает спрос на ИИ-ускорители Groq LPU (Language Processing Unit). Чуть более года назад Groq объявила, что больше не продаёт свои ИИ-ускорители, предлагая вместо этого совместно создавать ЦОД и облачные сервисы. Как заявляют в Groq, компания обеспечивает самую низкую стоимость за токен без ущерба качеству, что делает масштабное использование ИИ экономически выгодным как для ИИ-стартапов, так и для крупных корпораций по всему миру.

30.05.2025 [16:25], Руслан Авдеев

Скромно, зато всё своё: Bell Canada и Telus развернут в Канаде сеть ИИ ЦОДКрупнейшая по объёму выручки телеком-компания Канады создаст по всей стране сеть ИИ ЦОД, ориентируясь на пример США и других стран. Речь идёт о Bell Canada Enterprises (BCE), намеренной инвестировать в шести городах сотни миллионов долларов, сообщает Bloomberg со ссылкой на данные оператора. Первый объект в Камлупсе (Kamloops, Британская Колумбия) должны ввести в эксплуатацию уже в июне текущего года, а якорным арендатором для него станет стартап Groq, занимающийся разработкой ИИ-чипов и облачными сервисами. В той же провинции, а также в Манитобе и Квебеке в ближайшие годы планируется строительство и других объектов. Ожидается, что после завершения проекта, получившего имя Bell AI Fabric, мощность дата-центров составит 500 МВт, что немало для поддержки ИИ-проектов, но намного скромнее, чем проекты в США, на Ближнем Востоке и в Азии. Groq станет эксклюзивным партнёром сети ЦОД в деле инференса. Как заявляют в BCE, стране необходим суверенный ИИ, которым управляют канадцы — в компании хотят быть уверенными, что Канада «не будет отключена» в случае геополитической напряжённости и сохранит доступ к технологиям, необходимым для канадской экономики. В компании сетуют, что местные учёные во многом стали пионерами в области разработки современного ИИ, но страна отстаёт в коммерциализации соответствующих технологий.

Источник изображения: BCE BCE — не единственная компания, стремящаяся развивать ИИ в стране. Местный телеком-оператор Telus объявил о намерении потратить CA$70 млрд ($50. млрд) на расширение и апгрейд своей инфраструктуры. В частности, речь идёт о поддержке ЦОД, которые Telus также называет «суверенными ИИ-фабриками». Заодно планируется утилизировать тысячи тонн устаревших медных кабелей и расширить оптоволоконную сеть. В следующие пять лет Telus намерена ввести в эксплуатацию суверенные ИИ-объекты в Камлупсе, Британской Колумбии и Квебеке. Ранее в этом году, как сообщает Datacenter Dynamics, компания сотрудничала с NVIDIA над внедрением ускорителей Hopper и Blackwell в дата-центре в Квебеке к лету 2025 года. Сообщалось, что ИИ-фабрика будет использовать сеть PureFibre в сочетании с дата-центрами, на 99 % питаемыми возобновляемой энергией, для предоставления AIaaS.

Источник изображения: BCE Также в апреле сообщалось, что в Канаде построят крупнейший в мире 7,5-ГВт ЦОД с питанием от природного газа. Проект Wonder Valley предусматривает строительство крупного ИИ ЦОД без подключения к магистральным энергосетям в муниципальном округе Гринвью (Greenview) провинции Альберта. Стремление Канады увеличить количество локальных ИИ ЦОД также соответствует растущему спросу на инференс. В то время, как ИИ ЦОД, ориентированные на обучения ИИ-моделей, можно размещать почти где угодно при наличии свободной земли и энергии, для быстрого инференса необходима близость к потребителям и развитая сетевая инфраструктура. Как сообщают в Groq, суверенные ИИ-платформы составляют немалую часть бизнеса компании. Её сервисами пользуются более 1,6 млн разработчиков, которые могут выбрать как ИИ-модель, так и местоположение ЦОД для работы с данными. Над расширением суверенной инфраструктуры работают всё больше стран. В этом месяце Саудовская Аравия (также сотрудничающая с Groq) и Объединённые Арабские Эмираты (ОАЭ) объявили о планах по работе с американскими технологическими компаниями, включая NVIDIA и OpenAI над созданием локальной ИИ-инфраструктуры. Новые проекты подпитываются растущим спросом на вычислительные ресурсы для запуска ИИ-моделей, а также желанием оптимизировать ИИ под региональные потребности и языки.

06.05.2025 [21:12], Руслан Авдеев

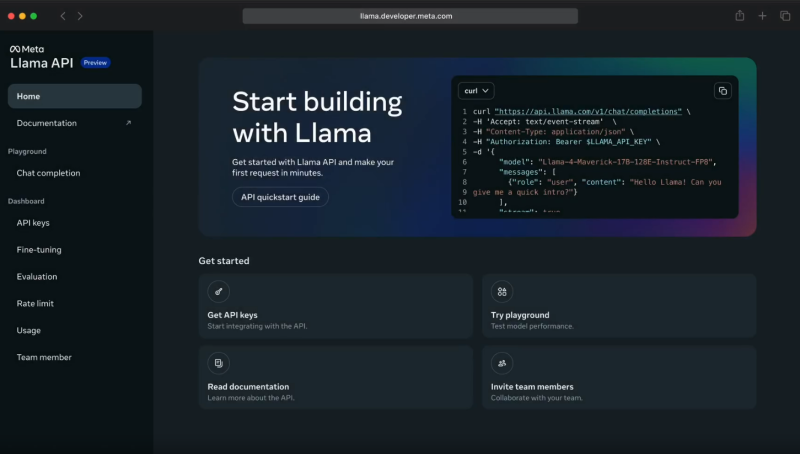

Meta✴ Llama API задействует ИИ-ускорители Cerebras и GroqMeta✴ объединила усилия с Cerebras и Groq для инференс-сервиса с применением API Llama. Открыв API-доступ к собственным моделям, Meta✴ становится чуть более похожа на облачных провайдеров. Как утверждают в Cerebras, разработчики, применяющие API для работы с моделями Llama 4 Cerebras, могут получить скорость инференса до 18 раз выше, чем у традиционных решений на базе GPU. В компании объявили, что такое ускорение позволит использовать новейшее поколение приложений, которые невозможно построить на других ИИ-технологиях. Речь, например, идёт о «голосовых» решениях с низкой задержкой, интерактивной генерации кода, мгновенном многоэтапном рассуждении и т. п. — многие задачи можно решать за секунды, а не минуты. После запуска инференс-платформы в 2024 году Cerebras обеспечила для Llama самый быстрый инференс, обрабатывая миллиарды токенов через собственную ИИ-инфраструктуру. Теперь прямой доступ к альтернативам решений OpenAI получит широкое сообщество разработчиков. По словам компании, партнёрство Cerebras и Meta✴ позволит создавать ИИ-системы, «принципиально недосягаемые для ведущих облаков». Согласно замерам Artificial Analysis, Cerebras действительно предлагает самые быстрые решения для ИИ-инференса, более 2600 токенов/с для Llama 4 Scout.

Источник изображения: Meta✴ При этом Cerebras не единственный партнёр Meta✴. Она также договорилась с Groq об использовании ускорителей Language Processing Units (LPU), которые обеспечивают высокую скорость (до 625 токенов/с), низкую задержку и хорошую масштабируемость при довольно низких издержках. Groq использует собственную вертикально интегрированную архитектуру, полностью контролируя и железо, и софт. Это позволяет добиться эффективности, недоступной в облаках на базе универсальных ИИ-чипов. Партнёрство с Meta✴ усиливает позиции Groq и Cerebras в борьбе с NVIDIA. Для Meta✴ новое сотрудничество — очередной шаг в деле выпуска готовых open source ИИ-моделей, которые позволят сосредоточиться на исследованиях и разработке, фактически передав инференс надёжному партнёру. Разработчики могут легко перейти на новый стек без необходимости дообучения моделей или перенастройки ускорителей — API Llama совместимы с API OpenAI. Пока что доступ к новым API ограничен. Цены Meta✴ также не сообщает. Meta✴ активно работает над продвижением своих ИИ-моделей. Так, она даже выступила с довольно необычной инициативой, предложив «коллегам-конкурентам» в лице Microsoft и Amazon, а также другим компаниям, поделиться ресурсами для развития и обучения моделей Llama. |

|