Материалы по тегу: ии

|

22.01.2026 [14:12], Руслан Авдеев

Alibaba создала совместное предприятие с Китайской национальной ядерной корпорациейКитайский техногигант Alibaba Group запустил совместное предприятие с принадлежащей государству компанией China National Nuclear Company (CNNC), занимающейся реализацией атомных проектов. Проект оценивается в ¥250 млн ($35,9 млн), сообщает Bloomberg. Оговорены потенциальные сферы сотрудничества, включая генерацию энергии, но реальные масштабы взаимодействия пока не разглашаются, а сама Alibaba информацию не комментирует. Новое соглашение потенциально имеет важное влияние на достижение целей Китая в сфере искусственного интеллекта. Alibaba является одним из крупнейших облачных провайдеров в стране, распоряжаясь дюжиной облачных регионов и почти 60 зонами доступности в Китае и Гонконге. В следующие несколько лет компания намерена выделить на развитие инфраструктуры $53 млрд, значительная часть их этих средств пойдёт на строительство ИИ ЦОД. CNNC основана в 1955 году и управляет одним из крупнейших парков атомных электростанций в мире. По данным за 2025 год, около 25 объектов генерируют более 23 ГВт. В портфолио у компании имеется и ещё 15–17 строящихся или одобренных для строительства объектов совокупной мощностью более 20 ГВт. Всего в КНР сегодня строятся 38–44 реактора, каждый год страна намерена достраивать по 6–10 из них.

Источник изображения: Amina Atar/unsplash.com По данным Datacenter Dynamics, Китай активно развивает атомную энергетику, планируя добиться 200 ГВт генерации к 2035 году, и 400–500 ГВт — к 2050 году. В отличие от США, где рост атомных проектов во многом связан с малыми модульными реакторами (SMR), Китай будет полагаться преимущественно на классические АЭС. Речь идёт о крупных реакторах, которые Китай способен строить дешевле и быстрее, чем США, благодаря государственному финансированию, использованию стандартизированных проектов и отработанному процессу лицензирования, без столь жёстких требований к проектам, как в Соединённых Штатах. Сделка — первая в своём роде между технологической компанией и застройщиком АЭС в Китае. За последние пару лет в США уже были подобные соглашения, например, недавно Meta✴ подписала три договора, два из которых — с разработчиками малых модульных реакторов TerraPower и Oklo, а один — с энергетическим гигантом Vistra. В общей сложности сделки обеспечат IT-гиганту доступ к 6,6 ГВт. Похожие сделки заключили Amazon (АЭС Susquehanna, SMR X-Energy), Google (АЭС DAEC, SMR Kairos) и Microsoft (АЭС Three Miles Island).

22.01.2026 [00:38], Владимир Мироненко

Глава NVIDIA объявил о крупнейшем в истории человечества строительстве ИИ-инфраструктурыГендиректор NVIDIA Дженсен Хуанг (Jensen Huang, на последнем фото справа), выступая на ежегодном заседании Всемирного экономического форума в Давосе (Швейцария), описал ИИ как основу «крупнейшего в истории человечества строительства инфраструктуры», способствующей созданию рабочих мест во всей мировой экономике. Хуанг представил ИИ не как единую технологию, а как «пятислойный торт», охватывающий энергетику, микросхемы и вычислительную инфраструктуру, облачные ЦОД, ИИ-модели и, в конечном итоге, прикладной уровень. По его словам, поскольку каждый слой ИИ-структуры должен быть построен и эксплуатироваться, перестройка платформы создаёт рабочие места во всей экономике — от энергетики и строительства до передового производства, облачных операций и разработки приложений. Прикладной уровень может быть сосредоточен на интеграции ИИ в финансовые услуги, здравоохранение или производство. «Именно этот верхний слой, в конечном счете, станет источником экономической выгоды», — отметил Хуанг. Развитие ИИ уже создаёт спрос на квалифицированную рабочую силу, начиная от производства электроэнергии и заканчивая изготовлением микросхем, строительством ЦОД и облачными операциями. Наибольшая экономическая выгода ожидается на уровне приложений, когда ИИ трансформирует такие отрасли, как здравоохранение, производство и финансовые услуги, и поменяет характер работы всей экономики, утверждает Хуанг. По словам Хуанга, венчурные инвестиции отражают то, как быстро ИИ меняет мировую экономику. Минувший год стал одним из крупнейших по объёму венчурного финансирования за всю историю, причем большая часть этого капитала поступила в так называемые «компании, изначально ориентированные на ИИ». Речь идёт о компаниях в здравоохранении, робототехнике, занимающихся производством и финансовыми услугами, то есть там, где, по словам Хуанга, «впервые модели достаточно хороши, чтобы что-то строить на их основе». Эти инвестиции напрямую обеспечивают создание рабочих мест. Хуанг отметил спрос на сантехников, электриков, строителей, сталелитейщиков, сетевых техников и бригады, ответственные за установку и эксплуатацию современного оборудования. Хуанг не считает, что ИИ ведёт к сокращению рабочих мест. Напротив, ИИ-технологии увеличивают спрос в таких областях, как радиология, и помогает справляться с административной работой в областях с нехваткой рабочей силы. Например, в США не хватает примерно 5 млн медсестёр, отчасти потому, что почти половину своего времени они тратят на ведение медицинской документации. Теперь эту обязанность можно возложить на ИИ. «ИИ — это инфраструктура», — заявил Хуанг, утверждая, что каждая страна должна относиться к ИИ так же, как к электричеству или дорогам. «ИИ должен быть частью вашей инфраструктуры», — отметил он. «Совершенно очевидно, что крайне важно научиться использовать ИИ — направлять его, управлять им, контролировать его работу, оценивать его», — сказал Хуанг, сравнивая эти навыки с лидерством и управлением персоналом. Для развивающихся стран ИИ обеспечит возможность сократить давние технологические пробелы. Что касается стран Европы, он призывал их объединить промышленные возможности с ИИ, чтобы раскрыть потенциал физического ИИ и робототехники. Участвовавший в дискуссии с Хуангом главный исполнительный директор BlackRock Лоренс Дуглас Финк (Laurence D. Fink) отметил, что исходя из вышесказанного можно сделать вывод о том, что мир далёк от «пузыря ИИ». Отвечая на вопрос, достаточно ли инвестиций в ИИ, Хуанг заявил, что необходимы крупные инвестиции, потому что «нужно создать инфраструктуру, необходимую для всех уровней ИИ». Он также отметил, что в 2025 году венчурные инвестиции составили рекордную сумму — более $100 млрд было вложено в ИИ по всему миру, большая часть — в стартапы, занимающиеся разработкой ИИ.

21.01.2026 [17:07], Руслан Авдеев

Глава Anthropic: продажа H200 в Китай равнозначна поставкам ядерного оружия Северной КорееГенеральный директор Anthropic Дарио Амодеи (Dario Amodei) недоволен тем, что США разрешили NVIDIA продавать китайским компаниям передовые ИИ-ускорители. Он сравнил это решение с раздачей ядерного оружия противникам, сообщает The Register. По словам Амодея, выступившего на Международном экономическом форуме в Давосе, руководители китайских компаний заявляют, что эмбарго на поставку американских чипов сдерживает их развитие. Он заявил, что продавать эти чипы — большая ошибка. Ранее США разрешили поставки ускорителей NVIDIA H200 китайским покупателям с пошлиной 25 %. Теперь слово за китайскими властями, которым ещё предстоит разрешить такие сделки. Anthropic желает, чтобы экспорт ИИ-технологий, наоборот, ужесточился — это заметно контрастирует с позициями NVIDIA и AMD, которые предупреждают, что запреты на экспорт только способствуют развитию ИИ-технологий в КНР. При этом на Китай приходится около половины исследователей в области искусственного интеллекта. Ранее Anthropic утверждала, что США и так лидируют в сфере ИИ-полупроводников, а экспортный контроль, на фоне того, что вычислительные мощности чипов удваиваются каждые два года, замедляет развитие Китая и укрепляет лидерство США. Компания уверена, что США на годы опережают Китай в способности выпускать передовые чипы. Доступ к американским разработкам позволит китайским создателям ПО вроде DeepSeek оказаться в лучшей позиции для конкуренции с Западом. При этом, как сообщает The Register, многие из наиболее производительных китайских LLM относятся к open source, поэтому их может использовать любой желающий, не опасаясь того, что данные его компании попадут в обучающий датасет, тогда как LLM американских компаний в основном «скрыты» за API, а сами компании расплывчато обещают не использовать пользовательские данные для обучения своих ИИ. При этом суды полны исков пользователей, связанных с нарушением прав на интеллектуальную собственность.

Источник изображения: CDC/unspalsh.com Слова Амодеи о том, что китайские разработчики LLM угрожают американскому бизнесу, слегка сгущают краски, но всё может действительно измениться, если китайские компании смогут импортировать передовые ускорители из США. Пока же, по словам бизнесмена, ИИ из КНР производителен только «на бумаге», а системы якобы специально оптимизируют для бенчмарков. Так или иначе, корпоративные пользователи действительно имеют немного вариантов, если желают получить доступ к хорошим открытым моделям — они в основном из Китая. Сама Anthropic называет главными конкурентами не стартапы из КНР, а OpenAI, Google и, чуть реже, другие американские компании. Anthropic пока не выкладывала ни одну из своих флагманских моделей в открытый доступ, но участвовала в нескольких совместных проектах с избранными клиентами, самым значимым из которых является AWS. Амодеи подчеркнул, что его продукты почти ни разу не проиграли в борьбе за контракт ИИ-модели из Поднебесной. Ключевое слово — «почти». Это означает, что китайским разработчикам всё-таки удавалось одержать верх несмотря на сложную ситуацию, в которой они находятся из-за экспортных ограничений. Компания последовательно критикует инициативы, способные обеспечить сотрудничество Запада с Китаем и даже не приветствует взаимодействие с другими мировыми игроками. Так, летом 2025 года сообщалось, что она намерена привлечь инвестиции с Ближнего Востока, но только потому, что избежать работы с регионом не удастся. В 2024 году Anthropic даже отказалась от инвестиций из Саудовской Аравии по соображениям «национальной безопасности».

21.01.2026 [15:28], Руслан Авдеев

ByteDance стремительно завоёвывает рынок облачных ИИ-сервисов КитаяКомпания ByteDance агрессивно осваивает китайский облачный рынок. Владелец популярной социальной сети TikTok пытается использовать свои достижения в сфере ИИ для выхода за пределы рынка пользовательских приложений, обеспечивших в своё время успех компании, сообщает The Financial Times. Компания продвигает облачные решения Volcano Engine для корпоративных клиентов, увеличивая команду продаж и устраивая ценовые войны с конкурентами. Источники сообщают, что ByteDance предлагает корпоративным клиентам собственные обширные данные и вычислительные ресурсы, например, для создания ИИ-агентов с использованием собственных моделей ByteDance. Тем самым она теснит Alibaba, Tencent и Huawei, которые долго доминировали на этом рынке. По данным IDC, Volcano Engine является в Китае вторым по величине провайдером ИИ-инфраструктуры и ПО после Alibaba. На долю ByteDance в I половине 2025 года приходилось около 13 % выручки от китайских облачных ИИ-сервисов ($390 млн), на долю Alibaba — 23 %. При этом на китайском облачном рынке в целом ByteDance имеет долю лишь 3 %. Иными словами, ByteDance стала лидером в сфере ИИ-сервисов, самом быстрорастущем сегменте рынка. По мнению некоторых аналитиков, компания может стать одним из ключевых игроков в Китае в сегменте кастомных ИИ-инструментов благодаря крупным собранным датасетам и развитой аппаратной инфраструктуре, добавив для достижения успеха агрессивное ценообразование и глубокую интеграцию со своей экосистемой пользователей.

Источник изображения: Liren/unsplash.com ByteDance хорошо разбирается в пользовательских технологиях, имея в портфолио социальную сеть TikTok и её китайский вариант Douyin, а также видеоредактор CapCut и новостной агрегатор Toutiao. Именно эти площадки обеспечивают большую часть выручки компании благодаря рекламе, продажам и подпискам. Согласно данным, предоставленным инвесторам, в III квартале выручка составила $50 млрд. Последние попытки выйти на рынок корпоративного ПО, включая премьеру похожего на Slack продукта Lark, не увенчались особенным успехом. Стратегия роста, ориентированная на ИИ, могла бы придать импульс для будущего выхода на IPO, которого инвесторы ожидают годами. ByteDance агрессивно выводит в коммерческую плоскость свои ИИ-возможности благодаря Volcano Engine. Компания акцентирует внимание на продажах флагманского сервиса HiAgent, посредством которого создаются кастомные ИИ-агенты для корпоративных клиентов. Стратегия опирается на массивные инвестиции в вычислительные мощности. ByteDance сегодня — в числе крупнейших покупателей ИИ-оборудования, она же была крупнейшим клиентом NVIDIA в 2024 году. По данным The Financial Times, в этом году значительная часть из ¥85 млрд, выделенных на ИИ-ускорители, будет потрачена на покупку NVIDIA H200, с некоторых пор разрешённых для поставок в КНР — если это одобрят китайские власти. При этом некоторые эксперты отмечают, что ByteDance имеет сильные позиции в разработке ПО и достаточные аппаратные ресурсы для получения значимой доли облачного рынка, но ей не хватает опыта в обслуживании корпоративных клиентов в сравнении с Tencent и Huawei, поэтому приходится навёрстывать упущенное.

Источник изображения: Claudio Schwarz/unsplash.com Крупные китайские игроки сами дают ByteDance такую возможность. Например, Tencent заявляла, что будет тратить ресурсы ИИ-ускорителей для внутренних нужд, не планируя масштабного расширения облачных сервисов для клиентов. Huawei, тем временем, сократила свои облачные ИИ-амбиции за последний год, сфокусировавшись на продаже чипов Ascend напрямую клиентам. По данным IDC, доля обеих компаний на облачном ИИ-рынке КНР слегка уменьшилась в I половине 2025 года. Становление ByteDance в качестве одного из китайских ИИ-гигантов привлекло меньше внимания, чем успехи DeepSeek и Alibaba, которые развивают успешные открытые ИИ-модели и одновременно публикуют исследования о своих методиках обучения ИИ. Напротив, ByteDance сохранила полный контроль над своими самыми передовыми моделями и компании-клиенты имеют к ним доступ только по подписке. К слову, Alibaba, яро выступавшая за open source подход к распространению моделей, в последние месяцы оставила некоторые из передовых вариантов «закрытыми». Другими словами, успехи ByteDance в сфере ИИ-моделей не освещаются слишком широко, поскольку отдача open source продуктов вызывает некоторые сомнения у многих разработчиков. Один из представителей команды ByteDance подчеркнул, что компания концентрирует усилия на создании лучших ИИ-моделей для клиентов, а не на гонке в сегменте open source.

21.01.2026 [14:39], Сергей Карасёв

AMD Ryzen AI 9 HX 370 и 128 Гбайт RAM: вышли индустриальные компьютеры SolidRun Bedrock RAI300 с пассивным охлаждениемКомпания SolidRun анонсировала индустриальные компьютеры семейства Bedrock RAI300, предназначенные для решения ИИ-задач на периферии. Утверждается, что это первые устройства данного класса, в основу которых положен мобильный процессор AMD Ryzen AI 9 HX 370. Названный чип объединяет 12 ядер (24 потока): четыре ядра на архитектуре Zen 5 с частотой 2,0/5,1 ГГц и восемь ядер на архитектуре Zen 5c с частотой 2,0/3,3 ГГц. В состав изделия входят GPU Radeon 890M (RDNA 3.5) и NPU Ryzen AI (XDNA 2) с ИИ-производительностью до 50 TOPS. Суммарное ИИ-быстродействие (CPU+GPU+NPU) достигает 80 TOPS. Объём оперативной памяти DDR5-5600 составляет до 128 Гбайт в виде двух модулей SO-DIMM. Доступны три слота M.2 Key-M 2280 (PCIe 4.0 x4) для SSD (NVMe) или дополнительных ИИ-ускорителей Hailo-8/Hailo-10. Кроме того, предусмотрен коннектор M.2 Key-B 3042/3052 (USB 3.0) для сотового модема 4G/5G (плюс два разъёма для SIM-карт). В оснащение входят четыре сетевых порта 2.5GbE (RJ45) на основе контроллера Intel I226. В зависимости от конфигурации поддерживается вывод изображения одновременно на четыре монитора через интерфейсы HDMI 2.1, DisplayPort 2.1 и mini-DP (×2). Присутствуют три порта USB 3.0, по одному порту USB 4 Type-C и USB 3.1 Type-A. Говорится о совместимости с Windows 10/11/IoT и Linux. Компьютеры серии SolidRun Bedrock RAI300 доступны в тонкой версии Tile с габаритами 160 × 130 × 29 мм (0,6 л) и в более крупной модификации с размерами 160 × 130 × 73 мм (1,5 л), которая наделена внешними радиаторами для рассеяния тепла. В обоих случаях применяется пассивное охлаждение. Диапазон рабочих температур простирается от -40 до +85 °C. Питание подаётся через коннектор Phoenix. Возможен монтаж на DIN-рейку.

20.01.2026 [23:54], Владимир Мироненко

Intel переманила «крёстного отца» экзафлопсного суперкомпьютера FrontierIntel провела кадровые перестановки в руководящем составе, наняв двух специалистов «со стороны» в рамках запланированного развития на рынке ИИ-инфраструктуры, сообщил ресурс CRN со ссылкой на служебную записку компании. Согласно документу, Николя Дюбе (Nicolas Dubé) ранее занимавший пост старшего вице-президента в Arm, был назначен на должность главы подразделения систем для ЦОД, а Эрик Демерс (Eric Demers), бывший топ-менджер Qualcomm, на должность главы подразделения разработки GPU. О назначениях объявил вице-президент и генеральный директор группы ЦОД Intel Кеворк Кечичян (Kevork Kechichian), которому будут непосредственно подчиняться оба руководителя. После реорганизации ему также будет подчиняться Жан-Дидье Аллегруччи (Jean-Didier Allegrucci), вице-президент по разработке SoC для ИИ. Генеральный директор Intel Лип-Бу Тан (Lip-Bu Tan) назвал способность конкурировать с чипами NVIDIA и других участников рынка одним из своих главных приоритетов в рамках плана возвращения компании на рынок после того, как она столкнулась с трудностями в привлечении клиентов к своим предыдущим ускорителям. «Объединение усилий в области Xeon, сетевых технологий и телекоммуникаций, а теперь и ИИ, укрепляет позиции x86, что является одним из ключевых преимуществ по мере того, как ИИ смещается в сторону инференса и агентных систем», — написал Кечичян в служебной записке. Эта реорганизация представляет собой отмену решения Тана, который в апреле прошлого года вывел группу разработчиков ИИ-ускорителей из подразделения, ранее называвшегося группой ЦОД и ИИ. Этот шаг снова меняет организационную структуру Intel: Кечичян принимает на себя обязанности по разработке ИИ-ускорителей от Тана. Генеральный директор возглавил её в ноябре прошлого года после того, как предыдущий руководитель команды, Сачин Катти (Sachin Katti), внезапно покинул компанию в связи с переходом в OpenAI. По поводу решения Тана вернуть команду разработчиков ИИ-ускорителей в группу ЦОД, Кечичян пояснил: «ИИ и современный ЦОД фундаментально связаны». В качестве руководителя подразделения Intel по системам и решениям для ЦОД Дюбе будет «определять техническую архитектуру и стратегию [группы ЦОД] в направлении создания комплексных систем и решений, от микросхем до приложений, обеспечивая интегрированные решения в области вычислительных ресурсов, хранения данных и сетей», — сообщил Кечичян в служебной записке. Дюбе также возьмёт на себя руководство командой Intel по интегрированным решениям в области кремниевой фотоники, которая ранее подчинялась исполнительному директору компании Джеффу Маквейгу (Jeff McVeigh). При этом Дюбе будет использовать свой опыт системной инженерии в Arm, а также опыт 13 лет работы в HPE, где «он руководил проектированием, реализацией и внедрением» программы компании по созданию первого в США экзафлопсного суперкомпьютера Frontier. По поводу обязанностей Демерса, Кечичян заявил, что топ-менджер, ранее возглавлявший разработку GPU в Qualcomm, будет руководить разработкой IP-блоков для GPU и курировать решения Intel для ЦОД на базе GPU. Круг его обязанностей будет включать в себя «координацию работы по архитектуре, компиляторам и драйверам для успешной разработки интегрированного аппаратного и ПО», добавил он. Демерс «будет тесно сотрудничать» с Лизой Пирс (Lisa Pearce), корпоративным вице-президентом и генеральным директором группы разработки ПО компании, а также с командой разработчиков ПО для GPU, чтобы «оптимизировать работу команд и рабочий процесс для достижения максимального эффекта», указал Кечичян в служебной записке.

20.01.2026 [21:58], Владимир Мироненко

Tesla возобновит строительство ИИ-суперкомпьютеров DojoГендиректор Tesla (Elon Musk) Илон Маск объявил в соцсети Х о решении компании возобновить работу над Dojo3, третьим поколением суперкомпьютерных систем, о чём сообщает Data Center Dynamics. Команда, занимавшаяся проектом Dojo, была расформирована в прошлом году в связи с тем, что компания отдала предпочтение ИИ-чипам, используемых в бортовых системах электромобилей. Также ранее было объявлено, что компания будет полагаться на чипы внешних партнёров. Вместе с тем компания возвращается к проекту Dojo, поскольку, по словам Маска, достигнуты успехи в разработке чипа AI5, что создало определённый запас прочности. Маск объявил, что однокристальный чип AI5 обеспечит производительность на уровне NVIDIA Hopper, при этом двухкристальный AI5 будет равен по мощности чипу с Blackwell. Он предложил всем заинтересованным в участии в проекте и «работе над созданием самых массово производимых в мире микросхем» отправить сообщение Tesla, указав в трёх пунктах самые сложные технические проблемы, которые они решили. Илон Маск также сообщил, что разработка чипа Tesla AI5 почти завершена, а чип AI6 находится на «ранней стадии» разработки, добавив, что компания также планирует создать чипы AI7, AI8 и AI9. По его словам, нынешний чип Tesla AI4 позволит достичь «уровня безопасности при автономном вождении, намного превышающего человеческий», а AI5 сделает электромобили Tesla «почти идеальными», также значительно улучшив функционирование человекоподобного робота Optimus. «AI6 для Optimus и ЦОД. AI7/Dojo3 будут использовать ИИ для космических вычислений», — написал Маск. В ноябре 2025 года он заявил, что существует «чёткий путь к удвоению производительности по всем показателям для AI6 в течение 10–12 мес. после выпуска AI5», а теперь он намерен сократить срок создания каждого нового поколения ИИ-чипов до 9 мес. Хотя сам миллиардер не стал называть сроки производства чипа AI5, ИИ-чат-бот Grok сообщил пользователям в ответ на запросы, что ограниченное производство AI5 ожидается в 2026 году, а массовое производство запланировано на 2027 год. В конце прошлого года Маск заявил акционерам Tesla, что компании, вероятно, потребуется построить «гигантскую фабрику» для производства своих ИИ-чипов, чтобы хотя бы частично удовлетворить в них потребности компании. Tesla уже сотрудничает с TSMC и Samsung, которые производят чипы AI5 и AI6 на заводах в Аризоне и Тайване, а также в Южной Корее и Техасе соответственно. На том же собрании акционеров Маск сказал, что, вероятно, стоит обсудить вопрос производства и с Intel. Как отметил Techpowerup, в августе прошлого года появились сообщения о присоединении к компании Маска Intel в качестве ключевого партнёра по упаковке чипов, что ознаменовало отход Tesla от прежней зависимости от TSMC в вопросах производства. Сообщается, что Intel будет управлять сборкой и тестированием, используя свою технологию EMIB. Это лучше подходит для больших блоков Tesla Dojo, объединяющих несколько чипов площадью 654 мм² в одном корпусе. В свою очередь, Samsung будет производить обучающие чипы D3 на своем заводе в Техасе с помощью 2-нм техпроцесса, оставив Intel контроль над процессами упаковки. Такое разделение труда решает проблему ограничений производственных мощностей и предоставляет Tesla большую гибкость в настройке схем межсоединений. Для автомобильных чипов AI5 компании Samsung и TSMC создадут разные версии, хотя Tesla стремится обеспечить одинаковую производительность в обоих случаях. Предполагается, что AI5 будет потреблять 150 Вт, при этом соответствуя по производительности NVIDIA H100, у которого TDP составляет до 700 Вт. Это было достигнуто путём удаления графических подсистем общего назначения и оптимизации архитектуры специально для ИИ-алгоритмов Tesla.

20.01.2026 [17:15], Сергей Карасёв

«Базальт СПО» приглашает на XXI ежегодную конференцию «Свободное программное обеспечение в высшей школе»«Базальт СПО» совместно с Институтом программных систем им. А.К. Айламазяна РАН проводит XXI Ежегодную конференцию «Свободное программное обеспечение в высшей школе» (OSEDUCONF). Мероприятие пройдёт 6–8 февраля 2026 года в г. Переславле-Залесском на базе ИПС РАН. Ведущие учёные, педагоги, разработчики и администраторы расскажут об опыте внедрения СПО и организации образовательного процесса, создания благоприятных условий для вовлечения студентов в реальные проекты разработки свободных программных продуктов. Оргкомитет принимает заявки на доклады по следующим темам:

Сроки подачи заявок Для слушателей:

Участие бесплатное. Онлайн-трансляция конференции будет доступна на VK Видео и странице конференции. Зарегистрироваться на конференцию и ознакомиться с информацией о форматах и шаблонах тезисов можно на сайте. По вопросам, связанным с докладами, тезисами, программой конференции, регистрацией, размещением, трансфером можно обратиться к организаторам по электронной почте conference@lists.altlinux.org.

20.01.2026 [13:02], Руслан Авдеев

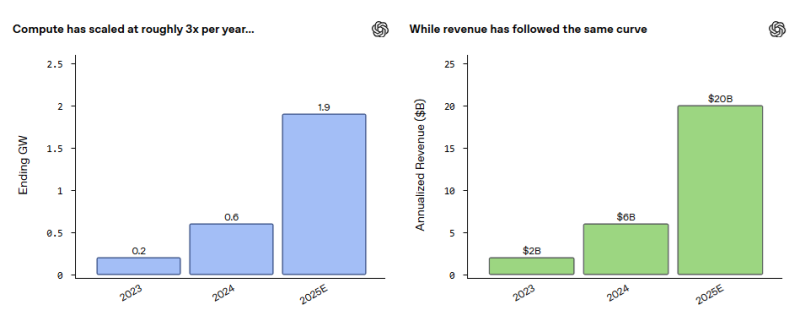

Мощность ИИ ЦОД OpenAI утроилась в 2025 году, достигнув 1,9 ГВтOpenAI Group PBC раскрыла информацию о финансовых показателях и ходе строительства дата-центров. По последним данным, её годовой регулярный доход (ARR), поступающий в основном от подписок, достиг в 2025 году $20 млрд. Для сравнения, в 2024 году он составлял $6 млрд, а годом ранее — $2 млрд. Мощность ЦОД выросла с 200 МВт до 1,9 ГВт, сообщает Silicon Angle. Синхронный рост доходов и вычислительных мощностей приблизительно на порядок за последние три года — не случайность. Представитель компании объявил, что OpenAI увязывает инвестиции в ЦОД по мере роста OpenAI с учётом достигнутых результатов и показателей спроса. Это позволяет избежать инвестиций в будущее, не обеспеченных реальными доходами.

Источник изображения: Jonathan Kemper/unsplash.com В OpenAI заявили, что компания работает не только над расширением ИИ-инфраструктуры, но и над тем, чтобы сделать её более экономически эффективной. Так, OpenAI снизила стоимость инференса до менее $1 за миллион токенов, отчасти благодаря комбинированному использованию оборудования разных типов. Сообщается, что передовые модели обучаются на наиболее производительном оборудовании, а масштабные нагрузки инференса приходятся на более дешёвую инфраструктуру. О каких именно чипах для недорогой инфраструктуры идёт речь, пока не сообщалось, но не исключено, что компания на деле использует такие же дорогие новейшие ускорители, как и при обучении. Дело в том, что самые производительные ИИ-чипы являются и самыми экономически эффективными. Поиск способов снизить стоимость оборудования в будущем, вероятно, станет даже большим приоритетом для OpenAI. В сентябре появилась информация, что компания закончит 2025 год с убытками $8 млрд, на $1,5 млрд выше, чем ожидалось изначально. В 2026 году, по некоторым оценкам, убытки составят $17 млрд. Некоторые источники свидетельствуют, что попытки компании разработать кастомные чипы и строить дата-центры — часть плана по снижению стоимости инфраструктуры. В 2025 году OpenAI подписала соглашение с Broadcom на $10 млрд о разработке собственных ИИ-ускорителей. Отдельно компания работает с подконтрольным SoftBank Group бизнесом SB Energy над строительством дата-центров Stargate на основе индивидуального проекта. Последние данные топ-менеджеров компании позволяют составить представление о долгосрочных планах обеспечения роста выручки. В частности предполагается, что на рынке ИИ будут развиваться новые модели монетизации. Речь идёт о «лицензировании, соглашениях на основе интеллектуальной собственности и ценообразовании, ориентированном на результат». Ещё один важнейший компонент стратегии роста OpenAI — реклама. В OpenAI подчёркивают, что планы развития компании также отдают приоритет использованию ИИ-агентов и прочим инструментам автоматизации рабочих процессов. Компания, как утверждается, акцентирует внимание на помощи пользователям в автоматизации задач в самых разных сферах. Ещё один приоритет — обеспечение моделям более длинного контекста диалогов.

20.01.2026 [12:12], Сергей Карасёв

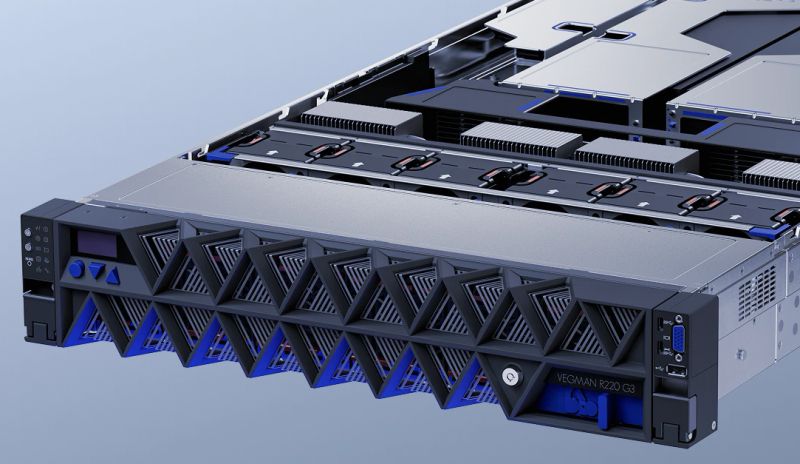

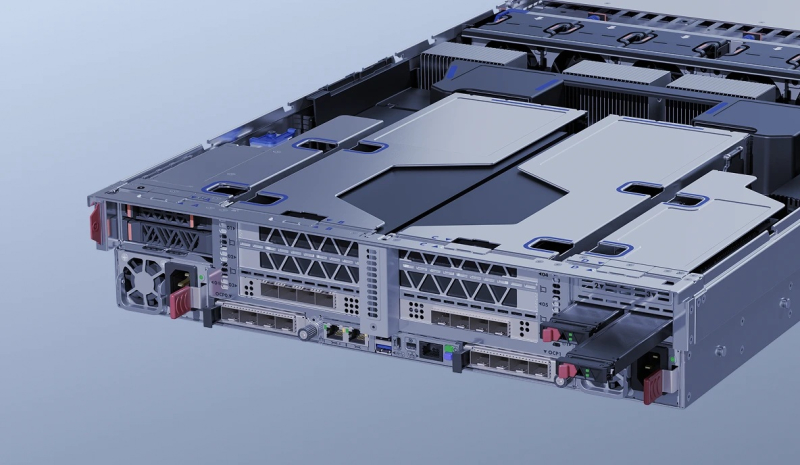

YADRO выпустила отечественные серверы Vegman R220 G3 на базе Intel Xeon Emerald RapidsКомпания YADRO, входящая в «ИКС Холдинг», объявила о доступности универсальных серверов Vegman R220 G3 на аппаратной платформе Intel. Устройства подходят для широкого спектра задач — от хранения и аналитики данных до НРС-приложений и нагрузок ИИ, говорит компания. Новинки выполнены в форм-факторе 2U. Допускается установка двух процессоров Xeon Sapphire Rapids или Xeon Emerald Rapids с показателем TDP до 350 Вт. Возможно использование до 8 Тбайт оперативной памяти DDR5-4400/5600 RDIMM в конфигурации 32 × 256 Гбайт. Во фронтальной части в зависимости от модификации могут быть установлены до 12 накопителей LFF (SAS/SATA/NVMe) или до 24 накопителей SFF (SAS/SATA плюс 16 × NVMe). Сзади предусмотрены посадочные места для четырёх изделий SFF (или 2 × SFF и 2 × M.2/E1.S). Допускается формирование массивов RAID 0/1/10/5/50/6/60. Реализована поддержка CXL 1.1. Есть два сетевых порта 1GbE и выделенный сетевой порт управления 1GbE (все с разъёмами RJ45). Доступны до 11 слотов PCIe 5.0 с учетом OCP 3.0 SFF и гнезда под контроллер RAID/HBA. Спереди находятся два порта USB 3.1 Type-C, по одному разъёму USB 2.0 Type-A и D-Sub, сзади — два порта USB 3.1 Type-A, последовательный интерфейс (разъём USB Type-C) и коннектор Mini DisplayPort (BMC). Питание обеспечивают два блока мощностью до 2700 Вт с сертификатом 80 PLUS Platinum. Применено воздушное охлаждение с шестью вентиляторами диаметром 60 мм с возможностью горячей замены. Диапазон рабочих температур — от +10 до +35 °C при относительной влажности от 20 % до 80 %. Заявлена совместимость с Astra Linux, ALT Linux, RED OS, zVirt и пр. С серверами поставляется ПО управления «YADRO Суприм» и набор инструментов Vegman Satellites. Реализована поддержка доступа через IPMI 2.0, WebUI, CLI, SNMP, Redfish. Устройства Vegman R220 G3 включены в Единый реестр российской радиоэлектронной продукции Минпромторга, что подтверждает соблюдение требований локализации. |

|