Материалы по тегу: ии

|

20.01.2026 [10:02], Владимир Мироненко

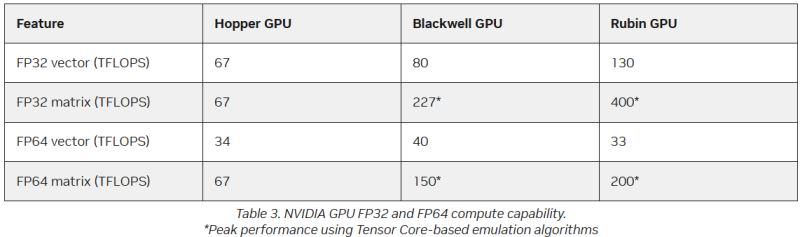

FP64 у вас ненастоящий: AMD сомневается в эффективности эмуляции научных расчётов на тензорных ядрах NVIDIAВместо создания специализированных чипов для аппаратных FP64-вычислений NVIDIA использует эмуляцию для повышения производительности HPC на ИИ-ускорителях, пишет The Register. Компания отказалась от развития FP64-блоков в поколении Blackwell Ultra, а в новейших ускорителях Rubin пиковая заявленная производительность векторных FP64-вычислений составляет 33 Тфлопс, тогда как у H100, вышедшего четыре года назад, она была равна 34 Тфлопс, а у Blackwell — около 40 Тфлопс. Если включить программную эмуляцию в библиотеках CUDA от NVIDIA, ускоритель, как утверждается, может достичь производительности до 200 Тфлопс в матричных FP64-вычислениях. Впрочем, и Blackwell с эмуляций способен выдать в этом случае до 150 Тфлопс, тогда как у Hopper были «честные» 67 Тфлопс. «В ходе многочисленных исследований с партнёрами и собственных внутренних изысканий мы обнаружили, что точность, достигаемая с помощью эмуляции, как минимум не уступает точности, получаемой от аппаратных тензорных ядер», — сообщил ресурсу The Register Дэн Эрнст (Dan Ernst), старший директор по суперкомпьютерным продуктам NVIDIA. В свою очередь, в AMD считают, что это утверждение справедливо не для всех сценариев. «В некоторых бенчмарках она показывает довольно хорошие результаты, но в реальных физических научных симуляциях это не очевидно», — говорит Николас Малайя (Nicholas Malaya), научный сотрудник AMD. Он выразил мнение, что, хотя эмуляция FP64, безусловно, заслуживает дальнейших исследований и экспериментов, такое решение ещё не готово к широкому применению. AMD и сама изучает возможность программной эмуляции FP64 на Instinct MI355X, чтобы определить области её возможного применения. Хотя чипы всё чаще используют типы данных с более низкой точностью, FP64 остаётся золотым стандартом для научных вычислений, и на то есть веские причины — FP64 не имеет себе равных по динамическому диапазону. Современные же LLM обучаются с использованием FP8-вычислений, а компактные типы данных MXFP8/MXFP4 или NVFP4 позволяют получить достаточный для ИИ диапазон значений. Это хорошее решение для нечёткой математики больших языковых моделей, но это не замена FP64 для HPC. ИИ-нагрузки обладают высокой устойчивостью к ошибкам, а HPC-задачи требуют высокой точности. AMD указала на то, что эмуляция FP64 у NVIDIA не совсем соответствует стандарту IEEE. Алгоритмы NVIDIA не учитывают такие понятия, как положительные и отрицательные нули, ошибки NaN (Not a Number) и ошибки infinite number (бесконечное число). Из-за этого небольшие ошибки в промежуточных вычислениях, используемых для эмуляции более высокой точности, могут привести к искажениям, способным повлиять на точность конечного результата, пояснил Малайя. По его словам, целесообразность использования эмуляции FP64 зависит от конкретного приложения. Эмуляция FP64 лучше всего работает для хорошо обусловленных проблем, где малые изменения «на входе» приводят к малым же изменениям в конечном результате. Ярким примером такой задачи является бенчмарк Linpack (HPL). «Но если вы посмотрите на материаловедение, коды для расчёта процессов горения, системы ленточых матриц и т.п., то увидите, что это гораздо менее обусловленные системы, и внезапно всё начинает давать сбои», — сказал он. Точность можно повысить, увеличив количество используемых операций, однако после определённого предела никаких преимуществ от эмуляции уже не будет. Вдобавок все эти операции требуют память. «У нас есть данные, которые показывают, что алгоритму Озаки требуется примерно вдвое больше памяти для эмуляции матриц FP64», — сказал Малайя. Поэтому компания готовит специализированные ускорители MI430X c повышенной FP64/FP32-производительностью, но, как опасаются учёные, она может оказаться не слишком в них заинтересована, поскольку ИИ-ускорители приносят больше денег. Эрнст утверждает, что для большинства специалистов в области HPC неполное соответствие стандарту IEEE не представляет большой проблемы. Всё во многом зависит от конкретного приложения. Тем не менее, NVIDIA разработала дополнительные алгоритмы для обнаружения и смягчения указанных выше ошибок и неэффективных операций эмуляции. Эрнст также признал, что использование памяти при эмуляции может быть несколько выше, но подчеркнул, что эти накладные расходы относятся к расчётам, а не к самому приложению — в большинстве случаев речь идёт о матрицах размером не более нескольких Гбайт. Впрочем, всё это не меняет того, что эмуляция полезна только для подмножества HPC-задач, которые полагаются на операции умножения плотных матриц (DGEMM). По словам Малайи, для 60–70 % рабочих нагрузок HPC эмуляция дает незначительные преимущества или ничего не меняет. «По нашим оценкам, подавляющее большинство реальных рабочих нагрузок HPC полагаются на векторное умножение (FMA), а не на DGEMM», — сказал он, отметив, что это действительно нишевый сегмент, хотя и не крошечная доля рынка. Для рабочих нагрузок, интенсивно использующих векторы, таких как вычислительная гидродинамика (CFD), ускорители Rubin по-прежнему будут полагаться на медленные векторные FP64-блоки.

19.01.2026 [14:16], Руслан Авдеев

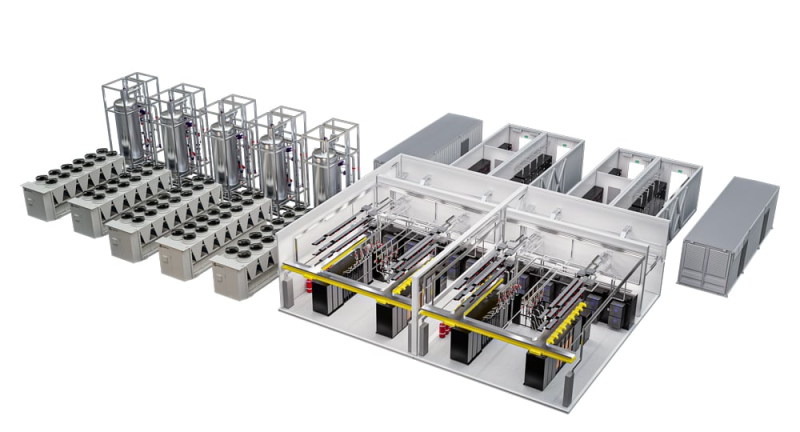

100+ кВт на стойку с СЖО: Vertiv обновила модульную инфраструктуру MegaMod HDX для ИИ и HPCVertiv анонсировала новые конфигурации MegaMod HDX. Это модульное силовое и охлаждающее решение, разработанное для вычислительных сред высокой плотности. Новые конфигурации обеспечивают гибкую адаптацию к растущим требованиям к питанию и охлаждению, занимают меньше места, требуют меньше времени на развёртывание и обеспечивают воспроизводимость благодаря заранее собранным на заводе конструкциям, прошедшим интеграцию и тестирование компонентов. Vertiv MegaMod HDX сочетает прямое жидкостное охлаждение чипов и воздушное охлаждение — это помогает справиться с интенсивными ИИ-нагрузками, поддерживая модульные среды для ИИ и передовые кластеры ускорителей. Базовый модуль стандартной высоты поддерживает до 13 стоек и мощность до 1,25 МВт. Комбинированное решение отличается большей высотой и поддерживает уже до 144 стоек и мощность до 10 МВт. Оба варианта обеспечивают плотность от 50 кВт до 100+ кВт на стойку с возможностью оптимизации системы охлаждения под актуальные запросы и с возможностью масштабирования.

Источник изображения: Vertiv Новые решения используют распределённую силовую архитектуру с резервированием. Для СЖО предусмотрен буфер, который обеспечит поддержку стабильной работы кластеров ускорителей во время техобслуживания. Обе конфигурации основаны на этом обширном портфолио, включающем, например, ИБП Vertiv Liebert APM2, блок распределения жидкости Vertiv CoolChip CDU, а также шинопровод Vertiv PowerBar и систему мониторинга инфраструктуры Vertiv Unify. Также Vertiv предлагает инфраструктуру IT-стоек, разработанную для беспрепятственной интеграции и поддержки IT-систем. В том числе речь идёт о стойках Vertiv и OCP-совместимых стойках, теплообменниках задней двери Vertiv CoolLoop RDHx, PDU и DC-системах Vertiv PowerDirect и т.п. Летом 2025 года сообщалось, что выручка Vertiv выросла на 35 % на фоне «беспрецедентного роста ЦОД», но новые тарифы, введённые США, не дают бизнесу развиваться активнее.

19.01.2026 [10:09], Сергей Карасёв

DeepX представила ИИ-ускорители DX-H1 V-NPU, DX-H1 Quattro и DX-M1 М.2Южнокорейский стартап Deepx, специализирующийся на разработке чипов для задач ИИ, анонсировал ускорители DX-H1 V-NPU, DX-H1 Quattro и DX-M1 М.2. В основу решений, которые демонстрировались на недавней выставке CES 2026 в Лас-Вегасе (Невада, США), положен нейропроцессорный узел Genesis NPU. Устройство DX-H1 V-NPU предназначено для выполнения операций, связанных с обработкой видеоматериалов: это может быть декодирование, кодирование, перекодирование и пр. Утверждается, что новинка обеспечивает снижение стоимости оборудования примерно на 80 % и сокращение энергопотребления на 85 % по сравнению с решениями на базе GPU при той же плотности каналов. Ускоритель выполнен в виде низкопрофильной карты расширения PCIe 3.0 x16 (x8 на уровне сигналов). Он оснащён двумя аппаратными видеокодеками и двумя NPU с общей производительностью до 50 TOPS (INT8) при инференсе в реальном времени. Возможно декодирование 64 каналов H.264/265 (1080р; 30 к/с) и кодирование 32 каналов H.264/265 (1080р; 30 к/с). Секция кодирования имеет доступ к 16 Гбайт памяти LPDDR5, секция NPU — к 8 Гбайт. Упомянуты интерфейс HDMI 2.0 и флеш-модуль eMMC вместимостью 32 Гбайт. Максимальное энергопотребление составляет 40 Вт. Решение DX-H1 Quattro, в свою очередь, оснащено четырьмя NPU с суммарной производительностью до 100 TOPS (INT8). В оснащение входят 16 Гбайт памяти LPDDR5. Ускоритель, выполненный в виде карты PCIe 3.0 x16, предназначены для выполнения ИИ-задач в дата-центрах и на периферии. Энергопотребление равно 20 Вт, диапазон рабочих температур простирается от -25 до +85 °C. Говорится о совместимости с Windows и различными вариантами Linux, включая Ubuntu. Изделие DX-M1 М.2 представляет собой ИИ-ускоритель в виде модуля М.2 2280, выполненный на чипе DX-M1. ИИ-производительность — до 25 TOPS, а энергопотребление не превышает 5 Вт. Используется интерфейс PCIe 3.0 x4. Говорится о возможности применения устройства в системах с архитектурой х86 и Arm. Диапазон рабочих температур — от -25 до +85 °C. Упомянута совместимость с Windows 11 и Ubuntu 22.04.

18.01.2026 [16:14], Руслан Авдеев

От телекома до солнечной энергетики: Евросоюз собирается изгнать китайские технологии из своей критической инфраструктурыБрюссельские бюрократы предлагают постепенно вытеснить оборудование китайского производства из критической инфраструктуры Евросоюза. Для этого компаниям из КНР вроде Huawei и ZTE намерены запретить участвовать в создании телекоммуникационных сетей, солнечных электростанций и сканеров систем безопасности, сообщает The Financial Times. Новые меры планируют принять в рамках обновлённой политики, касающейся безопасности и технологий, в попытке снизить зависимости от компаний США и «высокорисковых» бизнесов Китая — некоторые политики считают, что те могут поставить под угрозу конфиденциальные данные европейцев. В США использование оборудования Huawei и других компаний в телеком-сетях давно запрещено, тогда как в странах Евросоюза отказ носит скорее добровольный характер. В сопровождении к раннему проекту предложенного закона Cybersecurity Act (он всё ещё может быть изменён) ранее подчёркивалось, что «фрагментированные» национальные решения доказали свою неэффективность в масштабах всего европейского рынка. Точные сроки теперь уже принудительного вытеснения китайского бизнеса будет зависеть от оценки сопутствующих рисков. В расчёт также примут стоимость и доступность альтернативных решений. Прежние рекомендации принимались к исполнению в ЕС весьма неравномерно, некоторые страны Евросоюза по-прежнему полагаются на «высокорисковых» поставщиков. Так, в 2025 году Испания подписала контракт на €12 млн с Huawei на поставки оборудования для хранения материалов прослушки, одобренной местными судебными органами, правоохранительными органами или спецслужбами. Еврокомиссия инициировала расследования в отношении производителей поездов и ветрогенераторов, а в 2024 году провела рейды в офисах компании Nuctech, занимающейся производством охранного оборудования. Стоит отметить, что сегодня более 90 % установленных в Евросоюзе солнечных панелей — китайского производства. Представители индустрии также отмечают отсутствие приемлемых альтернатив с учётом того, что ЕС одновременно должен снизить зависимость как от китайских, так и от американских поставщиков. Телеком-операторы уже предупредили о росте цен для клиентов, который будет вызван новыми запретами. Законопроект будет рассмотрен Европарламентом и странами ЕС по отдельности. Высока вероятность, что предложенные временные рамки внедрения запретов вызовут негативную реакцию некоторых членов союза. Более того, предложение может столкнуться с противодействием групп лоббистов. Так, в SolarPower Europe, представляющей европейскую «солнечную» промышленность, Huawei является полноправным участником благодаря производству инверторов. В ноябре Пекин заявил, что попытка Еврокомиссии отказаться от использования технологий Huawei и ZTE нарушит «рыночные принципы и правила честной конкуренции». Министерство иностранных дел отметило, что факты свидетельствуют, что в нескольких странах отказ от качественного и безопасного оборудования из КНР не только сдерживает развитие технологий в самих странах, но и привозит к большим финансовым потерям.

18.01.2026 [15:09], Руслан Авдеев

BlackRock привлекла $12,5 млрд для инвестиций в ИИ-инфраструктуру, но это лишь часть масштабного планаBlackRock привлекла $12,5 млрд на инвестиции в ИИ-инфраструктуру совместно с Microsoft и MGX, сообщает Datacenter Dynamics. При этом BlackRock намерена в общей сложности привлечь на такие проекты в рамках фонда AIP $30 млрд акционерного капитала и ещё $70 млрд долгового финансирования. В сентябре 2024 года сообщалось, что MGX, Microsoft и BlackRock совместно инвестируют $100 млрд в ИИ-инфраструктуру. В ходе финансового отчёта за IV квартал 2025 года компания объявила, что сформированный для этих целей фонд Global AI Infrastructure Investment Partnership (AIP), к которому присоединились NVIDIA и xAI, а также Кувейтский фонд благосостояния (KIA), продолжает привлекать значительный капитал, в данном случае речь о $12,5 млрд, полученных благодаря партнёрству AIP с основателями и клиентами. По словам компании, партнёрство «разблокирует» возможности для «многотриллионных» инвестиций. Ранее фонд приобрёл за $40 млрд оператора ЦОД Aligned Data Center, это крупнейшая покупка такого рода в сфере цифровой инфраструктуры. В ноябре 2025 года Global Infrastructure Partners (GIP), принадлежащая BlackRock, объединилась с ACS для создания предприятия стоимостью €2 млрд ($2,33 млрд) для строительства ЦОД и управления ими. Предприятие будет курировать портфолио проектов цифровой инфраструктуры ACS, состоящее из инициатив по строительству ЦОД в США, Европе, Азии и Австралии, запланированная мощность — 1,7 ГВт. Ранее Blackeock также инвестировала в занимающуюся системами охлаждения компания Xnrgy, британский строительный бизнес Gravity Edge и разработчика ИИ-чипов Groq. Последний был приобретён NVIDIA за $20 млрд.

17.01.2026 [23:37], Владимир Мироненко

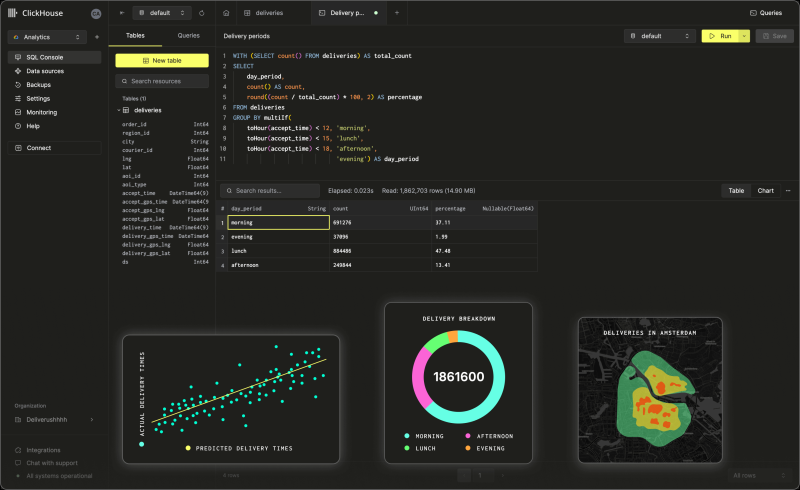

Капитализация ClickHouse после очередного раунда финансирования достигла $15 млрдClickHouse, разработчик колоночной СУБД с открытым исходным кодом, отделившийся более четырёх лет назад от Yandex NV, сообщил об успешном завершении раунда финансирования серии D, в ходе которого он привлёк $400 млн при оценке рыночной стоимости в $15 млрд. В предыдущем раунде, прошедшем в мае, оценка рыночной стоимости компании составила $6,35 млрд. Раунд возглавила инвестиционная группа Dragoneer Investment Group при участии Bessemer Venture Partners, GIC, Index Ventures, Khosla Ventures, Lightspeed Venture Partners, консультантов T. Rowe Price Associates и WCM Investment Management. Соучредитель и генеральный директор ClickHouse Аарон Кац (Aaron Katz) сообщил агентству Bloomberg, что компания планирует использовать полученные средства для ускорения разработки продукта, а также для увеличения продаж и маркетинга. ClickHouse отметила, что финансирование было получено на фоне продолжительного периода устойчивого роста компании. Её годовой регулярный доход (ARR) вырос более чем на 250 % в годовом исчислении. В настоящее время у её полностью управляемого сервиса ClickHouse Cloud насчитывается более 3 тыс. клиентов, включая Meta✴, Cursor, Sony и Tesla. Кац заявил, что ClickHouse была создана для обеспечения исключительной производительности и экономичности при работе с самыми требовательными рабочими нагрузками по обработке данных. Сейчас компания занимается внедрением унифицированной поддержой транзакционных и аналитических рабочих нагрузок, чего давно не хватало, а также наблюдаемостью (observability) LLM, чтобы разработчики ИИ-приложений могли оценивать качество результатов и поведение ИИ-моделей по мере их развёртывания. «Дополнительное финансирование в сочетании с продолжающимся развитием продукта позволяет нам предоставлять лидирующую платформу для сбора данных и мониторинга LLM в эпоху ИИ», — подчеркнул гендиректор ClickHouse. Инвестиционная компания Dragoneer отметила, что по мере того, как ИИ-системы переходят от экспериментов к продуктовому развёртыванию, требования, предъявляемые к базовой инфраструктуре обработки данных, возрастают, и всё большую ценность приобретают инфраструктурные платформы, которые обеспечивают крупномасштабные производственные нагрузки с большим объёмом данных: «По мере того, как модели становятся более функциональными, узкое место перемещается в инфраструктуру данных. ClickHouse выделяется тем, что обеспечивает производительность, экономичность и надёжность, необходимые для ИИ-систем, работающих в больших масштабах». ClickHouse также сообщила о приобретении стартапа Langfuse GmbH, разрабатывающего открытый инструмент для мониторинга LLM. Как сообщает SiliconANGLE, компании используют ПО Langfuse для отслеживания задержки и использования инфраструктуры своих приложений, работающих на основе LLM, что упрощает выявление первопричины сбоев и поиска решения. Эта сделка позволит ClickHouse улучшить интеграцию двух платформ. ClickHouse заявила, что цель состоит в том, чтобы сделать свою СУБД более конкурентоспособной среди разработчиков ИИ-приложений.

17.01.2026 [13:07], Сергей Карасёв

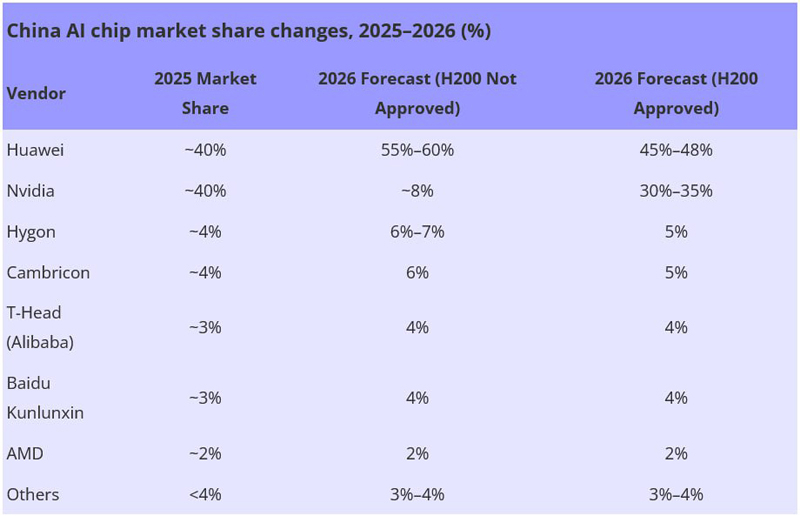

Huawei сравняла долю с NVIDIA на китайском рынке ИИ-чиповРезкий рост спроса на вычислительные мощности, геополитическое давление и ограничения в цепочках поставок приводят к трансформации китайского рынка ИИ-ускорителей. По оценкам Bernstein, которые приводит ресурс DigiTimes, позиции в КНР резко укрепила компания Huawei, которой удалось сравнять свою долю с NVIDIA. Объём сектора ИИ-чипов в Китае по итогам 2025 года достиг приблизительно $20,4 млрд. Примерно по 40 % от этой суммы, или по $8,16 млрд, приходится на Huawei и NVIDIA. Годом ранее доля Huawei составляла одну треть от показателей NVIDIA. Таким образом, сообща эти две компании контролируют около 80 % китайского рынка ИИ-ускорителей, что эквивалентно $16,32 млрд. Если не рассматривать двух лидеров, рынок ИИ-чипов в КНР является сильно фрагментированным. Так, Hygon и Cambricon занимают примерно по 4 %, при этом Hygon выигрывает от совместимости с архитектурой x86. T-Head Semiconductor, принадлежащая Alibaba, и Kunlunxin (Baidu) занимают по 3 % отрасли. Ещё около 2 % приходится на AMD. Все прочие игроки вместе взятые, включая Zixiao (Tencent), MetaX, Moore Threads и Biren, контролируют менее 4 % отрасли.

Источник изображения: DigiTimes Аналитики полагают, что в случае запрета поставок в Китай ускорителей H200 доля NVIDIA на местном рынке в 2026 году может сократиться до 8 %. При этом Huawei, как ожидается, укрепит позиции до 55–60 %. Если же поставки H200 в КНР будут одобрены, NVIDIA может занять 30–35 %, а Huawei — 45–48 %. При этом суммарная доля всех прочих игроков будет колебаться в пределах 24–27 %. По словам самой NVIDIA, запрет поставок ускорителей в Китай был большой ошибкой. В целом, считают эксперты, китайский рынок ИИ-чипов в период с 2023-го по 2028 году будет демонстрировать среднегодовой темп роста в сложных процентах (CAGR) на уровне 50 %. В результате, его объём за этот период увеличится с $11 млрд до $88 млрд.

16.01.2026 [16:57], Руслан Авдеев

Moody’s: несмотря на отсутствие явной прибыли, триллионные инвестиции в ИИ-инфраструктуру и не думают прекращатьсяВызванный развитием ИИ бум строительства ЦОД, похоже, не спешит идти на спад. При этом опасения возникновения «пузыря» на рынке и того, что вся «конструкция» рухнет от недостатка инвестиций, не особенно усиливаются, сообщает The Register со ссылкой на аналитику Moody’s. В отчёте Moody’s 2026 Outlook прогнозируется сохранение текущих тенденций. При этом спрос на вычислительные мощности продолжит расти из-за растущих же требований ИИ, облачных площадок и интернет-сервисов. Согласно имеющимся оценкам, чтобы обеспечить прогнозируемый рост вычислительных мощностей, до конца десятилетия потребуется не менее $3 трлн инвестиций (данные подтверждает JLL), включая расходы на строительство зданий, IT-инфраструктуры и реализацию связанных энергетических проектов, необходимых для обеспечения работы ЦОД. Тем не менее, эксперты обеспокоены ограниченными возможностями электросетей и проблемами со строительством новых ЦОД. Также отмечается, что получение реальных доходов становится «всё важнее в экосистеме ИИ» — это необходимо, чтобы слухи о возможных «пузырях» потеряли остроту. Поднятые вопросы далеко не новы. В мае 2025 года McKinsey & Company предупреждала, что огромные суммы на ИИ выделяются лишь на основе прогнозов спроса, т.е. всего лишь предположениях, пусть и обоснованных. Агентство прогнозировало, что к 2030 году инвестиции в ИИ ЦОД перевалят за $5 трлн. В MIT полагают, что 95 % корпоративных пользователей всё ещё не получили отдачи от вложений в ИИ, а Moody’s заявляет, что циклические сделки, при которых деньги циркулируют между ограниченным кругом компаний, включая OpenAI и Microsoft, уже пугают инвесторов.

Источник изображения: Arron Choi/unsplash.com Капитальные затраты шести крупнейших американских игроков — Microsoft, Amazon, Alphabet, Oracle, Meta✴ и CoreWeave — приблизились к $400 млрд в 2025 году и, вероятно, достигнут $500 млрд в 2026-м и $600 млрд в 2027-м. Пика общий объём инвестиций должен достигнуть в 2029 году, после чего в 2030 году вложения начнут сокращаться. Строительство новых ЦОД обходится всё труднее, во многом из-за ограниченного доступа к электроэнергии на большинстве рынков, не готовых удовлетворить такие скачки спроса. Moody’s отмечает, что в некоторых регионах общественность всё активнее противится строительству ЦОД, опасаясь, что те будут потреблять слишком много электричества и воды, а также повлияют на коммунальные платежи. При этом остаются регионы с «благоприятными законами», которые продолжат привлекать инвестиции. В 2025 году, например, Великобритания объявила о создании «зон роста» ИИ (AI Growth Zones) с упрощением бюрократических формальностей.

Источник изображения: Imagine Buddy/unsplash.com По мере того, как растут риски, от застройщиков требуют всё более быстрой реализации проектов, чтобы крупные арендаторы могли как можно быстрее наращивать IT-мощности. Этому мешает дефицит квалифицированных рабочих, строительных материалов и оборудования, из-за чего растут затраты. В отчёте подчёркивается, что некоторые арендаторы уже готовы к рискам, которых раньше старались избежать. Например, речь идёт о доступности электричества и коммунальных услуг и др. факторах. Moody's подчеркивает риски «круговых сделок» OpenAI, в ходе которых компания заключила соглашения на гигаватты новых мощностей ЦОД и другие активы стоимостью сотни миллиардов долларов. В основном финансирование этих активов зависит от долгосрочных договоров аренды с компаниями уровня Microsoft и Oracle, но растущая роль OpenAI в экосистеме ИИ создаёт нарастающий кредитный риск, зависящий от успеха компании. В своём последнем квартальном отчёте OpenAI сообщила о чистом убытке более $11,5 млрд. Недавно аналитики DC Byte назвали основные тренды рынка ЦОД в 2026 году: всё больше проектов ЦОД не доходят до стадии строительства, правительства всё активнее влияют на скорость реализации проектов, капитал всё больше расходуется на ранних стадиях реализации проектов, что повышает риски для инвесторов. Кроме того, рост рынка больше не завязан на крупнейшие ИИ-хабы вроде Северной Вирджинии или Сингапура и всё чаще участники рынка отдают предпочтение регионам с более стабильным энергоснабжением и прозрачными нормативами застройки.

16.01.2026 [16:26], Владимир Мироненко

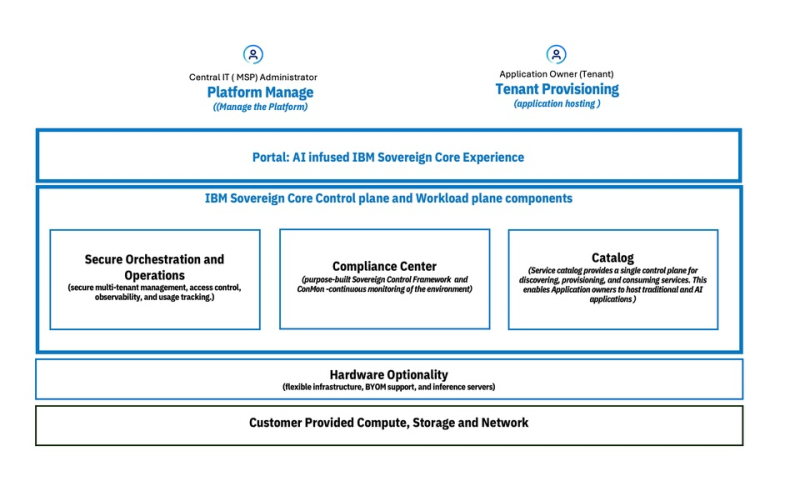

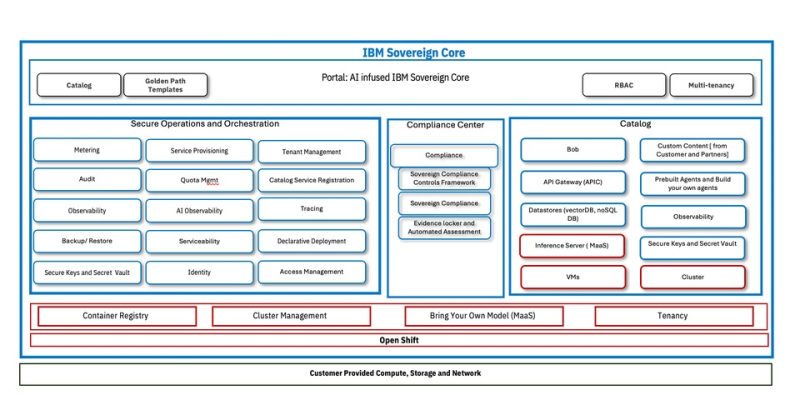

IBM представила облачную платформу IBM Sovereign Core для обеспечения непрерывного и проверяемого цифрового суверенитетаКомпания IBM представила программную платформу IBM Sovereign Core, разработанную для обеспечения более полного контроля обработки ИИ-приложений и облачных рабочих нагрузок на фоне дальнейшего ужесточения требований регулирующих органов к обеспечению цифрового суверенитета. IBM отметила, что цифровой суверенитет касается не только места размещения данных. Он также включает управление и контроль над технологической средой, контроль доступа и управление данными, управление исполнением рабочих нагрузок и юрисдикцию работы ИИ-моделей. Компания заявила, что организации при разработке инноваций испытывают всё большее давление в плане необходимости соответствия требованиям регуляторов, контроля операционной среды и хранения конфиденциальных данных в пределах национальных или региональных границ. IBM привела данные прогноза Gartner, согласно которому к 2030 году у более 75 % всех предприятий будет стратегия обеспечения цифрового суверенитета. IBM Sovereign Core — первое, по словам компании, в отрасли ПО с поддержкой суверенитета, предназначенное для создания, развёртывания и управления облачными и ИИ-нагрузками под собственным контролем организации в выбранных юрисдикциях. Оно базируется на открытых решениях Red Hat и, в отличие от предложений других провайдеров, предлагающих суверенные сервисы в виде наложения на существующие архитектуры политик или управляемых ими механизмов, предлагает суверенитет как встроенную функцию. Сачин Прасад (Sachin Prasad), программный директор по управлению продуктами в области ИИ и данных в IBM подчеркнул в интервью SiliconANGLE, что ИИ не относится к второстепенным элементам, он должен быть встроен в структуру. IBM сообщила, что при разработке IBM Sovereign Core основывалась на трёх фундаментальных принципах, которые формируют ПО от начала до конца. Во-первых, суверенитет — это возможность платформы, и он должен быть доказуемым. В IBM Sovereign Core суверенитет обеспечивается архитектурно, а не договорно. Управление основано не на наложении политик на существующие решения вендора, а на автоматизированных постоянно действующем контроле управления, принадлежащем пользователю. Платформа базируется на технологиях Red Hat OpenShift с изоляцией ПО, работающим как SaaS, но полностью находящимся под контролем компании и местных властей. Идентификация, ключи шифрования, журналы, телеметрия и аудиторские данные остаются полностью в пределах суверенных границ. Возможности постоянного соответствия требованиям встроены непосредственно в платформу, позволяя организациям по запросу получать готовые к проверке регуляторами доказательства суверенности. Во-вторых, платформа обеспечивает и суверенитет ИИ. В пределах суверенных границ организации могут развёртывать кластеры на базе CPU/GPU, использовать утверждённые открытые или проприетарные модели и управлять доступом к моделям, инструментам и источникам знаний через контролируемые шлюзы. Инференс и агенты работают локально, без экспорта данных или телеметрии внешним поставщикам. Что не менее важно, IBM Sovereign Core обеспечивает суверенитет во время выполнения, а не только во время конфигурации. Идентификация, доступ, использование моделей и активность постоянно отслеживаются и записываются, создавая чёткий аудиторский след для ИИ-систем, работающих в регулируемых областях. И в-третьих, суверенитет реализован не в ущерб производительности и масштабируемости. IBM Sovereign Core можно быстро развернуть и управлять тысячами ядер и сотнями узлов с различными требованиями и средствами контроля суверенности из единого центра. Автоматическая настройка идентификации, безопасности и соответствия требованиям заложена с самого начала, а самообслуживание для предоставления ресурсов CPU, GPU, ВМ и сред ИИ-инференса обеспечивает повторяемое развёртывание в корпоративных и многопользовательских моделях без ущерба для контроля — локально, в облаке или в партнёрских средах поставщиков услуг, где требуется лишь поддержка Kubernetes. Эта гибкость, по словам IBM, позволяет клиентам перемещать рабочие нагрузки не только между регионами, но и между различными инфраструктурами, что в сочетании с возможностью устанавливать уникальные параметры управления, позволит адаптироваться по мере изменения нормативных требований с развитием ИИ-технологий. Благодаря проверяемому аудиторскому следу, документирующему непрерывное соответствие требованиям, компания сможет в любой момент продемонстрировать соответствие нормам в области суверенитета и, таким образом, сократить расходы, связанные с аудитом. «Соответствие требованиям и аудит обходятся дорого с точки зрения времени и ресурсов, и ситуация только ухудшается», — сообщил главный аналитик Moor Insights and Strategy Джейсон Андерсен (Jason Andersen). «Всё, что упростит и оптимизирует этот процесс, принесёт большую пользу IT-специалистам и поставщикам управляемых услуг», — добавил он. Андерсен также отметил, что хотя на рынке предлагаются облачные решения для обеспечения суверенитета от AWS, Google и Microsoft, он «ещё не увидел ничего, созданного для гибридных сред, подобного тому, что предлагает IBM». По словам Прасада, при развёртывании новой платформы IBM первоначально сотрудничает с европейскими поставщиками услуг, прежде чем расширить сотрудничество на более широкий круг партнёров. Такой подход призван получить обратную связь, но не ограничит распространение. Он добавил, что IBM рассчитывает продавать пакет напрямую: «Он будет продаваться так же, как и любой другой продукт». Компания сообщила, что начиная с февраля, IBM Sovereign Core будет доступна в режиме предварительного тестирования, а выход полной общедоступной версии запланирован на середину 2026 года.

16.01.2026 [14:24], Сергей Карасёв

Gartner: глобальные расходы на ИИ в 2026 году достигнут $2,5 трлнПо оценкам Gartner, в 2025 году затраты, связанные с ИИ, достигли в мировом масштабе $1,76 трлн. Отрасль стремительно развивается: в 2026-м её объём, как ожидается, увеличится на 44 % в годовом исчислении, достигнув $2,53 трлн. А в 2027 году затраты могут вырасти до $3,34 трлн. Аналитики подсчитали, что в 2025-м наибольшая часть затрат пришлась на ИИ-инфраструктуру — $964,96 млрд. Связано это с активным развитием дата-центров, ориентированных на ресурсоёмкие задачи обучения больших языковых моделей (LLM) и инференса. Ожидается, что в 2026 году расходы в области ИИ-инфраструктуры составят $1,37 трлн, а в 2027-м — $1,75 трлн. Всевозможные ИИ-сервисы в 2025 году принесли $439,44 млрд, софт в области ИИ — $283,14 млрд, средства ИИ-кибербезопасности — $25,92 млрд. В 2026 году эти расходы, по мнению аналитиков Gartner, поднимутся соответственно до $588,65 млрд, $452,46 млрд и $51,35 млрд. В 2027-м ожидается увеличение затрат до $761,04 млрд, $636,15 млрд и $86,0 млрд. Среди других ключевых статей расходов названы ИИ-модели, ИИ-платформы для наук о данных и машинного обучения, платформы разработки ИИ-приложений и данные для ИИ. В 2025 году затраты по указанным направлениям оцениваются в $14,42 млрд, $21,87 млрд, $6,59 млрд и $827 млн соответственно. В 2026 году прогнозируется рост до $26,38 млрд, $31,12 млрд, $8,42 млрд и $3,12 млрд, а в 2027-м — до $43,45 млрд, $44,48 млрд, $10,92 и $6,44 млрд. Аналитики Gartner также говорят о продолжающемся увеличении поставок ИИ-серверов. Их продажи в денежном выражении в 2026 году, как прогнозируется, подскочат на 49 % по сравнению с предыдущим годом. На такие серверы придётся приблизительно 17 % от общих расходов на глобальном рынке ИИ. |

|