Материалы по тегу: ии

|

16.01.2026 [13:56], Руслан Авдеев

Наобещали с три кампуса: к Oracle подан коллективный иск из-за непрозрачных условий финансирования мегапроекта для OpenAIПротив Oracle подан коллективный иск от группы недовольных держателей облигаций. Последние утверждают, что потеряли деньги, поскольку компания ввела их в заблуждение относительно того, сколько средств ей потребуется для финансирования своих инфраструктурных ИИ-проектов, сообщает Tom’s Hardware со ссылкой на Reuters. В частности, истцы заявляют, что компания сообщала, что ей «могут» понадобиться дополнительные заёмные средства тогда, когда уже запланировала эмиссию очередной партии облигаций. По имеющимся данным, Oracle продала векселя и облигации на сумму $18 млрд 25 сентября 2025 года для поддержки инфраструктурной сделки с OpenAI на $300 млрд. Тем не менее инвесторы были весьма удивлены, что она выпустила новые облигации на сумму $38 млрд приблизительно двумя месяцами спустя. Как заявляется в иске, рынок очень быстро и негативно отреагировал на увеличение долгов Oracle, расценив дополнительные обязательства по ценным бумагам как увеличившийся кредитный риск компании. Из-за этого первоначальная серия облигаций и векселей упала в цене и теперь продаётся, как ценные бумаги компаний с более низким рейтингом. Держатели ценных бумаг во главе с пенсионным фондом Ohio Carpenters’ Pension Plan утверждают, что в сопроводительных документах к первоначальным облигациям сообщалось, что компания лишь рассматривает возможность дополнительных займов. Истцы уверены, что Oracle уже знала на тот момент, что выпустит новую, значительно более крупную партию ценных бумаг для финансирования масштабирования своего бизнеса. По словам истцов, Oracle и некоторые из её топ-менеджеров, как и 16 банков, выступивших андеррайтерами кредита, несут ответственность в соответствии с Законом о ценных бумагах (Securities Act) 1933 года. В то время как эксперты раз за разом повторяли о возможности появления пузыря на рынке ИИ, Oracle агрессивно занимала средства для финансирования своих планов в этой сфере. Когда компания запустила раунд привлечения средств в сентябре 2025 года на $18 млрд, спрос на ценные бумаги был так высок, что в четыре раза превысил предложение. Но уже через три месяца инвесторы зарегистрировали потерю на ценных бумагах $1,3 млрд. И хотя S&P и Moody's всё ещё присваивают компании рейтинги инвестиционного уровня, оценка на уровнях BBB или Baa2 лишь немногим отличается от «мусорной». Более того, рейтинговые агентства могут пересмотреть оценки в зависимости от уровня рисков, которые компания принимает на себя. Масштабное строительство ИИ-площадок требует миллиардов, если не триллионов долларов инвестиций. Это, вероятно, не особенно большая проблема в случае с компаниями уровня Microsoft, Meta✴ и Amazon, имеющих большие резервы и способных без особенного напряжения вкладывать в строительство огромные суммы. Компаниям поменьше нередко требуется стороннее финансирование с помощью векселей и облигаций, продажи акций и др. в разных комбинациях. Более того, многие, действующие в сфере ИИ компании участвуют в сети перекрёстных инвестиций, проектов, продаж и займов, поэтому крах даже одной из них может означать катастрофический коллапс всей экосистемы.

15.01.2026 [18:19], Сергей Карасёв

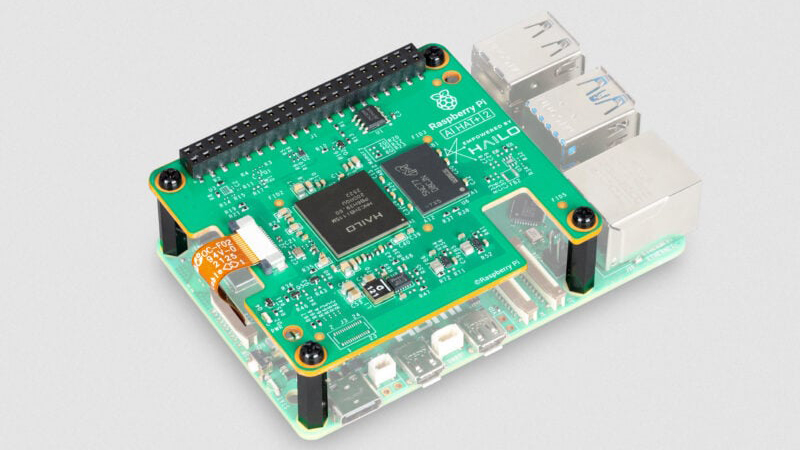

Модуль AI HAT+ 2 добавляет к Raspberry Pi 5 ИИ-ускоритель Hailo-10HКомпания Raspberry Pi анонсировала специализированный модуль расширения AI HAT+ 2, позволяющий использовать одноплатный компьютер Raspberry Pi 5 для ИИ-инференса. Новинка уже доступна для заказа по ориентировочной цене $130. Ранее Raspberry Pi выпустила ИИ-модуль AI HAT+, который в зависимости от модификации оснащается ускорителем Hailo-8 (26 TOPS) или Hailo-8L (13 TOPS). Такие изделия предназначены прежде всего для инференса. Решение Raspberry Pi AI HAT+ 2, в свою очередь, спроектировано под генеративный ИИ. В основу новинки положен ускоритель Hailo-10H, который позволяет использовать большие языковые модели (LLM), визуально-языковые модели (VLM) и другие модели генеративного ИИ локально. Чип функционирует в тандеме с 8 Гбайт LPDDR4/4X. Заявленная ИИ-производительность достигает 40 TOPS на операциях INT4. Для задач, основанных на машинном зрении, таких как распознавание объектов, оценка позы и сегментация сцены, производительность AI HAT+ 2 приблизительно эквивалентна быстродействию ранее выпущенного ИИ-модуля на базе Hailo-8.

Источник изображения: Raspberry Pi При подключении модуля операционная система Raspberry Pi OS автоматически обнаруживает ускоритель и переносит на него поддерживаемые задачи ИИ. Поначалу для изделия будут доступны следующие LLM: DeepSeek-R1-Distill, Qwen2.5-Coder, Qwen2.5-Instruct и Qwen2 (все с 1,5 млрд параметров), а также Llama3.2 (с 1 млрд параметров). В дальнейшем будут предложены более крупные модели.

15.01.2026 [16:15], Руслан Авдеев

Jefferies: как бы Трамп ни противился, солнечная энергия всё ещё остаётся привлекательной для ЦОДХотя нынешняя администрация США весьма скептически относятся к возобновляемым источникам энергии, солнечная энергетика, похоже, останется важным элементом снабжения ЦОД, сообщает The Register. По данным инвестиционного банка Jefferies, компании, занимающиеся «чистой» энергетикой, вынуждены адаптироваться к меняющимся временам. В частности, прошлым летом значительно уменьшены бюджетные ассигнования на многие налоговые льготы, выделявшиеся «чистым» энергетическим проектам с момента принятия Закона о снижении инфляции (Inflation Reduction Act) в США в 2022 году. Этому предшествовал более ранний указ, заморозивший одобрение проектов ветряной энергетики на федеральном уровне, что уже привело к искам к правительству. Впрочем, Jefferies отмечает, что бюджетный закон, несмотря на сокращение помощи, способствовал появлению определённости на рынке. Теперь компании, занятые «чистой» энергетикой, ориентируются на соглашения о выкупе энергии (PPA) с ИИ ЦОД. Атомная, газовая и геотермальная энергетика лучше подходят для такого спроса, но относительно недорогая солнечная энергия тоже играет свою роль. В качестве основных партнёров обычно рассматриваются поставщики энергии газовых турбин, что сдерживает рост PPA для солнечной и ветряной энергии. Тем не менее, эксперты предполагают, что компании в этих сферах в 2026 году всё равно расширят сферу своего действия.

Источник изображения: Markus Spiske/unspalsh.com В частности, речь идёт о рынке энергохранилищ. Согласно предыдущему прогнозу Jefferies, аккумуляторные хранилища (BESS) могут стать для ЦОД стандартным решением, поскольку в них нуждаются гиперскейлеры для развития ИИ-отрасли. В 2025 году исследование Centre for Net Zero продемонстрировало, что «микросети», включающие прибрежные ветряные и солнечные электростанции вкупе с аккумуляторными хранилищами и газовыми генераторами при ЦОД, обойдутся операторам дата-центров значительно дешевле, чем получение электроэнергии от малых модульных реакторов (SMR), несмотря на популярность последних в энергетической отрасли. Тем временем опубликованный Советом по международным отношениям (Council on Foreign Relations, CFR) доклад свидетельствует, что Конгресс США отклонил огромные сокращения бюджетных ассигнований на федеральные проекты исследований и развития энергетики, предложенные администрацией США. В CFR утверждают, что пересмотренный бюджет не позволит уступить Китаю и другим странам в деле внедрения передовых энергетических технологий. Новые технологии, более дешёвые и «чистые», чем доминирующие сегодня, сформируют триллионные рынки, причём Китай уже активно пользуется возможностью занять лидирующие позиции на рынках солнечных панелей и литий-ионных аккумуляторов. Значительную роль, по мнению Jefferies, может сыграть и мнение потребителей энергии. Доступность энергии является одной из ключевых проблем, что создаёт «положительные предпосылки» для ввода новых солнечных мощностей для частичной компенсации роста стоимости электроэнергии, хотя позиция администрация США относительно «зелёной» энергетики пока неизменна. В Jefferies предлагают следить, как будет развиваться ситуация с возобновляемыми источниками энергии на фоне роста розничных цен на электричество. Хотя Вашингтон, вероятно, будет и далее продвигать новые проекты АЭС и даже угольные инициативы, время запуска атомных станций слишком велико, чтобы позитивно повлиять на размер счетов за электричество.

15.01.2026 [10:10], Руслан Авдеев

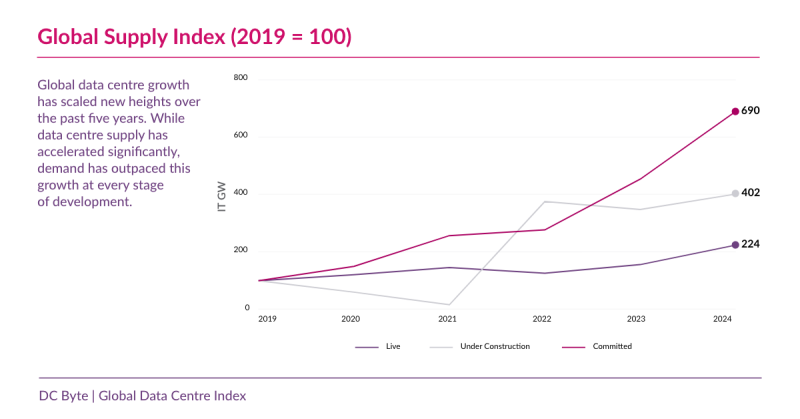

Планировать — не строить: пять трендов мирового рынка ЦОД в 2026 году по версии DC ByteВ 2026 году облака гиперскейлеров и ИИ-нагрузки требуют новых мощностей ЦОД, но возможность превратить запланированные мощности в действующие становится всё менее очевидной. Проблемы с доступностью энергии, ограничения регуляторов и задержки с вводом в эксплуатацию теперь оказывают существенное влияние, заявляется в докладе DC Byte. Аналитики назвали пять трендов, влияющих на планирование, финансирование и строительство новых мощностей ЦОД в 2026 году:

По данным DC Byte 2025 Global Data Centre Index, с 2019 года количество запланированных проектов ЦОД выросло более чем в шесть раз, но их вводимая в строй мощность растёт гораздо медленнее. В результате масштаб и спрос не меняются, но реализовать проекты становится сложнее, сроки реализации всё менее предсказуемы, а риски всё ощутимее. Дефицит электроэнергии, бюрократические барьеры и непредсказуемые сроки строительства будут ключевыми факторами для принятия решений о реализации инфраструктурных проектов для инвесторов и операторов, если ситуация останется неизменной в течение 2026 года.

Источник изображения: DC Byte Согласно докладу, разрыв между объектами «на бумаге» и реально строящимися дата-центрами только растёт. На некоторых ключевых рынках анонсированные мощности более чем вдвое больше действительно возводимых. Дело не в спросе — он велик в сфере облаков, соцсетей и ИИ, как и готовность инвесторов выделять средства. Реализация проектов нередко останавливается на полпути из-за проблем с присоединением к электросетям, задержек с получением разрешений от регуляторов, необходимости модернизации энергосетей и больших сроков поставок критически важного оборудования. В «зрелых» хабах уровень доступных мощностей упал ниже 1 %, но новые дата-центры по-прежнему часто так и не продвигаются дальше стадии планирования. Политические и бюрократические решения стали кардинально влиять на время реализации проектов. Исследование показало, что на некоторых зрелых рынках время присоединения к электросетям ожидается не раньше конца 2020-х гг., например, в Северной Вирджинии на подключение проектов мощнее 100 МВт может и вовсе уйти не менее семи лет. Если ранее разрешения на строительство получали за считанные месяцы, то теперь на это уходят годы, даже для хорошо финансируемых инициатив. На задержки влияют экологические законы, реформы зонирования, учёт энергоэффективности и др. Впрочем, на некоторых рынках происходит обратное — власти пытаются привлечь инвестиции, упрощая процесс получения всевозможных разрешений. Однако теперь инвесторы вынуждены вкладывать деньги в ЦОД как можно раньше, что связано с большими рисками — за 24–36 мес. до ожидаемого ввода в эксплуатацию, нередко на этапах покупки земли, переговорах о поставках энергии или получения разрешений. Ранее инвестиции поступали после подписания договоров с арендаторами или в ходе завершения основных этапов строительства. Ранние инвестиции обеспечивают доступ к энергии и земле, но существуют риски изменения законодательства, задержек с присоединением к сетям и проблем в цепочках поставок. Если тенденция сохранится, в 2026 году успешность инвестиций, вероятно, будет в большей степени зависеть от надёжности реализации проектов, чем просто от прогнозирования спроса.

Источник изображения: Benjamin White/unsplash.com Вместе с тем в ключевых мировых хабах ограничения только растут, так что рост смещается в направлении вторичных и совсем уж небольших рынков. Растущая доля новых проектов гиперскейл-уровня реализуется за пределами традиционных крупных, в местах с более доступной энергией. В Европе акцент смещается с рынка FLAPD (Франкфурт, Лондон, Амстердам, Париж и Дублин) в Южную и Центральную Европу. Такая децентрализация отражает ограничения в доступности энергии, земли и проблемах с регуляторами и заставляет пересматривать долгосрочные стратегии. Так, в АТР общая мощность ЦОД гиперскейлеров с 2020 по 2025 гг. росла в среднем на 32,9 % в год (CAGR), причём в основном рост отмечен за пределами старейших хабов региона. Если ограничения на ключевых рынках сохранятся, это скажется и на проектах в 2026 году. Рынки с более стабильным энергоснабжением и прозрачными правилами строительства растут более последовательно. Анализ показывает, что на таких рынках ввод мощностей идёт более стабильно, демонстрируя меньший разрыв между анонсированными, утверждёнными и введёнными в эксплуатацию ЦОД. Так, в Норвегии CAGR рынка в течение пяти лет с 2019 года составлил 43 % в год, а в Финляндии только в 2023–2024 гг. было введено более 1,4 ГВт IT-мощностей. Хотя в таких регионах нет крупных ежегодных анонсов новых проектов, в целом они обеспечивают более эффективную реализацию проектов, от стадии планирования до появления действующей инфраструктуры, с меньшими задержками, сроками реализации и рисками. С учётом пяти названных факторов, можно предполагать, что в 2026 году выигрывать будут проекты, которые легче реализовать — от стадии планирования до завершения строительства. По словам представителя DC Byte, значение теперь будет иметь не то, какие мощности ЦОД анонсированы, а то, сколько именно мощностей можно будет предоставить в срок. Недавно в докладе JLL сообщалось, что огромные затраты на ИИ ЦОД свидетельствуют не о «пузыре», а о «суперцикле» — к 2030 году на ЦОД будет потрачено $3 трлн. Правда, в сентябре 2025 года Bain Global Technology Report прогнозировала, что расходы ИИ-отрасли к 2030 году могут оказаться на $800 млрд больше её доходов.

15.01.2026 [09:09], Владимир Мироненко

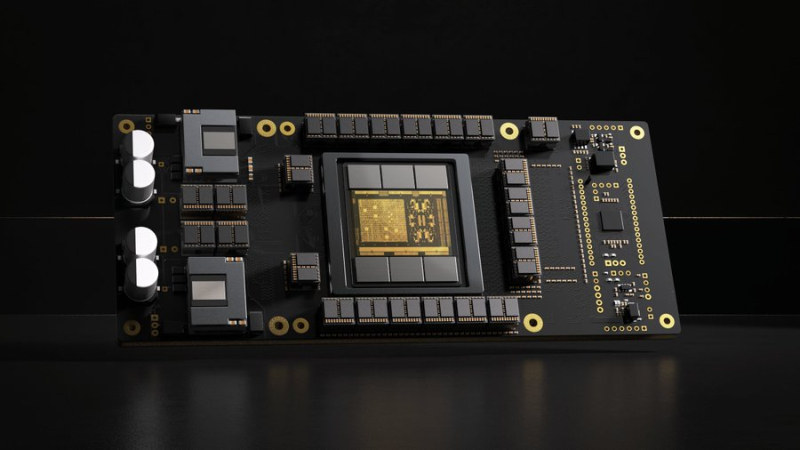

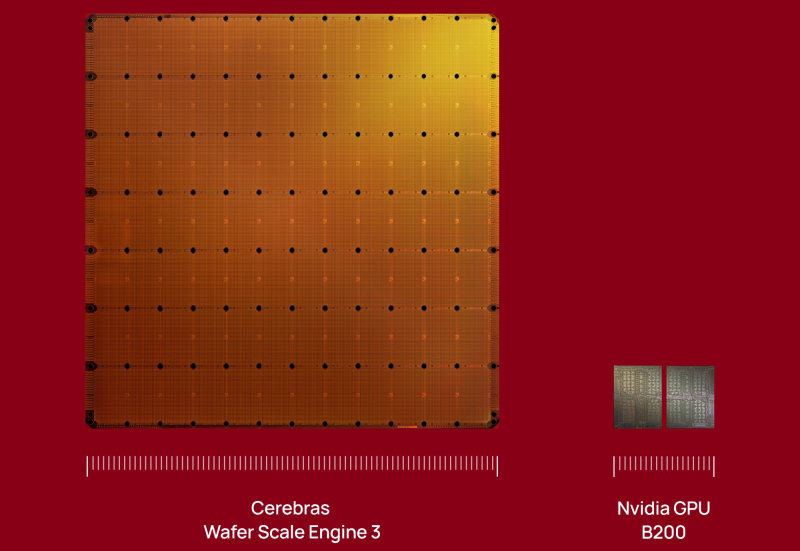

Инвесторы вкладывают сотни миллионов долларов в Etched и Cerebras в надежде, что они потеснят NVIDIA на рынке ИИЛидирующие позиции NVIDIA на рынке ИИ-ускорителей кажутся незыблемыми на долгие годы, но, как полагает ресурс SiliconANGLE, ей следует присмотреться к ближайшим конкурентам, которые пока не «дышат в спину», но стремительно наращивают свои возможности, получая солидную финансовую поддержку для роста. Согласно данным источников Bloomberg (официального сообщения пока не поступало), стартап Etched, занимающийся разработкой ИИ-чипов, привлёк около $500 млн в новом раунде финансирования, благодаря чему оценка его рыночной стоимости составила $5 млрд. Ещё более крупный конкурент NVIDIA, компания Cerebras Systems, по данным The Information, ведёт переговоры о привлечении $1 млрд инвестиций в рамках очередного раунда финансирования при оценке капитализации в $22 млрд. Всего лишь три месяца назад она уже получила $1,1 млрд при оценке в $8,1 млрд, в очередной раз перенеся IPO. По данным источников The Information, компания всё же выйдет на биржу в ближайшие месяцы. Сделка с OpenAI снизит её зависимость от базирующейся в ОАЭ компании G42. Как сообщают источники, нынешний раунд финансирования Etched возглавила компания Stripes при участии миллиардера Питера Тиля (Peter Thiel), а также компаний Positive Sum и Ribbit Capital. Ранее в инвестировании стартапа принимали участие Primary Venture Partners и известные бизнес-ангелы, такие как генеральный директор GitHub Томас Домке (Thomas Dohmke) и бывший руководитель Coinbase Баладжи Сринивасан (Balaji Srinivasan). По словам источников, с учётом этого раунда общая сумма привлечённых средств Etched приблизилась к $1 млрд. Это довольно внушительный финансовый резерв для стартапа, существующего всего два года. Etched создал Sohu — узкоспециализированный ASIC разработанный специально для инференса ИИ-моделями на архитектуре трансформеров. При разработке чипа Etched сотрудничала с группой Emerging Businesses компании TSMC, что свидетельствует как о технических амбициях, так и о производственной надёжности. Также к участию в проекте привлекли специалистов, ранее работавших в таких компаниях, как Cypress Semiconductor и Broadcom. В свою очередь, Cerebras Systems получила известность благодаря своим царь-чипам WSE, которые, по словам компании, значительно быстрее и энергоэффективнее решений NVDIA в ИИ-задачах. В отличие от Etched, Cerebras активно наращивает клиентскую базу, не только развёртывая оборудование, но и предоставляя услуги облачных ИИ-вычислений. Среди её клиентов — Meta✴, IBM и Mistral AI.

15.01.2026 [01:05], Игорь Осколков

$10 млрд за 750 МВт ИИ-мощностей: OpenAI подписала сделку с CerebrasOpenAI подписала многолетнее соглашение с разработчиком царь-ускорителей Cerebras, который до 2028 поставит 750 МВт вычислительных мощностей. По данным CNBC, сумма сделки превышает $10 млрд. Идёт ли речь о продаже ИИ-ускорителей или предоставлении сервисов инференса, пока не уточняется. «Вычислительная стратегия OpenAI заключается в создании отказоустойчивого портфеля, в рамках которого для различных рабочих нагрузок подбираются подходящие системы», — сообщила OpenAI, отметив высокую скорость инференса решений Cerebras, что ускорит генерацию ответов, обеспечит более естественное взаимодействие и позволит масштабировать использование ИИ в реальном времени для гораздо большего числа людей. OpenAI использует комбинацию ускорителей AMD и NVIDIA, а также строит гигантские ЦОД на базе решений последней в рамках проекта Stargate. Кроме того, OpenAI сотрудничает с Google, у которой есть ускорители TPU, а также разрабатывает собственные ИИ-чипы в партнёрстве с Broadcom. Наконец, компания может повлиять на разработку нового поколения фирменных ускорителей Microsoft Maia. AWS тоже не прочь дать OpenAI свои ИИ-ускорители Trainium, но пока компании договорились лишь о масштабной аренде чипов NVIDIA. Примечательно, что OpenAI ещё в 2017 году раздумывала, не купить ли Cerebras при участии Tesla, глава которой Илон Маск (Elon Musk) тогда всё ещё работал в OpenAI. На тот момент Cerebras было всего два года, а свой первый ускоритель WSE она представила только в 2019 году. Серьёзную поддержку компании оказала G42 из ОАЭ, но в итоге Cerebras оказалась от неё слишком зависима, так что сделка с OpenAI сыграет компании на руку в преддверии всё откладывающегося выхода на биржу.

14.01.2026 [16:27], Руслан Авдеев

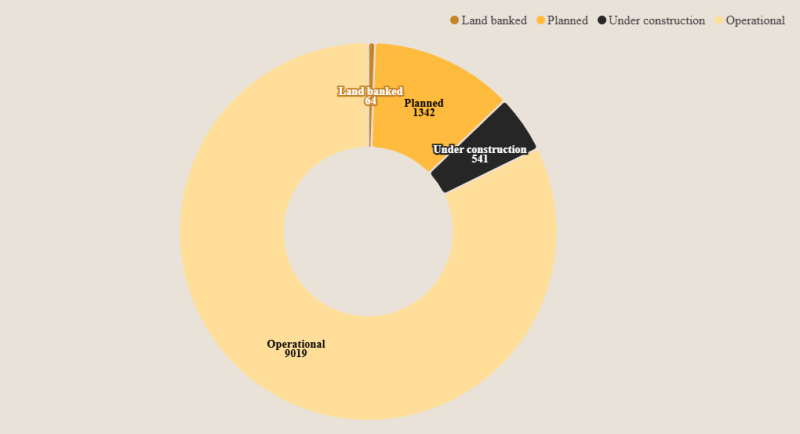

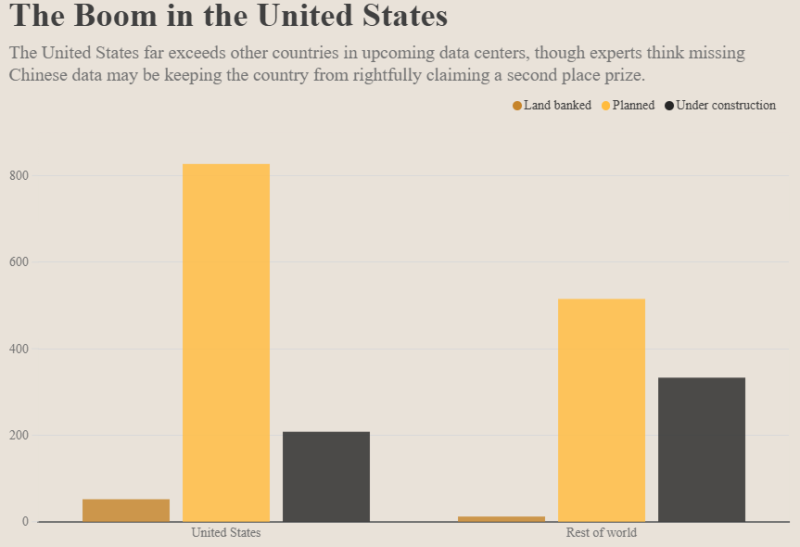

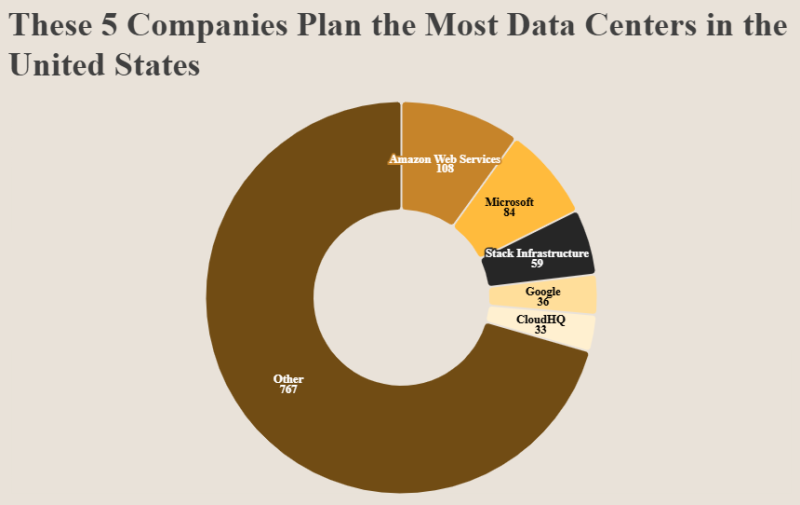

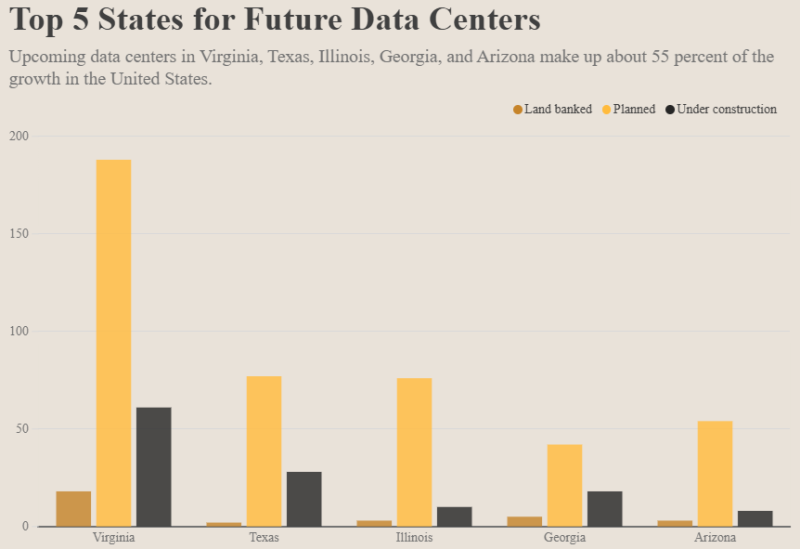

США являются лидерами в сфере развития ЦОД, но темпы роста отрасли в Китае остаются загадкойНа сегодняшний день в мире реализуются проекты 1947 новых дата-центров — более 20 % от числа действующих сегодня (9019 шт.). Учитываются как уже строящиеся или анонсированные объекты, так и те, для которых пока куплена только земля. Более половины новых проектов реализуется в США, но есть и сильный конкурент, данные о котором неполны, сообщает IEEE Spectrum. Если бы появились полные данные, роль США на рынке ЦОД, вероятно, оказалась бы ещё важнее. По словам эксперта Electric Power Research Institute (EPRI) Тома Уилсона (Tom Wilson), из-за доступности земли и специализации на HPC-сервисах средние размеры и энергопотребление ЦОД в США значительно выше, чем в других странах. Среди ключевых застройщиков называются AWS, Microsoft, Stack Infrastructure, Google и CloudHQ. При этом надо отметить, что гиперскейлеры не только строят собственные дата-центры, но и арендуют их. Тем не менее, по словам Уилсона, имеющаяся статистика, предоставленная Data Center Map, может недостаточно полно учитывать новые китайские дата-центры, поскольку зачастую никто не объявляет о них публично. Но даже если бы данные о китайских дата-центрах были актуальными, Уилсон считает, что США всё равно считались бы лидерами, а за ними, с некоторым отставанием, всё равно шёл бы Китай. Уилсона беспокоит способность электросетей США удовлетворить спрос новых дата-центров на энергию. Спрос оставался неизменным буквально в течение двадцати последних лет, а теперь индустрия ЦОД в США требует энергии в огромных объёмах. По словам эксперта, решение проблемы с энергоснабжением может заключаться в договорённости с операторами ЦОД, чтобы те потребляли энергию более «гибко». Например, речь может идти о проведении сложных вычислений вне пиковых нагрузок на энергосети или об использовании на площадках ЦОД энергохранилищ, что отчасти снизит нагрузку на энергосети. Будет ли таких мер достаточно для удовлетворения спроса — остаётся открытым пока вопросом. Известно другое. В декабре 2025 года экоактивисты более 230 организаций призвали США немедленно остановить строительство всех ИИ ЦОД, поскольку ИИ-бум представляет большую экологическую и общественную угрозу. Более того, в США начали расследование влияния ИИ ЦОД на рост тарифов на электроэнергию. Всего, по оценкам Omdia, капитальные затраты на ЦОД в мире превысят в 2025 году $657 млрд, расходы гиперскейлеров на дата-центры уже превысили ВВП целых стран.

14.01.2026 [15:39], Руслан Авдеев

США разрешили экспорт NVIDIA H200 в Китай, а Китай импорт H200 не разрешилСША официально разрешили поставки чипов NVIDIA H200 китайским клиентам несмотря на неодобрение некоторых политиков. Впрочем, как оказалось, в Китае эти ускорители не очень ждут, сообщает Reuters. Параллельно США прикрыли лазейку в законах, позволявшую КНР пользоваться передовыми ИИ-чипами в зарубежных ЦОД и облаках. Согласно новым американским правилам, продаваемые в КНР чипы должны перед поставками проверяться независимыми лабораториями для подтверждения их технических характеристик. При этом в Поднебесную запрещено продавать более 50 % от общего объёма чипов, продаваемых американским клиентам. NVIDIA придётся доказать, что в США достаточно ускорителей H200, а китайские клиенты должны пройти «необходимые процедуры безопасности» и не должны использовать полупроводники в военных целях. Ранее об этих условиях не сообщалось. В NVIDIA подчёркивают, что критики новых правил непреднамеренно продвигают интересы конкурентов компании, находящихся в американском «чёрном списке». В декабре было объявлено о возможности продавать чипы NVIDIA H200 в КНР с условием уплаты в американский бюджет пошлины в объёме 25 % от их стоимости. Китайским технологическим компаниям нужно порядка 2 млн H200, причём каждый из ускорителей стоит около $27 тыс. Это превышает запасы NVIDIA, на складах которой имеется не более 700 тыс. таких чипов. Глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что компания нарастит производство H200. По словам Reuters, пожелавшие остаться анонимными сотрудники китайской таможни заявили, что ввоз чипов NVIDIA H200 в Китай пока не разрешён. Также, по некоторым данным, китайские власти пригласили представителей местных технологических компаний на встречу, в ходе которой недвусмысленно указали не покупать H200 без крайней необходимости. Фактически, по данным источников СЧМИ, речь идёт о временном запрете закупок, который может стать постоянным. H200 в последнее время находится в центре обсуждений американо-китайских отношений. Хотя спрос со стороны китайского бизнеса велик, есть вероятность, что Пекин вовсе запретит ввоз таких чипов, чтобы местные разработчики ИИ-чипов могли развивать собственные проекты. Также возможно, что вопросы, касающиеся поставок H200, станут предметом торга с Вашингтоном. Пока нет данных, касается ли запрет уже сделанных заказов, или только новых. Желая замедлить развитие Китая в сфере ИИ и технологий в целом, США с 2022 года ввела ограничения на экспорт в КНР передовых полупроводников. В 2025 году США сначала запретили, а позже разрешили экспорт ускорителей H20, но поставки с августа фактически заблокировал сам Китай. Дженсен Хуанг заявлял, что доля NVIDIA на рынке ИИ-чипов КНР уменьшилась до нуля. H200 приблизительно в шесть раз производительнее H20 и отказаться от такого предложения полностью КНР будет весьма затруднительно, особенно с учётом того, что собственные чипы китайской разработки далеко не столь производительны.

14.01.2026 [13:05], Руслан Авдеев

Дональд Трамп: американцы не должны оплачивать модернизацию энергетической инфраструктуры для ИИ ЦОДДональд Трамп (Donald Trump) заявил, что техногиганты должны сами оплачивать адаптацию энергетической инфраструктуры для новых дата-центров — вместо того, чтобы перекладывать эту ношу на обычных людей, сообщает The Register. Соответствующее заявление он опубликовал в собственной социальной сети Truth Social, подчеркнув, что граждане США не должны оплачивать повышенные счета за электричество из-за дата-центров. Администрация президента работает с ключевыми технологическими компаниями для получения от них соответствующих обязательств. Трамп сообщил, что первой в списке станет Microsoft, которая уже сотрудничает с властями по данному вопросу. Это новая задача для президента, в прошлом году пообещавшего представителям технологической олигархии, что та получит столько энергии, сколько необходимо для сохранения лидерства США в сфере ИИ. Microsoft уже ответила на инициативу Трампа, представив т.н. проект Community-First AI Infrastructure. В компании утверждают, что намерены быть «хорошим соседом» в тех сообществах, где они строят ЦОД, владеют и управляют ими. Президент компании Брэд Смит (Brad Smith) заявил, что технологические компании имеют уникальную возможность обеспечить преимущества, которые ожидаются от внедрения ИИ, но в то же время несут ответственность за новые вызовы, которые это внедрение создаёт. В июне 2025 года один из представителей Microsoft жаловался, что есть сообщества, не желающие присутствия компании, а также на «отсутствие понимания» того, почему дата-центры необходимы, со стороны широкой общественности. Инициатива Community-First AI Infrastructure Initiative предоставляет рамочную программу для того, чтобы справляться с подобными вызовами, и связана с пятью обязательствами Microsoft:

Утверждается, что Microsoft будет запрашивать у коммунальных компаний цены на электричество, достаточно высокие, чтобы покрывать его стоимость для ЦОД компании, включая стоимость расширения инфраструктуры электроснабжения. Впрочем, Смит также отметил, что ИИ принесёт столько благ, что общество само должно помочь оплатить дополнительное электричество, в котором нуждается страна. Дополнительно Microsoft вновь подтвердила, что сохраняет и приверженность снижению объёмов используемой воды для ЦОД, к 2030 году интенсивность использования воды дата-центрами должна снизиться на 40 %. Впрочем, как сообщалось в 2023 году, год к году использование воды компанией только выросло на 34 % до 6,4 млн м3. Также Microsoft обязуется создавать новые рабочие места, хотя противники дата-центров отмечают, что тысячи человек нужны только на время строительства ЦОД, а в ходе их эксплуатации может хватить и 50. Впрочем, несмотря на весь оптимизм, Смит пришёл к выводу, что расширение инфраструктуры всегда сопряжено с трудностями, финансовыми затратами и неизбежно порождает опасения и споры. В Microsoft считают, что частные компании могли бы помочь, поскольку техногигантам не удастся преодолеть неизбежные вызовы в одиночку. Хотя многие эксперты опасаются пузыря на рынке ИИ, способного вызвать непредсказуемые последствия для всех сфер жизни, JPMorgan прогнозирует, что затраты на дата-центры и ИИ-инфраструктуру составят $5 трлн, а спрос будет «астрономический». Тем временем, как сообщалось в декабре 2025 года, в США стартовало расследование, касающееся влияния ИИ ЦОД на рост тарифов на электроэнергию.

14.01.2026 [09:45], Владимир Мироненко

Самая загадочная сделка 2025 года: зачем NVIDIA потратила $20 млрд на Groq?Сделка NVIDIA с ИИ-стартапом Groq, фактически означающая его поглощение, вызвала вопросы по поводу целей, которые преследует лидер ИИ-рынка. Для того, чтобы избежать волокиты с одобрением сделки регулирующими органами и антимонопольных расследований, NVIDIA провела её под видом приобретения неисключительной лицензии на технологии Groq. В результате сделки ключевые кадры Groq перешли в NVIDIA, а остатки команды во главе с финансовым директором продолжат управлять инфраструктурой GroqCloud и вряд ли смогут сохранить былую конкурентоспособность стартапа. Похожую сделку NVIDIA провела немногим ранее, фактически поглотив стартап Enfabrica, занимавшийся разработкой интерконнекта. В случае с Enfabrica, по слухам, сумма сделки составила $900 млн. Это большая сумма для стартапа, находящегося на ранней стадии, но вполне обоснованная в нынешних условиях, пишет EE Times. Groq — более крупный стартап, но и стоимость сделки гораздо выше — $20 млрд при последней оценке стартапа на уровне $6,9 млрд. Если в отношении Enfabrica предполагалось, что сделка была связана, хотя бы частично, с наймом персонала, то для Groq такая большая сумма вряд ли выглядит оправданной, если речь идёт только о привлечении квалифицированных кадров. Можно допустить, что NVIDIA планирует выпускать чипы Groq. Их упомянул в электронном письме сотрудникам гендиректор NVIDIA Дженсен Хуанг: «Мы планируем интегрировать процессоры Groq с низкой задержкой в архитектуру NVIDIA AI Factory, расширив платформу для обслуживания ещё более широкого спектра задач ИИ-инференса и рабочих нагрузок в реальном времени». Вместе с тем в ходе CES 2026 Хуанг заявил, что технология Groq не станет частью основного портфолио NVIDIA для ЦОД. «[Groq] — это совсем, совсем другое, и я не ожидаю, что что-либо заменит то, что мы делаем с Vera Rubin и нашим следующим поколением, — сказал Хуанг. — Однако мы могли бы добавить его технологию таким образом, чтобы что-то постепенно улучшить, чего мир ещё не смог сделать». Судя по фразе «могли бы», NVIDIA пока окончательно не определилась с тем, что будет делать с активами Groq. Технология Groq позволит решать задачи, которые недоступны для Vera Rubin, в частности, сверхбыстрый инференс в реальном времени, пишет EE Times. Можно предположить, что NVIDIA будет производить и развёртывать чипы Groq как отдельное решение в ЦОД. Хотя Хуанг и сказал об интеграции чипов Groq с архитектурой NVIDIA AI Factory, это всё ещё кажется несколько надуманным, так как означает признание NVIDIA в том, что её GPU не вполне подходят для некоторых рабочих нагрузок. Однако Дженсен Хуанг в очередной раз подчеркнул на CES 2026, что гибкости GPU вполне хватит для любых нагрузок. Впрочем, анонс соускорителей Rubin CPX говорит скорее об обратном. У Groq есть собственный программный стек, но насколько он хорош, сказать трудно. Для перезапуска технологий Groq в качестве продукта NVIDIA потребуется немало работы над ПО, а полноценная интеграция в программную экосистему может оказаться очень сложной. Более реалистичным вариантом может быть использование чиплета Groq вместе с большим чиплетом GPU для обработки определённых нагрузок, но и в этом случае ПО станет камнем преткновения, поскольку аппаратная часть принципиально слабо совместима с CUDA. Возникает вопрос: «Что же есть у Groq, чего нет у NVIDIA?». Одним из ответов может быть детерминизм — концепция, лежащая в основе архитектуры LPU Groq, которую компания пыталась продвинуть в автомобильной промышленности в 2020 году. Детерминизм имеет существенные преимущества для приложений, требующих функциональной безопасности, включая робототехнику — Хуанг в письме, упомянутом выше, говорит о «приложениях реального времени». Но для этого NVIDIA придется изменить свою риторику, признав, что для периферийных вычислений её ускорители подходят не всегда. В любом случае, у NVIDIA имеются огромные ресурсы и команда квалифицированных специалистов. Если бы она захотела создать ИИ-ускоритель, ориентированный на работу со SRAM, а не HBM, это обошлось бы гораздо дешевле уплаченных за Groq $20 млрд. Кроме того, утверждает EE Times, она могла бы за существенно меньшую сумму пробрести d-Matrix или даже SambaNova, которая готова продаться Intel всего за $1,6 млрд. Как полагают аналитики EE Times, помимо лицензирования технологии и найма специалистов Groq, в принятии решения купить стартап также сыграли роль коммерческие факторы. Groq имеет обширные партнёрские отношения с крупными компаниями стран Персидского залива. У стартапа также есть соглашения о суверенном ИИ и в других странах, что могло показаться привлекательным для NVIDIA. Тем не менее, одним из главных аргументов в пользу покупки Groq до сих пор было то, что это вполне жизнеспособная и недорогая альтернатива NVIDIA для построения суверенной ИИ-инфраструктуры. То есть покупку Groq можно также объяснить желанием помешать одному из клиентов-гиперскейлеров купить Groq, будь то из-за аппаратной интеллектуальной собственности или уже развёрнутой инфраструктуры. Это может быть Meta✴, Microsoft или даже OpenAI, чьи планы по созданию собственного ИИ-оборудования всё ещё находятся на стадии подготовки или пока имеют умеренный успех, тогда как Google уже готов отдать «на сторону» свои ускорители TPU, а AWS со своими Trainium всё-таки готова сотрудничать с NVIDIA по аппаратной части. В свою очередь, аналитики ресурса The Register объясняют покупку Groq за столь крупную сумму интересом NVIDIA к «конвейерной архитектуре» (dataflow) стартапа, которая, по сути, создана специально для ускорения вычислений линейной алгебры, выполняемых в ходе инференса. Стоит отметить, что архитектуры с управляемым потоком данных не ограничиваются проектами, ориентированными на SRAM. Например, NextSilicon использует HBM. Groq выбрал SRAM только потому, что это упростило задачу, но нет никаких причин, по которым NVIDIA не могла бы создать dataflow-ускоритель на основе IP-блоков Groq, используя SRAM, HBM или GDDR, пишет The Register. Правильно реализовать такую архитектуру очень сложно, но Groq удалось заставить её работать надлежащим образом, по крайней мере, для инференса, утверждает The Register. Таким образом, Groq даст NVIDIA оптимизированную для инференса вычислительную архитектуру, чего ей так сильно не хватало, полагают аналитики ресурса. Именно этого и не хватает NVIDIA, поскольку у неё фактически нет выделенных чипов для этой задачи. Ситуация изменится с запуском NVIDIA Rubin в 2026 году и их «напарников» Rubin CPX. При этом ускорители Groq LPU в силу малого объёма SRAM для обработки современных LLM необходимо объединять в кластеры из десятков и сотен чипов. Это верно и для других ускорителей примерно того же типа, включая Cerebras. Вместе с тем LPU, по мнению The Register, теоретически могут пригодиться для т.н. спекулятивного декодирования, когда малая модель, не больше нескольких миллиардов параметров, используется для предсказания ответов большой модели. Если малая модель правильно «угадывает» их, общая производительность инференса может вырасти в два-три раза. Стоит ли такая опция $20 млрд, вопрос отдельный, но Хуанг, по-видимому, играет вдолгую. |

|