Материалы по тегу: ии

|

14.01.2026 [01:29], Владимир Мироненко

Безоблачно: США запретили Китаю удалённый доступ к передовым ИИ-ускорителямПалата представителей США приняла подавляющим большинством «Закон о безопасности удалённого доступа» (Remote Access Security Act). Как сообщается на сайте Специального комитета Палаты Представителей США по стратегическому соперничеству между Соединёнными Штатами и Компартией Китая (CCP), этот закон расширяет действие «Закона о реформе экспортного контроля», позволяя федеральным властям «ограничивать возможности иностранных противников получать удалённый доступ к технологиям, включая ИИ-чипы, через облачные вычислительные сервисы». Проще говоря, теперь китайским компаниям запрещён доступ к передовым ускорителям в ЦОД и облаках за пределами КНР. Хотя экспорт ускорителей NVIDIA H200 теперь разрешён, поставка в Китай более мощных чипы на базе архитектуры Blackwell по-прежнему запрещена, как и ускорителей с новой архитектурой Vera Rubin. Новый закон призван перекрыть пробелы в законодательстве США, которыми с успехом пользуются китайские компании, получая доступ к находящимся под санкциями ИИ-ускорителям, покупая или арендуя их для использования на территории США. О таких обходных путях стало известно в 2024 году, когда выяснилось, что ByteDance, китайский владелец TikTok, арендовал передовые чипы NVIDIA у Oracle, пишет Data Center Dynamics. Как передаёт The Register, китайские компании обходят экспортные ограничения на высокопроизводительные ускорители NVIDIA и другие чипы, получая к ним доступ через такие платформы, как AWS и Azure, по крайней мере, с 2023 года. The Register также ранее сообщал, что китайские облачные провайдеры, такие как Alibaba и Tencent, могут предоставлять доступ к находящимся под экспортными ограничениями GPU клиентам в Китае, арендуя облачное оборудование, размещённое за пределами страны. В свою очередь, Microsoft и AWS предлагают в Китае через местных партнёров облачные услуги, в целом аналогичные тем, что доступны в других странах. «Амбиции КПК в области ИИ подпитываются доступом к американским чипам, размещённым в ЦОД за пределами Китая, — заявил председатель Специального комитета по Китаю, один из соавторов законопроекта. — Этот законопроект переводит наши законы в цифровую эпоху и ясно даёт понять, что облачные вычисления подпадают под действие американского законодательства об экспортном контроле, так же как и физические чипы. Устранение этих лазеек укрепит национальную безопасность США и защитит американские инновации». Новый закон теоретически может целиком перекрыть бизнес некоторых азиатских компаний. После появления сообщения о том, что NVIDIA потребует от китайских клиентов, приобретающих ускорители H200, полной предоплаты, чипмейкер выступил с опровержением, заявив агентству Reuters, которое первым сообщило об этом что «никогда не будет требовать от клиентов оплаты за продукцию, которую они не получают». В начале декабря администрация Трампа разрешила NVIDIA продавать H200 «одобренным клиентам» в Китае и других странах при условии выплаты 25-% пошлины. В свою очередь, китайское правительство попросило технологические компании страны приостановить оформление заказов на ускорители, пока регулирующие органы не определятся с соотношением приобретаемых чипов H200 и отечественных чипов «в нагрузку» к ним.

13.01.2026 [15:37], Руслан Авдеев

Стартап DayOne Data Centers привлёк более $2 млрд в раунде финансирования серии CОснованная в 2022 году компания DayOne Data Centers (ранее GDS International) сингапурского происхождения привлекла более $2 млрд в ходе раунда финансирования серии C для своих проектов дата-центров, сообщает Silicon Angle. Раунд возглавила компания Coatue, приняли участие и некоторые другие институциональные инвесторы, включая индонезийский фонд национального благосостояния. Ранее сообщалось, что DayOne получила $3,5 млрд на развитие ЦОД в малазийском Джохоре. Флагманский проект компании в финском городе Лахти (Lahti) площадью около 10 га обойдётся в €1,2 млрд, ввод в эксплуатацию запланирован на начало 2027 года. При полной загрузке речь будет идти о 120 МВт вычислительной инфраструктуры. Дата-центр будет по возможности использовать фрикулинг для экономии электроэнергии и воды. Объект оптимизирован для стоек с СЖО, оснащённых чипами NVIDIA. В Сингапуре компания строит 20-МВт объект, оснащённый твёрдооксидными топливными элементами, работающими на водороде.

Источник изображения: DayOne DayOne применяет предварительно собранные на заводе модульные конструкции. Компания заявляет, что такой подход ускоряет процесс строительства и снижает его стоимость. Возможностей компании хватит для выпуска до 2,5 тыс. модулей в год общей IT-мощностью 500 МВт. В своих ЦОД компания использует стек кастомного ПО для управления стойками с ИИ-ускорителями. Привлечённые средства используют для финансирования строительных проектов в Финляндии, Сингапуре, Японии и на некоторых других рынках. Компания сообщила, что уже зарезервировала мощности под клиентские заявки приблизительно на 1 ГВт. DayOne — как минимум третий оператор ЦОД, закрывший крупный раунд финансирования в последние месяцы. ИИ-облако Lambda привлекло более $1,5 млрд в ноябре 2025 года (перед выходом на IPO она хочет привлечь ещё $350 млн). Nscale к началу октабря также получила более $1,5 млрд в двух раундах инвестиций.

13.01.2026 [14:29], Руслан Авдеев

Поставки меди достигнут максимума на пике спроса — но их может не хватить из-за бума ИИЭксперты IT-отрасли обеспокоены ситуацией с поставками меди. Согласно результатам недавнего исследования, спрос, вероятно, превысит предложение в течении десятилетия. Это угрожает ограничить мировое технологическое развитие, сообщает The Register. Электрификация промышленности, транспорта и подогреваемый ИИ бум в сфере IT-инфраструктуры сказывается на спросе на медь, используемой буквально повсеместно, от питающих кабелей до интерконнектов и плат. Исследование S&P Global позволяет предположить, что мировое производство этого металла достигнет пика в 2030 году, составив 33 млн т, в то время как спрос продолжит расти и к 2040 году достигнет 42 млн т — это на 50 % больше, чем сегодня. В результате возникнет дефицит в объёме порядка 10 млн т без дальнейшего существенного увеличения добычи, что может привести к стремительному росту цен на медь, из-за которого производство электротоваров и IT-оборудования значительно подорожает. Цена металла по данным некоторых источников уже достигла рекорда в конце 2025 года. Хотя S&P назвала доклад «Медь в эпоху ИИ» (Copper in the Age of AI), бум ИИ ЦОД не является определяющим фактором при расчётах. На первый план выходит «домашняя» электрификация по всему миру, включая развивающиеся страны. Важное влияние оказывает и развитие рынка электромобилей, солнечной и ветряной генерации, а также расширение ЛЭП. И хотя мировой спрос на медь растёт, поставки в настоящее время падают, поскольку имеющиеся ресурсы истощаются.

Источник изображения: AnimGraph Lab/unsplash.com Первичные поставки металла горнодобывающим сектором переживают не лучшие времена, поскольку отрасль столкнулась с недостатком руд с высоким содержанием меди, ростом затрат и усложнением самой добычи. При этом ввод в эксплуатацию новых месторождений в среднем требует 17 лет. По данным доклада PricewaterhouseCoopers (PwC), добыче меди мешает и изменение климата — отрасль требует стабильных источников воды, хотя месторождения нередко находятся в засушливых регионах. Поставки за счёт переработки вторичного сырья, по данным S&P, не могут в полной мере компенсировать дефицит. Переход телеком-компаний на оптоволоконные кабели может высвободить до 800 тыс. т меди из кабелей, но аналитики уверены, что на переработанную медь к 2040 году придётся лишь треть от всех поставок металла. Его будет недоставать даже с учётом «агрессивного» совершенствования технологий сбора. Чтобы удовлетворить спрос, потребуются немалые усилия и инновации. S&P Global призывает сократить время выдачи разрешений, чтобы уменьшить сроки разработки месторождений, обеспечить стабильные условия инвестиций, внедрение новых технологий и расширение перерабатывающих мощностей вне уже существующих центров. На долю Китай приходится 40–50 % мировых мощностей по выплавке и переработке меди, поэтому цепочке поставок могут угрожать геополитические потрясения, особенно на фоне опасений, связанных с доминированием Китая в сфере редкоземельных металлов и не самых передовых, но весьма востребованных полупроводников.

Источник изображения: omid roshan/unsplash.com Так или иначе, первичное производство остаётся единственным настоящим решением для компенсации дефицита, но наращивание добычи и выплавки потребует значительных усилий и инвестиций. Как заявляют в S&P, будущие поставки меди зависят не только от геологов, инженеров, логистики и инвестиций, но и менеджмента и политиков. Отмечается, что выплавка и переработка является критически важным этапом в цепочке поставок, особенно если добывающие мощности сконцентрированы в ограниченном числе стран. В докладе подчёркивается, что для создания более надёжной системы поставок меди необходимо многостороннее сотрудничество и большая региональная диверсификация. При этом в сложившихся геополитических условиях само многостороннее сотрудничество надладить не всегда просто. Ещё в 2024 году сообщалось, что развитие генеративного ИИ всё больше зависит от доступности качественных данных, пресной воды, электроэнергии и чистой меди. В августе 2025 года эксперты BloombergNEF (BNEF) пришли к выводу, что рост дата-центров усугубит нехватку и без того дефицитного металла.

13.01.2026 [14:14], Руслан Авдеев

Meta✴ создаёт подразделение Meta✴ Compute для строительства ИИ ЦОД на десятки гигаваттКомпания Meta✴ Platforms запускает новое подразделение Meta✴ Compute, задачей которого станет надзор за проектами строительства ИИ ЦОД, активно реализуемыми IT-гигантом в последнее время. Meta✴ имеет масштабные планы расширения инфраструктуры, сообщает Silicon Angle. Курировать соответствующие проекты будет глава глобальных инфраструктурных проектов компании Сантош Джанардхан (Santosh Janardhan) совместно с одним из основателем Safe Superintelligence Дэниелем Гроссом (Daniel Gross). По словам главы Meta✴ Марка Цукерберга (Mark Zuckerberg), компания намерена ввести в эксплуатацию новую инфраструктуру ЦОД, потребляющую десятки гигаватт ещё в этом десятилетии и сотни гигаватт — в долгосрочной перспективе. Главной целью Meta✴ Compute является систематическое расширение ИИ-инфраструктуры в масштабе, выходящем далеко за пределы традиционного масштабирования ЦОД. Хотя Meta✴ уже управляет глобальной сетью гигантских дата-центров, речь идёт о беспрецедентных нововведениях.

Источник изображения: Adeolu Eletu/unspalsh.com ИИ-модели потребуют десятки гигаватт вычислительных мощностей, поэтому компания нуждается в покупке всё больших объёмов передового оборудования и строительства сотен зданий для его размещения. Создавая специальную организацию для решения соответствующих задач, компания рассчитывает заранее обеспечить доступ к земле, оборудованию и энергии, а не пытаться решать проблемы «на лету». Джанардхан сконцентрируется на технических аспектах строек Meta✴, включая стратегию развития, архитектуру систем компании, создание собственных чипов, ПО и инструментов разработки. Он же будет отвечать за повседневную работу ЦОД. Гросс возглавит новую группу, отвечающую за долгосрочное планирование создания новых мощностей и выстраивание цепочек поставок для обеспечения компании чипами, серверами и сетевым оборудованием для оснащения новых дата-центров. В частности, в сферу его ответственности входит упреждающее определение будущих вычислительных потребностей Meta✴, управление стратегическими отношениями с поставщиками, разработка и планирование новых бизнес-моделей, поддержка экспансии компании на многогигаваттном уровне и др. По словам Цукерберга, новая инициатива также позволит централизовать управление технологическим стеком компании — от программного обеспечения и архитектуры систем до чипов, сетей и ЦОД, что обеспечит максимально эффективное принятие любых инвестиционных решений. Кроме того, Meta✴ сможет отделить тактические задачи от долгосрочного стратегического планирования мощностей и создания цепочек поставок. Джанардхан и Гросс будут совместно работать с Диной Пауэлл МакКормик (Dina Powell McCormick) — новым президентом и вице-председателем компании. Одна из её задач — обеспечить соответствие многомиллиардных инвестиций в инфраструктуру стратегическим целям и добиться ощутимых экономических выгод в регионах присутствия. Также новый топ-менеджер отвечает за укрепление новых стратегических капитальных альянсов для усиления долгосрочной инвестиционной способности Meta✴. Создание Meta✴ Compute также может улучшить контроль отчётности в связи с её масштабными строительными проектами. В финансовом 2025 году капитальные расходы компании составили $72 млрд, большая часть средств ушла на ИИ ЦОД. Эти инвестиции ещё должны окупиться, поскольку самая передовая ИИ-модель компании — Llama 4 получила весьма сдержанные отклики. Хотя Meta✴ во многом сделала себе имя на рынке ИИ благодаря open source моделям, Llama 4 считается многими экспертами менее «сообразительной», чем ведущие базовые модели компаний уровня Google и OpenAI.

12.01.2026 [14:41], Сергей Карасёв

ASRock Rack показала ИИ-сервер на базе NVIDIA HGX B300 с СЖО ZutaCore HyperCoolКомпания ASRock Rack на выставке CES 2026 продемонстрировала ИИ-сервер 4U16X-GNR2/ZC, первая информация о котором была раскрыта в октябре прошлого года. Новинка создана в партнёрстве с разработчиком систем жидкостного охлаждения ZutaCore. Устройство выполнено в форм-факторе 4U. Возможна установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP). Доступны 32 слота для модулей оперативной памяти DDR5, три разъёма PCIe 5.0 x16 для карт FHHL и два сетевых порта 1GbE на базе контроллера Intel I350-AM2. Задействована аппаратная платформа NVIDIA HGX B300. Для отвода тепла используется система прямого жидкостного охлаждения ZutaCore HyperCool. Это двухфазное решение основано на применении специальной диэлектрической жидкости, которая не вызывает коррозии. Утверждается, что конструкция HyperCool безопасна для IT-оборудования и гарантирует сохранение работоспособности даже в случае утечки. СЖО поставляется в полностью собранном виде, что сокращает время монтажа в стойку. Сервер 4U16X-GNR2/ZC оборудован 12 фронтальными отсеками для SFF-накопителей с интерфейсом PCIe 5.0 x4 (NVMe); допускается горячая замена. Кроме того, есть внутренний разъём для одного SSD типоразмера М.2 (PCIe 5.0 x2). За питание отвечают десять блоков мощностью 3000 Вт с сертификатом 80 Plus Titanium. Габариты машины составляют 900 × 448 × 175 мм. Отмечается, что в стандартной стойке 42U могут быть размещены до восьми подобных серверов, что обеспечивает высокую плотность вычислительной мощности для наиболее ресурсоёмких нагрузок ИИ.

12.01.2026 [13:53], Руслан Авдеев

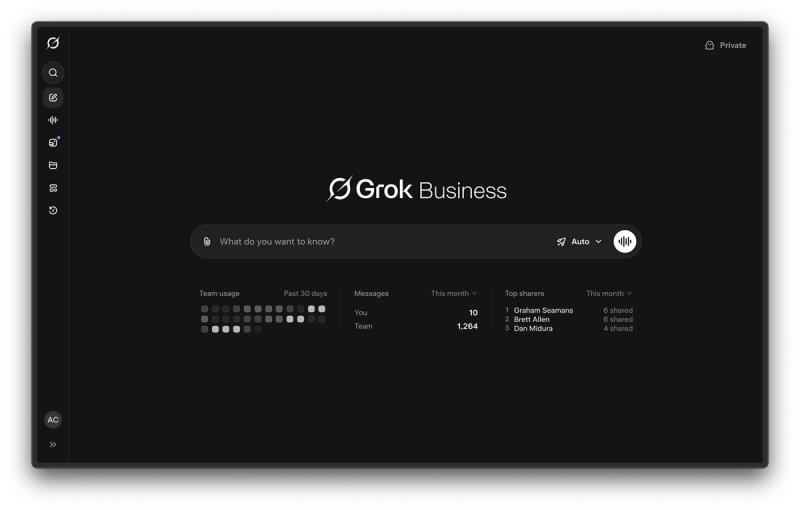

xAI представила тарифы Grok Business и Grok Enterprise для бизнес-пользователейКомпания xAI официально начала освоение рынка ИИ-сервисов для бизнес-пользователей. В самом конце декабря она представила два новых тарифа: Grok Business и Grok Enterprise. Предполагается, что они должны способствовать внедрению ИИ-моделей в компаниях для решения повседневных задач, причём со встроенными возможностями контроля настроек безопасности, конфиденциальности и др., сообщает Channel insider. Таким образом xAI выходит на высококонкурентный рынок корпоративных ИИ-инструментов. Аналогичные предложения уже имеются у OpenAI, Anthropic, Google и др. Для xAI это также означает переход от сервисов для индивидуальных экспериментов к предоставлению возможностей для выполнения совместных задач. Grok Business рассчитан на команды небольших и средних размеров и стоит $30/мес. за каждого пользователя. Предлагаются встроенные инструменты управления командами и организации общения, централизация платежей и контроль использования ПО. Другими словами, команды могут совместно работать в среде Grok, делиться результатами, а также подключать популярные инструменты вроде Google Drive, чтобы ИИ мог работать с информацией, которая уже использовалась. Grok Enterprise имееть расширенную функциональность для более крупных организаций. Цена не разглашается, но основной акцент будет сделан на ужесточении контроля и надзора. В частности, речь идёт о поддержке единой авторизации в масштабах всей компании, автоматизированном управлении профилями пользователей и функциями безопасности, разработанными для более крупных и сложных программных сред. В xAI утверждают, что оба плана построены с учётом необходимости обеспечивать корпоративную безопасность и конфиденциальность. Как подчёркивают в компании, корпоративная защита и конфиденциальность встроены в системы с самого начала — Grok не будет обучаться на предоставляемых клиентками данных.

Источник изображения: xAI Одна из наиболее примечательных функций — способность Grok работать с большими массивами документов. Grok обеспечивает агентный поиск с помощью Collections API. Это позволяет ИИ-модели использовать крупные хранилища документов в качестве первоочередных источников информации. Это может быть полезным, если необходим, например, анализ юридических документов или построение финансовых моделей. В ответы могут включаться цитаты, напрямую ведущие к исходным документам, с возможностью предварительного просмотра и выделения контекста. Для организаций со специальными требованиями к обеспечению безопасности материалов xAI предлагает вариант Enterprise Vault. Это даёт компаниям больше контроля над тем, как обрабатываются их данные, с предоставлением сопутствующей инфраструктуры, дополнительных уровней шифрования, которыми управляет сам пользователь, а не xAI. xAI утверждает, что данные зашифрованы как при передаче, так и при хранении. Тариф Enterprise также обеспечивает соответствие строгим требованиям: обеспечено соответствие инфраструктуры и процессов стандарту безопасности SOC 2 и нормативным актам (включая GDPR и CCPA). Также в его рамках предоставляется доступ к наиболее передовыми ИИ-моделям компании Grok 3, Grok 4 и Grok 4 Heavy. В то же время xAI продолжает наращивать инфраструктуру, необходимую для поддержки соответствующих проектов. Так, речь идёт о строительстве третьего дата-центра в штате Миссисипи (США). На днях появилась информация, что она привлекла $20 млрд на развитие бизнеса.

12.01.2026 [12:59], Сергей Карасёв

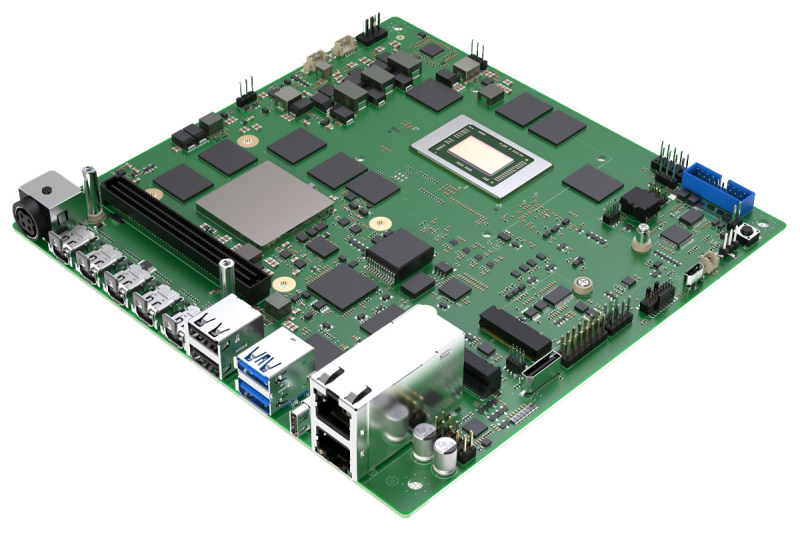

Sapphire представила Mini-ITX-плату EDGE+VPR-7P132 с чипом AMD Ryzen AI Embedded P132 и FPGA Versal AI Edge Gen2 VE3558Компания Sapphire Technology анонсировала плату EDGE+VPR-7P132 на платформе AMD Embedded+, предназначенную для построения различных периферийных устройств с ИИ-функциями. В новинке соседствуют процессор AMD Ryzen AI Embedded и адаптивная «система на чипе» AMD Versal AI Edge Gen 2. Решение выполнено в форм-факторе Mini-ITX с размерами 170 × 170 мм. Задействовано FPGA-решение Versal AI Edge Gen 2 VE3558 с восемью ядрами Arm Cortex-A78AE, десятью ядрами реального времени Arm Cortex-R52, графическим блоком Arm Mali-G78AE. Программируемая часть содержит 492 тыс. логических ячеек и 225 тыс. LUT. Чип обеспечивает ИИ-производительность до 123 TOPS на операциях INT8. Есть 16 Гбайт памяти LPDDR5-4266, флеш-модуль UFS 3.1 вместимостью 256 Гбайт, интерфейс Mini DisplayPort, а также модуль TPM 2.0 (Infineon OPTIGA TPM SLM 9672) и 250-контактный коннектор для плат расширения. CPU-секция получила процессор Ryzen AI Embedded P132 (V4526iX), который объединяет шесть ядер с архитектурой Zen 5 (12 потоков) с тактовой частотой до 4,5 ГГц, графический ускоритель AMD Radeon (RDNA 3.5) и нейропроцессорный блок с ИИ-производительностью до 50 TOPS в режиме INT8. Чип функционирует в тандеме с 64 Гбайт памяти LPDDR5-4266 (впаяна на плату). Предусмотрены коннектор M.2 Key M 2280 для SSD (PCIe 4.0 x4), слот M.2 Key E 2230 (PCIe 4.0 x1, I2S, USB 2.0) для адаптера Wi-Fi/Bluetooth и разъём OCulink x4. Плата получила два сетевых порта 10GbE, по два порта USB 3.2 Gen 2 Type-A и USB 2.0 Type-A, коннектор USB4 Type-C, четыре интерфейса Mini DisplayPort. Через внутренние разъёмы можно использовать аудиоинтерфейсы. Питание (12 В) подаётся через DC-коннектор. Диапазон рабочих температур простирается от 0 до +60 °C. Заявлена совместимость с RHEL/CentOS 7.9, RHEL 8.2-8.6 и Ubuntu 22.04. В качестве платы расширения упомянут модуль с поддержкой 12 камер для автомобильных систем и робототехники.

12.01.2026 [09:54], Владимир Мироненко

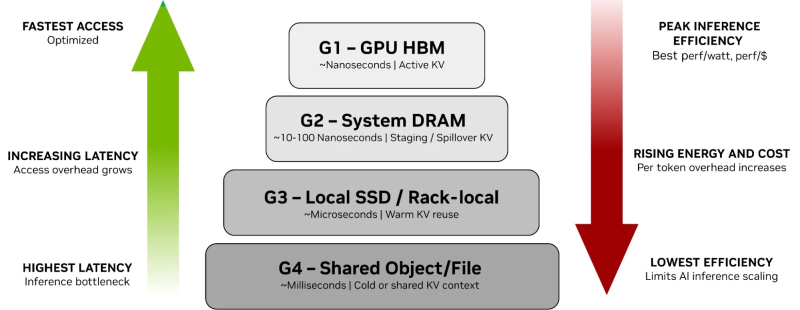

От NVMe к GPU: NVIDIA представила платформу хранения контекста инференса ICMSPВместе с официальным анонсом ИИ-платформы следующего поколения Rubin компания NVIDIA также представила платформу хранения контекста инференса NVIDIA Inference Context Memory Storage Platform (ICMSP), позволяющую решить проблемы хранения KV-кеша, который становится всё крупнее по мере роста LLM и решаемых задач. При выполнении инференса контекст растёт по мере генерации новых токенов, часто превышая доступную память ускорителя. В этом случае старые записи вытесняются из памяти, сначала в системную память, а потом на диск, чтобы не пересчитывать всё заново, когда они снова понадобятся. Проблемы существенно усугубляются при работе с агентным ИИ и обработке рабочих нагрузок с большим контекстом. Агентный ИИ приводит к появлению контекстных окон в миллионы токенов, а объём моделей может составлять уже триллионы параметров. В настоящее время эти системы полагаются на долговременную память для хранения контекста, позволяя агентам опираться на предыдущие рассуждения и расширять их на протяжении многих шагов, а не начинать с нуля при каждом запросе. По мере увеличения контекстных окон растут требования к ёмкости KV-кеша, делая эффективное хранение и повторное использование данных, в том числе совместное использование различными сервисами инференса, крайне важными для повышения производительности системы. Контекст инференса является производным и пересчитываемым, что требует архитектуры хранения, которая отдаёт приоритет энергоэффективности и экономичности, а также скорости и масштабируемости, а не традиционной надёжности хранения данных. NVIDIA отметила, что ИИ-фабрикам необходим дополнительный, специально разработанный уровень контекста, который рассматривает KV-кеш как собственный класс данных, предназначенный для ИИ, а не принудительно помещает его в дефицитную память HBM или в хранилище общего назначения. Платформа ICMSP использует DPU BlueField-4 для создания специализированного уровня памяти, чтобы преодолеть разрыв между высокоскоростной памятью GPU и масштабируемым общим хранилищем. Хранилище KV-кеша на основе NVMe должно эффективно обслуживать ускорители, узлы, стойки и кластеры целиком, говорит компания. Платформа ICMSP создаёт новый уровень (G3.5 на схеме выше) — флеш-память, подключённая через Ethernet и оптимизированная специально для KV-кеша. Этот уровень выступает в качестве долговременной агентной памяти на уровне ИИ-инфраструктуры, достаточно большой для одновременного хранения общего, развивающегося контекста многих агентов, но при этом достаточно близко расположенной для частой работы с памятью ускорителей и хостов. BlueField-4 отвечает за аппаратное ускорение размещения кеша и устранение накладных расходов на подготовку и перемещение данных и обеспечение безопасного, изолированного доступа к ним узлов с GPU, снижая зависимость от CPU хоста и минимизируя сериализацию и работу с системной памятью хоста. Программные продукты, такие как фреймворк DOCA, механизм разгрузки KV-кеша Dynamo и входящее в комплект ПО NIXL (Nvidia Inference Transfer Library), обеспечивают интеллектуальное, ускоренное совместное использование данных KV-кеша между ИИ-узлами. А Spectrum-X Ethernet обеспечивает оптимизированный RDMA-интерконнект, который связывает ICMS и узлы GPU. KV-кеш принципиально отличается от корпоративных данных: он является временным, производным и может быть пересчитан в случае потери. В качестве контекста инференса он не требует надёжности, избыточности или обширных механизмов защиты данных, разработанных для долговременных записей. Выделяя KV-кеш как отдельный, изначально предназначенный для ИИ класс данных, ICMS устраняет избыточные накладные расходы, обеспечивая повышение энергоэффективности до пяти раз по сравнению с универсальными подходами к хранению данных, сообщила NVIDIA. А своевременная подготовка и отдача данных более полно нагружает ускорители, что позволяет увеличить темп генерации токенов до пяти раз. Как сообщила NVIDIA, первоначальный список её партнёров, готовых обеспечить поддержку ICMSP с BlueField-4, который будет доступен во II половине 2026 года, включает AIC, Cloudian, DDN, Dell, HPE, Hitachi Vantara, IBM, Nutanix, Pure Storage, Supermicro, VAST Data и WEKA.

11.01.2026 [15:06], Руслан Авдеев

ИИ-облако Lambda пытается привлечь $350 млн перед выходом на IPOСтартап Lambda Inc., предлагающий облачную ИИ-платформу, как сообщается, намерен привлечь $350 млн на развитие бизнеса и ведёт переговоры с Mubadala Capital, которая должна возглавить новый раунд инвестиций. При этом менее двух месяцев назад прошёл раунд финансирования серии E, возглавленный TWG Global, в ходе которого удалось привлечь $1,5 млрд, сообщает Silicon Angle со ссылкой на The Information. Lambda выступает оператором дюжины дата-центров в США. Флагманским предложением является сервис Superclusters, который позволяет арендовать кластеры, имеющие до 165 тыс. ИИ-ускорителей NVIDIA. Lambda предлагает несколько поколений чипов NVIDIA, в том числе суперускорители GB300 NVL72. В скором времени обещана и доступность новейших Vera Rubin NVL72. Системы Lambda работают на кастомном пакете ПО Lambda Stack, состоящем из открытых ИИ-инструментов, которые компания оптимизировала для своего оборудования. Новый раунд финансирования, возможно, будет последним перед выходом компании на IPO во II полугодии 2026 года. В ноябре Lambda заключила многомиллиардный контракт с Microsoft. Согласно его условиям, Lambda предоставит гиганту из Редмонда доступ к десяткам тысяч ИИ-ускорителей. Также подписано соглашение на $1,5 млрд с NVIDIA, которая будет арендовать у Lambda свои же чипы.

11.01.2026 [14:48], Руслан Авдеев

OpenAI инвестирует $500 млн в энергетическое подразделение SoftBank — SB EnergyOpenAI Group инвестирует $500 млн в SB Energy — это дочерняя структура SoftBank Group, занимающаяся возобновляемыми источниками энергии и дата-центрами, сообщает Silicon Angle. Сделка предусматривает и дополнительные условия. Так, $500 млн инвестиций со стороны OpenAI удвоятся благодаря вкладу SoftBank, в результате в ходе раунда финансирования будет привлечён $1 млрд. Дополнительно SB Energy станет применять в своей внутренней деятельности сервисы OpenAI и поддержит инициативу Stargate. Партнёрство частично обусловлено тем, что SoftBank — уже крупнейший инвестор разработчика ChatGPT. В марте японская компания согласилась возглавить раунд финансирования OpenAI на $40 млрд, а в конце декабря она инвестировала не менее $22,5 млрд в своего партнёра. SB Energy основана SoftBank в 2011 году для строительства инфраструктуры возобновляемой энергии. Сейчас компания строит два энергохранилища в Калифорнии с совокупной мощностью порядка 1,36 ГВт. По данным SB Energy, на территории одного из кампусов также будет расположен парк солнечных элементов с пиковой мощностью 570 МВт. Активную деятельность SoftBank ведёт и в Техасе. В конце 2024 года она ввела в эксплуатацию солнечную электростанцию Orion Solar Belt на 900 МВт близ Остина. Она поддерживает один из кампусов Google. При этом SB Energy не только строит энергетические объекты, но и технологическую инфраструктуру. В частности, OpenAI объявила, что подразделению SoftBank доверят строительство инфраструктуры Stargate на 1,2 ГВт в округе Майлам (Milam) в Техасе, где расположена солнечная электростанция Orion Solar Belt. На сайте SB Energy также сообщается, что компания строит в Техасе второй кампус ЦОД, но не уточняется, будет ли он использоваться OpenAI. По имеющимся данным, речь идёт об объекте мощностью более 1 ГВт. OpenAI будет работать с SB Energy и SoftBank для разработки нового подхода к строительству дата-центров. Разработчик ChatGPT объявил, что методология объединяет оригинальный проект ЦОД от OpenAI с проверенными компетенциями SB Energy в скорости, «дисциплине затрат» и интегрированной энергетике. Речь идёт о неэксклюзивном приоритетном партнёрстве. Помимо участия в проектах Stargate, SB Energy обеспечит использование ChatGPT своими сотрудниками и начнёт использовать API OpenAI. Кроме того, SB Energy привлекает $800 млн инвестиционной компании Ares Management для масштабирования бизнеса. Сделка с OpenAI, касающаяся SB Energy — уже второй случай инвестиций в дочернюю структуру компании, которая сама инвестировала в OpenAI. В декабре OpenAI приобрела долю в фонде Thrive Holdings. Это дочерняя структура Thrive Capital, уже инвестировавшая в OpenAI в 2025 году более $1 млрд. |

|