Лента новостей

|

05.03.2025 [11:14], Сергей Карасёв

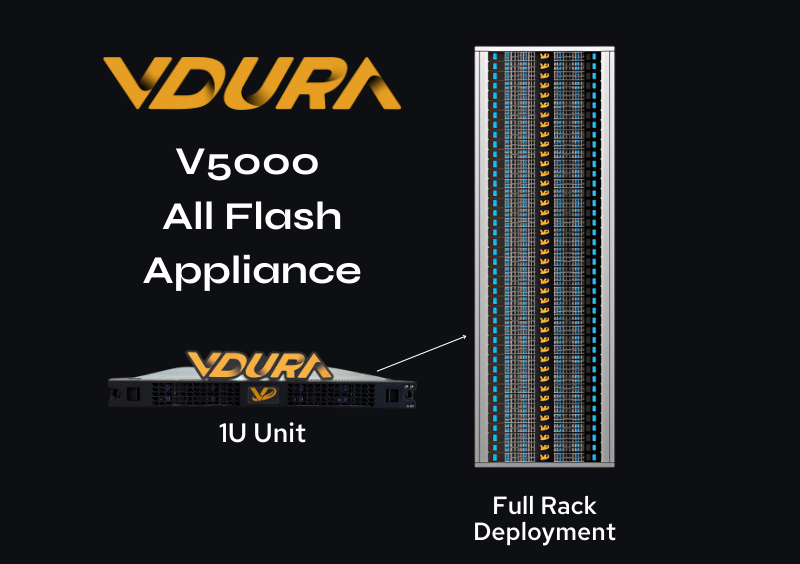

1,5 Пбайт в 1U: СХД Vdura V5000 получила All-Flash узлы F Node со 128-Тбайт NVMe QLC SSDКомпания Vdura анонсировала узел хранения данных V5000 All-Flash Appliance (F Node) типоразмера 1U, предназначенный для использования в составе платформы V5000. Изделие ориентировано на решение ресурсоёмких задач, связанных с ИИ, включая развёртывание генеративных моделей. Платформа V5000, анонсированная около трёх месяцев назад, объединяет управляющие узлы Director Node формата 1U и гибридные узлы хранения на основе SSD и HDD. Применяется фирменная программная платформа Vdura Data Platform (VDP) v11 с параллельной файловой системой PFS. Новые узлы F Node допускают установку 12 накопителей NVMe QLC вместимостью до 128 Тбайт каждый. Таким образом, суммарная «сырая» ёмкость узла достигает 1,536 Пбайт. В основу F Node положен процессор AMD EPYC 9005 Turin, функционирующий в тандеме с 384 Гбайт RAM. Задействован 400G-адаптер NVIDIA ConnectX-7 SmartNIC, обеспечивающий низкую задержку при передаче данных. Упомянуты три слота PCIe и один слот OCP 5.0. Минимальная конфигурация системы V5000 на базе All-Flash включает по три узла Director Node и F Node, которые могут масштабироваться независимо друг от друга для достижения необходимой производительности и/или вместимости. Одна стойка 42U может содержать три узла Director Node и до 39 узлов F Node, что обеспечит 59,9 Пбайт «сырой» ёмкости.

Источник изображения: Vdura В целом, как утверждается, возможно наращивание ресурсов до тысяч узлов F Node. Компания Vdura предлагает унифицированную высокопроизводительную инфраструктуру, которая способна поддерживать каждый этап жизненного цикла ИИ — от обучения модели до долгосрочного хранения данных.

05.03.2025 [10:27], Сергей Карасёв

«Гравитон» представил сетевые платформы для обеспечения кибербезопасности

apollo lake

comet lake

elkhart lake

intel

intel atom

гравитон

информационная безопасность

россия

сделано в россии

сети

Российский производитель вычислительной техники «Гравитон» анонсировал сетевые платформы для создания доверенных программно-аппаратных комплексов (ПАК) в области кибербезопасности. Изделия подходят для развёртывания межсетевых экранов, VPN-шлюзов, систем SD-WAN, балансировщиков трафика, систем фильтрации контента и обнаружения сетевых атак и пр. В семейство вошли модели С100, С200/C210 и С300: все они выполнены на процессорах Intel. Утверждается, что архитектура устройств в части интерфейсов соответствует запросам и особенностям российского рынка средств защиты информации. Решения разработаны с учётом требований постановления Правительства РФ от 14.11.2023 №1912, то есть относятся к классу доверенных ПАК. Вариант С100 в настольном форм-факторе оборудован чипом Celeron N3350 (Apollo Lake) и до 8 Гбайт DDR3L-1866 (1 × SO-DIMM; non-ECC). Есть слот M.2 Key B 2242 для SSD с интерфейсом SATA-3 (до 1 Тбайт), а также разъём Full-size PCI Express Mini Card (PCIe/USB; плюс слот для SIM-карты), что позволяет добавить адаптер Wi-Fi или модем 4G. Доступны три сетевых порта 1GbE RJ-45 (Intel I210), два порта USB 3.0 и интерфейс HDMI. Габариты составляют 146 × 118,2 × 26 мм, масса — 284 г. Модели С200 и C210 средней производительности предназначены для малых офисов и филиалов предприятий. Они несут на борту процессор Atom x6425E (Elkhart Lake) и до 32 Гбайт DDR4-3200 (2 × SO-DIMM; non-ECC). Есть слот M.2 Key M 2242 для SATA SSD и посадочное место для SFF-накопителя с интерфейсом SATA-3. Кроме того, предусмотрены разъёмы Half-size Mini PCIe (PCIe + USB 2.0), Full-size Mini PCIe (USB 2.0), M.2 Key B 3052/3042 (USB 2.0 + USB 3.0), M.2 Key E 2230 (USB 2.0/PCIe) и два слота для карт Nano-SIM. Сетевые порты могут быть выполнены по схеме 4 × 1GbE RJ-45 или 2 × 1GbE RJ-45 + 2 × 1GbE SFP (Intel I350). Плюс к этому имеются три порта 2.5GbE RJ-45 (MaxLinear GPY211), два порта USB 3.0 и интерфейс HDMI. Устройство имеет размеры 257 × 197 × 44 мм и весит 1,6 кг. Версия С200 предназначена для настольного размещения, а модификация С210 выполнена в корпусе для монтажа в серверную стойку. Наконец, высокопроизводительная платформа С300 для установки в стойку может комплектоваться чипом Xeon W-1200 или Core i9/i7/i5/i3 десятого поколения (Comet Lake). Поддерживается до 128 Гбайт DDR4-2933 ECC/non-ECC UDIMM в виде четырёх модулей. Реализованы слоты PCIe x8 (опционально через райзер), M.2 Key E 2230 (PCIe x1), M.2 Key M 2242/2280 (PCIe x4; опционально через райзер), Full-Size Mini PCIe (PCIeX1/SATA, USB2.0) и Nano-SIM. Доступны восемь портов 1GbE RJ-45 и два порта SFP (Intel I350) с возможностью расширения до 24 сетевых портов, интерфейсы USB 3.0 (×2) и HDMI. Кроме того, упомянуты два посадочных места для SFF-накопителей SATA-3. Габариты составляют 430 × 450 × 44 мм, масса — 7,3 кг. Все новинки могут эксплуатироваться при температурах от 0 до +40 °C. Предоставляется трёхлетняя гарантия. Внесение устройств в реестр Минпромторга России и начало серийного производства запланированы на II квартал 2025 года.

05.03.2025 [09:16], Руслан Авдеев

Новые правила NRO защитят региональных интернет-регистраторов от самих себя и коллегВотчины пяти Региональных интернет-регистраторов (RIR) ожидают изменения локального и глобального уровней. Сейчас организации работают над общей политикой, которая позволит им остановить неправомерные действия одного из них — хотя сам процесс пока вызывает немало вопросов, сообщает The Register. В 2023 году организация Number Resource Organization (NRO), головной орган всех RIR, сообщила о намерении пересмотреть документ ICP-2, с 2001 года определяющий критерии формирования новых RIR. Именно на основе этого документа были сформированы RIR для Африки, Латинской Америки и Карибского бассейна, они были созданы именно на основе принятой политики. С 2005 года новых RIR не открывалось. Теперь NRO намерена пересмотреть данный документ, поскольку тот регламентирует только создание RIR, но ничего не говорит о том, что делать, если будут отмечены злоупотребления и нарушения, наносящие ущерб глобальной системе IP-адресации. В 2024 году организация предложила принципы, которым должен соответствовать регистратор — от наличия сильного управления до, например, финансовой стабильности. Впервые в документе регламентируется весь жизненный цикл RIR, от формирования до мониторинга и отмены его полномочий. Однако с новой версией документа согласны не все, так что пока ведётся его доработка, а финальный вариант должен быть готов к концу 2025 года.

Источник изображения: NRO Одной из причин, по которой NRO решило пересмотреть ICP-2, является ситуация с африканским регистратором AFRINIC (African Network Information Centre). Представителей организации обвиняли в уголовных преступлениях, а также в коррупции. С 2023 года организация стала объектом многих судебных разбирательств и не смогла назначить генерального директора и сформировать совет директоров. Впрочем, пока она продолжает выполнять свои функции, но наличие готового регламента позволило бы провести реформы. В 2024 году азиатско-тихоокеанский регистратор APNIC (Asia Pacific Network Information Center) сменил генерального директора, который тут же уволил четырёх других директоров ради экономии и упрощения структуры организации. Нынешнее правление APNIC изучает возможность продления срока своих полномочий, но с введением верхнего лимита. Кроме того, по итогам проверки APNIC были отменены делегирования 44 субъектам в Индии. Аналогичная проверка начата и в Индонезии, где под подозрение попали 1200 делегирований. Латиноамериканский регистратор (Latin American and Caribbean Internet Addresses Registry, LACNIC) также сменил генерального директора. При этом почти сразу после назначения LACNIC выявил 120 несанкционированных входов на свой портал. Позже массивы информации об учётных записях обнаружили выставленными на продажу в даркнете. С тех пор политику входа на портал ужесточили, включая обязательное использование многофакторной аутентификации (MFA). Некоторые изменения происходят и в RIPE NCC — этот RIR отвечает за Европу, Ближний Восток и часть Центральной Азии. В частности, ведутся разговоры об открытии нового офиса в Дубае. RIPE NCC также приходится довольно сложно, поскольку в его зону ответственности входят Россия, Беларусь и Иран, находящиеся под санкциями отдельных государств, что необходимо учитывать этот фактор при работе. В 2023 году основанная RIPE NCC Евразийская группа сетевых операторов (ENOG) оказалась фактически расформированной после того, как её руководство покинуло посты. Кроме того, данные RIPE тоже попали в даркнет.

05.03.2025 [08:32], Руслан Авдеев

Last Energy построит в Техасе 30 малых модульных реакторов для питания ЦОДРазработчик малых модульных реакторов (SMR) Last Energy заявил о намерении построить 30 объектов для обслуживания рынка дата-центров в США. Их построят на принадлежащем компании участке площадью 80 га на юго-востоке Техаса в округе Хаскелл (Haskell), сообщает Datacenter Dynamics. Компания намерена в будущем поставлять электричество через частные и публичные электросети и уже подала заявку местному регулятору. А вот разрешение на строительство от Комиссии по ядерному регулированию США (US Nuclear Regulatory Commission) пока не получено. В компании заявили, что атомная энергетика — наилучший способ удовлетворить спрос на электричество в Техасе, причём именно её решения способны наилучшим образом сделать это. В компании уверены, что Техас признаёт роль АЭС в будущем процветании штата. По словам Last Energy, к постройке целого парка 20-МВт полностью модульных SMR PWR-20 её подтолкнул растущий на энергию со стороны местных ЦОД. Сейчас в штате действует более 340 ЦОД ёмкостью более 7,6 ГВт, но их количество и мощность, как предполагается, будут только расти. Компания уже заключила соглашения на поставку более 80 микрореакторов по всей Европе, половина из которых будет обслуживать именно ЦОД. В декабре 2024 года Last Energy получила предварительное предложение о долговом финансировании на сумму $103,7 млн от государственного Экспортно-импортного банка США (EXIM) для постройки первого из четырёх SMR в юге Уэльса (Великобритания) к 2027 году. Всего в Великобританию компания поставит 24 SMR, а ещё 10 — в Польшу. За последние 12 месяцев малые модульные реакторы стали весьма популярным товаром на рынке ЦОД, хотя ни одной коммерческой модели ещё не существует. В феврале Deep Fission, ведущая работы над SMR, объединилась с Endeavour Energy для совместного обеспечения 2 ГВт ЦОД Endeavour Edged. В прошлом году Amazon объявила, что сотрудничает с X-Energy и инвестирует в компанию для получения более 5 ГВт к 2039 году. До этого Google подписала соглашение с Kairos Power о покупке 500 МВт от шести-семи реакторов. Предполагается, что первый заработает в 2030 году. Оператор ЦОД Switch подписал соглашение о покупке до 12 ГВт с SMR компании Oklo.

04.03.2025 [22:37], Татьяна Золотова

Российские компании ринулись массово подавать иски к «дочке» MicrosoftРоссийские компании с начала 2025 года подали к ООО «Майкрософт Рус» (российское юрлицо Microsoft) четыре иска на общую сумму 110 млн руб. Для сравнения: в 2023 году сумма от претензий бывших клиентов Microsoft составляла приблизительно 170 млн руб., в 2024 году — 26,6 млн руб., в 2022 году — 34,7 млн руб. Предполагаемая причина всплеска новых исков — истечение срока исковой давности и обсуждаемые графики выплаты долгов. Об этом сообщает РБК со ссылкой на данные судебной картотеки. Ранее с Microsoft судились «Северсталь», «Ситроникс», «Уралкалий», «Национальный расчетный депозитарий», ВТБ, «МегаФон» и др. В январе 2025 года к ним присоединились Газпромбанк (иск на 91 млн руб.), «Лента» (16 млн руб.), ГК «Медси» (2,1 млн руб.), «Консист» (960 тыс. руб.). Из новых исков пока только одобрено обращение «Ленты», по остальным дела еще не заведены, передаёт РБК. Как сообщает РБК, на 31 декабря 2023 года (последние доступные данные) на счетах «Майкрософт Рус» было 139,6 млн руб. Выручка составляла 211,6 млн руб., чистый убыток — 34,5 млн руб.

Источник изображения: Surface / Unsplash В исках отражаются требования от бывших российских партнеров «Майкрософт Рус» в связи с невыполнением обязательств по договорам после ухода Microsoft из России в 2022 году. Сначала американская корпорация приостановила продажи продуктов и услуг, затем из-за санкций перестала продлевать подписки на Microsoft 365 корпоративным клиентам, отключила от облачных сервисов и др. При этом российские компании по-прежнему не готовы полностью отказаться от некоторых продуктов Microsoft, включая Windows и Office, а также Project и Visio. Рост количества предъявляемых к Microsoft денежных требований в 2025 году опрошенные РБК юристы связывают с истечением срока исковой давности. Они не исключают, что российские компании ведут переговоры с представителями «Майкрософт Рус» по выплатам и обсуждают графики платежей. Но без судебного решения в силу действующих ограничений и санкций головная компания не может направить денежные средства на погашение соответствующей задолженности.

04.03.2025 [17:38], Владимир Мироненко

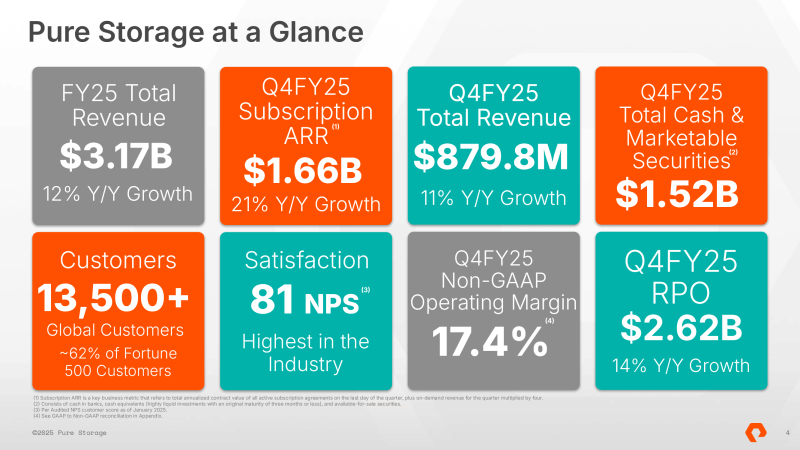

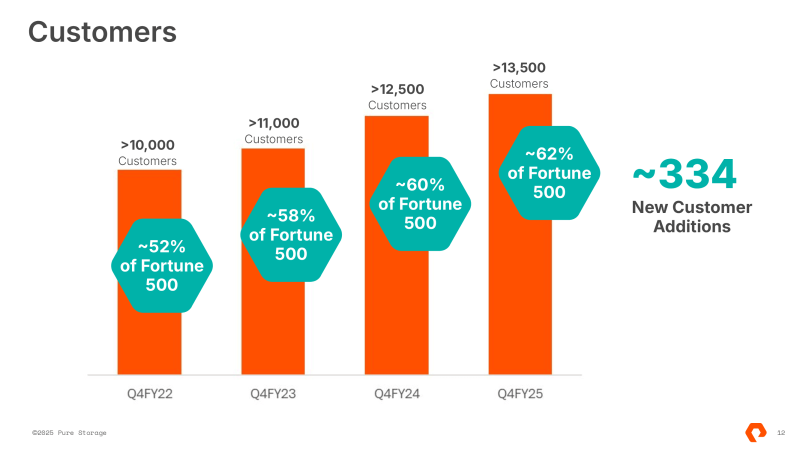

Pure Storage сообщила о росте выручки и прибыли, а также о расширении сотрудничества с гиперскейлеромПоставщик решений для хранения данных Pure Storage объявил финансовые результаты IV квартала и всего 2025 финансового года, завершившегося 2 февраля 2025 года. Несмотря на то, что показатели выручки и прибыли превзошли ожидания аналитиков, акции компании упали почти на 8 % после закрытия торгов из-за слабого прогноза по скорректированной операционной прибыли (Non-GAAP) на I квартал 2026 финансового года, оказавшейся ниже оценки Уолл-стрит. Non-GAAP, пишет SiliconANGLE. Выручка Pure Storage выросла в IV квартале на 11 % в годовом исчислении до $879,8 млн, превысив консенсусную оценку аналитиков в $870,4 млн. Более высокий, чем ожидалось, рост продаж был частично обусловлен ростом установленной базы компании. На конец квартала у неё было более чем 13 500 клиентов, по сравнению с примерно 11 000 годом ранее. За квартал у компании появилось 334 новых клиента. Генеральный директор Чарли Джанкарло (Charlie Giancarlo) сообщил, что 62 % компаний из списка Fortune 500 теперь являются клиентами Pure Storage, по сравнению с 60 % годом ранее.

Источник изображений: Pure Storage При этом выручка от предоставления услуг по подписке выросла год к году на 17 % до $385,1 млн, опередив по темпам роста общий рост выручки компании. Ещё больше вырос ежегодный регулярный доход (ARR) от подписки — на 2 % до $1,7 млрд. Продажи продуктов выросли всего на 7,4 % до $494,8 млн. Оставшиеся обязательства (RPO) составили $2,6 млрд (рост год к году на 14 %). Операционная прибыль (GAAP) за квартал составила $42,5 млн, скорректированная операционная прибыль (non-GAAP) — $153,1 млн или $0,45 на акцию. Аналитики, опрошенные Zacks, ожидали $0,42 прибыли на акцию. Чистая прибыль (GAAP) компании равняется $42,4 млн или $0,12 на акцию (падение на 35 %), скорректированная чистая прибыль (non-GAAP) — $153,2 млн или $0,45 на акцию. Валовая прибыль равна 67,5 %, что ниже, чем 71,9 % год назад. Снижение валовой прибыли было вызвано ростом цен на память NAND, влияющим на стоимость оптимизированных по ёмкости СХД FlashBlade//E, которые конкурируют с массивами на основе дисковых накопителей. По сути, Pure пришлось смириться с ростом затрат, предложив привлекательные цены, чтобы сохранить свою конкурентоспособность, отметил ресурс Blocks & Files. По словам гендиректора, в отчётном квартале были достигнуты рекордные продажи устройств FlashBlade, FlashArray//XL, Portworx, семейства FlashArray//E и подписок Evergreen. В свою очередь, аналитик Стив Макдауэлл (Steve McDowell) из NAND Research заявил в интервью SiliconANGLE, что «целевые по эффективности массивы all-flash являются драйвером роста для Pure, но они также менее прибыльны, чем массивы, ориентированные на производительность». Он отметил, что уже восьмой квартал подряд Pure Storage превосходит прогнозы Уолл-стрит, и в трёх из последних четырёх кварталов она показала рост более чем на 10 % в годовом исчислении, чем не может похвастать ни один из конкурентов. Несмотря на сильные результаты IV квартала, компания прогнозирует скорректированную операционную прибыль (non-GAAP) на текущий квартал в размере $83 млн, что ниже консенсус-прогноза аналитиков в $90 млн. Прогноз компании по выручке в размере $770 млн (рост год к году на 11 %) соответствует консенсусной оценке Уолл-стрит. Что касается показателей за 2025 финансовый год в целом, то Pure Storage впервые превысила рубеж по выручке в $3 млрд, завершив год с $3,2 млрд выручки, что больше прошлогоднего результата на 12 % и выше прогноза Уолл-стрит. Чистая прибыль (GAAP) составила $106,7 млн, что на 74 % больше, чем в предыдущем году. В 2026 финансовом году компания ожидает получить скорректированную операционную прибыль в размере $595 млн при выручке в размере $3,51 млрд (рост — 11 %). Подводя итоги за год, компания сообщила, что достигнута первая в отрасли победа в области проектирования в сотрудничестве с гиперскейлером из Топ-4, что позволило внедрить ПО DirectFlash от Pure Storage в крупномасштабные среды, в которых традиционно доминируют жёсткие диски (HDD). Комментируя достижение, Джанкарло рассказал, что компания продолжает обсуждать с гиперскейлером варианты использования различных типов уровней хранения данных в его инфраструктуре. По его словам, Pure Storage прогнозирует крупное производство и развёртывание СХД, начиная с 2027 финансового года. В свою очередь, технический директор Роб Ли (Rob Lee) сообщил, что Pure стремится к тому, чтобы её ПО Purity работало с ПО гиперскейлера и его архитектурами оборудования. «Сейчас мы работаем над несколькими различными уровнями производительности. Каждый из них требует своего собственного набора настроек. И, конечно, нам также необходимо квалифицировать несколько различных масштабов наших модулей DirectFlash вместе с несколькими различными производителями флеш-памяти для этих модулей», — рассказал он, добавив, что компания также планирует ускорить работу над увеличением плотности DirectFlash. По его словам, компания также обсуждает возможности взаимодействия с другими гиперскейлерами.

04.03.2025 [17:14], Руслан Авдеев

CoreWeave, закупившая более 250 тыс. ИИ-ускорителей NVIDIA, подала заявку на IPO — капитализация компании может превысить $35 млрдПровайдер облачной инфраструктуры CoreWeave готов выйти на IPO и привлечь средства на фоне ненасытного спроса инвесторов буквально на любые продукты, связанные с ИИ, сообщает Silicon Angle. Компания уже выполнила подготовительные «бумажные» работы, связанные со взаимодействием с Комиссией по ценным бумагами и биржам США (SEC). Планируется выход на биржу Nasdaq под тикером CRWV. Первичное размещение будет проведено под руководством Morgan Stanley, также участие примут JPMorgan Chase и Goldman Sachs. Хотя CoreWeave нельзя назвать самым узнаваемым именем на рынке ИИ, компания оказала значимое влияние на индустрию, обеспечивая бизнесам облачный доступ к дефицитным ИИ-ускорителям NVIDIA H100 и H200. Компания уже распоряжается обширной сетью дата-центров, раскинутой от Северной Америки до Европы. В ходе раунда финансирования осенью 2024 года компания заявляла, что располагает 14 ЦОД и планирует увеличит их число до 28 к концу года. До конца 2025 года она планирует развернуть ещё 10 дата-центров. Ранее компания даже попыталась купить своего партнёра по ЦОД Core Scientific, но в итоге просто увеличила аренду. Амбициозные планы компании по созданию инфраструктуры необходимы для поддержки её роста. Выручка в 2024 году взлетела на 700 %, превысив $1,92 млрд. Компания обещает ещё более быстрый рост в будущем и уже подписала контракты на $15 млрд. Впрочем, прибыльности пока добиться не удалось, чистый убыток в минувшем году составил $863,4 млн. В последний квартал выручка составила $747,4 млн, валовая прибыль достигла 76%. Ожидаемая оценка компании по итогам IPO — более $35 млрд. CoreWeave была основана в 2017 году под именем Atlantic Crypto и изначально специализировалась на криптомайнинге. С началом нестабильности на рынке криптовалют в 2022 году компания решила, что иметь дело с ИИ выгоднее, тем более что на тот момент уже «выстрелил» ChatGPT, а у компании был опыт работы с HPC-инфраструктурой. Начались закупки тысяч ИИ-ускорителей, иногда даже под залог уже имеющихся ускорителей. Компания стала настоящим спасением для многих бизнесов, предлагая гибкие и относительно недорогие схемы доступа к ускорителям. Её подход контрастирует с предложениями AWS и Google Cloud. А Microsoft и IBM сами пользуются услугами CoreWeave.  Согласно поданным для IPO документам, сегодня 38 % голосов в компании принадлежит её главе Майклу Интратору (Michael Intrator), 7 % — хеджевому фонду Magnetar и 1 % — NVIDIA. Те же документы свидетельствуют о том, что компания сегодня располагает парком из более чем 250 тыс. ускорителей NVIDIA, хотя большинство из них — относительно старые модели. Производство новейших Blackwell стартовало в ноябре, они лишь начали появляться в портфолио компании. Ускорители AMD и других конкурентов NVIDIA компания не использует. Считается, что речь идёт о первом крупном IPO технологической компании в текущем году, обычно это время для индустрии приходится на «затишье». В прошлом году на торги вышли ServiceTitan, Rubrik, Astera Labs и Reddit. До этого значимых выходов на биржу не было буквально с конца 2021 года, поскольку экономические условия стали довольно неблагоприятными. Скоро примеру CoreWeave, возможно, последует другой интересный стартап. В сентябре 2024 года заявку на IPO подала Cerebras Systems Inc. — прямой конкурент NVIDIA. Впрочем, процесс замедлился, поскольку деятельностью компании заинтересовался Комитет по иностранным инвестициям Министерства финансов США.

04.03.2025 [14:38], Руслан Авдеев

IBM закрыла R&D-центр в Китае, оставив без работы 1,8 тыс. специалистовПодразделение IBM China Investment Company Limited (IBMV) и её дочерние компании прекратили работу в КНР. Уход компании из Китая 1 марта скажется на карьерах более 1,8 тыс. сотрудников, занимавшихся исследованиями, разработками и тестированием в Пекине, Шанхае, Даляне и других городах, сообщает DigiTimes. По данным местных источников, штаб-квартира IBMV в Пекине уже пустует. После того, как Китай и США установили дипломатические отношения в 1979 году, IBM начала вести дела с КНР, инвестируя в местный бизнес на фоне экономического бума. Основанная в 1992 году компания IBMV курировала инициативы IBM в Китае. В августе 2024 года IBM неожиданно объявила, что сократит R&D-активность в Китае и что это коснётся более 1,6 тыс. человек. По слухам, распространяющимся в китайском сегменте интернета, на новый шаг компания, возможно, пошла под влиянием её главы Арвинда Кришны (Arvind Krishna) родом из Индии. У КНР и Индии довольно напряжённые отношения, а теперь последняя ещё и претендует на то, чтобы стать «мировой фабрикой» вместо Поднебесной, хотя производственные потенциалы пока несопоставимы. Так или иначе, недавно штат лабораторий в Пекине, Шанхае и Даляне оповестили в ходе онлайн-встречи, что их задачи будут переданы за рубеж.

Источник изображения: zhang kaiyv/unsplash.com С 1992 года в Китае работает полностью принадлежащее IBM коммерческое подразделение, которое сразу же стало приносить прибыль, в основном благодаря продаже мейнфреймов. Со временем IBM сместила фокус с выпуска оборудования на разработку ПО с полным спектром обслуживания, включая консалтинг (IBMC). По слухам, в 2025 году здесь также пройдут сокращения. Сейчас почти половина бизнеса IBM приходится именно на программное обеспечение, причём компания регулярно проводит увольнения в других регионах, а часть персонала и вовсе намерена заменить ИИ. В 2023 году эскалация отношений между США и Китаем привела к падению выручки и оттоку китайских клиентов, что, возможно, тоже сподвигло IBM отказаться от исследований и разработок в Китае. Признаки того, что IBM может уйти из КНР, были и ранее. Например, местные сотрудники компании неофициально сообщали журналистам о сокращении бизнеса. В 2023 году некоторых сотрудников перевели на другие задачи, а часть работ перенесли в Индию и Юго-Восточную Азию. Пока не вполне ясна и судьба совместного с китайской Inspur предприятия Inspur Business Machines (тоже IBM), сформированного для выпуска мощных серверных систем на базе открытой архитектуры POWER для крупного бизнеса. Правда, в 2023 году Вашингтон закрыл Inspur доступ к новейшим технологиям США, но в Китае POWER-процессоры разрабатываются уже давно.

04.03.2025 [11:33], Руслан Авдеев

Nokia завершила покупку InfineraNokia завершила покупку Infinera, что позволит финской компании усилить компетенции и масштабировать бизнес в сфере оптических сетей, а также позволит ускорить рост в сегменте ЦОД, сообщает пресс-служба компании. В подразделении Nokia Network Infrastructure отметили высокую скорость одобрения сделки регуляторами и поддержку соглашения клиентами компаний. Теперь речь идёт о формировании фактически новой организации, которая будет задавать тренды в отрасли и обеспечит клиентам доступ к всевозможным оптическим сетевым технологиям при поддержке Nokia Bell Labs. Масштабирование бизнеса позволит ускорить расширение портфолио продуктов. О подписании окончательного соглашения Nokia и Infinera объявили в июне 2024 года. Предполагалось, что Nokia сможет купить компанию из расчёта $6,65 за акцию, а владельцы ценных бумаг Infinera смогут продать их, получить взамен акции Nokia или выбрать комбинированный вариант. Команда Infinera присоединится к бизнесу Optical Networks компании Nokia, при этом бывший глава Infinera Дэвид Херд (David Heard) войдёт в группу Network Infrastructure в роли главы стратегического развития. Объединённая компания располагает более 1 тыс. клиентов по всему миру, обеспечивая своими решениями крупнейших операторов связи, а также крупнейших корпоративных клиентов, включая коммунальные, государственные, исследовательские и образовательные структуры.

Источник изображения: Nokia В Nokia рассчитывают, что сделка будет способствовать росту операционной прибыли и прибыли на акцию (EPS) в 2025 году и намерена заработать по итогам сделки более €200 млн к 2027 году. В частности, к 2027 году сделка должна обеспечить рост EPS более чем на 10 %. При этом не все сетевые активы приходятся Nokia ко двору. Например, в начале 2025 года Nokia завершила продажу Франции подразделения Alcatel Submarine Networks (ASN), занимающегося подводными кабелями.

04.03.2025 [11:16], Сергей Карасёв

Supermicro расширит производство ИИ-серверов в Кремниевой долинеКомпания Supermicro объявила о планах по строительству третьего производственного кампуса в Кремниевой долине, который поможет нарастить мощности по выпуску серверов с жидкостным охлаждением. Площадка расположится в Сан-Хосе (Калифорния, США), где находится штаб-квартира Supermicro. Согласно прогнозам, на фоне стремительного развития ИИ до 30 % новых дата-центров будут использовать решения с жидкостным охлаждением. На сегодняшний день Supermicro может ежемесячно поставлять до 5 тыс. серверных стоек с воздушным охлаждением или до 2 тыс. стоек с СЖО. Создание нового кампуса в Кремниевой долине даст возможность существенно нарастить объёмы производства. Проект будет реализовываться в несколько этапов. Площадь первого здания составит приблизительно 27 870 м2, тогда как площадь всего кампуса после завершения строительства будет достигать 278,7 тыс. м2. Работы на новой площадке начнутся в текущем году. Инициатива поддерживается мэрией Сан-Хосе. Ожидается, что проект создаст сотни дополнительных рабочих мест в различных секторах, включая инжиниринг, производство и корпоративное управление. Серверы Supermicro, оснащённые СЖО, помогут операторам ЦОД и гиперскейлерам повысить эффективность благодаря сокращению выбросов углекислого газа, экономии на эксплуатационных расходах и снижению потребления электроэнергии. Supermicro прогнозирует значительный рост выручки: в 2026 финансовом году, завершающемся в середине следующего календарного года, показатель, как ожидается, достигнет $40 млрд. Основным драйвером Supermicro называет более широкое внедрение технологии прямого жидкостного охлаждения (DLC) в дата-центрах. |

|