Материалы по тегу: mgx

|

03.12.2025 [01:28], Владимир Мироненко

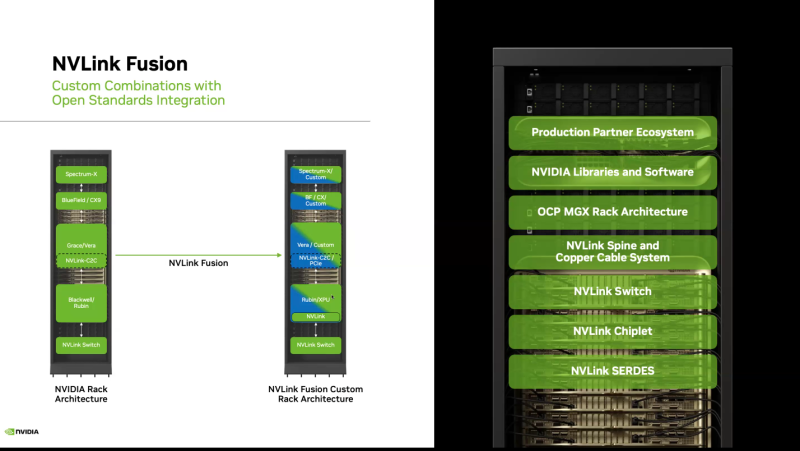

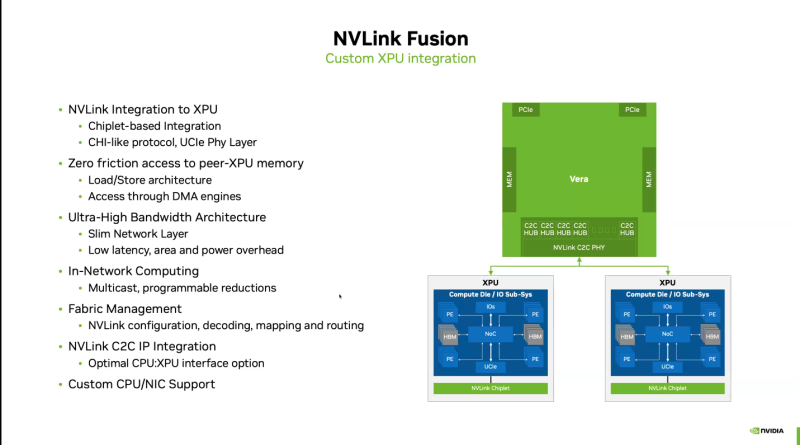

AWS «сдалась на милость» NVIDIA: анонсированы ИИ-ускорители Trainium4 с шиной NVLink FusionAWS готовит Arm-процессоры Graviton5, которые составят компанию ИИ-ускорителям Trainium4 с интерконнектом NVLink Fusion, фирменными EFA-адаптерам и DPU Nitro 6 с движком Nitro Isolation Engine. Но что более важно, все они будут «упакованы» в стойки стандарта NVIDIA MGX. Amazon и NVIDIA объявили о долгосрочном партнёрстве, в рамках которого ИИ-ускорители Trainium4 получит шину NVIDIA NVLink Fusion шестого поколения (по-видимому, 3,6 Тбайт/с в дуплексе), которая позволит создать стоечную платформу нового поколения, причём, что интересно, на базе архитектуры NVIDIA MGX, которая передана в OCP. Пикантность ситуации в том, что AWS годами практически игнорировала OCP, самостоятельно создавая стойки, их компоненты, включая СЖО, и архитектуру ИИ ЦОД в целом. Даже в нынешнем поколении стоек с GB300 NVL72 отказалась от референсного дизайна NVIDIA. NVIDIA же напирает на то, что для гиперскейлерам крайне трудно заниматься кастомными решениями — циклы разработки стоечной архитектуры занимают много времени, поскольку помимо проектирования специализированного ИИ-чипа, гиперскейлеры должны озаботиться вертикальным и горизонтальным масштабированием, интерконнектами, хранилищем, а также самой конструкцией стойки, включая лотки, охлаждение, питание и ПО.

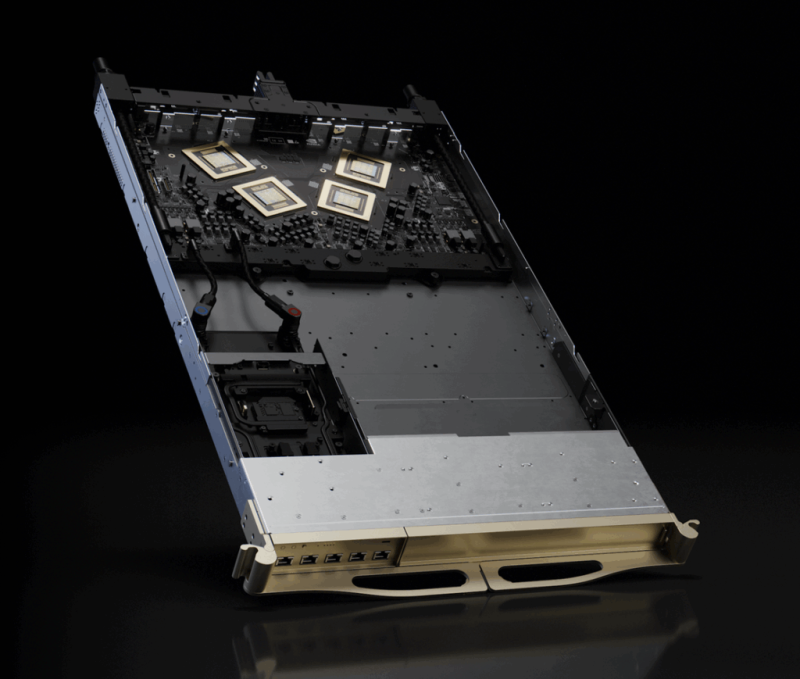

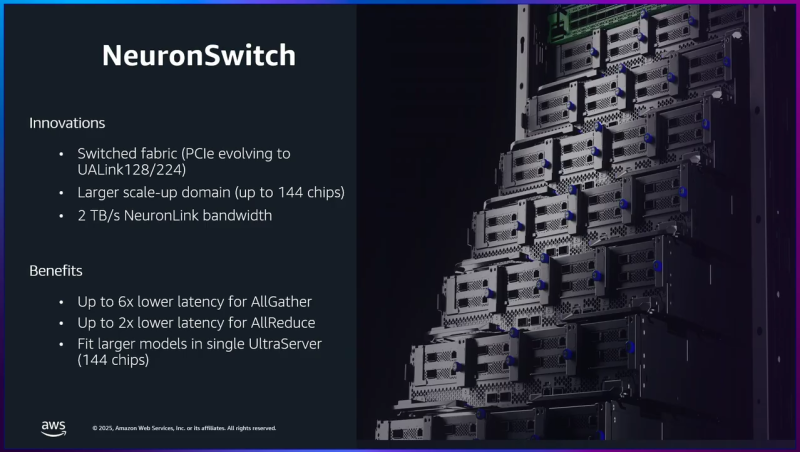

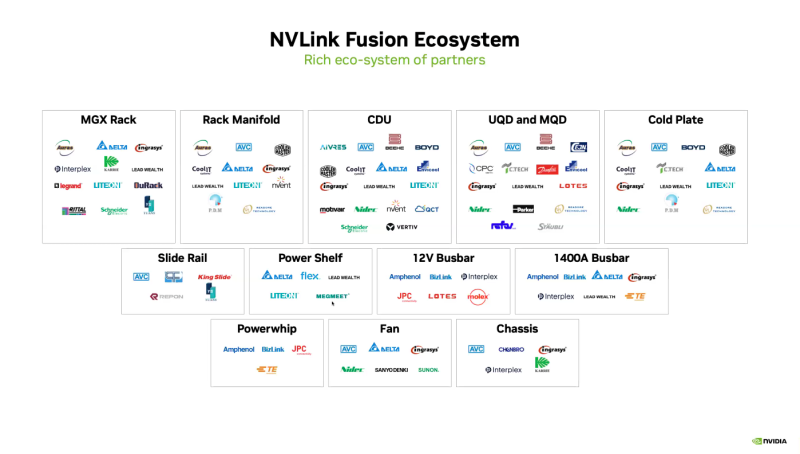

Источник изображения: NVIDIA Вместе с тем управление цепочкой поставок отличается высокой сложностью, так как требуется обеспечить согласованную работу десятков поставщиков, ответственных за десятки тысяч компонентов. И даже одна задержка поставки или замена одного компонента может поставить под угрозу весь проект. Платформа NVIDIA если не устраняет целиком, то хотя бы смягчает эти проблемы, предлагая готовые стандартизированные решения, которые могут поставлять множество игроков рынка. По словам NVIDIA, в отличие от других подходов к масштабированию сетей, NVLink — проверенная и широко распространённая технология. В сочетании с фирменным ПО NVLink Switch обеспечивает увеличение производительности и дохода от ИИ-инференса до трёх раз, объединяя 72 ускорителя в одном домене. Пользователи, внедрившие NVLink Fusion, могут использовать любую часть платформы — каждый компонент может помочь им быстро масштабироваться для удовлетворения требований интенсивного инференса и обучения моделей агентного ИИ, говорит NVIDIA. Что касается самих ускорителей Trainium4, то в сравнении с Trainium3 они будут вшестеро быстрее в FP4-расчётах, втрое быстрее в FP8-вычислениях, а пропускная способность памяти будет увеличена вчетверо. Впрочем, пока собственные ускорители Amazon не всегда могут составить конкуренцию чипам NVIDIA. Любопытно и то, что в рассказе о Trainium3 компания отметила о переходе от PCIe к UALink в коммутаторах NeuronSwitch для фирменного интерконнекта NeuronLink, объединяющего до 144 чипов Trainium. Однако после крупных инвестиций NVIDIA в Synopsys развитие UALink как открытой альтернативы NVLink теперь под вопросом.

29.11.2025 [14:58], Сергей Карасёв

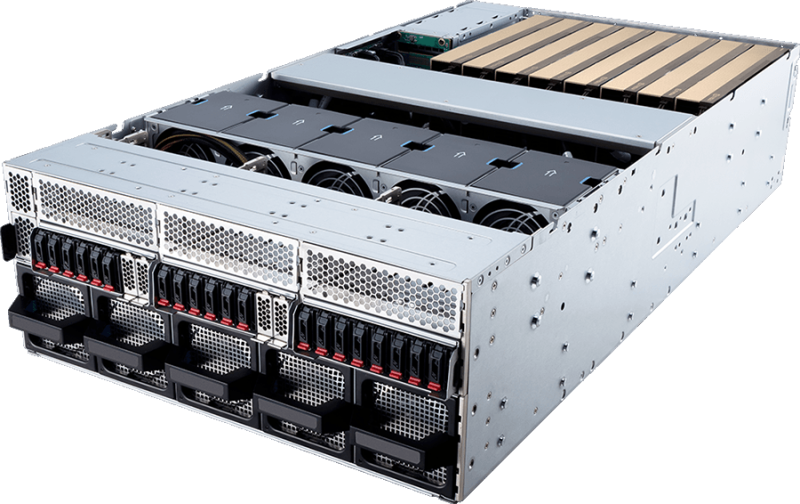

MGX-сервер MSI CG480-S6053 получил чипы AMD EPYC Turin и восемь слотов PCIe 5.0 x16 для FHFL-карт двойной шириныКомпания MSI анонсировала сервер CG480-S6053, предназначенный для ресурсоёмких задач ИИ и НРС. Устройство выполнено в форм-факторе 4U на архитектуре NVIDIA MGX. Возможна установка двух процессоров AMD EPYC 9005 Turin в исполнении Socket SP5 с показателем TDP до 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-6400 RDIMM/RIMM-3DS суммарным объёмом до 6 Тбайт (в конфигурации 24 × 256 Гбайт). Во фронтальной части расположены восемь отсеков для SFF-накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe); допускается горячая замена. Есть два внутренних коннектор М.2 для SSD типоразмера 2280/22110 с интерфейсом PCIe 3.0 x2 (NVMe). Сервер оснащён восемью слотами PCIe 5.0 x16 для карт FHFL двойной ширины. Могут устанавливаться, в частности, ИИ-ускорители NVIDIA H200 NVL и RTX Pro 6000 Blackwell Server Edition. Кроме того, есть пять слотов PCIe 5.0 x16 для карт FHFL одинарной ширины. Сервер располагает контроллером ASPEED AST2600, двумя сетевыми портами 10GbE (RJ45) на основе Intel X710-AT2, выделенным сетевым портом управления 1GbE, разъёмами USB 3.0/2.0 Type-A и Mini-DisplayPort. Модификация системы с обозначением CG481-S6053 получила восемь портом 400GbE на базе NVIDIA ConnectX-8 SuperNIC. Предусмотрен модуль TPM 2.0. Новинка имеет размеры 438,5 × 175 × 800 мм. Питание обеспечивают четыре блока с резервированием мощностью 3200 Вт (80 PLUS Titanium). Применено воздушное охлаждение с десятью системными вентиляторами диаметром 80 мм с возможностью горячей замены. Диапазон рабочих температур — от +10 до +35 °C.

14.11.2025 [10:03], Руслан Авдеев

NVIDIA ужесточит контроль над выпуском ИИ-платформ, задвинув Foxconn и других партнёров на второй планКомпания NVIDIA готовится изменить текущую бизнес-модель в контексте ИИ-серверов. Она намерена получить под свой контроль производство ИИ-платформ целиком, а не отдельные элементы цепочек поставок, сообщает Wccftech. Если обычно экосистема поставок NVIDIA опирается на партнёров, выпускающих компоненты конечных продуктов — Foxconn, Quanta (QCT) и Wistron (Wiwynn) — со своими собственными разработками, то в будущем компания фактически возьмёт под контроль всё производство вплоть до уровня стоек. До сих пор NVIDIA поставляла в основном ключевые компоненты, такие как ИИ-ускорители и системные платы вроде Bianca Port UPB. Тем не менее, в ходе отчёта Wistron за III квартал 2025 года представитель JPMorgan заявил, что компания, похоже, переходит к «прямым поставкам» полноценных систем. Если раньше NVIDIA отвечала за ключевые элементы стоек — ИИ-ускорители и платы, — то за остальную архитектуру отвечали подрядчики вроде Foxconn, Quanta и других компаний. Теперь, как полагают в JPMorgan, NVIDIA станет напрямую поставлять системы Level-10 (почти полный блок серверной стойки). Компания унифицирует конструкцию систем, заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна и запретит использование проприетарных архитектур, созданных самими подрядчиками. Фактически — это развитие философии MGX-архитектуры, предполагающей единые стандарты от серверного узла до полнофункциональной ИИ-фабрики. При этом время развёртывания таких комплексных систем сократится с 9–12 мес. до 90 дней, т.е. 3 мес. Поскольку 80 % наполнения систем будет предварительно определяться NVIDIA, новые платформы вроде Rubin/Rubin CPX можно будет внедрять ускоренными темпами. NVIDIA выиграет от быстрого вывода систем на рынок, роста маржинальности и расширения так называемого «общего адресуемого рынка» (TAM). В Wistron утверждают, что новая модель выгодна и заказчикам, поскольку ключевые работы по созданию ИИ-оборудования всё равно выполняет компания-подрядчик. В целом NVIDIA стремится перейти от роли обычного поставщика ИИ-чипов к модели, при которой IT-гигант контролирует развёртывание инфраструктуры целиком. Это как ускорит выпуск ИИ-систем, так и укрепит позиции компании. Впрочем, пока информация об изменениях поступает из сторонних источников — в самой NVIDIA её не подтверждали. При этом для гиперскейлеров, которые самостоятельно занимаются разработкой ИИ-платформ, пока, по-видимому, ничего не поменяется.

20.10.2025 [09:11], Сергей Карасёв

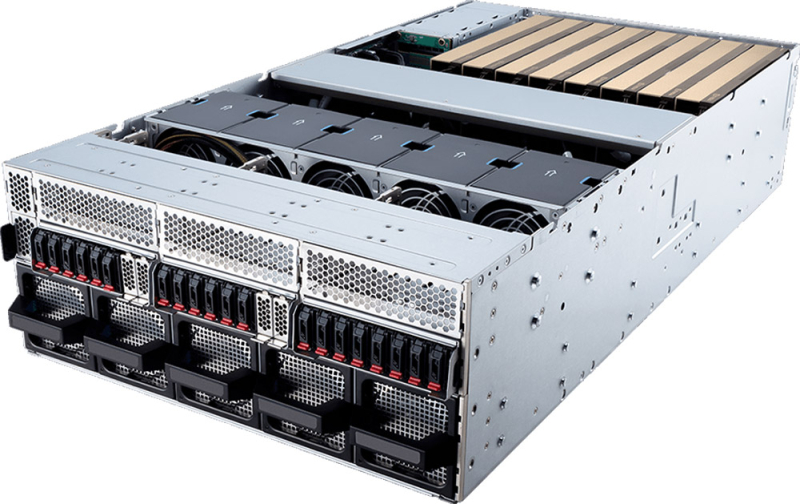

Pegatron представила ИИ-систему RA4802-72N2 на базе NVIDIA GB300 NVL72Компания Pegatron представила систему RA4802-72N2, предназначенную для наиболее ресурсоёмких ИИ-нагрузок, включая обучение больших языковых моделей (LLM) в масштабе и инференс. В основу положена платформа NVIDIA GB300 NVL72. Изделие GB300 содержит Arm-процессор Grace с 72 ядрами Neoverse V2 (Demeter) и два чипа Blackwell Ultra. В составе RA4802-72N2 объединены 18 вычислительных лотков, каждый из которых несёт на борту два Grace и четыре Blackwell Ultra. В сумме это даёт 36 процессоров Grace и 72 чипа Blackwell Ultra. Каждый из вычислительных узлов располагает 960 Гбайт памяти LPDDR5X и 1152 Гбайт памяти HBM3e. Таким образом, в общей сложности система оперирует примерно 17 Тбайт LPDDR5X и 20 Тбайт HBM3e. ИИ-производительность достигает 720 Пфлопс на операциях FP8/FP6. В состав RA4802-72N2 также входят девять коммутационных лотков. Общая пропускная способность интерконнекта NVLink составляет 130 Тбайт/с. В расчёте на вычислительный узел используются два адаптера NVIDIA ConnectX-8 и один DPU NVIDIA BlueField-3. Прочие характеристики включают контроллер Aspeed AST2600, модуль TPM 2.0, восемь отсеков для накопителей E1.S NVMe, коннектор M.2 2280/22110 NVMe. Система выполнена в форм-факторе 48U MGX с габаритами 600 × 2296 × 1200 мм. Применяется полностью жидкостное охлаждение. Полка питания оснащена шестью 1U-модулями мощностью 33 кВт. Поставки машины RA4802-72N2 уже начались.

06.10.2025 [14:27], Сергей Карасёв

GIP близка к поглощению оператора ЦОД Aligned Data Centers за $40 млрдИнвестиционная компания Global Infrastructure Partners (GIP), по сообщению Bloomberg, ведёт переговоры о покупке Aligned Data Centers — техасского оператора ЦОД. Стоимость последнего в рамках готовящейся сделки может составить около $40 млрд. В случае успеха сделка станет одной из крупнейших на рынке. На сегодняшний день Aligned Data Centers оперирует кампусами в Чикаго (штат Иллинойс), Далласе (штат Техас), Солт-Лейк-Сити (штат Юта), Финиксе (штат Аризона) и Северной Вирджинии. Кроме того, компания занимается строительством объектов в Мэриленде, Огайо, Иллинойсе и Вирджинии. В начале текущего года Aligned Data Centers привлекла на развитие $12 млрд в виде долговых обязательств и акционерного капитала из фондов, подконтрольных австралийской Macquarie Asset Management. Деньги помогут в развитии инфраструктуры ИИ ЦОД. В свою очередь, компания GIP, основанная в 2006 году, управляет клиентскими активами на сумму более $100 млрд. Первоочередное внимание уделяется секторам энергетики, транспорта, водоснабжения и утилизации отходов, а также цифровым технологиям, включая направление дата-центров. В январе 2024 года одна из крупнейших в мире инвестиционных компаний BlackRock приобрела GIP за $12,5 млрд. При этом сама BlackRock также владеет европейским оператором Mainova Webhouse. По информации Bloomberg, в сделке между GIP и Aligned Data Centers может принять участие инвестиционный фонд MGX, принадлежащий государственной холдинговой компании из Абу-Даби Mubadala Investment Company. При этом MGX уже владеет долей в Aligned Data Centers. Предполагается, что о продаже оператора ЦОД будет официально объявлено в ближайшее время. Ни одна из сторон комментарии по данному вопросу не даёт.

02.09.2025 [12:15], Сергей Карасёв

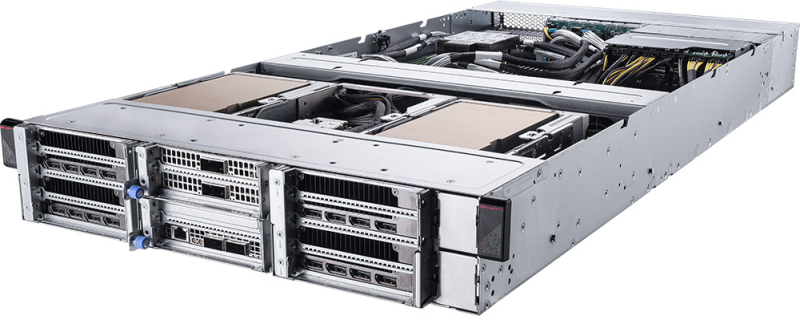

MSI выпустила серверы на платформе NVIDIA MGX с ускорителями RTX Pro 6000 Blackwell Server EditionКомпания MSI анонсировала серверы CG480-S5063 и CG290-S3063 на модульной архитектуре NVIDIA MGX. Новинки, ориентированные на задачи ИИ, оснащаются ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition с 96 Гбайт GDDR7. Модель CG480-S5063 выполнена в форм-факторе 4U. Допускается установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400/5200 или MRDIMM 8000). Во фронтальной части могут быть размещены 20 накопителей E1.S с интерфейсом PCIe 5.0 x4 (NVMe). Кроме того, есть два внутренних коннектора М.2 2280/22110 (PCIe 5.0 x2; NVMe). Система предлагает восемь слотов PCIe 5.0 x16 для карт FHFL двойной ширины и пять слотов PCIe 5.0 x16 для карт FHFL одинарной ширины. Таким образом, могут быть задействованы до восьми ИИ-ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на основе Intel X710-AT2, выделенный сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Питание обеспечивают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Задействовано воздушное охлаждение с вентиляторами, допускающими горячую замену. Диапазон рабочих температур — от 0 до +35 °C. В свою очередь, сервер CG290-S3063 типоразмера 2U рассчитан на один процессор Xeon 6500P/6700P с TDP до 350 Вт. Предусмотрены 16 слотов для модулей DDR5 (RDIMM 6400/5200 или MRDIMM 8000). В тыльной части расположены отсеки для четырёх SFF-накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe). Внутри есть два коннектора М.2 2280/22110 для SSD (PCIe 5.0 x2; NVMe). Данная система предоставляет четыре слота PCIe 5.0 x16 для карт FHFL двойной ширины и три слота PCIe 5.0 x16 для карт FHFL одинарной ширины. Могут быть использованы до четырёх ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. Прочие характеристики включают контроллер ASPEED AST2600, сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Применены четыре блока питания мощностью 2400 Вт с сертификатом 80 PLUS Titanium и воздушное охлаждение.

22.08.2025 [16:33], Владимир Мироненко

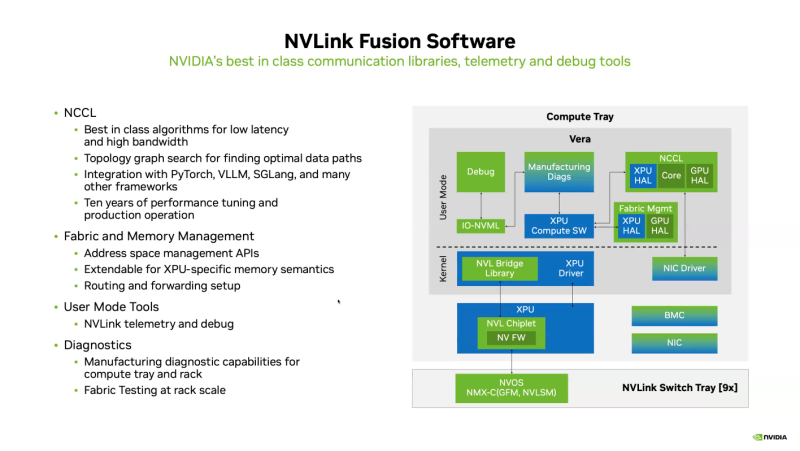

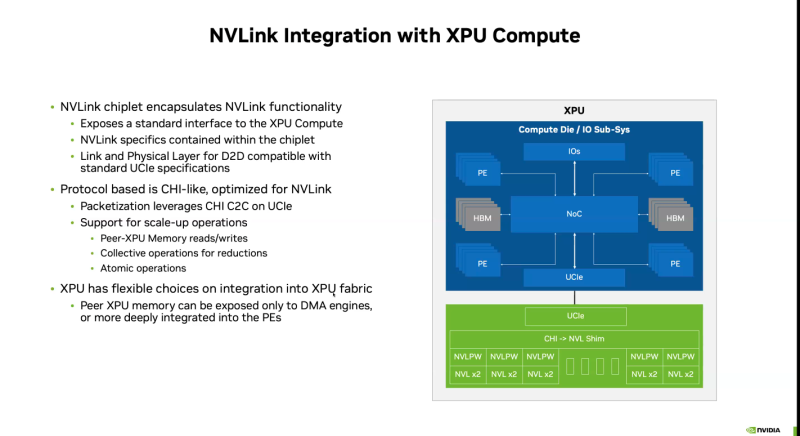

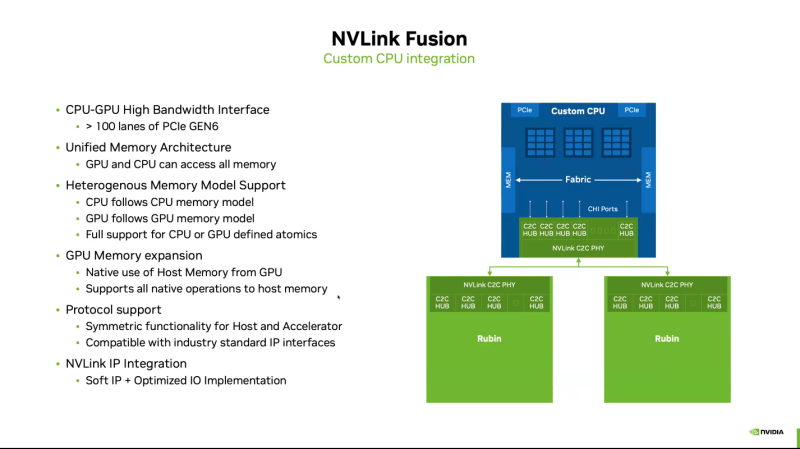

Почти как у самой NVIDIA: NVLink Fusion позволит создавать кастомные ИИ-платформыТехнологии NVIDIA NVLink и NVLink Fusion позволят вывести производительность ИИ-инференса на новый уровень благодаря повышенной масштабируемости, гибкости и возможностям интеграции со сторонними чипами, которые в совокупности отвечает стремительному росту сложности ИИ-моделей, сообщается в блоге NVIDIA. С ростом сложности ИИ-моделей выросло количество их параметров — с миллионов до триллионов, что требует для обеспечения их работы значительных вычислительных ресурсов в виде кластеров ускорителей. Росту требований, предъявляемых к вычислительным ресурсам, также способствует внедрение архитектур со смешанным типом вычислений (MoE) и ИИ-алгоритмов рассуждений с масштабированием (Test-time scaling, TTS). NVIDIA представила интерконнект NVLink в 2016 году. Пятое поколение NVLink, вышедшее в 2024 году, позволяет объединить в одной стойке 72 ускорителя каналами шириной 1800 Гбайт/с (по 900 Гбайт/с в каждую сторону), обеспечивая суммарную пропускную способность 130 Тбайт/с — в 800 раз больше, чем у первого поколения. Производительность NVLink зависит от аппаратных средств и коммуникационных библиотек, в частности, от библиотеки NVIDIA Collective Communication Library (NCCL) для ускорения взаимодействия между ускорителями в топологиях с одним и несколькими узлами. NCCL поддерживает вертикальное и горизонтальное масштабирование, а также включает в себя автоматическое распознавание топологии и оптимизацию передачи данных. Технология NVLink Fusion призвана обеспечить гиперскейлерам доступ ко всем проверенным в производстве технологиям масштабирования NVLink. Она позволяет интегрировать кастомные микросхемы (CPU и XPU) с технологией вертикального и горизонтального масштабирования NVIDIA NVLink и стоечной архитектурой для развёртывания кастомных ИИ-инфраструктур. Технология охватывает NVLink SerDes, чиплеты, коммутаторы и стоечную архитектуру, предлагая универсальные решения для конфигураций кастомных CPU, кастомных XPU или комбинированных платформ. Модульное стоечное решение OCP MGX, позволяющее интегрировать NVLink Fusion с любым сетевым адаптером, DPU или коммутатором, обеспечивает заказчикам гибкость в построении необходимых решений, заявляет NVIDIA. NVLink Fusion поддерживает конфигурации с кастомными CPU и XPU с использованием IP-блоков и интерфейса UCIe, предоставляя заказчикам гибкость в реализации интеграции XPU на разных платформах. Для конфигураций с кастомными CPU рекомендуется интеграция с IP NVLink-C2C для оптимального подключения и производительности GPU. При этом предлагаются различные модели доступа к памяти и DMA. NVLink Fusion использует преимущества обширной экосистемы кремниевых чипов, в том числе от партнёров по разработке кастомных полупроводников, CPU и IP-блоков, что обеспечивает широкую поддержку и быструю разработку новых решений. Основанная на десятилетнем опыте использования технологии NVLink и открытых стандартах архитектуры OCP MGX, платформа NVLink Fusion предоставляет гиперскейлерам исключительную производительность и гибкость при создании ИИ-инфраструктур, подытожила NVIDIA. При этом основным применением NVLink Fusion с точки зрения NVIDIA, по-видимому, должно стать объединение сторонних чипов с её собственными, а не «чужих» чипов между собой. Более открытой альтернативой NVLink должен стать UALink с дальнейшим масштабированием посредством Ultra Ethernet.

14.08.2025 [09:21], Сергей Карасёв

Gigabyte представила MGX-сервер с восемью ускорителями NVIDIA RTX Pro 6000Компания Gigabyte расширила ассортимент серверов для ИИ-задач, анонсировав модель XL44-SX2-AAS1 в форм-факторе 4U с модульной архитектурой NVIDIA MGX. Новинка предназначена для формирования ИИ-фабрик, работы с большими языковыми моделями (LLM) корпоративного уровня, научной визуализации, создания цифрового контента и других ресурсоёмких нагрузок. Сервер допускает установку двух процессоров Intel Xeon 6700/6500 и 32 модулей оперативной памяти DDR5 RDIMM/MRDIMM. В оснащение входят до восьми ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition, которые ориентированы на требовательные приложения ИИ. Эти карты несут на борту 96 Гбайт памяти GDDR7 (ECC) с пропускной способностью до 1,6 Тбайт/с. Во фронтальной части располагаются отсеки для восьми накопителей SFF с интерфейсом PCIe 5.0 (NVMe). Есть восемь разъёмов PCIe 5.0 x16 для двухслотовых карт FHFL, а также коннектор PCIe 5.0 x16 для однослотового DPU NVIDIA BlueField-3. В конструкции задействованы коммутационная плата NVIDIA MGX PCIe 6.0 на базе ASIC ConnectX-8 и контроллер Intel X710-AT2, на базе которого реализованы два сетевых порта 10GbE. За питание отвечают четыре блока с сертификатом 80 PLUS Titanium мощностью 3200 Вт каждый с резервированием по схеме 3+1, благодаря чему обеспечиваются стабильность и надёжность во время непрерывной круглосуточной эксплуатации. На лицевую панель выведены гнёзда RJ45 для сетевых кабелей и порты USB Type-A. Прочие технические характеристики сервера Gigabyte XL44-SX2-AAS1 пока не раскрываются.

22.05.2025 [12:43], Сергей Карасёв

ASRock Rack показала серверы NVIDIA HGX B300 и систему XGMRACK GB300 NVL72Компания ASRock Rack в рамках выставки Computex 2025 представила серверы нового поколения, оснащённые ИИ-ускорителями NVIDIA на архитектуре Blackwell. Кроме того, демонстрируются другие индустриальные и корпоративные продукты, включая материнские платы и системы с процессорами AMD и Intel. В число новинок вошёл сервер ASRock Rack 8U16X-GNR2 типоразмера 8U с воздушным охлаждением. Он выполнен на платформе NVIDIA HGX B300. По заявления разработчика, достигается в семь раз более высокая ИИ-производительность по сравнению с сопоставимыми системами, оборудованными ускорителями NVIDIA на архитектуре Hopper. Суммарный объём памяти HBM3e составляет около 2,3 Тбайт. Задействованы сетевые адаптеры NVIDIA ConnectX-8 SuperNIC. Кроме того, ASRock Rack готовит к выпуску сервер 4U16X-GNR2 на базе NVIDIA HGX B300 с жидкостным охлаждением. Обе модели ориентированы на ресурсоёмкие рабочие ИИ-нагрузки, такие как агентные системы, рассуждающие модели и генеративные сервисы. На стенде ASRock Rack представлено стоечная система XGMRACK на основе NVIDIA GB300 NVL72. Она объединяет 36 чипов NVIDIA Grace и 72 ускорителя NVIDIA Blackwell Ultra. Вычислительные и коммутационные узлы используют на 100 % жидкостное охлаждение. Общий объём памяти HBM3e превышает 20 Тбайт. Применяются решения NVIDIA Quantum-X800 InfiniBand и Spectrum-X Ethernet. ASRock Rack также представила серверы на модульной архитектуре NVIDIA MGX для масштабируемых ИИ-приложений и периферийных вычислений. В число таких машин входит модель 4UXGM-GNR2 типоразмера 4U с поддержкой двух процессоров Intel Xeon 6700P, 6500P (Granite Rapids) или Xeon 6700E (Sierra Forest). Доступны 32 слота для модулей оперативной памяти DDR5-6400, 16 посадочных мест для накопителей E1.S с интерфейсом PCIe 5.0 x4, два коннектора М.2 22110/2280 для SSD (PCIe 5.0 x4 и PCIe5.0 x2), восемь слотов PCIe 5.0 x16 FHFL, пять слотов PCIe 5.0 x16 FHHL и один слот PCIe 5.0 x16 HHHL. Установлены контроллер ASPEED AST2600 и четыре блока питания мощностью 1200 Вт с сертификатом 80 PLUS Titanium.

21.03.2025 [14:21], Сергей Карасёв

MSI представила серверы на архитектуре NVIDIA MGX с процессорами Intel Xeon 6Компания MSI анонсировала серверы CG480-S5063 и CG290-S3063 для задач ИИ и HPC, а также приложений с интенсивным использованием данных. В основу систем положены процессоры Intel Xeon 6500P и 6700P поколения Granite Rapids и модульная архитектура NVIDIA MGX. Модель CG480-S5063 выполнена в форм-факторе 4U. Возможна установка двух чипов Xeon 6 в исполнении LGA4710 с показателем TDP до 350 Вт. Доступны 32 слота для модулей DDR5-6400/8000 RDIMM/RDIMM-3DS/MRDIMM суммарным объемом до 8 Тбайт. Во фронтальной части расположены 20 отсеков для накопителей E1.S с интерфейсом PCIe 5.0 x4 (NVMe). Кроме того, есть два внутренних слота для SSD в формате М.2 2280/22110 PCIe 5.0 x2 (NVMe). В общей сложности реализованы 13 слотов PCIe 5.0 x16. Допускается применение до восьми ускорителей NVIDIA H200. Предусмотрены два сетевых порта 10GbE на базе Intel X710-AT2, выделенный сетевой порт управления 1GbE, контроллер ASPEED AST2600, порты USB 3.0/2.0 Type-A и Mini-DisplayPort. Питание обеспечивают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Задействовано воздушное охлаждение. В свою очередь, сервер CG290-S3063 рассчитан на один процессор Xeon 6 с TDP до 350 Вт. Объем памяти DDR5-6400/8000 RDIMM/RDIMM-3DS/MRDIMM может достигать 4 Тбайт (16 слотов). Доступны восемь тыльных отсеков для SFF-накопителей, два коннектора для SSD М.2 2280/22110 с интерфейсом PCIe 5.0 x2 (NVMe), а также восемь слотов PCIe 5.0 x16. Поддерживается установка до четырёх ускорителей NVIDIA H200. В оснащение входят контроллер ASPEED AST2600, сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Применены два блока питания мощностью 2400 Вт с сертификатом 80 PLUS Titanium и система воздушного охлаждения. Серверы могут эксплуатироваться при температурах от 0 до +35 °C. |

|