Материалы по тегу: hardware

|

10.09.2025 [17:29], Сергей Карасёв

CoreWeave сформировала венчурное подразделение для поддержки проектов в области ИИПровайдер облачных услуг для ИИ-задач CoreWeave объявил о создании венчурного подразделения CoreWeave Ventures, которое займётся поддержкой компаний и основателей проектов в области искусственного интеллекта и перспективных вычислительных технологий. Отмечается, что на фоне стремительного развития ИИ спрос на специализированные инструменты и приложения, а также сопутствующую инфраструктуру продолжает расти. CoreWeave Ventures поможет ускорить вывод новых разработок на коммерческий рынок путём предоставления финансирования, технической экспертизы и вычислительных мощностей. Поддержку планируется оказывать по нескольким направлениям. Это, в частности, различные модели капиталовложений, которые помогут компаниям в разработке продуктов и масштабировании операций. Кроме того, CoreWeave будет предоставлять упрощённый доступ к своей облачной платформе, специально оптимизированной для ИИ-нагрузок. Компании также смогут воспользоваться средами тестирования для оценки реальных сценариев использования ИИ-решений. Дополнительно CoreWeave предоставит аналитику стратегий создания продуктов и их вывода на рынок на основе сотрудничества с сотнями предприятий и организаций в сфере ИИ. В целом, CoreWeave Ventures в обмен на акционерный капитал планирует обеспечивать поддержку на протяжении всего жизненного цикла проекта — от начала реализации до выхода на рынок. Новое венчурное подразделение уже сотрудничает с рядом компаний, включая разработчиков больших языковых моделей (LLM) и инфраструктурных решений. Отметим, что во II квартале текущего года CoreWeave получила $1,21 млрд выручки, что в три раза больше по сравнению с результатом годичной давности, когда показатель составлял $395,37 млн. При этом компания понесла чистые убытки в размере $290,51 млн против $323,02 млн во II четверти 2024 года. Более того, CoreWeave продолжает наращивать долги, хотя до конца 2026 года обязана вернуть кредиторам порядка $8 млрд.

10.09.2025 [15:12], Руслан Авдеев

Госзакупки электроники Huawei, Lenovo и HP резко снизилисьПо итогам I полугодия 2025 года в России были организованы 42 госзакупки электроники китайской Huawei на 174,3 млн руб. Это более чем вдвое меньше в сравнении с аналогичным периодом 2024 года, сообщают «Ведомости». Для сравнения, в I полугодии 2024 года речь шла о 97 государственных закупках — общая сумма сделок составила 446,5 млн руб. За тот же период упали закупки и продукции другой китайской компании — Lenovo: со 107 единиц на общую сумму 155,6 млн руб. в I полугодии 2024 года до 65 ед. на сумму 97,7 млн руб. в I полугодии 2025-го. При этом электроники американского производителя HP в I полугодии прошлого года было куплено 260 ед. на 1,1 млрд руб., хотя номенклатура товаров не раскрывается. Спад коснулся и этих закупок — до 94 ед. (628,8 млн руб.). Впрочем, наблюдается общее снижение всех госзакупок в стране, что коснулось и зарубежных, и отечественных производителей.

Источник изображения: Dmitry Rodionov/unspalsh.com По словам представителя поисково-аналитической системы «Тендерплан», сокращение наблюдается как в штучном, так и в денежном измерениях. В целом в I полугодии 2024 года было приобретено 11,7 тыс. ед. электроники на сумму 37,4 млрд руб. В 2025 году оно упало на 16 % год к году до 9,8 тыс. В денежном выражении они сократились до 27,3 млрд руб. — на 27 % меньше год к году. Стоит отметить, что в конце августа российские производители предложили ужесточить т.н. правило «второй лишний» — если хотя бы один производитель из РФ, продающий продукцию из реестра российской электроники, участвует в тендере, остальные заявки с иностранными товарами отклоняются — из-за нарушений при проведении тендеров заказчиками на фоне роста локализации продуктов в стране. Впрочем, по мнению экспертов, если для компаний решения российского производства не станут более привлекательными, новые меры лишь увеличат нагрузку на бюджет. Пока неизвестно, как такие ограничения, если их введут, могут повлиять на дальнейшие закупки и их масштабы.

10.09.2025 [13:35], Сергей Карасёв

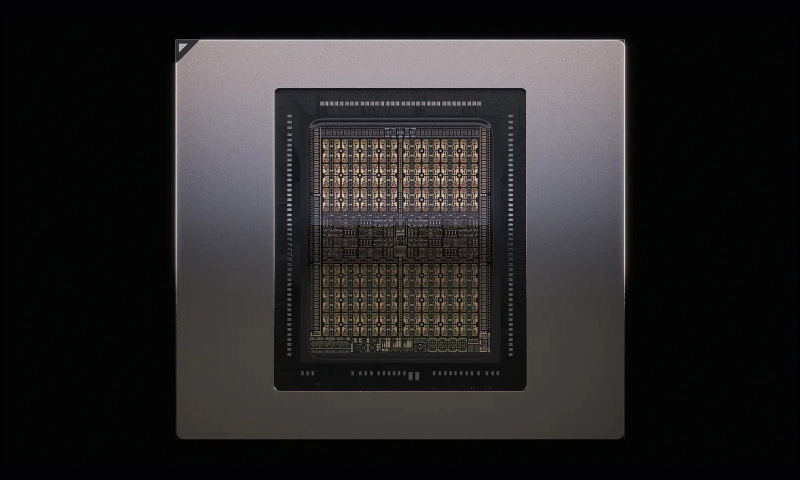

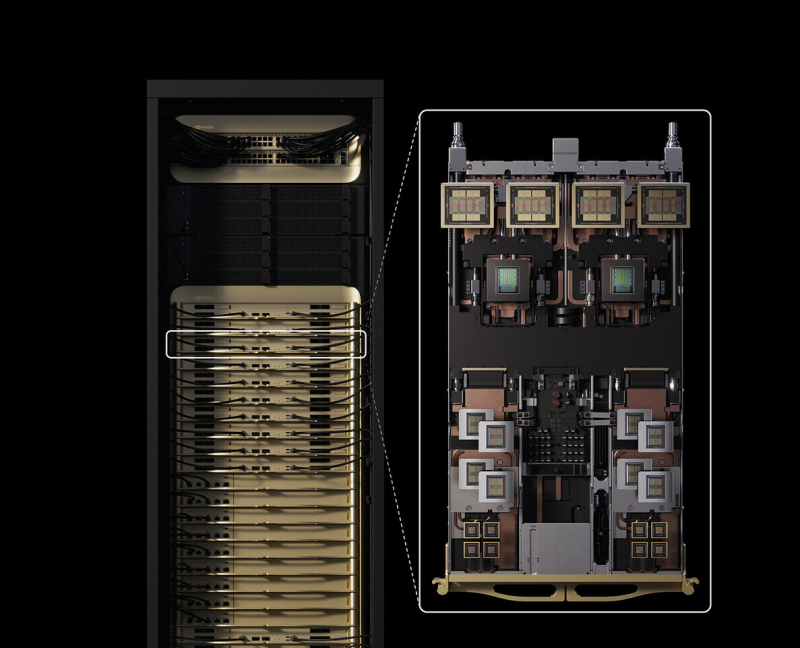

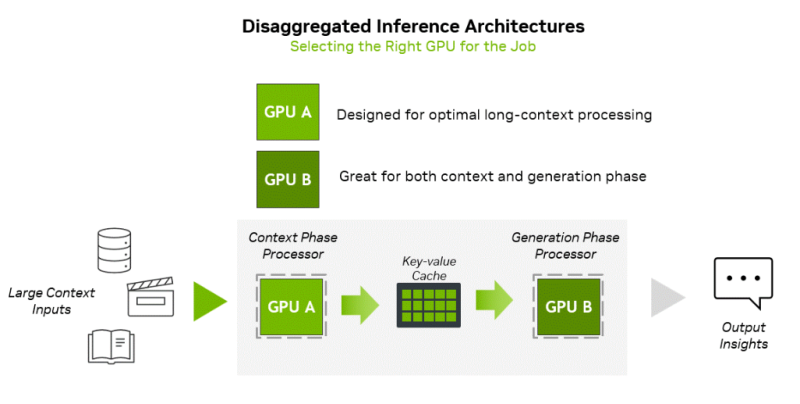

NVIDIA представила соускоритель Rubin CPX со 128 Гбайт GDDR7 для масштабных задач ИИ-инференсаNVIDIA неожиданно анонсировала чип Rubin CPX — GPU нового класса, спроектированный для масштабных задач ИИ-инференса и работы с моделями, использующими длинный контекст. Поставки решения планируется организовать в конце 2026 года. Чип Rubin CPX выполнен в виде монолитного кристалла и оснащён 128 Гбайт памяти GDDR7. Заявленная ИИ-производительность достигает 30 Пфлопс в режиме NVFP4. Предусмотрены по четыре блока NVENC и NVDEC для кодирования и декодирования видеоматериалов. Новинка дополнит другие ускорители компании. Оркестрацией нагрузок будет заниматься платформа NVIDIA Dynamo, распределяющая нагрузки между подходящими для каждой задачи ускорителями. Изделие Rubin CPX предназначено для использования вместе с Arm-процессорами Vera и ускорителями Rubin в составе новой стоечной платформы NVIDIA Vera Rubin NVL144 CPX. Эта система будет объединять 144 чипа Rubin CPX, 144 чипа Rubin и 36 процессоров Vera (88 кастомных 3-нм Arm-ядер). Говорится об использовании суммарно 100 Тбайт памяти с агрегированной пропускной способностью 1,7 Пбайт/с. Общая производительность на операциях NVFP4 — до 8 Эфлопс, что примерно в 7,5 раза больше по сравнению с системами NVIDIA GB300 NVL72. Задействована система жидкостного охлаждения. Кроме того, NVIDIA планирует выпуск двухстоечного решения, включающего стойку Vera Rubin NVL144 CPX и «обычную» стойку Vera Rubin NVL144. «Платформа Vera Rubin ознаменует собой новый скачок производительности в области вычислений ИИ, предлагая как GPU следующего поколения Rubin, так и чип нового класса CPX. Это первый CUDA GPU, специально разработанный для ИИ с длинным контекстом, когда модели одновременно обрабатывают миллионы токенов», — отмечает Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA. Основная задача Rubin CPX — работа с контекстом в больших моделях и создание KV-кеша. Эта операция ограничена вычислительными способностями чипа, тогда как генерация токенов зависит уже от пропускной способности памяти и интерконнекта для быстрого обмена данными. NVIDIA предложила разделить эти этапы и на аппаратном уровне. CPX лишён HBM, зато операции возведения в степень он делает втрое быстрее, чем Blackwell Ultra.

10.09.2025 [12:44], Сергей Карасёв

В облаке Vultr по всему миру стали доступны ускорители AMD Instinct MI355XЧастный облачный провайдер Vultr объявил о том, что в его глобальной инфраструктуре стали доступны ускорители AMD Instinct MI355X, официально представленные в июне нынешнего года. Утверждается, что эти изделия устанавливают новый стандарт соотношения цены и производительности для ресурсоёмких ИИ-задач, в частности, инференса. Решение Instinct MI355X построено на архитектуре AMD CDNA 4-го поколения. Устройство располагает 288 Гбайт памяти HBM3E, пропускная способность которой достигает 8 Тбайт/с. Применяется жидкостное охлаждение. Упомянута поддержка программного стека AMD ROCm. На сайте Vultr говорится, что теоретическая производительность ИИ при использовании в конфигурации 8 × Instinct MI355X OAM достигает 20,1 Пфлопс в режиме FP16, 40,3 Пфлопс на операциях INT8/FP8 и 80,5 Пфлопс в режиме FP4. При развёртывании ускорителей Instinct MI355X в своём облаке Vultr тесно сотрудничала с AMD и Supermicro. Благодаря 32 облачным регионам на шести континентах Vultr гарантирует низкую задержку и высокую доступность вычислительных мощностей. Стоимость услуг, как утверждается, ниже по сравнению с аналогичными предложениями гиперскейлеров. Ускорители Instinct MI355X подходят не только для инференса и обучения ИИ-моделей, но и для других нагрузок HPC, таких как симуляции, сложное моделирование или обработка больших массивов данных.

10.09.2025 [12:25], Сергей Карасёв

QNAP представила сетевые хранилища серии QuNAS на базе Intel Twin LakeКомпания QNAP Systems анонсировала сетевые хранилища семейства QuNAS, ориентированные на применение в сфере малого и среднего бизнеса. В серию вошли модели Qu805, Qu605 и Qu405, рассчитанные соответственно на восемь, шесть и четыре накопителя формата LFF или SFF с интерфейсом SATA-3. В основу новинок, выполненных в «настольном» форм-факторе, положена аппаратная платформа Intel Twin Lake. В зависимости от модификации задействован чип Intel Processor N150 (четыре ядра; до 3,6 ГГц; 6 Вт) или Core i3-N355 (восемь ядер; до 3,9 ГГц; 15 Вт). В состав этих изделий входит ускоритель Intel UHD Graphics. Объём оперативной памяти LPDDR5 составляет 8 или 16 Гбайт (один слот для модуля SO-DIMM). В оснащение NAS также входит флеш-модуль eMMC вместимостью 8 Гбайт. Отсеки для накопителей у устройств располагаются во фронтальной части; допускается горячая замена. Кроме того, предусмотрены два внутренних коннектора M.2 2280 для NVMe SSD с интерфейсом PCIe 3.0 x1. Хранилища наделены двумя сетевыми портами 2.5GbE с гнёздами RJ45, двумя портами USB 3.2 Gen2 Type-A и одним портом USB 3.2 Gen2 Type-C (на лицевой панели), а также интерфейсом HDMI 2.1 с поддержкой видео с разрешением до 4096 × 2160 пикселей (60 Гц). Габариты модели Qu805 составляют 165 × 217 × 285 мм, масса — 3,1 кг (без установленных накопителей). Версии Qu605 и Qu405 имеют размеры соответственно 165 × 217 × 226 и 165 × 217 × 168 мм и весят 2,52 и 2,15 кг. Диапазон рабочих температур — от 0 до +40 °C. Питание обеспечивает внешний адаптер мощностью 96–150 Вт.

10.09.2025 [09:46], Руслан Авдеев

Data4 получит от французских АЭС 40 МВт для своих ЦОДНа фоне неослабевающего спроса на электричество для дата-центров европейский оператор ЦОД Data4 заключил с государственной компания Électricité de France (EDF) 12-летний контракт на поставку с 2026 года 40 МВт от французских АЭС, сообщает The Register. Это первый в стране долговременный договор Nuclear Production Allocation Contract (CAPN), позволяющий получать энергию по цене, не зависящей от волатильности рынков. Он дополнит имеющиеся долгосрочные соглашения о закупке солнечной и ветряной энергии (PPA) Data4 управляет дата-центрами во Франции, Испании, Польше, Германии и Греции. По расчётам экспертов, она владеет не менее 1,5 ГВт мощностей. Заключение контракта CAPN — часть более широкой стратегии Data4 по интеграции во все свои операции низкоуглеродной и возобновляемой энергии с повышением устойчивости эксплуатации ЦОД. Многие компании в Европе и за её пределами уже начали требовать от поставщиков энергии данные об экоустойчивости в рамках локальных нормативов, вроде европейской директивы CSRD. В Data4 сообщают, что в сочетании с PPA новый контракт гарантирует экоустойчивый, надёжный и постоянный доступ к «низкоуглеродной» энергии по контролируемой цене. Франция может считаться идеальной страной для подобного соглашения, поскольку порядка 70 % электричества здесь вырабатывается именно АЭС. Кроме того, как заявляют в EDF, инициатива полностью соответствует обязательствам государственной корпорации по поддержке развития ЦОД и обеспечению энергетического и промышленного суверенитета страны.

Источник изображения: Jametlene Reskp/unsplash.com Ранее EDF предложила операторам дата-центров доступ к собственным землям для строительства новых кампусов ЦОД с «благоприятными условиями» для подключения к электросетям, что позволит ускорить ввод проектов в эксплуатацию на несколько лет. EDF также выступила в числе партнёров строительства гигантского ИИ ЦОД близ Парижа. Комплекс мощностью 1,4 ГВт — проект совместного предприятия NVIDIA, Mistral AI, Французского национального инвестиционного банка и инвестиционного фонда MGX из ОАЭ. Кроме того, от АЭС запитают и 1-ГВт кампус Fluidstack. АЭС сегодня рассматриваются, как способ удовлетворить растущие энергетические потребности индустрии ЦОД. По мнению некоторых экспертов, ядерная энергетика будет поддерживать мировой энергетический баланс ещё долгие годы, но масштабные инвестиции в эту отрасль не решают ключевой проблемы — на строительство АЭС уходит много времени, а потребности ИИ в электричестве растут уже сейчас. В марте 2025 года сообщалось, что Amazon, Meta✴ и Google совместно с крупнейшими мировыми компаниями и банками помогут утроить мощность АЭС во всём мире уже к 2050 году.

09.09.2025 [23:00], Руслан Авдеев

Fermi America, стоящая за мегапроектом 11-ГВт ИИ ЦОД HyperGrid с питанием от АЭС, собралась на биржу

fermi america

hardware

ipo

westinghouse

аэс

ии

полезные ископаемые

сша

финансы

цод

электропитание

энергетика

Стоящая за проектом строительства 11-ГВт кампуса ИИ ЦОД HyperGrid в Амарилло (Техас) Fermi America подала заявку на IPO. Она намерена разместить обыкновенные акции на бирже Nasdaq Global Select Market, но их количество и ценовой диапазон пока не определены, сообщает пресс-служба компании. UBS Investment Bank, Cantor и Mizuho станут главными андеррайтерами, а Macquarie Capital, Stifel и Truist Securities — дополнительными. По данным Datacenter Dynamics, Fermi работает над Project Matador, в рамках которого и предполагается построить 11-ГВт кампус площадью 167 га. В проекте участвует объединение технических университетов штата (Texas Tech University System). Кампус построят на территории Техасского технологического университета (Texas Tech University, TTU). Сооснователем компании является бывший министр энергетики и бывший губернатор Техаса Рик Перри (Rick Perry). Ввод в эксплуатацию первой очереди на 1 ГВт запланирован на конец 2026 года, но само строительство ещё не начато. Fermi будет использовать локальные источники энергии, включая газовые, солнечные и ветряные электростанции. В июле компания приобрела более 600 МВт мощностей в рамках двух сделок — в том числе девять газовых генераторов, которые в 2026 помогут получть ЦОД до 1 ГВт. Впрочем, газовые турбины будут основным источником энергии лишь в краткосрочной перспективе — Fermi намерена разместить на площадке четыре PWR-реактора Westinghouse AP1000 поколения III+ c электрической мощностью около 1,1 ГВт. Fermi и Westinghouse подали регуляторам совместную заявку Combined Operating License Application (COLA), чтобы ускорить получение разрешений.

Источник изображения: Fermi America Параллельно Fermi подписала два других «атомных» соглашения — меморандумы о взаимопонимании с южнокорейскими Hyundai и Doosan Enerbility, поскольку есть риск не уложиться в сроки и бюджеты. Последний энергоблок AP1000 заработал в США в 2023 году, на семь лет позже запланированного. На АЭС ушло на $17 млрд больше запланированного, причём сама Westinghouse в процессе строительства прошла через банкротство. В сентябре Fermi успешно привлекла $100 млн в раунде финансирования серии C, который возглавила австралийская Macquarie Group. Последняя также открыла для Fermi кредитную линию на $250 млн. Это не первая компания, предложившая концепцию прямого питания ЦОД от АЭС. AWS потратила $650 млн, чтобы приобрести кампус около АЭС Susquehanna. Microsoft намерена возродить АЭС Three Mile Island, Мета✴ выкупила всю энергию АЭС Clinton Clean Energy Center на 20 лет вперёд, а Oracle объявила о намерении развернуть три SMR общей мощностью более 1 ГВт.

09.09.2025 [17:50], Сергей Карасёв

Бескабельные серверы и стойки Softbank помогут роботам вытеснить людей из ЦОДКорпорация SoftBank объявила о разработке новой стойки для серверов без кабелей. Это поможет в организации обслуживания ЦОД при помощи специализированных роботов. Стойка упрощает выполнение таких задач, как установка и демонтаж модулей, замена компонентов в случае неисправности и проведение автоматизированных проверок. В современных ЦОД большое количество кабелей внутри серверных стоек является серьёзным препятствием для выполнения тех или иных работ с использованием роботов. Из-за плотной кабельной сети затрудняется точное определение и управление целевым оборудованием в стойке, что негативно отражается на возможностях автоматизации обслуживания. Для решения данной проблемы SoftBank разработала серверную стойку с «бескабельной конструкцией».

Источник изображений: SoftBank Новинка имеет ширину 19″: она выполнена в соответствии со стандартом OCP ORv3 (Open Rack v3). Говорится о совместимости с системами жидкостного охлаждения. Стойка рассчитана на монтаж серверов общего назначения. Питание подаётся по общей шине на задней стороне стойки. В системе охлаждения используется «слепой разъём», упрощающий соединение магистралей СЖО. Для передачи данных служит оптический интерфейс. Таким образом, при установке серверы могут просто задвигаться в стойку без необходимости подключения кабелей.  В настоящее время SoftBank готовится к тестированию стоек в реальных условиях с использованием специализированных роботов для обслуживания. Проект является частью программы SoftBank по внедрению автоматизации в дата-центре для задач ИИ на острове Хоккайдо, открытие которого запланировано на 2026 финансовый год. Нужно отметить, что робототехнические комплексы для выполнения рутинных задач в ЦОД тестируют и многие другие компании. В их число входят Google, Digital Edge, Digital Realty, Scala Data Centers и Oracle. Правда, пока речь идёт в основном о патрулировании и выполнении некоторых простейших с точки зрения человека операций.

09.09.2025 [17:00], Владимир Мироненко

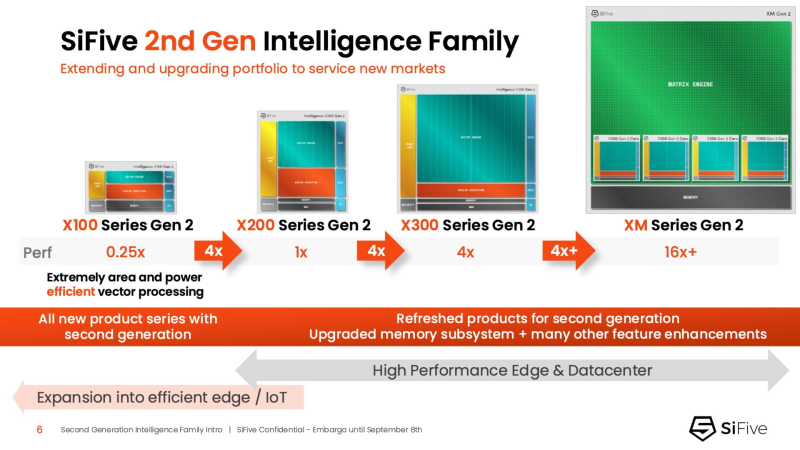

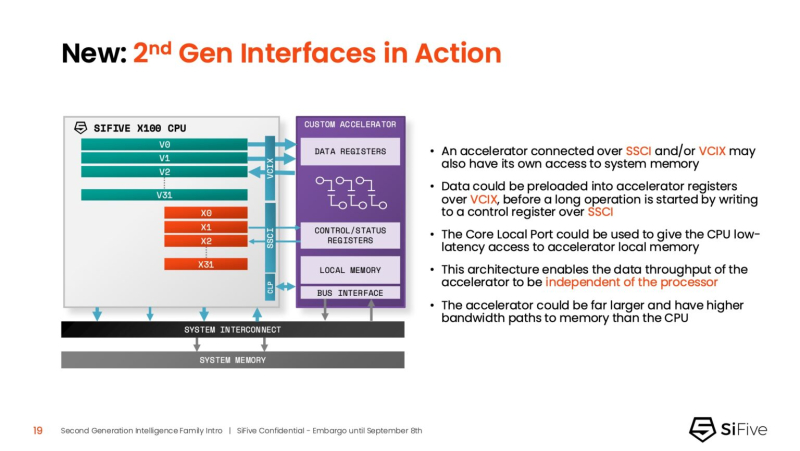

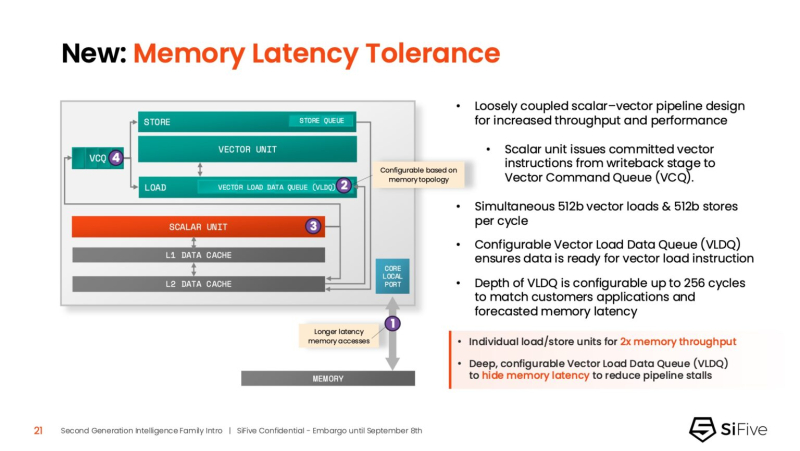

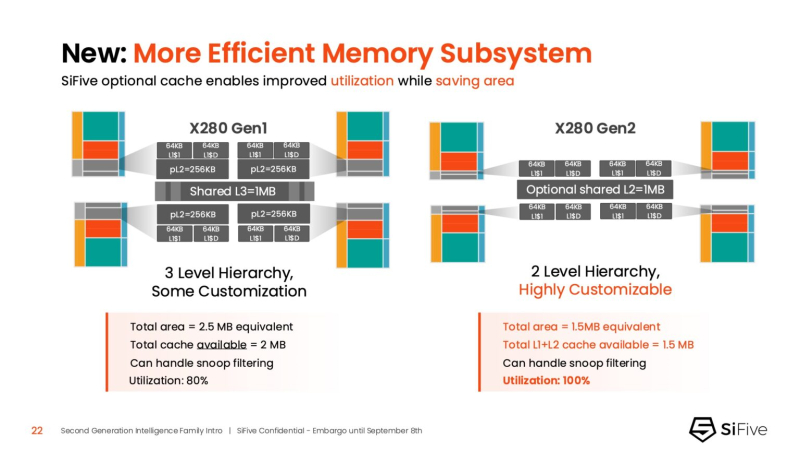

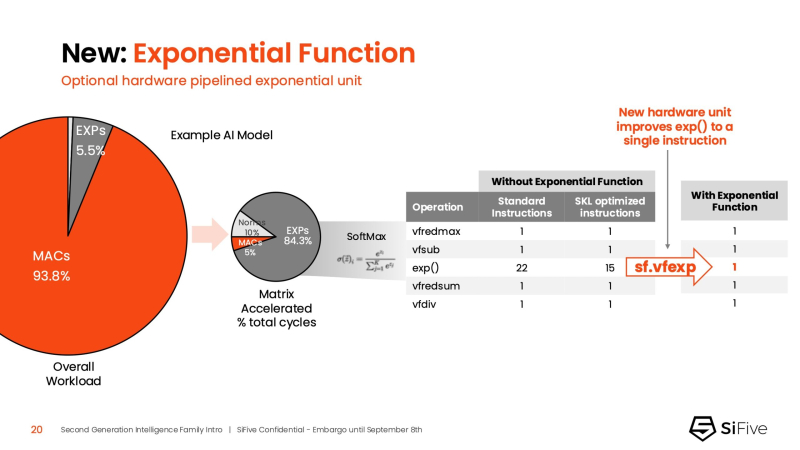

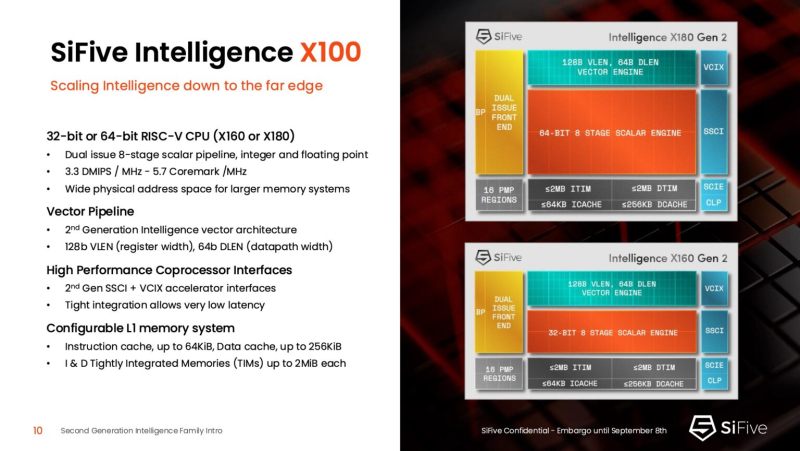

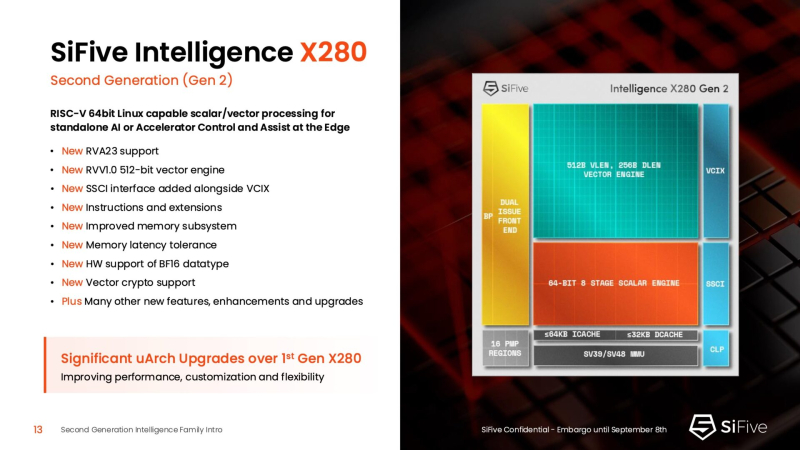

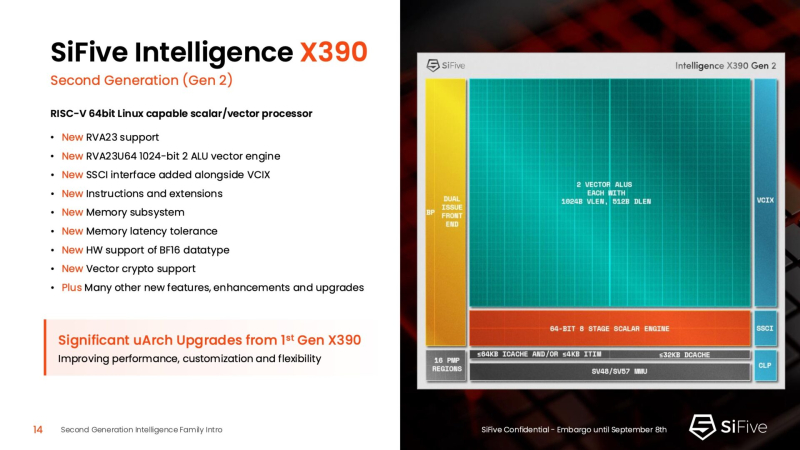

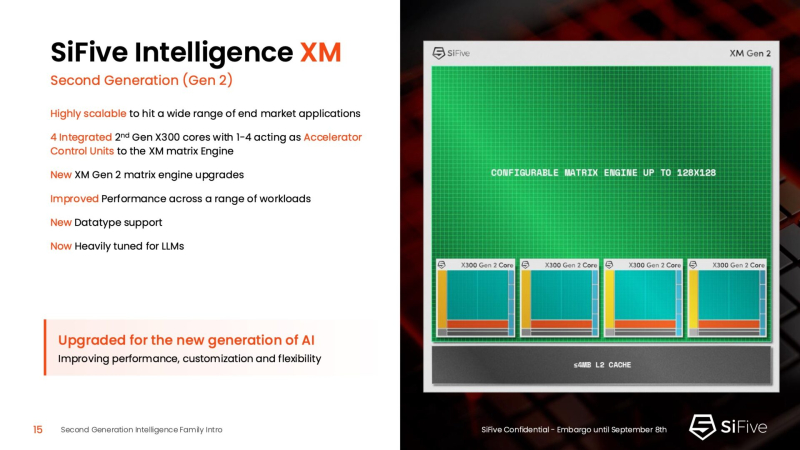

Быстрее и «умнее»: SiFive представила второе поколени RISC-V-ядер IntelligentSiFive представила семейство ядер Intelligent второго поколения с архитектурой RISC-V, включающее новые ядра X160 Gen 2 и X180 Gen 2, а также обновлённые решения X280 Gen 2, X390 Gen 2 и XM Gen 2. Новые решения разработаны для расширения возможностей скалярной, векторной и, в случае серии XM, матричной обработки данных, адаптированных для современных задач в сфере ИИ. Как отметил ресурс EE Times, анонсируя новую линейку продуктов, SiFive стремится воспользоваться быстрорастущим спросом на решения для обработки ИИ-нагрузок, который, по прогнозам Deloitte, вырастет как минимум на 20 % во всех технологических средах, включая впечатляющий скачок на 78 % в сфере периферийных вычислений с использованием ИИ. Ядра SiFive второго поколения позволяют решать критически важные задачи в области внедрения ИИ, в частности, в области управления памятью и ускорения нелинейных функций. Ключевым нововведением в процессорах серии X является их способность функционировать в качестве блока управления ускорителем (ACU). Это позволяет ядрам SiFive обеспечивать основные функции управления и поддержки для ускорителя заказчика через интерфейсы SiFive Scalar Coprocessor Interface (SSCI) и Vector Coprocessor Interface eXtension (VCIX). Данная архитектура позволяет заказчикам сосредоточиться на инновациях в обработке данных на уровне платформы, оптимизируя программный стек. Джон Симпсон (John Simpson), главный архитектор SiFive, сообщил ресурсу EE Times, что интеллектуальные ядра SiFive обеспечивают гибкость, сокращают трафик системной шины за счёт локальной обработки на чипе ускорителя и обеспечивают более тесную связь для задач пред- и постобработки. Он рассказал, что SiFive представила два важных усовершенствования в архитектуре, которые напрямую устраняют узкие места производительности: устойчивость к задержкам памяти и более эффективную подсистему памяти. Функцию Memory Latency Tolerance позволяет снизить задержку загрузки. Симпсон рассказал, что блок скалярных вычислений, обрабатывающий все инструкции, отправляет векторные инструкции в очередь векторных команд (VCQ). При обнаружении такого инструкции одновременно отправляется запрос в подсистему памяти (кеш L2 или выше). Ранняя отправка запросов, отделённая от исполнения, позволяет быстрее получить ответ от памяти и поместить его в переупорядочиваемую настраиваемую очередь загрузки векторных данных (VLDQ). Это гарантирует готовность данных к моменту, когда инструкция в конечном итоге покинет VCQ, что приводит к «загрузке вектора в течение одного цикла». Симпсон подчеркнул конкурентное преимущество решения, отметив: «Xeon, представленный на Hot Chips, может обслуживать 128 невыполненных запросов, и это топовый показатель для Xeon, а в нашем четырёхъядерном процессоре этот показатель составляет 1024». Эта «прекрасная технология» обеспечивает непрерывную обработку данных, эффективно предотвращая простои конвейера. Более эффективная подсистема памяти, которая представляет собой ещё одно существенное обновление, основана на переходе от инклюзивной к неинклюзивной иерархии кешей. В инклюзивной системе кеширования предыдущего поколения данные из общего кеша L3 реплицировались в частные кеши L1/L2, что компания посчитала неэффективным расходом «кремния». Конструкция ядер второго поколения исключает копирование, что, по словам Симпсона, даёт «в 1,5 раза большую производительность по сравнению с первым поколением» при меньшей занимаемой площади на кристалле. SiFive также интегрировала новый аппаратный конвейерный экспоненциальный блок. В то время как MAC-операции доминируют в рабочих ИИ-нагрузках, возведение в степень становится следующим серьёзным узким местом. Например, в BERT LLM, ускоренных матричным движком, операции softmax, включающие возведение в степень, занимают более 50 % оставшихся циклов. Программными оптимизациями SiFive сократила выполнение функции возведения в степень с 22 до 15 циклов, а новый аппаратный блок сокращает её до одной инструкции, уменьшая общее время выполнения функции до пяти циклов. Программный стек для семейства Intelligence второго поколения поддерживает масштабируемость. В серии XM среда выполнения машинного обучения уже распределяет рабочие нагрузки между несколькими кластерами XM на одном кристалле. Впрочем, пока масштабирование за пределы одного кристалла требует дальнейшей разработки библиотеки межпроцессорного взаимодействия (IPC). Флагманские решения X160 Gen 2 и X180 Gen 2 могут быть настроены для работы под управлением операционной системы реального времени, пишет SiliconANGLE. 32-бит IP-ядро Intelligence X160 разработано для оптимизации энергоэффективности и приложений с жесткими ограничениями по площади кристалла, в то время как 64-бит IP-ядро Intelligence X180 обеспечивает более высокую производительность и лучшую интеграцию с более крупными подсистемами памяти, сообщил ресурс CNX-Software. X160 поставляется с кеш-памятью объёмом до 200 КиБ и памятью объёмом 2 МиБ. Помимо промышленного оборудования, ядро может найти применение в потребительских устройствах, таких как фитнес-трекеры. Кроме того, X160 можно установить в системах с несколькими ИИ-ускорителями для управления чипами и предотвращения изменения прошивки. Благодаря двум встроенным кешам общей ёмкостью более 4 МиБ ядро позволяет работать с большим объёмом данных. По данным SiFive, X160 подходит для обучения ИИ-моделей и использования в оборудовании ЦОД. В свою очередь, ядро X280 ориентировано на потребительские устройства, такие как гарнитуры дополненной реальности, а X390 также может использоваться в автомобилях и инфраструктурных системах. Последнее ядро выполняет векторную обработку в четыре раза быстрее, чем X280. Все пять продуктов Intelligence Gen 2 уже доступны для лицензирования, а появление первых чипов на их основе ожидается во II квартале 2026 года. SiFive сообщила, что два ведущих американских производителя полупроводников лицензировали новую серию X100 ещё до её публичного анонса. Они используют IP-ядро X100 в двух различных сценариях: одна компания задействует сочетание скалярного векторного ядра SiFive с матричным движком, выступающим в качестве блока управления ускорителем, а вторая использует векторный движок в качестве автономного ИИ-ускорителя.

09.09.2025 [12:25], Сергей Карасёв

Microsoft присоединилась к Всемирной ядерной ассоциацииКорпорация Microsoft, по сообщению ресурса Datacenter Dynamics, присоединилась к Всемирной ядерной ассоциации (WNA) — международной некоммерческой организации со штаб-квартирой в Лондоне, которая занимается продвижением ядерной энергетики. World Nuclear Association была основана в 2001 году. Её основными направлениями деятельности являются поддержка передовых ядерных технологий, таких как малые модульные реакторы, содействие упрощению процессов лицензирования и укрепление глобальных цепочек поставок в области атомной энергетики. На сайте WNA говорится, что на сегодняшний день в состав ассоциации входят компании и организации, базирующиеся в 44 странах по всему миру. Это, в частности, крупные предприятия в области атомного машиностроения, строительства и обращения с отходами, а также научно-исследовательские и опытно-конструкторские учреждения. В числе участников WNA значатся Accenture, CEZ, Constellation Energy, EDF, GE Vernova, Iberdrola, Oklo, PG&E и многие другие.

Источник изображения: WNA «Членство Microsoft в ассоциации — это переломный момент для отрасли. Участие корпорации ускорит внедрение ядерной энергетики в масштабах, необходимых как для достижения климатических целей, так и для удовлетворения растущего спроса на энергию со стороны дата-центров», — говорит доктор Сама Бильбао-и-Леон (Sama Bilbao y León), генеральный директор WNA. Сообщается, что подразделение по энергетическим технологиям Microsoft будет напрямую сотрудничать с техническими рабочими группами WNA с целью ускорения внедрения ядерной энергетики, оптимизации процессов регулирования и разработки новых коммерческих моделей. Конечная цель заключается в том, чтобы масштабировать ядерную энергетику для удовлетворения растущих потребностей цифровой экономики, в том числе в сегменте ЦОД. Microsoft развивает ряд проектов в области ядерной энергетики. Ранее сообщалось, что редмондская корпорация формирует команду для работы над малыми атомными реакторами для питания дата-центров. Кроме того, Microsoft заключила 20-летний контракт с крупнейшим в США оператором АЭС Constellation Energy на поставку электроэнергии, которая будет производиться на площадке Three Mile Island в Пенсильвании. При этом Microsoft надеется, что ИИ ускорит разработку экономически эффективных коммерческих термоядерных реакторов, которые смогут обеспечить энергией крупные ЦОД. |

|