Материалы по тегу: amd

|

02.05.2025 [13:55], Сергей Карасёв

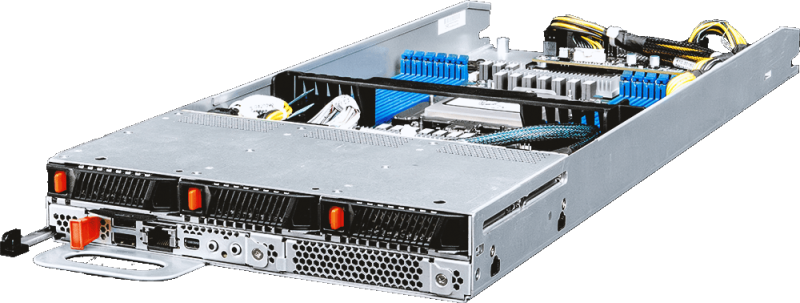

MSI представила многоузловые OCP-серверы на базе AMD EPYC 9005 TurinКомпания MSI анонсировала многоузловые серверы высокой плотности, выполненные в соответствии со стандартом OCP ORv3 (Open Rack v3). Дебютировали модели Open Compute CD281-S4051-X2 и Core Compute CD270-S4051-X4 на аппаратной платформе AMD EPYC 9005 Turin. Решение Open Compute CD281-S4051-X2, выполненное в форм-факторе 2OU, представляет собой двухузловой сервер для инфраструктур гиперскейлеров. Каждый узел может оснащаться одним процессором EPYC 9005 с показателем TDP до 500 Вт и 12 модулями DDR5. Доступны до 12 посадочных мест для накопителей E3.S с интерфейсом PCIe 5.0 (NVMe). Говорится о поддержке CPU-радиаторов Extended Volume Air Cooling (EVAC) и 48-вольтной архитектуры питания ORv3 (48VDC). В свою очередь, Core Compute CD270-S4051-X4 (S4051D270RAU3-X4) — это четырёхузловой сервер стандарта Data Center Modular Hardware Systems (DC-MHS). Устройство имеет типоразмер 2U. Оно подходит для облачных вычислений, CDN-сетей, ИИ-инференса и машинного обучения, виртуализации сетевых функций, телеком-приложений и пр. Каждый узел новинки рассчитан на один чип EPYC 9005 с TDP до 400 Вт. Есть 12 слотов для модулей DDR5-6000 RDIMM/RIMM-3DS суммарным объёмом до 3 Тбайт, три фронтальных отсека для накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe), два внутренних коннектора M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x2 (NVMe), а также слот PCIe 5.0 x16 OCP 3.0. Кроме того, каждый узел располагает контроллером ASPEED AST2600, сетевым портом управления 1GbE, разъёмами USB 2.0 Type-A и Mini DisplayPort, последовательным портом (USB Type-A). Вся система Core Compute CD270-S4051-X4 оборудована двумя блоками питания мощностью 2700 Вт с сертификатом 80 PLUS Titanium. Установлены четыре вентилятора охлаждения с возможностью горячей замены. Диапазон рабочих температур — от 0 до +35 °C. Габариты составляют 448 × 87 × 747 мм.

02.05.2025 [13:50], Сергей Карасёв

MiTAC анонсировала OCP-серверы на основе AMD EPYC Turin с воздушным и жидкостным охлаждением, а также edge-сервер на базе Intel Xeon Sapphire RapidsКомпания MiTAC Computing Technology представила OCP-серверы нового поколения C2810Z5 и C2820Z5, предназначенные для приложений ИИ и НРС. Устройства выполнены на аппаратной платформе AMD EPYC 9005 Turin. Решение C2810Z5 типоразмера 2OU имеет двухузловую конструкцию. Каждый узел допускает установку одного процессора и 12 модулей оперативной памяти DDR5-6400. Доступны шесть отсеков для накопителей U.2 и два посадочных места для SSD стандарта E1.S. Предусмотрены слоты PCIe 5.0 x16 для карт FHHL, HHHL и OCP NIC 3.0. Устройство оснащено воздушным охлаждением. Данная модель подходит для развёртывания микросервисов в облачных средах. В свою очередь, вариант C2820Z5 — это четырёхузловая система 2OU с технологией прямого жидкостного охлаждения. Каждый узел поддерживает два процессора EPYC 9005 Turin и 24 модуля памяти DDR5. Сервер подходит для высокопроизводительных вычислений. Кроме того, MiTAC анонсировала семейство серверов Whitestone 2 (WS2): это, как утверждается, компактная, но мощная платформа, специально оптимизированная для сетей Open RAN и периферийных задач. Система выполнена в корпусе небольшой глубины формата 1U. Задействован процессор Intel Xeon поколения Sapphire Rapids. Предусмотрены восемь слотов для модулей DDR5. Во фронтальной части находятся четыре порта 25GbE SFP28 и восемь портов 10GbE SFP+. Говорится о поддержке IEEE 1588 v2, Sync-E и GPS для синхронизации. В тыльной части располагаются вентиляторы охлаждения в виде девяти сдвоенных блоков.

28.04.2025 [14:48], Сергей Карасёв

ИИ-суперкомпьютер в чемодане — GigaIO Gryf обеспечит производительность до 30 ТфлопсКомпания GigaIO объявила о доступности системы Gryf — так называемого ИИ-суперкомпьютера в чемодане, разработанного в сотрудничестве с SourceCode. Это сравнительно компактное устройство, как утверждается, обеспечивает производительность ЦОД-класса для периферийных развёртываний. Первая информация о Gryf появилась около года назад. Устройство выполнено в корпусе с габаритами 228,6 × 355,6 × 622,3 мм, а масса составляет примерно 25 кг. Система может эксплуатироваться при температурах от +10 до +32 °C. Конструкция предусматривает использование модулей Sled четырёх типов: это вычислительный узел Compute Sled, блок ускорителя Accelerator Sled, узел хранения Storage Sled и сетевой блок Network Sled. Доступны различные конфигурации, но суммарное количество модулей Sled в составе Gryf не превышает шести. Плюс к этому в любой комплектации устанавливается модуль питания с двумя блоками мощностью 2500 Вт. Узел Compute Sled содержит процессор AMD EPYC 7003 Milan с 16, 32 или 64 ядрами, до 512 Гбайт DDR4, системный SSD формата M.2 (NVMe) вместимостью 512 Гбайт и два порта 100GbE QSFP56. Блок Storage Sled объединяет восемь накопителей NVMe SSD E1.L суммарной вместимостью до 492 Тбайт. Модуль Network Sled предоставляет два порта QSFP28 100GbE и шесть портов SFP28 25GbE. За ИИ-производительность отвечает модуль Accelerator Sled, который может нести на борту ускоритель NVIDIA L40S (48 Гбайт), H100 NVL (94 Гбайт) или H200 NVL (141 Гбайт). В максимальной конфигурации быстродействие в режиме FP64 достигает 30 Тфлопс (3,34 Пфлопс FP8), а пропускная способность памяти — 4,8 Тбайт/с.

Источник изображения: GigaIO Архитектура новинки обеспечивает возможность масштабирования путём объединения в единый комплекс до пяти экземпляров Gryf: в общей сложности можно совместить до 30 модулей Sled в той или иной конфигурации. Заказы на Gryf уже поступили со стороны Министерства обороны США, американских разведывательных структур и пр.

18.04.2025 [12:18], Сергей Карасёв

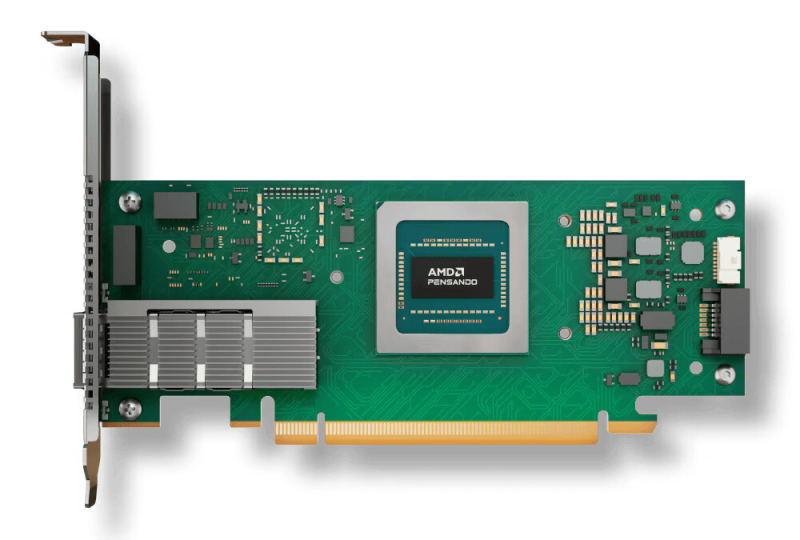

AMD выпустила DPU Pensando Pollara 400 для ИИ-инфраструктур с поддержкой Ultra EthernetКомпания AMD объявила о доступности DPU Pensando Pollara 400 AI NIC, первая информация о котором появилась в октябре прошлого года. Решение предназначено для построения высокопроизводительной ЦОД-инфраструктуры, ориентированной на рабочие нагрузки ИИ и машинного обучения. По заявлениям AMD, Pensando Pollara 400 — это первая в отрасли полностью программируемая сетевая карта AI NIC, разработанная с учетом стандартов консорциума Ultra Ethernet (UEC). Это обеспечивает максимальную гибкость, включая возможность добавления дополнительных функций. Новинка выполнена в виде низкопрофильной карты расширения половинной длины (HHHL) с интерфейсом PCIe 5.0 x16. Предусмотрен один порт QSFP112 400GbE с возможностью использования в режимах 25/50/100/200GbE. Заявлена поддержка RoCEv2, UEC RDMA, MCTP/SMBus, SPDM over MCTP, MCTP over PCIe VDM, а также шифрования AES-GCM 128/256. Реализованы различные функции, отвечающие за повышение быстродействия и эффективности. В частности, выборочная повторная передача помогает поднять производительность сети благодаря переотправке только потерянных или повреждённых пакетов. Контроль перегрузки с учётом пути даёт возможность оптимизировать производительность с помощью интеллектуальной балансировки нагрузки и автоматического обхода перегруженных маршрутов. Упомянуты также средства быстрого обнаружения неисправностей, инструменты обработки неупорядоченных пакетов и упорядоченной доставки сообщений. В целом, как подчёркивает AMD, благодаря совместимости с открытой экосистемой Pensando Pollara 400 помогает сократить капитальные затраты, не жертвуя при этом производительностью. Заказчики получают богатый набор функций и возможность программирования.

17.04.2025 [13:31], Руслан Авдеев

Сначала NVIDIA, потом AMD: США не позволили продать в Китай ускорители Instinct на $800 млнNVIDIA оказалась не единственным разработчиком чипов, который пострадает от новых торговых санкций, введённых в отношении Китая администрацией США. В минувшую среду AMD заявила, что ожидает «списания» $800 млн — около 16 % выручки серии Instinct за 2024 финансовый год, сообщает The Register. Причина — ограничения на экспорт, введённые США, которые блокируют поставки её ИИ-ускорителей Instinct MI308 в Китай и другие страны, вызывающие «обеспокоенность». Как и в случае с NVIDIA, велика вероятность, что американские власти могут пересмотреть запреты, рассматривая партии поставок в индивидуальном порядке и выдавая экспортные лицензии для MI308 в Китай. При этом AMD отмечает в документе, поданном в Комиссию по ценным бумагам и биржам (SEC), что подать заявки на лицензии компания намерена, но нет никаких гарантий, что они будут одобрены в итоге. Пока же AMD в том же положении, что и NVIDIA, не успевшая распродать запасы ослабленных ускорителей H20 и теперь ожидающая изменения ситуации со складами, полными их запасов. Хотя потенциальные убытки AMD выглядят весьма скромно в сравнении с $5,5 млрд, которые потеряет NVIDIA в результате запрета продаж H20 в Китай и некоторые другие страны без специального разрешения, для AMD в этом приятного всё равно мало. Бизнес рос хорошими темпами со времени дебюта ускорителей MI300X в конце 2023 года.

Источник изображения: AMD Ранее AMD заявляла, что производительность MI300X до 32 % выше в сравнении с NVIDIA H100 в некоторых задачах. Как и NVIDIA, AMD рассчитывала разработать собственную версию ослабленного ускорителя для китайского рынка по аналогии c A800 и H800, а позже H20. Речь шла именно о серии MI308 — правда, о ней практически ничего не известно. Год назад говорилось, что некие урезанные версии Instinct MI309 оказались недостаточно слабы для экспорта в Китай. По-видимому, AMD в MI308 пришлось ещё сильнее снизить производительность и пропускную способность интерфейсов. Хотя возможности NVIDIA и AMD вести дела с Китаем будут серьёзно ограничены в обозримом будущем, компании, возможно, снова смогут доработать существующие модели, дополнительно снизив производительность для обхода ограничений, введённых Министерством торговли США. Intel также готовила отдельную серию ИИ-ускорителей Habana Gaudi3 — к обычным HL-325L, HL-335 и HL-338 были добавлены урезанные HL-328 и HL-388. Впрочем, продажами Habana компания и так не может похвастаться. Также не исключено, что AMD начнёт продвигать MI308 в качестве ускорителя для инференса в странах, куда продавать их по американским законам всё ещё можно. Это позволит хотя бы вернуть часть инвестиций. Нечто подобное произошло с NVIDIA A800. В Китай они не попали, но NVIDIA смогла продать их HP для установки в рабочии станции. Заинтересованность в A800 и H800 также выражала Индия, на которую на тот момент ограничения в основном не распространялись.

15.04.2025 [23:38], Владимир Мироненко

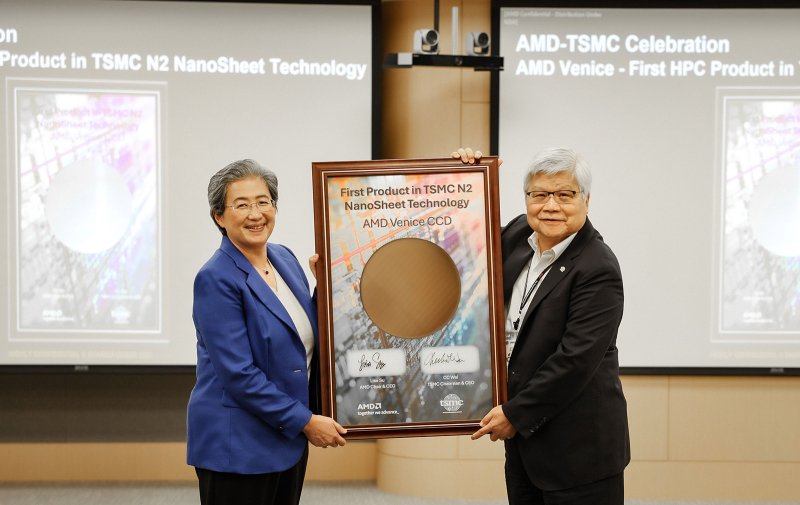

AMD начнёт размещать заказы на производство чипов в СШАAMD впервые в своей новейшей истории начнёт размещать заказы на производство своих чипов в США — на заводе TSMC в Аризоне. Об этом заявила 15 апреля генеральный директор AMD Лиза Су (Lisa Su) в ходе своего визита на Тайвань, где провела встречу с руководством TSMC, а также с другими партнёрами, пишет Reuters. Лиза Су сообщила, что совместно с TSMC был достигнут ряд важных вех, включая успешный пробный выпуск 2-нм чипа. Она также продемонстрировала совместно с генеральным директором TSMC Си-Си Вэем (C.C. Wei) кремниевую пластину с образцами чиплета CCD для серверных процессоров EPYC Venice на архитектуре Zen 6, который будет производиться с использованием 2-нм техпроцесса TSMC N2 — это первый в отрасли продукт для HPC-систем, который будет выпускаться по столь тонкой технологии со следующего года, говорит AMD. AMD также объявила об успешном запуске и валидации AMD EPYC Turin на новой фабрике TSMC в Аризоне. «Наш новый EPYC пятого поколения показал себя очень хорошо, поэтому мы готовы начать производство», — заявила журналистам в Тайбэе Лиза Су. Выпуск чипа начнётся в 2026 году. Правда, самые передовые техпроцессы, включая 2-нм, эта фабрика получит только через несколько лет. Как сообщают ресурсы Anue и TechNews, Лиза Су также заявила, что хотя Тайвань является ключевым регионом в цепочкк поставок AMD, компания наращивает своё присутствие в США. Су отметила, что приобретение ZT Systems за $4,9 млрд стало ключевым шагом для увеличения производства ИИ-серверов на чипах AMD в США: «Мы хотим иметь очень устойчивую цепочку поставок, поэтому Тайвань продолжает оставаться очень важной частью этой цепочки поставок, но Соединённые Штаты также будут важны, и мы расширяем нашу работу там, включая нашу работу с TSMC и другими ключевыми партнёрами». Впоследствии Су также подтвердила намерение «найти стратегического партнёра для [продажи] производственных активов компании ZT Systems». Она не стала вдаваться в подробности, но по данным Bloomberg, Compal Electronics, Wiwynn (Wistron) и Jabil собираются представить предложения по покупке производственных мощностей ZT Systems. Ранее демонстрировавшие интерес к покупке Inventec, которая в итоге продала AMD свою долю в ZT Systems, и Pegatron отказались от дальнейшего участия в борьбе за этот актив, сообщили источники Bloomberg. Сейчас самое подходящее время для AMD для продажи производственных мощностей в США, поскольку многие тайваньские OEM/ODM-вендоры спешат начать строительство заводов в США, чтобы избежать текущих или будущих пошлин, отметил Bloomberg. AMD намерена завершить продажу к концу II квартала. Стоимость сделки оценивается в $3–4 млрд. В свою очередь, NVIDIA объявила в понедельник о планах в течение четырёх следующих лет выпустить в США с помощью производственных партнёров ИИ-платформы на $500 млрд. Сейчас компания строит заводы совместно с Foxconn в Хьюстоне и с Wistron в Далласе. Тайваньские фирмы, включая Foxconn (Hon Hai Precision Industry Co.), полагаются на Мексику как на ключевой центр сборки и производства компонентов ИИ-серверов. После президентских выборов в США в прошлом году Foxconn приобрела землю под новое производствj и пообещала, что вскоре объявит о дополнительных инвестициях в экономику США. А тайваньская Quanta Computer одобрила увеличение уставного капитала своего американского подразделения на $230 млн.

02.04.2025 [12:19], Руслан Авдеев

AMD закрыла сделку по покупке ZT Systems за $4,9 млрдAMD вышла на новый уровень конкуренции с NVIDIA, объявив о завершении сделки по покупке компании ZT Systems, специализирующейся на выпуске серверов, в том числе высокопроизводительных решений для гиперскейлеров. Утверждается, что это позволит объединить «ведущие в индустрии системы» и «компетенции уровня стоек» с передовыми полупроводниковыми технологиями AMD, сообщает портал CRN. Также ожидается, что это приведёт к созданию нового класса комплексных ИИ-решений. В AMD заявили, что сделка стоимостью $4,9 млрд была завершена в понедельник. IT-гигант предложит для совместного бизнеса широкий ассортимент процессоров, ускорителей и сетевых чипов, чтобы вывести на рынок «новый класс ИИ-продуктов». ZT Systems предлагает универсальную вычислительную инфраструктуру, хотя именно производственное направление компании AMD продаст. Прошлым летом было объявлено, что покупка этой компании поможет AMD лучше конкурировать с ИИ-гигантом NVIDIA в сегменте ЦОД, особенно на рынке решений для крупных предприятий и гиперскейлеров.

Источник изображения: ZT Systems Хотя AMD значительно нарастила инвестиции в конкуренцию с продуктами NVIDIA и в последние годы активно развивает ускорители серии Instinct, а также ПО ROCm (Radeon Open Compute) — альтернативу NVIDIA CUDA, её выручка в сфере ИИ пока не сопоставима с показателями NVIDIA. В прошлом году чипы AMD Instinct принесли компании $5 млрд выручки, тогда как доход NVIDIA в бизнесе, связанном с ЦОД и ускорителями, составил $102,2 млрд. В AMD отказались давать прогноз по выручке от Instinct в 2025 году, в отличие от 2024 года. Вместо этого в компании заявили, что этот сегмент позволит получать десятки миллиардов долларов «в ближайшие годы». После завершения сделки команды разработчиков и поддержки ZT Systems будут работать совместно с подразделениями AMD, отвечающими за ЦОД и ИИ-проекты. Отмечается, что приобретение компании позволит партнёрам значительно сократить сроки разработки и внедрения ИИ-систем «кластерного уровня». В компании подчёркивают, что покупка ZT Systems — важный шаг в реализации стратегии AMD по разработке передовых решений для обучения ИИ-моделей и инференса, адаптированных под индивидуальные потребности клиентов. Новые решения будут базироваться на открытой экосистеме, объединяющей «открытое» ПО, корпоративные сетевые технологии, а теперь ещё и системы ZT Systems с их экспертизой в клиентской поддержке. В августе 2024 года ZT Systems оценивалась в $4,9 млрд. Согласно данным Комиссии по ценным бумагам и биржам США (SEC), сделка предусматривала передачу 8,3 млн обычных акций AMD и $3,4 млрд продавцам компании. В документе также указано, что AMD планирует передать им дополнительно 740 961 акцию и $300 млн после выполнения определённых условий. В феврале сообщалось, что выручка AMD в сегменте дата-центров бьёт рекорды, хотя акции компании на тот момент несколько упали в цене.

17.03.2025 [10:21], Сергей Карасёв

MiTAC представила ИИ-серверы на базе Intel Xeon 6 и AMD EPYC 9005/9004Компания MiTAC Computing Technology (подразделение MiTAC Holdings) на конференции Supercomputing Asia 2025 анонсировала серверы G4520G6 и TN85-B8261, построенные на аппаратной платформе Intel и AMD соответственно. Новинки ориентированы на ресурсоёмкие задачи, связанные с ИИ, машинным обучением и НРС-нагрузками. Модель G4520G6 выполнена в форм-факторе 4U: допускается установка двух процессоров Intel Xeon 6700 в исполнении LGA4710 с показателем TDP до 350 Вт. Есть 32 слота для модулей RDIMM/RDIMM-3DS DDR5-5200/6400 и MRDIMM DDR5-8000 суммарным объёмом до 8 Тбайт. Во фронтальной части расположены восемь отсеков для SFF-накопителей NVMe U.2. Кроме того, доступны три внутренних коннектора для SSD формата М.2 22110/2280 с интерфейсом PCIe 4.0. Сервер располагает 11 слотами PCIe 5.0 x16 FHFL и тремя слотами OCP 3.0 (PCIe 5.0 x16). Возможна установка до восьми двуслотовых GPU-ускорителей. Упомянуты контроллер Aspeed AST2600, сетевой порт управления 1GbE (Realtek RTL8211F), разъёмы USB 3.0 (×2), USB 3.2 Gen1 (×2), D-Sub и последовательный порт. Питание обеспечивают четыре блока мощностью 9000 Вт с сертификатом 80 Plus Titanium. Применяется воздушное охлаждение. В свою очередь, модель TN85-B8261 типоразмера 2U может нести на борту два чипа AMD EPYC 9005 Turin или EPYC 9004 Genoa c величиной TDP до 500 Вт. Есть 24 слота для модулей DDR5-6000 суммарным объёмом до 6 Тбайт, восемь посадочных мест для SFF-накопителей NVMe U.2, шесть слотов PCIe 5.0 x16. Могут быть установлены до четырёх двуслотовых GPU-ускорителей полной высоты. Предусмотрены два сетевых порта 10GbE (Intel X550-AT2), выделенный сетевой порт управления 1GbE (Realtek RTL8211F), контроллер Aspeed AST2600, четыре порта USB 3.2 Gen1 и интерфейс D-Sub. Реализовано воздушное охлаждение. Установлены два блока питания мощностью 2700 Вт с сертификатом 80 Plus Titanium. Серверы могут эксплуатироваться при температурах от +10 до +35 °C.

15.03.2025 [14:08], Сергей Карасёв

Supermicro представила GPU-серверы на базе Intel Xeon 6900P и AMD EPYC 9005/9004

amd

b200

emerald rapids

epyc

genoa

granite rapids

hardware

intel

nvidia

sapphire rapids

supermicro

turin

xeon

ии

сервер

Компания Supermicro представила большое количество серверов, рассчитанных на ИИ-задачи, НРС-нагрузки и периферийные вычисления. В частности, дебютировали системы в форм-факторе 10U с возможностью установки восьми ускорителей NVIDIA B200 (SXM): это системы SuperServer SYS-A22GA-NBRT, SuperServer SYS-A21GE-NBRT и A+ Server AS-A126GS-TNBR. Модель SuperServer SYS-A22GA-NBRT рассчитана на два процессора Intel Xeon 6900P семейства Granite Rapids, каждый из которых может насчитывать до 128 ядер (TDP до 500 Вт). Доступны 24 слота для модулей оперативной памяти DDR5-8800 MRDIMM суммарным объёмом до 6 Тбайт. Есть десять фронтальных отсеков для SFF-накопителей с интерфейсом PCIe 5.0 x4 (NVMe) и два коннектора для SSD типоразмера M.2 2280/22110/25110 (PCIe 4.0 x4 NVMe). Предусмотрены десять слотов для карт PCIe 5.0 x16 LP и два слота для карт PCIe 5.0 x16 FHHL. Питание обеспечивают шесть блоков мощностью 5250 Вт. Реализовано воздушное охлаждение. Вариант SuperServer SYS-A21GE-NBRT поддерживает установку двух процессоров Intel Xeon поколения Emerald Rapids или Sapphire Rapids, содержащих до 64 вычислительных ядер (с показателем TDP до 350 Вт). Доступны 32 слота для модулей DDR5-4400/5600 максимальным объёмом 8 Тбайт. Предусмотрены десять отсеков для накопителей SFF (PCIe 5.0 x4 NVMe), два коннектора M.2 2280 (PCIe 3.0 x4 NVMe), восемь слотов PCIe 5.0 x16 LP, два слота PCIe 5.0 x16 FHHL, шесть блоков питания мощностью 5000 Вт. Модель A+ Server AS-A126GS-TNBR, в свою очередь, может комплектоваться двумя чипами AMD EPYC 9005 Turin или EPYC 9004 Genoa (максимум 192 ядра, до 500 Вт). Доступны 24 слота для модулей DDR5-6000 суммарным объёмом до 9 Тбайт. Реализованы десять фронтальных SFF-отсеков (8 × NVMe и 2 × SATA), два коннектора M.2 NVMe, восемь слотов PCIe 5.0 x16 LP и два слота PCIe 5.0 x16 FHHL. Задействованы шесть блоков питания мощностью 5250 Вт с сертификатом Titanium. Машина оборудована воздушным охлаждением.

Кроме того, Supermicro представила компактный сервер SYS-112D-36C-FN3P, в основу которого положена аппаратная платформа Intel Xeon 6 SoC (Granite Rapids-D), оптимизированная специально для сетевых и периферийных устройств. Эта модель наделена двумя портами 100GbE QSFP28 и слотом PCIe 5.0 FHFL. Поддерживается до 512 Гбайт памяти DDR5. Дебютировали системы SYS-E201-14AR и SYS-E300-14AR, рассчитанные на задачи IoT и ИИ на периферии.

15.03.2025 [13:48], Сергей Карасёв

Gigabyte представила мощную систему Gigapod для ИИ-кластеров и blade-серверыКомпания Gigabyte анонсировала мощную систему Gigapod для создания GPU-кластеров, рассчитанных на ресурсоёмкие задачи ИИ и НРС. Кроме того, представлены blade-серверы семейства B343-C40 и другие решения корпоративного класса. Gigapod представляет собой стойку, оборудованную GPU-серверами и прочими необходимыми компонентами. В частности, могут применяться серверы серий G893 и G4L3 с воздушным и жидкостным охлаждением, а также гибкими возможностями в плане выбора CPU и GPU. Например, модель G893-ZX1-AAX2 допускает установку двух процессоров AMD EPYC 9005 Turin или EPYC 9004 Genoa, 24 модулей оперативной памяти DDR5-6000, восьми SFF-накопителей NVMe, двух SSD формата М.2 2280/22110 и пр. Система комплектуется восемью ИИ-ускорителями AMD Instinct MI325X. Питание обеспечивают 12 блоков мощностью 3000 Вт с сертификатом 80 PLUS Titanium.

Системы Gigapod могут иметь различные конфигурации на основе пяти и девяти стоек: 9 × 42U, 9 × 48U, 9 × 44OU и 5 × 48U. При этом допускается применение разных ИИ-ускорителей, включая NVIDIA B200, NVIDIA H200, NVIDIA H100, AMD Instinct MI300 и Intel Gaudi 3. В максимальной конфигурации объединены 32 узла GPU, что в сумме даёт до 256 ускорителей ИИ. Заказчики могут выбрать опцию прямого жидкостного охлаждения (DLC). Говорится о возможности установки DPU NVIDIA BlueField-3 и адаптеров NVIDIA ConnectX-7. В семейство blade-серверов, в частности, вошла модель B343-C40-AAJ1: это 10-узловая система в форм-факторе 3U. Узлы могут комплектоваться одним процессором AMD EPYC 4004 или Ryzen 7000/9000. Конфигурация каждого узла включает четыре слота для модулей DDR5, два посадочных места для SFF-накопителей (NVMe или SATA), два сетевых порта 1GbE, слот М.2 и разъём для карты PCIe 5.0 x16 FHHL. |

|