Материалы по тегу: инференс

|

17.02.2026 [11:08], Сергей Карасёв

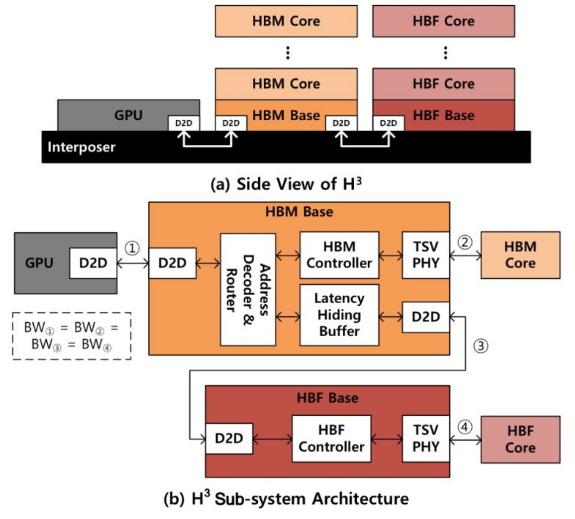

SK hynix предлагает гибридную память HBM/HBF для ускорения ИИ-инференсаКомпания SK hynix, по сообщению ресурса Blocks & Files, разработала концепцию гибридной памяти, объединяющей на одном интерпозере HBM (High Bandwidth Memory) и флеш-чипы с высокой пропускной способностью HBF (High Bandwidth Flash). Предполагается, что такое решение будет подключаться к GPU для повышения скорости ИИ-инференса. Современные ИИ-ускорители на основе GPU оснащаются высокопроизводительной памятью HBM. Однако существуют ограничения по её ёмкости, из-за чего операции инференса замедляются, поскольку доступ к данным приходится осуществлять с использованием более медленных SSD. Решить проблему SK hynix предлагает путём применения гибридной конструкции HBM/HBF под названием H3. Архитектура HBF предусматривает монтаж кристаллов NAND друг над другом поверх логического кристалла. Вся эта связка располагается на интерпозере рядом с контроллером памяти, а также GPU, CPU, TPU или SoC — в зависимости от предназначения конечного изделия. В случае H3 на интерпозере будет дополнительно размещён стек HBM. Отмечается, что время доступа к HBF больше, чем к HBM, но вместе с тем значительно меньше, нежели к традиционным SSD. Таким образом, HBF может служить в качестве быстрого кеша большого объёма.

Источник изображения: SK hynix По заявлениям SK hynix, стеки HBF могут иметь до 16 раз более высокую ёмкость по сравнению с HBM, обеспечивая при этом сопоставимую пропускную способность. С другой стороны, HBF обладает меньшей износостойкостью при записи, до 4 раз более высоким энергопотреблением и большим временем доступа. HBF выдерживает около 100 тыс. циклов записи, а поэтому лучше всего подходит для рабочих нагрузок с интенсивным чтением. В результате, как утверждается, гибридная конструкция сможет эффективно решать задачи инференса при использовании больших языковых моделей (LLM) с огромным количеством параметров. В ходе моделирования работы H3, проведенного специалистами SK hynix, рассматривался ускоритель NVIDIA Blackwell B200 с восемью стеками HBM3E и таким же количеством стеков HBF. В пересчете на токены в секунду производительность системы с памятью H3 оказалась в 1,25 раза выше при использовании 1 млн токенов и в 6,14 раза больше при использовании 10 млн токенов по сравнению с решениями, оборудованными только чипами HBM. Более того отмечено 2,69-кратное повышение производительности в расчёте на 1 Вт затрачиваемой энергии по сравнению с конфигурациями без HBF. К тому же связка HBM и HBF может обрабатывать в 18,8 раз больше одновременных запросов, чем только HBM.

13.02.2026 [13:18], Руслан Авдеев

ECL представила всеядную энергетическую архитектуру для периферийных ИИ ЦОДКомпанией ECL (EdgeCloudLink) анонсирована платформа FlexGrid. Речь идёт об энергетической архитектуре, позволяющей развёртывать ИИ ЦОД высокой плотности в локациях с ограниченными возможностями питания. Решение предлагается как способ масштабирования инфраструктуры инференса за пределы крупных кампусов, в которых осуществляется обучение ИИ-моделей — в городские агломерации, периферийные локации и промзоны, где зачастую доступно не более 50–100 МВт, сообщает Converge Digest. FlexGrid обеспечивает модульное развёртывание на площадках мощностью от 2–10 МВт с возможностью масштабировать подключение до 20–25 МВт на объект с помощью интеграции дополнительных, локальных источников энергии различного происхождения. Основа платформы — патентованная система управления питанием ECL, позволяющая объединять несколько источников энергии, включая классические электросети, водородные топливные элементы, генераторы на природном газе, возобновляемые источники и дизельные генераторы. В результате обеспечивается унифицированная подача постоянного или переменного тока. В отличие от традиционных дата-центров, в норме использующих один тип источников энергии, FlexGrid позволяет менять источники энергии или добавлять к ним новые без изменения базовой энергетической инфраструктуры объектов.

Источник изображения: ECL ECL утверждает, что это позволяет оперативно реагировать на региональные энергетические ограничения, изменения политики энергоснабжения на местах и дефицит топлива, при этом сохраняя стабильное качество электропитания ИИ-инфраструктуры. ECL подчёркивает, что FlexGrid разработана для «нормализации» подачи энергии из любых локальных источников и надёжного энергоснабжения ИИ-объектов в условиях ограничений сетевой энергоинфраструктуры. Пока конкуренты стремятся обеспечить себе мощности от 50 МВт для обучения, ECL работает на обозримую перспективу, делая ставку на периферийные объекты, где жизненно важным становится возможность агрегации и управления питанием таким образом, чтобы обеспечить гибкий выбор площадок и быстрый ввод объектов в эксплуатацию. Летом 2026 года сообщалось, что ECL напечатала свой первый модульный дата-центр, работающий от водородных элементов питания. В сентябре того же года появилась информация, что компаняи построит гигантский «зелёный» ЦОД TerraSite-TX1, а первым арендатором станет ИИ-облако Lambda. Годом позже вышла новость о том, что Lambda и ECL впервые запитали NVIDIA GB300 NVL72 от водорода, но теперь стартап перешёл к более универсальным решениям.

06.02.2026 [10:53], Владимир Мироненко

Без дефицитной HBM: Positron AI готовит ИИ-ускоритель Asimov с терабайтами LPDDR5xКомпания Positron AI сообщила о привлечении $230 млн инвестиций в рамках переподписанного раунда финансирования серии B, в результате которого оценка её рыночной стоимости превысила $1 млрд. Раунд возглавили ARENA Private Wealth, Jump Trading и Unless при участии новых инвесторов Qatar Investment Authority (QIA), Arm и Helena, а также существующих инвесторов Valor Equity Partners, Atreides Management, DFJ Growth, Resilience Reserve, Flume Ventures и 1517. Объявление было сделано на мероприятии Web Summit Qatar, что подчеркивает растущий международный авторитет компании, отметил ресурс eWeek. На то, чтобы перейти в категорию единорогов, Positron AI потребовалось 34 месяца. Positron AI отметила решение Jump Trading стать одним из лидеров раунда после того, как эта компания стала её клиентом. «Для рабочих нагрузок, которые нас интересуют, узкими местами всё чаще становятся память и энергопотребление, а не теоретические вычисления», — сказал технический директор Jump Trading. — В ходе наших тестов Positron Atlas показал примерно в три раза меньшую сквозную задержку, чем сопоставимая система на базе NVIDIA H100, при оценке рабочих нагрузок инференса, в готовом к производству корпусе с воздушным охлаждением и цепочкой поставок, которую мы можем спланировать». Полученные инвестиции позволят ускорить выход платформы следующего поколения Asimov, разработанной на заказ. Компания планирует завершить тестирование Asimov к концу III квартала, а пробные версии появятся в конце I квартала 2027 года. В Asimov будет использоваться память LPDDR (без HBM), но возможность приблизиться к теоретической пиковой пропускной способности памяти означает, что компании и не нужно полагаться на HBM для быстрой генерации токенов, сообщил ресурсу EE Times технический директор Positron. Вычислительные элементы Asimov — это эволюция блоков Atlas с добавлением ядер Arm и улучшенным интерконнектом. Расширить память LPDDR5x в Asimov можно с помощью CXL — с 864 Гбайт до 2,3 Тбайт на чип. Чип позволяет создать два независимых домена памяти, чтобы лучше утилизировать её. Хосит-интерфейс чипа — PCI 6.0 x32. Хотя LPDDR5x дешевле и ёмче HBM, она значительно уступает ей по пропускной способности. Если ускорители Rubin от NVIDIA оснащены 288 Гбайт памяти HBM4 с пиковой пропускной способностью 22 Тбайт/с, то для Asimov, по-видимому, потолок составляет около 3 Тбайт/с, пишет The Register (в спецификациях указано 2,76 Тбайт/с). По словам Positron, разница в том, что её чипы действительно могут использовать 90 % этой пропускной способности, в то время как GPU на базе HBM в реальных условиях едва достигают 30 % пиковой пропускной способности, хотя память Rubin даже в этом случае примерно в 2,4 раза быстрее, чем у Asimov. Компания сообщила, что 400-Вт чип оснащён систолической матрицей 512×512, работающей на частоте 2 ГГц и поддерживающей типы данных TF32, FP16/BF16, FP8, NVFP4 и INT4. Эта матрица управляется рядом ядер Armv9 и может быть переконфигурирована, например, в 128×512 (GEMV) или 512×128 (GEMM), в зависимости от того, какой вариант более выгоден для решения конкретной задачи. Четыре чипа Asimov образуют 4U-платформу Titan с воздушным охлаждением и пропускной способностью между чипами 16 Тбит/с. Компания отметила, что Asimov рассчитан на поддержку 2 Тбайт памяти на ускоритель и 8 Тбайт памяти на систему Titan с аналогичной пропускной способностью памяти, как у ускорителя NVIDIA Rubin. В масштабе стойки это означает объём памяти более 100 Тбайт. До 4096 систем Titan (16384 ускорителя) могут быть объединены в единый масштабируемый домен с более чем 32 Пбайт памяти. Это достигается с помощью чистого межчипового интерконнекта, а не коммутируемых масштабируемых сетей, как в стоечных архитектурах NVIDIA или AMD. Positron подчеркнула, что её архитектура, ориентированная на память, открывает доступ к высокоэффективным задачам инференса, включая большие языковые модели с длинным контекстом, агентные рабочие процессы и модели медиа и видео следующего поколения.

03.02.2026 [17:15], Руслан Авдеев

OpenAI не устроили чипы NVIDIA для инференса, теперь она ищет альтернативыПо данным многочисленных отраслевых источников, компания OpenAI недовольна некоторыми ИИ-чипами NVIDIA и с прошлого года ищет им альтернативы. Потенциально это усложнит отношения между крупнейшими игроками рынка на фоне бума ИИ, сообщает Reuters. Изменения стратегии OpenAI связаны с усилением акцента на инференсе. NVIDIA доминирует в нише ускорителей для обучения ИИ-моделей, но теперь инференс стал отдельным рынком с сильной конкуренцией. Решение OpenAI — вызов доминированию NVIDIA в сфере ИИ и препятствие $100-млрд сделки между компаниями, обеспечивающей разработчику чипов долю в ИИ-стартапе в обмен на доступ к передовым ускорителям. Предполагалось, что сделка будет закрыта за недели, но вместо этого переговоры ведутся месяцами. В то же время OpenAI заключила соглашение с AMD и Cerebras (её в своё время даже хотели купить) для получения «альтернативных» чипов, а также разрабатывает собственный ИИ-ускоритель при участии Broadcom. Amazon тоже не прочь предоставить OpenAI собственные ускорители, равно как и Google. Изменение планов OpenAI изменило и потребности в вычислительных мощностях и замедлило переговоры с NVIDIA. В минувшую субботу глава NVIDIA Дженсен Хуанг (Jensen Huang) опроверг слухи о проблемах с OpenAI, назвав их «чепухой» и подчеркнув, что клиенты продолжают выбирать NVIDIA для инференса, поскольку компания обеспечивает наилучшее соотношение производительности и совокупной стоимости владения, причём в больших масштабах. Отдельно представитель OpenAI заявлял, что компания полагается на NVIDIA для поставок большинства чипов для инференса, причём именно NVIDIA обеспечивает наилучшую производительность на каждый вложенный доллар. Глава OpenAI Сэм Альтман (Sam Altman) отметил, что NVIDIA выпускает «лучшие чипы в мире» и есть надежда, что OpenAI останется её «гигантским» клиентом очень долгое время. При этом, как сообщает Reuters со ссылкой на семь источников, OpenAI не удовлетворена производительностью инференса, на которую способны чипы NVIDIA. В частности, речь идёт о специализированных задачах вроде разработки ПО с помощью ИИ и коммуникаций ИИ с другим ПО. По данным одного из источников, компании понадобится новое аппаратное обеспечение, которое в конечном счёте обеспечит в будущем порядка 10 % вычислительных мощностей для инференса. OpenAI обсуждала возможности работы с ИИ-стартапами, включая Cerebras и Groq для обеспечения чипов с более быстрым инференсом, но NVIDIA фактически поглотила Groq на $20 млрд, что привело к прекращению переговоров с компанией. Хотя формально речь идёт неэксклюзивном лицензировании технологий Groq, что в теории позволяет сторонним компаниям получить доступ к решениям Groq, фактически все разработчики перешли в NVIDIA, а оставшаяся небольшая команда отвечает за выполнение облачных контрактов с имеющимися заказчиками. Чипы NVIDIA хорошо подходят для обработки больших объёмов данных при обучении больших ИИ-моделей вроде тех, что стоят за ChatGPT. Тем не менее прогресс требует массового использования уже обученных моделей для дальнейшего инференса и ИИ-рассуждений. Как сообщается, OpenAI с 2025 года ищет альтернативы ускорителям NVIDIA с упором на компании, создающие чипы с большими объёмами интегрированной SRAM. Maia 200 от Microsoft, по-видимому, компании не очень подходит. Инференс моделей более требователен к памяти, чем обучение, а вычислительная нагрузка, наоборот, не так велика. В тоге нередко на доступ к данным уходит больше времени, чем на расчёты. NVIDIA и AMD полагаются на внешнюю память, что замедляет соответствующие процессы общения с чат-ботами. В OpenAI проблемы отметили при эксплуатации системы Codex, активно продвигаемой компанией для создания кода. В компании считают, что некоторые слабости системы связаны именно с оборудованием NVIDIA. Конкуренты OpenAI полагаются на альтернативное оборудование. Anthropic активно использует AWS Trainium и Google TPU, а Google уже много лет использует свои TPU, которые с недавних пор готова отдавать на сторону. TPU оптимизированы в том числе для инференса и в некоторых отношениях более производительны, чем GPU общего назначения AMD и NVIDIA. Когда OpenAI недвусмысленно выразила отношение к технологиям NVIDIA, та предложила компаниям, создающим ускорители с упором на SRAM, включая Cerebras и Groq, купить их бизнес. Cerebras отказалась и заключила прямую сделку с OpenAI. Groq вела переговоры с OpenAI о предоставлении вычислительных мощностей, что вызвало интерес у инвесторов, оценивших капитализацию компании на уровне $14 млрд.

01.02.2026 [11:55], Сергей Карасёв

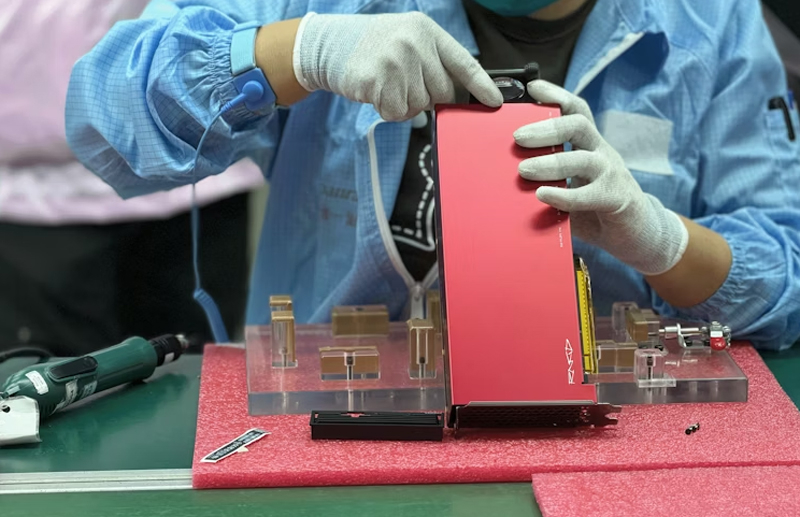

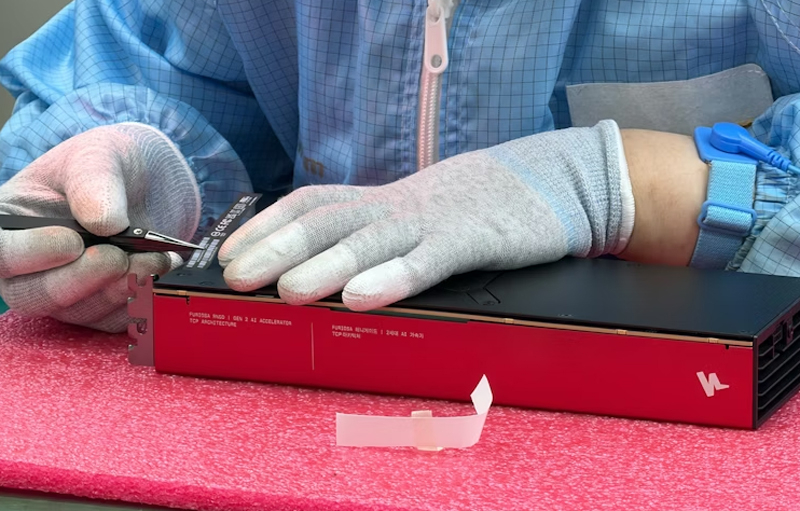

Южнокорейский стартап FuriosaAI начал массовое производство ИИ-ускорителей RNGDЮжнокорейский стартап FuriosaAI объявил о начале серийного выпуска ИИ-ускорителей RNGD и серверов NXT RNGD на их основе. Отмечается, что благодаря тесному партнёрству с TSMC, SK hynix и другими отраслевыми игроками, включая ASUS, сформирована стабильная производственная и логистическая цепочка, а новые продукты доступны корпоративным заказчикам по всему миру. ИИ-ускоритель RNGD выполнен в виде карты расширения PCIe 5.0 x16: он оснащён 48 Гбайт HBM3 с пропускной способностью до 1,5 Тбайт/с и 256 Мбайт SRAM с пропускной способностью 384 Тбайт/с. Показатель TDP не превышает 180 Вт. Заявленная производительность достигает 512 Тфлопс на операциях INT8. В свою очередь, система NXT RNGD формата 4U несёт на борту восемь карт RNGD. Энергопотребление находится на уровне 3 кВт. Утверждается, что в стандартную серверную стойку с воздушным охлаждением можно установить пять экземпляров NXT RNGD, что обеспечит ИИ-быстродействие до 20 Пфлопс (INT8).

Источник изображений: FuriosaAI Как подчёркивает FuriosaAI, современные ИИ-модели требуют колоссальных вычислительных мощностей, но подавляющее большинство корпоративных дата-центров имеют воздушное охлаждение, а их мощность ограничена 15 кВт на стойку. Поэтому для использования огромного количества GPU-ускорителей с показателем TDP до 600 Вт и более требуется дорогостоящая и трудоёмкая модернизация инфраструктуры. Применение изделий RNGD позволяет решить проблему. По заявлениям FuriosaAI, её решения обеспечивает в 3,5 раза большую вычислительную плотность, чем системы на базе NVIDIA H100 в стандартных средах.  Для ускорителей RNGD доступен полнофункциональный комплект разработки SDK. Говорится о поддержке популярных ИИ-моделей, таких как Qwen 2 и Qwen 2.5. Объём первой изготовленной партии изделий составил 4000 единиц.

29.01.2026 [16:57], Сергей Карасёв

Китайский конкурент NVIDIA H20 — Alibaba представила ИИ-ускоритель Zhenwu 810E с 96 Гбайт HBM2eКомпания T-Head Semiconductor, подразделение китайского интернет-гиганта Alibaba Group Holding, представила ИИ-ускоритель собственной разработки Zhenwu 810E. Изделие, как утверждается, может использоваться для обучения ИИ-моделей и инференса, а также для решения других ресурсоёмких задач, например, в области автономного вождения. В основу новинки положены аппаратная и программная архитектуры, полностью разработанные специалистами T-Head. Решение оснащено 96 Гбайт памяти HBM2e. Применен проприетарный интерконнект ICN (Inter-Chip Network), обеспечивающий пропускную способность до 700 Гбайт/с — у каждого чипа есть семь таких интерфейсов для прямого объединения с другими чипами. Для подключения к хосту используется шина PCIe 5.0 x16. В плане производительности Zhenwu 810E, по имеющейся информации, превосходит ускоритель NVIDIA A800, а также некоторые GPU китайского производства. Подчеркивается, что новое решение T-Head способно составить конкуренцию NVIDIA H20. Напомним, что и A800, и H20 разработаны специально для китайского рынка в соответствии с американскими требованиями по контролю над экспортом высокопроизводительных процессоров. Некоторые источники также предполагают, что модернизированная версия чипа Zhenwu сможет обеспечить производительность, превосходящую показатели NVIDIA A100.

Источник изображения: T-Head Alibaba уже использует Zhenwu 810E для обучения своих больших языковых моделей Qianwen, а также для ИИ-инференса. Кроме того, на базе новых чипов в сочетании с облачными сервисами Alibaba предоставляются услуги более чем 400 клиентам, включая Государственную электросетевую компанию (SGCC), Китайскую академию наук (CAS) и стартап по производству электромобилей Xpeng. Собственные ИИ-чипы проектируют и многие другие китайские компании. В частности, местный стартап Iluvatar CoreX недавно поделился планами по выпуску GPU-ускорителей, превосходящих по возможностям NVIDIA Rubin. Соответствующие разработки также ведут Kunlunxin (Baidu), Zixiao (Tencent), MetaX, Moore Threads и Biren. Но ведущими игроками рынка ИИ-чипов КНР остаются NVIDIA и Huawei.

27.01.2026 [01:23], Владимир Мироненко

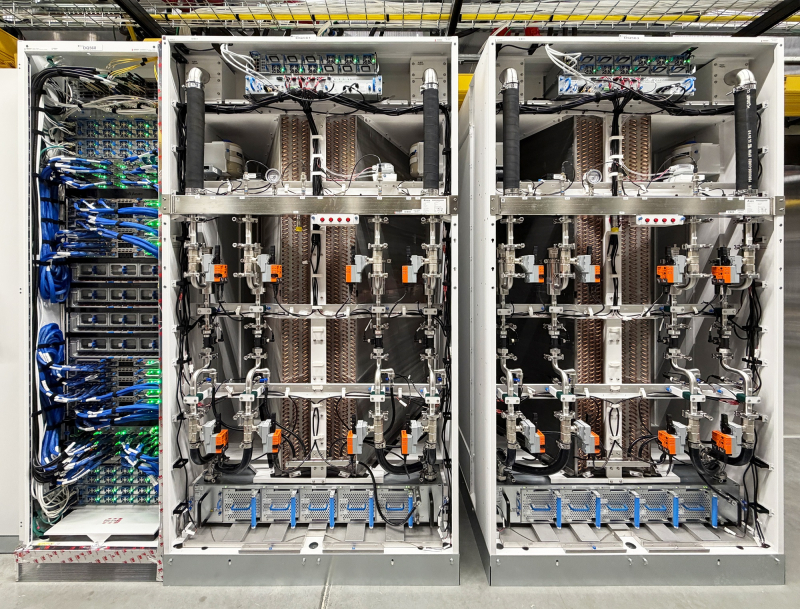

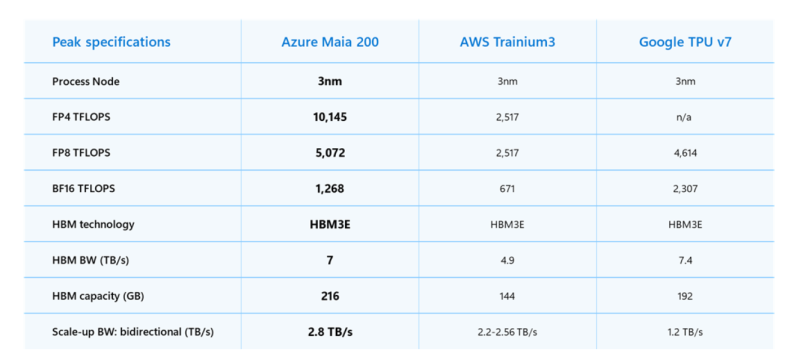

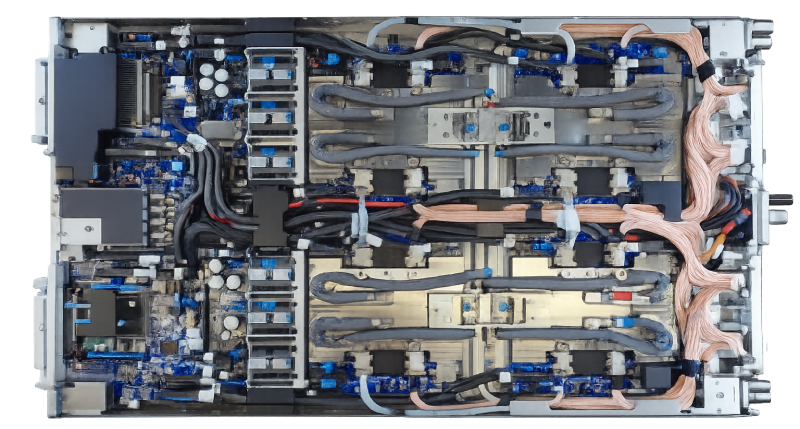

Microsoft представила ИИ-ускоритель Maia 200 с 216 Гбайт HBM3eMicrosoft представила 3-нм ИИ-ускоритель Maia 200 для инференса с собственными тензорными ядрами с поддержкой форматов FP8/FP4, переработанной подсистемой памяти с 216 Гбайт HBM3e (7 Тбайт/с), 272 Мбайт SRAM, DMA-движком, оптимизированной NOC, а также «механизмами перемещения данных, обеспечивающими быструю и эффективную работу масштабных моделей». Maia 200 содержит более 140 млрд транзисторов. FP4-производительность составляет более 10 Пфлопс что в три раза выше, чем у Amazon Trainium3, но почти вдвое меньше, чем у NVIDIA Blackwell, и более 5 Пфлопс в FP8-вычислениях, чуть превосходя по производительности Google TPU v7 Ironwood и опять-таки примерно вдвое уступая Blackwell. При этом TDP составляет 750 Вт, а для охлаждения используются СЖО и фирменные теплообменники второго поколения. На системном уровне Maia 200 использует всего лишь двухуровневую унифицированную сетевую фабрику, построенную на стандартном Ethernet. Специальный транспортный уровень Maia AI, который используется и для вертикального, и для горизонтального масштабирования, и тесно интегрированный сетевой адаптер обеспечивают производительность, высокую надёжность и преимущества по стоимости без использования проприетарных интерконнектов. Каждый акселератор получил выделенный интерфейс с пропускной способностью 2,8-Тбайт/с (в дуплексе). Обещаны предсказуемые, высокопроизводительные коллективные операции в кластерах, объединяющих до 6144 ускорителей. Внутри каждого узла есть четыре ускорителя Maia 200, которые общаются друг с другом напрямую, т.е. без использования коммутатора. «Maia 200 также является самой эффективной системой для выполнения задач ИИ, когда-либо развёрнутой Microsoft, обеспечивая на 30 % лучшую производительность на доллар, чем новейшее оборудование в нашем парке», — сообщила компания. Maia 200 уже используется в регионе US Central недалеко от Де-Мойна (Des Moines, шт. Айова), а в дальнейшем планируется развёртывание новых ускорителей в регионе US West 3, недалеко от Финикса (Phoenix, шт. Аризона). Компания также представила предварительную версию SDK Maia с полным набором инструментов для создания и оптимизации LLM для Maia 200. Он включает в себя полный набор возможностей, в том числе интеграцию с PyTorch, компилятор Triton и оптимизированную kernel-библиотеку, а также доступ к низкоуровневому программированию Maia. Microsoft сообщила, что Maia 200 будет использоваться в рамках её гетерогенной ИИ-инфраструктуры для работы с различными моделями, включая GPT-5.2 от OpenAI, обеспечивая преимущества в соотношении производительности и затрат для Microsoft Foundry и Microsoft 365 Copilot. Команда Microsoft Superintelligence будет использовать Maia 200 для генерации синтетических данных и обучения с подкреплением для улучшения собственных моделей следующего поколения. В сценариях использования конвейера синтетических данных использование Maia 200 позволит ускорить процесс генерации и фильтрации высококачественных данных, специфичных для конкретной предметной области.

26.01.2026 [09:39], Владимир Мироненко

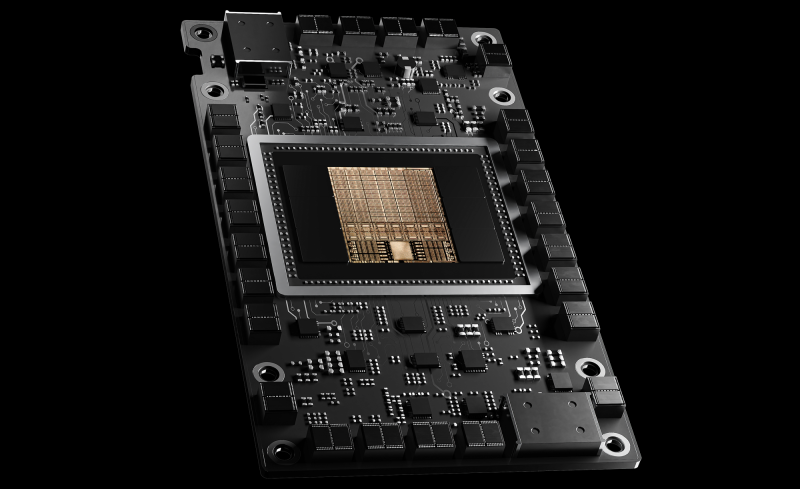

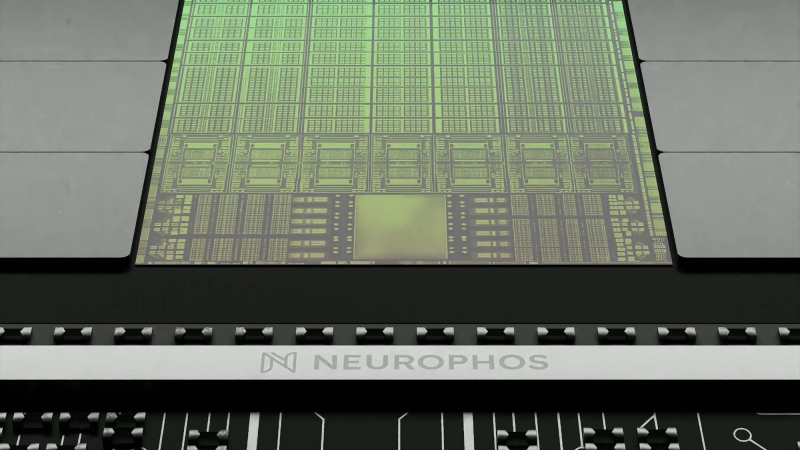

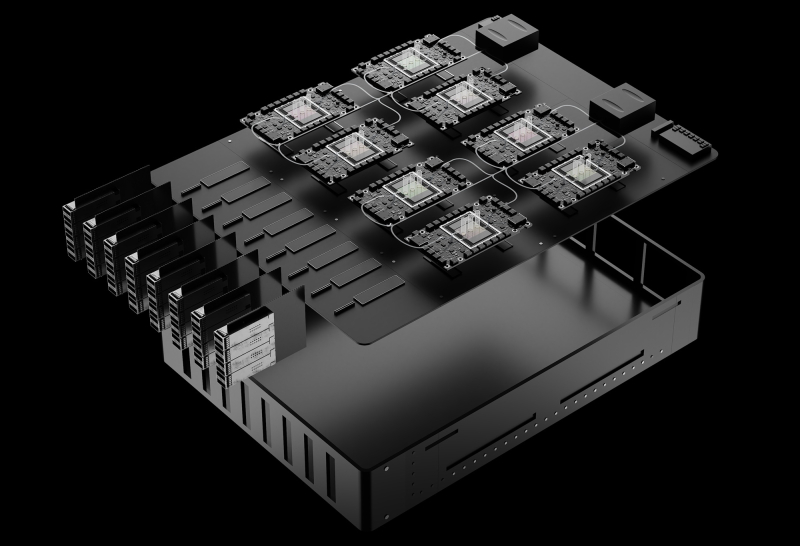

ИИ-расчёты — в OPU: Neurophos готовит 56-ГГц фотонный ускоритель Tulkas T100Стартап Neurophos, специализирующийся на разработках в области фотонных чипов для ИИ-нагрузок, сообщил о привлечении $110 млн в рамках переподписанного раунда финансирования серии А, в результате чего общий объём полученных им инвестиций вырос до $118 млн. Раунд возглавила Gates Frontier Билла Гейтса (Bill Gates) при участии M12 (венчурный фонд Microsoft), Carbon Direct Capital, Aramco Ventures, Bosch Ventures, Tectonic Ventures, Space Capital и др. В число инвесторов также вошли DNX Ventures, Geometry, Alumni Ventures, Wonderstone Ventures, MetaVC Partners, Morgan Creek Capital, Silicon Catalyst Ventures, Mana Ventures, Gaingels и другие. Юридическим консультантом выступает Cooley LLP. Полученные средства компания планирует использовать для ускорения разработки своей первой интегрированной фотонной вычислительной системы. Она включает в себя готовые к использованию в ЦОД модули OPU, полный программный стек и аппаратное обеспечение с ранним доступом для разработчиков. Кроме того, компания расширяет свою штаб-квартиру в Остине и открывает новый инженерный центр в Сан-Франциско для удовлетворения первоначального спроса клиентов. Стартап разработал «метаповерхностный модулятор» с оптическими свойствами, позволяющими его использовать в качестве тензорного процессора для выполнения матрично-векторного умножения. Разработанные стартапом оптические модуляторы на основе метаматериалов микронного масштаба в 10 тыс. раз меньше существующих фотонных элементов, что впервые делает фотонные вычисления реальностью. Эти модуляторы интегрируются с технологией вычислений в памяти для сокращения перемещения данных. «Современные задачи инференса с использованием ИИ требуют колоссальных вычислительных мощностей и ресурсов, — сообщил доктор Марк Трембле (Marc Tremblay), корпоративный вице-президент и технический эксперт по базовой ИИ-инфраструктуре ИИ. — Нам необходим прорыв в вычислительной мощности, сопоставимый с теми скачками, которые мы наблюдаем в самих ИИ-моделях, и именно этим занимается технология Neurophos и ее высококвалифицированная команда». Компания, основанная Патриком Боуэном (Patrick Bowen) и Эндрю Траверсо (Andrew Traverso), включает в себя ветеранов отрасли из NVIDIA, Apple, Samsung, Intel, AMD, Meta✴, ARM, Micron, Mellanox, Lightmatter и др. Neurophos разрабатывает оптический процессор (OPU), который объединяет более миллиона микронных оптических элементов обработки на одном чипе. Он обеспечивает до 100 раз большую производительность и энергоэффективность по сравнению с ведущими современными чипами, утверждает компания. «Закон Мура замедляется, но ИИ не может позволить себе ждать. Наш прорыв в фотонике открывает совершенно новый уровень масштабирования благодаря массивному оптическому параллелизму на одном чипе. Этот сдвиг на уровне физики означает, что как эффективность, так и скорость улучшаются по мере масштабирования, освобождаясь от энергетических барьеров, которые ограничивают традиционные GPU», — говорит Боуэн. «Эквивалент оптического транзистора, который вы получаете сегодня на заводах, огромен. Он имеет длину около 2 мм. Вы просто не можете разместить достаточное количество таких транзисторов на чипе, чтобы получить вычислительную плотность, хотя бы отдалённо конкурирующую с современными CMOS-технологиями», — сообщил ресурсу The Register Боуэн. «В мае мы получили первый кремниевый кристалл, продемонстрировав, что можем сделать это с помощью стандартного CMOS-процесса, что означает совместимость с существующими технологиями производства. На кристалле находится одно фотонное тензорное ядро размером 1000 × 1000 [обрабатывающих элементов]», — сказал он. Это значительно больше, чем обычно встречается в большинстве GPU, которые обычно используют механизмы матричного умножения размером 256 × 256 обрабатывающих элементов. Однако для чипа Neurophos достаточно одного тензорного ядра вместо десятков или даже сотен таких, как в ускорителях NVIDIA. Боуэн говорит, что тензорное ядро в ускорителе Neurophos первого поколения будет занимать примерно 25 мм². Оснащение остальной части микросхемы размером с фотошаблон — это «главная проблема, связанная с поддержкой этого невероятно мощного тензорного ядра», сказал Боуэн. В частности, Neurophos требуется огромное количество векторных процессоров и SRAM, чтобы тензорное ядро не испытывало нехватки данных. Это связано с тем, что само тензорное ядро — которое в чипе будет всего лишь одно — работает на частоте около 56 ГГц. Но поскольку матричное умножение выполняется оптическим методом, единственная потребляемая тензорным ядром энергия уходит на преобразование электрических сигналов в оптические и обратно, сообщил Боуэн. Как сообщает Neurophos, её первый OPU Tulkas T100 получит 768 Гбайт памяти HBM (20 Тбайт/с) и 200 Мбайт L2-кеша. Производительность системы составит 470 POPS (FP4/INT4) или 400 TOPS (FP16/INT16) при потреблении от 1 до 2 КВт под нагрузкой, демонстрируя энергоэффективность до 235 TOPS/Вт. Следует учитывать, что эти цифры пока лишь ориентиры. Чип всё ещё находится в активной разработке, и полномасштабное производство, как ожидается, начнётся не раньше середины 2028 года. Как утверждают в Neurophos, проблем с массовым производством оптических чипов не предвидится, поскольку они могут быть изготовлены с использованием стандартных материалов, инструментов и процессов полупроводниковых фабрик. Боуэн предполагает, что Tulkas T100 будет выполнять аналогичную роль, что и соускоритель NVIDIA Rubin CPX для работы с контекстом и создания KV-кеша. «Текущая концепция, которая может измениться, заключается в том, что мы разместим одну нашу стойку, состоящую из 256 наших чипов, и она будет сопряжена с чем-то вроде стойки NVL576», — сказал он. В долгосрочной перспективе возможен и переход к генерации токенов, но для этого потребуется разработка множества технологий, включая интегрированную оптику. Боуэн сообщил ресурсу TechCrunch, что Neurophos уже заключил контракты с несколькими клиентами (хотя он отказался назвать их имена), и такие компании, как Microsoft, «очень внимательно изучают» продукцию стартапа. Хотя на рынке ИИ-ускорителей и так большая конкуренция, Боуэн уверен, что повышение производительности и эффективности, обеспечиваемое оптическими вычислениями, станет достаточным конкурентным преимуществом чипов стартапа. «Все остальные, включая NVIDIA, в плане фундаментальной физики кремния, скорее эволюционны, чем революционны, и это связано с прогрессом TSMC. Если посмотреть на улучшение техпроцессов TSMC, то в среднем они повышают энергоэффективность примерно на 15 %, и на это уходит пара лет», — сказал он.

19.01.2026 [10:09], Сергей Карасёв

DeepX представила ИИ-ускорители DX-H1 V-NPU, DX-H1 Quattro и DX-M1 М.2Южнокорейский стартап Deepx, специализирующийся на разработке чипов для задач ИИ, анонсировал ускорители DX-H1 V-NPU, DX-H1 Quattro и DX-M1 М.2. В основу решений, которые демонстрировались на недавней выставке CES 2026 в Лас-Вегасе (Невада, США), положен нейропроцессорный узел Genesis NPU. Устройство DX-H1 V-NPU предназначено для выполнения операций, связанных с обработкой видеоматериалов: это может быть декодирование, кодирование, перекодирование и пр. Утверждается, что новинка обеспечивает снижение стоимости оборудования примерно на 80 % и сокращение энергопотребления на 85 % по сравнению с решениями на базе GPU при той же плотности каналов. Ускоритель выполнен в виде низкопрофильной карты расширения PCIe 3.0 x16 (x8 на уровне сигналов). Он оснащён двумя аппаратными видеокодеками и двумя NPU с общей производительностью до 50 TOPS (INT8) при инференсе в реальном времени. Возможно декодирование 64 каналов H.264/265 (1080р; 30 к/с) и кодирование 32 каналов H.264/265 (1080р; 30 к/с). Секция кодирования имеет доступ к 16 Гбайт памяти LPDDR5, секция NPU — к 8 Гбайт. Упомянуты интерфейс HDMI 2.0 и флеш-модуль eMMC вместимостью 32 Гбайт. Максимальное энергопотребление составляет 40 Вт. Решение DX-H1 Quattro, в свою очередь, оснащено четырьмя NPU с суммарной производительностью до 100 TOPS (INT8). В оснащение входят 16 Гбайт памяти LPDDR5. Ускоритель, выполненный в виде карты PCIe 3.0 x16, предназначены для выполнения ИИ-задач в дата-центрах и на периферии. Энергопотребление равно 20 Вт, диапазон рабочих температур простирается от -25 до +85 °C. Говорится о совместимости с Windows и различными вариантами Linux, включая Ubuntu. Изделие DX-M1 М.2 представляет собой ИИ-ускоритель в виде модуля М.2 2280, выполненный на чипе DX-M1. ИИ-производительность — до 25 TOPS, а энергопотребление не превышает 5 Вт. Используется интерфейс PCIe 3.0 x4. Говорится о возможности применения устройства в системах с архитектурой х86 и Arm. Диапазон рабочих температур — от -25 до +85 °C. Упомянута совместимость с Windows 11 и Ubuntu 22.04.

15.01.2026 [18:19], Сергей Карасёв

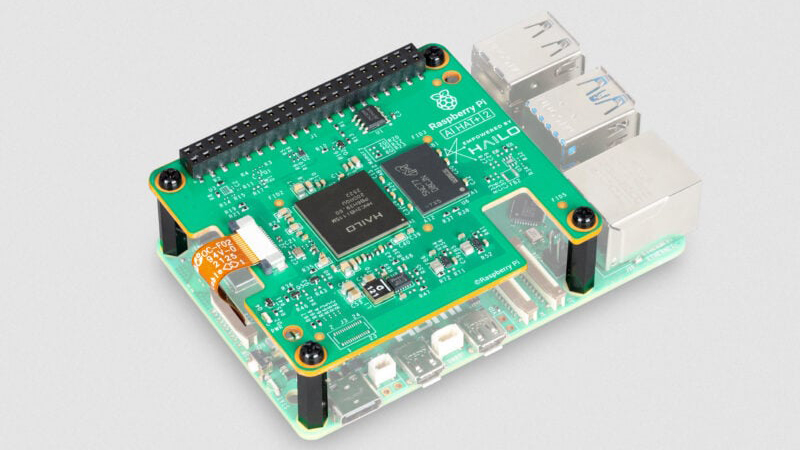

Модуль AI HAT+ 2 добавляет к Raspberry Pi 5 ИИ-ускоритель Hailo-10HКомпания Raspberry Pi анонсировала специализированный модуль расширения AI HAT+ 2, позволяющий использовать одноплатный компьютер Raspberry Pi 5 для ИИ-инференса. Новинка уже доступна для заказа по ориентировочной цене $130. Ранее Raspberry Pi выпустила ИИ-модуль AI HAT+, который в зависимости от модификации оснащается ускорителем Hailo-8 (26 TOPS) или Hailo-8L (13 TOPS). Такие изделия предназначены прежде всего для инференса. Решение Raspberry Pi AI HAT+ 2, в свою очередь, спроектировано под генеративный ИИ. В основу новинки положен ускоритель Hailo-10H, который позволяет использовать большие языковые модели (LLM), визуально-языковые модели (VLM) и другие модели генеративного ИИ локально. Чип функционирует в тандеме с 8 Гбайт LPDDR4/4X. Заявленная ИИ-производительность достигает 40 TOPS на операциях INT4. Для задач, основанных на машинном зрении, таких как распознавание объектов, оценка позы и сегментация сцены, производительность AI HAT+ 2 приблизительно эквивалентна быстродействию ранее выпущенного ИИ-модуля на базе Hailo-8.

Источник изображения: Raspberry Pi При подключении модуля операционная система Raspberry Pi OS автоматически обнаруживает ускоритель и переносит на него поддерживаемые задачи ИИ. Поначалу для изделия будут доступны следующие LLM: DeepSeek-R1-Distill, Qwen2.5-Coder, Qwen2.5-Instruct и Qwen2 (все с 1,5 млрд параметров), а также Llama3.2 (с 1 млрд параметров). В дальнейшем будут предложены более крупные модели. |

|