Материалы по тегу: hardware

|

05.09.2025 [11:39], Сергей Карасёв

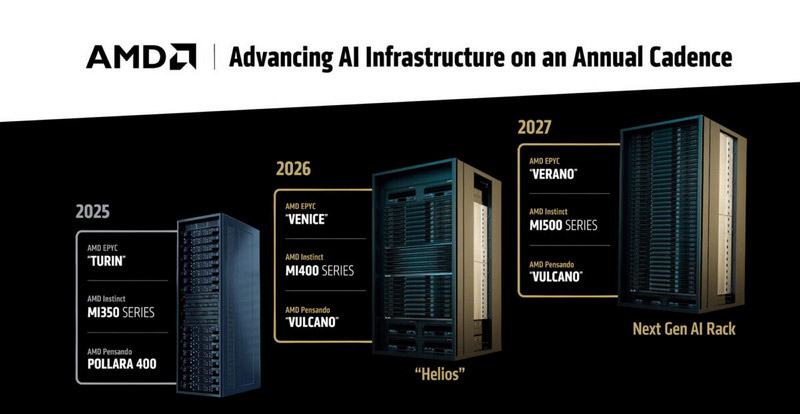

AMD готовит суперускоритель Mega Pod с 256 ускорителями Instinct MI500Компания AMD, по сообщению ресурса Tom's Hardware, готовит платформу MI500 Scale Up MegaPod для наиболее ресурсоёмких нагрузок ИИ. Эта система, как ожидается, выйдет в 2027 году и составит конкуренцию стоечным решениям NVIDIA следующего поколения. Известно, что в основу MI500 Scale Up MegaPod лягут 64 процессора EPYC поколения Verano и 256 ускорителей серии Instinct MI500. Для сравнения: платформа AMD Helios, выход которой запланирован на 2026 год, сможет объединять до 72 ускорителей Instinct MI400, тогда как в состав системы NVIDIA NVL576 на основе стойки Kyber войдут 144 ускорителя поколения Rubin Ultra. В конструктивном плане MI500 Scale Up MegaPod, согласно имеющейся информации, будет представлять собой платформу с тремя серверными стойками. В боковых разместятся по 32 вычислительных лотка с одним процессором EPYC Verona и четырьмя ИИ-ускорителями Instinct MI500, тогда как центральная стойка получит 18 лотков, предназначенных для коммутаторов UALink. В целом, в состав системы войдут 64 узла, насчитывающих в общей сложности 256 ускорителей.

Источник изображения: AMD По сравнению с NVIDIA NVL576 со 144 ускорителями новая платформа AMD обеспечит примерно на 78 % больше карт в расчёте на систему. Однако пока не ясно, сможет ли AMD MI500 Scale Up MegaPod превзойти решение NVIDIA по производительности: NVL576, как ожидается, получит 147 Тбайт памяти HBM4, тогда как быстродействие этой системы будет достигать 14 400 Пфлопс на операциях FP4. Отмечается также, что для AMD MI500 Scale Up MegaPod предусмотрено использование исключительно жидкостного охлаждения — как для вычислительных, так и для сетевых узлов. Предполагается, что система поступит в продажу в конце 2027 года — примерно в то же время, когда, вероятно, дебютирует NVIDIA NVL576.

05.09.2025 [10:19], Владимир Мироненко

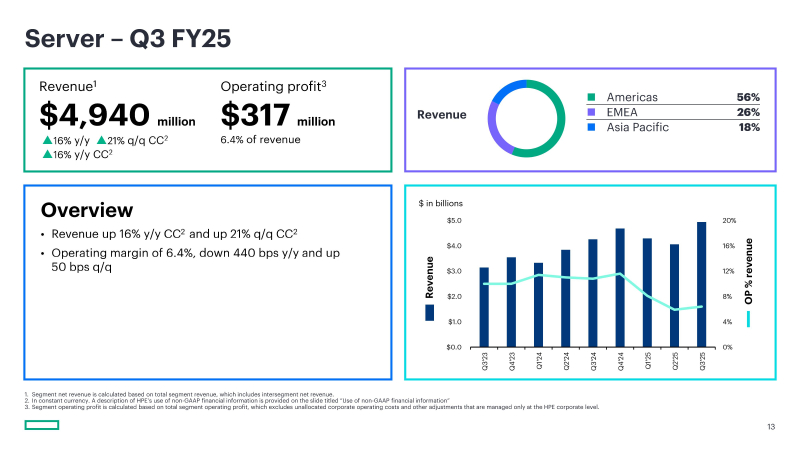

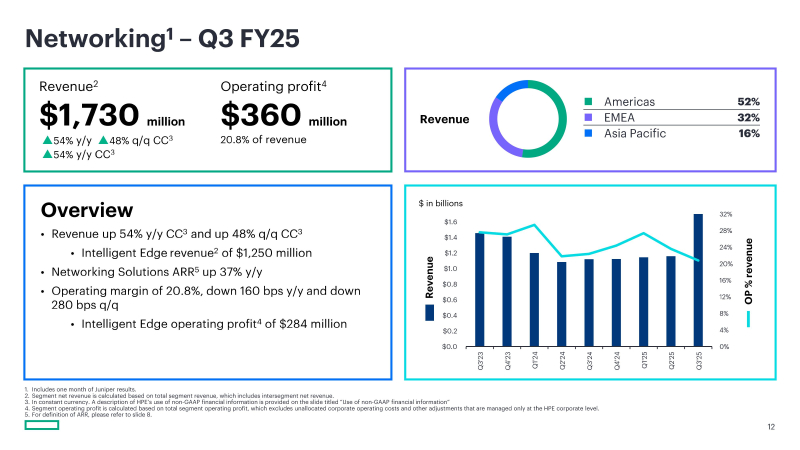

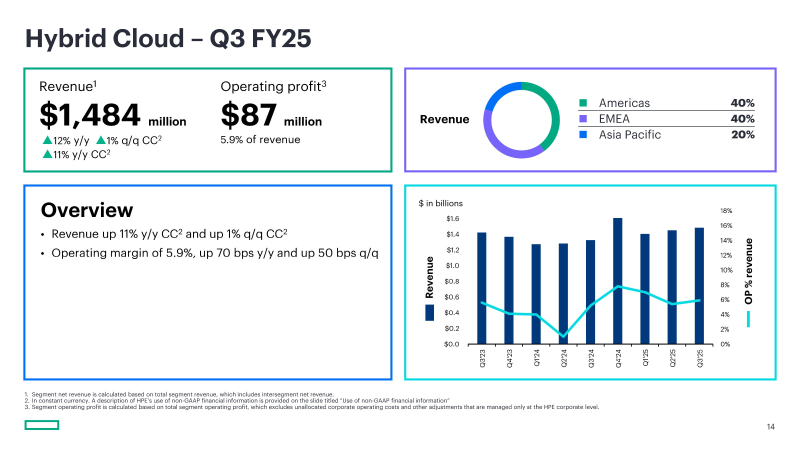

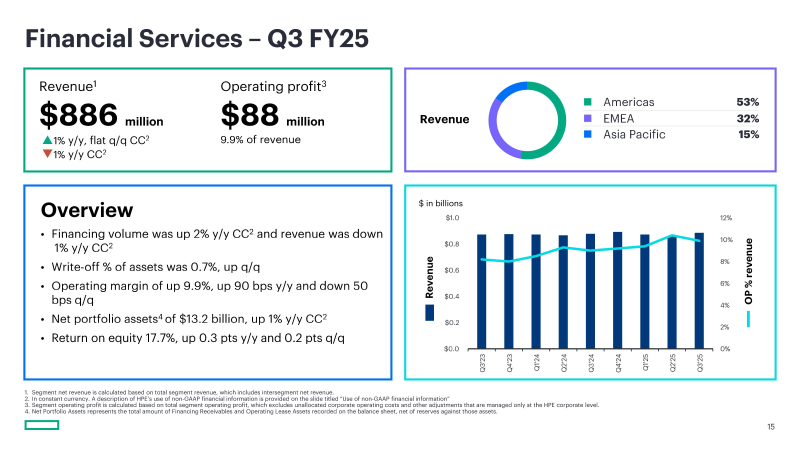

Сети, серверы, ИИ: HPE превзошла ожидания Уолл-стрит по квартальной выручкеHPE объявила финансовые результаты за III квартал 2025 финансового года, закончившийся 31 июля 2025 года, превзойдя прогнозы Уолл-стрит по выручке, что обусловлено высоким спросом в сегментах серверов и сетевых решений, отметило агентство Reuters. Выручка HPE составила $9,14 млрд, что на 19 % больше год к году и выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $8,53 млрд. Чистая прибыль (GAAP) упала до $276 млн или $0,21 на разводнённую акцию с $512 млн или $0,38 на разводнённую акцию годом ранее. Скорректированная прибыль (Non-GAAP) на разводнённую акцию упала год к году на $0,06 до $0,44, превысив прогноз Уолл-стрит в $0,42 (по данным investors.com), вместе с тем соответствуя собственному прогнозу компании в диапазоне $0,40–$0,45. Скорректированная валовая прибыль (Non-GAAP) составила 29,9 %, что на 50 базисных пунктов больше по сравнению с предыдущим кварталом, хотя и ниже на 190 базисных пунктов год к году. Выручка от продаж серверов увеличилась на 16 % в годовом исчислении до $4,94 млрд, в то время как выручка от продаж сетевого оборудования выросла на 54 % до $1,73 млрд. При этом выручка от поставок ИИ-серверов составила $1,6 млрд (рост на $0,6 млрд к предыдущему кварталу), включая одну крупную и выгодную сделку с крупным производителем ИИ-моделей (по данным msn.com). Портфель невыполненных заказов по поставке ИИ-серверов достиг $3,7 млрд. Выручка сегмента гибридного облака, включающего СХД и часть серверного бизнеса, на который также приходится HPE GreenLake, увеличилась год к году на 12 % до $1,48 млрд. Выручка сегмента финансовых услуг увеличилась на 1 % до $886 млн. «Мы не только получаем новую выручку, но и постепенно привлекаем новых клиентов», — заявила финансовый директор Мари Майерс (Marie Myers). Она также отметила растущую популярность компании среди государственных и корпоративных клиентов, что отражается в портфеле заказов. Сделки с такими клиентами имеют более привлекательный профиль прибыли по сравнению со сделками с производителями ИИ-моделей или гиперскейлерами. «Корпоративные и государственные компании, как правило, представляют собой более стабильный и устойчивый бизнес», — сообщила Майерс. По данным аналитика Barclays Тима Лонга (Tim Long), с 2023 года на корпоративные и государственные компании приходится половина заказов на ИИ-серверы. В июле HPE закрыла сделку по приобретению Juniper Networks за $14 млрд, что представляет собой самое значительное расширение портфолио компании с момента отделения от HP десять лет назад. Компания ожидает синергию выручки на сумму не менее $600 млн в течение следующих трёх лет, а также дополнительный потенциал роста за счёт кросс-продаж платформ сетевой автоматизации и безопасности Juniper Mist на базе ИИ в глобальной корпоративной базе HPE и подписках GreenLake, пишет Converge! Network Digest. HPE прогнозирует в текущем квартале выручку в размере от $9,7 до $10,1 млрд, что в среднем значении ниже консенсус-прогноза FactSet в размере $10,1 млрд. Прогноз по скорректированной прибыли (Non-GAAP) на акцию составляет от $0,56 до $0,60, в то время как аналитики ожидают $0,56. Несмотря на слабый прогноз по выручке акции компании выросли на 4 % — инвесторов воодушевили её успехи в серверном бизнесе.

04.09.2025 [22:26], Андрей Крупин

В Арктике развернут крупный 20-МВт ЦОД на 500 стойко-местВ арктической зоне России будет построен крупный центр обработки данных. Об этом было объявлено на полях проходящего по Владивостоке Восточного экономического форума — 2025. Инициатором проекта стала Корпорация развития Дальнего Востока и Арктики, заключившая соглашение о сотрудничестве с компанией «Группа Сибстар» о строительстве площадки для размещения дата-центра на территории преференциального режима Арктической зоны РФ. Объём инвестиций в строительство ЦОД составит 1 млрд руб., предполагается привлечение государственных средств. Проектная мощность будущего дата-центра составит 20 МВт, для размещения вычислительного оборудования будет организовано 500 стойко-мест. О сроках ввода объекта в эксплуатацию не сообщается. «Мы планируем реализовать проект по созданию высокотехнологичного дата-центра в Арктике. Центр станет ключевым узлом современной цифровой экономики. Местный суровый климат позволит с максимальной эффективностью охлаждать оборудование, экономя большое количество энергии, а полученная тепловая энергия может быть использована в социальных нуждах. Проект создаст новые высококвалифицированные рабочие места, внесёт серьёзные налоговые отчисления в местный бюджет и даст стимул дальнейшему развитию энергетической и сетевой инфраструктуры арктической зоны», — заявил заместитель директора компании «Группа Сибстар». Напомним, что в российской Арктической зоне уже функционирует ЦОД «Ростелекома» — он расположен в Мурманске и имеет ёмкость 20 стоек. Также ведётся строительство вычислительного комплекса при Кольской АЭС (Мурманская область) — его вместимость составит 48 стоек, а мощность 1 МВт.

04.09.2025 [16:33], Руслан Авдеев

AWS инвестирует $4,4 млрд в новозеландские облачные ЦОДAmazon (AWS) анонсировала открытие в Новой Зеландии облачного региона, а также намерение потратить более NZ$7,5 млрд ($4,4 млрд) на местные дата-центры. Впервые о плане было объявлено ещё в 2021 году, а теперь он получил «второе дыхание», сообщает Bloomberg. Для страны это достаточно значимая инвестиция. AWS создаст облачный регион AWS Asia Pacific, чтобы удовлетворить растущий спрос на облачные сервисы по всей стране. Как сообщают в AWS, строительство, эксплуатация и обслуживание дата-центров позволит ежегодно создавать более 1 тыс. рабочих мест с полной занятостью. Кроме того, увеличится валовый внутренний продукт Новой Зеландии — приблизительно на NZ$10,8 млрд. (более $6.3 млрд). Сроки инвестиций не называются. Новая Зеландия стремится стать новым «магнитом» для иностранных инвестиций в ЦОД, чтобы придать импульс местной экономике, в прошлом году погрузившейся в глубокую рецессию и до сих пор не восстановившейся. Власти специально реформировали градостроительные законы, желая ускорить выдачу разрешений на новые проекты. Кроме того, для привлечения иностранных инвесторов и предпринимателей скорректирован визовый режим. Власти отметили, что по данным Amazon, строительство в Новой Зеландии на 20 % дороже, чем в соседней Австралии, поэтому необходимо менять законы. Новый облачный регион обеспечит уже имеющимся клиентам вроде Xero и Kiwibank возможность локального выполнения любых рабочих нагрузок, локального же хранения данных и предоставления цифровых услуг с малой задержкой. Это, по мнению AWS, позволит быстрее создавать новые облачные продукты. В Новой Зеландии постепенно реализуют всё новые проекты, связанные с дата-центрами и сопутствующей инфраструктурой. Одним из важнейших стал анонсированный весной 2025 года проект Google и Vocus, желающих дотянуть до побережья страны подводный интернет-кабель Honomoana.

04.09.2025 [14:54], Сергей Карасёв

ICL организовала производство модульных ЦОД DataCubeРоссийская группа компаний ICL приступила к производству собственных модульных дата-центров семейства DataCube. Решения, как утверждается, ориентированы на предприятия, стремящиеся оптимизировать свою IT-инфраструктуру и повысить эффективность работы. За проект DataCube отвечает системный интегратор ICL Services в составе группы ICL. Модульный подход, по заявлениям компании, обеспечивает лёгкость в расширении, снижение капитальных затрат и улучшение надёжности систем. При этом площадка может быть развёрнута в непосредственной близости от объекта заказчика. Все решения соответствуют стандарту Tier III. В семейство модульных ЦОД вошли три модификации — ICL Data MonoCube, ICL Data MultiCube и ICL Data MegaCube. Первая представляет собой полностью готовый к работе дата-центр, созданный для оперативного развёртывания IT-инфраструктуры. На базе MonoCube могут развёрнуты от 5 до 10 стоек, а максимальная мощность IT-нагрузки составляет 90 кВт. Модуль легко транспортируется и устанавливается на улице или в помещении, а внутренняя компоновка обеспечивает эффективную эксплуатацию и обслуживание оборудования, говорит компания. Внутри размещены системы охлаждения, электроснабжения и безопасности, а также ИБП.

Источник изображений: ICL ICL Data MultiCube вмещает от 12 до 20 стоек с максимальной мощностью IT-нагрузки 180 кВт. Этот ЦОД включает нескольких взаимосвязанных модулей, объединённых в единую адаптируемую архитектуру. Решение предназначено для уличного размещения. В состав входят машинный зал с межрядным охлаждением и системой изоляции горячих и холодных коридоров, а также технический модуль с системой электропитания (N или 2N), ИБП (N+1 или 2N), щитами АВР, системами безопасности и АГПТ. Предусмотрены система мониторинга, видеонаблюдение, СКУД и СКС. Возможно подключение ДГУ.  Старшая версия ICL Data MegaCube собирается из модулей высокой заводской готовности непосредственно на площадке заказчика. Количество стоек варьируется от 25 до 64 и более, мощность IT-нагрузки — от 200 кВт. Каждый элемент инфраструктуры — от машинного зала до электропитания и систем безопасности — размещается в отдельных специализированных модулях. Такая архитектура обеспечивает надёжную работу систем, быстроту масштабирования и строгий контроль всех инженерных процессов, сообщает ICL.

04.09.2025 [14:47], Руслан Авдеев

Google бросила вызов NVIDIA, предложив малым облачным провайдерам собственные ИИ-ускорители TPUПо последним данным, Google обратилась к небольшим облачным провайдерам, обычно сдающим в аренду чипы NVIDIA, с необычным предложением — сдавать в аренду её собственные ИИ-ускорители TPU, ранее доступные только в облаке самой Google, сообщает Trendforce со ссылкой на The Information. Это может привести к прямой конкуренции с NVIDIA. Сообщается, что Google уже заключила соглашение как минимум с одним поставщиком облачных сервисов — лондонской Fluidstack. Предполагается разместить TPU в нью-йоркском дата-центре последней. Fluidstack предложены льготы для расширения бизнеса за счёт TPU. Если компания не сможет покрыть расходы на аренду ЦОД в Нью-Йорке, Google обещает предоставить поддержку в объёме до $3,2 млрд. Как утверждается в отчёте, Google ориентируется на молодые компании, в основном на поставщиков облачных услуг, активных пользователей ускорителей NVIDIA. Сообщается, что она уже пыталась заключить аналогичные договоры с другими поставщиками, в настоящее время отдающими предпочтение NVIDIA — включая такие перспективные компании как Crusoe, которая строит ЦОД для OpenAI. Также возможно сотрудничество с CoreWeave, сдающей оборудование NVIDIA в аренду Microsoft (в основном для OpenAI) и также имеющей прямой контракт с OpenAI.

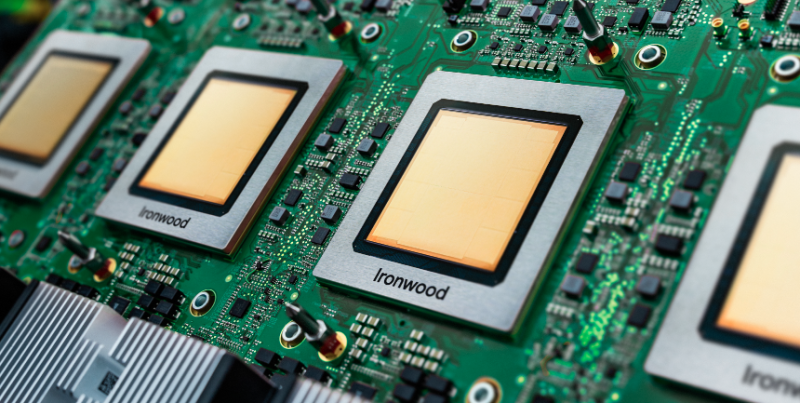

Источник изображения: Google Google довольно давно работает над созданием ИИ-ускорителей. По данным источников The Information, компания рассматривала возможности расширения связанного с TPU бизнеса, чтобы увеличить выручку и снизить зависимость от чипов NVIDIA. По оценкам Morningstar, совокупную стоимость бизнеса TPU и подразделения DeepMind составляет приблизительно $900 млрд. Отмечается, что вышедшие в декабре 2024 года TPU Trillium шестого поколения, весьма востребованы, ожидается и рост спроса на седьмое поколение ускорителей — TPU Ironwood. Это первая модель, разработанная для масштабного инференса. Ранее Google в основном применяла TPU для собственных проектов. Однако некоторое время назад доступность TPU для внешних заказчиков в рамках Google Cloud стала намного выше. Эти чипы использует, например, Apple. Впрочем, и она теперь хочет получить ускорители NVIDIA.

04.09.2025 [09:37], Руслан Авдеев

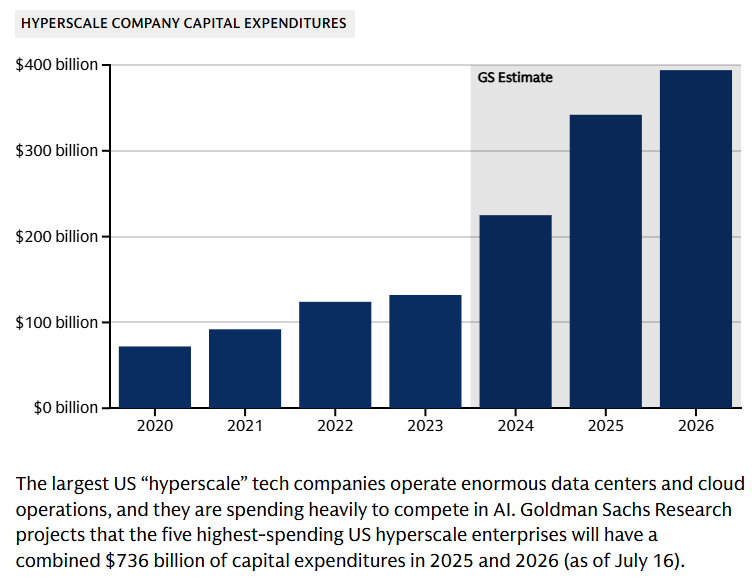

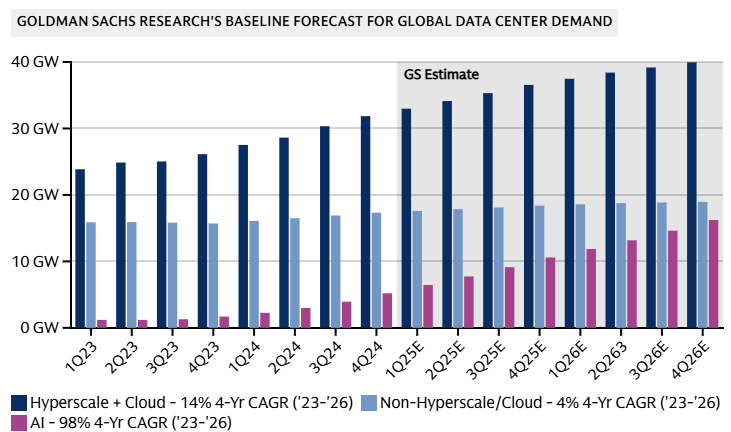

Goldman Sachs допускает крах «пузыря» ИИ на фоне бума в сфере ЦОДИсследование Goldman Sachs свидетельствует, что к 2027 году мощность ЦОД вырастет на 50 % благодаря спросу на ИИ, а энергопотребление сектора удвоится к 2030 году. При этом финансисты отмечают, что повсеместное внедрение ИИ может не оправдать ожиданий инвесторов, сообщает The Register — ИИ-бум породил «лихорадочную атмосферу», в которой крупные технологические компании находятся в постоянном страхе из-за вероятных изменений рынка. По оценкам компании, сегодня глобальная мощность дата-центров составляет порядка 62 ГВт, на облачные нагрузки приходится 58 %, на традиционные нагрузки — 29 % и лишь 13 % — на искусственный интеллект. В начале 2023 года доля ИИ-нагрузок была околонулевой, а к 2027 году она достигнет уже 28 %. Доля облачных нагрузок сократится до 50 %, традиционных — до 21 %. Конечно, сократится лишь доля от общей мощности, а не сами нагрузки из-за активного развития ИИ. По данным Omdia, расходы на ЦОД уже сопоставимы со средними по размеру мировыми экономиками — одна Amazon инвестирует в ЦОД около $118 млрд, что приблизительно равно ВВП Коста-Рики. В Counterpoint Research допускают, что бум ИИ ЦОД может привести к удвоению мировых доходов полупроводниковой промышленности с 2024 по 2030 гг. до более $1 трлн. Большая часть спроса, вероятно, будет приходиться на решения гиперскейл-уровня в краткосрочной и долгосрочной перспективе.

Источник изображения: Lanju Fotografie/unsplash.com Обучение ИИ требует специального оборудования, что приводит к кардинальным изменениям рынка. По данным Goldman Sachs, если два года назад на передовой сервер приходилось по восемь ИИ-ускорителей, то к 2027 году речь будет идти о 576 экземплярах, потребляющих 600 кВт — речь про стойки Kyber с суперускорителями NVIDIA Rubin Ultra NVL576.

Источник изображения: Goldman Sachs Research В результате к 2030 году потребление дата-центрами электричества в мире должно вырасти на 165 %, т.е. с 1–2 % в 2023 году до 3–4 % к концу текущего десятилетия. Ожидается, что за счёт возобновляемых источников будет обеспечено 40 % дополнительной энергии для ЦОД. Поможет и ядерная энергетика, но не так кардинально. Оставшиеся 60 % придётся на генерацию на природном газе, что увеличит выбросы парниковых газов к концу текущего десятилетия на 215–220 млн т — эквивалент 0,6 % от общемировых выбросов, связанных с энергетикой.

Источник изображения: Goldman Sachs Research Хотя прогнозы экспертов относительно рынка ЦОД обычно оптимистичны, финансовые эксперты тщательно следят за любыми негативными изменениями на рынке. Риски включают потенциальные проблемы с монетизацией ИИ. К ним же относится и вариант, при котором инновации значительно удешевят разработку и коммерциализацию моделей. Базовый сценарий предполагает CAGR моoностей ЦОД на уровне 17 % — 92 ГВт к 2027 году. При этом разные сценарии прогнозируют рост в 14 % (если ИИ будет не так интересен бизнесу, как ожидается) до 20 % — если ситуация будет развиваться более оптимистично. Опасения финансовых магнатов отражают «ИИ-скептицизм», присутствующий в более широком масштабе. Глава OpenAI Сэм Альтман (Sam Altman) недавно констатировал, что в отрасли наблюдается «ИИ-пузырь», а эксперты компании McKinsey ещё в начале года предупредили, что никто не может с высокой достоверностью прогнозировать спрос на ИИ в будущем.

03.09.2025 [23:51], Руслан Авдеев

Рынок коммерческих ЦОД в России показал антирекорд по приросту стойко-местСогласно данным iKS-Consulting, в I половине 2025 года строительство ЦОД в России значительно сбавило темпы — в стране введено втрое меньше новых мощностей, чем за год до этого, во многом из-за проблем с финансами: нехваткой инвестиций с ростом затрат. Всё это происходит на фоне дефицита стойко-мест в ключевых регионах, Москве и Санкт-Петербурге, и дальнейшей концентрации рынка в руках нескольких лидеров. В I полугодии в коммерческих дата-центрах России появились 3,7 тыс. новых стоек, что в три раза меньше год к году. Если по итогам 2024 года прирост количества стойко-мест составил 15,3 % (суммарно 81,2 тыс.), то в текущем году они, вероятно, составят 5,5 % (85,7 тыс.). Завершение реализации многих проектов коммерческих ЦОД перенесли с 2025 на 2026–2027 гг. Ранее органический рост рынка коммерческих ЦОД характеризовался вводом в эксплуатацию «волнами», но подобного зарегистрированному в I полугодии изменения динамики рынок не видел уже 10 лет. По словам аналитиков, имеется дефицит финансовых и кадровых ресурсов. Игрокам рынка сложно получить финансирование из-за высокой стоимости заёмного капитала и ставки ЦБ. Сложившаяся ситуация приводит к неопределённости в планировании дальнейших вложений. Более того, многие страдают от иностранных санкций, из-за которых затруднена закупка оборудования, и возросших требований к обеспечению безопасности данных. Общий объём рынка коммерческих ЦОД в РФ по выручке в 2024 году составил 130,9 млрд руб. (+16,3 % год к году): 38,8 % пришлось на колокацию, 53,8 % — на облачные сервисы. По итогам прошлого года основной объём введённых стоек пришёлся на Московский регион (77,2 %) и Санкт-Петербург (9,5 %), а прочим регионам досталось лишь 13,3 %. В этом году географическое распределение существенно не поменяется. В среднесрочной перспективе аналитики ожидают возведение удалённых от клиентов дата-центров и микро-ЦОД на их территории. Среди прочего ожидается переход госструктур на сервисную модель. В пятёрку лидеров по количеству стойко-мест вошли РТК-ЦОД, IXCellerate, Росатом, DataPro и Selectel, лидерами по подведённой мощности считаются они же в аналогичном порядке. При этом концентрация рынка только усилится. Согласно прогнозу, к концу 2025-го у РТК-ЦОД будет введено суммарно 27 637 стойко-мест, у IXCellerate — 10 329, а у Росатома и DataPro — 6570 и 6553 соответственно. Максимальная разрешённая электрическая мощность коммерческих ЦОД в 2025 году, как ожидается, составит 990,6 МВт (+18 % год к году). Средняя максимальная разрешённая мощность на стойку составляет чуть более 10 кВт, средняя IT-мощность стойки — 5,98 кВт. В среднесрочной перспективе ожидается ограниченный рост спроса на стойки высокой плотности для ИИ-проектов, рост цены строительства 1 кВт и стоимости аренды, а также развитие ЦОД с неоднородной отказоустойчивостью.

03.09.2025 [18:03], Руслан Авдеев

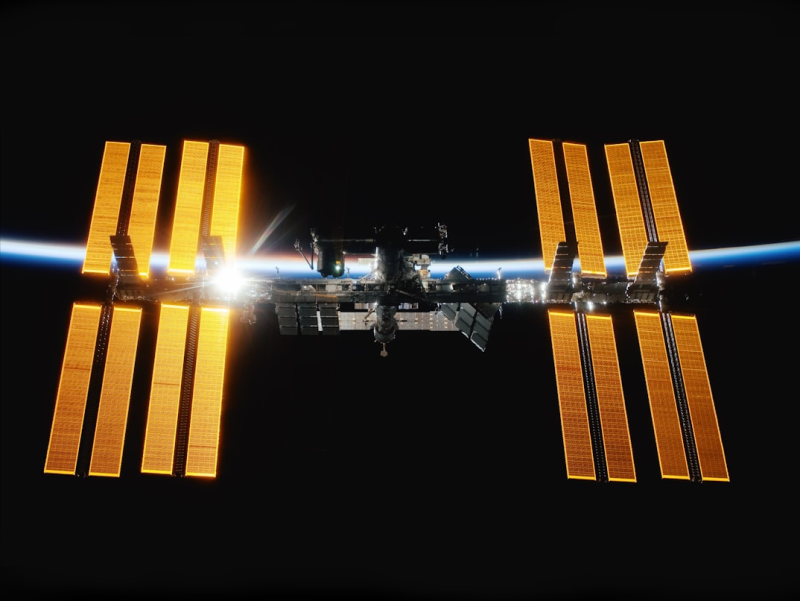

Прототип орбитального ЦОД Axiom Space и Red Hat для экспериментов с периферийными вычислениями прибыл на МКС24 августа Axiom Space и Red Hat отправили на МКС прототип орбитального ЦОД, который уже прибыл на станцию в составе 33-й коммерческой грузовой миссии SpaceX, сообщает Datacenter Knowledge. Целью эксперимента является проверка возможности автономной работы современной вычислительной инфраструктуры в космосе, не полагаясь на зависимость от дорогих спутниковых каналов связи. Новое решение оснащено модулем Axiom Space AxDCU-1, работающем на платформе Red Hat Device Edge, специально разработанной для сред с ограниченными ресурсами. Система использует облегчённый вариант Kubernetes-окружения — платформу Red Hat MicroShift, дающую возможность запускать контейнеризированные рабочие нагрузки в космосе. Задачи выполняются в контейнерах, которые можно удалённо обновлять с Земли. Ключевая особенность системы — её способность работать автономно, без постоянной связи, самостоятельно справляясь с длительными перерывами в коммуникации, которые возникают из-за быстрого движения МКС по орбите. Red Hat Device Edge решает проблему с помощью автоматического отката состояния и функций самовосстановления без вмешательства человека, а также встроенного мониторинга работоспособности и производительности. Для экономии трафика используют дельта-обновления ПО. Сообщается, что дефицит сетевых и вычислительных ресурсов всегда был проблемой на МКС, многие годы было трудно анализировать и передавать данные в режиме реального времени. Орбитальный ЦОД поможет решить эту проблему, с локальной обработкой информации и отправкой на Землю уже готовых результатов. Предполагается, что полезнее всего это будет для экспериментов в сфере естественных наук и биомедицины. В ходе таких исследований часто генерируются большие объёмы данных, но необходимость передавать их на Землю может привести к потерям более ценной и срочной информации. Axiom Space разрабатывает и собственную коммерческую станцию, которая будет оснащена значительными по меркам космоса вычислительными мощностями. По мере развития новой станции будет расти и потребность в масштабируемых, независимых вычислительных средах. «Контейнерный» подход предназначен для поддержки периферийного ИИ, автоматизации и поддержки критически важного ПО на будущих платформах. Впрочем, инновации для космоса найдут место и на Земле, где тоже немало мест с экстремальными условиями. По словам представителя компании-разработчика, извлекаемые «уроки» приносят прямую пользу — повышение надёжности критической инфраструктуры, развитие автономных систем, периферийного ИИ и др. для удалённых или ограниченных в ресурсах регионах напрямую способствуют улучшению качества жизни на Земле.

03.09.2025 [17:22], Сергей Карасёв

«К2 НейроТех» представил ПАК-AI 2.0 с увеличенной на 30 % производительностью

emerald rapids

gpu

hardware

intel

sapphire rapids

xeon

yadro

ии

к2тех

россия

сделано в россии

сервер

Компания «К2 НейроТех», подразделение компании «К2Тех», анонсировала программно-аппаратный комплекс ПАК-AI 2.0, предназначенный для построения локальной ИИ-инфраструктуры. Утверждается, что по сравнению с оригинальной версией платформы, дебютировавшей в июне нынешнего года, производительность поднялась на 30 %. ПАК объединяют аппаратный слой, платформу управления, преднастроенное ПО и инструменты для работы с ИИ. Решение может быть кастомизировано под конкретные задачи заказчика. Количество серверных стоек масштабируется для обеспечения необходимой производительности. Реализован встроенный маркетплейс приложений, через который в числе прочего доступна платформа Yandex Cloud AI Studio для создания приложений на базе ИИ. Обновленная аппаратная платформа ПАК-AI 2.0 включает шесть серверов YADRO, в том числе серверы для глубокого обучения, инференса и работы с большими данными, а также новый GPU-сервер G4208P G3. Последний специально разработан для обучения нейросетей, обработки больших объемов данных и построения распределённых ИИ-кластеров. Этот сервер несёт на борту два процессора Intel Xeon Sapphire Rapids или Emerald Rapids с TDP до 350 Вт. Поддерживается до 8 Тбайт DDR5. Возможна установка до восьми GPU двойной ширины (PCIe 5.0 x16) с энергопотреблением до 450 Вт каждый. Помимо улучшенной аппаратной части, ПАК-AI 2.0 получил доработанную сборку Kubernetes, которая предоставляет в режиме самообслуживания работу с различными ускорителями (в том числе PCIe, SXM) в формате GPU, vGPU MIG и увеличивает производительность GPU до 30 %. Благодаря этому, как утверждается, повышается эффективность запуска моделей машинного обучения и снижаются эксплуатационные расходы. «К2 НейроТех» заявляет, что ПАК позволяет в короткие сроки развернуть IT-инфраструктуру, которая максимально раскрывает потенциал ИИ, обеспечивает высокий уровень безопасности и соответствие регламентам ИБ, а также прозрачное управление данными. Благодаря наличию LLM-моделей и агентов, предварительно настроенных для выполнения бизнес-задач, ускоряется вывод продуктов на рынок. |

|