Материалы по тегу: hardware

|

03.09.2025 [14:11], Сергей Карасёв

Acer представила компактную ИИ-станцию Veriton GN100 за $4000 с суперчипом NVIDIA GB10Компания Acer анонсировала рабочую станцию небольшого форм-фактора Veriton GN100 AI Mini Workstation, предназначенную для решения задач в области ИИ. Новинка, в частности, обеспечивает возможность локального запуска моделей с большим количеством параметров, снижая зависимость от облачной инфраструктуры. Устройство выполнено в корпусе с габаритами 150 × 150 × 50,5 мм. Основой служит суперчип NVIDIA GB10 Grace Blackwell, который объединяет ускоритель Blackwell с тензорными ядрами пятого поколения и 20-ядерный процессор Grace (10 × Arm Cortex-X925 и 10 × Arm Cortex-A725). Заявленная ИИ-производительность достигает 1000 TOPS на операциях FP4. Новинка несёт на борту 128 Гбайт памяти LPDDR5x, а вместимость SSD формата M.2 (NVMe) может достигать 4 Тбайт (поддерживается шифрование данных). В оснащение входят адаптеры Wi-Fi 7 и Bluetooth 5.1, а также сетевой контроллер NVIDIA ConnectX-7 SmartNIC. Предусмотрены четыре порта USB 3.2 Type-C, интерфейс HDMI 2.1b и разъём RJ45 для сетевого кабеля. Весит устройство около 1,5 кг. В качестве программной платформы применяется NVIDIA DGX OS — модификации Ubuntu, адаптированная специально для работы с ИИ. Две рабочие станции Veriton GN100 AI Mini Workstation посредством ConnectX-7 могут быть объединены в одну систему, что позволит работать с ИИ-моделями, насчитывающими до 405 млрд параметров. Говорится о поддержке таких инструментов, как PyTorch, Jupyter и Ollama. Приобрести новинку можно будет по ориентировочной цене $4000 или €4000 в зависимости от региона продаж.

03.09.2025 [09:47], Владимир Мироненко

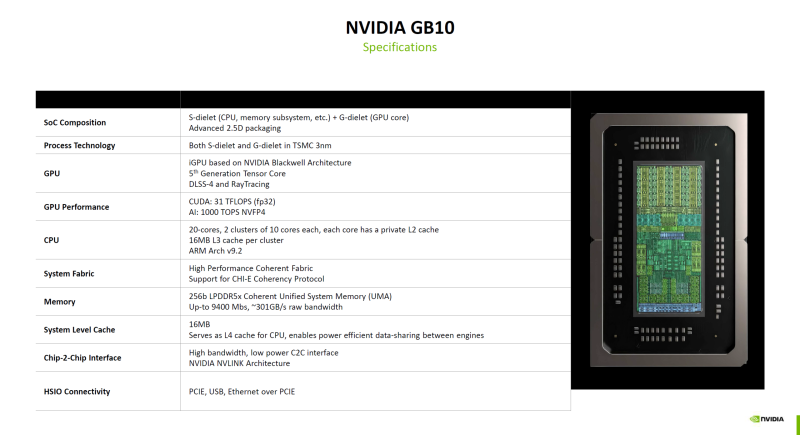

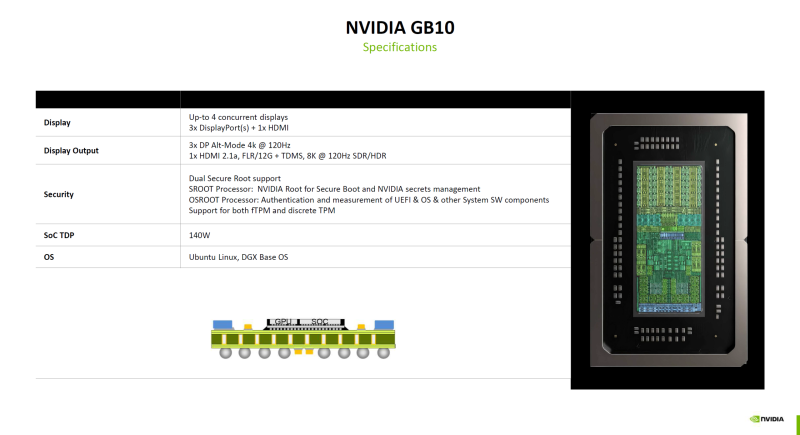

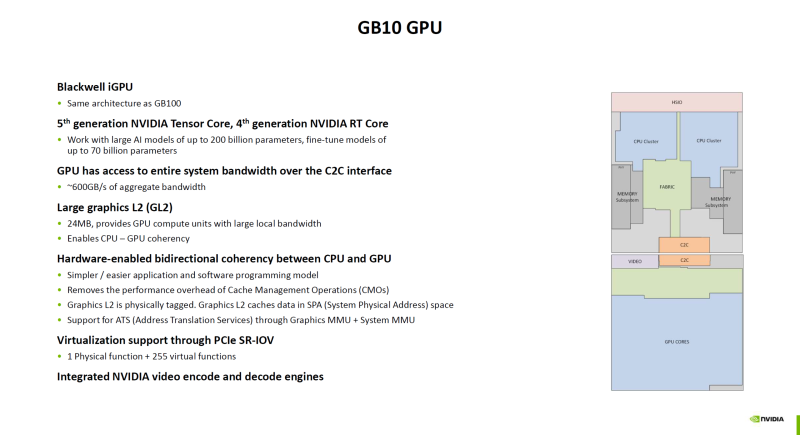

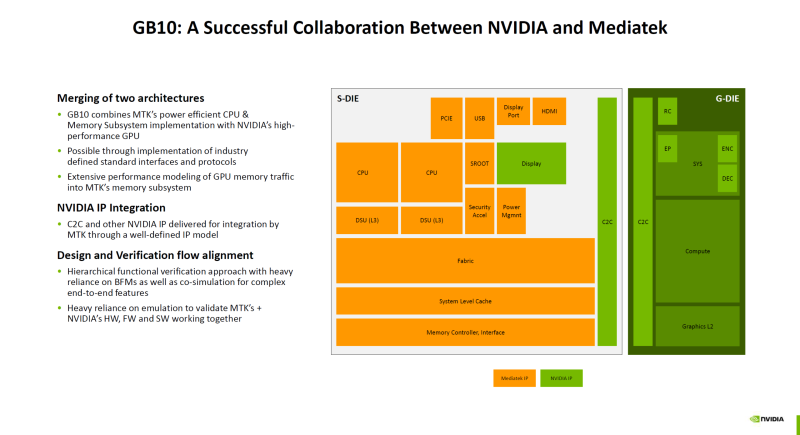

Гибридный суперчип NVIDIA GB10 оказался технически самым совершенным в семействе BlackwellNVIDIA поделилась подробностями о суперчипе GB10 (Grace Blackwell), который ляжет в основу рабочих станций DGX Spark (ранее DIGITS) для ИИ-задач, пишет ресурс ServeTheHome. Ранее сообщалось, что GB10 был создан NVIDIA в сотрудничестве MediaTek. GB10 объединяет чиплет CPU от MediaTek (S-Dielet) с ускорителем Blackwell (G-Dielet) с помощью 2.5D-упаковки. Оба кристалла изготавливаются по 3-нм техпроцессу TSMC. Как отметил ServeTheHome, GB10 технически является самым передовым продуктом на архитектуре Blackwell на сегодняшний день. CPU включает 20 ядер на базе архитектуры Armv9.2, которые разбиты на два кластера по десять ядер (Cortex-X925 и Cortex-A725). На каждый кластер приходится 16 Мбайт кеш-памяти L3. Унифицированная оперативная память LPDDR5X-9400 ёмкостью 128 Гбайт подключена напрямую к CPU через 256-бит интерфейс с пропускной способностью 301 Гбайт/с. Объёма памяти достаточно для работы с моделями с 200 млрд параметров. На кристалле CPU также находятся контроллеры HSIO для PCIe, USB и Ethernet. Для адаптера ConnectX-7 с поддержкой RDMA и GPUDirect выделено всего восемь линий PCIe 5.0, что не позволит работать обоим имеющимся портам в режиме 200GbE. Именно этот адаптер позволяет объединить две системы DGX Spark в пару для работы с ещё более крупными моделями. G-Die имеет ту же архитектуру, что и B100. Ускоритель оснащён тензорными ядрами пятого поколения и RT-ядрами четвёртого поколения и обеспечивает производительность 31 Тфлопс в FP32-вычислениях. ИИ-производительность в формате NVFP4 составляет 1000 TOPS. Ускоритель подключён к CPU через шину NVLink C2C с пропускной способностью 600 Гбайт/с. G-Die оснащён 24 Мбайт кеш-памяти L2, которая также доступна ядрам CPU в качестве кеша L4, что обеспечивает когерентность памяти между CPU и GPU на аппаратном уровне. Поддерживается технология SR-IOV, интегрированы движки NVDEC и NVENC. Возможно подключение до четырёх дисплеев: три DisplayPort Alt-mode (4K@120 Гц) и один HDMI 2.1a (8K@120 Гц). Что касается безопасности, есть выделенные процессоры SROOT и OSROOT, а также поддержка fTPM и дискретного TPM (по данным Wccftech). TDP GB10 составляет 140 Вт.

03.09.2025 [08:53], Руслан Авдеев

«Фантомные» ИИ ЦОД ещё не построены, но уже мешают энергокомпаниям СШАДата-центры США отчаянно нуждаются в электроэнергии, но пока нет точных данных, сколько их будет построено в итоге и сколько электричества им действительно необходимо. Американские коммунальные компании сообщают о взрывном росте запросов на присоединение к сетям со стороны будущих ИИ ЦОД, причём в некоторых случаях их аппетиты многократно превышает текущее энергопотребление региона, сообщает The Wall Street Journal. Так, American Electric Power (AEP), обслуживающая 11 штатов, и техасские Oncor (Sempra) с CenterPoint Energy суммарно получили от дата-центров запросы на фантастические 400 ГВт. Проблема отчасти в том, что нередко потребности одного и того же дата-центра многократно учитываются разными коммунальными службами — застройщики направляют запросы самым разным поставщикам электричества, одновременно подыскивая лучшие места для будущих ЦОД. При этом по факту многие проекты так и останутся на бумаге, поскольку на присоединение к энергосетям уходят годы, а за это время могут поменяться законы, правила зонирования и т.д. Такие объекты уже прозвали «фантомными ЦОД». Поэтому коммунальные службы не хотят рисковать, наспех строя лишние электростанции и ЛЭП, поскольку не исключено, что ИИ-бум представляет собой очередной «мыльный пузырь», платить за который придётся остальными потребителям.

Источник изображения: American Public Power Association/unsplash.com По данным Министерства труда, цены на электроэнергию по всей стране за год уже выросли на 5,5 %. Спрос на электричество в США не менялся почти 20 лет, приблизительно до 2020 года, но сейчас он растёт по всей стране примерно на 2 % в год. Во многом это связано с ажиотажем вокруг ИИ с его фантастически выросшими запросами. Быстрее всего спрос растёт в местах вроде Северной Вирджинии и Техаса, где строятся крупные ЦОД и развивается производство. Например, к концу у Oncor было 552 запроса на присоединение к сети от крупных клиентов, включая ЦОД и производственные предприятия, т.е. почти на треть больше, чем в конце марта. Пиковый уровень потребления электричества клиентами компании составляет 31 ГВт. При этом ЦОД просят ещё 186 ГВт, а промышленные предприятия — порядка 19 ГВт. Если раньше типичный запрос составлял менее 100 МВт, то сейчас этот показатель приблизился к 700 МВт. Энергосистема AEP оценивается в 37 ГВт, уже заключены соглашения ещё на 24 ГВт. При этом в очереди на рассмотрении находятся заявки на колоссальные 190 ГВт. В компании полагают, что не все проекты будут реализованы. Наконец, потребление клиентов CenterPoint Energy в районе Хьюстона (Техас) составляет чуть больше 22 ГВт, и это один из самых высоких показателей для мегаполиса США. Запросы на подключение составляют 53 ГВт, из них 25 ГВт приходится на ЦОД. При этом год назад ЦОД было нужно всего 1 ГВт. По оценкам компании, по факту понадобится лишь пятая часть запрошенных мощностей. Как сообщало в апреле Международное энергетическое агентство (IEA), энергопотребление ЦОД к 2030 году в мире вырастет более чем вдвое. В конце 2024 года появился отчёт Национальной лаборатории Лоуренса в Беркли (LBNL), где сообщалось, что в 2028 году на дата-центры США может прийтись уже 12 % энергопотребления всей страны. В конце июля 2025 года Anthropic предрекла, что к 2028 году только для ИИ в США потребуется 50 ГВт. Впрочем, ИИ-чипов может на всех и не хватить.

03.09.2025 [01:58], Владимир Мироненко

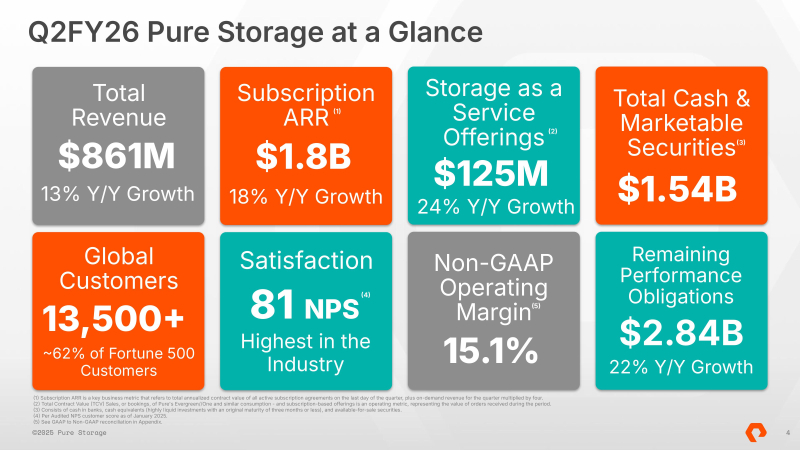

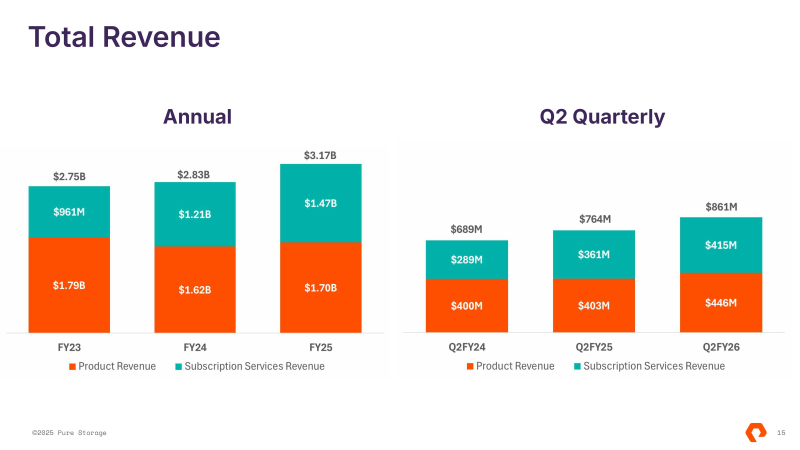

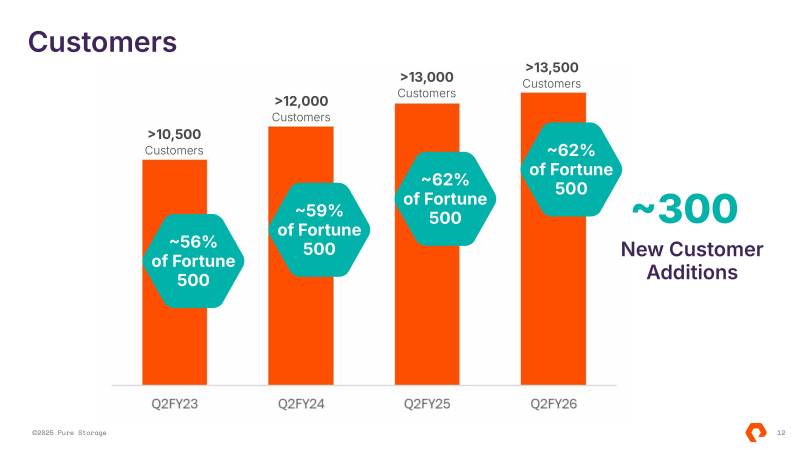

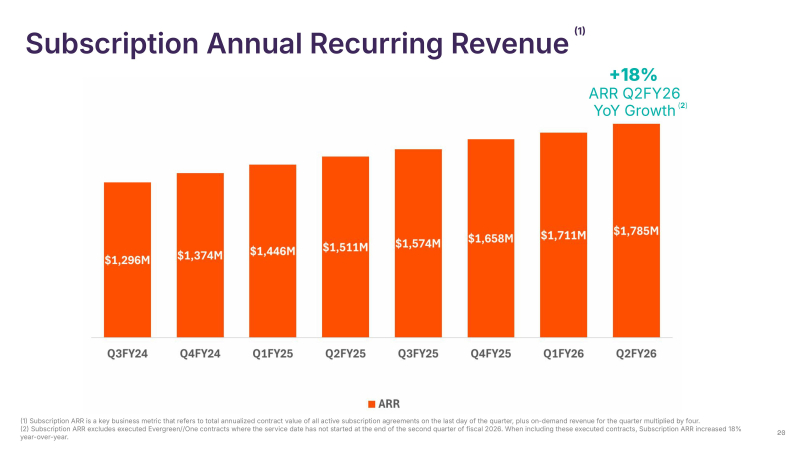

Акции Pure Storage резко выросли после квартального отчёта на фоне успехов в сотрудничестве с Meta✴Акции Pure Storage подскочили на 32 % до рекордной отметки после того, как этот поставщик СХД опубликовал квартальные результаты, превзошедшие прогнозы Уолл-стрит, и повысил свой прогноз на год, сообщил CNBC. Выручка Pure Storage за II финансовый квартал, завершившийся 3 августа 2025 года, составила $861 млн, превысив результат аналогичного квартала годом ранее на 13 %, а также консенсус-прогноз аналитиков, опрошенных LSEG, в размере $846,9 млн. Скорректированная прибыль на акцию (non-GAAP) составила 43 цента, превысив средний прогноз аналитиков, согласно опросу LSEG, в 39 центов. Чистая прибыль (GAAP) составила $47,1 млн или $0,14 на акцию, что больше показателя годом ранее на 32 %. Выручка от предоставления услуг по подписке выросла год к году на 15 % до $414,7 млн. Ежегодный регулярный доход (ARR) от подписки увеличился на 18 % до $1,8 млрд. Продажи продуктов увеличились на 10,9 % до $446,3 млн. Оставшиеся обязательства (RPO) составили $2,8 млрд (рост год к году на 22 %). В III квартале Pure Storage прогнозирует выручку в размере $950 – $960 млн, что значительно превышает целевой показатель Уолл-стрит в $913,2 млн (по данным SiliconANGLE). Компания повысила свой прогноз выручки на весь год до $3,6 – $3,63 млрд с прежнего диапазона $3,51–$3,53 млрд. Как пишет Blocks & Files, компания сообщила, что было заключено около 300 новых договоров с клиентами, при этом общее количество клиентов превысило 13,5 тыс. и приближается к 14 тыс. Выручка от платформы STaaS увеличилась на 24 % в годовом исчислении до $125 млн. Аналитик NAND Research Стив Макдауэлл (Steve McDowell) сообщил ресурсу SiliconANGLE, что предложения компании в сегменте Storage-as-a-Service были самым ярким событием в отчётном квартале, поскольку выручка от этой услуги росла значительно быстрее, чем предложения в любом другом продуктовом сегменте. Финансовый директор Тарек Роббиати (Tarek Robbiati) отметил «значительный рост всего портфолио, поддерживаемый спросом со стороны крупных предприятий, и продолжающуюся динамику развития FlashBlade, включая FlashBlade//E, а также ускорение темпов роста основных предложений ПО и услуг Evergreen//One, Cloud Block Store и Portworx». Он пояснил, что капвложения в размере $62 млн включают покупку тестового и инфраструктурного оборудования для поддержки расширения ЦОД и обеспечения роста числа подписчиков Evergreen//One. В марте Pure Storage объявила, что заключила соглашение с Meta✴, согласно которому станет «ключевым поставщиком хранилищ» для социальной сети. В ходе общения с аналитиками гендиректор и председатель совета директоров Чарльз Джанкарло (Charles Giancarlo) заявил: «Наше стратегическое сотрудничество с Meta✴ продолжается по плану. Они уже начали первое масштабное развёртывание, и во II квартале мы получили первую выручку от этой деятельности». Роббиати сообщил, что компания ожидала в 2026 финансовом году развёртывание 1–2 Эбайт с использованием технологии DirectFlash в рамках соглашения с Meta✴ и теперь есть уверенность, что прогноз будет реализован, и, возможно, превышен. Он добавил, что компания отмечает «растущий интерес со стороны других гиперскейлеров», стремящихся заменить свои традиционные СХД на решения Pure. Технический директор Роб Ли (Rob Lee) заявил, что сделка с Meta✴ «ускорила взаимодействие как с другими потенциальными клиентами-гиперскейлерами, так и с поставщиками… Эти ранние взаимодействия продвигаются успешно… идёт активное раннее тестирование и оценка технологий, а также проводятся многочисленные проверки концепции». Ли рассказал, что этот процесс существенно отличается от традиционного цикла продаж: «Это скорее процесс совместной разработки, состоящий из нескольких этапов. Выбор технологии для оценки, её тестирование, в конечном итоге приводящее к победе в дизайне, когда данная технология выбирается в качестве своего рода плана, затем проводится поэтапное валидационное тестирование на пути к пилотной версии и, наконец, к масштабированию». Ли также отметил, что Pure Storage наращивает продажи на рынке неооблаков: «Мы добились ряда успехов с поставщиками GPUaaS, обслуживая не только их GPU, но и некоторые из их потребностей в резервном копировании и защите данных, а также ВМ и блочном хранилище». В интервью CNBC Джанкарло заявил, что хотя компания продаёт свои продукты корпоративным клиентам около 15 лет с момента своего основания, в последнее время она ориентируется на гиперскейлеров. В результате рекордного роста акций рыночная стоимость Pure Storage увеличилась до $26 млрд.

02.09.2025 [14:47], Руслан Авдеев

OpenAI построит в Индии дата-центр мощностью более 1 ГВтOpenAI намерена построить в Индии дата-центр мощностью не менее 1 ГВт. Компания ищет местных партнёров для сотрудничества в рамках нового проекта, сообщает Silicon Angle со ссылкой на Bloomberg. Кроме того, партнёров ищут и для продвижения ChatGPT на местном рынке. По предварительным оценкам, новый ИИ ЦОД сможет разместить почти 60 тыс. чипов NVIDIA B200. Пока нет данных, входит ли новый ЦОД в инициативу компании OpenAI for Countries. Программа, запущенная в 2025 году, предполагает создание ИИ ЦОД по всему миру. OpenAI уже заключила контракты на создание инфраструктуры в ОАЭ и Норвегии. Впрочем, речь идёт не только о дата-центрах. Компания предлагает помощь в запуске локальных версий ChatGPT и поддержку местных ИИ-стартапов, в том числе инвестиции в некоторые из них. В феврале 2025 года глава OpenAI Сэм Альтман (Sam Altman) встретился с представителями индийских властей, чтобы обсудить создание «недорогой» ИИ-платформы. Недавно компания запустила новый тариф ChatGPT специально для Индии — подписка ChatGPT Go стоит всего около $4,5/мес. и позволяет обрабатывать в сутки в 10 раз больше запросов, чем в бесплатной версии. Также компания намерена распространить среди местных преподавателей и студентов около 500 тыс. лицензий на использование ChatGPT. До конца года OpenAI намерена открыть офис в Нью-Дели. Создание собственного ЦОД в Индии позволит сократить задержку доступа для местных пользователей. Кроме того, такой проект способен помочь и в борьбе за местных корпоративных клиентов. Особенно это касается организаций, которым необходимо хранить данные локально, обеспечивая информационную безопасность и конфиденциальность. Данные о строительстве ЦОД в Индии появились через несколько недель после заключения соглашения с Oracle о строительстве в США дата-центра на 4,5 ГВт. В следующие четыре года OpenAI намерена ввести в эксплуатацию в США не менее 5,5 ГВт дополнительных мощностей, что обойдётся, вероятно, в $500 млрд.

02.09.2025 [12:15], Сергей Карасёв

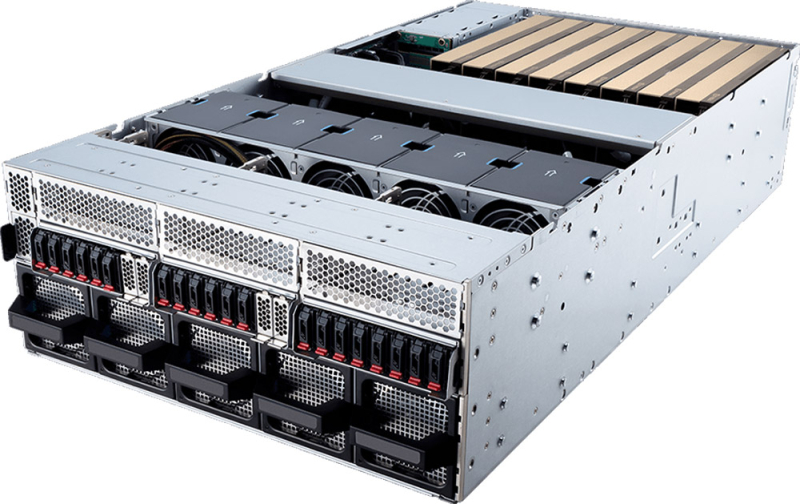

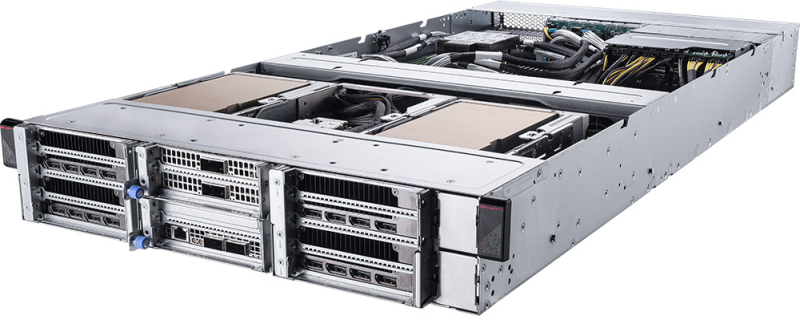

MSI выпустила серверы на платформе NVIDIA MGX с ускорителями RTX Pro 6000 Blackwell Server EditionКомпания MSI анонсировала серверы CG480-S5063 и CG290-S3063 на модульной архитектуре NVIDIA MGX. Новинки, ориентированные на задачи ИИ, оснащаются ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition с 96 Гбайт GDDR7. Модель CG480-S5063 выполнена в форм-факторе 4U. Допускается установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400/5200 или MRDIMM 8000). Во фронтальной части могут быть размещены 20 накопителей E1.S с интерфейсом PCIe 5.0 x4 (NVMe). Кроме того, есть два внутренних коннектора М.2 2280/22110 (PCIe 5.0 x2; NVMe). Система предлагает восемь слотов PCIe 5.0 x16 для карт FHFL двойной ширины и пять слотов PCIe 5.0 x16 для карт FHFL одинарной ширины. Таким образом, могут быть задействованы до восьми ИИ-ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на основе Intel X710-AT2, выделенный сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Питание обеспечивают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Задействовано воздушное охлаждение с вентиляторами, допускающими горячую замену. Диапазон рабочих температур — от 0 до +35 °C. В свою очередь, сервер CG290-S3063 типоразмера 2U рассчитан на один процессор Xeon 6500P/6700P с TDP до 350 Вт. Предусмотрены 16 слотов для модулей DDR5 (RDIMM 6400/5200 или MRDIMM 8000). В тыльной части расположены отсеки для четырёх SFF-накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe). Внутри есть два коннектора М.2 2280/22110 для SSD (PCIe 5.0 x2; NVMe). Данная система предоставляет четыре слота PCIe 5.0 x16 для карт FHFL двойной ширины и три слота PCIe 5.0 x16 для карт FHFL одинарной ширины. Могут быть использованы до четырёх ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. Прочие характеристики включают контроллер ASPEED AST2600, сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Применены четыре блока питания мощностью 2400 Вт с сертификатом 80 PLUS Titanium и воздушное охлаждение.

01.09.2025 [23:54], Сергей Карасёв

Разработчик термоядерных реакторов Commonwealth Fusion Systems получил на развитие ещё $863 млнКомпания Commonwealth Fusion Systems (CFS), отделившаяся от Массачусетского технологического института (MIT) в 2018 году, объявила о проведении очередного раунда финансирования, в ходе которого на развитие привлечено $863 млн. CFS специализируется на технологиях термоядерного синтеза. Компания рассчитывает до 2035 года создать коммерческие термоядерные реакторы мощностью 400 МВт. В мае 2025-го CFS привлекла более $1 млрд от неназванного гиперскейлера. А минувшим летом соглашение о покупке термоядерной энергии у CFS заключила Google: договор стал расширением партнёрства между двумя компаниями, впервые начатого в 2021 году. В осуществлённом раунде финансирования Series B2 приняло участие большое количество инвесторов. Впервые средства в CFS вложили Brevan Howard Macro Venture Fund, Counterpoint Global (Morgan Stanley), Stanley Druckenmiller, FFA Private Bank, Galaxy Interactive, Gigascale Capital, HOF Capital, Neva SGR (Intesa Sanpaolo Bank) и NVentures (венчурное подразделение NVIDIA), Planet First Partners и Woori Venture Partners US. Кроме того, в инвестиционной программе принял участие консорциум из 12 японских компаний во главе с Mitsui & Co. и Mitsubishi. Финансовую поддержку также оказали прежние инвесторы, включая Breakthrough Energy Ventures, Emerson Collective, Eni, Future Ventures, Gates Frontier, Google, Hostplus Superannuation Fund, Khosla Ventures, Lowercarbon Capital, Safar Partners, Эрик Шмидт (Eric Schmidt, бывший гендиректор Google), Starlight Ventures и Tiger Global. Полученные средства CFS направит в том числе на завершение работ над демонстрационной термоядерной установкой SPARC, которую планируется ввести в эксплуатацию в 2026–2027 гг. Кроме того, компания продолжит реализацию проекта по строительству термоядерной электростанции ARC в округе Честерфилд (Chesterfield) штата Вирджиния: этот объект, как ожидается, заработает в начале 2030-х годов. В случае успешной реализации ARC станет первым в своём роде проектом в области термоядерной энергетики, в рамках которого электроэнергия будет поступать в реальную энергосистему.

01.09.2025 [23:40], Руслан Авдеев

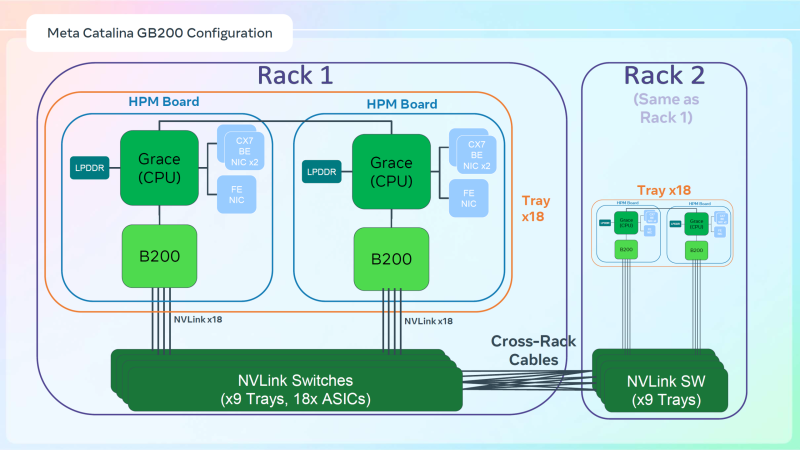

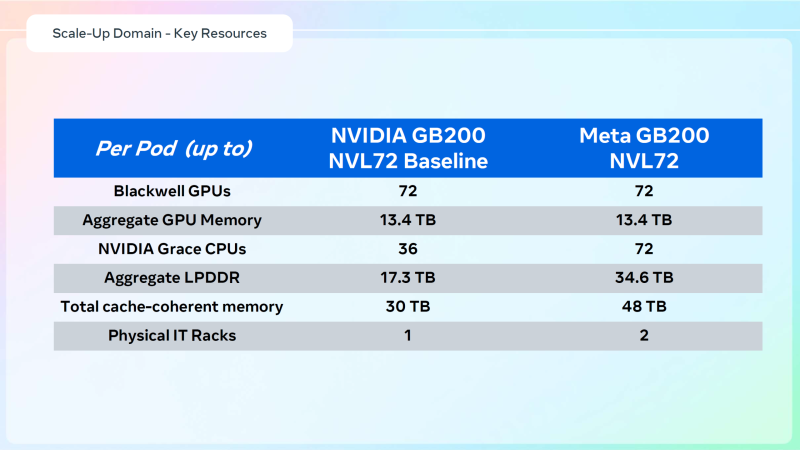

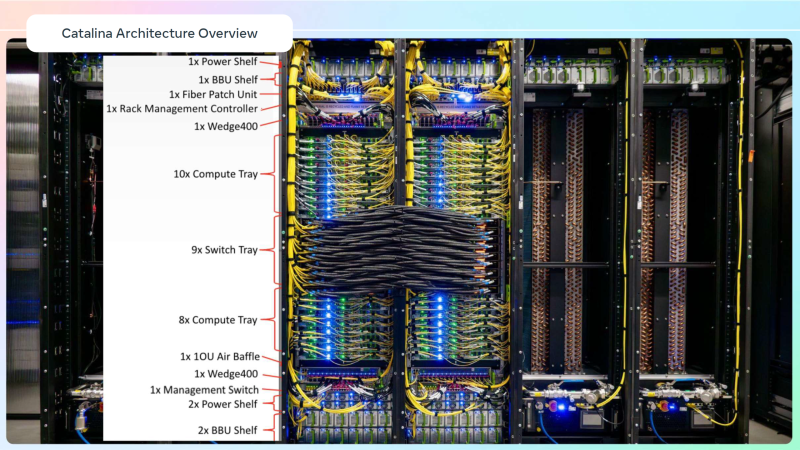

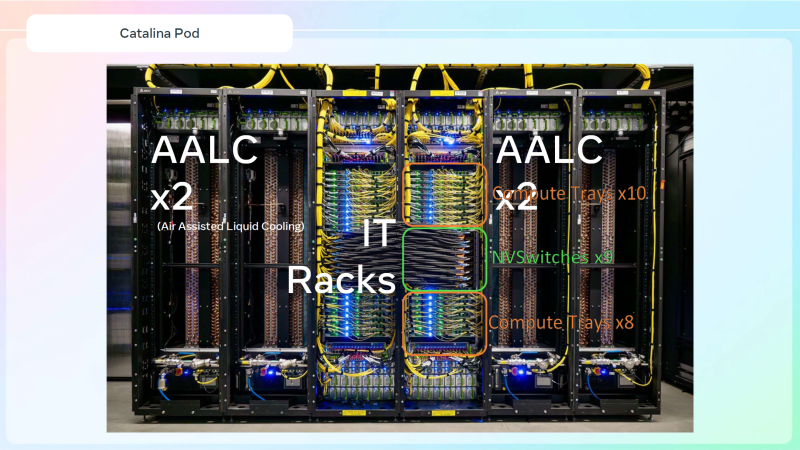

Meta✴ «растянула» суперускорители NVIDIA GB200 NVL36×2 на шесть стоек, чтобы обойтись воздушным охлаждениемДля того, чтобы развернуть в традиционных ЦОД с воздушным охлаждением современные высокоплотные стойки с ИИ-ускорителями, приходится идти на ухищрения. Один из вариантов предложила Meta✴, передаёт Wccftech. Хотя у Meta✴ есть собственный полноценный вариант суперускорителя NVIDIA GB200 NVL72 на базе ORv3-стоек Catalina (до 140 кВт) со встроенными БП и ИБП, компания также разработала также вариант, схожий с конфигурацией NVL36×2, от производства которого NVIDIA отказалась, посчитав его недостаточно эффективным. Ускоритель NVL36×2 задумывался как компромиссный вариант для ЦОД с воздушным охлаждением — одна стойка (плата Bianca, 72 × B200 и 36 × Grace) «растянута» на две.

Источник изображений: Meta✴ via Wccftech Meta✴ пошла несколько иным путём. Она точно так же использует две стойки, одна конфигурация узлов другая. Если в версии NVIDIA в состав одно узла входят один процессор Grace и два ускорителя B200, то у Meta✴ соотношение CPU к GPU уже 1:1. Все вместе они точно так же образуют один домен с 72 ускорителями, но объём памяти LPDDR5 в два раза больше — 34,6 Тбайт вместо 17,3 Тбайт. Эту пару «обрамляют» четыре стойки — по две с каждый стороны. Для охлаждения CPU и GPU по-прежнему используется СЖО, теплообменники которой находятся в боковых стойках и продуваются холодным воздухом ЦОД. Это далеко не самая эффективная с точки зрения занимаемой площади конструкция, но в случае гиперскейлеров оплата в арендуемых дата-центрах нередко идёт за потребляемую энергию, а не пространство. В случае невозможности быстро переделать собственные ЦОД или получить площадку, поддерживающую высокоплотную энергоёмкую компоновоку стоек и готовую к использованию СЖО, это не самый плохой вариант. В конце 2022 года Meta✴ приостановила строительство около дюжины дата-центров для пересмотра их архитектуры и внедрения поддержки ИИ-стоек и СЖО. Первые ЦОД Meta✴, построенные по новому проекту, должны заработать в 2026 году, передаёт DataCenter Dynamics. На сегодня у Meta✴ около 30 действующих или строящихся кампусов ЦОД, большей частью на территории США. Планируются ещё несколько кампусов, включая гигаваттные. Также компания выступает крупным арендатором дата-центров, а сейчас в пылу гонки ИИ и вовсе переключилась на быстровозводимые тенты вместо капитальных зданий, лишённые резервного питания и традиционных систем охлаждения. Собственные версии GB200 NVL72 есть у Google, Microsoft и AWS. Причём все они отличаются от эталонного варианта, который среди крупных игроков, похоже, использует только Oracle. Так, AWS решила разработать собственную СЖО, в том числе из-за того, что ей жизненно необходимо использовать собственные DPU Nitro. Google ради собственного OCS-интерконнекта «пристроила» к суперускорителю ещё одну стойку с собственным оборудованием. Microsoft же аналогично Meta✴ добавила ещё одну стойку с теплообменниками и вентиляторами.

01.09.2025 [12:05], Сергей Карасёв

Giga Computing представила блейд-серверы B-series на платформах AMD и IntelКомпания Giga Computing, подразделение Gigabyte, объявила о выходе на рынок блейд-серверов, оптимизированных для корпоративных, периферийных и облачных рабочих нагрузок. Первыми системами данного класса стали устройства B343-C40 на аппаратной платформе AMD и B343-X40 с процессорами Intel. Все новинки выполнены в форм-факторе 3U с 10-узловой конфигурацией. Серверы B343-C40 могут комплектоваться чипами EPYC 4005 Grado или Ryzen 9000 с показателем TDP до 170 Вт (один CPU на узел). Доступны четыре слота для модулей оперативной памяти DDR5-5600/3600 в расчете на узел. Каждый из узлов также предлагает слот M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x1, два посадочных места для SFF-накопителей NVMe/SATA, один разъём для карты расширения FHHL с интерфейсом PCIe 5.0 x16 и три слота OCP NIC 3.0 (PCIe 4.0 x4). В семейство B343-C40 вошли три модификации — B343-C40-AAJ1, B343-C40-AAJ2 и B343-C40-AAJ3, у которых каждый из узлов располагает соответственно двумя портами 1GbE (контроллер Intel I350-AM2), 10GbE (Broadcom BCM57416) и 25GbE (Broadcom BCM57502). Кроме того, во всех случаях предусмотрен выделенный сетевой порт управления 1GbE и контроллер ASPEED AST2600 (на узел). За питание системы в целом отвечают четыре блока мощностью 2000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +30 °C. Применяется воздушное охлаждение. В свою очередь, у сервера B343-X40 каждый из узлов может оснащаться одним процессором Xeon 6300 с TDP до 95 Вт. Реализованы четыре слота для модулей DDR5-4400/4000/3600 и два порта 1GbE на основе контроллера Intel I350-AM2 (в расчёте на узел). В остальном технические характеристики аналогичны AMD-версиям. При этом в систему установлены два блока питания мощностью 3200 Вт с сертификатом 80 PLUS Titanium.

01.09.2025 [09:18], Руслан Авдеев

«ДолИИна» — проект 50-МВт ИИ ЦОД в Ленинградской области«ВСП Глобал» (VSP Global) и «Атомдата» (дочернее предприятие «Росатома») подписали меморандум о сотрудничестве в целях развития инфраструктуры и информационных технологий в сфере ИИ. В частности, предусмотрено создание совместного предприятия для реализации проекта «IT-кластер «ДолИИна» по строительству ИИ ЦОД в Ленинградской области рядом с городом Павловск. Также предусматривается совместная реализация ряда проектов в области, сотрудничество с ведущими вузами РФ, Российской ассоциацией искусственного интеллекта (РАИИ), отраслевыми бизнес-объединениями и т.д. Проект ЦОД предусматривает постройку пяти объектов общей мощностью 50 МВт. Предусмотрено размещение стоек мощностью от 20 до 100 кВт (с СЖО). Впрочем, помимо высоконагруженных стоек предусмотрено размещение и традиционных стоек в рамках колокации. Кампус находится в непосредственной близости от 110-кВ подстанции и, как передаёт «ИКС-МЕДИА», от магистральной газовой трубы высокого давления, что позволит задействовать газ для резервного питания объектов. Также отмечается хорошая транспортная доступность. Общая ожидаемая ёмкость ЦОД — до 3 тыс. стоек. Ожидаемый PUE — в районе 1,2, для чего, в частности, планируется задействовать адиабатическое охлаждение. Оборудование ЦОД будет по возможности российского производства. Кроме того, в составе кампуса предусмотрено общественно-деловое пространство площадью 40 тыс. м2. В ноябре 2025 года планируется получить разрешение на строительство, которое будет проводиться поэтапно. Начало работ намечено на конец 2025 года. По словам «Атомдаты», «большое количество компаний, не говоря про стартапы, не могут позволить себе GPU-кластер за миллионы долларов. А специализированной инфраструктуры, где можно было бы арендовать такой кластер, в стране практически нет». По словам VSP Global, в России есть два монополиста в области ИИ — «Сбер» и «Яндекс». Для конкуренции не хватает подходящей инфраструктуры, и «ДолИИна» должна решить эту проблему. |

|