Материалы по тегу: hardware

|

02.09.2025 [12:15], Сергей Карасёв

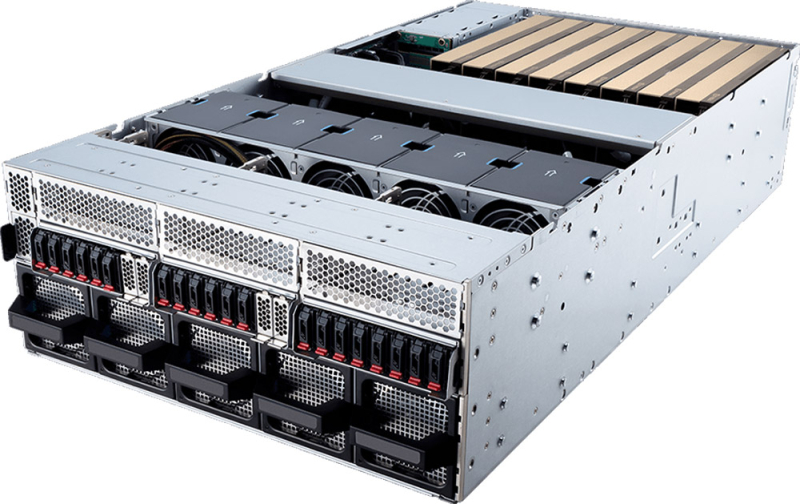

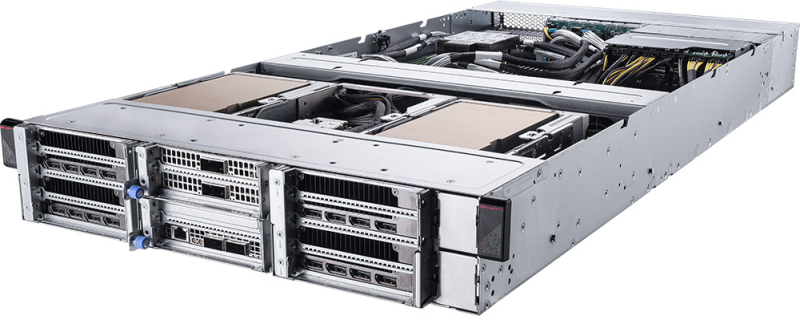

MSI выпустила серверы на платформе NVIDIA MGX с ускорителями RTX Pro 6000 Blackwell Server EditionКомпания MSI анонсировала серверы CG480-S5063 и CG290-S3063 на модульной архитектуре NVIDIA MGX. Новинки, ориентированные на задачи ИИ, оснащаются ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition с 96 Гбайт GDDR7. Модель CG480-S5063 выполнена в форм-факторе 4U. Допускается установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400/5200 или MRDIMM 8000). Во фронтальной части могут быть размещены 20 накопителей E1.S с интерфейсом PCIe 5.0 x4 (NVMe). Кроме того, есть два внутренних коннектора М.2 2280/22110 (PCIe 5.0 x2; NVMe). Система предлагает восемь слотов PCIe 5.0 x16 для карт FHFL двойной ширины и пять слотов PCIe 5.0 x16 для карт FHFL одинарной ширины. Таким образом, могут быть задействованы до восьми ИИ-ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на основе Intel X710-AT2, выделенный сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Питание обеспечивают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Задействовано воздушное охлаждение с вентиляторами, допускающими горячую замену. Диапазон рабочих температур — от 0 до +35 °C. В свою очередь, сервер CG290-S3063 типоразмера 2U рассчитан на один процессор Xeon 6500P/6700P с TDP до 350 Вт. Предусмотрены 16 слотов для модулей DDR5 (RDIMM 6400/5200 или MRDIMM 8000). В тыльной части расположены отсеки для четырёх SFF-накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe). Внутри есть два коннектора М.2 2280/22110 для SSD (PCIe 5.0 x2; NVMe). Данная система предоставляет четыре слота PCIe 5.0 x16 для карт FHFL двойной ширины и три слота PCIe 5.0 x16 для карт FHFL одинарной ширины. Могут быть использованы до четырёх ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. Прочие характеристики включают контроллер ASPEED AST2600, сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Применены четыре блока питания мощностью 2400 Вт с сертификатом 80 PLUS Titanium и воздушное охлаждение.

01.09.2025 [23:54], Сергей Карасёв

Разработчик термоядерных реакторов Commonwealth Fusion Systems получил на развитие ещё $863 млнКомпания Commonwealth Fusion Systems (CFS), отделившаяся от Массачусетского технологического института (MIT) в 2018 году, объявила о проведении очередного раунда финансирования, в ходе которого на развитие привлечено $863 млн. CFS специализируется на технологиях термоядерного синтеза. Компания рассчитывает до 2035 года создать коммерческие термоядерные реакторы мощностью 400 МВт. В мае 2025-го CFS привлекла более $1 млрд от неназванного гиперскейлера. А минувшим летом соглашение о покупке термоядерной энергии у CFS заключила Google: договор стал расширением партнёрства между двумя компаниями, впервые начатого в 2021 году. В осуществлённом раунде финансирования Series B2 приняло участие большое количество инвесторов. Впервые средства в CFS вложили Brevan Howard Macro Venture Fund, Counterpoint Global (Morgan Stanley), Stanley Druckenmiller, FFA Private Bank, Galaxy Interactive, Gigascale Capital, HOF Capital, Neva SGR (Intesa Sanpaolo Bank) и NVentures (венчурное подразделение NVIDIA), Planet First Partners и Woori Venture Partners US. Кроме того, в инвестиционной программе принял участие консорциум из 12 японских компаний во главе с Mitsui & Co. и Mitsubishi. Финансовую поддержку также оказали прежние инвесторы, включая Breakthrough Energy Ventures, Emerson Collective, Eni, Future Ventures, Gates Frontier, Google, Hostplus Superannuation Fund, Khosla Ventures, Lowercarbon Capital, Safar Partners, Эрик Шмидт (Eric Schmidt, бывший гендиректор Google), Starlight Ventures и Tiger Global. Полученные средства CFS направит в том числе на завершение работ над демонстрационной термоядерной установкой SPARC, которую планируется ввести в эксплуатацию в 2026–2027 гг. Кроме того, компания продолжит реализацию проекта по строительству термоядерной электростанции ARC в округе Честерфилд (Chesterfield) штата Вирджиния: этот объект, как ожидается, заработает в начале 2030-х годов. В случае успешной реализации ARC станет первым в своём роде проектом в области термоядерной энергетики, в рамках которого электроэнергия будет поступать в реальную энергосистему.

01.09.2025 [23:40], Руслан Авдеев

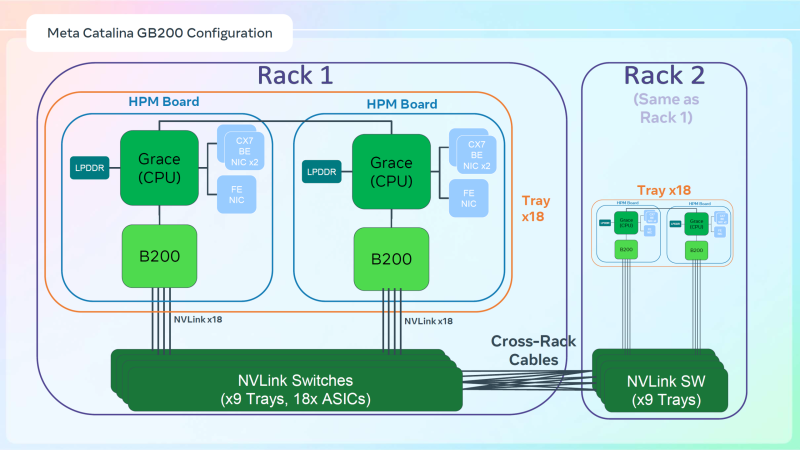

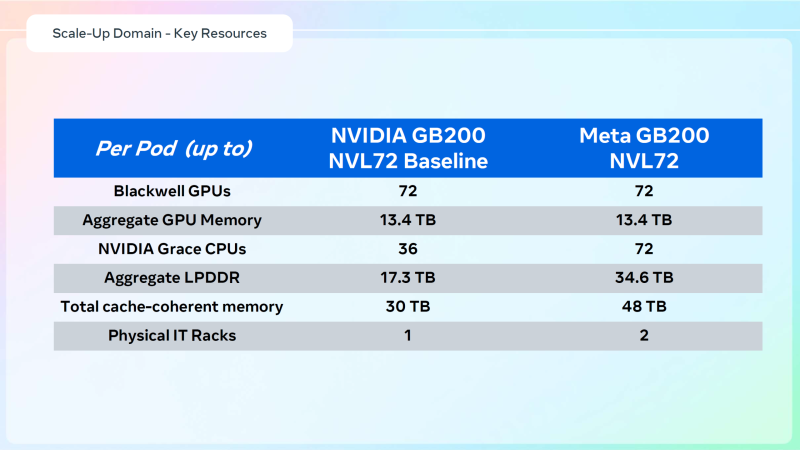

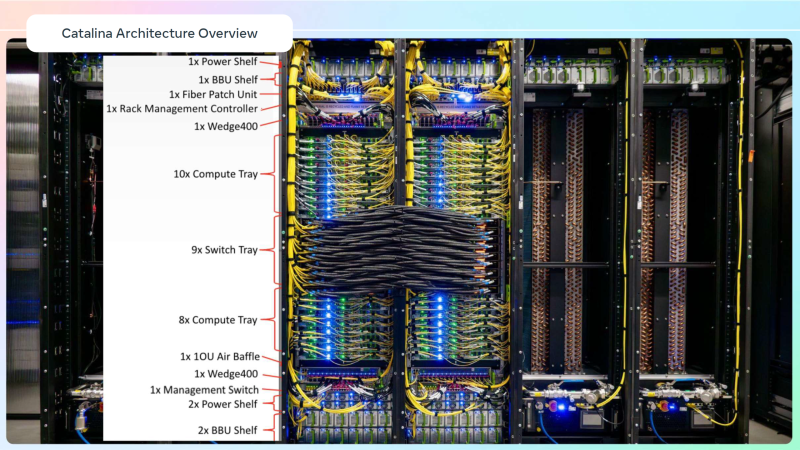

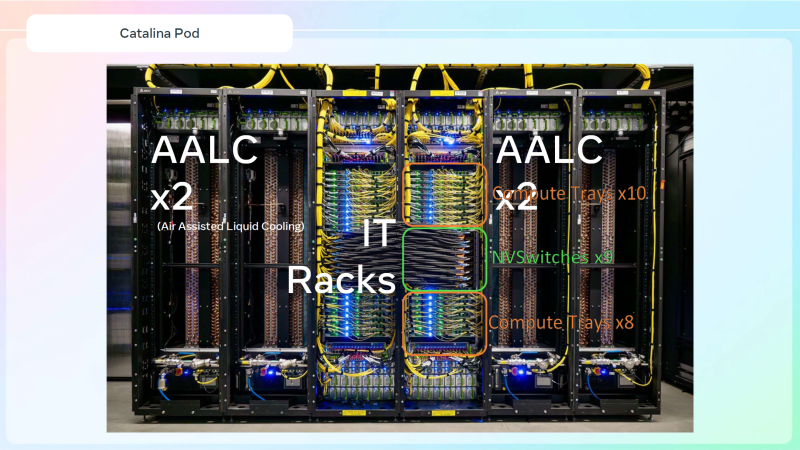

Meta✴ «растянула» суперускорители NVIDIA GB200 NVL36×2 на шесть стоек, чтобы обойтись воздушным охлаждениемДля того, чтобы развернуть в традиционных ЦОД с воздушным охлаждением современные высокоплотные стойки с ИИ-ускорителями, приходится идти на ухищрения. Один из вариантов предложила Meta✴, передаёт Wccftech. Хотя у Meta✴ есть собственный полноценный вариант суперускорителя NVIDIA GB200 NVL72 на базе ORv3-стоек Catalina (до 140 кВт) со встроенными БП и ИБП, компания также разработала также вариант, схожий с конфигурацией NVL36×2, от производства которого NVIDIA отказалась, посчитав его недостаточно эффективным. Ускоритель NVL36×2 задумывался как компромиссный вариант для ЦОД с воздушным охлаждением — одна стойка (плата Bianca, 72 × B200 и 36 × Grace) «растянута» на две.

Источник изображений: Meta✴ via Wccftech Meta✴ пошла несколько иным путём. Она точно так же использует две стойки, одна конфигурация узлов другая. Если в версии NVIDIA в состав одно узла входят один процессор Grace и два ускорителя B200, то у Meta✴ соотношение CPU к GPU уже 1:1. Все вместе они точно так же образуют один домен с 72 ускорителями, но объём памяти LPDDR5 в два раза больше — 34,6 Тбайт вместо 17,3 Тбайт. Эту пару «обрамляют» четыре стойки — по две с каждый стороны. Для охлаждения CPU и GPU по-прежнему используется СЖО, теплообменники которой находятся в боковых стойках и продуваются холодным воздухом ЦОД. Это далеко не самая эффективная с точки зрения занимаемой площади конструкция, но в случае гиперскейлеров оплата в арендуемых дата-центрах нередко идёт за потребляемую энергию, а не пространство. В случае невозможности быстро переделать собственные ЦОД или получить площадку, поддерживающую высокоплотную энергоёмкую компоновоку стоек и готовую к использованию СЖО, это не самый плохой вариант. В конце 2022 года Meta✴ приостановила строительство около дюжины дата-центров для пересмотра их архитектуры и внедрения поддержки ИИ-стоек и СЖО. Первые ЦОД Meta✴, построенные по новому проекту, должны заработать в 2026 году, передаёт DataCenter Dynamics. На сегодня у Meta✴ около 30 действующих или строящихся кампусов ЦОД, большей частью на территории США. Планируются ещё несколько кампусов, включая гигаваттные. Также компания выступает крупным арендатором дата-центров, а сейчас в пылу гонки ИИ и вовсе переключилась на быстровозводимые тенты вместо капитальных зданий, лишённые резервного питания и традиционных систем охлаждения. Собственные версии GB200 NVL72 есть у Google, Microsoft и AWS. Причём все они отличаются от эталонного варианта, который среди крупных игроков, похоже, использует только Oracle. Так, AWS решила разработать собственную СЖО, в том числе из-за того, что ей жизненно необходимо использовать собственные DPU Nitro. Google ради собственного OCS-интерконнекта «пристроила» к суперускорителю ещё одну стойку с собственным оборудованием. Microsoft же аналогично Meta✴ добавила ещё одну стойку с теплообменниками и вентиляторами.

01.09.2025 [12:05], Сергей Карасёв

Giga Computing представила блейд-серверы B-series на платформах AMD и IntelКомпания Giga Computing, подразделение Gigabyte, объявила о выходе на рынок блейд-серверов, оптимизированных для корпоративных, периферийных и облачных рабочих нагрузок. Первыми системами данного класса стали устройства B343-C40 на аппаратной платформе AMD и B343-X40 с процессорами Intel. Все новинки выполнены в форм-факторе 3U с 10-узловой конфигурацией. Серверы B343-C40 могут комплектоваться чипами EPYC 4005 Grado или Ryzen 9000 с показателем TDP до 170 Вт (один CPU на узел). Доступны четыре слота для модулей оперативной памяти DDR5-5600/3600 в расчете на узел. Каждый из узлов также предлагает слот M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x1, два посадочных места для SFF-накопителей NVMe/SATA, один разъём для карты расширения FHHL с интерфейсом PCIe 5.0 x16 и три слота OCP NIC 3.0 (PCIe 4.0 x4). В семейство B343-C40 вошли три модификации — B343-C40-AAJ1, B343-C40-AAJ2 и B343-C40-AAJ3, у которых каждый из узлов располагает соответственно двумя портами 1GbE (контроллер Intel I350-AM2), 10GbE (Broadcom BCM57416) и 25GbE (Broadcom BCM57502). Кроме того, во всех случаях предусмотрен выделенный сетевой порт управления 1GbE и контроллер ASPEED AST2600 (на узел). За питание системы в целом отвечают четыре блока мощностью 2000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +30 °C. Применяется воздушное охлаждение. В свою очередь, у сервера B343-X40 каждый из узлов может оснащаться одним процессором Xeon 6300 с TDP до 95 Вт. Реализованы четыре слота для модулей DDR5-4400/4000/3600 и два порта 1GbE на основе контроллера Intel I350-AM2 (в расчёте на узел). В остальном технические характеристики аналогичны AMD-версиям. При этом в систему установлены два блока питания мощностью 3200 Вт с сертификатом 80 PLUS Titanium.

01.09.2025 [09:18], Руслан Авдеев

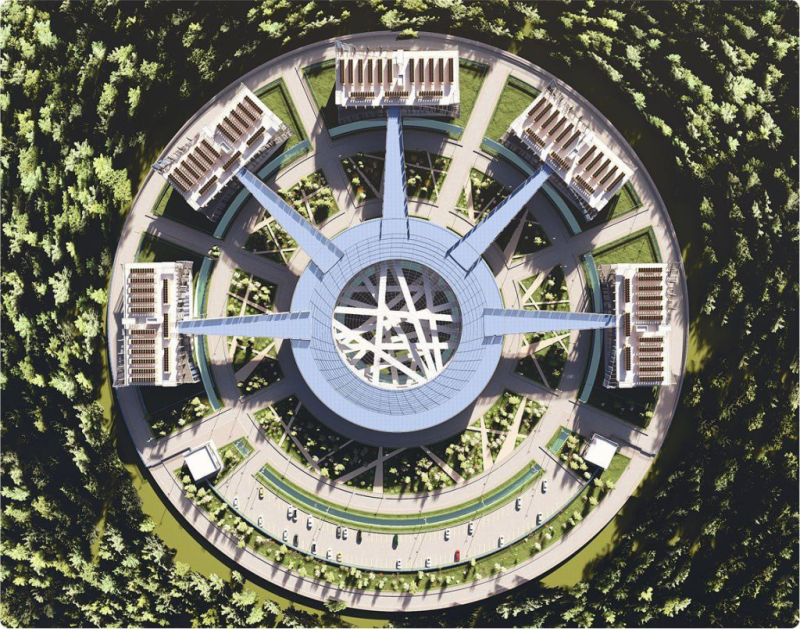

«ДолИИна» — проект 50-МВт ИИ ЦОД в Ленинградской области«ВСП Глобал» (VSP Global) и «Атомдата» (дочернее предприятие «Росатома») подписали меморандум о сотрудничестве в целях развития инфраструктуры и информационных технологий в сфере ИИ. В частности, предусмотрено создание совместного предприятия для реализации проекта «IT-кластер «ДолИИна» по строительству ИИ ЦОД в Ленинградской области рядом с городом Павловск. Также предусматривается совместная реализация ряда проектов в области, сотрудничество с ведущими вузами РФ, Российской ассоциацией искусственного интеллекта (РАИИ), отраслевыми бизнес-объединениями и т.д. Проект ЦОД предусматривает постройку пяти объектов общей мощностью 50 МВт. Предусмотрено размещение стоек мощностью от 20 до 100 кВт (с СЖО). Впрочем, помимо высоконагруженных стоек предусмотрено размещение и традиционных стоек в рамках колокации. Кампус находится в непосредственной близости от 110-кВ подстанции и, как передаёт «ИКС-МЕДИА», от магистральной газовой трубы высокого давления, что позволит задействовать газ для резервного питания объектов. Также отмечается хорошая транспортная доступность. Общая ожидаемая ёмкость ЦОД — до 3 тыс. стоек. Ожидаемый PUE — в районе 1,2, для чего, в частности, планируется задействовать адиабатическое охлаждение. Оборудование ЦОД будет по возможности российского производства. Кроме того, в составе кампуса предусмотрено общественно-деловое пространство площадью 40 тыс. м2. В ноябре 2025 года планируется получить разрешение на строительство, которое будет проводиться поэтапно. Начало работ намечено на конец 2025 года. По словам «Атомдаты», «большое количество компаний, не говоря про стартапы, не могут позволить себе GPU-кластер за миллионы долларов. А специализированной инфраструктуры, где можно было бы арендовать такой кластер, в стране практически нет». По словам VSP Global, в России есть два монополиста в области ИИ — «Сбер» и «Яндекс». Для конкуренции не хватает подходящей инфраструктуры, и «ДолИИна» должна решить эту проблему.

31.08.2025 [15:51], Руслан Авдеев

Alibaba разработала собственный ИИ-ускоритель для инференсаНа фоне нарастающего давления со стороны китайских властей, стремящихся избавиться от зависимости от ИИ-чипов NVIDIA и и других западных аналогов, Alibaba разработала собственный ИИ-ускоритель. В пятницу появились данные, что новейший чип китайского IT-гиганта ориентирован на инференс, сообщает The Register. Подразделения Alibaba T-Head довольно давно работает над собственными ИИ-решениями. В 2019 году он представила вариант Hanguang 800, но в отличие от современных моделей NVIDIA и AMD, он в первую очередь предназначен для классических ML-моделей машинного обучения (таких как ResNet), а не для современных больших языковых моделей (LLM). Утверждается, что новый чип будет справляться с более разнообразными нагрузками. В обозримом будущем для обучения Alibaba, вероятно, будет по-прежнему использовать ускорители NVIDIA. По имеющимся данным, в отличие от ускорителей Huawei Ascend, продукт Alibaba совместим с программной платформой NVIDIA, что позволяет лишь немного переработать используемый код. При этом использование инструментов CUDA не является необходимым для инференса. Alibaba, вероятно, ориентируется на более высокоуровневые варианты вроде PyTorch или TensorFlow. Так или иначе, чип придётся выпускать в Китае из-за санкций США. Кто именно займётся непосредственно выпуском не указывается, но весьма вероятно, что речь идёт о SMIC. Кроме того, Китаю запрещено продавать высокоскоростную память HBM2e и более новые версии — если они уже не интегрированы в готовый ускоритель. Это значит, что Alibaba или будет использовать «медленную» память GDDR или LPDDR, а также накопленные запасы HBM, пока не появятся собственные аналоги. Новости об очередных полупроводниках китайского производства появились на фоне призывов китайского правительства не использовать ускорители NVIDIA H20 из соображений безопасности. Впрочем, NVIDIA, которой не так давно вновь разрешили поставлять H20 в Китай, все обвинения решительно отрицает. По некоторым данным, ведётся разработка нового ускорителя семейства Blackwell, специально для Китая. Впрочем, в текущем квартале компания всё равно не рассчитывает на доходы в КНР, поскольку механизмы возобновления продажи и взимания 15-процентной экспортной пошлины ещё не отработаны. Тем временем китайские лидеры ИИ-отрасли ищут альтернативы продуктам компании. DeepSeek переориентировала свои модели на использование нового поколения китайских чипов. Компания не назвала поставщика, но, по некоторым данным, перенести обучение на Ascend не удалось. Впрочем, сама Huawei старается ускорить и инференс. Стартап Enflame, поддерживаемый Tencent, разрабатывает новый ускоритель L600, который получит 144 Гбайт (3,6 Тбайт/с) и поддержку FP8-вычислений. MetaX анонсировала модель C600 со 144 Гбайт HBM3e, но производство, вероятно, будет ограничено имеющимися резервами памяти. Наконец, Cambricon Technologies также работает над собственным ускорителем Siyuan 690, который, как ожидается, будет лучше NVIDIA H100.

31.08.2025 [15:31], Владимир Мироненко

Новый урок арифметики от NVIDIA: Дженсен Хуанг назвал фантастическую сумму капзатрат на ИИ-инфраструктуруГендиректор NVIDIA Дженсен Хуанг (Jensen Huang) сообщил в ходе отчёта за II квартал 2026 финансового года, что капзатраты четырёх крупнейших гиперскейлеров (Amazon Web Services, Google, Microsoft и Meta✴ Platforms) составят около $600 млрд в год. По его словам, эта сумма удвоилась всего за два года и является движущей силой текущего развития ИИ-инфраструктуры. Как отметил ресурс SiliconANGLE, последние квартальные отчёты гиперскейлеров, а также аналитические данные экспертов, освещающих их деятельность, говорят о том, что их совокупный прогноз капитальных затрат гораздо ниже объявленной Хуангом суммы, хотя этот показатель стремительно растёт благодаря спросу на ИИ-технологии. NVIDIA в ответ на просьбу объяснить столь большое расхождение уточнила, что эта сумма отражает общие расходы отрасли на инфраструктуру ЦОД, а не только расходы ведущих поставщиков облачных сервисов. Если говорить о планах по объёмам капзатрат на текущий год (календарный или финансовый), то гиперскейлеры прогнозируют следующее:

Согласно выводам аналитиков (Jefferies, Investing.com) по «большой тройке» с Meta✴ и Oracle прогноз капзатрат на облаке на 2025 год составляет $417 млрд, что на 64 % больше, чем годом ранее, и почти в три раза больше, чем в 2023 году. Налицо существенное расхождение между объявленными Хуангом $600 млрд и данными аналитиков, а также прогнозами самих гиперскейлеров. Возможные причины расхождения по версии SiliconANGLE:

Названная главой NVIDIA сумма в $600 млрд не подтверждается прогнозами ведущих гиперскейлеров на 2025 год и расчётами аналитиков, которые предполагают, что совокупные капзатраты составят $400–$450 млрд. Разрыв, как пишет SiliconANGLE, обусловлен как неопределённостью масштаба (что именно считается капиталовложениями у гиперскейлеров), так и намерением Хуанга подчеркнуть, что NVIDIA находится в центре ИИ-бума. NVIDIA известна порой довольно вольным обращением с цифрами и прогнозами. Это касается заявлений производительности платформ без явного указания точности и формата вычислений (так в мгновение ока появились экзафлопсные суперкомпьютеры, которые в более традиционных FP64-расчётах не сильны), учёта количества GPU в узлах (несколько лет компанию не беспокоило, что в состав одного ускорителя входило два GPU-чиплета), или отхода от привычных способов указания пропускной способности интерфейсов (для NVLink суммируется скорость передачи данных в обе стороны).

30.08.2025 [00:15], Владимир Мироненко

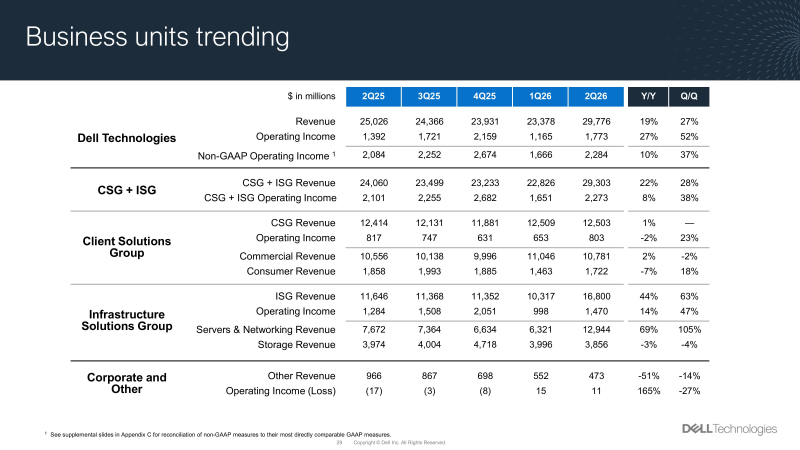

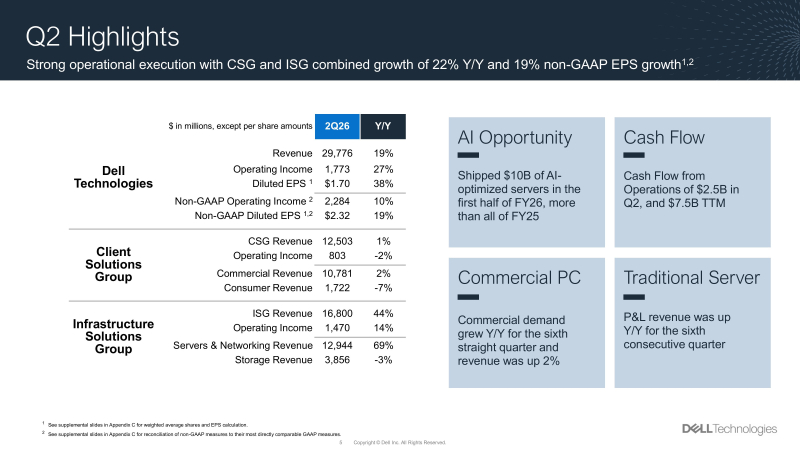

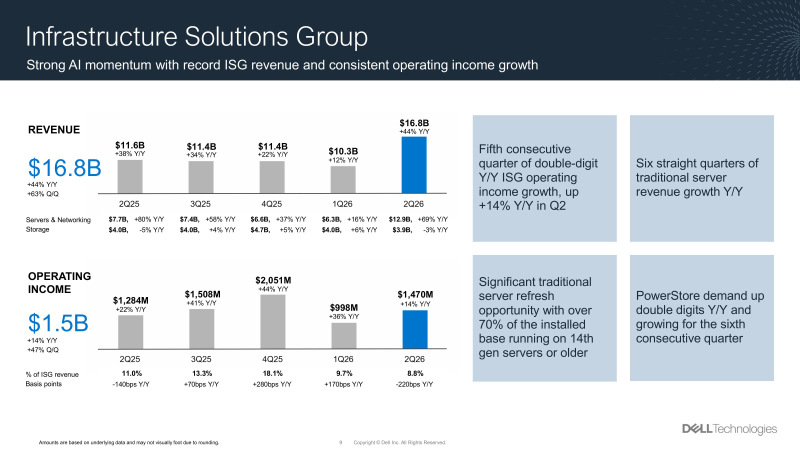

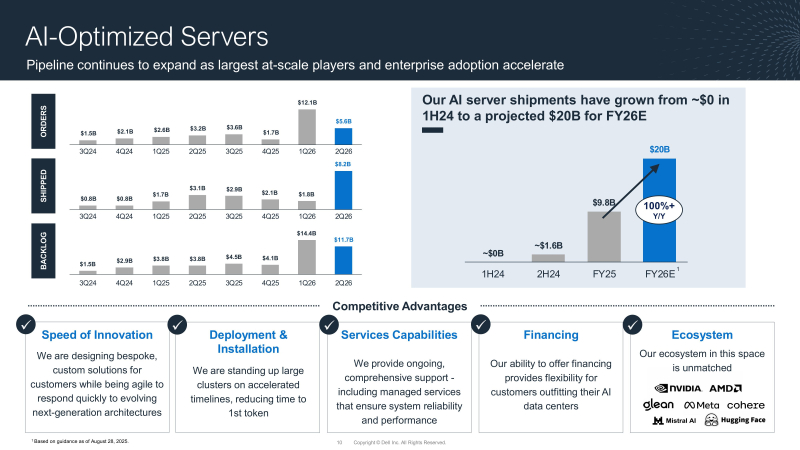

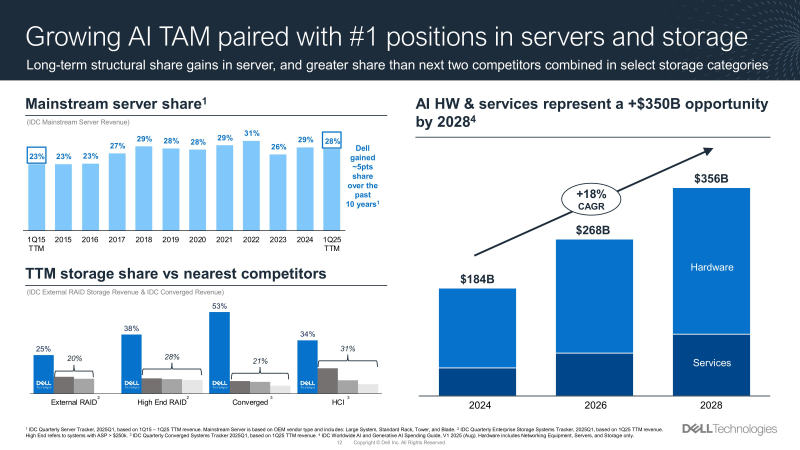

Dell впервые больше заработала на серверах и СХД, чем на ПК и ноутбукахПосле объявления финансовых результатов за II квартал 2026 финансового года, превысивших прогнозы Уолл-стрит, акции Dell Technologies упали на 5 % в ходе расширенных торгов, поскольку прогноз прибыли Dell на III квартал оказался ниже ожиданий аналитиков, пишет Reuters. Выручка Dell за II квартал 2026 финансового года, завершившийся 1 августа 2025 года, достигла рекордной величины в $29,78 млрд, что на 19 % больше, чем годом ранее, превысив также консенсус-прогноз аналитиков, опрошенных LSEG, в размере $29,17 млрд. Скорректированная прибыль на разводнённую акцию (Non-GAAP) в размере $2,32 тоже превысила ожидания Уолл-стрит в $2,30 на разводнённую акцию. Чистая прибыль (GAAP) компании выросла на 32 % до $1,16 млрд или $1,70 на разводнённую акцию. Скорректированная валовая прибыль (Non-GAAP) снизилась год к году с 22,0 до 18,7 % и не оправдала ожиданий аналитиков в 19,6 %. Джефф Кларк (Jeff Clarke), заместитель председателя совета директоров и главный операционный директор Dell, сообщил, что в I половине 2026 финансового года компания поставила ИИ-решений на сумму $10 млрд, превысив поставки за весь 2025 финансовый год. «Это помогло нам добиться очередного рекордного квартального дохода в сегменте серверов и сетевого оборудования, который вырос на 69 %», — отметил Кларк. Он добавил, что спрос на ИИ-решения компании остаётся исключительным, и она повышает прогноз по поставкам ИИ-серверов на 2026 финансовый год до $20 млрд, что выше предыдущего прогноза в $15 млрд и вдвое больше, чем в предыдущем финансовом году. Во II квартале компания получила заказы на ИИ-системы на $5,6 млрд и поставила на рекордную сумму в $8,2 млрд. В итоге к концу квартала портфель ожидающих выполнения заказов на ИИ-системы оставил $11,7 млрд. Dell заявила, что её портфель потенциальных заказов в области ИИ продолжает последовательно расти и по-прежнему в несколько раз превышает объём невыполненных поставок в несколько раз. Кларк отметил двузначный рост в процентах в сфере корпоративных и суверенных решений в области ИИ. Выручка подразделения Infrastructure Solutions Group (ISG), занимающегося поставкой серверных продуктов, а также массивов хранения данных и сетевого оборудования, впервые превысила доход подразделения Dell Client Solutions Group (CSG), поставляющего ПК и ноутбуки, составив $16,8 млрд (рост год к году на 44 %). Подразделение CSG увеличило выручку в годовом исчислении на 1 % до $12,5 млрд. При этом выручка от продаж серверов и сетевого оборудования увеличилась на 69 % до $12,94 млрд, а выручка от СХД снизилась на 3 % до $3,86 млрд, что ниже целевого показателя StreetAccount в $4,1 млрд. Операционная прибыл ISG выросла на 14 % до $1,47 млрд. Dell сообщила, что в категории СХД спрос на PowerStore вырос на двузначные значения в годовом исчислении, демонстрируя рост шестой квартал подряд, причём пять кварталов подряд — на двузначные значения, что обусловлено активным участием партнёров. 46 % покупателей были новыми клиентами PowerStore, а 23 % — впервые обратились к Dell Storage, пишет Blocks & Files. Кларк отметил, что «в целом сектор флеш-хранилищ показал значительный рост, обусловленный сильными характеристиками решений PowerMax, PowerStore, PowerScale и ObjectScale». Аналитик Constellation Research Хольгер Мюллер (Holger Mueller) сообщил в интервью ресурсу SiliconANGLE, что Dell уже прочно удерживает рынок серверов, являясь одним из немногих поставщиков решений для локальных рабочих нагрузок, поэтому неудивительно, что компания добивается столь быстрого прогресса в области локальных решений для ИИ. По его словам, стремительный рост выручки Dell от ИИ-серверов показывает, что многие клиенты компании стремятся заменить ими имеющиеся традиционные серверы. Dell повысила свой прогноз годовой выручки до $105,0–$109,0 млрд при среднем значении $107 млрд с первоначального $101–$105 млрд, а также скорректированной разводнённой прибыли (Non-GAAP) на акцию до $9,55 в среднем значении, что превысило прогнозы Уолл-стрит в $104,6 млрд и $9,38 на акцию. Однако прогноз Dell по скорректированной прибыли на разводнённую акцию (Non-GAAP) за III квартал в $2,45 в среднем значении оказался ниже прогноза аналитиков LSEG в $2,55, несмотря на то что Dell ожидает выручку в диапазоне $26,5–$27,5 млрд ($27 млрд в среднем значении) за III финансовый квартал, превысившую прогноз в $26,1 млрд. Dell объяснила слабый прогноз по прибыли тем, что большая часть оставшейся прибыли в этом году придётся на IV финансовый квартал, что является следствием сезонности спроса, особенно в сегменте СХД. Падение акций Dell на 5 % после оглашения результатов не так значимо, поскольку их стоимость с начала года выросла на 16 %, превзойдя индекс S&P 500, который за тот же период вырос чуть более чем на 10 %.

29.08.2025 [23:15], Владимир Мироненко

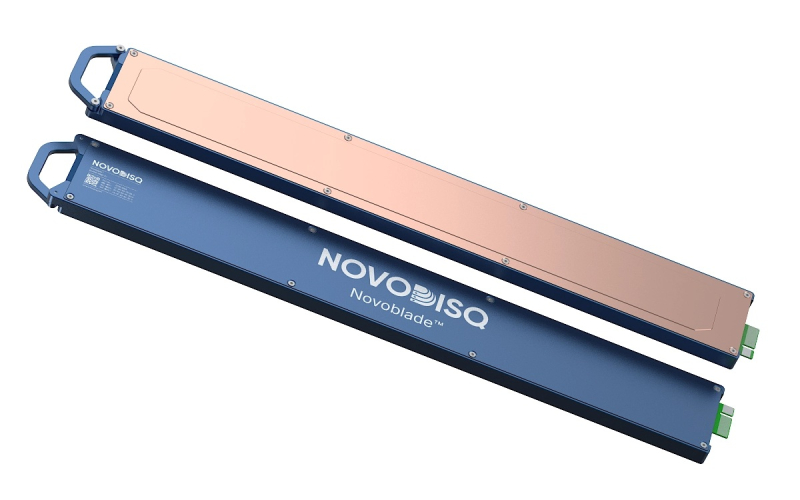

11,5 Пбайт в 2U: Novodisq представил блейд-сервер для ИИ и больших данныхСтартап Novodisq представил блейд-сервер формата 2U ёмкостью 11,5 Пбайт с функцией ускорения ИИ и др. задач. Гиперконвергентная кластерная система разработан для замены или дополнения традиционных решений NAS, SAN и публичных облачных сервисов. Новинка поддерживает платформы Ceph, MinIO и Nextcloud (также планируется поддержка DAOS), предлагая доступ по NFS, iSCSI, NVMe-oF и S3. Сервер содержит до 20 модулей Novoblade с фронтальной загрузкой. В каждом из них имеется до четырёх встроенных E2 SSD Novoblade объёмом 144 Тбайт каждый, на базе TLC NAND с шиной PCIe 4.0 x4. Накопители поддерживают NVMe v2.1 и ZNS, обеспечивая последовательную производительность чтения/записи до 1000 Мбайт/с, а на случайных операциях — до 70/30 тыс. IOPS. Надёжность накопителей составляет до 24 PBW. Энергопотребление: от 5 до 10 Вт. Система Novoblade предназначена для «тёплого» и «холодного» хранения данных. Модули Novoblade объединяют вычислительные возможности, ускорители и хранилища. Основной модулей являются гибридные SoC AMD Versal AI Edge Gen 2 (для ИИ-нагрузок) или Versal Prime Gen 2 (для традиционных вычислений) c FPGA, 96 Гбайт DDR5, 32 Гбайт eMMC, модулем TPM2 и двумя интерфейсам 10/25GbE с RoCE v2 RDMA и TSN. Энергопотребление не превышает 60 Вт. Есть функции шифрования накопителей, декодирования видео, ускорения ИИ-обработки, оркестрации контейнеров и т.д. Платформа специально разработана для задач с большими объёмами данных, таких как геномика, геопространственная визуализация, видеоархивация и периферийные ИИ-вычисления. Сервер может работать под управлением стандартных дистрибутивов Linux (RHEL и Ubuntu LTS) с поддержкой Docker, Podman, QEMU/KVM, Portainer и OpenShift. 2U-шасси глубиной 1000 мм рассчитано на установку до двадцати модулей Novodisq и оснащено двумя (1+1) БП мощностью 2600 Вт каждый (48 В DC). Возможно горизонтальное масштабирование с использованием каналов 100–400GbE. В базовой конфигурации шасси включает четыре 200GbE-модуля с возможностью горячей замены, каждый из которых имеет SFP28-корзины, а также управляемый L2-коммутатор. Предусмотрен набор средств управления, включая BMC с веб-интерфейсом, CLI и поддержкой API Ansible, SNMP и Redfish. Novoblade поддерживает локальное и удалённое управление, может интегрироваться в существующий стек или предоставляться с помощью инструментов «инфраструктура как код» (Infrastructure-as-Code). По словам разработчика, система Novoblade обеспечивает плотность размещения примерно в 10 раз выше, чем у сервера на основе жестких дисков, и снижает энергопотребление на 90–95 % без необходимости в механическом охлаждении. Novodisq утверждает, что общая стоимость владения системой «обычно на 70–90 % ниже, чем у традиционных облачных или корпоративных решений в течение 5–10 лет». «Это обусловлено несколькими факторами: уменьшенным пространством в стойке, низким энергопотреблением, отсутствием платы за передачу данных, минимальным охлаждением, длительным сроком службы и значительным упрощением управления. В отличие от облака, ваши расходы в основном фиксированы, а значит, предсказуемы, и, в отличие от традиционных систем, Novodisq не требует дорогостоящих лицензий, внешних контроллеров или постоянных циклов обновления. Вы получаете высокую производительность, долгосрочную надёжность и более высокую экономичность с первого дня», — приводит Blocks & Files сообщение компании. Для сравнения, узлы Dell PowerScale F710 и F910 на базе 144-Тбайт Solidigm SSD ёмкостью 122 Тбайт, 24 отсеками в 2U-шасси и коэффициентом сжатия данных 2:1 обеспечивают почти 6 Пбайт эффективной емкости, что почти вдвое меньше, чем у сервера Novoblade.

29.08.2025 [15:05], Руслан Авдеев

Microsoft, OpenAI и NVIDIA предупредили, что ИИ теперь может физически навредить энергосетямГодами эксперты в области кибербезопасности уделяли внимание защите критической инфраструктуры в основном от цифровых атак с помощью самых разных систем, не позволявших создать угрозу электросетям. Однако новое исследование, проведённое специалистами из Microsoft, OpenAI и NVIDIA, показывает, что главной угрозой электросетям выступают отнюдь не хакеры, а ИИ. Исследование «Стабилизация энергоснабжения для обучающих ИИ ЦОД» (Power Stabilization for AI Training Datacenters) выявило интересную тенденцию, связанную с быстрым внедрением ИИ в больших масштабах. В процессе эксплуатации ускорителей есть два основных этапа: вычислительный, когда они активно выполняют сложные математические операции, потребляя много энергии, и коммуникационный, когда они обмениваются данными между собой. Во время перехода от первого этапа ко второму происходит резкий спад энергопотребления, а от второго к первому — его стремительный рост. В случае с гиперскейлерами скачки могут составлять десятки или сотни мегаватт, что негативно сказывается на состоянии электросетей в целом. Дело не просто в неэффективном использовании ресурсов — речь идёт об угрозе критически важной инфраструктуре. В докладе говорится, что колебания потребления могут совпасть с резонансными частотами ключевых компонентов энергосистемы, включая генераторы и оборудование ЛЭП, что потенциально приводит к дестабилизации сети, повреждению оборудования и масштабным авариям. Другими словами, активность ИИ представляет прямую физическую угрозу для аналоговой инфраструктуры электросетей.

Источник изображения: American Public Power Association/unsplash.com Для решения этой проблемы предлагаются три основных подхода. Во-первых, во время простоя на ускорителях можно решать второстепенные (или вообще бессмысленные, как делала Meta✴) задачи, держа оборудование на «холостом ходу» без полной остановки вычислений. Метод простой, но не самый лучший — общая энергоэффективность не растёт, снижение производительности при выполнении основной задачи вполне возможно. Во-вторых, можно непосредственно на уровне ИИ-ускорителей задавать минимальный порог энергопотребления, что тоже не способствует энергоэффективности. Наконец, в-третьих, можно использовать аккумулирующие энергию системы: в моменты низкого потребления они заряжаются, а во время скачка нагрузки отдают накопленную в них энергию вместо того, чтобы резко увеличивать потребление от общей электросети. Подобные системы позволяют избежать скачков и сгладить рост и снижение потребляемой мощности. Так, Google уже давно размещает литий-ионных ячейки непосредственно в стойках. Для стоек GB300 NVL72 NVIDIA дополнила блоки питания буфером, который позволяет смягчить колебания потребления и снизить пиковую нагрузку на сеть до 30 %. Энергосети давно являются частью критической инфраструктуры, но новые угрозы для них теперь находятся на стыке цифрового и реального мира. Получив неавторизованный доступ к крупному ИИ-кластеру, злоумышленники могут намеренно изменить паттерн энергопотребления так, чтобы навредить материальной инфраструктуре. Другими словами, злоумышленники могут повредить электростанцию или энергосети, даже не приближаясь к ним. В докладе Microsoft, OpenAI и NVIDIA заинтересованные стороны прямо отмечают, что масштаб ИИ вырос до отметки, на которой цифровая активность ведёт к важным физическим последствиям. Специалистам по кибербезопасности придётся уделять время не только цифровой реальности, но и заняться защитой критически важной инфраструктуры и учитывать последствия разрабатываемых и внедряемых алгоритмов. Примером может служить инцидент, произошедший летом 2024 года в Вирджинии, когда миллисекундный сбой привёл к одномоментному отключению 60 дата-центров мощностью 1,5 ГВт на несколько часов. |

|