Материалы по тегу: ускоритель

|

12.01.2024 [19:04], Руслан Авдеев

Индия охотно купит ускорители NVIDIA, не доставшиеся Китаю из-за санкцийСтремящаяся ускорить технологическое развитие Индия, вероятно, сместит Китай на пьедестале крупного покупателя передовых ускорителей NVIDIA. Как сообщает The Register, это поможет производителю сохранить приемлемые финансовые результаты даже на фоне соблюдения антикитайских санкций. Тем более, что с рынка КНР компания полностью не уходит. Индийские IT-гиганты активно осваивают рынок ИИ. Например, индийская Yotta готовится к 2025 году получить 32 тыс. ускорителей NVIDIA на сумму порядка $1 млрд, в первую очередь H100 и наиболее современные H200, для создания облачной ИИ-платформы Shakti Cloud. Yotta полагается на оценки экспертов, по прогнозам которых ещё до конца текущего десятилетия на системы машинного обучения в Индии потратят $14 млрд. Кроме того, Reliance Jio закупит ускорители H200 и вместе с NVIDIA создаст большую языковую модель, а Tata и NVIDIA развернут ИИ-инфраструктуру на базе H200. После очередного санкционного удара США по Китаю в октябре 2023 года бизнес NVIDIA в КНР оказался под угрозой, но индийский рынок может скомпенсировать вероятные потери. Хотя финансовые эксперты NVIDIA полны оптимизма и ожидают, что рост спроса на ускорители покроет убытки от сокращения китайского рынка, полностью уходить из Поднебесной компания не планирует. Ранее NVIDIA подготовила для Китая урезанные по возможностям ускорители A800 и H800 суммарной стоимостью порядка $5 млрд. Впоследствии компании пришлось создать для Китая три новые модели ускорителей, соответствующие обновлённым санкционным требованиям, а уже выпущенные решения пристраивать на других рынках. Впрочем, по слухам, в Китае восприняли идею дальнейшего ухудшения ИИ-чипов для страны весьма прохладно. К тому же некоторые заказчики успели накопить запасы ускорителей.

25.12.2023 [14:53], Сергей Карасёв

Samsung и Naver создали ИИ-чип, кратно превосходящий NVIDIA H100 по энергоэффективностиОдна из крупнейших южнокорейских интернет-компаний Naver и местный гигант Samsung, по сообщению ресурса BusinessKorea, разработали специализированный ИИ-чип, который, как утверждается, обладает гораздо более высокой энергетической эффективностью по сравнению с другими аналогичными продуктами на коммерческом рынке. Ранее Naver из-за дефицита NVIDIA H100 вынужденно перешла на использование Intel Xeon в некоторых ИИ-задачах. Подробностей об изделии не слишком много. Известно, что пока оно реализован посредством FPGA. Для снижения энергопотребления задействована память LPDDR, но её тип и объём не раскрываются. По имеющимся данным, новинка Samsung и Naver показывает приблизительно восьмикратный выигрыш в энергопотреблении по отношению к ускорителю NVIDIA H100. При этом не называются показатели быстродействия, а поэтому судить о производительности в расчёте на 1 Вт затрачиваемой энергии пока не представляется возможным.

Источник изображения: pixabay.com Представители Naver, как отмечает ресурс DigiTimes, говорят, что конкурирующие ИИ-решения обычно используют 16-бит представление чисел, тогда как новый продукт Samsung и Naver оперирует 4-бит значениями, благодаря чему и достигается улучшение общих показателей. На создание изделия ушёл приблизительно год — Samsung и Naver сотрудничают над проектом с декабря 2022-го. Планируется, что новые чипы будут использоваться для поддержания работы масштабной ИИ-модели Naver HyperCLOVA X объёмом более 200 млрд параметров.

20.12.2023 [17:00], Сергей Карасёв

Представлен китайский ИИ-ускоритель Moore Threads MTT S4000 с быстродействием до 200 TOPSКитайская компания Moore Threads, по сообщению ресурса VideoCardz, анонсировала специализированный ускоритель MTT S4000 для приложений ИИ и работы с большими языковыми моделями (LLM). Решение выполнено в виде двухслотовой карты расширения с интерфейсом PCIe 5.0 х16. В основу изделия положена архитектура MUSA третьего поколения, подробности о которой не раскрываются. Есть 48 Гбайт памяти GDDR6 с пропускной способностью до 768 Гбайт/с. Реализована технология MTLink 1.0, которая позволяет объединять в одной системе несколько ИИ-ускорителей. Как утверждает Moore Threads, новинка обладает производительностью до 25 Тфлопс на операциях FP32, до 50 Тфлопс на операциях TF32, до 100 Тфлопс на операциях FP16/BF16 и 200 TOPS на операциях INT8. Для сравнения: ИИ-ускоритель предыдущего поколения MTT S3000 несёт на борту 32 Гбайт памяти и обеспечивает пиковую производительность FP32 на уровне 15,2 Тфлопс. Таким образом, размер памяти увеличен на 50 %, тогда как быстродействие FP32 поднялось на 64 %. Изделие MTT S4000 оснащено пассивным охлаждением. Предусмотрены четыре разъёма DisplayPort, что позволяет подключать мониторы. Заявлена возможность одновременной обработки до 96 видеопотоков в формате 1080p. Сопутствующие инструменты разработки USIFY позволяют полноценно использовать программное обеспечение NVIDIA на базе CUDA. Ускорители Moore Threads MTT S4000 будут поставляться по отдельности и в составе систем Kuae, аналогичных NVIDIA DGX. Платформа Kuae MCCX D800 содержит восемь карт; возможно объединение таких серверов в кластеры. Говорится о поддержке различных LLM, таких как LLaMA, GLM, Aquila, Baichuan, GPT, Bloom, Yuyan объёмом до 130 млрд параметров. Первые 1000 ускорителей MTT S4000 лягут в основу нового китайского кластера для ИИ-задач. Moore Threads отмечает, что китайский исследовательский институт Чжиюань посредством кластера с 1000 ускорителей смог обучить модель с 70 млрд параметров за 33 дня, тогда как для 130 млрд параметров потребуется 56 суток.

15.12.2023 [16:57], Сергей Карасёв

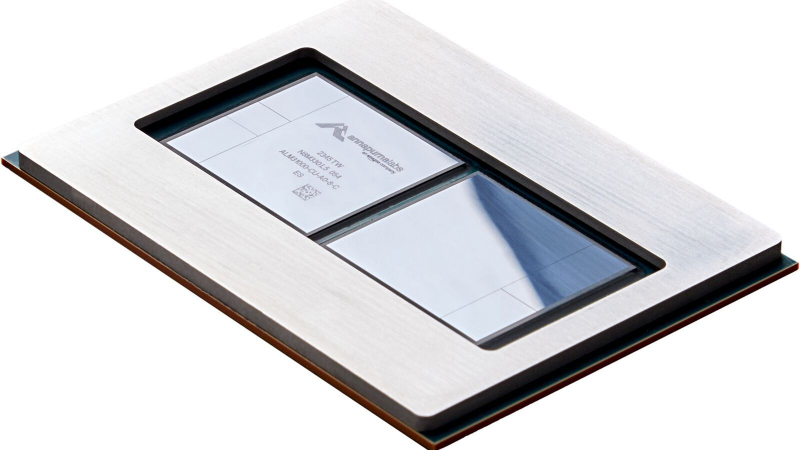

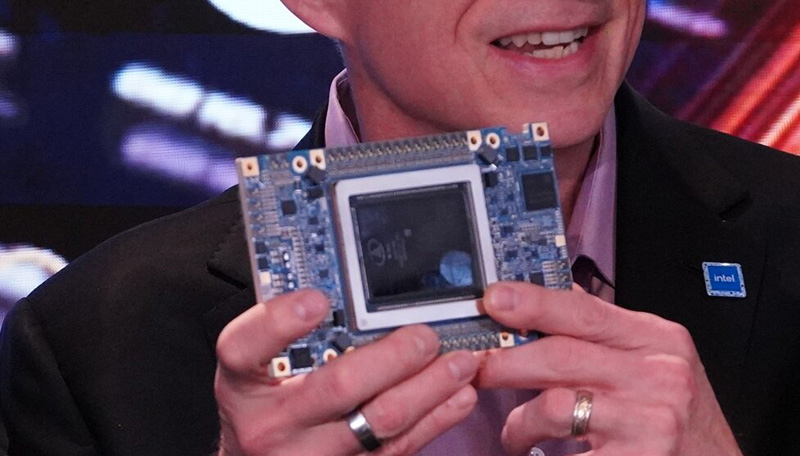

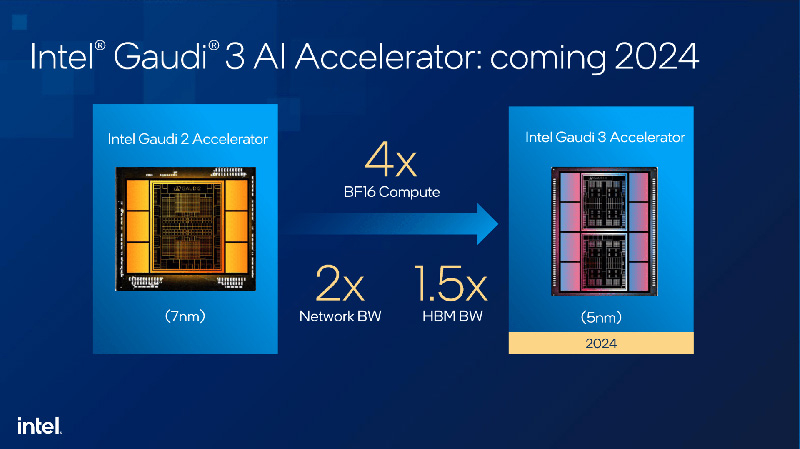

Intel показала ИИ-ускоритель Habana Gaudi3Корпорация Intel на мероприятии AI Everywhere показала ИИ-ускоритель следующего поколения — изделие Gaudi3, которое появится на коммерческом рынке в 2024 году. Новинка призвана составить конкуренцию решению NVIDIA H100, которое применяется в составе многих ИИ-платформ по всему миру. Gaudi3 придёт на смену ускорителю Gaudi2, который дебютировал в мае 2022 года. Данное устройство оснащено 96 Гбайт памяти HBM2e с пропускной способностью 2,45 Тбайт/с. Показатель TDP достигает 600 Вт. Gaudi3 будет существенно лучше Gaudi2, хотя полные характеристики пока не раскрываются. Однако демонстрация чипа говорит о высокой степени готовности продукта.

Источник изображений: Intel В целом, ничего существенно нового глава Intel о новинке не рассказал. Так, производительность BF16-вычислений увеличена приблизительно в четыре раза по сравнению с Gaudi2. Пропускная способность HBM-памяти выросла в полтора раза, а пропускная способность сети — вдвое. Ускоритель Gaudi3 будет изготавливаться с применением 5-нм технологии против 7-нм у предшественника. В конструкцию Gaudi3 входят восемь сборок HBM, тогда как у решения второго поколения их шесть.  Ранее говорилось, что Gaudi3 можно будет применять в серверах с воздушным и жидкостным охлаждением. Во втором случае речь идёт о двухфазной системе на основе хладагента среднего давления. Причём в этой СЖО не будут использоваться полифторалкильные вещества (PFAS, «вечные химикаты»).

09.12.2023 [23:30], Сергей Карасёв

Pliops готовит новый СУБД-ускоритель XDP с удвоенной производительностьюКомпания Pliops в рамках конференции Gartner приоткрыла завесу тайны над ускорителем Extreme Data Processor (XDP) следующего поколения. По заявления разработчика, новинка обеспечит приблизительно двукратное увеличение производительности по сравнению с предшественником. Изделия XDP предназначены для ускорения широкого спектра приложений. Среди них названы реляционные базы данных, разнородные СУБД NoSQL, резидентные базы данных, платформы 5G и IoT, задачи ИИ и машинного обучения, а также другие системы с интенсивным использованием информации. Сервисы XDP Data, работающие на базе ускорителей XDP, как отмечает Pliops, позволяют операторам дата-центров максимизировать инвестиции в свои инфраструктуры благодаря экспоненциальному увеличению производительности и надёжности хранилища, а также улучшению общей эффективности. Утверждается, в частности, что решение XDP-AccelDB обеспечивает десятикратное повышение быстродействия СУБД MongoDB и снижение совокупной стоимости владения до 95 %.

Источник изображения: Pliops Для администраторов Mongo DB и IT-специалистов платформа Pliops обеспечивает такие преимущества, как оптимизация ёмкости на уровне узла и кластера; экономически эффективная масштабируемость; оптимизация операций с базой данных, включая резервное копирование и восстановление; инфраструктура, отвечающая требованиям приложений и производительности. Ускорители Pliops XDP для MongoDB станут доступны в I квартале 2024 года. Компания Pliops также сообщила о сотрудничестве с Lenovo по выводу на рынок новых решений для работы с данными.

07.12.2023 [21:04], Сергей Карасёв

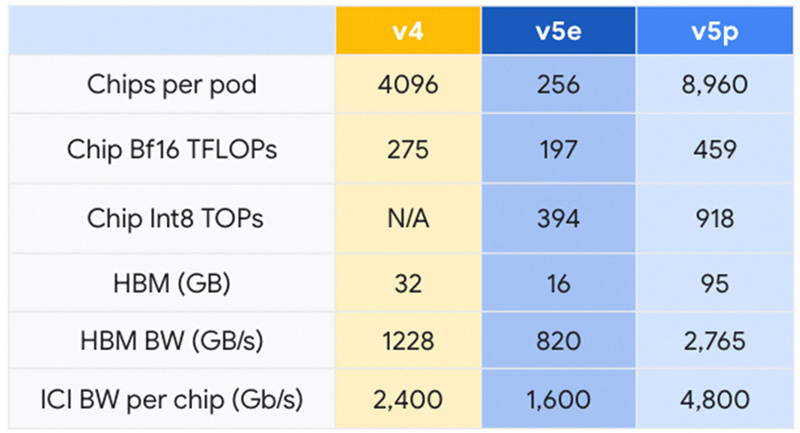

Google представила Cloud TPU v5p — свой самый мощный ИИ-ускорительКомпания Google анонсировала свой самый высокопроизводительный ускоритель для задач ИИ — Cloud TPU v5p. По сравнению с изделием предыдущего поколения TPU v4 обеспечивается приблизительно 1,7-кратный пророст быстродействия на операциях BF16. Впрочем, для Google важнее то, что она наряду с AWS является одной из немногих, кто при разработке ИИ не зависит от дефицитных ускорителей NVIDIA. К этому же стремится сейчас и Microsoft. Решение Cloud TPU v5p оснащено 95 Гбайт памяти HBM с пропускной способностью 2765 Гбайт/с. Для сравнения: конфигурация TPU v4 включает 32 Гбайт памяти HBM с пропускной способностью 1228 Гбайт/с.

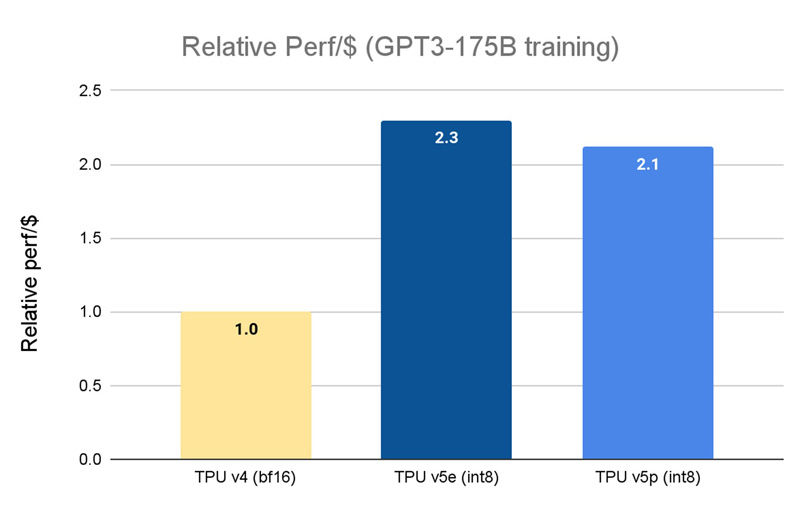

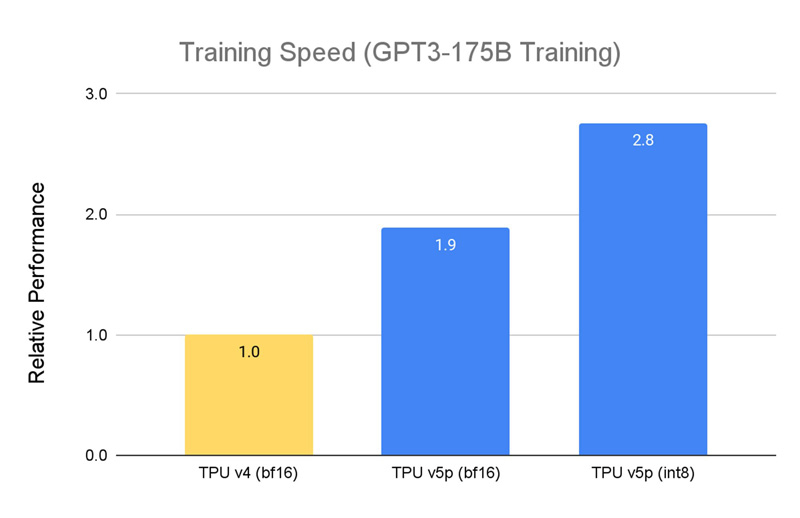

Источник изображений: Google Кластер на базе Cloud TPU v5p может содержать до 8960 чипов, объединённых высокоскоростным интерконнектом со скоростью передачи данных до 4800 Гбит/с на чип. В случае TPU v4 эти значения составляют соответственно 4096 чипов и 2400 Гбит/с. Что касается производительности, то у Cloud TPU v5p она достигает 459 Тфлопс (BF16) против 275 Тфлопс у TPU v4. На операциях INT8 новинка демонстрирует результат до 918 TOPS.  В августе нынешнего года Google представила ИИ-ускоритель TPU v5e, созданный для обеспечения наилучшего соотношения стоимости и эффективности. Это изделие с 16 Гбайт памяти HBM (820 Гбит/с) показывает быстродействие 197 Тфлопс и 394 TOPS на операциях BF16 и INT8 соответственно. При этом решение обеспечивает относительную производительность на доллар на уровне $1,2 в пересчёте на чип в час. У TPU v4 значение равно $3,22, а у новейшего Cloud TPU v5p — $4,2 (во всех случаях оценка выполнена на модели GPT-3 со 175 млрд параметров).  По заявлениям Google, чип Cloud TPU v5p может обучать большие языковые модели в 2,8 раза быстрее по сравнению с TPU v4. Более того, благодаря SparseCores второго поколения скорость обучения моделей embedding-dense увеличивается приблизительно в 1,9 раза. На базе TPU и GPU компания предоставляет готовый программно-аппаратный стек AI Hypercomputer для комплексной работы с ИИ. Система объединяет различные аппаратные ресурсы, включая различные типы хранилищ и оптический интерконнект Jupiter, сервисы GCE и GKE, популярные фреймворки AX, TensorFlow и PyTorch, что позволяет быстро и эффективно заниматься обучением современных моделей, а также организовать инференс.

02.12.2023 [23:17], Сергей Карасёв

ИИ-ускорители Intel Gaudi3 получат двухфазное жидкостное охлаждение VertivКомпании Intel и Vertiv объявили о заключении соглашения о сотрудничестве, в рамках которого планируется разработка эффективной СЖО для ускорителей Gaudi3: эти решения, предназначенные для ресурсоёмких ИИ-задач, увидят свет в 2024 году. Сообщается, что Gaudi3 можно будет использовать в составе серверов с воздушным и жидкостным охлаждением. В первом случае допускается работа при тепловой нагрузке до 40 кВт с температурой окружающего воздуха на входе до +35 °C. В качестве альтернативы предлагается применять двухфазное жидкостное охлаждение. Такое решение протестировано при совокупной мощности ИИ-ускорителей до 160 кВт с использованием на входе воды с температурой от +17 до +45 °C. Эта система на основе хладагента среднего давления, как утверждается, поможет заказчикам реализовать повторное использование тепла, одновременно улучшив показатели эффективности использования воды (WUE) и энергии (PUE). Кроме того, клиенты смогут снизить совокупную стоимость владения (TCO).

Источник изображения: Vertiv Системы двухфазного жидкостного охлаждения отводят тепло более эффективно по сравнению с другими решениями. Однако в последнее время технология столкнулась с критикой. Проблема заключается в том, что в таких системах используются фтористые соединения, такие как Novec от 3M, который недавно был снят с производства из-за опасений по поводу того, что состав может представлять угрозу для здоровья людей. Как сообщает ресурс Datacenter Dynamics, ссылаясь на заявления представителей Vertiv, в СЖО для Gaudi3 не будут применяться полифторалкильные вещества (PFAS, «вечные химикаты»), будущее которых находится под вопросом. Однако пока не уточняется, какую именно альтернативную жидкость намерена использовать компания.

01.12.2023 [11:55], Сергей Карасёв

Объём мирового рынка ЦОД-ускорителей вырастет на порядок к 2030 годуКомпания ResearchAndMarkets обнародовала прогноз по глобальному рынку ускорителей для дата-центров на период до 2030 года. Аналитики полагают, что спрос на такие решение будет быстро расти, что объясняется стремительным развитием сегмента ИИ, продолжающимся переносом корпоративных рабочих нагрузок в облако, расширением сетей 5G и пр. По оценкам, в 2022 году объём мировой отрасли ЦОД-ускорителей составил около $33,4 млрд. В дальнейшем ожидается показатель CAGR (среднегодовой темп роста в сложных процентах) на уровне 34,2 %. В результате, к 2030-му затраты достигнут $351,5 млрд, то есть увеличатся на порядок.

Источник изображения: NVIDIA В сегменте ускорителей на основе GPU прогнозируется значение CAGR около 32,1 %: если эти ожидания оправдаются, к концу текущего десятилетия затраты по данному направлению поднимутся до $128,5 млрд. Величина CAGR в сфере CPU, по мнению аналитиков, в течение рассматриваемого периода составит 36,1 %. Отмечается рост спроса на FPGA-решения. В 2022 году около трети всей выручки на рынке ЦОД-ускорителей пришлось на США — приблизительно $10,6 млрд. В Китае значение CAGR до 2030 года прогнозируется на уровне 33 %: в результате, к концу десятилетия выручка здесь достигнет $58 млрд. Среди других быстрорастущих географических регионов специалисты ResearchAndMarkets называют Японию и Канаду, где показатель CAGR ожидается в размере 30,4 % и 29,2 % соответственно в период 2022–2030 гг. На европейском рынке Германия покажет среднегодовой темп роста около 23,9 %.

29.11.2023 [03:43], Владимир Мироненко

AWS представила 96-ядерный Arm-процессор Graviton4 и ИИ-ускоритель Trainium2Amazon Web Services представила Arm-процессор нового поколения Graviton4 и ИИ-ускоритель Trainium2, предназначенный для обучения нейронных сетей. Всего к текущему моменту компания выпустила уже 2 млн Arm-процессоров Graviton, которыми пользуются более 50 тыс. клиентов. «Graviton4 представляет собой четвёртое поколение процессоров, которое мы выпустили всего за пять лет, и это самый мощный и энергоэффективный чип, который мы когда-либо создавали для широкого спектра рабочих нагрузок», — отметил Дэвид Браун (David Brown), вице-президент по вычислениям и сетям AWS. По сравнению с Graviton3 новый чип производительнее на 30 %, включает на 50 % больше ядер и имеет на 75 % выше пропускную способность памяти. Graviton4 будет иметь до 96 ядер Neoverse V2 Demeter (2 Мбайт L2-кеша на ядро) и 12 каналов DDR5-5600. Кроме того, новый чип получит поддержку шифрования трафика для всех своих аппаратных интерфейсов. Процессор изготавливается по 4-нм техпроцессу TSMC и, вероятно, имеет чиплетную компоновку. Возможно, это первый CPU компании, ориентированный на работу в двухсокетных платформах. Поначалу Graviton4 будет доступен в инстансах R8g (пока в статусе превью), оптимизированных для приложений, интенсивно использующих ресурсы памяти — высокопроизводительные базы данных, in-memory кеши и Big Data. Эти инстансы будут поддерживать более крупные конфигурации, иметь в три раза больше vCPU и в три раза больше памяти по сравнению с инстансами Rg7, которые имели до 64 vCPU и 512 Гбайт ОЗУ. В свою очередь, Trainium 2 предназначен для обучения больших языковых моделей (LLM) и базовых моделей. Сообщается, что ускоритель в сравнении с Trainium 1 вчетверо производительнее и при этом имеет в 3 раза больший объём памяти и в 2 раза более высокую энергоэффективность. Инстансы EC2 Trn2 получат 16 ИИ-ускорителей с возможностью масштабирования до 100 тыс. единиц в составе EC2 UltraCluster, которые суммарно дадут 65 Эфлопс, то есть по 650 Тфлопс на ускоритель. Как утверждает Amazon это позволит обучать LLM с 300 млрд параметров за недели вместо месяцев. Со временем на Graviton4 заработает SAP HANA Cloud, портированием и оптимизацией этой платформы уже занимаются. Oracle также перенесла свою СУБД на Arm, а заодно перевела все свои облачные сервисы на чипы Ampere, в которую в своё время инвестировала. Microsoft же пошла по пути AWS и недавно анонсировала 128-ядерый Arm-процессор (Neoverse N2) Cobalt 100 и ИИ-ускоритель Maia 100 собственной разработки. Всё это может представлять отдалённую угрозу для AMD и Intel. С NVIDIA же все всё равно пока что продолжают дружбу — именно в инфраструктуре AWS, как ожидается, появится самый мощный в мире ИИ-суперкомпьютер на базе новых GH200.

28.11.2023 [22:20], Игорь Осколков

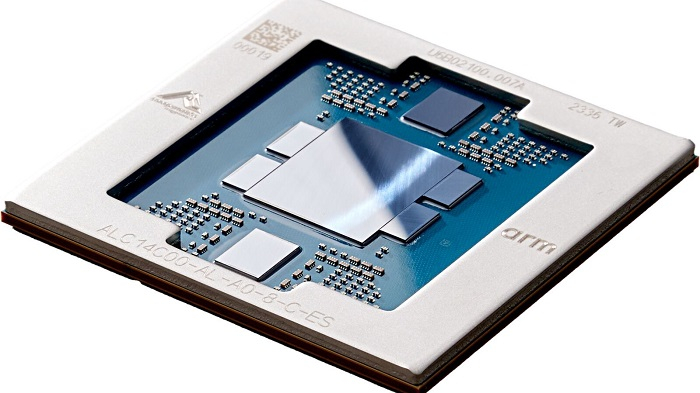

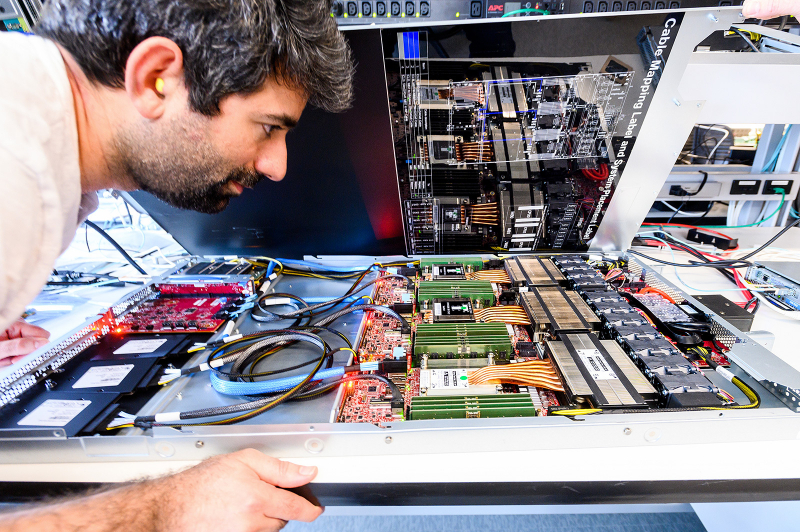

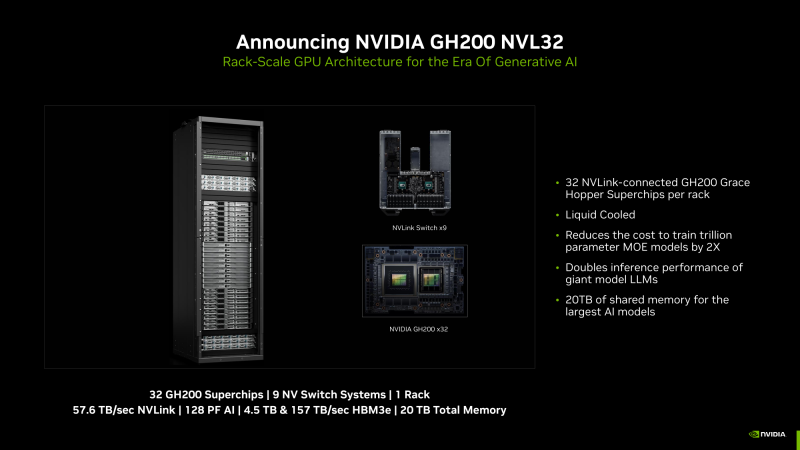

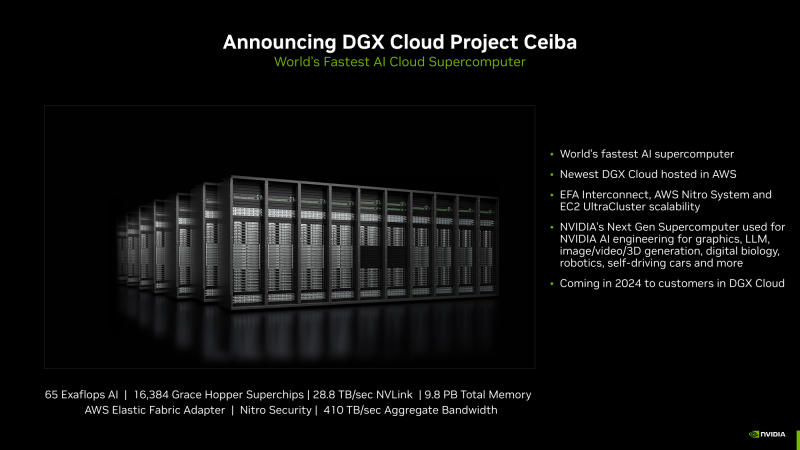

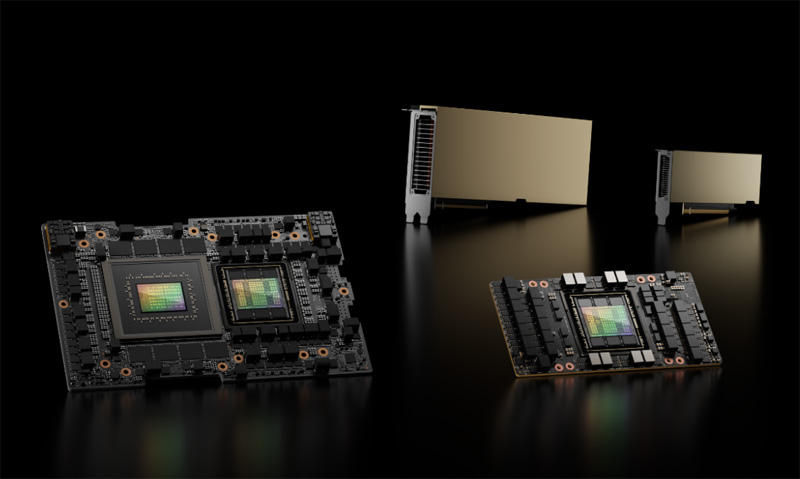

NVIDIA анонсировала суперускоритель GH200 NVL32 и очередной самый мощный в мире ИИ-суперкомпьютер Project CeibaAWS и NVIDIA анонсировали сразу несколько новых совместно разработанных решений для генеративного ИИ. Основным анонсом формально является появление ИИ-облака DGX Cloud в инфраструктуре AWS, вот только облако это отличается от немногочисленных представленных ранее платформ DGX Cloud тем, что оно первом получило гибридные суперчипах GH200 (Grace Hoppper), причём в необычной конфигурации.

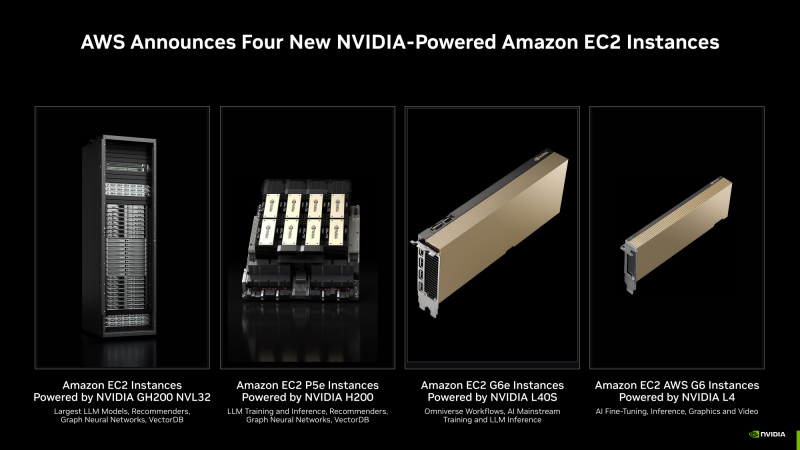

Изображения: NVIDIA В основе AWS DGX Cloud лежит платформа GH200 NVL32, но это уже не какой-нибудь сдвоенный акселератор вроде H100 NVL, а целая, готовая к развёртыванию стойка, включающая сразу 32 ускорителя GH200, провязанных 900-Гбайт/с интерконнектом NVLink. В состав такого суперускорителя входят 9 коммутаторов NVSwitch и 16 двухчиповых узлов с жидкостным охлаждением. По словам NVIDIA, GH200 NVL32 идеально подходит как для обучения, так и для инференса действительно больших LLM с 1 трлн параметров. Простым перемножением количества GH200 на характеристики каждого ускорителя получаются впечатляющие показатели: 128 Пфлопс (FP8), 20 Тбайт оперативной памяти, из которых 4,5 Тбайт приходится на HBM3e с суммарной ПСП 157 Тбайтс, и агрегированная скорость NVLink 57,6 Тбайт/с. И всё это с составе одного EC2-инстанса! Да, новая платформа использует фирменные DPU AWS Nitro и EFA-подключение (400 Гбит/с на каждый GH200). Новые инстансы, пока что безымянные, можно объединять в кластеры EC2 UltraClasters. Одним из таких кластеров станет Project Ceiba, очередной самый мощный в мире ИИ-суперкомпьютер с FP8-производительность 65 Эфлопс, объединяющий сразу 16 384 ускорителя GH200 и имеющий 9,1 Пбайт памяти, а также агрегированную пропускную способность интерконнекта на уровне 410 Тбайт/с (28,8 Тбайт/с NVLink). Он и станет частью облака AWS DGX Cloud, которое будет доступно в начале 2024 года. В скором времени появятся и EC2-инстансы попроще: P5e с NVIDIA H200, G6e с L40S и G6 с L4. |

|