Материалы по тегу: s

|

04.09.2025 [09:37], Руслан Авдеев

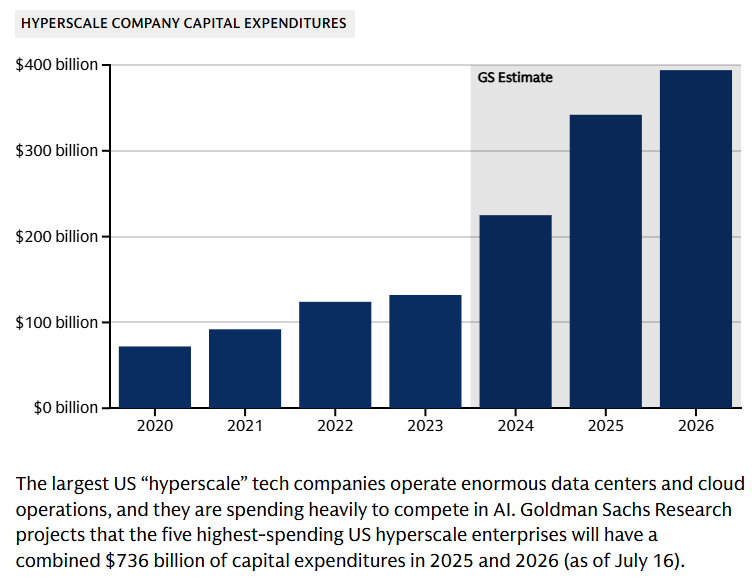

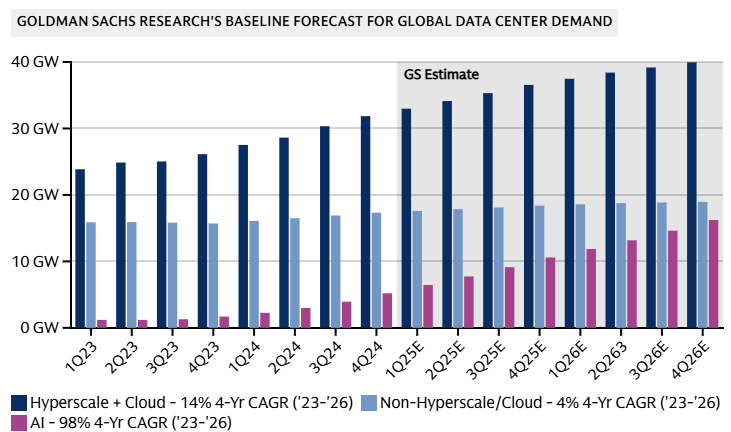

Goldman Sachs допускает крах «пузыря» ИИ на фоне бума в сфере ЦОДИсследование Goldman Sachs свидетельствует, что к 2027 году мощность ЦОД вырастет на 50 % благодаря спросу на ИИ, а энергопотребление сектора удвоится к 2030 году. При этом финансисты отмечают, что повсеместное внедрение ИИ может не оправдать ожиданий инвесторов, сообщает The Register — ИИ-бум породил «лихорадочную атмосферу», в которой крупные технологические компании находятся в постоянном страхе из-за вероятных изменений рынка. По оценкам компании, сегодня глобальная мощность дата-центров составляет порядка 62 ГВт, на облачные нагрузки приходится 58 %, на традиционные нагрузки — 29 % и лишь 13 % — на искусственный интеллект. В начале 2023 года доля ИИ-нагрузок была околонулевой, а к 2027 году она достигнет уже 28 %. Доля облачных нагрузок сократится до 50 %, традиционных — до 21 %. Конечно, сократится лишь доля от общей мощности, а не сами нагрузки из-за активного развития ИИ. По данным Omdia, расходы на ЦОД уже сопоставимы со средними по размеру мировыми экономиками — одна Amazon инвестирует в ЦОД около $118 млрд, что приблизительно равно ВВП Коста-Рики. В Counterpoint Research допускают, что бум ИИ ЦОД может привести к удвоению мировых доходов полупроводниковой промышленности с 2024 по 2030 гг. до более $1 трлн. Большая часть спроса, вероятно, будет приходиться на решения гиперскейл-уровня в краткосрочной и долгосрочной перспективе.

Источник изображения: Lanju Fotografie/unsplash.com Обучение ИИ требует специального оборудования, что приводит к кардинальным изменениям рынка. По данным Goldman Sachs, если два года назад на передовой сервер приходилось по восемь ИИ-ускорителей, то к 2027 году речь будет идти о 576 экземплярах, потребляющих 600 кВт — речь про стойки Kyber с суперускорителями NVIDIA Rubin Ultra NVL576.

Источник изображения: Goldman Sachs Research В результате к 2030 году потребление дата-центрами электричества в мире должно вырасти на 165 %, т.е. с 1–2 % в 2023 году до 3–4 % к концу текущего десятилетия. Ожидается, что за счёт возобновляемых источников будет обеспечено 40 % дополнительной энергии для ЦОД. Поможет и ядерная энергетика, но не так кардинально. Оставшиеся 60 % придётся на генерацию на природном газе, что увеличит выбросы парниковых газов к концу текущего десятилетия на 215–220 млн т — эквивалент 0,6 % от общемировых выбросов, связанных с энергетикой.

Источник изображения: Goldman Sachs Research Хотя прогнозы экспертов относительно рынка ЦОД обычно оптимистичны, финансовые эксперты тщательно следят за любыми негативными изменениями на рынке. Риски включают потенциальные проблемы с монетизацией ИИ. К ним же относится и вариант, при котором инновации значительно удешевят разработку и коммерциализацию моделей. Базовый сценарий предполагает CAGR моoностей ЦОД на уровне 17 % — 92 ГВт к 2027 году. При этом разные сценарии прогнозируют рост в 14 % (если ИИ будет не так интересен бизнесу, как ожидается) до 20 % — если ситуация будет развиваться более оптимистично. Опасения финансовых магнатов отражают «ИИ-скептицизм», присутствующий в более широком масштабе. Глава OpenAI Сэм Альтман (Sam Altman) недавно констатировал, что в отрасли наблюдается «ИИ-пузырь», а эксперты компании McKinsey ещё в начале года предупредили, что никто не может с высокой достоверностью прогнозировать спрос на ИИ в будущем.

03.09.2025 [17:22], Сергей Карасёв

«К2 НейроТех» представил ПАК-AI 2.0 с увеличенной на 30 % производительностью

emerald rapids

gpu

hardware

intel

sapphire rapids

xeon

yadro

ии

к2тех

россия

сделано в россии

сервер

Компания «К2 НейроТех», подразделение компании «К2Тех», анонсировала программно-аппаратный комплекс ПАК-AI 2.0, предназначенный для построения локальной ИИ-инфраструктуры. Утверждается, что по сравнению с оригинальной версией платформы, дебютировавшей в июне нынешнего года, производительность поднялась на 30 %. ПАК объединяют аппаратный слой, платформу управления, преднастроенное ПО и инструменты для работы с ИИ. Решение может быть кастомизировано под конкретные задачи заказчика. Количество серверных стоек масштабируется для обеспечения необходимой производительности. Реализован встроенный маркетплейс приложений, через который в числе прочего доступна платформа Yandex Cloud AI Studio для создания приложений на базе ИИ. Обновленная аппаратная платформа ПАК-AI 2.0 включает шесть серверов YADRO, в том числе серверы для глубокого обучения, инференса и работы с большими данными, а также новый GPU-сервер G4208P G3. Последний специально разработан для обучения нейросетей, обработки больших объемов данных и построения распределённых ИИ-кластеров. Этот сервер несёт на борту два процессора Intel Xeon Sapphire Rapids или Emerald Rapids с TDP до 350 Вт. Поддерживается до 8 Тбайт DDR5. Возможна установка до восьми GPU двойной ширины (PCIe 5.0 x16) с энергопотреблением до 450 Вт каждый. Помимо улучшенной аппаратной части, ПАК-AI 2.0 получил доработанную сборку Kubernetes, которая предоставляет в режиме самообслуживания работу с различными ускорителями (в том числе PCIe, SXM) в формате GPU, vGPU MIG и увеличивает производительность GPU до 30 %. Благодаря этому, как утверждается, повышается эффективность запуска моделей машинного обучения и снижаются эксплуатационные расходы. «К2 НейроТех» заявляет, что ПАК позволяет в короткие сроки развернуть IT-инфраструктуру, которая максимально раскрывает потенциал ИИ, обеспечивает высокий уровень безопасности и соответствие регламентам ИБ, а также прозрачное управление данными. Благодаря наличию LLM-моделей и агентов, предварительно настроенных для выполнения бизнес-задач, ускоряется вывод продуктов на рынок.

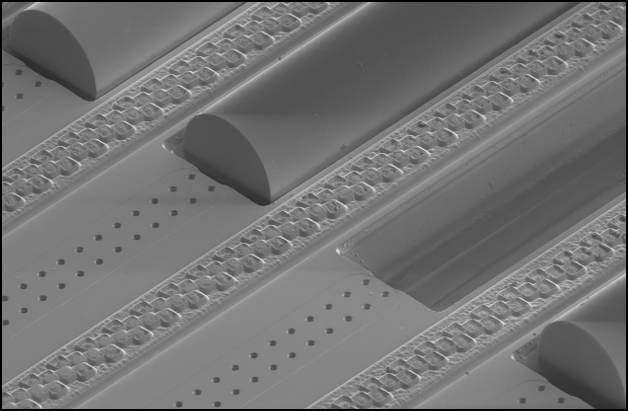

03.09.2025 [16:32], Владимир Мироненко

GlobalFoundries объявила о готовности к массовому развёртыванию решений в сфере кремниевой фотоникиАмериканский контрактный производитель полупроводников GlobalFoundries вывел свою платформу кремниевой фотоники в отдельную линейку продуктов и удвоил инвестиции в её развитие, сообщил Кевин Соукуп (Kevin Soukup), старший вице-президент. Он сравнил текущее состояние внедрения технологии с «режимом запуска» Tesla, характеризующимся готовностью к ускоренному массовому развёртыванию, пишет Converge! Network Digest. По словам Соукупа спрос на кремниевую фотонику в ЦОД определяют три взаимосвязанных фактора: взрывной рост объёмов данных, развитие ИИ и LLM с триллионами параметров, а также стремительное увеличение энергопотребления. По его оценкам, к 2030 году глобальное энергопотребление ЦОД может удвоиться, и только в США на ИИ ЦОД будет приходиться 10–15 % всего потребления электроэнергии страны. При этом многие ASIC простаивают до 75 % времени в связи с низкой скоростью передачи данных между чипами. «Кремниевая фотоника снижает энергопотребление и задержку, обеспечивая при этом возможность масштабирования архитектур как в горизонтальном, так и в вертикальном направлении для GPU и ASIC», — сказал он.

Источник изображения: GlobalFoundries GlobalFoundries опубликовала программу развития, охватывающую три ключевых подхода к оптической связи. В категории подключаемой оптики традиционные оптические модули с пропускной способностью 200 Гбит/с на линию, подключаемые к сетевым коммутаторам, широко используются в ЦОД уже сейчас. Модули с поддержкой 400 Гбит/с на линию пройдут тестирование к концу 2025 года. Выпуск прототипов намечен на 2026 год, запуск массового производства — на 2027 год. В категории линейной оптики (LPO) — оптических решений, в которых цифровая обработка сигнала перенесена с оптического модуля на хост-схему ASIC, что снижает энергопотребление и задержку, GlobalFoundries планирует развёртывания в ближайшей перспективе с партнерами по экосистеме. В категории интегрированной фотоники (CPO) основное внимание уделяется передовым корпусам, многоволоконным соединениям, отсоединяемым (detachable) оптическим интерфейсам и стекированию фотонных и электронных схем. Соукуп сообщил, что компанией была создана серьёзная экосистема для развитя фотоники, включая новый Центр упаковки передовых фотонных модулей (APPC) в Мальте (штат Нью-Йорк) для производства оптических модулей в стране. Intel и Broadcom также активно продвигают LPO- и CPO-решения, а Marvell инвестирует в подключаемые решения на базе DSP. Отрасль вступает в критическую фазу, когда гиперскейлеры должны выбирать оптическую архитектуру, которая обеспечивает баланс между масштабируемостью, эффективностью и рисками развёртывания, отметил Converge! Network Digest.

03.09.2025 [13:39], Руслан Авдеев

SAP инвестирует более €20 млрд в суверенное облако для поддержки европейских клиентовКрупнейший немецкий разработчик ПО — компания SAP объявила о намерении инвестировать в течение 10 лет более €20 млрд ($23,3 млрд) в свою суверенную облачную инфраструктуру в Европе, сообщает CNBC. Компания предложит IaaS на базе собственных дата-центров. Дополнительно будет представлена новая локальная опция, которая позволит пользоваться инфраструктурой SAP в дата-центрах заказчика. В Германии также будет доступно облако Delos Cloud. Цель новой инициативы — обеспечить хранение данных клиентов на территории Евросоюза для соблюдения правил защиты местных данных, включая GDPR. По словам SAP, инновации и суверенитет нераздельны. Он добавил, что европейским компаниям важно получить доступ к новейшим технологиям вроде ИИ в «контексте полного суверенитета». За последний год тема суверенитета стала особенно популярной, на фоне геополитических противоречий компаниям пришлось провести переоценку зависимости от иностранных технологий. Государства всё чаще стараются полагаться на локальную инфраструктуру, необходимую для обучения и эксплуатации ИИ. В результате AWS, Google и Microsoft объявили о новых сервисах в сфере суверенных облаков, призванных хранить европейские данные в ЕС. При этом Microsoft и Google выразили готовность защищать интересы европейских клиентов перед американским правительством.

Источник изображения: Carl Gruner/unsplash.com ЕС считает развитие ИИ одним из приоритетов региона — блок стремиться составить конкуренцию США и Китаю, от которых пока значительно отстаёт в этом отношении. Ранее Еврокомиссия рассказала о планах инвестировать €20 млрд в создание «ИИ-гигабафрик», оснащённых мощнейшими ИИ-суперкомпьютерами. В SAP объявили, что тесно участвуют в создании таких фабрик, но компания не будет в проекте ведущим партнёром. Представитель SAP добавил, что её инвестиции в объёме более €20 млрд, предусматриваемые для европейского суверенного облака, не повлияют на капитальные затраты компании на следующий год, они уже заложены в её финансовые планы. SAP является одним из ключевых европейских игроков в IT-сфере — компания стала самым дорогим публичным бизнесом в Европе. Примечательно, что ещё в июне 2025 года сообщалось, что SAP не видит смысла в строительстве Европой собственной облачной инфраструктуры в противовес американским гиперскейлерам. В конце мая появилась новость, что Евросоюз готов признать, что отказаться от американских облаков «почти невозможно», а в июле Synergy Research Group заявила, что доля европейских облачных провайдеров на местном рынке снизилась до 15 % и остаётся на этом уровне годами.

02.09.2025 [12:15], Сергей Карасёв

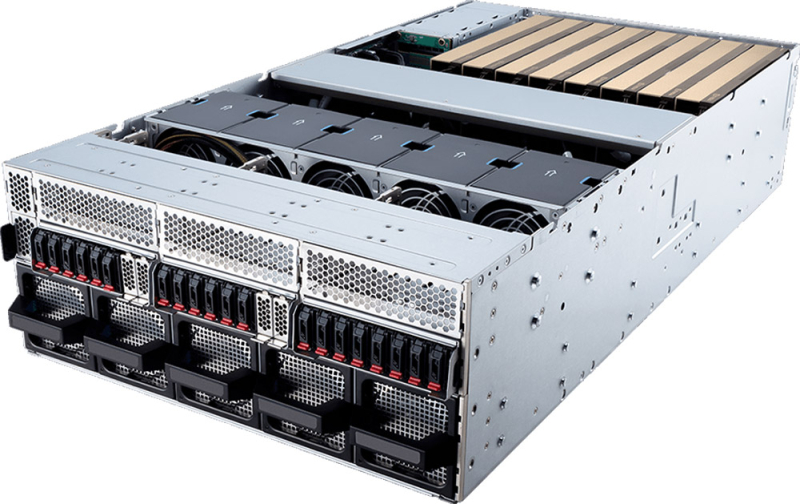

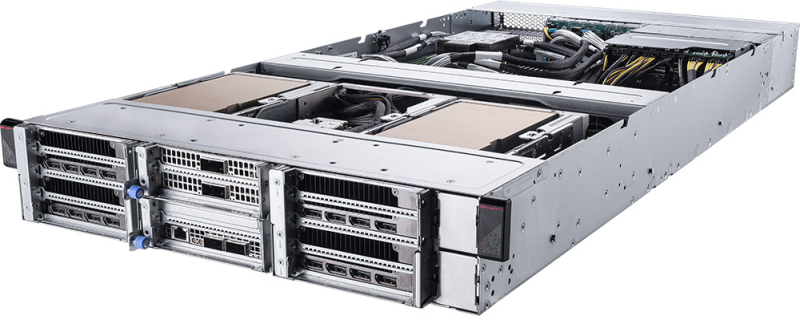

MSI выпустила серверы на платформе NVIDIA MGX с ускорителями RTX Pro 6000 Blackwell Server EditionКомпания MSI анонсировала серверы CG480-S5063 и CG290-S3063 на модульной архитектуре NVIDIA MGX. Новинки, ориентированные на задачи ИИ, оснащаются ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition с 96 Гбайт GDDR7. Модель CG480-S5063 выполнена в форм-факторе 4U. Допускается установка двух процессоров Intel Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400/5200 или MRDIMM 8000). Во фронтальной части могут быть размещены 20 накопителей E1.S с интерфейсом PCIe 5.0 x4 (NVMe). Кроме того, есть два внутренних коннектора М.2 2280/22110 (PCIe 5.0 x2; NVMe). Система предлагает восемь слотов PCIe 5.0 x16 для карт FHFL двойной ширины и пять слотов PCIe 5.0 x16 для карт FHFL одинарной ширины. Таким образом, могут быть задействованы до восьми ИИ-ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на основе Intel X710-AT2, выделенный сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Питание обеспечивают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Задействовано воздушное охлаждение с вентиляторами, допускающими горячую замену. Диапазон рабочих температур — от 0 до +35 °C. В свою очередь, сервер CG290-S3063 типоразмера 2U рассчитан на один процессор Xeon 6500P/6700P с TDP до 350 Вт. Предусмотрены 16 слотов для модулей DDR5 (RDIMM 6400/5200 или MRDIMM 8000). В тыльной части расположены отсеки для четырёх SFF-накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe). Внутри есть два коннектора М.2 2280/22110 для SSD (PCIe 5.0 x2; NVMe). Данная система предоставляет четыре слота PCIe 5.0 x16 для карт FHFL двойной ширины и три слота PCIe 5.0 x16 для карт FHFL одинарной ширины. Могут быть использованы до четырёх ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. Прочие характеристики включают контроллер ASPEED AST2600, сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Применены четыре блока питания мощностью 2400 Вт с сертификатом 80 PLUS Titanium и воздушное охлаждение.

02.09.2025 [09:10], Руслан Авдеев

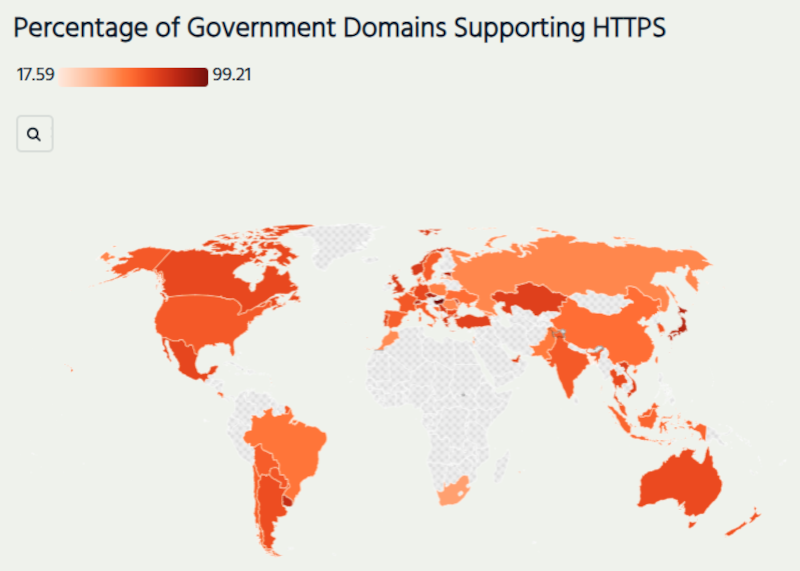

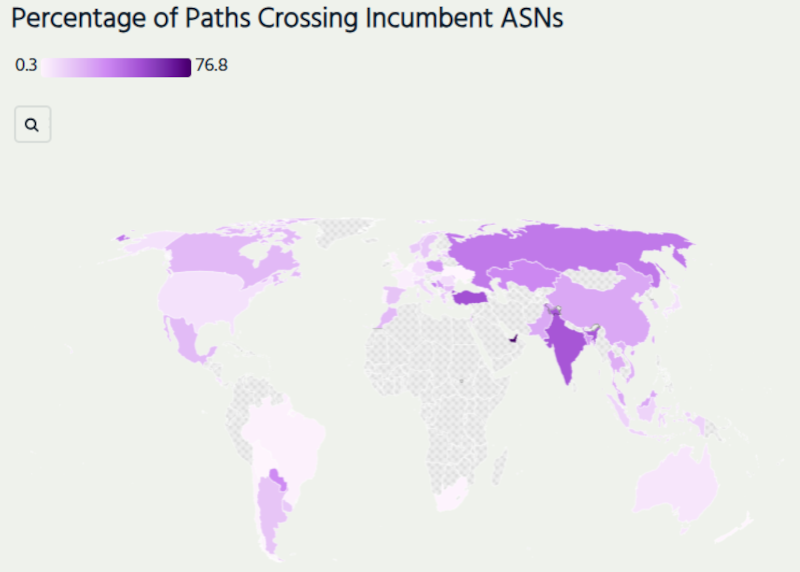

Госсайты многих стран оказались лишены элементарной защиты, а трафик до них идёт через зарубежные сетиСогласно результатам исследования, проведённого в рамках исследовательской стипендии Internet Society Pulse Северо-Западным университетом США (Northwestern University), интернет-трафик к правительственным доменам часто пересекает границы, сообщает The Register. Более того, их связность порой страдает, а иногда трафик даже не шифруется. В исследование попали правительственные сайты 58 стран. Обнаружилось, что значительная часть данных таких сайтов либо свободно пересекает границы, либо использует зарубежные точки обмена трафиком (IX). Так, в странах вроде Малайзии, Норвегии, ЮАР и Таиланда через зарубежные IX проходит 23–43 % трафика, а данные для новозеландских правительственных ресурсов зачастую проходят через Австралию.

Источник изображения: Internet Society Pulse Предполагается, что к использованию офшорной инфраструктуры чаще склонны менее развитые страны. Они же зачастую не используют HTTPS для защиты. Например, в случае Албании через иностранные сети проходит 86 % трафика госсайтов, а ещё 15 % — через расположенные за рубежом IX. При этом лишь треть правительственных доменов вообще применяют HTTPS. В совокупности это создаёт условия для MitM-атак.

Источник изображения: Internet Society Pulse У Казахстана свои особенности. Все правительственные ресурсы располагаются в сетях страны и использует локальные точки обмена, уровень внедрение HTTPS высок и составляет 71,5 %. Однако около 70 % трафика госресурсов проходит через единственного телеком-оператора «Казахтелеком», что снижает устойчивость. Нечто похожее наблюдается в Бангладеше, Пакистане и Турции из-за «наследия» государственных телеком-монополий. В ОАЭ более ¾ маршрутов пролегает через сети Etisalat. А маршрутизации марокканского трафика госсайтов через Испанию и Францию наводит на мысли об «интересных колониальных связях». По данным исследования, США, Великобритания, Канада, Швейцария и Швеция распределяют «государственный» трафик между разными операторами связи и точками обмена, благодаря чему правительственные ресурсы и сервисы более устойчивы к техническим сбоям. А вот оценить показатели африканских государств оказалось трудно, поскольку инструментов вроде RIPE ATLAS на континенте немного.

01.09.2025 [23:50], Андрей Крупин

MWS Cloud в 1,5 раза увеличила мощности GPU-облака для искусственного интеллектаКомпания MWS Cloud (входит в МТС Web Services) сообщила о расширении в первом полугодии 2025 года мощностей виртуальной инфраструктуры с GPU в полтора раза. Виртуальная инфраструктура была расширена в двух московских ЦОД — в «Авантаже» и GreenBushDC, а также в дата-центре в Санкт-Петербурге. Виртуальная инфраструктура с GPU позволяет обучать и выводить в инференс любые ML-, LLM- и CV-модели. Поверх неё можно развернуть ML-платформу или платформу для инференса MWS Cloud. Доступ к ускорителям в облаках тарифицируются по принципу Pay as You Go (PAYG, оплата по мере потребления).

Источник изображения: Luke Peters / unsplash.com Новые мощности предназначены для разработчиков, data-саентистов и организаций, которые обучают сложные ML- и LLM-модели (включая генеративные нейросети), запускают инференс высоконагруженных коммерческих продуктов, разрабатывают компьютерное зрение для систем распознавания и анализа, используют ресурсоёмкие вычисления для рендеринга, симуляций и работы с большими данными. «Мы видим устойчивый рост спроса на виртуальную инфраструктуру с GPU. С начала года её потребление в облаке MWS Cloud увеличилось почти в 1,7 раза. В связи с этим мы стремимся соразмерно расширять наши облачные мощности», — отметил директор по новым продуктам MWS Cloud Алексей Кузнецов.

01.09.2025 [12:05], Сергей Карасёв

Giga Computing представила блейд-серверы B-series на платформах AMD и IntelКомпания Giga Computing, подразделение Gigabyte, объявила о выходе на рынок блейд-серверов, оптимизированных для корпоративных, периферийных и облачных рабочих нагрузок. Первыми системами данного класса стали устройства B343-C40 на аппаратной платформе AMD и B343-X40 с процессорами Intel. Все новинки выполнены в форм-факторе 3U с 10-узловой конфигурацией. Серверы B343-C40 могут комплектоваться чипами EPYC 4005 Grado или Ryzen 9000 с показателем TDP до 170 Вт (один CPU на узел). Доступны четыре слота для модулей оперативной памяти DDR5-5600/3600 в расчете на узел. Каждый из узлов также предлагает слот M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x1, два посадочных места для SFF-накопителей NVMe/SATA, один разъём для карты расширения FHHL с интерфейсом PCIe 5.0 x16 и три слота OCP NIC 3.0 (PCIe 4.0 x4). В семейство B343-C40 вошли три модификации — B343-C40-AAJ1, B343-C40-AAJ2 и B343-C40-AAJ3, у которых каждый из узлов располагает соответственно двумя портами 1GbE (контроллер Intel I350-AM2), 10GbE (Broadcom BCM57416) и 25GbE (Broadcom BCM57502). Кроме того, во всех случаях предусмотрен выделенный сетевой порт управления 1GbE и контроллер ASPEED AST2600 (на узел). За питание системы в целом отвечают четыре блока мощностью 2000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +30 °C. Применяется воздушное охлаждение. В свою очередь, у сервера B343-X40 каждый из узлов может оснащаться одним процессором Xeon 6300 с TDP до 95 Вт. Реализованы четыре слота для модулей DDR5-4400/4000/3600 и два порта 1GbE на основе контроллера Intel I350-AM2 (в расчёте на узел). В остальном технические характеристики аналогичны AMD-версиям. При этом в систему установлены два блока питания мощностью 3200 Вт с сертификатом 80 PLUS Titanium.

28.08.2025 [09:28], Владимир Мироненко

ASUS Cloud увеличит вычислительные мощности Тайваня на 50 %, построив 250-Пфлопс ИИ-суперкомпьютерASUS Cloud в партнёрстве с Taiwan AI Cloud (Taiwan Web Service Corp) и Национальным центром высокопроизводительных вычислений Тайваня (National Center for High-performance Computing, NCHC) в Тайнане (Тайвань) построит суперкомпьютер на ускорителях NVIDIA. Об этом сообщил гендиректор ASUS Cloud и Taiwan AI Cloud Питер Ву (Peter Wu, на фото ниже) в интервью газете South China Morning Post (SCMP). Питер Ву рассказал, что суперкомпьютер с начальной производительностью 80 Пфлопс (точность не уточняется) будет работать на 1700 ускорителях NVIDIA H200. Его запуск запланирован на декабрь, а со временем производительность новой системы вырастет до 250 Пфлопс. Ранее сообщалось, что NVIDIA также поставит два суперускорителя GB200 NVL72 и узлы HGX B300 для данной машины. По словам Ву, после запуска суперкомпьютера общая вычислительную мощность HPC-систем Тайваня вырастет минимум на 50 %. В феврале 2025 года Национальный совет по науке и технологиям Тайваня (NSTC) объявил о планах по увеличению общей вычислительной мощности систем страны примерно до 1200 Пфлопс к 2029 году с имеющихся 160 Пфлопс. Как отметил DataCenter Dynamics, ASUS ранее сотрудничала с NVIDIA в развёртывании суперкомпьютеров на Тайване, включая 9-Плфопс машину Taiwania 2. В 2022 году ASUS и NVIDIA построили на Тайване суперкомпьютер для медицинских исследований. Taiwan AI Cloud уже реализовала аналогичные нынешнему проекты по созданию ИИ-инфраструктуры в других странах. Среди них — ЦОД в Сингапуре, а также объект во Вьетнаме с 200 ускорителями NVIDIA, который строят для государственного оператора Viettel. Этот проект стартовал в начале 2025 года после того, как правительство США одобрило поставку чипов NVIDIA. Ву отметил рост популярности агентного ИИ. Министерство цифровых технологий острова (MODA) «рекомендовало нам предоставить открытую архитектуру с фреймворком агентного ИИ», чтобы помочь местным компаниям использовать или модернизировать свои существующие приложения, сказал он. Говоря о материковом Китае, Питер Ву заявил, что компании будет «непросто» реализовывать там аналогичные проекты «из-за ситуации с поставками GPU». Китайский подход, заключающийся в «стекировании и кластеризации» малопроизводительных чипов для достижения производительности, аналогичной системам с передовыми ИИ-ускорителями, может быть осуществим с точки зрения инференса. Ву отметил, что запуск DeepSeek «рассуждающей» модели R1 в январе спровоцировал рост спроса на инференс, поскольку эта модель превосходно справляется с такими задачами. «Если рабочая нагрузка аналогична [инференсу], будет легче внедрить альтернативную технологическую схему с существующими [чипами]», — сказал Ву, добавив, что разработчики «могут столкнуться с проблемами в выборе GPU», если проект предполагает обучение или тонкую настройку ИИ-систем. Говоря о будущем, Ву сообщил, что ожидает дальнейшего развития трёх сегментов ИИ в будущем: вычислительной геномики, квантовых вычислений и так называемых цифровых двойников. «Приложение-убийца [для цифровых двойников] может появиться в сфере ухода за пожилыми людьми, помогая им получать лекарства, еду или принимать душ», — прогнозирует Ву.

27.08.2025 [08:58], Руслан Авдеев

Южнокорейские энергетики помогут AWS и X-energy развернуть в США сеть малых модульных реакторов для ИИ ЦОДAmazon (AWS) и разработчик малых модульных реакторов (SMR) X-energy заключили соглашения о партнёрстве с южнокорейскими Korea Hydro & Nuclear Power и Doosan Enerbility с целью развёртывания в США более 5 ГВт атомных мощностей на базе SMR Xe-100 к 2039 году — в первую очередь для удовлетворения потребностей ЦОД в электричестве, сообщает Datacenter Dynamics. Компании намерены привлечь до $50 млрд государственных и частных инвестиций для постройки Xe-100 и расширения цепочек поставок. В X-energy заявляют, что партнёрство объединяет южнокорейские энергетические и атомные технологии с передовыми реакторными и топливными технологиями X-energy, чтобы решить «историческую» энергетическую задачу, ускорив вывод Xe-100 на рынок. Утверждается, что сотрудничество США и Южной Кореи в этом секторе жизненно важно для сохранения лидерства США в гонке за ИИ. Соглашение будет способствовать более тесному сотрудничеству между ядерными секторами Южной Кореи и США, с опорой на существующие отношения X-energy. В частности, предусмотрено сотрудничество в сфере проектирования реакторов, развития цепочек поставок, планирования строительных проектов, в сфере инвестиционных стратегий и долгосрочной эксплуатации реакторов для комбинации атомных и ИИ-проектов. В AWS подчёркивают, что потребности ИИ ЦОД в электроэнергии растут, поэтому новое партнёрство позволит развить инновационные безуглеродные решения и технологии в этой сфере, что поможет получить США более 5 ГВт новых генерирующих мощностей.

Источник изображения: X-energy Xe-100 представляет собой высокотемпературный газовый реактор, использующий топливные элементы размером с бильярдный шар, каждый из которых содержит тысячи фрагментов уранового топлива. Реактор будет вырабатывать 80 МВт электрической и 200 МВт тепловой энергии. В феврале X-energy завершила раунд финансирования серии C-1, аккумулировав $700 млн. Средства потратят на завершение проектирования и лицензирования SMR, строительство первой очереди завода по производству топлива TRISO-X в США, а также на проекты, в которых предполагается использовать SMR X-energy. В прошлом году Amazon уже объявила о партнёрстве с X-energy и инвестициях в стартап. В рамках соглашения с Amazon будет поставлено четыре SMR консорциуму государственных коммунальных предприятий Energy Northwest. Ожидается, что реакторы станут генерировать порядка 320 МВт на начальном этапе, но с возможностью увеличения общей мощности до 960 МВт. Ввод в эксплуатацию первых мощностей запланирован на начало 2030-х гг. На днях также стало известно, что американская TerraPower поможет SK Group сформировать в Южной Корее экосистему малых модульных реакторов. Ранее в августе поддерживаемая Google компания Kairos Power подписала соглашение о покупке 50 МВт электроэнергии с Tennessee Valley Authority (TVA) для поставок электричества в дата-центры Google. А Equinix подписала три крупных соглашения с передовыми разработчиками атомных реакторов на поставку до 774 МВт электроэнергии. Кроме того, за последний год Data4, Oracle, Switch и Endeavour также подписали соглашения с разработчиками SMR. |

|