Материалы по тегу: s

|

12.09.2025 [23:07], Владимир Мироненко

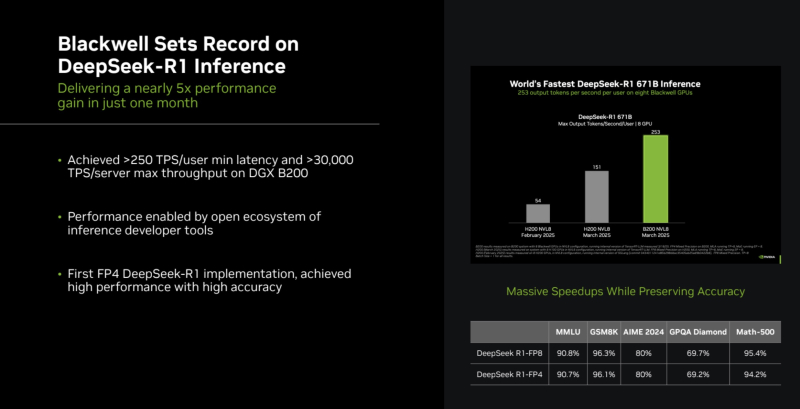

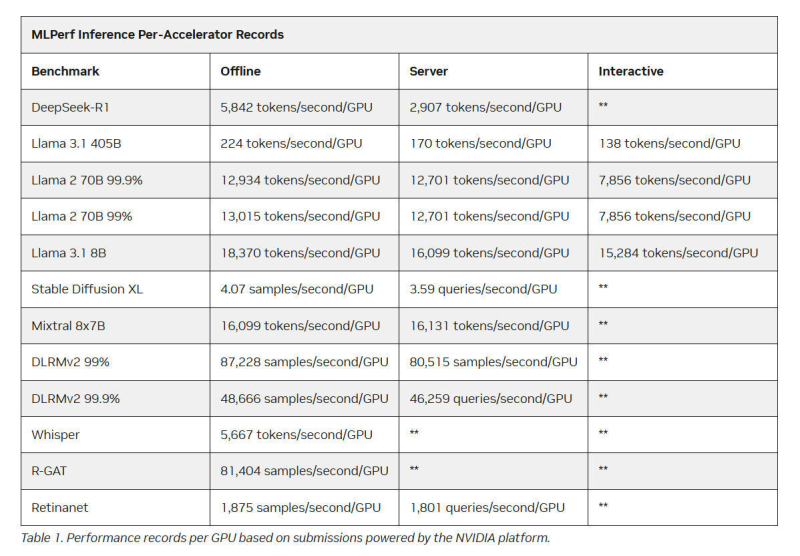

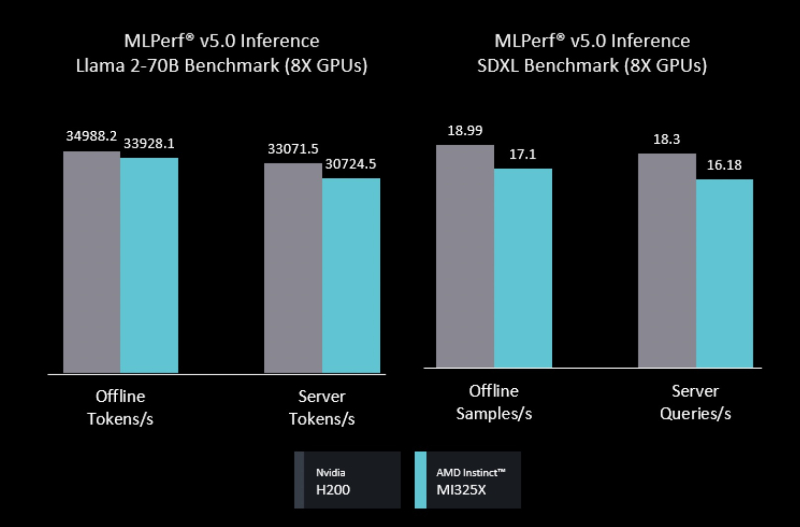

Intel Arc Pro впервые поучаствовали в бенчмарках MLPerf Inference, но в лидерах предсказуемо осталась NVIDIAMLCommons объявил результаты набора бенчмарков MLPerf Inference v5.1. Последний раунд демонстрирует, насколько быстро развивается инференс и соответствующие бенчмарки, пишет ресурс HPCwire. В этом раунде было рекордное количество заявок — 27. Представлены результаты сразу пяти новых ускорителей: AMD Instinct MI355X, Intel Arc Pro B60 48GB Turbo, NVIDIA GB300, NVIDIA RTX 4000 Ada 20GB, NVIDIA RTX Pro 6000 Blackwell Server Edition. Всего же количество результатов MLPerf перевалило за 90 тыс. результатов. В текущем раунде были представлены три новых бенчмарка: тест рассуждений на основе модели DeepSeek-R1, тест преобразования речи в текст на основе Whisper Large v3 и небольшой тест LLM на основе Llama 3.1 8B. Как отметил ресурс IEEE Spectrum, бенчмарк на основе модели Deepseek R1 671B (671 млрд параметров), более чем в 1,5 раза превышает самый крупный бенчмарк предыдущего раунда на основе Llama 3.1 405B. В модели Deepseek R1, ориентированной на рассуждения, большая часть вычислений выполняется во время инференса, что делает этот бенчмарк ещё более сложным. Что касается самого маленького бенчмарка, основанного на Llama 3.1 8B, то, как поясняют в MLCommons, в отрасли растёт спрос на рассуждения с малой задержкой и высокой точностью. SLM отвечают этим требованиям и являются отличным выбором для таких задач, как реферирование текста или периферийные приложения. В свою очередь бенчмарк преобразования голоса в текст, основанный на Whisper Large v3, был разработан в ответ на растущее количество голосовых приложений, будь то смарт-устройства или голосовые ИИ-интерфейсы. NVIDIA вновь возглавила рейтинг MLPerf Inference, на этот раз с архитектурой Blackwell Ultra, представленной платформой NVIDIA GB300 NVL72, которая установила рекорд, увеличив пропускную способность DeepSeek-R1 на 45 % по сравнению с предыдущими системами GB200 NVL72 (Blackwell). NVIDIA также продемонстрировала высокие результаты в бенчмарке Llama 3.1 405B, который имеет более жёсткие ограничения по задержке. NVIDIA применила дезагрегацию, разделив фазы работы с контекстом и собственно генерацию между разными ускорителями. Этот подход, поддерживаемый фреймворком Dynamo, обеспечил увеличение в 1,5 раза пропускной способности на один ускоритель по сравнению с традиционным обслуживанием на системах Blackwell и более чем в 5 раз по сравнению с системами на базе Hopper. NVIDIA назвала «дезагрегированное обслуживание» одним из ключевых факторов успеха, помимо аппаратных улучшений при переходе к Blackwell Ultra. Также свою роль сыграло использованием фирменного 4-бит формата NVFP4. «Мы можем обеспечить точность, сопоставимую с BF16», — сообщила компания, добавив, что при этом потребляется значительно меньше вычислительной мощности. Для работы с контекстом NVIDIA готовит соускоритель Rubin CPX. В более компактных бенчмарках решения NVIDIA также продемонстрировали рекордную пропускную способность. Компания сообщила о более чем 18 тыс. токенов/с на один ускоритель в бенчмарке Llama 3.1 8B в автономном режиме и 5667 токенов/с на один ускоритель в Whisper. Результаты были представлены в офлайн-, серверных и интерактивных сценариях, при этом NVIDIA сохранила лидерство в расчете на GPU во всех категориях. AMD представила результаты AMD Instinct MI355X только в «открытой» категории, где разрешены программные модификации модели. Ускоритель MI355X превзошёл в бенчмарке Llama 2 70B ускоритель MI325X в 2,7 раза по количеству токенов/с. В этом раунде AMD также впервые обнародовала результаты нескольких новых рабочих нагрузок, включая Llama 2 70B Interactive, MoE-модель Mixtral-8x7B и генератор изображений Stable Diffusion XL. В число «закрытых» заявок AMD входили системы на базе ускорителей AMD MI300X и MI325X. Более продвинутый MI325X показал результаты, схожие с показателями систем на базе NVIDIA H200 на Llama 2 70b, в комбинированном тесте MoE и тестах генерации изображений. Кроме того, компанией была представлена первая гибридная заявка, в которой ускорители AMD MI300X и MI325X использовались для одной и той же задачи инференса — бенчмарка на базе Llama 2 70b. Возможность распределения нагрузки между различными типами ускорителей — важный шаг, отметил IEEE Spectrum. В этом раунде впервые был представлен и ускоритель Intel Arc Pro. Для бенчмарков использовалась видеокарта MaxSun Intel Arc Pro B60 Dual 48G Turbo, состоящая из двух GPU с 48 Гбайт памяти, в составе платформы Project Battlematrix, которая может включать до восьми таких ускорителей. Система показала результаты на уровне NVIDIA L40S в небольшом тесте LLM и уступила ему в тесте Llama 2 70b. Следует также отметить, что в этом раунде, как и в предыдущем, участвовала Nebius (ранее Yandex N.V.). Компания отметила, что результаты, полученные на односерверных инсталляциях, подтверждают, что Nebius AI Cloud обеспечивает «высочайшие» показатели производительности для инференса базовых моделей, таких как Llama 2 70B и Llama 3.1 405B. В частности, Nebius AI Cloud установила новый рекорд производительности для NVIDIA GB200 NVL72. По сравнению с лучшими результатами предыдущего раунда, её однохостовая инсталляция показала прирост производительности на 6,7 % и 14,2 % при работе с Llama 3.1 405B в автономном и серверном режимах соответственно. «Эти два показателя также обеспечивают Nebius первое место среди других разработчиков MLPerf Inference v5.1 для этой модели в системах GB200», — сообщила компания.

11.09.2025 [23:19], Владимир Мироненко

Nebius привлекла $3,75 млрд после заключения контракта с MicrosoftПоставщик облачных решений для ИИ Nebius (бывшая материнская структура «Яндекса» Yandex N.V.) привлёк $3,75 млрд благодаря размещению конвертируемых облигаций и продаже акций. Ранее сообщалось, что компания намерена увеличить капитальные затраты в 2025 году. В ходе размещения компания увеличила предложение конвертируемых ценных бумаг с первоначально объявленной суммы $2,0 млрд до $2,75 млрд, распределив её поровну между двумя траншами по $1,375 млрд в рамках закрытого предложения квалифицированным институциональным покупателям в соответствии с Правилом 144A Закона о ценных бумагах 1933 года. Первый транш со ставкой купона 1,0 % должен быть погашен в 2030 году, второй со ставкой купона 2,75 % подлежит погашению в 2032 году. Цена конвертации облигаций составляет $138,75 за единицу, что соответствует 50-% премии к цене их размещения. Также было продано акций класса А по цене $92,5 за единицу на сумму $1,0 млрд. Согласно пресс-релизу Nebius, привлечённые средства будут использованы «для финансирования дальнейшего роста бизнеса, включая приобретение дополнительных вычислительных мощностей и оборудования, приобретение стратегически важных высококачественных и удобно расположенных земельных участков у надежных поставщиков, расширение сети своих центров обработки данных, а также для общих корпоративных целей». Привлечение средств Nebius последовало после заключения крупного контракта с Microsoft на предоставление технологическому гиганту в течение пяти лет доступа к выделенной ИИ-инфраструктуре в новом ЦОД в Винеленде (Vineland) в Нью-Джерси (на изображении выше). Стоимость контракта составляет $17,4 млрд с возможностью увеличения суммы сделки до $19,4 млрд за счёт увеличения предоставляемых мощностей и услуг. О планах Nebius по созданию ЦОД в Нью-Джерси, который теперь будет по крайней мере частично сдан в аренду Microsoft, стало известно в марте. Первоначальная мощность ЦОД составляет 300 МВт с возможностью расширения ещё на 400 МВт. Также у компании есть площадки в Финляндии, где она в прошлом году пообещала увеличить мощность до 75 МВт, и во Франции. Как сообщает Datacenter Dynamics, компания также развёртывает кластеры в ЦОД Patmos в Канзас-Сити (штат Миссури), в ЦОД Verne Global в Исландии, в ЦОД Ark в Великобритании и на новом объекте в Израиле.

11.09.2025 [18:04], Сергей Карасёв

В облаке Astra Cloud появились выделенные серверы с процессорами Baikal-SОблачный провайдер «Астра Облако» (Astra Cloud), входящий в «Группу Астра», и российский производитель микроэлектроники «Байкал Электроникс» объявили о запуске сервиса аренды выделенных серверов, оснащённых отечественными процессорами Baikal-S. Предложение ориентировано в том числе на объекты критической информационной инфраструктуры (КИИ). Чипы Baikal-S (BE-S1000) содержат 48 ядер Arm Cortex-A75, поддерживают память DDR4-3200 МГц (6 каналов, до 128 Гбайт на канал), имеют 80 линий PCIe 4.0 и два интерфейса 1GbE. Заявленное энергопотребление находится на уровне 120 Вт. Серверы расположены в московском дата-центре с надёжностью Tier IV, что гарантирует максимальную отказоустойчивость инфраструктуры. На таких объектах дублируются и основные, и дополнительные системы, а показатель доступности достигает 99,995 %. Время простоя не превышает 26 минут в год. Сервис аренды серверов на базе Baikal-S ориентирован на заказчиков, которым необходимо отладить и адаптировать своё ПО под отечественную архитектуру. Помимо предприятий КИИ, это могут быть государственные организации, корпоративные заказчики и пр. Благодаря арендной модели аппаратные ресурсы полностью закрепляются за клиентом. Это, как утверждается, обеспечивает предсказуемую производительность приложений и высокий уровень защиты данных. Среди других преимуществ нового сервиса названы возможность формирования частных облаков и отказоустойчивых кластеров, гибкость в настройке систем под индивидуальные потребности, отсутствие капитальных затрат на покупку и обслуживание оборудования, технологическая независимость от зарубежных платформ. «Запуск аренды выделенных серверов на процессорах Baikal-S — это важный шаг в развитии отечественной IT-сферы. Мы даём бизнесу и государственным структурам доступ к надёжной, предсказуемой и безопасной платформе для построения частных облаков и работы с критичными нагрузками», — говорит технический директор «Группы Астра».

10.09.2025 [12:25], Сергей Карасёв

QNAP представила сетевые хранилища серии QuNAS на базе Intel Twin LakeКомпания QNAP Systems анонсировала сетевые хранилища семейства QuNAS, ориентированные на применение в сфере малого и среднего бизнеса. В серию вошли модели Qu805, Qu605 и Qu405, рассчитанные соответственно на восемь, шесть и четыре накопителя формата LFF или SFF с интерфейсом SATA-3. В основу новинок, выполненных в «настольном» форм-факторе, положена аппаратная платформа Intel Twin Lake. В зависимости от модификации задействован чип Intel Processor N150 (четыре ядра; до 3,6 ГГц; 6 Вт) или Core i3-N355 (восемь ядер; до 3,9 ГГц; 15 Вт). В состав этих изделий входит ускоритель Intel UHD Graphics. Объём оперативной памяти LPDDR5 составляет 8 или 16 Гбайт (один слот для модуля SO-DIMM). В оснащение NAS также входит флеш-модуль eMMC вместимостью 8 Гбайт. Отсеки для накопителей у устройств располагаются во фронтальной части; допускается горячая замена. Кроме того, предусмотрены два внутренних коннектора M.2 2280 для NVMe SSD с интерфейсом PCIe 3.0 x1. Хранилища наделены двумя сетевыми портами 2.5GbE с гнёздами RJ45, двумя портами USB 3.2 Gen2 Type-A и одним портом USB 3.2 Gen2 Type-C (на лицевой панели), а также интерфейсом HDMI 2.1 с поддержкой видео с разрешением до 4096 × 2160 пикселей (60 Гц). Габариты модели Qu805 составляют 165 × 217 × 285 мм, масса — 3,1 кг (без установленных накопителей). Версии Qu605 и Qu405 имеют размеры соответственно 165 × 217 × 226 и 165 × 217 × 168 мм и весят 2,52 и 2,15 кг. Диапазон рабочих температур — от 0 до +40 °C. Питание обеспечивает внешний адаптер мощностью 96–150 Вт.

09.09.2025 [12:21], Сергей Карасёв

Microsoft потратит почти $20 млрд на аренду ИИ-инфраструктуру у NebiusКорпорация Microsoft, по сообщению Datacenter Dynamics, подписала пятилетнее соглашение на использование вычислительной инфраструктуры компании Nebius (бывшая материнская структура «Яндекса»). Речь идёт об аренде серверов на основе GPU для ресурсоёмких нагрузок ИИ. Nebius, напомним, занимается созданием ИИ-инфраструктуры с использованием ускорителей NVIDIA. У компании, в частности, есть площадки в Финляндии и во Франции. Кроме того, в конце 2024 году Nebius объявила о формировании своего первого вычислительного ИИ-кластера на территории США: система развёрнута на базе дата-центра Patmos в Канзас-Сити (штат Миссури). По условиям заключённого договора, Microsoft с конца текущего года начнёт использовать вычислительные мощности нового дата-центра Nebius в Вайнленде (Vineland) на территории Нью-Джерси (США). Этот объект имеет мощность 300 МВт с перспективой наращивания ещё на 400 МВт.

Источник изображения: Nebius Стоимость контракта между Microsoft и Nebius составляет $17,4 млрд на пять лет. Причём, по условиям соглашения, сумма может быть увеличена до $19,4 млрд — если корпорации Microsoft потребуются дополнительные услуги и (или) мощности. После анонса сделки стоимость акций Nebius подскочила примерно на 60 %. Предполагается, что сотрудничество с Microsoft поможет Nebius значительно расширить бизнес. При этом для выполнения условий контракта Nebius планирует в ближайшее время привлечь заёмные средства. Нужно отметить, что Microsoft также арендует вычислительные мощности у CoreWeave: на эти цели редмондский гигант потратит почти $10 млрд в период с 2023-го по 2030 год. В 2024 году на долю Microsoft пришлось около 62 % выручки CoreWeave, которая достигла $1,9 млрд.

08.09.2025 [12:11], Сергей Карасёв

Бывший гендиректор AWS Адам Селипски назначен на пост консультанта KKR по ИИИнвестиционная компания KKR, по сообщению ресурса Datacenter Dynamics, назначила на должность старшего консультанта по стратегиям в области технологий и ИИ Адама Селипски (Adam Selipsky), который ранее занимал пост генерального директора облачного провайдера Amazon Web Services (AWS). Селипски с 1995-го по 2005 год работал в компании RealNetworks. Затем стал вице-президентом по маркетингу и поддержке AWS: в этой корпорации он проработал 11 лет, после чего в 2016 году возглавил разработчика ПО для визуализации данных Tableau. В 2021 году вернулся в Amazon, начав исполнять обязанности гендиректора AWS. В KKR Селипски займётся вопросами стратегии, распределения капитала и управления бизнесом Real Assets стоимостью $179 млрд. Речь идёт об активах в сферах дата-центров, оптоволоконных и беспроводных сетей, а также энергетики. В настоящее время KKR владеет и управляет большим количеством ЦОД — 155 объектов по всему миру, а также имеет проектные мощности на 15 ГВт. В активе KKR — двенадцать компаний, которые специализируются на оптоволоконных сетях, обслуживающих почти 30 млн домохозяйств. Компания управляет более чем 130 тыс. объектов беспроводной инфраструктуры по всей Европе и в Азиатско-Тихоокеанском регионе.

Источник изображения: AWS Кроме того, KKR является владельцем фирмы CoolIT, специализирующейся на разработке систем прямого жидкостного охлаждения. В начале текущего года KKR инвестировала средства в Gulf Data Hub — одного из крупнейших операторов дата-центров на Ближнем Востоке. KKR также подписала соглашение на $50 млрд о стратегическом партнёрстве с американской инвестиционной компанией Energy Capital Partners (ECP) с целью строительства ЦОД и реализации энергетических проектов. Ранее KKR в партнёрстве с T-Mobile приобрела поставщика услуг широкополосного доступа в интернет Metronet. Плюс к этому KKR является совладельцем оператора ЦОД CyrusOne. Сообщается также, что KKR ведёт переговоры о приобретении ST Telemedia Global Data Centres, в которой ей принадлежит доля в 15 %, и финансировании дата-центров Meta✴.

06.09.2025 [13:42], Сергей Карасёв

Состоялся официальный запуск первого в Европе экзафлопсного суперкомпьютера JUPITERВ Юлихском исследовательском центре (FZJ) в Германии официально введён в эксплуатацию суперкомпьютер JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research) — первый в Европе вычислительный комплекс экзафлопсного класса. Система будет использоваться в том числе для исследований в области климата, нейробиологии и квантового моделирования. Контракт на создание JUPITER подписан между Европейским совместным предприятием по развитию высокопроизводительных вычислений (EuroHPC JU) и консорциумом, в который входят Eviden (Atos) и ParTec. Суперкомпьютер состоит из блока Booster для решения ресурсоёмких задач и универсального блока cCuster. В основу Booster положена платформа BullSequana XH3000 с прямым жидкостным охлаждением. Используются около 6000 вычислительных узлов с гибридными ускорителями NVIDIA Quad GH200 и интерконнектом InfiniBand NDR200 (4×200G на узел, DragonFly+). В общей сложности задействованы почти 24 тыс. суперчипов NVIDIA GH200 (Grace Hopper). В июньском рейтинге TOP500 блок JUPITER Booster располагался на четвёртом месте: на тот момент его FP64-производительность составляла 793,4 Пфлопс. Теперь показатель преодолел рубеж в 1 Эфлопс. При этом ИИ-производительность, как ожидается, будет находиться на уровне 90 Эфлопс. «С запуском первого в Европе эксафлопсного суперкомпьютера мы открываем новую главу в развитии науки, искусственного интеллекта и инноваций. JUPITER укрепляет цифровой суверенитет Европы и ускоряет научные исследования», — отмечает Екатерина Захариева (Ekaterina Zaharieva), еврокомиссар по стартапам, исследованиям и инновациям. JUPITER планируется использовать для прогнозирования погоды и моделирования изменений климата, работы с европейскими большими языковыми моделями (LLM) и генеративным ИИ, разработки лекарственных препаратов и картирования человеческого мозга, моделирования молекулярной динамики и пр. Ожидается, что JUPITER сможет побить мировой рекорд по скорости обработки кубитов в квантовых вычислениях. Между тем продолжается создание блока cCuster. В его состав войдут энергоэффективные высокопроизводительные Arm-процессоры SiPearl Rhea1. Эти чипы содержат 80 ядер Neoverse V1 (Zeus), 64 Гбайт HBM2e и четыре интерфейса DDR5. Модуль cCuster будет оснащён двумя такими процессорами на каждый вычислительный узел, 512 Гбайт DDR5 (в отдельных узлах 1 Тбайт) и одним NDR200-подключением. Общее количество узлов составит около 1300. Ожидаемая FP64-производительность — 5 Пфлопс. Хранилище суперкомпьютера включает быструю СХД ExaFLASH и ёмкую ExaSTORE. ExaFLASH включает 20 All-Flash СХД IBM Storage Scale 6000: 21 Пбайт («сырая» 29 Пбайт), запись до 2 Тбайт/с, чтение до 3 Тбайт/с. В ExaSTORE под хранение будет выделена «сырая» ёмкость 300 Пбайт, а для резервного копирования и архивов будет использоваться ленточная библиотека ёмкостью 700 Пбайт. По оценкам, суммарные расходы на JUPITER и его эксплуатацию в течение шести лет достигнут примерно €500 млн. Половину от этой суммы предоставит EuroHPC, а остальную часть покроют Федеральное министерство образования и научных исследований Германии (BMBF) и Министерство культуры и науки земли Северный Рейн-Вестфалия (MKW NRW). Машина размещена в модульном ЦОД, что упростит дальнейшую модернизацию. Нужно отметить, что на сегодняшний день только три суперкомпьютера в мире официально преодолели планку в 1 Эфлопс. Это машины El Capitan, Frontier и Aurora: все они установлены в лабораториях Министерства энергетики США (DoE). Впрочем, Китай о своих HPC-комплексах публично практически не говорит уже несколько лет, так что реальный список экзафлопсных систем гораздо больше.

04.09.2025 [16:33], Руслан Авдеев

AWS инвестирует $4,4 млрд в новозеландские облачные ЦОДAmazon (AWS) анонсировала открытие в Новой Зеландии облачного региона, а также намерение потратить более NZ$7,5 млрд ($4,4 млрд) на местные дата-центры. Впервые о плане было объявлено ещё в 2021 году, а теперь он получил «второе дыхание», сообщает Bloomberg. Для страны это достаточно значимая инвестиция. AWS создаст облачный регион AWS Asia Pacific, чтобы удовлетворить растущий спрос на облачные сервисы по всей стране. Как сообщают в AWS, строительство, эксплуатация и обслуживание дата-центров позволит ежегодно создавать более 1 тыс. рабочих мест с полной занятостью. Кроме того, увеличится валовый внутренний продукт Новой Зеландии — приблизительно на NZ$10,8 млрд. (более $6.3 млрд). Сроки инвестиций не называются. Новая Зеландия стремится стать новым «магнитом» для иностранных инвестиций в ЦОД, чтобы придать импульс местной экономике, в прошлом году погрузившейся в глубокую рецессию и до сих пор не восстановившейся. Власти специально реформировали градостроительные законы, желая ускорить выдачу разрешений на новые проекты. Кроме того, для привлечения иностранных инвесторов и предпринимателей скорректирован визовый режим. Власти отметили, что по данным Amazon, строительство в Новой Зеландии на 20 % дороже, чем в соседней Австралии, поэтому необходимо менять законы. Новый облачный регион обеспечит уже имеющимся клиентам вроде Xero и Kiwibank возможность локального выполнения любых рабочих нагрузок, локального же хранения данных и предоставления цифровых услуг с малой задержкой. Это, по мнению AWS, позволит быстрее создавать новые облачные продукты. В Новой Зеландии постепенно реализуют всё новые проекты, связанные с дата-центрами и сопутствующей инфраструктурой. Одним из важнейших стал анонсированный весной 2025 года проект Google и Vocus, желающих дотянуть до побережья страны подводный интернет-кабель Honomoana.

04.09.2025 [09:37], Руслан Авдеев

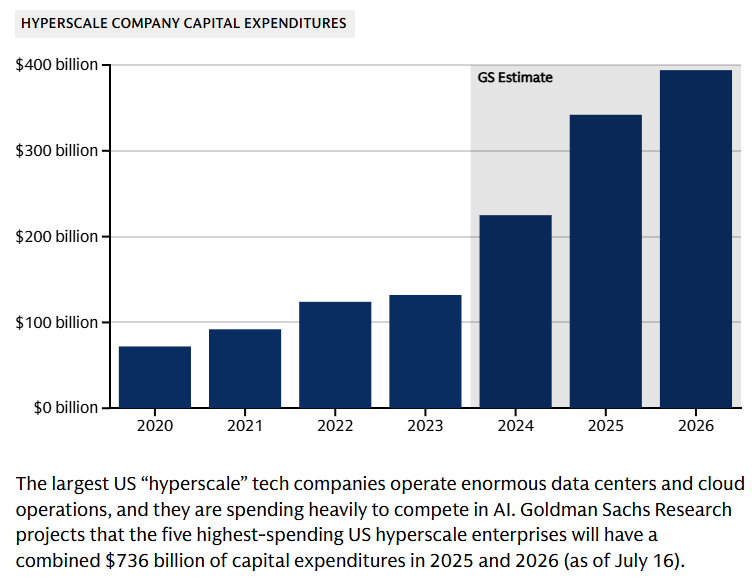

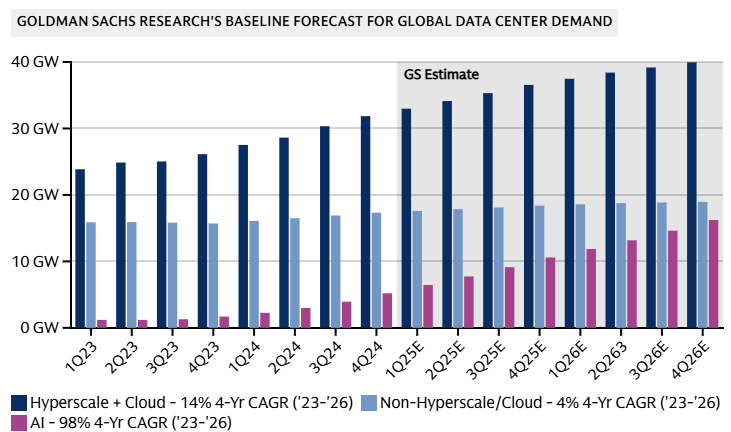

Goldman Sachs допускает крах «пузыря» ИИ на фоне бума в сфере ЦОДИсследование Goldman Sachs свидетельствует, что к 2027 году мощность ЦОД вырастет на 50 % благодаря спросу на ИИ, а энергопотребление сектора удвоится к 2030 году. При этом финансисты отмечают, что повсеместное внедрение ИИ может не оправдать ожиданий инвесторов, сообщает The Register — ИИ-бум породил «лихорадочную атмосферу», в которой крупные технологические компании находятся в постоянном страхе из-за вероятных изменений рынка. По оценкам компании, сегодня глобальная мощность дата-центров составляет порядка 62 ГВт, на облачные нагрузки приходится 58 %, на традиционные нагрузки — 29 % и лишь 13 % — на искусственный интеллект. В начале 2023 года доля ИИ-нагрузок была околонулевой, а к 2027 году она достигнет уже 28 %. Доля облачных нагрузок сократится до 50 %, традиционных — до 21 %. Конечно, сократится лишь доля от общей мощности, а не сами нагрузки из-за активного развития ИИ. По данным Omdia, расходы на ЦОД уже сопоставимы со средними по размеру мировыми экономиками — одна Amazon инвестирует в ЦОД около $118 млрд, что приблизительно равно ВВП Коста-Рики. В Counterpoint Research допускают, что бум ИИ ЦОД может привести к удвоению мировых доходов полупроводниковой промышленности с 2024 по 2030 гг. до более $1 трлн. Большая часть спроса, вероятно, будет приходиться на решения гиперскейл-уровня в краткосрочной и долгосрочной перспективе.

Источник изображения: Lanju Fotografie/unsplash.com Обучение ИИ требует специального оборудования, что приводит к кардинальным изменениям рынка. По данным Goldman Sachs, если два года назад на передовой сервер приходилось по восемь ИИ-ускорителей, то к 2027 году речь будет идти о 576 экземплярах, потребляющих 600 кВт — речь про стойки Kyber с суперускорителями NVIDIA Rubin Ultra NVL576.

Источник изображения: Goldman Sachs Research В результате к 2030 году потребление дата-центрами электричества в мире должно вырасти на 165 %, т.е. с 1–2 % в 2023 году до 3–4 % к концу текущего десятилетия. Ожидается, что за счёт возобновляемых источников будет обеспечено 40 % дополнительной энергии для ЦОД. Поможет и ядерная энергетика, но не так кардинально. Оставшиеся 60 % придётся на генерацию на природном газе, что увеличит выбросы парниковых газов к концу текущего десятилетия на 215–220 млн т — эквивалент 0,6 % от общемировых выбросов, связанных с энергетикой.

Источник изображения: Goldman Sachs Research Хотя прогнозы экспертов относительно рынка ЦОД обычно оптимистичны, финансовые эксперты тщательно следят за любыми негативными изменениями на рынке. Риски включают потенциальные проблемы с монетизацией ИИ. К ним же относится и вариант, при котором инновации значительно удешевят разработку и коммерциализацию моделей. Базовый сценарий предполагает CAGR моoностей ЦОД на уровне 17 % — 92 ГВт к 2027 году. При этом разные сценарии прогнозируют рост в 14 % (если ИИ будет не так интересен бизнесу, как ожидается) до 20 % — если ситуация будет развиваться более оптимистично. Опасения финансовых магнатов отражают «ИИ-скептицизм», присутствующий в более широком масштабе. Глава OpenAI Сэм Альтман (Sam Altman) недавно констатировал, что в отрасли наблюдается «ИИ-пузырь», а эксперты компании McKinsey ещё в начале года предупредили, что никто не может с высокой достоверностью прогнозировать спрос на ИИ в будущем.

03.09.2025 [17:22], Сергей Карасёв

«К2 НейроТех» представил ПАК-AI 2.0 с увеличенной на 30 % производительностью

emerald rapids

gpu

hardware

intel

sapphire rapids

xeon

yadro

ии

к2тех

россия

сделано в россии

сервер

Компания «К2 НейроТех», подразделение компании «К2Тех», анонсировала программно-аппаратный комплекс ПАК-AI 2.0, предназначенный для построения локальной ИИ-инфраструктуры. Утверждается, что по сравнению с оригинальной версией платформы, дебютировавшей в июне нынешнего года, производительность поднялась на 30 %. ПАК объединяют аппаратный слой, платформу управления, преднастроенное ПО и инструменты для работы с ИИ. Решение может быть кастомизировано под конкретные задачи заказчика. Количество серверных стоек масштабируется для обеспечения необходимой производительности. Реализован встроенный маркетплейс приложений, через который в числе прочего доступна платформа Yandex Cloud AI Studio для создания приложений на базе ИИ. Обновленная аппаратная платформа ПАК-AI 2.0 включает шесть серверов YADRO, в том числе серверы для глубокого обучения, инференса и работы с большими данными, а также новый GPU-сервер G4208P G3. Последний специально разработан для обучения нейросетей, обработки больших объемов данных и построения распределённых ИИ-кластеров. Этот сервер несёт на борту два процессора Intel Xeon Sapphire Rapids или Emerald Rapids с TDP до 350 Вт. Поддерживается до 8 Тбайт DDR5. Возможна установка до восьми GPU двойной ширины (PCIe 5.0 x16) с энергопотреблением до 450 Вт каждый. Помимо улучшенной аппаратной части, ПАК-AI 2.0 получил доработанную сборку Kubernetes, которая предоставляет в режиме самообслуживания работу с различными ускорителями (в том числе PCIe, SXM) в формате GPU, vGPU MIG и увеличивает производительность GPU до 30 %. Благодаря этому, как утверждается, повышается эффективность запуска моделей машинного обучения и снижаются эксплуатационные расходы. «К2 НейроТех» заявляет, что ПАК позволяет в короткие сроки развернуть IT-инфраструктуру, которая максимально раскрывает потенциал ИИ, обеспечивает высокий уровень безопасности и соответствие регламентам ИБ, а также прозрачное управление данными. Благодаря наличию LLM-моделей и агентов, предварительно настроенных для выполнения бизнес-задач, ускоряется вывод продуктов на рынок. |

|