Материалы по тегу: hpc

|

09.12.2025 [13:05], Сергей Карасёв

Сандийские национальные лаборатории запустили суперкомпьютер Spectra с ускорителями NextSilicon Maverick-2Сандийские национальные лаборатории (SNL) Министерства энергетики США (DOE) объявили о создании суперкомпьютера Spectra с нестандартной архитектурой. В его основу положены изделия Maverick-2 — интеллектуальные вычислительные ускорители (Intelligent Compute Accelerator, ICA), разработанные компанией NextSilicon. Система Spectra спроектирована по программе Vanguard, цель которой заключается в исследовании потенциала передовых компьютерных архитектур применительно к проектам в сфере национальной безопасности. Первой платформой Vanguard стал комплекс Astra, запущенный в 2018 году: на момент анонса это был самый быстрый в мире суперкомпьютер на базе Arm-чипов. Среди других примечательных машин SNL можно отметить Kingfisher на ИИ-чипах Cerebras WSE-3, а также две нейроморфные системы: на базе SpiNNaker2 и на базе Loihi II (Hala Point). Spectra объединяет 64 вычислительных узла, каждый из которых оснащён двумя двухкристальными ОАМ-модулями Maverick-2: эти изделия содержат 64 управляющих ядра RISC-V, 192 Гбайт памяти HBM3E и два интерфейса 100GbE. В общей сложности задействованы 128 экземпляров Maverick-2. Особенностью ускорителей является возможность динамической реконфигурации оборудования на основе данных, получаемых непосредственно во время выполнения задачи. Такой подход позволяет устранять узкие места, присущие традиционным CPU и GPU. Подробнее об архитектуре Maverick-2 можно узнать в нашем материале. За монтаж суперкомпьютера Spectra отвечала компания Penguin Solutions. Она разработала специализированный сервер, поддерживающий до четырёх ОАМ-модулей Maverick-2, хотя в текущей конфигурации используются два. Применены передовая СЖО с отрицательным давлением Chilldyne и платформа Penguin Tundra, что обеспечивает оптимизацию управления температурой и распределения питания, а также возможности масштабирования.

04.12.2025 [15:49], Сергей Карасёв

Лаборатория МФТИ получила российский JBOG-массив RSC ScaleStream-C для решения сложных ИИ-задачЛаборатория машинного обучения в науках о Земле Московского физико-технического института (МФТИ) взяла на вооружение внешний массив PCIe-коммутации RSC ScaleStream-C, разработанный российской группой компаний РСК. Это решение предназначено для выполнения ресурсоёмких задач, связанных с ИИ. RSC ScaleStream-C представляет собой JBOG-платформу в форм-факторе 3U, допускающую установку до десяти карт с интерфейсом PCIe 4.0 x16 (могут применяться карты разной ширины), которая может быть подключена к четырём серверам. Мощности ускорителей могут динамически перераспределяться между серверами. По заявлениям РСК, такой подход позволяет значительно увеличить утилизацию GPU (в некоторых случаях на десятки процентов) по сравнению со стандартными конфигурациями, когда карты устанавливаются непосредственно в серверы. Лаборатория получила массив RSC ScaleStream-C с четырьмя GPU (модель не уточняется). В перспективе могут быть добавлены дополнительные карты. Предполагается, что система поможет ускорить выполнение задач, связанных с базовыми высокоразрешающими ИИ-моделями атмосферы, океана и климата. Ожидается, что применение RSC ScaleStream-C позволит Лаборатории машинного обучения в науках о Земле существенно расширить возможности уже имеющегося оборудования при работе с ИИ-моделями. Основным направлением деятельности Лаборатории является создание ИИ-методов для моделирования атмосферы, океана и климата, а также для обработки данных в фундаментальных и прикладных задачах морской геологии, морской биологии, экологии моря, метеорологии, в области взаимодействия океана и атмосферы, городской микрометеорологии и пр. Специалисты лаборатории занимаются обработкой данных натурных наблюдений и измерений в метеорологии и океанологии, экологическим мониторингом, моделированием природных процессов и другими задачами, для которых требуются значительные вычислительные ресурсы.

03.12.2025 [20:51], Владимир Мироненко

HPE одной из первых начнёт выпускать интегрированные стоечные ИИ-платформы AMD Helios AI

amd

broadcom

epyc

hardware

hpc

hpe

instinct

juniper networks

mi400

ocp

ualink

venice

германия

ии

суперкомпьютер

AMD объявила о расширении сотрудничества с HPE, в рамках которого HPE станет одним из первых поставщиков стоечных систем AMD Helios AI, которые получат коммутаторы Juniper Networking (компания с недавних пор принадлежит HPE), разработанные совместно с Broadcom, и ПО для бесперебойного высокоскоростного подключения по Ethernet. AMD Helios AI — открытая полнофункциональная ИИ-платформа на базе архитектуры OCP Open Rack Wide (ORW), разработанная для крупномасштабных рабочих нагрузок и обеспечивающая FP4-производительность до 2,9 Эфлопс на стойку благодаря ускорителям AMD Instinct MI455X, процессорам EPYC Venice шестого поколения и DPU Pensando Vulcano, работающими под управлением открытой программной экосистемы ROCm для нагрузок ИИ и HPC. Как отметил The Register, сетевая архитектура этой системы будет представлять собой масштабируемую реализацию UALink over Ethernet (UALoE) и специализированным коммутатором Juniper Networks на базе сетевого чипа Broadcom Tomahawk 6 (102,4 Тбит/с). Система разработана для упрощения развёртывания крупномасштабных ИИ-кластеров, что позволяет сократить время разработки решений и повысить гибкость инфраструктуры. В отличие от NVIDIA, AMD не выпускает коммутаторы, предлагая открытую экосистему, так что HPE и другие компании могут интегрировать собственные сетевые решения. The Register полагает, что HPE и Broadcom решили не гнаться за отдельной аппаратной реализацией UALink, если данные можно передавать поверх Ethernet. «Это первое в отрасли масштабируемое решение, использующее Ethernet, стандартный Ethernet. Это означает, что оно полностью соответствует открытому стандарту и позволяет избежать привязки к проприетарному поставщику, использует проверенную сетевую технологию HPE Juniper для обеспечения масштабируемости и оптимальной производительности для рабочих нагрузок ИИ», — заявила HPE. HPE заявила, что это позволит её стоечной системе поддерживать трафик, необходимый для обучения модели с триллионами параметров, а также обеспечить высокую пропускную способность инференса. Стоечная система HPE будет включать 72 ускорителя AMD Instinct MI455X с 31 Тбайт HBM4 с агрегиированной пропускной способностью 1,4 Пбайт/с. Агрегированная скорость интерконнекта составит 260 Тбайт/с. Новинка будет доступна в 2026 году. AMD также сообщила, что Herder, новый суперкомпьютер для Центра высокопроизводительных вычислений в Штутгарте (HLRS) (Германия), получит Instinct MI430X и EPYC Venice. Он будет построена на платформе HPE Cray Supercomputing GX5000. Поставка Herder запланирована на II половину 2027 года, а ввод в эксплуатацию — к концу 2027 года. Herder заменит используемый центром суперкомпьютер Hunter.

28.11.2025 [09:53], Руслан Авдеев

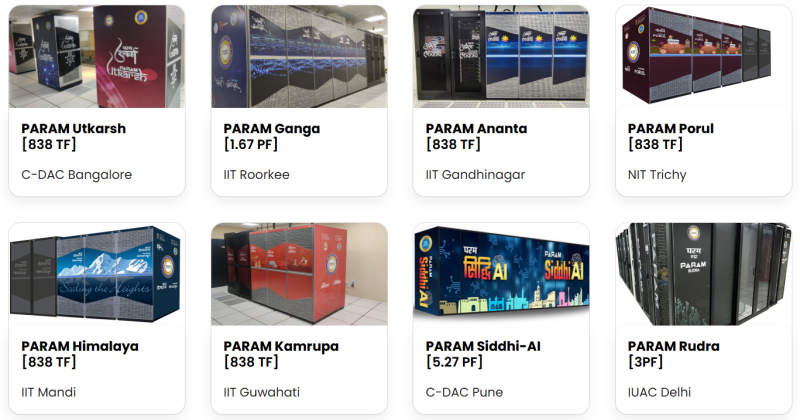

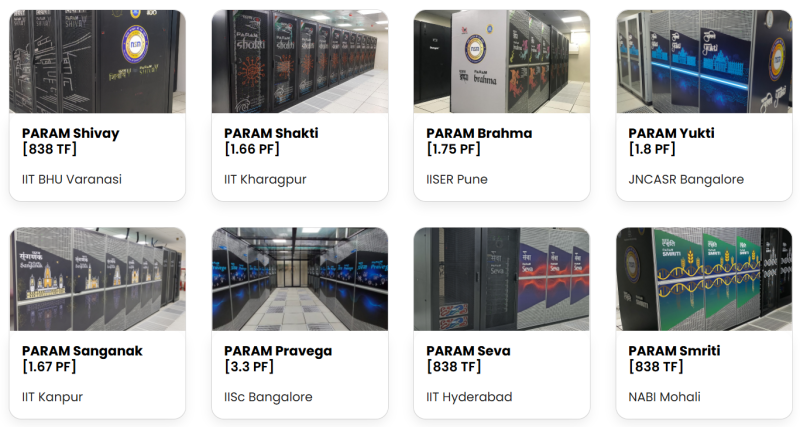

Индия построила 37 суперкомпьютеров за 10 лет, а теперь нацелилась на cоздание импортозамещённых HPC-системЗа 10 лет, прошедших с запуска в Индии Национальной суперкомпьютерной миссии (National Supercomputing Mission, NSM), страна ввела в эксплуатацию 37 суперкомпьютеров совокупной производительностью 39 Пфлопс, ещё один кластер мощностью 35 Пфлопс должен заработать в конце 2025 года. Хотя многие из машин используют технологии местного происхождения, Индии ещё далеко до роли лидера ИИ-отрасли или крупного игрока на рынке полупроводников, сообщает The Register. NSM заработала в 2015 году для обеспечения запросов правительства и исследователей. Цели, в основном, достигнуты — более 13 тыс. учёных имеют доступ к суперкомпьютерным ресурсам MSM, уровень загрузки оборудования составил 85–95 %, выполнено более 10 млн задач, опубликовано более 1,5 тыс. научных статей в рецензируемых журналах. Развитие суперкомпьютеров в Индии курирует Центр развития передовых вычислений (Centre for Development of Advanced Computing, C-DAC), в 2020 году призвавший создавать собственные, индийские компоненты для экзафлопсных суперкомпьютеров. Процесс включает проектирование чипов, плат, интерконнектов и хранилищ, в том числе с использованием технологии кремниевой фотоники. Сейчас цены на «домашнее» оборудование сопоставимы с продукцией мировых OEM-производителей, но прямые закупки и локальное производство позволяет снизить затраты минимум на 15 %. В C-DAC утверждают, что усилия приносят успех, а уровень «индигенизации» (производства и внедрения технологий внутри страны) превысил 50 % — в числе прочего речь идёт о серверных узлах, интерконнектах и системном ПО. Узлы построены на серверной платформе Rudra на базе Intel Xeon с ускорителями AMD или NVIDIA и используют 200G-интерконнект Trinetra, который, впрочем, минимум вдвое уступает по задержкам InfiniBand. Они обеспечивают работу около трети HPC-парка. Вскоре появятся и узлы с CPU AMD. Разработку собственного Arm-процессора AUM, создаваемого при участии MosChip и Socionext, должны завершить в 2027 году, а собственных мощных GPU у Индии нет. Каждая новая система на базе Rudra оснащается СЖО (DLC) разработки C-DAC, что обеспечивает 10 % экономии энергии на уровне узла при полной нагрузке и соответствует PUE 1,20–1,25 на уровне объектов. Это приблизительно на 20 % лучше в сравнении с аналогами на воздушном охлаждении. Базовой ОС на многих кластерах NSM является Red Hat Enterprise Linux (RHEL) или его бесплатные аналоги, но всё пользовательское окружение, включая планировщики задач, менеджеры ресурсов и системы мониторинга, построена на собственных открытых разработках C-DAC. Этот подход позволяет избежать зависимости от коммерческого ПО. Впрочем, некоторые местные эксперты уверены, что уровень локализации в рамках NSM гораздо меньше заявленных 50 %, а программно-аппаратной экосистемы, которая превращает прототипы в надёжные продукты, нет. При этом Индии фактически остаётся зависимой от глобальных игроков, что вызывает опасения относительно надёжности цепочек поставок и возможных санкций. Так, для AUM требуется 5-нм техпроцесс, но фабрик такого класса в стране нет. Впрочем, местные пользователи довольны и нынешними машинами NSM, ведь раньше у них и такого не было. Текущий этап NSM завершается 31 декабря. C-DAC уже объявила цели для NSM 2.0 — ввод 1,5 Эфлопс в течение пяти лет. В первую волну, вероятно, попадут 100-Пфлос суперкомпьютеры на оборудовании Intel и AMD. Ключевая вторая волна нацелена на достижение экзафлопсной производительности с AUM. Но C-DAC не гонится за «сырой» производительностью — важнее решение специфических для Индии задач. Кроме того, есть проект ИИ-суперкомпьютера Lenovo, которая намерена наладить здесь выпуск серверов, на базе местных ускорителей Krutrim. Пока не хватает специалистов для разработки, эксплуатации и оптимизации HPC-систем, а также развития производства. В будущем предлагается создание крупных систем экзафлопсного класса с полной локализацией, продолжением НИОКР в области ПО и «железа». Наконец, планируется и создание HPC-маркетплейса, где предприятия любого размера смогут давать задачи, а учёные — разрабатывать решения. Достижение технологического суверенитета для Индии весьма важно. Так, в октябре сообщалось, что техногиганты США приостановили развитие ЦОД в Индии, хотя ранее обещали вложить в них миллиарды долларов, из-за некоторого охлаждения отношений Нью-Дели и Вашингтона. При этом около года назад глава NVIDIA Дженсен Хуанг заявил, что Индия должна стать одним из лидеров в области ИИ и создать собственную инфраструктуру.

25.11.2025 [14:40], Руслан Авдеев

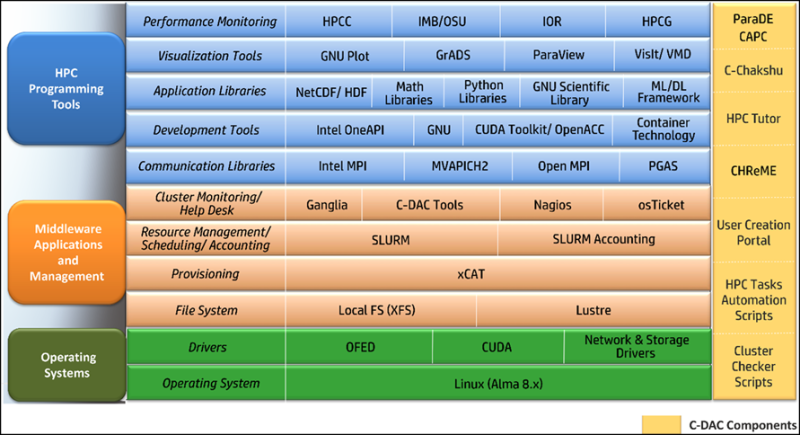

«Миссия Генезис» — США бросят силы на развитие ИИ для научных открытийВ понедельник президент США подписал указ о выполнении «Миссии Генезис» (Genesis Mission). Речь идёт о федеральной программе стимулирования инноваций с использование ИИ-технологий. Это последний из шагов нынешней администрации по продвижению и внедрению ИИ, сообщает Bloomberg. По словам представителя Белого дома, усилия направлены на оптимизацию координации исследований, проводимых правительственными ведомствами. Также предусмотрена более эффективная интеграция ИИ-инструментов для обеспечения всё новых научных прорывов. Сообщается, что для выполнения миссии будут задействовать вычислительные ресурсы национальных лабораторий Министерства энергетики для доступа к федеральным наборам данных и проведения большего количества экспериментов с применением ИИ-технологий. Предполагается, что подобные усилия могут помочь быстрее совершать научные открытия. Как сообщают источники в администрации президента, развитию суперкомпьютерных ресурсов в лабораториях министерства будут способствовать договоры с частными компаниями, включая NVIDIA, Dell, HPE и AMD. Новая инициатива, как ожидается, ускорит научные открытия в сфере материаловедения, здравоохранения и энергетики. Также в Белом доме подчёркивают необходимость инноваций для развития производства и снижения цен — это ещё один из приоритетов администрации. Заявляется, что благодаря ИИ Америка находится «на пороге научной революции».

Источник изображения: CDC/unspalsh.com Тем не менее, внедрение новых технологий может увеличить нагрузку на энергосети США. В Министерстве энергетики, наоборот, подчёркивают, что Genesis поможет противостоять росту цен на электричество, одна из конечных целей программы в энергетическом секторе — получить больше энергии и сделать сеть более эффективной, а также обратить вспять рост цен, вызвавший недовольство американских граждан. Предполагается, что сначала цены стабилизируются, а потом начнут снижаться. Ранее в ноябре об инициативе уже говорили в Белом доме. Подчёркивалось, что в администрации Трампа гонку ИИ-технологий считают столь же важной, как, в своё время, Манхэттенский проект (создание атомной бомбы). Миссию даже назвали крупнейшей мобилизацией федеральных научных ресурсов со времён программы «Аполлон», в рамках которой людей отправляли на Луну. Текущая администрация сделала развитие ИИ одним из главных приоритетов, стремясь одержать победу в гонке с Китаем и другими странами за первенство в этой сфере. Ряд указов предусматривает смягчение налогового бремени, чтобы упростить бизнесу создание ИИ-инфраструктуры и ЦОД, а союзникам — получить ключевое оборудование и программное обеспечение. Кроме того, обещана более жёсткая борьба с правительствами штатов — готовится указ, позволяющий подавать на штаты в суд за регулирование сферы ИИ — он считает его неконституционным. В июле сообщалось, что Министерство энергетики США выделило бизнесу свои земли для ускоренного строительства ЦОД и электростанций в соответствии с программой AI Action Plan, направленной на сохранение мирового лидерства в сфере ИИ.

25.11.2025 [14:05], Владимир Мироненко

AWS потратит $50 млрд на расширение облачных мощностей для правительства США: +1,3 ГВт на ИИ и HPCAmazon объявила о планах инвестировать до $50 млрд в расширение инфраструктуры ИИ и HPC для правительства США. Компания начнёт реализацию проектов в 2026 году и планирует добавить почти 1,3 ГВт вычислительной мощности в регионах AWS Top Secret, AWS Secret и AWS GovCloud (US) на всех уровнях секретности путём строительства новых ЦОД. Федеральные агентства получат расширенный доступ к комплексным ИИ-сервисам AWS, включая SageMaker, Bedrock, Nova и Anthropic Claude. Также в их распоряжение будут предоставлены ведущие модели класса open-weight foundation, ИИ-ускорители Trainium и ИИ-инфраструктура NVIDIA, что позволит им разрабатывать индивидуальные решения в области ИИ, оптимизировать большие наборы данных и повышать производительность труда, сообщила Amazon. Ранее AWS, Google, Oracle, Microsoft, xAI и др. IT-гиганты предоставили госслужбам США существенные скидки на облачные услуги в рамках программы OneGov. Это позволит государственным агентствам ускорить обработку информации и принятие решений. Интеграция ИИ с моделированием и имитацией позволит им решать за считанные часы самые сложные задачи, на которые раньше уходили недели или месяцы, а также «автоматически обнаруживать угрозы и разрабатывать планы реагирования», обрабатывая спутниковые снимки, данные датчиков и исторические закономерности в «беспрецедентном масштабе». «Наши инвестиции в специализированную правительственную инфраструктуру ИИ и облачные технологии коренным образом изменят подход федеральных агентств к использованию суперкомпьютинга, — заявил генеральный директор AWS Мэтт Гарман. — Мы предоставляем агентствам расширенный доступ к передовым возможностям ИИ, которые позволят им ускорить выполнение критически важных задач — от кибербезопасности до разработки лекарств. Эти инвестиции устраняют технологические барьеры, сдерживавшие развитие правительства, и укрепляют лидирующие позиции Америки в эпоху ИИ». Компания отметила, что этот шаг подчёркивает позицию AWS как лидера в области государственных облачных вычислений, поддерживающего более 11 тыс. государственных учреждений. AWS уже давно предоставляет правительству США выделенные облачные регионы. В 2011 году она запустила AWS GovCloud (US-West), AWS Top Secret-East — изолированное облако для секретных рабочих нагрузок — в 2014 году, AWS Secret Region — в 2017 году, с 2018 года добавила второй регион GovCloud (US-East), AWS Top Secret-West, а в октябре 2025 года — AWS Secret-West. Компания не раскрывает точное местоположение ЦОД и регионов. Как пишет Data Center Dynamics, другие страны также доверяют AWS свою самую секретную информацию. В Великобритании в 2021 году сообщили, что три британских разведывательных агентства использовали AWS для хранения совершенно секретных данных. В 2024 году AWS получила контракт стоимостью $1,3 млрд правительства Австралии на строительство ЦОД для совершенно секретной информации — спецслужбы получат возможность работы без использования открытого интернета.

24.11.2025 [15:14], Сергей Карасёв

Технологии тысячеядерного RISC-V-ускорителя Esperanto будут переданы в open sourceСтартап Ainekko, специализирующийся на разработке аппаратных и программных решений в сфере ИИ, по сообщению EE Times, приобрёл интеллектуальную собственность и некоторые активы компании Esperanto Technologies. Речь идёт о дизайне чипов, программных инструментах и фреймворке. Фирма Esperanto, основанная в 2014 году, специализировалась на создании высокопроизводительных ускорителей с архитектурой RISC-V для задач НРС и ИИ. В частности, было представлено изделие ET-SoC-1, объединившее 1088 энергоэффективных ядер ET-Minion и четыре высокопроизводительных ядра ET-Maxion. Основной сферой применения чипа был заявлен инференс для рекомендательных систем, в том числе на периферии. Однако в июле нынешнего года стало известно, что Esperanto сворачивает деятельность и ищет покупателя на свои разработки — ключевых инженеров переманили крупные компании. А продать чипы Meta✴, в чём, по-видимому, и заключался изначальный план, не удалось. Как рассказала соучредитель Ainekko Таня Дадашева (Tanya Dadasheva), её компания работает с чипами Esperanto в течение примерно полугода. Изначально компания планировала использовать чипы Esperanto для запуска своего софтверного стека. В частности, удалось перенести llama.cpp up и tinygrad. Когда стало понятно, что Esperanto вряд ли выживет, было принято решение выкупить разработки стартапа. Во всяком случае, это лучше, чем просто закрыть компанию, оставив её заказчиков ни с чем, как поступила AMD с Untether AI.

Источник изображения: Esperanto Ainekko планирует передать сообществу open source технологии Esperanto, связанные с многоядерной архитектурой RISC-V, включая RTL, референсные проекты и инструменты разработки. Предполагается, что решения Esperanto будут востребованы прежде всего в области периферийных устройств, где большое значение имеет энергоэффективность. Архитектура Esperanto, как утверждается, подходит для таких задач, как робототехника и дроны, системы безопасности, встраиваемое оборудование с ИИ-функциями и пр. Второй соучредитель Ainekko Роман Шапошник (Roman Shaposhnik) добавляет, что многоядерная архитектура Esperanto подходит не только для разработки ИИ-чипов, но и для создания «универсальной вычислительной платформы». Сама Ainekko намерена выпустить чип с восемью ядрами Esperanto и 16 Мбайт памяти MRAM, разработанной стартапом Veevx. Отмечается, что соучредитель и генеральный директор Veevx, ветеран Broadcom Даг Смит (Doug Smith), является ещё одним сооснователем Ainekko. В дальнейшие планы входит разработка процессора с 256 ядрами: по производительности он будет сопоставим с чипом Broadcom BCM2712 (4 × 64-бит Arm Cortex-A76), лежащим в основе Raspberry Pi 5, но оптимизирован для инференса.

20.11.2025 [11:37], Сергей Карасёв

Представлен самый мощный суперкомпьютер на Ближнем Востоке — 122,8-Пфлопс система Shaheen IIIУниверситет науки и технологий имени короля Абдаллы (KAUST) в Саудовской Аравии объявил о запуске вычислительного комплекса Shaheen III. На сегодняшний день, как утверждается, это самый мощный суперкомпьютер на Ближнем Востоке: его FP64-производительность достигает 122,8 Пфлопс. Применять Shaheen III планируется для решения широкого спектра ресурсоёмких задач. Среди них названа разработка нового поколения малых и больших языковых моделей (LLM), ориентированных на арабский регион. Кроме того, суперкомпьютер поможет в создании цифрового двойника всего Аравийского полуострова — интегрированной среды моделирования, объединяющей атмосферные, океанические и земные процессы. Эта виртуальная модель будет способствовать решению комплексных проблем, таких как управление разливами нефти и оптимизация морских перевозок. В числе других задач названы оптимизация сельскохозяйственной деятельности и управления водными ресурсами, поиск передовых материалов, диагностика редких заболеваний, улучшение качества медицинской визуализации, разработка перспективных лекарственных препаратов и пр. Система создана компанией HPE на платформе Cray EX с прямым жидкостным охлаждением (DLC). В общей сложности задействованы 2800 гибридных суперчипов NVIDIA GH200 Grace Hopper с 72-ядерным Arm-процессором NVIDIA Grace и ускорителем NVIDIA H100 с 96 Гбайт памяти HBM3. Общее количество используемых ядер составляет 574 464. Применён интерконнект Slingshot-11. В качестве программной платформы используется HPE Cray OS. В ноябрьском рейтинге самых мощных суперкомпьютеров мира TOP500 система Shaheen III занимает 18-ю позицию. Её теоретическое пиковое быстродействие заявлено на уровне 155,21 Пфлопс. Энергопотребление — 1,98 МВт.

19.11.2025 [11:49], Сергей Карасёв

Второй европейский экзафлопсный суперкомпьютер Alice Recoque получит чипы AMD EPYC Venice и ускорители Instinct MI430XЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) и французско-нидерландский Консорциум Жюля Верна объявили о том, что в создании суперкомпьютера Alice Recoque примут участие компании Eviden (входит в состав Atos Group), AMD и SiPearl. О проекте Alice Recoque впервые стало известно в июне прошлого года. Это будет второй европейский суперкомпьютер экзафлопсного класса после системы JUPITER, смонтированной в Юлихском исследовательском центре (FZJ) в Германии. Соглашение о создании Alice Recoque подписано между EuroHPC JU и французским национальным агентством высокопроизводительных вычислений (GENCI). Комплекс будет смонтирован в дата-центре на территории Брюйер-ле-Шатель (Bruyères-le-Châtel), к юго-западу от Парижа. Как сообщается, в состав Alice Recoque войдут унифицированный вычислительный раздел и скалярный раздел. Основой первого послужит новая платформа Eviden BullSequana XH3500, содержащая серверы с 256-ядерными процессорами AMD EPYC Venice и ускорителями Instinct MI430X, оснащёнными 432 Гбайт памяти HBM4 с пропускной способностью 19,6 Тбайт/с. Кроме того, говорится о применении AMD FPGA и высокопроизводительной подсистемы хранения данных DDN. Суперкомпьютер объединит 94 стойки с суммарным энергопотреблением «менее 15 МВт». В свою очередь, скалярный раздел будет использовать 128-ядерные Arm-процессоры SiPearl Rhea2. Общее количество таких ядер превысит 100 тыс. В качестве интерконнекта в составе Alice Recoque планируется использовать технологию BullSequana eXascale Interconnect (BXI v3), обеспечивающую скорость передачи данных до 400 и 800 Гбит/с для CPU- и GPU-узлов соответственно. Машина получит систему прямого жидкостного охлаждения (DLC) пятого поколения (с тёплой водой) разработки Eviden для унифицированных стоек и технологию охлаждаемых дверей для скалярных стоек. Интеллектуальное программное обеспечение Eviden Argos обеспечит мониторинг в режиме реального времени и оптимизацию энергопотребления. Говорится о широком применении компонентов с открытым исходным кодом, таких как SLURM, Kubernetes, LUSTRE, Grafana и Prometheus. Монтаж суперкомпьютера Alice Recoque начнётся в 2026 году. Затраты на приобретение, доставку, установку и обслуживание системы составят €354,8 млн. EuroHPC JU предоставит половину этой суммы, ещё столько же обеспечат Франция, Нидерланды и Греция в рамках Консорциума Жюля Верна. Общие инвестиции в проект на протяжении пяти лет оцениваются в €554 млн. Использовать новый вычислительный комплекс планируется для решения сложных задач в сферах моделирования климата, разработки передовых материалов, энергетики и пр. Система также поможет в развитии европейских моделей ИИ следующего поколения и цифровых двойников для персонализированной медицины.

18.11.2025 [10:54], Сергей Карасёв

Начался монтаж крупнейшего в США академического суперкомпьютера Horizon с ИИ-быстродействием до 80 ЭфлопсНациональный научный фонд США (NSF) объявил о начале монтажа вычислительно комплекса Horizon — крупнейшего в стране академического суперкомпьютера. Система расположится в Техасском центре передовых вычислений (TACC) при Техасском университете в Остине (UT Austin). Проект реализуется в сотрудничестве с Dell, NVIDIA, VAST Data, Spectra Logic, Versity и Sabey Data Centers. Суперкомпьютер будет развёрнут в новом дата-центре мощностью 15–20 МВт с передовым жидкостным охлаждением в Раунд-Роке (штат Техас). В основу системы лягут серверы Dell PowerEdge. Говорится об использовании процессоров NVIDIA Vera и суперчипов NVIDIA Grace Blackwell. В общей сложности будут задействованы около 1 млн CPU-ядер и примерно 4 тыс. GPU. Архитектура предусматривает использование интерконнекта NVIDIA Quantum-2 InfiniBand. Вместимость локального хранилища данных, выполненного исключительно на основе SSD, составит 400 Пбайт. Оно обеспечит пропускную способность при чтении/записи более 10 Тбайт/с. Заявленная производительность Horizon — 300 Пфлопс: это примерно в 10 раз больше по сравнению с системой Frontera, которая в настоящее время является самым мощным академическим суперкомпьютером в США. При выполнении ИИ-задач новый вычислительный комплекс обеспечит быстродействие до 20 Эфлопс на операциях BF16/FP16 и до 80 Эфлопс в режиме FP4 — более чем 100-кратный прирост по сравнению с нынешними машинами, которые эксплуатируются в американских академических кругах. При этом говорится о повышении энергетической эффективности до шести раз. Запуск Horizon запланирован на весну 2026 года. Суперкомпьютер будет использоваться для решения сложных и ресурсоёмких задач в таких областях, как биомедицина, физика, энергетика, экология и пр. В частности, система будет применяться для моделирования климата. |

|