Материалы по тегу: hardware

|

15.05.2025 [09:36], Руслан Авдеев

СЖО с гарантией: Intel и Shell предложили сертифицированные системы погружного охлаждения для платформ на базе XeonПоскольку внедрение ИИ и HPC увеличивает потребность операторов ЦОД в мощной инфраструктуре, необходимы и более экоустойчивые, эффективные и масштабируемые решения для охлаждения оборудования. Компания Intel совместно с Shell Global Solutions предложили сертифицированное комплексное решение для иммерсионного охлаждения серверов с процессорами Intel Xeon Emerald Rapids или Sapphire Rapids, сообщает пресс-служба Intel. По информации Dell’Oro Group, системы жидкостного охлаждения становятся всё популярнее и к 2028 году на них будет приходиться 36 % выручки от общих продаж систем терморегуляции дата-центров. Однако внедрение высокоэффективного погружного охлаждения до недавнего времени тормозилось из-за отсутствия сертифицированных, прошедших проверки и готовых к развёртыванию продуктов. Intel и Shel провели валидацию полной системы иммерсионного охлаждения для ЦОД на основе оборудования Supermicro и Submer. Решение Intel Data Center Certified for Immersion Cooling называется первым в своём роде и задаёт новый отраслевой стандарт по эффективности и надёжности в долгосрочной перспективе. Масштабное тестирование и строгая валидация в лабораториях Intel позволяет операторам ЦОД внедрять проверенную инфраструктуру, будучи уверенными в её готовности к современным рабочим нагрузкам ИИ и HPC, говорится в пресс-релизе.

Источник изображения: Intel В рамках процесса сертификации Intel предлагает дополнительную гарантию на использование процессоров Xeon с однофазным иммерсионным охлаждением Xeon Processor Single-Phase Immersion Warranty Rider, подтверждающей надёжность и эффективность инфраструктуры, а также её совместимость с охлаждающими жидкостями Shell. Дополнительно исследуется возможность будущего сотрудничества для сертификации новейших поколений процессоров компании с жидкостями Shell.

Источник изображения: Intel Как заявил представитель Intel, по мере роста потребностей ЦОД, сертифицированные Intel решения для погружного охлаждения станут играть ключевую роль в обеспечении работы энергоэффективной и масштабируемой вычислительной инфраструктуры — ЦОД получили доступ к проверенным, готовым к внедрению технологиям охлаждения. Другими словами, операторы ЦОД смогут получить доступ к решениям с повышенной производительностью, минуя этап пилотного проекта — можно сразу переходить к внедрению предварительно проверенных вариантов с высокой энергоэффективностью и малым воздействием на окружающую среду. При этом такие решения обеспечены первыми в отрасли сертификатами и гарантиями Intel.

14.05.2025 [23:27], Руслан Авдеев

США отменили спорные ограничения на экспорт ИИ-ускорителей в другие страны, но запретили им покупать ускорители HuaweiВызвавшие немало споров «Правила распространения ИИ» (AI Diffusion rules), которые должны были ограничить продажу американских ускорителей уже на этой неделе, официально отменены президентом США Дональдом Трампом (Donald Trump), сообщает The Register. Министерство торговли США выполнило данное ранее обещание отменить экспортный контроль для большинства стран на том основании, что он «подавлял бы американские инновации и обременял бы компании новыми нормативными требованиями». В заявлении министерства также подчёркивалось, что новые правила подорвали бы дипломатические отношения Соединённых Штатов с десятками стран. Рамочную программу опубликовали в последние дни правления администрации Байдена — она была направлена на ограничение продаж ИИ-чипов буквально большинству стран мира, за исключением нескольких избранных союзников — в число счастливчиков не вошли даже многие страны НАТО. Предполагалось, что новые ограничения заставят «пострадавшие» страны серьёзно относиться к контролю возможного реэкспорта или контрабанды ИИ-чипов и оборудования в недружественные страны.

Источник изображения: Greg Bulla / Unsplash Хотя некоторые приветствовали ограничения, многие американские технологические компании выступили резко против новых правил, заявив, что страны, не получив ИИ-инфраструктуру от США, смогут получить её от Китая. В администрации Трампа разрабатывают собственный подход. Политики обещают защитить национальные интересы США, но подробностей пока очень мало. Ранее Министерство торговли также выпустило документ, в котором предупредило об опасностях IaaS — многие компании закрывают глаза на то, что китайские разработчики ИИ-моделей работают со своими проектами в их облаках. Хотя покупать передовые чипы структурам из КНР давно запрещено, им никто не мешает арендовать ИИ-инфраструктуру, в том числе в США. Во вторник Бюро промышленности и безопасности (BIS) Министерства торговли США также выпустило разъяснение к Правилам экспортного контроля (EAR), в котором предупредило, что производители чипов могут подпадать под экспортные ограничения при продажах иностранным облачным провайдерам. В этих правилах уже предусмотрен запрет гражданам США, а также поставщикам облачных услуг и операторам ЦОД без разрешения и сознательно предоставлять сервисы или заключать контракты, которые будут способствовать разработке ИИ-решений недружественным странами для целей военной разведки или создания оружия. В частности, в разъяснении указывается, что производителям также потребуется разрешение США на продажу чипов иностранным IaaS-провайдерам, если известно, что ускорители могут использоваться противниками США. Фактически поставщикам напомнили, что если таких провайдеров поймают на помощи в обучении моделей для китайских военных, за этим последует суровое наказание. Более того, США ужесточают контроль не только над новыми чипами для ИИ, но и над теми, что уже есть у иностранных компаний, если они могут быть использованы для разработки «враждебного» ИИ. Наконец, в BIS зашли настолько далеко, что ограничили использование в любой точке мира ускорителей Huawei — наиболее производительной альтернативы чипам NVIDIA в Китае, поскольку, якобы, есть высокая вероятность того, что такие чипы сделаны с использованием американских технологий, но без лицензии.

14.05.2025 [16:40], Владимир Мироненко

Минцифры Хабаровского края завершило переход на систему резервного копирования YADRO TATLIN.BACKUPКомпания YADRO сообщила об успешном завершении перехода инфраструктуры резервного хранения данных Министерства цифрового развития и связи Хабаровского края на решение YADRO TATLIN.BACKUP в рамках реализации ИТ-стратегии, ориентированной на импортонезависимость и технологическую устойчивость. Ведомство обладает развитой ИТ-инфраструктурой, обеспечивающей стабильную работу критически важных региональных информационных систем, в связи с чем вопросы сохранности и доступности данных имеют для него первостепенное значение. В числе ключевых требований к новой системе резервного копирования были указаны наличие полезной ёмкости не менее 160 Тбайт, поддержка высокоэффективной дедупликации переменным блоком и дедупликации на источнике, совместимость с отечественным ПО резервного копирования, а также наличие оборудования в реестре Минпромторга РФ. Система хранения TATLIN.BACKUP отвечает потребностям инфраструктуры ведомства в эффективном хранении данных за счет дедупликации блоком переменной длины, а также возможностью использовать специализированный протокол для передачи только уникальных данных T-BOOST. Совместимость с ПО резервного копирования «Кибер Бэкап» была подтверждена на выполнении реальных рабочих задач. Помимо функции резервного копирования, система может использоваться для долгосрочного хранения информации — для холодных данных и архивов. Начальник управления развития и эксплуатации ИТ-инфраструктуры Минцифры Хабаровского края Евгений Седельников отметил, что YADRO поставила ведомству надёжную и эффективную систему для хранения резервных копий, также обеспечив квалифицированную сервисную поддержку. «Благодаря TATLIN.BACKUP мы смогли сохранить привычный подход к работе с данными и получить функциональность высокого уровня, но уже на базе полностью российской технологической платформы» — сообщил он. «Универсальность TATLIN.BACKUP позволяет применять решение под любые задачи резервного копирования. Важно и то, что система разработана с учетом необходимости защиты критической инфраструктуры — она устойчива к потерям питания, аппаратным сбоям и атакам вирусов-шифровальщиков, а в перспективе и злоумышленникам. Это актуальный, качественный и надёжный подход к защите данных», — подчеркнул Павел Филин, ведущий менеджер по продукту TATLIN.BACKUP.

14.05.2025 [16:31], Руслан Авдеев

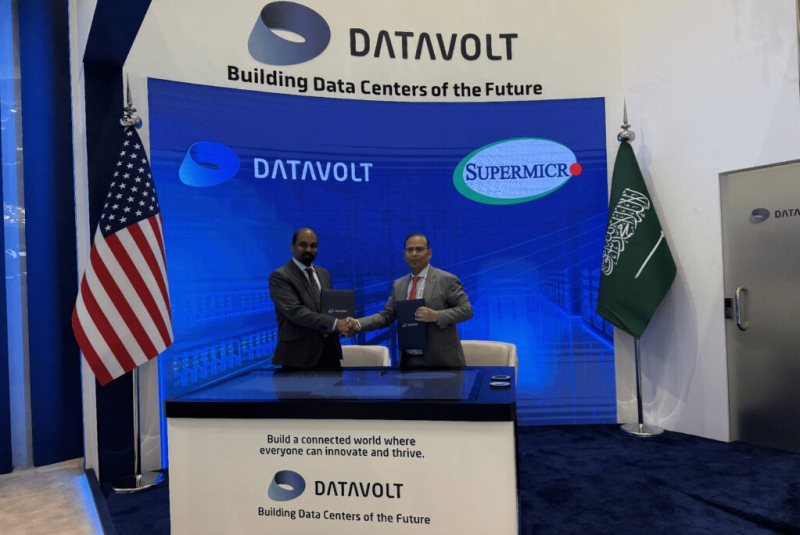

DataVolt и Supermicro анонсировали $20-млрд сделку по ускоренному развёртыванию экологичных ИИ ЦОДВедущий саудовский оператор ЦОД DataVolt объявил о подписании сделки о многолетнем партнёрстве с Supermicro. Новое сотрудничество ускорит поставку ИИ-решений высокой плотности и стоечных систем с СЖО для кампусов DataVolt гиперскейл-уровня в Саудовской Аравии и США, сообщает пресс-служба DataVolt. Отмечается, что участие американских властей и стратегический подход наследного принца и премьер-министра Мухаммеда ибн Салмана ибн Абдул-Азиза Аль Сауда (Mohammed bin Salman Al Saud) позволили создать благоприятную бизнес-среду в стране. В DataVolt заявили, что очень рады сотрудничеству с Supermicro. DataVolt намерена объединить водородную энергетику гигаваттного уровня с нулевыми выбросами и самые передовые в индустрии серверные технологии, что обеспечит экоустойчивость и возможность беспрецедентного масштабирования нагрузок. В Supermicro тоже рады сотрудничеству с DataVolt и продолжению расширения производства на территории США. В компании уверены, что работая вместе, партнёры смогут создать передовую вычислительную ИИ-инфраструктуру, что будет способствовать реализации саудовских планов по превращению в международный инновационный и технологический хаб. Сделка, оценённая в $20 млрд, укрепляет стратегические связи между компаниями и знаменует важную веху в их совместной работе, демонстрируя серьёзные намерения в развитии решений для ИИ и дата-центров.

Источник изображения: DataVolt DataVolt не только выступает оператором ЦОД, но и активно интегрирует всевозможные инфраструктурные решения, связанные с возобновляемой энергетикой. Штаб-квартира компании находится в Саудовской Аравии, но филиалы также имеются в США, Узбекистане, Индии и ОАЭ. Также компания ведёт дела в Южной Корее и Южной Африке, мечтая распространить влияние на весь Ближний Восток, Африку и Азию. В первую очередь компания занимается обеспечением потребностей гиперскейлеров, крупных бизнесов и правительственных организаций. Новое сотрудничество, возможно, станет едва ли не спасительным импульсом для Supermicro. В конце апреля компания объявила предварительные неаудированные финансовые результаты за III квартал 2025 финансового года (закончился 31 марта). Они оказались значительно ниже оценок аналитиков, в связи с чем её акции упали на 19 %.

14.05.2025 [15:05], Руслан Авдеев

OpenAI рассматривает строительство ЦОД в ОАЭКомпания OpenAI рассматривает целесообразность строительства в Объединенных Арабских Эмиратах нового дата-центра. Это может значительно расширить её присутствие на Ближнем Востоке, сообщает Bloomberg со ссылкой на осведомлённые источники. Решение ещё не принято, ситуация может измениться по результатам визита в страну президента США Дональда Трампа (Donald Trump). Глава OpenAI Сэм Альтман (Sam Altman) тоже находится с в регионе в рамках делового тура технологических лидеров. В самой OpenAI слухи пока не комментируют, но недавно компания заявляла, что ищет сотрудничества с национальными правительствами для строительства ИИ-инфраструктуры за пределами США и продвижения американского лидерства в данной сфере. Возможная сделка, вероятно, связана с инвестиционной активностью на время поездки Трампа по региону. В том числе планируется предоставить расширенный доступ к передовым полупроводникам бизнесу из Саудовской Аравии — ранее США ограничили его для большей части мира. OpenAI уже сотрудничает с ОАЭ. Совместные проекты компания начала реализовать с G42 из Абу-Даби в 2023 году. В 2024 году последняя получила $1,5 млрд инвестиций от спонсора OpenAI — Microsoft. Инвестиционная компания MGX, контролируемая королевской семьёй ОАЭ, в своё время приняла участие в финансировании OpenAI на $6,6 млрд, раунд закрылся в октябре прошлого года. Также MGX намерена внести вклад в совместный проект Stargate в США, в котором помимо OpenAI участвуют SoftBank и Oracle.

Источник изображения: David Rodrigo/unsplash.com Пока нет данных, ЦОД какой мощности OpenAI намерена построить в ОАЭ. Во многом проект зависит от того, сможет ли компания импортировать передовые ускорители NVIDIA, поскольку США ограничили их продажу в страну с 2023 года. Впрочем, администрация Трампа относится к партнёрам с Ближнего Востока гораздо мягче администрации Байдена, поэтому не исключено соглашение о существенном упрощении доступа к полупроводникам странам Персидского залива. Сделка с США может привести к импорту в ОАЭ более 1 млн ускорителей NVIDIA, большая часть их них будет выделена американским компаниям, строящим ЦОД в государствах региона. На фоне обещаний стран Персидского залива инвестировать немалые средства в американскую экономику, администрация Трампа более охотно разрешает поставки полупроводников на Ближний Восток. Ранее администрация Трампа уже объявила, что рамочная программа эпохи Байдена, призванная регулировать некоторые из вопросов регулирования, будет пересмотрена. Пока чиновники Трампа разрабатывают новые глобальные правила в отношении оборота чипов.

14.05.2025 [14:55], Сергей Карасёв

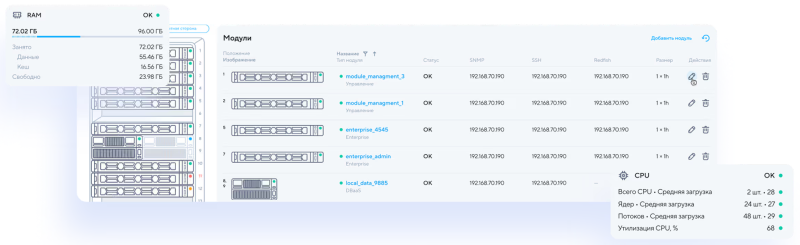

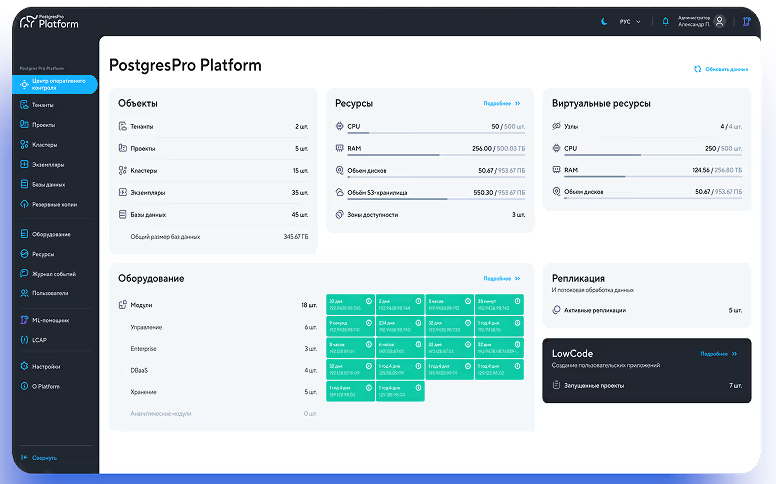

Представлена машина баз данных Postgres Pro Machine для высоконагруженных системКомпания Postgres Professional анонсировала машину баз данных Postgres Pro Machine с модульной архитектурой, предназначенную для высоконагруженных систем. Проект по созданию платформы реализуется в партнёрстве с российским разработчиком и производителем IT-оборудования Delta Computers. В производство машины Postgres Professional инвестирует более 1,5 млрд руб. Утверждается, что Postgres Pro Machine — первая в России платформа, которая может объединять четыре типа разных СУБД. В их число входят высоконагруженные базы данных, обработка аналитических запросов, оркестрация большого количества СУБД среднего размера и горизонтальное масштабирование (шардирование). При этом управлять всеми типами баз данных можно будет через единый графический интерфейс. Конструкция Postgres Pro Machine предусматривает наличие ряда модулей: OLTP, DBaaS, HTAP, OLAP, а также блоков управления, хранения, коммутации и питания. Модуль OLTP, который станет доступен в III квартале текущего года, отвечает за такие функции, как работа с большими высоконагруженными базами, высокоскоростной интерконнект, синхронная реплика с минимальной задержкой.

Источник изображения: Postgres Professional В свою очередь, модуль DBaaS (выйдет в I четверти 2026 года) обеспечит работу с большим количеством баз данных, бесшовное управление средой виртуализации, автоматизацию процессов управления, конфигурирования и масштабирования. Модуль HTAP (появится во II квартале 2026-го) будет включать горизонтальное масштабирование с использованием шардирования, работу с базами данных размером 2 Пбайт и более, строгие гарантии изоляции и согласованности данных на базе технологии Postgres Pro. Задачами модуля OLAP (станет доступен в III четверти 2026 года) названы: высокопроизводительная аналитика для данных (2 Пбайт и более), реализация ETL-задач, партицирование больших исторических данных, ведение полной истории изменений, строгие гарантии изоляции и согласованности данных на базе технологии Postgres Pro. Модуль управления в числе прочего обеспечит мониторинг всех компонентов и отказоустойчивое исполнение. Задачи блока хранения — резервное копирование баз данных, хранение шаблонов виртуальных машин, интеграция со всеми продуктами экосистемы Postgres Pro. Модуль коммутации и питания предоставит выделенную сеть для управления оборудованием, централизованное питание по ОСР-стандарту, коммутацию с интерфейсами 100 Гбит/с и 400 Гбит/с. Стойка с оборудованием имеет стандартную ширину 600 мм и использует трёхфазное питание. Отмечается, что благодаря глубокой синергии аппаратного уровня и программного обеспечения Postgres Pro Machine обеспечит рост быстродействия на 30 % и более по сравнению с существующими решениями. Компоненты системы работают на базе Postgres Pro Enterprise и поддерживают всю функциональность, доступную в соответствующем релизе. Среди возможностей — встроенная отказоустойчивость, пулер и балансировка соединений, резервное копирование и восстановление.  Модули DBaaS, HTAP и OLAP поддерживают горизонтальное масштабирование — при необходимости можно добавлять новые вычислительные узлы. Модуль OLTP горизонтально не масштабируется, но можно задействовать несколько таких блоков параллельно. Postgres Pro Machine использует единую модель авторизации и разграничения доступа на всех уровнях — от управления оборудованием до доступа к виртуальным машинам. Интеграция со службой корпоративного каталога выполняется на этапе пусконаладочных работ. «Сейчас большинство российских компаний вынуждены поддерживать несколько различных технологических стеков для работы с базами данных — СУБД на виртуальных машинах; базы данных, работающие без дополнительного слоя виртуализации; аналитические СУБД; СУБД размером более 150 Тбайт. Postgres Pro Machine закроет все эти возможности в рамках одной системы, что обеспечит существенную экономию времени, денег и человеческих ресурсов заказчика», — отмечает заместитель генерального директора Postgres Professional.

14.05.2025 [10:18], Руслан Авдеев

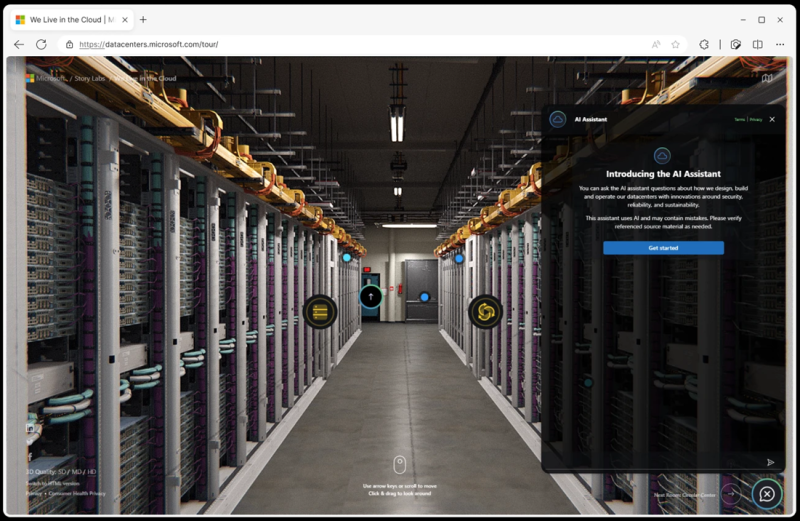

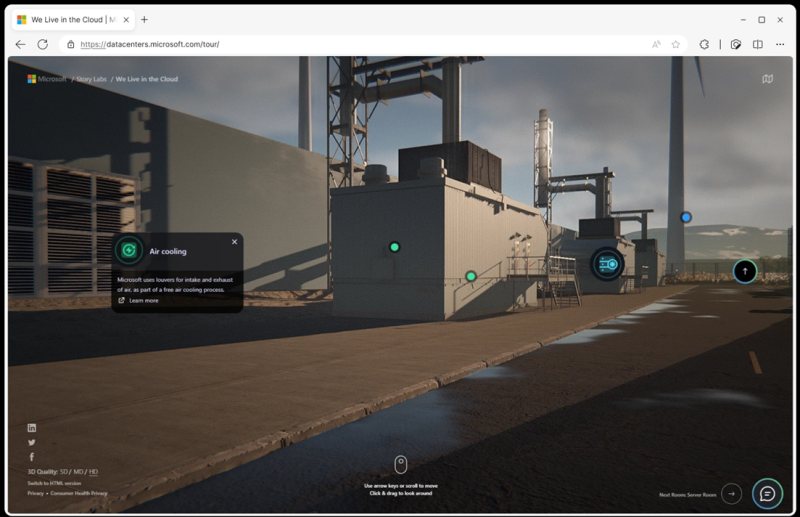

Окно в облака: Microsoft подготовила виртуальный тур по дата-центру компанииMicrosoft создала специальный сайт, на котором любой желающий может принять участие в виртуальном туре по ЦОД, сообщает пресс-служба компании. Посетители смогут узнать особенности устройства дата-центров: от собственно зданий до серверов, сетей, ИИ-инфраструктуры и т.п. Virtual Datacenter Tour знакомит с дизайном, стоящим за более чем 300 ЦОД компании по всему миру. Инфраструктура ЦОД касается едва ли не каждой сферы современной жизни, от онлайн-банкинга до удалённой работы, видеозвонков, социальных сетей и многого другого. ЦОД стоят за облаками, позволяя клиентам обходиться, полностью или частично, без собственных программно-аппаратных комплексов. Облака объединяют миллионы серверов и виртуальных машин, хранят данные и приложения, а также обеспечивают пользователей контентом и сервисами.

Источник изображения: Microsoft ЦОД Microsoft вмещают тысячи серверов, включая резервные системы, и присутствие компании на рынке расширяется. Поскольку реальные экскурсии по ЦОД для большинства граждан запрещены по соображениям безопасности (за некоторыми забавными исключениями), в Microsoft организовали виртуальную 3D-копию дата-центра. При этом пользователи смогут воспользоваться ИИ-ботов, чтобы получить дополнительную информацию.

Источник изображения: Microsoft Экскурсия доступна как владельцам компьютеров, так и мобильных устройств. Сайт регулярно пополняется новыми «помещениями» и контентом. Виртуальный ассистент, предоставляемый сервисом Azure Open AI, специально создан для ответов на многие вопросы по теме: об экоустойчивости Microsoft Cloud, технологиях охлаждения, системах безопасности, обеспечения надёжности работы и т. п. Можно посетить виртуальную серверную и ознакомиться с новейшим оборудованием и комплектующими, вроде разработанных дома CPU Azure Cobalt или кастомных ИИ-ускорителей Azure Maia. Впрочем, в Azure доступны и решения других компаний-партнёров. Любознательные посетители смогут ознакомиться с электрооборудованием, включая аккумуляторы и резервные генераторы, и т.п.

14.05.2025 [08:52], Руслан Авдеев

Moody’s предупреждает о рисках перенасыщения рынка ИИ ЦОДХотя в 2025 году планируется реализация рекордного количества масштабных проектов строительства ЦОД, эксперты предостерегают, что быстрые темпы строительства могут привести к неблагоприятным последствиям. В новом отчёте Moody’s Ratings говорится, что стремительный рост ИИ ЦОД сопровождается кредитными и инфраструктурными рисками, сообщает Datacener Knowledge. В исследовании подчёркивается, что ИИ формирует новую архитектуру ЦОД, но не исключены угрозы технического устаревания, геополитические проблемы и перенасыщение рынка. Основные выводы отчёта Moody’s:

При этом ЦОД перестали рассматриваться как просто недвижимость, теперь их считают объектами критически важной инфраструктуры (КИИ) и активно привлекают инвестиции для их строительства. Причём то, что раньше считалось гиперскейл-объектом, по нынешним меркам уже считается устаревшим. Если раньше объект на 100 МВт считали крупным, то теперь речь идёт о гигаваттных кампусах. Также, по данным агентства, средняя плотность стойки выросла с 6 кВт в 2016 году до 12 кВт в 2024-м. В ЦОД гиперскейлеров речь идёт уже о 40–60 кВт, а в ИИ ЦОД может превышать 200 кВт.

Источник изображения: Shivendu Shukla/unsplash.com В Moody’s отмечают целый ряд знаковых проектов, включая 5,6 ГВт-комплекс Wonder Valley в канадской провинции Альберта, кампус Meta✴ на 1,5 ГВт в Луизиане и проект Stargate, курируемый OpenAI. Такие дата-центры размещают в отдалённых районах с достаточно дешёвой электроэнергией и именно ИИ, а не облака, стал катализатором новой волны строительства. По мнению некоторых экспертов, дефицит электроэнергии может стать ограничителем роста отрасли уже к 2028 году. Вопрос даже не в доступном объёме, а во времени, которое нужно для получения доступа к новым мощностям. В ответ на эти вызовы операторы начинают сотрудничать с энергетиками напрямую, а то и строят собственные электростанции при кампусах. Ещё один тренд — использование не столь востребованного ранее природного газа, поскольку теперь часто дешевле возвести электростанцию, чем закупать дорогое IT-оборудование, не имея гарантированного энергоснабжения. Ключевым отличие от эпохи «доткомов» в том, что сегодня мощности арендуют ещё до завершения строительства ЦОД и никто не готов вкладывать миллиарды без готовых арендаторов. По оценкам Moody’s, более 90 % объектов гиперскейл-уровня и ИИ-кампусов имеют предварительные контракты на аренду ещё на стадии строительства. Кроме того, схемы поэтапного строительства позволяют гибко адаптироваться к меняющемуся спросу и контролировать финансы. Другими словами, революция в сфере ИИ кардинально меняет правила игры в сфере ЦОД, но без грамотного управления рисками рынок может столкнуться с «перенасыщением» инфраструктурой, энергетическими кризисами и финансовыми потерями. Инвесторов и строителей призывают учитывать инфраструктурные ограничения, геополитические риски и неопределённость спроса. В любом случае считается, что будущее — за гибкими, экоустойчивыми и энергосберегающими решениями.

14.05.2025 [00:23], Владимир Мироненко

Саудовская Аравия всерьёз намерена стать лидером в ИИ: госстартап Humain договорился о многомиллиардном партнёрстве с NVIDIA, AMD и AWSНаследный принц Саудовской Аравии Мухаммед ибн Салман аль-Сауд (Mohammed bin Salman Al Saud) основал новую компанию Humain по разработке ИИ-технологий, пишет Reuters. Развитие этого направления является одним из приоритетов при трансформации экономики страны в соответствии с целями программы «Видение – 2030» (Vision 2030), призванной снизить её зависимость от добычи ископаемого топлива. На сегодняшней встрече Мухаммеда ибн Салмана с президентом США Дональдом Трампом (Donald Trump), находящимся с четырёхдневным визитом в регионе, которая прошла при участии миллиардера Илона Маска (Elon Musk), а также на совместном саудовско-американском инвестиционном форуме в Эр-Рияде, ИИ был одной из центральных тем повестки дня. Humain возглавляет сам наследный принц в качестве председателя. Гендиректором назначен Тарек Амин (Tareq Amin). Компания принадлежит Суверенному фонду Саудовской Аравии, взявшему на себя обязательство вложить значительные средства в развитие ИИ-технологий в стране. Как пишет Bloomberg со ссылкой на агентство Saudi Press Agency, новая компания займётся запуском ЦОД, развертыванием ИИ-инфраструктуры и облачных сервисов, а также разработкой больших языковых моделей (LLM) с поддержкой арабского языка. Компания намерена создать полностью готовую интегрированную ИИ-платформу для решения практических задач. В заявлении компании также указано, что она станет ИИ-центром для таких секторов, как энергетика, здравоохранение, производство и финансовые услуги страны. Поможет ей в этом целый ряд американских технологических компаний. В частности, было объявлено о сотрудничестве с NVIDIA, в рамках которого компании «будут использовать платформы и опыт NVIDIA, чтобы сделать Саудовскую Аравию мировым лидером в области ИИ, облачных GPU-вычислений и цифровой трансформации для стимулирования инноваций и роста во всем мире». В течение следующих пяти лет Humain произведёт крупные инвестиции в строительство ИИ-фабрик в Саудовской Аравии мощностью до 500 МВт, использующих сотни тысяч передовых ускорителей NVIDIA. На первом этапе будет установлено 18 тыс. суперускорителей NVIDIA GB300 с интерконнектом NVIDIA InfiniBand. Эти ИИ ЦОД предоставят надёжную базовую инфраструктуру для обучения и развёртывания суверенных ИИ-моделей, что позволит Саудовской Аравии и другим странам ускорить инновации и цифровую трансформацию, отмечено в пресс-релизе. Сообщается, что Humain также развернёт платформу NVIDIA Omniverse, что позволит таким отраслям, как производство, логистика и энергетика, создавать полностью интегрированные цифровые двойники, повышая эффективность, безопасность и устойчивость производств, а также ускоряя движение страны к «Индустрии 4.0». Также было объявлено о партнёрстве Humain с AMD, в рамках которого будет инвестировано в течение пяти лет до $10 млрд в развертывание в стране ИИ-инфраструктуры мощностью 500 МВт. «Вместе мы создаём глобально значимую ИИ-платформу, которая обеспечивает производительность, открытость и охват на беспрецедентном уровне», — заявила генеральный директор AMD Лиза Су (Lisa Su). Предполагается, что часть мощностей будет введена в эксплуатацию в 2026 году. Humain будет предоставлять услуги клиентам, а AMD — поставлять чипы и ПО. Также Humain подписала соглашение о сотрудничестве с AWS с целью реализации проекта по созданию «Зоны ИИ» (AI Zone) в Саудовской Аравии стоимостью $5 млрд, пишет TechCrunch. Зона будет включать специализированную ИИ-инфраструктуру AWS, серверы, сети. Упомянуты и программы обучения и сертификации. Humain сообщила о планах разрабатывать решения в области ИИ с использованием технологий AWS и работать с AWS над предоставлением доступа к инструментам и ПО для ИИ-стартапов из Саудовской Аравии. Саудовская Аравия обязала компании и ИИ-сервисы хранить данные на территории королевства, стимулируя провайдеров размещать свои объекты в стране, чтобы не потерять имеющиеся контракты. В частности, Google и Oracle объявили о планах по расширению присутствия в регионе. Ранее страна ообъявила о $14,9 млрд инвестиций в ИИ-сектор.

13.05.2025 [22:15], Алексей Степин

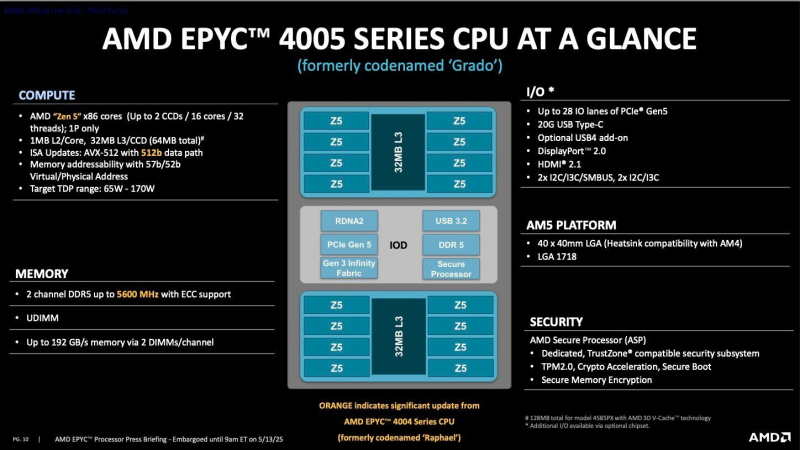

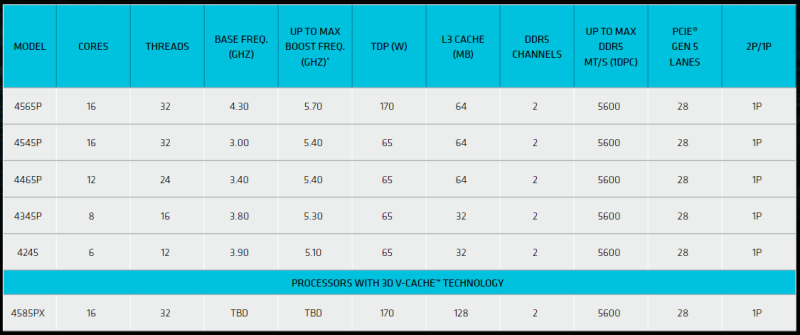

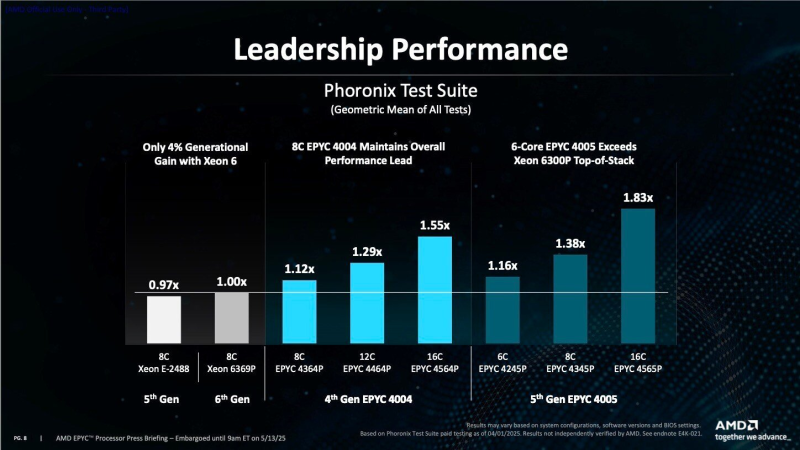

AMD представила процессоры EPYC 4005 Grado для сокета AM5Спустя год после анонса серверных процессоров начального уровня EPYC 4004 компания AMD обновила данный модельный ряд улучшенными чипами EPYC 4005 Grado. Как и прежде, процессоры ориентированы на применение в серверах для периферийных вычислений, хостинга, а также в решениях для малого и среднего бизнеса. В основе Grado лежат ядра Zen 5, что позволило повысить удельную производительность, получить поддержку более скоростной памяти DDR5 и расширенные возможностями ввода-вывода. Процессоры EPYC 4005 могут иметь до 16 ядер с поддержкой SMT и полноценной реализации AVX-512. Объём кеша L2 составляет 1 Мбайт на ядро, L3 — 32 Мбайт на восьмиядерный кристалл CCD; некоторые модели оснащаются дополнительным объёмом 3D V-Cache. Контроллер памяти в блоке IOD двухканальный, поддерживаются модули DDR5-5600 ECC суммарным объёмом до 192 Гбайт. Стоит, однако, отметить, что с памятью без коррекции ошибок EPYC 4005 не совместимы. Как и предки новинки в лице настольных Ryzen, EPYC 4005 предоставляют 28 линий PCI Express 5.0, а также интерфейсы USB 3.2 и USB 4 (опционально). Интегрированное видеоядро предлагает поддержку Display Port 2.0 и HDMI 2.1. В плане подсистемы накопителей процессоры могут обеспечивать работу до 14 устройств в различных конфигурациях, включая SATA и NVMe. Поддерживаются массивы RAID 0/1/5/10 с возможностью миграции. Наличие встроенного сопроцессора безопасности AMD Secure Processor вкупе с поддержкой TPM 2.0, шифрованием памяти и поддержкой доверенных зон (TrustZone) гарантирует высокий уровень безопасности. Процессоры полностью совместимы с инфраструктурой AM5 (LGA 1718), что облегчит жизнь системным интеграторам. Даже AMD EPYC 4004 имели лучшее соотношение возможностей к цене, нежели могли предложить аналогичные по классу Intel Xeon E-2400. Сохраняется это положение дел и для EPYC 4005: у Intel Xeon 6300 максимум восемь ядер, в то время как решение AMD может предложить 16 полновесных ядер Zen 5. Впрочем, у Intel есть ещё серия Granite Rapids-D, самые младшие модели которой гипотетически могут составить конкуренцию EPYC 4005. Всего в новую серию на момент анонса вошло шесть моделей. Венчает список 16-ядерный EPYC 4565P с теплопакетом 170 Вт (4,3–5,7 ГГц) стоимостью $589. Несколько особняком стоит модель EPYC 4585PX с расширенным до 128 Мбайт кешем L3, в остальном повторяющая характеристики модели 4565P. За кеш придётся доплатить — обойдётся такой EPYC в $699. Остальные представители модельного ряда EPYC 4005 имеют теплопакет 65 Вт, а их турбо-частоты ограничены 5,4–5,5 ГГц при базовых частотах менее 4 ГГц и количестве ядер от 6 до 16. Ресурс Phoronix уже провёл предварительное тестирование новинок, получив обнадёживающие результаты: EPYC 4565 в 1,83 раза превзошёл Intel Xeon 6369P, и даже шестиядерный EPYC 4245P опередил того же соперника на 16 %. Восьмиядерный EPYC 4345P оставил позади бывшего флагмана из серии Xeon E с 38-% отрывом. Все модели AMD EPYC 4005 поддерживают работу в среде Windows Server, RHEL, SLES и Ubuntu. Доступны новые процессоры AMD EPYC уже сейчас. Ряд ведущих производителей серверного оборудования, в том числе Altos, ASRock Rack, GIGABYTE, Mitac, MSI и Supermicro представили свои варианты решений на базе EPYC 4005. |

|