Материалы по тегу: azure

|

18.11.2025 [17:07], Руслан Авдеев

Евросоюз рассматривает необходимость ограничения возможностей американских облачных гигантовЕвросоюз рассматривает возможность ужесточения контроля за деятельностью облачных гигантов AWS, Microsoft Azure и Google Cloud, передаёт Bloomberg. Анитимонополные регуляторы намерены принять решение, следует ли ввести дополнительные ограничения для кого-либо из этих гиперскейлеров в соответствии с действующим в ЕС законом Digital Markets Act (DMA), сообщает издание со ссылкой на источники, «знакомые с ситуацией». План расследования разработан после ряда крупных сбоев в облачном секторе — они привели к хаосу в работе глобальных служб и стали дополнительным свидетельством того, что не стоит опираться лишь на нескольких крупных игроков. Речь о крупных сбоях AWS и Microsoft Azure. Пока облачные гиперскейлеры не подпадали под действие DMA, поскольку большая часть их деятельности связана с корпоративными контрактами, что затрудняет подсчёт индивидуальных пользователей их сервисов. Именно их количество может послужить для ЕС одним из главных оснований для введения дополнительного надзора за облачными сервисами из США.

Источник изображения: Jon Del Rivero/unspalsh.com В рамках расследования регуляторы оценят, стоит ли заставлять ведущих операторов брать на себя новые обязательства, включая повышение уровня совместимости с конкурирующим ПО (что особенно актуально для Microsoft) и упрощение переноса данных пользователей от одного облачного провайдера к другому. Кроме того, не исключены запреты на обязательную продажу пакетов услуг или ПО без возможности купить их по отдельности, а также ограничения на стимулирование подобных «пакетных» продаж. Еврокомиссия и представители гиперскейлеров ситуацию пока не комментируют. Закон DMA, принятый ЕС в 2023 году, призван ограничить деятельность крупнейших IT-гигантов, устанавливая ряд правил и запретов. Пока они не применялись против крупных облачных провайдеров, контролирующих значительную долю рынка. Если облачные сервисы в итоге будут признаны подпадающими под правила DMA, штрафы за их нарушения могут быть весьма чувствительными даже для гиперскейлеров. Например, Apple и Meta✴ уже почувствовали жёсткость закона на себе, заплатив штрафы €500 млн ($579 млн) и €200 млн ($231 млн) соответственно.

01.11.2025 [02:03], Владимир Мироненко

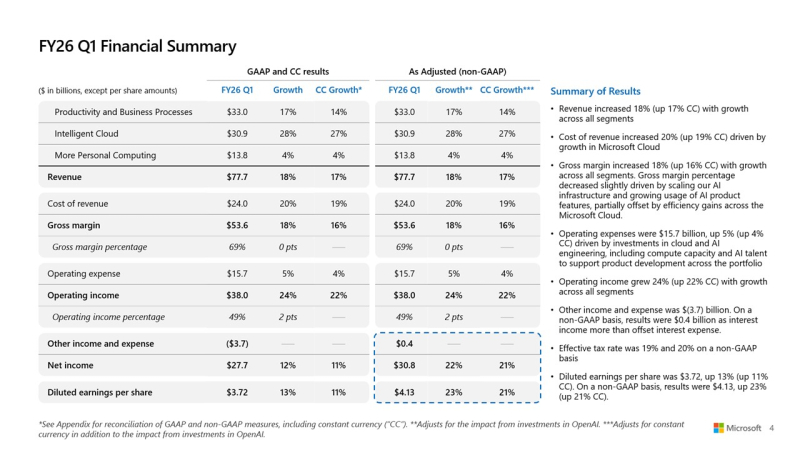

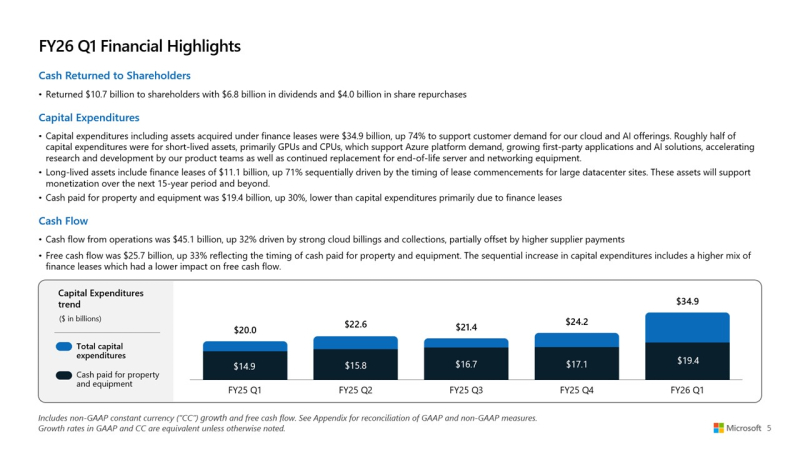

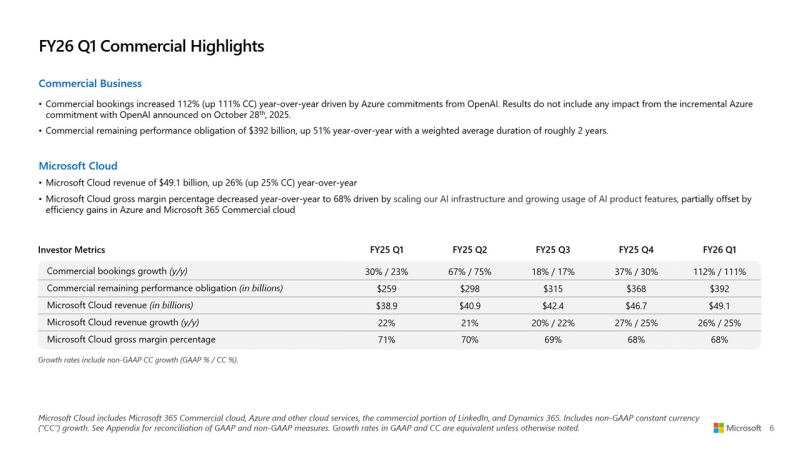

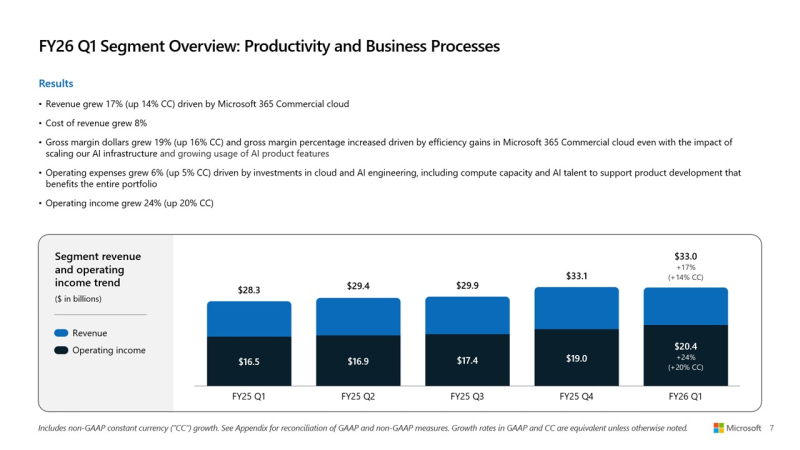

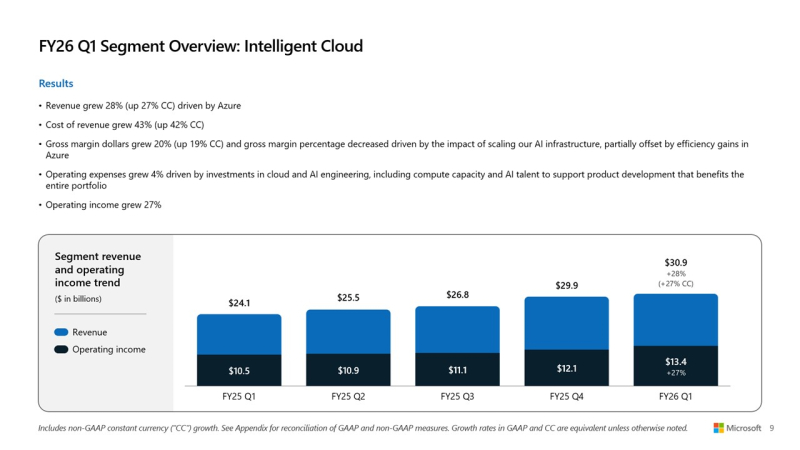

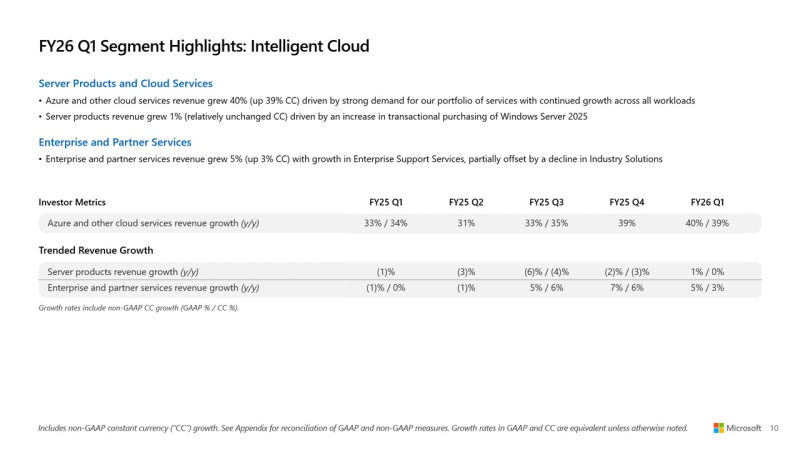

Большие расходы на большой ИИ: Microsoft увеличила выручку и прибыль, но акции упали из-за роста капзатрат на ЦОД и ускорителиMicrosoft сообщила о впечатляющем начале 2026 финансового года, обусловленном растущим спросом на облачную инфраструктуру и ИИ. Выручка за I квартал, закончившийся 30 сентября 2025 года, выросла на 18 % по сравнению с аналогичным периодом прошлого года, до $77,67 млрд, превысив консенсус-прогноз аналитиков, опрошенных LSEG, в размере $75,33 млрд. Чистая прибыль (GAAP) выросла до $27,75 млрд или $3,72 на разводнённую акцию с $24,67 млрд или $3,30 на акцию за аналогичный период прошлого года при консенсус-прогнозе от LSEG в размере $3,67 на акцию. Драйвером роста Microsoft по-прежнему оставалось подразделение Microsoft Intelligent Cloud, в которое входят облако Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы. В сегменте «Дополнительные персональные вычисления» (More Personal Computing) выручка выросла на 4 % до $13,8 млрд благодаря росту доходов от Windows и рекламы. Это выше консенсус-прогноза StreetAccount в $12,83 млрд. Выручка Intelligent Cloud достигла $30,9 млрд (+28 %), превысив консенсус-прогноза StreetAccount в $30,25 млрд. Успех стал возможен благодаря росту Azure и других облачных сервисов на 40 %, что тоже выше консенсус-прогноза аналитиков, опрошенных StreetAccount, которые ожидали рост на 38,2 %. Общая выручка Microsoft Cloud достигла $49,1 млрд, увеличившись на 26 %, а коммерческие обязательства по исполнению контрактов выросли на 51 % до $392 млрд. Компания заявила, что ожидает рост выручки Azure во II финансовом квартале на 37 %, что немного выше оценки Visible Alpha в 36,4 %, о чём сообщает Reuters. Финансовый директор Эми Худ (Amy Hood) заявила аналитикам в ходе телефонной конференции, что рост мог бы быть выше, если бы не ограничения по вычислительным мощностям, которые, по ожиданиям Microsoft, сохранятся как минимум до конца текущего финансового года в июне 2026 года. Выручка в сегменте «Производительность и бизнес-процессы» (Microsoft Productivity and Business Processes) выросла на 17 % до $33,0 млрд, в первую очередь за счёт Microsoft 365, Dynamics 365 и LinkedIn, что выше консенсус-прогноза в $32,33 млрд, ожидаемого аналитиками, опрошенными StreetAccount. Доход от облачного сервиса Microsoft 365 увеличился на 17 %, от потребительского облачного сервиса Microsoft 365 — на 26 %, от LinkedIn — на 10 %, от Dynamics 365 — на 18 %. «Наша облачная и ИИ-фабрика планетарного масштаба, совместно с Copilots в высокодоходных областях, способствует широкому распространению и реальному влиянию, — заявил Сатья Наделла (Satya Nadella), председатель совета директоров и генеральный директор Microsoft. — Именно поэтому мы продолжаем увеличивать инвестиции в ИИ, как в основной капитал, так и в персонал, чтобы реализовать огромные возможности, которые открывают перед нами». Несмотря на рост финансовых показателей, акции Microsoft упали почти на 4 % в ходе расширенных торгов после того, как Эми Худ сообщила об ускорении роста капитальных затрат в этом финансовом году. В минувшем квартале капитальные затраты, включая финансовый лизинг, достигли $34,9 млрд, что существенно больше, чем в предыдущем квартале ($24,2 млрд), и выше прогноза в примерно $30 млрд. Среди крупных проектов — передовой ИИ ЦОД Fairwater стоимостью $3,3 млрд, который вскоре обзаведётся близнецом стоимостью $4 млрд. Примерно половина этих расходов была направлена на краткосрочные активы, связанные с расширением вычислительных мощностей и заменой оборудования, в то время как долгосрочные активы в размере $11,1 млрд пошли на новые договоры аренды мощностей, которые, как ожидается, будут способствовать монетизации в течение следующих 15 лет, сообщил ресурс Converge! Network Digest. «Показатели капитальных затрат несколько тревожны», — отметил Боб Лэнг (Bob Lang), главный аналитик опционов Explosive Options, комментируя падение акций Microsoft. Рост капзатрат с $20 млрд в I квартале 2025 финансового года до $34,9 млрд в I квартале 2026 финансового года (+75 %) свидетельствует об устойчивом инвестиционном цикле, направленном на поддержку её ИИ-инфраструктуры. В этом финансовом году Microsoft планирует увеличить общую ИИ-мощность более чем на 80 % и удвоить площадь своих ЦОД в течение следующих двух лет, что обусловлено ростом рабочих нагрузок ИИ и спросом на Azure. В текущем квартале Microsoft ожидает выручку в размере от $79,5 до $80,6 млрд, что составляет в средней отметке $80,05 млрд, в то время как аналитики, по данным LSEG, прогнозируют $79,95 млрд. Насколько повлияет на компанию пересмотр соглашения с OpenAI, ради которой Microsoft вкладывала столько денег в ИИ-инфраструктуру, пока не известно. Зато известно, что из-за инвестиций в OpenAI компания по итогам текущего квартала потеряла $3,1 млрд чистой прибыли. И что компания хочет большей самостоятельности в сфере ИИ.

30.10.2025 [11:45], Руслан Авдеев

Снова DNS: доступ к сервисам Microsoft Azure восстановили после глобального сбояВ конце минувшей среды Microsoft объявила об успешном решении проблем с конфигурацией DNS, вызвавших сбои на платформе Azure. Инцидент повлиял на работу сервисов компании и затронул множество отраслей по всему миру, сообщает Reuters. Как сообщили представители Azure, хотя уровень ошибок и задержек вернулись к уровню, предшествовавшему инциденту, небольшое число клиентов всё ещё могут сталкиваться с проблемами, и компания всё ещё работает над устранением последствий. В Microsoft заявляют, что инцидент продолжался в течение восьми часов. Ранее в среду авиакомпания Alaska Airlines заявила, что столкнулась с проблемами в работе ключевых систем, включая сайт, из-за проблем с Azure и восстанавливает работу систем после того, как Microsoft решила проблему. Сайт лондонского аэропорта Хитроу тоже вернулся к работе после перерыва в среду, от сбоя пострадал и телеком-оператор Vodafone. Приблизительно в 12:00 по восточному времени США (19:00 по Москве) в среду 29 октября в Azure сообщили, что у их клиентов и сервисов Microsoft, использующих Azure Front Door (глобальную облачную сеть доставки контента и приложений), возникли проблемы, которые привели к таймаутам и ошибкам. По данным Downdetector на 19:49 ET (02:49 по Москве, 30 октября), число пользователей, сообщавших о проблемах с Azure, упало до 230. Для сравнения, на пике ранее в тот же день речь шла о более 18 тыс. жалоб. К 22:44 ET статистика Downdetector свидетельствовала о 77 сбоях Microsoft 365, на пике речь шла об около 20 тыс. жалобах. Поскольку речь идёт только о случаях обращений на сайт сервиса, настоящее число пострадавших может быть намного больше. Недавний масштабный сбой AWS, который, как в итоге выяснилось, тоже был вызван проблемами с DNS, стал крупнейшим с прошлогоднего инцидента с ПО CrowdStrike, нарушившего работу оборудования в больницах, банках и аэропортах — это продемонстрировало чрезвычайную уязвимость связанных глобальных технологий, находящихся под контролем всего нескольких компаний.

29.10.2025 [02:10], Владимир Мироненко

OpenAI стала «корпорацией общественного блага» и сократила зависимость от Microsoft, но и Microsoft не забыла подстраховатьсяOpenAI завершила реструктуризацию после более года переговоров с управлениями генеральных прокуроров Калифорнии и Делавэра, которая устанавливает более чёткие механизмы управления и подотчётности, пишет The Verge. Также компания подписала новое соглашение с Microsoft, в котором, в том числе, подробно описываются дальнейшие действия сторон в случае, если «общий искусственный интеллект» (AGI) удастся когда-либо создать. После реструктуризации коммерческая структура компании теперь является «корпорацией общественного блага» (Public Benefit Corporation, PBC) под названием OpenAI Group PBC. Некоммерческое подразделение получило название OpenAI Foundation, сохранив функцию контроля коммерческой деятельности компании и владение акциями коммерческой структуры, в настоящее время оцениваемой примерно в $130 млрд. Как отметил ресурс The Verge, если бы OpenAI не завершила реструктуризацию до конца года, она могла бы потерять до $10 млрд ранее объявленных SoftBank инвестиций. Согласно сообщению в блоге OpenAI, OpenAI Foundation первоначально выделит $25 млрд на два направления: ускорение исследований в области здравоохранения посредством открытых и ответственно разработанных передовых наборов медицинских данных и научных грантов, а также разработку технологий устойчивости ИИ для защиты критически важных систем, таких как электросети, больницы и финансовые учреждения. Эти инициативы основаны на деятельности ранее созданного OpenAI фонда People-First AI Fund с бюджетом в $50 млн. Новая структура компании гарантирует, что по мере роста коммерческого успеха OpenAI её некоммерческое подразделение получит ресурсы для поддержки глобальных проектов, представляющих общественный интерес, пишет ресурс Converge! Network Digest. Некоммерческое подразделение также получит «дополнительную долю собственности» после того, как коммерческая деятельность OpenAI достигнет достаточного уровня оценки, который пока не определён. Новая структура OpenAI стала компромиссом, на который пришлось пойти в связи с противодействием прокуроров, а также из-за затяжной судебной тяжбы с Илоном Маском (Elon Musk), который подал в суд на компанию и отдельно на генерального директора Сэма Альтмана (Sam Altman) с целью воспрепятствовать переходу OpenAI на коммерческую основу. Первоначальный план Альтмана заключался в преобразовании OpenAI в коммерческую организацию, при этом некоммерческая часть больше не контролировала бы какие-либо аспекты деятельности компании. Но в итоге был предложен вариант, в рамках которого у некоммерческой материнской организации OpenAI будет пакет акций на сумму до $100 млрд и она продолжит осуществлять надзор за компанией. В рамках этих преобразований Microsoft и OpenAI подписали новое окончательное соглашение, пересматривающее долгосрочное партнёрство. Согласно новому соглашению, Microsoft владеет долей в OpenAI Group PBC на сумму около $135 млрд, что составляет примерно 27 % на основе разводненной стоимости акций, включая всех владельцев — сотрудников, инвесторов и OpenAI Foundation. До этого доля Microsoft составляла 32,5 %. Microsoft отметила, что соглашение сохраняет ключевые элементы, которые питали успешное партнёрство, а это означает, что OpenAI остаётся партнёром Microsoft, а Microsoft сохраняет исключительные права на интеллектуальную собственность и эксклюзивность Azure API до создания AGI. После того как OpenAI объявит о создании AGI, достоверность этого заявления будет проверена независимой экспертной комиссией. Права интеллектуальной собственности Microsoft на модели и продукты OpenAI продлены до 2032 года и теперь включают модели, созданные после появления AGI, с соответствующими защитными барьерами. Права интеллектуальной собственности Microsoft на исследования OpenAI сохранятся до 2030 года или до момента, когда экспертная комиссия подтвердит достижение AGI, «в зависимости от того, что наступит раньше». Права на интеллектуальную собственность предоставляют Microsoft доступ к «конфиденциальным методам, используемым при разработке моделей и систем», и включают модели, предназначенные исключительно для внутреннего использования или исследовательских целей. Не относятся к исследовательской интеллектуальной собственности архитектура модели, веса модели, код инференса, код тонкой настройки и любая интеллектуальная собственность, связанная с аппаратным и программным обеспечением ЦОД. При этом Microsoft сохраняет права и на эту интеллектуальную собственность. Зато права Microsoft теперь не распространяются на потребительское оборудование OpenAI. Также теперь OpenAI может разрабатывать некоторые продукты совместно со сторонними организациями. Продукты с использованием API OpenAI, разработанные совместно со сторонними организациями, будут доступны исключительно в Azure. Продукты, не использующие API, могут предоставляться любым поставщиком облачных услуг. Microsoft тоже может теперь разрабатывать AGI самостоятельно или в партнёрстве с третьими сторонами. Дополнительные условия включают обязательство OpenAI приобрести облачные сервисы Azure на сумму $250 млрд, отмену преимущественного права Microsoft на заключение контрактов на вычислительные ресурсы и возможность OpenAI предоставлять доступ к API клиентам из сферы национальной безопасности США независимо от поставщика облачных услуг. Теперь OpenAI также может выпускать модели с открытыми весами, соответствующие оговоренным критериям.

13.10.2025 [16:45], Руслан Авдеев

Microsoft не хватает ЦОД и серверов в США, причём не только для ИИПроблемы с дата-центрами Microsoft сохранятся дольше, чем рассчитывала компания. Это подчёркивает трудности, с которыми она сталкивается в своём стремлении удовлетворить спрос на облачные технологии, сообщает Bloomberg. Источники, знакомые с внутренними прогнозами Microsoft, сообщают, что во многих облачных регионах на территории США не хватает физического пространства и/или серверов. В некоторых ключевых регионах, включая Северную Вирджинию и Техас, новые подписки на сервисы Azure ограничат до I половины 2026 года. Это дольше, чем компания заявляла ранее. В июле её представитель сообщал, что действующие ограничения сохранятся до конца 2025 года. Нехватка мощностей касается как оборудования с ИИ-ускорителями, так и традиционных серверов, долгое время бывших костяком классических облачных сервисов. Двигателем роста Microsoft является облачное подразделение Azure, которое в 2025 финансовом году принесло более $75 млрд. По темпам развития оно опережает крупнейших конкурентов AWS и Google Cloud. Нехватка серверов для сдачи в аренду клиентам постоянно препятствует выполнению планов гиперскейлеров. В ходе шести последних квартальных отчётов Microsoft последовательно заявляла о неспособности удовлетворить спрос на облачные услуги, у AWS и Google проблемы очень похожие. Представитель Microsoft, впрочем, заявлял, что Azure в США имеет достаточно ресурсов для роста, на пиковые периоды компания может использовать специальные методы распределения мощностей, позволяющие распределить нагрузку между ЦОД, чтобы обеспечить стабильную работу всех пользователей, избегая дефицита ресурсов в отдельных регионах. В норме клиенты Azure выбирают облачные регионы с учётом их физической близости и доступных сервисов, но в некоторых случаях, если ресурсов недостаточно, менеджеры Microsoft рекомендуют другие объекты. Тем не менее такие обходные пути могут усложнить работу и увеличить время передачи данных между ЦОД и клиентом. В Hexaware Technologies сообщают, что те, кому не хватает ресурсов Azure, переносят нагрузки в другие места, используют несколько регионов Azure или отправляют в облако только критически важные нагрузки до высвобождения ресурсов. В исключительных случаях Microsoft даже компенсирует дополнительные непредвиденные расходы. По имеющимся данным, Microsoft только за последний год увеличила мощность ЦОД более чем на 2 ГВт. Интенсивные вычислительные потребности ИИ привели к необходимости создания новых дата-центров. Впрочем, сегодня Microsoft не достаёт и ресурсов традиционной облачной инфраструктуры. По словам источников, OpenAI сегодня является крупнейшим облачным клиентом Microsoft, использующим серверы на основе CPU. Кроме того, такие машины применяет и сама Microsoft для обеспечения работы своих приложений. По слухам, некоторые внутренние проекты закрываются в проблемных регионах для экономии ресурсов. На ввод в эксплуатацию нового ЦОД «с нуля» могут уйти годы. Впрочем, за пределами США доступность ЦОД значительно выше. Например, многие европейские регионы Microsoft могут регистрировать новых клиентов без ограничений. По словам Microsoft, если в январе 2025 года она надеялась, что соотношение спроса и предложения в США улучшится к июню, то позже в компании стали говорить, что оптимистичным сценарием будет улучшение ситуации к декабрю. Впрочем, развитие компании не прекращается. Недавно пресс-служба отчиталась о введении в действие новых мощностей в Азии. Кроме того, Microsoft развернула для OpenAI первый в мире ИИ-кластер на базе суперускорителей NVIDIA GB300 NVL72. Сейчас компания достраивает «самый передовой» ИИ ЦОД в мире Fairwater, а потом потратит $4 млрд на ещё один такой же.

13.10.2025 [13:50], Руслан Авдеев

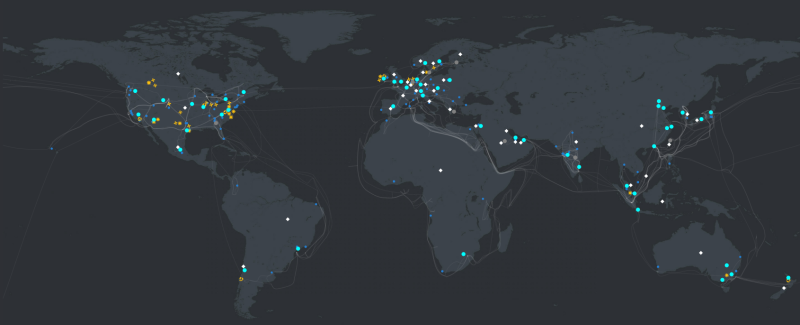

Microsoft запустила новые облачные регионы в Малайзии и Индонезии и откроет дополнительные в Индии и на ТайванеMicrosoft активно участвует в цифровой трансформации Азии, расширяя свою облачную инфраструктуру в регионе. В 2025 году компания запустила новые мощности Azure в Малайзии и Индонезии и планирует дальнейшее расширение с открытием новых облачных регионов в Индии и на Тайване в 2026 году, сообщает пресс-служба компании. Дополнительно IT-гигант намерен открыть второй регион в Малайзии — Southeast Asia 3. На азиатских рынках компания вкладывает миллиарды долларов в расширение собственной ИИ-инфраструктуры, внедряя передовые вычислительные и сетевые технологии, а также системы хранения. Инвестиции позволят бизнесам по всей Азии легко масштабироваться и использовать новые возможности для роста. Глобальная инфраструктура Microsoft охватила более 70 регионов 33 стран — это больше, чем у любого поставщика облачных услуг, утверждает компания. В Азии, где местный бизнес глубоко интегрирован в мировую экономику, дата-центры Microsoft обеспечивают бесперебойную масштабируемость, низкие задержки и соблюдение необходимых нормативов. Имея в распоряжении десяток регионов ЦОД в Азии, компания вкладывает значительные средства в расширение присутствия на континенте.

Источник изображения: Esmonde Yong/unspalsh.com В Восточной Азии исторически сложился рынок в Японии и Корее, который, как ожидается, продемонстрирует дальнейший рост и расширение. В апреле 2025 года компания запустила зоны доступности Azure в регионе Japan West, повысив надёжность и эффективность инфраструктуры в рамках двухлетнего плана инвестиций в ИИ и облачную инфраструктуру в стране. Дополнительно компания объявила о запуске Microsoft 365 и связанных решений для коммерческих клиентов в облачном регионе Taiwan North. Сервисы Azure также доступны в регионе некоторым клиентам, а в 2026 году, как ожидается, к ним получат доступ все желающие. В Юго-Восточной Азии компания тоже усиливает свои позиции, наращивая инвестиции. В мае 2025 года она запустила облачные регионы в Индонезии и Малайзии: ЦОД гиперскейл-уровня, готовность к ИИ-проектам, три зоны доступности и малая задержка для местных клиентов. Недавно введённый в эксплуатацию регион Indonesia Central — долгожданное для бизнеса дополнение, предлагающее комплексные сервисы Azure и локальную доступность Microsoft 365. Ожидается, что постоянные инвестиции в Индонезию приведут к значительному расширению местных кластеров, что позволит региону стать одним из крупнейших в Азии. Ещё весной 2024 года компания обещала вложить $1,7 млрд в облака и ИИ в Индонезии.

Источник изображения: Ernests Vaga/unsplash.com Malaysia West является первым облачным регионом в стране, с Azure и Microsoft 365. Возможностями региона уже пользуются нефтегазовый гигант из Малайзии — PETRONAS. В Малайзии Microsoft намерена открыть новый регион Southeast Asia 3 в городе Джохор-Бару (Johor Bahru). Когда регион нового поколения запустят, он будет предлагать наиболее современные и важные облачные сервисы Microsoft для сложных рабочих нагрузок. Дополнительно в 2024 году Microsoft объявила о развитии облачных технологий и ИИ-сервисов в Таиланде. В Индии уже есть несколько действующих регионов ЦОД, присутствие компании в стране будет только расширяться с запуском региона India South Central в Хайдарабаде (Hyderabad) в 2026 году. Это часть инвестиций в объёме $3 млрд, которые компания направит в течение двух лет на индийскую облачную и ИИ-инфраструктуру. В Microsoft утверждают, что инвестиции компании в инфраструктуру в Азии обусловлены потребностью в большей гибкости и оперативности в современной облачной среде. Благодаря значительным инвестициям в Азию, Microsoft может предлагать новые и более экономичные регионы Azure, подходящие как для малых, так и для крупных организаций. Новые регионы вроде Indonesia Central позволяют компаниям оптимизировать расходы на облака, сохраняя высокую производительность и доступность.

10.10.2025 [14:50], Руслан Авдеев

Не для себя стараемся: Microsoft развернула для OpenAI первый в мире ИИ-кластер на базе суперускорителей NVIDIA GB300 NVL72Microsoft представила первый в мире ИИ-кластер, использующий более 4,6 тыс. NVIDIA Blackwell Ultra в составе суперускорителей NVIDIA GB300 NVL72, объединённых интерконнектом Quantum-X800 InfiniBand. Этот кластер — лишь первый из многих. Компания развернёт сотни тысяч ускорителей Blackwell Ultra в ИИ ЦОД по всему миру. Благодаря им Microsoft намерена стать первой, поддерживающей обучение для моделей с сотнями триллионов параметров. Как сообщают в Microsoft, запуск в Microsoft Azure суперкластера NVIDIA GB300 NVL72 стал важным шагом в развитии передовых ИИ-технологий. Разработанная совместно с NVIDIA система представляет собой первый в мире масштабируемый ИИ-кластер на основе GB300, обеспечивающий вычислительные мощности, необходимые OpenAI для обслуживания моделей с триллионами параметров. Речь идёт о новом стандарте ускоренных вычислений, говорят компании. Новые инстансы Azure ND GB300 v6 оптимизированы для рассуждающих моделей, агентных систем и мультимодального генеративного ИИ. Каждая стойка GB300 NVL72 обслуживает 18 виртуальных машин, а сам суперускоритель с производительностью до 1,44 Эфлопс (FP4 Tensor Core) включает:

Источник изображения: Microsoft Создание передовой инфраструктуры требует переосмысления всех уровней системы, включая вычисления, память, системы охлаждения и питания, ЦОД в целом как единой структуры. Новая архитектура стоек обеспечивает высокую пропускную способность инференса при меньших задержках на крупных моделях, это позволяет агентным и мультимодальным ИИ-системам быть более масштабируемыми и эффективными, чем когда-либо, говорит компания. Для масштабирования за пределы стойки используется NVIDIA Quantum-X800 InfiniBand, что гарантирует обучения сверхбольших моделей с применением десятков тысяч ИИ-ускорителей с минимальными накладными расходами на их синхронизацию, что дополнительно повышает производительность.

Источник изображения: Microsoft Передовые системы охлаждения Azure используют автономные теплообменники, чтобы свести к минимуму расход воды и поддерживать температурную стабильность для высокоплотных кластеров. Также продолжается разработка и внедрение новых моделей распределения питания, обеспечивающих высокую энергетическую плотность и динамический баланс нагрузок. Дополнительную помощь в оптимизации работы оказывает и модернизированное программное обеспечение. Ранее Microsoft обладала эксклюзивными правами на предоставление облачных сервисов компании OpenAI, но в январе 2025 года появилась новость, что ИИ-стартапу разрешили пользоваться и облаками других провайдеров, если у Microsoft не хватит собственных мощностей. Разногласия между компаниями продолжают нарастать. Формально первенство по создание кластера на базе GB300 NVL72 принадлежит CoreWeave, имеющей тесные отношения с NVIDIA и обслуживающей OpenAI — как напрямую, так и при посредничестве Microsoft.

03.10.2025 [12:06], Руслан Авдеев

ВМС США с головой погрузились в облако Microsoft Azure и никак не могут выбратьсяВоенно-морские силы США объяснили, почему не могут отказаться от использования своей обособленной среде Microsoft Azure без полной реконструкции собственной облачной платформы. По данным The Register, ВМС опубликовали специальное письмо, в котором детально рассказали, почему заключили с Microsoft соглашение Strategic Cloud Platform — Enterprise Mission Integration. В документе констатируется, что для облачной среды NAVSEA, обеспечивающей доступ к программам ВМС и Министерства обороны (Министерства войны), возможен только один исполнитель, способный предоставить необходимые для работы услуги и решения. Для того, чтобы продолжать операции в среде NAVSEA, необходимо использовать сервисы Microsoft — Azure Data Transfer, Azure Kubernetes Service (AKS), Azure Structured Query Language (SQL) platform-as-a-service (PaaS), Azure Key Vault, Azure Monitor и ExpressRoute, размещённые в Microsoft GovCloud. В документе отмечается, что для смены облачного провайдера потребовалось бы переделать всё решение для военных с нуля, что потребует интеграции новой облачной среды и переделки прикладных решений, поддерживающих Defensive Cyber Operations (DCO). Это приведёт к перерыву в работе и неизбежным провалам миссий. Фактически единственным подходящим облачным провайдером является та же Microsoft, а все попытки организовать перенос с платформы компании на мощности другого провайдера столкнутся с проблемами совместимости, не соответствующими требованиям для правительственных сервисов.

Источник изображения: Sven Piper/unsplash.com Подобные выводы, по данным ВМС, подтвердились в ходе консультаций со всеми участниками программы Joint Warfighting Cloud Capability (JWCC), включая AWS, Google и Oracle. В будущем в рамках проекта NAVSEA планируется строить облачную инфраструктуру с использованием открытых стандартов контейнеризации, чтобы избежать зависимости от одного облачного провайдера-монополиста. Примечательно, что ранее в этом году Microsoft попала под прицел критиков за передачу на аутсорс в рамках программы Digital Escorts поддержки военных сервисов сотрудникам своего китайского подразделения. Сообщается, что подобная практика уже прекращена. Microsoft не впервые оказывается в центре скандала. В Евросоюзе Google целенаправленно ведёт с монополистом борьбу, обвиняя того в кратном завышении цен при использовании ПО Microsoft сторонними облачными провайдерами. Как сообщает Datacenter Dynamics, участие в программе JWCC, оцениваемой в $9 млрд, одобрили в декабре 2022 года AWS, Microsoft Azure, Google и Oracle. Она заменила предыдущее соглашение Joint Enterprise Defense Infrastructure (JEDI) от 2018 года, рассчитанное на 10 лет и $10 млрд, которое отменили из-за того, что он целиком достался Microsoft. В июле 2025 года американское правительственное Агентство оборонных информационных систем (DISA) раскрыло, что ищет новых партнёров, готовых присоединиться к программе, например, более мелких облачных провайдеров.

02.10.2025 [16:54], Руслан Авдеев

Затраты — выше, безопасность — ниже: Google снова посетовала на заградительное лицензирование Microsoft

google

google cloud platform

microsoft

microsoft azure

software

евросоюз

информационная безопасность

конкуренция

лицензия

облако

В Google Cloud рассказали о результатах жалобы в Еврокомиссию, поданной в связи с неконкурентными практиками лицензирования облачных сервисов компанией Microsoft. В частности, речь шла о введении денежных штрафов для компаний, использующих Windows Server на облачных платформах конкурентов Azure, сообщается в блоге Google. В компании утверждают, что Microsoft не испугало внимание со стороны регуляторов — компания намерена сохранить «заградительное лицензирование» для большинства облачных клиентов, а ситуация в целом становится только хуже. Недавно Microsoft заявила, что усилия по стимуляции клиентов к переходу в Azure «далеки от завершения» и это — один из трёх «столпов», стимулирующих рост бизнеса. Теперь Microsoft вносит новые изменения в лицензионную политику, чтобы переманить в своё облако больше клиентов, в том числе запрещая поставщикам управляемых услуг размещать некоторые рабочие нагрузки на платформах альтернативных облачных провайдеров. Это не осталось без внимания регуляторов. Так, в рамках комплексного расследования Управление по конкуренции и рынкам Великобритании (CMA) установило, что подобное лицензирование вредит пользователям облаков, мешает конкуренции, тормозит экономический рост и инновации. За поведением Microsoft, как утверждают в Google, следят всё больше регуляторов по всему миру. Отмена заградительных мер может способствовать ускорению роста экономики по всему миру. Microsoft всё ещё применяет наценку в 400 % для клиентов, решающих перенести старые рабочие нагрузки в облака конкурентов. В результате клиенты вынуждены пользоваться Azure, если хотят использовать ПО Microsoft — иначе переход будет слишком дорогим. По информации CMA, повышение цен на облачные услуги на 5 % из-за отсутствия конкуренции обходится британским компаниям в £500 млн/год. Исследование в Евросоюзе показало, что «заградительное лицензирование» обходится местным компаниям в €1 млрд/год, а в США отсутствие сильной конкуренции из-за лицензионной практики Microsoft ведёт к перерасходу средств госучреждениями на $750 млн/год.

Источник изображения: Michał Mancewicz/unsplash.com Страдают и кибербезопасность и надёжность сервисов, поскольку Microsoft фактически вынуждает клиентов работать в небезопасной единой экосистеме, в которой атаки на небезопасное ПО Microsoft распространяются даже на государственные учреждения и критически важные отрасли. А в условиях массового внедрения ИИ прекращение неконкурентной политики Microsoft является чрезвычайно важным, поскольку клиентам для доступа к ИИ в значимых масштабах приходится переходить в облака и именно клиенты должны решать, о чьих облаках идёт речь. В CMA утверждают, что с момента ужесточения условий лицензирования в последние годы облако Azure привлекало клиентов вдвое-втрое быстрее, чем конкуренты, главным образом из-за ограниченности выбора, влияющего на конкурентоспособность Европы в целом. Согласно недавним европейским исследованиям, отмена «запретительного лицензирования» может помочь ЕС высвободить €1,2 трлн дополнительного ВВП к 2030 году и обеспечить в год €450 млрд на экономии бюджетных средств и повышении производительности. Спустя год после жалобы в Еврокомиссию позиция Google остаётся прежней — ограничительное лицензирование в сфере облачных технологий вредит бизнесу и подрывает его конкурентоспособность. Для обеспечения инноваций и роста регуляторы должны положить конец антиконкурентной практике уже сейчас. Ранее сообщалось, что Google предлагала деньги европейским облачным бизнесам, входящим в ассоциацию CISPE и имевшим претензии к Microsoft, чтобы те не отзывали жалобы. Тем не менее, результатов добиться не удалось, а мелкий бизнес из Евросоюза не пошёл на конфронтацию с Microsoft, оставив в одиночестве AWS и Google Cloud. Попытки создать альтернативные решения Microsoft тоже «провалила».

30.09.2025 [23:25], Владимир Мироненко

С 1 ноября клиентов гиперскейлеров вынудят покупать лицензии на VMware напрямую у Broadcom

aws

broadcom

google cloud platform

microsoft azure

software

vmware

виртуализация

гиперскейлер

лицензия

облако

В связи с отменой Broadcom бессрочных лицензий VMware и переходом на модель подписки BYOS (Bring Your Own Subscription, «принеси свою собственную подписку»), обеспечивающую переносимость лицензии на проверенные VMware решения на базе VMware Cloud Foundation (VCF), клиенты крупнейших облачных провайдеров должны с 1 ноября покупать подписки на VCF напрямую у неё, без посредников. Об изменениях отношений с гиперскейлерами Broadcom объявила в самом конце августа. Google Cloud Platform анонсировала изменения в работе сервиса Google Cloud VMware Engine (GCVE) от Google Cloud Platform (GCP), который позволяет запускать рабочие нагрузки на основе VMware в инфраструктуре Google Cloud, однако через несколько часов удалила запись. Тем не менее, копия сообщения прямо говорит, что теперь клиентам придётся обращаться за лицензиями и разрешением на их использование в GCP к Broadcom. Google первой среди гиперскейлеров предложила клиентам опцию Bring Your Own License (BYOL) для сред VMware в начале 2024 года. Согласно договорённости Google и Broadcom, пользователи GCP получат следующие возможности:

Для всех остальных заказчиков с 1 ноября 2025 года для развёртывания GCVE потребуется лицензия, купленная у Broadcom. Основные возможности VMware Engine для клиентов GCP останутся прежними. GCVE останется управляемой службой Google, которая предоставляет выделенную среду VMware Cloud Foundation, работающую непосредственно на инфраструктуре Google Cloud. Microsoft сообщила, что решение Azure VMware Solution (AVS) готово к изменениям в политике Broadcom. Вариант Azure VMware Solution VCF BYOL доступен во всех 35 регионах по всему миру. Цена варианта BYOL будет меньше, чем AVS с пакетной подпиской VCF. Microsoft прекратит продажу Azure VMware Solution с комплектной подпиской на VCF после 15 октября 2025 года. После этой даты для покупки новых узлов Azure VMware Solution потребуется подписка на VCF, приобретенная непосредственно у Broadcom. Узлы Azure VMware Solution с опцией PayGo смогут работать без дополнительных лицензий и изменений в продукте до 31 октября 2026 года. Клиенты могут перейти с AVS PayGo, приобретя до 15 октября 2025 года зарезервированные инстансы Azure VMware Solution с уже включённой подпиской VCF. AWS же в начала августа 2025 года, т.е. до публичного объявления Broadcom о смене политики лицензирования для клиентов гиперскейлеров, сообщила об общедоступности сервиса Amazon Elastic VMware Service (Amazon EVS), который позволяет запускать среды VCF в виртуальном частном облаке Amazon VPC и интегрировать их с другими сервисами AWS. При этом лицензии так же придётся покупать у Broadcom, причём минимум на 256 ядер. Нюанс в том, что EVS пока поддерживает только VCF версии 5.2.1 и только на узлах i4i.metal на базе Intel Xeon Ice Lake-SP. |

|