Материалы по тегу:

|

12.12.2025 [22:18], Владимир Мироненко

ИИ-бум вернул Cisco во времена пузыря доткомов: через четверть века акции компании вернулись к историческому пику, но не её капитализацияCisco Systems, один из лидеров ИТ-индустрии во времена разрастания пузыря доткомов на фоне эйфории инвесторов от потенциальных возможностей интернета и доступности венчурного капитала, вновь вернулась к былым показателям, отчасти благодаря ИИ-буму, пишет Bloomberg. В минувшую среду акции Cisco Systems выросли на 0,9 % до $80,25, наконец превысив максимум, достигнутый более чем 25 лет назад. Уровень акций компаний на 27 марта 2000 года рассматривается многими экспертами как пик пузыря доткомов, он же был пиковым уровнем индекса Nasdaq 100 до конца 2015 года. По словам Деки Малларки (Dec Mullarkey), управляющего директора SLC Management, это является своего рода напоминанием о том, как долго может проходить восстановление после кризиса. Например, японскому фондовому рынку потребовались десятилетия, чтобы оправиться от пузыря конца 1980-х годов: «Как только вы теряете доверие инвесторов в результате болезненной распродажи, им могут потребоваться годы, чтобы прийти в себя». Рост акций в среду был частью более широкого ралли американских фондовых индексов после того, как Федеральная резервная система (ФРС) США снизила процентные ставки на третьем заседании подряд. Индекс S&P 500 вырос на 0,7 %, в то время как индекс Nasdaq 100 прибавил 0,4 %. Сейчас инвесторы и специалисты по рыночным прогнозам проводят параллели между сегодняшним ралли, возглавляемым «Великолепной семеркой», и прошлым, когда оно достигло рекордного уровня в конце 1990-х годов, а Cisco была одним из т.н. «Четырёх всадников биржи Nasdaq» наряду с Microsoft, Intel и Dell, которые привлекли огромный интерес инвесторов. За два года, предшествовавших достижению рекордного показателя в 2000 году акции Cisco взлетели почти на 600 % и рыночная стоимость компании превысила $500 млрд. После того, как пузырь доткомов лопнул, Cisco потеряла около 90 % своей стоимости, которая в конце 2002 года упала до отметки в $60 млрд. С тех пор акции Cisco выросли более чем на 800 %, но рыночная капитализация компании остается более чем на 40 % ниже её пикового уровня эры доткомов. Малларки считает рост акций является «признаком уверенности» в Cisco, хотя сейчас к ней больше подходит определение «коммунальной» компании, а не новаторской. Нынешний рост акций Cisco был обусловлен высоким прогнозом компании по выручке, сообщившей в прошлом месяце, что объём продаж в текущем финансовом году, который заканчивается в июле, достигнет $61 млрд, что выше ожиданий Уолл-стрит и примерно на 1$ млрд больше прежнего прогноза. Это добавило оптимизма инвесторам в отношении того, что расходы на ИИ-инфраструктуру помогут ускорить рост компании в ближайшие годы. Вместе с тем многие аналитики на Уолл-стрит по-прежнему скептически относятся к тому, что более широкий бум расходов на ИИ-инфраструктуру может продолжаться такими же высокими темпами длительное время.

12.12.2025 [21:35], Руслан Авдеев

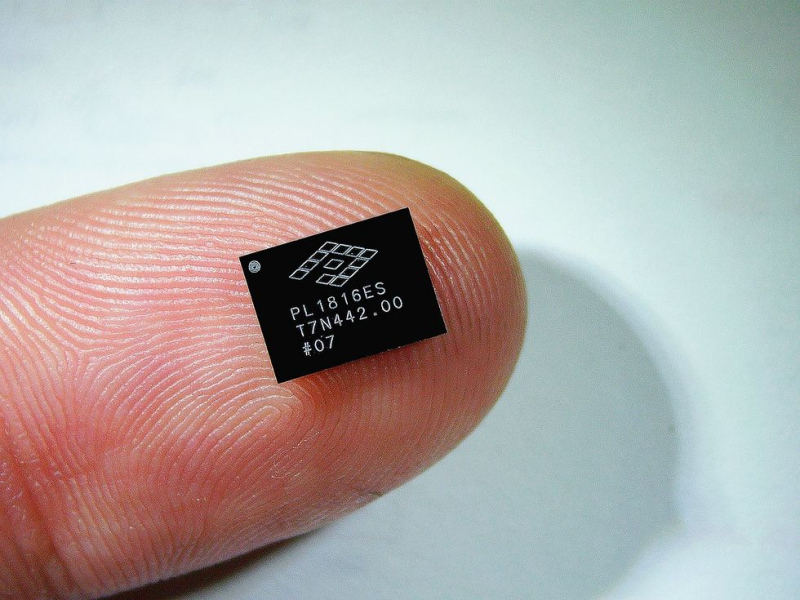

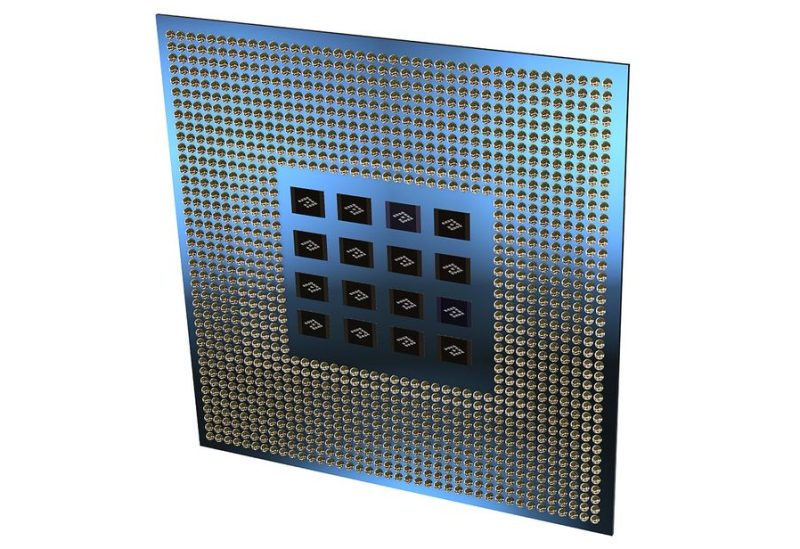

Крошечные чипы для гигантской экономии: PowerLattice пообещала удвоить производительность ИИ-ускорителей на ваттЕсли энергоснабжение организовано неэффективно, на обеспечение работы ИИ-ускорителя мощностью 700 Вт может понадобиться и 1700 Вт. Решить это проблему поможет стартап PowerLattice, который миниатюризировал и переупаковал высоковольтные регуляторы, сообщает IEEE Spectrum. В компании утверждают, что её новые чиплеты позволяют снизить реальное энергопотребление наполовину, удвоив таким образом производительность на ватт. Чиплеты можно разместить максимально близко к вычислительным кристаллам. Традиционные системы питания ИИ-чипов преобразуют переменный ток из сети в постоянный, а затем понижают напряжение до уровня, подходящего ускорителям (порядка 1 В). При значительном падении напряжения сила тока на финальном участке пути к чипу резко возрастает для сохранения нужного уровня мощности. Именно здесь и происходят существенные энергопотери и тепловыделение, которые можно снизить, разместив питающую электронику как можно ближе к потребителю — на расстоянии в несколько миллиметров, а не сантиметров, т.е. буквально внутри чипа. PowerLattice упаковала все необходимые компоненты в один чиплет размеров с пару ластиков, которые ставятся на карандаши. всего вдвое больше стирательной резинки. Чиплеты располагаются под подложкой корпуса вычислительного чипа. Одной из ключевых задач было уменьшение индукторов, помогающих поддерживать стабильное выходное напряжение. Пришлось применять специальный магнитный сплав, позволяющий очень эффективно использовать пространство, работая на высоких частотах, в сто раз выше, чем при использовании традиционного варианта. Уникальность решения в том, что сплав сохраняет лучшие магнитные свойства на высоких частотах, чем сопоставимые материалы. Утверждается, что полученные чиплеты более чем в 20 раз компактнее по площади, чем современные стабилизаторы. При этом толщина каждого из них составляет всего 100 мкм, что сопоставимо с толщиной волоса. Такие чиплеты действительно можно размещать очень близко к кристаллам процессора. При этом заказчики могут использовать несколько чиплетов в зависимости от прожорливости и требований конкретных чипов. Энергорасход можно снизить на 50 %, обещает компания, но эксперты пока сомневаются в этом — для достижения такого уровня экономии нужно динамическое управление электропитанием в режиме реального времени в зависимости от текущей нагрузки, что с решением PowerLattice может быть недостижимо. Сейчас PowerLattice тестирует свой продукт на надёжность, а первые клиенты получат чиплеты приблизительно через два года. Intel тоже работает над модулем Fully Integrated Voltage Regulator, которая тоже помогает решить похожие проблемы. В самом стартапе Intel в качестве конкурента не рассматривается, поскольку подход у компаний разны, кроме того, Intel вряд ли будет предлагать свои решения конкурирующим производителям чипов. Эксперты утверждают, что ещё 10 лет назад у компании не было шансов на успех, поскольку поставщики процессоров давали гарантию на них только при покупке их же модулей питания. Например, Qualcomm продавала свои чипсеты только вкупе с чипами управления питанием её же производства. Однако сейчас всё чаще практикуется гетерогенный подход, когда заказчики комбинируют компоненты разных компаний для оптимизации своих систем. Хотя поставщики уровня Intel и Qualcomm, вероятно, будут иметь фору при работе с крупными клиентами, более мелкие разработчики чипов и ИИ-инфраструктуры, возможно, будут искать альтернативные модули управления электропитанием.

12.12.2025 [17:21], Руслан Авдеев

Никаких закладок: NVIDIA анонсировала новое ПО для мониторинга и продления жизни ИИ-ускорителей в ЦОД

dcim

nvidia

open source

software

амортизация

ии

мониторинг

охлаждение

цод

электропитание

энергоэффективность

NVIDIA разрабатывает новое открытое ПО, благодаря которому операторы ЦОД смогут получать более подробные данные о тепловом состоянии и иных параметрах работы ИИ-ускорителей. Предполагается, что это поможет решать проблемы, связанные с перегревом оборудования и его надёжностью, увеличив его срок службы и производительность. NVIDIA отдельно подчёркивает, что телеметрия собирается только в режиме чтения без слежки за оборудованием, а в ПО нет «аварийных выключателей» и бэкдоров. Да и в целом использование новинки опционально. ПО обеспечивает операторам ЦОД доступ к мониторингу потребления энергии, загрузки, пропускной способности памяти и других ключевых параметров в масштабах всего парка ускорителей. Это помогает выявлять на ранних стадиях риски и проблемные компоненты и условия работы, отслеживать использование ИИ-ускорителей, их конфигурации и ошибки. Детализированная телеметрия становится всё важнее для планирования и управления масштабными инфраструктурами, говорит компания. ПО позволит:

Такой мониторинг особенно важен на фоне недавнего отчёта учёных Принстонского университета, в котором сообщается, что интенсивные тепловые и электрические нагрузки способны сократить срок службы ИИ-чипов до года-двух, хотя обычно предполагается, что они способны стабильно проработать до трёх лет. Современные ускорители потребляют 700 Вт и более, а высокоплотные системы — от 6 кВт. Из-за этого формируются зоны перегрева, происходят колебания энергопотребления и растёт риск деградации интерконнектов в высокоплотных стойках. Телеметрия, позволяющая оценить потребление энергии в реальном времени, состояние интерконнектов, систем воздушного охлаждения и др. позволяет перейти от реактивного мониторинга к проактивному проектированию. Рабочие нагрузки можно размещать с учётом теплового режима, быстрее внедрять СЖО или гибридные системы охлаждения, оптимизировать работу сетей с уменьшением тепловыделения. Также ПО может помочь операторам ЦОД выявлять скрытые ошибки, вызванные несоответствием версий прошивки или драйверов. Благодаря этому можно повысить общую стабильность парка ускорителей. Кроме того, без задержек передаваемые данные об ошибках и состоянии компонентов могут значительно сократить среднее время восстановления работы и упростить анализ причин сбоев. Соответствующие данные могут влиять на решения о тратах на инфраструктуру и стратегию её развития на уровне предприятия.

Источник изображения: NVIDIA Как заявляют в Gartner, современный ИИ представляет собой «энергоёмкого и сильно нагревающегося монстра», разрушающего экономику и принципы работы ЦОД. В результате, предприятиям нужны специальные инструменты мониторинга и управления для того, чтобы ситуация не вышла из-под контроля. В ближайшие годы использование подобных решений, вероятно, станет обязательным. Кроме того, прозрачность на уровне всего парка оборудования становится необходимой для обоснования роста бюджетов на ИИ-инфраструктуру. По словам экспертов, такие программные инструменты позволяют оптимизировать капитальные и операционные затраты на ЦОД и инфраструктуру, запланированные на ближайшие годы. «Каждый доллар и каждый ватт» должны быть учтены при эффективном использовании ресурсов.

12.12.2025 [15:43], Владимир Мироненко

В МФТИ изучили альтернативы ИИ-ускорителям NVIDIA — китайские Moore Threads и MetaX оказались неплохиВ связи с прекращением поставок в Россию ускорителей NVIDIA, ограничениями на загрузку драйверов и отсутствием их техподдержки Институт искусственного интеллекта МФТИ провёл исследование рынка альтернативных ускорителей, включая продукты китайских производителей Moore Threads и MetaX с целью оценки их способности обеспечить полный цикл работы современных ИИ-моделей. Исследование включало анализ архитектурных особенностей ускорителей, драйверов, совместимости с фреймворками и тестирование под нагрузкой при работе с LLM, инференсом, задачами компьютерного зрения и распределённых вычислений. Проведена оценка скорости и воспроизводимости вычислений, устойчивости при росте нагрузки и стабильности поведения моделей на разных типах ускорителей. Исследователи пришли к выводу, что ускорители Moore Threads s4000 и MetaX C500 могут применяться в широком спектре сценариев, обеспечивая стабильный запуск популярных LLM, корректную работу современных фреймворков, предсказуемую производительность и устойчивость работы при длительных нагрузках. В отдельных типах вычислений альтернативные ускорители не уступали или даже обгоняли NVIDIA A100. Особое внимание было уделено возможности работы альтернативных ускорителей в составе вычислительных узлов и кластеров. Разработанный стек ПО позволяет эффективно распределять ресурсы, объединять мощности для работы с крупными моделями и создавать кластерные конфигурации, сообщили в МФТИ. В МФТИ планируют и дальше тестировать новые поколения ускорителей, расширив перечень поддерживаемых моделей, а также намерены подготовить отраслевые рекомендации для создания автономной ИИ-инфраструктуры. На основе исследования в МФТИ был создан Центр компетенций по решениям, не зависящим от NVIDIA, который объединяет лучшие инженерные практики, методики тестирования, оптимизированные конфигурации и опыт взаимодействия с поставщиками. Он будет оказывать помощь компаниям в подборе оборудования, проведении нагрузочного тестирования под конкретные задачи, настройке вычислительных цепочек, а также может сопровождать платформы в процессе эксплуатации.

12.12.2025 [12:59], Руслан Авдеев

«ТМТ Консалтинг»: в России отмечено рекордное количество подключений к домашнему интернетуНа фоне проблем с мобильным интернетом в Российской Федерации зарегистрировали рекордное количество подключений к домашнему. «Известия» со ссылкой на данные «ТМТ Консалтинг» сообщают, что в III квартале 2025 года количество российских абонентов фиксированного интернет-доступа выросло на 500 тыс. человек. Рост спроса наблюдается у ключевых провайдеров, и в ближайшее время число абонентов продолжит расти. Как сообщают в «ТМТ Консалтинг», на конец ноября в России насчитывалось 38,46 млн подключённых домохозяйств, темпы прироста на 500 тыс. подписчиков в компании называют рекордными для рынка проводного интернета, как минимум, с 2010 года. В I квартале абонентская база фиксированного широкополосного доступа выросла на 170 тыс. человек, во II квартале — на 200 тыс. Лидером по количеству подключений стали «Ростелеком» с 237 тыс. абонентов и МТС со 169 тыс. Из-за нестабильности работы мобильного интернета абонентская база активнее всего увеличивалась на юге России, на Урале, в Поволжье и Московской области. Фиксируется и рост заявок от бизнеса, особенно малых и средних предприятий. Клиенты переходят на фиксированный интернет для собственных информационных систем, для кассовых аппаратов и раздачи беспроводной связи посетителям. По данным «Ростелекома», в последние месяцы рост подтверждённых обращений на подключение домашнего интернета составлял 12–15 % ежегодно. Максимальный рост в III квартале отмечен и у других провайдеров. В том числе вырос спрос и на спутниковый интернет. В ComNews Research полагают, что в IV квартале не исключено появление ещё 600–700 тыс. новых подписчиков. При этом, по словам экспертов, провайдеры фиксированного интернета пытаются воспользоваться ситуацией для поднятия цен.

12.12.2025 [12:47], Владимир Мироненко

Китайские Hygon и Sugon отказались от слияния из-за изменения рыночной конъюнктурыКитайская компания Hygon Information Technology, специализирующаяся на выпуске ускорителей и процессоров отказалась от планов по приобретению производителя серверов и суперкомпьютеров Dawning Information Industry (Sugon). Обе компании заверили, что это решение не окажет серьезного влияния на их деятельность и финансовое положение, а также на их дальнейшее сотрудничество. Как сообщает ресурс South China Morning Post, на этой неделе обе компании, акции которых котируются на Шанхайской бирже, заявили об отмене дальнейших переговоров о слиянии, о которых стало известно в мае этого года, поскольку «рыночная ситуация значительно изменилась с момента начала планирования этой сделки» и «условия для осуществления этой крупной реструктуризации активов ещё не сформировались». На прошедшем затем брифинге для инвесторов представители Sugon и Hygon отметили, что за последние несколько месяцев в связи с изменениями на рынке наблюдались колебания цен акций обеих компаний. На волатильность их акций повлияли «изменения во внутренней и международной обстановке, общая тенденция на фондовом рынке материкового Китая, изменения в популярности ИИ-индустрии и рыночные ожидания».  Как сообщалось ранее, приобретение Sugon компанией Hygon планировалось оплатить акциями. Акционеры Sugon должны были получить 0,5525 акций Hygon за каждую принадлежащую им акцию. Это соответствовало оценке Sugon в ¥115,967 млрд ($16 млрд). С момента объявления о готовящейся сделке акции Sugon выросли более чем на 45 %, а акции Hygon — на 60 %. После её отмены, акции Sugon на Шанхайской бирже упали в среду на 10 %, акции Hygon снизились на 0,4 %. Компания Sugon, поддерживаемая Китайской академией наук, была внесена 2019 году правительством США в санкционный список вместе с тремя её дочерними предприятиями.

12.12.2025 [12:44], Сергей Карасёв

Чипы-коммутаторы Xsight Labs X2 пропишутся в спутниках SpaceX Starlink V3Компания Xsight Labs объявила о том, что её программируемые чипы-коммутаторы X2 будут использоваться в составе космических аппаратов SpaceX Starlink V3, предназначенных для организации высокоскоростного спутникового интернет-доступа в глобальном масштабе. Изделия Xsight X2 изготавливаются по техпроцессу TSMC N5. Они обеспечивают пропускную способность до 12,8 Тбит/с. Возможно использование до 128 портов; поддерживаются режимы 100GbE, 200GbE и 400GbE. Заявленное энергопотребление составляет менее 200 Вт. Задержка при работе на скорости 100GbE — менее 700 нс. Чипы выполнены в корпусе с размерами 55 × 55 мм. Каждый спутник Starlink V3 обеспечивает пропускную способность канала связи свыше 1 Тбит/с, что более чем в 10 раз превышает показатель Starlink V2. При этом скорость передачи данных по восходящему каналу составляет около 160 Гбит/с. Решения Xsight X2 помогут в обеспечении надёжной связи при больших нагрузках. Отмечается, что работа глобальной инфраструктуры Starlink зависит от передачи больших объёмов данных в реальном времени, включая трафик, передаваемый по оптическим каналам между спутниками. При этом задействованы технологии адаптивного управления лучом. В такой ситуации полностью программируемая архитектура чипа Xsight X2 позволяет динамически адаптироваться к меняющимся требованиям орбитальных линий связи, обеспечивая оптимальную производительность в различных условиях. В результате, для конечных потребителей услуг обеспечивается скорость интернет-доступа, сопоставимая с оптическими каналами. Утверждается, что изделия Xsight X2 прошли комплексные испытания на соответствие требованиям, предъявляемым к компонентам для работы в экстремальных условиях космического пространства. Речь идет об устойчивости к вибрации, радиации, низким температурам и пр.

12.12.2025 [00:25], Владимир Мироненко

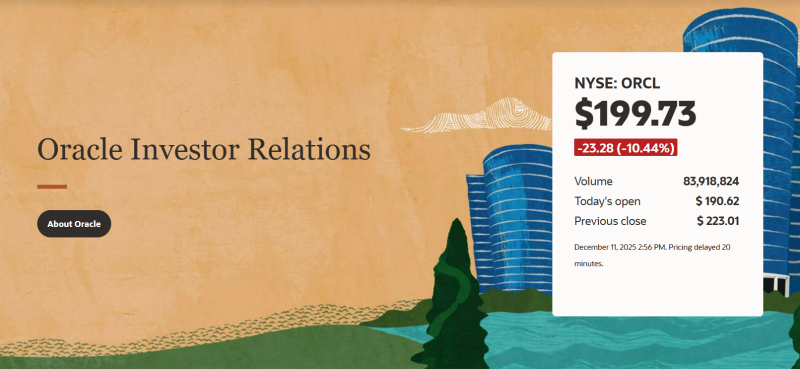

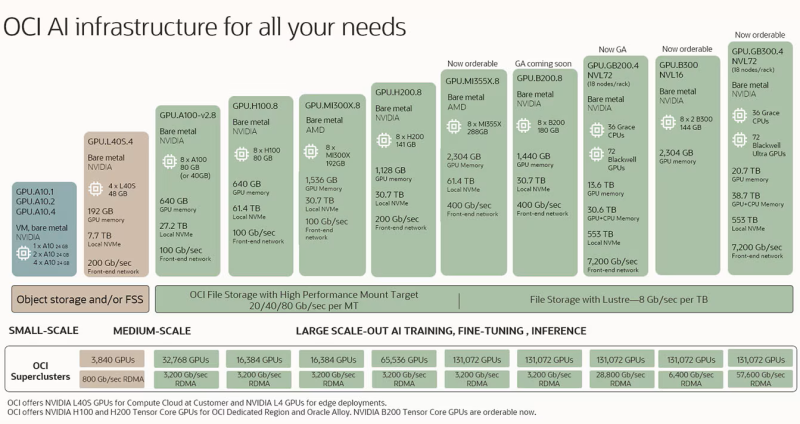

Акции Oracle показали рекордное с 2001 года падение, потянув за собой других игроков ИИ-рынкаOracle объявила результаты за II квартал 2026 финансового года, завершившегося 30 ноября. Выручка и операционная прибыль компании не оправдали ожиданий аналитиков. При этом компания повысила прогноз по расходам, что усилило опасения инвесторов по поводу её возможностей извлечь выгоду из огромного спроса ИИ-индустрии на вычислительные мощности, отметил The Wall Street Journal. В связи с этим её акции упали более чем на 11 % на внебиржевых торгах, показав в итоге самое серьёзное падение в течение дня с 2001 года. По итогам торгов в среду акции потеряли примерно треть от своей пиковой стоимости в сентябре, когда акции компании показали рекордный за 26 лет рост. Падение акций Oracle подтолкнули к падению акции других участников рынка. Акции AMD и NVIDIA упали примерно на 1 % каждая, а акции облачного провайдера CoreWeave снизились более чем на 3 % (по данным CNBC). Компания сообщила о скорректированной прибыли (Non-GAAP) за II квартал в размере $2,26 на разводнённую акцию, что значительно выше целевого показателя Уолл-стрит в $1,64 на акцию согласно консенсус-прогнозу LSEG. Вместе с тем выручка компании, несмотря на рост на 14 % по сравнению с аналогичным периодом прошлого года, до $16,06 млрд, оказалась ниже прогноза аналитиков в $16,21 млрд. Чистая прибыль (GAAP) увеличилась до $6,14 млрд, или $2,10 на разводнённую акцию, с $3,15 млрд, или $1,10 годом ранее. Выручка от облачных услуг составила $7,98 млрд, что превысило консенсус-прогноз аналитиков, опрошенных StreetAccount, в $7,92 млрд. Выручка от облачной инфраструктуры (OCI IaaS) составила $4,1 млрд, увеличившись на 68 %. Выручка от облачных приложений (OCI SaaS) равна $3,9 млрд (+11 %). Выручка от интегрированных облачных решений (SaaS) — $1,1 млрд (+18 %), выручка от NetSuite Cloud ERP (SaaS) — $1 млрд (+13 %). Выручка от разработки ПО снизилась на 3 % до $5,88 млрд, что ниже среднего прогноза аналитиков в $6,06 млрд. Продажи оборудования выросли на 7 % до $776 млн, сервисы принесли компании $1,43 млрд (+7 %). Oracle рассчитывает повысить маржинальность OCI на 30–40 %. Объём оставшихся обязательств по контрактам (RPO) вырос год к году на 438 % до $523 млрд, что выше среднего прогноза аналитиков в $501,8 млрд (согласно данным StreetAccount). Рост был вызван «новыми обязательствами от Meta✴, NVIDIA и др. компаний», сообщил в пресс-релизе главный финансовый директор Oracle Дуг Керинг (Doug Kehring). По его словам, с учётом новых обязательств, Oracle теперь планирует капитальные затраты на весь год в размере около $50 млрд, по сравнению с $35 млрд по состоянию на сентябрь. Капзатраты за 2025 финансовый год составили $21,2 млрд. Для сравнения: годовые капзатраты AWS ожидаются на уровне $125 млрд, Google — $91–$93 млрд, Meta✴ — $70–$72 млрд (а в перспективе $600 млрд), Microsoft — $80 млрд (и до $120 млрд в 2026 финансовом году), а у Alibaba Cloud, не имеющей свободного доступа к передовым ускорителям NVIDIA — $16 млрд. Здесь учитываются несколько разные периоды, но порядок затрат виден. Объявление в сентябре о том, что портфель заказов Oracle вырос до $455 млрд, привело к резкому росту акций компании. Однако с тех пор их цена упала из-за опасений по поводу уровня риска, который Oracle берёт на себя, развивая свою инфраструктуру. По данным The Register, в ноябре Oracle акции упали на 23 % — в начале месяца они стоили около $250, а в конце — около $200. Керинг попытался успокоить инвесторов, пояснив, что у компании имеется доступ к капиталу из нескольких источников, включая государственные облигации, банки и частные рынки долгового финансирования. «Кроме того, существуют и другие варианты финансирования через клиентов, которые могут предоставлять свои собственные чипы для установки в наших ЦОД, и поставщиков, которые могут сдавать свои чипы в аренду, а не продавать их», — пояснил он, добавив, что оба варианта позволяют Oracle синхронизировать её платежи с поступлениями средств и занимать значительно меньшие суммы, чем предполагают большинство аналитиков. Кроме того, Oracle отличается от «большой тройки» гиперскейлеров тем, что занимается строительством и развёртыванием ЦОД преимущественно после подтверждения обязательств клиентов. Следует отметить, что это была первая квартальная конференция по финансовым итогам с участием новых со-генеральных директоров Oracle, Клея Магуйрка (Clay Magouyrk) и Майка Сицилии (Mike Sicilia), которые заняли этот пост после ухода Сафры Кац (Safra Catz) в сентябре. В своём выступлении Сицилия отметил появление новых крупных клиентов облака OCI, в том числе Airbus, Deutsche Bank, LSEG, Panasonic, Canon и Rubrik. Аналитик Valoir Ребекка Веттеманн (Rebecca Wettemann) назвала в интервью ресурсу SiliconANGLE весьма показательным то, что он счёл необходимым подчеркнуть такое количество успешных сделок с клиентами. «Рынок был очень обеспокоен чрезмерной зависимостью Oracle от OpenAI и других проектов в области ИИ с точки зрения RPO и прогнозов, поэтому этот список успешных сделок с клиентами и ускорения роста приложений демонстрирует некоторое долгожданное разнообразие, что, безусловно, является позитивным фактором», — пояснила она. Веттеманн назвала хорошей новостью для Oracle и её стратегии капитальных затрат увеличение капвложений, поскольку она пытается занять центральное место в буме ИИ. Некоторые инвесторы обеспокоены огромным долгом, который она взяла на себя для своих инвестиций. Значительная часть портфеля заказов Oracle приходится на OpenAI Group PBC, которая обязалась потратить более $300 млрд на облачные инфраструктурные сервисы Oracle в течение следующих пяти лет. «Чем дольше портфель заказов остается невостребованным, тем выше риск того, что Oracle не сможет его монетизировать, или же ландшафт ИИ изменится настолько, что некоторые клиенты не смогут выполнить свои обязательства», — сообщила Веттеманн. Аналитик Constellation Research Хольгер Мюллер (Holger Mueller) отметил, что некоторые инвесторы могли заметить, что рост выручки Oracle происходит за счёт значительных затрат, что приводит к снижению прибыльности по мере увеличения объёмов продаж. Вместе с тем он согласился с финансовым директором по поводу того, что долг, который Oracle берёт на себя, не является проблемой. «При процентных платежах в размере приблизительно $1 млрд долговая нагрузка более чем управляема для компании», — сказал аналитик. Комментируя продажу доли в Ampere, основатель Oracle Ларри Эллисон (Larry Ellison) сказал, что решение было принято, потому что, по его мнению, больше нет смысла продолжать проектировать, производить и использовать собственные микросхемы в своих ЦОД. «Компания привержена политике чиповой нейтральности, — сказал он. — Нам необходимо быть готовыми и иметь возможность использовать любые чипы, которые захотят приобрести наши клиенты». В свою очередь, Клей Магуйрк отметил, что у Oracle более 211 действующих и планируемых облачных регионов по всему миру. Кроме того, компания наполовину завершила строительство 72 мультиоблачных ЦОД, которые будут интегрированы в облака Amazon, Google и Microsoft. «Наш бизнес по мультиоблачным базам данных — самый быстрорастущий бизнес: во II квартале он вырос на 817 %», — сказал он. Также следует обратить внимание на слова Майка Сицилии о том, что у компании «огромные преимущества перед конкурентами в области приложений». «Обучение ИИ и продажа моделей ИИ — это очень крупный бизнес, но мы считаем, что существует еще большая возможность — внедрение ИИ в самые разные продукты», — сообщил Сицилия. — Oracle находится в уникальном положении для внедрения ИИ во все три уровня наших программных продуктов: ПО для облачных ЦОД, ПО для автономных баз данных и аналитики, а также ПО для приложений. Все три направления Oracle уже достаточно масштабны — ИИ сделает их всё лучше и масштабнее». В III финансовом квартале Oracle ожидает скорректированную прибыль (Non-GAAP) на акцию в размере от $1,70 до $1,74 и рост выручки на 19-21 %. Консенсус-прогноз LSEG предполагает прибыль на акцию в размере $1,72 и выручку в размере $16,87 млрд, что подразумевает рост год к году на 19 %.

11.12.2025 [22:26], Андрей Крупин

«Рег.ру» вывел на рынок приватного ИИ-ассистента для работы с конфиденциальными даннымиРаботающая на рынке хостинга, доменов и облачных решений компания «Рег.ру» сообщила о доступности клиентам приватного ИИ-ассистента, реализованного по модели HaaS (Hardware as a Service). Новый продукт призван закрыть потребность бизнеса в использовании генеративного ИИ там, где развёртывание в публичном облаке невозможно из-за нормативных требований или внутренних политик безопасности. В отличие от облачной версии, где ресурсы выделяются из общего пула, приватный ИИ-ассистент функционирует в полностью изолированном контуре. «Рег.ру» берет на себя техническую поддержку инфраструктуры с широким ассортиментом предустанавливаемых open-source ИИ-моделей. Донастройку и интеграцию решения под конкретные бизнес-задачи организации могут выполнять самостоятельно или с привлечением партнёров-интеграторов.

Источник изображения: Steve Johnson / unsplash.com Решение поставляется в виде серверных машин с ускорителями NVIDIA (включая решения H100 и H200 с 80 и 141 Гбайт памяти соответственно, а также карты серий A100, L40S и A6000), на которых размещается образ на базе платформы Ollama с предустановленными ИИ-моделями и веб-интерфейсом. Серверы поддерживают установку до 8 GPU, комплектуются производительными CPU, оперативной памятью до 4 Тбайт и NVMe-накопителями. Архитектура сервиса позволяет проводить аттестацию для соответствия строгим стандартам, включая ФЗ-152 «О персональных данных» и требования ФСТЭК России.

11.12.2025 [17:40], Сергей Карасёв

32 Гбайт GDDR6 и до 4096 потоковых процессоров: AMD представила ускорители Radeon AI Pro R9700S и R9600D для рабочих станцийAMD пополнила семейство профессиональных видеокарт Radeon AI Pro R9000 моделями Radeon AI Pro R9700S и Radeon AI Pro R9600D, выполненными на архитектуре RDNA 4 с графическим чипом Navi 48. Ускорители рассчитаны на использование в рабочих станциях. Модель Radeon AI Pro R9700S получила 64 исполнительных блока, 4096 потоковых процессоров и 128 ИИ-блоков. Изделие насчитывает 53,9 млрд транзисторов. Игровая частота (Game Frequency) достигает 2350 МГц, частота с ускорением (Boost Frequency) — 2920 МГц. Пиковая ИИ-производительность в режиме FP32 достигает 47,8 Тфлопс, на векторных операциях FP16 — 95,7 Тфлопс, в режиме INT8 (Structured Sparsity) — 766 TOPS. Энергопотребление составляет 300 Вт. В свою очередь, версия Radeon AI Pro R9600D располагает 48 исполнительными блоками, 3072 потоковыми процессорами и 96 ИИ-блоками. Игровая частота — 1080 МГц, частота с ускорением — 2020 МГц. Показатели быстродействия в режимах FP32, FP16 Vector и INT8 Structured Sparsity указаны на отметках 24,8 Тфлопс, 49,6 Тфлопс и 397 TOPS соответственно. Энергопотребления равно 150 Вт. Обе новинки используют интерфейс PCIe 5.0 x16, несут на борту 32 Гбайт памяти GDDR6 с 256-бит шиной и пропускной способностью до 640 Гбайт/с. Объём кеша AMD Infinity Cache равен 64 Мбайт. Ускорители получили двухслотовое исполнение и по четыре интерфейса DisplayPort 2.1a. Задействовано пассивное охлаждение. Заявлена совместимость с Windows 10/11 и Linux. Среди поддерживаемых технологий упомянуты AMD Fluid Motion Frames, Radeon Super Resolution, Smart Access Memory, Smart Access Video, Radeon Anti-Lag, Radeon Image Sharpening 2, Enhanced Sync, FreeSync, Radeon Chill, Virtual Super Resolution, FSR и др. Также поддерживается работа с ROCm. |

|