Лента новостей

|

29.01.2026 [16:57], Сергей Карасёв

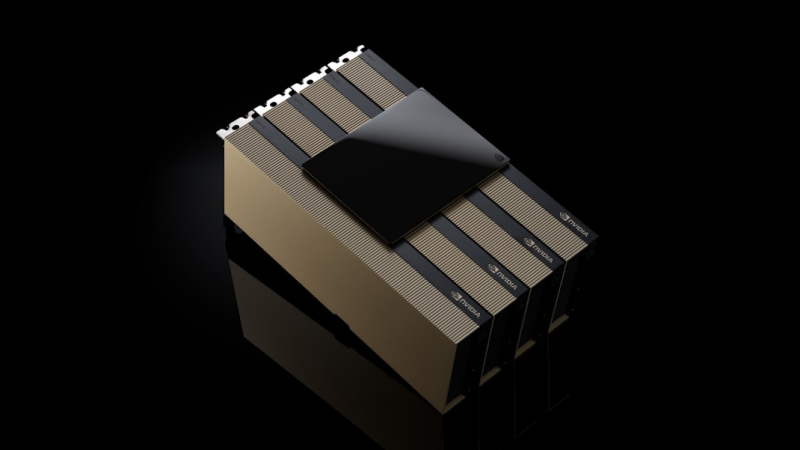

Китайский конкурент NVIDIA H20 — Alibaba представила ИИ-ускоритель Zhenwu 810E с 96 Гбайт HBM2eКомпания T-Head Semiconductor, подразделение китайского интернет-гиганта Alibaba Group Holding, представила ИИ-ускоритель собственной разработки Zhenwu 810E. Изделие, как утверждается, может использоваться для обучения ИИ-моделей и инференса, а также для решения других ресурсоёмких задач, например, в области автономного вождения. В основу новинки положены аппаратная и программная архитектуры, полностью разработанные специалистами T-Head. Решение оснащено 96 Гбайт памяти HBM2e. Применен проприетарный интерконнект ICN (Inter-Chip Network), обеспечивающий пропускную способность до 700 Гбайт/с — у каждого чипа есть семь таких интерфейсов для прямого объединения с другими чипами. Для подключения к хосту используется шина PCIe 5.0 x16. В плане производительности Zhenwu 810E, по имеющейся информации, превосходит ускоритель NVIDIA A800, а также некоторые GPU китайского производства. Подчеркивается, что новое решение T-Head способно составить конкуренцию NVIDIA H20. Напомним, что и A800, и H20 разработаны специально для китайского рынка в соответствии с американскими требованиями по контролю над экспортом высокопроизводительных процессоров. Некоторые источники также предполагают, что модернизированная версия чипа Zhenwu сможет обеспечить производительность, превосходящую показатели NVIDIA A100.

Источник изображения: T-Head Alibaba уже использует Zhenwu 810E для обучения своих больших языковых моделей Qianwen, а также для ИИ-инференса. Кроме того, на базе новых чипов в сочетании с облачными сервисами Alibaba предоставляются услуги более чем 400 клиентам, включая Государственную электросетевую компанию (SGCC), Китайскую академию наук (CAS) и стартап по производству электромобилей Xpeng. Собственные ИИ-чипы проектируют и многие другие китайские компании. В частности, местный стартап Iluvatar CoreX недавно поделился планами по выпуску GPU-ускорителей, превосходящих по возможностям NVIDIA Rubin. Соответствующие разработки также ведут Kunlunxin (Baidu), Zixiao (Tencent), MetaX, Moore Threads и Biren. Но ведущими игроками рынка ИИ-чипов КНР остаются NVIDIA и Huawei.

29.01.2026 [16:38], Владимир Мироненко

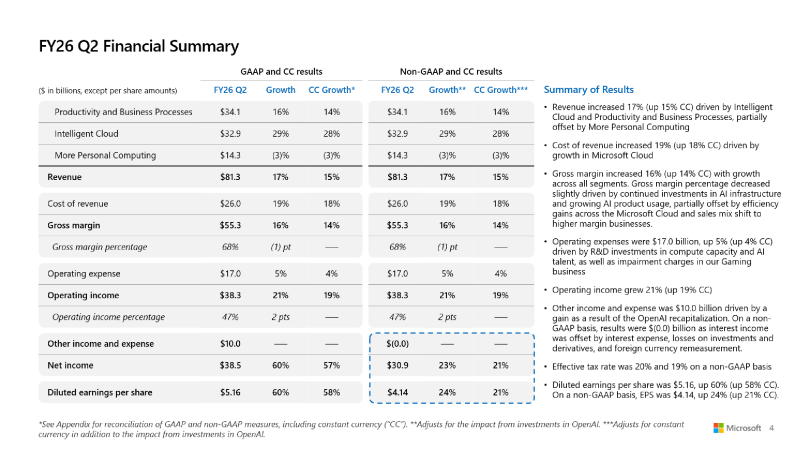

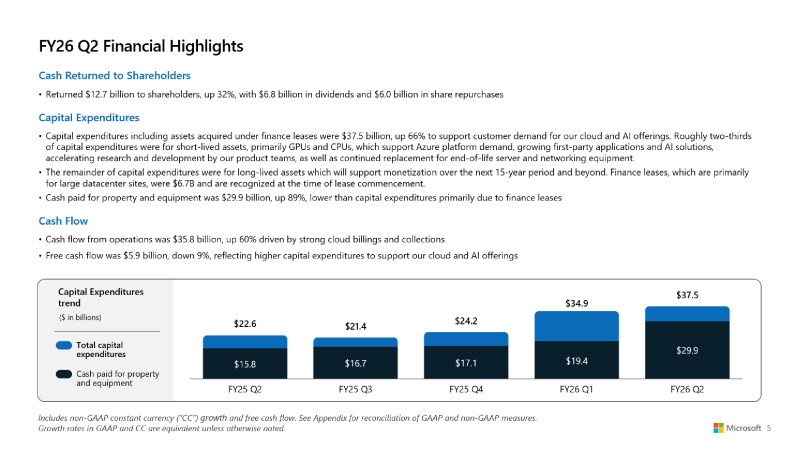

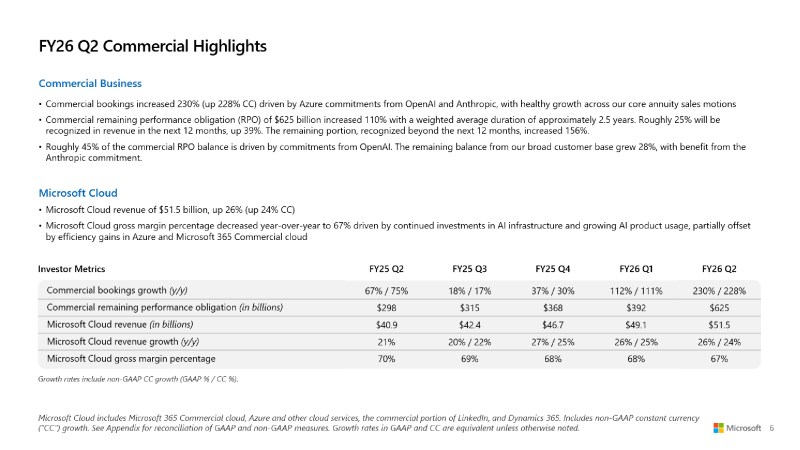

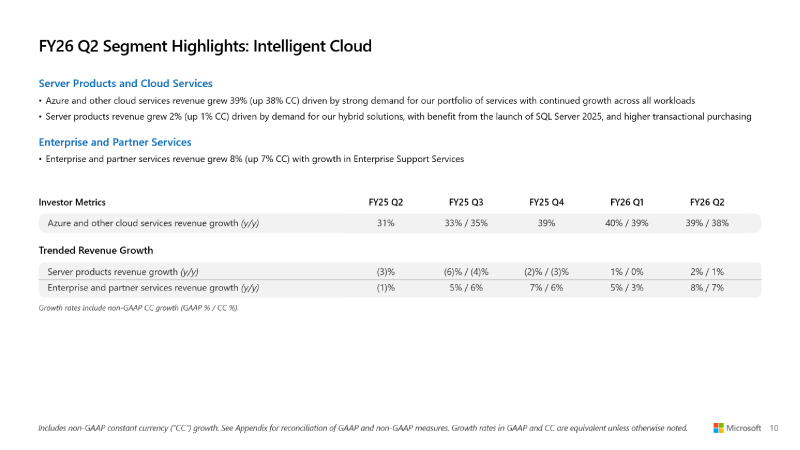

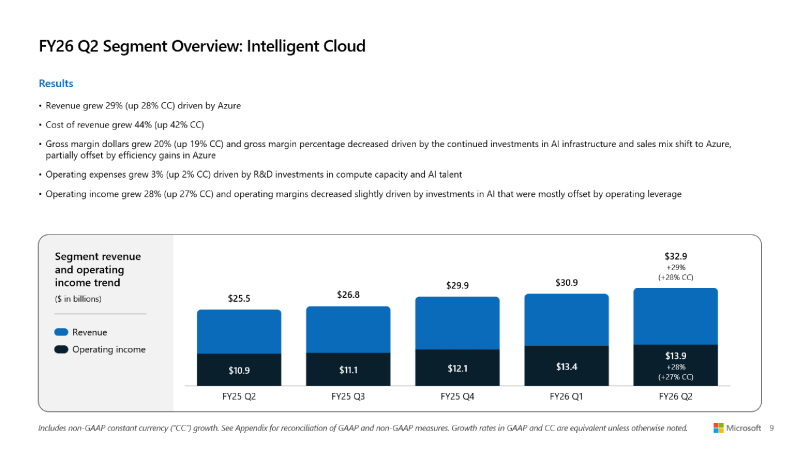

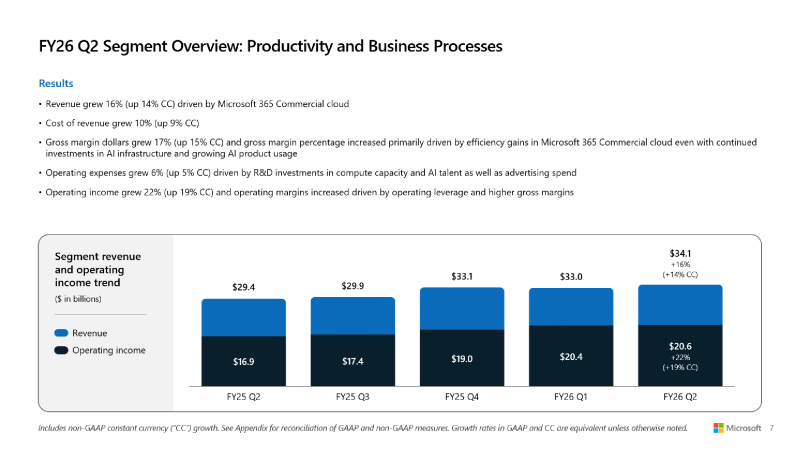

Microsoft превысила прогнозы Уолл-стрит, но её акции упали из-за замедления роста облачных сервисовMicrosoft объявила результаты за II квартал 2026 финансового года, закончившийся 31 декабря 2025 года. Несмотря на то, что результаты компании превысили прогнозы Уолл-стрит, её акции упали на 7 % на внебиржевых торгах в среду после сообщения о замедлении роста облачных сервисов, пишет ресурс CNBC. Скорректированная прибыль (Non-GAAP) Microsoft на разводнённую акцию составила $4,14 при объёме продаж в $81,27 млрд, в то время как аналитики, опрошенные LSEG, ожидали $3,97 скорректированной прибыли при выручке в размере $80,27 млрд. Microsoft уточнила, что скорректированная прибыль не включает влияние инвестиций компании в OpenAI. Согласно отчёту Microsoft, её выручка за второй финансовый квартал выросла на 16,7 % по сравнению с аналогичным периодом предыдущего финансового года. Чистая прибыль (GAAP) составила $38,46 млрд или $5,16 на акцию, что на 60 % выше показателя годом ранее в $24,11 млрд или $3,23 на акцию. Валовая маржа компании была самой низкой за три года, составив чуть более 68 %. «Выручка Microsoft Cloud в этом квартале превысила $50 млрд, что отражает высокий спрос на наш портфель услуг», — сообщила Эми Худ (Amy Hood), исполнительный вице-президент и главный финансовый директор Microsoft, добавив, что компания превзошла ожидания по выручке, операционной прибыли и прибыли на акцию. Выручка Microsoft Cloud выросла на 26 % до $51,5 млрд, а оставшиеся коммерческие обязательства компании по исполнению контрактов, представляющие собой незаработанную выручку и суммы, которые будут признаны в качестве выручки позже, выросли на 110 % до $625 млрд. Это стало возможным благодаря оставшимся коммерческим обязательствам OpenAI перед Microsoft в области облачных сервисов на сумму $250 млрд в течение квартала. Microsoft заявила, что 45 % оставшихся коммерческих обязательств связаны с OpenAI, а оставшаяся часть суммы выросла на 28 %. «Портфель заказов действительно хорош, но информация о том, что OpenAI составляет 45 % от их портфеля, возвращает нас к вопросу: сможет ли OpenAI достичь этих финансовых целей, чтобы расплатиться с Oracle, Microsoft и многими другими поставщиками?» — задался вопросом аналитик Jefferies Брент Тилл (Brent Thill) в программе Closing Bell Overtime на CNBC. Остальная часть оставшихся обязательств по коммерческому выполнению контрактов «больше, чем у большинства конкурентов, более диверсифицирована, чем у большинства конкурентов, и, честно говоря, я думаю, что мы очень уверены в этом», — сказала Эми Худ. Она отметила, что Microsoft остаётся «мастштабным поставщиком» для OpenAI. Microsoft сообщила, что чистые убытки от инвестиций в OpenAI составила $7,58 млрд, или $1,02 на акцию. Компания также отметила, что её прочие доходы во II финансовом квартале составили $9,97 млрд, что обусловлено рекапитализацией OpenAI, пишет ресурс Constellationr. Сегмент Microsoft Intelligent Cloud, включающий облачную инфраструктуру Azure, принес $32,91 млрд выручки (рост 29 %), что больше консенсус-прогноза StreetAccount в размере $32,40 млрд. Рост Azure и других облачных сервисов составил 39 % по сравнению с 40-% ростом в I финансовом квартале. Аналитики, опрошенные StreetAccount и CNBC, ожидали рост на 39,4 и 38,9 % соответственно. Выручка в сегменте «Производительность и бизнес-процессы» (Microsoft Productivity and Business Processes) выросла на 16 % до $34,12 млрд, что выше консенсус-прогноза в $33,48 млрд аналитиков, опрошенных StreetAccount. Доход от облачного сервиса Microsoft 365 увеличился на 17 %, от потребительского облачного сервиса Microsoft 365 — на 29 %, от LinkedIn — на 11 %, от Dynamics 365 — на 19 %. В настоящее время у компании 15 млн коммерческих подписчиков Microsoft 365 Copilot. До этого момента Microsoft не сообщала о количестве пользователей, имеющих доступ к Copilot. У Copilot есть потенциал роста. В настоящее время Microsoft располагает более чем 450 млн платных коммерческих пользователей Microsoft 365. Сегмент More Personal Computing, включающий Windows, Xbox, Surface и Bing, принес $14,25 млрд выручки (падение год к году на 3 %), что ниже консенсус-прогноза аналитиков StreetAccount в $14,38 млрд. В отчётном квартале капитальные затраты и финансовая аренда Microsoft составили $37,5 млрд, что на 66 % больше в годичном исчислении и выше прогноза аналитиков, опрошенных Visible Alpha, в $34,31 млрд. Худ сообщила, что примерно две трети из них приходится на краткосрочные активы, такие как GPU и CPU (согласно MarketBeat). Microsoft активно инвестирует в ЦОД для удовлетворения спроса на ИИ и другие облачные вычислительные услуги. Однако компания ожидает снижения капитальных затрат в третьем финансовом квартале, подчеркнул ресурс Investors. «Мы находимся только на начальных этапах распространения ИИ, и Microsoft уже построила бизнес в сфере ИИ», — заявил генеральный директор Microsoft Сатья Надела (Satya Nadella). «В общей сложности за этот квартал мы добавили почти один гигаватт вычислительных мощностей», — сообщил он во время телефонной конференции. Наделла подчеркнул необходимость создания решений для «гетерогенных и распределённых» рабочих нагрузок ИИ и заявил, что Microsoft оптимизирует свои решения, ориентируясь на «токены на ватт на доллар», что, по его словам, способствует повышению эффективности использования и снижению общей стоимости владения за счет полупроводниковых компонентов, систем и ПО. Он отметил «50-% увеличение пропускной способности» для рабочих нагрузок инференса OpenAI, обеспечивающих работу Copilot, и сказал, что Microsoft соединила площадки ЦОД через AI WAN, создав, по его словам, «первую в своем роде суперфабрику ИИ» для ЦОД Fairwater. В III финансовом квартале Microsoft прогнозирует выручку в размере от $80,65 до $81,75 млрд. Средний показатель составил $81,2 млрд, что соответствует консенсус-прогнозу LSEG в $81,19 млрд. Прогноз компании по квартальному росту облачных сервисов Azure составил от 37 до 38 % при консенсус-прогнозе StreetAccount в размере 37,1 %. Ожидаемая операционная маржа компании в III квартале 2026 финансового года равна 45,1 %, что ниже консенсус-прогноза StreetAccount в 45,5 %. Операционные расходы будут включать инвестиции в вычислительные мощности и персонал для ИИ.

29.01.2026 [13:01], Руслан Авдеев

STT GDC запускает в Сингапуре экспериментальный дата-центр с HVDC-питаниемОператор ЦОД ST Telemedia Global Data Centres (STT GDC) анонсировал запуск тестового ЦОД FutureGrid Accelerator с питанием постоянным током в Сингапуре — это первый в Юго-Восточной Азии инфраструктурный объект с высоковольтным High Voltage Direct Current (HVDC) энергоснабжением, сообщает Datacenter Dynamics. Расположенная при центре Electrification and Power Grids Centre (EPGC) Наньянского технологического университета (NTU) Сингапура на острове Джуронг, первая в регионе площадка демонстрирует интеграцию HVDC-технологий с реальными ИИ-нагрузками. Это позволит удовлетворять требованиям к высокой плотности размещения и высокой отказоустойчивости вычислений нового поколения в сфере ИИ. Проект совместно разработан STT GDC и Liteon при поддержке Energy Research Institute при NTU и детища NTU — компании Amperesand. Фактически чипы в ИИ-серверах работают от постоянного тока, но дата-центры изначально получают и распределяют переменный. Это ведёт в постоянной конвертации AC–DC, что приводит к энергопотерям. Гиперскейлеры пытаются добиться большей энергетической плотности стоек, используя прямое DC-питание. Солнечные и ветряные электростанции, как и многие топливные ячейки, также генерируют постоянный ток. STT GDC добавляет, что HVDC также повышает энергоэффективность, что ведёт к меньшим выбросам CO2 и использованию меньшего количества меди. FutureGrid Accelerator, по словам создателей — стратегическая инвестиция в достижение сингапурского цифрового лидерства в долгосрочной перспективе. Сотрудничество мировых лидеров ИИ-индустрии над этим проектом позволяет строить инфраструктуру, готовую к будущим ИИ-нагрузкам, в то же время находясь на передовом крае внедрения экоустойчивых технологий. Тестовая площадка позволит оценить производительность HVDC-систем с нагрузками не менее 325 кВт, используя архитектуру Liteon и твердотельные трансформаторы Solid State Transformer (SST) Amperesand. STT GDC планирует внедрять технологию в будущих ЦОД в Сингапуре, а позже — масштабировать её использование на все мировые рынки. Компания также подписала меморандум о взаимопонимании с местными образовательными и научными учреждениями: Institute of Technical Education (ITE), Singapore Polytechnic (SP), NTU Singapore и National University of Singapore (NUS) для расширения пула талантов в городе-государстве. Соглашения помогут в течение пяти лет обучить более 8 тыс. сингапурцев в рамках программ, посвящённых ИИ-инфраструктуре и устойчивым энергетическим системам. Внимание будет уделяться не только IT и экоустойчивости, но и финансовой стороне вопроса, маркетингу и другим смежным дисциплинам. Прпоекты с применением постоянного тока сегодня — не редкость. Например, ещё в конце 2024 года Microsoft и Meta✴ представили дизайн ИИ-стойки с раздельными шкафами для питания и IT-оборудования с переходом на архитектуру 400 В DC. В мае 2025 года было объявлено, что Google готовит мегаваттные стойки с питанием 400 В DC, тогда же сообщалось, что Infineon и NVIDIA разрабатывают архитектуру HVDC-питания 800 В DC для ИИ ЦОД. В октябьре 2025 года появилась информация, что OCP запустила инициативу Open Data Center for AI для стандартизации инфраструктуры передовых ИИ ЦОД с мегаваттными стойками, в числе прочего уделялось внимание и технологиям HVDC. Наконец, тогда же опубликована новость, что ABB поддержит NVIDIA во внедрении 800 В DC питания для мегаваттных ИИ-стоек.

29.01.2026 [10:39], Руслан Авдеев

NVIDIA, Microsoft и Amazon ведут переговоры об инвестициях до $60 млрд в OpenAINVIDIA, Microsoft и Amazon ведут переговоры о новых инвестициях в OpenAI. Предполагается, что компании готовы вложить в бизнес партнёра до $60 млрд, сообщает The Information. Как заявляет The Information со ссылкой на «лицо, знакомое с ситуацией», NVIDIA — действующий инвестор, чьи чипы активно используются для работы с ИИ-моделями OpenAI, ведёт переговоры о том, чтобы вложить до $30 млрд. Microsoft, давно поддерживающая OpenAI, также ведёт переговоры, но готова потратить лишь менее $10 млрд. При этом Amazon (AWS), готовая стать новым инвестором, обсуждает о вложении значительно больше $10 млрд, потенциально — даже более $20 млрд. Сообщается, что OpenAI близка к тому, чтобы получить юридически не обязывающие меморандумы о договорённостях (term sheets) или инвестиционные обязательства от названных компаний. NVIDIA, Microsoft, Amazon и OpenAI пока новости не комментируют. Ранее сообщалось, что SoftBank Group ведёт переговоры об инвестициях дополнительных $30 млрд в OpenAI. Масштаб инвестиций Amazon может зависеть от отдельных переговоров, предусматривающих возможное расширение сделки по аренде облачных серверов у Amazon компанией OpenAI и заключение коммерческого соглашения о продаже OpenAI своих продуктов — Amazon может оформить корпоративные подписки на ChatGPT. Сейчас OpenAI пытается бороться с ростом цен на обучение и эксплуатацию своих ИИ-моделей на фоне ужесточающейся конкуренцией с компанией Google и более мелкими игроками. Впрочем, плохо контролируемые инвестиции могут быть весьма опасными. Так, американские банки уже крайне неохотно дают деньги Oracle, из-за уже имеющихся обязательств последней перед OpenAI. На днях сообщалось, что OpenAI готовит крупнейший в своей истории раунд финансирования на $50 млрд при участии инвесторов Ближнего Востока.

29.01.2026 [10:28], Сергей Карасёв

AAEON готовит индустриальный компьютер UP Xtreme PTL Edge на базе Intel Panther Lake для ИИ-задачКомпания AAEON сообщила о подготовке компьютера небольшого форм-фактора UP Xtreme PTL Edge, предназначенного для использования в промышленной сфере. Новинка, в частности, подходит для решения ИИ-задач на периферии. В основу устройства положена аппаратная платформа Intel Panther Lake. Устройство заключено в корпус с габаритами 218 × 129 × 49,5 мм. Максимальная конфигурация предполагает применение процессора Core Ultra X7 358H с 16 ядрами (4Р+8Е+4LPE) с максимальной тактовой частотой 4,8 ГГц. В состав чипа входят графический блок Intel Arc B390 (до 2,5 ГГц) с ИИ-производительностью до 122 TOPS в режиме INT8 и нейропроцессорный узел (NPU) с быстродействием до 50 TOPS (INT8). Таким образом, суммарная производительность на задачах ИИ превышает 170 TOPS. Менее мощная версия компьютера несёт на борту чип Core Ultra 5 338H с 12 ядрами (4Р+4Е+4LPE) с частотой до 4,7 ГГц и графическим ускорителем Intel Arc B370. У этого изделия общее ИИ-быстродействие находится на уровне 145 TOPS (INT8). Новинка поддерживает до 128 Гбайт оперативной памяти DDR5-7200 в виде двух модулей SO-DIMM. Доступны два слота M.2 2280 M-Key (PCIe 4.0 x4) для SSD и разъём M.2 2230 E-Key (PCIe 3.0 x1, USB 2.0) для комбинированного адаптера Wi-Fi/Bluetooth. Есть два порта 2.5GbE на основе контроллера Intel I226-IT. За безопасность отвечает модуль TPM 2.0. Реализованы по два порта USB 3.1 Type-A и USB 4.0 Type-C (с поддержкой DP 2.1), два интерфейса HDMI 2.1, два последовательных порта RS-232/422/485, два гнезда RJ45 для сетевых кабелей, комбинированное аудиогнездо на 3,5 мм и 40-контактная колодка GPIO. Питание (19–36 В) подаётся через DC-разъём. Допускается монтаж посредством крепления VESA. Диапазон рабочих температур простирается от 0 до +60 °C. Заявлена совместимость с Windows 11 IoT Enterprise и Ubuntu 24.04 LTS. Серийное производство модели UP Xtreme PTL Edge компания AAEON намерена организовать к концу текущего квартала.

29.01.2026 [10:20], Руслан Авдеев

Конец неопределённости: Пекин одобрил импорт NVIDIA H200Китайские власти начали выдавать разрешения на импорт в страну ИИ-ускорителей NVIDIA H200. Это положит конец неопределённости, царившей после того, как поставки второго по производительности чипа NVIDIA в Поднебесную одобрили представители американских властей, сообщает гонконгская SCMP. Первая партия, как сообщают источники, поступит местным техногигантам, остро нуждающимся в передовых ускорителях. Впрочем, ожидается, что поддерживаемые государством компании вроде телеком-операторов, смогут покупать такие чипы только под жёстким контролем. Пока одобрены поставки более 400 тыс. ускорителей компаниям ByteDance, Alibaba Group Holding и Tencent Holdings, прочие бизнесы продолжают ожидать получения разрешений. В самой NVIDIA новости не комментируют. Это важные изменения китайской политики после того, как Пекин временно придержал поставки H200 ранее в январе 2026 года уже после того, как Вашингтон одобрил экспорт. Это отражает желание китайских властей сохранить баланс между необходимостью покупать передовые ИИ-чипы и стремлением добиться самодостаточности в этой сфере.

Источник изображения: NVIDIA По мнению экспертов, неограниченный доступ к закупкам чипов NVIDIA нанёс бы удар местной китайской индустрии ИИ-полупроводников. Поэтому регуляторам необходимо установить некоторые рамки для ограничения доли использования ИИ-ускорителей иностранного производства и управления спросом. Ранее допускалось, что китайские компании обяжут закупать определённое количество чипов местного производства при покупке H200 у NVIDIA. По мнению экспертов Национального университета Сингапура, одобрение Пекином импорта H200 вызвано стратегическими мотивами — это обеспечит дальнейшее ускоренное развитие китайских ИИ-технологий. Стоит отметить, что разрешение на поставки H200 довольно прохладно принято многочисленными политическими и бизнес-группами в США. Например, глава компании Anthropic сравнил такие продажи с поставками ядерного оружия Северной Корее.

29.01.2026 [08:43], Руслан Авдеев

Microsoft построит в Висконсине третий «самый передовой» ИИ ЦОД в мире по проекту FairwaterMicrosoft получила разрешение на строительство 15 дополнительных дата-центров в кампусе Маунт Плезант (Mount Pleasant, Висконсин), сообщает Datacenter Dynamics. Дополнительные объекты возведут на участке близ существующего кампуса Microsoft Project Fairwater на месте несостоявшегося производства Foxconn. На одном участке планируется построить девять дата-центров, каждый площадью более 53 тыс. м2, на втором — ещё шесть, площадью не менее 52 тыс. м2 каждый. Строительство ИИ ЦОД началось в 2023 году, изначально планировалось освоить более 127 га земли. В том же году техногигант получил разрешение ещё на 404 га. С тех пор компания скупает землю вокруг. В частности, она купила площадью 64 га за $43 млн в августе 2024 года. В сентябре 2025 года Microsoft сообщила, что намерена вложить в следующие три года в развитие кампуса дополнительные $4 млрд — помимо тех $3,3 млрд, что уже потрачены на Project Fairwater, который сама компания называет самым передовым в мире. Аналогичный ЦОД по проекту Fairwater запущен в Атланте (Джорджия).

Источник изображения: Dave Hoefler/unsplash.com Существующая площадка занимает территорию в 127,5 га и вмещает три больших двухэтажныъ здания общей площадью 111 483 м2. Для строительства потребовалось 74,9 км забивных свай глубокого заложения, около 12 тыс. т строительной стали, 193 км подземных кабелей среднего напряжения и 116,8 км трубопроводов для инженерных систем. Ранее в январе 2026 года компания объявила, что приостановила строительство на территории кампуса, оценивая масштабы и последние изменения технологий, а также то, как это может повлиять на строительство объектов. На тот момент представитель Microsoft заявлял, что нет причин думать, что масштабы или «природа» проекта изменятся. Теперь, судя по всему, концепцию всё же значительно пересмотрели. В Висконсине Microsoft рассматривала строительство дата-центра в Каледонии (Caledonia), но отказалась от проекта всего через несколько недель после его анонса.

28.01.2026 [23:51], Владимир Мироненко

SK hynix создала на базе Solidigm американскую «дочку» для инвестиций в ИИ-решенияЮжнокорейская компания SK hynix объявила о создании в США новой компании, специализирующейся на решениях в сфере ИИ с предварительным названием AI Company (AI Co.). Новая компания будет сформирована путём реструктуризации Solidigm (SK hynix NAND Product Solutions Corp.), калифорнийской «дочки» SK hynix по производству SSD корпоративного класса, образованной в 2021 году в результате покупки NAND-бизнеса Intel за $9 млрд. При этом её бизнес-операции будут переданы новой дочерней компании, которая будет называться Solidigm Inc., «для обеспечения преемственности бренда». Новая структура призвана укрепить конкурентоспособность SK hynix в области технологий памяти для ИИ-платформ, включая высокоскоростную память (HBM). Компания заявила, что эта инициатива знаменует собой переход от традиционной роли производителя памяти к роли ключевого партнёра в решениях для ИИ ЦОД. Полученные в этой роли возможности будут объединены для создания синергии с дочерними компаниями и филиалами SK Group. SK hynix отметила, что благодаря своему бизнесу по производству SSD корпоративного класса, Solidigm уже является ключевым игроком в экосистеме ИИ ЦОД. Включение Solidigm в состав AI Company направлено на поиск возможностей для сотрудничества и развития бизнеса, которые могут создать синергию с различными направлениями бизнеса в ИИ-индустрии. Официальное название AI Company будет объявлено в феврале. Сначала будет сформирована временная управленческая команда и совет директоров, после чего запланирован переход к постоянной управленческой группе, состоящей из местных экспертов с глубокими знаниями рынка США. Для обеспечения первоначального финансирования SK hynix инвестирует в AI Company $10 млрд. Причём эта сумма будет структурирована как резерв на привлечение капитала, в рамках которого средства будут использоваться по запросу AI Co. для финансирования инвестиций. SK hynix планирует осуществлять через AI Co. стратегические инвестиции в ИИ-компании и расширять сотрудничество с американскими новаторами в сфере ИИ. SK hynix стремится укрепить своё лидерство в области производства памяти, одновременно развивая возможности решений по всей цепочке создания стоимости в ИИ ЦОД, поскольку растёт спрос на оптимизацию на системном уровне для решения проблем с узкими местами в передаче данных, отметил ресурс Korea IT Times. Первоначально SK hynix планирует сосредоточиться на ПО для оптимизации ИИ-систем, а затем постепенно расширять инвестиции в экосистему ИИ ЦОД. Недавно сообщалось о том, что SK hynix на три месяца ускорила график запуск завода по производству микросхем в южнокорейском Йонъине (Yongin), поскольку компания вкладывает большие деньги в освоение ИИ-волны. На поставках для ЦОД можно заработать ещё больше, поскольку, по крайней мере в краткосрочной перспективе, это создало дефицит памяти в потребительском секторе, отметил ресурс Hothardware. Также в этом месяце стало известно, что SK hynix инвестирует ₩19 трлн ($12,9 млрд) в строительство нового завода по упаковке и тестированию чипов для ИИ-технологий в Чхонджу (Cheongju). Планы по созданию нового предприятия в США также соответствуют политике США, стимулирующей размещение производства в стране с помощью регулирования пошлин на поставки извне. SK hynix уже строит в Индиане научно-исследовательский центр по производству современных микросхем и их упаковке стоимостью $3,87 млрд, о котором было объявлено ещё в 2024 году. Завод будет производить HBM для ИИ-ускорителей, начало его работы запланировано на 2028 год, пишет ресурс CNBC.

28.01.2026 [18:23], Руслан Авдеев

TD Cowen: американские банки расхотели давать в долг Oracle из-за её сделок с OpenAIСогласно докладу TD Cowen, возможность Oracle приобретать новые мощности ЦОД в США оказалась под вопросом из-за обязательства перед партнёром — компанией OpenAI. Банки начали сомневаться, что Oracle способна профинансировать все масштабные проекты, в которые она пытается ввязаться, сообщает Datacenter Dynamics. К Oracle уже подали иск держатели облигаций, обвиняющих компанию в сокрытии данных о том, сколько именно ей потребуется взять в долг для поддержки строительства ИИ-инфраструктуры в рамках сделки с OpenAI на $300 млрд. Компания привлекла около $58 млрд долгового финансирования для ИИ ЦОД в интересах OpenAI, включая $38 млрд для финансирования кампусов в Техасе (Frontier) и Висконсине (Lighthouse) и около $20 млрд — для кампуса в Нью-Мексико (Project Jupiter). Ещё $10 млрд займов ушло на первый кампус Stargate в Техасе. Тем не менее, в обновлении материалов Data Center Channel Checks, подготовленном TD Cowen, заявляется, что Oracle потребуется приобрести около 3 млн ИИ-ускорителей и прочего IT-оборудования для обеспечения уже действующих договорённостей. Это вызывает вопросы у инвесторов как в акционерный, так и в долговой капитал, которые сомневаются в возможности компании финансировать все стройки. TD Cowen сообщила о росте кредитно-дефолтных свопов (CDS), которые говорят о повышении ожиданий рынком риска дефолта. Также беспокойство вызывает одновременное снижение котировок акций и облигаций компании. TD Cowen добавляет, что теперь Oracle требует авансовые депозиты в объёме 40 %, чтобы компенсировать дополнительные капитальные затраты, необходимые для роста выручки, а также изучает другие возможности решения вопросов финансирования. Согласно TD Cowen, одним из вариантов может быть увольнение 20–30 тыс. сотрудкников, что даст $8–$10 млрд свободного денежного потока, и продажа Cerner, которую Oracle купила за $28,3 млрд в 2022 году. Потребность OpenAI в капитале, по расчётам, составляет $156 млрд, и это исходя из консервативной оценки в $30 млн/МВт с учётом IT-инфраструктуры. Ситуация усугубляется существующими обязательствами OpenAI — $1,4 трлн долгосрочных контрактов. Это привело к тому, что многие американские банки стали отказываться от финансирования Oracle из-за соглашений компании с OpenAI, а в случаях, если кредиты всё же готовы выделить, условия финансирования стали намного хуже. Азиатские банки, желающие получить доступ к рынку финансирования ИИ-индустрии, всё ещё готовы предоставлять средства операторам, арендующим мощности Oracle, но значительное сокращение денежных вливаний со стороны их американских коллег привело к существенному замедлению роста бизнеса Oracle и ставит под сомнение способность компании наращивать выручку. Также отмечается, что переговоры об аренде ЦОД Oracle находятся под угрозой из-за того, что стороны не смогли договориться об обеспечении финансирования, что затрудняет усилия техногиганта по наращиванию своих арендных мощностей. В более широком контексте, доклад свидетельствует о росте индустрии ЦОД, в 2025 году рынок аренды дата-центров составил рекордные 16,4 ГВт. 5,1 ГВт арендовали в IV квартале, 7,4 ГВт — в III, 2.0 ГВт — во II, 1,9 ГВт — в I. Инвестиционный банк отметил, что в IV квартале, исторически всегда считавшемся наиболее «медленным», показатели аренды были очень высокими. В числе лидеров рынка аренды 2025 года — гиперскейлеры, включая Oracle. На начало 2026 года TD Cowen ожидает «чрезвычайно активный» портфель заказов на аренду ЦОД в США, около 9,2 ГВт уже «в процессе», а среди гиперскейлеров отмечается «здоровое разнообразие». В отчёте также отмечается, что это свидетельствует о спросе со стороны американских ИИ-лабораторий и крупных облачных провайдеров. Meta✴ к 2028 году намерена обеспечить себе 15 ГВт мощностей в США, OpenAI — 10 ГВт к 2029 году, Microsoft — 10 ГВт к 2030 году. При этом ускорение спроса ведёт и к увеличению затрат на строительство ЦОД, а также оплату труда квалифицированных сотрудников. Всё это повышает стоимость аренды на «спотовом» рынке. Предполагается, что от этого выиграют при продлении контрактов такие компании, как Digital Realty и Equinix. Наконец, в отчёте отмечается умеренный рост сроков поставки оборудования для систем бесперебойного питания и распределения электроэнергии. По мнению экспертов, это в целом свидетельствует о росте сроков поставок из-за того, что спрос на оборудование превысил предложение. Также это привело к росту цен на оборудование, что выгодно для поставщиков вроде Vertiv.

28.01.2026 [16:32], Руслан Авдеев

Oracle арендует ИИ ЦОД Project Jupiter в Нью-Мексико в интересах OpenAI StargateOracle подтвердила аренду в интересах OpenAI Stargate крупного кампуса ИИ ЦОД Project Jupiter, строящегося в округе Донья-Ана (Doña Ana) в Нью-Мексико. Кампус с четырьмя ЦОД займёт территорию около 567 га, где также разместятся электрическая микросеть, энергохранилище и установка по опреснению воды, сообщает Datacenter Dynamics. Project Jupiter строится компаниями Stack и BorderPlex Digital Assets, ранее они сообщали, что намерены инвестировать в проект $165 млрд. По данным Oracle, компания заплатит штату и округу более $600 млн в виде налогов на валовый доход и выделит принимающему округу $320 млн на развитие школ, инфраструктуры и местных служб. Ещё $50 млн будет потрачено на ремонт, строительство и восстановление местных систем водоснабжения. Предполагается, что реализация проекта позволит создать 1,5 тыс. постоянных рабочих мест — намного больше, чем ожидалось раньше. Oracle также отмечает, что ЦОД будут использовать замкнутую, неиспарительную систему охлаждения, которая не будет потреблять питьевую воду из местной системы водоснабжения. После того, как строительство четырёх зданий ЦОД будет завершено, основное потребление воды будет приходиться на местные кухни, туалетные комнаты и комнаты отдыха, что по объёму сопоставимо с типичными офисными зданиями.

Источник изображения: Oracle Oracle рассчитывает использовать собственную микросеть, работающую независимо от публичных систем электроснабжения, поэтому появление нового кампуса не должно сказаться на тарифах на электричество. Oracle оплатит энергетические расходы кампуса, а также строительство ЛЭП, аккумуляторного хранилища и электроподстанции. При этом проект вызвал негативную реакцию. Некоммерческая организация Empowerment Congress of Doña Ana County и двое местных жителей судятся с местными властями, утверждая, что проект не предоставил достаточно информации, а решение властей утвердить предложенные механизмы финансирования и налоговые льготы для проекта ЦОД «подпорчено» процедурными и нормативно-правовыми нарушениями. Ранее в январе 2026 года компания BorderPlex, участвующая в реализации Project Jupiter, объявил о намерении получить 500 МВт возобновляемой энергии к 2028 году для обеспечения своего портфолио ЦОД в Нью-Мексико, которое должно увеличиться до 1 ГВт к 2032 году. |

|