Лента новостей

|

31.01.2026 [13:19], Андрей Крупин

ФСТЭК России опубликовала рекомендации по безопасной настройке Samba

active directory

software

администрирование

защита предприятия

информационная безопасность

кии

фстэк россии

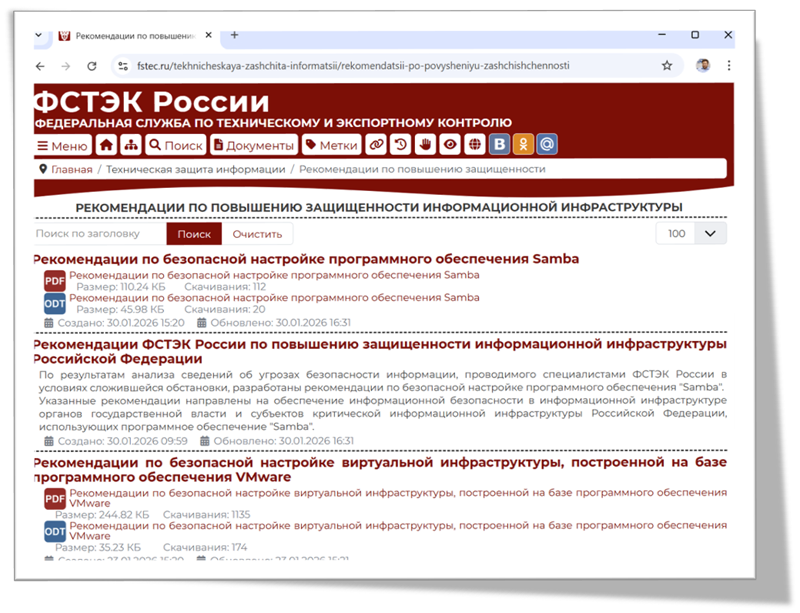

Федеральная служба по техническому и экспортному контролю выпустила рекомендации по безопасной настройке программного обеспечения Samba в IT-инфраструктуре органов государственной власти и субъектов критической информационной инфраструктуры РФ. Документ подготовлен по результатам анализа сведений о киберугрозах, проводимого специалистами ведомства. Samba представляет собой свободно распространяемый многофункциональный серверный продукт, который используется в качестве моста между операционными системами Windows и Unix-подобными системами (Linux, macOS, BSD и др.) для совместного использования файлов и принтеров. Решение поддерживает протоколы SMB/CIFS (Server Message Block / Common Internet File System), может выступать в роли контроллера домена Active Directory, совместимого с реализацией Windows Server 2008 и способного обслуживать все поддерживаемые Microsoft версии Windows-клиентов, в том числе Windows 11. Также Samba может использоваться в качестве файлового сервера, сервиса печати и сервера идентификации.  В опубликованных ФСТЭК России рекомендациях перечислены различные аспекты и нюансы конфигурирования ПО Samba. В частности, затронуты вопросы парольной политики, разграничения прав доступа к файлам, отключения устаревшего протокола SMBv1, настройки аудита и журналирования событий, средств шифрования и резервного копирования данных. Отдельное внимание уделено конфигурированию ключевых подсистем и групповых политик. Документ размещён на информационном портале Федеральной службы по техническому и экспортному контролю fstec.ru в разделе «Техническая защита информации → Рекомендации по повышению защищённости информационной инфраструктуры». Напомним, что ФСТЭК России ведёт централизованный учёт информационных систем и иных объектов КИИ по отраслям экономики, а также мониторинг и оценку текущего состояния технической защиты информации и обеспечения безопасности значимых объектов критической информационной инфраструктуры. Также в числе обязанностей ведомства значится оперативное информирование органов власти, местного самоуправления и организаций об угрозах безопасности информации и уязвимостях информационных систем и иных объектов КИИ, а также о мерах по технической защите от этих угроз и уязвимостей.

30.01.2026 [22:19], Руслан Авдеев

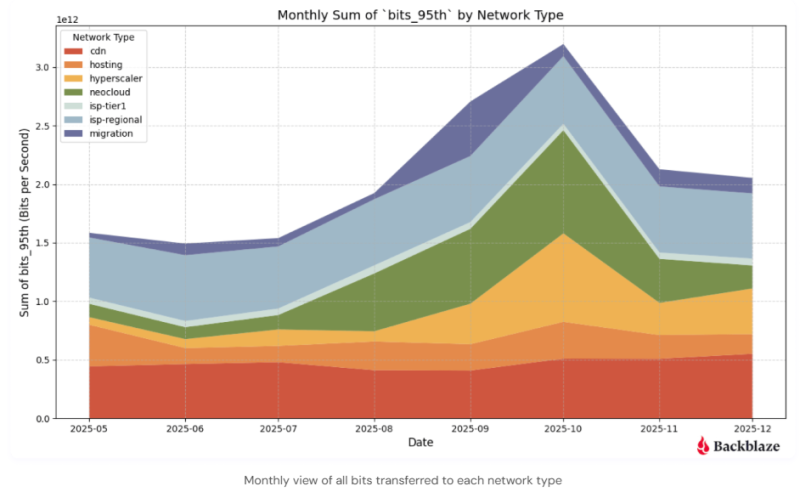

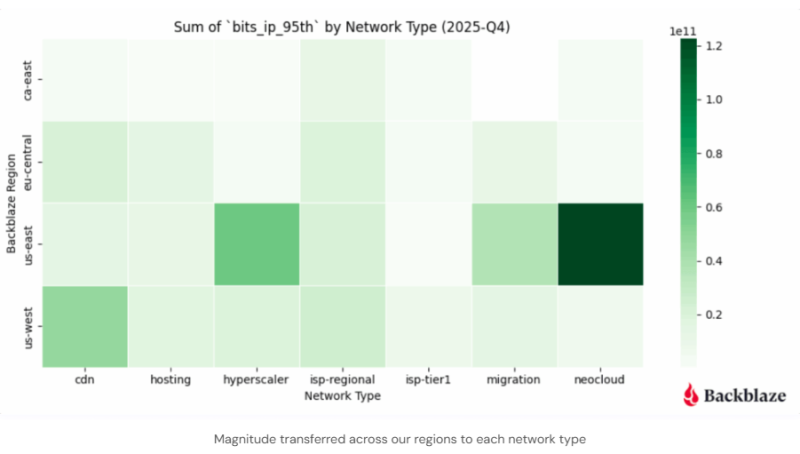

Неооблака «засасывают» ИИ-данные как чёрные дыры, меняя поведение СетиКомпания Backblaze, предоставляющая сервисы облачного хранения, опубликовала доклад Q4 2025 Network Stats, который свидетельствует о росте связанного с искусственным интеллектом трафика в направлении неооблачных провайдеров. Это, как утверждают в компании, свидетельствует о смещении интернет-трендов в сторону оптимизированного для ИИ-задач сетевого поведения, подходящего для масштабного обучения ИИ-моделей и инференса. Данные IV квартала демонстрируют, что массивные датасеты всё чаще передаются короткими, устойчивыми «импульсами» — активность сосредоточена преимущественно в регионе US-East (США). Наблюдается отклонение от привычного, распределённого характера перемещения интернет-трафика, поскольку теперь «гравитация данных» всё сильнее стягивает в единую конфигурацию хранилища, вычисления и сети. Backblaze наблюдала рост связанного с неооблачными провайдерами трафика с июля по ноябрь, пиковых значений он достиг в октябре 2025 года. Вместе отмеченные шаблоны поведения позволяют предположить, что движение больших массивов связанных с ИИ данных остаётся «сконцентрированным» и устойчивым.

Источник изображения: Backblaze Согласно данным Backblaze, ИИ-трафик сконцентрирован в регионе US-East, а связанные с ИИ «транзакции» данных концентрируются близ неооблачных вычислительных хабов в Северной Вирджинии, Нью-Йорке и Атланте, что подчёркивает важность наличия каналов связи с низкой задержкой для задач, связанных с обучением моделей. Нормой становятся потоки информации с «высокой магнитудой» — если раньше трафик передавался, в основном, по принципу «от многих к многим», то теперь речь нередко идёт об устойчивых высокоскоростных соединениях между специализированными системами хранения данных и вычислений. Растут объёмы масштабных миграций данных: трафик, связанный с переносом информации увеличивался с августа по октябрь, что обусловлено передачей больших датасетов по частным ВОЛС.

Источник изображения: Backblaze При этом регион US-West всё ещё имеет критическое значение для пользовательского трафика, пока составляющего большую часть трафика в целом. Там концентрируются точки обмена трафиком, которые позволяют эффективно и с низкой задержкой доставлять контент конечным интернет-пользователям через сети интернет-провайдеров. Как заявляет компания, мало что может изменить сетевое поведение быстрее, чем ИИ. Она и сама предлагает сервис хранения B2 Overdrive, которым пользуются неооблака для работы с LLM. В сентябре 2025 года сообщалось, что среднегодовой темп роста выручки неооблаков за пять лет составил 82 %, а в октябре того же года появились данные, что Квартальная выручка неооблаков выросла на 200 %, а в 2030 году она достигнет $180 млрд.

30.01.2026 [20:45], Руслан Авдеев

Китай тоже планирует строительство гигаваттных космических ЦОДКитай намерен отправить в космос ИИ ЦОД в следующие пять лет, бросив вызов нескольким американским компаниям, сообщает Reuters. Компания China Aerospace Science and Technology Corporation (CASC), главный в КНР космический подрядчик, пообещала построить космическую ИИ-инфраструктуру «гигаваттного класса» в рамках очередной пятилетки, передаёт государственная телерадиокомпания CCTV. Новые космические ЦОД объединят возможности облачных и периферийных устройств, а также позволят добиться глубокой интеграции вычислительных мощностей, систем хранения данных и каналов связи высокой пропускной способности, что позволит обрабатывать данные с Земли в космосе. Американская SpaceX рассчитывает использовать средства от планируемого в 2026 году IPO на $25 млрд для строительства в космосе ИИ ЦОД из-за энергии на Земле. Об этом глава компании Илон Маск (Elon Musk) завил на прошлой неделе на форуме в Давосе. По его словам, это очевидное решение, а первые проекты заработают в ближайшие два, максимум три года. По мнению Маска, солнечные электростанции на орбите смогут генерировать в пять раз больше энергии, чем их аналоги на Земле. Китай также планирует перенести добычу электричества для ИИ-задач в космос, используя хабы гигаваттного класса с солнечным питанием для создания облака Space Cloud «промышленного» уровня к 2030 году. Об это сообщалось в декабре в одном из документов CASC. Последняя включила интеграцию космической солнечной энергетики с ИИ-вычислениями в пятилетний план китайского экономического развития. Также в плане CASC сообщается о намерении развивать космический туризм в течение той же пятилетки. Сейчас Китай и США — основные соперники в космическом пространстве, желающие превратить космические исследования в прикладные коммерческие проекты, а также использовать космическое пространство для достижения военного и стратегического доминирования. CASC пообещала превратить Китай в ведущую космическую державу к 2045 году. Впрочем, пока ключевой проблемой Пекина является отсутствие надёжной многоразовой ракеты, которая уже есть у SpaceX. Это уже позволило компании добиться почти монопольного положения на рынке LEO-спутников (Starlink). CASC также объявила об открытии обучающего центра School of Interstellar Navigation при Китайской академии наук, который поможет подготовить новое поколение кадров в перспективных отраслях, связанных с полётами в глубокий космос. Открытие нового образовательного учреждения свидетельствует об амбициях Китая превратиться из страны, осваивающей околоземное пространство в державу, осваивающую глубокий космос. По данным местных СМИ, следующие 10–20 лет станут «окном» для прорывного развития КНР в сфере «межзвёздной» навигации. Инновации в фундаментальных исследованиях и технологические прорывы должны преобразить картину исследования дальнего космоса. А пока что США и Китай активно конкурируют в попытке вернуть людей на Луну, которую человечество не посещало «лично» с последней миссии «Аполлон» в 1972 году. Сегодня американские проекты космических ЦОД сыплются, словно из рога изобилия. Бывший глава Google Эрик Шмидт (Eric Schmidt) купил Relativity Space, чтобы заняться запуском космических дата-центров. На МКС прибыл прототип орбитального ЦОД Axiom Space. В октябре сообщалось, что NVIDIA поможет Starcloud отправить на орбиту первый ИИ-спутник с ускорителем H100, развернуть облачную платформу на спутнике Starcloud должна была Crusoe. Наконец, в ноябре Google поведала об инициативе Project Suncatcher, предусматривающей использование группировок спутников-ЦОД на основе своих фирменных ИИ-ускорителей. А основатель Amazon и Blue Origin Джефф Безос (Jeff Bezos) пророчит эпоху космических ЦОД гигаваттного масштаба.

30.01.2026 [20:24], Руслан Авдеев

От технологического наследия к построению будущего — Atos перезапустила бренд Bull для HPC, ИИ и квантовых инновацийПечально известная своими финансовыми проблемами французская компания Atos официально перезапустила один из своих ведущих брендов. Теперь Bull позиционируется как глобальный лидер в HPC-, ИИ- и квантовых системах. Bull разрабатывает, внедряет и обслуживает оборудование и ПО, в том числе суперкомпьютеры. Bull позиционируется, как единственный европейский игрок, способный разрабатывать, выпускать и внедрять решения такого класса. Работа поддерживается командой исследователей и инженеров, производственными возможностями и др. Bull, как сообщают в самой компании, позволяет странам и отраслям полностью контролировать свои ИИ-мощности и данные. Бизнес Bull основан на более чем вековом опыте в сфере вычислений и исследований, связанных с data science. Как утверждают в Atos, возрождение Bull — стратегически важная веха на пути бренда к формированию частной, независимой компании после подписания соглашения о покупке акций Францией 31 июля 2025 года. Корни у бренда европейские, но сейчас он, по словам Atos, занимает лидирующие позиции ещё и в Латинской Америке и Индии. Bull владеет полным технологическим стеком, от разработки интегральных микросхем и интерконнектов до ИИ-платформ и приложений. Бренд обеспечивает надёжные решения промышленного уровня для критически важных секторов, включая, например, оборону и энергетику, одновременно снижая совокупную стоимость владения. По словам руководства бренда, с запуском Bull осуществляется «переподключение» к технологическому наследию для строительства будущего. Миссией компании называется обеспечение мощных, устойчивых и суверенных вычислений и ИИ-технологий, позволяющих уверенно и осмысленно внедрять инновации на уровне отраслей и целых наций.

Источник изображения: Bull Примечательна судьба самой Atos Group. Хотя сама компания позиционирует себя как лидера в сфере цифровой трансформации с 63 тыс. сотрудников и ежегодной выручкой €8 млрд, действующим в 61 странах под двумя брендами (Atos для сервисов и Eviden для продуктов), дела у компании идут, мягко говоря, непросто. Atos не первый год теряет выручку по всем направлениям, а будущее компании всё более туманно. Поэтому Atos заключила сделку с французским государством, согласно которой ему будут переданы «золотые акции» Bull SA. После неоднократных попыток спасти компанию, частой смены директоров и даже новостей о её возможной национализации Францией, летом 2025 года появилась информация, что власти Франции сделали предложение купить подразделение Advanced Computing в составе группы Atos.

30.01.2026 [20:00], Руслан Авдеев

США продвигают «атомные кампусы» с ослабленными требованиями к ядерной безопасности, чтобы запитать ИИ ЦОДМинистерство энергетики США (DoE) предлагает штатам разместить у себя «атомные кампусы» (Nuclear Lifecycle Innovation Campuses), которые должны придать второе дыхание атомной энергетике путём снижения требований к безопасности ядерных объектов, сообщает The Register. Фактически речь идёт о том, что на территории кампусов можно будет размещать объекты по обогащению и производству ядерного топлива, а также перерабатывать и хранить радиоактивные отходы. Также возможно строительство ядерных реакторов и размещения снабжаемых их энергией дата-центров. Ранее СМИ сообщали, что администрация действующего президента США рассматривает возможность направить «миллиарды, если не сотни миллиардов долларов» на программу полного ядерного топливного цикла, чтобы ускорить строительство новых реакторов. Штаты должны до 1 апреля 2026 года сообщить о намерении разместить у себя «атомные кампусы», а также заявить, какие стимулы и какая поддержка им нужны. При этом DoE отдаст приоритет проектам, финансируемым за счёт частного капитала и средств штатов, а федеральную поддержку ограничат. Кроме того, властям нужны «надёжные финансовые гарантии», чтобы бремя ответственности в случае неудачи проектов не легло на налогоплательщиков. В 2025 году Министерство энергетики назвало десять компаний, отобранных для тестирования и ускорения работ по проектам реакторов, не связанных с национальными лабораториями в рамках анонсированной президентом США программы Nuclear Reactor Pilot Program. Однако, как передаёт The Register, Министерство энергетики в обстановке секретности переписало директивы, касающиеся ядерной безопасности, смягчив регулирование эксплуатации атомных объектов.

Источник изображения: Dan Meyers/unsplash.com Изменения внесли для того, чтобы ускорить разработку реакторов нового поколения, которые в администрации Трампа рассматривают в качестве источника энергии для ИИ ЦОД и других секторов экономики. Утверждается, что из нормативных документов удалены сотни страниц требований, связанных с обеспечением безопасности реакторов. Сократились требования к документообороту, повысили уровень допустимого уровня облучения работников — до того, как будет инициировано расследование инцидента. Уже не так строго будут защищаться грунтовые воды и окружающая среда. Некоторые учёные уже забили тревогу, говоря, что подтверждаются «худшие опасения» относительно надзора за безопасностью атомной энергетики в период правления действующей администрации. Подчёркивается, что министерство не просто разрушило основы регулирования атомной отрасли, но и сделало это тайно, хотя текущие нормы разрабатывались с учётом катастроф в Чернобыле и на Фукусиме. Любые новые проекты в сфере атомной энергетики по-прежнему должны получать лицензии Комиссии по ядерному регулированию США (NRC) для коммерческой энергогенерации, но ведомство якобы уже согласилось ограничить объём проверок безопасности для объектов, получивших одобрение DoE. Трамп и его сторонники активно продвигают расширение атомных генерирующих мощностей в США. Ещё в июле 2025 года сообщалось, что власти страны выделили федеральные земли для строительства ЦОД и электростанций. В сентябре сообщалось, что бум атомной энергетики обойдётся США в $350 млрд инвестиций, а выработка энергии к 2025 году увеличится на 63 %. Наконец, Deloitte заявляла, что АЭС смогут обеспечить 10 % будущего спроса ЦОД США на электроэнергию, но строить их придётся быстрее.

30.01.2026 [10:54], Владимир Мироненко

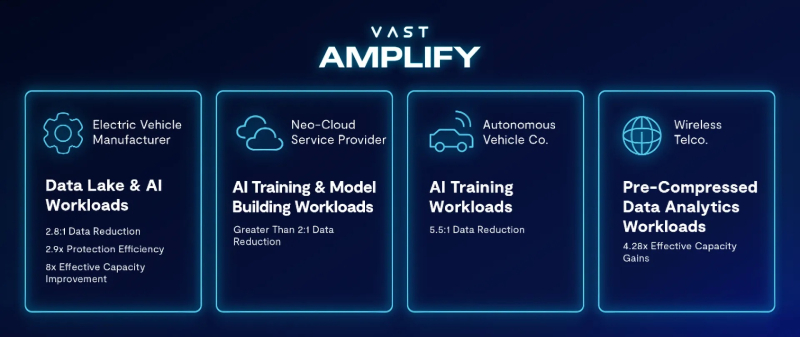

Спасите наши SSD: VAST Data запустила программу VAST Amplify для повышения эффективности использования имеющихся накопителейВ ответ на растущий дефицит флеш-памяти компания VAST Data, специализирующаяся на инфраструктуре для ИИ, представила программу VAST Amplify, разработанную для того, чтобы помочь организациям увеличить эффективную ёмкость имеющихся у них SSD. Взаимодействие компании с клиентом в рамках VAST Amplify проходит в несколько этапов. Сначала производится исследование инфраструктуры, в ходе которого VAST анализирует всю среду хранения данных клиента, чтобы выявить участки недоиспользуемых SSD, фрагментации между разрозненными системами и связанные с устаревшей архитектурой потери, которые снижают эффективную ёмкость. Затем следует быстрая квалификация платформы — процесс быстрой сертификации существующих серверов и SSD клиента для использования в экосистеме VAST, позволяющий обойти зависимость от новых окон распределения оборудования. После этого с помощью восстановления и интеграции мощностей перепрофилированное оборудование объединяется в единое унифицированное пространство имён на базе ОС VAST AI. Это преобразует фрагментированную, привязанную к серверам флеш-память в глобально доступный пул высокопроизводительного хранилища, где мощность может динамически распределяться для любого приложения, устраняя ограничения, связанные с серверными границами или устаревшими архитектурами. Защита данных осуществляется на уровне платформы с использованием высокоэффективного кодирования с исправлением ошибок, а не традиционных методов, требующих интенсивной репликации и потребляющих в два-три раза больше «сырого» места. Это увеличивает полезную ёмкость при сохранении отказоустойчивости в масштабе. Как сообщается, программа обеспечивает шестикратное увеличение эффективной ёмкости, благодаря использованию базовой архитектуры VAST Data — Disaggregated Shared Everything (DASE) — и набору передовых программных технологий. В отличие от традиционных систем, которые выполняют редукцию данных в изолированных узлах или томах, подход VAST является глобальным и всеобъемлющим. Одним из ключевых элементов является непрерывная глобальная редукция на основе сходства. Эта технология ищет и устраняет повторяющиеся паттерны данных по всему кластеру хранения, а не только в одном файле, наборе данных или томе. Это позволяет существенно увеличить эффективную ёмкость при фиксированном объёме флеш-памяти, особенно в ИИ-средах, где наборы обучающих данных могут содержать огромное количество похожей или дублирующейся информации. Большую роль играет архитектура записи, оптимизированная для SCM (Storage Class Memory). Все входящие данные сначала записываются в сверхбыстрый SCM-буфер, что позволяет системе «поглощать» случайные и «импульсные» записи, а затем интеллектуально организовывать и записывать данные на базовые SSD большими последовательными блоками, что снижает коэффициент усиления записи, повышает износостойкость и срок службы флеш-накопителей, поддерживая при этом низкую задержку без необходимости использования дорогостоящего оборудования с избыточным резервированием. Благодаря сочетанию этих методов, операционная система VAST AI OS позволяет значительно увеличить эффективную ёмкость при фиксированном объёме физической флеш-памяти, говорит компания. Впрочем, Dell, крупный поставщик более традиционных СХД, не одобряет подход VAST Data, который фактически подразумевает использование б/у SSD.

30.01.2026 [10:43], Сергей Карасёв

Lightmatter представила оптический VLSP-движок Guide для ИИ-платформ нового поколенияКомпания Lightmatter, специализирующаяся на разработке ИИ-ускорителей и других продуктов на основе фотоники, объявила о «фундаментальном прорыве» в лазерной архитектуре для систем передачи данных: представлена т.н. платформа сверхмасштабируемой фотоники — Very Large Scale Photonics (VLSP). Первым изделием на её основе стал оптический движок Guide, ориентированный на ИИ-системы следующего поколения. Отмечается, что современные решения CPO (Co-Packaged Optics) и NPO (Near-Package Optics) базируются на дискретных лазерных диодах на основе фосфида индия (InP), интегрированных в модули ELSFP (External Laser Small Form Factor Pluggable). Однако эти архитектуры сталкиваются с трудностями, обусловленными ограничениями по мощности. Компоненты, при изготовлении которых используется эпоксидная смола, уязвимы к термическому повреждению. Вместе с тем для удвоения полосы пропускания требуется кратное увеличение количества ELSFP, что приводит к соответствующему повышению стоимости и энергопотребления, а также к увеличению занимаемого пространства. Кроме того, в случае дискретных лазеров могут возникать проблемы с обеспечением точного разнесения длин волн. Изделие Guide VLSP, как утверждается, устраняет существующие ограничения. Новая интегрированная архитектура по сравнению с дискретными лазерными модулями позволяет сократить количество компонентов, предлагая при этом значительно более высокую производительность и улучшенную надёжность. Технология предусматривает возможность масштабирования от 1 до 64+ длин волн при одновременном снижении сложности сборки. В результате значительно повышается плотность компоновки: платформа Guide первого поколения обеспечивает коммутационную способность до 100 Тбит/с в 1U-шасси. Для сравнения, в случае обычных решений потребовалось бы 18 модулей ELSFP в шасси высотой 4U. Движок Guide используется в валидационных платформах Passage M-Series и L-Series (Bobcat). Говорится, что изделие обеспечивает пропускную способность до 51,2 Тбит/с на лазерный модуль в случае NPO и CPO. Выходная мощность составляет не менее 100 мВт в расчёте на оптическое волокно. Возможна генерация 16 длин волн с мультиплексированием. Поддерживаются двунаправленные фотонные каналы связи, в которых две сетки длин волн с шагом 400 ГГц чередуются с точным смещением на 200 ГГц (±20 ГГц). Новая платформа уже доступна заказчикам для тестирования. Между тем компания Lightmatter сообщила о заключении сразу нескольких партнёрских соглашений. В частности, планируется интеграция решений Synopsys в платформу Lightmatter Passage 3D Co-Packaged Optics. В сотрудничестве с Global Unichip Corp. (GUC) Lightmatter намерена заняться разработкой CPO-продуктов для гиперскейлеров, ориентированных на ИИ. Кроме того, Lightmatter и Cadence объединили усилия с целью ускорения разработки передового интерконнекта для ИИ-инфраструктур.

29.01.2026 [23:55], Владимир Мироненко

Непоколебимая вера в ИИ: Meta✴ удвоит капзатраты в 2026 годуMeta✴ Platforms сообщила финансовые результаты IV квартала и всего 2025 года, завершившегося 31 декабря 2025 года. Выручка компании за квартал составила $59,89 млрд, что больше год к году на 24% при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $58,59 млрд (по данным CNBC). При этом чистая прибыль выросла год к году на 9% до $22,77 млрд. Прибыль на разводнённую акцию составила $8,88 (+11%), что выше прогноза от LSEG в размере $8,23 на разводнённую акцию. За 2025 год выручка Meta✴ достигла $200,97 млрд, увеличившись год к году на 22%. Чистая прибыль составила $60,46 млрд (падение на 3%) или $23,49 на разводнённую акцию. В I квартале 2026 года компания прогнозирует выручку в пределах от $53,5 до $56,5 млрд, что немного меньше результата IV квартала, но выше прогноза аналитиков, опрошенных LSEG, в размере $51,41 млрд. На фоне этого прогноза выручки, превзошедшего ожидания экспертов, акции Meta✴ подскочили на 10%. Meta✴ заявила, что общие расходы в 2026 году составят от $162 до $169 млрд. При этом капитальные затраты, связанные с ИИ, в 2026 году, как ожидается, составят от $115 до $135 млрд, что превышает прогнозы аналитиков в $110,7 млрд. Это почти вдвое больше, чем капитальные затраты компании в 2025 году, которые составили $72,2 млрд. Роста затрат направлен на поддержку подразделения Meta✴ Superintelligence Labs (MSL), а также основной повседневной деятельности компании, заявила финансовый директор Сьюзан Ли (Susan Li). Ранее компания пообещала потратить $600 млрд на ИИ ЦОД, инфраструктуру и кадры. В начале этого месяца компания Meta✴ представила новую инициативу под названием Meta✴ Compute, направленную на расширение ИИ-инфраструктуры и улучшение управления своей растущей сетью ИИ ЦОД, заявив о планах построить десятки гигаватт мощностей в течение этого десятилетия и сотни гигаватт в будущем. Meta✴ считает, что эта ставка на развитие ИИ окупится с лихвой. «Несмотря на значительное увеличение инвестиций в инфраструктуру, в 2026 году мы ожидаем получить операционную прибыль, превышающую прибыль 2025 года», — сказала Ли. Глава компании Марк Цукерберг (Mark Zuckerberg) считает значительные затраты оправданными, отметив, что Meta✴ сейчас наблюдает значительное ускорение развития ИИ: «Я ожидаю, что 2026 год станет годом, когда эта волна ещё больше ускорится по нескольким направлениям. Мы начинаем видеть, как агенты действительно работают. Это откроет возможности для создания совершенно новых продуктов и трансформирует наш подход к работе». «Мы начинаем видеть потенциал ИИ, который понимает наш личный контекст, включая нашу историю, наши интересы, наш контент и наши отношения. Ценность агентов во многом обусловлена уникальным контекстом, который они могут видеть», — отметил глава Meta✴. По его словам, Meta✴ также работает над объединением больших языковых моделей (LLM) с системами рекомендаций, которые лежат в основе Facebook✴, Instagram✴, Threads и ёе рекламных систем, что, как ожидается, позволит увеличить доходы от рекламы. Т.е. рост вложений в инфраструктуру связан и с увеличением сложности и размера своих ИИ-моделей, которые должны помочь в подборе рекламных объявлений для пользователей. В IV квартале компания уже удвоила количество ускорителей, используемых для обучения генеративной модели ранжирования рекламы GEM (Generative Ads Recommendation Model), позволяющей в реальном времени определять, какие объявления будут максимально уместными для конкретного пользователя. «Сегодня наши системы помогают людям оставаться на связи с друзьями, понимать мир и находить интересный и развлекательный контент. Но вскоре мы сможем понимать уникальные личные цели людей и персонализировать ленты, чтобы показывать каждому человеку контент, который помогает ему улучшить свою жизнь так, как он этого хочет», — заявил Цукерберг.

29.01.2026 [22:49], Андрей Крупин

«Мегафон» построил частную LTE‑сеть протяжённостью более 530 кмОператор «Мегафон» сообщил о завершении масштабного проекта по созданию частной LTE‑сети для предприятия «Эльгауголь», управляющего комплексом активов по добыче и транспортировке угля. Развёрнутая телекоммуникационной компанией сетевая инфраструктура объединила три ключевых объекта угледобывающего холдинга: Эльгинское угольное месторождение, порт «Эльга» и Тихоокеанскую железнодорожную ветку. Это позволило создать крупнейшую в России Private LTE‑сеть протяжённостью более 530 километров, которая обеспечивает голосовую связь, передачу данных, телеметрию и позиционирование техники. Решение позволяет координировать логистику, управлять производственными процессами и внедрять промышленные IoT‑сервисы.

Источник изображения: Lightsaber Collection / unsplash.com Проект реализовывался в несколько этапов. Первый стартовал в 2022 году на месторождении и стал основой для цифровизации производственных процессов предприятия. В 2024 году сеть была модернизирована: расширено покрытие и увеличена скорость мобильного интернета, построены дополнительные базовые станции для работы на труднодоступных участках. Также была запущена вторая очередь проекта в порту «Эльга», что обеспечило полное покрытие производственной зоны. Завершающим этапом стало строительство сети вдоль Тихоокеанской железной дороги от Якутии до Хабаровского края. Специалисты «Мегафона» установили несколько десятков базовых станций, обеспечив мобильное покрытие на всём протяжении железнодорожной линии. Это повысило безопасность и надёжность движения поездов, а также позволило в режиме реального времени контролировать перемещение техники и грузов.

29.01.2026 [18:20], Руслан Авдеев

ИИ и облака вместо телефонов: Telefónica превратит десятки «медных» АТС в периферийные ЦОДИспанский оператор связи и ЦОД Telefónica ускоряет реализацию стратегии расширения периферийных вычислений. Для этого компания переоборудует ненужные более телефонные АТС с медными компонентами в мини-ЦОД на 1–2 МВт. Среднесрочная цель — развернуть в стране более 100 таких узлов, сообщает Datacenter Dynamics. После полного отключения аналоговой телефонной связи в Испании большое количество АТС с медными кабельными системами осталось без дела, поэтому Telefónica España начала переделывать их в распределённые периферийные ЦОД небольшой мощности. Новые ЦОД ориентированы на предоставление ИИ и облачных сервисов с низкой задержкой — они находятся вблизи от конечных потребителей и призваны укрепить цифровой суверенитет страны. На сегодня уже эксплуатируется 12 подобных узлов, коммерческие услуги компания намерена начать предоставлять после завершения тестовой фазы. На горизонте 5–7 лет планируется развернуть более 100 таких дата-центров. Вторую жизнь получит и сеть связанных электростанций. Новые edge-узлы интегрируют с ВОЛС и 5G-сетями. Новый план — часть общеевропейского проекта развития периферийных вычислений, в его рамках Telefónica выделена субсидия в размере €93 млн ($111 млн). Компания дополнила её собственными средствами, хотя объёмы инвестиций не раскрываются. Также в европейском проекте участвуют телеком-операторы Orange, Deutsche Telekom и Telecom Italia.

Источник изображения: Telefonica К концу 2026 года Telefónica рассчитывает запустить ещё 17 периферийных узлов, дополняя свои лидирующие позиции в сегментах FTTH — на её долю приходится более 31 млн подключенных домохозяйств — и 5G, это способствует цифровой трансформации в стране. Telefónica отмечает, что её т.н. Edge Plan выводит Испанию на передний край инноваций в Европе в контексте обеспечения технологического суверенитета, позволяя создавать местную инфраструктуру без помощи «неевропейских» вендоров. Периферийная архитектура комбинирует эластичность облака с возможностью обработки данных в непосредственной близости от их источника. Это минимизирует задержки и в то же время обеспечивает соответствие сопутствующих процессов европейским правовым нормам. Стремление обрести технологический суверенитет, в первую очередь от США, в последнее время стало ключевым вектором деятельности для многих европейских компаний и политиков. Так, Франция в январе 2025 года объявила, что местных госслужащих переведут с Zoom и Teams на суверенный видеочат Visio. Суверенные решения предлагают европейцам и европейские компании вроде SAP, а вот техногиганты из США не пользуются былой популярностью — не так давно Microsoft признала что не может обеспечить настоящий суверенитет европейских данных, поскольку вынуждена подчиняться в первую очередь законам США. |

|