Лента новостей

|

10.03.2026 [09:34], Владимир Мироненко

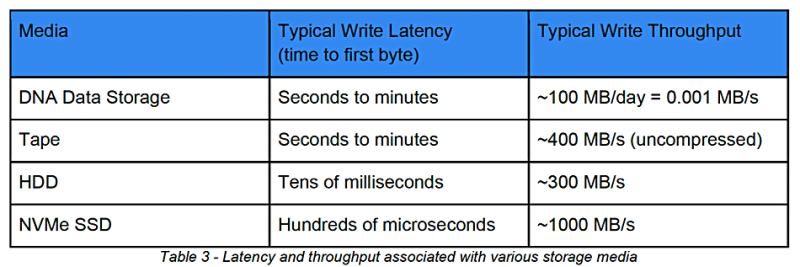

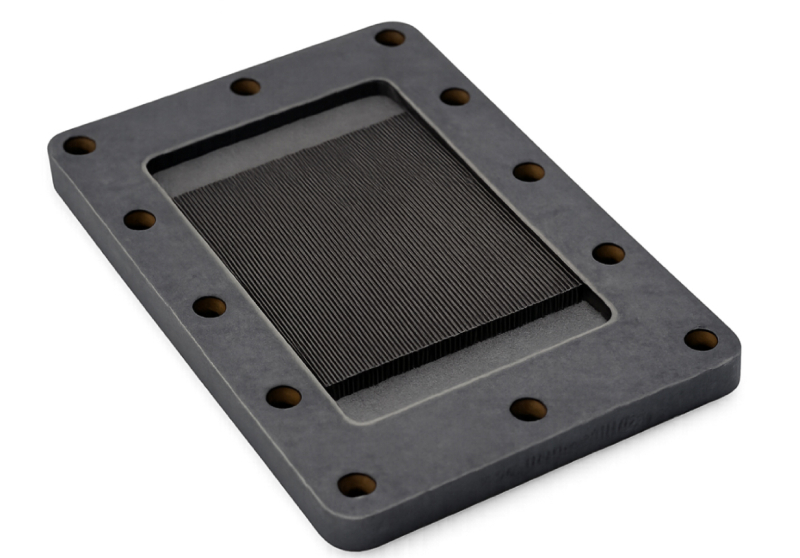

Biomemory вот-вот представит ЦОД-решение для хранения данных на основе ДНКФранцузская компания Biomemory, специализирующаяся на разработке решений в области СХД на основе ДНК для IT-индустрии и кибербезопасности, объявила о приобретении активов у Catalog Technologies, «бостонского пионера в области хранения и обработки данных на основе ДНК». Хранение данных на основе ДНК подходит для архивирования, регулируемых и обучающих наборов данных для ИИ, а также для записей о соответствии требованиям и критически важных резервных копий, пишет Blocks & Files. Обе компании разрабатывают технологии хранения данных на основе ДНК, которые кодируют цифровую информацию в синтетическую ДНК, полученную из бактерий, и редактируют её с помощью ферментов. Обе используют сопоставление цифровых данных с биобезопасными (защищёнными от несанкционированного доступа, кражи или утечки) блоками ДНК вместо попарного синтеза ДНК. Это позволяет повысить скорость чтения и снизить количество ошибок, а также открывает возможности для поиска и вычисления непосредственно в структурах данных ДНК. Catalog первой на рынке создала промышленные машины для записи данных на ДНК — в 2018 году она представила первый прототип устройства Shannon. Также Catalog запатентовала метод поиска данных в СХД на основе ДНК. Biomemory разрабатывает картриджи для хранения данных на основе ДНК, которые совместимы с существующим «железом» и ПО. «Мы работаем над оборудованием, которое можно устанавливать в стойку и которое по форм-фактору подходит для ЦОД», — сообщил ресурсу Techtarget Оливье Ловре (Olivier Lauvray), вице-президент по индустриализации и партнёрским отношениям в Biomemory. Biomemory позиционирует своё решение как ещё один уровень хранения с S3-доступом. В Biomemory сообщили, что технологии компаний «синергетически дополняют друг друга, сочетая ферментативную биозащищённую (защищённую от воздействия опасных биологических факторов) сборку блоков ДНК с масштабируемой высокоскоростной печатью, высокопроизводительным считыванием и низким уровнем ошибок». Сделка также расширяет присутствие в Северной Америке Biomemory, получившей офис в Бостоне и ключевых экспертов из Catalog для исследований и разработки, производства и поддержки. Благодаря сделке Biomemory сможет ускорить внедрение решений корпоративного уровня для безопасного хранения и обработки данных ДНК, и, используя свой запатентованный метод массового производства биобезопасной ДНК и ферментных расходных материалов, обеспечить конкурентоспособные операционные затраты (OpEx). Модульная, дружественная к ИТ-инфраструктуре архитектура и протокол квалификации, аналогичный ISO, позволяют быстро адаптироваться к приобретенной технологии, ПО и оборудованию. Biomemory DNA Card — запатентованный контейнер для надёжного хранения данных в течение 50, 100 или 150 лет с низким показателем неисправимых ошибок (UBER) и уникальным способом обеспечения пожизненной читаемости — в сочетании с решениями Catalog поможет быстро создать новые коммерческие решения для хранения данных или обеспечения кибербезопасности. Согласно пресс-релизу, многослойные решения для 3D-печати от Biomemory в сочетании с крупномасштабной высокопроизводительной печатью от Catalog ускорят уплотнение и миниатюризацию ДНК-хранилищ. Biomemory стремится стать первым поставщиком ДНК-хранилищ данных, развёрнутых в ЦОД. Первые коммерческие решения с использованием приобретённых активов компания планирует запустить во II половине 2026 года. По словам Ловре, потребуется примерно год, чтобы воспользоваться всеми разработками Catalog, и ещё два-три года, чтобы запустить производство принтеров и ДНК-карт для закупки предприятиями. В 2027 году Biomemory планирует построить и эксплуатировать собственные ЦОД для предложения клиентам в качестве услуги. Брент Эллис (Brent Ellis), ведущий аналитик Forrester Research, считает, что Biomemory предстоит преодолеть ещё немало препятствий, прежде чем она сможет выпустить коммерчески жизнеспособный продукт или услугу. Первая из проблем — наличие потенциального рынка для хранения данных ДНК. Эллис утверждает, что рынок слишком мал и большинству корпоративных организаций не нужна такая долговременная сохранность данных. «Более того, по прошествии определённого времени наличие данных становится обузой», — отметил он. Хранение данных в ДНК также имеет практические проблемы, такие как гораздо более низкая скорость чтения/записи по сравнению с конкурирующими методами долговременного архивирования, необходимость в специализированном оборудовании и ещё не достигнутые прорывы в масштабировании. В отчёте SNIA от 2025 года выражались аналогичные сомнения относительно возможности коммерциализации СХД на основе ДНК до конца этого десятилетия. Microsoft прекратила участие в разработке ДНК-хранилищ, отметив, что это «просто не даёт ожидаемого прироста на порядки». «Сторонники хвалили экстремальную плотность, но неясно, насколько это вообще актуально», — передаёт TechRadar. К тому же, есть конкурирующие предложения, например, доступное голографическое хранилище данных компании HoloMem, недавно завершивший первое пробное развёртывание своей системы хранения HoloDrive в существующей ленточной библиотеке. Компания намерена сделать голографическое хранение пригодным для массового производства к 2027 году. Хранение ДНК на порядки менее плотное, чем при использовании голографии, в то время как HoloMem и конкурирующие поставщики уже находятся в терабайтном диапазоне, отметил аналитик.

09.03.2026 [22:22], Руслан Авдеев

Google выделила $50 млн на устранение суперзагрязнителей из окружающей средыКомпания Google присоединилась к инициативе Super Pollutant Action, обязавшись выделить до 2030 года $50 млн на удаление из окружающей среды т.н. «суперзагрязнителей» — веществ, более опасных для атмосферы и климата, чем углекислота, в т.ч. метан и фторсодержащие газы. В инициативе уже участвуют компании Amazon и др., в общей сложности рассчитывающие инвестировать $100 млн, сообщает Datacenter Dynamics. Предполагается, что собранные средства помогут нарастить финансирование проектов, снижающих использование суперзагрязнителей. Организатором инициативы выступила коалиция Beyond Alliance, уделяющая основное внимание решениям, способным благоприятно сказаться на климате уже в ближайшей перспективе. Для этого предлагается масштабировать инвестиции в высокоинтегрированные климатические решения и снижение выбросов парниковых газов помимо CO2. По некоторым данным, на суперзагрязнителях различной природы лежит минимум половина вины за глобальное потепление. По словам Google, суперзагрязнители являются «ключевой» частью уравнения, призванного снизить глобальное потепление. Сокращение их использования — жизненно важная мера наряду с удалением из атмосферы избыточной углекислоты. Коалиция Beyond Alliance будет отвечать за исследования, доклады и информацию о проблеме. Она же составит план действий на ближайщее время. По мнению Beyond Alliance, сейчас решающее десятилетие для климата. Снижение уровня суперзагрязнителей — одна из мер, которая может быстро трансформировать кривую климатических изменений. Сообщается что инициатива демонстрирует, как частный капитал может применяться там, где это нужнее всего — для минимизации глобального потепления, улучшения качества воздуха и незамедлительного достижения измеримых результатов. Google уже поддержала ряд компаний, ищущих способы удаления суперзагрязнителей с помощью различных технологий. Например, в мае 2025 года она помогла Recoolit и Cool Effect в проекте, призванном устранить из атмосферы более 25 тыс. тонн суперзагрязнителей к 2030 году. В сентябре того же года она заключила соглашение с компанией Vaulted Deep об утилизации 50 тыс. тонн соответствующих отходов. Впрочем, дисбаланс в сфере защиты окружающей среды сегодня заметен, как никогда. Не так давно сообщалось, что операторы дата-центров используют всё больше экологически небезопасных газовых турбин, а в конце февраля 2026 года появились данные, что корпоративные закупки «чистой» энергии впервые упали в 2025 году после почти 10 лет роста. При этом практически в то же время сообщается, что Microsoft на 100 % компенсировала свои затраты энергии с помощью возобновляемой энергетики.

09.03.2026 [16:39], Владимир Мироненко

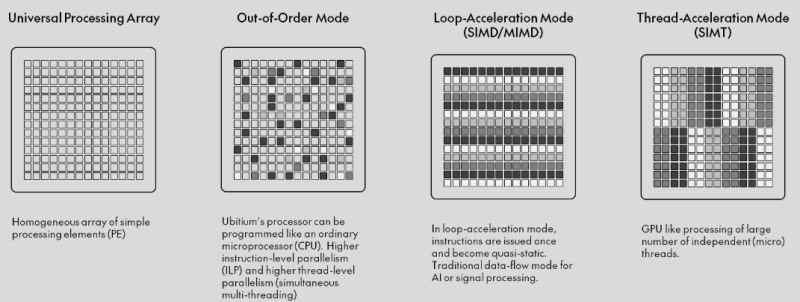

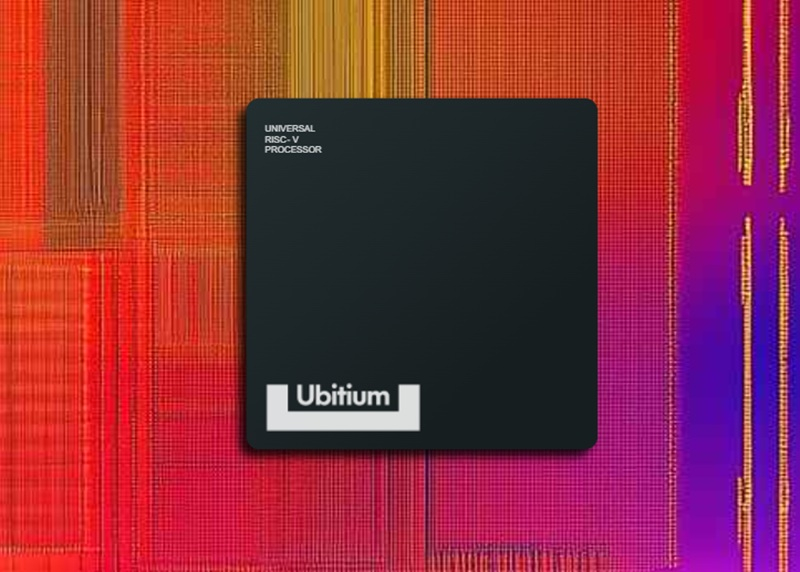

Ubitium стала на шаг ближе к выпуску универсального RISC-V процессора, заменяющего CPU, GPU, DSP и FPGAНемецкий стартап Ubitium объявил о завершении стадии tape-out (финальный этап проектирования) универсального RISC-V-процессора, изготовленного по 8-нм техпроцессу Samsung Foundry и предназначенного для рынка встроенных вычислительных систем автомобилей, промышленного оборудования и бытовой электроники, включая радарные и многосенсорные сигнальные цепи, аудио и голосовую связь в реальном времени, компьютерное зрение, периферийный ИИ, промышленный человеко-машинный интерфейс (HMI) и т.д. В основе процессора Ubitium лежит «универсальный процессорный массив» (Universal Processing Array) — программно-определяемая система с 256 элементами, объединяющая функции CPU, GPU, DSP и FPGA и способная мгновенно менять режимы выполнения во время работы. Такая унификация позволяет чипу переключаться между режимом работы в качестве CPU общего назначения для обслуживания ОС и режимом работы в качестве ИИ-ускорителя, избегая задержек при передаче данных между отдельными чипами.

Источник изображения: Ubitium Завершение tape-out на 8-нм техпроцессе Samsung подтверждает работоспособность основного процессорного массива и интерфейса LPDDR5. Для Ubitium доказательство того, что один процессор может обрабатывать общие вычислительные задачи, задачи обработки в реальном времени и задачи ИИ на одном кристалле, является важным шагом на пути к коммерческой жизнеспособности, отметил EE Times. «Это решение претворяет давно существующую концепцию в жизнь», — заявил Мартин Форбах (Martin Vorbach), технический директор Ubitium. «Встроенные системы переросли архитектуры, на которые сегодня опирается отрасль. Консолидация больше не является необязательной. Она неизбежна», — добавил он. Технология, лежащая в основе этого проекта, совершенствовалась более 15 лет. Для её воплощения в жизнь Форбахом совместно с рядом специалистов была создана в 2024 году компания Ubitium. Ускорить разработку позволило привлечение $3,7 млн в рамках посевного раунда в конце прошлого года, который совместно возглавили Runa Capital, Inflection и KBC Focus Fund. Инвестиции позволили Ubitium проверить архитектуру и подготовить наборы для разработки (IDK) для первых клиентов. «Индустрия процессоров объёмом $500 млрд построена на жёстких границах между вычислительными задачами», — сказал Хён Шин Чо (Hyun Shin Cho), генеральный директор Ubitium и соучредитель. — Мы стираем эти границы. Наш универсальный процессор делает всё — CPU, GPU, DSP, FPGA — на одном чипе, в одной архитектуре. Это не просто постепенное улучшение. Это смена парадигмы. Это архитектура процессора, которую требует эпоха ИИ». Как отметил EE Times, завершение tape-out продукта — это не просто большая победа для Ubitium. Это также поворотный момент для экосистемы RISC-V. Открытая архитектура RISC-V используется большей частью для создания обычных ядер, которые полагаются на внешние ускорители для сложных рабочих нагрузок. Ubitium расширяет границы использования архитектуры, сохраняя полную совместимость с RISC-V. Процессор поддерживает стандартные наборы инструментов RISC-V для разработки ПО и может работать под управлением Linux и RTOS. Кроме того, унифицированный программный стек устраняет необходимость в компиляторах для конкретного поставщика или проприетарных языках, что позволяет быстро внедрять инновации и сократить время разработки. Компания сотрудничает с Samsung Foundry и ADTechnology для завершения проектирования и с Siemens Digital Industries Software — для проверки микросхемы (pre-silicon validation). Вторая стадия tape-out запланирована на конец этого года, а серийное производство начнётся в 2027 году, сообщила компания.

09.03.2026 [15:46], Руслан Авдеев

Договаривайтесь заранее: Sandisk пообещала скидки предусмотрительным клиентам с долгосрочными контрактамиПо словам главы Sandisk Дэвида Геклера (David Goeckeler), компания стремится к заключению долгосрочных соглашений о поставке NAND-памяти клиентам, представляющим индустрию дата-центров. Рынок памяти находится на этапе структурных изменений, вызванных спросом со стороны ИИ-проектов. Многолетние контракты обеспечат баланс предсказуемого спроса и привлекательных экономических условий — это позволит отойти от традиционно применявшейся в отрасли поквартальной модели ценообразования. Sandisk подчёркивает, что в новой реальности соглашения превратились из инструментов переговоров о ценах в критически важные механизмы обеспечения поставок, поскольку индустрия ЦОД нуждается в крупных и долгосрочных поставках NAND-памяти. Sandisk рассчитывает, что на ЦОД будет приходиться крупнейшая доля рынка NAND-памяти в календарном 2026 году, рост составит 20–60 % в течение двух циклов прогнозирования. В минувшем квартале производитель сообщал о последовательном увеличении продаж в сегменте дата-центров на 64 %, после роста в 20 % в предыдущем отчётном периоде. Изменения свидетельствуют о фундаментальной трансформации рынка, поскольку гиперскейлерам требуется прогнозируемое предложение для удовлетворения растущих потребностей в оборудовании. Клиенты Sandisk уже передают компании прогнозы спроса до 2028 года включительно, теперь речь идёт об обсуждении соглашений сроком на 1–5 лет. Sandisk стремится добиться привлекательных и стабильных финансовых результатов своей деятельности. Кроме того, компания рассчитывает сформировать портфолио механизмов фиксированного и гибкого ценообразования, чтобы обеспечить оптимальные результаты в разных рыночных условиях. Подчёркивается, что клиенты, готовые к долгосрочным обязательствам, получат приоритетные поставки в условиях дефицита предложения. Те, кто предпочитает договариваться ежеквартально, могут оказаться в менее выгодной ситуации, столкнувшись с нехваткой компонентов. Sandisk намерена и дальше ежегодго наращивать производство памяти на уровне 15–19 %, к концу 2026 года основными станут чипы BiCS8. Слухи о возможном переходе к BiCS10 для удовлетворения спроса опровергаются — для закрытия текущих потребностей рынка достаточно имеющихся производственных мощностей. На SanDisk приходится приблизительно 25 % рынка периферийных вычислений. Сейчас она расширяет портфолио SSD для корпоративных клиентов. Проводятся квалификационные испытания продуктов гиперскейлерами, в т.ч. QLC SSD ёмкостью 128 Тбайт под кодовым названием Stargate, в финансовых отчётах поставки которых ещё не отмечены. Также совместно с южнокорейской SK Hynix разрабатывается память HBF. Ожидается, что прототипы соответствующих кристаллов появятся уже к концу 2026 года, а готовые для тестирования клиентами варианты — годом позже. Работу совместного предприятия Sandisk и Kioxia продлили ещё на пять лет, т.е. Sandisk обеспечила себе производственные мощности до 2034 года. Благодаря этому компания сможет инвестировать в исследования и разработки на уровне, сопоставимом с лидерами рынка, сохраняя лидерство по минимизации издержек.

09.03.2026 [13:59], Сергей Карасёв

Евросоюз анонсировала инициативу EURO-3C по созданию федеративной IT-инфраструктурыЕвропейская комиссия анонсировала инициативу EURO-3C, которая предполагает формирование федеративной инфраструктуры «телекоммуникации — облако — периферия». На реализацию проекта выделяется €75 млн. Главной целью инициативы является обеспечение цифрового суверенитета. Финансирование осуществляется по программе Horizon Europe, которая направлена на развитие исследований и инноваций. Ключевые задачи — решение глобальных проблем, цифровая трансформация и повышение конкурентоспособности европейской экономики. EURO-3C предполагает предоставление передовых цифровых услуг исключительно через региональную европейскую инфраструктуру. Такой подход поможет снизить зависимость от провайдеров из третьих стран, что важно в условиях сложившейся геополитической обстановки. Речь идёт об объединении телекоммуникационных сетей, периферийных вычислений и облачных сервисов в единую интегрированную среду, которая предоставит потребителям доступ к высокоскоростным и безопасным сервисам. Новая инициатива, как отмечается, соответствует целям предлагаемого закона Digital Networks Act, направленного на укрепление телеком-сектора, развитие высокоскоростных сетей (5G/6G) и усиление кибербезопасности. Кроме того, ожидается дальнейшее расширение сферы ИИ. В рамках EURO-3C объединятся ведущие европейские компании и организации: телекоммуникационные операторы, поставщики облачных услуг, разработчики ПО, производители оборудования, научно-исследовательские институты и пр. В общей сложности свой вклад в реализацию проекта внесут почти 90 учреждений.

09.03.2026 [13:15], Сергей Карасёв

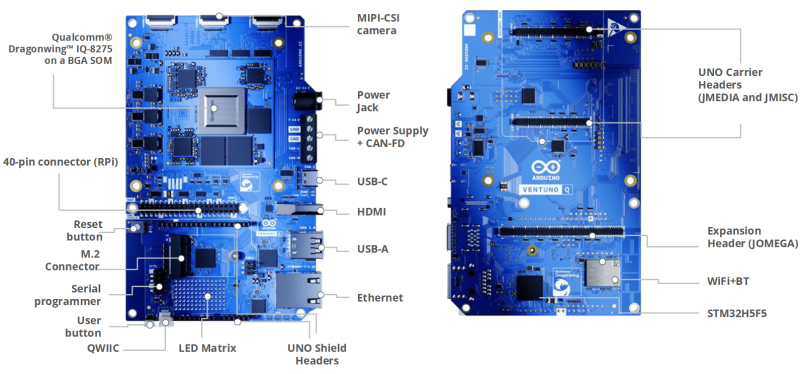

Arduino представила одноплатный компьютер Ventuno Q для ИИ-роботовУчастники проекта Arduino расширили ассортимент одноплатных компьютеров, анонсировав решение Ventuno Q: это старший собрат модели Uno Q, дебютировавшей в октябре прошлого года. Новинка предназначена для построения различных устройств с ИИ-функциями, таких как роботизированные платформы, системы машинного зрения, решения с распознаванием жестов и речи и пр. В основу Ventuno Q положен процессор Qualcomm Dragonwing IQ-8275. Чип содержит восемь вычислительных ядер Kryo с тактовой частотой до 2,35 ГГц, графический ускоритель Adreno 623 с поддержкой OpenGL ES 3.2, блок обработки изображений Spectra 690 и цифровой сигнальный процессор Hexagon. Заявленная ИИ-производительность достигает 40 TOPS. Говорится о возможности использования до 12 камер, двух дисплеев, памяти LPDDR5x-3200, интерфейсов USB 3.1, Ethernet и PCIe. В дополнение к процессору Dragonwing IQ-8275 задействован микроконтроллер реального времени STMicroelectronics STM32H5 на основе ядра Arm Cortex-M33 с частотой до 250 МГц, отвечающий за работу сенсоров, силовых приводов и пр. Основной процессор работает под управлением Ubuntu/Debian, тогда как микроконтроллер STM32H5 использует Arduino Core на базе Zephyr OS. Одноплатный компьютер несёт на борту 16 Гбайт LPDDR5, флеш-накопитель eMMC вместимостью 64 Гбайт, контроллеры Wi-Fi и Bluetooth, а также сетевой адаптер 2.5GbE. Кроме того, предусмотрен коннектор М.2 для дополнительного SSD. Реализованы интерфейсы MIPI-CSI (4 линии), MIPI-DSI, порты USB Type-C, USB Type-А и HDMI, а также 40-контактная колодка, совместимая с Raspberry Pi. Среди прочего упомянуты матрица светодиодов 13 × 8, коннекторы JMISC, JMEDIA и JOMEGA. Могут применяться модули Arduino Modulino, сенсоры Qwiic и платы Raspberry Pi Hat. В продажу Arduino Ventuno Q поступит во II квартале 2026 года. Приобрести одноплатный компьютер можно будет через магазин Arduino Store, а также через площадки реселлеров, включая DigiKey, Farnell, Macfos, Mouser и RS.

09.03.2026 [13:14], Сергей Карасёв

Индустриальный мини-компьютер AAEON Intelli TWL01 Edge поддерживает два 4K-дисплеяКомпания AAEON анонсировала компьютер небольшого форм-фактора Intelli TWL01 Edge, предназначенный для построения систем видеоконференцсвязи, видеостен и других коммерческих или индустриальных платформ. Устройство обеспечивает возможность вывода изображения одновременно на два дисплея формата 4К. Основой служит аппаратная платформа Intel Twin Lake. Максимальная конфигурация включает чип Intel Core 3 Processor N355 (восемь ядер; до 3,9 ГГц; 15 Вт) и 16 Гбайт LPDDR5. Есть встроенный флеш-накопитель eMMC вместимостью 64 Гбайт (опционально — 128 Гбайт), который может быть дополнен SSD (NVMe; PCIe x2) типоразмера M.2 2280. Компьютер оснащён двумя сетевыми портами 1GbE. Предусмотрен разъём M.2 2230 E-Key (PCIe x1, USB 2.0) для комбинированного адаптера Wi-Fi / Bluetooth. В арсенале новинки — четыре порта USB 3.1 Type-A (10 Гбит/с), два интерфейса HDMI 2.0b, два гнезда RJ45 для сетевых кабелей, последовательный порт RS-232/422/485, аудиогнездо на 3,5 мм и 10-контактная колодка GPIO. Устройство заключено в корпус с размерами 152 × 124 × 39 мм, масса составляет около 0,64 кг. Применено пассивное охлаждение; ребристая верхняя поверхность улучшает рассеяние тепла. Диапазон рабочих температур простирается от 0 до +50 °C. Возможен монтаж на DIN-рейку, стену и крепление VESA. Питание (9–36 В) подаётся через DC-коннектор; типовое энергопотребление находится в пределах от 15 до 37 Вт. Заявлена совместимость с Windows 11 LTSC, Ubuntu 24.04 LTS и Yocto 5.1. За безопасность отвечает модуль TPM 2.0.

08.03.2026 [14:50], Сергей Карасёв

Карборунд-алмазные водоблоки Coherent Thermadite 800 вдвое теплопроводнее и к тому же легче медныхКомпания Coherent анонсировала охлаждающие пластины Thermadite 800 Liquid Cold Plates (LCP) для систем жидкостного охлаждения, рассчитанных на ИИ-ускорители следующего поколения. Новые изделия, как утверждается, способны снизить температуру чипа более чем на 15 °C по сравнению с обычными медными аналогами. Thermadite представляет собой композитный материал на основе реакционно-связанного карбида кремния (RB-SiC), который формируется путём инфильтрации кремния в пористую заготовку из карбида кремния и углерода. А благодаря включению алмаза в матрицу SiC материал Thermadite обеспечивает высокую теплопроводность, низкий коэффициент теплового расширения, жёсткость и стабильность размеров. Такие характеристики позволяют использовать Thermadite для отвода тепла от мощных электронных компонентов, в частности, от GPU в передовых ИИ-ускорителях. По заявлениям Coherent, Thermadite 800 обладает теплопроводностью 800 Вт/м⋅К — примерно вдвое больше, чем у меди. Кроме того, материал имеет приблизительно на 60 % меньшую плотность, чем медь, что позволяет использовать его в системах, к массе которых предъявляются жёсткие требования. При этом устраняются проблемы с деформацией и надёжностью, которые могут возникать в обычных металлических охлаждающих пластинах при работе под высоким давлением. Пластины Thermadite 800 имеют сложную микроканальную архитектуру, оптимизированную под конкретные чипы: это даёт возможность эффективно отводить тепло от наиболее горячих зон при минимизации расхода охлаждающей жидкости. В результате, снижаются общие эксплуатационные расходы.

08.03.2026 [14:44], Владимир Мироненко

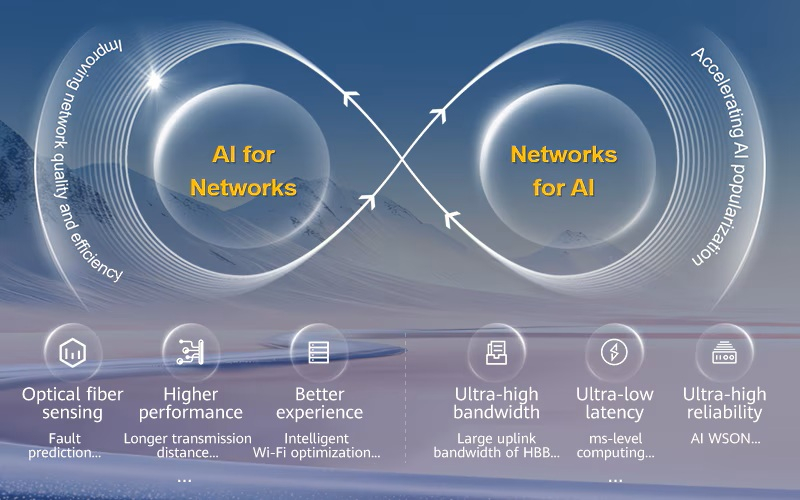

Huawei представила решения для оптических сетей нового поколения для ИИ-нагрузокHuawei провела на MWC 2026 презентацию продуктов и решений, в рамках которой Боб Чен (Bob Chen), президент подразделения оптических продуктов Huawei, представил продукты и решения для оптических сетей нового поколения, призванные способствовать синергии между ИИ и сетями, с упором на ориентированные на ИИ. Он отметил, что развитие ИИ открывает новые возможности для операторов, но также предъявляет более высокие требования к пропускной способности сети, задержке и надёжности, делая необходимой модернизацию оптических сетей для эпохи ИИ. Ведущие мировые операторы также ускоряют развертывание оптических сетей следующего поколения. Боб Чен заявил, что Huawei развивает решения для оптических сетей следующего поколения в двух направлениях: «ИИ для сетей» и «сети для ИИ». В рамках направления «ИИ для сетей» ИИ-технологии обеспечивают интеллектуальное обнаружение волоконно-оптических кабелей, повышают производительность сети и удобство использования, улучшают эффективность эксплуатации и технического обслуживания, а также снижают энергопотребление. В рамках направления «сети для ИИ» расширенные сетевые возможности помогают операторам создавать целевые оптические сети, ориентированные на ИИ, ускоряя внедрение ИИ в домах и на предприятиях.

Источник изображения: Huawei «ИИ для сетей»: повышение качества и эффективности сети

«Сети для ИИ»: ускорение популяризации ИИ

В области оптического доступа Huawei представила FAN-продукты следующего поколения, такие как технология FTTR (Fiber-to-the-Room), OLT (Optical Line Terminal), ONT (Optical Network Terminal) и ODN (Optical Distribution Network). В частности, Huawei выпустила продукты OTN (Optical Transport Network) следующего поколения для магистральных и метросетей, помогая операторам создавать агентные UBB-сети.

08.03.2026 [14:20], Сергей Карасёв

ИИ-облако Iren закупит 50 тыс. ускорителей NVIDIA B300Неооблачная компания Iren объявила о заключении соглашения о покупке более 50 тыс. ускорителей NVIDIA B300. Эта сделка позволит Iren расширить общий парк установленных ускорителей примерно до 150 тыс. ед., что к концу 2026 года обеспечит доход от облачных ИИ-вычислений в размере свыше $3,7 млрд. Закупаемые ускорители NVIDIA B300 в течение этого года будут развёрнуты в существующих дата-центрах Iren с воздушным охлаждением в Маккензи (Британская Колумбия, Канада) и Чилдрессе (Техас, США). При этом подчёркивается, что площадки компании в Чилдрессе и Канал-Флэтс (Британская Колумбия) располагают возможностями для дальнейшего наращивания вычислительных мощностей. За последние восемь месяцев Iren привлекла $9,3 млрд в виде предоплат от клиентов, конвертируемых облигаций, лизинга и средств для приобретения оборудования. В частности, были получены $3,6 млрд на закупку ИИ-ускорителей для нужд Microsoft. Iren намерена использовать эти и другие источники средств для финансирования дополнительных капитальных затрат в размере приблизительно $3,5 млрд: деньги пойдут на покупку серверов, хранилищ, сетевых устройств и вспомогательного оборудования, а также на оплату труда. Условия соглашений предусматривают выполнение платежей после отгрузки техники — это повышает эффективность использования оборотного капитала. «Наращивание мощностей до 150 тыс. ускорителей ставит Iren в число крупнейших мировых поставщиков облачной инфраструктуры для ИИ», — говорит Дэниел Робертс (Daniel Roberts), соучредитель и один из генеральных директоров компании. На сегодняшний день Iren управляет несколькими кампусами ЦОД общей мощностью 810 МВт. Ещё 2,1 ГВт находятся в стадии строительства, 1 ГВт — в стадии разработки. Компания, ранее фокусировавшаяся на майнинге криптовалют, переориентирует свои ресурсы на задачи в сфере ИИ. |

|