Материалы по тегу: pue

|

31.07.2025 [12:37], Руслан Авдеев

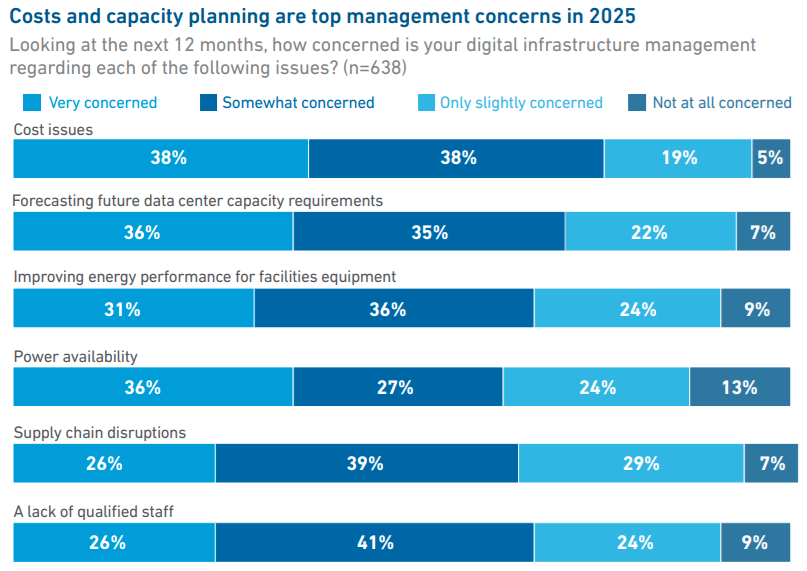

Uptime Institute: лишь треть владельцев и операторов ЦОД занимаются обучением ИИ-моделей или инференсомСогласно данным ежегодного глобального опроса, проводимого Uptime Institute, в 2025 году лишь около трети владельцев и операторов ЦОД занимаются задачами, связанными с обучением ИИ-моделей и инференсом, сообщается в докладе организации. В документе отмечается, что те, кто сегодня использует ИИ-технологии, находятся на «ранней стадии развития», но значительно больше игроков намерены последовать их примеру. Новый отчёт является результатом опроса, полученного от более чем 800 владельцев и операторов ЦОД с апреля по май 2025 года, из которых 43 % находятся в Европе и Северной Америке. По информации Uptime Institute, опрошенные представители бизнеса больше всего обеспокоены вопросами затрат (38 % — крайне обеспокоены), а на втором месте — вопросы прогнозирования будущих потребностей в мощностях ЦОД (36 %). На третьем месте — повышение энергоэффективности, на четвёртом — доступность электроэнергии.

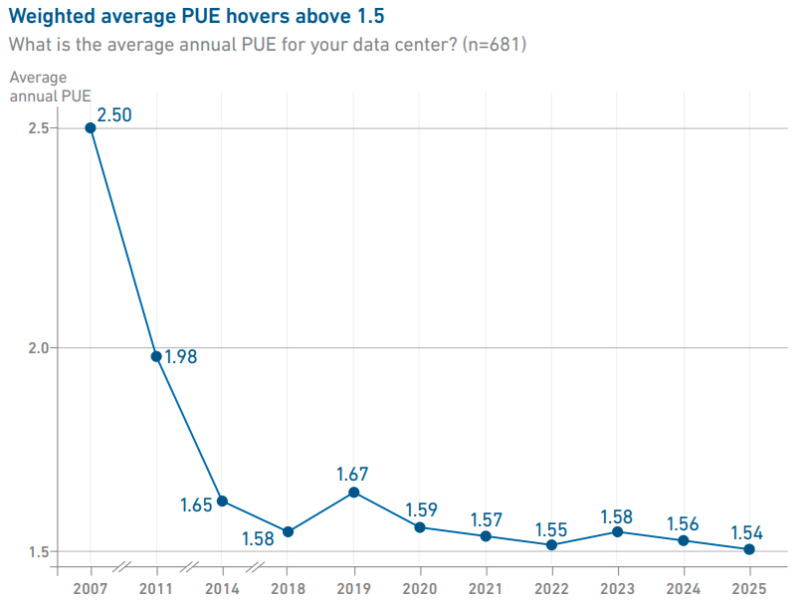

Источник изображения: Uptime Institute Хотя плотность мощности в стойках продолжает расти, в среднем она находится на уровне 10–30 кВт. В Uptime уверены, что лишь немногие проекты используют стойки мощностью более 30 кВт, но «экстремальные» плотности пока встречаются довольно редко. Тем временем уровень PUE по-прежнему остаётся относительно стабильным, среднее значение в текущем году составило 1,54 — уже шестой год подряд оно практически не меняется.

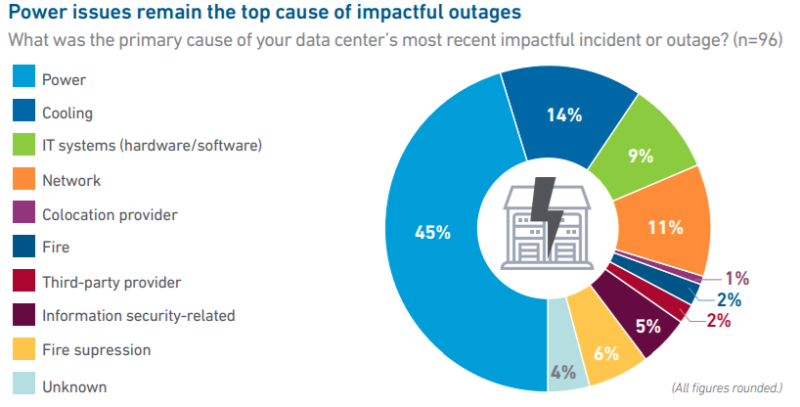

Источник изображения: Uptime Institute Примечательно, что число «значимых» сбоев в работе ЦОД сокращается с учётом общего роста IT-рынка, хотя число публикаций об отказах в работе дата-центров, наоборот, растёт. В отчёте это объясняют просто растущей заметностью и важностью цифровой инфраструктуры в жизни людей. Большинство отключений всё ещё связаны со сбоями электроснабжения (45 %), а также некоторыми другими причинами — впрочем, в 2024 году этот показатель был на уровне 54 %. В отчёте предполагают, что начали окупаться инвестиции в резервирование электропитания и достижения в сфере распределённых и программных архитектур обеспечения отказоустойчивости. Отдельное исследование свидетельствует, что сбои в электропитании в основном связаны с отказами ИБП, а также проблемами с отказами генераторов и переключателями питания.

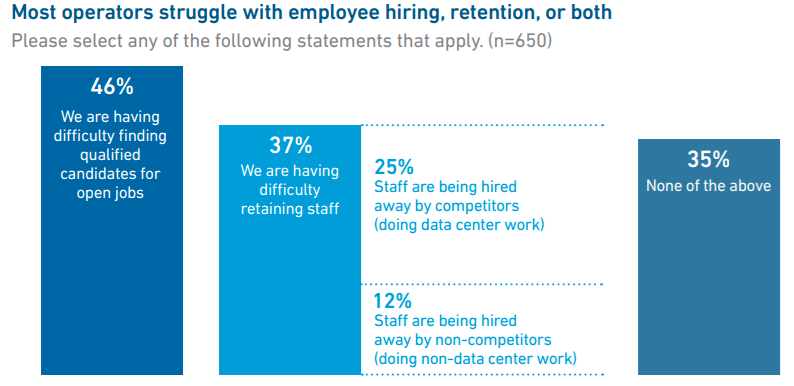

Источник изображения: Uptime Institute Что касается вопроса облачных и локальных вычислений, в Uptime считают, что сейчас около 55 % рабочих нагрузок в той или иной мере размещены вне локальной инфраструктуры, и лишь 45 % приходятся на локальные дата-центры. Вероятно, доля облачных вычислений к 2027 году вырастет до 58 %. Одним из важнейших остаётся кадровый вопрос — почти половина операторов сообщает, что затрудняется с поиском сотрудников, а около 37 % имеют проблемы с удержанием персонала. По словам представителя Uptime Institute, данные организации показывают, что операторам одновременно приходится решать ряд стратегических задач, от прогнозирования технологических изменений до планирования масштабирования бизнеса и подготовки к непредсказуемому спросу на ИИ-вычисления и их поддержку. Подчёркивается, что впервые стало сложнее нанимать и удерживать руководителей старшего звена, чем людей на более низких позициях. Многие опытные руководители уходят на пенсию на фоне нового этапа бурного роста индустрии и нехватки управленцев.

Источник изображения: Uptime Institute В числе прочих выводов — данные о том, что показатели устойчивого развития пострадали из-за коммерческого интереса бизнеса к ИИ и частичного смягчения регуляторных требований в отрасли. В январе 2025 года Uptime Institute сообщал, что развитие ИИ в ЦОД может привести к невыполнению обязательств, взятых операторами по достижению целей устойчивого развития. Также в Uptime отметили использование операторами дата-центров ИИ-решений, в том числе для повышения эффективности объектов (58 %), снижения риска человеческих ошибок (51 %) и повышения производительности труда персонала (48 %).

03.07.2025 [15:01], Руслан Авдеев

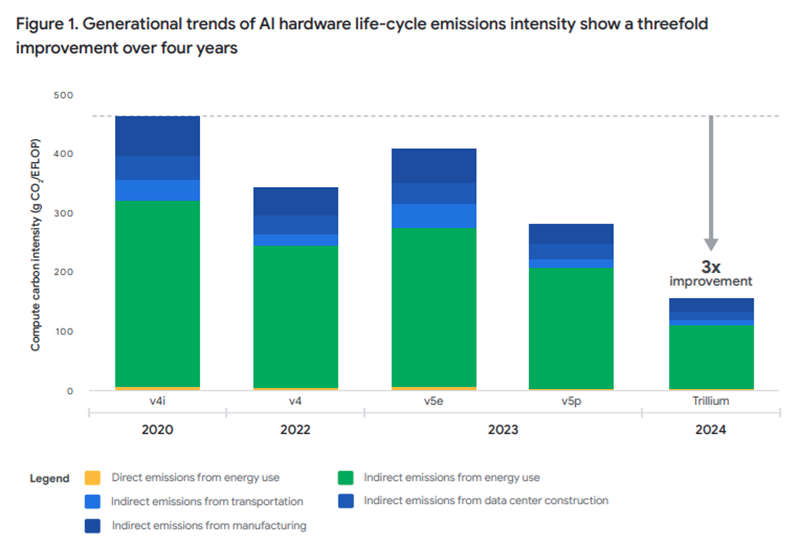

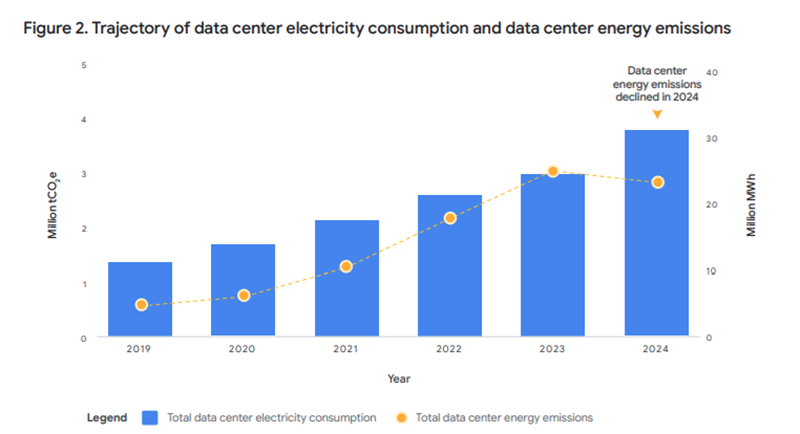

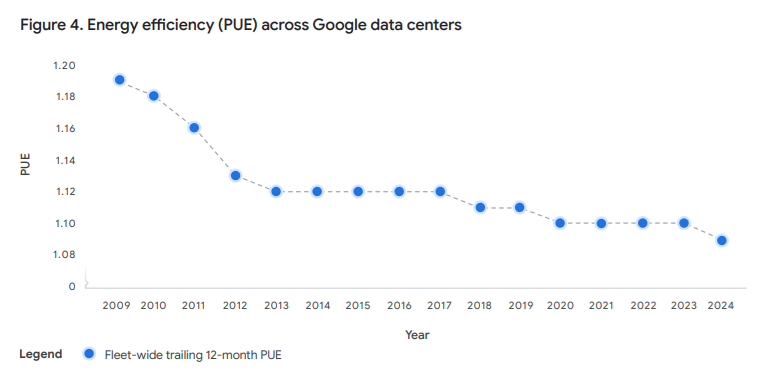

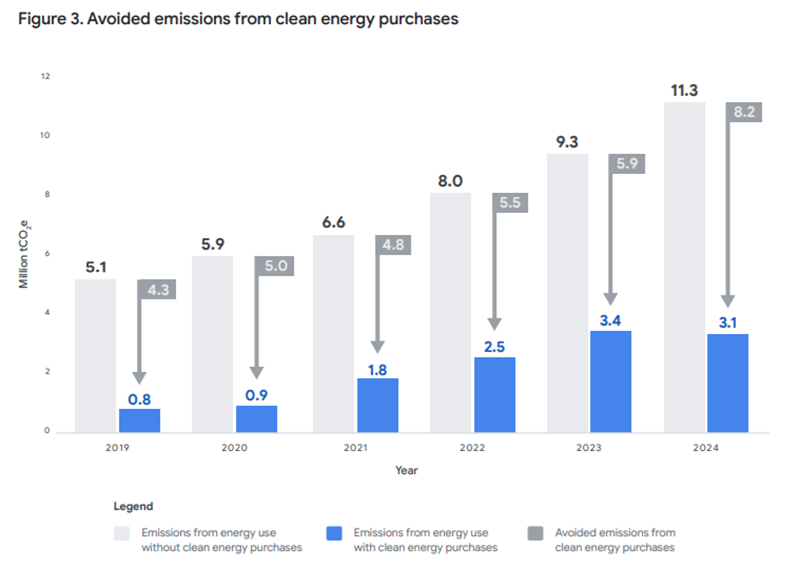

Из-за ИИ дата-центры Google резко нарастили энергопотребление, но их PUE всё равно снизилсяВ Google связывают будущее искусственного интеллекта со своей климатической стратегией. В компании заявили о намерении обеспечить энергоснабжение ИИ «чистым» электричеством на фоне растущего энергопотребления глобальных проектов гиперскейлера, сообщает eWeek. Как свидетельствует десятый отчёт Google Environmental Report, в 2024 году выбросы ЦОД, связанные с энергетикой, снизились на 12 % при росте энергопотребления на 27 %. Прогресс в Google объясняют долгосрочными контрактами на поставки «чистой» энергии и повышением энергоэффективности — это помогает компенсировать негативные экологические эффекты от развития ИИ. Компания даже смогла впервые за шесть лет снизить среднегодовой PUE дата-центров с 1,10 до 1,09. По данным Google, компания значительно расширила применение «чистой» энергии, подписав крупнейший в своей истории пакет контрактов на её поставку. Речь идёт о 8 ГВт новых мощностей, вдвое больше в сравнении с 2023 годом. Также было введено в эксплуатацию 2,5 ГВт по более ранним контрактам.

Источник изображений: Google Положительная динамика отмечается и на региональном уровне. В девяти регионах более 80 % электричества поступает от безуглеродных источников, а общемировой средний показатель достиг 66 % благодаря интеллектуальному перераспределению нагрузки и локализованным закупкам энергии.  Удалось добиться и повышения эффективности оборудования. Последнее поколение чипов компании в 30 раз энергоэффективнее моделей 2018 года. Кроме того, благодаря пяти инструментам Google в 2024 году удалось предотвратить выбросы 26 млн метрических тонн CO₂ — более чем вдвое снизив углеродный след от собственных операций компании.  Несмотря на системные улучшения, общий углеродный след Google в 2024 году увеличился. В отчёте указываются и некоторые проблемы, а также замедление прогресса в ряде направлений. Так, общий объём выбросов вырос из-за активного строительства, выпуска оборудования и деятельности подрядчиков. Выбросы Scope 3, относящиеся к цепочкам поставок и производству, увеличились на 22 % год к году.  При этом в Азиатско-Тихоокеанском регионе уровень использования безуглеродной энергии остаётся на прежнем уровне в 12 %, а в некоторых других странах доля начала даже снижаться из-за ограниченного доступа к возобновляемой энергии. Взрывной рост инфраструктуры заставляет Google пересматривать подход к климатическим обязательствам и энергетике. Компания намерена больше вкладывать в передовые технологии и использовать инновационные схемы закупок энергии.  Например, недавно появилась информация о закупке 200 МВт термоядерной энергии у Commonwealth Fusion Systems — правда, проект ещё далёк от готовности к коммерческому использованию. В целом ожидается более активный переход на безуглеродную энергетику, особенно в регионах с высоким уровнем использования ископаемого топлива (например, в Азии). Представитель Google заявил, что компания совершенствует подход к достижению климатических целей, не снижая темпов развития ИИ на пользу обществу. Обозначенные в отчёте Google проблемы стали отражением общей обеспокоенности индустрии «экологическим следом» искусственного интеллекта. Компании всех масштабов компенсируют выбросы инвестициями в экопроекты (например, сохранение лесов), но эффект от них не так велик и отложен во времени. А в засушливых регионах активисты и власти часто критикуют владельцев дата-центров за высокое потребление чистой воды. Кроме того, эксперты требуют большей прозрачности относительно влияния ИИ на окружающую среду.

18.06.2025 [09:29], Руслан Авдеев

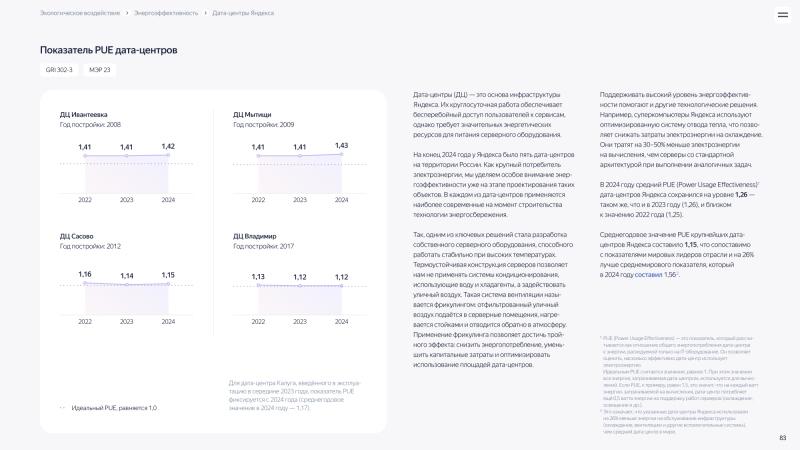

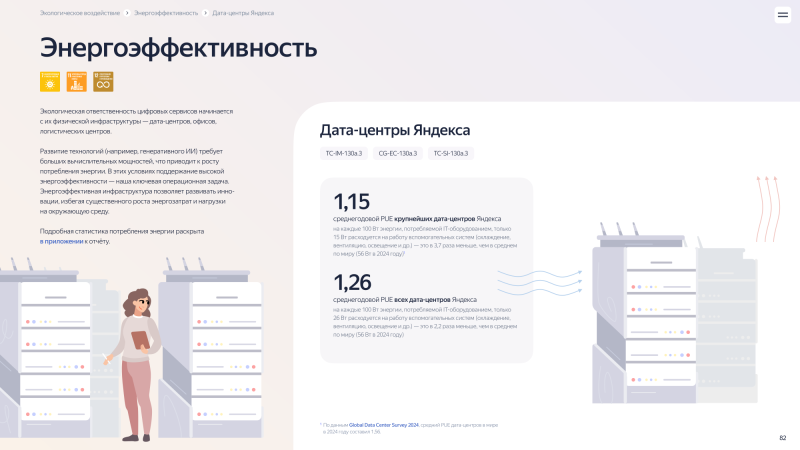

Дата-центры Яндекса нарастили энергопотребление, сохранив PUEКомпания «Яндекс» опубликовала отчёт об устойчивом развитии в 2024 году. Немало внимание в материалах уделили статистике и выводам, посвящённым работе её дата-центров, в том числе — показателям энергоэффективности и углеродным выбросам, сообщает пресс-служба группы. На территории России на конец 2024 года Яндекс располагал пятью дата-центрами. По словам компании, особое внимание энергоэффективности уделялось уже на этапе проектирования ЦОД. Компания занимается разработкой собственного серверного оборудования, готового к стабильной работе при высоких температурах. Особая конструкция серверов позволяет не применять системы кондиционирования с водой и хладагентами — вместо этого используется фрикулинг, который снижает энергопотребление, уменьшает капитальные затраты и позволяет оптимизировать использование площадей ЦОД (впрочем, развитие ИИ не всегда совместимо с таким подходом). Применяются и другие технологии энергосбережения, например, суперкомпьютеры используют специальную систему эффективного отвода тепла, экономящие электричество. Такие решения тратят на 30–50 % меньше электроэнергии, чем серверы со стандартной архитектурой при прочих равных условиях.

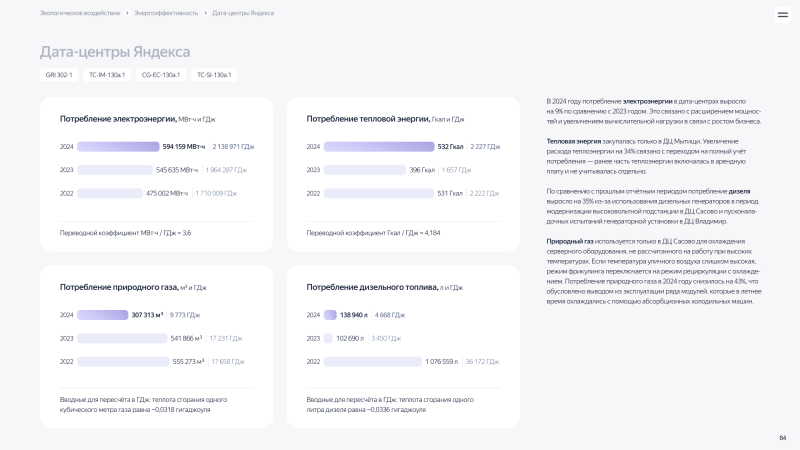

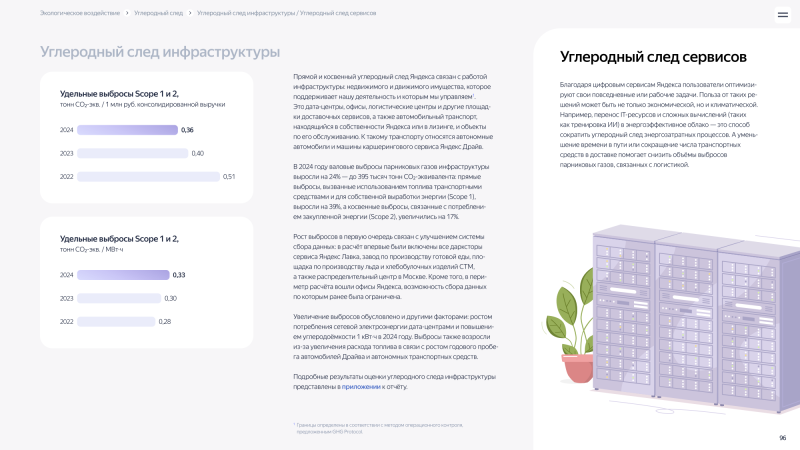

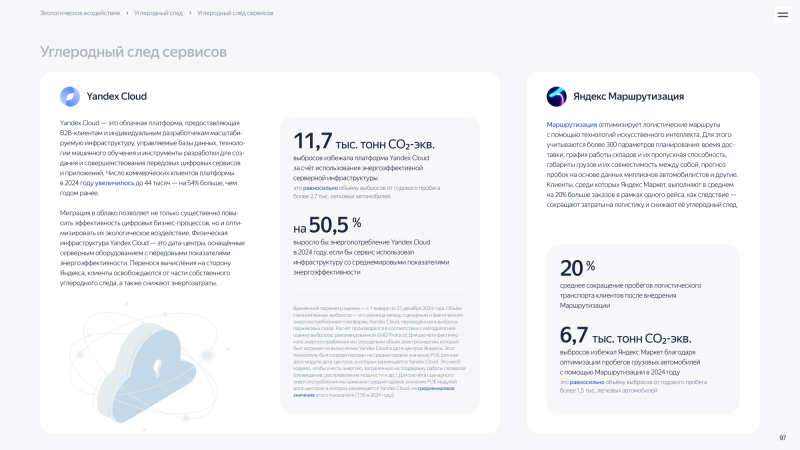

Источник изображений: Яндекс Среднегодовой PUE крупнейших дата-центров Яндекса составляет 1,15, что заметно ниже среднемирового показателя 1,56. PUE для всех ЦОД Яндекса составил 1,26. В сравнении с 2023 годом среднегодовой PUE ЦОД Яндекса не изменился и остался близок к значению 2022 года (1,25). Тепловая энергия закупалась только для ЦОД Мытищи. Увеличение расхода тепла на 34 % связано с переходом на полный учёт потребления — ранее часть теплоэнергии включалась в арендную плату и не учитывалась отдельно. По сравнению с прошлым отчётным периодом потребление дизельного топлива выросло на 35 % из-за использования дизельных генераторов в период модернизации высоковольтной подстанции в ЦОД Сасово и пусконаладочных испытаний генераторной установки в ЦОД Владимир. Наконец, природный газ используется только в ЦОД Сасово для охлаждения серверного оборудования, не рассчитанного на работу при высоких температурах. При слишком высокой температуре воздуха на улице вместо фрикулинга используется режим рециркуляции с охлаждением. Потребление природного газа в 2024 году снизилось на 43 %. Это обусловлено выводом из эксплуатации ряда модулей, которые летом охлаждались с помощью абсорбционных холодильных машин. Что касается углеродных выбросов, более половины совокупного углеродного следа компании приходится именно на дата-центры — 51 % (в 2023 году речь шла о 53 %). Прямой и косвенный углеродный след Яндекса связан с работой инфраструктуры, помимо ЦОД, включающей недвижимое и движимое имущество, от офисов до площадок сервисов доставки и автомобилей. В 2024 году валовые выбросы парниковых газов инфраструктуры выросли на 24 % — до 395 тыс. т СО2-эквивалента. Прямые выбросы Scope 1 выросли на 39 %, а косвенные (Scope 2), связанные с потреблением закупленной энергии, увеличились на 17%. В первую очередь показатели выросли в связи с улучшением системы сбора данных. Увеличение выбросов связано и с ростом потребления электроэнергии дата-центрами и повышением углеродоёмкости 1 кВт·ч в 2024 году, а также в связи с другими факторами. Специальная статистика по углеродным выбросам представлена в приложении. Важную роль играют показатели облачной платформы Yandex Cloud построенной на ЦОД Яндекса. Число коммерческих клиентов платформы в 2024 году выросло до 44 тыс., на 54 % больше, чем в 2023 году. По статистике компании, Yandex Cloud избежала 11,7 тыс. выбросов, эквивалентных CO2e за счёт «использования энергоэффективной серверной инфраструктуры», что равносильно выбросам от годового пробега более 2,7 тыс. легковых автомобилей. Подчёркивается, что если бы в 2024 году использовали оборудование со среднемировыми показателями энергоэффективности, энергопотребление облака Yandex Cloud выросло бы на 50,5 %. В сравнении с 2023 годом энергопотребление ЦОД Яндекса в 2024 году выросло на 9 %, что связано с «расширением мощностей и увеличением вычислительной нагрузки в связи с ростом бизнеса». В целом энергопотребление дата-центров составило в 2024 году 594,16 ГВт∙ч — против 545,64 ГВт∙ч в 2023 году.

11.12.2024 [00:24], Руслан Авдеев

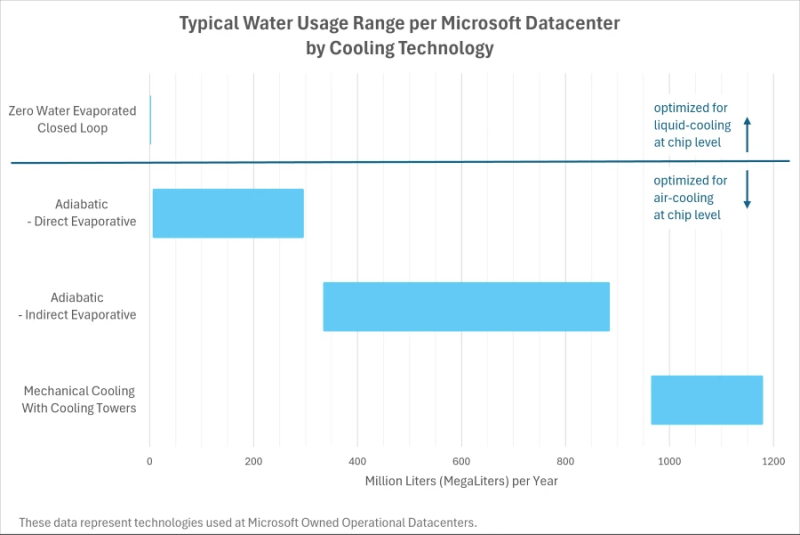

Бессточные ЦОДы: новые дата-центры Microsoft будут иметь околонулевой расход водыMicrosoft анонсировала новую архитектуру охлаждения своих ЦОД, где вода циркулирует в замкнутом контуре, а испарения вообще нет. Все дата-центры Microsoft, разрабатываемые с августа 2024 года, получат новые системы охлаждения. Они, как ожидается, заработают к концу 2027 года. А впервые новые подходы будут опробованы в строящихся ЦОД в Финиксе (Аризона) и Маунт-Плезанте (Висконсин) в 2026 году, сообщает пресс-служба компании. Впрочем, существующие объекты по-прежнему будут использовать различные комбинации систем охлаждения. По словам Microsoft, новая архитектура снизит потребление питьевой воды каждым дата-центром компании более чем на 125 млн л/год. Эта цифра рассчитана с учётом среднего показателя эффективности использования воды (WUE) на уровне 0,30 л/кВт∙ч, который за последние три года улучшился на 39 %. А с начала 2000-х, когда компания стала сама строить ЦОД, WUE снизился на 80 %. Это результат усилий по уменьшению объёма сточных вод, повышению температур в ЦОД и усилению контроля за работой оборудования. Кроме того, в Техасе, Вашингтоне, Калифорнии и Сингапуре компания использует очищенные сточные и оборотные воды. В компании заявляют, что новые технологии используют замкнутые контуры жидкостного охлаждения — как только система заполнена водой во время монтажа, вода будет циркулировать между серверами и охладителями без необходимости постоянной «дозаправки». Этот подход сочетается с прямым жидкостным охлаждением, что позволяет использовать в контурах более тёплую воду, улучшая не только WUE, но PUE.

Источник изображения: Microsoft Правда, параллельно ожидается «номинальное увеличение» расхода электроэнергии каждым новым дата-центром на основе соответствующих технологий. Впрочем, в компании заявляют, что работают над другими инновациями для обеспечения «более целевого охлаждения» и снижения энергозатрат. Новая архитектура в некоторых случаях позволит избежать ситуаций, когда компания вынужденно использует воздушное охлаждение или строит системы очистки сточных вод своих дата-центров.

05.12.2024 [09:13], Руслан Авдеев

AWS представила новую архитектуру ИИ ЦОД, энергоэффективную и экологичную

aws

hardware

pue

водоснабжение

дизель

ибп

ии

охлаждение

сжо

сша

цод

экология

электропитание

энергетика

энергоэффективность

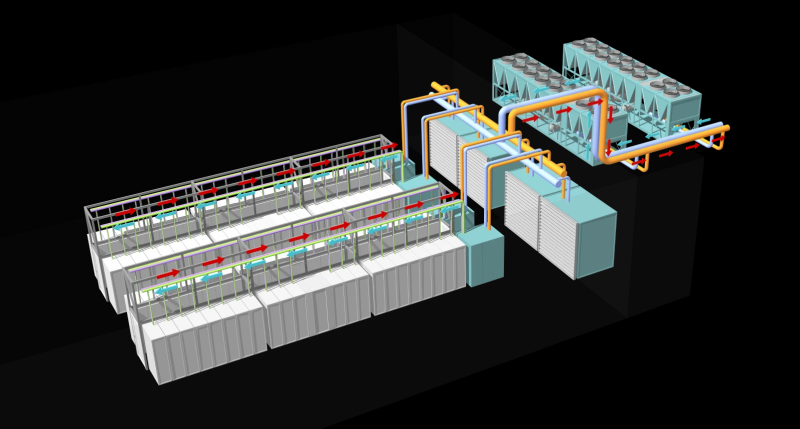

AWS рассказала об инновациях, внедряемых в её ЦОД для поддержки ИИ-нагрузкок следующего поколения. По данным DataCenter Dynamics, нововведения связаны в первую очередь с электропитанием и охлаждением. Они направлены на повышение энергоэффективности дата-центров AWS. Первые ЦОД на базе новой архитектуры заработают в начале 2025 года. Новые решения в свежих новых дата-центрах компании по всему миру, а некоторые начнут применять уже на существующих объектах. В компании подчёркивают, что решения изначально спроектированы как модульные, поэтому возможная поэтапная модернизация площадок для внедрения СЖО, повышения энергоэффективности и снижения углеродного следа. Так, AWS упростит электрическую и механическую структуру новых ЦОД, чтобы облегчит их обслуживание и повысить надёжность. В частности, упростится подход к распределению энергии внутри ЦОД, а источники резервного питания будут размещаться ближе к стойкам. Это позволит повысить доступность инфраструктуры до 99,9999 % времени, а количество стоек, которых могут коснуться проблемы с энергоснабжением, снизится на 89 %. Также уменьшится количество вентиляторов для отвода горячего воздуха. Вместо этого будет применяться естественный перепад давления, что положительно скажется на энергопотреблении. Вместе с тем AWS намерено вшестеро увеличить мощность стойки в следующие два года, и ещё втрое — в будущем. Впрочем, в ИИ-серверах, где мощность ускорителей приближается к 1 кВт, без СЖО обойтись сложно. AWS готовит суперкластеры Project Rainier и Project Ceiba на базе AWS Tranium2 и NVIDIA Blackwell соответственно, поэтому она вместе с крупным производителем СЖО будет внедрять прямое жидкостное охлаждение и в новых, и в старых ЦОД. В некоторых случаях будет использоваться и гибридное охлаждение. Одним из главных плюсов новой архитектуры охлаждения является гибкость — акцент на воздушное или жидкостное охлаждение будет делаться в зависимости от потребностей оборудования и возможностей конкретных дата-центров. Заодно AWS использовала имеющиеся данные и генеративный ИИ для поиска наиболее эффективного способа размещения стоек в своих ЦОД, добавив ещё 12 % вычислительных мощностей на каждую площадку. Новая технология будет применяться как к новому оборудованию для ИИ-систем, так и для других типов техники. Также компания внедрила собственную систему управления механическими и электрическими устройствами — она поможет стандартизировать мониторинг и эксплуатацию дата-центров. Наконец, предприняты усилия по повышению экобезопасности дата-центров. AWS заявила, что новая архитектура охлаждения снизит потребление энергии на 46 % во времена пиковых нагрузок без увеличения потребления воды. Доля углеродных выбросов при производстве бетона, используемого при строительстве ЦОД, уменьшена на 35 % относительно средней по отрасли, кроме того, на 35 % сокращается потребление стали в целом, а та, что используется, поступает из электродуговых печей, а не газовых, что сокращает косвенные выбросы. Наконец, резервные генераторы AWS переведут на возобновляемое дизельное топливо. Дополнительно AWS совместно с Orbital Materials запустила пилотный проект по тестированию разработанного с помощью ИИ материала, помогающего захватывать в дата-центрах углекислый газ — речь идёт о «губке на атомном уровне», взаимодействующей только с молекулами углекислоты. Тестирование материала, три года разрабатывавшегося компаниями, начнётся в начале 2025 года. По данным Orbital, новый материал значительно дешевле аналогов. В дальнейшем стартап планирует испытать разработанные с помощью ИИ технологии для экономии воды и охлаждения чипов. DataCenter Dynamics также отмечает, что AWS впервые раскрыла показатель PUE своих дата-центров. В среднем он составляет 1,15, а самая лучшая площадка достигла 1,04. Для сравнения: у Google эти показатели составляют 1,1 и 1,06 соответственно, у Microsoft — 1,18 и 1,12 (у новых объектов). ЦОД Meta✴ в среднем имеют PUE около 1,08, а Oracle говорит об 1,15.

15.05.2024 [14:18], Руслан Авдеев

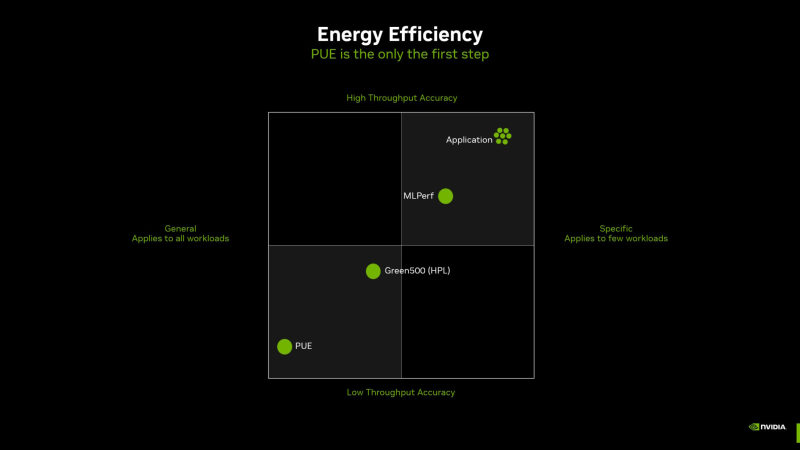

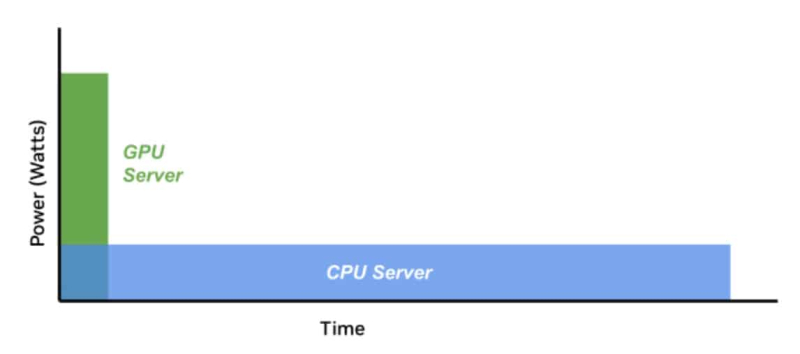

PUE у вас неправильный: NVIDIA призывает пересмотреть методы оценки энергоэффективности ЦОД и суперкомпьютеровОператорам дата-центров и суперкомпьютеров не хватает инструментов для корректного измерения энергоэффективности их оборудования и оценки прогресса на пути к экоустойчивым вычислениям. Как утверждает NVIDIA, нужна новая система оценки показателей при использовании оборудования в реальных задачах. Для оценки эффективности ЦОД существует как минимум около трёх десятков стандартов, некоторые уделяют внимание весьма специфическим критериям вроде расхода воды или уровню безопасности. Сегодня чаще всего используется показатель PUE (power usage effectiveness), т.е. отношение энергопотребления всего объекта к потреблению собственно IT-инфраструктуры. В последние годы многие операторы достигли практически идеальных значений PUE, поскольку, например, на преобразование энергии и охлаждение нужно совсем мало энергии. В эпоху роста облачных сервисов оценка PUE показала довольно высокую эффективность, но в эру ИИ-вычислений этот индекс уже не вполне соответствует запросам отрасли ЦОД — оборудование заметно изменилось. NVIDIA справедливо отмечает, что PUE не учитывает эффективность инфраструктуры в реальных нагрузках. С таким же успехом можно измерять расход автомобилем бензина без учёта того, как далеко он может проехать без дозаправки. При этом среднемировой показатель PUE дата-центров остаётся неизменным уже несколько лет, а улучшать его всё дороже. Что касается энергопотребления, разное оборудование при одинаковых затратах может давать самые разные результаты. Другими словами, если современные ускорители потребляют больше энергии, это не значит, что они менее эффективны, поскольку они дают несопоставимо лучший результат в сравнении со старыми решениями. NVIDIA неоднократно приводила подобные сравнения и между своими GPU с обычными CPU, а теперь предлагает распространить этот подход на ЦОД целиком, что справедливо, учитывая стремление NVIDIA сделать минимальной единицей развёртывания целую стойку. Как считают в NVIDIA, оценивать качество ЦОД можно только с учётом того, сколько энергии тратится для получения результата. Так, ЦОД для ИИ могут полагаться на MLPerf-бенчмарки, суперкомпьютеры для научных исследований могут требовать измерения других показателей, а коммерческие дата-центры для стриминговых сервисов — третьих. В идеале бенчмарки должны измерять прогресс в ускоренных вычислениях с использованием специализированных сопроцессоров, ПО и методик. Например, в параллельных вычислениях GPU намного энергоэффективнее обычных процессоров Не так давно эксперты Стэнфордского университета отметии, что с 2003 года производительность ускорителей выросла приблизительно в 7 тыс. раз, а соотношение цены и производительности стало в 5,6 тыс. раз лучше. А с учётом того, что современные ЦОД достигли PUE на уровне приблизительно 1,2, подобная метрика практически исчерпала себя, теперь стоит ориентироваться на другие показатели, релевантные актуальным проблемам. Хотя напрямую сравнить некоторые аспекты невозможно, сегментировав деятельность ЦОД на типы рабочих нагрузок, возможно, удалось бы получить некоторые результаты. В частности, операторам ЦОД нужен пакет бенчмарков, измеряющих показатели при самых распространённых рабочих ИИ-нагрузках. Например, неплохой метрикой может стать Дж/токен. Впрочем, NVIDIA грех жаловаться на недостойные оценки — в последнем рейтинге Green500 именно её системы заняли лидерские позиции.

20.03.2024 [10:45], Руслан Авдеев

Еврокомиссия одобрила схему отчётности об экологических показателях ЦОДЕврокомиссией принята новая схема отчётности о выбросах дата-центров. Она поможет эффективнее отслеживать прогресс операторов в деле достижения эко- и энергоустойчивости, передаёт Datacenter Dynamics. схема Data centres in Europe является частью Европейской директивы по энергоэффективности (European Energy Efficiency Directive или EED), которая должна помочь до 2030 года снизить общее энергопотребление ЕС на 11,7 %, а углеродные — на 55 %. Согласно новым правилам, предоставляемая операторами информация будет отправляться в центральную базу данных, где станет применяться для прозрачного и мотивированного планирования и принятия решений странами — участницами Евросоюза и Еврокомиссией, а также для оценки ключевых характеристик устойчивости ЦОД. Правила распространяются на все дата-центры ёмкостью более 500 кВт. Операторы будут обязаны сообщать о площади ЦОД, установленной мощности, энергопотреблении, индексе PUE, температурных показателях и утилизации «мусорного» тепла, выделяемого в процессе работы ЦОД. Наконец, необходимо будет докладывать об использовании воды и возобновляемой энергии.

Источник изображения: Christian Lue/unsplash.com Операторы будут обязаны предоставлять данные ежегодно. Первый «дедлайн» сначала назначили на 15 мая 2024 года, но позже перенесли на 15 сентября. Тем не менее, в дальнейшем отчёты за предыдущий год должны будут подаваться до 15 мая текущего. Вероятно, Еврокомиссия перенесла изначальную дату, прислушавшись к жалобам на то, что у операторов осталось слишком мало времени для сбора первичной отчётности.

26.07.2023 [09:09], Владимир Мироненко

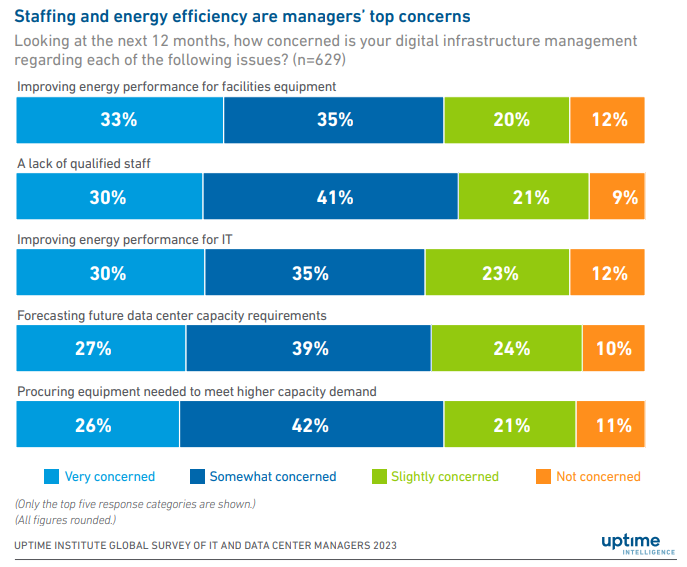

Дата-центрам всё труднее повышать энергоэффективность и соответствовать экологическим требованиямUptime Institute опубликовал данные ежегодного, 13-го по счёту, опроса операторов ЦОД Global DataCenter Survey 2023, который показал, что из-за недостаточного сбора данных об использовании электроэнергии и воды им будет сложно соответствовать новым требованиям и нормативным актам по отчётности в области экологически устойчивого развития. На фоне ужесточения контроля со стороны регулирующих органов за деятельностью отрасли с целью уменьшения вредного воздействия ЦОД на окружающую среду результаты исследования показывают, какую работу необходимо выполнить в данном секторе для улучшения отслеживания объёмов потребляемых ресурсов и генерируемых выбросов. «В нескольких исследованиях, проведённых за последние годы, Uptime Institute отмечал, что сбор и представление данных, связанных с устойчивостью, а также расчёт соответствующих показателей в лучшем случае носят фрагментарный характер. Опрос ещё раз подтверждает это мнение», — говорится в сопроводительной записке. «Многим операторам будет сложно соответствовать новым требованиям к отчётности в области устойчивого развития или требованиям некоторых клиентов и даже общественности». В отчёте указано, что операторы, как правило, фокусируются на мониторинге использования электроэнергии и воды на своих объектах, а не на учёте количества выделяемых ими парниковых газов, по соображениям экономии средств. «Потребление электроэнергии, PUE и расход воды легко отслеживать, и любое улучшение в этих областях часто позволяет сэкономить средства, — говорится в отчёте. — Сокращения выбросов CO2, которое, конечно, может быть частично достигнуто за счёт добросовестного управления энергопотреблением, гораздо сложнее добиться и это приносит меньше непосредственной выгоды». 88 % участников опроса заявили, что следят за потреблением электроэнергии, а 71 % — что контролируют PUE, но менее половины респондентов сообщили о том, что докладывают о потреблении воды или что следят за утилизацией своих серверов. «Отчётность о показателях, связанных с фактическими выбросами CO2, остаётся очень слабой, что говорит о том, что в предстоящие годы потребуются некоторые быстрые восстановительные работы», — указано в отчёте. Впервые за 13 лет участникам также был задан вопрос о ключевых проблемах в управлении, вызывающих у них обеспокоенность. В ответ многие в качестве главной проблемы назвали кадровый вопрос, который со временем многие надеются решить с помощью ИИ, а также необходимость повышения энергоэффективности своих дата-центров. В частности, было отмечено, что по показателю энергоэффективности прогресс застопорился. В течение четырёх–пяти лет среднегодовой показатель PUE остаётся на отметке 1,58–1,59. Это говорит о том, что простые способы улучшения PUE уже исчерпали себя. Для повышения энергоэффективности многих существующих объектов необходимы капитальные работы, дорогостоящие и потенциально опасные. Естественно, более современные объекты имеют лучшие показатели: 16 % респондентов в этом году сообщили о среднегодовом показателе PUE ниже 1,3, в основном в Европе, США и Канаде. В опросе Uptime Institute участвовали более 850 владельцев и операторов центров обработки данных, а также 700 поставщиков и консультантов, которым были заданы вопросы о состоянии отрасли с точки зрения устойчивости, результативности, укомплектования персоналом и регулирования. |

|