Материалы по тегу: ии

|

14.08.2024 [17:13], Владимир Мироненко

Google предупредила об отключении облачного сервиса BigQuery в России 9 сентябряПользователи облачного сервиса BigQuery в России получили уведомление Google о предстоящем прекращении его работы в стране с 9 сентября, сообщил Telegram-канал ГК Softline (ПАО «Софтлайн»). Отмечается, что отключение коснётся только BigQuery, в то время как Google Workspace (включает электронную почту, сервисы Docs, Sheets, Slides, Drive и т.д.) и другие сервисы Google Cloud пока продолжат работу и дальше. BigQuery — полностью управляемая платформа для хранения и анализа больших массивов данных с поддержкой ИИ, рассчитанная на многодвижковую, многоформатную и мультиоблачную среду. Её запустили около 10 лет назад. Сейчас пользователи имеют возможность создания и запуска моделей ML для своих данных в BigQuery. Также можно использовать новейшие модели Gemini, чтобы извлекать информацию из всех типов данных и выполнять с помощью генеративного ИИ такие задачи как резюмирование текста, генерация текста, векторный поиск и т.д.

Источник изображения: Google Весной 2024 года Microsoft также начала отключать российских корпоративных пользователей от ряда облачных продуктов. Аналогичные меры ожидались и от AWS, а также других крупных зарубежных облачных провайдеров. Позавчера Google также объявила о закрытии платформы AdSense для пользователей из РФ.

13.08.2024 [20:33], Владимир Мироненко

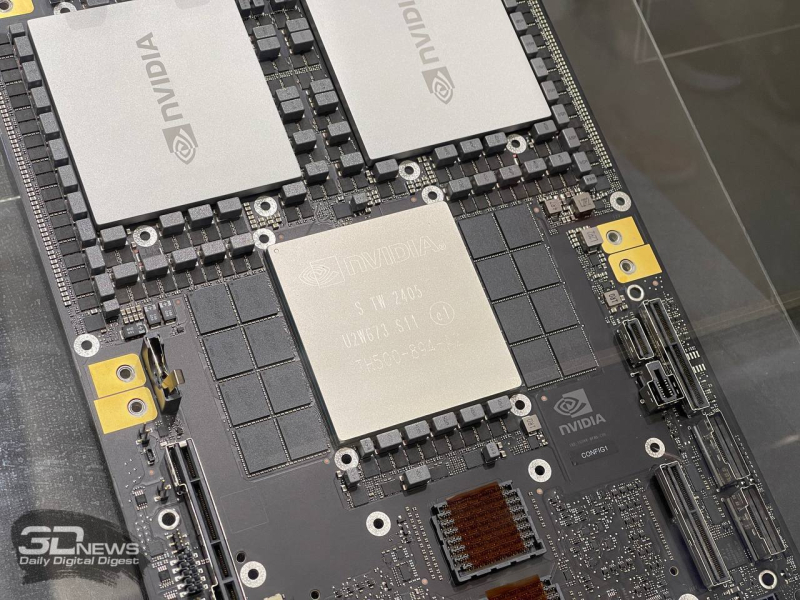

Huawei готовит к выпуску ИИ-ускоритель Ascend 910C, конкурента NVIDIA H100Huawei Technologies вскоре представит новый ИИ-ускоритель Ascend 910C, сопоставимый по производительности с NVIDIA H100, сообщила газета The Wall Street Journal со ссылкой на информированные источники. По их словам, китайские интернет-компании и операторы в последние недели тестировали этот чип и в настоящее время ByteDance (материнская компания TikTok), поисковик Baidu и государственный оператор связи China Mobile ведут переговоры по поводу его поставок. Судя по озвученным цифрам, заказы могут превысить 70 тыс. шт. на общую сумму около $2 млрд. Huawei намерена начать поставки уже в октябре, сообщили источники, но компания не стала комментировать эти сообщения. Huawei была включена в «чёрный» список Entity List Министерства торговли США в 2019 году, что лишило её возможности производить закупки передовых чипов и оборудования для их выпуска, а также размещать заказы на производство микросхем за пределами Поднебесной. Однако благодаря многомиллиардной государственной поддержке компания стала национальным лидером во многих областях, включая ИИ, и ключевой частью усилий Пекина по «удалению» американских технологий, отметила WSJ. При этом Китай наращивает поддержку отечественного производства полупроводников и в мае выделил $48 млрд в рамках третьего транша национального инвестиционного фонда для этой отрасли.

Источник изображения: huaweicentral.com Из-за санкций США китайским клиентам NVIDIA приходится довольствоваться ИИ-ускорителем H20, разработанным специально для Китая с учётом экспортных ограничений Министерства торговли США, в то время как американские клиенты NVIDIA, такие, как OpenAI, Amazon и Google, вскоре получат доступ к гораздо более производительным чипам, включая GB200. NVIDIA также готовит для Китая чип B20, хотя есть опасения, что и он может попасть под новые ограничения США. По оценкам аналитиков SemiAnalysis, 910C может быть даже лучше, чем B20, и если Huawei сможет наладить выпуск нового чипа, а NVIDIA по-прежнему не сможет продавать китайским клиентам передовые ускорители, то у последней все шансы быстро потерять долю рынка в стране. Согласно подсчётам SemiAnalysis, в 2025 году Huawei может произвести 1,3–1,4 млн ускорителей 910C, если не столкнётся с дополнительными ограничениями США. Аналитики ожидают, что NVIDIA продаст более 1 млн H20 в Китае в этом году на сумму около $12 млрд, т.е. в штучном выражении примерно вдове больше, чем Huawei 910B. По словам источников, в последние недели Huawei начала накапливать запасы HBM-чипов, используемых в ИИ-ускорителях, в связи с опасениями ввода США новых экспортных ограничений. На прошедшей в июне конференции, посвящённой полупроводниковой промышленности, представитель руководства Huawei сообщил, что почти половина больших языковых моделей (LLM), созданных в Китае, была обучена с помощью ускорителей компании. Он также отметил, что в этих задачах 910B превосходит по производительности NVIDIA A100.

13.08.2024 [13:33], Руслан Авдеев

SK Telecom и Nokia с помощью ИИ превратят коммерческие оптоволоконные сети в гигантские сенсорыSK Telecom (SKT) и Nokia договорились о разработке «чувствительных» оптоволоконных сетей. Технология будет использовать ИИ для мониторинга окружающей среды вокруг кабелей. На первом этапе компании намерены собрать с использованием машинного обучения данные с коммерческой сети SKT. Систему планируется использовать для распознавания землетрясений, климатических изменений и прочих ситуаций, например, инцидентов на близлежащих стройках. К концу года планируется внедрение технологии на территории всей Южной Кореи. Прохождение сигнала по оптоволокну может меняться под влиянием различных факторов, включая перепады температуры, вибрации и т.д. На основе технологии, предусматривающей применение ИИ, SKT и Nokia намерены добиться более стабильной работы оптоволоконных сетей, изучая воздействие погодных условий и даже близлежащих строительных объектов на кабели. При этом никакой модификации самих кабелей не требуется, так что систему мониторинга можно быстро развернуть на существующей инфраструктуре. Идея использования ВОЛС в качестве сенсоров далеко не нова. Такие системы нередко используются в охранных целях, правда, в этом случае речи о передачи данных обычно не идёт. Но операторы пытаются найти новые применения своим сетям. В ноябре появилась новость об использовании кабелей в Японии для оценки снежного покрова, Güralp проложила в водах близ Италии кабель SMART для мониторинга сейсмической активности, а SMART-кабель TAM TAM между Новой Каледонией и Вануату предупредит о землетрясениях и цунами.

10.08.2024 [23:28], Руслан Авдеев

ЦОД с газопроводом: энергокомпании США обсуждают с операторами дата-центров поставки голубого топливаАмериканские энергокомпании US Energy Transfer и Williams Cos. обсуждают с операторами дата-центров возможность строительства трубопроводов для поставки газа непосредственно на территорию кампусов для питания электростанций. По данным Datacenter Dynamics, бум ИИ ведёт к росту спроса на энергию и многие видят в получении энергии на месте возможное решение проблемы. По словам представителя Energy Transfer, общавшегося с отраслевыми экспертами, компания обсуждает возможности с ЦОД разных масштабов. Многие из них весьма положительно относятся к самой идее генерировать электричество на месте. Сейчас компания расширяет уже существующие электростанции и изучает возможность подключения к газовым магистралям новых. Williams Cos. также отмечает рост спроса и, как сообщают в компании, пытаются найти решение в ответ на многочисленные запросы. В частности речь идёт о юго-восточной части США и центре атлантического побережья страны. В число регионов попал и штат Вирджиния, на территории которого расположено огромное количество ЦОД, уже страдающих от дефицита электроэнергии.

Источник изображения: Quinten de Graaf/unsplash.com Местный поставщик электричества Dominion Energy в докладе за 2023 год сообщил, что принадлежащая ему распределяющая компания Virginia Power продавала 24 % всего поставляемого здесь электричества именно дата-центрам в минувшем году, в 2022 году рост составлял 21 %. Компания объявила, что потребление индивидуальных объектов выросло с приблизительно 30 МВт до 60–90 МВт, а аппетиты кампусов могут составлять от 300 МВт до нескольких гигаватт. В январе 2024 года PJM Interconnection отметила, что ожидает роста энергопотребления в зонах своей ответственности почти на 40 % в следующие 15 лет, одним из ключевых драйверов роста должны стать дата-центры. С увеличением ограничений для сетей электропередач выработка энергии на месте может стать единственным средством получения одобрения на строительство новых ЦОД. Нечто подобное уже происходит и в Ирландии. В результате фактического моратория на строительство дата-центров в районе Дублин, некоторые ЦОД выразили намерение подключиться к газовым магистралям вместо попыток присоединения к энергосети. С тех пор Ирландия уже начала реализовывать политику частного энергоснабжения, позволяя компаниям строить собственную энерготранспортную инфраструктуру во избежание проблем с энергоснабжением в других сферах, использующих сети общего пользования.

10.08.2024 [22:58], Сергей Карасёв

CoreWeave активно нанимает топ-менеджеров Google, Oracle и AWS для развития ИИ ЦОДКомпания CoreWeave, предоставляющая облачные услуги для ИИ-задач, по сообщению Datacenter Dynamics, приняла на работу сразу нескольких топ-менеджеров, которые ранее занимали различные руководящие должности в Google, Oracle и AWS. Ожидается, что они помогут CoreWeave в развитии направления дата-центров. В частности, CoreWeave назначила старшим вице-президентом по проектированию Чена Голдберга (Chen Goldberg). До этого он в течение восьми лет работал в Google, в том числе в качестве генерального директора и вице-президента по развитию Kubernetes и направления бессерверных вычислений. Кроме того, в CoreWeave в качестве главного операционного директора пришёл Сачин Джайн (Sachin Jain). Ранее он трудился в Oracle, отвечая за инфраструктуру ИИ, снабжение ЦОД и управление группами IaaS в рамках облачной платформы Oracle Cloud Infrastructure (OCI). Кроме того, в течение примерно четырёх лет Джайн занимал пост вице-президента Google Cloud, руководя планированием мощностей и оптимизацией ресурсов.

Источник изображения: CoreWeave В середине марта 2024 года CoreWeave назначила нового финансового директора: им стал Нитин Агравал (Nitin Agrawal), до этого занимавший должность вице-президента по финансам в Google Cloud. А позднее CoreWeave объявила о том, что на пост её продуктового директора назначен Четан Капур (Chetan Kapoor), ранее исполнявший обязанности директора по управлению продуктами в подразделении AWS EC2. CoreWeave активно развивает бизнес, в том числе в сфере дата-центров. В мае нынешнего года компания сообщила о намерении вложить £1 млрд в ИИ ЦОД в Великобритании. Ещё $2,2 млрд будет инвестировано в аналогичные проекты в материковой Европе. За последние два года CoreWeave привлекла приблизительно $12 млрд, в том числе в виде долгового финансирования. Средства направляются на развитие ЦОД и закупку необходимого оборудования.

10.08.2024 [12:01], Руслан Авдеев

Cisco второй раз за год уволит тысячи сотрудников и сосредоточится на ИИ и кибербезопасностиКомпания Cisco сократит тысячи сотрудников в ходе второго раунда увольнений. По данным Reuters, это связано с тем, что компания намерена сместить фокус внимания на области с высокими темпами роста, включая кибербезопасность и системы искусственного интеллекта (ИИ). Если в феврале Cisco уволила порядка 4 тыс. человек, то теперь, не исключено, под сокращение попадёт несколько больше. Вероятнее всего, компания объявит о непростых кадровых решениях уже в будущую среду в ходе очередного квартального отчёта. В своё время Reuters сообщила о февральских увольнениях ещё до того, как об этом объявила сама компания, поэтому её источники могут считаться довольно надёжными. При этом в июле 2023 года штат Cisco составлял 84,9 тыс человек. После сообщения Reuters об очередных сокращениях акции компании упали в цене приблизительно на 1 %, всего они подешевели за год более чем на 9 %. Сейчас компания страдает от малого спроса и проблем с цепочками поставок для своего основного бизнеса. Это заставляет её диверсифицировать бизнес — например, в марте закрыта сделка по покупке за $28 млрд компании Splunk, занимающейся обеспечением кибербезопасности. Покупка позволит снизить зависимость от «разовых» продаж, стимулируя бизнес, связанный с продажей технологических решений по подпискам. Кроме того, компания пытается интегрировать ИИ в свои продукты и в мае подтвердила намерение добиться в 2025 году продаж ИИ-решений на $1 млрд. В июне компания основала миллиардный фонд для инвестиций в ИИ-стартапы вроде Cohere, Mistral AI и Scale AI. На тот момент компания объявила, что за последние годы приобрела 20 связанных с ИИ компаний. Увольнения — последнее из событий такого рода в технологической индустрии, позволяющая сократить издержки в текущем году, чтобы компенсировать большие инвестиции в ИИ. Всего, по данным портала Layoffs.fyi, с начала года в 393 технокомпаниях уволили более 126 тыс. человек. Ранее в августе Dell объявила о сокращении более 10 % рабочей силы — около 12,5 тыс. человек, в основном из отделов продаж и маркетинга.

09.08.2024 [23:50], Владимир Мироненко

Купить, не покупая: IT-гиганты научились поглощать ИИ-стартапы, не привлекая внимания регуляторовСтартапы в сфере ИИ привлекли миллиарды долларов инвестиций в прошлом году в надежде, что вложения в скором времени окупятся. Однако этого не случилось и сейчас многим из них приходится бороться за выживание, обращаясь за помощью к крупным технологическим компаниям, пишет газета The Wall Street Journal. Так, стартап Character.AI объявил о сделке с Google по использованию его технологии, в рамках которой часть его персонала, а также соучредители Ноам Шазир (Noam Shazeer) и Даниэль Де Фрейтас (Daniel De Freitas) переходят в штат поискового гиганта. Также согласно условиям сделки Google выплатит стартапу лицензионный сбор в размере $2 млрд, что позволит рассчитаться с ранними инвесторами, сообщили люди, знакомые с этим вопросом. По словам источника WSJ, компании обсуждали возможность прямого приобретения, но пришли к выводу, что в этом случае без расследования регуляторов вряд ли обойдётся. Новый тип сделки, который фактически является приобретением, хотя формально к таковым не относится, позволяет обойти типичный процесс регулирования в то время, когда регулирующие органы ужесточают контроль деятельности крупных технологических компаний по расширению влияния на рынке генеративного ИИ. Аналогичную сделку заключил в июне стартап Adept AI с компанией Amazon, взявшей на себя обязательство нанять большую часть сотрудников стартапа и заплатить около $330 млн за лицензирование технологии, сообщили информированные источники WSJ. Этого было достаточно, чтобы вместе с оставшимися у Adept AI средствами расплатиться с инвесторами. Хотя сам стартап, который в прошлом году оценивался в $1 млрд, рассчитывал на более блестящее будущее. Adept привлёк чуть более $400 млн инвестиций, но затраты на создание его технологии превзошли ожидания ее основателей, сообщил информатор WSJ. Этой весной стартап обратился к ряду компаний, включая Microsoft и Salesforce, а в итоге заключил сделку с Amazon. Сейчас в Adept осталось около 25 сотрудников, и теперь стартап будет заниматься использованием и продажей существующих технологий без разработки новых. Аналогичную сделку провернула в марте Microsoft, приняв на работу почти всех сотрудников разработчика ИИ Inflection, чтобы открыть новое подразделение потребительского ИИ, и заплатив около $650 млн за лицензирование технологий. Впрочем, эта сделка уже заинтересовала британского регулятора. Инвесторы прогнозируют дальнейшие сделки по поглощению ИИ-стартапов, как реальные, так и фиктивные, поскольку сроки окупаемости ИИ-технологий оказались гораздо больше, чем они рассчитывали, и сейчас приходится думать о выживании. Спасение технологическим гигантом лучше, чем закрытие, но это далеко не нарушение статус-кво технологической отрасли, на которое делали ставку инвесторы, отметила WSJ. Вместо этого технологические гиганты ещё больше укрепили своё влияние на рынке ИИ. По словам источников WSJ в ИИ-отрасли, усиление мер администрации США по блокированию технологических слияний и поглощений стало одной из причин необычных сделок с Character, Adept и Inflection. Так называемые сделки acqui-hires, когда крупная компания покупает стартап в основном для найма его сотрудников, для Кремниевой долины не новость. Но найм ключевых сотрудников стартапа и получение его технологий в обмен на лицензионный сбор отличаются от этого типа сделки, позволяя компании получить желаемое без необходимости в одобрении регулятором. Впрочем, по словам источников, Федеральная торговая комиссия США (FTC) изучает как сделку Amazon с Adept, так и сделку Microsoft с Inflection с целью выяснить, не было ли у покупателя умысла избежать с помощью составленного таким образом соглашения одобрения правительства. В Великобритании у регуляторов вызвала вопросы инвестиция Amazon $4 млрд в ИИ-стартап Anthropic.

09.08.2024 [09:32], Руслан Авдеев

ИИ ЦОД за полгода: Supermicro анонсировала DCBBS, методологию быстрого возведения и модернизации дата-центровВ Supermicro рассказали о методологии строительства дата-центров DCBBS, позволяющей создавать небольшие ЦОД за срок от полугода или сокращать время строительства более крупных объектов с трёх до двух лет. Как сообщает The Register, о новом подходе рассказал глава компании Чарльз Лян (Charles Liang) во время последнего финансового отчёта. Глава Supermicro подчеркнул, что выручка только за IV квартал 2024 финансового года превзошла всю выручку за 2022 год. Впрочем, Лян признал, что новую проприетарную технологию прямого жидкостного охлаждения (DLC) оказалось трудно и дорого разработать, не в последнюю очередь из-за дефицита компонентов. Именно это стало причиной того, что компания недополучила $800 млн квартальной выручи, разоачаровала аналитиков и резко потеряла в рыночной стоимости. Тем не менее глава компании уверен, что инвестиции в дополнительные производственные мощности помогут справиться с этой нехваткой и удвоить число выпускаемых стоек с DLC с 1500 до 3000 в месяц в течение финансового года. По словам Ляна, СЖО Supermicro стоят не больше, чем обычные системы охлаждения, но системы с ним потребляют меньше энергии, т.е. в итоге позволяют экономить средства. Спрос на подобные комплекты увеличится, уверены в компании. Анонсированная в ходе отчёта методология Supermicro 4.0 Datacenter Building Block Solutions (DCBBS) позволит значительно ускорить ввод в эксплуатацию ЦОД и оптимизировать их стоимость. Предполагается полная интеграция ИИ-вычислений, серверов, хранилищ, сети, энергетического оборудования и, конечно, СЖО, а также ПО для сквозного управления и услуги по развёртыванию и обслуживанию. Предполагается, что два года будет уходить создание крупных ИИ ЦОД, а для на объекты меньшего масштаба или модернизацию старых ЦОД уйдёт всего 6-12 месяцев. При этом в компании не ожидают, что новые ускорители NVIDIA Blackwell, которые как раз без СЖО обходиться будут с трудом, поспособствуют росту Supermicro в 2025 финансовом году. Финансовые аналитики выразили озабоченность падением маржинальности бизнеса, но Лян подчеркнул, что Supermicro улучшит показатели. Впрочем, планам компании может помешать сама NVIDIA, вынужденно отложившая массовое производство новейших ускорителей. Услуги в рамках DCBBS компания намерена предложить к концу 2024 года.

08.08.2024 [00:48], Сергей Карасёв

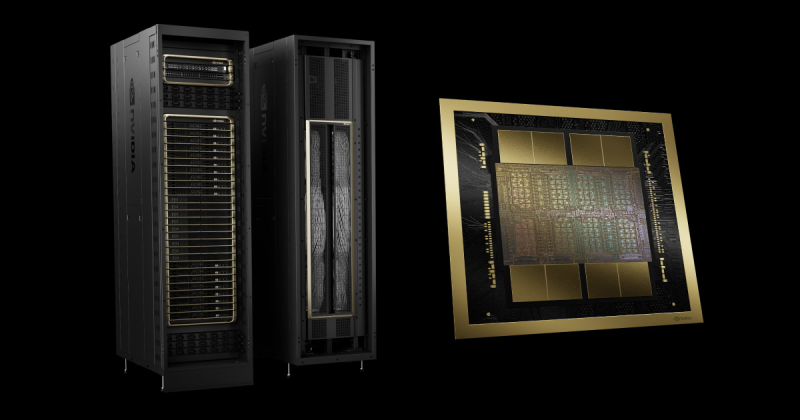

NVIDIA задержит выпуск ускорителей GB200, отложит B100/B200, а на замену предложит B200AКомпания NVIDIA, по сообщению ресурса The Information, вынуждена повременить с началом массового выпуска ИИ-ускорителей следующего поколения на архитектуре Blackwell, сохранив высокие темпы производства Hopper. Проблема, как утверждается, связана с технологией упаковки Chip on Wafer on Substrate (CoWoS) от TSMC. Отмечается, что NVIDIA недавно проинформировала Microsoft о задержках, затрагивающих наиболее продвинутые решения семейства Blackwell. Речь, в частности, идёт об изделиях Blackwell B200. Серийное производство этих ускорителей может быть отложено как минимум на три месяца — в лучшем случае до I квартала 2025 года. Это может повлиять на планы Microsoft, Meta✴ и других операторов дата-центров по расширению мощностей для задач ИИ и НРС. По данным исследовательской фирмы SemiAnalysis, задержка связана с физическим дизайном изделий Blackwell. Это первые массовые ускорители, в которых используется технология упаковки TSMC CoWoS-L. Это сложная и высокоточная методика, предусматривающая применение органического интерпозера — лимит возможностей технологии предыдущего поколения CoWoS-S был достигнут в AMD Instinct MI300X. Кремниевый интерпорзер, подходящий для B200, оказался бы слишком хрупок. Однако органический интерпозер имеет не лучшие электрические характеристики, поэтому для связи используются кремниевые мостики. В используемых материалах как раз и кроется основная проблема — из-за разности коэффициента теплового расширения различных компонентов появляются изгибы, которые разрушают контакты и сами чиплеты. При этом точность и аккуратность соединений крайне важна для работы внутреннего интерконнекта NV-HBI, который объединяет два вычислительных тайла на скорости 10 Тбайт/с. Поэтому сейчас NVIDIA с TSMC заняты переработкой мостиков и, по слухам, нескольких слоёв металлизации самих тайлов. Вместе с тем у TSMC наблюдается нехватка мощностей по упаковке CoWoS. Компания в течение последних двух лет наращивала мощности CoWoS-S, в основном для удовлетворения потребностей NVIDIA, но теперь последняя переводит свои продукты на CoWoS-L. Поэтому TSMC строит фабрику AP6 под новую технологию упаковки, а также переведёт уже имеющиеся мощности AP3 на CoWoS-L. При этом конкуренты TSMC не могут и вряд ли смогут в ближайшее время предоставить хоть какую-то альтернативную технологию упаковки, которая подойдёт NVIDIA. Таким образом, как сообщается, NVIDIA предстоит определиться с тем, как использовать доступные производственные мощности TSMC. По мнению SemiAnalysis, компания почти полностью сосредоточена на стоечных суперускорителях GB200 NVL36/72, которые достанутся гиперскейлерам и небольшому числу других игроков, тогда как HGX-решения B100 и B200 «сейчас фактически отменяются», хотя малые партии последних всё же должны попасть на рынок. Однако у NVIDIA есть и запасной план. План заключается в выпуске упрощённых монолитных чипов B200A на базе одного кристалла B102, который также станет основой для ускорителя B20, ориентированного на Китай. B200A получит всего четыре стека HBM3e (144 Гбайт, 4 Тбайт/с), а его TDP составит 700 или 1000 Вт. Важным преимуществом в данном случае является возможность использования упаковки CoWoS-S. Чипы B200A как раз и попадут в массовые HGX-системы вместо изначально планировавшихся B100/B200. На смену B200A придут B200A Ultra, у которых производительность повысится, но вот апгрейда памяти не будет. Они тоже попадут в HGX-платформы, но главное не это. На их основе NVIDIA предложит компромиссные суперускорители MGX GB200A Ultra NVL36. Они получат восемь 2U-узлов, в каждом из которых будет по одному процессору Grace и четыре 700-Вт B200A Ultra. Ускорители по-прежнему будут полноценно объединены шиной NVLink5 (одночиповые 1U-коммутаторы), но вот внутри узла всё общение с CPU будет завязано на PCIe-коммутаторы в двух адаптерах ConnectX-8. Главным преимуществом GX GB200A Ultra NVL36 станет воздушное охлаждение из-за относительно невысокой мощности — всего 40 кВт на стойку. Это немало, но всё равно позволит разместить новинки во многих ЦОД без их кардинального переоборудования пусть и ценой потери плотности размещения (например, пропуская ряды). По мнению SemiAnalysis, эти суперускорители в случае нехватки «полноценных» GB200 NVL72/36 будут покупать и гиперскейлеры.

07.08.2024 [12:28], Руслан Авдеев

Китайские компании набивают склады HBM-памятью Samsung в ожидании новых американских санкцийКитайские техногиганты, включая игроков вроде Huawei и Baidu, а также стартапы активно запасают HBM-чипы Samsung Electronics. По данным агентства Reuters, это делается в ожидании новых ограничений со стороны США на поставки в КНР чипов, использующих американские технологии. Как сообщают источники издания, компании наращивают закупки соответствующих чипов ещё с начала 2024 года, на долю китайских покупателей придётся порядка 30 % выручки Samsung от продаж HBM в I половине 2024 года. Экстренные меры наглядно демонстрируют нежелание Китая отказываться от технологических амбиций даже на фоне торговых войн с США и их союзниками. Ранее Reuters сообщало, что американские власти намерены представить новые санкционные ограничения ещё до конца текущего месяца. Они призваны ограничить возможности китайской полупроводниковой индустрии. Источники сообщают, что в документах будут заданы и параметры для ограничений на поставки HBM-памяти. Министерство торговли США отказалось от комментариев, но на прошлой неделе заявило, что постоянно обновляет правила экспортного контроля для защиты национальной безопасности США и технологической экосистемы страны.

Источник изображения: Samsung HBM-чипы считаются критически важными компонентами при разработке передовых ИИ-ускорителей. Возможности выпуска HBM пока доступны только трём производителям: южнокорейским SK Hynix и Samsung, а также американской Micron Technology. По данным информаторов Reuters, в Китае особым спросом пользуется вариант HBM2E, который отстаёт от передового HBM3E. Глобальный бум ИИ-технологий привёл к дефициту наиболее передовых решений. По мнению экспертов, поскольку собственные китайские технологии в этой области ещё не слишком зрелые, спрос китайских компаний и организаций на сторонние HBM-чипы чрезвычайно велик, а Samsung оставалась единственной опцией, поскольку производственные мощности других производителей уже забронированы американскими ИИ-компаниями. Хотя объёмы и стоимость запасённых Китаем HBM-чипов оценить нелегко, известно, что они используются компаниями самого разного профиля, а Huawei, например, применяет Samsung HBM2E для выпуска передовых ИИ-ускорителей Ascend. Впрочем, Huawei и CXMT уже сфокусировали внимание на разработке чипов HBM2 — они на три поколения отстают от HBM3E. Тем не менее, американские санкции могут помешать новым китайским проектам. Более того, от них может больше пострадать Samsung, чем её ключевые соперники, которые меньше связаны с китайским рынком. Micron не продаёт HBM-чипы в Китай с прошлого года, а SK Hynix, чьими ключевыми клиентами являются компании вроде NVIDIA, специализируются на более современных решениях. |

|