Материалы по тегу: ии

|

11.11.2023 [15:23], Сергей Карасёв

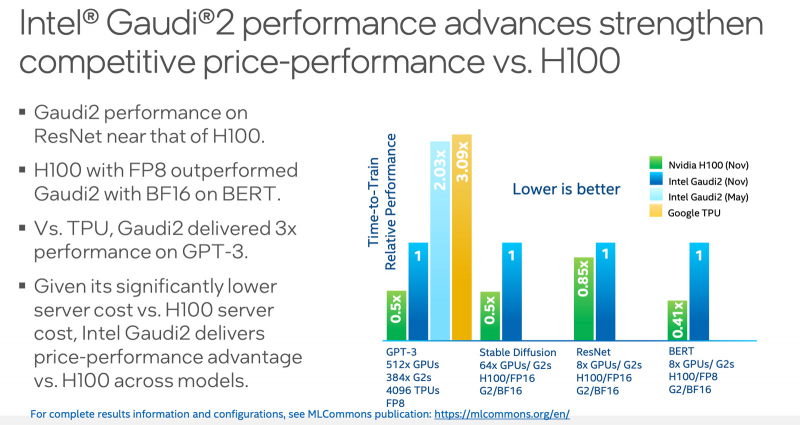

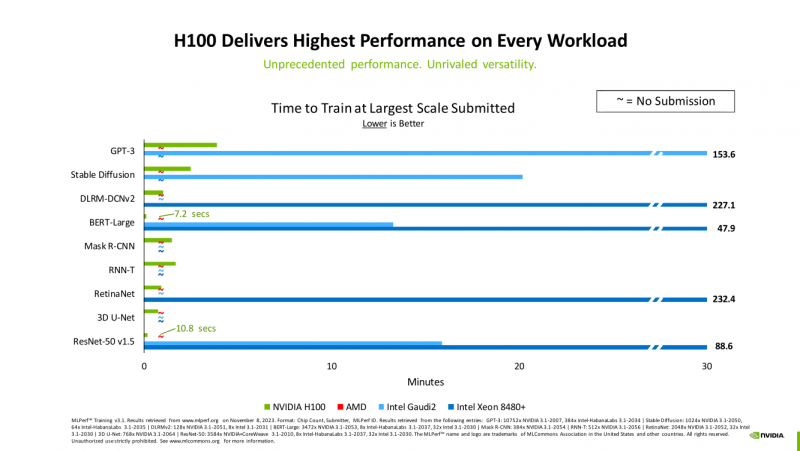

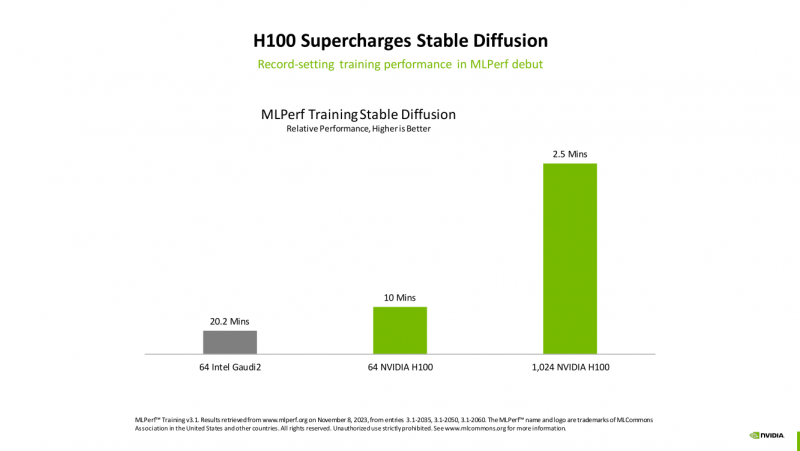

MLPerf: Intel улучшила производительность Gaudi2, но лидером остаётся NVIDIA H100Консорциум MLCommons обнародовал результаты тестирования различных аппаратных решений в бенчмарке MLPerf Training 3.1, который оценивает производительность на ИИ-операциях. Отмечается, что корпорация Intel смогла существенно увеличить быстродействие своего ускорителя Habana Gaudi2, но безоговорочным лидером остаётся NVIDIA H100. Тесты проводились на платформе Xeon Sapphire Rapids. Отмечается, что для некоторых задач Intel реализовала поддержку FP8-вычислений, благодаря чему производительность поднялась в два раза по сравнению с показателями, которые этот же ускоритель демонстрировал ранее. Согласно результатам тестов, в бенчмарке GPT-3 ускоритель Gaudi2 ровно в два раза проигрывает решению NVIDIA H100. То же самое касается теста Stable Diffusion: при этом нужно отметить, что Gaudi2 использовал формат BF16, а H100 — FP16. В ResNet эти ускорители демонстрируют сопоставимую производительность. В тесте BERT чип H100 при использовании FP8-вычислений показал значительное преимущество перед Gaudi2, который использовал формат BF16. Сама Intel отмечает, что с внедрением поддержки FP8 система с 384 ускорителями Gaudi2 способна завершить обучение GPT-3 за 153,58 мин. При использовании 64 чипов Gaudi2 тест Stable Diffusion может быть завершён за 20,2 мин (BF16). Для тестов BERT и ResNet-50 на восьми ускорителях Gaudi2 (BF16) результат составляет 13,27 и 15,92 мин соответственно. Вместе с тем стоимость и доступность ускорителей Intel, как считается, существенно лучше, чем у решений NVIDIA.

10.11.2023 [21:17], Руслан Авдеев

IBM инвестирует $500 млн в ИИ-стартапы, ориентированные на корпоративных клиентовКомпания IBM учредила фонд Enterprise AI Venture Fund, который поддержит стартапы, занятые разработкой ИИ-продуктов, рассчитанных на корпоративных клиентов. Создание фонда является частью более масштабного плана, в рамках которого IBM планирует нарастить присутствие в быстрорастущей ИИ-отрасли. Помимо денег фонд обеспечит и комплексную поддержку для выхода на рынок, в том числе в виде возможности установить партнёрские отношения с самой IBM. Новая структура Enterprise AI Venture Fund станет проводником для стартапов, стремящихся поскорее перейти с раннего этапа развития к гиперросту. Особое внимание будет уделяться решениям для узконаправленных проектов. Кроме того, компании получат доступ к опыту техногиганта и стратегиям выхода на рынок. Вместе с тем, по имеющимся данным, IBM не намерена вкладывать много средств в ИИ-стартапы, напрямую конкурирующие с существующими решениями. IBM инвестировала немалые средства в сторонние ИИ-стартапы и до учреждения фонда. В сентябре она поддержала раунд инвестиций HiddenLayer общей стоимостью $50 млн и участвовала в инвестициях в объёме $235 млн в компанию Hugging Face. По прогнозам IBM, ИИ к 2030 году позволит «высвободить продуктивность» на $16 трлн, а запуск венчурного фонда открывает дополнительный канал для использования потенциала ИИ и развития компаний.

10.11.2023 [16:26], Сергей Карасёв

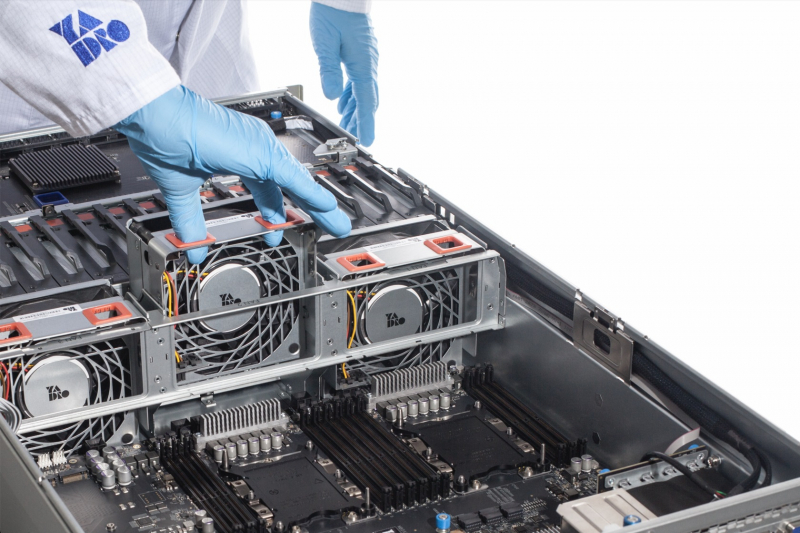

ВТБ представил полностью российский ПАК «Куб импортозамещения» на серверах YADROВТБ анонсировал программно-аппаратный комплекс (ПАК) «Куб импортозамещения», использующий исключительно российские технологии. Система предназначена для построения IT-инфраструктур разного масштаба. Решение состоит из импортозамещённых компонентов как на уровне инфраструктуры, так и на уровне ПО. В настоящее время ПАК составляет основу ИТ-ландшафта ВТБ, сообщает компания. Аппаратная составляющая «Куба импортозамещения» использует серверы российской компании YADRO и телеком-оборудование Бифорком Тек. В основу программной части легла отечественная ОС Astra Linux. Кроме того, применяется платформа VTB.Cloud, которая обеспечивает облачные мощности для развёртывания виртуальных машин, количество которых может составлять от 3,5 до 5 тыс. (на базе одного «куба»). В ВТБ отмечают, что на основе ПАК функционирует более 70 % систем банка, а в 2024 году этот показатель планируется поднять практически до 100 %. Кроме того, ВТБ довел долю расходов на отечественный софт до 75 % в общем объёме расходов на ПО. Отмечается, что банк продолжает работу по миграции своих информационных систем из дата-центров предыдущего поколения на новые площадки. Замещён уже пятый по счёту ЦОД, а до конца 2024 года планируется заместить ещё два нецелевых дата-центра. «На пути к обеспечению технологического суверенитета мы научились не только заменять одни решения другими, но и создавать принципиально новое. Одним из таких решений стал "Куб импортозамещения". Нам удалось создать универсальный блок для строительства и почти неограниченного масштабирования ИТ-инфраструктуры под потребности бизнеса. Мы готовы делиться накопленным опытом и помогать в распространении таких комплексов на российском рынке», — сообщил представитель компании.

10.11.2023 [16:11], Сергей Карасёв

ИИ-стартап Anthropic задействует чипы Google TPU v5e для обучения моделейСтартап Anthropic, специализирующийся на технологиях генеративного ИИ, по информации Datacenter Dynamics, намерен использовать ускорители Google TPU для обучения своих систем, включая большую языковую модель Claude. Многие компании вынуждены искать альтернативы дефицитным чипам NVIDIA, хотя это и требует дополнительных затрат для адаптации ПО. Речь идёт о чипах Google TPU v5e, которые были анонсированы в августе нынешнего года. Это специализированные решения, предназначенные для обучения нейросетей или инференс-систем среднего и большого классов. Ускоритель содержит четыре блока матричных вычислений, по одному блоку для скалярных и векторных расчётов, а также HBM2-память.

Источник изображения: pixabay.com Google и Anthropic уже связывают партнёрские отношения. В частности, в конце 2022-го Google приобрела в этом ИИ-стартапе долю в размере 10 % за $300 млн. В октябре 2023-го стало известно, что Google предоставит Anthropic дополнительно $500 млн, а позднее — ещё $1,5 млрд. Google уже добавила в своё облако ИИ-модели Anthropic, а стартап, в свою очередь, развернул один из самых крупных кластеров Google Kubernetes Engine (GKE) для ИИ. Между тем интерес к Anthropic проявляют и другие компании. Так, в августе нынешнего года SK Telecom вложила $100 млн в этот ИИ-стартап. А в сентябре Amazon объявила о намерении инвестировать в Anthropic до $4 млрд. По условиям соглашения, Anthropic будет использовать облачные ресурсы AWS; кроме того, стороны займутся разработкой чипов Trainium и Inferentia нового поколения.

09.11.2023 [16:15], Сергей Карасёв

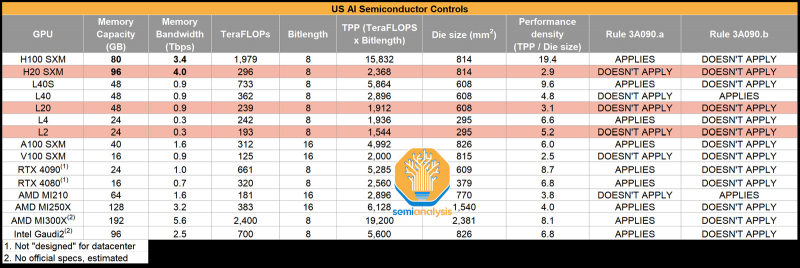

NVIDIA якобы готовит для Китая три новых ускорителя взамен подпавших под санкции: H20, L20 и L2Компания NVIDIA, по сообщению Reuters, планирует выпустить три новых ИИ=ускорителя, модифицированных специально для Китая с учётом дополнительных санкций со стороны США. Изделия фигурируют под обозначениями HGX H20 (SXM), L20 (PCIe) и L2 (PCIe), а их официальная презентация состоится не раньше 16 ноября. Напомним, в середине октября 2023 года США ввели новые ограничения на поставку передовых чипов NVIDIA в Китай: они затронули решения A800 и H800 — модифицированные версии A100 и H100, созданные специально для рынка КНР с учетом ранее действовавших американских ограничений. После этого NVIDIA пришлось искать новые регионы сбыта для «урезанных» ускорителей, предназначавшихся для Поднебесной. Как теперь сообщается, NVIDIA снова нашла возможность поставлять ускорители на китайский рынок, который потенциально может обеспечить значительную выручку. Решения H20, L20 и L2 не подпадают ни под одно из действующих экспортных ограничений. Обратной стороной медали является то, что производительность у них серьёзно снижена (см. характеристики в таблице выше), передаёт SemiAnalysis. Отмечается, что у NVIDIA уже готовы образцы новых ускорителей для китайского рынка, а их массовое производство будет организовано в течение следующего месяца. Сама компания какие-либо комментарии по поводу обнародованной в интернете информации не даёт.

09.11.2023 [13:50], Андрей Крупин

Президент расширил полномочия и штат ФСТЭК РоссииПрезидент РФ подписал указ, увеличивающий штат работников Федеральной службы по техническому и экспортному контролю и расширяющий её полномочия по управлению безопасностью значимых объектов критической информационной инфраструктуры (КИИ). Об этом сообщает издание D-Russia.ru со ссылкой на официальный портал правовой информации. Согласно документу, предельная штатная численность центрального аппарата ведомства будет увеличена с 260 до 289 сотрудников, территориальных органов — с 1012 до 1101 работника (без учёта персонала для охраны и обслуживания зданий). Также указ наделяет ФСТЭК России полномочиями по созданию информационной автоматизированной системы для управления деятельностью по технической защите информации и обеспечению безопасности значимых объектов КИИ.  В рамках своей компетенции ФСТЭК России будет вести централизованный учёт информационных систем и иных объектов КИИ по отраслям экономики, а также мониторинг и оценку текущего состояния технической защиты информации и обеспечения безопасности значимых объектов критической информационной инфраструктуры. Также в числе обязанностей ведомства значится оперативное информирование органов власти, местного самоуправления и организаций об угрозах безопасности информации и уязвимостях информационных систем и иных объектов КИИ, а также о мерах по технической защите от этих угроз и уязвимостей. Список объектов критической информационной инфраструктуры страны включает телекоммуникационные и IT-системы, а также АСУ ТП, которые используются в государственных органах, здравоохранении, на транспорте и в связи, кредитно-финансовой сфере, топливно-энергетическом комплексе и различных отраслях промышленности: атомной, оборонной, ракетно-космической, химической и других.

09.11.2023 [01:35], Руслан Авдеев

Microsoft из-за прожорливости Bing Chat пришлось договориться об аренде ИИ-ускорителей NVIDIA у OracleТочно неизвестно, велик ли спрос на ИИ-сервисы Microsoft или у компании просто недостаточно вычислительных ресурсов, но IT-гиганту пришлось договариваться с Oracle об использовании ИИ-ускорителей в ЦОД последней. Как сообщает The Register, речь идёт о применении оборудования Oracle для «разгрузки» некоторых языковых моделей Microsoft, применяемых в Bing. Во вторник компании анонсировали многолетнее соглашение. Как сообщают в Microsoft, одновременное использование компанией как Oracle Cloud, так и Microsoft Azure расширит возможности клиентов и ускорит работу с поисковыми сервисами. Сотрудничество связано с тем, что Microsoft надо всё больше вычислительных ресурсов для заявляемого «взрывного роста» её ИИ-сервисов, а у Oracle как раз имеются десятки тысяч ускорителей NVIDIA A100 и H100 для аренды.

Источник изображения: cliff1126/pixabay.com Служба Oracle Interconnect обеспечивает взаимодействие с облаком Microsoft Azure, что позволяет работающим в Azure сервисам взаимодействовать с ресурсами Oracle Cloud Infrastructure (OCI). Раньше такое решение уже применялось, но для сторонних клиентов двух компаний. Теперь Microsoft применяет Interconnect наряду с Azure Kubernetes Service для организации работы ИИ-узлов в облаке Oracle на благо Bing Chat. Microsoft ещё в феврале интегрировала чат-бота Bing Chat в свой поисковый сервис и свой браузер. Не так давно добавилась и возможность, например, генерировать изображения прямо в процессе диалога. При этом использование больших языковых моделей требует огромного числа ускорителей для их тренировки, но для инференса необходимы ещё большие вычислительные мощности. В Oracle утверждают, что облачные суперкластеры компании, которые, вероятно, будет использовать Microsoft, могут масштабироваться до 32 768 ИИ-ускорителей A100 или 16 384 ускорителей H100 с использованием RDMA-сети с ультранизкой задержкой. Дополнением является хранилище петабайтного класса. В самой Microsoft избегают говорить, сколько именно узлов Oracle нужно компании, причём, похоже, не намерены делать этого и в будущем. Конкуренты сотрудничают уже не в первый раз. В сентябре Oracle сообщала о намерении размещать системы с базами данных в ЦОД Azure. Более того, ещё в мае 2023 года Microsoft и Oracle изучали возможность аренды ИИ-серверов друг у друга на случай, если у них вдруг не будет хватать вычислительных мощностей для крупных облачных клиентов. Ранее ходили слухи, что похожие соглашения Microsoft подписала с CoreWeave и Lambda Labs, к которым NVIDIA более благосклонна в вопросах поставки ускорителей. Попутно Microsoft ищет более экономичные альтернативы языковым моделям OpenAI.

08.11.2023 [20:00], Игорь Осколков

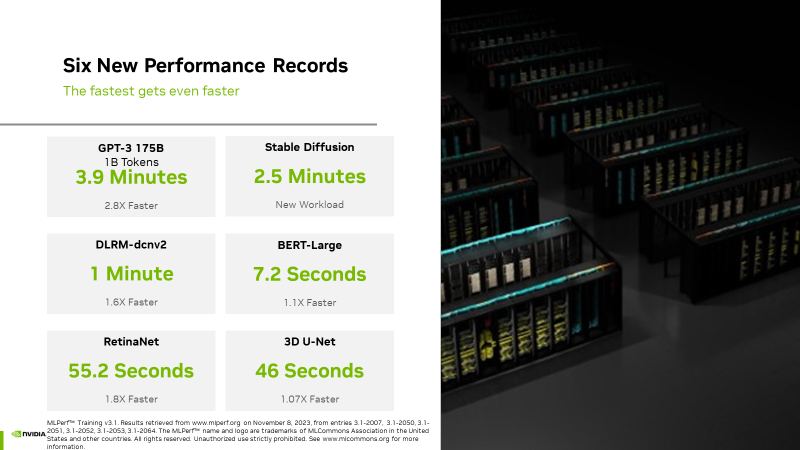

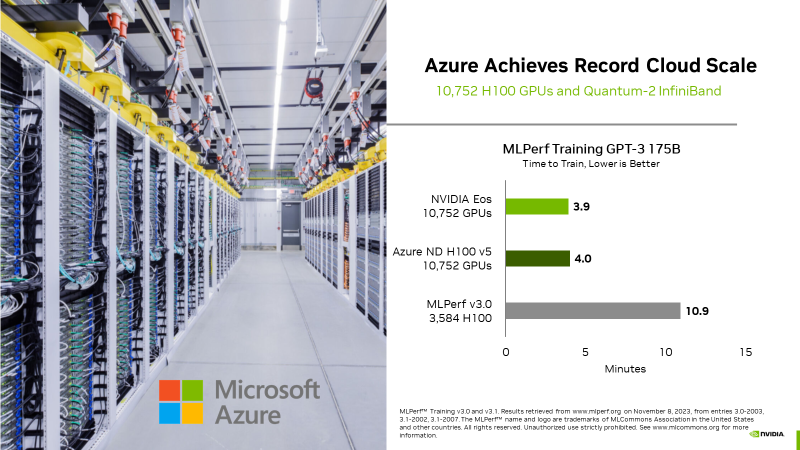

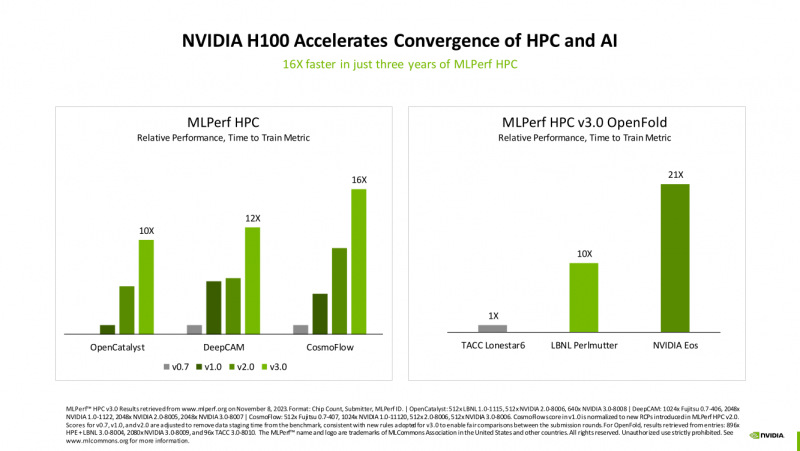

Счёт на секунды: ИИ-суперкомпьютер NVIDIA EOS с 11 тыс. ускорителей H100 поставил рекорды в бенчмарках MLPerf TrainingВместе с публикацией результатов MLPerf Traning 3.1 компания NVIDIA официально представила новый ИИ-суперкомпьютер EOS, анонсированный ещё весной прошлого года. Правда, с того момента машина подросла — теперь включает сразу 10 752 ускорителя H100, а её FP8-производительность составляет 42,6 Эфлопс. Более того, практически такая же система есть и в распоряжении Microsoft Azure, и её «кусочек» может арендовать каждый, у кого найдётся достаточная сумма денег. Суммарно EOS обладает порядка 860 Тбайт памяти HBM3 с агрегированной пропускной способностью 36 Пбайт/с. У интерконнекта этот показатель составляет 1,1 Пбайт/с. В данном случае 32 узла DGX H100 объединены посредством NVLink в блок SuperPOD, а за весь остальной обмен данными отвечает 400G-сеть на базе коммутаторов Quantum-2 (InfiniBand NDR). В случае Microsoft Azure конфигурация машины практически идентичная с той лишь разницей, что для неё организован облачный доступ к кластерам. Но и сам EOS базируется на платформе DGX Cloud, хотя и развёрнутой локально. В рамках MLPerf Training установила шесть абсолютных рекордов в бенчмарках GPT-3 175B, Stable Diffusion (появился только в этом раунде), DLRM-dcnv2, BERT-Large, RetinaNet и 3D U-Net. NVIDIA на этот раз снова не удержалась и добавила щепотку маркетинга на свои графики — когда у тебя время исполнения теста исчисляется десятками секунд, сравнивать свои результаты с кратно меньшими по количеству ускорителей кластерами несколько неспортивно. Любопытно, что и на этот раз сравнивать H100 приходится с Habana Gaudi 2, поскольку Intel не стесняется показывать результаты тестов. NVIDIA очередной раз подчеркнула, что рекорды достигнуты благодаря оптимизациям аппаратной части (Transformer Engine) и программной, в том числе совместно с MLPerf, а также благодаря интерконнекту. Последний позволяет добиться эффективного масштабирования, близкого к линейному, что в столь крупных кластерах выходит на первый план. Это же справедливо и для бенчмарков из набора MLPerf HPC, где система EOS тоже поставила рекорд.

08.11.2023 [14:21], Сергей Карасёв

«Аквариус» представила СХД Wareus формата 4U вместимостью до 8400 ТбайтРоссийская компания «Аквариус» выпустила высокопроизводительные СХД семейства Wareus с управляющим ПО собственной разработки. Утверждается, что новинки подходят для задач общего назначения и критической важности. Решения выполнены в формате 4U. Устройства несут на борту два полностью резервируемых контроллера, работающих по схеме Active–Active. В оснащение входят четыре неназванных 24-ядерных процессора Intel Xeon (до 96 ядер на систему) и от 256 Гбайт до 2 Тбайт оперативной памяти на контроллер. СХД построены на основе программного комплекса управления Wareus, который создан на базе принципов безопасной разработки ПО. Софт спроектирован специалистами «Аквариус» с нуля для обеспечения управления современными высокопроизводительными СХД корпоративного класса. Реализовано управление физическими носителями, рабочими и резервными группами дисков и пулами. Доступны варианты с одной или двумя дисковыми полками на 24 носителя в одном корпусе, а также модификации с внешними подключаемыми дисковыми полками (JBOD/JBOF/AFA). Предлагаются СХД на основе SAS/NVMe SSD суммарным объёмом до 4600 Тбайт, а также на основе SAS HDD общей вместимостью до 8400 Тбайт. Всего СХД может обслуживать до 600 накопителей. Сетевая подсистема поддерживает стандарты 10GbE/25GbE/50GbE/100GbE. Упомянута поддержка iSCSI, RDMA, RoCEv2. Возможно формирование массивов RAID 4/5/6. Доступен специальный высокопроизводительный алгоритм RAID Multi Mirror, который работает в режиме параллельного доступа к физическим носителям и позволяет в несколько раз повысить потоковую производительность СХД. Среди других особенностей разработчик выделяет следующие функции:

08.11.2023 [02:13], Владимир Мироненко

Baidu закупила неанонсированные ИИ-ускорители Huawei Ascend 910B вместо решений NVIDIA из-за санкций СШАВ связи с введением новых экспортных ограничений США, лишивших китайские компании доступа даже к ускорителям A800 и H800, предназначенным для китайского рынка, им пришлось искать альтернативу у отечественных производителей. По данным Reuters, техногигант Baidu, один из ведущих игроков на китайском рынке ИИ, ещё в августе, то есть за месяц до запрета США, разместил заказ на поставку ИИ-ускорителей у Huawei Technologies. По словам источника Reuters, Baidu заказала для установки в 200 серверах 1600 ИИ-ускорителей Ascend 910B, разработанных Huawei разработала в качестве альтернативы NVIDIA A100. Причём к октябрю Huawei поставила порядка 1000 ускорителей. По данным источника, стоимость контракта составляет ¥450 млн ($61,83 млн), срок выполнения — до конца года. Сумма контракта сравнительно небольшая по сравнению с обычными закупками чипов китайских компаний у NVIDIA, но это может превратиться в тенденцию, грозящую американскому чипмейкеру потерей крупных клиентов. Впрочем, уже сейчас NVIDIA, по данным The Wall Street Journal, пришлось из-за введения санкций разорвать контракты на поставку ускорителей китайским фирмам в следующем году на сумму более $5 млрд. А для Huawei это открывает доступ к рынку объёмом $7 млрд. Как сообщается, чипы Huawei уступают по производительности ускорителям NVIDIA, но для китайского рынка считаются лучшим вариантом. «Они заказали 910B, чтобы подготовиться к будущему, когда у них, возможно, больше не будет возможности делать закупки у NVIDIA», — сообщил источник Reuters.

Изображение: Huawei Официально ускоритель Ascend 910B, представляющий собой следующее поколение 7-нм чипа Ascend 910, анонсирован не был, хотя некоторые упоминания о нём встречаются в публичных комментариях китайских компаний и учёных, а также в технических руководствах на веб-сайте Huawei. Председатель китайского IT-гиганта iFlyTek похвалил 910B, который, по его словам, «в основном такой же как NVIDIA A100», отметив, что iFlyTek сотрудничает с Huawei в деле разработки аппаратного обеспечения. |

|