Материалы по тегу: ии

|

14.11.2023 [19:04], Владимир Мироненко

Ускорители NVIDIA GH200 появились во всех облачных регионах VultrVultr, крупнейший в мире частный облачный провайдер, объявил о доступности суперчипа NVIDIA GH200 Grace Hopper во всех своих 32 облачных регионах. Портфолио провайдера также включает предложения на базе HGX H100, A100, L40S, A40 и A16. Vultr видит свою миссию в том, чтобы сделать HPC-решения простыми в использовании и доступными для предприятий и разработчиков по всему миру. Ускорители NVIDIA интегрированы с широким спектром предложений Vultr в области виртуализированных облачных платформ и bare metal, а также с управляемыми кластерами Kubernetes, управляемыми базами данных, блочными и объектными хранилищами и многим другим. Этот комплексный набор продуктов и услуг делает Vultr предпочтительным универсальным облачным поставщиком для предприятий любого размера с критически важными инициативами в области ИИ и машинного обучения, считает компания.

Источник изображения: Vultr Vultr также объявила о получении статуса NVIDIA Elite в партнёрской сети NVIDIA в области вычислений — NVIDIA Partner Network for Compute Competency. Статус ориентирован на партнёров, которые предоставляют вычислительные платформы с ускорителями NVIDIA для корпоративных заказчиков. Партнёры по Compute должны обеспечивать высокую производительность, масштабируемость и безопасность для каждой платформы.

14.11.2023 [18:29], Руслан Авдеев

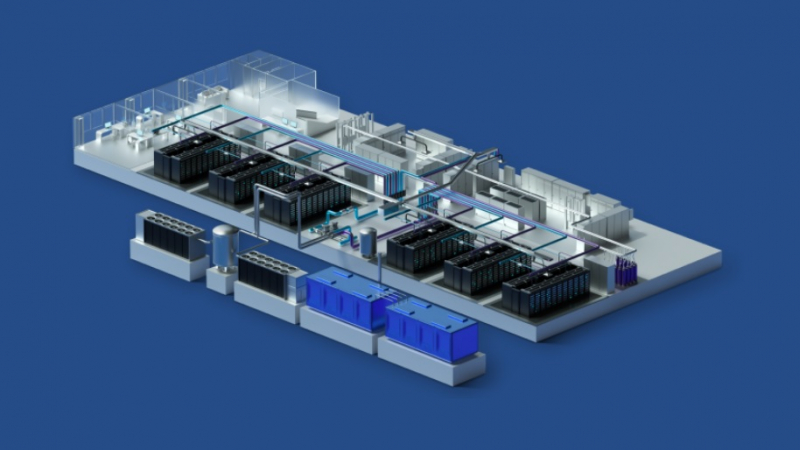

Sitronics Group представила модульный ЦОД для банков, ритейлеров и телеком-операторовВ ходе форума «Финополис» российская Sitronics Group представила модульный ЦОД. Как сообщает пресс-служба компании, серийное производство подобных продуктов запущено ранее в 2023 году в Подмосковье. Решение рассчитано на клиентов разного профиля, от банков до телеком-операторов и ретейлеров. Отмечается, что Sitronics Group способна обеспечить использование в своих ЦОД до 70 % компонентов отечественного производства, а система косвенного адиабатического охлаждения разработана самой Sitronics. Заказчик может получить и платформу виртуализации Sitronics, уже внесённую в реестр российского программного обеспечения, а серверы внесены в реестр Минпромторга страны.

Источник изображения: Sitronics Group В Sitronics Group сообщают, что среди заказчиков весьма востребована модель сдачи готовых к работе дата-центров. Благодаря подходу, предполагающему создание решения «под ключ», компания может обеспечить повышенные уровни защиты IT-инфраструктуры и надёжности оборудования. В то же время заказчик сократит затраты на строительство и обслуживание благодаря централизации работ при воплощении проектов в жизнь и сокращению необходимости в содержании нескольких команд, ответственных за разные аспекты работы ЦОД. Как подчеркнули в компании, модули подобных ЦОД собираются и испытываются на производстве, что положительно сказывается не только на качестве работ, но и обеспечивает быстрое развёртывание на территории заказчика. Важной продающей характеристикой таких ЦОД является мобильность решения — оно изначально создано с учётом возможности транспортировки в стандартном 40-футовом, что позволяет быстро доставить оборудование в любой регион страны. Данные о начале производства первых модульных ЦОД компанией Sitronics Group появились ещё в мае 2023 года. Сообщалось, что такой дата-центр можно развернуть за небольшое время — в течение нескольких месяцев, а построить его можно практически в любом месте.

14.11.2023 [03:20], Алексей Степин

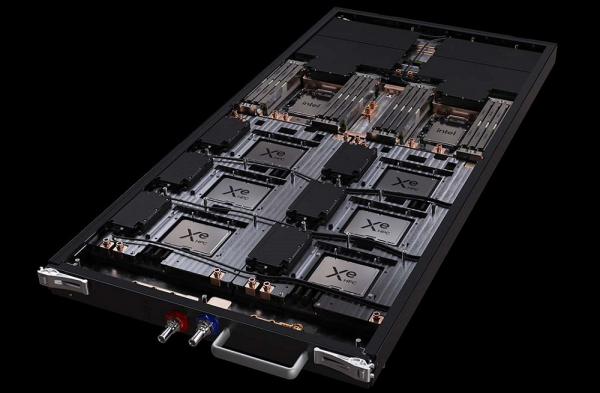

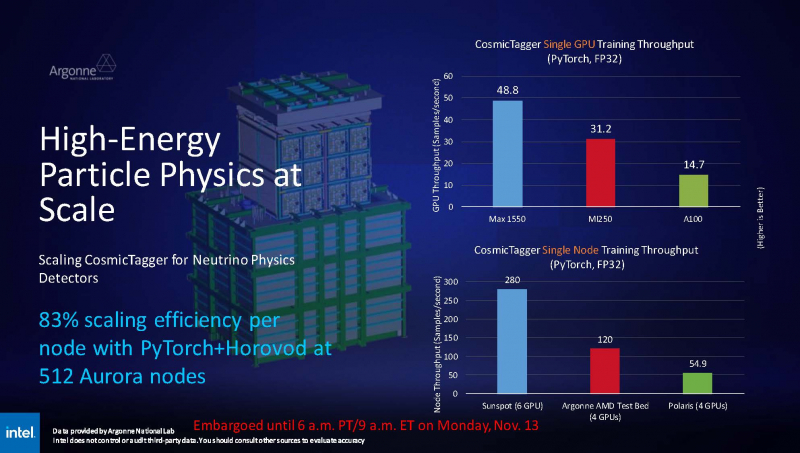

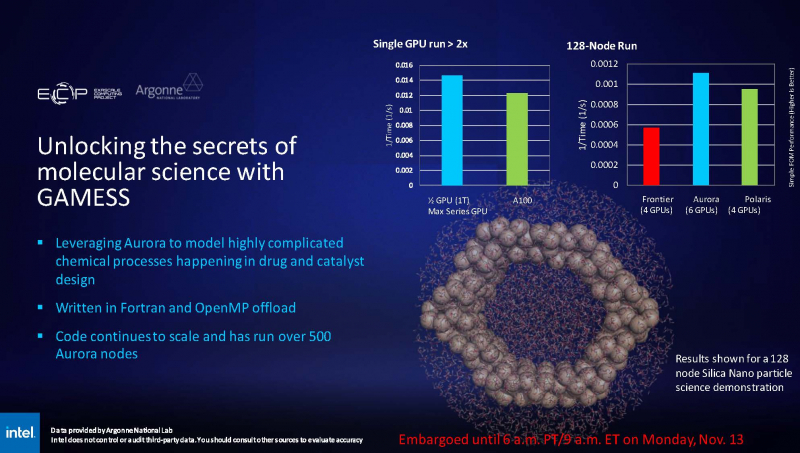

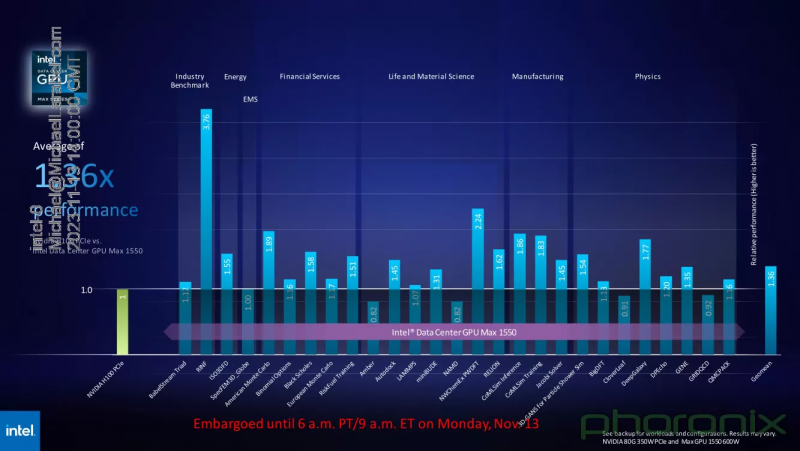

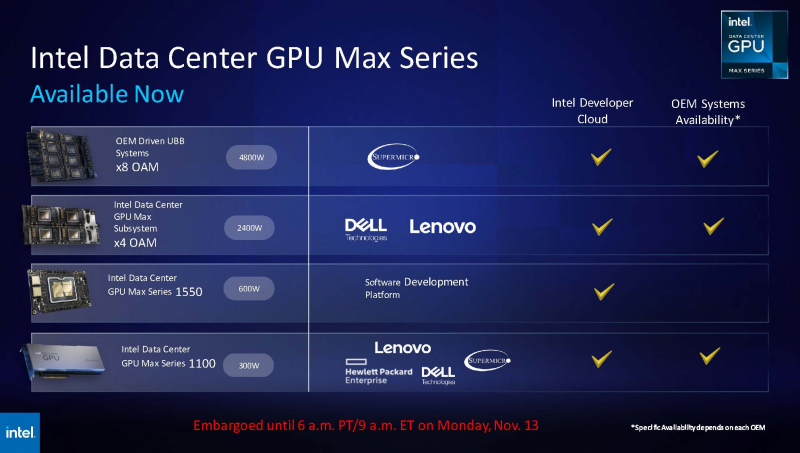

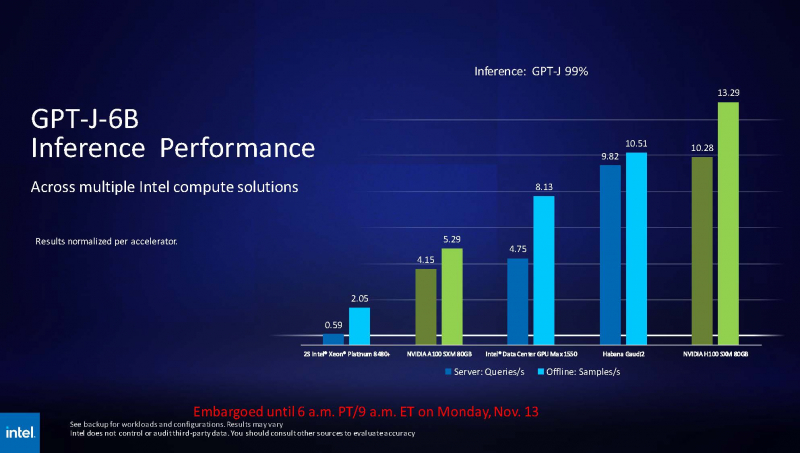

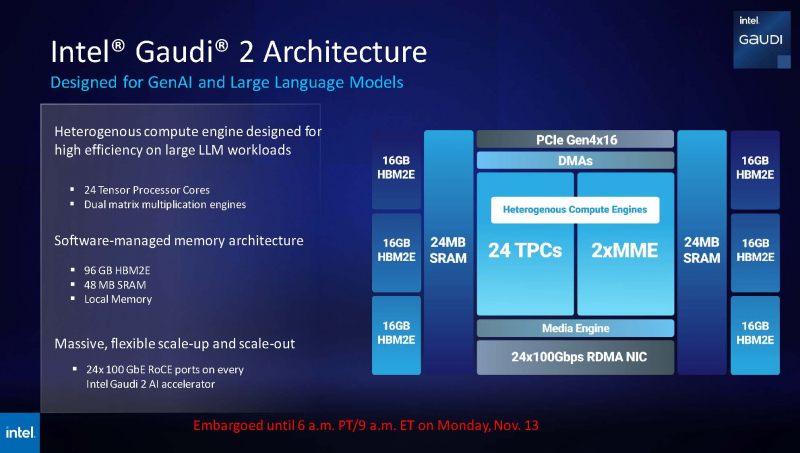

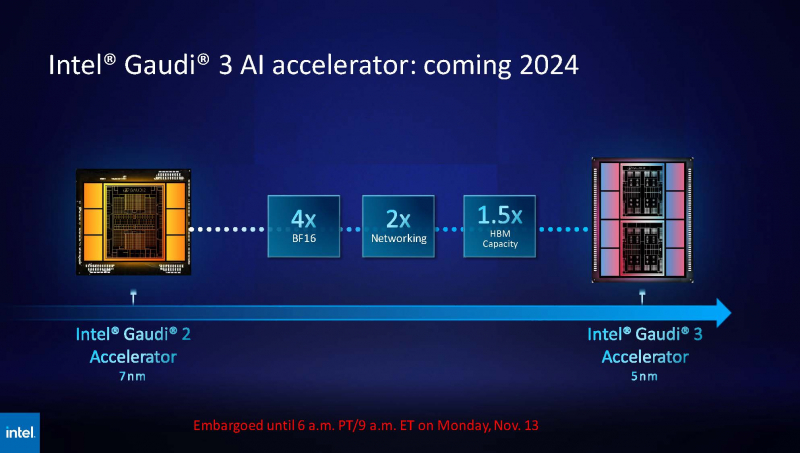

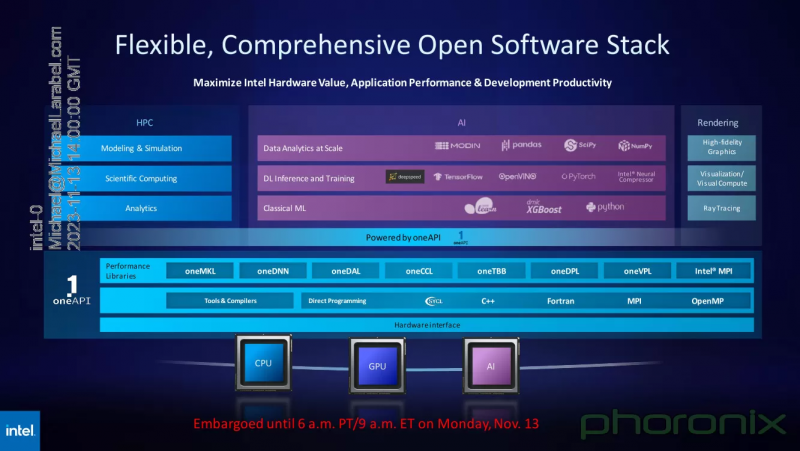

Intel показала результаты тестов ускорителя Max 1550 и рассказала о будущих чипах Gaudi3 и Falcon ShoresВ рамках SC23 корпорация Intel продемонстрировала ряд любопытных слайдов. На них присутствуют результаты тестирования ускорителя Max 1550 с архитектурой Xe, а также планы относительно следующего поколения ИИ-ускорителей Gaudi. При этом компания применила иной подход, нежели обычно — вместо демонстрации результатов, полученных в стенах самой Intel, слово было предоставлено Аргоннской национальной лаборатории Министерства энергетики США, где летом этого года было завершён монтаж суперкомпьютера экза-класса Aurora, занимающего нынче второе место в TOP500.  В этом HPC-кластере применены OAM-модули Max 1550 (Ponte Vecchio) с теплопакетом 600 Вт. Они содержат в своём составе 128 ядер Xe и 128 Гбайт памяти HBM2E. Интерфейс Xe Link позволяет общаться напрямую восьми таким модулям, что обеспечивает более эффективную масштабируемость. Хотя настройка вычислительного комплекса Aurora ещё продолжается, уже имеются данные о производительности Max 1550 в сравнении с AMD Instinct MI250 и NVIDIA A100. В тесте физики высоких частиц, использующих сочетание PyTorch+Horovod (точность вычислений FP32), ускорители Intel уверенно заняли первое место, а также показали 83% эффективность масштабирования на 512 узлах Aurora. В тесте, симулирующем поведение комплекса кремниевых наночастиц, ускорители Max 1550, также оказались первыми как в абсолютном выражении, так и в пересчёте на 128-узловой тест в сравнении с системами Polaris (четыре A100 на узел) и Frontier (четыре MI250 на узел). Написанный с использованием Fortran и OpenMP код доказал работоспособность и при масштабировании до более чем 500 вычислительных узлов Aurora. В целом, ускорители Intel Max 1550 демонстрируют хорошие результаты и не уступают NVIDIA H100: в некоторых задачах их относительная эффективность составляет не менее 0,82, но в большинстве других тестов этот показатель варьируется от 1,0 до 3,76. Очевидно, что у H100 появился достойный соперник, который, к тому же, имеет меньшую стоимость и большую доступность. Но сама NVIDIA уже представила чипы (G)H200, а AMD готовит Instinct MI300. Системы на базе Intel Max доступны в различном виде: как в облаке Intel Developer Cloud, так и в составе OEM-решений. Supermicro предлагает сервер с восемью модулями OAM, а Dell и Lenovo — решения с четырьями ускорителями в этом же формате. PCIe-вариант Max 1100 доступен от вышеуказанных производителей, а также у HPE. Помимо ускорителей Max, Intel привела и новые данные о производительности ИИ-сопроцессоров Gaudi2. Компания продолжает активно совершенствовать и оптимизировать программную экосистему Gaudi. В результате, в инференс-системе на базе модели GPT-J-6B результаты ускорителей Gaudi2 уже сопоставимы с NVIDIA H100 (SXM 80 Гбайт), а A100 существенно уступает как Gaudi2, так и Max 1550. Но самое интересное — это сведения о планах относительно следующего поколения Gaudi. Теперь известно, что Gaudi3 будет производиться с использованием 5-нм техпроцесса. Новый чип будет в четыре раза быстрее в вычислениях BF16, а также получит вдвое более мощную подсистему памяти и в 1,5 раза больше памяти HBM. Увидеть свет он должен в 2024 году. Заодно компания напомнила, что процессоры Xeon Emerald Rapids будут представлены ровно через месяц, а Granite Rapids появятся в 2024 году. В 2025 появится чип Falcon Shores, который теперь должен по задумке Intel сочетать в себе GPU и ИИ-сопроцессор. Он объединит архитектуры Habana и Xe в единое решение с тайловой компоновкой, памятью HBM3 и полной поддержкой CXL. Следует отметить, что такая унификация вполне реальна: Intel весьма активно развивает универсальный, гибкий и открытый стек технологий в рамках проекта oneAPI. В него входят все необходимые инструменты — от компиляторов и системных библиотек до средств интеграции с популярными движками аналитики данных, моделями и библиотеками искусственного интеллекта.

13.11.2023 [22:05], Сергей Карасёв

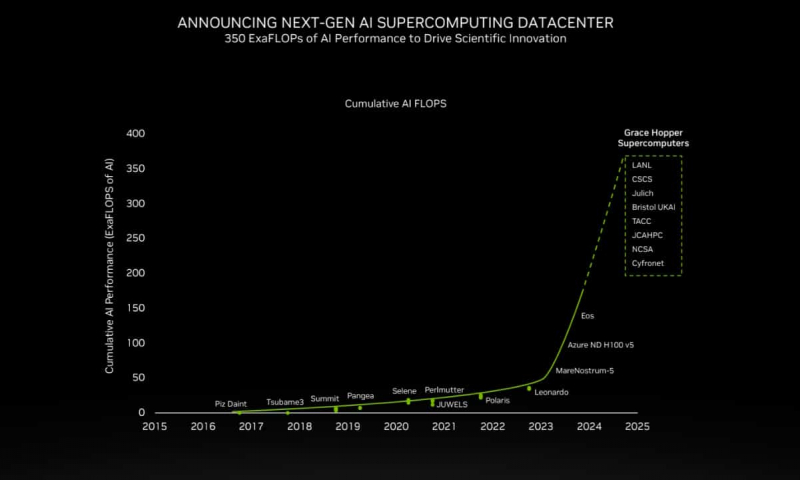

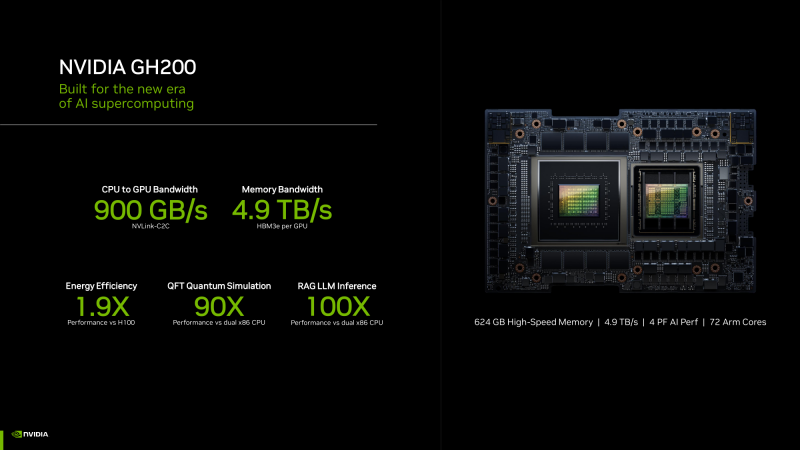

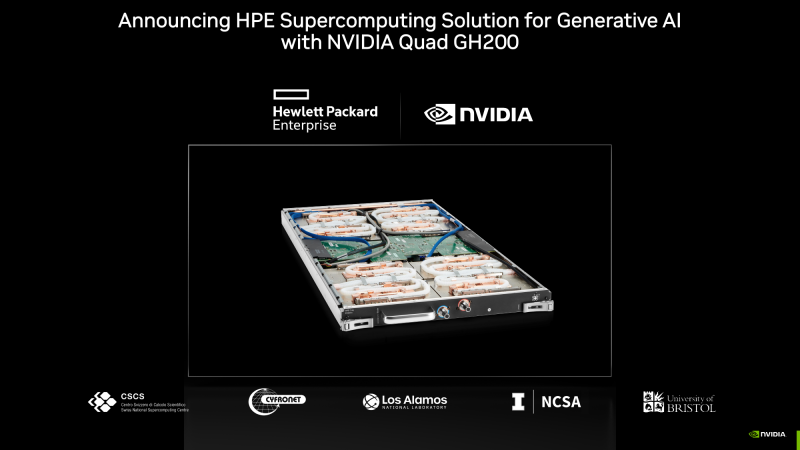

200+ Эфлопс: суперчип NVIDIA Grace Hopper ляжет в основу более 40 ИИ-суперкомпьютеровКомпания NVIDIA сообщила о том, что её суперчип GH200 Grace Hopper ляжет в основу более чем 40 ИИ-суперкомпьютеров по всему миру, которые используются в исследовательских центрах, на облачных площадках и пр. Отмечается, что в скором времени станут доступны десятки новых НРС-систем на базе GH200. Этот суперчип позволяет решать самые сложные научные задачи на базе ИИ, которые требуют обработки терабайт данных. В совокупности вычислительные системы на базе GH200, как сообщается, обеспечат ИИ-производительность около 200 Эфлопс. В частности, HPE объявила, что интегрирует GH200 в суперкомпьютеры HPE Cray. Узлы EX254n оснащаются двумя модулями Quad GH200 с четырьмя суперчипами в каждом, обеспечивая возможность масштабирования до десятков тысяч узлов. Аналогичный подход используется и в платформе Eviden BullSequana XH3000, которую Юлихский исследовательский центр (FZJ) в Германии получит в составе Jupiter — первого европейского суперкомпьютера экзафлопсного класса. Объединённый центр передовых высокопроизводительных вычислений в Японии (JCAHPC) намерен использовать суперчип в своём суперкомпьютере следующего поколения. Техасский центр передовых вычислений при Техасском университете в Остине (США) оборудует суперчипами НРС-систему Vista. Национальный центр суперкомпьютерных приложений при Университете Иллинойса в Урбане-Шампейне будет использовать решения GH200 в составе ИИ-платформы DeltaAI. А Британия получит ИИ-суперкомпьютер Isambard-AI на основе этого суперчипа, который разместится в Бристольском университете. Все эти системы присоединяются к ранее анонсированным платформам на базе GH200 от Швейцарского национального суперкомпьютерного центра (CSCS) и SoftBank Corp. GH200 уже доступен у некоторых поставщиков облачных услуг, таких как Lambda и Vultr. CoreWeave объявила о планах открыть инстансы GH200 в I квартале 2024 года. Другие производители систем, такие как ASRock Rack, ASUS, Gigabyte и Ingrasys, начнут поставки серверов с этими суперчипами к концу года.

13.11.2023 [18:07], Андрей Крупин

СУБД Postgres Pro Standard получила расширенную функциональность и возможность гибкой настройки прав доступаКомпания Postgres Professional сообщила о выпуске новой версии российской СУБД Postgres Pro Standard 16.0.1, построенной на базе свободной объектно-реляционной системы управления базами данных PostgreSQL. В представленный релиз программного комплекса включены расширение синтаксиса SQL/JSON, новые средства мониторинга рабочей нагрузки и возможность гибкой настройки правил доступа к обрабатываемой СУБД информации. В частности, в Postgres Pro Standard версии 16.0.1 появились новые предопределённые роли пользователей. Они позволяют более гибко подходить к выдаче разрешений на выполнение определённых действий в базе данных, не наделяя пользователей избыточными полномочиями. Эта функциональность добавлена в рамках выполнения требований безопасности ФСТЭК России по защите от действий суперпользователя.  Система управления базами данных также получила обновлённые модули, компоненты и библиотеки, в числе которых фигурирует доработанное расширение pg_proaudit, которое обеспечивает регистрацию различных событий, связанных с безопасностью. Отдельное внимание разработчиками было уделено исправлению и устранению выявленных в коде СУБД Postgres Pro Standard ошибок и уязвимостей. С развёрнутым списком новых возможностей и изменений Postgres Pro Standard 16.0.1 можно ознакомиться в примечаниях к релизу. Там же приведены все необходимые инструкции по установке обновлённой версии СУБД.

13.11.2023 [17:00], Игорь Осколков

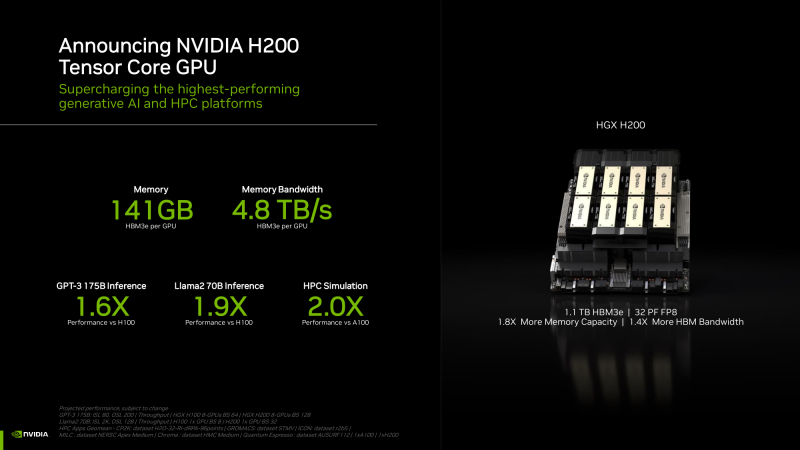

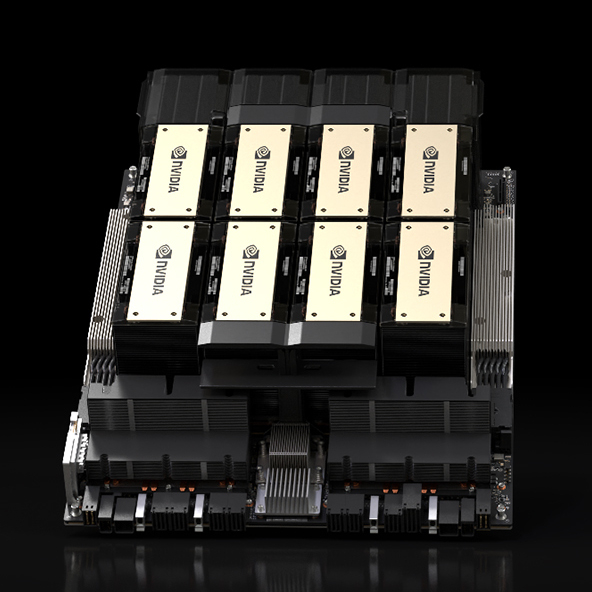

NVIDIA анонсировала ускорители H200 и «фантастическую четвёрку» Quad GH200NVIDIA анонсировала ускорители H200 на базе всё той же архитектуры Hopper, что и их предшественники H100, представленные более полутора лет назад. Новый H200, по словам компании, первый в мире ускоритель, использующий память HBM3e. Вытеснит ли он H100 или останется промежуточным звеном эволюции решений NVIDIA, покажет время — H200 станет доступен во II квартале следующего года, но также в 2024-м должно появиться новое поколение ускорителей B100, которые будут производительнее H100 и H200.

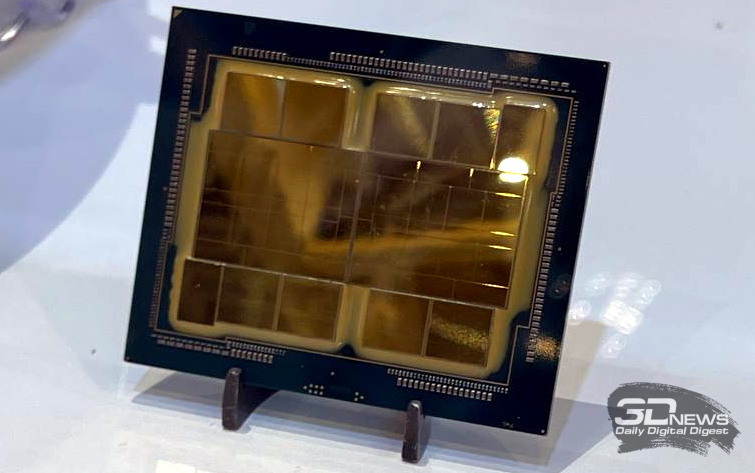

HGX H200 (Источник здесь и далее: NVIDIA) H200 получил 141 Гбайт памяти HBM3e с суммарной пропускной способностью 4,8 Тбайт/с. У H100 было 80 Гбайт HBM3, а ПСП составляла 3,35 Тбайт/с. Гибридные ускорители GH200, в состав которых входит H200, получат до 480 Гбайт LPDDR5x (512 Гбайт/с) и 144 Гбайт HBM3e (4,9 Тбайт/с). Впрочем, с GH200 есть некоторая неразбериха, поскольку в одном месте NVIDIA говорит о 141 Гбайт, а в другом — о 144 Гбайт HBM3e. Обновлённая версия GH200 станет массово доступна после выхода H200, а пока что NVIDIA будет поставлять оригинальный 96-Гбайт вариант с HBM3. Напомним, что грядущие конкурирующие AMD Instinct MI300X получат 192 Гбайт памяти HBM3 с ПСП 5,2 Тбайт/с. На момент написания материала NVIDIA не раскрыла полные характеристики H200, но судя по всему, вычислительная часть H200 осталась такой же или почти такой же, как у H100. NVIDIA приводит FP8-производительность HGX-платформы с восемью ускорителями (есть и вариант с четырьмя), которая составляет 32 Пфлопс. То есть на каждый H200 приходится 4 Пфлопс, ровно столько же выдавал и H100. Тем не менее, польза от более быстрой и ёмкой памяти есть — в задачах инференса можно получить прирост в 1,6–1,9 раза. При этом платы HGX H200 полностью совместимы с уже имеющимися на рынке платформами HGX H100 как механически, так и с точки зрения питания и теплоотвода. Это позволит очень быстро обновить предложения партнёрам компании: ASRock Rack, ASUS, Dell, Eviden, GIGABYTE, HPE, Lenovo, QCT, Supermicro, Wistron и Wiwynn. H200 также станут доступны в облаках. Первыми их получат AWS, Google Cloud Platform, Oracle Cloud, CoreWeave, Lambda и Vultr. Примечательно, что в списке нет Microsoft Azure, которая, похоже, уже страдает от недостатка H100. GH200 уже доступны избранным в облаках Lamba Labs и Vultr, а в начале 2024 года они появятся у CoreWeave. До конца этого года поставки серверов с GH200 начнут ASRock Rack, ASUS, GIGABYTE и Ingrasys. В скором времени эти чипы также появятся в сервисе NVIDIA Launchpad, а вот про доступность там H200 компания пока ничего не говорит. Одновременно NVIDIA представила и базовый «строительный блок» для суперкомпьютеров ближайшего будущего — плату Quad GH200 с четырьмя чипами GH200, где все ускорители связаны друг с другом посредством NVLink по схеме каждый-с-каждым. Суммарно плата несёт более 2 Тбайт памяти, 288 Arm-ядер и имеет FP8-производительность 16 Пфлопс. На базе Quad GH200 созданы узлы HPE Cray EX254n и Eviden Bull Sequana XH3000. До конца 2024 года суммарная ИИ-производительность систем с GH200, по оценкам NVIDIA, достигнет 200 Эфлопс.

13.11.2023 [17:00], Сергей Карасёв

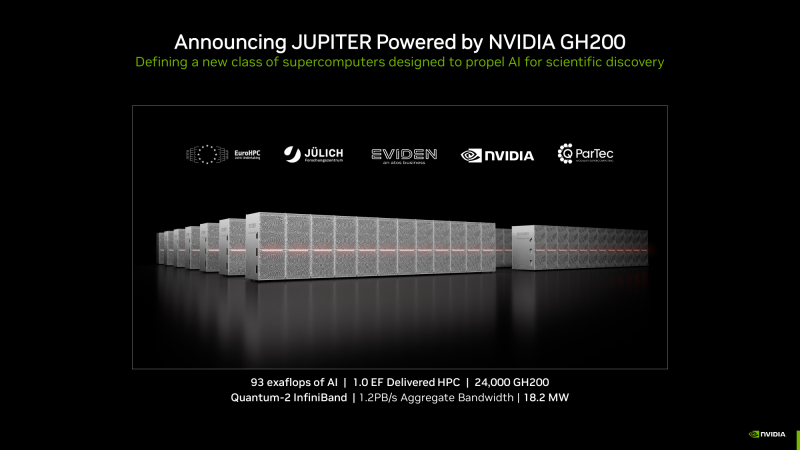

Первый в Европе экзафлопсный суперкомпьютер Jupiter получит 24 тыс. гибридных суперчипов NVIDIA Grace HopperКомпания NVIDIA в ходе конференции по высокопроизводительным вычислениям SC23 сообщила о том, что её суперчип GH200 Grace Hopper станет одной из ключевых составляющих НРС-системы Jupiter — первого европейского суперкомпьютера экзафлопсного класса.

Узел BullSequana XH3000 (Источник здесь и далее: NVIDIA) Jupiter — проект Европейского совместного предприятия по развитию высокопроизводительных вычислений (EuroHPC JU). Комплекс расположится в Юлихском исследовательском центре (FZJ) в Германии. В создании суперкомпьютера участвуют NVIDIA, ParTec, Eviden и SiPearl. Архитектура системы модульная, что позволяет адаптировать её под разные классы задач. В основу одного из основных блоков Jupiter ляжет платформа Eviden BullSequana XH3000 с прямым жидкостным охлаждением, а в состав каждого узла войдут модули Quad GH200. Общее количество суперчипов составит 23752. В качестве интерконнекта будет применяться NVIDIA Quantum-2 InfiniBand. Быстродействие на операциях обучения ИИ составит до 93 Эфлопс, а FP64-производительность должна достичь 1 Эфлопс. При этом общая потребляемая мощность Jupiter составит всего 18,2 МВт. Применять систему Jupiter планируется для решения наиболее сложных задач. Среди них — моделирование климата и погоды в высоком разрешении (на базе NVIDIA Earth-2), создание новых лекарственных препаратов (NVIDIA BioNeMo и NVIDIA Clara), исследования в области квантовых вычислений (NVIDIA cuQuantum и CUDA Quantum), промышленное проектирование (NVIDIA Modulus и NVIDIA Omniverse). Ввод Jupiter в эксплуатацию запланирован на 2024 год.

13.11.2023 [16:16], Сергей Карасёв

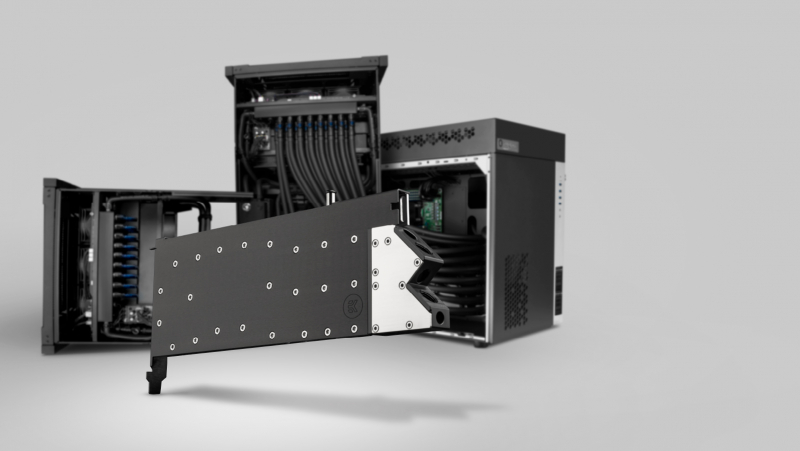

OSS представила защищённый ИИ-сервер Gen 5 AI Transportable на базе NVIDIA H100Компания One Stop Systems (OSS) на конференции по высокопроизводительным вычислениям SC23 представила сервер Gen 5 AI Transportable, предназначенный для решения задач ИИ и машинного обучения на периферии. Устройство, рассчитанное на монтаж в стойку, выполнено в корпусе уменьшенной глубины. Новинка соответствует американским военным стандартам в плане устойчивости к ударам, вибрации, диапазону рабочих температур и пр. Сервер может применяться в составе мобильных дата-центров, на борту грузовиков, самолётов и подводных лодок. Возможна установка четырёх ускорителей NVIDIA H100 и до 16 NVMe SSD суммарной вместимостью до 1 Пбайт. Говорится о поддержке до 35 одновременных ИИ-нагрузок. Кроме того, могут применяться сетевые решения стандарта 400 Гбит/с. При необходимости можно подключить NAS-хранилище в усиленном исполнении.

Источник изображения: OSS Для сервера доступны различные варианты охлаждения: воздушное, автономное жидкостное или внешний теплообменник с жидкостным контуром. Поддерживаются различные варианты организации питания с переменным и постоянным током для использования на суше, в воздухе и море. При использовании СЖО ускорители H100, по всей видимости, комплектуются водоблоком EK-Pro NVIDIA H100 GPU WB. Реализована фирменная архитектура Open Split-Flow: она обеспечивает высокую эффективность охлаждения даже при небольшой скорости потока жидкости, что позволяет применять не слишком мощные помпы или помпы, работающие с невысокой скоростью. Микроканалы, фрезерованные на станке с ЧПУ, обладают минимальным гидравлическим сопротивлением потоку. Водоблок имеет однослотовое исполнение. Предусмотрено проприетарное ПО U-BMC (Unified Baseboard Management Controller) для динамического управления скоростью вентиляторов, мониторинга системы и пр. Сервер подходит для монтажа в большинство 19″ стоек.

13.11.2023 [13:56], Сергей Карасёв

ИИ-стартап Aleph Alpha привлёк более $500 млн, в том числе от HPE и SAPНемецкий стартап Aleph Alpha, специализирующийся на технологиях ИИ, сообщил о проведении крупного раунда финансирования Series B, в ходе которого на развитие получено более $500 млн. Средства предоставили, в частности, HPE и SAP. Фирма Aleph Alpha, сформированная в 2019 году, занимается разработкой больших языковых моделей (LLM). При этом стартап делает упор на концепцию «суверенитета данных». Свои LLM компания предлагает корпоративным заказчикам и государственным учреждениям.

Источник изображения: pixabay.com Aleph Alpha создала семейство LLM под названием Luminous, которое включает три модификации: 13 млрд, 30 млрд и 70 млрд параметров. На веб-сайте компании указано, что также планируется разработка более совершенных языковых моделей с числом параметров до 300 млрд. Модели Aleph Alpha могут обрабатывать текст на английском, немецком, французском, итальянском и испанском языках, а также принимать изображения в качестве входных данных. Эти LLM, как утверждается, подходят для решения самых разных задач — от генерации текста до сортировки документов по темам. Доступ к моделям предоставляется через API, так что разработчики могут интегрировать их в свои продукты. Программу финансирования Series B возглавили Инновационный парк искусственного интеллекта (Ipai), фонд Bosch Ventures и компании Schwarz Group. Деньги выделили упомянутые НРЕ и SAP, а также Christ&Company Consulting и Burda Principal Investments. Стартап вложит полученные средства в дальнейшую разработку LLM и в коммерциализацию своих решений.

13.11.2023 [10:10], SN Team

4–5 декабря 2023 года пройдёт открытая конференция ИСП РАН, посвящённая 75-летию отечественных информационных технологий4–5 декабря 2023 года в главном здании Российской академии наук в Москве состоится ежегодная Открытая конференция ИСП РАН им. В.П. Иванникова, посвящённая 75-летию отечественных информационных технологий. Главная цель — обмен результатами фундаментальных исследований и практическим опытом их внедрения. В 2022 году в конференции приняли участие более 650 человек. Организаторами мероприятия выступают Институт системного программирования имени В.П. Иванникова РАН, Российская академия наук, НИЦ «Курчатовский институт», Академия криптографии РФ, Фонд перспективных исследований, международная ассоциация IEEE и IEEE Computer Society. Конференция проводится при поддержке ФСТЭК России. К участию в пленарном заседании приглашены представители руководства РАН, вузов, ИТ-компаний, государственных министерств и ведомств. «Развитие нашего института всегда опиралось на историю. От наших предшественников мы унаследовали великую научную школу и модель работы, основанную на интеграции науки, образования и индустрии. Со временем мы перешли от разработки отдельных технологий к формированию международных сообществ, — рассказал директор ИСП РАН, академик РАН Арутюн Аветисян. — Вместе с десятками компаний и вузов мы создаём репозиторий доверенного системного ПО, работаем над биомедицинскими решениями, повышаем безопасность искусственного интеллекта. Наши технологии внедрены более чем в 100 компаниях, в том числе в Samsung и в «Лаборатории Касперского». Только за последний год более 300 наших патчей добавлены в такие проекты, как ядро Linux, PyTorch и TensorFlow. Вместе с партнёрами мы работаем над обеспечением технологической независимости страны, опираясь на лучшие достижения прошлого, и сохраняем открытость на международном уровне — для успешного будущего». На конференции будут представлены доклады по таким темам, как технологии анализа, моделирования и трансформации программ; управление данными и информационные системы; решение задач механики сплошных сред с использованием СПО; САПР микроэлектронной аппаратуры и лингвистические системы анализа. Состоится также выставка технологий ИСП РАН и компаний-партнёров. Важной частью конференции станет секция «Образование, технологии, сообщество: системный подход к безопасной разработке». Она объединит три тематических блока, которые будут посвящены формированию единой концепции обучения системному программированию, результатам совместной работы ИСП РАН и компаний-партнёров в Технологическом центре исследования безопасности ядра Linux и другим актуальным темам в области кибербезопасности. В секции примут участие представители таких компаний, как «Лаборатория Касперского», «ИнфоТекс», CodeScoring, ГК «Солар», а также представители московских и региональных вузов (МГТУ им. Н.Э. Баумана, Новгородский государственный университет, Чувашский государственный университет и другие). Состоится также традиционный круглый стол «Цифровая медицина», который объединит десятки врачей и ИТ-специалистов и подведёт научно-практические итоги года в этой области. На выставке будут представлены платформа для анализа биомедицинских данных, разработанная в ИСП РАН, и прикладное решение на её основе — сервис для нейросетевой классификации ЭКГ. Посетители смогут прямо на стенде снять ЭКГ, получить консультацию врача и проверить результаты с помощью сервиса нейросетевой классификации. В рамках конференции запланирован II воркшоп «Системы доверенного искусственного интеллекта», в котором примут участие представители Исследовательского центра доверенного искусственного интеллекта (ИЦДИИ) ИСП РАН, а также его индустриальных партнёров («Лаборатория Касперского», «ЕС-Лизинг», «Технопром», «Интерпроком»). Приглашаются также сотрудники других исследовательских центров. Участие в конференции бесплатное, необходимо зарегистрироваться: https://www.isprasopen.ru/#Registration. Сайт мероприятия: https://www.isprasopen.ru/.  |

|