Материалы по тегу: ии

|

17.11.2023 [13:33], Сергей Карасёв

Alibaba отказалась от выделения облачного бизнеса в самостоятельную публичную компаниюКитайский IT-гигант Alibaba Group Holding в финансовом отчёте за квартал, завершившийся 30 сентября 2023 года, сообщил о том, что не будет выделять облачный бизнес в самостоятельную компанию с последующим выходом на биржу. Причина — ужесточившиеся санкции со стороны США в отношении КНР. Весной нынешнего года Alibaba объявила о намерении провести масштабную реорганизацию, в ходе которой на базе облачных активов планировалось создать отдельную структуру. В дальнейшем Alibaba рассчитывала провести IPO этой компании. Около двух месяцев назад, в середине сентября 2023-го, генеральный директор Alibaba Даниэль Чжан (Daniel Zhang), также возглавлявший облачное подразделение компании, неожиданно подал в отставку. Тогда сообщалось, что его место займёт Эдди Ву (Eddie Wu) — один из соучредителей Alibaba и один из первых её разработчиков. И вот теперь говорится, что планы по трансформации облачного бизнеса пересмотрены.

Источник изображения: Alibaba В финансовом отчёте сказано, что после того, как США расширили свои правила экспортного контроля, чтобы еще больше ограничить поставки в Китай современных компьютерных чипов и оборудования для производства полупроводников, сформировались неопределённости в отношении перспектив подразделения Alibaba Cloud Intelligence Group. Санкции могут негативно повлиять на возможности группы предлагать облачные продукты и услуги и выполнять обязательства по существующим контрактам. Кроме того, ограничивается потенциал модернизации оборудования. «Мы считаем, что полное выделение Cloud Intelligence Group в самостоятельную структуру может не дать желаемого эффекта. Поэтому мы решили не приступать к реализации данного плана, а вместо этого сосредоточимся на разработке модели устойчивого роста для Cloud Intelligence Group в нынешней нестабильной ситуации», — говорится в заявлении Alibaba. По итогам закрытого квартала выручка Alibaba Group составила ¥224,79 млрд ($30,81 млрд), что на 9 % больше прошлогоднего результата. Чистая прибыль оказалась на уровне ¥27,71 млрд ($3,80 млрд). Облачное подразделение Cloud Intelligence Group показало квартальную выручку в размере ¥27,65 млрд ($3,79 млрд), что соответствует росту примерно на 2 % в годовом исчислении.

16.11.2023 [19:11], Андрей Крупин

Первая и единственная: выпущена экспериментальная сборка российской ОС «Альт» для китайской архитектуры Loongarch64Компания «Базальт СПО» выпустила сборку операционных систем «Альт» на базе китайских процессоров с архитектурой Loongarch64. Утверждается, что в настоящий момент это первая и единственная российская ОС, работающая с данной аппаратной платформой. Сборка выполнена с графической средой Xfce на базе нестабильной (экспериментальной) ветки репозитория проекта «Сизиф». Подчёркивается, что на адаптацию программного кода ОС «Альт» для архитектуры Loongarch64 ушло всего девять месяцев. Такой быстрый результат стал возможен благодаря автоматизации сборочного процесса с помощью технологии догоняющей сборки пакетов. «Наша компания представила первую в России операционную систему для архитектуры Loongarch64. Процессоры на её основе появились на отечественном рынке совсем недавно, а значит, организациям и предприятиям предстоит масштабная работа по адаптации программного обеспечения к работе с китайской архитектурой. Операционные системы «Альт» могут стать платформой для тестирования таких продуктов», — сообщил генеральный директор «Базальт СПО».

Источник изображения: «Базальт СПО» Операционные системы «Альт» работают на 8 архитектурах: основных — i586, x86_64, aarch64, armh, ppc64le, и «догоняющих» — «Эльбрус», mipsel, riscv64. Опыт создания ОС для этих аппаратных платформ был использован при портировании на Loongarch64. В дальнейшем планируется релиз дистрибутивов ОС семейства «Альт» для китайской процессорной архитектуры.

16.11.2023 [17:12], Руслан Авдеев

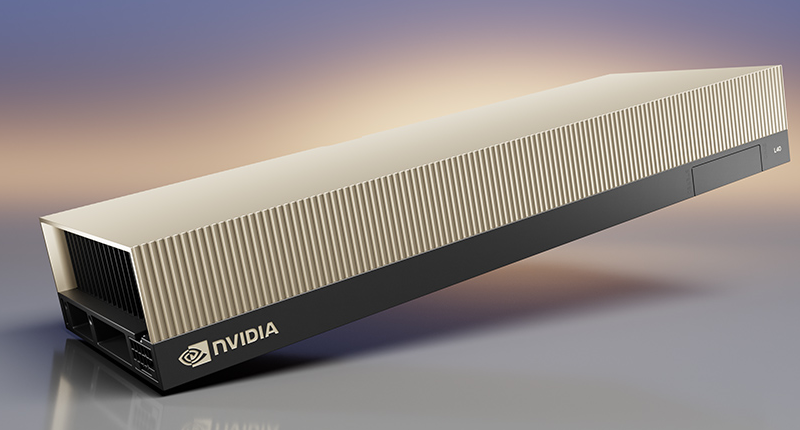

Игры кончились: облачные игровые сервисы помогут пережить дефицит ускорителей для ИИПо мере того, как генеративный ИИ становится всё популярнее, растёт и дефицит вычислительных ресурсов, что создаёт значимые барьеры для новичков, желающих заняться бизнесом в этой сфере. Как сообщает DigiTimes, проблему, возможно, помогут решить облачные игровые сервисы, располагающие огромным числом высокопроизводительных ускорителей, которые можно использовать для ИИ-проектов. Например, тайваньское подразделение японского сервис-провайдера Ubitus располагает десятками тысяч ускорителей — столько имеют немногие бизнесы в IT-отрасли. По мнению некоторых экспертов, облачные игровые сервисы скоро могут принять участие в разработках, связанных с генеративным ИИ. По классификации SemiAnalysis IT-компании делились на две группы: «богатые» ускорителями и «бедные». В первую группу входят немногочисленные компании, владеющие более 20 тыс. ускорителей A100 или H100, например, Google, Anthropic, X, Meta✴, Inflection и OpenAI, причём у некоторых есть и более 100 тыс. ускорителей.

Изображение: NVIDIA В первой половине ноября 2023 года Ubitus объявила о сотрудничестве с Национальным университетом Тайваня в области ИИ-вычислений — компания, возможно, является крупнейшим на острове оператором ускорителей, изначально предназначенных для облачных игровых проектов. Фактически излишки ресурсов уже направляются на работу с большими языковыми моделями (LLM), в частности, на китайском языке. По некоторым данным, IT-гиганты вроде Google уже предлагали компании рассмотреть возможность участия в развитии ИИ-отрасли на Тайване. При этом тайваньские эксперты подчёркивают, что для облачных игр обычно применяют флагманские GPU серии RTX — они гораздо менее производительны в ИИ-задачах, но и на порядок дешевле специализированных ускорителей. Впрочем, в Ubitus утверждают, что преимущественно используют ускорители именно такого типа, включая H100, A100 и L40S в PCIe-исполнении.

16.11.2023 [16:23], Сергей Карасёв

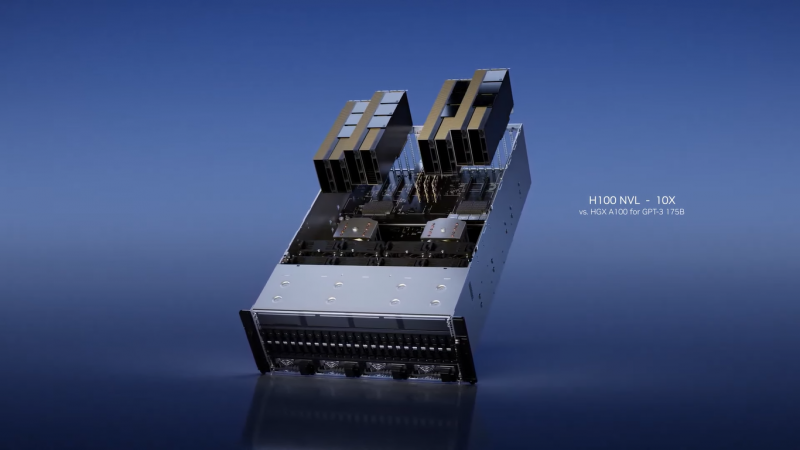

В облаке Microsoft Azure появились первые в отрасли ИИ-инстансы на базе NVIDIA H100 NVLКорпорация Microsoft объявила о том, что на базе облака Azure стали доступны виртуальные машины NC H100 v5 для HPC-вычислений и нагрузок ИИ. Это, как отмечается, первые в отрасли облачные инстансы на базе ускорителей NVIDIA H100 NVL. Данное решение объединяет два PCIe-ускорителя H100, соединённых посредством NVIDIA NVLink. Объём памяти HBM3 составляет 188 Гбайт, а заявленная FP8-производительность (с разреженностью) достигает почти 4 Пфлопс. Инстансы H100 v5 основаны на платформе AMD EPYC Genoa. В зависимости от реализации, доступны 40 или 80 vCPU и 320 и 640 Гбайт памяти соответственно. В первом случае задействован один ускоритель NVIDIA H100 NVL с 94 Гбайт памяти HBM3, во втором — два ускорителя с суммарно 188 Гбайт памяти HBM3. Пропускная способность сетевого подключения — 40 и 80 Гбит/с. В отличие от виртуальных машин серии ND, рассчитанных на самые крупные модели ИИ, инстансы NC оптимизированы для обучения и инференса моделей меньшего размера, которым не требуются сверхмасштабные массивы данных. Виртуальные машины Azure NC H100 v5 также хорошо подходят для определённых НРС-нагрузок: это гидродинамика, молекулярная динамика, квантовая химия, прогнозирование погоды и моделирование климата, а также финансовая аналитика. В 2024 году Microsoft добавит в облако Azure виртуальные машины с новейшими ускорителями NVIDIA H200: оно смогут обрабатывать более крупные модели ИИ без увеличения задержки. А уже сейчас клиентам Azure стал доступен сервис DGX Cloud.

16.11.2023 [16:10], Андрей Крупин

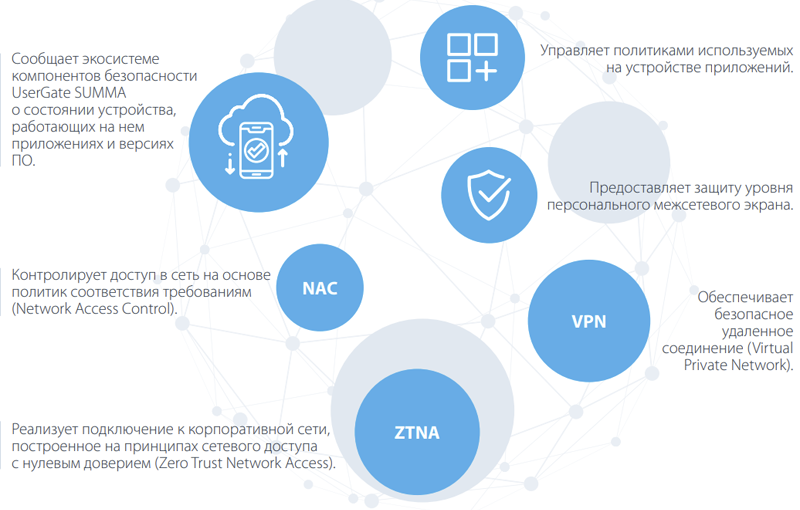

UserGate представила релиз-кандидат ОС UGOS 7.1, а также новые ИБ-решения класса SIEM и EDRРоссийская компания UserGate объявила о релиз-кандидате версии 7.1 операционной системы UGOS, которая является основой для экосистемы UserGate SUMMA, включающей все необходимые инструменты для комплексной защиты современной IT-инфраструктуры. Платформа UGOS 7.1 Release Candidate получила поддержку технологии UserID с расширенными возможностями идентификации пользователей, новый движок IPSv3 модуля обнаружения вторжений и доработанные средства контроля сетевого трафика на уровне приложений L7 по модели OSI с возможностью создания пользовательских сигнатур. Помимо этого, ОС дополнилась поддержкой протокола VPN IKEv2 и технологии UpStream Proxy, позволяющей предоставлять безопасный доступ в интернет там, где он по умолчанию не предусмотрен — например, для обновления продуктов ИБ, находящихся в закрытых сегментах сети.

Экосистема продуктов безопасности UserGate SUMMA В рамках релиз-кандидата UGOS 7.1 компания также представила два новых продукта — UserGate Client и UserGate SIEM Light. UserGate Client — программное обеспечение класса Endpoint Detection & Response (EDR) для конечных станций. Оно обеспечивает безопасное удалённое соединение посредством VPN, контролирует доступ в сеть на основе политик соответствия требованиям (Network Access Control), реализует подключение к корпоративной сети, построенное на принципах сетевого доступа с нулевым доверием (Zero Trust Network Access), и решает прочие задачи по обеспечению защиты пользовательских устройств.

Функции UserGate Client UserGate SIEM Light — система управления событиями информационной безопасности (Security Information and Event Management), отвечающая за сбор информации из различных источников и приведение их к единому формату для удобства последующего разбора и анализа инцидентов. Платформа обладает функциональностью решений класса IRP/SOAR, позволяет анализировать поведение различных процессов, выявлять риски и автоматически обеспечивать на основе этого анализа адекватную реакцию, защищать от угроз или аномального поведения на самой ранней стадии, а также управлять процессами реагирования на инциденты информационной безопасности. Оба решения входят в экосистему UserGate SUMMA. Все продукты UserGate реализованы как в виде программно-аппаратных комплексов, так и в виртуальном исполнении с поддержкой всех существующих на рынке гипервизоров, а также с возможностью развёртывания в облачном окружении.

16.11.2023 [15:29], Сергей Карасёв

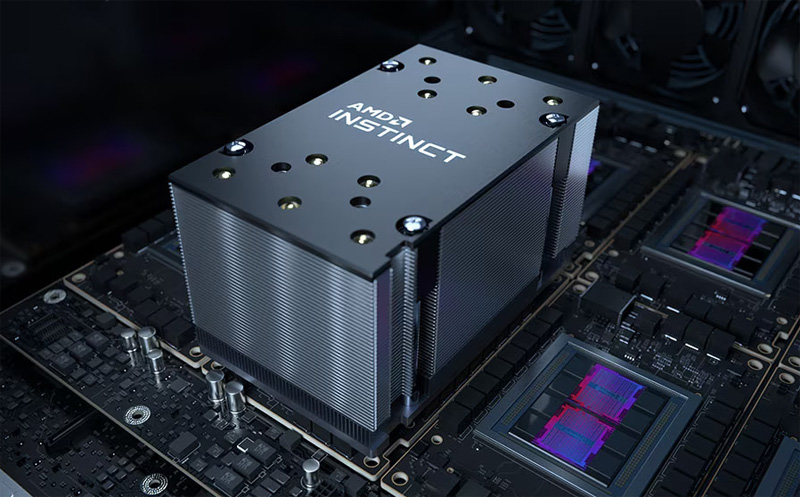

В Microsoft Azure появились инстансы ND MI300X v5 с восемью ускорителями AMD Instinct и процессорами Intel XeonКомпания Microsoft анонсировала инстансы Azure ND MI300X v5 на основе ускорителей AMD Instinct MI300X, представленных летом нынешнего года. Эти ВМ ориентированы на ресурсоёмкие ИИ-нагрузки, в частности, на решение задач инференса. Изделия Instinct MI300X несут на борту 192 Гбайт памяти HBM3 с пропускной способностью до 5,2 Тбайт/с. В составе одной виртуальной машины ND MI300X v5 объединены восемь ускорителей, соединённых между собой посредством Infinity Fabric 3.0, а с хостом — по PCIe 5.0. В сумме это даёт 1,5 Тбайт памяти HBM3, что, как отмечает Microsoft, является самой большой ёмкостью HBM, доступной в облаке. Виртуальные машины Azure ND — это дополнение к семейству решений на базе GPU, такие машины специально предназначены для рабочих нагрузок ИИ и глубокого обучения. Microsoft подчёркивает, что в случае ND MI300X v5 используется та же аппаратная платформа, которая применяется и для других ВМ семейства. Она включает процессоры Intel Xeon Sapphire Rapids, 16 каналов оперативной памяти DDR5, а также подключение NVIDIA Quantum-2 CX7 InfiniBand с пропускной способностью 400 Гбит/с на каждый ускоритель и 3,2 Тбит/с на виртуальную машину.

Источник изображения: AMD По заявлениям Microsoft, на базе ND MI300X v5 могут запускаться самые крупные модели ИИ. Клиенты могут быстро перейти на новые инстансы с других решений серии ND благодаря тому, что открытая платформа AMD ROCm содержит все библиотеки, компиляторы, среды выполнения и инструменты, необходимые для ускорения ресурсоемких приложений.

16.11.2023 [02:43], Алексей Степин

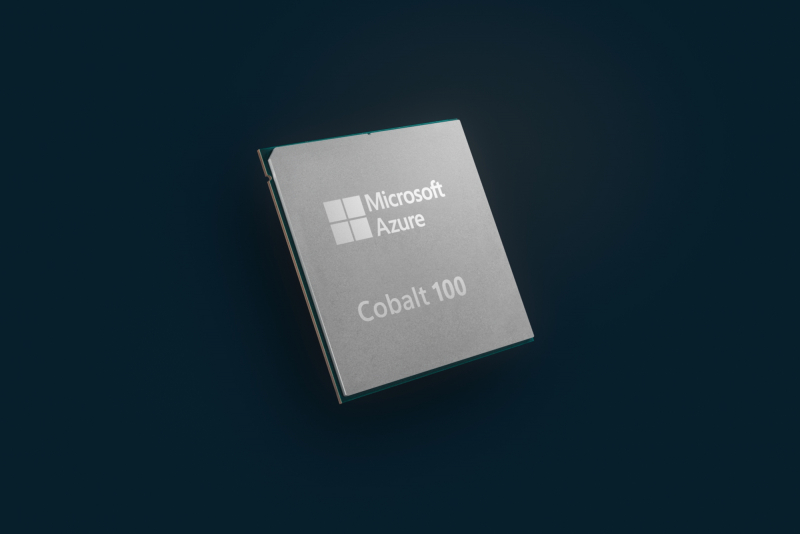

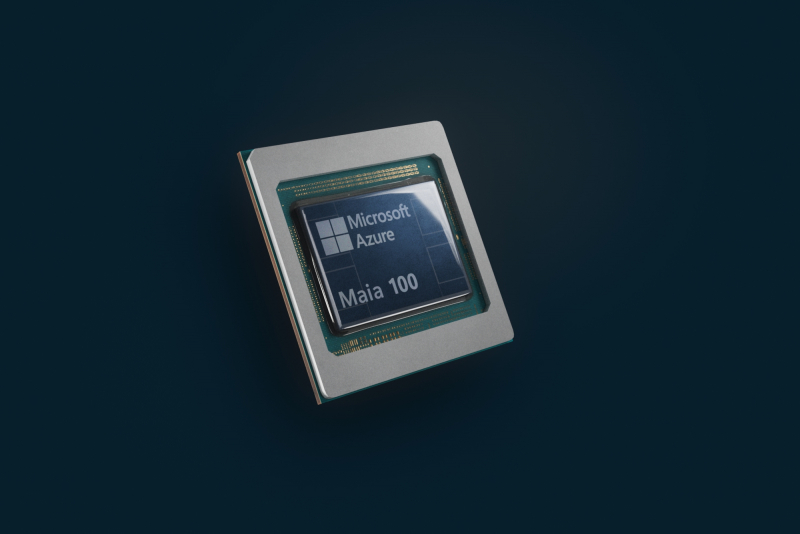

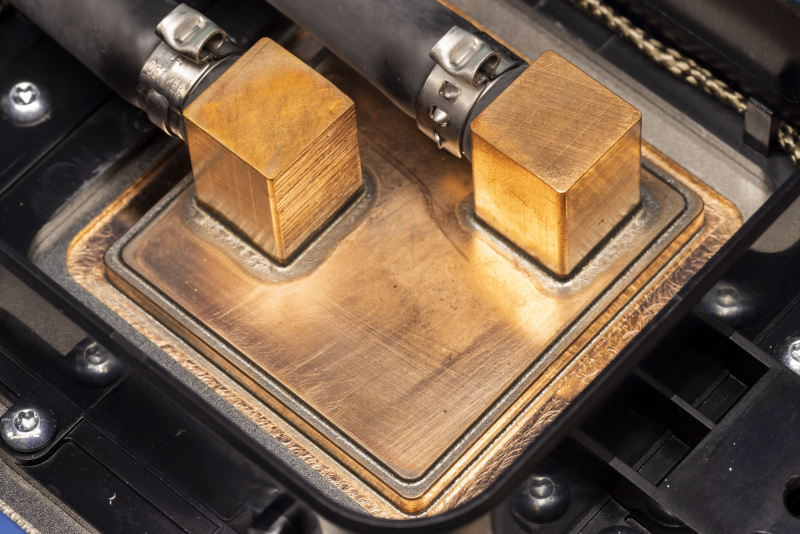

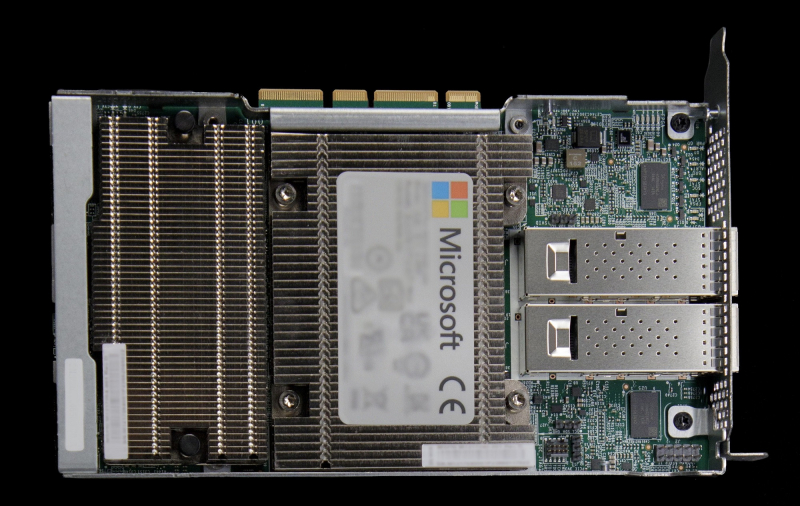

Microsoft представила 128-ядерый Arm-процессор Cobalt 100 и ИИ-ускоритель Maia 100 собственной разработкиГиперскейлеры ради снижения совокупной стоимости владения (TCO) и зависимости от сторонних вендоров готовы вкладываться в разработку уникальных чипов, изначально оптимизированных под их нужды и инфраструктуру. К небольшому кругу компаний, решившихся на такой шаг, присоединилась Microsoft, анонсировавшая Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100. Первопроходцем в этой области стала AWS, которая разве что память своими силами не разрабатывает. У AWS уже есть три с половиной поколения Arm-процессоров Graviton и сразу два вида ИИ-ускорителей: Trainium для обучения и Inferentia2 для инференса. Крупный китайский провайдер Alibaba Cloud также разработал и внедрил Arm-процессоры Yitian и ускорители Hanguang. Что интересно, в обоих случаях процессоры оказывались во многих аспектах наиболее передовыми. Наконец, у Google есть уже пятое поколение ИИ-ускорителей TPU. Microsoft заявила, что оба новых чипа уже производятся на мощностях TSMC с использованием «последнего техпроцесса» и займут свои места в ЦОД Microsoft в начале следующего года. Как минимум, в случае с Maia 100 речь идёт о 5-нм техпроцессе, вероятно, 4N. В настоящее время Microsoft Azure находится в начальной стадии развёртывания инфраструктуры на базе новых чипов, которая будет использоваться для Microsoft Copilot, Azure OpenAI и других сервисов. Например, Bing до сих пор во много полагается на FPGA, а вся ИИ-инфраструктура Microsoft крайне сложна. Microsoft приводит очень мало технических данных о своих новинках, но известно, что Azure Cobalt 100 имеет 128 ядер Armv9 Neoverse N2 (Perseus) и основан на платформе Arm Neoverse Compute Subsystem (CSS). По словам компании, процессоры Cobalt 100 до +40 % производительнее имеющихся в инфраструктуре Azure Arm-чипов, они используются для обеспечения работы служб Microsoft Teams и Azure SQL. Oracle, вложившаяся в своё время в Ampere Comptuing, уже перевела все свои облачные сервисы на Arm. Чип Maia 100 (Athena) изначально спроектирован под задачи облачного обучения ИИ и инференса в сценариях с использованием моделей OpenAI, Bing, GitHub Copilot и ChatGPT в инфраструктуре Azure. Чип содержит 105 млрд транзисторов, что больше, нежели у NVIDIA H100 (80 млрд) и ставит Maia 100 на один уровень с Ponte Vecchio (~100 млрд). Для Maia организован кастомный интерконнект на базе Ethernet — каждый ускоритель располагает 4,8-Тбит/с каналом для связи с другими ускорителями, что должно обеспечить максимально эффективное масштабирование. Сами Maia 100 используют СЖО с теплообменниками прямого контакта. Поскольку нынешние ЦОД Microsoft проектировались без учёта использования мощных СЖО, стойку пришлось сделать более широкой, дабы разместить рядом с сотней плат с чипами Maia 100 серверами и большой радиатор. Этот дизайн компания создавала вместе с Meta✴, которая испытывает аналогичные проблемы с текущими ЦОД. Такие стойки в настоящее время проходят термические испытания в лаборатории Microsoft в Редмонде, штат Вашингтон. В дополнение к Cobalt и Maia анонсирована широкая доступность услуги Azure Boost на базе DPU MANA, берущего на себя управление всеми функциями виртуализации на манер AWS Nitro, хотя и не целиком — часть ядер хоста всё равно используется для обслуживания гипервизора. DPU предлагает 200GbE-подключение и доступ к удалённому хранилищу на скорости до 12,5 Гбайт/с и до 650 тыс. IOPS. Microsoft не собирается останавливаться на достигнутом: вводя в строй инфраструктуру на базе новых чипов Cobalt и Maia первого поколения, компания уже ведёт активную разработку чипов второго поколения. Впрочем, совсем отказываться от партнёрства с другими вендорами Microsoft не намерена. Компания анонсировала первые инстансы с ускорителями AMD Instinct MI300X, а в следующем году появятся инстансы с NVIDIA H200.

15.11.2023 [16:56], Сергей Карасёв

Российская «дочка» HPE договорилась с дистрибьютором OCS — взыскания на 2 млрд рублей отмененыДевятый арбитражный апелляционный суд, по сообщению «Интерфакса», отменил два решения Арбитражного суда Москвы, который ранее удовлетворил иски дистрибутора OCS Distribution (ООО «О-си-эс-центр») в отношении российского подразделения корпорации Hewlett Packard Enterprise (HPE) — ООО «Хьюлетт паккард энтерпрайз». Стороны заключили мировые соглашения. Российская «дочка» HPE в сложившейся геополитической обстановке прекратила деятельность на российском рынке. При этом компания не выполнила обязательства по договорам и осталась должна партнёрам миллиарды рублей. В этой связи против поставщика оборудования корпоративного класса посыпались многочисленные судебные иски.

Источник изображения: pixabay.com Со стороны ООО «О-си-эс-центр» к российской структуре HPE были поданы два иска: на 1,44 млрд руб. от 31 октября 2022 года и на 551 млн руб. от 5 апреля 2023-го. Оба были полностью удовлетворены минувшим летом. Однако со стороны ООО «Хьюлетт паккард энтерпрайз» была подана апелляция. Как теперь стало известно, оба постановления отменены: суд объявил о прекращении производств по этим делам и утверждении мировых соглашений. Подробности договорённостей между сторонами не раскрываются, поскольку слушания проходили в закрытом режиме. Между тем к российской «дочке» HPE недавно были поданы новые крупные иски на сотни миллионов рублей. Среди них — претензии ООО «Компания Комплит» на сумму 4 859 645,7 руб., ООО «Треолан» на сумму 653 291 714,32 руб. и ООО «Компинтегро» на сумму 2 035 715,33 руб.

15.11.2023 [15:52], Сергей Карасёв

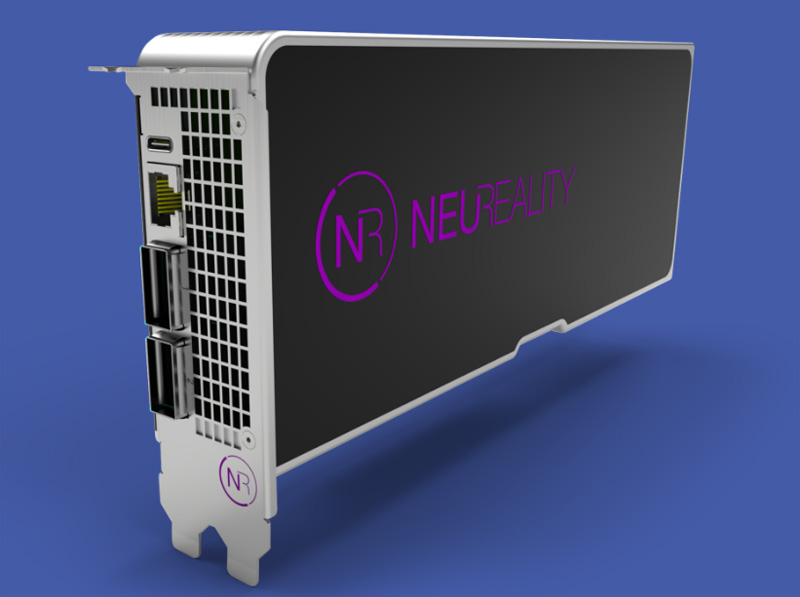

NeuReality представила «сервер на чипе» и другие аппаратные ИИ-решения для инференсаКомпания NeuReality на конференции по высокопроизводительным вычислениям SC23 представила полностью интегрированное решение NR1 AI Inference, предназначенное для ИИ-платформ. Изделие спроектировано специально для ускорения инференса и снижения нагрузки на аппаратные ресурсы. Утверждается, что благодаря использованию технологий NeuReality операторы крупных дата-центров могут на 90 % сократить затраты на выполнение операций ИИ. При этом производительность по сравнению с традиционными системами на основе CPU больше на порядок. Впрочем, конкретные цифры не приводятся.

Источник изображений: NeuReality В продуктовое семейство NeuReality входит решение NR1, которое разработчик называет «сервером на чипе» со встроенным нейросетевым движком. По заявлениям NeuReality, это первый в мире «сетевой адресуемый процессор» — NAPU (Network Addressable Processing Unit). Этот специализированный чип, ориентированный на задачи инференса, обладает возможностями виртуализации и сетевыми функциями.  Изделие NR1 является основой вычислительного модуля NR1-M AI Inference Module, выполненного в виде полноразмерной двухслотовой карты расширения PCIe. Модуль может подключаться к внешнему ускорителю глубокого обучения (DLA). Наконец, анонсирован сервер NR1-S AI Inference Appliance, который оснащается картами NR1-M AI Inference Module. NeuReality отмечает, что данная система позволяет снизить стоимость и энергопотребление почти в 50 раз на операциях инференса по сравнению со стандартными платформами.

14.11.2023 [19:26], Сергей Карасёв

TACC получит ИИ-суперкомпьютер Vista с суперчипами NVIDIA GH200 Grace HopperТехасский центр передовых вычислений (TACC) при Техасском университете в Остине (США) на конференции по высокопроизводительным вычислениям SC23 анонсировал суперкомпьютер Vista, ориентированный на задачи ИИ и машинного обучения. Запуск этого комплекса в эксплуатацию запланирован на начало 2024 года. Отмечается, что Vista станет связующим звеном между нынешним суперкомпьютером TACC Frontera и будущей системой TACC Horizon, проект которой финансируется Национальным научным фондом (NSF). Ввод Horizon в строй намечен на 2025 год: ожидается, что этот комплекс будет на порядок быстрее Frontera. Что касается Vista, то эта система знаменует собой переход от традиционной архитектуры х86, которая применяется во Frontera и системах Stampede, в пользу Arm. В частности, будут задействованы суперчипы NVIDIA GH200 Grace Hopper, которые содержат 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H200. В составе Vista чипами GH200 будут оборудованы немногим более половины всех вычислительных узлов. Оставшиеся узлы получат процессор NVIDIA Grace CPU Superchip, содержащий два кристалла Grace в одном модуле (144 ядра).

Источник изображения: TACC Для Vista предусмотрено использование 400G-интерконнекта NVIDIA Quantum-2 InfiniBand. Компания VAST Data предоставит для суперкомпьютера высокопроизводительное флеш-хранилище, подключенное к Stampede3. Вычислительные узлы будут производиться компанией Gigabyte, а интеграцию обеспечит Dell. |

|