Материалы по тегу: ии

|

05.08.2024 [14:40], Андрей Крупин

Служба каталогов ALD Pro получила сертификат ФСТЭК России по 4-му уровню доверия

active directory

astra linux

software

импортозамещение

информационная безопасность

сделано в россии

сертификация

фстэк россии

«Группа Астра» сообщила о получении сертификата Федеральной службы по техническому и экспортному контролю на систему централизованного управления доменом ALD Pro. Программный комплекс ALD Pro предназначен для автоматизации и централизованного управления рабочими станциями, иерархией подразделений и групповыми политиками, а также прикладными сервисами для IT-инфраструктур организаций различного масштаба. Продукт может использоваться в качестве замены Microsoft Active Directory и учитывает интересы администраторов и пользователей компаний, переходящих на отечественный софт. ALD Pro включён в дорожную карту «Новое общесистемное программное обеспечение»; решению присвоен статус «особо важного продукта» в рамках программы Минцифры России. Выданный ФСТЭК России сертификат подтверждает соответствие ALD Pro требованиям по безопасности информации, устанавливающим уровни доверия к средствам технической защиты информации и средствам обеспечения безопасности информационных технологий. Продукт соответствует 4-му уровню доверия и располагает набором декларируемых в технических условиях функциональных возможностей.

Источник изображения: aldpro.ru Решение подходит не только для информационных систем общего пользования (ИСОП) II класса, но также для государственных информационных систем (ГИС), информационных систем персональных данных (ИСПДн) и автоматизированных систем управления техническими процессами (АСУ ТП) до 1-го класса защищённости включительно. Кроме того, программный комплекс можно применять на значимых объектах критической информационной инфраструктуры, в том числе 1-ой категории. «Сегодня заказчики активно переходят с зарубежных решений на отечественные. Мы понимаем, что внедряемый софт должен быть не только функциональным, но и надёжным, и получение сертификата ФСТЭК России — это документальное подтверждение безопасности ALD Pro. Защищённость всегда была и будет одним из ключевых приоритетов нашей команды, нам важно предоставлять клиентам стабильные и качественные решения», — говорится в сообщении «Группы Астра».

05.08.2024 [12:48], Руслан Авдеев

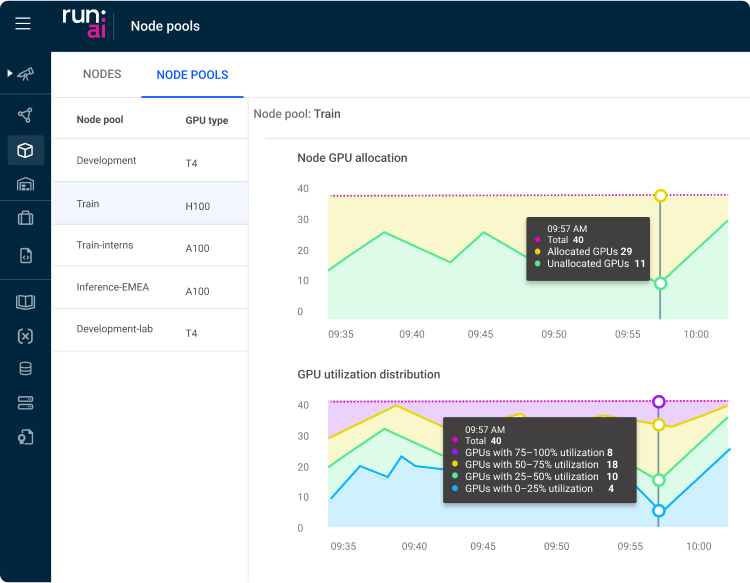

NVIDIA купила Run:ai, чтобы «похоронить» наработки стартапа, подозревает Минюст СШАПо данным Silicon Angle, американское Министерство юстиции взялось за сделку NVIDIA по покупке стартапа Run:ai, занимающегося разработкой софта для управления рабочими нагрузками ИИ. ПО позволяет более эффективно использовать вычислительные ресурсы при работе с ИИ-приложениями, что может оказаться помехой для бизнеса NVIDIA. Информация о расследовании появилась у СМИ на прошлой неделе. Пару месяцев назад источники уже сообщали, что министерство расследует доминирующее положение NVIDIA на рынке ИИ-чипов. По данным источников сделку будут рассматривать независимо от предыдущего расследования.

Источник изображения: Romain Dancre/unsplash.com NVIDIA купила стартап из Тель-Авива Run:ai (зарегистрированный как Runai Labs Ltd) в начале года за $700 млн. Ранее он уже привлёк от инвесторов порядка $118 млн. Предлагаемая им платформа позволяет расширить функциональность кластеров ускорителей и повысить их уровень утилизации. В Run:ai позволяет запускать на одном и том же ускорителе несколько задач. Также платформа позволит избегать конфликтов памяти, а также присущих ИИ-вычислениям ошибок. Выполнение рабочих нагрузок может быть ускорено другими методами. Например, для обучения языковой модели разработчики разбивают её на части, каждую из которых тренируют на отдельном ускорителе. Фрагменты регулярно обмениваются данными в ходе обучения, но работа настроена благодаря Run:ai таким образом, что обмен данными происходит быстрее, а сеансы обучения выходят короче. Другими словами, реализация ИИ-проектов может быть ускорена без добавления новых вычислительных ресурсов. Верно и обратное, задачи можно завершать с той же скоростью с использованием меньшего числа ускорителей. Как раз последний вариант привлёк внимание Министерства юстиции. Платформа, способная снизить количество необходимых ускорителей, может привести к тому, что некоторые клиенты станут покупать меньше продуктов NVIDIA. Чиновники подозревают IT-гиганта в том, что он намерен просто «похоронить» технологию, угрожающую её основному бизнесу.

Источник изображения: Run:ai Изучаются и другие аспекты деятельности компании. Например, в министерстве желают знать, не ставит ли NVIDIA условием для доступа к своим ускорителям покупку клиентами других своих продуктов или не ставит ли она условием обязательство не покупать оборудование у конкурентов. В NVIDIA утверждают, что лидируют на рынке совершенно заслуженно, соблюдая все законы, а продукты компании открыты и доступны любым бизнесам — клиенты могут сами принять решение, которое подходит им лучше всего. В прошлом месяце появлялась информация о том, что выдвинуть обвинения против NVIDIA намерен антимонопольный регулятор Франции. Вероятно, в поле зрения попадает набор инструментов CUDA для разработки ПО, используемого с ускорителями и видеокартами компании. Чиновников беспокоит и вложения NVIDIA в облачные компании, ориентирующиеся на ИИ, вроде CoreWeave, массово внедряющие ускорители компании в своей инфраструктуре. Предполагается, что инвестор сможет повлиять на предпочтения партнёров при покупке ускорителей и ПО.

05.08.2024 [10:34], Руслан Авдеев

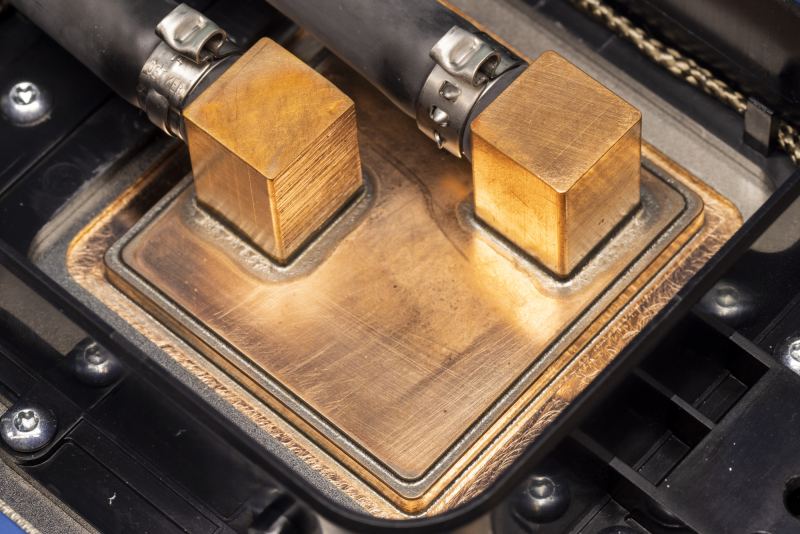

Microsoft начала активно внедрять прямое жидкостное охлаждение в своих ЦОД и приступила к прикладному изучению микрогидродинамикиКомпания Microsoft стала активно применять прямое жидкостное охлаждение чипов в серверах своих ЦОД. Datacenter Dynamics сообщает, что IT-гигант приступил и к изучению более передовой технологии, основанной на принципах микрогидродинамики. Как свидетельствует недавний пост в блоге компании, посвящённый использованию воды и применяемым СЖО разных поколений, сейчас разрабатывается новая архитектура дата-центров, оптимизированных для прямого жидкостного охлаждения чипов. Это требует переосмысления конструкции серверов и серверных стоек для внедрения новых методов терморегуляции и управления энергией. Компания уже использует sidekick-СЖО в действующих ЦОД. Впервые они были представлены во время анонса процессоров Cobalt и ИИ-ускорителей Maya. Последние будут развёрнуты в кастомных стойках и кластерах Ares. Серверы для них шире 19″ и даже OCP-стоек и нуждаются именно в жидкостном охлаждении — других конфигураций не предусмотрено. Каждый сервер получит по четыре ускорителя Maya, а стойка будет вмещать восемь серверов. А рядом с ней будет ещё одна стойка с компонентами охлаждения. Аналогичный дизайн использует Meta✴, которая также была вынуждена пересмотреть архитектуру своих ЦОД из-за ИИ. Не менее интересны и разработки в сфере микрогидродинамики. Этот подход предусматривает размещение микроканалов для подачи жидкости буквально внутри самих чипов, что обеспечивает ещё более высокую эффективность охлаждения. В компании утверждают, что все эти разработки оптимизированы для поддержки ИИ-нагрузок в ЦОД и в то же время дружественны к экологии. Благодаря инновациям можно значительно снизить потребление чистой воды, одновременно обеспечивая повышенную ёмкость серверных стоек, благодаря чему возрастает польза от каждого задействованного квадратного метра. Microsoft намерена стать «водно-положительной» к 2030 году. В ESG-докладе 2023 года компания заявила, что использовала в 2022 году 6,4 млн м3, преимущественно для своих ЦОД. В докладе 2024 года показатель увеличился уже до 7,8 млн м3 в 2023 году. Проблемы с потреблением воды вообще характерны для IT-гиганта и его партнёров. Запись в блоге Microsoft также свидетельствует о том, что компания расширила использование восстановленной и переработанной воды на площадках в Техасе, Вашингтоне, в Калифорнии и Сингапуре. В Нидерландах, Ирландии и Швеции компания собирает дождевую воду и намерена расширить эту практику на Канаду, Великобританию, Финляндию, Италию, Южную Африку и Австрию. В Нидерландах, правда, всё оказалось не так хорошо, как обещала компания. Как заявляют Microsoft, с первого поколения собственных дата-центров в начале 2000-х годов до текущего поколения в 2020-х, использование воды на кВт·ч снизилось более чем на 80 %. Ранее компания сотрудничала с разработчиком систем двухфазного погружного жидкостного охлаждения LiquidStack, который поддерживается одним из поставщиков Microsoft — Wiwynn. В прошлом году LiquidStack представила однофазную систему иммерсионного охлаждения для ИИ-систем, а также запустила в США производство СЖО, но для кого именно она их выпускает, не уточняется.

05.08.2024 [08:16], Сергей Карасёв

Новые кластеры Supermicro SuperCluster с ускорителями NVIDIA L40S ориентированы на платформу Omniverse

emerald rapids

hardware

intel

l40

nvidia

omniverse

sapphire rapids

supermicro

xeon

ии

кластер

сервер

Компания Supermicro расширила семейство высокопроизводительных вычислительных систем SuperCluster, предназначенных для обработки ресурсоёмких приложений ИИ/HPC. Представленные решения оптимизированы для платформы NVIDIA Omniverse, которая позволяет моделировать крупномасштабные виртуальные миры в промышленности и создавать цифровых двойников. Системы SuperCluster for NVIDIA Omniverse могут строиться на базе серверов SYS-421GE-TNRT или SYS-421GE-TNRT3 с поддержкой соответственно восьми и четырёх ускорителей NVIDIA L40S. Обе модели соответствуют типоразмеру 4U и допускают установку двух процессоров Intel Xeon Emerald Rapids или Sapphire Rapids в исполнении Socket E (LGA-4677) с показателем TDP до 350 Вт (до 385 Вт при использовании СЖО). Каждый из узлов в составе новых систем SuperCluster несёт на борту 1 Тбайт оперативной памяти DDR5-4800, два NVMe SSD вместимостью 3,8 Тбайт каждый и загрузочный SSD NVMe M.2 на 1,9 Тбайт. В оснащение включены четыре карты NVIDIA BlueField-3 (B3140H SuperNIC) или NVIDIA ConnectX-7 (400G NIC), а также одна карта NVIDIA BlueField-3 DPU Dual-Port 200G. Установлены четыре блока питания с сертификатом Titanium мощностью 2700 Вт каждый. В максимальной конфигурации система SuperCluster for NVIDIA Omniverse объединяет пять стоек типоразмера 48U. В общей сложности задействованы 32 узла Supermicro SYS-421GE-TNRT или SYS-421GE-TNRT3, что в сумме даёт 256 или 128 ускорителей NVIDIA L40S. Кроме того, в состав такого комплекса входят три узла управления Supermicro SYS-121H-TNR Hyper System, три коммутатора NVIDIA Spectrum SN5600 Ethernet 400G с 64 портами, ещё два коммутатора NVIDIA Spectrum SN5600 Ethernet 400G с 64 портами для хранения/управления, два коммутатора управления NVIDIA Spectrum SN2201 Ethernet 1G с 48 портами. При необходимости конфигурацию SuperCluster for NVIDIA Omniverse можно оптимизировать под задачи заказчика, изменяя масштаб вплоть до одной стойки. В этом случае применяются четыре узла Supermicro SYS-421GE-TNRT или SYS-421GE-TNRT3.

04.08.2024 [15:25], Сергей Карасёв

В Google Cloud появился выделенный ИИ-кластер для стартапов Y CombinatorОблачная платформа Google Cloud, по сообщению TechCrunch, развернула выделенный субсидируемый кластер для ИИ-стартапов, которые поддерживаются венчурным фондом Y Combinator. Предполагается, что данная инициатива поможет Google привлечь в своё облако перспективные компании, которым в будущем могут понадобиться значительные вычислительные ресурсы. Отмечается, что для ИИ-стартапов на ранней стадии одной из самых распространённых проблем является ограниченная доступность вычислительных мощностей. Крупные предприятия обладают достаточными финансами для заключения многолетних соглашений с поставщиками облачных услуг на доступ к НРС/ИИ-сервисам. Однако у небольших фирм с этим возникают сложности. Ожидается, что Google Cloud поможет в решении данной проблемы. Google предоставит выделенный кластер с приоритетным доступом для стартапов Y Combinator. Платформа базируется на ускорителях NVIDIA и тензорных процессорах (TPU) самой Google. Каждый участник программы получит кредиты на сумму $350 тыс. для использования облачных сервисов Google в течение двух лет. Кроме того, Google предоставит стартапам кредиты в размере $12 тыс. на расширенную поддержку и бесплатную годовую подписку Google Workspace Business Plus. Молодые компании также смогут консультироваться с экспертами Google в области ИИ. Оказав поддержку ИИ-стартапам, Google в дальнейшем сможет рассчитывать на заключение с ними долгосрочных контрактов на обслуживание. Говорится, что за последние 18 лет примерно 5 % стартапов Y Combinator стали единорогами с оценкой $1 млрд и более. Такие компании могут принести облачной платформе Google значительную выручку в случае заключения соглашения о сотрудничестве. С другой стороны, фонд Y Combinator сможет привлечь больше перспективных ИИ-проектов, предлагая вычислительные ресурсы Google вместе со своей поддержкой. Аналогичные программы есть и у других игроков. Так, венчурный инвестор Andreessen Horowitz (a16z) тоже запасается ИИ-ускорителями, чтобы стать более привлекательным для ИИ-стартапов. AWS предлагает ИИ-стартапам доступ к облаку и сервисам, а Alibaba Cloud готова предоставить ресурсы в обмен на долю в стартапе. Сама Google на днях наняла основателей стартапа Character.AI и лицензировал его модели. Стартапу, по-видимому, не хватило средств на ИИ-ускорители для дальнейшего развития.

02.08.2024 [18:01], Руслан Авдеев

ИИ и ЦОД: капитальные затраты Meta✴ во II квартале выросли до $8,5 млрдВ Meta✴ продолжают активно вкладывать средства в серверы, дата-центры и сетевую инфраструктуру — компания выстраивает экосистему для искусственного интеллекта. По информации Datacenter Dynamics, капитальные затраты во II квартале составили $8,5 млрд, ожидается, что они будут расти и в дальнейшем. Выручка за отчётный период превзошла прогнозы экспертов и составила $39,07 млрд, на 22 % больше в сравнении с аналогичным периодом прошлого года. Чистая прибыль в прошедшем квартале — $13,46 млрд, рост составил 73 %. Прогноз выручки на следующий квартал — $38,5-$41 млрд. Капитальные затраты оказались несколько ниже ($8,5 млрд), чем предполагали отраслевые эксперты ($9,51 млрд), тем не менее рост составил 32,8 % год к году. Компания ожидает и дальнейшего значительного роста капитальных вложений в 2025 году, при этом имеется достаточный запас гибкости. Та же инфраструктура, что построена для обучения генеративного ИИ, будет использована и для инференса. Кроме того, инфраструктуру можно будет модифицировать для других задач, включая ранжирование, рекомендательные системы и др. Как утверждают в Meta✴, несмотря на рост инвестиций, генеративный ИИ не должен стать значимым драйвером выручки в 2024 году. Впрочем, по словам главы компании Марка Цукерберга (Mark Zuckerberg), он скорее рискнёт создать лишнюю ёмкость до того, как она понадобится, чем станет добиваться её строительства с опозданием, с учётом довольно длительной реализации новых внутренних проектов. Ожидается, что для тренировки ИИ-модели Llama 4 понадобится почти в 10 раз больше вычислительных мощностей, чем было необходимо для Llama 3. Для последующих моделей потребуется ещё больше. К концу года компания будет использовать ускорители эквивалентные по вычислительной способности 600 тыс. экземпляров NVIDIA H100. По словам финансового директора Meta✴ Сьюзан Ли (Susan Li), компания применяет стратегию поэтапного строительства ЦОД, позволяющую быстро увеличивать общую ёмкость для удовлетворения спроса. При этом в будущем капитальные затраты снизятся, поскольку не будет необходимости сразу сдавать большие объекты.

02.08.2024 [12:17], Сергей Карасёв

«Систэм Электрик» представила чиллеры CoolFlow с гибкими возможностями кастомизацииРоссийская компания «Систэм Электрик» (Systême Electric; ранее — Schneider Electric) объявила о выпуске чиллеров семейства CoolFlow, которые, как утверждается, обладают широкими возможностями для адаптации под индивидуальные требования заказчика. Новинки ориентированы на применение в современных дата-центрах. Отмечается, что новые решения сочетают в себе передовые технологии для достижения высокой энергетической эффективности и улучшения экологических показателей. Чиллеры обеспечивают надёжное охлаждение серверного оборудования, одновременно минимизируя энергопотребление и углеродный след. В семейство CoolFlow входят устройства воздушного охлаждения с опцией фрикулинга двух типов. Это модели на базе спиральных компрессоров холодопроизводительностью от 30 до 700 кВт, а также чиллеры на основе винтовых компрессоров холодопроизводительностью от 300 до 1500 кВт. Решения оснащены встроенным гидромодулем, который включает в себя все необходимые компоненты для выполнения только одного подключения к чиллеру — без необходимости внешних подсоединений к вспомогательному оборудованию, например, насосам. Устройства изначально оснащены специальным зимним комплектом, который позволяет эксплуатировать их при температурах до -45 °C. При необходимости может быть добавлен высоконапорный насос. Преимуществом чиллеров семейства CoolFlow названы широкие возможности в плане кастомизации. Устройства можно адаптировать к индивидуальным требованиям каждого проекта, оптимизируя их для конкретных условий эксплуатации. Благодаря модульной конструкции достигается гибкость масштабирования: допускается создание систем различной мощности, подходящих для разных объектов — от небольших до крупных дата-центров. Чиллеры CoolFlow могут применяться не только для строительства и эксплуатации ЦОД, но и в других отраслях промышленности, а также для создания микроклимата в офисах и бизнес-центрах. «Систэм Электрик» предлагает возможность изменения стандартных размеров чиллеров и модификации их базовых характеристик. В частности, заказчики могут выбрать двойной или раздельный ввод питания, определённую насосную группу (1/1+1/1 с VSD/1+1 c VSD), а также установку источника бесперебойного питания на контроллер, расходомеров, накопительного бака, сетевых карт RS485 или SNMP, металлических сетчатых фильтров на теплообменники и пр.

02.08.2024 [08:05], Владимир Мироненко

«Альт Платформа» от «Базальт СПО» сделает сборку ПО и дистрибутивов ОС проще и удобнее«Базальт СПО», российский разработчик ОС семейства «Альт», предложил вниманию разработчиков технологический комплекс «Альт Платформа», который, по словам создателей, имеет всё необходимое для сборки ПО и выпуска дистрибутивов операционных систем и значительно упрощает выполнение этих задач. Решение включено в Единый реестр российского ПО под №21540. «Альт Платформа» может использоваться для широкого круга задач, включая создание специализированных сборок под конкретное оборудование (банкоматы, промышленные контроллеры и т. п.) и под нужды крупных организаций, локализованных ОС, а также для формирования дистрибутивов с предустановленным дополнительным ПО и для разработки прикладного ПО, совместимого с ОС серии «Альт» и другими созданными на «Альт Платформе» дистрибутивами. В состав «Альт Платформы» входят:

«Базальт СПО» готова обучить специалистов заказчика пользоваться программным комплексом «Альт Платформа», вести свой репозиторий и дополнять его сторонним ПО, а также предлагает техническую поддержку трёх уровней: базового, стандартного и расширенного. «Базальт СПО» с 2001 года развивает собственную инфраструктуру разработки, на которой создано уже десять поколений операционных систем. Её центральное звено — бесплатный репозиторий «Сизиф» — один из крупнейших в мире технологически независимых репозиториев, наряду с Debian, Red Hat и SUSE. Репозиторий формируется из свободного ПО международных проектов и собственных разработок компании. Он поддерживается «Базальт СПО» и находится на территории и под юрисдикцией РФ. Каждые несколько лет разработчики «Базальт СПО» выделяют из «Сизифа» бранч — стабильную ветку репозитория. Все помещаемые в него пакеты тестируются, уязвимости исправляются и для всех них обеспечивают совместимость, благодаря чему формируется банк проверенных пакетов с системой контроля зависимостей, на основе которого выпускаются дистрибутивы. Помимо бинарных пакетов в стабильный бранч входит исходный код практически всех пакетов. Бранч можно использовать как для обновления ОС «Альт», так и для создания и обновления собственных дистрибутивов.

01.08.2024 [17:17], Владимир Мироненко

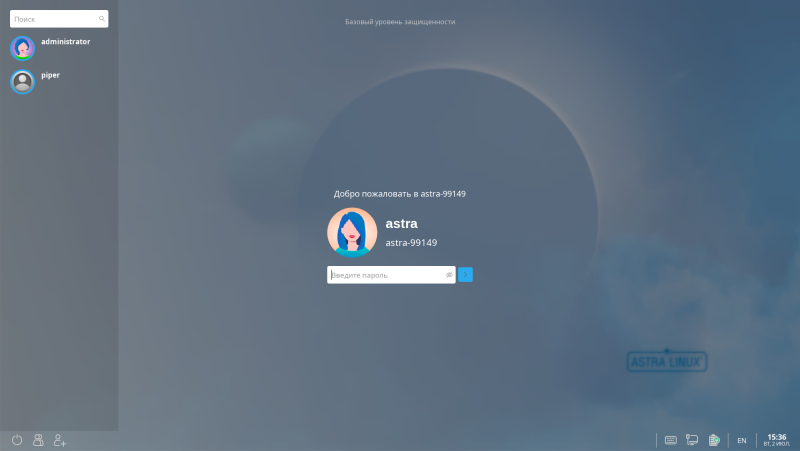

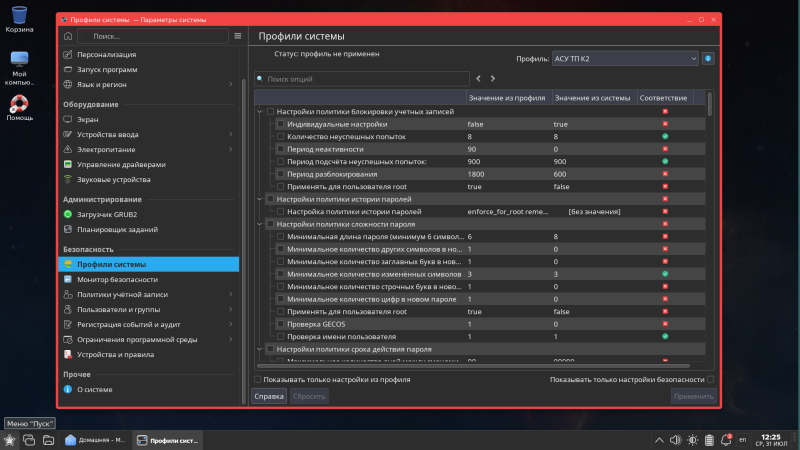

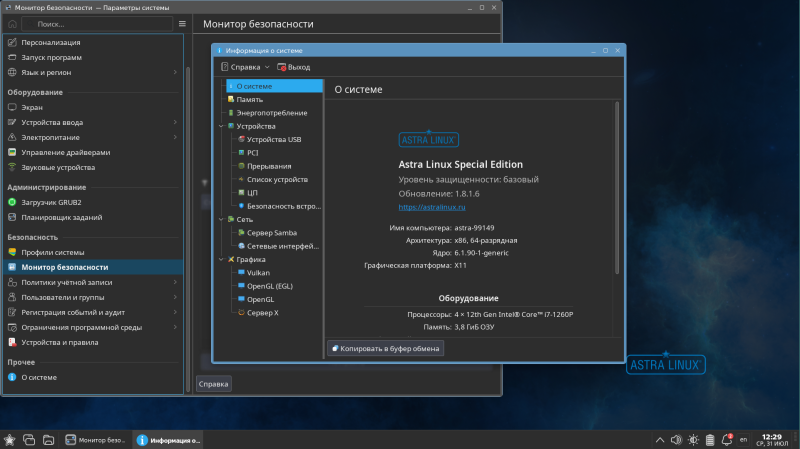

«Группа Астра» представила российскую ОС Astra Linux 1.8 на базе Debian 12Российский производитель инфраструктурного программного обеспечения ПАО «Группа Астра» сообщил о выходе новой версии своего флагманского продукта — операционной системы Astra Linux восьмого поколения. Новая версия ОС Astra Linux основана на пакетной базе Debian 12 (Bookworm), стабильном открытом дистрибутиве с длительной поддержкой, что позволяет использовать актуальные приложения и библиотеки. Обновлена структура репозиториев Astra Linux, которые разделили на два репозитория — Main и Extended. Main включает в себя компоненты, прошедшие полный цикл сертификации, а Extended содержит средства разработки и пакеты для сборки Main-репозитория вместе с дополнительными прикладными и системными пакетами. Новинка предлагает расширенные возможности для разработчиков и системных администраторов, в том числе улучшенное сопровождение виртуализации и контейнеризации. А новые функции и обновлённые драйверы позволяют пользователям более эффективно использовать аппаратные ресурсы.

Источник изображений: «Группа Астра» Благодаря режиму Live CD можно ознакомиться и оценить новую ОС до её установки. При этом процесс обновления Astra Linux 1.7 до версии 1.8 теперь автоматизирован. Домашняя папка пользователя сохраняется, позволяя при возникновении ошибки обновления «откатить» процесс к предыдущей версии. Новинка также получила обновлённый инсталлятор, который упрощает процесс развёртывания, собирая все необходимые параметры в одном окне и позволяя выполнить установку в один клик. Как сообщает компания, в ОС Astra Linux 1.8 используются Linux-ядра версий 6.x, причём доступны две ветки — на базе ядра Linux 6.1 (с долговременной поддержкой), доработанного с учётом результатов исследований ИСП РАН, которое будет обновляться на протяжении всего жизненного цикла ОС, а также на базе последней версии (latest) 6.6 (с кратковременной поддержкой). Версия ядра Linux 6.1 предназначена для пользователей, ориентированных на стабильную работу и информационную безопасность. ИСП РАН под руководством ФСТЭК России совместно с консорциумом разработчиков осуществляет поиск и устранение уязвимостей в коде, формируя набор безопасных ядер. Astra Linux 1.8 предлагает готовые рекомендованные профили настройки средств защиты информации (СЗИ) для различных сценариев использования. Достаточно указать нужный профиль и необходимые настройки будут автоматически приведены в соответствие с требованиями по защищённости системы. Ранее для этого требовалась ручная настройка. А в целях реализации ограничения программной среды (динамического контроля целостности ПО) теперь можно использовать сертифицированное СКЗИ КриптоПро CSP и сертификаты ключей проверки цифровой подписи, выпущенные удостоверяющим центром. Как и предыдущие версии, Astra Linux 8-го поколения предназначена для обработки и защиты любой информации ограниченного доступа. Astra Linux 1.8 успешно прошла комплекс испытаний в системе сертификации СЗИ ФСТЭК России по первому, самому высокому уровню доверия. Astra Linux 1.8 имеет сертификат ФСТЭК России, подтверждающий её соответствие требованиям по безопасности информации, предъявляемым сразу к нескольким видам СЗИ: к ОС, средствам виртуализации и контейнеризации, а также СУБД — по 1 классу защиты. Наконец, в релизе 1.8 появился новый визуальный стиль Astra Proxima. При этом сохранён привычный пользовательский опыт, обеспечивая плавный переход от предыдущих версий Astra Linux. Отмечено, что Astra Proxima был разработан с учётом последних тенденций в области UI/UX . Новый стиль применяется во всех компонентах Astra Linux 1.8, обеспечивая целостность и гармоничность визуального оформления. Также в обновлённой версии ОС Astra Linux используется звуковая тема под названием «Звёздный минимализм», созданная при участии «Роскосмоса» из «голосов» реальных космических объектов.

01.08.2024 [15:32], Руслан Авдеев

У Twitter нашёлся заброшенный кластер из когда-то дефицитных NVIDIA V100Работавший в Twitter во времена продажи социальной сети Илону Маску (Elon Musk) разработчик Тим Заман (Tim Zaman), ныне перешедший в Google DeepMind, рассказал о необычной находке, передаёт Tom’s Hardware. По его словам, через несколько недель после сделки специалисты обнаружили кластер из 700 простаивающих ускорителей NVIDIA V100. Сам Заман охарактеризовал находку как «честную попытку построить кластер в рамках Twitter 1.0». Об этом событии Заману напомнили новости про ИИ-суперкомпьютер xAI из 100 тыс. ускорителей NVIDIA H100. Находка наводит на печальные размышления о том, что Twitter годами имел в распоряжении 700 высокопроизводительных ускорителей на архитектуре NVIDIA Volta, которые были включены, но простаивали без дела. Они были в дефиците на момент выпуска в 2017 году, а Заман обнаружил бездействующий кластер только в 2022 году. Нет ничего удивительного, что приблизительно тогда же было решено закрыть часть дата-центров социальной сети. Примечательно, что в кластере использовались PCIe-карты, а не SXM2-версии V100 с NVLink, которые намного эффективнее в ИИ-задачах. Заман поделился и соображениями об «ИИ-гигафабрике». Он предположил, что использование 100 тыс. ускорителей в рамках одной сетевой фабрики должно стать эпическим вызовом, поскольку на таких масштабах неизбежны сбои, которыми необходимо грамотно управлять для сохранения работоспособности всей системы. По его мнению, следует разделить систему на независимые домены (крупные кластеры так и устроены). Заман также задался вопросом, какое максимальное количество ускорителей может существовать в рамках одного кластера. По мере того, как компании создают всё более масштабные системы обучения ИИ, будут выявляться как предсказуемые, так и неожиданные пределы того, сколько ускорителей можно объединить. |

|