Материалы по тегу: nvidia

|

28.08.2025 [22:32], Владимир Мироненко

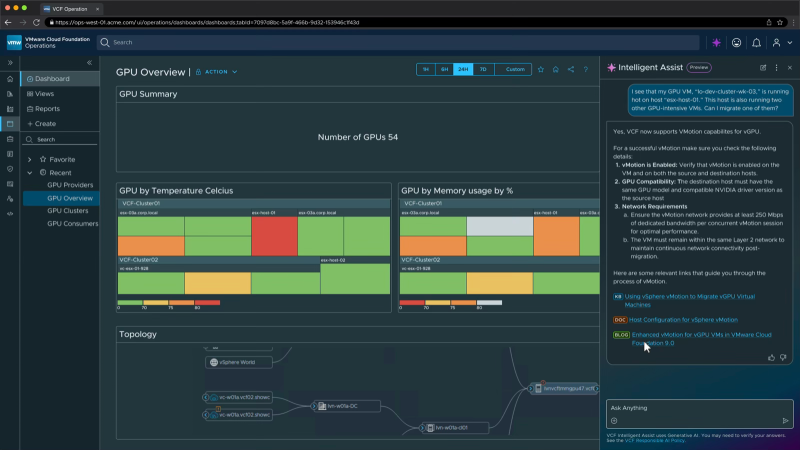

Broadcom интегрировала в VCF ИИ-сервисы и поддержку новейших ускорителей AMD и NVIDIA — всё это будет доступно бесплатноBroadcom объявила об интеграции ИИ-сервисов VMware Private AI в платформу VMware Cloud Foundation (VCF) без дополнительных затрат для клиентов. Компании смогут пользоваться ИИ-функциями в рамках подписки на VCF, начиная с I квартала 2026 года. По словам компании, это упростит и ускорит внедрение новых ИИ-сервисов заказчиков. Некоторые эксперты считают, что дальнейшая модернизации VMware и повышение привлекательности пакета VCF для компаний благодаря интеграции частных ИИ-сервисов могут стать важным шагом для сохранения клиентской базы VMware. Компании получат множество преимуществ: от расширенного планирования инфраструктуры и балансировки нагрузки, предоставляемых с помощью распределенного планировщика ресурсов (DRS), до схем автоматизации, позволяющих развёртывать сложные ИИ-сервисы за считанные минуты, используя оптимизированные драйверы устройств, ядра для конкретных ускорителей и многое другое, обещает Broadcom. VMware Private AI Services помогут компаниям развёртывать и управлять ИИ-приложениями в современной частной облачной инфраструктуре, сохраняя конфиденциальность и безопасность данных. ИИ-сервисы включают среду выполнения моделей, хранилище моделей, мониторинг ускорителей, службу индексации и поиска данных, векторную базу данных, шлюз API и конструктор ИИ-агентов. Целью проекта является создание более интегрированного, безопасного и удобного для разработчиков решения, которое будет выглядеть и работать как публичное облако с точки зрения получения услуг, безопасности и масштабируемости. Это означает большую автоматизацию, больше API и лучшую прозрачность производительности и затрат, отметил ресурс SiliconANGLE. Разработчикам будет помогать генеративный ИИ-помощник VCF Intelligent Assist. Он поможет диагностировать и решить проблемы инфраструктуры, используя базу знаний Broadcom. В дальнейшем будет добавлена функция автоматического исправления ошибок. Broadcom сообщила, что в ближайшее время VCF 9.0 получит поддержку протокола Model Context Protocol (MCP), позволяющего ИИ-агентам подключаться к внешним источникам данных и инструментам и использовать их для совместной работы с другими агентами. Также платформа будет поддерживать функцию Multi-accelerator Model Runtime, которая обеспечивает гибкое развёртывание ИИ-моделей на различном оборудовании, включая ускорители AMD и NVIDIA. Кроме того, клиенты получат многопользовательский доступ к моделям (Multi-tenant Models-as-a-service), что поможет снизить затраты за счёт безопасного доступа арендаторов или отдельных подразделений к общим ИИ-моделям. Broadcom добавила в платформу VCF поддержку оборудования и ПО NVIDIA, в том числе систем Blackwell, включая RTX Pro 6000, и адаптеров ConnectX-7. Также Broadcom заявила о сотрудничестве с AMD, что позволит организациям использовать VCF с ускорителями AMD Instinct серии MI350 и ПО ROCm. Заодно Broadcom объявила о расширенном сотрудничестве с Canonical, благодаря которому клиенты смогут использовать Ubuntu в своих частных облаках с полной корпоративной поддержкой, включая ускоренное управление патчами и повышенную кибербезопасность.

28.08.2025 [14:01], Руслан Авдеев

NVIDIA жалуется на многомиллиардные потери из-за торговой войны США и КитаяNVIDIA призвала Вашингтон скорее одобрить продажу ускорителей Blackwell в КНР. Призыв прозвучал в ходе финансового отчёта компании за II квартал 2025 года, сообщает The Register. Как говорят в компании, её продукты разрабатываются и продаются для коммерческого использования, и каждая продажа принесёт выгоду американской экономике. Если компании дадут возможность конкурировать по всему миру, её ИИ-стек станет повсеместным стандартом. По мнению главы NVIDIA Дженсена Хуанга (Jensen Huang), только в этом году Китай мог бы обеспечить компании рынок объёмом $50 млрд, если бы она могла удовлетворить спрос конкурентоспособными продуктами. отсутствии H20 китайские компании переходят на подержанные ускорители NVIDIA A100/H100. При этом весьма вероятно, что к слабым моделям покупатели возвращаться не захотят вовсе. Сейчас NVIDIA готовит для Китая более производительный ИИ-ускоритель на архитектуре Blackwell и ожидает разрешение Вашингтона на выдачу экспортных лицензий. Президент США уже давал понять, что он открыт для этой идеи, а Хуанг критиковал запрет на продажи, утверждая, что это только усилит конкурентоспособность Китая.

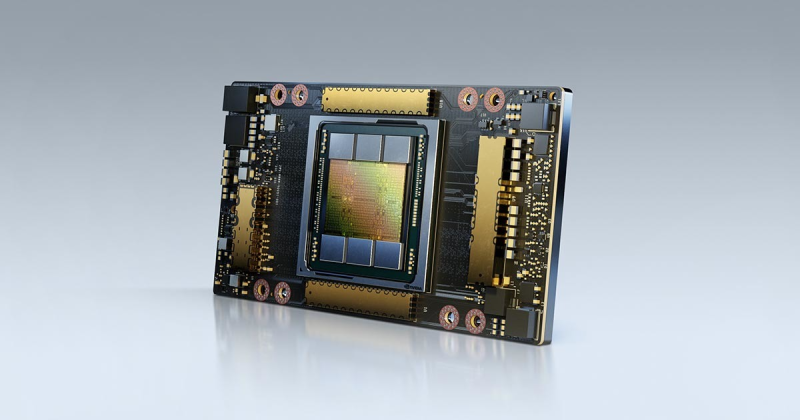

Источник изображения: NVIDIA Тем временем NVIDIA ожидает потери времени и денег из-за затормозившихся продаж ослабленного ускорителя H20 в Поднебесной. Кроме того, в компании отмечают, что власти объявили о 15-% «налоге» на продажи ускорителей в КНР, но реальные правовые механизмы для регулирования этого процесса пока отсутствуют. По данным компании, если Вашингтон всё-таки даст «добро», NVIDIA могла бы увеличить выручку ещё на $2–$5 млрд — помимо $54 млрд, которые компания, вероятно, получит в III квартале. Хотя NVIDIA всё ещё не может продать запас H20 в Китае, компании удалось найти другого покупателя, на которого ограничения не распространяются. NVIDIA продала ему соответствующих ускорителей на $650 млн, высвободив благодаря сделке «зарезервированные» $180 млн.

28.08.2025 [13:03], Руслан Авдеев

Китайский бизнес переходит на подержанные ускорители NVIDIA A100 и H100 из-за проблем с поставками H20Китайская ИИ-индустрия постепенно переходит на восстановленные или подержанные ИИ-ускорители NVIDIA A100 и H100 после того, как очередные экспортные ограничения на NVIDIA H20 заставили компании искать альтернативы этому продукту. Искусственно ослабленный ускоритель H20 должен был сохранить присутствие NVIDIA на китайском рынке, но чип фактически «оказался на обочине» даже после того, как на его продажи вновь дали зелёный свет после временного запрета — китайские регуляторы поставили под сомнение его безопасность, сообщает Tom’s Hardware со ссылкой на Digitimes. Всё это привело к стремительному росту спроса на старые модели A100 и H100, китайские компании проводят некую «реконфигурацию» таких ускорителей для использования в недорогих, но высокопроизводительных системах инференса. Последний требует значительно меньше ресурсов, чем обучение ИИ-моделей, рабочие нагрузки могут эффективно выполняться на относительно слабом оборудовании. Именно поэтому даже A100 с 80 Гбайт HBM2e (2 Тбайт/с), представленный ещё в 2020 году, в некоторых случаях остаётся вполне востребованным. Хотя архитектура Ampere уступает Hopper по пиковой производительности, она всё ещё эффективна для инференса благодаря относительно большому объёму памяти и развитой экосистеме ПО CUDA. Для чат-ботов и рекомендательных систем экономически эффективно использовать системы без самых современных чипов. Представленные в 2022 году H100 значительно производительнее A100 в задачах, связанных с обучением. В то же время H20 изначально был оптимизирован для менее ресурсоёмкого инференса, но его возможности урезали так сильно, что производительность в сравнении с H100 у этой модели ниже в 3–7 раз, а в задачах, связанных с вычислениями FP64, он медленнее более чем в 30 раз. Другими словами, даже A100 всё ещё могут быть привлекательнее для китайских покупателей, чем новые H20.

Источник изображения: NVIDIA Поскольку пока никому не удалось создать что-то сопоставимое с программной экосистемой NVIDIA CUDA, старые GPU вполне востребованы. Тем более что оборудование для инференса менее требовательно во всех отношениях, а китайские ЦОД, по-видимому, не испытывают проблем с энергий и готовы платит за восстановленную устаревшую электронику, даже с пониженной надёжностью. В результате NVIDIA оказалась в странном положении. Компания в своё время списала $5,5 млрд из-за нераспроданных запасов H20 — когда в США решили полностью запретить их поставки в Китай. После снятия запрета компания резко нарастила выпуск H20, но теперь столкнулась уже с нежеланием властей КНР видеть эти чипы в стране. Тем не менее, её ускорители по-прежнему являются одним из главных катализаторов бума ИИ в Китае. Другими словами, чипы компании по-прежнему доминируют на рынке Поднебесной, но активность на теневых рынках может снизить выгоду от бизнеса с Китаем. Впрочем, уже появилась информация о разработке нового ускорителя на основе современной архитектуры Blackwell — хотя и тоже ослабленного.

28.08.2025 [12:16], Владимир Мироненко

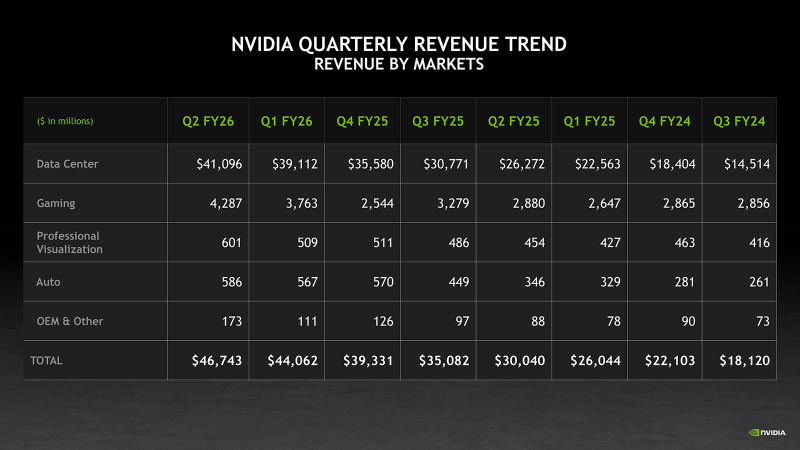

Рекордные продажи NVIDIA не впечатлили инвесторов из-за слабой выручки в сегменте ЦОД и неопределённости с поставками в КитайNVIDIA сообщила финансовые результаты за II квартал 2026 финансового года, завершившийся 27 июля 2025 года. Прибыль и выручка компании превзошли ожидания аналитиков. Также было заявлено, что рост продаж в III квартале сохранится на уровне выше 50 %, что стало для Уолл-стрит сигналом о том, что спрос на ИИ-инфраструктуру не будет снижаться, пишет ресурс CNBC. Выручка составила $46,74 млрд, что на 6 % больше, чем в предыдущем квартале, и на 56 % больше, чем годом ранее, а также больше прогноза аналитиков, опрошенных LSEG, в размере $46,06 млрд. Скорректированная чистая прибыль (Non-GAAP) составила $25,78 млрд или $1,05 на разводнённую акцию, что выше консенсус-прогноза аналитиков, по данным от LSEG, в размере $1,01 на разводнённую акцию. Несмотря на достигнутые результаты, акции компании упали в ходе расширенных торгов на 2,3 %, поскольку выручка от продуктов для ЦОД второй квартал подряд оказалась ниже прогнозов, составив $41,1 млрд (рост год к году на 56 %) при прогнозе StreetAccount в $41,34 млрд. Как полагает ресурс The Guardian, это также свидетельствует о том, что опасения инвесторов по поводу пузыря ИИ и последствий торговых войн Дональда Трампа (Donald Trump) не утихли. Рост выручки NVIDIA год к году превышает 50 % уже девять кварталов подряд, начиная с середины 2023 года, когда начался бум генеративного ИИ. Однако II квартал был отмечен для NVIDIA самым слабым ростом за этот период. NVIDIA также значительно увеличила чистую прибыль по сравнению с прошлым годом — до $26,42 млрд или $1,08 на разводнённую акцию, что на 59 % больше, чем за аналогичный период прошлого года. В сегменте продуктов для ЦОД выручка от поставки решений для вычислений выросла на 50 % год к году до $33,84 млрд, а выручка от продаж сетевого оборудования выросла за квартал на 98 % до $7,25 млрд. Более половины выручки в этом сегменте принесли крупные клиенты. Выручка от решений с архитектурой Blackwell увеличилась год к году на 17 % до $27 млрд. В прошедшем квартале продажи H20 китайским клиентам не осуществлялись. NVIDIA реализовала из ранее зарезервированных запасов H20 на сумму $180 млн клиентам за пределами Китая. Финансовый директор Колетт Кресс (Colette Kress) заявила, что NVIDIA может получить от $2 до $5 млрд выручки от продажи H20 в Китай в течение квартала, если позволит геополитическая обстановка. По её словам, некоторые компании выразили заинтересованность в приобретении H20, и первая группа компаний уже получила лицензии на его покупку. Гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) подчеркнул важность для компании китайского рынка, продажи на котором, по его словам, могут составить до $50 млрд в этом году. «Мы обсуждаем с администрацией важность того, чтобы американские компании имели возможность работать на китайском рынке», — сказал Хуанг. Он также заявил, что помимо одобрения продаж H20 в Китае компаниям, не подпадающим под санкции, у NVIDIA есть потенциальная возможность в конечном итоге продавать в этой стране версию ускорителя на архитектуре Blackwell. Напомним, что американским компаниям было разрешено продавать чипы в Китай при условии уплаты 15 % экспортной пошлины в госбюджет. Предложенную правительством схему юристы назвали неконституционным злоупотреблением властью. Колетт Кресс дала понять, что отсутствие поставок в Китай в минувшем квартале был вызвано неопределённостью этой схемы, которая официально не закреплена в федеральном законодательстве. «Хотя некоторые наши китайские клиенты получили лицензии за последние несколько недель, — сказала Кресс, — мы не отгружали ни одного ускорителя H20 по этим лицензиям». Что касается других направлений деятельности NVIDIA, то выручка от игрового бизнеса в отчётном квартале выросла на 49 % по сравнению с прошлым годом до $4,29 млрд. Автомобильное и робототехническое подразделение компании увеличило продажи год к году на 69 % до $586 млн. В сегменте профессиональной визуализации продажи выросли на 32 % до $601 млн. NVIDIA прогнозирует выручку в текущем квартале в размере $54 млрд ± 2 %. Компания уточнила, что её прогноз не учитывает поставки H20 в Китай. По данным LSEG, аналитики ожидают выручку в финансовом III квартале в размере $53,1 млрд. Хуанг заявил, что компания ожидает, что к концу десятилетия расходы на ИИ-инфраструктуру составят от $3 до $4 трлн, пишет TechCrunch.

28.08.2025 [09:28], Владимир Мироненко

ASUS Cloud увеличит вычислительные мощности Тайваня на 50 %, построив 250-Пфлопс ИИ-суперкомпьютерASUS Cloud в партнёрстве с Taiwan AI Cloud (Taiwan Web Service Corp) и Национальным центром высокопроизводительных вычислений Тайваня (National Center for High-performance Computing, NCHC) в Тайнане (Тайвань) построит суперкомпьютер на ускорителях NVIDIA. Об этом сообщил гендиректор ASUS Cloud и Taiwan AI Cloud Питер Ву (Peter Wu, на фото ниже) в интервью газете South China Morning Post (SCMP). Питер Ву рассказал, что суперкомпьютер с начальной производительностью 80 Пфлопс (точность не уточняется) будет работать на 1700 ускорителях NVIDIA H200. Его запуск запланирован на декабрь, а со временем производительность новой системы вырастет до 250 Пфлопс. Ранее сообщалось, что NVIDIA также поставит два суперускорителя GB200 NVL72 и узлы HGX B300 для данной машины. По словам Ву, после запуска суперкомпьютера общая вычислительную мощность HPC-систем Тайваня вырастет минимум на 50 %. В феврале 2025 года Национальный совет по науке и технологиям Тайваня (NSTC) объявил о планах по увеличению общей вычислительной мощности систем страны примерно до 1200 Пфлопс к 2029 году с имеющихся 160 Пфлопс. Как отметил DataCenter Dynamics, ASUS ранее сотрудничала с NVIDIA в развёртывании суперкомпьютеров на Тайване, включая 9-Плфопс машину Taiwania 2. В 2022 году ASUS и NVIDIA построили на Тайване суперкомпьютер для медицинских исследований. Taiwan AI Cloud уже реализовала аналогичные нынешнему проекты по созданию ИИ-инфраструктуры в других странах. Среди них — ЦОД в Сингапуре, а также объект во Вьетнаме с 200 ускорителями NVIDIA, который строят для государственного оператора Viettel. Этот проект стартовал в начале 2025 года после того, как правительство США одобрило поставку чипов NVIDIA. Ву отметил рост популярности агентного ИИ. Министерство цифровых технологий острова (MODA) «рекомендовало нам предоставить открытую архитектуру с фреймворком агентного ИИ», чтобы помочь местным компаниям использовать или модернизировать свои существующие приложения, сказал он. Говоря о материковом Китае, Питер Ву заявил, что компании будет «непросто» реализовывать там аналогичные проекты «из-за ситуации с поставками GPU». Китайский подход, заключающийся в «стекировании и кластеризации» малопроизводительных чипов для достижения производительности, аналогичной системам с передовыми ИИ-ускорителями, может быть осуществим с точки зрения инференса. Ву отметил, что запуск DeepSeek «рассуждающей» модели R1 в январе спровоцировал рост спроса на инференс, поскольку эта модель превосходно справляется с такими задачами. «Если рабочая нагрузка аналогична [инференсу], будет легче внедрить альтернативную технологическую схему с существующими [чипами]», — сказал Ву, добавив, что разработчики «могут столкнуться с проблемами в выборе GPU», если проект предполагает обучение или тонкую настройку ИИ-систем. Говоря о будущем, Ву сообщил, что ожидает дальнейшего развития трёх сегментов ИИ в будущем: вычислительной геномики, квантовых вычислений и так называемых цифровых двойников. «Приложение-убийца [для цифровых двойников] может появиться в сфере ухода за пожилыми людьми, помогая им получать лекарства, еду или принимать душ», — прогнозирует Ву.

26.08.2025 [13:36], Сергей Карасёв

Advantech представила ИИ-систему MIC-743 на базе NVIDIA Jetson ThorКомпания Advantech анонсировала компьютер небольшого форм-фактора MIC-743, предназначенный для решения ИИ-задач на периферии. Устройство, в частности, может использоваться для работы с большими языковыми моделями (LLM) и визуально-языковыми моделями (VLM). В основу новинки положена аппаратная платформа NVIDIA Jetson Thor с вычислительным модулем Jetson T5000. Он содержит CPU с 14 ядрами Arm Neoverse-V3AE с максимальной тактовой частотой 2,6 ГГц и 2560-ядерный GPU на архитектуре Blackwell с частотой до 1,57 ГГц (96 тензорных ядер пятого поколения). Объём памяти LPDDR5X составляет 128 Гбайт. ИИ-производительность достигает 2070 Тфлопс (FP4 Sparse).

Источник изображения: Advantech Компьютер может быть оснащён SSD формата M.2 2280 с интерфейсом PCIe x4 (NVMe). Есть слоты M.2 2230 E-Key (PCIe x1 и USB 2.0) для адаптера Wi-Fi и M.2 3052/3042 B-Key (USB 3.0 и USB 2.0) для сотового модема (имеется слот Nano SIM). Предусмотрены сетевые порты 5GbE RJ45 и QSFP28 (4 × 25 GbE), интерфейс HDMI с поддержкой разрешения до 3840 × 2160 при частоте обновления 60 Гц, четыре порта USB 3.2 Gen2, аудиогнёзда на 3,5 мм. MIC-743 имеет размеры 195 × 200 × 71,5 мм и весит примерно 2 кг. Диапазон рабочих температур простирается от -10 до +35 °C. Применяется программное обеспечение NVIDIA JetPack 7.0. Для новинки заявлена бесшовная интеграция с различными датчиками, камерами и периферийными устройствами для быстрого создания комплексных решений на базе ИИ. Устройство подходит для применения на промышленных предприятиях, в исследовательских лабораториях, центрах разработки и пр.

22.08.2025 [22:44], Владимир Мироненко

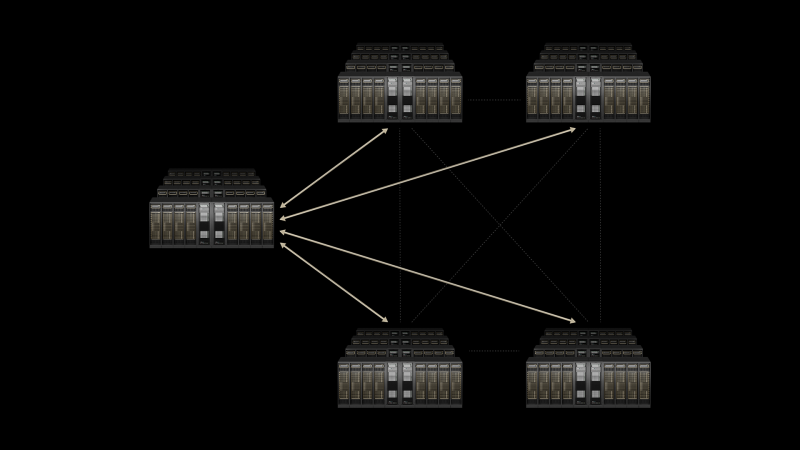

Связанные одной целью: NVIDIA Spectrum-XGS Ethernet объединит несколько ЦОД в одну ИИ-суперфабрикуNVIDIA анонсировала Spectrum-XGS Ethernet, масштабируемую технологию для объединения распределённых ЦОД в унифицированные гигантские ИИ-фабрики. Похожее решения не так давно предложила и Broadcom, анонсировав коммутаторы Jericho4. На фоне роста спроса на обработку ИИ-нагрузок отдельные ЦОД достигают пределов допустимой мощности, но выход за пределы одного объекта связан с трудностями из-за ограничений существующей сетевой инфраструктуры с высокой задержкой, джиттером и непрогнозируемой производительностью. NVIDIA позиционирует Spectrum-XGS Ethernet как революционное дополнение к платформе NVIDIA Spectrum-X Ethernet, которое устраняет эти ограничения. Решение служит третьим столпом ИИ-вычислений, выходящим за рамки вертикального и горизонтального масштабирования, и предназначено для повышения производительности и масштабируемости Spectrum-X Ethernet для объединения нескольких распределённых ЦОД в массивы ИИ-фабрик, способных обрабатывать ИИ-нагрузки в гигантских масштабах. «Индустриальная революция в области ИИ уже началась, и гигантские ИИ-фабрики являются важнейшей инфраструктурой, — заявил генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) — С помощью NVIDIA Spectrum-XGS Ethernet мы расширяем возможности по масштабированию, объединяя ЦОД в городах, странах и континентах в огромные ИИ-суперфабрики». Spectrum-XGS Ethernet дополняет платформу Spectrum-X алгоритмами, которые динамически адаптируют сеть с учётом расстояния между объектами ЦОД. Решение опирается на усовершенствованный автоматический контроль перегрузки, точное управление задержками и сквозную телеметрию. По словам NVIDIA, Spectrum-XGS Ethernet практически удваивает производительность работы библиотеки коллективных коммуникаций NVIDIA NCCL, ускоряя взаимодействие множества ускорителей и множества узлов и обеспечивая предсказуемую производительность в географически распределённых ИИ-кластерах. В результате несколько ЦОД будут работать как единая ИИ-фабрика, полностью оптимизированная для подключения на больших расстояниях. CoreWeave одной из первых внедрит Spectrum-XGS Ethernet в свои ЦОД. Сама NVIDIA не новичок в распределённых ИИ-вычислениях — её собственные кластеры для внутренних нужд размещались в нескольких дата-центрах США.

22.08.2025 [16:33], Владимир Мироненко

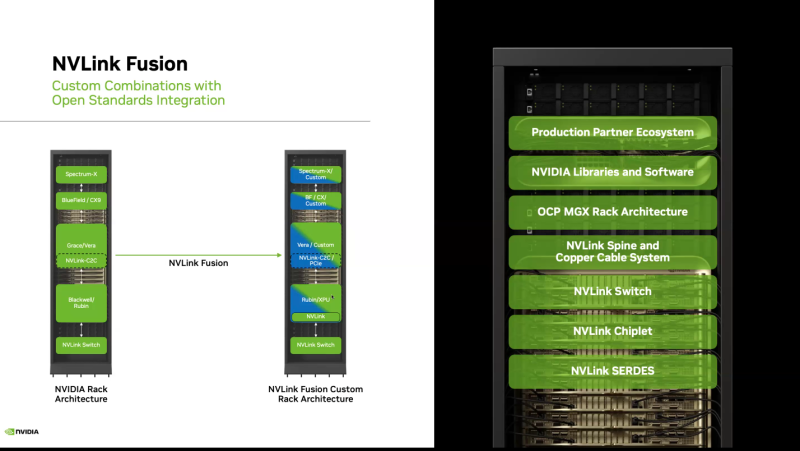

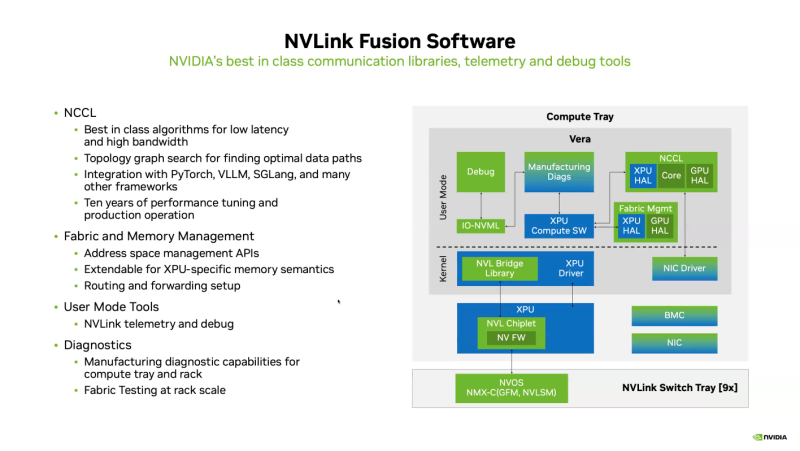

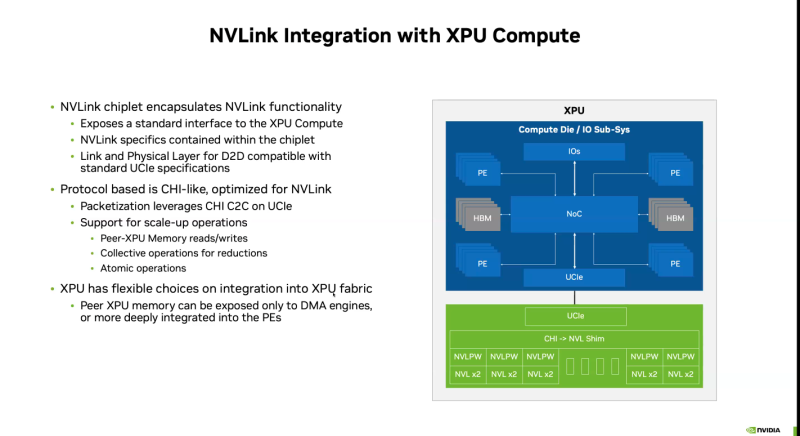

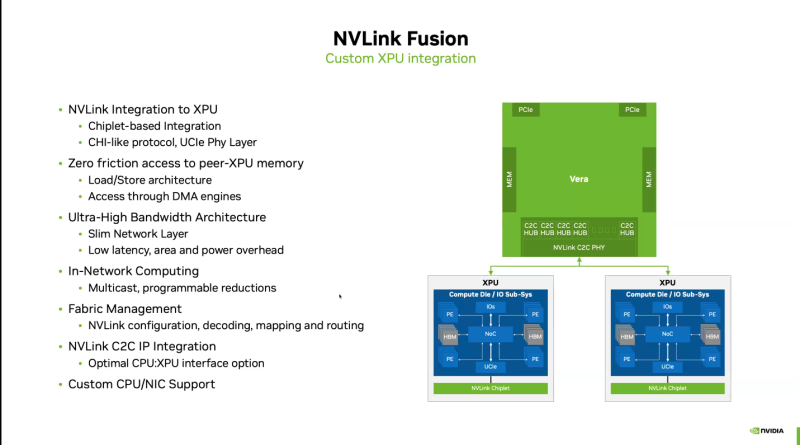

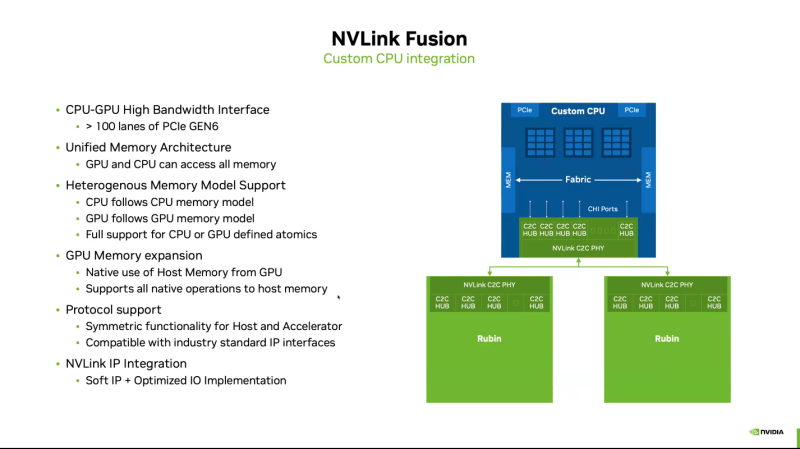

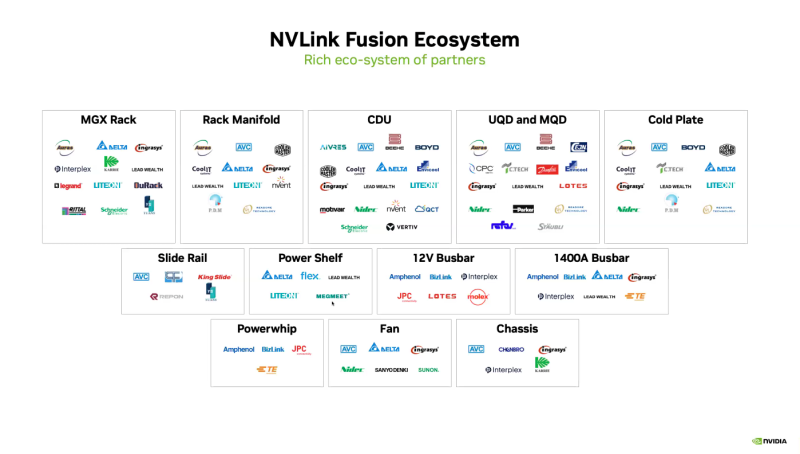

Почти как у самой NVIDIA: NVLink Fusion позволит создавать кастомные ИИ-платформыТехнологии NVIDIA NVLink и NVLink Fusion позволят вывести производительность ИИ-инференса на новый уровень благодаря повышенной масштабируемости, гибкости и возможностям интеграции со сторонними чипами, которые в совокупности отвечает стремительному росту сложности ИИ-моделей, сообщается в блоге NVIDIA. С ростом сложности ИИ-моделей выросло количество их параметров — с миллионов до триллионов, что требует для обеспечения их работы значительных вычислительных ресурсов в виде кластеров ускорителей. Росту требований, предъявляемых к вычислительным ресурсам, также способствует внедрение архитектур со смешанным типом вычислений (MoE) и ИИ-алгоритмов рассуждений с масштабированием (Test-time scaling, TTS). NVIDIA представила интерконнект NVLink в 2016 году. Пятое поколение NVLink, вышедшее в 2024 году, позволяет объединить в одной стойке 72 ускорителя каналами шириной 1800 Гбайт/с (по 900 Гбайт/с в каждую сторону), обеспечивая суммарную пропускную способность 130 Тбайт/с — в 800 раз больше, чем у первого поколения. Производительность NVLink зависит от аппаратных средств и коммуникационных библиотек, в частности, от библиотеки NVIDIA Collective Communication Library (NCCL) для ускорения взаимодействия между ускорителями в топологиях с одним и несколькими узлами. NCCL поддерживает вертикальное и горизонтальное масштабирование, а также включает в себя автоматическое распознавание топологии и оптимизацию передачи данных. Технология NVLink Fusion призвана обеспечить гиперскейлерам доступ ко всем проверенным в производстве технологиям масштабирования NVLink. Она позволяет интегрировать кастомные микросхемы (CPU и XPU) с технологией вертикального и горизонтального масштабирования NVIDIA NVLink и стоечной архитектурой для развёртывания кастомных ИИ-инфраструктур. Технология охватывает NVLink SerDes, чиплеты, коммутаторы и стоечную архитектуру, предлагая универсальные решения для конфигураций кастомных CPU, кастомных XPU или комбинированных платформ. Модульное стоечное решение OCP MGX, позволяющее интегрировать NVLink Fusion с любым сетевым адаптером, DPU или коммутатором, обеспечивает заказчикам гибкость в построении необходимых решений, заявляет NVIDIA. NVLink Fusion поддерживает конфигурации с кастомными CPU и XPU с использованием IP-блоков и интерфейса UCIe, предоставляя заказчикам гибкость в реализации интеграции XPU на разных платформах. Для конфигураций с кастомными CPU рекомендуется интеграция с IP NVLink-C2C для оптимального подключения и производительности GPU. При этом предлагаются различные модели доступа к памяти и DMA. NVLink Fusion использует преимущества обширной экосистемы кремниевых чипов, в том числе от партнёров по разработке кастомных полупроводников, CPU и IP-блоков, что обеспечивает широкую поддержку и быструю разработку новых решений. Основанная на десятилетнем опыте использования технологии NVLink и открытых стандартах архитектуры OCP MGX, платформа NVLink Fusion предоставляет гиперскейлерам исключительную производительность и гибкость при создании ИИ-инфраструктур, подытожила NVIDIA. При этом основным применением NVLink Fusion с точки зрения NVIDIA, по-видимому, должно стать объединение сторонних чипов с её собственными, а не «чужих» чипов между собой. Более открытой альтернативой NVLink должен стать UALink с дальнейшим масштабированием посредством Ultra Ethernet.

22.08.2025 [13:30], Алексей Разин

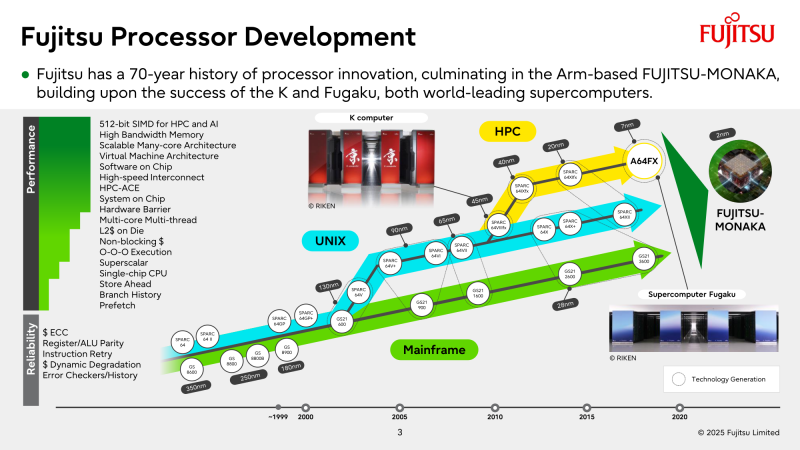

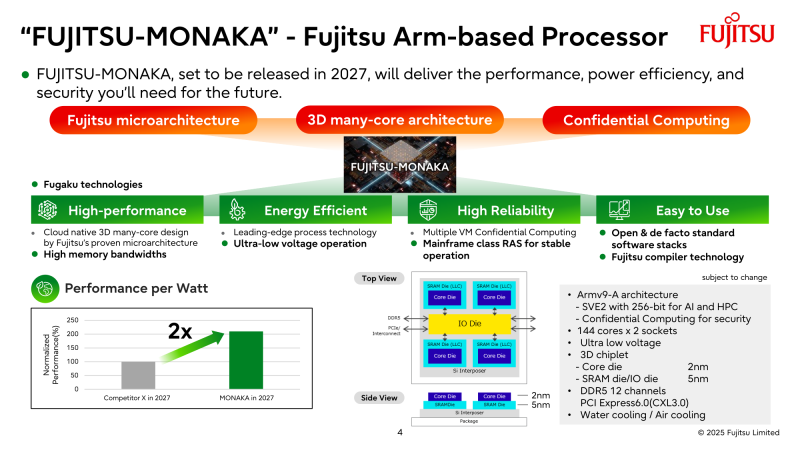

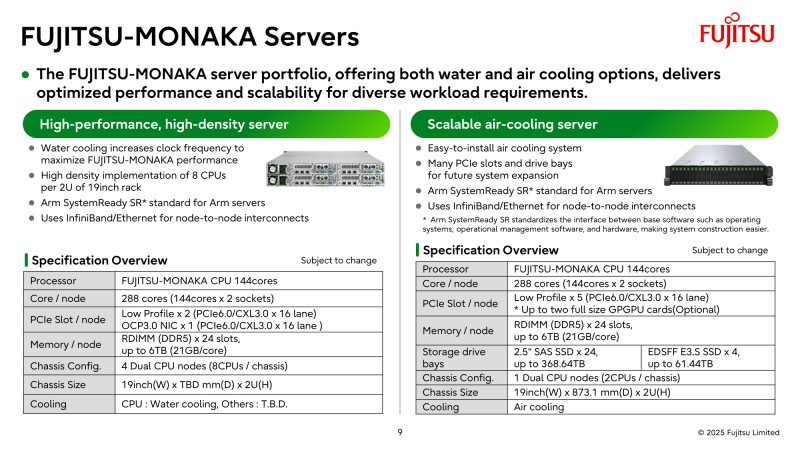

NVIDIA поможет японцам создать один из мощнейших суперкомпьютеров мира FugakuNEXTВ начале этого десятилетия созданный в Японии суперкомпьютер Fugaku пару лет удерживался на верхней строчке в рейтинге мощнейших систем мира TOP500, он и сейчас занимает в нём седьмое место. В попытке технологического реванша японский исследовательский институт RIKEN доверился компании NVIDIA, которая поможет Fujitsu создать суперкомпьютер Fugaku NEXT. Помимо Arm-процессоров Fujitsu MONAKA-X, в основу нового японского суперкомпьютера лягут и ускорители NVIDIA, хотя изначально планировалось обойтись без них. NVIDIA будет принимать непосредственное участие в интеграции своих компонентов в суперкомпьютерную систему, создаваемую японскими партнёрами. По меньшей мере, скоростные интерфейсы, которыми располагает NVIDIA, пригодятся для обеспечения быстрого канала передачи информации между CPU и ускорителями. Сама NVIDIA обтекаемо говорит, что для этого можно задействовать шину NVLink Fusion. С ускорителями AMD, по-видимому, эти процессоры будут общаться более традиционно, т.е. по шине PCIe. Кроме того, NVIDIA собирается применить в составе данной системы передовые типы памяти. Применяемые при создании FugakuNEXT решения, по мнению представителей NVIDIA, смогут стать типовыми для всей отрасли в дальнейшем. Подчёркивается, что будущая платформа станет не просто техническим апгрейдом, а инвестицией в будущее страны. Сама архитектура системы не уточняется, поэтому сложно судить, насколько активно японские разработчики будут использовать ускорители NVIDIA, и к какому поколению они будут относиться. Создатели ставят перед собой амбициозные цели — FugakuNEXT должна стать первой системой «зетта-масштаба». Своего предшественника она должна превзойти более чем в пять раз, обеспечив быстродействие на уровне 600 Эфлопс (FP8). На уровне приложений прирос быстродействия может быть стократным, отмечают создатели. Новый суперкомпьютер сможет применяться для обучения больших языковых моделей. Впрочем, в строй он будет введён лишь к 2030 году, а Fujitsu ещё только предстоит выпустить свои процессоры MONAKA-X для этой системы.

21.08.2025 [19:51], Руслан Авдеев

NVIDIA тормозит развитие погружных СЖО, но через пару лет ситуация может изменитьсяЭксперименты с иммерсионным охлаждением для мейнфреймов и суперкомпьютеров начали проводиться ещё в 1970-х годах прошлого века, но массовой технология так и не стала из-за высокой стоимости и сложности обслуживания. Примечательно, что сегодня, когда чипы становятся всё более горячими, главным препятствием на пути коммерческого внедрения иммерсионных технологий стала NVIDIA, передаёт ZDNet Korea со ссылкой на источники в индустрии. Возрождение интереса к технологии началось в конце 2000-х гг., когда всерьёз встала проблема повышения энергоэффективности дата-центров. С середины 2010-х крупные облачные компании вроде Microsoft, Google и Alibaba начали эксперименты с двухфазным иммерсионным охлаждением, однако рынок таких систем до сих пор находится в зачаточном состоянии. NVIDIA же «виновата» тем, что не сертифицирует подобные системы. Как заявил один из отраслевых инсайдеров, компания не даёт никаких гарантий при использовании иммерсионных систем со своими ускорителями, поскольку неизвестно, какие проблемы могут возникнуть в долгосрочной перспективе. Прямое жидкостное охлаждение (DLC) менее эффективно, чем иммерсионные системы, но NVIDIA всё ещё считает, что пока достаточно и этого.

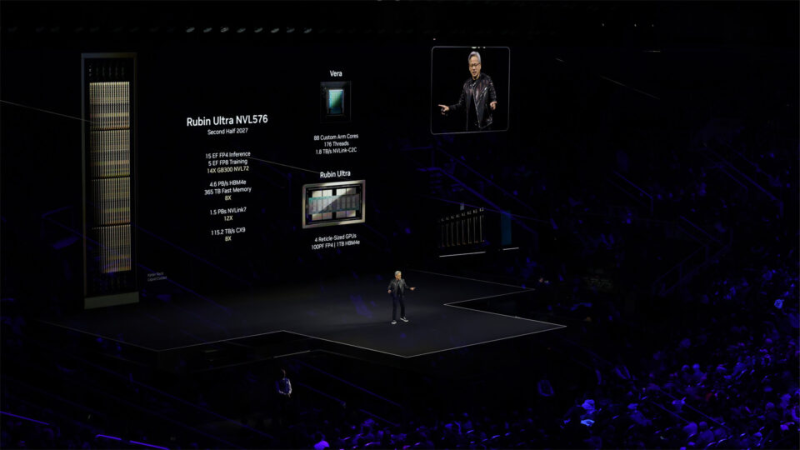

Источник изображения: NVIDIA Влияние на отсутствие повсеместного внедрения иммерсионного охлаждения, вероятно, оказали и экономические причины. Погружные СЖО требуют специальной инфраструктуры, поэтому внедрить их в уже действующие ЦОД с традиционным воздушным охлаждением трудно. При этом системы прямого жидкостного охлаждения (DLC) успешно сочетаются с воздушными системами на базе уже имеющейся инфраструктуры. Эксперты прогнозируют, что настоящий расцвет рынка иммерсионного охлаждения придётся на 2027–2028 гг. Ожидается, что оно будет активно распространяться после выхода ускорителей NVIDIA Rubin Ultra. Так, стойка Rubin Ultra NVL576 будет потреблять 600 кВт, а Google, OCP и Schneider Electric уже проектируют стойки мегаваттного класса. Следующее поколение чипов будет обладать настолько интенсивным тепловыделением, что охладить с помощью привычных СЖО уже не получится, говорит один из инсайдеров. По слухам, NVIDIA активно нанимает специалистов, связанных с иммерсионным охлаждением. Источники свидетельствуют, что в будущем у операторов ЦОД якобы просто не останется выбора. Однако Intel, ZutaCore, CoolIT, Accelsius и др. уже представили водоблоки для чипов с TDP от 1 кВт до 4,5 кВт, так что DLС ещё долго будут сохранять актуальность. |

|