Материалы по тегу: hpc

|

11.11.2024 [07:52], Сергей Карасёв

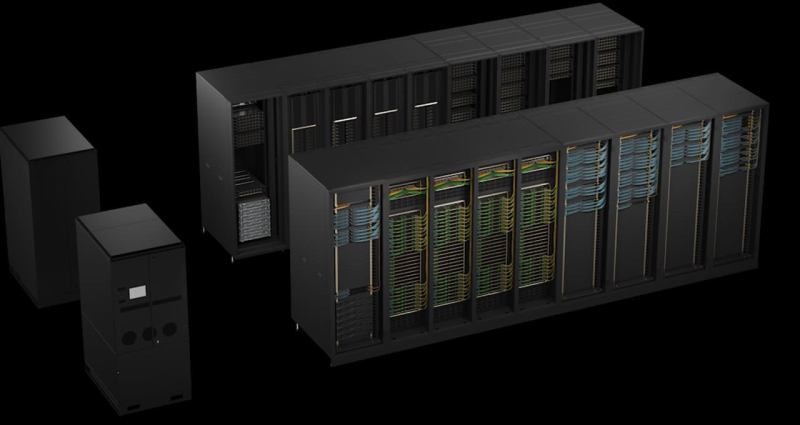

Lenovo поставит Италии НРС-кластер на базе Intel Xeon Emerald Rapids для исследований в области чистой энергииНациональное агентство по новым технологиям, энергетике и устойчивому экономическому развитию Италии (ENEA) выбрало компанию Lenovo для создания нового суперкомпьютера. Использовать НРС-комплекс планируется для ускорения исследований в области чистой энергии, в частности, по направлению ядерного синтеза. Проект нацелен на повышение вычислительной мощности платформы CRESCO (Computational Center for Research on Complex Systems — Вычислительный центр в области исследований сложных систем). Эта суперкомпьютерная система располагается в исследовательском центре Портичи (регион Кампания, административный центр Неаполь). Lenovo развернёт кластер из 758 узлов, в оснащение каждого из которых войдут два процессора Intel Xeon Platinum 8592+ поколения Emerald Rapids (64С/128T; 1,9–3,9 ГГц; 350 Вт). Говорится о применении технологии прямого жидкостного охлаждения Lenovo Neptune Direct Water-Cooling, которая позволяет отводить до 98 % тепла, генерируемого НРС-комплексом. Подчёркивается, что, помимо повышения производительности, оборудование Lenovo обеспечит высокую энергетическую эффективность. Серверы изготавливаются на предприятии Lenovo в Венгрии, а близость к месту установки позволяет сократить расходы по транспортировке и снизить выбросы вредных газов в атмосферу.

Источник изображения: Lenovo После введения в эксплуатацию новой системы общее быстродействие CRESCO поднимется примерно в шесть раз: с нынешних 1,01 до более чем 6,5 Пфлопс. Это выведет платформу в лидеры по вычислительной мощности в Италии. ENEA управляет развитой вычислительной инфраструктурой, которая предоставляет пользователям ресурсы для расчётов, моделирования и трёхмерной визуализации данных. В настоящее время сеть объединяет шесть объектов в разных областях: это Фраскати, Портичи, Болонья, Казачча, Трисайя и Бриндизи.

09.11.2024 [20:20], Руслан Авдеев

Жители Мемфиса не рады развитию ИИ-суперкомпьютера xAI Coloussus Илона МаскаАктивисты из числа жителей американского Мемфиса раскритиковали оператора энергосети Tennessee Valley Authority (TVA) за предоставление стартапу xAI Илона Маска доступа к дополнительным 150 МВт для питания ИИ-суперкомпьютера Colossus, сообщает Datacenter Dynamics. В минувший четверг TVA одобрил запрос от энергокомпании Memphis Light, Gas and Water (MLGW). Colossus предназначен для обучения и обслуживания ИИ-бота Grok, заработавшего ранее в этом году. Суперкомпьютер разместился в помещениях бывшего завода Electrolux в промышленном парке на юго-востоке Мемфиса. Ранее Маск заявлял, что речь идёт о самом быстром в мире ИИ-суперкомпьютере, включающем 100 тыс. ускорителей NVIDIA H100. Правда, буквально через несколько дней Meta✴ похвасталась ещё более крупной системой для обучения Llama-4. Но и Маск обещал в ближайшие месяцы удвоить мощность суперкомпьютера, который получит 50 тыс. ускорителей NVIDIA H200. Всё это означает, что машине потребуется много энергии. Ранее в этом году MLGW согласилась обеспечить xAI ещё 150 МВт, ожидалось лишь одобрение TVA. Комплекс даже пришлось запитать от мобильных газовых генераторов Voltagrid, что само по себе вызвало недовольство местных жителей. xAI со своей стороны пообещала построить крупнейшую в мире систему очистки сточных вод с керамическим мембранами, а также с дисконтом предоставлять ресурсы энергохранилища Tesla Megapack, построенного рядом с Colossus, для поддержки стабильности энергосети Мемфиса. Новость не вызывала энтузиазма у местных активистов и экозащитников, обеспокоенных вероятной нагрузкой на энергосети города и низким качеством воздуха. Активисты также подчёркивают, что оператор TVA обязан служить интересам общества и изучить последствия выделения xAI дополнительных 150 МВт, поскольку регион и так страдает от высоких нагрузок на сети и загрязнения окружающей среды. Дело, в частности, в том, что TVA намерена построить турбины на природном газе для получения ещё 200 МВт, поскольку оператор ещё прошлой осенью не справлялся со спросом. В TVA заявляют, что задача оператора — работать с партнёрами для привлечения в регион инвестиций и рабочих мест, в каждом случае аккуратно оцениваются детали каждого предложения. MLGW получит из бюджета $760 тыс. для введения в строй ещё 50 МВт, а xAI обязуется построить за $24 млн собственную подстанцию на 150 МВт. Существующие договорённости предусматривают, что xAI будет получать ежемесячные скидки от поставщика энергии, пока не компенсирует стоимость возводимой ей подстанции и та не перейдёт в собственность MLGW.

05.11.2024 [15:40], Сергей Карасёв

MONAKA + Instinct: AMD и Fujitsu вместе создадут Arm-платформы для ИИ и HPCAMD и Fujitsu объявили о подписании меморандума о взаимопонимании с целью формирования стратегического партнёрства, направленного на создание вычислительных платформ для ИИ и HPC. Предполагается, что сотрудничество охватит различные сферы — от разработки специализированных решений до коммерциализации. Речь идёт об объединении передовых аппаратных решений в области CPU и GPU с сопутствующим ПО. Партнёры намерены содействовать формированию открытой экосистемы для задач ИИ. В частности, упомянуты Arm-процессоры Fujitsu MONAKA и ускорители AMD Instinct. Стороны намерены задействовать открытый программный стек AMD ROCm и специализированный софт Fujitsu для изделий с архитектурой Arm. В целом, сотрудничество будет сосредоточено на трёх ключевых направлениях — инжиниринг, экосистемы и бизнес. Партнёры рассчитывают создать инновационные вычислительные платформы для ИИ и HPC к 2027 году. AMD и Fujitsu также будут сообща работать над маркетинговыми кампаниями и улучшать взаимодействие с заказчиками. Например, планируется создание совместного центра для клиентов. «Объединяя инновационную технологию графических чипов AMD с эффективными и высокопроизводительными процессорами Fujitsu, мы стремимся создать среду, в которой больше компаний смогут использовать инструменты ИИ при одновременном снижении энергопотребления в дата-центрах», — говорит Вивек Махаджан (Vivek Mahajan), корпоративный вице-президент и технический директор Fujitsu. Нужно отметить, что ранее Fujitsu заключила соглашение о сотрудничестве с Supermicro. Компании займутся разработкой СЖО для ЦОД, а также серверов следующего поколения на чипах Fujitsu MONAKA для широкого спектра рабочих нагрузок — от ИИ и НРС до облачных и периферийных задач. Два года назад AMD также подписала аналогичное соглашение о сотрудничестве с европейским разработчиком серверных Arm-процессоров SiPearl.

05.11.2024 [11:17], Сергей Карасёв

Создан консорциум UALink по разработке альтернативы NVIDIA NVLinkВ мае нынешнего года был сформирован альянс Ultra Accelerator Link (UALink) по разработке технологии, призванной составить конкуренцию NVIDIA NVLink. А теперь участники отрасли объявили о создании соответствующего консорциума — UALink Consortium. Новую структуру возглавляют представители AMD, AWS, Astera Labs, Cisco, Google, HPE, Intel, Meta✴ и Microsoft. В состав консорциума также входят Cadence, Lenovo, H3C, Centec, Anapass и пр. Кроме того, к участию приглашаются другие заинтересованные стороны. Фактически участники заняты созданием более открытой альтернативы NVLink. «Стандарт UALink определяет высокоскоростную связь с низкими задержками для масштабируемых систем ИИ в дата-центрах. Заинтересованные компании могут присоединиться к консорциуму и поддержать нашу миссию: создание открытого и высокопроизводительного интерконнекта для рабочих нагрузок ИИ», — сказал Вилли Нельсон (Willie Nelson), президент UALink. Отмечается, что компании, входящие в совет консорциума, охватывают широкий спектр отраслей — от поставщиков облачных услуг и OEM-производителей до разработчиков ПО и полупроводниковых компонентов. В I квартале 2025 года планируется представить общедоступную спецификацию UALink 1.0, которая предусматривает пропускную способность до 200 Гбит/с на соединение. В пределах одного домена при этом могут быть объединены до 1024 ускорителей ИИ. Выпуск спецификации UALink 1.0 станет важной вехой, поскольку она определит открытый отраслевой стандарт, позволяющий ускорителям и коммутаторам ИИ взаимодействовать более эффективно. Это откроет новые возможности в плане развития и внедрения крупных ИИ-моделей.

04.11.2024 [17:05], Сергей Карасёв

NextSilicon представила самооптимизирующиеся ускорители вычислений Maverick-2Компания NextSilicon сообщила о разработке устройств Maverick-2 — так называемых интеллектуальных вычислительных ускорителей (Intelligent Compute Accelerator, ICA). Изделия, как утверждается, обеспечивают высокую производительность и эффективность при решении задач HPC и ИИ, а также при обслуживании векторных баз данных. NextSilicon разрабатывает новую вычислительную платформу для ресурсоёмких приложений. Применяются специальные программные алгоритмы для динамической реконфигурации оборудования на основе данных, получаемых непосредственно во время выполнения задачи. Это позволяет оптимизировать производительность и энергопотребление. Maverick-2 ICA, по словам компании, представляет собой программно-определяемый аппаратный ускоритель. По заявлениям NextSilicon, изделие в плане производительности на один ватт затрачиваемой энергии более чем в четыре раза превосходит традиционные GPU, а в сравнении с топовыми CPU и вовсе достигается 20-кратное превосходство. При этом говорится об уменьшении эксплуатационных расходов более чем в два раза. «Телеметрические данные, собранные во время работы приложения, используются интеллектуальными алгоритмами NextSilicon для непрерывной самооптимизации в реальном времени. Результатом являются эффективность и производительность в задачах HPC при сокращении потребления энергии на 50–80 % по сравнению с традиционными GPU», — заявляет компания. Решения Maverick-2 доступны в виде однокристальной карты расширения PCIe 5.0 x16 и двухкристального OAM-модуля. В первом случае объём памяти HBM3e составляет 96 Гбайт, энергопотребление — 300 Вт. У второго изделия эти показатели равны 192 Гбайт и 600 Вт. Тактовая частота в обоих вариантах — 1,5 ГГц. При производстве применяется 5-нм технология TSMC. Говорится о совместимости с популярными языками программирования и фреймворками, такими как C/C++, Fortran, OpenMP и Kokkos. Это позволяет многим приложениям работать без изменений, упрощая портирование и устраняя необходимость в проприетарном программном стеке.

04.11.2024 [13:05], Сергей Карасёв

DeepL развернёт в Швеции ИИ-платформу на базе NVIDIA DGX GB200 SuperPod, чтобы «разрушить языковые барьеры»Компания DeepL объявила о намерении развернуть вычислительный комплекс на платформе NVIDIA DGX SuperPOD с ускорителями GB200. Система расположится на площадке EcoDataCenter в Швеции, а её ввод в эксплуатацию запланирован на середину 2025 года. DeepL специализируется на разработке средств автоматического перевода на основе ИИ. По заявлениям Ярека Кутыловски (Jarek Kutylowski), генерального директора и основателя DeepL, компания создала решение, которое по точности перевода превосходит все другие сервисы на рынке. Более 100 тыс. предприятий, правительственных структур и других организаций, а также миллионы индивидуальных пользователей по всему миру применяют языковые ИИ-инструменты DeepL. Штат компании насчитывает более 1 тыс. сотрудников. Её поддерживают инвестициями Benchmark, IVP, Index Ventures и др. В 2023 году DeepL развернула суперкомпьютер Mercury на базе NVIDIA DGX SuperPOD с ускорителями H100. В июньском рейтинге TOP500 эта система занимает 41-е место с FP64-производительностью 21,85 Пфлопс и теоретическим пиковым быстродействием 33,85 Пфлопс. Платформа NVIDIA DGX SuperPOD с ускорителями GB200 предусматривает использование жидкостного охлаждения. Возможно масштабирование до десятков тысяч ускорителей. DeepL намерена применять новый комплекс для исследовательских задач — в частности, для разработки передовых ИИ-моделей, которые позволят ещё больше расширить возможности средств перевода между различными языками. Это позволит «разрушить языковые барьеры для предприятий и профессионалов по всему миру», обещает компания.

02.11.2024 [12:04], Руслан Авдеев

ParTec обвинила NVIDIA и Microsoft в нарушении патентов на ИИ-суперкомпьютерыНемецкий разработчик и интегратор HPC-решений ParTec выступил с иском к NVIDIA, обвинив последнюю в нарушении патентных прав. По данным The Register, компания требует запретить продажи ускорителей NVIDIA в 18 странах, участвующих в общей для ЕС патентной системе. ParTec, принимающая участие в создании первой в Европе экзафлопсной машины JUPITER и других суперкомпьютеров вроде MareNostrum5, подтвердила, что предметом спора являются те же самые патенты, из-за которых Partec уже подала иск против Microsoft в США. Впрочем, не исключено, что ParTec намерена добиваться не запрета продаж, а подписания с NVIDIA лицензионного договора — иначе блокировка сбыта в Европе ускорителей NVIDIA может повлиять на реализацию проектов с участием самой ParTec. Оба иска касаются патентов, связанных с динамической модульной системной архитектурой (dMSA). Именно она имеет важнейшее значение для построения высокопроизводительных вычислительных кластеров и обеспечивает оптимальное взаимодействие CPU, GPU и прочей электроники в составе систем, применяемых как для обучения ИИ-моделей, так и для инференса. Ранее в ParTec сообщали, что Microsoft незаконно использовала именно эту интеллектуальную собственность при создании облачной платформы Azure AI.

Источник изображения: Tingey Injury Law Firm/unsplash.com Иск к NVIDIA ParTec и её лицензионный агент BF exaQC AG подали в Единый патентный суд Евросоюза 27 октября. В ParTec намерены добиваться запрета для NVIDIA распространять свои ускорители в странах Евросоюза, в которых действуют патенты, а также возмещения ущерба. По имеющимся данным, речь идёт о патентах EP2628080 и EP3743812, причём последний действует во всех странах ЕС, являющихся частью Единой патентной системы. Речь идёт о 18 государствах, в том числе Германии, Франции и Италии. Если истцы выиграют суд, продажа ряда продуктов NVIDIA в этих странах будет запрещена. В компании утверждают, что давно предвидели перспективы ПО для масштабирования вычислений, поэтому и занялись разработкой dMSA. Компания также утверждает, что вела переговоры с NVIDIA, продемонстрировав свою модульную архитектуру, ПО ParaStation и ключевые патенты. NVIDIA якобы проявила большой интерес к технологии и даже объявила о готовности разрабатывать суперкомпьютеры с использованием ParaStation, но впоследствии эти планы так и не были реализованы. Сейчас компании так или иначе сотрудничают над созданием других суперкомпьютеров, где NVIDIA выступает «предпочтительным поставщиком» ускорителей для ЦОД. В ParTec заявили, что иск был неизбежен, поскольку NVIDIA отказалась вести переговоры о поставках ускорителей. Последняя якобы поступила так из-за иска ParTec к Microsoft — одного из ключевых клиентов NVIDIA. В ParTec подчёркивают, что благодаря её технологиям Германия и Европа в целом получат возможность развить собственную «суверенную индустрию». Однако мир сегодня зависит от нарушителей патентов, т.е. NVIDIA и Microsoft, распространяющих решения, представляющие угрозу для Германии и европейской IT-индустрии, говорит ParTec.

01.11.2024 [11:14], Сергей Карасёв

Марк Цукерберг: для обучения ИИ-модели Llama-4 используются более 100 тыс. ускорителей NVIDIA H100Председатель правления и генеральный директор Meta✴ Марк Цукерберг (Mark Zuckerberg), по сообщению ресурса Tom's Hardware, раскрыл масштабы кластера, который используется для обучения ИИ-модели нового поколения Llama-4. По его словам, для этих целей задействованы более 100 тыс. ускорителей NVIDIA H100. Напомним, в начале сентября нынешнего года стартап xAI, курируемый Илоном Маском (Elon Musk), объявил о запуске ИИ-суперкомпьютера Colossus, в основу которого положены 100 тыс. штук H100. В дальнейшем количество ускорителей в составе Colossus планируется увеличить вдвое. Теперь об эксплуатации кластера схожего масштаба рассказал Цукерберг. Глава Meta✴ не стал вдаваться в подробности о характеристиках Llama-4, ограничившись лишь фразами вроде «новые модальности», «более сильные рассуждения» и «повышенное быстродействие». Ранее Meta✴ заявляла о намерении потратить в 2024-м от $30 млрд до $37 млрд на развитие своей инфраструктуры — прежде всего для задач ИИ. Кроме того, говорилось, что к концу текущего года компания рассчитывает оперировать мощностями, эквивалентными более чем 500 тыс. ускорителей NVIDIA H100.

Источник изображения: Meta✴ Вместе с тем, как отмечается, возникают сложности при обеспечении питанием столь масштабных ИИ-кластеров. Дело в том, что один современный GPU может потреблять до 3,7 МВт·ч электроэнергии в год. Это означает, что массив из 100 тыс. таких ускорителей потребует не менее 370 ГВт·ч в год, чего достаточно для обеспечения энергией более 34 млн среднестатистических американских домохозяйств. Цукерберг признаёт, что трудности, связанные с доступностью энергоресурсов, в перспективе могут ограничить темпы роста отрасли ИИ. Как добавляет ComputerWeekly, Meta✴ также отказалась от практики увеличения срока службы серверов с целью сокращения расходов. Ранее компания сообщила о продлении периода эксплуатации оборудования до пяти лет вместо прежних четырёх с половиной: это, как ожидалось, даст экономию в $1,5 млрд. Однако теперь финансовый директор Meta✴ Сьюзан Ли (Susan Li) заявила, что компания в свете стремительного развития ИИ намерена применять серверы последнего поколения, чтобы максимально эффективно использовать доступную ёмкость существующих дата-центров.

30.10.2024 [12:00], Сергей Карасёв

NVIDIA представила эталонные архитектуры для корпоративных ИИ-фабрикКомпания NVIDIA анонсировала инициативу Enterprise Reference Architectures (Enterprise RA), в рамках которой партнёры и заказчики смогут использовать эталонные архитектуры для построения собственных ИИ-платформ корпоративного уровня, рассчитанных на ресурсоёмкие нагрузки. NVIDIA отмечает, что на фоне перехода от вычислений общего назначения к ускоренным вычислениям предприятия сталкиваются с различными трудностями при проектировании и развёртывании инфраструктуры ЦОД. Это затрудняет разработку долгосрочных стратегий и снижает эффективность инвестиций. Инициатива Enterprise RA призвана решить проблемы. Эталонные архитектуры Enterprise RA помогут организациям минимизировать ошибки при проектировании так называемых фабрик ИИ (дата-центров для задач ИИ), предоставляя комплексные рекомендации по аппаратному и программному обеспечению, а также подробные указания по оптимальным конфигурациям серверов, кластеров и сетей. В результате клиенты смогут снизить затраты и сократить время, необходимое для построения вычислительной ИИ-инфраструктуры нового поколения. Среди преимуществ предлагаемого подхода названы масштабируемость и управляемость, высокий уровень безопасности (применяется принцип нулевого доверия), оптимальная производительность, снижение сложности систем и ускоренный выход на рынок. Эталонные архитектуры спроектированы таким образом, чтобы их можно было легко модернизировать в будущем. Говорится о совместимости с различными сторонними аппаратными и программными компонентами, но в перечень рекомендаций входят прежде всего решения самой NVIDIA, включая:

Решения на базе NVIDIA Enterprise RA будут предлагаться партнёрами NVIDIA, включая Dell, НРЕ, Lenovo и Supermicro.

29.10.2024 [20:28], Сергей Карасёв

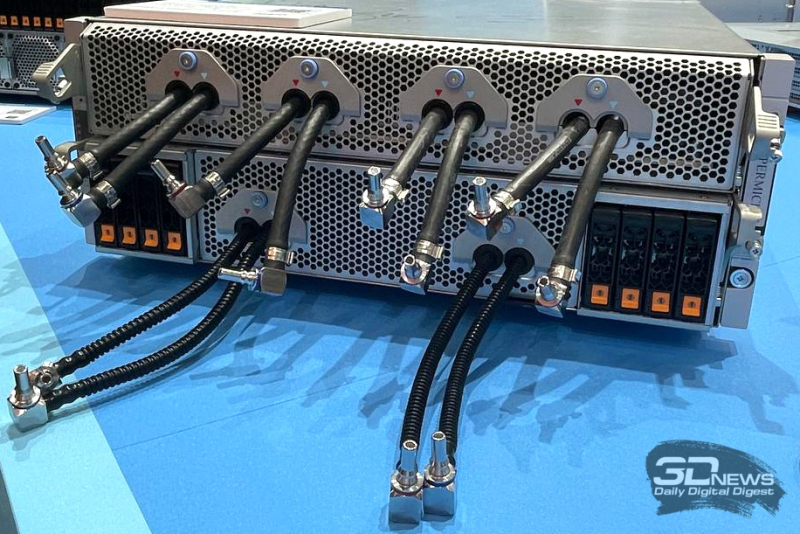

Раскрыты подробности архитектуры ИИ-кластера xAI Colossus со 100 тыс. ускорителей NVIDIA H100Портал ServeTheHome рассказал подробности об архитектуре вычислительного кластера xAI Colossus, предназначенного для обучения крупных ИИ-моделей. Эта система использует 100 тыс. NVIDIA H100, а в дальнейшем количество ускорителей планируется увеличить вдвое. Это самый крупный из известных ИИ-кластеров на текущий момент. Оборудование для него поставили компании Dell и Supermicro. Стартап xAI, курируемый Илоном Маском (Elon Musk), объявил о запуске суперкомпьютера Colossus в начале сентября нынешнего года. Утверждается, что на создание системы потребовалось всего 122 дня. Причём с момента установки первой стойки с серверами до начала обучения ИИ-моделей прошло только 19 суток. Впрочем, как отмечают эксперты, поскольку машина является «однозадачной», т.е. в отличие от традиционных суперкомпьютеров предназначенной только для работы с ИИ, ускорить строительство было не так уж сложно, хотя результат всё равно впечатляющий. Как сообщается, в составе Colossus применены серверы на платформе NVIDIA HGX H100, оборудованные системой жидкостного охлаждения. Каждый узел Supermicro серии TNHR2-LCC типоразмера 4U содержит восемь ускорителей NVIDIA H100 и два CPU. Узел разделён на две половинки, одна с CPU и PCIe-коммутаторами и одна с HGX-платой, которые могут извлекаться независимо для простоты обслуживания. CPU, коммутаторы и ускорители охлаждаются посредством СЖО. Вентиляторы в шасси тоже есть. Воздух от них попадает на теплообменники на задней двери, которые уносят остаточное тепло. Холодных и горячих коридоров в ЦОД нет, воздух имеет одинаковую температуру во всём зале. В нижней части стоек располагается ещё один 4U-блок Supermicro для CDU с резервированием и поддержкой горячей заменой насосов. Каждый сервер имеет четыре блока питания с резервированием и возможностью горячей замены, которые подключены к трёхфазным PDU. Одна стойка объединяет восемь узлов NVIDIA HGX H100, между которыми располагаются коллекторы СЖО в формате 1U. Таким образом, каждая стойка насчитывает 64 экземпляра H100. Стойки организованы в группы по восемь штук, которые образуют малые кластеры из 512 ускорителей H100. Они в свою очередь объединены в т.н. «острова» по 25 тыс. ускорителей, каждому из которых полагается собственный машинный зал. Общее количество стоек в составе Colossus превышает 1500. Помимо узлов с ускорителями также есть CPU-узлы и узлы хранения All-Flash (1U). Как отмечает NVIDIA, в кластере Colossus задействована сетевая платформа Spectrum-X Ethernet. Применены коммутаторы Spectrum-X SN5600 и сетевые карты на базе чипа BlueField-3. Компания говорит об использовании трёхуровневой Ethernet-сети с 400GbE-подключением, но точная топология не указана. Судя по всему, выделенной сети для работы с хранилищем не предусмотрено. Каждом ускорителю полагается один 400GbE-адаптер SuperNIC, который и объединяет их в RDMA-сеть. Кроме того, у каждого GPU-узла есть ещё один 400GbE DPU, а также подключение к сервисной сети. Сетевые карты находятся в собственных лотках, благодаря чему их можно заменять без демонтажа шасси. По словам NVIDIA, уровень утилизации сети достигает 95 %. В качестве энергетического буфера между электросетью и суперкомпьютером используются аккумуляторные банки Tesla Megapack ёмкостью 3,9 МВт·ч каждый. Они необходимы для того, чтобы компенсировать всплески потребляемой мощности, когда нагрузка на ускорители резко возрастает в силу выполняемых ИИ-задач. Впрочем, вероятно, есть и ещё одна причина для такого решения — на первом этапе Colossus был лишён подключения к основной энергосети и в вопросе питания во многом полагался на генераторы. |

|