Материалы по тегу: c

|

21.07.2025 [16:42], Сергей Карасёв

Запущен самый мощный в Великобритании ИИ-суперкомпьютер — комплекс Isambard-AIВ Великобритании официально введён в эксплуатацию суперкомпьютер Isambard-AI: это самый мощный в стране вычислительный комплекс, ориентированный на задачи ИИ. В июньском рейтинге TOP500 машина занимает 11-е место, а в списке наиболее энергоэффективных систем Green500 — четвёртую позицию. Суперкомпьютер назван в честь британского инженера Изамбарда Кингдома Брюнеля (Isambard Kingdom Brunel), внёсшего значимый вклад в Промышленную революцию. Проект реализован при участии компаний NVIDIA и HPE, Бристольского университета (University of Bristol) и других организаций. Создание Isambard-AI обошлось примерно в £225 млн ($302 млн). В основу комплекса положена платформа HPE Cray EX с интерконнектом Slingshot 11. Задействованы 5448 суперчипов NVIDIA GH200 Grace Hopper, которые объединяют 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H200. Применена СХД Cray ClusterStor E1000 вместимостью 25 Пбайт. Питание полностью обеспечивается от источников энергии с нулевыми выбросами углерода. Избыточное тепло может использоваться для обогрева близлежащих зданий. Развёрнута система прямого жидкостного охлаждения HPE. В тесте Linpack комплекс Isambard-AI демонстрирует FP64-быстродействие на уровне 216,5 Пфлопс, тогда как теоретический пиковый показатель составляет 278,58 Пфлопс. Производительность при решении ИИ-задач достигает 21 Эфлопс (FP8). Как отмечается, Isambard-AI более чем в 10 раз превосходит по скорости второй по быстродействию суперкомпьютер в Великобритании и предоставляет больше вычислительной мощности, чем все остальные НРС-машины страны вместе взятые. Новый комплекс будет применяться для решения наиболее сложных и ресурсоёмких задач, таких как разработка передовых лекарственных препаратов, моделирование климата, материаловедение, большие языковые модели (LLM) и др. Доступ к ресурсам Isambard-AI регулируется Министерством науки, инноваций и технологий и Департаментом исследований и инноваций Великобритании.

21.07.2025 [09:27], Сергей Карасёв

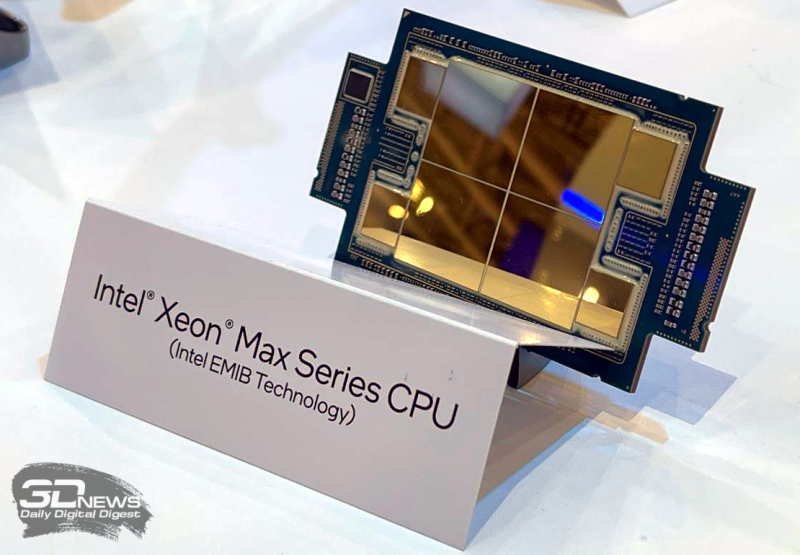

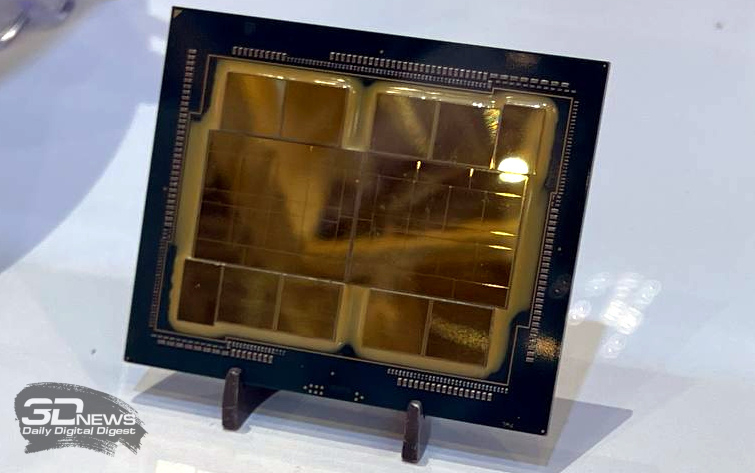

10 долгих лет: состоялся официальный запуск экзафлопсного суперкомпьютера AuroraВ Аргоннской национальной лаборатории (ANL) Министерства энергетики США (DOE) в Иллинойсе состоялась церемония торжественного разрезания ленты в честь официального запуска суперкомпьютера Aurora экзафлопсного класса. В мероприятии приняли участие руководители и исследователи Intel, HPE и DOE. Церемония была скорее формальностью, поскольку Aurora стала доступна исследователям со всего мира в начале текущего года. Aurora является одним из трёх суперкомпьютеров DOE с производительностью более 1 Эфлопс. Наряду с El Capitan в Ливерморской национальной лаборатории имени Лоуренса (LLNL) и Frontier в Национальной лаборатории Оук-Ридж (ORNL) эти НРС-комплексы занимают первые три места как в списке TOP500 самых быстрых суперкомпьютеров мира, так и в бенчмарке HPL-MxP для оценки производительности ИИ. У суперкомпьютера непростая судьба. Анонс машины состоялся в 2015 году — система с FP64-производительностью на уровне 180 Пфлопс по плану должна была заработать в 2018 году. Однако планы неоднократно корректировались, а проект в конце концов был кардинально пересмотрен. Первые тестовые кластеры системы заработали более двух лет назад, а частично запущенная система попала в TOP500 в конце 2023 года. Целиком она заработала в 2024 году. В проекте по созданию Aurora принимали участие Intel и HPE. Машина построена на платформе HPE Cray EX — Intel Exascale Compute Blade: задействованы процессоры Intel Xeon CPU Max и ускорители Intel Data Center GPU Max, объединённые интерконнектом HPE Slingshot. В общей сложности применяются 63 744 ускорителей, что делает Aurora одним из крупнейших в мире суперкомпьютеров на базе GPU. Установлена ОС SUSE Linux Enterprise Server 15 SP4. Производительность в тесте Linpack составляет 1,012 Эфлопс, а теоретический пиковый показатель достигает 1,980 Эфлопс. НРС-комплекс занимает площадь около 930 м2. Развёрнута современная инфраструктура жидкостного охлаждения. Общая протяжённость соединений превышает 480 км, а количество конечных точек сети достигает 85 тыс. Aurora останется по-своему уникальным суперкомпьютером: CPU с HBM на борту больше не планируются, от Ponte Vecchio компания отказалась в пользу Habana Gaudi и Falcon Shores. Но и последние на рынок не попадут, а будут использоваться для внутренних тестов и обкатки технологий. На смену им должны прийти Jaguar Shores, но точных дат Intel не называет.  Вычислительные мощности Aurora, как отмечается, помогают в решении сложнейших задач в самых разных областях. В биологии и медицине исследователи используют ИИ-возможности суперкомпьютера для прогнозирования эволюции вирусов, улучшения методов лечения рака и картирования нейронных связей в мозге. В аэрокосмической сфере Aurora используется для создания двигательных установок нового поколения и моделирования аэродинамических процессов. Комплекс играет важную роль в развитии технологий термоядерной энергетики, квантовых вычислений и пр.

19.07.2025 [13:39], Сергей Карасёв

Rockchip представила 10-ядерный Arm-процессор RK3668 с ИИ-модулемКомпания Rockchip, как сообщает ресурс CNX Software, процессор RK3668 на архитектуре Arm, предназначенный для создания одноплатных компьютеров и других устройств с ИИ-функциями. Изделие насчитывает 10 вычислительных ядер в конфигурации 4 × Arm Cortex-A730 и 6 × Arm Cortex-A530 (Armv9.3). Причём на сегодняшний день эти ядра официально не представлены. В состав чипа входят графический процессор Arm Magni с производительностью до 1–1,5 Тфлопс и блок VPU с возможностью декодирования материалов в формате 8K (60 к/с). Новинка располагает интегрированным нейропроцессорным модулем (NPU) с быстродействием до 16 TOPS для ускорения ИИ-операций. Процессор изображений (ISP) с ИИ-функциями поддерживает работу с видео 8K (30 к/с). Реализованы четыре канала оперативной памяти LPDDR5/5x/6 с пропускной способностью до 100 Гбайт/с. Возможно использование флеш-накопителей UFS 4.0. Поддерживаются интерфейсы HDMI 2.1 (до 8K / 60 к/с), MIPI DSI, PCIe, UCIe. Производственные нормы — 5–6 нм. Кроме того, Rockchip раскрыла дополнительную информацию о чипе RK3688, первые упоминания которого появились в октябре 2024 года. Это изделие объединяет 12 вычислительных ядер в конфигурации 8 × Arm Cortex-A730 и 4 × Arm Cortex-A530. Пропускная способность памяти LPDDR6 достигает 200 Гбайт/с. Возможно декодирование видеоматериалов 16Kp30 и кодирование 8Kp60. Производительность встроенного NPU-блока повышена до 32 TOPS. Этот процессор будет изготавливаться по технологии 4–5 нм. Одной из первых компаний, которая возьмёт на вооружение новые чипы, станет Radxa: она, в частности, готовит одноплатный компьютер Rock 6 на основе RK3668.

18.07.2025 [17:11], Руслан Авдеев

США намерены ослабить влияние Китая на подводную интернет-инфраструктуру, но у них это вряд ли получитсяВ погоне за технологическим лидерством США, похоже, решили пойти на новые меры. В частности, присутствие китайских технологий в кабелях, от которых зависит инфраструктура США, решено минимизировать — но пока неизвестно, хватит ли у Соединённых Штатов на это ресурсов, сообщает The Register. Глава Федеральной комиссии по связи США (FCC) Брендан Карр (Brendan Carr) объявил, что его ведомство обсуждает правило, которое не только защитит подводные кабели от противников США, но и будет способствовать инвестициям в подводную инфраструктуру. Как и в случае со многими другими технологическими проектами 2025 года, меры принимаются для того, чтобы «ускорить развитие ИИ-инфраструктуры». По словам Карра, поскольку США строят ИИ ЦОД и прочую инфраструктуру, необходимую для лидерства в ИИ и других сферах, подводные телеком-кабели стали «важны как никогда». Чиновник отметил, что на подводные кабели приходится 99 % международного интернет-трафика и они, по его мнению, регулярно подвергаются угрозам. Новые правила предусматривают автоматический запрет компаниям, контролируемым «враждебными государствами», на строительство, эксплуатацию или аренду подводных кабелей. Также запрещается использование «регулируемого» (covered) оборудования в подводной инфраструктуре. Поскольку текст самого правила не опубликован, пока можно только догадываться, о каком именно оборудовании идёт речь. В FCC отказались предъявлять документ или отвечать на дополнительные вопросы журналистов.

Источник изображения: Zulfugar Karimov/unspalsh.com Не исключено, что речь идёт о чём-то, похожем на приказ о постепенной замене в американских телеком-сетях оборудования китайских компаний Huawei и ZTE, подписанный в 2021 году. По данным на июль 2024 года, FCC заявляла, что до полного успеха в этом направлении ещё очень далеко и большинству телеком-компаний не хватает миллиардов долларов на финансирование исполнения. Судя по тому, что этот приказ в полной мере не выполнен в США до сих пор, реализация нового запрета тоже вряд ли будет простой. Проблема безопасности подводных кабелей активно обсуждается в последние годы, а сообщения об атаках на них появляются всё чаще. Причём желающих совершить диверсию, предположительно, немало — от крупных стран до небольших группировок. При этом ежегодно десятки инцидентов с кабелями происходят по естественным причинам. Однако утверждается, что Китай не ограничивается диверсиями в своих прибрежных водах и вредит даже на Балтике, хотя такие атаки не подтверждаются. Европейские страны активно принимают меры для совместной защиты акватории региона. Так, собственные силы для охраны уже выделила Швеция, подводный беспилотник намерена применять Германия, а Китай якобы разрабатывает специальное оружие для уничтожения подводной кабельной инфраструктуры. Правда, слухи порой оборачиваются фарсом.

16.07.2025 [11:44], Сергей Карасёв

Broadcom представила 51,2-Тбит/с чип-коммутатор Tomahawk Ultra — альтернативу NVIDIA InfiniBand и NVLinkКомпания Broadcom анонсировала чип-коммутатор Tomahawk Ultra, специально разработанный для кластеров НРС и платформ ИИ. Новинка, как ожидается, составит конкуренцию InfiniBand в традиционных суперкомпьютерах, NVLink в стоечных решениях вроде NVIDIA GB200 NVL72, а также Ultra Accelerator Link (UALink) в масштабируемых системах ИИ в дата-центрах. Решение Tomahawk Ultra разработано в рамках инициативы Broadcom Scaling Up Ethernet (SUE). Утверждается, что эта технология будет поддерживать масштабируемые системы с не менее чем 1024 ускорителями ИИ. Для сравнения, NVIDIA заявляет, что её коммутационная система NVLink 5/6 позволяет объединить до 576 ускорителей в одном домене. Broadcom подчёркивает, что чип Tomahawk Ultra разработан с нуля специально для удовлетворения потребностей высоконагруженных НРС-сред и ИИ-кластеров. Новинка обеспечивает коммутационную способность 51,2 Тбит/с при размере пакетов 64 байта. Задержка составляет 250 нс, что значительно меньше, чем у коммутаторов с более высокой пропускной способностью. А общая задержка при общении XPU между собой составляет не более 400 нс. Поддерживается обработка до 77 млрд пакетов в секунду.

Источник изображений: Broadcom Основная часть трафика, передаваемого через коммутаторы Ethernet, состоит из пакетов большего размера. Поэтому при проектировании сетевого оборудования внимание уделяется прежде всего увеличению размера пакетов для оптимизации пропускной способности. Вместе с тем обмен пакетами небольшого размера широко распространен в платформах НРС/ИИ: представленная новинка Broadcom нацелена именно на такие среды.

Чип-коммутатор Tomahawk Ultra (семейство BCM78920) поддерживают 64 порта 800GbE, 128 портов 400GbE или 256 портов 200GbE. Изделие использует блоки Peregrine 106.25G PAM4 SerDes. Решение совместимо по выводам с Broadcom Tomahawk 5 (TH5). Поддерживаются функции, предназначенные для масштабируемых нагрузок ИИ и HPC, включая Link Layer Retry (LLR), Credit-based Flow Control (CBFC) и AI Fabric Headers (AFH). Кроме того, непосредственно в ASIC реализована поддержка коллективных операций вроде AllReduce and AllGather. Используются измененные заголовки Ethernet, размер которых уменьшен с 46 до 10 байт: это позволяет оптимизировать общее соотношение размера заголовка к полезной нагрузке. Упомянута совместимость с современными топологиями сетей HPC, такими как Mesh, Torus и Dragonfly. Кроме того, заявлена совместимость с Ultra Ethernet (UEC). Поставки Tomahawk Ultra уже начались.

15.07.2025 [21:45], Руслан Авдеев

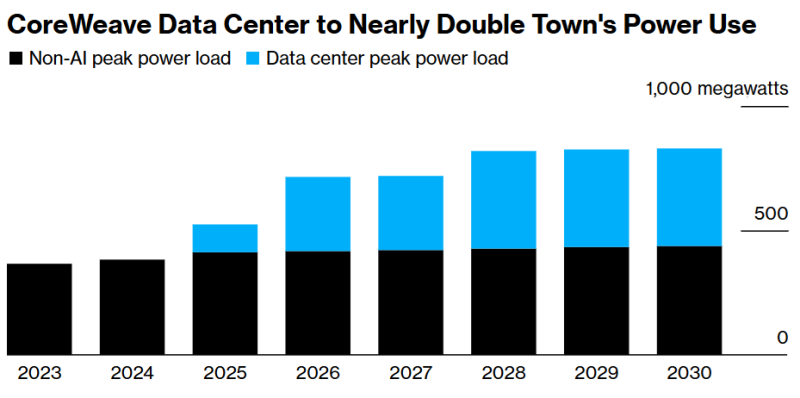

Всё ради OpenAI: дата-центр CoreWeave удвоит энергопотребление техасского городкаКомпания CoreWeave расширит дата-центр в техасском городе Дентон (Denton) в интересах OpenAI. В результате, как прогнозируют эксперты, это удвоит энергопотребление расположенного близ Далласа города — наглядное свидетельство того, как ИИ ЦОД влияют на современную энергосистему, сообщает Bloomberg. Согласно презентации конца 2024 года и электронной корреспонденции, с которой удалось ознакомиться Bloomberg, из-за дата-центра местным властям придётся решать проблему выросшей нагрузки на электросеть. ЦОД строится Core Scientific и будет использоваться OpenAI. При этом буквально на днях CoreWeave объявила о приобретении Core Scientific примерно за $9 млрд ради получения прямого контроля над её кампусами. Население Дентона, расположенного приблизительно в 80 км от Далласа, за последние четверть века почти удвоилось, увеличившись до 166 тыс. человек. Чтобы удовлетворить выросший спрос на электричество, связанный с ИИ-проектами, город перекладывает дополнительные расходы на оператора ЦОД и строит дополнительную сетевую инфраструктуру. По словам представителя коммунальной компании Denton Municipal Electric, для полного обеспечения ЦОД Core Scientific, придётся вложить дополнительные средства в ЛЭП.

Источник изображения: Nils Huenerfuerst/unsplash.com Как и некоторые другие крупные проекты ИИ ЦОД, площадка в Дентоне изначально была ориентирована на майнинг, но в декабре 2024 года было решено сменить её профиль и переключиться на обслуживание ИИ-инфраструктуры. При этом электричества понадобится больше — дата-центр не будет сокращать работу в периоды, когда цены на электроэнергию особенно высоки, что увеличит нагрузку на электросеть. Дата-центр Core Scientific в Дентоне станет крупнейшим объектом компании с потреблением около 390 МВт, на него уйдёт большая часть резервных мощностей города. По данным местных коммунальных служб, это создаст значительную нагрузку на энергосистему, и подключение новых крупных потребителей может привести к перегрузкам. Проблему отчасти планируют смягчить установкой резервных генераторов и аккумуляторов. Дата-центры — крупнейший драйвер энергопотребления в Техасе, новый закон обязывает их использовать резервные генераторы или сокращать нагрузку в чрезвычайных ситуациях.

Источник изображения: Bloomberg ЦОД в Дентоне не получил значимых налоговых льгот. Местные власти ожидают, что объект принесёт более $600 млн в виде налогов. Кроме того, ожидается создание 135 рабочих мест. При этом местный проект гораздо скромнее дата-центра Crusoe в Абилине (Abilene), мощность которого составит 1,2 ГВт. Он создаётся в рамках проекта Stargate при участии Oracle и в интересах OpenAI. Но и он теряется на фоне дата-центра AWS в Индиане, который будет потреблять энергии как половина населения штата. По данным февральского отчёта техасских властей, уже в 2026 году плановые резервы энергосистемы штата могут опуститься буквально до отрицательных значений — энергии будет не хватать из-за дата-центров, нефтегазовых объектов и майнинга криптовалюты. По данным НКО Texas Reliability Entity, оценивающей надёжность систем электроснабжения, огромный новый спрос представляет большую проблему, которая потребует превентивного реагирования, чтобы обычные жители штата не остались без доступа к электричеству. В конце 2024 года Министерство энергетики США сообщало, что в 2028 году на дата-центры США может прийтись уже 12 % энергопотребления всей страны. В июне 2025 года регулятор North American Electric Reliability Corp. (NERC) объявил, что подключение к сетям ЦОД в настоящее время весьма рискованно, поскольку дата-центры несут угрозу электросетям США из-за своей непредсказуемости.

14.07.2025 [13:16], Сергей Карасёв

Biostar представила индустриальный компьютер EdgeComp MS-1335U с поддержкой четырёх дисплеевКомпания Biostar анонсировала компьютер небольшого форм-фактора EdgeComp MS-1335U, предназначенный для использования в промышленной сфере. Устройство может применяться для построения различных терминалов, IoT-систем, платформ периферийных вычислений и т. п. В основу компьютера положен процессор Intel поколения Raptor Lake — чип Core i5-1335U (2P+8E; 3,4–4,6 ГГц; 15 Вт). Доступны два слота для модулей оперативной памяти SO-DIMM DDR5-5200 суммарным объёмом до 96 Гбайт. Для подключения накопителей предусмотрены порт SATA-3 и коннектор M.2 Key-M 2242/2260/2280 (PCIe 4.0 x4). Кроме того, есть разъём M.2 Key-B 3042/3052 (PCIe 3.0 x1 + USB 3.2; слот для SIM-карты) для сотового модема 4G/5G и разъём M.2 Key-E 2230 (PCIe 3.0 x1 + USB 2.0) для адаптера Wi-Fi / Bluetooth.

Источник изображений: Biostar Возможен вывод изображения одновременно на четыре монитора через интерфейсы HDMI 2.0, DisplayPort (DP++ 1.4) и два порта USB Type-C / DP: во всех случаях поддерживается разрешение 4096 × 2160 пикселей при 60 к/с. Устройство располагает сетевыми контроллерами Intel I226V и Intel I226LM стандарта 2.5GbE и звуковым кодеком Realtek ALC897.  Модель EdgeComp MS-1335U получила по два порта USB 3.2 Gen2 Type-A и USB 2.0, два гнезда RJ45 и четыре последовательных порта (3 × RS232/422/485 и 1 × RS232). Питание (9–24 В) подаётся через DC-разъём. Габариты составляют 182 × 150 × 48 мм. Диапазон рабочих температур — от 0 до +60 °C. Ребристая верхняя панель корпуса выполняет функции радиатора. Заявлена совместимость с Windows 10/11, Windows 10 IoT Enterprise и Ubuntu 20.04.

10.07.2025 [17:30], Сергей Карасёв

Bloomberg: Китай строит в пустыне гигантский комплекс ИИ ЦОД для 115 тыс. ускорителей NVIDIA, поставки которых запрещены СШАНа окраине пустыни Гоби в Синьцзяне (автономный район на северо-западе Китая), по сообщению Bloomberg News, ведутся активные работы по строительству кампуса ЦОД для ИИ-задач. Согласно имеющейся информации, в этих дата-центрах будут применяться серверы с ускорителями NVIDIA, поставки которых запрещены в КНР в соответствии с американскими санкциями. Специалисты Bloomberg News проанализировали сведения, содержащиеся в инвестиционных одобрениях, тендерных документах и заявках китайских компаний. Утверждается, что масштабные планы Китая в отношении развития ИИ прямо предусматривают использование «запрещённых» продуктов NVIDIA, а не только местных решений вроде Huawei Ascend. В частности, в IV квартале 2024 года власти Синьцзяна (Xinjiang) и соседней провинции Цинхай (Qinghai) одобрили создание в общей сложности 39 дата-центров, в которых будет задействовано более 115 тыс. ИИ-ускорителей NVIDIA. Причём во всех случаях речь идёт об H100 и H200. Операторы ЦОД в Синьцзяне намерены разместить львиную долю этих ускорителей в одном крупном комплексе, который будет использоваться для обучения передовых ИИ-моделей и других ресурсоёмких нагрузок. Строительные работы организованы в уезде Иу (Yìwū). Сотрудникам Bloomberg News не удалось установить, каким способом китайские компании намерены приобретать изделия NVIDIA, закупки которых запрещены без получения специальных лицензий от правительства США. Местные операторы дата-центров, государственные чиновники и представители центрального правительства в Пекине отказались давать какие-либо комментарии по данному вопросу. Между тем, как отмечается в публикации, стоимость 115 тыс. указанных ИИ-ускорителей может составить миллиарды долларов, исходя из цен на чёрном рынке Китая. И всё же строительство комплекса ЦОД продолжается. Синьцзян, и особенно регион Хами (Hāmì), включающий уезд Иу, богаты ветровой и солнечной энергией, а также углём. Это позволит решить вопросы, связанные с энергообеспечением дата-центров. Дополнительными достоинствами выбранного региона являются доступность больших территорий, низкая стоимость земли и прохладный климат в высотных районах. Согласно тендерной документации, полученной Bloomberg, по состоянию на июнь 2025 года по семи проектам ЦОД в Синьцзяне либо начаты строительные работы, либо выиграны тендеры на услуги ИИ-вычислений. В частности, один из крупнейших проектов связан с энергокомпанией Nyocor из Тяньцзиня (Tianjin), которая специализируется на солнечной и ветровой энергетике. Инициатива предусматривает создание дата-центра на базе 625 серверов с ускорителями H100. Nyocor продаёт вычислительные мощности корпорации Infinigence AI — одной из крупнейших организаций в сфере ИИ-инфраструктуры в Китае. В документах по 27 другим проектам ЦОД, одобренным в Синьцзяне и Цинхае в прошлом году, упоминаются в общей сложности более 9 тыс. серверов и около 72 тыс. ускорителей H100/H200. Два высокопоставленных чиновника американской администрации заявили, что по их оценкам, в Китае имеется примерно 25 тыс. запрещенных ИИ-ускорителей NVIDIA: такое количество, как утверждается, не вызывает серьёзного беспокойства. Более того, даже в случае приобретения ещё 115 тыс. карт NVIDIA масштабы соответствующих ИИ-платформ в КНР окажутся несопоставимы с мощью развитой инфраструктурой ИИ в США. Нужно отметить, что за последние годы власти Китая потратили $6,1 млрд на строительство крупных кампусов ЦОД, тогда как ещё $28 млрд вложили частные инвесторы. Площадки дата-центров появились в регионе Внутренняя Монголия, провинциях Нинся, Ганьсу, Гуйчжоу, регионе Пекин-Тяньцзинь-Хэбэй, а также в дельте Янцзы и на других территориях. Однако многие подобные объекты оказались невостребованными из-за переоценённого спроса и архитектурных недоработок.

10.07.2025 [15:49], Владимир Мироненко

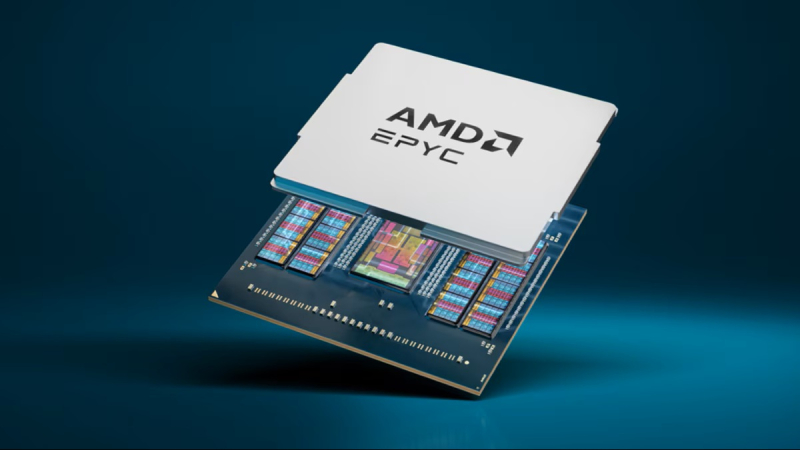

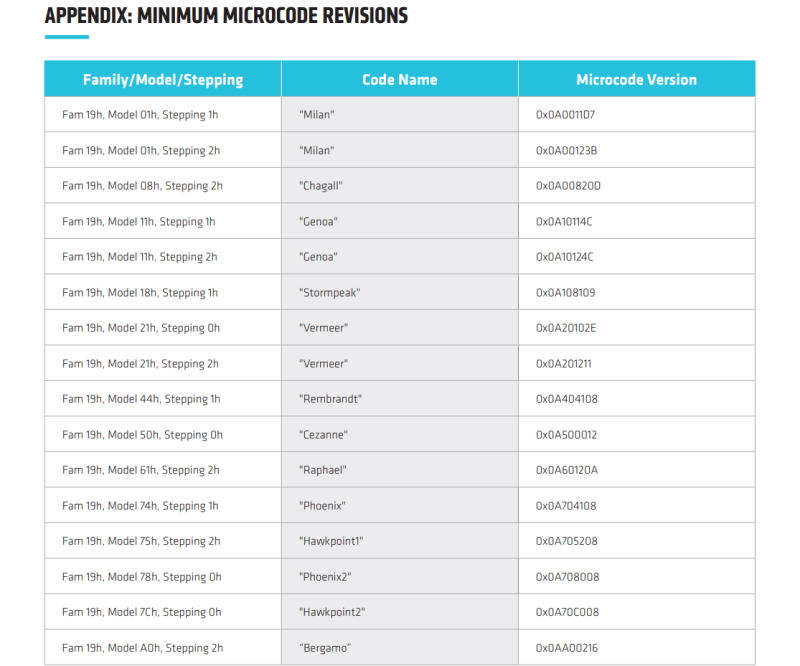

В процессорах AMD найдены уязвимости TSA, похожие на Meltdown и SpectreAMD сообщила об обнаружении нового класса микроархитектурных атак на свои процессоры — TSA (Transient Scheduler Attack). TSA подобны Meltdown и Spectre и затрагивают широкий спектр CPU AMD и способны привести к раскрытию информации. TSA включает сразу четыре уязвимости, которые были обнаружены исследователями Microsoft и Швейцарской высшей технической школы Цюриха (ETH Zurich). Две из них имеют средний уровень (medium severity) опасности, две — низкий уровень (Low severity). Несмотря на это Trend Micro и CrowdStrike оценили угрозу как «критическую», пишет ресурс The Register. Низкие оценки серьёзности объясняются высокой сложностью выполнения успешной атаки. AMD заявила, что её может осуществить только злоумышленник, способный запустить произвольный код на целевой машине, получив доступ через вредоносное ПО или вредоносную виртуальную машину, но для успешного выполнения атак требуются лишь низкие привилегии. Как утверждает AMD, TSA невозможно эксплуатировать через вредоносные веб-сайты, а для надёжного извлечения данных потребуется многократный запуск. Это связано с тем, что атака основана на использовании состояния «ложного завершения» (false completion), которое возникает, когда процессор ожидает быстрого завершения исполнения инструкций загрузки, но какое-либо условие препятствует их успешному завершению. В результате происходит повторная загрузка данных и выполнение зависимых операций, но из-за особенностей чипов «анализ времени выполнения может использоваться как источник утечки информации из микроархитектурных структур, оставшейся после спекулятивного выполнения других операций», — сообщил ресурс OpenNet. При использовании двух уязвимостей средней степени серьёзности успешные атаки на чипы AMD могут привести к утечке информации из ядра ОС. В других сценариях утечка данных может произойти также из приложений или виртуальных машин. Доступ к данным ядра потенциально может позволить злоумышленникам повысить привилегии, обойти механизмы безопасности, обеспечить персистентность и т.д. Баги низкого уровня могут привести к утечке внутренних данных о работе процессора, которые AMD не считает конфиденциальными.

Источник: AMD AMD заявила о двух различных вариантах TSA, которые могут быть реализованы на её чипах в зависимости от источника извлечения данных — TSA-SQ и TSA-L1.

Согласно технической документации AMD, уязвимости TSA-L1 вызваны ошибкой в использовании микротегов кешем L1 для поиска. Процессор может полагать, что данные находятся в кеше, хотя на самом деле это не так, что приводит к загрузке неверных данных, которые злоумышленник может затем вывести. Уязвимости TSA-SQ возникают, когда инструкция загрузки ошибочно извлекает данные из Store Queue, когда необходимые данные недоступны. В этом случае злоумышленник может обнаружить неверные данные и использовать их для извлечения информации, например, из ядра ОС, из ранее загруженных данных, даже если они выполнялись в другом контексте. Уязвимости проявляются в семействе процессоров AMD на базе микроархитектур Zen 3 и Zen 4, в том числе, в сериях Ryzen 5000/6000/7000/8000, EPYC Milan/Milan-X/Genoa/Genoa-X/Bergamo/Siena, Instinct MI300A, AMD Ryzen Threadripper PRO 7000 WX, EPYC Embedded 7003/8004/9004/97X4, Ryzen Embedded 5000/7000/V3000. В целом обновление микрокода и PI-прошивок (Platform Initialization) необходимо для чипов серий EPYC, Ryzen, Instinct.

09.07.2025 [11:55], Сергей Карасёв

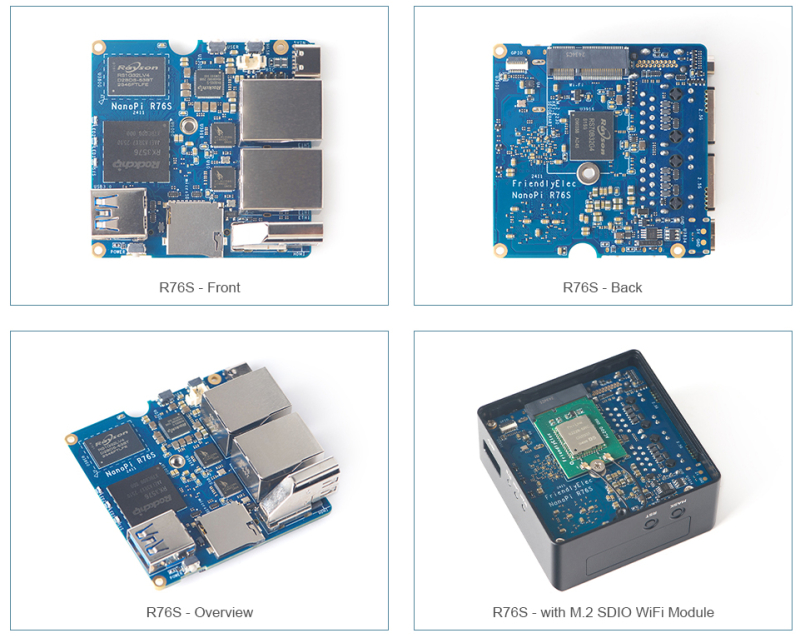

Вышел крошечный одноплатный компьютер NanoPi R76S с двумя портами 2.5GbE и 16 Гбайт ОЗУКоманда FriendlyElec пополнила ассортимент одноплатных компьютеров моделью NanoPi R76S, которая может использоваться для создания различных сетевых устройств, в частности, шлюзов, маршрутизаторов и пр. Новинка уже доступна для заказа по ориентировочной цене от $50 до $100 в зависимости от модификации. В основу изделия положен процессор Rockchip RK3576: он объединяет по четыре ядра Cortex-A72 и Cortex-A53 с частотой 2,2 ГГц и 2,0 ГГц соответственно, а также графический ускоритель Arm Mali-G52 MC3 с поддержкой OpenGL ES 1.1, 2.0 и 3.2, OpenCL 2.0, Vulkan 1.2. Имеется нейропроцессорный блок (NPU) с ИИ-производительностью до 6 TOPS в режиме INT8. Встроенный VPU-модуль обеспечивает возможность декодирования материалов H.265, VP9, AV1 и AVS2 в форматах 8K (30 к/с) и 4K (120 к/с), а также кодирования H.264, H.265 и MJPEG в формате до 4K (60 к/с).

Источник изображений: FriendlyElec Одноплатный компьютер может нести на борту 2/4 Гбайт оперативной памяти LPDDR4X или 16 Гбайт памяти LPDDR5. Есть флеш-накопитель eMMC вместимостью 32 Гбайт и слот для карты MicroSD с поддержкой стандарта UHS-1. Упомянуты 8-контактный коннектор GPIO FPC и 3-контактный коннектор UART. Новинка располагает двумя сетевыми портами 2.5GbE (RJ45) на основе контроллеров RTL8125BG PCIe, интерфейсом HDMI 2.0 с поддержкой 4Kp60, портами USB 3.2 Gen1 Type-A и USB Type-C (данные и питание). К разъёму M.2 E-Key может быть подключён опциональный модуль Wi-Fi/Bluetooth. Размеры платы составляют 58 × 58 мм: она может быть размещена внутри фирменного металлического корпуса с ребристой верхней поверхностью и габаритами 62,5 × 62,5 × 29,2 мм. Диапазон рабочих температур простирается от 0 до +70 °C. Для NanoPi R76S заявлена совместимость с Alpine Linux, Android 14 Tablet/TV, Buildroot, Debian 12 Core, Debian 11 Desktop, FriendlyWrt 21.02/23.05/24.10, OpenMediaVault, Proxmox VE, Ubuntu 20.04 Desktop, Ubuntu 24.04 Desktop/Core. |

|