Материалы по тегу: nvidia

|

02.10.2025 [21:02], Владимир Мироненко

Microsoft потратит $33 млрд на доступ к 100+ тыс. NVIDIA GB300 в неооблаках, но со временем хочет перейти на свои ИИ-ускорителиВ Сети появились новые подробности о сделке стоимостью до $19,4 млрд, заключённой Microsoft с Nebius Group NV в начале сентября. Как сообщает Bloomberg со ссылкой на информированные источники, Microsoft получит пятилетний доступ к выделенной инфраструктуре на базе более чем 100 тыс. суперускорителей NVIDIA GB300. Ранее сообщалось, что речь идёт о мощностях нового ЦОД Nebius в Вайнленде (Нью-Джерси, США). Как пишет Forbes, Nebius отличается от многих облачных провайдеров тем, что фокусируется только на рабочих нагрузках ИИ и МО, что позволяет лучше оптимизировать архитектуру ЦОД в отличие от гиперскейлеров, которые занимаются решением множества задач. Кроме того, Nebius отличается от других неооблаков, таких как CoreWeave, тем, что предоставляет инструменты и сервисы для разработчиков, которые позволяют совершенствовать ИИ-модели, выполнять инференс и разрабатывать кастомные решения, а не просто фокусируется на «чистой» вычислительной мощности. При этом Nebius начала наращивать вычислительные мощности ещё до того, как возник спрос на эти ресурсы, отметил Forbes. Подобные контракты Microsoft заключила с ещё несколькими неооблаками (neocloud), включая CoreWeave, Nscale и Lambda, на общую сумму в $33 млрд, и они обеспечивают её большую выгоду. Вместо того, чтобы тратить огромные ресурсы на строительство собственных ЦОД, Microsoft обращается к проверенному поставщику ИИ-инфраструктуры, благодаря чему может быстрее совершенствовать свою ИИ-инфраструктуру с меньшими первоначальными затратами, используя высвободившиеся мощности для предоставления клиентам прибыльных услуг на базе ИИ. Вдобавок такой подход позволяет Microsoft быстрее менять стратегию, чем при использовании собственных дата-центров. В начале бума ИИ Microsoft арендовала мощности даже у Oracle, своего прямого конкурента, для поддержки ИИ-функций в поиске Bing. Эти сделки также устраняют для Microsoft значительную часть финансовых рисков, связанных со строительством собственных ЦОД. Она не только сразу получает необходимые мощности для своих ИИ-сервисов, вместо того чтобы тратить годы на строительство ЦОД, но и перекладывает на других вопросы строительства, финансирования и управление этими ЦОД, что даёт компании большую финансовую гибкость. Так, Microsoft может отнести некоторые затраты к операционным, а не капитальным, что, по словам аналитика Bernstein Марка Мёрдлера (Mark Moerdler), даёт потенциальные преимущества для денежного потока, налогообложения и способа представления прибыли в финотчётах. Компания использует серверы неооблаков не только для обучения ИИ-моделей, но и для сложного инференса. Сделки с неооблаками становятся популярными и у конкурентов Microsoft, хотя им далеко до её масштабов. В мае 2025 года OpenAI расширила с конкурирующей с Nebius компанией CoreWeave контракт стоимостью $11,9 млрд на $4 млрд, после чего заключила ещё одно соглашение на $6,5 млрд, увеличив общую сумму соглашений до $22,4 млрд. Ещё один технологический гигант Meta✴ подписал сделку с CoreWeave на сумму в $14,2 млрд, обеспечив себе доступ к её облачным ИИ-сервисов на период до 2031 года. Вместе с тем в долгосрочной перспективе Microsoft намерена переключиться на ИИ-ускорители собственной разработки, которые обеспечивают лучший показатель TCO, передаёт CNBC. Два года назад компания представила первые ИИ-чипы Maia 100. Следующее поколение этих чипов, как ожидается, появится в 2026 году. При этом компания сосредоточится не на чипах в отдельности, а будет использовать более системный подход, учитывающий вопросы охлаждения, интерконнекта и т.д. Пока что, признаёт Microsoft, в течение многих лет решения NVIDIA обеспечивали лучшее соотношение цены к производительности.

29.09.2025 [11:10], Руслан Авдеев

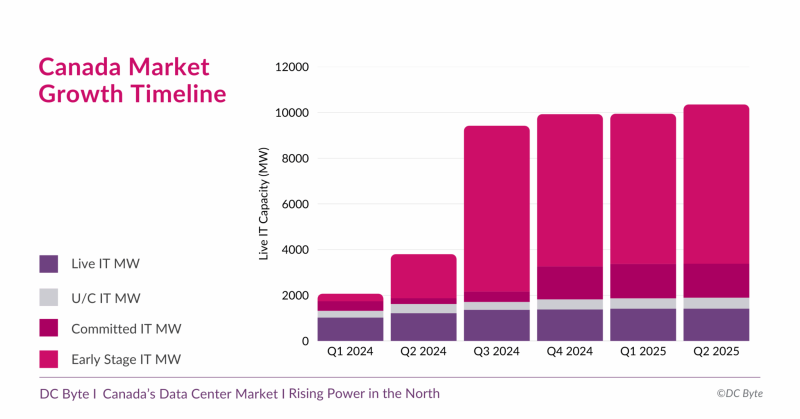

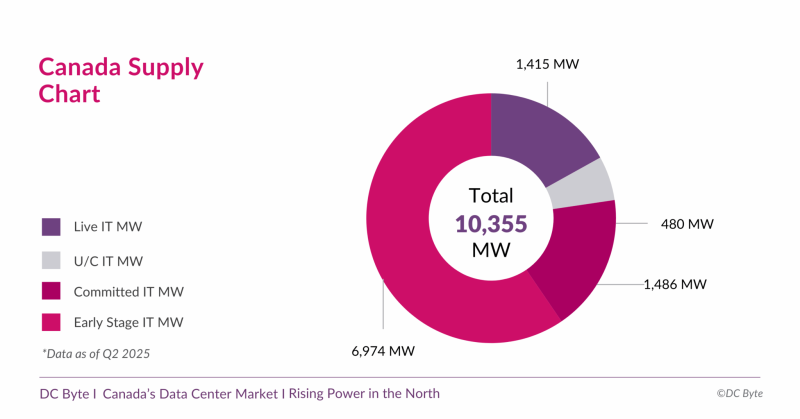

Канадский рынок дата-центров вырастет почти на порядок — до 10,3 ГВтКанада готовится к новой фазе развития рынка дата-центров. В отчёте аналитического агентства DC Byte говорится, что общая ёмкость рынка ЦОД в обозримом будущем вырастет до 10,3 ГВт с нынешних введённых в эксплуатацию 1,4 ГВт. Проекты общей мощностью 8,9 ГВт находятся на разных этапах реализации, их них 6,9 ГВт — на ранних этапах без фактического начала строительства. Во многом будущий рост объясняется серией анонсов, состоявшихся во II полугодии 2024 года. В том числе речь идёт о проекте инвестора, бизнесмена и шоумена Кевином О’Лири (Kevin O’Leary) Wonder Valley в провинции Альберта. В своё время было заявлено, что речь идёт о строительстве 55 объектов мощностью 100 МВт каждый с питанием от природного газа. Это крупнейший проект, на который приходится 5,6 ГВт от общего плана (по другим данным — 7,5 ГВт). В DC Byte отмечают, что речь идёт о новом этапе роста, связанном с бумом ИИ и ориентированных на ускорители дата-центров. Тем не менее, они должны заработать не раньше 2027 года, а пока же рынок всё ещё ориентирован на «традиционные» дата-центры, где лидируют Vantage, Cologix и Compass. 93 % IT-нагрузок ЦОД страны приходится на Торонто, Монреаль и провинцию Альберту (столица Эдмонтон). При этом в Канаде 60 % местной генерации приходится на ГЭС, т.е. «зелёную» энергетику, что при соблюдении некоторых условий, не может не привлекать глобальных игроков. Впрочем, природного газа здесь тоже хватает, и на него тоже делают ставку. Пока же местные проекты отличает скромность. Так, совокупная мощность сети ИИ ЦОД Bell AI Fabric, планируемой Bell Canada и Telus, составит 500 МВт. Впрочем, на конференции All In Canada AI Ecosystem в Монреале Канада представила стратегию развития суверенного ИИ, подчеркнув важность цифрового суверенитета и экономической независимости, и анонсировала открытие первой ИИ-фабрики Telus, построенной при поддержке NVIDIA и HPE. Фабрика обеспечивает полный цикл работы с ИИ — от обучения моделей до инференса, с хранением данных внутри страны и питанием от возобновляемой энергии на 99 %. Тогда AMD и канадская Cohere объявили о расширении сотрудничества в сфере ИИ. В частности, ключевые «безопасные» решения последней, включая Command A, Vision, Translate и North, будут доступны на ИИ-инфраструктуре на базе ускорителей Instinct. Благодаря этому корпоративные и государственные клиенты, включая канадские проекты «суверенного ИИ», получат больше возможностей выбора ИИ-инструментов. AMD станет использовать платформу Cohere North для решения собственных инженерных и бизнес-задач.

28.09.2025 [12:30], Сергей Карасёв

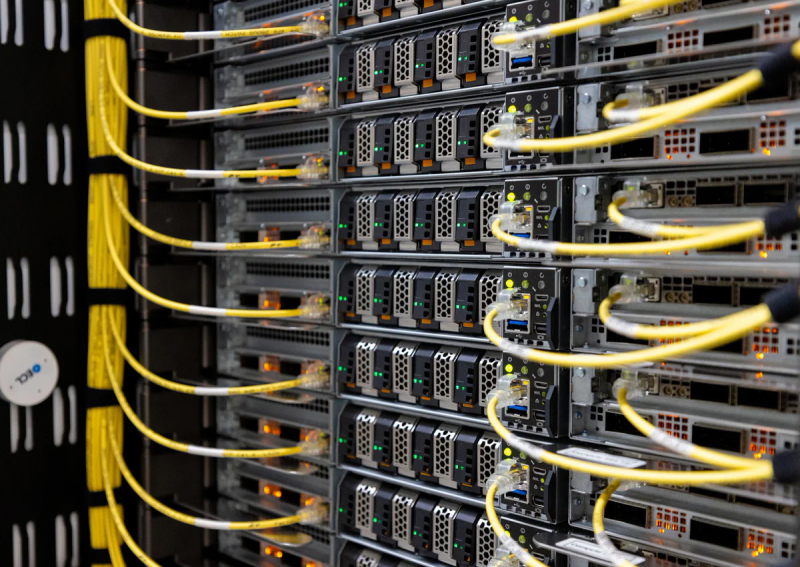

«Зелёная» энергия для «зелёных» ускорителей: Lambda и ECL впервые запитали NVIDIA GB300 NVL72 от водородаОблачный провайдер Lambda и стартап ECL объявили о развёртывании первых в отрасли систем NVIDIA GB300 NVL72 с питанием от водорода. Высокопроизводительная платформа предназначена для обучения базовых ИИ-моделей, инференса и других ресурсоёмких задач. ECL специализируется на создании автономных модульных дата-центров с питанием от водорода, при возведении которых применяются технологии 3D-печати. Первым ЦОД компании стал объект MV1 мощностью 1 МВт на площадке в Маунтин-Вью (Калифорния, США). Кроме того, ECL заявила о намерении построить ИИ ЦОД TerraSite-TX1 мощностью 1 ГВт к востоку от Хьюстона (Техас, США). Как сообщается, системы NVIDIA GB300 NVL72 компании Lambda смонтированы на базе модульного дата-центра MV1. Эта площадка отличается нулевым потреблением воды и нулевым уровнем выбросов вредных газов в атмосферу. Питание обеспечивается исключительно от водородных топливных элементов. Развёрнутые устройства GB300 NVL72 разработаны компанией Supermicro. Они обладают мощностью 142 кВт. Для отвода тепла применяется система прямого жидкостного охлаждения, вода для которой поступает от водородных топливных элементов, на которых вырабатывается в качество побочного продукта при генерации электричества. Задействованы централизованные блоки распределения охлаждающей жидкости (CDU). Утверждается, что это первое в отрасли подобное сочетание инфраструктуры на базе ускорителей NVIDIA с водородным источником «зеленой» энергии. Отмечается, что развёртывание систем NVIDIA GB300 NVL72, масса которых составляет примерно 1800 кг, сопряжено с серьёзными трудностями. Лишь немногие дата-центры способны справиться с требованиями к плотности мощности и охлаждению. Водородные топливные элементы рассматриваются в качестве одного из наиболее перспективных способов решение проблемы питания таких объектов. При этом становится возможным устойчивое развитие облачных ИИ-платформ.

27.09.2025 [15:32], Сергей Карасёв

Майнинговая компания Iren увеличила мощность ИИ-облака, закупив тысячи ускорителей NVIDIA и AMD за $674 млнКриптомайнинговая компания Iren (ранее известная как Iris Energy), по сообщению Datacenter Dynamics, увеличила количество ИИ-ускорителей в своём облаке примерно в два раза. Стоимость приобретённого оборудования оценивается в $674 млн. Компании прочат статус серьёзного игрока на рынке неооблаков. Компания находится в процессе перехода от майнинга криптовалют к облачному бизнесу на базе ИИ. В частности, закуплены 7100 ускорителей NVIDIA B300 и 4200 изделий NVIDIA B200, а также 1100 AMD Instinct MI350X. В результате, общее количество ускорителей в составе платформы Iren достигло приблизительно 23 тыс. Новое оборудование в ближайшие месяцы будет развёрнуто в кампусе Iren в городе Принс-Джордже (Prince George) в северной части провинции Британская Колумбия в Канаде. В настоящее время на этой площадке ведётся строительство вычислительного комплекса с жидкостным охлаждением мощностью 10 МВт (ИТ-нагрузка), который сможет поддерживать более 4500 суперускорителей NVIDIA GB300. В конце августа нынешнего года Iren сообщила о приобретении 1200 ускорителей NVIDIA B300 для серверов с воздушным охлаждением и 1200 изделий NVIDIA GB300 для систем с жидкостным охлаждением: стоимость данной партии составила примерно $168 млн. Эти чипы также предназначены для ЦОД в Принс-Джордже. Тогда говорилось, что Iren привлекла финансирование в размере около $96 млн для покупки GB300: средства получены по схеме лизинга сроком на два года. В настоящее время Iren управляет пятью кампусами ЦОД общей мощностью 810 МВт, расположенными в Северной Америке: два в Техасе (США) и три в Британской Колумбии (Канада). Ещё 2,1 ГВт находятся в стадии строительства, причём 2 ГВт из них приходится на новый кампус в Техасе. Как отмечает Дэниел Робертс (Daniel Roberts), соучредитель и содиректор Iren, удвоение парка GPU позволит удовлетворить растущие потребности клиентов в масштабируемых вычислительных мощностях.

26.09.2025 [10:33], Руслан Авдеев

Media Stream AI построит в Манчестере 2-МВт ИИ ЦОД с охлаждением водой из местного каналаБританская медиакомпания Media Stream AI (MSAI) намерена открыть в Солфорде (Salford, Большой Манчестер) дата-центр в популярном «творческом» районе Media City. Объект мощностью 2 МВт будет использовать для охлаждения воду из канала Рочдейл (Rochdale), сообщает Datacenter Dynamics. Система охлаждения будет состоять из замкнутого контура с теплообменниками и драйкулеров. При поддержке Lenovo объект стоимостью £50 млн ($67,3 млн) сможет обеспечить плотность стоек на уровне 30–60 кВт при PUE менее 1,2. На площадке планируется разместить 1,1 тыс. ускорителей NVIDIA H200 в составе серверов Lenovo ThinkSystem с СЖО Neptune. В будущем возможно расширение до 2,3 тыс. ускорителей. Объект должен заработать в I квартале 2026 года. Компания намерена создать там же собственную виртуальную продакшн-студию и робототехническую лабораторию. Media Stream AI рассчитывает предоставлять ИИ-сервисы медиакомпаниям и работникам творческих профессий. На сайте стартапа объявлено, что он намерен предоставить доступ к ускорителям NVIDIA L4, A10G, A4000, A5000, A100, H100 и L40. Также компания намерена развернуть к концу 2026 года площадки в Германии и Франции. Более того, MSAI заключила соглашение с властями Ямайки о строительстве и эксплуатации первого на острове ИИ ЦОД. Прецеденты использования похожих систем охлаждения есть. Например, Digital Realty использует для охлаждения ЦОД во Франции и Великобритании проточную речную воду. Green Mountain намерена развернуть систему охлаждения речной водой на своём новом объекте в Германии. Речное охлаждение также используют Denv-R во Франции и Nautilus в Калифорнии. Наконец, сеть европейских супермаркетов Lidl объявила, что один из её ЦОД в Германии тоже использует охлаждение речной водой, а норвежский оператор дата-центров Polar утверждает, что для охлаждения одного из своих ЦОД намерен использовать близлежащую реку. Участвуют в подобных проектах и гиперскейлеры. Площадка Google в Финляндии использует для охлаждения и морскую воду.

24.09.2025 [16:55], Владимир Мироненко

OpenAI арендует, а не купит чипы у NVIDIA в рамках $100-млрд сделкиВ СМИ появились новые подробности о сделке NVIDIA и OpenAI, в рамках которой чипмейкер инвестирует в OpenAI $100 млрд. Как сообщает газета The Financial Times, переговоры прошли напрямую между гендиректором NVIDIA Дженсеном Хуангом (Jensen Huang) и главой OpenAI Сэмом Альтманом (Sam Altman). Главы компаний обсуждали подробности соглашения практически без официальных консультаций с банками, которые обычно выступают посредниками в подобных случаях. По данным The Information, в числе обсуждаемых вопросов было применение новой бизнес-модели лизинга чипов. Вместо того чтобы напрямую приобретать ускорители NVIDIA, OpenAI фактически будет брать у NVIDIA чипы в аренду с постепенной оплатой, что потенциально снизит первоначальные затраты на 10–15 % в течение пяти лет. Точные условия аренды или лизинга не разглашаются. У кого останутся чипы после окончания срока действия договора, тоже не говорится.

Источник изображения: NVIDIA Данный подход отражает более широкую тенденцию в ИИ-отрасли, где капиталоёмкая ИИ-инфраструктура рассматривается скорее как услуга, чем как основной актив. Такая бизнес-модель позволяют компаниям быстро масштабироваться без значительных капитальных затрат, в то время как NVIDIA обеспечивает себе долгосрочные источники дохода. Как отметил Альтман, сделка знаменует собой «новую модель финансирования <…>, при которой мы можем платить постепенно, а не покупать всё сразу». «Чипы и системы составляют огромную [долю] стоимости, и оплатить её авансом сложно», — добавил он. По словам аналитиков, действия Хуанга, направленные на то, чтобы сделать NVIDIA «предпочтительным стратегическим партнёром OpenAI в области вычислений и сетевых технологий», затруднят переход ИИ-разработчиков на конкурирующие чипы. Также укрепляет позиции компании в отрасли программная платформа NVIDIA CUDA, ставшая стандартным инструментом написания ИИ-приложений. Удерживая ИИ-разработчиков в своей экосистеме, Хуанг инвестирует в OpenAI, а также в десятки других стартапов, занимающихся ИИ-приложениями, облачными вычислениями, робототехникой и здравоохранением, что «многократно окупится для NVIDIA в будущем», говорят эксперты.

23.09.2025 [01:00], Владимир Мироненко

NVIDIA инвестирует в OpenAI $100 млрд, которые в основном пойдут на покупку её же ускорителейNVIDIA и OpenAI объявили о подписании соглашения о намерениях в рамках стратегического партнёрства, согласно которому NVIDIA поставит OpenAI ускорители для развёртывания ИИ-инфраструктуры мощностью не менее 10 ГВт, что позволит обучать и запускать модели следующего поколения на пути к созданию суперинтеллекта. Для поддержки планов OpenAI, включающих строительство нескольких дата-центров, NVIDIA обязалась инвестировать в неё до $100 млрд, но поэтапно и по мере развёртывания новых ИИ-кластеров NVIDIA. Запуск первого этапа запланирован на II половину 2026 года с началом поставок платформы Vera Rubin. Первые $10 млрд от NVIDIA станут доступны после того, как стороны достигнут окончательного соглашения о покупке OpenAI её ИИ-платформ. Ожидается, что детали нового этапа стратегического партнёрства будут определены в ближайшие недели. Проект не связан со Stargate. Агентство Reuters отметило взаимовыгодный характер сделки, в результате которой NVIDIA получает долю в крупнейшей в мире компании в области ИИ, уже являющейся её важным клиентом. В свою очередь, OpenAI получает необходимые денежные средства и доступ для покупки передовых чипов, которые необходимы ей в первую очередь для сохранения своего доминирования в условиях растущей конкуренции. По словам источника Reuters, близкого к OpenAI, сделка будет включать две отдельные, но взаимосвязанные транзакции. Стартап сам заплатит NVIDIA за чипы, в то время как деньги NVIDIA пойдут на приобретение миноритарной доли акций. Согласно пресс-релизу, OpenAI будет сотрудничать с NVIDIA в качестве приоритетного стратегического партнёра в области вычислений и сетевых технологий для реализации планов по развитию ИИ-фабрик. Компании будут совместно оптимизировать свои планы по разработке ПО OpenAI для моделирования и инфраструктуры, а также аппаратного и программного обеспечения NVIDIA. Напомним, что NVIDIA поддержала OpenAI в раунде финансирования на $6,6 млрд в октябре 2024 года. Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) сообщил телеканалу CNBC, что 10 ГВт эквивалентны от 4 до 5 млн GPU. По его словам, именно такой объём компания поставит в этом году, что «вдвое больше, чем в прошлом году». «Спрос на ускорители NVIDIA фактически является неотъемлемой частью разработки передовых ИИ-моделей», — заявил аналитик eMarketer Джейкоб Борн (Jacob Bourne), отметив, что подобные сделки также должны снизить опасения по поводу потери продаж в Китае. Он добавил, что это также опровергает предположение о том, что конкурирующие производители чипов или кастомные разработки крупных технологических платформ способны потеснить NVIDIA. Масштаб инвестиций NVIDIA может привлечь внимание антимонопольных органов, пишет Reuters. Министерство юстиции США и Федеральная торговая комиссия США (FTC) достигли соглашения в середине 2024 года, которое открыло путь для потенциальных расследований роли Microsoft, OpenAI и NVIDIA в ИИ-индустрии. Однако администрация Дональда Трампа (Donald Trump) пока придерживается более мягкого подхода к вопросам конкуренции по сравнению с предыдущей администрацией. Инвестиции NVIDIA последовали за недавним раундом вторичного финансирования, в ходе которого OpenAI получила у ряда инвесторов оценку в $500 млрд.

21.09.2025 [13:40], Сергей Карасёв

Schneider Electric готовит стойки NVIDIA GB300 NVL72 мощностью 142 кВтКомпания Schneider Electric анонсировала две эталонные платформы, призванные ускорить построение инфраструктур для дата-центров, ориентированных на ресурсоёмкие нагрузки ИИ и НРС. Разработка систем ведётся в партнёрстве с NVIDIA. Один из проектов предусматривает создание референсных стоек для суперускорителей NVIDIA GB300 NVL72. Такие стойки смогут обеспечивать мощность до 142 кВт. Предусмотрено использование жидкостного охлаждения. В одном машинном зале могут быть расположены три кластера GB300 NVL72, насчитывающих в общей сложности до 1152 ускорителей. Отмечается, что в основу решения положены наработки и опыт, полученные в ходе реализации аналогичного проекта для NVIDIA GB200 NVL72. Клиентам будет доступна специальная среда моделирования на базе вычислительной гидродинамики (CFD): могут применяться цифровые двойники для оценки различных конфигураций электропитания и охлаждения с целью оптимизации платформ под определённые нужды.

Источник изображения: Schneider Electric Второй эталонный проект, как утверждается, представляет собой первую и единственную в отрасли платформу, предполагающую интеграцию систем управления питанием и жидкостным охлаждением, включая решения Motivair (контрольный пакет акций этой фирмы Schneider Electric приобрела в конце 2024 года). Для новой платформы заявлена совместимость с NVIDIA Mission Control — программным обеспечением NVIDIA для контроля производственных процессов и оркестрации работы ИИ-систем, включая управление кластерами и рабочими нагрузками. В таких системах могут применяться суперускорители GB300 NVL72 и GB200 NVL72. Подчёркивается, что новые эталонные решения являются результатом продолжающегося сотрудничества Schneider Electric и NVIDIA, которое направлено на удовлетворение растущих потребностей операторов дата-центров в области ИИ.

21.09.2025 [13:23], Сергей Карасёв

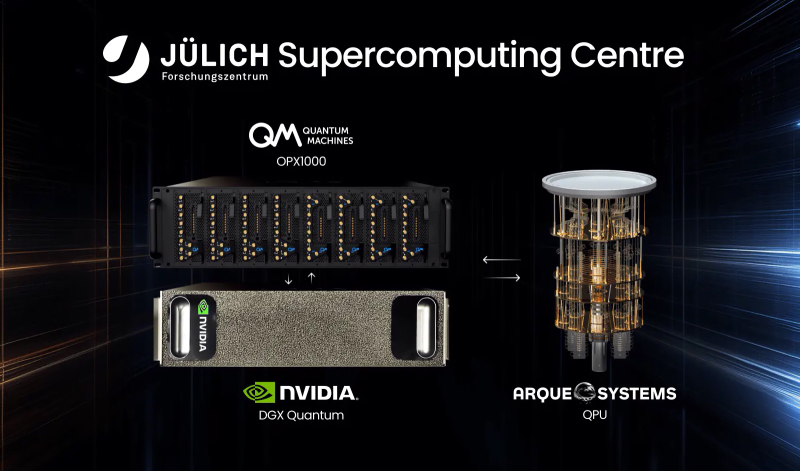

В Германии запущена квантово-классическая система с суперчипами NVIDIA GH200Компании Quantum Machines и Arque Systems развернули в Юлихском суперкомпьютерном центре в Германии (Jülich Supercomputing Centre, JSC) гибридную квантово-классическую вычислительную систему на платформе NVIDIA DGX Quantum. Это первый подобный проект, реализованный на базе крупной НРС-площадки в Европе. Новая система сочетает суперчипы NVIDIA GH200, 5-кубитный квантовый процессор Arque Systems и гибридный квантово-классический контроллер Quantum Machines OPX1000. Использованная архитектура, как утверждается, обеспечивает возможность квантовой коррекции ошибок (QEC), что является критически важным требованием при организации практических квантовых вычислений. Контроллер OPX1000, как отмечается, обеспечивает бесшовное взаимодействие между классическими и квантовыми вычислительными ресурсами. Достигается двусторонняя передача данных с задержкой менее 4 мкс, что в 1000 раз лучше, чем в предыдущих подобных реализациях. Ключевыми задачами проекта названы ускорение процедур калибровки кубитов и тестирование производительности квантовой коррекции ошибок. Кроме того, на базе комплекса планируется осуществлять разработку гибридных квантово-классических вычислительных алгоритмов. Одним из главных преимуществ платформы названа возможность запуска нейронных сетей и моделей машинного обучения на высокопроизводительных GPU с сохранением взаимодействия с квантовой подсистемой с низкой задержкой. Такой уровень интеграции, как подчёркивается, недоступен ни в одной другой современной системе квантовых вычислений. «Объединяя квантовые и классические вычислительные ресурсы на базе ведущего европейского суперкомпьютерного центра, мы открываем новые возможности для исследователей в плане изучения гибридных квантово-классических алгоритмов», — говорит доктор Кристель Михильсен (Kristel Michielsen), директор JSC. Нужно отметить, что JSC является оператором первого в Европе экзафлопсного суперкомпьютера — машины JUPITER, которая была официально запущена в эксплуатацию в сентябре 2025 года. Система использует примерно 6000 вычислительных узлов с гибридными ускорителями NVIDIA Quad GH200 и интерконнектом InfiniBand NDR200 (4×200G на узел, DragonFly+): в общей сложности задействованы почти 24 тыс. NVIDIA GH200.

20.09.2025 [01:40], Владимир Мироненко

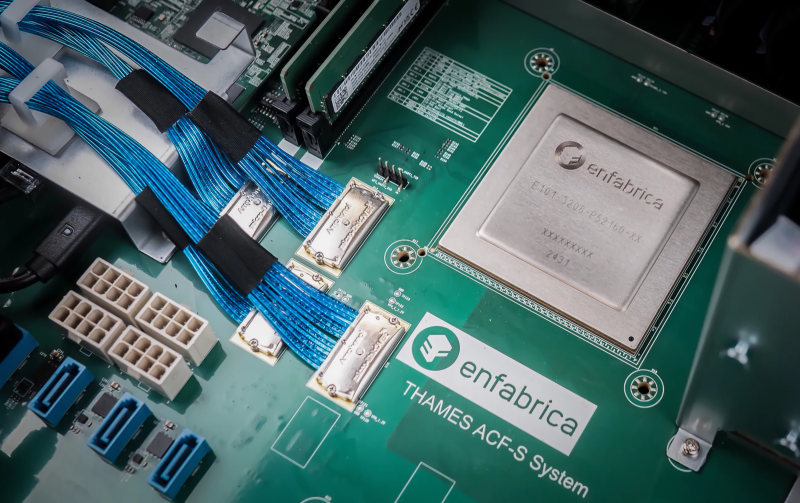

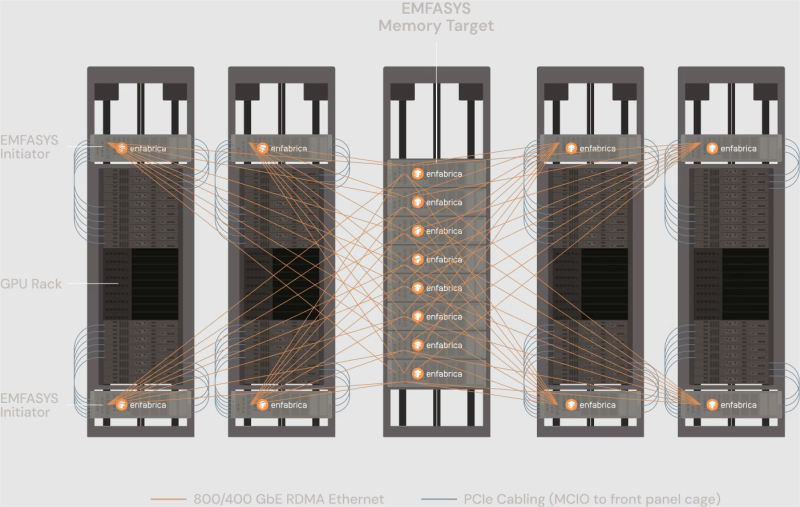

NVIDIA купила за $900 млн разработчика интерконнекта для ИИ-платформ EnfabricaСогласно публикациям CNBC и The Information, NVIDIA заключила сделку с разработчиком интерконнекта для ИИ-систем Enfabrica стоимостью $900 млн, чтобы лицензировать ряд его технологий, а также переманить его гендиректора и ключевых сотрудников. Оплата сделки, завершённой на прошлой неделе, производилась собственными средствами NVIDIA и её акциями. Глава Enfabrica Рочан Санкар (Rochan Sankar) уже присоединился к команде NVIDIA. Спрос на вычислительные мощности для поддержки генеративного ИИ со стороны таких компаний, как OpenAI, Anthropic, Mistral, AWS, Microsoft и Google, ставит перед NVIDIA сложную задачу: как создать унифицированный, отказоустойчивый GPU-кластер, способный справиться с такими огромными нагрузками. Решения Enfabrica, основанной в 2019 году, призваны решить эту задачу. Как пишет Network World со ссылкой на аналитиков, NVIDIA считает интеграцию технологий Enfabrica критически важной для повышения эффективности своих кластеров в обучении новейших ИИ-моделей. Во всяком случае, Enfabrica утверждает, что её технология позволяет бесшовно объединить более 100 тыс. ускорителей в единый кластер. Кроме того, к ускорителям можно добавить CXL-пулы DRAM/SSD. «Используя SuperNIC и фабрику Enfabrica, NVIDIA может ускорить передачу данных в кластерах, обойти текущие ограничения масштабирования сетевых фабрик и снизить зависимость от дорогостоящей памяти HBM», — отметила Рачита Рао (Rachita Rao), старший аналитик Everest Group, имея в виду чип ACF-S, разработанный для обеспечения более высокой пропускной способности, большей отказоустойчивости, меньшей задержки и лучшего программного управления для операторов ЦОД, работающих с ресурсоёмкими ИИ-системами и HPC. Enfabrica утверждает, что ACF-S более отказоустойчив в сравнении с традиционным интерконнектом, поскольку заменяет двухточечные соединения GPU многопутевой архитектурой, которая снижает перегрузку, улучшает распределение данных и гарантирует, что сбои в работе GPU не приведут к остановке процесса вычислений. По мнению Чарли Дая (Charlie Dai), главного аналитика Forrester, для NVIDIA также представляет интерес технология EMFASYS, позволяющая дать ИИ-серверам доступ к внешним пулам памяти. По словам Дая, сочетание ACF-S и EMFASYS может помочь NVIDIA добиться более высокой загрузки GPU и снижения совокупной стоимости владения (TCO) — ключевых показателей для гиперскейлеров и разработчиков LLM. Как сообщает Blocks & Files, Enfabrica привлекла в общей сложности $290 млн венчурного финансирования: $50 млн в раунде A в размере $50 млн в 2022 году при оценке в $50 млн; $125 млн в раунде B в 2023 году с оценкой в размере $250 млн; $115 млн в раунде C в 2024 году. По данным Pitchbook, оценочная стоимость компании сейчас составляет около $600 млн. NVIDIA инвестировала в компанию в раунде B. На этой неделе NVIDIA также объявила об инвестициях в Intel в размере $5 млрд в рамках совместной разработки специализированных чипов для ЦОД и ПК. Квазислияния получили широкое распространение в Кремниевой долине, поскольку позволяют обойти препоны регуляторов. В начале этого года Meta✴ приобрела за $14,3 млрд 49 % акций Scale AI, переманив его основателя Александра Ванга (Alexandr Wang) вместе с ключевыми сотрудниками. Месяц спустя Google объявила о похожем соглашении с ИИ-стартапом Windsurf, в рамках которого его соучредитель и гендиректор Варун Мохан (Varun Mohan) перешёл вместе с рядом сотрудников в подразделение Google DeepMind. Аналогичные сделки были в прошлом году у Google с Character.AI, Microsoft с Inflection AI и у Amazon с Adept. |

|