Материалы по тегу: nvidia

|

19.09.2025 [14:43], Владимир Мироненко

NVIDIA инвестирует £2 млрд в развитие экосистемы ИИ-стартапов Великобритании — £500 млн получит NscaleNVIDIA объявила об инвестициях в размере £2 млрд ($2,7 млрд) в ИТ-рынок Великобритании с целью стимулирования развития экосистемы стартапов в сфере ИИ, разработки инновационных ИИ-технологий, создания новых компаний и рабочих мест, а также расширения конкурентных возможностей Великобритании на мировом ИИ-рынке. Как отмечено в пресс-релизе NVIDIA, развитие ИИ-компаний в Великобритании осложняется ограниченным доступом к суперкомпьютерам, ограниченным венчурным капиталом за пределами Лондона, а также растущими ценами на электроэнергию и трудностями с доступом венчурных капиталистов к ведущим академическим учреждениям, где многие исследователи также являются предпринимателями. В связи с этим американский технологический гигант планирует в сотрудничестве с британскими компаниями Accel, Air Street Capital, Balderton Capital, Hoxton Ventures и Phoenix Court ускорить развитие ИИ-экосистемы в Великобритании, предоставив новый капитал стартапам в этой сфере. Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA, заявил, что сейчас самое подходящее время для инвестиций в Великобританию, поскольку «ИИ открывает новые горизонты в науке и стимулирует развитие совершенно новых отраслей». «Благодаря новому капиталу и развитой инфраструктуре мы удваиваем усилия, чтобы дать Великобритании возможность возглавить следующую волну инноваций в области ИИ», — подчеркнул он. В связи с недавним обязательством NVIDIA производить в США суперкомпьютеры для ИИ-нагрузок на сумму до полутриллиона долларов, инвестиции будут осуществляться в Соединённых Штатах и «активироваться» в Великобритании, а британские венчурные партнеры помогут производителю чипов найти стартапы в области ИИ, которым необходима поддержка, отметил Bloomberg. По данным ресурса, NVIDIA планирует инвестировать в разработчиков технологий автономных транспортных средств Wayve и Oxa, финтех-компанию Revolut, а также ИИ-стартапы PolyAI, Synthesia, Latent Labs и Basecamp Research. Wayve сообщила, что NVIDIA инвестирует в компанию $500 млн для ускорения разработки и внедрения её ИИ-модели. Сумма в £2 млрд также включает в себя долю NVIDIA в размере £500 млн ($683 млн) в британской компании Nscale, занимающейся разработкой ИИ ЦОД. Средства будут выделены из баланса NVIDIA, сообщил представитель компании. Ранее Microsoft, OpenAI и Google также объявили об инвестициях на общую сумму в десятки миллиардов долларов и партнёрских соглашениях в Великобритании.

19.09.2025 [14:19], Сергей Карасёв

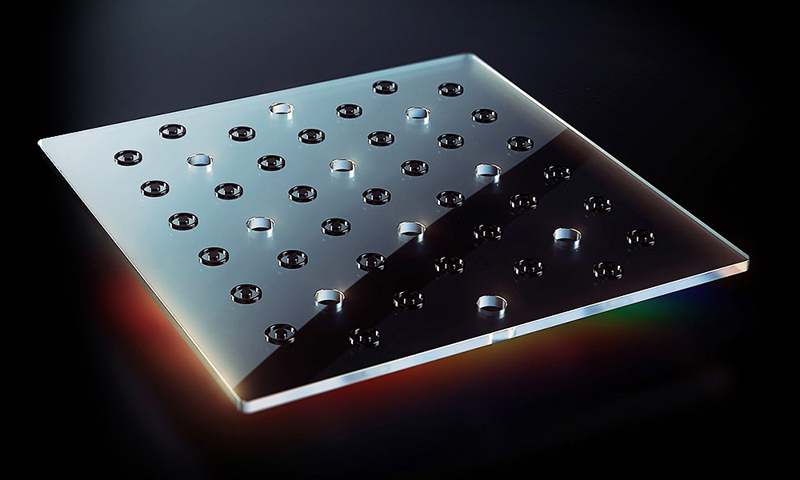

В Нью-Йорке заработал гибридный ЦОД Digital Realty с ИИ-кластером и квантовым компьютеромКомпания Digital Realty объявила об открытии на своей площадке JFK10 в Нью-Йорке специализированного дата-центра для задач ИИ, объединяющего вычисления на базе GPU и квантового компьютера. В реализации проекта приняли участие NVIDIA и Oxford Quantum Circuits (OQC). В состав платформы входит квантовая система Genesis, разработанная специалистами OQC. Она базируется на фирменной технологии двухканальных кубитов Dimon, которая, как утверждается, является прорывом в области устранения ошибок. Применение Dimon, по заявлениям OQC, позволяет снизить накладные расходы, одновременно открывая путь к отказоустойчивым квантовым вычислениям. Ещё одной составляющей нового дата-центра являются суперчипы NVIDIA GH200. Их использование в связке с Genesis позволяет сформировать среду для гибридных квантовых вычислений в области ИИ. Применённый подход предоставляет предприятиям доступ к интегрированной платформе, обеспечивающей более быстрое обучение ИИ-моделей и генерацию данных с повышенной эффективностью. Таким образом, компании могут одновременно задействовать возможности квантовых вычислений и ИИ при реализации сложных проектов и создании приложений следующего поколения.

Источник изображения: OQC Одной из ключевых сфер использования гибридной платформы названы финансы. Речь идёт о высокоточном моделировании рисков, обнаружении мошенничества, оптимизации услуг и пр. Кроме того, система может применяться для улучшения логистических операций, поддержки принятия решений в условиях неопределённости, повышения устойчивости в критически важных областях и др. Квантовые вычисления открывают также новые возможности для самого ИИ. Предполагается, что в перспективе новые системы Genesis будут поставляться с ускорителями NVIDIA в стандартной комплектации.

19.09.2025 [11:42], Сергей Карасёв

AAEON представила компактную ИИ-систему Intelli i14 Edge с ускорителем NVIDIA RTXКомпания AAEON анонсировала компьютер небольшого форм-фактора Intelli i14 Edge, рассчитанный на использование в коммерческой и индустриальной сферах. Устройство подходит для решения задач промышленной автоматизации, машинного зрения, предиктивного обслуживания, проектирования робототехники и пр. В основу новинки положена аппаратная платформа Intel Raptor Lake. Применён процессор Core i9-14900T, который объединяет 24 вычислительных ядра (8Р + 16Е; 32 потока). Максимальная тактовая частота — 5,5 ГГц. В состав чипа входит графический блок Intel UHD Graphics 770. Объём оперативной памяти DDR5-4800 может достигать 32 Гбайт в виде двух модулей SO-DIMM с поддержкой ЕСС. Компьютер несёт на борту ускоритель NVIDIA RTX A2000 или RTX A4500 (MXM), благодаря чему обеспечивается возможность локальной обработки ИИ-моделей. Есть два коннектора M.2 2280 M-Key для NVMe SSD и разъём M.2 2230 E-Key для адаптера Wi-Fi / Bluetooth. Реализованы два интерфейса DisplayPort для вывода изображения. Благодаря наличию сетевых портов 2.5GbE (Intel I226-IT) и 1GbE (Intel I219-LM), а также пяти разъёмов USB 3.2 Gen1 Type-A, как отмечает AAEON, обеспечивается бесшовная интеграция с камерами, лидарами, инерциальными измерительными блоками (IMU) и промышленными концентраторами ввода-вывода. Предусмотрен также один порт USB 3.2 Gen2 Type-C. Устройство имеет размеры 205 × 190 × 70 мм и весит около 3 кг. Диапазон рабочих температур — от 0 до +50 °C. Решение протестировано на устойчивость к вибрации в соответствии со стандартом IEC EN60068-2-64, что делает его пригодным для использования в автомобильных системах помощи водителю при движении (ADAS), оборонных комплексах, робототехнических платформах и других системах, которые эксплуатируются в неблагоприятных условиях. Говорится о совместимости с Windows 10 IoT.

19.09.2025 [01:45], Владимир Мироненко

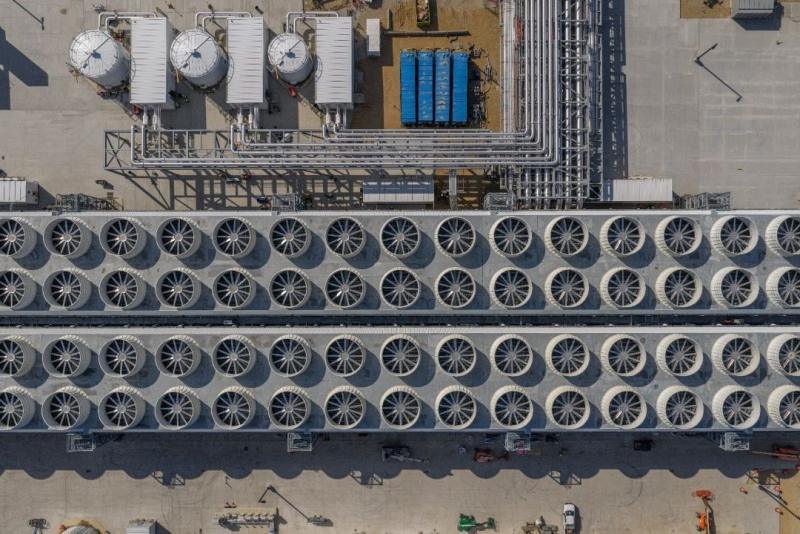

Microsoft вот-вот достроит «самый передовой» ИИ ЦОД в мире Fairwater и потратит $4 млрд на ещё один такой жеMicrosoft заявила, что находится на завершающей стадии строительства дата-центра Fairwater в Маунт-Плезант (Mount Pleasant) в Висконсине (США) стоимостью $3,3 млрд, который она называет самым передовым ИИ ЦОД в мире, пишет газета The Wall Street Journal. Ранее сообщалось, что Microsoft приостановила вторую фазу проекта, чтобы провести переоценку планов. Вице-председатель и президент Microsoft Брэд Смит (Brad Smith) сообщил, что объект будет запущен в эксплуатацию в начале 2026 года и первоначально будет использоваться для обучения моделей компании OpenAI, к которой затем могут присоединиться и другие арендаторы, включая саму Microsoft. Неподалёку будет построен ещё один ИИ ЦОД таких же масштабов, на который компания выделит в течение следующих трёх лет $4 млрд. Третий ЦОД семейства Fairwater появится в Джорджии. По словам Смита, сочетание вычислительной мощности ускорителей NVIDIA с сетевыми и системными решениями сделает проекты «поистине передовыми», что позволит обучать продвинутые как никогда ИИ-модели. ЦОД в Висконсине занимает площадь в 127,5 Га и включает три двухэтажных здания (это упростит развёртывание сети) общей площадью 111,5 тыс. м 2. Для его строительства потребовалось 74,6 км свай фундамента глубокого заложения, 112 тыс. т металлоконструкций, 190 км подземного кабеля среднего напряжения и 112,6 км трубопроводов. Впрочем, признаёт компания, им повезло, что хоть какая-то базовая инфраструктура на участке уже была создана усилиями бывшего владельца кампуса — Foxconn. Microsoft сообщила, что в ЦОД будут размещены сотни тысяч ускорителей NVIDIA GB200, соединённых оптоволокном (800G InfiniBand/Ethernet), которого хватило бы, чтобы «обернуть планету четыре раза». Производительность ЦОД будет в десять раз выше, чем у самых быстрых современных суперкомпьютеров, утверждает компания, не предоставляя дополнительных подробностей. ЦОД отличается передовой системой охлаждения. Более 90 % оборудования объекта будет обслуживаться замкнутой системой СЖО, которая будет заполнена на этапе строительства и, по словам компании, не потребует дозаправки. Остальная часть серверного оборудования будет использовать охлаждение наружным воздухом, а вода будет потребляться лишь в самые жаркие дни. В результате общее годовое потребление воды одним ЦОД на территории кампуса будет примерно эквивалентно расходу воды обычного ресторана за этот же период. Для питания ЦОД будут заключены соглашения о закупках электроэнергии (PPA) из возобновляемых источников. Microsoft также финансирует новый проект солнечной электростанции мощностью 250 МВт, строительство которой в настоящее время ведётся в округе Портидж (Portage). Ожидается, что в первом ЦОД штат составит около 500 сотрудников, а после завершения строительства второго дата-центра их количество вырастет до 800.

18.09.2025 [17:16], Сергей Карасёв

Стартап Carbon3.ai намерен развернуть в Великобритании экологичную суверенную ИИ-инфраструктуруКомпания Carbon3.ai, по сообщению Datacenter Dynamics, планирует создать в Великобритании общенациональную суверенную ИИ-инфраструктуру, которая в конечном итоге будет насчитывать до 100 тыс. GPU-ускорителей. Партнёрами в рамках масштабного проекта выступают НРЕ, VAST Data и World Wide Technology (WWT). Целью инициативы является развёртывание сети ЦОД, получающих питание исключительно от возобновляемых источников энергии. Все инфраструктурные объекты будут располагаться исключительно на территории Великобритании, соответствуя стандартам национальной безопасности. Предполагается, что сеть свяжет более 50 площадок по всей стране. На сайте Carbon3.ai говорится, что проектом предусмотрено использование ИИ-ускорителей NVIDIA Blackwell для решения ресурсоёмких задач, включая обучение больших языковых моделей (LLM) и инференс. Кроме того, будет задействована программно-аппаратная платформа HPE Private Cloud AI. Carbon3.ai заявляет, что уже получила в Великобритании «значительный первоначальный капитал», рассчитывая в перспективе довести объём привлечённых средств до £1 млрд ($1,36 млрд). Предполагается, что создаваемая суверенная ИИ-инфраструктура поможет клиентам контролировать свои данные, одновременно добиваясь целей в области устойчивого развития.

Источник изображения: Carbon3.ai Нужно отметить, что на днях ряд крупных компании объявили о намерении инвестировать огромные суммы в развитие ИИ в Великобритании. Так, Microsoft планирует вложить в ИИ-проекты на территории этой страны около $30 млрд, BlackRock — примерно $678 млн, а Google — около $6,8 млрд. Кроме того, NVIDIA и партнёры инвестируют до $15 млрд в расширение британских дата-центров, создав ИИ-фабрики со 120 тыс. ускорителей Blackwell. Компания CoreWeave вложит в дата-центры для задач ИИ в Великобритании дополнительно $2 млрд.

18.09.2025 [16:09], Владимир Мироненко

Intel разработает для NVIDIA кастомные CPU для серверов и ПК, а NVIDIA вложит в Intel $5 млрдNVIDIA и корпорация Intel заключили соглашение о сотрудничестве с целью совместной разработки специализированных чипов для ЦОД и ПК для использования гиперскейлерами, а также другими клиентами на корпоративном и потребительском рынках. Согласно пресс-релизу, компании намерены обеспечить бесшовное объединение архитектур NVIDIA и Intel с использованием NVIDIA NVLink, реализуя преимущества NVIDIA в области ИИ и ускоренных вычислений совместно с ведущими технологиями процессоров Intel и экосистемой x86 для предоставления передовых решений для клиентов. Ранее NVIDIA представила интерконнект NVLink Fusion, который как раз и позволяет объединять решения компании с чиплетами других вендоров. Одним из первых продуктов стал чип GB10, включающий GPU Blackwell и Arm-процессор MediaTek. В рамках партнёрства Intel разработает кастомные серверные x86-процессоры для ИИ-платформ NVIDIA. Для персональных компьютеров Intel разработает SoC с архитектурой x86 и GPU-чиплетами NVIDIA RTX. Новые SoC RTX на базе x86 будут использоваться в широком спектре ПК. У Intel уже был опыт интеграции GPU AMD в свои SoC, но не слишком удачный — Kaby Lake-G были заброшены через пару лет после выхода. В рамках соглашения о сотрудничестве NVIDIA инвестирует в Intel $5 млрд путём приобретения на эту сумму обыкновенных акций Intel по цене $23,28 за единицу. После этого объявления акции Intel подскочили на премаркете на 33 % до примерно $33 за единицу, сообщил ресурс CNBC. Ранее SoftBank потратила $2 млрд на покупку акций Intel по $23/шт. В конце августа власти США приобрели 9,9 % долю в Intel за $8,9 млрд, получив акции по $20,47 за бумагу. «Это историческое сотрудничество тесно связывает ИИ-технологии и ускоренные вычисления NVIDIA с CPU Intel и обширной экосистемой x86 — слиянием двух платформ мирового класса. Вместе мы расширим наши экосистемы и заложим основу для следующей эры вычислений», — отметил генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang). Как полагают аналитики CNBC, сотрудничество, по всей видимости, не включают производство чипов NVIDIA на производственных мощностях Intel.

18.09.2025 [15:25], Сергей Карасёв

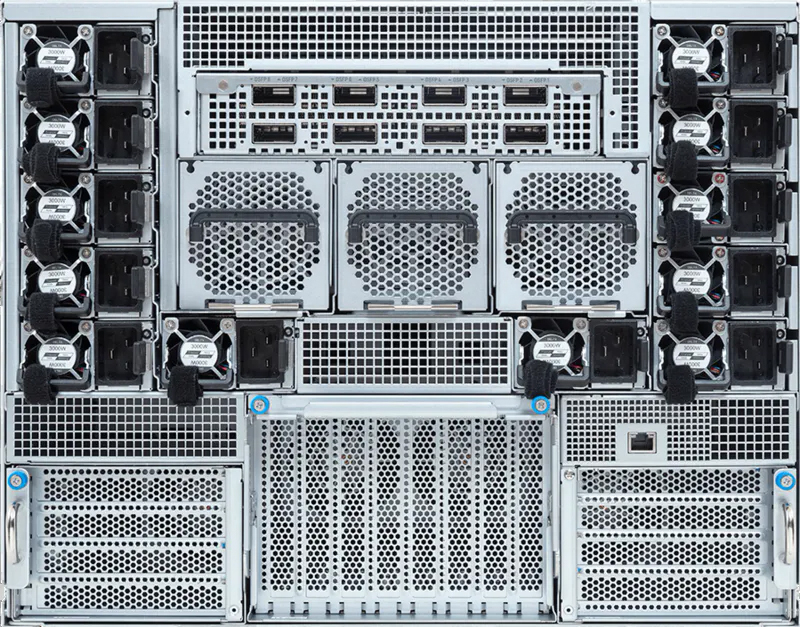

Giga Computing представила флагманский ИИ-сервер на базе NVIDIA HGX B300Компания Giga Computing, подразделение Gigabyte, анонсировала сервер G894-SD3-AAX7 — флагманскую систему, предназначенную для решения сложных HPC-задач, обучения больших языковых моделей (LLM), инференса и других ресурсоёмких ИИ-нагрузок. В основу новинки положены процессорры Intel Xeon Granite Rapids и ускорители NVIDIA Blackwell Ultra. Сервер выполнен в форм-факторе 8U. Возможна установка двух процессоров Xeon 6500P/6700P с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 RDIMM-6400 или MRDIMM-8000. Во фронтальной части расположены восемь посадочных мест для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe) и поддержкой горячей замены. Кроме того, есть два внутренних коннектора для SSD типоразмера M.2 2280/22110 (PCIe 5.0 x4 и PCIe 5.0 x2).  Система, построенная на платформе NVIDIA HGX B300, имеет восемь SXM-ускорителей Blackwell Ultra. Могут быть реализованы восемь портов 800G OSFP InfiniBand или 16 портов 400GbE посредством адаптеров NVIDIA ConnectX-8 SuperNIC. Говорится о поддержке DPU NVIDIA BlueField-3 и о наличии четырёх слотов PCIe 5.0 x16 для карт FHHL.  Сервер оснащён двумя портами 10GbE на базе Intel X710-AT2, выделенным сетевым портом управления 1GbE, контроллером ASPEED AST2600, двумя портами USB 3.2 Gen1 Type-A и интерфейсом D-Sub. Применяется воздушное охлаждение. За питание отвечают 12 блоков мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +30 °C.

17.09.2025 [23:52], Владимир Мироненко

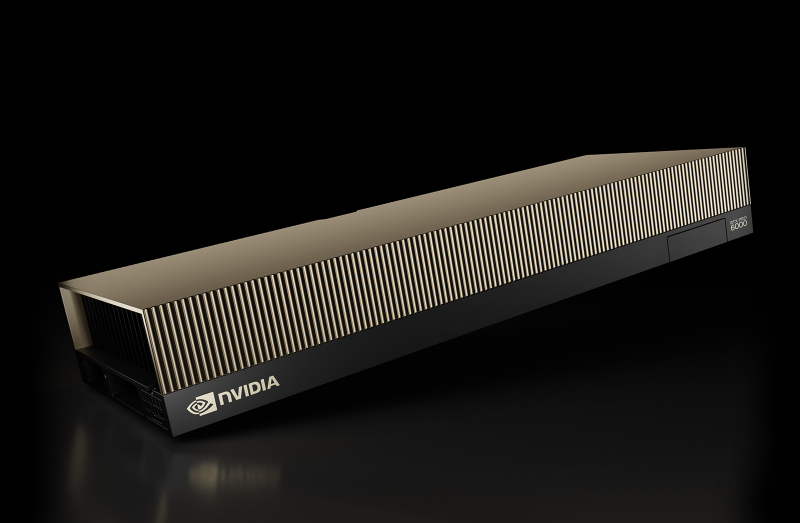

Глава NVIDIA разочарован запретом Китая на покупку RTX Pro 6000D, но все вопросы будут решаться на высшем уровнеВ Китае вынесли запрет компаниям, включая ByteDance и Alibaba, на тестирование и размещение заказов на разработанный специально для Поднебесной ускоритель NVIDIA RTX Pro 6000D, сообщила в среду Financial Times со ссылкой на источники, знакомые с ситуацией. За несколько дней по итогам расследования Государственного управления по регулированию рынка Китая (SAMR) до власти обвинили NVIDIA в нарушении антимонопольного законодательства при покупке Mellanox. По словам источника, запрет Государственной канцелярии интернет-информации КНР (CAC) поступил после проведения сравнения чипов, изготавливаемых компаниями Huawei и Cambricon, а также Alibaba и Baidu, с продукцией NVIDIA. В итоге регулятор пришёл к выводу, что китайские ИИ-чипы достигли уровня, сопоставимого или превосходящего уровень продукции NVIDIA, разрешённой к экспорту в Китай. В прошлом месяце Financial Times сообщила о планах китайских производителей чипов утроить объём производства ИИ-ускорителей в стране в следующем году.

Источник изображения: NVIDIA | NVIDIA RTX PRO 6000 Blackwell Server Edition Ускоритель RTX Pro 6000D был представлен в июле во время визита гендиректора компании Дженсена Хуанга (Jensen Huang) в Пекин. Тогда же NVIDIA заявила, что Вашингтон ослабляет ранее введенный запрет на экспорт в страну ускорителей H20. Financial Times сообщила, что китайские регулирующие органы в ответ на ослабление ограничений со стороны США ужесточили контроль закупок H20, требуя от компаний предоставить обоснование решения купить эти чипы вместо отечественной продукции. При этом RTX Pro 6000D спросом не пользуется. Комментируя запрет Пекина, Дженсен Хуанг заявил, что разочарован этим. «Мы можем служить рынку, только если страна этого хочет», — сказал он. «Мы рекомендовали всем финансовым аналитикам не включать Китай» в финансовые прогнозы, заявил Хуанг, пояснив, что этот вопрос «в значительной степени будет обсуждаться правительствами США и Китая».

17.09.2025 [13:15], Сергей Карасёв

NVIDIA и партнёры развернут в Великобритании ИИ-фабрики со 120 тыс. ускорителей BlackwellКомпания NVIDIA, как и ожидалось, объявила о масштабных инвестициях в развитие ИИ-инфраструктуры в Великобритании. Инициатива будет реализовываться совместно с партнёрами, в число которых входят Microsoft, оператор ИИ-облака CoreWeave и британский поставщик ИИ-инфраструктуры Nscale. Речь идёт о создании ИИ-фабрик, которые смогут поддерживать наиболее ресурсоёмкие нагрузки, в том числе модели OpenAI. Предполагается, что создание таких площадок позволит Великобритании достичь своих государственных целей в области ИИ и развития инноваций. В рамках масштабного проекта NVIDIA и партнёры инвестируют до £11 млрд ($15 млрд) в расширение британских дата-центров. В общей сложности будут установлены 120 тыс. мощных ускорителей Blackwell Ultra, что станет крупнейшим подобным развёртыванием в истории Великобритании. Компании Nscale, OpenAI и NVIDIA участвуют в программе Stargate UK, предполагающей формирования платформы для передовых ИИ-моделей, в том числе GPT-5.

Источник изображения: NVIDIA Nscale и Microsoft также объявили о планах строительства самого мощного британского суперкомпьютера. Ожидается, что он будет оснащён более чем 24 тыс. ускорителей Grace Blackwell Ultra. Платформу планируется использовать в том числе для предоставления сервисов Microsoft Azure в Великобритании. Кроме того, NVIDIA поможет компании Nscale в масштабировании её инфраструктуры по всему миру: в общей сложности в глобальном масштабе (в США, Португалии, Норвегии и других странах) будут развёрнуты до 300 тыс. Grace Blackwell, включая 60 тыс. в Великобритании. Вместе с тем CoreWeave объявила о создании в Шотландии современного дата-центра на базе Grace Blackwell Ultra, получающего питание от возобновляемых источников энергии. Нужно также отметить, что ранее стало известно о планах американской компании BlackRock инвестировать до £500 млн ($678 млн) в расширение инфраструктуры дата-центров в Великобритании. Кроме того, Google намерена вложить £5 млрд ($6,8 млрд) в развитие ИИ в этой стране.

17.09.2025 [13:15], Руслан Авдеев

Собственный ЦОД Stargate и крупнейший в стране ИИ-суперкомпьютер: американские IT-гиганты вложат более $40 млрд в развитие ИИ в Великобритании

coreweave

google

hardware

microsoft

nscale

nvidia

openai

salesforce

stargate

великобритания

ии

инвестиции

суперкомпьютер

сша

финансы

цод

Microsoft объявила о намерении вложить около $30 млрд в ИИ-проекты на территории Великобритании к 2028 году. $15,5 млрд уйдёт на капитальное расширение в течение трёх лет, а $15,1 млрд — на операции в стране, сообщает CNBC. В частности, инвестиции позволят построить «крупнейший суперкомпьютер» в Великобритании с более 23 тыс. передовых ускорителей (24 тыс. по данным NVIDIA) совместно с британской Nscale. Дата запуска не раскрывалась, но в Nscale ранее объявляли, что новый ЦОД компании заработает в 2026 году и обеспечит доступ к 46 тыс. ускорителей. Планируемая мощность составляет 50 МВт, а всего на площадку выделено 90 МВт. На фоне государственного визита в Великобританию президента США Дональда Трампа (Donald Trump), инвестировать в развитие ИИ в стране пообещали NVIDIA, Google, OpenAI и Salesforce, общая сумма превысит $40 млрд. Эксперты ожидают, что премьер-министр Великобритании Кир Стармер и Дональд Трамп подпишут 17 сентября новое соглашение, открывая путь к инвестициям и сотрудничеству в сфере ИИ, квантовых и ядерных технологий. Президент Microsoft Брэд Смит (Brad Smith) заявил, что его позиция в отношении Великобритании «потеплела» с годами, ранее он критиковал Соединённое Королевство за попытку заблокировать в 2023 году сделку Microsoft по покупке Activision-Blizzard за $69 млрд. Впрочем, в том же году она была одобрена. По словам Смита, его воодушевляют сделанные правительстовм в последние несколько лет шаги для улучшения делового климата — ещё несколько лет назад подобные инвестиции были бы немыслимы из-за действующих норм и практики. Кроме того, не было спроса на такие вложения в ИИ. NVIDIA уже объявила о намерении вложить в Великобританию совместно с Nscale и CoreWeave £11 млрд ($15 млрд). NVIDIA намерена разместить в Соединённом Королевстве 120 тыс. ИИ-ускорителей Blackwell, это станет крупнейшим в этом роде проектом компании в Европе. Утверждается, что это сделает Великобританию действительно «производителем ИИ, а не потребителем».

Источник изображения: chan lee/unsplash.com Инвестировать в ИИ-проекты в Великобритании £5 млрд ($6,8 млрд) намерена Google. Компания откроет новый ЦОД в 19 километрах от центра Лондона. В Google уверены, что новый дата-центр поможет удовлетворить спрос на сервисы компании с ИИ-элементами: Google Cloud, Workspace, Search и Maps. Предполагается, что инвестиции позволят ежегодно создавать 8250 рабочих мест в британских компаниях. Значительный вклад внесёт и OpenAI благодаря проекту Stargate UK. Речь идёт о специализированной местной версии масштабного проекта, совместно реализуемого с SoftBank и Oracle. В Великобритании ИИ-стартап будет сотрудничать над проектом с Nscale и NVIDIA. OpenAI уже заявила, что в начале 2026 года для внедрения в Великобритании будут развёрнуты 8 тыс. ИИ-ускорителей с возможностью расширения мощностей до 31 тыс. в будущем. Первая крупная стройка для Stargate UK запланирована на территории Cobalt Park в Ньюкасле (Newcastle) на севере Англии. Salesforce объявила о планах увеличить инвестиции в Великобритании до $6 млрд, увеличив обязательства в сравнении с 2023 годом до $4 млрд. В Salesforce подчеркнули, что визит Трампа в Великобританию подтверждает важность отношений между Великобританией и США. Наконец, CoreWeave объявила о дополнительных инвестициях в размере £1,5 млрд для увеличения мощности своего ИИ ЦОД в стране. Благодаря этому обязательству общий объем инвестиций CoreWeave в этой стране достигнет £2,5 млрд. Суммарный объём инвестиций IT-гигантов превысит $40 млрд. |

|