Материалы по тегу: hardware

|

12.09.2025 [23:30], Владимир Мироненко

Благодаря NVIDIA доля Arm на рынке серверных процессоров достигла 25 %Стремительный рост вычислительных мощностей ЦОД на фоне бума ИИ-технологий способствовал росту доходов не только производителей ускорителей и серверных CPU, но и компании Arm, чью архитектуру они используют в своих чипах, передаёт The Register. В январе Arm заявила о намерении занять 50 % рынка чипов для ЦОД к концу 2025 года Согласно исследованию Dell’Oro Group, во II квартале доля Arm-чипов на рынке серверных CPU составила 25 %, тогда как годом ранее она равнялась 15 %. Движущей силой роста стало внедрение суперускорителей NVIDIA GB200 NVL72 и GB300 NVL72, которые включают 36 Arm-процессоров Grace на базе архитектуры Neoverse V2 (Demeter) с интерфейсом NVLink-C2C. Заказы на поставку чипов NVIDIA расписаны на месяцы вперёд, что обеспечивает гарантированный источник доходов Arm наряду с ростом доли на рынке. Аналитик Dell’Oro Барон Фунг (Baron Fung) сообщил The Register, что ещё год назад рост Arm на рынке серверных процессоров обеспечивался практически исключительно за счёт кастомных CPU, таких как AWS Graviton. Но теперь выручка от продаж Grace сопоставима с доходами от облачных GPU. AWS использует кастомные процессоры на архитектуре Arm с 2018 года. А Microsoft и Google лишь в последние несколько лет начали всерьёз развивать свои Arm-процессорах Cobalt и Axion соответственно, отметил The Register. Рост доли Arm на рынке зависит от того, насколько больше разработчиков чипов выведет свои чипы на рынок серверных процессоров. NVIDIA сейчас работает над новым процессором на базе Arm с использованием кастомных ядер Vera. Qualcomm и Fujitsu также работают над серверными чипами. А появление NVIDIA NVLink Fusion может привести к созданию новых гибридных чипов. По данным Dell’Oro, рост рынка ИИ-технологий также привёл к росту рынка компонентов для серверов и СХД, составившему во II квартале 44 % в годовом исчислении. Продажи SmartNIC и DPU, которые зачастую тоже используют Arm-ядра, примерно удвоились по сравнению с прошлым годом на фоне перехода на Ethernet для вычислительных ИИ-кластеров. Поставки ASIC для обработки ИИ-нагрузок сейчас сопоставимы с объёмами поставок GPU, хотя GPU по-прежнему приносят большую часть доходов.

12.09.2025 [23:07], Владимир Мироненко

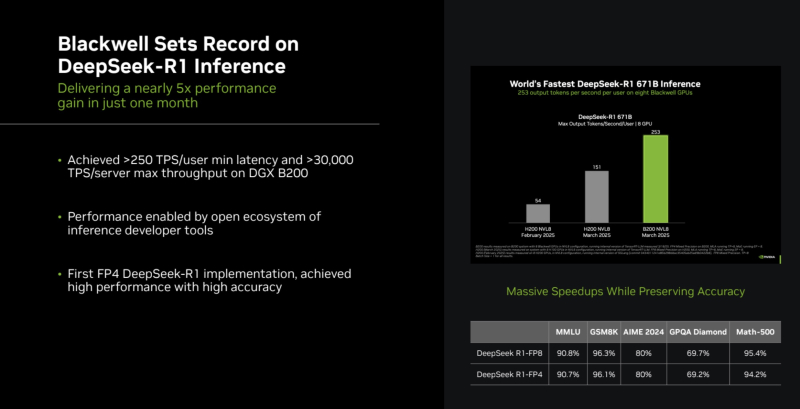

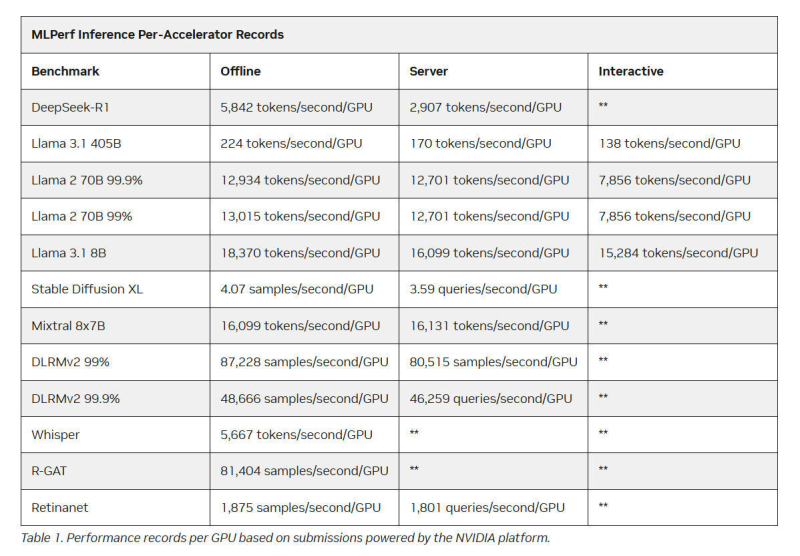

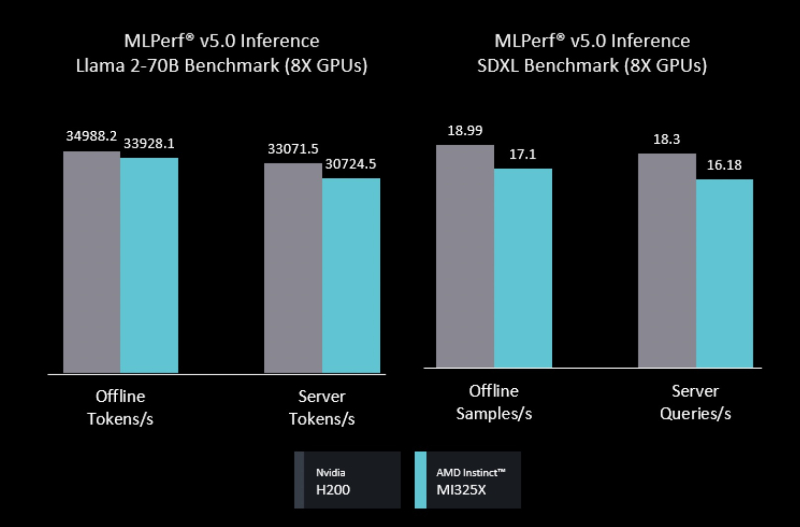

Intel Arc Pro впервые поучаствовали в бенчмарках MLPerf Inference, но в лидерах предсказуемо осталась NVIDIAMLCommons объявил результаты набора бенчмарков MLPerf Inference v5.1. Последний раунд демонстрирует, насколько быстро развивается инференс и соответствующие бенчмарки, пишет ресурс HPCwire. В этом раунде было рекордное количество заявок — 27. Представлены результаты сразу пяти новых ускорителей: AMD Instinct MI355X, Intel Arc Pro B60 48GB Turbo, NVIDIA GB300, NVIDIA RTX 4000 Ada 20GB, NVIDIA RTX Pro 6000 Blackwell Server Edition. Всего же количество результатов MLPerf перевалило за 90 тыс. результатов. В текущем раунде были представлены три новых бенчмарка: тест рассуждений на основе модели DeepSeek-R1, тест преобразования речи в текст на основе Whisper Large v3 и небольшой тест LLM на основе Llama 3.1 8B. Как отметил ресурс IEEE Spectrum, бенчмарк на основе модели Deepseek R1 671B (671 млрд параметров), более чем в 1,5 раза превышает самый крупный бенчмарк предыдущего раунда на основе Llama 3.1 405B. В модели Deepseek R1, ориентированной на рассуждения, большая часть вычислений выполняется во время инференса, что делает этот бенчмарк ещё более сложным. Что касается самого маленького бенчмарка, основанного на Llama 3.1 8B, то, как поясняют в MLCommons, в отрасли растёт спрос на рассуждения с малой задержкой и высокой точностью. SLM отвечают этим требованиям и являются отличным выбором для таких задач, как реферирование текста или периферийные приложения. В свою очередь бенчмарк преобразования голоса в текст, основанный на Whisper Large v3, был разработан в ответ на растущее количество голосовых приложений, будь то смарт-устройства или голосовые ИИ-интерфейсы. NVIDIA вновь возглавила рейтинг MLPerf Inference, на этот раз с архитектурой Blackwell Ultra, представленной платформой NVIDIA GB300 NVL72, которая установила рекорд, увеличив пропускную способность DeepSeek-R1 на 45 % по сравнению с предыдущими системами GB200 NVL72 (Blackwell). NVIDIA также продемонстрировала высокие результаты в бенчмарке Llama 3.1 405B, который имеет более жёсткие ограничения по задержке. NVIDIA применила дезагрегацию, разделив фазы работы с контекстом и собственно генерацию между разными ускорителями. Этот подход, поддерживаемый фреймворком Dynamo, обеспечил увеличение в 1,5 раза пропускной способности на один ускоритель по сравнению с традиционным обслуживанием на системах Blackwell и более чем в 5 раз по сравнению с системами на базе Hopper. NVIDIA назвала «дезагрегированное обслуживание» одним из ключевых факторов успеха, помимо аппаратных улучшений при переходе к Blackwell Ultra. Также свою роль сыграло использованием фирменного 4-бит формата NVFP4. «Мы можем обеспечить точность, сопоставимую с BF16», — сообщила компания, добавив, что при этом потребляется значительно меньше вычислительной мощности. Для работы с контекстом NVIDIA готовит соускоритель Rubin CPX. В более компактных бенчмарках решения NVIDIA также продемонстрировали рекордную пропускную способность. Компания сообщила о более чем 18 тыс. токенов/с на один ускоритель в бенчмарке Llama 3.1 8B в автономном режиме и 5667 токенов/с на один ускоритель в Whisper. Результаты были представлены в офлайн-, серверных и интерактивных сценариях, при этом NVIDIA сохранила лидерство в расчете на GPU во всех категориях. AMD представила результаты AMD Instinct MI355X только в «открытой» категории, где разрешены программные модификации модели. Ускоритель MI355X превзошёл в бенчмарке Llama 2 70B ускоритель MI325X в 2,7 раза по количеству токенов/с. В этом раунде AMD также впервые обнародовала результаты нескольких новых рабочих нагрузок, включая Llama 2 70B Interactive, MoE-модель Mixtral-8x7B и генератор изображений Stable Diffusion XL. В число «закрытых» заявок AMD входили системы на базе ускорителей AMD MI300X и MI325X. Более продвинутый MI325X показал результаты, схожие с показателями систем на базе NVIDIA H200 на Llama 2 70b, в комбинированном тесте MoE и тестах генерации изображений. Кроме того, компанией была представлена первая гибридная заявка, в которой ускорители AMD MI300X и MI325X использовались для одной и той же задачи инференса — бенчмарка на базе Llama 2 70b. Возможность распределения нагрузки между различными типами ускорителей — важный шаг, отметил IEEE Spectrum. В этом раунде впервые был представлен и ускоритель Intel Arc Pro. Для бенчмарков использовалась видеокарта MaxSun Intel Arc Pro B60 Dual 48G Turbo, состоящая из двух GPU с 48 Гбайт памяти, в составе платформы Project Battlematrix, которая может включать до восьми таких ускорителей. Система показала результаты на уровне NVIDIA L40S в небольшом тесте LLM и уступила ему в тесте Llama 2 70b. Следует также отметить, что в этом раунде, как и в предыдущем, участвовала Nebius (ранее Yandex N.V.). Компания отметила, что результаты, полученные на односерверных инсталляциях, подтверждают, что Nebius AI Cloud обеспечивает «высочайшие» показатели производительности для инференса базовых моделей, таких как Llama 2 70B и Llama 3.1 405B. В частности, Nebius AI Cloud установила новый рекорд производительности для NVIDIA GB200 NVL72. По сравнению с лучшими результатами предыдущего раунда, её однохостовая инсталляция показала прирост производительности на 6,7 % и 14,2 % при работе с Llama 3.1 405B в автономном и серверном режимах соответственно. «Эти два показателя также обеспечивают Nebius первое место среди других разработчиков MLPerf Inference v5.1 для этой модели в системах GB200», — сообщила компания.

12.09.2025 [16:30], Сергей Карасёв

«Аквариус» представил российские серверы Aquarius AQserv AS на базе Intel Xeon Ice Lake-SPРоссийская компания «Аквариус» анонсировала двухсокетные серверы семейства Aquarius AQserv AS на аппаратной платформе Intel Xeon Ice Lake-SP. Устройства подходят для широкого спектра задач, включая виртуализацию и развёртывание программно-определяемых хранилищ (SDS), а также построение систем резервного копирования, видеонаблюдения и потокового видео. В серию вошли модели Aquarius AQserv T50 D108AS, Aquarius AQserv T50 D212AS и Aquarius AQserv T50 D436AS в форм-факторе 1U, 2U и 4U соответственно. Младшая допускает установку процессоров с TDP до 185 Вт, две другие — до 235 Вт. Все серверы располагают 16 слотами для модулей DDR4-3200 суммарным объёмом до 4 Тбайт. У версии Aquarius AQserv T50 D108AS во фронтальной части расположены по четыре отсека для накопителей SFF (SAS/SATA) и LFF/SFF (SAS/SATA/NVMe) с возможностью горячей замены. Есть два внутренних коннектора для SSD типоразмера M.2 2280 с интерфейсом PCIe 4.0 x4, а также по одному слоту PCIe 4.0 x16 (x8) и PCIe 4.0 x16 для низкопрофильных карт расширения. Применены два блока питания мощностью 750 Вт с сертификатом 80 PLUS Platinum / Titanium. Модель Aquarius AQserv T50 D212AS, в свою очередь, получила четыре отсека для накопителей LFF/SFF (SAS/SATA/NVMe) и восемь отсеков для устройств LFF/SFF (SAS/SATA) во фронтальной части, два тыльных посадочных места для накопителей SFF (SAS/SATA/NVMe) c горячей заменой и два внутренних коннектора M.2 2280 (PCIe 4.0 x4). Доступны четыре слота PCIe 4.0 x16 и два разъёма PCIe 4.0 x8 для низкопрофильных карт расширения. За питание отвечают два блока мощностью до 2000 Вт с сертификатом 80 PLUS Platinum / Titanium. Старшая версия, Aquarius AQserv T50 D436AS, может нести на борту до 40 накопителей в следующей конфигурации: 24 × LFF/SFF (SAS/SATA) спереди, 2 × SFF SAS/SATA/NVMe) и 12 × LFF/SFF (SAS/SATA) сзади, 2 × M.2 2280 (PCIe 4.0 x4) во внутренней части. Предусмотрены четыре слота PCIe 4.0 x16 и два слота PCIe 4.0 x8. Установлены два блока питания мощностью до 2000 Вт (80 PLUS Platinum / Titanium). Все новинки оборудованы контроллером Aspeed AST2500, двумя портами 2.5GbE (Intel I225/I226) и двумя портами 10GbE (Intel x710), интерфейсами D-Sub и USB 3.2 Gen1 Type-A, последовательным портом. Применена система воздушного охлаждения с быстрозаменяемыми вентиляторами с ШИМ-управлением. Серверы снабжены системой удалённого управления «Аквариус Командир» с выделенным портом, который предоставляет полный контроль через WebUI, а также IPMI 2.0 и Redfish. Кроме того, устройства имеют расширенные возможности администрирования из любой точки мира (KVMoIP и Remote Media Redirection) и поддержку централизованного мониторинга. Заявлена совместимость с Astra Linux 1.7.5 и выше, «Альт Сервер» 10, «РЕД ОС» 7.3 и выше, Windows Server 2016/2019, Red Hat Enterprise Linux Server 8.x и Ubuntu 22.04.

12.09.2025 [11:39], Сергей Карасёв

OpenAI и NVIDIA инвестируют миллиарды долларов в британские дата-центрыКомпании OpenAI и NVIDIA, по сообщению Bloomberg News, намерены в ближайшее время объявить о масштабных инвестициях в инфраструктуру дата-центров в Великобритании. Речь идёт о вложениях в размере «миллиардов долларов». Ожидается, что анонс будет сделан на следующей неделе во время второго государственного визита президента США Дональда Трампа в Великобританию, который пройдёт с 17 по 19 сентября. Король Карл III и королева Камилла примут американского лидера и его жену Меланию в Виндзорском замке в графстве Беркшир. В состав делегации США войдут руководители ряда американских корпораций, включая генерального директора OpenAI Сэма Альтмана (Sam Altman) и главу NVIDIA Дженсена Хуанга (Jensen Huang). Ожидается, что эти компании в рамках финансирования развития британских ЦОД объединят усилия с лондонской фирмой Nscale Global Holdings Ltd. В целом, как ожидается, во время предстоящего визита Трампа американские компании из различных отраслей объявят о десятках миллиардов долларов инвестиций в Великобританию. Представители OpenAI и NVIDIA ситуацию пока никак не комментируют. OpenAI стремится укрепить позиции в Европе, где она сталкивается с гораздо более строгим регулированием, нежели в США. С мая нынешнего года компания реализует программу OpenAI for Countries, которая предполагает создание ИИ ЦОД по всему миру. Первым европейским дата-центром, создающимся в рамках этой инициативы, станет объект Stargate Norway в Норвегии. На начальном этапе мощность этого ЦОД составит 230 МВт с возможностью последующего добавления ещё 290 МВт. Интерес к развитию инфраструктуры дата-центров в Великобритании проявляют и другие американские компании. В частности, в конце прошлого года стало известно о том, что Cloud HQ, CyrusOne, CoreWeave и ServiceNow намерены вложить около $8,22 млрд в строительство ЦОД в этой стране.

12.09.2025 [11:35], Сергей Карасёв

150 кВт на стойку для тестов: Digital Realty открыла лабораторию DRIL для ускорения внедрения ИИ и гибридного облакаОператор дата-центров Digital Realty объявил об открытии лаборатории инноваций DRIL (Digital Realty Innovation Lab) — специализированной тестовой площадки, призванной ускорить внедрение ИИ и гибридного облака. Партнёрами в рамках данного проекта являются Lenovo, AMD, Cisco и CommScope, которые предоставляют различные аппаратные и инфраструктурные решения. Отмечается, что ИИ оказывает преобразующее влияние на самые разные отрасли. Однако при его масштабном развёртывании предъявляются высокие требования к инфраструктуре ЦОД в плане обеспечения необходимой производительности при одновременной оптимизации энергопотребления. Площадка DRIL призвана помочь компаниям в создании сложных архитектур, ориентированных на ресурсоёмкие задачи ИИ. DRIL предоставляет партнёрам и клиентам полностью поддерживаемую реальную тестовую среду для апробации ИИ-развёртываний и гибридных облачных сред перед их масштабированием. Компании могут запускать собственные рабочие нагрузки с целью проверки эффективности и оптимизации.

Источник изображения: Digital Realty Лаборатория DRIL сформирована на базе кампуса Digital Realty в Северной Вирджинии. На площадке, оснащённой серверами с процессорами AMD EPYC и ускорителями AMD Instinct, могут тестироваться рабочие нагрузки ИИ и HPC. Говорится о высокоплотном размещением оборудования — свыше 150 кВт на серверную стойку. Задействована технология прямого жидкостного охлаждения (DLC) Lenovo Neptune. Лаборатория DRIL, как подчёркивается, позволяет компаниям раскрыть весь потенциал ИИ и корпоративных рабочих нагрузок, даже если у них нет собственного дата-центра с современным оборудованием. Используя DRIL, клиенты могут снизить риски, оптимизировать конфигурацию своих систем и ускорить переход от этапа проверки концепции к фактическому внедрению. Предприятия могут тестировать различные сценарии задержек в разных локациях, оценивать требования к питанию, охлаждению и GPU-ресурсам, а также управлять ИИ-нагрузками.

12.09.2025 [11:29], Сергей Карасёв

PCIe по оптике: Macom представила чипсет, увеличивающий длину соединений PCIe 6.0 до 100 мКомпания Macom Technology Solutions анонсировала новый чипсет, который, как утверждается, позволяет преодолеть существующие ограничения по длине соединений PCIe 6.0 и CXL (Compute Express Link). Изделие обеспечивает возможность высокоскоростной передачи данных с малой задержкой на большие расстояния по паре оптических волокон. Чипсет объединяет трансимпедансный усилитель (TIA) MATA-38794 и драйвер VCSEL MALD-38795. Достигается скорость передачи данных в 64 Гбит/с (PAM4) по восьми линиям PCIe. Протяженность соединений PCIe 6.0 при использовании многомодового оптоволоконного кабеля составляет до 100 м. Подчёркивается, что компоненты MATA-38794 и MALD-38795 обеспечивают масштабируемое и прозрачное подключение посредством PCIe, отвечающее требованиям современных вычислительных сред. Кроме того, новое изделие поддерживает передачу по дополнительному оптоволокну критически важных сигналов, включая сигналы синхронизации, сброса и пробуждения, а также USB и Ethernet. Это, как подчёркивается, «обеспечивает полную прозрачность шины PCIe на больших расстояниях». Чипсет предназначен для формирования платформ дезагрегированных вычислений для задач ИИ и НРС. В отличие от традиционных серверных архитектур, основанных на интегрированном оборудовании и многоуровневых сетевых протоколах, дезагрегированные системы используют оптический интерконнект для прямого подключения ресурсов. Благодаря этому снижается задержка, уменьшается энергопотребление и достигается гибкое масштабирование. Интерфейс PCIe позволяет формировать высокоскоростные соединения типа GPU–GPU и CPU–память.

12.09.2025 [07:26], Сергей Карасёв

Kioxia и NVIDIA разрабатывают SSD нового типа для ИИ-систем в качестве альтернативы HBMКомпании Kioxia и NVIDIA, по сообщению Nikkei, разрабатывают SSD нового типа для ИИ-систем, которые по показателю IOPS (операций ввода/вывода в секунду) будут превосходить современные изделия практически в 100 раз. Предполагается, что такие устройства смогут стать альтернативой HBM при расширении памяти ИИ-ускорителей. Коити Фукуда (Koichi Fukuda), главный инженер подразделения твердотельных накопителей Kioxia, рассказал, что компания проектирует устройства в соответствии с требованиями NVIDIA. Речь идёт об SSD следующего поколения с интерфейсом PCIe 7.0. Предполагается, что такие изделия смогут демонстрировать показатель IOPS на уровне 100 млн, что позволит применять их в том числе для ИИ-инференса. Более того, NVIDIA стремится к достижению значения IOPS в 200 млн. Такого результата Kioxia рассчитывает добиться путём объединения в массив двух SSD нового типа. Особенностью этих накопителей станет то, что они смогут обмениваться данными с GPU напрямую, не вовлекая в эти операции CPU, как в случае с традиционными решениями. Пробные поставки устройств планируется организовать во II половине 2026 года, тогда как на коммерческом рынке накопители нового типа могут появиться в 2027-м. Согласно прогнозам Kioxia, к 2029 году почти половина спроса на NAND-память, которая применяется в SSD, будет связана с системами ИИ. Участники рынка также говорят о возобновлении инвестиций в разработку NAND-продуктов после двухлетнего затишья. Восстановление активности среди производителей объясняется растущей потребностью в высокоскоростных накопителях большой вместимости с высокими показателями быстродействия при произвольном доступе. Одним из перспективных направлений названо создание решений на основе флеш-памяти с высокой пропускной способностью HBF (High Bandwidth Flash): разработки в данной сфере, в частности, ведёт SanDisk.

12.09.2025 [00:44], Владимир Мироненко

Intel покидает уже второй по счёту главный архитектор Xeon в этом годуРесурсу CRN стало известно о предстоящем уходе из Intel в конце этого месяца Ронака Сингхала (Ronak Singhal), который стал уже вторым главным архитектором процессоров Xeon, покинувшим компанию за последние восемь месяцев после ухода в январе Сайлеша Коттапалли (Sailesh Kottapalli) в Qualcomm. Intel подтвердила CRN, что Сингхал покидает компанию. Уход Сингхала ресурс связывает с назначением Кеворка Кечичяна (Kevork Kechichian) главой Группы ЦОД (DCG) в рамках реорганизации компании, проводимой гендиректором Лип-Бу Таном (Lip-Bu Tan). В последнее время Сингхал руководил реализацией технологической стратегии и управлением продуктами в разрезе серверных процессоров Xeon. Ответственность Сингхалпа также распространялась на разработку платформ и множества сопутствующих технологий, касающихся памяти, безопасности и ИИ в Xeon. Ранее Сингхал руководил разработкой серверной архитектуры Haswell и Broadwell, последний из которых, по его словам, стал первым 14-нм серверным чипом компании. Он также возглавлял разработку IP-блоков для процессоров Xeon, Core и Atom.

Источник изображения: Intel В конце июля Тан сообщил сотрудникам, что компания «сосредоточена на восстановлении» доли рынка серверных процессоров, наращивая выпуск чипов Granite Rapids, а также «расширяя возможности для нагрузок гиперскейлеров». Как отметил финансовый директор Дэвид Цинснер (David Zinsner), линейка серверных продуктов Diamond Rapids, запуск которой запланирован на следующий год, «не даёт желаемого результата». По его словам, следующее поколение — Coral Rapids — является «реальной возможностью», которая позволит Intel «сделать действительно большой шаг вперёд».

11.09.2025 [23:19], Владимир Мироненко

Nebius привлекла $3,75 млрд после заключения контракта с MicrosoftПоставщик облачных решений для ИИ Nebius (бывшая материнская структура «Яндекса» Yandex N.V.) привлёк $3,75 млрд благодаря размещению конвертируемых облигаций и продаже акций. Ранее сообщалось, что компания намерена увеличить капитальные затраты в 2025 году. В ходе размещения компания увеличила предложение конвертируемых ценных бумаг с первоначально объявленной суммы $2,0 млрд до $2,75 млрд, распределив её поровну между двумя траншами по $1,375 млрд в рамках закрытого предложения квалифицированным институциональным покупателям в соответствии с Правилом 144A Закона о ценных бумагах 1933 года. Первый транш со ставкой купона 1,0 % должен быть погашен в 2030 году, второй со ставкой купона 2,75 % подлежит погашению в 2032 году. Цена конвертации облигаций составляет $138,75 за единицу, что соответствует 50-% премии к цене их размещения. Также было продано акций класса А по цене $92,5 за единицу на сумму $1,0 млрд. Согласно пресс-релизу Nebius, привлечённые средства будут использованы «для финансирования дальнейшего роста бизнеса, включая приобретение дополнительных вычислительных мощностей и оборудования, приобретение стратегически важных высококачественных и удобно расположенных земельных участков у надежных поставщиков, расширение сети своих центров обработки данных, а также для общих корпоративных целей». Привлечение средств Nebius последовало после заключения крупного контракта с Microsoft на предоставление технологическому гиганту в течение пяти лет доступа к выделенной ИИ-инфраструктуре в новом ЦОД в Винеленде (Vineland) в Нью-Джерси (на изображении выше). Стоимость контракта составляет $17,4 млрд с возможностью увеличения суммы сделки до $19,4 млрд за счёт увеличения предоставляемых мощностей и услуг. О планах Nebius по созданию ЦОД в Нью-Джерси, который теперь будет по крайней мере частично сдан в аренду Microsoft, стало известно в марте. Первоначальная мощность ЦОД составляет 300 МВт с возможностью расширения ещё на 400 МВт. Также у компании есть площадки в Финляндии, где она в прошлом году пообещала увеличить мощность до 75 МВт, и во Франции. Как сообщает Datacenter Dynamics, компания также развёртывает кластеры в ЦОД Patmos в Канзас-Сити (штат Миссури), в ЦОД Verne Global в Исландии, в ЦОД Ark в Великобритании и на новом объекте в Израиле.

11.09.2025 [18:04], Сергей Карасёв

В облаке Astra Cloud появились выделенные серверы с процессорами Baikal-SОблачный провайдер «Астра Облако» (Astra Cloud), входящий в «Группу Астра», и российский производитель микроэлектроники «Байкал Электроникс» объявили о запуске сервиса аренды выделенных серверов, оснащённых отечественными процессорами Baikal-S. Предложение ориентировано в том числе на объекты критической информационной инфраструктуры (КИИ). Чипы Baikal-S (BE-S1000) содержат 48 ядер Arm Cortex-A75, поддерживают память DDR4-3200 МГц (6 каналов, до 128 Гбайт на канал), имеют 80 линий PCIe 4.0 и два интерфейса 1GbE. Заявленное энергопотребление находится на уровне 120 Вт. Серверы расположены в московском дата-центре с надёжностью Tier IV, что гарантирует максимальную отказоустойчивость инфраструктуры. На таких объектах дублируются и основные, и дополнительные системы, а показатель доступности достигает 99,995 %. Время простоя не превышает 26 минут в год. Сервис аренды серверов на базе Baikal-S ориентирован на заказчиков, которым необходимо отладить и адаптировать своё ПО под отечественную архитектуру. Помимо предприятий КИИ, это могут быть государственные организации, корпоративные заказчики и пр. Благодаря арендной модели аппаратные ресурсы полностью закрепляются за клиентом. Это, как утверждается, обеспечивает предсказуемую производительность приложений и высокий уровень защиты данных. Среди других преимуществ нового сервиса названы возможность формирования частных облаков и отказоустойчивых кластеров, гибкость в настройке систем под индивидуальные потребности, отсутствие капитальных затрат на покупку и обслуживание оборудования, технологическая независимость от зарубежных платформ. «Запуск аренды выделенных серверов на процессорах Baikal-S — это важный шаг в развитии отечественной IT-сферы. Мы даём бизнесу и государственным структурам доступ к надёжной, предсказуемой и безопасной платформе для построения частных облаков и работы с критичными нагрузками», — говорит технический директор «Группы Астра». |

|