Материалы по тегу: энергоэффективность

|

02.02.2026 [23:44], Андрей Крупин

Экология в приоритете: проект энергоэффективного ЦОД МТС получил прописку в федеральном реестре углеродных единицКомпания «Мобильные ТелеСистемы» сообщила о регистрации проекта «Строительство ЦОД с энергоэффективной системой охлаждения на площадке ПАО "МТС"» в российском национальном реестре углеродных единиц. Проект энергоэффективного дата-центра реализован МТС на территории модульного ЦОД в Тосненском районе Ленинградской области. В основе проектного решения лежит использование энергоэффективной адиабатической системы охлаждения для сокращения показателей удельного потребления энергоресурсов на единицу произведённого холода. Ожидается, что в перспективе до 2032 года проект позволит сократить выбросы парниковых газов совокупным объёмом 1375 тонн СО2-эквивалента. «Ленинградский модульный ЦОД МТС — первый климатический проект в российской телеком-отрасли. Согласно углеродной стратегии, наша цель — снижение углеродоемкости на 60 % к 2030 году по сравнению с 2021 годом, и мы рассчитываем, что тиражирование строительства современных ЦОД повысит энергоэффективность компании за счёт снижения потребления электроэнергии. Регистрация проекта в реестре — важный шаг к достижению стратегических задач МТС в области управления выбросами парниковых газов и углеродного менеджмента», — говорится в заявлении оператора.

31.01.2026 [21:37], Сергей Карасёв

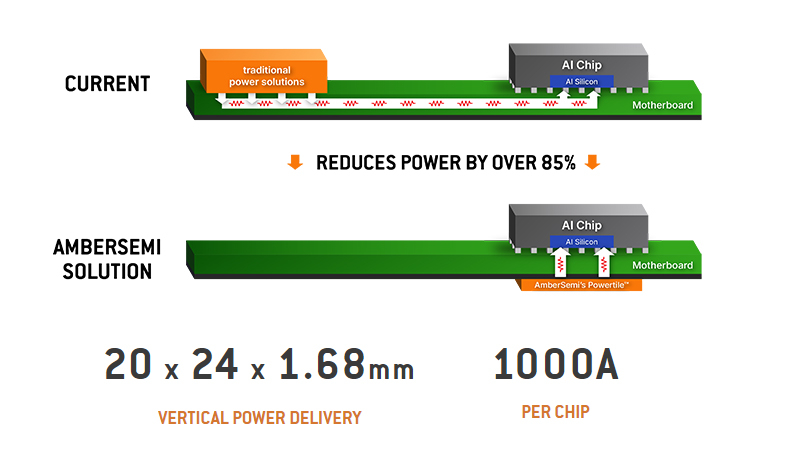

10 тыс. ампер на ускоритель: AmberSemi представила чип питания PowerTile для повышения энергоэффективности ИИ ЦОДКалифорнийская компания AmberSemi, специализирующаяся на разработке полупроводниковых изделий, сообщила о создании нового чипа управления питанием под названием PowerTile для дата-центров, ориентированных на ресурсоёмкие задачи ИИ. Решение PowerTile представляет собой конвертер DC-DC, предназначенный для использования с мощными современными процессорами. Новинка монтируется на обратной стороне системной платы непосредственно под компонентом, на который подаётся питание. AmberSemi заявляет, что благодаря такой вертикальной схеме потери мощности сокращаются более чем на 85 % по сравнению с традиционным боковым распределением питания. В результате, значительно повышается эффективность и улучшается масштабируемость ИИ-систем. Изделие PowerTile имеет размеры 20 × 24 × 1,68 мм. Чип способен подавать до 1000 А на CPU, GPU, FPGA или другие компоненты с высоким энергопотреблением. В системе могут быть задействованы несколько экземпляров PowerTile, что обеспечивает возможность наращивания тока до 10 000 А и более. Благодаря небольшой толщине может быть использовано жидкостное охлаждение.

Источник изображений: AmberSemi По оценкам AmberSemi, для ИИ ЦОД мощностью 500 МВт решение PowerTile может сэкономить до 225 МВт, что эквивалентно $160 млн/год. Компания сравнивает это с приблизительной годовой выработкой энергии малым модульным ядерным реактором. AmberSemi подчёркивает, что чип PowerTile разработан с учётом будущих архитектур дата-центров для ИИ, поскольку мощность таких объектов постоянно увеличивается.  Тар Кейси (Thar Casey), генеральный директор AmberSemi, отмечает, что существующие архитектуры питания с трудом справляются с быстро растущими потребностями ИИ-платформ. Это создаёт узкое место, ограничивающее дальнейшее наращивание производительности систем. PowerTile открывает путь для решения проблемы. AmberSemi планирует организовать тестирование изделия совместно с ключевыми партнёрами в конце текущего года. Поставки первых серийных образцов PowerTile начнутся в 2027-м.

18.12.2025 [16:20], Сергей Карасёв

IXcellerate разработала собственное решение для эффективного охлаждения высоконагруженных ЦОДРоссийский оператор коммерческих дата-центров IXcellerate сообщил о разработке передового решения для охлаждения высоконагруженных машинных залов. Компания уже получила патент на изобретение, которое прошло независимую экспертизу Федеральной службы по интеллектуальной собственности. Целью исследовательского проекта являлось создание технологии для увеличения мощности системы кондиционирования при неизменной площади помещения. При этом требовалось решить проблемы неравномерного распределения воздуха, обеспечив возможность размещать стойки в любой точке машинного зала без изменения конфигураций инженерных систем. В процессе разработки специалисты использовали CFD-инструменты. В результате, была получена специальная формула для расчёта объёма расходуемого воздуха, температурного режима и суммарной площади теплообменников для оптимального подбора мощности и количества вентиляторов. Формула позволила сконструировать новую воздухоохладительную камеру статического давления: она обеспечивает равномерное распределение воздушных потоков на все теплообменные аппараты. Инновационное решение внедрено в действующих машинных залах Южного кампуса IXcellerate с общей нагрузкой более 30 МВт. По заявлениям компании, применённая технология обеспечивает ряд преимуществ по сравнению с другими системами. В частности, благодаря оптимизации повышена энергоэффективность ЦОД и снижено потребление электроэнергии. Количество стойко-мест удалось увеличить на 15 % при сохранении прежней площади машинного зала. Исключены риски перегрева высоконагруженного IT-оборудования. Кроме того, достигнут оптимальный температурный график теплоносителя, благодаря чему дата-центр работает в энергосберегающем режиме фрикулинга. Разработка новой технологии особенно важна в свете сформировавшейся геополитической обстановки, из-за которой поставки импортной продукции в Россию ограничены. Предложенное решение позволяет поддерживать параметры климата по стандарту ASHRAE, обеспечивает отказоустойчивость и сервисное обслуживание оборудования без перерывов на ремонты. Система подходит для любых дата-центров и помещений с серверным оборудованием.

12.12.2025 [21:35], Руслан Авдеев

Крошечные чипы для гигантской экономии: PowerLattice пообещала удвоить производительность ИИ-ускорителей на ваттЕсли энергоснабжение организовано неэффективно, на обеспечение работы ИИ-ускорителя мощностью 700 Вт может понадобиться и 1700 Вт. Решить это проблему поможет стартап PowerLattice, который миниатюризировал и переупаковал высоковольтные регуляторы, сообщает IEEE Spectrum. В компании утверждают, что её новые чиплеты позволяют снизить реальное энергопотребление наполовину, удвоив таким образом производительность на ватт. Чиплеты можно разместить максимально близко к вычислительным кристаллам. Традиционные системы питания ИИ-чипов преобразуют переменный ток из сети в постоянный, а затем понижают напряжение до уровня, подходящего ускорителям (порядка 1 В). При значительном падении напряжения сила тока на финальном участке пути к чипу резко возрастает для сохранения нужного уровня мощности. Именно здесь и происходят существенные энергопотери и тепловыделение, которые можно снизить, разместив питающую электронику как можно ближе к потребителю — на расстоянии в несколько миллиметров, а не сантиметров, т.е. буквально внутри чипа. PowerLattice упаковала все необходимые компоненты в один чиплет размеров с пару ластиков, которые ставятся на карандаши. Чиплеты располагаются под подложкой корпуса вычислительного чипа. Одной из ключевых задач было уменьшение индукторов, помогающих поддерживать стабильное выходное напряжение. Пришлось применять специальный магнитный сплав, позволяющий очень эффективно использовать пространство, работая на высоких частотах, в сто раз выше, чем при использовании традиционного варианта. Уникальность решения в том, что сплав сохраняет лучшие магнитные свойства на высоких частотах, чем сопоставимые материалы. Утверждается, что полученные чиплеты более чем в 20 раз компактнее по площади, чем современные стабилизаторы. При этом толщина каждого из них составляет всего 100 мкм, что сопоставимо с толщиной волоса. Такие чиплеты действительно можно размещать очень близко к кристаллам процессора. При этом заказчики могут использовать несколько чиплетов в зависимости от прожорливости и требований конкретных чипов. Энергорасход можно снизить на 50 %, обещает компания, но эксперты пока сомневаются в этом — для достижения такого уровня экономии нужно динамическое управление электропитанием в режиме реального времени в зависимости от текущей нагрузки, что с решением PowerLattice может быть недостижимо. Сейчас PowerLattice тестирует свой продукт на надёжность, а первые клиенты получат чиплеты приблизительно через два года. Intel тоже работает над модулем Fully Integrated Voltage Regulator, которая тоже помогает решить похожие проблемы. В самом стартапе Intel в качестве конкурента не рассматривается, поскольку подход у компаний разный, кроме того, Intel вряд ли будет предлагать свои решения конкурирующим производителям чипов. Эксперты утверждают, что ещё 10 лет назад у компании не было шансов на успех, поскольку поставщики процессоров давали гарантию на них только при покупке их же модулей питания. Например, Qualcomm продавала свои чипсеты только вкупе с чипами управления питанием её же производства. Однако сейчас всё чаще практикуется гетерогенный подход, когда заказчики комбинируют компоненты разных компаний для оптимизации своих систем. Хотя поставщики уровня Intel и Qualcomm, вероятно, будут иметь фору при работе с крупными клиентами, более мелкие разработчики чипов и ИИ-инфраструктуры, возможно, будут искать альтернативные модули управления электропитанием.

12.12.2025 [17:21], Руслан Авдеев

Никаких закладок: NVIDIA анонсировала новое ПО для мониторинга и продления жизни ИИ-ускорителей в ЦОД

dcim

nvidia

open source

software

амортизация

ии

мониторинг

охлаждение

цод

электропитание

энергоэффективность

NVIDIA разрабатывает новое открытое ПО, благодаря которому операторы ЦОД смогут получать более подробные данные о тепловом состоянии и иных параметрах работы ИИ-ускорителей. Предполагается, что это поможет решать проблемы, связанные с перегревом оборудования и его надёжностью, увеличив его срок службы и производительность. NVIDIA отдельно подчёркивает, что телеметрия собирается только в режиме чтения без слежки за оборудованием, а в ПО нет «аварийных выключателей» и бэкдоров. Да и в целом использование новинки опционально. ПО обеспечивает операторам ЦОД доступ к мониторингу потребления энергии, загрузки, пропускной способности памяти и других ключевых параметров в масштабах всего парка ускорителей. Это помогает выявлять на ранних стадиях риски и проблемные компоненты и условия работы, отслеживать использование ИИ-ускорителей, их конфигурации и ошибки. Детализированная телеметрия становится всё важнее для планирования и управления масштабными инфраструктурами, говорит компания. ПО позволит:

Такой мониторинг особенно важен на фоне недавнего отчёта учёных Принстонского университета, в котором сообщается, что интенсивные тепловые и электрические нагрузки способны сократить срок службы ИИ-чипов до года-двух, хотя обычно предполагается, что они способны стабильно проработать до трёх лет. Современные ускорители потребляют 700 Вт и более, а высокоплотные системы — от 6 кВт. Из-за этого формируются зоны перегрева, происходят колебания энергопотребления и растёт риск деградации интерконнектов в высокоплотных стойках. Телеметрия, позволяющая оценить потребление энергии в реальном времени, состояние интерконнектов, систем воздушного охлаждения и др. позволяет перейти от реактивного мониторинга к проактивному проектированию. Рабочие нагрузки можно размещать с учётом теплового режима, быстрее внедрять СЖО или гибридные системы охлаждения, оптимизировать работу сетей с уменьшением тепловыделения. Также ПО может помочь операторам ЦОД выявлять скрытые ошибки, вызванные несоответствием версий прошивки или драйверов. Благодаря этому можно повысить общую стабильность парка ускорителей. Кроме того, без задержек передаваемые данные об ошибках и состоянии компонентов могут значительно сократить среднее время восстановления работы и упростить анализ причин сбоев. Соответствующие данные могут влиять на решения о тратах на инфраструктуру и стратегию её развития на уровне предприятия.

Источник изображения: NVIDIA Как заявляют в Gartner, современный ИИ представляет собой «энергоёмкого и сильно нагревающегося монстра», разрушающего экономику и принципы работы ЦОД. В результате, предприятиям нужны специальные инструменты мониторинга и управления для того, чтобы ситуация не вышла из-под контроля. В ближайшие годы использование подобных решений, вероятно, станет обязательным. Кроме того, прозрачность на уровне всего парка оборудования становится необходимой для обоснования роста бюджетов на ИИ-инфраструктуру. По словам экспертов, такие программные инструменты позволяют оптимизировать капитальные и операционные затраты на ЦОД и инфраструктуру, запланированные на ближайшие годы. «Каждый доллар и каждый ватт» должны быть учтены при эффективном использовании ресурсов.

13.10.2025 [00:30], Владимир Мироненко

Вложи $5 млн — получи $75 млн: NVIDIA похвасталась новыми рекордами в комплексном бенчмарке InferenceMAX v1

b200

gb200

hardware

nvidia

open source

semianalysis

бенчмарк

ии

инференс

рекорд

финансы

энергоэффективность

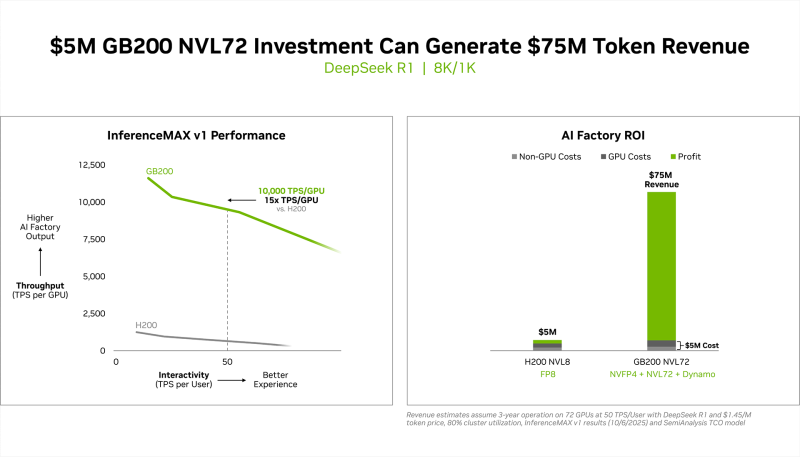

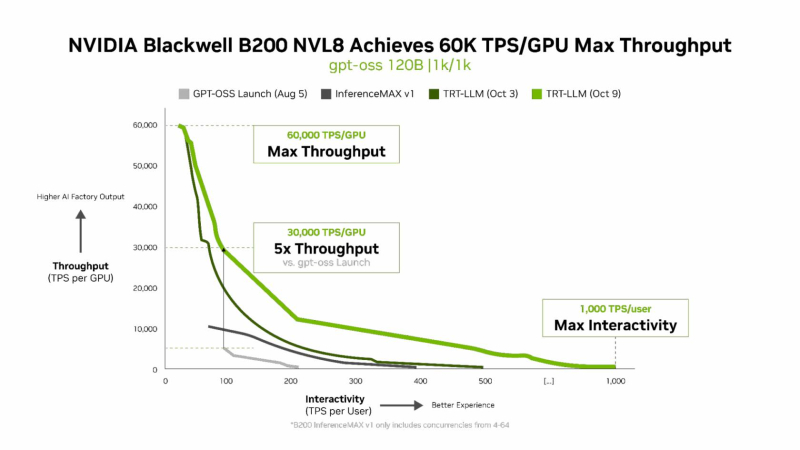

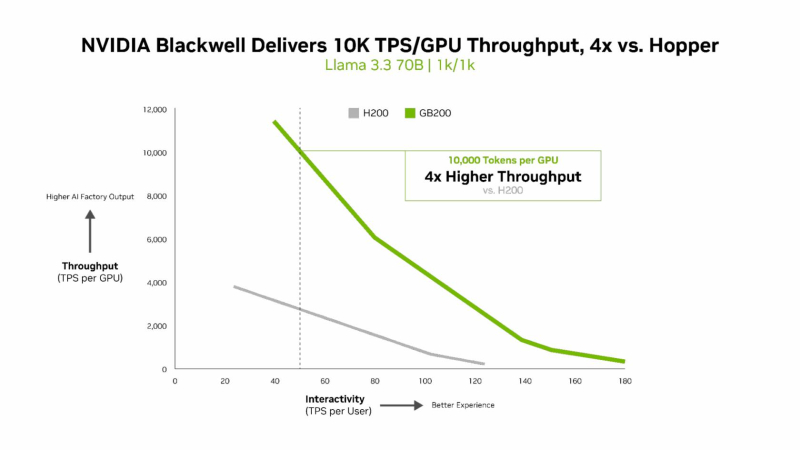

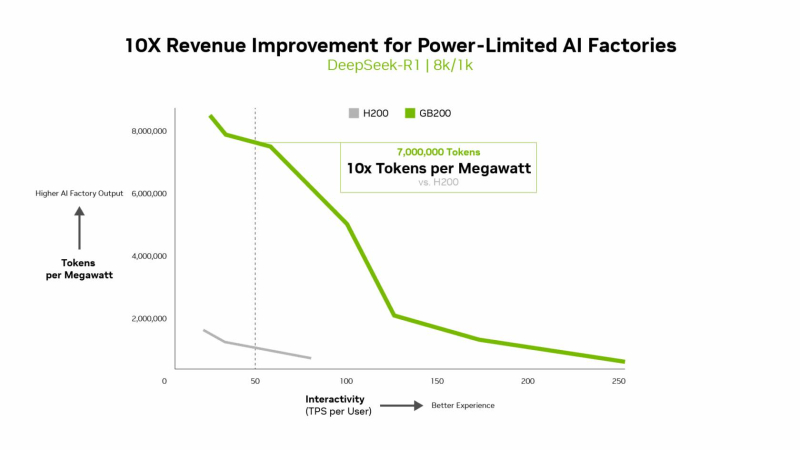

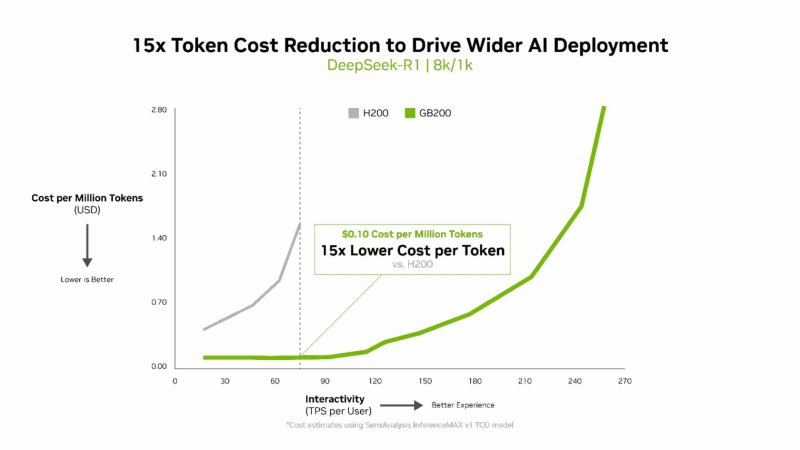

NVIDIA сообщила о результатах, показанных суперускорителем GB200 NVL72, в новом независимом ИИ-бенчмарке InferenceMAX v1 от SemiAnalysis. InferenceMAX оценивает реальные затраты на ИИ-вычисления, определяя совокупную стоимость владения (TCO) в долларах на миллион токенов для различных сценариев, включая покупку и владение GPU в сравнении с их арендой. InferenceMAX опирается на инференс популярных моделей на ведущих платформах, измеряя его производительность для широкого спектра вариантов использования, а результаты может перепроверить любой желающий, говорят авторы бенчмарка. Суперускоритель GB200 NVL72 победил во всех категориях бенчмарка InferenceMAX v1. Чипы NVIDIA Blackwell показали наилучшую окупаемость инвестиций — вложение в размере $5 млн приносят $75 млн дохода от токенов DeepSeek R1, обеспечивая 15-кратную окупаемость (год назад NVIDIA обещала ROI на уровне 700 %). Также ускорители поколения Blackwell отличаются самой низкой совокупной стоимостью владения. например, оптимизация ПО NVIDIA B200 позволила добиться стоимости всего в два цента на миллион токенов на OpenAI gpt-oss-120b, обеспечив пятикратное снижение стоимости одного токена всего за два месяца. NVIDIA B200 первенствовал и по пропускной способности и интерактивности, обеспечив 60 тыс. токенов в секунду на ускоритель и 1 тыс. токенов в секунду на пользователя в gpt-oss с новейшим стеком NVIDIA TensorRT-LLM. NVIDIA сообщила, что постоянно повышает производительность путём оптимизации аппаратного и программного стека. Первоначальная производительность gpt-oss-120b на системе NVIDIA DGX Blackwell B200 с библиотекой NVIDIA TensorRT LLM уже была лидирующей на рынке, но команды NVIDIA и сообщество разработчиков значительно оптимизировали TensorRT LLM для ускорения исполнения открытых больших языковых моделей (LLM). Компания отметила, что выпуск TensorRT LLM v1.0 стал значительным прорывом в повышении скорости инференса LLM благодаря распараллеливанию и оптимизации IO-операций. А у недавно вышедшей модели gpt-oss-120b-Eagle3-v2 используется спекулятивное декодирование — интеллектуальный метод, позволяющий предсказывать несколько токенов одновременно. Это уменьшает задержку и обеспечивает получение ещё более быстрых результатов — пропускная способность выросла втрое, до 100 токенов в секунду на пользователя (TPS/пользователь), а общая производительность на ускоритель выросла с 6 до 30 тыс. токенов. Для моделей с «плотной» архитектурой (Dense AI), таких как Llama 3.3 70b, которые требуют значительных вычислительных ресурсов из-за большого количества параметров и одновременного использования всех параметров в процессе инференса, NVIDIA Blackwell B200 достиг нового рубежа производительности в бенчмарке InferenceMAX v1, отметила NVIDIA. Суперускоритель показал более 10 тыс. токенов/с (TPS) на GPU при 50 TPS на пользователя, т.е. вчетверо более высокую пропускную способность на GPU по сравнению с NVIDIA H200. NVIDIA подчеркнула, что такие показатели, как количество токенов на Вт, стоимость на миллион токенов и TPS/пользователь не уступают по важности пропускной способности. Фактически, для ИИ-фабрик с ограниченной мощностью ускорители с архитектурой Blackwell обеспечивают до 10 раз лучшую производительность на МВт по сравнению с предыдущим поколением и позволяют получать более высокий доход от токенов. Компания отметила, что стоимость обработки одного токена (Cost per Token) имеет решающее значение для оценки эффективности ИИ-модели и напрямую влияет на эксплуатационные расходы. NVIDIA утверждает, что в целом архитектура NVIDIA Blackwell позволила снизить стоимость обработки миллиона токенов в 15 раз по сравнению с предыдущим поколением. В InferenceMAX используется метод оценки эффективности Pareto front, определяющий наилучшее (компромиссное) сочетание различных факторов для оценки производительности ускорителя. Это показывает, насколько Blackwell лучше конкурентов справляется с балансом стоимости, энергоэффективности, пропускной способности и скорости отклика. Системы, оптимизированные только для одной метрики, могут демонстрировать пиковую производительность «в вакууме», но такая «экономика» не масштабируется в производственных средах. Компания отметила, что ИИ переходит от экспериментальных пилотных проектов к ИИ-фабрикам — инфраструктуре, которая производит интеллектуальные решения, преобразуя данные в токены и решения в режиме реального времени. Фреймворк NVIDIA Think SMART помогает предприятиям ориентироваться в этом переходе, демонстрируя, как полнофункциональная платформа инференса обеспечивает измеримую окупаемость инвестиций. Обещая 15-кратную окупаемость инвестиций и непрерывный рост производительности за счёт ПО, NVIDIA не просто лидирует в текущей гонке ИИ-технологий, но и задаёт правила для следующего этапа, где экономика будет определять победителей рынка, пишет The Tech Buzz. Для предприятий, делающих ставку на конкурирующие платформы в своих стратегиях по развёртыванию ИИ, результаты таких бенчмарков должны побудить к пересмотру выбора ИИ-инфраструктуры.

06.07.2025 [00:44], Владимир Мироненко

Esperanto, создатель уникального тысячеядерного RISC-V-ускорителя, закрывается — всех инженеров переманили крупные компанииСтартап Esperanto, специализирующийся на разработке серверных ускорителей на базе архитектуры RISC-V, сворачивает свою деятельность, сообщил ресурс EE Times. В настоящее время компания, которую уже покинуло большинство сотрудников, ищет покупателя на свои технологии или заинтересованных в лицензировании её разработок. Компания известна созданием тысячеядерного ИИ-ускорителя ET-SoC-1. Генеральный директор Esperanto Арт Свифт (Art Swift) сообщил EE Times о закрытии дочерних предприятий в Европе — у неё была значительная инженерная команда в Испании и ещё одна небольшая в Сербии. В штаб-квартире Esperanto в Маунтин-Вью (Калифорния) численность персонала сократилась на 90 %. Свифт и еще несколько инженеров остались, чтобы продать или лицензировать разработки компании и содействовать любой потенциальной передаче технологий. По словам Свифта, компания подверглась атаке со стороны богатых конкурентов, которые предлагали зарплату «в два, три, даже в четыре раза выше», чем могла предложить небольшая Esperanto. «Они фактически уничтожили наши команды — очень жаль, но мы не смогли конкурировать с ними», — говорит Свифт, отмечая, что уже несколько компаний проявило интерес к приобретению технологии или её лицензированию на неисключительной основе. Он добавил, что у Esperanto был крупный клиент, которому есть что предложить, что добавляет оптимизма. Ранее компания, судя по всему, пыталась предложить свои чипы Meta✴.

Источник изображения: Esperanto Technologies Интерес рынка к RISC-V для чипов ЦОД остаётся высоким, особенно в Европе, где инвестирует в новую экосистему чипов на основе RISC-V. Вместе с тем именно ключевое преимущество разработок Esperanto — энергоэффективность — оказалось труднореализуемым, говорит гендиректор: «При неограниченном бюджете на электроэнергию энергоэффективность на самом деле не имеет значения». Esperanto готовила к выпуску чиплет второго поколения, который должен был поступить в производство на мощностях Samsung по 4-нм техроцессу в 2026 году. Чиплет предложил бы до 16 Тфлопс в FP64-вычислениях или до 256 Тфлопс в FP8-расчётах при потреблении 15–60 Вт. В один чип можно объединить до восьми чиплетов. Третье поколение технологии удвоило бы вычислительную мощность чиплетов. «Компании действительно были заинтересованы в получении этой технологии, так что посмотрим», — говорит Свифт. В прошлом году Esperanto договорилась с корпорацией NEC о сотрудничестве в области НРС с целью создания программных и аппаратных решений следующего поколения с архитектурой RISC-V. Также сообщалось о разработке чипа ET-SoC-2 для НРС и ИИ-задач. На пике развития штат Esperanto составлял 140 человек. По словам Свифта, 95 % бывших сотрудников стартапа уже нашли новую работу. В аналогичной ситуации оказалась Codasip, объявившая о готовности продать свои активы, поскольку обострение конкуренции на рынке RISC-V и отсутствие достаточного запаса средств ограничивают возможности небольших компаний, которые зачастую не могут конкурировать с IT-гигантами. ИИ-стартап Untether AI тоже провалил тест на выживание, объявив о закрытии бизнеса после того, как AMD переманила ряд его ведущих специалистов.

03.07.2025 [15:01], Руслан Авдеев

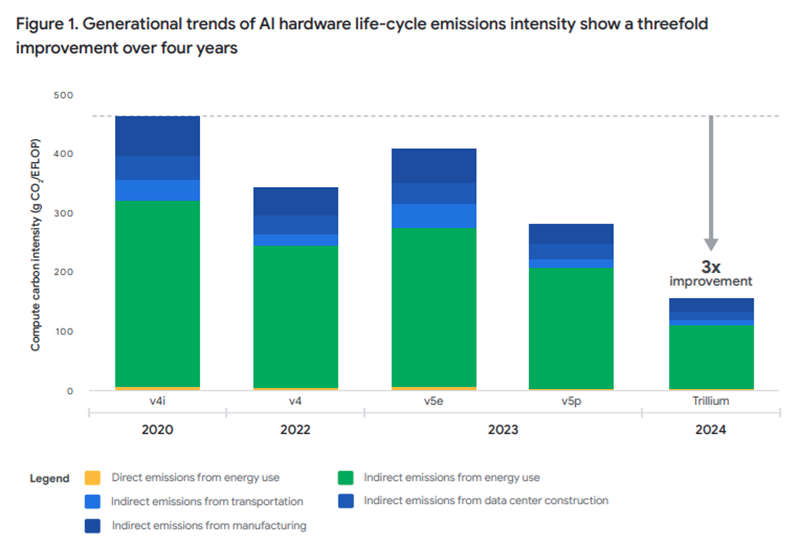

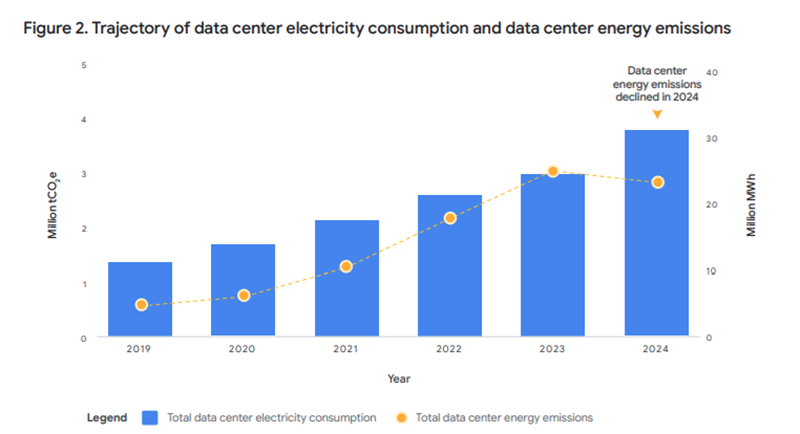

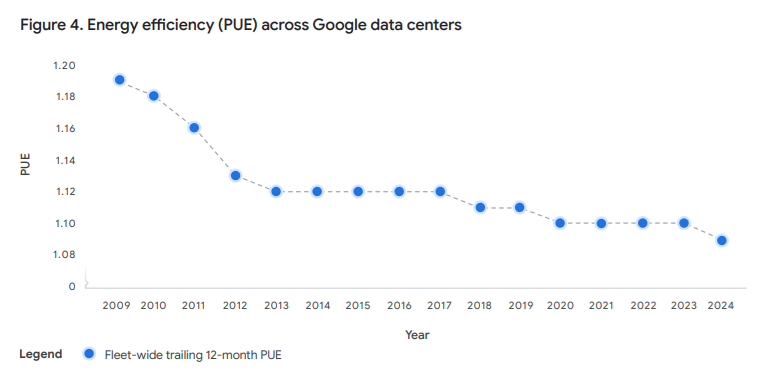

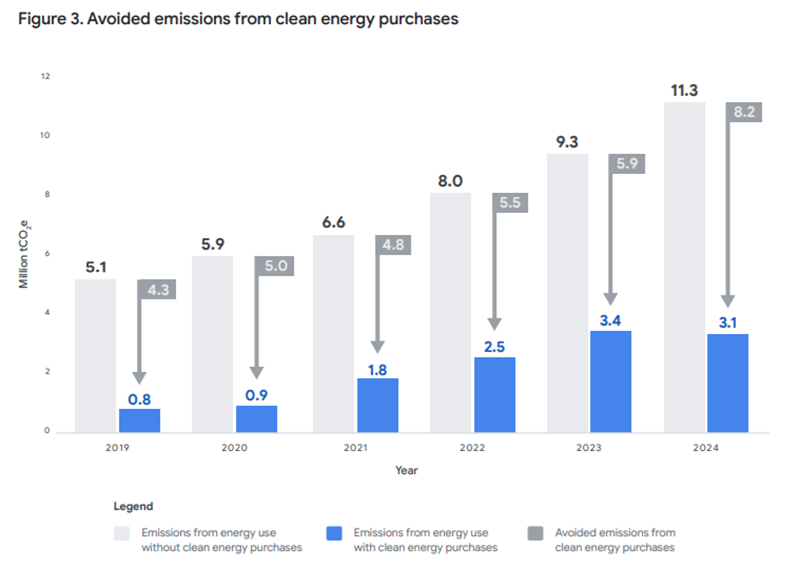

Из-за ИИ дата-центры Google резко нарастили энергопотребление, но их PUE всё равно снизилсяВ Google связывают будущее искусственного интеллекта со своей климатической стратегией. В компании заявили о намерении обеспечить энергоснабжение ИИ «чистым» электричеством на фоне растущего энергопотребления глобальных проектов гиперскейлера, сообщает eWeek. Как свидетельствует десятый отчёт Google Environmental Report, в 2024 году выбросы ЦОД, связанные с энергетикой, снизились на 12 % при росте энергопотребления на 27 %. Прогресс в Google объясняют долгосрочными контрактами на поставки «чистой» энергии и повышением энергоэффективности — это помогает компенсировать негативные экологические эффекты от развития ИИ. Компания даже смогла впервые за шесть лет снизить среднегодовой PUE дата-центров с 1,10 до 1,09. По данным Google, компания значительно расширила применение «чистой» энергии, подписав крупнейший в своей истории пакет контрактов на её поставку. Речь идёт о 8 ГВт новых мощностей, вдвое больше в сравнении с 2023 годом. Также было введено в эксплуатацию 2,5 ГВт по более ранним контрактам.

Источник изображений: Google Положительная динамика отмечается и на региональном уровне. В девяти регионах более 80 % электричества поступает от безуглеродных источников, а общемировой средний показатель достиг 66 % благодаря интеллектуальному перераспределению нагрузки и локализованным закупкам энергии.  Удалось добиться и повышения эффективности оборудования. Последнее поколение чипов компании в 30 раз энергоэффективнее моделей 2018 года. Кроме того, благодаря пяти инструментам Google в 2024 году удалось предотвратить выбросы 26 млн метрических тонн CO₂ — более чем вдвое снизив углеродный след от собственных операций компании.  Несмотря на системные улучшения, общий углеродный след Google в 2024 году увеличился. В отчёте указываются и некоторые проблемы, а также замедление прогресса в ряде направлений. Так, общий объём выбросов вырос из-за активного строительства, выпуска оборудования и деятельности подрядчиков. Выбросы Scope 3, относящиеся к цепочкам поставок и производству, увеличились на 22 % год к году.  При этом в Азиатско-Тихоокеанском регионе уровень использования безуглеродной энергии остаётся на прежнем уровне в 12 %, а в некоторых других странах доля начала даже снижаться из-за ограниченного доступа к возобновляемой энергии. Взрывной рост инфраструктуры заставляет Google пересматривать подход к климатическим обязательствам и энергетике. Компания намерена больше вкладывать в передовые технологии и использовать инновационные схемы закупок энергии.  Например, недавно появилась информация о закупке 200 МВт термоядерной энергии у Commonwealth Fusion Systems — правда, проект ещё далёк от готовности к коммерческому использованию. В целом ожидается более активный переход на безуглеродную энергетику, особенно в регионах с высоким уровнем использования ископаемого топлива (например, в Азии). Представитель Google заявил, что компания совершенствует подход к достижению климатических целей, не снижая темпов развития ИИ на пользу обществу. Обозначенные в отчёте Google проблемы стали отражением общей обеспокоенности индустрии «экологическим следом» искусственного интеллекта. Компании всех масштабов компенсируют выбросы инвестициями в экопроекты (например, сохранение лесов), но эффект от них не так велик и отложен во времени. А в засушливых регионах активисты и власти часто критикуют владельцев дата-центров за высокое потребление чистой воды. Кроме того, эксперты требуют большей прозрачности относительно влияния ИИ на окружающую среду.

27.06.2025 [17:17], Руслан Авдеев

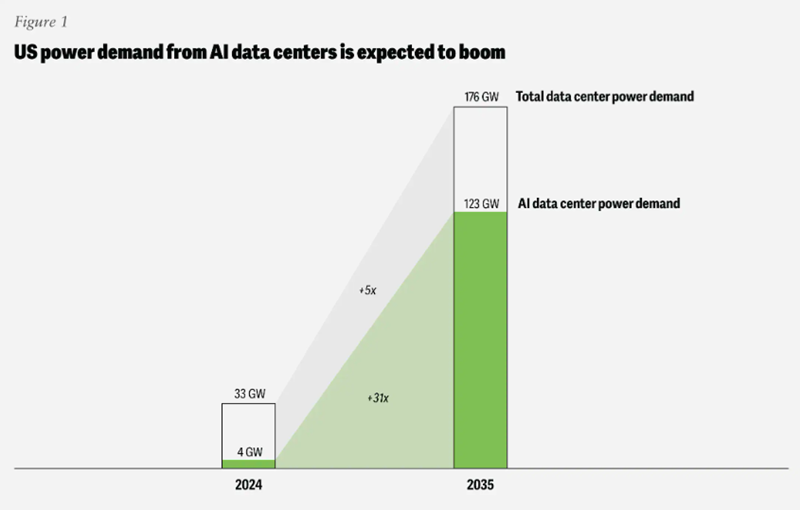

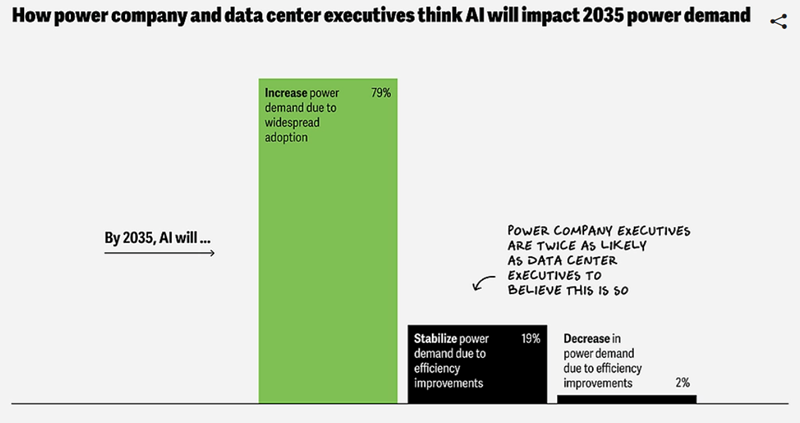

Deloitte: прожорливость ИИ ЦОД может привести к перегрузке энергетической инфраструктуры СШАПотребность ИИ ЦОД в США в энергии к 2035 году может вырасти в 30 раз — до 123 ГВт с 4 ГВт в 2024 году. При этом работающие с ИИ-оборудованием дата-центры требуют гораздо больше энергии на единицу площади, чем классические, что может вызвать серьёзные проблемы в энергосетях уже в обозримом будущем, сообщает The Register со ссылкой на отчёт Deloitte Insights «Сможет ли инфраструктура США успеть за экономикой ИИ?» (Can US infrastructure keep up with the AI economy?) В исследование подчёркивается, что крупные ЦОД потребляют всё больше энергии, в то время модернизация энергосетевой инфраструктуры и ввод новых источников энергии сталкиваются с рядом препятствий из-за бюрократии и сбоев в цепочках поставок. Потенциальным решением могут стать технологические инновации, которые сделают инфраструктуру ЦОД более энергоэффективной. Кроме того, успех зависит от упрощения регулирования и масштабов финансовых вливаний в отрасль. Оценки Deloitte свидетельствуют, что в прошлом году американские дата-центры потребовали около 33 ГВт, но из них лишь 4 ГВт ушло на ИИ-проекты. Компания прогнозирует, что к 2035 году мощность ЦОД в целом вырастет впятеро, а вот ИИ ЦОД — более чем в 30 раз. На них придётся до 70 % от общего объёма в 176 ГВт.

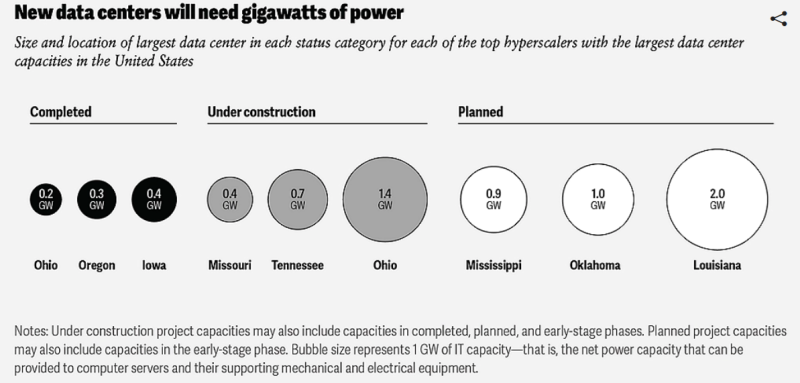

Источник изображения: Deloitte Дата-центров станет больше, и они будут крупнее. В Deloitte подчёркивают, что сейчас крупнейшие американские ЦОД «большой тройки» гиперскейлеров потребляют менее 500 МВт каждый, но сейчас строятся объекты с мощностью более 2 ГВт. На ранних стадиях планирования находятся дата-центры, потребляющие уже до 5 ГВт. Другими словами, спрос на электричество продолжит расти. За последний год рост спроса в основном компенсировался увеличением генерации энергии газовыми электростанциями, несмотря на то что гиперскейлеры неоднократно декларировали приверженность «зелёной» повестке и обещали добиться нулевых выбросов. Компания предупреждает, что некоторые запросы на присоединение смогут быть удовлетворены лишь через семь лет, причём на строительство ЦОД обычно уходит меньше времени, чем на создание генерирующих мощностей. Если дата-центр можно построить за несколько лет, то новые газовые электростанции, свободные от контрактов на поставку энергии, вероятно, появятся не раньше следующего десятилетия.

Источник изображения: Deloitte Проблемы с цепочками поставок мешают как энергокомпаниям, так и гиперскейлерам, поскольку импорт в США многих критически важных компонентов с недавних пор подпадает под действие заградительных тарифов. Кроме того, потенциально будут расти цены на сталь, алюминий, медь и цемент, что только усугубит ситуацию в энергетике. Исследователи Deloitte опросили операторов ЦОД и энергетические компании, чтобы выяснить, какие стратегии помогут справиться с потенциальной нехваткой энергии, вызванной бумом строительства ЦОД. Ключевыми инструментами названы технологические инновации, изменения в регулировании и рост финансирования. Инновации, как ожидается, позволят создать более энергоэффективную инфраструктуру — например, можно будет перейти на оптическую передачу данных и современные твердотельные трансформаторы. Реформа нормативно-правовой базы регуляторами может включать переход от поддержки «спекулятивных» проектов на более реалистичные, с переходом на принцип «первым готов — первым обслужен». С похожими проблемами уже столкнулась Великобритания, в связи с чем регулятор Ofgem пересмотрел систему очередями на подключение, призванную исключить т. н. «зомби-проекты», и ускорить процесс введения в эксплуатацию более жизнеспособных.

Источник изображения: Deloitte В итоге всё сводится к наличию больших денег, поскольку развитие инфраструктуры потребует масштабного финансирования, а влияние ИИ ЦОД на стратегию развития становится всё более очевидным в дискуссиях об инвестициях. Потенциальные риски связаны с тем, что ограничения мощности и пропускной способности современных энергосетей США могут затормозить развитие ИИ — энергокомпании могут упустить шанс расширить и модернизировать сети, что может привести к катастрофическим последствиям для отрасли. В результате под вопросом может оказаться экономическое и геополитическое лидерство США — для страны это вопрос конкурентоспособности или даже национальной безопасности. Американский регулятор North American Electric Reliability Corp. (NERC), отвечающий за надзор за электросетями и сопутствующей инфраструктурой, сообщил, что подключение ЦОД к электричеству сегодня весьма рискованно из-за их нестабильного энергопотребления. Ситуация может усугубиться с появлением ускорителей с энергопотреблением 15 кВт. В апреле Deloitte сообщала, что АЭС смогут обеспечить 10 % будущего спроса ЦОД США на электроэнергию, но строить их придётся быстрее.

17.06.2025 [22:35], Руслан Авдеев

Pure Storage и Solidigm раскритиковали заявления Seagate об экологичности HDDPure Storage, Solidigm и Ocient с одной стороны и Seagate с другой не сошлись во мнениях относительно углеродного следа SSD и HDD. В Seagate утверждают, что HDD экологичнее SSD вопреки распространённым предрассудкам, сообщает Blocks & Files. Seagate утверждает, что SSD требуют меньше энергии в сравнении с HDD при эксплуатации, но хуже для окружающей среды с точки зрения углеродного выброса, поскольку загрязнение атмосферы в процессе производства с лихвой «компенсирует» выбросы при эксплуатации. Компания сравнила углеродные выбросы типовых 30,72-Тбайт SSD, 30-Тбайт HDD на базе Mozaic 3+ и ленточного привода с одним носителем LTO-9 (45 Тбайт со сжатием). Расчёты Seagate свидетельствуют, что по основным параметрам HDD выигрывают. По словам Seagate, цель доклада — предоставить точные сведения операторам дата-центров для принятия обоснованных решений. В своих расчётах компания ссылается на статью 2023 года The Dirty Secret of SSDs: Embodied Carbon, согласно которой для SSD изначальный углеродный след (CO2e) в значительной степени связан с затрачиваемым при производстве электричеством, преимущественно получаемом с помощью сжигания угля и природного газа. На 1 Гбайт флеш-памяти приходится 0,16 кг CO2e (показатель SEF), а на 30,72 Тбайт — уже 4915,2 кг. По словам авторов доклада, на выпуск SSD приходится в восемь раз больше выбросов CO2e, чем на HDD аналогичной ёмкости, но в расчётах Seagate разница составила почти 170x.

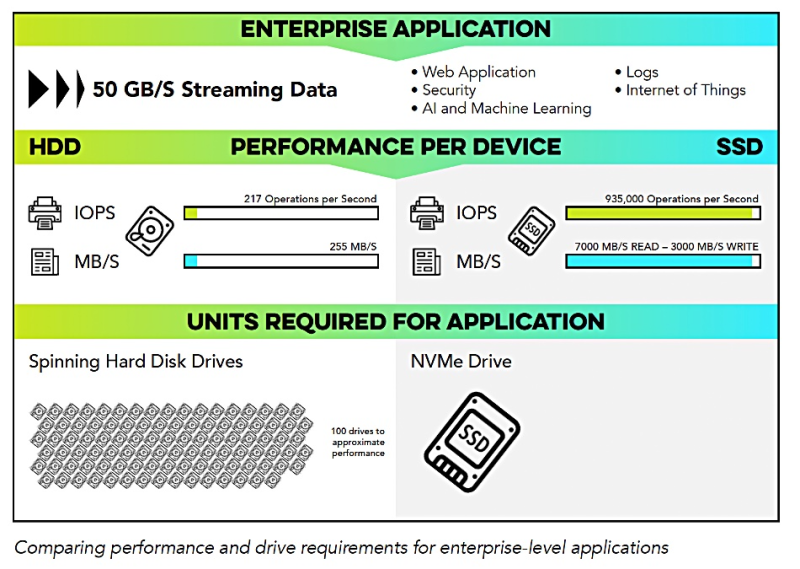

Источник изображения: OCIENT Pure Storage, выпускающая All-Flash СХД и мечтающая изжить жёсткие диски из ЦОД, отметила в своём блоге, что восьмикратная разница в уровне SEF между SSD и HDD не соответствует реальности. На практике она сейчас составляет уже не 8x, а около 2x. При этом ёмкость новых SSD растёт, а по мере роста плотности размещения информации показатель CO2e/Гбайт будет снижаться быстрее, чем у HDD, так что по этому показателю накопители скоро как минимум сравняются. А догнать по ёмкости QLC SSD жёсткие диски пока не в состоянии. Ocient и Solidigm рассмотрели проблему со своей стороны. По их данным, в статье 2023-го года речь в основном идёт о потребительских накопителях, так что попытка Seagate перенести эти показатели на корпоративные СХД, по-видимому, не совсем корректна. В корпоративных сценариях NVMe SSD дают кратный прирост производительности в нагрузках Big Data и ИИ. Таким образом, их более высокий изначальный углеродный след нивелируется за счёт снижения энергозатрат и сокращения количества серверов.

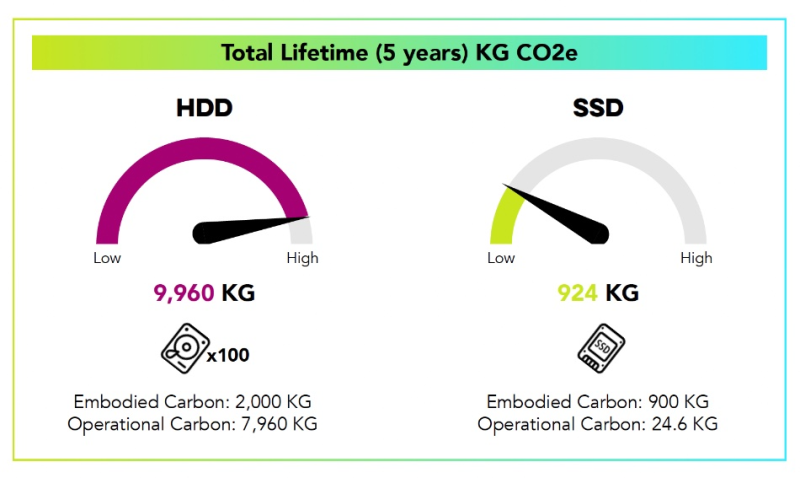

Источник изображения: OCIENT Для простоты расчётов Ocient и Solidigm приравняли по производительности один NVMe-накопитель к 100 жёстким дискам. По словам компаний, получается, что фактический углеродный след SSD будет совсем другим — 100 HDD по 20 кг CO2 на диск (это на треть меньше показателя самой Seagate) дадут 2000 кг, тогда как один SSD — всего 900 кг даже с поправкой на ёмкость (без уточнения, о какой вместимости и поправке идёт речь). За пять лет система на 100 жёстких дисках выбросит 7960 кг CO2, а NVMe SSD корпоративного класса — всего 24,6 кг. Суммарный углеродный след для HDD в этом случае составит 9960 кг, а для SSD — всего лишь 924 кг. |

|