Материалы по тегу: сбой

|

06.03.2026 [12:37], Руслан Авдеев

На просвет не видно, чьё: кабели с иностранным оптоволокном предложено временно считать российскимиМинпромторг РФ выступил с предложением отложить обязательное использование российского оптоволокна в кабелях ВОЛС на два года, сообщает «Коммерсантъ». В ПП №719 указаны параметры, при которых продукция признаётся российской. В этом случае производители могут включать её в реестр Минпромторга, что, например, позволяет участвовать в государственных закупках. Требование подтверждать отечественное происхождение оптоволокна министерство предложило перенести на 2028 год. Предлагается считать с 1 июня 2026 года российским кабель, выпущенный в стране из иностранного оптоволокна. Утверждается, что единственный в ЕАЭС завод по выпуску оптоволокна «Оптиковолоконные системы» (ОВС) в Мордовии приостановил производство в результате повреждения оборудования, а запасы на складах подходят к концу. Восстановление производства вероятно в декабре 2027 года. Не исключено, что к 2028 году потребности рынка удовлетворить отечественным волокном в полной мере не удастся. По данным «Коммерсанта», новый проект постановления способен расширить количество предприятий, которые могут подтвердить российское происхождение продукции для включения в реестр. По данным ассоциации «Электрокабель», пока существующее требование об обязательном использовании российского оптоволокна невыполнимо и сейчас оно блокирует закупки оптоволоконных кабелей для критически важных систем связи, энергетического комплекса и др.

Источник изображения: Compare Fibre/unsplash.com До приостановки производства, по некоторым оценкам, доля продукции ОВС на российском рынке составляла порядка 30-40 %, общие мощности компании обеспечивали выпуск 4 млн км оптоволокна в год, хотя стране требуется не менее 20 млн км. По имеющимся данным, оптоволокно зарубежного, преимущественно китайского, производства уже кратно подорожало в последнее время. По словам экспертов, современный объём потребления оптоволокна в России в рыночных целях составляет около 15 млн км ежегодно, из них на выпуск кабелей уходит около 2 млн км. В случае, если отсрочка будет одобрена, заводы смогут продолжить своевременный выпуск кабелей и обеспечат выполнение программы госзакупок, но решение носит временный характер и «фиксирует» зависимость страны от импорта до 2028 года.

06.03.2026 [10:16], Руслан Авдеев

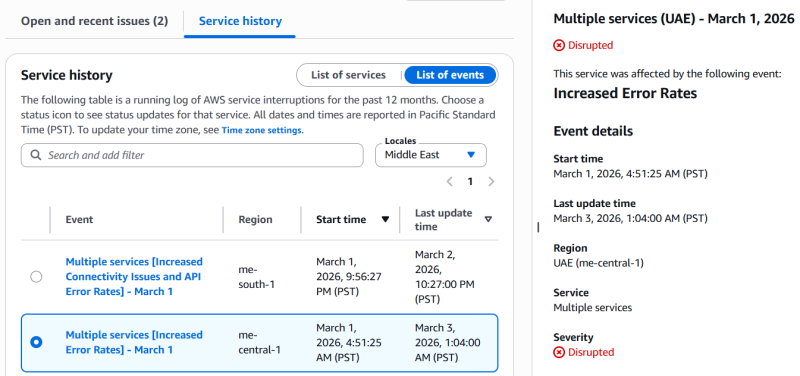

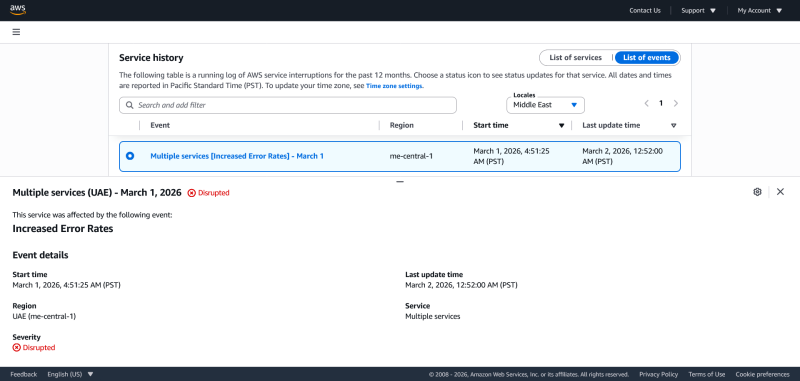

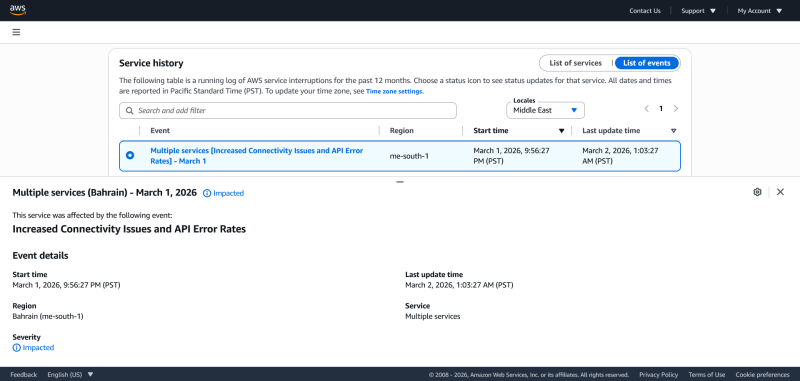

Атака беспилотников на ближневосточные дата-центры AWS заставит пересмотреть подход к отказоустойчивости облаковПрогноз бывшего главы Google Эрика Шмидта (Eric Schmidt) о том, что в будущем критические важные ИИ ЦОД будут защищены военными базами, может оказаться не такими уж фантастическим. Атаки на дата-центры AWS на Ближнем Востоке наглядно показали, что до сих пор в проектах по обеспечению отказоустойчивости некоторые факторы практически игнорировались, сообщает Datacenter Knowkedge. Хотя объекты гиперскейлеров, несмотря на периодические сбои, обычно устойчивее, чем большинство частных ЦОД, облачная инфраструктура обычно противостоит привычным техническим неполадкам — отключение оборудования, перебои в электроснабжении и потеря связности. Планы большинства корпораций, вероятно, не предусматривают защиты от скоординированных атак на физическую инфраструктуру. Если ранее выбор облачного региона был вопросом задержки, суверенитета данных или соответствия местным нормативным требованиям, то теперь остро встают вопросы политической стабильности, вероятности эскалации и возможностей защиты КИИ, в том числе военным путём. Облачные регионы из весьма абстрактных понятий (только у AWS есть более 900 ЦОД различного формата) перешли в категорию физических объектов в конкретных локациях с высокой стоимостью активов. Особенно привлекательны такие цели во время асимметричных конфликтов, когда удар несколькими беспилотниками может вывести из строя критически важный объект, обеспечивающий работу в регионе самых разных структур. Удары по AWS показали, что в геополитических конфликтах концентрация инфраструктуры в одном месте может стать скорее минусом, чем плюсом. В дооблачную эпоху существовали тысячи разнообразных ЦОД с той или иной степенью защиты, но большинство из них не были критически важными для жизни и работы великого множества людей сразу. В эпоху гиперскейлеров нормой стали огромные кампусы, поэтому чрезвычайно надёжные в обычное время дата-центры являются привлекательной целью, поражение которой может принести серьёзный ущерб. Хотя отказываться от облачных технологий уже поздно, возможно, придётся переосмыслить их архитектуру. По словам Datacenter Knowledge, IT-инфраструктура должна служить подспорьем бизнесу и не предназначена для апокалиптических сценариев без экономического обоснования. Другими словами, отраслевые руководители должны выявить уязвимости своих организаций, поскольку игнорирование таких угроз можно назвать «концептуальной» халатностью. IT-управленцы должны оценить, можно ли перенести рабочие нагрузки и важнейшие данные между регионами или даже на другие континенты к альтернативным облачным провайдерам. В расчёт необходимо принимать финансовые ограничения, требования к максимальной задержке, сложность эксплуатации и геополитические риски. Не исключено, что в будущем для пользователей станут привлекательнее не высокоэффективные централизованные ЦОД, а децентрализованные архитектуры с централизованным управлением. Хотя они менее эффективны, рабочие нагрузки будут рассеяны по географически рассредоточенным объектам, что помешает нанести масштабный урон в случае наступления непредвиденных обстоятельств. Пока что отрасль внимательно наблюдает за восстановлением работы AWS в пострадавших зонах доступности, чтобы скорректировать свои планы на будущее. Не исключено, что гораздо востребованнее станут и подземные дата-центры, нередко расположенные в бывших бункерах, оставшихся с прошлых конфликтов, или шахтах и рудниках. Как минимум несколько проектов есть в США и Европе (Швеции, Германии, России и др.). Впрочем, в Израиле подземные ЦОД строят с нуля.

03.03.2026 [16:05], Руслан Авдеев

Иранские дроны повредили два дата-центра Amazon в ОАЭ и «зацепили» ещё один в БахрейнеВ результате ударов беспилотников на Ближнем Востоке пострадали три дата-центра Amazon. Компания отказалась от корпоративных эвфемизмов о попадании неких «объектов», которые вызвали «искрение и возгорание», и прямо заявила, что дроны попали в два ЦОД в ОАЭ, обслуживающие зоны доступности mec1-az2 и mec1-az3 региона ME-CENTRAL-1. Третий ЦОД в Бахрейне (mes1-az2 в ME-SOUTH-1) пострадал от удара в «непосредственной близости» от него. Хотя прямо Amazon об этом не говорит, очевидно, что беспилотники были иранские. Как заявила AWS, удары нанесли «структурный урон», нарушили подачу электроэнергии объектам компании, а в некоторых случаях потребовалось тушение пожаров, что причинило дополнительный ущерб, на этот раз от воды. По словам компании, организовано тесное сотрудничество с местными властями, а первостепенное внимание уделяется безопасности персонала. Зоны mec1-az2 и mec1-az3 региона ME-CENTRAL-1 по-прежнему работают с перебоями, третья зона — mec1-az1 продолжает функционировать в обычном режиме, хотя затронуты некоторые сервисы az1, зависевшие и от работы других зон. В регионе ME-SOUTH-1, расположенном в Бахрейне, пострадал один объект. Впрочем, как в Бахрейне, так и в ОАЭ клиенты продолжают сталкиваться ошибками и проблемами доступности ряда сервисов. В компании предполагают, что инфраструктуру ожидает длительный процесс восстановления с учётом «характера причинённого физического ущерба». С учётом ситуации на Ближнем Востоке AWS рекомендует клиентам создавать резервные копии информации и оценить, насколько возможен перенос рабочих нагрузок в другие облачные регионы Amazon.

02.03.2026 [13:00], Руслан Авдеев

Облако AWS пострадало от «удара объектов по ЦОД» в ОАЭ, приведшего к пожаруЗоны доступности mec1-az2 и mec1-az3 в регионе AWS ME-CENTRAL-1 в ОАЭ прекратили работу после того, как по дата-центру ударили «объекты». По данным AWS, объекты вызвали «искры и возгорание». Пожарные отключили сетевое электропитание и генераторы объекта для того, чтобы без помех погасить огонь. Сервисы EC2 и S3 отключены полностью, ещё 84 сервиса подвержены различным проблемам. Зона mec1-az1 не пострадала. Тем, кто не использовал резервирование в нескольких зонах, компания рекомендует развернуть нагрузки из последних бэкапов в незатронутых зонах или регионах. Сообщается, что компания всё ещё ждёт разрешения для того, чтобы вновь подать питание, и как только получит его, будет обеспечено безопасное восстановление работы и связи. Одновременно пострадала и зона доступности mes1-az2 региона ME-SOUTH-1 в Бахрейне. Компания сообщает о проблемах с питанием и сетевым подключением, но не уточняет причины сбоя. Всего проблемы затронули 66 сервисов. Остальные зоны региона не пострадали.

19.02.2026 [16:58], Руслан Авдеев

«Прогоревший» криптомайнер: NFN8 не пережила пожар в ЦОД, падение биткоина и переметнувшегося к OpenAI партнёраКриптомайнинговая компания NFN8 Group подала заявление о банкротстве в Техасе, все её активы выставлены на продажу. Компания ссылается на многочисленные вызовы, негативно сказавшиеся на выручке, сообщает Datacenter Dynamics, основной проблемой банкротства назван пожар в ЦОД, случившийся в 2025 году. NFN8 управляет собственными майнинговыми системами, а также продаёт оборудование сторонним компаниям с последующей обратной арендой, оплачиваемой за счёт майнинга на нём биткоинов. Компания обратилась к оператору Core Scientific для размещения таких систем в 2020 году. К концу 2022 года оператор управлял большей частью её инфраструктуры, но ровно в этот момент заявил о банкротстве. Хотя Core Scintific продолжал обслуживать некоторых майнеров, контракт с NFN8 был разорван в середине 2023 года, оставив компанию с «тысячами» активных майнинговых установок, которые нельзя было немедленно развернуть в другом месте. В случае с покупателями и арендодателями оборудования, чьи системы продолжали работать на площадках, не связанных с Core Scientific, NFN8 продолжила как его использование, так и выплаты. Арендодателей, чьё майнинговое оборудование «застряло», NFN8 уведомила о ситуации и временно приостановила платежи. Компания планировала возобновить майнинг уже на новых объектах к весне 2024 года, но в апреле произошёл халвинг биткоина. К лету 2024 года стало понятно, что выручки от майнинга не хватает для покрытия арендных платежей, операционных расходов и капитальных издержек одновременно, поэтому NFN8 приостановила некоторые выплаты до зимы 2024 года. Однако некоторые арендодатели подали иск, обвинив компанию в нарушении договоров, мошенничестве и вероятных нарушениях законодательства о ценных бумагах. NFN8 отвергла обвинения, но арбитражное разбирательство всё ещё не закончено. Не исключается, что судебные издержки и возможное неблагоприятное решение может привести к ещё более разрушительным для бизнеса последствиям. Core Scientific более не обслуживает компанию, теперь она арендует мощности на трёх площадках, включая одну в Кристал-Сити (Crystal City) в Техасе, где в конце 2025 года произошёл пожар. В результате майнинговые мощности и выручка NFN8 уменьшились наполовину. Теперь компания желает получить компенсации от страховой компании, но о времени начала выплат ничего не известно. Из-за пожара и надвигающегося судебного разбирательства компания была вынуждена объявить о «защите» в соответствии с главой 11 Кодекса о банкротстве США, позволяющей не продать компанию с молотка полностью, а провести её реорганизацию. Core Scientific смогла оправиться от проблем, переключившись с майнинга на ИИ и фактически обслуживая OpenAI при посредничестве CoreWeave.

10.02.2026 [09:57], Руслан Авдеев

Евросоюз потратит €347 млн на защиту и ремонт подводных кабелей — начнут с БалтикиЕврокомиссия объявила, что растущие риски для критически важной подводной кабельной инфраструктуры заставляют Евросоюз активизировать усилия по её защите. На днях представлен комплекс мер Cable Security Toolbox по снижению рисков безопасности кабелей и список кабельных проектов, представляющих интерес для Европы (Cable Projects of European Interest, CPEI). Также пересмотрен план Connecting Europe Facility (CEF) — Digital Work Programme по распределению €347 млн на стратегические кабельные проекты, в т.ч. на расширение европейских возможностей по ремонту кабелей. Новая инициатива — часть плана ЕС по обеспечению безопасности кабелей (EU Action Plan on Cable Security), направленного на укрепление безопасности подводной кабельной инфраструктуры Европы, в т.ч. на противодействие преднамеренным повреждениям и саботажу. Инструментарий для обеспечения безопасности включает шесть стратегических мер и четыре технические и вспомогательные. Комплекс разработали с учётом оценки рисков, уязвимостей и угроз, проведённой в октябре 2025 года. Государственному финансированию подлежат 13 направлений CPEI. Реализация проекта рассчитана на три пятилетки, до 2040 года. Проекты CPEI будут иметь приоритет при выборе в ходе предстоящих конкурсах предложений в рамках программы CEF. Им же будет уделяться особое внимание при планировании следующей многолетней программы финансирования. Оценка рисков, инструменты и CPEI определены Еврокомиссией и представителями государств в рамках специальной экспертной группы, посвящённой кабелям (Cables Expert Group). Еврокомиссия внесла поправки в план CEF Digital Work Programme, выделив €347 млн на финансирование кабельных проектов, имеющих стратегическое значение.

Источник изображения: Teo D/unsplash.com В 2026 году €60 млн выделят на два проекта по развитию возможностей ремонта кабелей, отдельно проведут конкурс на €20 млн для оборудования кабельных SMART-систем. Речь идёт о датчиках и элементах систем мониторинга, интегрированных в подводную кабельную инфраструктуру для сбора сейсмических и иных данных в режиме реального времени. Также в 2026–2027 гг. объявят два конкурса для финансирования CPEI на €267 млн. В рамках CEF Digital объявлен конкурс на €20 млн для развития «адаптируемых» модулей для ремонта подводной кабельной инфраструктуры. Предполагается, что такие модули будут размещать в портах и на верфях, что ускорит восстановление подводной инфраструктуры. Речь идёт о первом этапе более масштабной инициативы, предназначенной для всех морских бассейнов с присутствием Евросоюза (Балтийского, Средиземного и Атлантического). В ходе реализации пилотного проекта будет уделяться первоочередное внимание Балтийскому морю в связи с участившимися в последние годы случаями обрывов подводных кабелей. Предполагается, что объекты критически важной инфраструктуры могут стать целями для неких враждебных действий. Заявки на финансирование будут приниматься только от государственных организаций, имеющих полномочия реагировать на чрезвычайные ситуации, включая силы гражданской обороны, береговой охраны и ВМС. В рамках действующей многолетней рабочей программы CEF Digital multiannual Work Programme (2024–2027 гг.) на связанные с подводными кабелями проекты в общей сложности распределено €533 млн, из них €186 млн уже выделены на 25 проектов. В 2021–2024 гг. Евросоюз уже выделил €186 млн на 51 проект подключения к магистральным кабелям. Стоит отметить, что защита кабелей продвигается также по линии НАТО (Baltic Sentry) и отдельных стран. Так, срочно озаботиться вопросами ремонта и защиты подводных кабелей призывали британские власти.

15.01.2026 [14:42], Руслан Авдеев

Бирмингем снова отложил перезапуск печально известной ERP-системы Oracle FusionГородской совет Бирмингема отложил повторный запуск печально известной ERP-системы Oracle Fusion, ставшей причиной многомиллионных расходов. В совете заявили, что сотрудникам нужно больше времени, чтобы адаптироваться к стандартным процессам вендора, сообщает The Register. Очередные манипуляции с ПО в крупнейшем муниципалитете Евросоюза последовали за крайне неудачной попыткой внедрить в 2022 году в Бирмингеме Oracle Fusion для управления миллионными поступлениями налогоплательщиков и многомиллионными же расходами, фактически превратившей местные власти в банкротов. Общая стоимость перехода с SAP на Oracle увеличилась с заложенных изначально £19 млн до около £131 млн, а позже до £170 млн. С учётом потерь в результате неудачного внедрения речь идёт уже о £216,5 млн, хотя эксперты в самом начале предрекали крупные проблемы, ведущие к задержке платежей и накоплению долгов В 2020 году муниципалитет запланировал заменить устаревшую систему SAP на стандартный вариант ПО Oracle. Тем не менее, проект подвергся усиленной кастомизации, включая внедрение системы сверки банковских счетов (Bank Reconciliation System), работу которой должным образом так и не смогли наладить. Когда изменения ПО практически парализовали работу системы, власти Бирмингема попытались заново внедрить решение Oracle «из коробки», а для банковских процедур было решено использовать стороннее ПО Income Management.

Источник изображения: Francisco Gomes/unsplash.com Замена должна была состояться в апреле, но недавно двое представителей муниципалитета заявили о переносе процедуры как минимум до лета. По результатам тестирования и оценки готовности ПО совет учёл мнение сотрудников и решил перенести дату ввода системы в эксплуатацию для снижения рисков и для того, чтобы гарантировать точность выплаты зарплат. Подчёркивается, что речь идёт лишь о переносе сроков, а не очередном «перезапуске». Хотя в мае 2024 года обслуживание школ исключили из обновлённого проекта, его стоимость продолжала расти. По данным муниципальных властей, управленческие решения должны быть приняты позже в январе, а независимая экспертиза должна установить, готова ли программа к запуску. Местные политики уже предрекают, что муниципалитет придёт к местным выборам в мае без функционирующей финансовой системы. Сами представители совета утверждают, что необходимо убедиться в успешности повторного внедрения ПО, не стремясь обеспечить его к заданным датам в ущерб стабильности. Влияния на работу действующей системы новая не окажет, а сервисы продолжат функционировать так, как функционируют сейчас. Бюджет на повторное внедрение системы включал резервные средства на случай изменений, поэтому роста расходов не ожидается. Внедрение будет проходить поэтапно, с независимой проверкой на согласованных заранее контрольных точках.

07.01.2026 [14:17], Руслан Авдеев

Не только баги, но и настоящий бэкдор: британская техподдержка Fujitsu Horizon была набрана из «легализованных хакеров»В скандале с печально известной системой Fujitsu Horizon для Почты Великобритании наметился неожиданный сюжетный поворот. Согласно новым данным, Horizon страдала не только от багов в области бухучёта, из-за которых по обвинению в воровстве были осуждены сотни невиновных сотрудников почтовых отделений — деньги вполне могли украсть сотрудники службы технической поддержки Horizon, причём так, что об этом никто бы никогда не догадался, сообщает Computer Weekly. Ричард Ролл (Richard Roll), работавший на третьей линии службы поддержки Horizon в 2001–2004 гг., дал показания в суде, которые помогли пострадавшим почтовым клеркам. По данным бывшего сотрудника Fujitsu, правила аудита удалённого доступа могли игнорироваться группой «легализованных» хакеров, способных использовать бэкдоры для доступа к счетам почтовых отделений. Ролл был опрошен ещё в 2015 году, но детали были обнародованы на фоне предстоящей встречи главы европейского подразделения Fujitsu с британским Комитетом по вопросам бизнеса и торговли (Business and Trade Committee). В 2015 году, через несколько месяцев после того, как Fujitsu отстранили от расследования инцидентов с Horizon, Ролл показал, что сотрудники японской компании могли обходить аудит удалённого доступа к счетам. По его словам, система была полна «дыр», а сотрудники техподдержки были «легализованными хакерами», которые «могли взломать что угодно». По словам Ролла, специалисты службы поддержки на деле никогда не воровали денег, но вполне могли бы, воспользовавшись бэкдорами. Во всяком случае, во время его работы коллеги в подобном замечены не были.

Источник изображения: Clint Patterson/unsplash.com В 2018–2019 гг. Ролл также давал показания в интересах пострадавших, судившихся с Почтой Великобритании. Около 800 сотрудников почт на основе данных Horizon ошибочно обвинили в финансовых преступлениях в 2000–2015 гг. В результате многие сотрудники лишились средств к существованию, а их привычным жизням пришёл конец после предъявления обвинений. На момент выявления инцидентов Почта Великобритании использовала свои полномочия, чтобы направлять дела управляющих почтовыми отделениями в суд или принуждать к заключению сделок о признании вины. Впоследствии почтовое ведомство, наконец, признало возможность скрытого удалённого доступа. В 2023 году возможность бесконтрольного доступа, в том числе к счетам почтовых отделений, признал и бывший IT-руководитель Fujitsu — фактически сотрудники компании могли скрыть изменения в информационных системах от управляющих, а компании буквально приходилось верить в их добросовестность, без контроля реальной активности. Информация о скандале с британскими почтами появилась более 15 лет назад, с тех пор с переменным успехом ведётся расследование, в ходе которого почта и Fujitsu пытаются переложить вину друг на друга (с точки зрения суда виноваты обе стороны). В конце 2024 года Fujitsu заявляла, что неоднократно предупреждала Почту Великобритании о проблемах с ПО Horizon. Впрочем, в октябре 2025 года появилась информация, что компания влила £280 млн в британское подразделение в преддверии выплат компенсаций жертвам. Сама Fujitsu начала терять контракты с британскими госслужбами и задумалась о сокращении штата ради экономии.

02.01.2026 [21:10], Владимир Мироненко

Финляндия задержала судно Fitburg в связи с повреждением подводного интернет-кабеля в Балтийском мореФинская полиция задержала грузовое судно Fitburg, следовавшее из России, которое подозревается в повреждении подводного телекоммуникационного кабеля компании Elisa, проложенного по дну Финского залива из Хельсинки (Финляндия) в Таллин (Эстония). Повреждение произошло в исключительной экономической зоне Эстонии. Весь экипаж судна, следовавшего под флагом Сент-Винсента и Гренадин, в составе 14 человек был арестован, сообщил ресурс BBC. «На данном этапе полиция расследует инцидент как умышленное причинение тяжкого ущерба имуществу, попытку умышленного причинения тяжкого ущерба имуществу и умышленное вмешательство в телекоммуникации», — говорится в заявлении полиции. Телекоммуникационный оператор Elisa, заявил, что работа сервисов не пострадала благодаря использованию резервных маршрутов, пишет Data Center Dynamics. Правительство Эстонии сообщило, что в среду также произошел сбой второго телекоммуникационном кабеле, соединяющем страну с Финляндией. Президент Эстонии Алар Карис (Alar Karis) заявил: «Надеюсь, это не было преднамеренным действием, но расследование прояснит ситуацию». Ранее в 2025 году НАТО запустило программу Baltic Sentry для защиты от атак на подводные энергетические и информационные кабели в Балтийском море. В ноябре 2024 года китайский сухогруз, следовавший из России, обвинили в повреждении двух кабелей в Балтийском море. Поначалу в причастности к этому подозревали Россию, но позже было заявлено, что повреждение произошло в результате несчастного случая. В конце 2024 года в Балтийском море произошло сразу несколько обрывов кабелей. UPD 13.01.2026: судно отпущено, однако часть команды по-прежнему задержана.

23.12.2025 [08:21], Владимир Мироненко

Сбой питания из-за бури привёл к ошибке в работе атомных часов NIST и проблемам с NTPСотрудник Национального института стандартов и технологий США (NIST) попытался отключить резервные генераторы, питающие часть инфраструктуры, обеспечивающей поддержку протокола сетевого времени (NTP), после того как отключение электроэнергии в минувшую субботу в районе Боулдера (Boulder, штат Колорадо) из-за плохих погодных условий, привело к ошибкам в работе атомных часов, пишет The Register. Ошибка часов на станции в Боулдере на тот момент составляла <4,8 мкс. «Шкала времени, генерируемая на основе ансамбля атомных часов в нашем кампусе в Боулдере вышла из строя из-за длительного отключения электроэнергии», — пояснил Джеффри Шерман (Jeffrey Sherman), физик-руководитель NIST, ответственный за обслуживание атомных часов института, добавив, что из-за этого «службы интернет-времени Боулдера больше не имеют точной привязки времени». NIST использует свои атомные часы, в частности, для предоставления NTP-сервиса, используемого для синхронизации работы устройств Сети. Если NTP не работает, это может привести к трудностям с аутентификацией между системами и нестабильной работе приложений. Впрочем, крупные игроки используют собственные NTP-сервисы. А для синхронизации нередко используются сигналы GNSS. Шерман также рассказал, что резервный генератор включился и продолжил поддерживать работу серверов, в связи с чем он попытается его отключить, «чтобы избежать распространения неверного времени». Но сделать это оказалось проблемой, поскольку буря, вызвавшая сбой электроэнергии, была настолько сильной, что объект было разрешено посещать только сотрудникам экстренных служб. Учёный отметил, что, судя по всему, из-за погодных условий вышел из строя один из основных генераторов. «В другом здании кампуса находятся дополнительные часы, резервные источники питания которых обеспечиваются другим генератором; если они останутся работоспособными, это позволит нам перенастроить основную шкалу времени, когда восстановится стабильность работы станции, без использования внешних часов или опорных сигналов», — добавил он. «Чтобы представить отклонение в несколько микросекунд в контексте, следует отметить, что шкала времени NIST обычно работает примерно в пять тысяч раз лучше на наносекундном уровне, используя специальное статистическое среднее многих часов», — указал Шерман в сообщении. «Такая точность важна для научных приложений, телекоммуникаций, критической инфраструктуры и контроля целостности систем позиционирования. Но такая точность недостижима при передаче времени через общедоступный интернет; более типичны неопределённости порядка 1 мс из-за асимметрии и колебаний задержки пакетов», — добавил он. Компания Xcel Energy, местный поставщик электроэнергии, объяснила отключение электроэнергии сильным ветром. NIST сообщил ресурсу CBS News, что предупредил своих пользователей, включая телекоммуникационные и аэрокосмические организации, о возможных проблемах из-за погодных условий в районе Боулдера, рекомендовав им использовать другие источники информации о времени. 22 декабря, в 06:00 UTC (9:00 мск) NIST сообщил, что все службы времени, предоставляемые кампусом в Боулдере, снова доступны и отдают точное время. |

|