Материалы по тегу:

|

05.12.2024 [16:47], SN Team

Дата-сонификация, нейроэксперименты и ИИ-тренажеры: как прошла ИТ-конференция «Импульс Т1»Тема этого года — «Инженеры больших идей» — объединила создателей технологических продуктов, ученых и разработчиков. Первый день «Импульса Т1» во всех городах был посвящен хакатонам, собравшим более 180 команд. Участники работали над актуальными задачами бизнеса: создавали систему взаимодействия с цифровым ассистентом, разрабатывали решения для автоматизации документооборота, реализовывали платформы для повышения эффективности рекрутинговых процессов. Второй день мероприятий собрал ведущих экспертов отрасли на пленарных сессиях в разных городах — суммарно участники конференции посетили более 80 секций и докладов, разделенных на три тематических трека: «Инженеры», «Ученые» и «Творцы». Представители ВТБ, ИТ-холдинга Т1, ГК «Росатом», InfoWatch, NtechLab, BIOCAD, Университета ИТМО, СПбГУТ и других технологических и ИТ-компаний, а также вузов и научных сообществ рассказали о формуле создания «большой идеи» и о том, как технологии помогают решать актуальные проблемы в промышленном секторе, медицине, дизайне и повседневной жизни. В этом году на московской конференции организаторы представили ИИ-тренажер собеседований, разработанный совместно с компанией Geecko. Основанный на анализе более 20 тысяч интервью, он изучает ответы на вопросы: оценивает технические компетенции и гибкие навыки и предлагает рекомендации по каждому ответу пользователя. В ходе «Импульса Т1» прошел ряд научно-технологических экспериментов. Так, в Москве представили саунд-арт проект, в рамках которого посетителям удалось прослушать звуковые композиции, отражающие атмосферу каждого из городов присутствия конференции. Технология дата-сонификации преобразовала данные из локаций ИТ-хабов в электронную музыку. На стенде также продемонстрировали визуализацию этих треков. Кроме того, совместно с биотех-лабораторией Neiry на территории Хлебозавода №9 провели нейроэксперимент на стыке искусства и технологий. С помощью специального гаджета сравнили мозговую активность представителей творческих и технических профессий во время разных занятий, привычных для их рода деятельности. Эксперимент показал максимальную концентрацию внимания у участников во время программирования и рисования. Присутствие же зрителей повышало стресс у художников, но не влияло на программистов. Медитация и музыка способствовали расслаблению обоих участников. На заключительном мероприятии в Москве Холдинг Т1 объявил о старте сотрудничества с МГТУ им. Н.Э. Баумана. Студенты смогут пройти практику в компаниях ИТ-холдинга Т1, работая над реальными задачами и применяя теоретические знания на практике. Кроме того, планируется создание и реализация научно-исследовательских инициатив, а также разработка практики по применению новых технологий и продуктов для ИТ-рынка. «На фоне роста проектов по цифровизации увеличивается спрос на талантливых ИТ-специалистов — по сравнению с аналогичным периодом предыдущего года он вырос на треть. Рынку крайне необходима площадка, где встречаются бизнес, молодые специалисты, исследователи. Наша конференция в 2024 году объединила более 7 тысяч человек в шести городах России и Беларуси, а число участников хакатона возросло до 600. Это в очередной раз доказывает тот факт, что тема технологического развития становится все более востребованной среди молодых специалистов», — отметил Алексей Фетисов, генеральный директор Холдинга Т1.

05.12.2024 [16:14], Сергей Карасёв

Запущен британский Arm-суперкомпьютер Isambard 3 с суперчипами NVIDIA GraceВ Великобритании введён в эксплуатацию суперкомпьютер Isambard 3, предназначенный для ресурсоёмких приложений ИИ и задач НРС. Реализация проекта обошлась приблизительно в £10 млн, или примерно $12,7 млн. Машина пришла на смену комплексу Isambard 2, который отправился на покой в сентябре нынешнего года. Система Isambard 3 создана в рамках сотрудничества между исследовательским консорциумом GW4 Alliance, в который входят университеты Бата, Бристоля, Кардиффа и Эксетера, а также компаниями HPE, NVIDIA и Arm. Суперкомпьютер назван в честь британского инженера Изамбарда Кингдома Брюнеля, внесшего значимый вклад в Промышленную революцию. Полностью технические характеристики Isambard 3 не раскрываются. Известно, что в основу машины положены 384 суперпроцессорами NVIDIA Grace со 144 ядрами (2 × 72) Arm Neoverse V2 (Demeter), общее количество которых превышает 55 тыс. Задействована высокопроизводительная СХД HPE, которая обеспечивает расширенные IO-возможности с интеллектуальным распределением данных по нескольким уровням. Благодаря этому достигается эффективная обработка задач с интенсивным использованием информации, таких как обучение моделей ИИ. Известно также, что в составе комплекса применяется фирменный интерконнект HPE Slingshot, а в качестве внутреннего интерконнекта служит технология NVLink-C2C, которая в семь раз быстрее PCIe 5.0. Каждый узел суперкомпьютера содержит один суперчип Grace и сетевой адаптер Cassini с пропускной способностью до 200 Гбит/с. Объём системной памяти составляет 2 × 120 Гбайт (240 Гбайт). Отмечается, что Isambard 3 демонстрирует в шесть раз более высокую производительность и в шесть раз лучшую энергоэффективность по сравнению с Isambard 2. Пиковое быстродействие FP64 у Isambard 3 достигает 2,7 Пфлопс при энергопотреблении менее 270 кВт. Применять новый суперкомпьютер планируется для таких задач, как проектирование оптимальной конфигурации ветряных электростанций на суше и воде, моделирование термоядерных реакторов, исследования в сфере здравоохранения и пр. Суперкомпьютер расположен в автономном дата-центре с системой самоохлаждения HPE Performance Optimized Data Center (POD) в Национальном центре композитов в Научном парке Бристоля и Бата. Там же ведётся монтаж ИИ-комплекса Isambard-AI стоимостью £225 млн ($286 млн), который должен стать самым быстрым и мощным суперкомпьютером в Великобритании. Проект Isambard-AI реализуется в несколько этапов. Первая фаза предполагает монтаж 42 узлов, каждый из которых несёт на борту четыре суперчипа NVIDIA GH200 Grace Hopper и 4 × 120 Гбайт памяти для CPU (доступно 460 Гбайт — по 115 Гбайт на CPU), а также 4 × 96 Гбайт памяти для GPU (H100). В ходе второй фазы будут добавлены 1320 узлов, насчитывающих в сумме 5280 суперчипов NVIDIA GH200 Grace Hopper. Кроме того, в состав Isambard 3 входит экспериментальный x86-модуль MACS (Multi-Architecture Comparison System), включающий сразу восемь разновидностей узлов на базе процессоров AMD EPYC и Intel Xeon нескольких поколений, часть из них также имеет ускорители AMD Instinct MI100 и NVIDIA H100/A100. Все они объединены 200G-интерконнектом HPE Slingshot.

05.12.2024 [15:22], Руслан Авдеев

Роботизированный флот: НАТО тестирует плавучие беспилотники для защиты подводных кабелей и береговой охраныНАТО проводит эксперименты с оборудованием для формирования беспилотного «спецназа». По данным Stars and Stripes, речь идёт о беспилотных надводных судах (USV) для патрулирования берегов и защиты от атак подводных интернет-кабелей. Участники альянса заинтересованы в таком оборудовании и намерены сформировать роботизированный флот уже в 2025 году, заявил один из высокопоставленных представителей НАТО. Недавно организация приняла участие в учениях Digital Talon 3.0, в ходе которых помимо прочего отрабатывалось использование вооружённых безэкипажных катеров и использование авианосцев для старта летающих БПЛА. Подводные дроны для патрулирования интернет-кабелей уже разрабатываются Францией в рамках Martoc Project. У США же есть подразделение морских беспилотников Task Force 59 (TF 59), которое испытывает как полностью автономные аппараты, так и управляемые дистанционно. Считается, что подразделение — лишь первое в своём роде, формирующее облик будущего ВМФ. В НАТО ещё не придумали звучного названия новым силам, пока известных как USV Fleet, но уже известно, что они будут работать под управлением Командования военно-морских сил НАТО (MARCOM). По данным военных, фактически флот беспилотников уже существует, силы Task Force 59 испытывают его на Ближнем Востоке. Закончить отладку роботизированного флота и представить его другим участникам альянса планируется к следующему саммиту НАТО в июне 2025 года. Буквально на днях в Балтийском море произошёл обрыв кабелей, принадлежащих входящим в НАТО странам. Хотя подобные инциденты случаются довольно часто, датские военные задержали китайский сухогруз, имевший несчастье проходить во время инцидентов вблизи места происшествия.

05.12.2024 [14:28], Руслан Авдеев

OpenAI намерена построить в США собственные ИИ ЦОД для коммерциализации технологийКомпания OpenAI намерена построить собственные дата-центры в США в рамках плана по привлечению к своим сервисам 1 млрд пользователей и дальнейшей коммерциализации своих технологий. По словам представителя OpenAI, компания намерена получить в своё распоряжение ЦОД как для обучения, так и для инференса, сообщает Financial Times. По словам представителя компании, «чипы, данные и энергия» станут ключевыми факторами, которые помогу компании выиграть в гонке ИИ-технологий и создать AGI, потенциально соответствующий возможностям человеческого мозга или даже превосходящий его. OpenAI намерена построить кластеры ЦОД на Среднем Западе и юго-востоке США. Подробности пока не разглашаются, но подтверждается, что строительство дата-центров является частью стратегии коммерциализации ИИ-технологий компании. В своё время OpenAI была основана как некоммерческая организация, но теперь переходит к более традиционной для бизнеса корпоративной структуре. Как сообщает Financial Times, компания наняла своего первого главу по финансам и продуктам и теперь якобы рассматривает возможности интеграции рекламы в свои решения. Что касается действующей цифровой инфраструктуры OpenAI, которая ранее в этом году привлекла ещё $6,6 млрд, в основном полагается на дата-центры Microsoft Azure — именно Microsoft вложила в стартап миллиарды долларов. Недавно компания начала посматривать и на других облачных провайдеров, а в июне анонсировала партнёрство с Oracle, в рамках которого Oracle Cloud Infrastructure будет задействована для обучения ИИ-моделей (правда, тоже при посредничестве Microsoft). Запросы компании превышают мощности, которые способна предоставить ей Microsoft. Не так давно OpenAI пыталась убедить правительство США в необходимости создания 5-ГВт дата-центров, способных вместить сразу 2 млн ускорителей. Компания заявила, что это уже вопрос национальной безопасности, и даже подготовила целый ряд рекомендаций.

05.12.2024 [13:37], Сергей Карасёв

AWS представила инстансы EC2 P5en на базе NVIDIA H200 и кастомизированных чипов Intel XeonОблачная платформа AWS объявила о доступности инстансов EC2 P5en, рассчитанных на такие нагрузки, как глубокое обучение, генеративный ИИ, обработка данных в реальном времени и приложения HPC. В основу новых экземпляров положены аппаратные компоненты Intel и NVIDIA. В частности, задействованы кастомизированные процессоры Xeon Sapphire Rapids. У них все ядра могут одновременно работать на турбо-частоте 3,2 ГГц, а максимальная частота отдельных ядер достигает 3,8 ГГц. Кроме того, применяются ИИ-ускорители NVIDIA H200 и адаптеры AWS Elastic Fabric Adapter (EFA) v3 с пропускной способностью до 3,2 Тбит/с. Конфигурация инстансов EC2 P5en включает 192 vCPU, 2048 ГиБ памяти, восемь ускорителей H200 и восемь SSD вместимостью 3,84 Тбайт каждый. Пропускная способность EBS составляет 100 Гбит/с. Отмечается, что экземпляры P5en демонстрируют увеличение производительности локального хранилища до двух раз и пропускной способности EBS до 25 % по сравнению с инстансами P5 на базе NVIDIA H100.

Источник изображения: NVIDIA На сегодняшний день инстансы EC2 P5en доступны в американских регионах AWS US East (Огайо) и US West (Орегон), а также в Азиатско-Тихоокеанском регионе в Токио. Предлагаются различные тарифные опции, включая оплату по мере использования. Ранее были представлены инстансы EC2 P5e с процессорами AMD EPYC Milan, 2 ТиБ памяти, восемью ускорителями NVIDIA H200 и восемью NVMe SSD на 3,84 Тбайт каждый. У этих экземпляров пропускная способность EBS равна 80 Гбит/с.

05.12.2024 [13:33], Руслан Авдеев

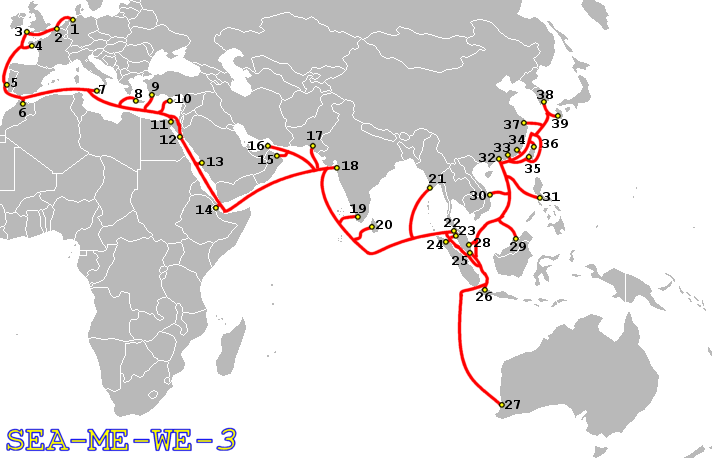

Некогда самый протяжённый в мире подводный интернет-кабель SeaMeWe-3 отключили от Сети после 25 лет работыПодводный интернет-кабель SeaMeWe-3 наконец отправили «на покой» после 25лет работы. Введённая в эксплуатацию в 1999 году кабельная система имеет 39 посадочных станций в 33 странах на четырёх континентах, сообщает Datacenter Dynamics. Теперь функции кабеля взяли на себя другие цифровые магистрали, проложенные по дну моря от Азии до Австралии, Африки и Европы. Ранее кабель SeaMeWe-3 считался самым протяжённым в мире — совокупная длина всех сегментов составляла 39 тыс. км. Относительно недавно пальму первенства перехватил новый кабель 2Africa длиной порядка 45 тыс. км, который имеет 46 посадочных станций в 33 странах Африки, Азии и Европы. Инфраструктуру SeaMeWe-3 построили на основе более короткого SeaMeWe-2. В консорциуме, отвечавшем за строительство, участвовали более 92 компаний, относящихся к телеком-индустрии, во главе с оператором Orange (ранее France Telecom). Кроме того, в числе ключевых спонсоров проекта выступала и китайская China Telecom.

Источник изображения: J.P.Lon / Wikipedia Из-за протяжённости, размеров и возраста сбои в работе SeaMeWe-3 со временем стали происходить всё чаще, доставляя немало хлопот. Так, в Южно-Китайском море обрыв случился в августе 2017 года, около Сингапура — в декабре 2017 года. Также имели место обрывы в декабре 2016 года и сентябре 2015 года. На устранение некоторых и вовсе ушло несколько месяцев. Впрочем, единичные перебои со связью случались и ранее.

05.12.2024 [09:13], Руслан Авдеев

AWS представила новую архитектуру ИИ ЦОД, энергоэффективную и экологичную

aws

hardware

pue

водоснабжение

дизель

ибп

ии

охлаждение

сжо

сша

цод

экология

электропитание

энергетика

энергоэффективность

AWS рассказала об инновациях, внедряемых в её ЦОД для поддержки ИИ-нагрузкок следующего поколения. По данным DataCenter Dynamics, нововведения связаны в первую очередь с электропитанием и охлаждением. Они направлены на повышение энергоэффективности дата-центров AWS. Первые ЦОД на базе новой архитектуры заработают в начале 2025 года. Новые решения в свежих новых дата-центрах компании по всему миру, а некоторые начнут применять уже на существующих объектах. В компании подчёркивают, что решения изначально спроектированы как модульные, поэтому возможная поэтапная модернизация площадок для внедрения СЖО, повышения энергоэффективности и снижения углеродного следа. Так, AWS упростит электрическую и механическую структуру новых ЦОД, чтобы облегчит их обслуживание и повысить надёжность. В частности, упростится подход к распределению энергии внутри ЦОД, а источники резервного питания будут размещаться ближе к стойкам. Это позволит повысить доступность инфраструктуры до 99,9999 % времени, а количество стоек, которых могут коснуться проблемы с энергоснабжением, снизится на 89 %. Также уменьшится количество вентиляторов для отвода горячего воздуха. Вместо этого будет применяться естественный перепад давления, что положительно скажется на энергопотреблении. Вместе с тем AWS намерено вшестеро увеличить мощность стойки в следующие два года, и ещё втрое — в будущем. Впрочем, в ИИ-серверах, где мощность ускорителей приближается к 1 кВт, без СЖО обойтись сложно. AWS готовит суперкластеры Project Rainier и Project Ceiba на базе AWS Tranium2 и NVIDIA Blackwell соответственно, поэтому она вместе с крупным производителем СЖО будет внедрять прямое жидкостное охлаждение и в новых, и в старых ЦОД. В некоторых случаях будет использоваться и гибридное охлаждение. Одним из главных плюсов новой архитектуры охлаждения является гибкость — акцент на воздушное или жидкостное охлаждение будет делаться в зависимости от потребностей оборудования и возможностей конкретных дата-центров. Заодно AWS использовала имеющиеся данные и генеративный ИИ для поиска наиболее эффективного способа размещения стоек в своих ЦОД, добавив ещё 12 % вычислительных мощностей на каждую площадку. Новая технология будет применяться как к новому оборудованию для ИИ-систем, так и для других типов техники. Также компания внедрила собственную систему управления механическими и электрическими устройствами — она поможет стандартизировать мониторинг и эксплуатацию дата-центров. Наконец, предприняты усилия по повышению экобезопасности дата-центров. AWS заявила, что новая архитектура охлаждения снизит потребление энергии на 46 % во времена пиковых нагрузок без увеличения потребления воды. Доля углеродных выбросов при производстве бетона, используемого при строительстве ЦОД, уменьшена на 35 % относительно средней по отрасли, кроме того, на 35 % сокращается потребление стали в целом, а та, что используется, поступает из электродуговых печей, а не газовых, что сокращает косвенные выбросы. Наконец, резервные генераторы AWS переведут на возобновляемое дизельное топливо. Дополнительно AWS совместно с Orbital Materials запустила пилотный проект по тестированию разработанного с помощью ИИ материала, помогающего захватывать в дата-центрах углекислый газ — речь идёт о «губке на атомном уровне», взаимодействующей только с молекулами углекислоты. Тестирование материала, три года разрабатывавшегося компаниями, начнётся в начале 2025 года. По данным Orbital, новый материал значительно дешевле аналогов. В дальнейшем стартап планирует испытать разработанные с помощью ИИ технологии для экономии воды и охлаждения чипов. DataCenter Dynamics также отмечает, что AWS впервые раскрыла показатель PUE своих дата-центров. В среднем он составляет 1,15, а самая лучшая площадка достигла 1,04. Для сравнения: у Google эти показатели составляют 1,1 и 1,06 соответственно, у Microsoft — 1,18 и 1,12 (у новых объектов). ЦОД Meta✴ в среднем имеют PUE около 1,08, а Oracle говорит об 1,15.

05.12.2024 [08:26], Владимир Мироненко

ЦОД солнечной обсерватории NASA SDO затопило — ремонт продлится до 2025 годаИз-за прорыва трубы системы охлаждения в серверной объединённого центра космических операций NASA при Стэнфордском университете (JSOC) вышло из строя оборудование, использовавшееся для обработки данных об активности Солнца, поступающих от обсерватории солнечной динамики (SDO), а также с космического зонда IRIS. Об этом сообщил ресурс Space. Из-за сильного затопления был нанесён значительный ущерб лаборатории, где размещаются серверы, «обрабатывающие и распределяющие данные с инструментов Helioseismic and Magnetic Imager (HMI) и Atmospheric Imaging Array (AIA), а также с космического аппарата IRIS», сообщили члены команды JSOC, добавив, что ремонт продлится до 2025 года. Учёные также отметили, что обработка научных данных, поступающих с HMI, AIA и IRIS, будет отложена на продолжительное время, как и доступ к архивным данным в JSOC. SDO в целом ежемесячно предоставляет около 42 Тбайт данных. Хотя данные с SDO продолжат поступать, их пока нельзя обрабатывать в режиме реального времени, что негативно отразится на возможности оценки солнечной погоды. Сообщается, что до восстановления оборудования JSOC данные с прибора HMI будут храниться в Нью-Мексико. SDO, запущенная на орбиту в 2010 году, позволяет вести наблюдения за Солнцем, уделяя особое внимание его магнитному полю, циклам активности и влиянию на Солнечную систему, и помогает учёным лучше понять, как солнечная активность влияет на жизнь на Земле. HMI и AIA — два из трёх научных инструментов SDO. Как сообщается, данный инцидент не отразился на обработке данных, собираемых третьим инструментом, Extreme Ultraviolet Variability Experiment (EVE).

04.12.2024 [19:26], Владимир Мироненко

С Microsoft в Великобритании требуют £1 млрд за завышение расценок для клиентов облачных конкурентовВ минувший вторник на Microsoft подали в суд в Великобритании с обвинением в несправедливом завышении цен для клиентов конкурирующих облачных компаний, сообщил ресурс CNBC. В иске утверждается, что клиенты платформ Amazon Web Services (AWS), Google Cloud Platform и Alibaba Cloud, являющихся основными конкурентами облака Microsoft Azure, вынуждены платить больше за лицензии на Windows Server в инфраструктуре конкурентов. В качестве компенсации пострадавшие британские фирмы требуют выплатить £1 млрд. Microsoft предлагает фирмам, использующим Windows Server в Azure, более низкую цену, чем у прямых конкурентов на облачном рынке. В иске указано, что фирмы, пользующиеся серверным ПО Microsoft, фактически переплачивают за использование альтернативных облачных платформ. Утверждается, что Microsoft использует своё доминирующее положение на рынке облачных серверных ОС, устанавливая более высокие цены и побуждая клиентов переходить на Azure. Представляющая интересы истцов Мария Луиза Стази (Maria Luisa Stasi), глава отдела права и политики группы по защите цифровых прав Article19, сообщила CNBC, что «Microsoft пытается заставить клиентов использовать свой сервис облачных вычислений Azure и ограничить конкуренцию в секторе», добавив, что иск «нацелен на то, чтобы оспорить антиконкурентное поведение Microsoft, заставить её раскрыть суммы незаконных переплат компаний в Великобритании и вернуть деньги организациям, с которых несправедливо взимают завышенную плату». Коллективный иск против Microsoft включает тысячи компаний и организаций. Иск подан по модели opt-out, согласно которой участники включаются в группу истцов без надобности в обязательном волеизъявлении, если только они сами не откажутся от участия в процессе. Это означает, что любая потенциально пострадавшая компания автоматически учитывается в иске и может получить компенсацию в случае проигрыша Microsoft. Представитель Стази сообщил CNBC, что она представляет интересы клиентов Amazon, Google и Alibaba, но не самих облачных платформ. Ранее в этом году Microsoft заключила соглашение на €20 млн с поддерживаемой AWS группой лоббистов CISPE, что позволило ей избежать антимонопольного расследования ЕС по поводу обвинений в несправедливой практике лицензирования ПО в Azure. Вместе с тем в мировое соглашение не были включены Amazon Web Services (AWS), Google Cloud Platform и Alibaba Cloud. Вскоре после этого Google подала жалобу в Еврокомиссию на антиконкурентную практику лицензирования Microsoft. В июне 2023 года Google направила в Федеральную торговую комиссию США (FTC) письмо с обвинением Microsoft в антиконкурентной практике, в связи с чем регулятор начал подготовку к антимонопольному расследованию. Основанная Google новая группа Open Cloud Coalition (OCC) намерена поддерживать открытость на облачном рынке, в частности, с помощью поддержки деятельности антимонопольных органов. Microsoft, в свою очередь, утверждает, что за последние пару лет выручка Google и AWS только росла, что говорит о наличии конкуренции, а не об её отсутствии.

04.12.2024 [17:43], Сергей Карасёв

AWS построит распределённый ИИ-суперкомпьютер Project Rainier с десятками тысяч ИИ-ускорителей Trainium2Облачная платформа AWS официально представила инстансы EC2 Trn2 и Trn2 UltraServer — самые высокопроизводительные решения EC2, ориентированные на ИИ-приложения, машинное обучение и задачи инференса. В основу положены фирменные ускорители Amazon Trainium2 второго поколения. ИИ-ускорители Trainium2 содержат восемь ядер NeuronCore и 96 ГиБ памяти HBM с пропускной способностью 2,9 Тбайт/с. Ядра могут адресоваться и использоваться по отдельности или же пары физических ядер могут быть сгруппированы в один логический блок. Trainium2 обеспечивает FP8-быстродействие до 1,3 Пфлопс, а FP8-производительность в разреженных вычислениях достигает 5,2 Пфлопс. Инстансы EC2 Trn2 содержат 16 ускорителей Trainum2, связанных посредством интерконнекта NeuronLink. В сумме это даёт 128 ядер NeuronCore и 1,5 ТиБ памяти HBM с суммарной пропускной способностью 46 Тбайт/с. Производительность на операциях FP8 достигает 20,8 Пфлопс. Каждый инстанс включает 192 vCPU, 2 ТиБ памяти и адаптеры AWS Elastic Fabric Adapter (EFA) v3 на 3,2 Тбит/с. Утверждается, что инстансы Trn2 обеспечивают в четыре раза более высокую производительность, в четыре раза большую пропускную способность памяти и в три раза большую ёмкость памяти, нежели инстансы Trn1. Кроме того, экземпляры Trn2 предлагают на 30–40 % лучшее соотношение цены и производительности, чем EC2 P5e и P5en на базе GPU. Инстансы Trn2 доступны в регионе AWS US East (Огайо), а в ближайшем будущем появятся и в других зонах. В свою очередь, платформа UltraServer включает четыре инстанса Trn2 (64 ускорителя Trainum2) с интерконнектом NeuronLink с низкой задержкой. В сумме это даёт 512 ядер NeuronCore и 6 ТиБ памяти HBM с суммарной пропускной способностью 185 Тбайт/с. Быстродействие на операциях FP8 составляет 83 Пфлопс (332 Пфлопс в разреженных вычислениях). Новые узлы используют СЖО. Десятки тысяч ускорителей Trainium2 могут формировать кластеры EC2 UltraCluster. В частности, такую систему в рамках инициативы Project Rainier компания Amazon намерена создать в партнёрстве со стартапом Anthropic, который специализируются на технологиях генеративного ИИ. Интересно, что ИИ-суперкомпьютер Project Rainier будет распределённым — его узлы разместятся сразу в нескольких ЦОД. ВОЛС между дата-центрами организует Lumen. Одной из причин от попытки построить один гигантский кампус называется невозможность быстро получить достаточно энергии в одном месте, хотя у компании уже есть площадка рядом с АЭС. Недавно Amazon объявила о намерении удвоить инвестиции в Anthropic, доведя их до $8 млрд. Создание системы Rainier планируется завершить в следующем году. Ожидается, что она станет одним из крупнейших в мире вычислительных кластеров для обучения моделей ИИ. По заявлениям AWS, комплекс обеспечит в пять раз более высокую производительность по сравнению с платформой, которую Anthropic использовала до сих пор для разработки своих языковых моделей. Достанутся ли Anthropic и ресурсы ещё облачного ИИ-суперкомпьютера Project Ceiba, который получит 21 тыс. суперчипов NVIDIA Blackwell, не уточняется. Кроме того, по сообщению The Register, компания Amazon приоткрыла завесу тайны над ИИ-ускорителями следующего поколения — изделиями Trainium3. По сравнению с предшественниками они, как утверждается, обеспечат четырёхкратное увеличение быстродействия. Говорится, что Trainium3 станет первым специализированным ускорителем для ИИ и машинного обучения, созданным на основе 3-нм техпроцесса. Эффективность по сравнению с Trainium2 увеличится примерно на 40 %. Ожидается, что на коммерческом рынке изделия Trainium3 появятся в конце 2025 года. |

|