Лента новостей

|

11.07.2025 [18:32], Руслан Авдеев

Бюрократы да экологи: Microsoft посетовала на трудность развития ЦОД в ЕвропеК 2027 году Microsoft рассчитывает более чем удвоить мощность европейских дата-центров. При этом в компании предполагают, что добиться необходимых результатов будет непросто из-за раздутой бюрократии и экологических норм, сообщает The Register. Компания пообещала усилить поддержку европейского бизнеса на фоне трений с США, в т.ч. в области защиты пользовательских данных и обеспечения «цифровой надёжности». Ранее Microsoft пообещала расширить парк дата-центров в 16 европейских странах, нарастив в течение двух лет их мощность на 40 % и более чем вдвое увеличив присутствие в сравнении с 2023 годом — всего компания будет располагать более 200 ЦОД в регионе. Утверждается, что компания не выросла в Европе так же, как выросла в США, из-за ряда сложностей, в том числе регулирования деятельности и строгих оценок воздействия на окружающую среду. Именно поэтому работать в Европе немного сложнее и несколько дороже, чем в США, считают в Microsoft. В Европе компании угрожают моратории, да и не везде рады расширению её присутствия. Речь, по-видимому, идёт об Ирландии, где в некоторых регионах фактически введён мораторий на создание новых ЦОД из-за нехватки энергии, но в то же время проводится «зелёная» политика. Впрочем, в других странах быстро закупить много мощностей ЦОД тоже непросто, хотя именно это и требуется. С точки зрения Microsoft, время выхода на рынок играет решающую роль. За последние два года компания заключила много арендных сделок, что создало давление на компанию в условиях жёстких рыночных требований.

Источник изображения: Microsoft Microsoft хотела бы строить собственные дата-центры, но задержки в выдаче разрешений на покупку земель вынуждают использовать аренду как временное решение, чтобы не останавливать проекты. Однако инвестиции в колокацию становятся ненадёжными из-за масштабов проектов и бюрократических сложностей. Отдельно отмечается проблема с доступом к электроэнергии — в Европе планирование осуществляется на 18 месяцев дольше, чем где-либо ещё. Операторы энергосетей не справляются с нагрузкой, что приводит к задержкам в присоединении дата-центров. Из-за этого та же Ирландия теряет инвестиции в пользу скандинавских стран. Необходимость строительства новых ЦОД мешает Microsoft добиться «отрицательного» уровня выбросов к 2030 году. В отчёте об экоустойчивости за 2025 год компания заявила, что её выбросы всех типов (Scope 1, 2 и 3) увеличились на 23,4 % в сравнении с показателями 2020 года. Это не так плохо, как данные в докладе за предшествовавший год, где рост составил почти 30 % к 2020 году — в основном из-за развития ИИ и облака. Директор Microsoft по устойчивому развитию отметил, что в поставленные в 2020 году цели сравнимы «полётом на Луну». А пять лет спустя стало понятно, что до этого «полёта» ещё дальше. Впрочем, в Microsoft довольны тем, что рост является весьма скромным с учётом роста потребления энергии на 168 % и роста выручки на 71 % с 2020 года. Также указывается на усилия вроде подписания контрактов на 19 ГВт возобновляемой энергии в 16 странах (фактически покупке PPA) и строительстве дата-центров с применением дерева или низкоуглеродного бетона. Как утверждают в компании, это снижает углеродный след на 65 %.

11.07.2025 [15:02], Владимир Мироненко

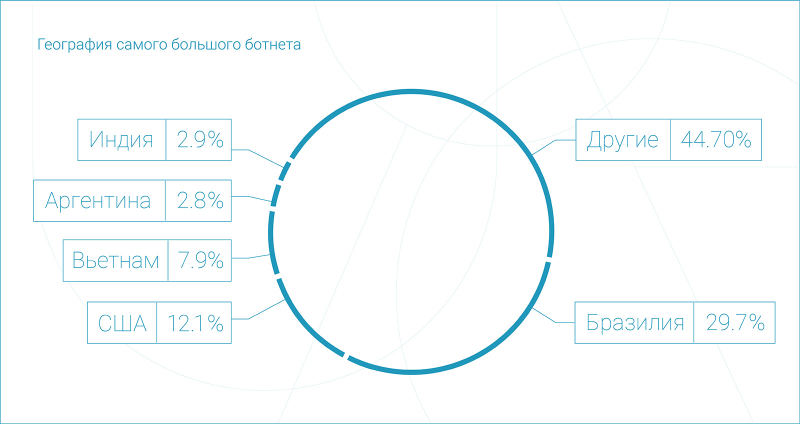

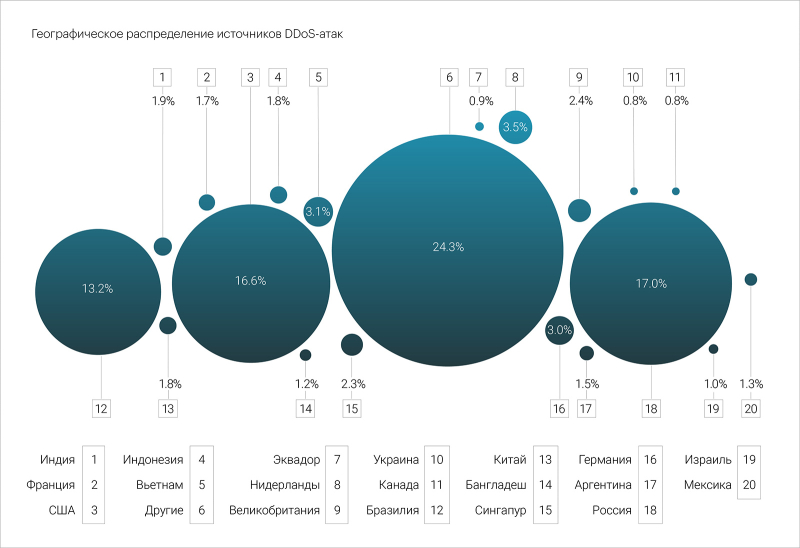

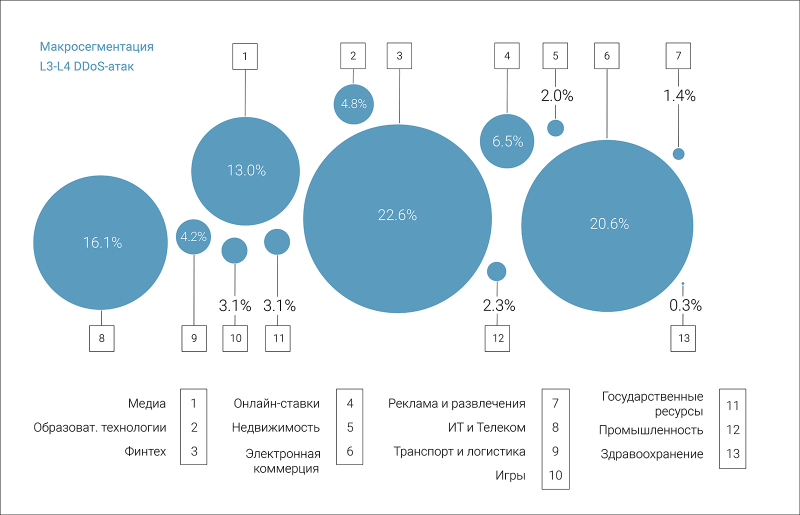

Curator: DDoS-атак во втором квартале стало в 1,5 раза больше, а рекордный ботнет вырос до 4,6 млн устройствКомпания Curator (ранее Qrator Labs) опубликовала отчёт, посвящённый статистике DDoS-атак, BGP-инцидентов и бот-активности во II квартале 2025 года, согласно которому общее число атак увеличилось на 43 % год к году. При это рост количество атак на уровне приложений (L7) был ещё больше — на 74 %. Чаще всего во II квартале DDoS-атакам на сетевом и транспортном уровне (L3–L4) подвергались сегменты «Финтех» (22,6 %), «Электронная коммерция» (20,6 %) и «ИТ и Телеком» (16,1 %), на которые пришлось 59,3 % от всех L3-L4 атак за этот период. Самая продолжительная атака в отчётном квартале была зафиксирована в микросегменте «Онлайн-букмекеры». Её продолжительность составила чуть более 4 суток — 96,5 часа. 16 мая исследователи зафиксировали новую атаку огромного ботнета, обнаруженного 26 марта 2025, которая в этот раз была направлена на организацию из сегмента «Государственные ресурсы» и продолжалась чуть больше часа. Если в марте ботнет состоял из 1,33 млн устройств, то в этот раз он включал в 3,5 раза больше устройств — порядка 4,6 млн IP-адресов. Чаще всего источниками DDoS-атак на уровне приложений в отчётном квартале были Россия (17 %) и США (16,6 %), третье место у Бразилии (13,2 %), значительно увеличившей долю за последний год. В исследовании также отмечен резкий рост трафика «плохих» ботов (+31 %), который значительно превысил прирост количества защищаемых ресурсов. Пик роста пришёлся на апрель-май, после чего в июне наступил некоторый спад. Главной целью «плохих» ботов во II квартале был сегмент «Электронная коммерция», доля которого выросла до 59,6 %. Далее по числу атак следуют сегменты «Онлайн-ставки» (16,5 %) и «Медиа» (9,6 %). На эти три сегмента пришлось более 85 % всего трафика «плохих» ботов.

11.07.2025 [14:49], Сергей Карасёв

В семейство самоуничтожающихся SSD Team Group P250Q вошли модели вместимостью до 2 ТбайтКомпания Team Group выпустила SSD серии P250Q, о подготовке которых сообщалось в марте нынешнего года. Особенностью новинок является аппаратная система самоуничтожения One-Click Data Destruction, которая гарантирует полное удаление хранящейся информации без возможности восстановления. В устройствах реализована запатентованная технология, основанная на использовании независимой электрической цепи для стирания данных на аппаратном уровне: осуществляется это путём непосредственного воздействия на чипы флеш-памяти. Для активации функции может использоваться специальная физическая кнопка: в зависимости от продолжительности нажатия на неё запускаются различные режимы уничтожения информации, а о ходе процесса информируют светодиодные индикаторы. Кроме того, предусмотрена интеллектуальная программная система автоматического возобновления процесса самоуничтожения на случай внезапного отключения питания. Таким образом, даже если выключить компьютер или извлечь накопитель после активации функции удаления, стирание данных будет завершено после восстановления подачи питания.

Источник изображения: Team Group SSD семейства P250Q выполнены в формате М.2 2280 с интерфейсом PCIe 4.0 x4 (NVMe 1.4). Применены чипы флеш-памяти 3D TLC NAND. В семейство входят модели вместимостью 256 и 512 Гбайт, а также 1 и 2 Тбайт. Заявленная скорость последовательного чтения информации достигает 7000 Мбайт/с, скорость последовательной записи — 5500 Мбайт/с. Величина MTBF (средняя наработка на отказ) превышает 3 млн часов. Диапазон рабочих температур — от 0 до +70 °C. Производитель предоставляет на накопители трёхлетнюю гарантию. Новинки ориентированы на использование в оборонном секторе, индустриальной сфере и в других областях, где требуется повышенный уровень конфиденциальности и защиты данных.

11.07.2025 [09:09], Сергей Карасёв

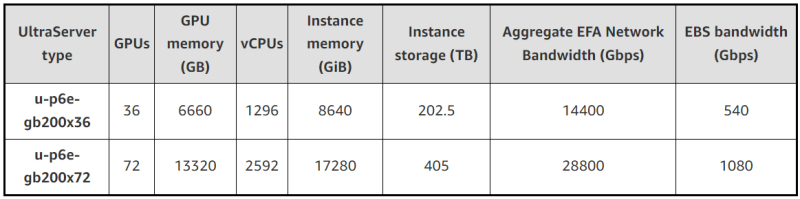

В облаке AWS появились инстансы EC2 P6e-GB200 UltraServer на базе ИИ-суперускорителей NVIDIA GB200 NVL72Облачная платформа AWS объявила о доступности высокопроизводительных инстансов EC2 P6e-GB200 UltraServer, рассчитанных на наиболее ресурсоёмкие нагрузки ИИ. В основу экземпляров положены суперускорители NVIDIA GB200 NVL72. Система GB200 NVL72 объединяет в одной стойке 18 узлов 1U, каждый из которых содержит два ускорителя GB200, что даёт в общей сложности 72 чипа B200 и 36 процессоров Grace. Задействована шина NVLink 5. Инстансы u-p6e-gb200-x72 предоставляют доступ к 72 чипам поколения Blackwell в одном домене NVLink, включая примерно 13,4 Тбайт памяти HBM3e. Производительность в режиме FP8 достигает 360 Пфлопс. Количество vCPU составляет до 2592, объём памяти — до 17 280 ГиБ. Кроме того, предоставляется до 405 Тбайт пространства для хранения данных. Используются адаптеры AWS Elastic Fabric Adapter (EFAv4) с низкой задержкой, агрегированной скоростью передачи данных 28,8 Тбит/с и поддержкой NVIDIA GPUDirect RDMA. Пропускная способность EBS достигает 1080 Гбит/с. Также доступны u-p6e-gb200-x36 с вдвое меньшими характеристиками.

Источник изображений: AWS Применяется система AWS Nitro, которая переносит функции виртуализации, хранения и сетевые операции на выделенное оборудование и ПО для повышения производительности и улучшения безопасности. Инстансы EC2 P6e-GB200 UltraServer объединяются в кластеры EC2 UltraCluster, что обеспечивает возможность безопасного и надёжного масштабирования до десятков тысяч ускорителей. AWS отмечает, что новые экземпляры подходят для работы с передовыми ИИ-моделями, насчитывающими триллионы параметров. При этом может использоваться сочетание экспертных и рассуждающих моделей. После резервирования ёмкости стоимость за инстанс списывается авансом, и цена не меняется после оплаты.

11.07.2025 [08:53], Руслан Авдеев

Агентство по охране окружающей среды США посетовало на непрекращающиеся попытки бездумного внедрения ИИПо словам Агентства по охране окружающей среды (EPA) США, стартапы очень часто бездумно обращаются к ИИ без чёткого плана действий и проверенных данных. В результате предприниматели терпят неудачи и удивляются, почему ничего не сработало, передаёт The Register, отмечая, что на практике ставка на ИИ окупается лишь в четверти случаев. Глава информационной службы EPA заявил, что ИИ — не панацея от всех проблем, как считают многие. ИИ необходимо внедрять в бизнес с учётом конкретных сценариев использования, но некоторые видят, как ИИ внедряется в других организациях, и стремятся к тому же, «не задавая правильных вопросов». По словам чиновника, часто для решения задачи вовсе не нужен ИИ, а попытка угнаться за модой может замедлить рост компании, а не ускорить его. Примечательно, что в последнее время доходность инвестиций в ИИ оказалась довольно низкой. EPA вторит и компания Maximus, ответственная за разработку IT-решений для госслужб США. Компания сообщила о жалобах на большое количество ботов «на службе» у государственных учреждений. В Maximus разработали процесс оценки решения задач — оказалось, что в некоторых случаях ИИ действительно вовсе не нужен. По словам EPA, простое делегирование текущих задач искусственному интеллекту не всегда позволяет добиться нужного эффекта. Например, в гипотетической ситуации, когда компания перекладывает заполнение некой формы, являющееся частью бизнес-процесса, на ИИ без изучения логики бизнес-процесса может оказаться, что задачу передали машине без особой необходимости и с затратой лишних ресурсов. Тщательный анализ процесса поможет ответить на действительно важный вопрос: нужно ли вообще выполнение конкретной задачи с помощью ИИ, если её обработка вручную будет в несколько раз дешевле? Другими словами, любой ИИ-проект настолько хорош, насколько хороши данные, использованные при его планировании. Сейчас EPA среды ведёт реестр ИИ-приложений для поиска «наилучших вариантов использования ИИ». При этом крупный IT-бизнес, наоборот, заинтересован в повсеместном внедрении ИИ. Так, Microsoft планомерно укрепляет лидерство в сфере ИИ, предлагая клиентам почти 2 тыс. моделей, в том числе от конкурентов.И это далеко не единственная платформа такого рода на рынке.

11.07.2025 [08:18], Владимир Мироненко

ГК «Гарда»: лишь треть российских компаний использует решения для защиты данныхСогласно исследованию ГК «Гарда», проведенном в апреле 2025 года, среди российских компаний большей популярностью из числа решений для защиты данных пользуются системы классов DLP (Data Leak Prevention, защита от утечки данных) и DAG/DCAP (Data Access Governance и Data-Centric Audit and Protection, контроль доступа и аудит с фокусом на данных), в то время как технологии защиты баз данных (DBF, Data Base Firewall) применяются реже. Виной этому является низкая осведомленность о таких решениях, несмотря на их высокую эффективность, отметили исследователи. В опросе приняли участие представители более 100 компаний из финансовой и промышленной отраслей, здравоохранения, ретейла и e-commerce, ИТ, а также транспортно-логистических и государственных организаций, большей частью со штатом более 1000 сотрудников (64 %). Две трети (67 %) участников опроса отдают предпочтение комплексным платформам, которые объединяют инструменты защиты (например, DBF и DAM, Database Activity Monitoring) с системами хранения, обработки и анализа данных. Такой подход характерен для финансового сектора, ИТ, промышленности, госсектора, а также сферы ретейла и e-commerce. Системы автоматизация поиска и классификации данных пока внедрили лишь 11 % компаний. Хотя более 85 % респондентов знакомы с каталогами данных, лишь треть использует их в своей деятельности. В свою очередь, маскирование данных применяют ⅔ компаний. Половина из них использует только динамическое маскирование, менее четверти — сочетают динамическое маскирование со статическим. Такие технологии больше всего получили распространение в ИТ, промышленном и финансовом секторах, меньше всего — в ретейле и e-commerce. Опрос показал, что взаимодействие между бизнесом и ИБ-подразделениями по-прежнему является «узким» местом. Чаще всего респонденты отмечали замедление процессов, а также проблемы с выдачей прав доступа и синхронизацией критичных активов. Лишь у 23 % компаний нет проблемам во взаимодействии с ИБ-командами. Как отметили в ГК «Гарда», реагирование на инциденты в сфере информационной безопасности в большинстве организаций уже либо автоматизировано полностью (23 %), либо реализовано в полуавтоматическом режиме с ручным подтверждением (39 %). По словам Ильи Лушина, директора по продуктам защиты данных группы компаний «Гарда», это говорит о постепенном росте зрелости ИБ-процессов, снижении ложноположительных срабатываний и стремлении перейти от мониторинга событий к реальной защите данных.

10.07.2025 [18:26], Владимир Мироненко

«Криптонит» представил российский инструмент для оценки безопасности 5G-сетейРоссийская компания «Криптонит» (входит в «ИКС Холдинг») представила модель sigmaAuth (σAuth), предназначенную для анализа безопасности протоколов анонимной аутентификации, применяемых в 5G-сетях. Новая разработка позволит повысить устойчивость мобильных сетей к кибератакам наряду с обеспечением защиты цифровой идентичности пользователей. Сообщается, что σAuth уже можно применять для анализа отечественных решений 5G-AKA-GOST и S3G-5G, которые сейчас проходят этап стандартизации в техническом комитете ТК26. В частности, с помощью σAuth можно выявлять уязвимости в протоколах связи и подтверждать их стойкость с помощью строгих математических доказательств. Модель опирается на парадигму «доказуемой стойкости», использующую математические методы для подтверждения безопасности протоколов, что делает её универсальным и перспективным решением для создания новых стандартов киберзащиты, а также проектирования и анализа протоколов безопасности в других цифровых инфраструктурах. Как отметили в «Криптоните», σAuth формализует понятие анонимности и учитывает сценарии, при которых нарушитель, например, может получить доступ к IoT-оборудованию. Это особенно важно в настоящее время, когда защита постоянных идентификаторов, таких как IMSI и SUPI, играет ключевую роль в обеспечении безопасности. Согласно данным GSMA Intelligence, в 2024 году число подключений в 5G-сетях по всему миру достигло 2 млрд. 5G-стандарт помимо смартфонов обеспечивает подключение промышленных систем, транспорта, датчиков, что создаёт широкую поверхность атаки. И одним из уязвимых элементов 5G-сетей является процесс аутентификации: злоумышленники могут перехватывать сообщения, отслеживать пользователей или подделывать цифровые идентификаторы, отметила «Криптонит». Как указано в пресс-релизе, разработанная специалистами «Криптонита» новая и более безопасная версия протокола аутентификации ECIES+5G-AKA была одобрена рабочей группой SA3 международной стандартизирующей организации 3GPP. Также компания представила исследования по разработке протокола аутентифицированной выработке ключей 5G-AKA-GOST, который позволит повысить защищённость российского 5G-сегмента.

10.07.2025 [17:30], Сергей Карасёв

Bloomberg: Китай строит в пустыне гигантский комплекс ИИ ЦОД для 115 тыс. ускорителей NVIDIA, поставки которых запрещены СШАНа окраине пустыни Гоби в Синьцзяне (автономный район на северо-западе Китая), по сообщению Bloomberg News, ведутся активные работы по строительству кампуса ЦОД для ИИ-задач. Согласно имеющейся информации, в этих дата-центрах будут применяться серверы с ускорителями NVIDIA, поставки которых запрещены в КНР в соответствии с американскими санкциями. Специалисты Bloomberg News проанализировали сведения, содержащиеся в инвестиционных одобрениях, тендерных документах и заявках китайских компаний. Утверждается, что масштабные планы Китая в отношении развития ИИ прямо предусматривают использование «запрещённых» продуктов NVIDIA, а не только местных решений вроде Huawei Ascend. В частности, в IV квартале 2024 года власти Синьцзяна (Xinjiang) и соседней провинции Цинхай (Qinghai) одобрили создание в общей сложности 39 дата-центров, в которых будет задействовано более 115 тыс. ИИ-ускорителей NVIDIA. Причём во всех случаях речь идёт об H100 и H200. Операторы ЦОД в Синьцзяне намерены разместить львиную долю этих ускорителей в одном крупном комплексе, который будет использоваться для обучения передовых ИИ-моделей и других ресурсоёмких нагрузок. Строительные работы организованы в уезде Иу (Yìwū). Сотрудникам Bloomberg News не удалось установить, каким способом китайские компании намерены приобретать изделия NVIDIA, закупки которых запрещены без получения специальных лицензий от правительства США. Местные операторы дата-центров, государственные чиновники и представители центрального правительства в Пекине отказались давать какие-либо комментарии по данному вопросу. Между тем, как отмечается в публикации, стоимость 115 тыс. указанных ИИ-ускорителей может составить миллиарды долларов, исходя из цен на чёрном рынке Китая. И всё же строительство комплекса ЦОД продолжается. Синьцзян, и особенно регион Хами (Hāmì), включающий уезд Иу, богаты ветровой и солнечной энергией, а также углём. Это позволит решить вопросы, связанные с энергообеспечением дата-центров. Дополнительными достоинствами выбранного региона являются доступность больших территорий, низкая стоимость земли и прохладный климат в высотных районах. Согласно тендерной документации, полученной Bloomberg, по состоянию на июнь 2025 года по семи проектам ЦОД в Синьцзяне либо начаты строительные работы, либо выиграны тендеры на услуги ИИ-вычислений. В частности, один из крупнейших проектов связан с энергокомпанией Nyocor из Тяньцзиня (Tianjin), которая специализируется на солнечной и ветровой энергетике. Инициатива предусматривает создание дата-центра на базе 625 серверов с ускорителями H100. Nyocor продаёт вычислительные мощности корпорации Infinigence AI — одной из крупнейших организаций в сфере ИИ-инфраструктуры в Китае. В документах по 27 другим проектам ЦОД, одобренным в Синьцзяне и Цинхае в прошлом году, упоминаются в общей сложности более 9 тыс. серверов и около 72 тыс. ускорителей H100/H200. Два высокопоставленных чиновника американской администрации заявили, что по их оценкам, в Китае имеется примерно 25 тыс. запрещенных ИИ-ускорителей NVIDIA: такое количество, как утверждается, не вызывает серьёзного беспокойства. Более того, даже в случае приобретения ещё 115 тыс. карт NVIDIA масштабы соответствующих ИИ-платформ в КНР окажутся несопоставимы с мощью развитой инфраструктурой ИИ в США. Нужно отметить, что за последние годы власти Китая потратили $6,1 млрд на строительство крупных кампусов ЦОД, тогда как ещё $28 млрд вложили частные инвесторы. Площадки дата-центров появились в регионе Внутренняя Монголия, провинциях Нинся, Ганьсу, Гуйчжоу, регионе Пекин-Тяньцзинь-Хэбэй, а также в дельте Янцзы и на других территориях. Однако многие подобные объекты оказались невостребованными из-за переоценённого спроса и архитектурных недоработок.

10.07.2025 [15:49], Владимир Мироненко

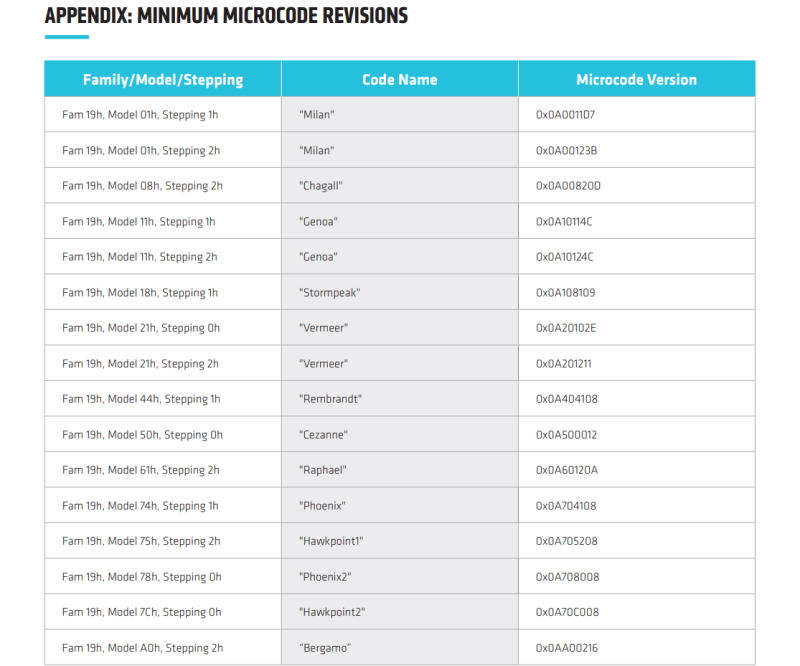

В процессорах AMD найдены уязвимости TSA, похожие на Meltdown и SpectreAMD сообщила об обнаружении нового класса микроархитектурных атак на свои процессоры — TSA (Transient Scheduler Attack). TSA подобны Meltdown и Spectre и затрагивают широкий спектр CPU AMD и способны привести к раскрытию информации. TSA включает сразу четыре уязвимости, которые были обнаружены исследователями Microsoft и Швейцарской высшей технической школы Цюриха (ETH Zurich). Две из них имеют средний уровень (medium severity) опасности, две — низкий уровень (Low severity). Несмотря на это Trend Micro и CrowdStrike оценили угрозу как «критическую», пишет ресурс The Register. Низкие оценки серьёзности объясняются высокой сложностью выполнения успешной атаки. AMD заявила, что её может осуществить только злоумышленник, способный запустить произвольный код на целевой машине, получив доступ через вредоносное ПО или вредоносную виртуальную машину, но для успешного выполнения атак требуются лишь низкие привилегии. Как утверждает AMD, TSA невозможно эксплуатировать через вредоносные веб-сайты, а для надёжного извлечения данных потребуется многократный запуск. Это связано с тем, что атака основана на использовании состояния «ложного завершения» (false completion), которое возникает, когда процессор ожидает быстрого завершения исполнения инструкций загрузки, но какое-либо условие препятствует их успешному завершению. В результате происходит повторная загрузка данных и выполнение зависимых операций, но из-за особенностей чипов «анализ времени выполнения может использоваться как источник утечки информации из микроархитектурных структур, оставшейся после спекулятивного выполнения других операций», — сообщил ресурс OpenNet. При использовании двух уязвимостей средней степени серьёзности успешные атаки на чипы AMD могут привести к утечке информации из ядра ОС. В других сценариях утечка данных может произойти также из приложений или виртуальных машин. Доступ к данным ядра потенциально может позволить злоумышленникам повысить привилегии, обойти механизмы безопасности, обеспечить персистентность и т.д. Баги низкого уровня могут привести к утечке внутренних данных о работе процессора, которые AMD не считает конфиденциальными.

Источник: AMD AMD заявила о двух различных вариантах TSA, которые могут быть реализованы на её чипах в зависимости от источника извлечения данных — TSA-SQ и TSA-L1.

Согласно технической документации AMD, уязвимости TSA-L1 вызваны ошибкой в использовании микротегов кешем L1 для поиска. Процессор может полагать, что данные находятся в кеше, хотя на самом деле это не так, что приводит к загрузке неверных данных, которые злоумышленник может затем вывести. Уязвимости TSA-SQ возникают, когда инструкция загрузки ошибочно извлекает данные из Store Queue, когда необходимые данные недоступны. В этом случае злоумышленник может обнаружить неверные данные и использовать их для извлечения информации, например, из ядра ОС, из ранее загруженных данных, даже если они выполнялись в другом контексте. Уязвимости проявляются в семействе процессоров AMD на базе микроархитектур Zen 3 и Zen 4, в том числе, в сериях Ryzen 5000/6000/7000/8000, EPYC Milan/Milan-X/Genoa/Genoa-X/Bergamo/Siena, Instinct MI300A, AMD Ryzen Threadripper PRO 7000 WX, EPYC Embedded 7003/8004/9004/97X4, Ryzen Embedded 5000/7000/V3000. В целом обновление микрокода и PI-прошивок (Platform Initialization) необходимо для чипов серий EPYC, Ryzen, Instinct.

10.07.2025 [15:10], Руслан Авдеев

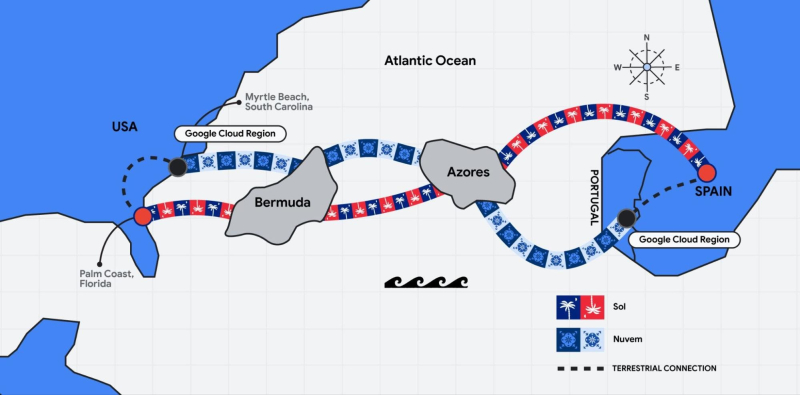

Google проложит свой второй трансатлантический интернет-кабель — SolКомпания Google анонсировала новую трансатлантическую кабельную систему Sol, которая соединит Испанию, Флориду (США), Бермудские и Азорские острова. Кабель станет единственным действующим оптоволоконным соединением между Флоридой и Европой. Sol, включающий 16 оптоволоконных пар, дополнит и подстрахует ВОЛС Nuvem между Южной Каролиной (США) и Португалией. Посадочная станция для Sol будет построена в городе Палм-Кост (Palm Coast) во Флориде при участии DC BLOX. Также будет проложен наземный кабельный маршрут, соединяющий Палм-Кост с облачным регионом компании в Южной Каролине. С испанской стороны за необходимую инфраструктуру в Сантандере (Santander) будет отвечать Telxsius. Sol поможет интегрировать регион Google Cloud в Мадриде в глобальную сеть IT-гиганта. В DC BLOX сообщили, что прокладка Google Sol позволит подключать и дополнительные кабели, а новый кампус Palm Coast Cable Landing Station укрепит позиции Флориды как центра глобальных коммуникаций». В Испании тоже рады новому проекту. Приветствуют инициативу и другие компании и структуры, в том числе власти Бермудских и Азорских островов.

Источник изображения: Google Как утверждают в Google, Sol увеличит пропускную способность, повысит надежность и сократит задержки для пользователей Google и клиентов Google Cloud по всему миру. Наряду с кабелями Nuvem, Firmina, Equiano и Grace Hopper, он также создаёт ключевые узлы связи «по ту сторону Атлантики», укрепляя экономику на местах и обеспечивая людям и компаниям всего мира доступ к преимуществам ИИ-сервисов. |

|