Материалы по тегу: сервер

|

20.10.2025 [16:00], Сергей Карасёв

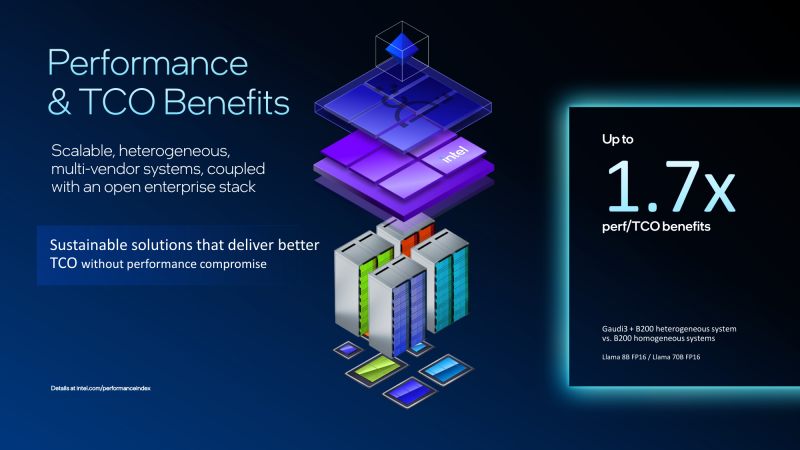

Экономичный гибрид: Intel объединила ускорители Gaudi 3 и NVIDIA B200 в одной ИИ-платформеКорпорация Intel показала гибридную стоечную систему Устройство объединяет посредством Ethernet массивы ускорителей Gaudi3 и NVIDIA B200. Платформа Gaudi3 Rack Scale 64 содержит до 16 вычислительных узлов. Каждый из них оснащён двумя неназванными процессорами Intel Xeon, четырьмя OAM-ускорителями Intel Gaudi 3 (64 в одном домене), четырьмя 400GbE-адаптерами NVIDIA ConnectX-7 и одним DPU NVIDIA BlueField-3, отмечает SemiAnalysis. Суммарно доступно 8,2 Тбайт HBM2e, а агрегированная пропускная способность составляет 76,8 Тбайт/с. Мощность суперускорителя составляет 120 кВт. Кроме того, задействованы 12 коммутаторов на чипах Broadcom Tomahawk 5 (51,2 Тбит/с). Для масштабирования и связи с другими узлами, в том числе NVIDIA, используется именно Ethernet. В составе гибридной системы ускорители Intel Gaudi 3 используются на decode-стадии, т.е. для генерации токенов, где важен объём и пропускная способность памяти, тогда как чипы NVIDIA B200 отвечают за prefill-задачи инференса, т.е. за обработку контекста и заполнение KVCache, где важна скорость вычислений. NVIDIA сама стремится к этому же подходу и уже анонсировала соускорители Rubin CPX, которые как раз будут заниматься работой с контекстом в сверхбольших моделях и созданием KV-кеша. Intel утверждает, что гибридная конфигурация из Gaudi3 и B200 позволяет достичь 1,7-кратного прироста производительности в расчёте на доллар совокупной стоимости владения (TCO) по сравнению с платформами, использующими только B200. Однако, как отмечается, эти заявления пока не подтверждены независимыми тестами. К тому же, программная платформа Gaudi3 отстаёт от платформы NVIDIA и является закрытой. Кроме того, нынешняя архитектура Gaudi приближается к концу своего существования, что ставит под сомнение жизнеспособность предложенной платформы в долгосрочной перспективе. Для Intel это, возможно, один из немногих шансов продать остатки Gaudi3. Между тем Intel недавно анонсировала GPU-ускоритель Crescent Island, разработанный специально для ИИ-инференса. Решение, в основу которого положена архитектура Xe3P, получит 160 Гбайт памяти LPDDR5X. Массовые поставки будет организованы не ранее 2027 года. Ранее компания отказалась от планов по выпуску Falcon Shores, сосредоточившись на Jaguar Shores. Сейчас же компания начала сворачивать поддержку ускорителей Ponte Vecchio (Intel Max) и Arctic Sound (Flex).

20.10.2025 [09:11], Сергей Карасёв

Pegatron представила ИИ-систему RA4802-72N2 на базе NVIDIA GB300 NVL72Компания Pegatron представила систему RA4802-72N2, предназначенную для наиболее ресурсоёмких ИИ-нагрузок, включая обучение больших языковых моделей (LLM) в масштабе и инференс. В основу положена платформа NVIDIA GB300 NVL72. Изделие GB300 содержит Arm-процессор Grace с 72 ядрами Neoverse V2 (Demeter) и два чипа Blackwell Ultra. В составе RA4802-72N2 объединены 18 вычислительных лотков, каждый из которых несёт на борту два Grace и четыре Blackwell Ultra. В сумме это даёт 36 процессоров Grace и 72 чипа Blackwell Ultra. Каждый из вычислительных узлов располагает 960 Гбайт памяти LPDDR5X и 1152 Гбайт памяти HBM3e. Таким образом, в общей сложности система оперирует примерно 17 Тбайт LPDDR5X и 20 Тбайт HBM3e. ИИ-производительность достигает 720 Пфлопс на операциях FP8/FP6. В состав RA4802-72N2 также входят девять коммутационных лотков. Общая пропускная способность интерконнекта NVLink составляет 130 Тбайт/с. В расчёте на вычислительный узел используются два адаптера NVIDIA ConnectX-8 и один DPU NVIDIA BlueField-3. Прочие характеристики включают контроллер Aspeed AST2600, модуль TPM 2.0, восемь отсеков для накопителей E1.S NVMe, коннектор M.2 2280/22110 NVMe. Система выполнена в форм-факторе 48U MGX с габаритами 600 × 2296 × 1200 мм. Применяется полностью жидкостное охлаждение. Полка питания оснащена шестью 1U-модулями мощностью 33 кВт. Поставки машины RA4802-72N2 уже начались.

16.10.2025 [16:44], Сергей Карасёв

Pegatron представила ИИ-сервер AS501-4A1-16I1 с СЖО и 16 ускорителями AMD Instinct MI355XPegatron анонсировала высокопроизводительный сервер AS501-4A1-16I1 с СЖО для задач НРС, а также ресурсоёмких приложений ИИ, включая инференс и обучение больших языковых моделей. Устройство выполнено в форм-факторе 5OU на аппаратной платформе AMD. До восьми серверов AS501-4A1-16I1 могут быть установлены в стойку RA5100-128I1. Это позволяет сформировать ИИ-систему высокой плотности, насчитывающую до 32 процессоров EPYC 9005 и до 128 ускорителей Instinct MI355X. Конструкция системы включает два CPU-узла и два лотка GPU. Каждая из CPU-секций допускает установку двух процессоров AMD EPYC 9005 Turin с показателем TDP до 500 Вт и 24 модулей оперативной памяти DDR5-6400 RDIMM. Таким образом, в общей сложности могут быть задействованы четыре чипа EPYC и 48 модулей ОЗУ. В свою очередь, каждый из GPU-лотков оснащается восемью ускорителями AMD Instinct MI355X, которые несут на борту 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. В общей сложности реализованы 12 слотов PCIe 5.0 x16 FHHL, в которые установлены десять однопортовых сетевых адаптеров 400GbE и два двухпортовых адаптера 10GbE В оснащение входят контроллер Aspeed AST2600, два сетевых порта 1GbE (RJ45), выделенный сетевой порт управления (RJ45), последовательный порт (разъём Micro-USB), интерфейсы USB 2.0 Type-C и Mini-DP. В дополнение к СЖО имеются десять вентиляторов охлаждения. Применяется шина питания ORv3 на 48 В DC.

14.10.2025 [09:54], Сергей Карасёв

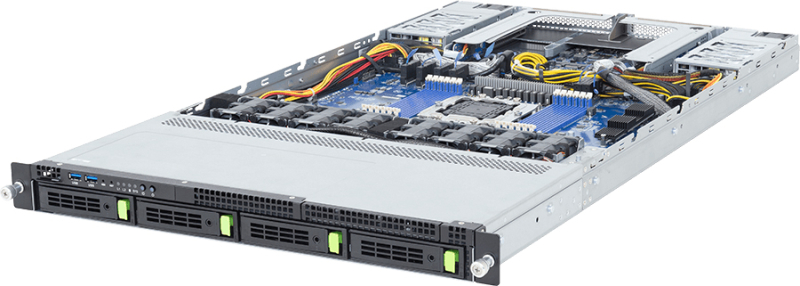

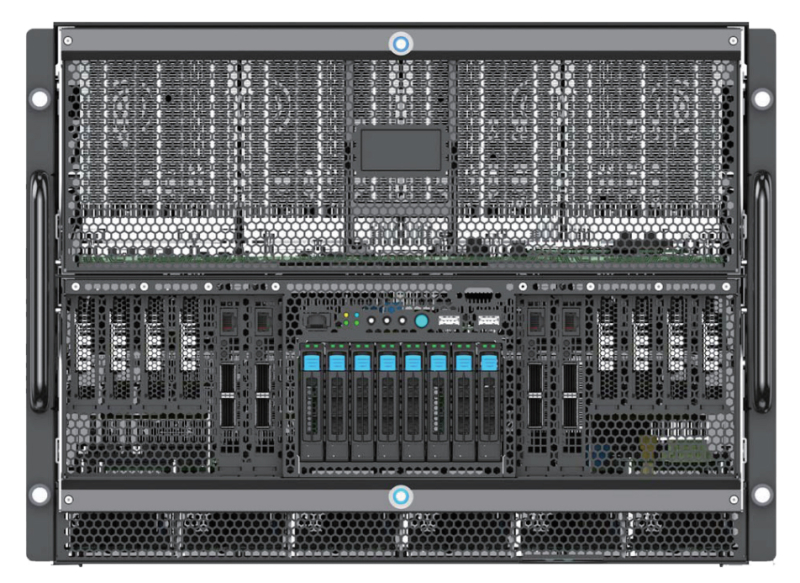

Giga Computing представила ИИ-сервер TO86-SD1 на платформе NVIDIA HGX B200Компания Giga Computing, подразделение Gigabyte, анонсировала высокопроизводительный сервер TO86-SD1 для обучения ИИ-моделей, инференса и ресурсоёмких HPC-задач. Новинка выполнена в форм-факторе 8OU в соответствии со стандартом OCP ORv3. Возможна установка двух процессоров Intel Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400 или MRDIMM 8000). Во фронтальной части предусмотрены отсеки для восьми SFF-накопителей с интерфейсом PCIe 5.0 (NVMe); поддерживается горячая замена. Есть коннектор M.2 2280/22110 для SSD (PCIe 5.0 x4). Упомянута поддержка CXL 2.0. Сервер несёт на борту ИИ-ускорители NVIDIA HGX B200 поколения Blackwell в конфигурации 8 × SXM. Суммарный объём памяти HBM3E составляет 1,4 Тбайт. Доступны 12 слотов PCIe 5.0 x16 для карт расширения FHHL с доступом через лицевую панель корпуса. Говорится о совместимости с NVIDIA BlueField-3 DPU и NVIDIA ConnectX-7 NIC.

Источник изображения: Giga Computing В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на базе Intel X710-AT2, выделенный сетевой порт управления 1GbE, разъёмы USB 3.2 Gen1 Type-C, Micro-USB и Mini-DP. Применяется система воздушного охлаждения с четырьмя 92-мм вентиляторами в области материнской платы и двенадцатью 92-мм кулерами в GPU-секции. Диапазон рабочих температур — от +10 до +35 °C. Заявлена совместимость с Windows Server, RHEL, Ubuntu, Citrix, VMware ESXi.

13.10.2025 [13:20], Сергей Карасёв

«Инферит» представил российские 2U-серверы для ИИ на базе Intel Xeon Emerald RapidsРоссийский поставщик IT-решений «Инферит» (ГК Softline) анонсировал серверы на аппаратной платформе Intel. Дебютировали модели UR2X2G4V1-D24, GR2X2G4V1-D24, UR2X2G4V1-D12 и GR2X2G4V1-D12 для решения различных задач. Все новинки выполнены в форм-факторе 2U. Они могут нести на борту два процессора Intel Xeon Sapphire Rapids или Xeon Emerald Rapids с TDP до 350 Вт. Поддерживается до 8 Тбайт оперативной памяти DDR5-4400/4800 в виде 32 модулей. Модель Inferit UR2X2G4V1-D24 предназначена для комплексных вычислений, виртуализации, облачных сервисов и работы с большими данными. Во фронтальной части расположены 24 отсека для SFF-накопителей SAS/SATA/NVME с поддержкой горячей замены. Доступны два слота PCIe 5.0 x16 и четыре слота PCIe 5.0 x8 для карт полной высоты, а также два разъёма OCP 3.0 (PCIe 5.0 x8). Предусмотрены выделенный сетевой порт управления 1GbE (RJ45), последовательный порт, разъёмы USB 3.0 и D-Sub. Установлены два блока питания мощностью 1300 Вт с сертификатом 80 Plus Platinum. Вариант Inferit GR2X2G4V1-D24 имеет аналогичные технические характеристики, но оснащается двумя ИИ-ускорителями на базе GPU суммарной мощностью до 600 Вт. Система ориентирована на развёртывание языковых моделей, обучение ИИ, 3D-визуализацию и 3D-рендеринг, работу с большими данными, комплексные научные вычисления, виртуализацию и облачные сервисы. Задействованы два блока питания на 2000 Вт с сертификатом 80 Plus Platinum. Сервер Inferit UR2X2G4V1-D12, в свою очередь, подходит для комплексных вычислений, виртуализации и облачных сервисов. Он оборудован 12 лицевыми отсеками для LFF/SFF-накопителей SAS/SATA/NVMe с поддержкой горячей замены. Прочие характеристики аналогичны версии Inferit UR2X2G4V1-D24. Наконец, модификация Inferit GR2X2G4V1-D12 схожа с версией GR2X2G4V1-D24, но при этом оснащена 12 посадочными местами для накопителей LFF/SFF. На все серверы опционально предустанавливается фирменная ОС «МСВСфера». Базовая гарантия составляет три года с возможностью продления до пяти лет. «Мы укрепляем свои позиции на рынке ИТ, развивая линейки собственных продуктов для бизнеса и госсектора. Новая серия серверов — это топовое решение в нашей продуктовой линейке для крупного бизнеса, науки и госучреждений. Конструируя их, мы ориентировались не только на производительность — надёжность, масштабируемость и минимум отказов были не меньшими приоритетами», — говорит «Инферит Техника».

08.10.2025 [15:30], Сергей Карасёв

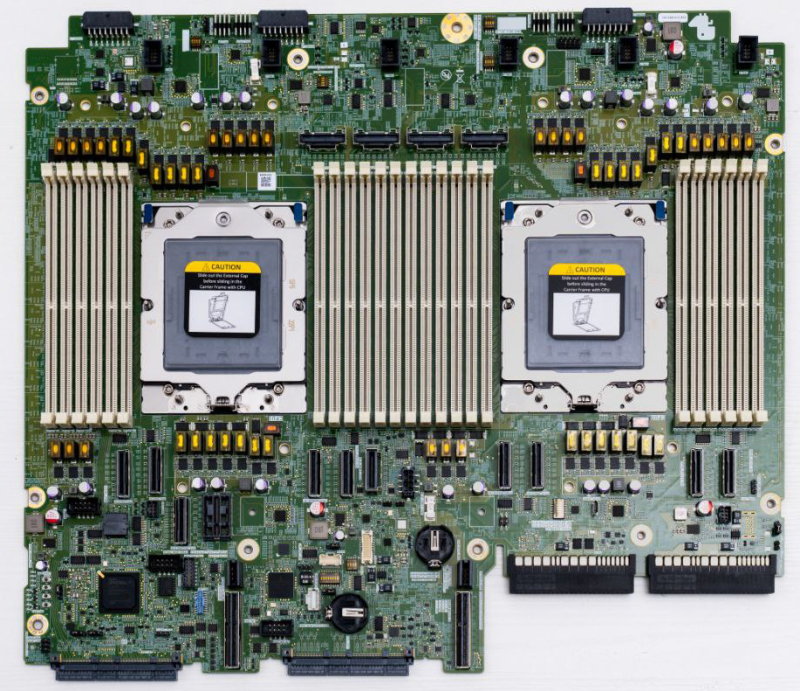

Selectel представила российскую серверную платформу на базе AMD EPYC 9005 TurinКомпания Selectel объявила о разработке собственной материнской платы, предназначенной для построения российских серверов на процессорах AMD EPYC 9005 Turin. Новинка дополнит представленные ранее серверы SSE-I112-G6 и SSE-I224-G6 на базе Intel Xeon 6 (6700). Изделие рассчитано на установку двух чипов в исполнении SP5, которые могут насчитывать до 192 вычислительных ядер. Доступны 24 слота для модулей оперативной памяти DDR5-6400. Платформа допускает подключение до 24 накопителей NVMe (PCIe 5.0) формата SFF и до 12 устройств стандарта LFF, что позволяет создавать высокопроизводительные серверы хранения данных. Прочие технические характеристики платы таковы: два разъёма OCP NIC 3.0 x16, два сетевых порта 1GbE, по два порта USB 3.2 на передней и задней панелях, контроллер ASPEED AST2600 (прошивка собственная). Могут быть использованы два райзера с поддержкой разъёмов FHFL PCIe 5.0: два x16 в первом и один или два x8/x16 во втором. Упомянуто управление питанием FPGA. По заявлениям Selectel, серверы на новой материнской плате могут заинтересовать корпоративных заказчиков из финансового сектора и телеком-операторов. Кроме того, такие устройства могут найти применение в сферах ИИ и НРС. Потенциальными покупателями также названы SaaS-компании, которые стремятся сократить операционные расходы. Заместитель генерального директора по разработке и эксплуатации продуктов Selectel, отмечает, что выпуск решений на базе процессоров AMD в дополнение к Intel-продуктам даёт возможность диверсифицировать технологические платформы. Это важно в условиях сформировавшейся геополитической обстановки, когда поставки зарубежных CPU могут быть нестабильными. Кроме того, заказчики получают дополнительную гибкость при построении IT-инфраструктуры.

03.10.2025 [08:58], Сергей Карасёв

Giga Computing представила серверы с Arm-чипами AmpereOne M для ИИ-инференсаКомпания Giga Computing, подразделение Gigabyte, анонсировала серверы R1A3-T40 и R2A3-T40, построенные на процессорах AmpereOne M, которые спроектированы специально для поддержания ресурсоёмких ИИ-нагрузок в дата-центрах. Представленные системы подходят для инференса, облачных приложений и пр. Модель R1A3-T40 выполнена в форм-факторе 1U, устройство R2A3-T40 — в корпусе 2U. В обоих случаях допускается установка одного чипа AmpereOne M, который может содержать до 192 кастомизированных 64-бит ядер на базе Arm v8.6+. Показатель TDP — до 425 Вт. Есть 12 слотов для модулей оперативной памяти DDR5-5600. Младшая версия располагает четырьмя фронтальными отсеками для накопителей LFF/SFF с интерфейсом SATA/SAS-4 или PCIe 5.0 (NVMe). Доступны два слота PCIe 5.0 x16 для карт расширения типоразмера FHHL и два разъёма OCP NIC 3.0 PCIe 5.0 x16. Сервер 2U, в свою очередь, оснащён 12 посадочными местами для SFF-накопителей (SATA/SAS-4 или PCIe 5.0), одним слотом PCIe 5.0 x16 и одним разъёмом OCP NIC 3.0 PCIe 5.0 x16. Новинки несут на борту контроллер ASPEED AST2600 и сетевой адаптер Intel I210-AT стандарта 1GbE. Есть выделенный сетевой порт управления 1GbE, а также коннектор M.2 для SSD формата 2242/2260/2280/22110 с интерфейсом PCIe 5.0 x4. Питание обеспечивают два блока мощностью 1600 Вт с сертификатом 80 PLUS Titanium. Предусмотрены три порта USB 3.2 Gen1 Type-A (два располагаются на лицевой панели), порт Micro-USB, интерфейс Mini-DP, гнёзда RJ45 для сетевых кабелей и аналоговый разъём D-Sub (только у модели R2A3-T40). Применена система воздушного охлаждения. Диапазон рабочих температур — от +10 до +35 °C.

02.10.2025 [12:25], Сергей Карасёв

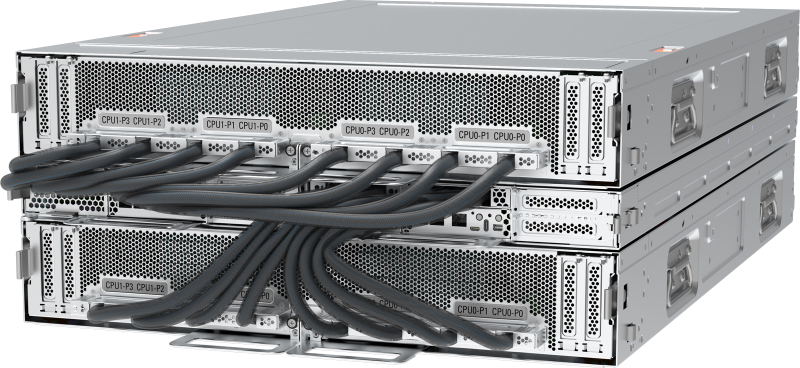

Dell представила сервер PowerEdge XR8720t для инфраструктур Cloud RANКомпания Dell анонсировала сервер PowerEdge XR8720t, ориентированный на заказчиков из телекоммуникационного сектора. Устройство, выполненное на аппаратной платформе Intel, предназначено для применения в составе инфраструктур Cloud RAN. По заявлениям Dell, PowerEdge XR8720t — это первое односерверное решение Cloud RAN. Отмечается, что обычно для таких задач требуются несколько серверов, что объясняется фундаментальными архитектурными ограничениями. Уникальная многосекционная архитектура Dell позволяет обойти эти сложности, используя единственный сервер в корпусе типоразмера 2U, в котором блоки располагаются бок о бок. Утверждается, что модель PowerEdge XR8720t специально разработана для периферийных и телекоммуникационных рабочих нагрузок, где задержка, отказоустойчивость и адаптивность имеют первостепенное значение. Полностью характеристики новинки не раскрываются. Известно, что сервер оснащается процессорами Xeon 6, насчитывающими от 32 до 72 вычислительных ядер. Это первый сервер с сетевым адаптером Intel OCP 3.0 E830-XXVDA8. Разъёмы для подключения сетевых кабелей располагаются во фронтальной части. Устройство заключено в корпус глубиной 433 мм. Питание обеспечивают два блока мощностью 1400 Вт. Диапазон рабочих температур простирается от -5 до +55 °C. Говорится о соответствии стандартам NEBS Level 3 и GR-3108 Class 1. Сервер рассчитан на эксплуатацию в неблагоприятных условиях. Ещё одним преимуществом решения названа модульная архитектура, благодаря которой клиенты смогут расширять мощности или добавлять новые узлы без необходимости перепроектирования всей инфраструктуры.

26.09.2025 [11:35], Сергей Карасёв

Стартап FuriosaAI представил ИИ-сервер NXT RNGD с производительностью 4 ПфлопсЮжнокорейский стартап FuriosaAI анонсировал высокопроизводительный сервер NXT RNGD для ресурсоёмких нагрузок ИИ. Утверждается, что в сценариях частного облака и локальных дата-центров новинка обеспечивает большую эффективность и меньшую стоимость владения по сравнению с решениями, оборудованными ускорителями на базе GPU. Система NXT RNGD заключена в корпус форм-фактора 4U. Она оснащена восемью специализированными ускорителями RNGD, которые выполнены в виде карт расширения PCIe 5.0 x16. Каждая из карт располагает 48 Гбайт памяти HBM3 с пропускной способностью до 1,5 Тбайт/с и 256 Мбайт памяти SRAM (384 Тбайт/с). Таким образом, суммарный объём памяти HBM3 составляет 384 Гбайт.

Источник изображения: FuriosaAI Ускорители RNGD обладают ИИ-производительностью до 512 Тфлопс в режиме FP8 и до 512 TOPS в режиме INT8. Таким образом, сервер NXT RNGD демонстрирует показатели до 4 Пфлопс и 4 тыс. TOPS соответственно. При этом общая потребляемая мощность составляет 3 кВт против 10,2 кВт у NVIDIA DGX H100. Таким образом, как отмечает FuriosaAI, стандартная серверная стойка мощностью 15 кВт способна вместить до пяти систем NXT RNGD, в то время как в случае NVIDIA DGX H100 может поддерживаться работа только одной машины. Среди других преимуществ платформы NXT RNGD разработчик называет простоту и удобство развёртывания в любом месте (в том числе с ограничениями по доступной мощности), суверенитет данных (подходит для приложений с обработкой конфиденциальной информации), гибкость в плане новых вариантов использования (доступен комплект SDK) и существенное снижение совокупной стоимости владения. В настоящее время сервер предлагается для тестирования клиентам по всему миру. Приём заказов на NXT RNGD начнётся в 2026 году.

25.09.2025 [11:37], Сергей Карасёв

Edgecore Networks представила ИИ-сервер AGS8600 на базе AMD EPYC Turin и Instinct MI325XКомпания Edgecore Networks анонсировала сервер AGS8600 формата 8U, построенный на аппаратной платформе AMD. Устройство, уже доступное для заказа, предназначено для решения ресурсоёмких задач в сферах ИИ, машинного обучения, НРС, научных исследований и пр. Система несёт на борту два 64-ядерных процессора EPYC 9575F поколения Turin с показателем TDP в 400 Вт. Доступны 24 слота для модулей оперативной памяти DDR5. Во фронтальной части расположены восемь отсеков для SFF-накопителей U.2 (NVMe): базовая конфигурация включает шесть SSD вместимостью 7,68 Тбайт каждый и два SSD на 1,92 Тбайт. Сервер укомплектован восемью GPU-ускорителями Instinct MI325X с 256 Гбайт памяти HBM3e и производительностью до 2,6 Пфлопс в режиме FP8. Задействованы семь линий Infinity Fabric в расчёте на GPU. В оснащение включены восемь однопортовых сетевых адаптеров BCM957608-P1400GDF00 400G QSFP112-DD PCIe Ethernet NIC. Кроме того, присутствуют два двухпортовых адаптера BCM957608-P2200GQF00 200GbE QSFP112 PCIe Ethernet NIC, выделенный сетевой порт управления 1GbE, контроллер ASPEED AST2600, два порта USB 3.0 и интерфейс D-Sub. За возможности расширения отвечают восемь слотов PCIe 5.0 x16 для карт половинной высоты и четыре разъёма PCIe 5.0 x16 для карт полной высоты. Питание обеспечивают шесть блоков мощностью 3300 Вт с сертификатом 80 Plus Titanium. Применена система воздушного охлаждения с 15 вентиляторами, допускающими горячую замену. Габариты составляют 448 × 850 × 351 мм. Диапазон рабочих температур — от +10 до +35 °C. На сервере используется ОС с ядром Linux. Среди поддерживаемого ПО упомянуты ROCm 6.2.4, RCCL 2.20.5, PyTorch 2.3/2.2/2.1/2.0/1.13, TensorFlow 2.16.1/2.15.1/2.14.1, JAX 0.4.26 и ONNX Runtime 1.17.3. |

|