Материалы по тегу: ии

|

24.07.2025 [15:50], Руслан Авдеев

AWS закрыла ИИ-лабораторию в ШанхаеAmazon Web Services закрыла лабораторию, занимавшуюся разработками в сфере искусственного интеллекта в Шанхае (КНР). Речь идёт о центре Amazon Web Services AI Shanghai Lablet, открывшемся в 2018 году, сообщает The Financial Times. Сколько сотрудников работало в китайском подразделении, не уточняется. Бывший сотрудник лаборатории сообщил, что структура ликвидируется в связи со «стратегическими изменениями на фоне напряжённости в отношениях США и Китая». Предполагается, что в основном сотрудники занимались разработкой инструментов для ИИ и вопросами обработки естественного языка. По имеющимся данным, именно шанхайская лаборатория сыграла ключевую роль в создании open source инструмента Deep Graph — библиотека предназначалась для работы с графовыми нейросетями. Хотя ранее в этом месяце США отменили правила, запрещавшие NVIDIA и AMD поставлять в КНР ослабленные ИИ-ускорители, представители американских властей подчеркнули, что в будущем контроль за продажами таких чипов вновь может быть ужесточён. В новейшем программном документе Белого дома AI Action Plan рекомендуется «использовать творческие подходы к обеспечению экспортного контроля» и противостоянию с соперниками в целом уделяется немало внимания.

Источник изображения: Jerry Zhang/unsplash.com Также не исключается, что закрытие ИИ-лаборатории связано с недавней волной сокращений в AWS по собственной инициативе, которая коснулась «как минимум сотни» должностей. Вероятно, это коснулось и подразделения AWS, занимающегося обучением и сертификацией. Как сообщал представитель Amazon, после тщательного анализа деятельности организации, её приоритетов и целей на будущее принято трудное бизнес-решение о ликвидации некоторых ролей в командах AWS. Сокращают работы над ИИ в Китае и некоторые другие компании. Ранее сообщалось, что консалтинговая McKinsey & Co. приказала местному подразделению воздержаться от проектов, связанных с системами генеративного ИИ. В китайском подразделении работают более 1 тыс. сотрудников. В начале марта появилась информация, что IBM закроет в стране R&D-центр, оставив без работы 1,8 тыс. сотрудников. Впрочем, IBM поспешила заверить, что не уходит из КНР. В 2025 году Microsoft предложила «релокацию» 700–800 сотрудникам в Китае. По данным СМИ, речь идёт о специалистах в сфере ИИ и облаков. По некоторым расчётам, это около 10 % от общего числа сотрудников в филиале, относящемся к Азиатско-Тихоокеанскому региону, в основном действующем в Китае. Предполагается, что ранее компания уже закрыла лабораторию IoT and AI Insider Lab в Шанхае. С 2017 года такие центры по всему миру в основном помогают клиентам компании создавать подключенные устройства с ИИ-функциями. Буквально на днях представитель Microsoft заявил о смене политики в отношении госзаказчиков из Минобороны США — теперь ни одна инженерная команда из Китая не будет оказывать техподдержку облаку Пентагона и связанным сервисам. Дело в том, что Microsoft, как оказалось, передавала данные из Пентагона на аутсорс китайским коллегам.

24.07.2025 [15:36], Руслан Авдеев

Мы и они: Белый дом представил агрессивный план развития ИИ в США для сохранения мирового лидерства

hardware

закон

ии

инвестиции

информационная безопасность

санкции

строительство

сша

цод

экология

энергетика

В минувшую среду Белый дом США выступил с программой AI Action Plan, призванной дерегулировать развитие ИИ и строительство дата-центров. Также план должен пресечь «идеологическую предвзятость» в ИИ-моделях, сообщает The Register. Развитие ИИ рассматривается как гонка сторонников Америки и её противников. С учётом этого должна формироваться как внутренняя, так и внешняя политика. Предполагается создание обширной ИИ-инфраструктуры и обеспечение её энергией. Для этого предлагается отвергнуть как «климатические догмы», так и бюрократическую волокиту. Утверждается, что ИИ слишком важен, чтобы душить его бюрократией на раннем этапе на всех уровнях. Суть плана — в выявлении правил, мешающих развитию ИИ-рынка и их немедленном устранении. Федеральное финансирование ИИ будет перенаправляться из штатов, где регулирование ИИ слишком строгое. Федеральную комиссию по связи (FCC) призвали выяснить, не мешают ли правовые нормы штатов её деятельности, а Федеральную торговую комиссию (FTC) — отложить расследования, мешающие ИИ-инновациям. Пентагон получит «зелёный свет» на испытания ИИ и автономных систем и перевод рабочих процессов на ИИ-системы — предусмотрена трансформация как боевых, так и офисных операций. План США предусматривает создание отраслевых «песочниц» для экспериментов в области ИИ, а также испытаний искусственного интеллекта в реальных условиях. Будут приняты меры по использованию ИИ и в органах власти, с прикомандированием ИИ-специалистов для помощи. Европейские эксперты обращают внимание на разницу в стратегии обработки данных в США и Европе. Если основная философия США — инновации прежде всего, то в Евросоюзе на первом месте — регулирование, безопасность и меры предосторожности. AI Action Plan стандартизирует госзакупки в сфере ИИ, но, в отличие схожего плана предыдущего президента, критерии оценки закупок будут существенно отличаться и, например, привлекать к работам будут тех специалистов, которые «объективны и свободны от идеологической предвзятости». Правда, по мнению экспертов, от предвзятости будет очень трудно избавиться. Сам Трамп и его сторонники заявляют о том, что отныне правительство США будет иметь дело только с тем ИИ, который «стремится к истине, справедливости и строгой беспристрастности». Правда, в самом плане предписывается выявлять предвзятость в китайских моделях. Кроме того, по словам некоторых экспертов, «борьба с предвзятостью» может создать трудности для бизнесов, вынужденных соблюдать нормы Евросоюза и других стран, поскольку модели вряд ли будут обучать отдельно для каждого региона и есть пределы того, в какой степени будет осуществляться дерегулирование. По-видимому, будет пересмотрена и работа с правообладателями, на материалах которых обучаются модели. Дополнительно будет вестись борьба с дипфейками, способными помешать судебным расследованиям. Например, в плане рассматривается возможность разработки программы оценки дипфейков Guardians of Forensic Evidence под контролем Национального института стандартов и технологий (NIST) и применение других мер. Операторы дата-центров смогут рассчитывать на большую свободу действий в строительстве, поскольку получат больше возможностей для работ вблизи водных ресурсов. Предусмотрено смягчение требований к охране окружающей среды, качеству воздуха и воды. Ведомства, распоряжающиеся большими участками федеральных земель, должны будут разрешать операторам ЦОД строительство на них объектов, включая электростанции. Предполагается, что в первую очередь от этого выиграют крупные игроки — по словам экспертов, без учёта интересов широкой общественности. Дополнительно Трамп подкрепил положения плана, подписав указ об ускоренном развитии индустрии дата-центров. При этом новые объекты будут требовать много электричества — план рекомендует масштабную модернизацию энергосетей. В фаворе оказались геотермальная и ядерная энергетика, которые дополнят нефтегазовый и угольный сектора генерации. Также, конечно, предусмотрено продолжение поддержки производства чипов для ИИ, но будут отменены некоторые условия финансирования, в частности тоже связанные с «идеологией». Возможно, это может быть связано с программами т.н. «инклюзивности» и др. для компаний, выпускающих микросхемы. Дополнительно план предполагает подготовку более квалифицированных специалистов вспомогательных специальностей вроде электриков, специалистов по HVAC и т.п., причём иногда прямо со школьной скамьи. В посвящённом дипломатии разделе делается чёткое разделение на «мы» и «они». В нём описывается некий ИИ-альянс, который будет получать доступ к американским ИИ-технологиям. В его поддержку будет разработан ряд мер по предотвращению попадания технологий в недружественные страны — в т.ч. предусмотрена проверка местоположения продуктов и решений и прочие меры мониторинга спецслужбами. Если при Байдене была разработана трёхуровневая система, в рамках которой передовые микросхемы попадали только самым преданным сторонникам США, то при Трампе её отменили до вступления в силу. Вероятно, будет действовать иная система, с новыми мерами контроля в отношении Китая и некоторых других регионов, но более мягким контролем в отношении других стран. Так, администрация снова разрешила поставки некоторых ускорителей NVIDIA в КНР, но в то же время запретила поставки в ОАЭ. Администрация Трампа ожидает, что союзники будут строго соблюдать правила экспортного контроля, это будет регулироваться соглашениями между небольшим числом стран. В документе прямо говорится, что правительство отказывается от более широких многосторонних соглашений. Другими словами, Вашингтон намерен сотрудничать со своими ближайшими партнёрами для «продвижения инноваций и американских ценностей». Ещё одной особенностью плана является его особое отношение к рискам. Если ранее учитывался ряд «проблемных» вопросов, связанных с ИИ, от вопросов соблюдения гражданских прав до прав сотрудников, то новая концепция рисков уделяет больше внимания злоумышленникам, использующим ИИ, призывает к сотрудничеству разработчиков ИИ-моделей для повышения безопасности ПО и уделяет внимание необходимости создания безопасных ЦОД для Пентагона, разработке безопасных ИИ-решений для военных ведомств и др. Хотя такие меры, возможно, пригодились бы большинству стран, есть немало других рисков, требующих повышенного внимания — социальных, этических и др., которым в новом плане не уделяется особенного внимания. Для страны, которая выделяет на ИИ огромные средства, ситуация довольно опасная.

24.07.2025 [11:37], Сергей Карасёв

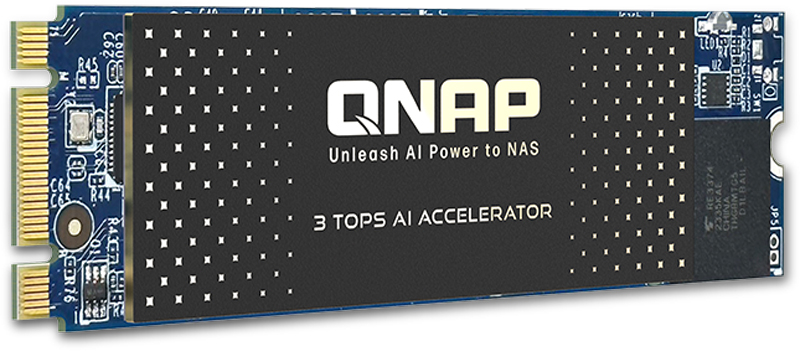

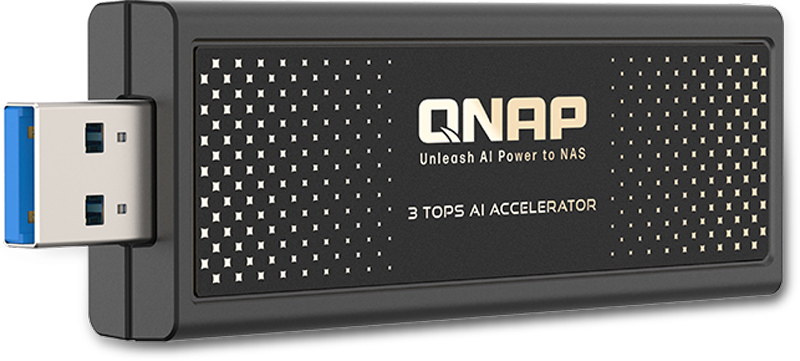

QNAP выпустила ИИ-ускорители для NAS: QAI-M100 и QAI-U100Компания QNAP Systems анонсировала ИИ-ускорители QAI-M100 и QAI-U100, предназначенные для решения различных задач на периферии: это может быть распознавание лиц и объектов, анализ данных в режиме реального времени и пр. Новинки могут использоваться с сетевыми хранилищами QNAP. Изделие QAI-M100 выполнено в форм-факторе M.2 2280 (M+B key) с интерфейсом PCIe 2.0 x1. Задействован процессор Rockchip RK1808 с двумя вычислительными ядрами Arm Cortex-A35, работающими на частоте до 1,6 ГГц. Интегрированный нейропроцессорный блок с поддержкой TensorFlow, Caffe и ONNX обеспечивает производительность до 3 TOPS на операциях INT8. Модуль VPU способен декодировать видеоматериалы H.264 в формате 1080p60 и кодировать 1080p30. Говорится о поддержки памяти LPDDR2/LPDDR3/DDR3/DDR3L/DDR4-800 (в оснащение ускорителя входит 1 Гбайт). В комплект поставки включён тонкий радиатор для рассеяния тепла. В свою очередь, вариант QAI-U100 представляет собой внешний ускоритель в виде USB-брелока с интерфейсом USB 3.2 Gen1. Размеры составляют 92,5 × 29 × 11 мм. Прочие технические характеристики аналогичны устройству типоразмера М.2.

Источник изображений: QNAP Для работы с новинками требуется NAS под управлением QTS 5.2.1.2930 build 20241025 (или более поздней версией) или QuTS hero h5.2.1.2929 build 20241025 (или выше). Обеспечивается совместимость с софтом QNAP AI Core v3.5.0 (и выше), Multimedia Console v2.7.0 (или более поздними версиями) и QuMagie v1.5.1 (и выше).  Модель QAI-M100 может устанавливать в такие сетевые хранилища QNAP, как TS-435XeU, TS-473A, TS-673A, TS-h765eU и TS-873A. Модификация QAI-U100 может подключаться к различным NAS с количеством отсеков от трёх до 16, включая ТС-332Х, TS-432PXU, TS-432PXU-RP, TS-432X, TS-432XU, TS-432XU-RP, TS-435XeU, TS-473A, TS-632X, TS-673A, TS-h765eU, TS-832PX, TS-832PXU, TS-832PXU-RP, TS-832X, TS-832XU, TS-932PX, TS-932X, TS-h973AX, TS-1232PXU-RP, TS-1232XU, TS-1673AU-RP и др.

23.07.2025 [23:47], Руслан Авдеев

Курируемый OpenAI ИИ-мегапроект Stargate с трудом продвигается вперёд, но самой OpenAI это не мешаетПроект Stargate под руководством SoftBank, OpenAI и Oracle при участии Microsoft, Arm, NVIDIA и MGX должен укрепить лидерство Америки в сфере искусственного интеллекта. Но, как оказалось, проект стоимостью до $500 млрд с трудом сдвинулся с мёртвой точки, а планы его стали намного скромнее, сообщает The Wall Street Journal. Через полгода после анонса Stargate компании-партнёры всё ещё не заключила ни одной сделки по строительству ИИ ЦОД. По данным некоторых источников, знакомых с вопросом, SoftBank и OpenAI, совместно руководящие проектом, имеют разногласия относительно ключевых вопросов партнёрства, включая выбор мест для строительства объектов. Кроме того, хотя в январе компании пообещали немедленно инвестировать в Stargate $100 млрд, сейчас цель намного скромнее — построить к концу году небольшой ЦОД, вероятно, в Огайо (США). Не особенно активный старт препятствует амбициям SoftBank, ранее в этом году выделившей $30 млрд на OpenAI. Это крупнейшая инвестиция в стартап за всю его историю. SoftBank пришлось влезть в долги, продать активы и буквально сделать на компанию судьбоносную для себя ставку. Инвестиции позволили компании принять участие в проекте Stargate. Однако уже весной Softbank столкнулась с трудностями в связи новыми пошлинами США. При этом на словах у компаний дела идут отлично, они готовы построить ЦОД на 10 ГВт в нескольких штатах. Однако OpenAI «устремилась вперёд» без SoftBank, подписывая соглашения об аренде и строительстве ЦОД с другими операторами. Недавно она заключила сделку по аренде у Oracle 4,5 ГВт мощностей и 2 млн ИИ-ускорителей в нескольких штатах в ближайшие три года, согласно которой компания Сэма Альтмана (Sam Altman) будет выплачивать партнёру более $30 млрд/год. Softbank в этой сделке не участвует. Вместе с кампусом Stargate I в техасском Абилине (Abilne), который создаётся усилиями Crusoe Energy и всё той же Oracle, у OpenAI уже законтрактованы 5 ГВт, т.е. ровно столько, сколько она и планировала получить на первом этапе проекта за примерно $100 млрд. Кроме того, ещё одним крупным подрядчиком OpenAI стала CoreWeave. С ней заключены контракты на $16 млрд (11,9 млрд + 4 млрд). Сейчас она активно арендует или скупает ЦОД, преимущественно у бывших майнеров (как и она сама и та же Crusoe). Нюанс в том, что ключевым заказчиком CoreWeave всё это время была Microsoft, которая арендовала мощности в интересах OpenAI. Вторым же по величине клиентом оказалась NVIDIA, которая инвестировала в CoreWeave, первой дала ей дефицитные ИИ-ускорители, а потом сама же арендовала их. При этом между Microsoft и OpenAI сохраняются партнёрские отношения, но разлад между ними очень серьёзен. Впрочем, источники сообщают, что несмотря на медленный старт Stargate и разногласия, в SoftBank оптимистично настроены и намерены вложить в компанию ещё больше средств. Глава SoftBank Масаёси Сон (Masayoshi Son) давно мечтал занять видное место на рынке ИИ и за последние 10 лет вложил более $140 млрд в перспективные стартапы в этой сфере, но упустил возможность присоединиться к OpenAI и конкурентам до запуска ChatGPT, а также потратил средства на некоторые неудачные проекты вроде WeWork. Значительного успеха бизнесмен добился в 2016 году, купив Arm, капитализация который за последние пару лет значительно выросла. Осенью 2024 года Сон сосредоточил внимание на OpenAI, а Сэм Альтман уже тогда имел гигантские амбиции, заявив, что для следующего этапа развития ИИ потребуются триллионы долларов. В январе 2025 года партнёры пообещали Трампу потратить на ИИ в США $500 млрд к 2029 году. На запуск совместного предприятия OpenAI и SoftBank обещали выделить по $18 млрд. Ожидалось, что оно займется разработкой и строительством ЦОД, а затем сдаст их в аренду OpenAI. Говорилось, что Сон станет председателем СП, SoftBank сосредоточится на финансах, а OpenAI — на операционной деятельности. Первоначально партнёрами назывались Oracle и MGX из ОАЭ, но их роль была неизвестна. Сейчас же Oracle говорит, что фактически Stargate ещё нет. По словам людей, знакомых с ситуацией, одним из камней преткновения между OpenAI и SoftBank стал вопрос о том, насколько масштабно следует строить ЦОД на площадках, связанных с SB Energy — разработчиком энергетических решений, поддерживаемым SoftBank. Stargate надеется использовать новую, недорогую конструкцию ЦОД для своего первого проекта в Огайо. Компаниям ещё предстоит найти площадки, построить инфраструктуру, закупить ИИ-чипы и обеспечить питание ЦОД, а также найти инвесторов, которые покроют большую часть расходов и решить другие вопросы. Тем временем обучение новых ИИ-моделей требует всё больше ресурсов и компаниями вроде OpenAI приходится вкладывать всё больше средств задолго до того, как появится прибыль — если появится. Годовой контракт OpenAI с Oracle на $30 млрд приблизительно в три раза превышает годовую выручку, недавно спрогнозированную компанией Альтмана. Она ежегодно теряет миллиарды долларов, рассчитывая, что в будущем её выручка многократно увеличивается за счёт платных услуг и рекламы. Впрочем, не она одна. По слухам, xAI «сжигает» по $1 млрд в месяц в расчёте на будущий успех.

23.07.2025 [17:20], Владимир Мироненко

Идея создания национального аналога SAP не нашла поддержки у бизнесаПредложение правительства о создании консорциума для разработки национальной ERP-системы, появившееся после сообщения о том, что «Севергрупп» до сих не удалось найти отечественную замену немецкой SAP, покинувшей Россию в 2022 году, не нашло поддержки у бизнеса, пишет РБК. Ранее против этой инициативы выступила «1С». На заседании правления Ассоциации предприятий компьютерных и информационных технологий (АПКИТ), которая включает крупнейшие компании по разработке и внедрению ПО, дистрибуции и системной интеграции, пришли к выводу о нецелесообразности расходования государственных средств на создание национальной ERP, когда на рынке уже имеются зрелые решения. К тому же это противоречит политике правительства, предложившего ранее механизм «рынок в обмен на инвестиции», когда компании инвестируют средства в доработку своих программ в обмен на упрощение процедуры госзакупок. Представитель Минцифры сообщил РБК, сейчас формируется состав участников нового консорциума, который должен выявить проблемы, мешающие переходу на российские ERP, предложить пути их преодоления и сказать, чем может помочь государство, добавив, что сейчас ряд российских компаний ведёт эту работу на базе Национального центра компетенций по информсистемам управления холдингом (АНО НЦК ИСУ). Индустриальные центры компетенций (ИЦК) помогают в доработке и внедрении уже существующих на рынке ERP, но не занимаются разработкой новых. Вместе с тем «Севергрупп» ведёт переговоры о повторном создании консорциума для доработки отечественной ERP, поскольку используемая сейчас платформа SAP без регулярных обновлений устареет. Также поддержала идею создания консорциума корпорация «Галактика», но только при участии в нём вендоров наряду с крупнейшими пользователями. В свою очередь, в группе «УльтимаТек» предложили для ускорения замещения SAP в крупных компаниях признать ERP-системы частью критической информационной инфраструктуры. В РЖД сообщили, что полностью перейдут в 2027 году на платформу «1С». Это решение выбрали и в «Росатоме», причём недостающие функции разрабатывает дочерняя компания «Гринатом». В «Ростехе» рассказали, что совместно с 1С разрабатывают и внедряют ERP-платформу на предприятиях «Объединённой авиастроительной корпорации» и «Объединённой двигателестроительной корпорации», планируя в дальнейшем запустить её на других своих предприятиях.

23.07.2025 [17:18], Руслан Авдеев

Anthropic намерена привлечь инвестиции с Ближнего Востока, хотя сама этому не очень радаAnthropic намерена привлечь инвестиции из ОАЭ и Катара, сообщил глава компании Дарио Амодей (Dario Amodei) во внутренней памятке сотрудникам. Он добавил, что бизнес фактически невозможно вести, пытаясь сделать так, чтобы «плохие люди» не могли извлечь выгоду, сообщает Wired. От работы с Ближним Востоком отказаться не удастся. Ранее компания выступала против поставок ИИ-ускорителей в КНР и страны Ближнего Востока. Информация появилась на фоне конкуренции ИИ-бизнесов за привлечение капитала, необходимого для разработки передовых ИИ-моделей и развития ЦОД. Так, в январе 2025 года OpenAI анонсировала проект Stargate, финансирование которого во многом возложено на государственного инвестора MGX из ОАЭ, а четыре месяца спустя компания объявила о намерении построить в Абу-Даби крупный дата-центр. Anthropic дата-центры здесь строить не намерена. Anthropic подчёркивает, что «цепочка поставок» для создания передовых ИИ моделей должна находиться в США для сохранения лидерства Америки, но в компании считают важным делиться преимуществами ИИ с другими регионами мира, если такие действия не противоречат её «Политики использования» продуктов. Более того, в 2024 году Anthropic отказалась от инвестиций из Саудовской Аравии по соображениям «национальной безопасности». При этом криптобиржа FTX, владевшая 8 % Anthropic, обанкротилась, и значительная часть акций компании на сумму около $500 млн досталась ATIC Third International Investment из ОАЭ. В мае 2025 года президент США Дональд Трамп (Donald Trump) посетил ОАЭ и Саудовскую Аравию в рамках поездки, в основном посвящённой инвестициям. Во встрече приняли участие и представители технологической индустрии, включая Илона Маска (Elon Musk), Сэма Альтмана (Sam Altman) и главу NVIDIA Дженсена Хуанга (Jensen Huang). Руководства Anthropic на встрече не было, хотя, по словам Амодея, в этом регионе сосредоточено около $100 млрд инвестиционного капитала. Если компания желает остаться на переднем крае инноваций, доступ к таким деньгам даст серьёзное преимущество, без него сохранять лидерство будет намного сложнее. Компания намерена привлекать целевые, «чисто финансовые» инвестиции из стран Персидского залива, в то же время не давая возможности влиять на неё. Однако Амодей признал, что инвесторы способны добиться «мягкого влияния» благодаря обещанию будущих инвестиций, что усложнит отказ от сотрудничества. Бизнесмен считает, что стоит посмотреть, сколько можно получить без уступок. По его мнению, речь всё равно идёт о миллиардах долларов. Компания выступила против создания ИИ-кластеров на Ближнем Востоке и поставок NVIDIA H20 в КНР, заявляя, что «цепочка поставок» для ИИ — слишком опасный инструмент. В итоге США разрешили поставки H20 Китаю, но приостановили поставки более мощных ускорителей в ОАЭ. Амодей опасается, что без централизованных запретов компании станут получать средства, всё более ввязываясь в сотрудничество с Ближним Востоком. Впрочем, они, по словам Амодея, уже вынуждены вести дела с регионом по отдельности, не сумев сформировать общей позиции. Бизнесмен подчеркнул, что решение о будущем сотрудничестве, как и многие другие решения, имеет свои минусы, но в целом в компании считают его правильным. Осталось дождаться новостей о том, посчитают ли в странах Персидского залива правильным сотрудничество с компанией, придерживающейся подобных взглядов — особенно на фоне того, что желающие получить инвестиции буквально выстраиваются в очередь.

23.07.2025 [15:46], Руслан Авдеев

Илон Маск объявил, что ИИ-суперкомпьютер xAI Colossus 2 запустят в ближайшие неделиОснователь ИИ-стартапа xAI Илон Маск (Elon Musk) поделился в социальной сети X информацией о будущем второго кампуса ЦОД в Мемфисе (Теннесси). В числе прочего он объявил намерении запустить в эксплуатацию суперкомпьютер Colossus 2 в ближайшие недели, сообщает Commercial Appeal. По его словам, Colossus 2 получит 550 тыс. ИИ-ускорителей. Компания располагает в городе двумя кампусами — Colossus 1 и Colossus 2. Первый расположен на территории бывшего завода Electrolux и включает 230 тыс. укорителей, в том числе 30 тыс. NVIDIA GB200. Система используется только для обучения, инференс осуществляется в облаках партнёров xAI. Второй кампус, Colossus 2 на площадке Тулейн-роуд (Tulane Road), на первом этапе получит 110 тыс. GB200 и GB300, что потребует 170 МВт энергии. Он должен начать работу в течение нескольких недель. Сроки развёртывания оставшихся 440 тыс. ускорителей не определены, поскольку поставки NVIDIA GB300 задерживаются. В феврале дочерняя структура xAI, компания CTC Property, купила более 75 га вдоль Тулейн-роуд за $70,9 млн. С тех пор, как xAI объявил о планах довести количество ускорителей Colossus до 1 млн, всё чаще возникает вопрос, как именно компания намерена снабжать свой проект энергией. В мае Маск объявил, что Colossus 2 станет первым гигаваттным ИИ-кластером. 15 июля в xAI подтвердили, что компания работает с Memphis Light, Gas and Water (MLGW) и Tennessee Valley Authority (TVA) над обеспечением объекта питанием. MLGW подтвердила, что у неё есть договор на поставку 500 кВт объекту xAI на Тулейн-роуд. А 16 июля MXZ Tech LLC, дочерняя компания xAI, приобрела территорию бывшей электростанции Duke Energy (46 га) неподалёку от кампуса Colossus 2. Этот объект сохранил подключение к энергосети TVA. Кроме того, кампус Colossus 2 уже получил 168 модулей Tesla Megapacks. По-видимому, этот кампус тоже не обойдётся без газовых турбин, и использование которых для питания Colossus 1 вызвало недовольство местных экоактививстов NAACP и SELC. Впрочем, пока непонятно, состоится ли серьёзное разбирательство. Совсем недавно Илон Маск сообщил о намерении ввести в эксплуатацию эквивалент 50 млн NVIDIA H100 в течение пяти лет — это ответ на недавнее заявление OpenAI о намерении освоить более 1 млн ускорителей к концу текущего года, а в будущем получить в своё распоряжение 100 млн ускорителей. Сейчас xAI намерена найти ещё $12 млрд на закупку ускорителей.

23.07.2025 [12:51], Сергей Карасёв

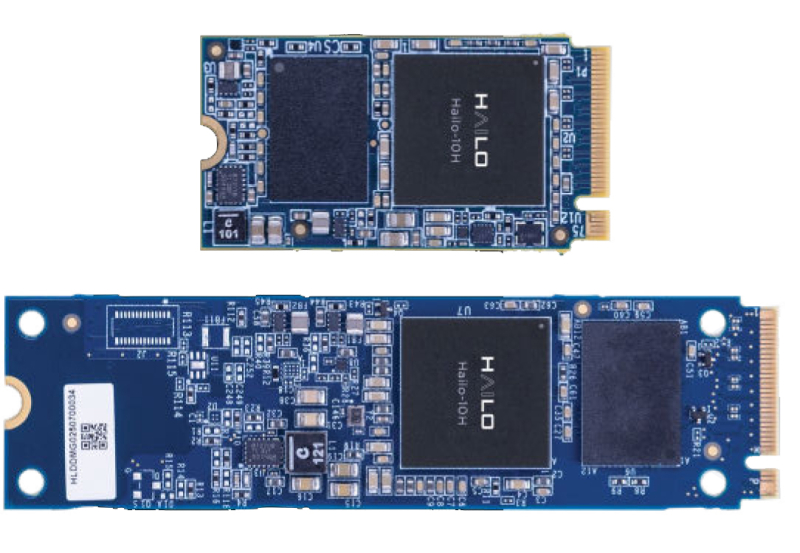

Ускоритель Hailo-10H обеспечивает поддержку генеративного ИИ на периферииКомпания Hailo сообщила о коммерческой доступности изделия Hailo-10H — ИИ-ускорителя второго поколения, ориентированного на работу с генеративными приложениями на периферии. Новинка доступна в виде интегрируемого чипа COB (Chip On Board), а также в виде модулей формата M.2 Key M 2242/2280. По словам компании. при энергопотреблении всего 2,5 Вт новинка способна выдавать более 10 токенов в секунду на моделях с 2 млрд параметров, при этом на отдачу первого токена уходит менее одной секунды. Также чип позволяет детектировать объекты в режиме реального времени в видеопотоке 4K. По заявлениям разработчика, Hailo-10H позволяет использовать большие языковые модели (LLM), визуально-языковые модели (VLM) и другие модели генеративного ИИ локально — без необходимости подключения к облаку. Это выводит ИИ-возможности периферийных устройств на новый уровень. Кроме того, обеспечивается ряд других преимуществ по сравнению с обработкой информации в облаке. В частности, достигается высокий уровень конфиденциальности, поскольку персональные данные не пересылаются на сторонние серверы, а остаются на устройстве. Отпадает также необходимость оплаты облачных вычислительных ресурсов. Ускоритель Hailo-10H может использоваться в системах с CPU на архитектурах x86 и Arm. Энергопотребление находится на уровне 2,5 Вт. Говорится о совместимости с Linux, Windows и Android, а также с фреймворками TensorFlow, TensorFlow Lite, Keras, PyTorch и ONNX. Изделия в виде модулей М.2 используют интерфейс PCIe 3.0 x4. Объём встроенной памяти LPDDR4/4X составляет 4 или 8 Гбайт. Предусмотрены индустриальный и автомобильный варианты исполнения: в первом случае диапазон рабочих температур простирается от -40 до +85 °C, во втором — от -40 до +105 °C. Производительность Hailo-10H достигает 40 TOPS в режиме INT4 и 20 TOPS в режиме INT8. Ускоритель полностью совместим с программным стеком Hailo. Среди ключевых сфер применения новинки названы автомобилестроение, телекоммуникации, розничная торговля, информационная безопасность, персональные компьютеры и пр.

23.07.2025 [09:37], Владимир Мироненко

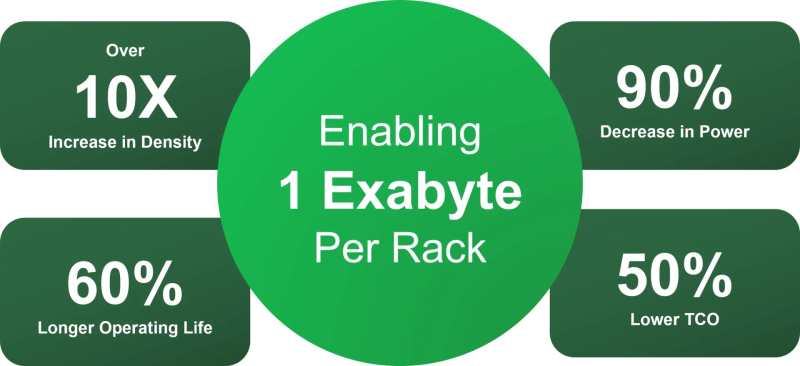

SSD не нужны: OFP обещает на порядок повысить плотность All-Flash СХД и наполовину снизить расходы на инфраструктуруИнициатива Open Flash Platform (OFP) призвана полностью пересмотреть работу с флеш-памятью в ИИ ЦОД. Участники OFP — Hammerspace, Linux Foundation, Лос-Аламосская национальная лаборатория (LANL), ScaleFlux, SK hynix и Xsight Systems — намерены отказаться от традиционных All-Flash хранилищ и контроллеров. Вместо них предложено использовать флеш-картриджи с минимумом аппаратной начинки, а доступ к таким массивам предоставлять посредством DPU и pNFS. Как отмечено в пресс-релизе, OFP отвечает многим фундаментальным требованиям, возникающим в связи со следующим этапом развития СХД для ИИ. Для ИИ требуются поистине огромные массивы данных, но вместе с тем ЦОД сталкиваются с дефицитом энергии, повышением температуры и недостатком свободного места. Именно поэтому в OFP решили, что инфраструктуры хранения для ИИ лучше разработать с чистого листа. Если 10 лет назад технология NVMe вывела флеш-память на новый уровень производительности благодаря отказу от устаревших шин данных и контроллеров, то теперь OFP обещает раскрыть возможности флеш-памяти, исключив посредников в виде серверов хранения и проприетарных программных стеков. OFP же опирается на открытые стандарты и open source решения, в частности, Parallel NFS (pNFS) и стандартный Linux, для размещения флеш-памяти непосредственно в SAN. А отказ от традиционных СХД обеспечит на порядок большую плотность размещения данных, существенную экономию энергии и значительно более низкую совокупную стоимость владения. OFP отметила, что существующие решения изначально привязаны к модели сервера хранения, которая требует чрезмерных ресурсов для повышения производительности и возможностей. Конструкции всех современных поставщиков AFA не оптимизированы для достижения максимальной плотности размещения флеш-памяти и привязаны к сроку службы CPU (обычно пять лет), тогда как срок службы флеш-памяти в среднем составляет восемь лет. Эти серверы хранения также предлагают проприетарные структуры и уровни хранения данных, что приводит к увеличению количества копий данных и добавлению расходов на лицензирование для каждого узла. Комментируя инициативу, ресурс Blocks & Files отметил, что Pure Storage и другие поставщики AFA уже предлагают оптимизированные схемы лицензирования и подписки, в том числе с обновлением контроллеров и дисковых полок. Та же Pure Storage предлагает более высокую плотность хранения, чем многие другие поставщики, хотя и использует проприетарные решения. Поддержкой DPU тоже удивить нельзя. Например, VAST Data уже поддерживает работу своего ПО на NVIDIA BlueField-3. А большинство поставщиков флеш-массивов и так поддерживают RDMA и GPUDirect. OFP выступает за открытый, основанный на стандартах подход, включающий несколько основных элементов:

Благодаря использованию открытых архитектур и компонентов, соответствующих отраслевым стандартам, реализация OFP приведёт к значительному повышению эффективности хранения данных, утверждают основатели инициативы. Так, обещано десятикратное увеличение плотности размещения данных, что позволит «упаковать» в одну стойку 1 Эбайт, попутно снизив энергопотребление на 90 %, увеличив срок службы флеш-памяти на 60 % и уменьшив совокупную стоимость владения (TCO) на 60 % по сравнению со стандартными массивами хранения. По мнению Blocks & Files, в текущем виде OFP выглядит скорее как маркетинговая инициатива, от которой в первую очеред выиграют её участники. Концепция же «сетевых» SSD сама по себе не нова. Весной Kioxia показала SSD с «оптикой». Да, тут речь идёт скорее о блочном доступе и NVMe-oF, но, например, Nimbus Data в прошлом году представила ExaDrive EN с поддержкой NFS.

23.07.2025 [01:39], Владимир Мироненко

Oracle поставит OpenAI два миллиона ИИ-чипов для ЦОДOpenAI объявила о заключении соглашения с Oracle о строительстве дополнительных ЦОД мощностью 4,5 ГВт в США в рамках расширенного партнёрства, что станет дальнейшим развитием проекта Stargate. OpenAI пока не назвала площадки для этих ЦОД, но рассматриваются штаты, Мичиган, Висконсин и Вайоминг, пишет Bloomberg. Компания сообщила, что с учётом строящегося объекта в Абилине (штат Техас), общая мощность дата-центров Stargate в США составит более 5 ГВт, и в них будет использоваться более чем 2 млн чипов для ИИ-задач. Ранее в этом месяце стало известно о планах OpenAI арендовать дополнительные мощности ЦОД у Oracle. В январе OpenAI, Oracle и SoftBank Group объявили о намерении инвестировать $500 млрд в развёртывание ИИ-инфраструктуры на 10 ГВт в США в течение следующих четырёх лет. Теперь OpenAI заявляет, что рассчитывает превысить это обязательство «благодаря сильной динамике сотрудничества с такими партнёрами, как Oracle и SoftBank». Как отметил Bloomberg, хотя OpenAI назвала строительство дополнительных ЦОД совместно с Oracle частью проекта Stargate, SoftBank не участвует в его финансировании. В мае Bloomberg сообщил, что SoftBank столкнулась с трудностями в переговорах о финансировании проекта на фоне общей экономической неопределенности, связанной с пересмотром пошлин США. OpenAI также рассказала о ходе строительства кампуса Stargate I в Абилине (Техас), где часть объекта уже введена в эксплуатацию. Oracle начала поставлять первые стойки с чипами NVIDIA GB200 в прошлом месяце, и часть ЦОД уже работает несколько недель, сообщила компания. Также OpenAI отметила, что Microsoft продолжит предоставлять облачные сервисы для неё, в том числе через Stargate. |

|